Краткое содержание. Модели машинного обучения, обученные на данных участников без каких-либо гарантий конфиденциальности, могут допустить утечку чувствительной информации. Например, при применении машинного обучения в рекламе в идеале мы хотим изучить общие закономерности («показывать научно-ориентированную рекламу пользователям, посещающим научные сайты»), однако параметры модели могут закодировать конкретные факты об интересах отдельного пользователя («Иван посетил https://brave.com/research/ 7 марта 2024 года»). К сожалению, некоторые организации могут не придерживаться заявленных принципов обучения моделей с учётом конфиденциальности пользовательских данных. Это может происходить как намеренно, так и непреднамеренно (к примеру, в случае с труднообнаружимыми багами).

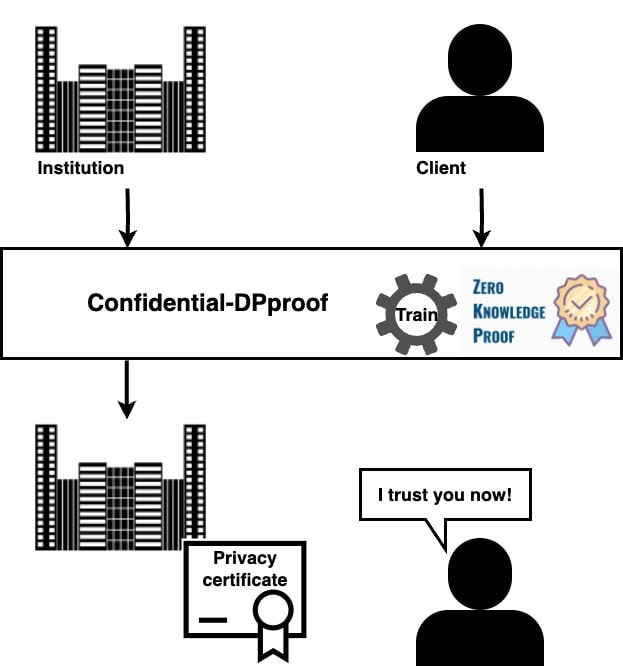

Наша модель верифицируемого конфиденциального обучения под названием Confidential-DPproof (Confidential proof of differentially private training) способствует более конфиденциальному обучению, и не раскрывает при этом никакой информации об использованных данных и самой модели.

Confidential-DPproof доступна с открытым исходным кодом и может использоваться организациями для предоставления гарантий верифицируемой конфиденциальной защиты клиентских данных в продуктах на основе машинного обучения.

Почему важна конфиденциальность пользовательских данных при обучении моделей?

Модели машинного обучения, обученные без защищающего конфиденциальность данных алгоритма, могут запомнить чувствительную информацию из своей обучающей выборки. Публикация параметров или даже только результатов моделей машинного обучения может подвергнуть риску конфиденциальность пользователей, которые внесли свой вклад в процесс их обучения. Например,

Атаки типа membership inference используют доступ к результатам модели для получения выводов о присутствии (или отсутствии) конкретных данных в её обучающей выборке.

Атаки типа data reconstruction, где исходные данных из обучающей выборки восстанавливаются благодаря анализу параметров модели.

Как мы можем защитить конфиденциальность пользователей?

Фреймворк дифференциальной конфиденциальности является золотым стандартом для формализации гарантий конфиденциальности. При обучении моделей машинного обучения алгоритм обучения с дифференциальной конфиденциальностью математически точным образом предоставляет участникам гарантии того, что данные, предоставленные каждым отдельным участником, имеют ограниченное влияние на конечную модель. Таким образом, отсутствие или наличие конкретного участника не может создать существенно отличающуюся модель.

Подход, известный как Differentially Private Stochastic Gradient Descent, является каноническим подходом к обучению моделей машинного обучения с гарантиями дифференциальной конфиденциальности. Он гарантирует дифференциальную конфиденциальность благодаря: 1) обрезке градиентов для каждого примера до фиксированной нормы, чтобы ограничить чувствительность алгоритма к данным каждого отдельного участника (предполагая, что каждый участник вносит в обучение только одну точку данных); и 2) добавлению откалиброванного шума к градиентам до их применения для обновления модели, чтобы обеспечить неотличимость между обновлениями. Обучение моделей машинного обучения с использованием этого подхода значительно снижает риски любых атак, направленных на данные обучения.

Почему важна верифицируемая конфиденциальность?

Реализация подобных алгоритмов обучения может быть сложной, и трудно обнаруживаемые ошибки могут легко возникать в результате необычных и сложных модификаций базового алгоритма обучения. Поэтому организации могут на самом деле не придерживаться своих заявлений о гарантиях дифференциальной конфиденциальности при обучении моделей как намеренно, так и случайно. К примеру, вы можете ознакомиться с неочевидными моментами касательно работы Apple с подобной моделью здесь.

Поэтому важно, чтобы компании или другие организации, использующие DP-SGD, могли продемонстрировать, что они действительно тренируют модели в рамках соответствующих мер защиты конфиденциальности данных.

Фреймворк Confidential-DPproof

Мы разработали фреймворк Confidential-DPproof, позволяющий организациям напрямую и проактивно доказать с помощью протокола Zero Knowledge Proof любой заинтересованной стороне: пользователям, клиентам, регуляторам или правительствам, что их модели машинного обучения действительно были обучены с сохранением конфиденциальности данных.

Как работает Confidential-DPproof?

Мы предлагаем протокол Zero Knowledge Proof для проактивной генерации сертификата конфиденциальности в процессе обучения, сохраняющий при этом конфиденциальность всей релевантной информации, включая обучающие данные и параметры модели. Zero Knowledge Proof позволяет стороне доказывать утверждения о конфиденциальности своих данных, не раскрывая их. Таким образом, набор данных или модель доказывающего не раскрываются третьим сторонам.

Участники. Рассмотрим ситуацию с двумя сторонами: доказывающим и аудитором:

Доказывающий — это организация, которая хочет обучить модель на чувствительном наборе данных для целей, основанных на машинном обучении.

Аудитор — это сторонний участник (например, пользователь или аудитор), цель которого — верифицировать гарантии конфиденциальности модели доказывающего.

Желаемые характеристики:

Полнота. Аудитор должен быть в состоянии сделать вывод о гарантии конфиденциальности и предоставить общедоступный сертификат этой гарантии.

Надёжность. Аудитор должен иметь возможность обнаружить злонамеренных доказывающих, которые намеренно или случайно не придерживаются своих заявлений об обучении моделей машинного обучения с гарантиями конфиденциальности.

Zero Knowledge. Обучающие данные и параметры модели, полученные во время обучения, должны оставаться конфиденциальными, поскольку организации не желают/не имеют права делиться своими моделями и данными с третьими сторонами по причинам сохранения конфиденциальности данных и исходя из опасений, связанных с интеллектуальной собственностью.

Фреймворк Confidential-DPproof работает следующим образом:

Доказывающий публично объявляет о гарантиях конфиденциальности, которые он планирует предоставить;

Доказывающий и аудитор договариваются об алгоритме обучения Differentially Private Stochastic Gradient Descent и конкретных значениях его гиперпараметров.

Доказывающий и аудитор запускают наш новый zero-knowledge протокол.

Доказывающий получает сертификат о заявленной гарантии конфиденциальности.

Какова производительность Confidential-DPproof?

Поскольку мы разработали Confidential-DPproof для того, чтобы организации могли доказывать конфиденциальность своих моделей аудиторам, сохраняя при этом конфиденциальность своих данных и модели, мы рассматриваем следующие вопросы:

Какие компромиссы между полезностью и сертифицированными гарантиями конфиденциальности может достичь Confidential-DPproof, учитывая i) соответствующие интересы организаций (с точки зрения полезности); ii) соответствующие интересы аудитора (с точки зрения конфиденциальности); и iii) ограничения, налагаемые моделью верификации zero-knowledge, относительно сложности моделей?

Какова стоимость (с точки зрения времени выполнения) проверки процесса обучения с соблюдением конфиденциальности?

Вывод: ConfidentialDPproof работает за приемлемое на практике время выполнения!

Вы можете ознакомиться с полной версией нашей статьи, чтобы узнать больше.