Сохранность данных компании очень важна. Хранение информации на серверах сторонних провайдеров в дата-центрах — удобный вариант, но не идеальный. Никто не может гарантировать, что на сервера не попадет вирус или их не взломают. Чтобы получить полный контроль над данными и обезопасить свой бизнес, задумайтесь о собственной серверной комнате.

В прошлой статье мы рассказывали как выбрать сервер для малого бизнеса. В этот раз поговорим о том, как установить собственную серверную комнату, позабыв об аренде места у поставщиков.

Отказ от услуг хранения данных и перенос сервера на свою территорию решает многие проблемы безопасности. Однако придется потратиться на покупку и установку специального оборудования.

Владельцев малого бизнеса может смутить настройка и сборка серверной, но понимая основы работы серверного оборудования, достаточно просто сделать собственное хранилище, не прибегая к магии.

Стойка сделает все проще

Стоечные сервера (rackmount server) — один из самых популярных вариантов для малого бизнеса. Они надежны, просты в эксплуатации, достаточно мощные, легко масштабируемы и занимают мало места. Самые популярные марки серверов в России — Dell, Asus, HP и Supermicro.

В небольших компаниях соединенные между собой серверы часто складывают на столе или полке рядом с офисным оборудованием. Это простой и дешевый способ раскладки, но как только оборудования становится больше, начинаются проблемы и беспорядок.

Свободно лежащее оборудование полностью открыто для физического воздействия. Это бомба замедленного действия, которая дожидается несчастного случая. Стоит кому-то пролить кофе или споткнуться о провода, всё может выйти из строя. Более того, даже обычная пыль, скопившаяся на корпусе серверов может вывести их из строя.

Где хранить серверы в офисе? Для этого есть специальное оборудование — стойки и шкафы для серверов типа rackmount. Стойки немного дороже напольных и не-стоечных аналогов, но с установленными в них серверами проще работать. Кроме того, стойки и шкафы для хранения серверов легко найти, они продаются в любой компании занимающейся поставкой телекоммуникационного оборудования.

Стойки на все времена

Перед тем как купить серверную стойку, хорошо бы разобраться в базовых характеристиках.

Стойки измеряются юнитами, обозначается как RU (Rackmount Unit) или просто U. Один юнит равен 44,45 мм, компоненты оборудования и высоту стоек измеряют по числу юнитов. Например, сетевой коммутатор имеет 1U–2U, rack-серверы — 1U–4U, blade-серверы — 5U–10U и больше.

При выборе сервера обратите внимание на ширину и глубину стойки. Для первого это 19 дюймов (48,26 см), а для второго — 600–1000 мм. Некоторые серверные стойки оснащены регулируемыми кронштейнами, хотя большинство стоек поставляется с монтажным комплектом, который можно использовать до тех пор, пока хватает глубины для установки сервера.

Самый популярный сегодня вариант хранения серверов — стойка с четырьмя опорами шириной 19 дюймов. Стандартные измерения высоты для полноформатных полок — 42U, половинных — 24U. Cуществуют полки с другими размерами, например настольные варианты от 5U до 20U. Измерения не учитывают реальную высоту стоек, которая зависит от дизайна конкретной модели. Некоторые стойки комплектуются колесиками для большей мобильности.

Существует несколько альтернатив серверным стойкам, полезных в случае ограниченного пространства в офисе. Это стойки с открытым каркасом и небольшие настенные шкафы. Стоит обратить внимание, что к такому оборудованию есть ряд требований, например, открытые стойки должны быть привинчены к полу, а настенные шкафы не предназначены для сильных нагрузок, в них может поместиться лишь несколько серверов и сетевых коммутаторов.

Уберите шум

Компаниям, которые не могут выделить комнату под серверы, должны подумать о том, как минимизировать шум от «железа». Но всё же, если это возможно, выделите отдельную комнату под серверы, даже совсем маленькую, это стоит усилий, поскольку поможет избавиться от излишней влажности в помещении и устранит шум, который влияет на работоспособность сотрудников. Кроме этого, отдельное помещение для серверов защитит от кражи и визита посторонних.

Малому бизнесу часто не приходится выбирать где ставить серверы: либо в одном из углов офиса, либо посреди ИТ-отдела. В таких случаях рекомендуется использовать стойки со звукопоглощающими панелями. Но поскольку отверстия для вентиляции полок все равно есть, конечный уровень шума будет зависеть от модели самой стойки.

Подумайте об охлаждении

Если вы планируете использовать несколько сетевых коммутаторов в паре с сетевым хранилищем, то потребности в охлаждении нет. Пакет из еще нескольких серверов, пары адаптеров бесперебойного питания и сетевых хранилищ с расширенным объемом памяти начнут быстро нагреваться. Излишне говорить, что высокие температуры могут сократить срок службы оборудования и стать причиной отключений и аварий.

Чтобы не допустить перегревания, можно сопоставить нагрузку на сетевое оборудование с его мощностью или просто измерить температуру внутри стойки, этого будет достаточно.

Один из часто задаваемых вопросов при оборудовании собственной серверной — кто будет следить за оборудованием ночью? Для этого потребуется отдельный кондиционер, который не связан с общей системой вентиляции и включается только в определенное время. В идеале нужно два отдельных кондиционера, которые включаются посменно, поддерживая беспрерывную работу серверного оборудования.

Сделайте комнату безопасной

Серверная — это пожаро- и взрывоопасное место. Все помещения от 24 м2 оснащаются системами пожаротушения и оповещения. Кроме этого, не помешает система видеонаблюдения. Она поможет обезопасить комнату от вторжения посторонних и быстро среагировать в случае происшествий.

Также в самой серверной должна быть памятка о правилах пожарной безопасности, инструменты для тушения пожара должны пройти инвентаризацию.

Разберитесь с проводами

Упорядоченная система хранения проводов — залог хорошей вентиляции стоек. Поэтому не стоит заполнять полноформатную полку 42U оборудованием 1U до отказа, поскольку это создаст путаницу из кабелей и затруднит вентиляцию оборудования. Кроме этого, если вы будете покупать старые серверы, стоит оставлять интервалы в 1U для того чтобы обеспечить дополнительный поток воздуха.

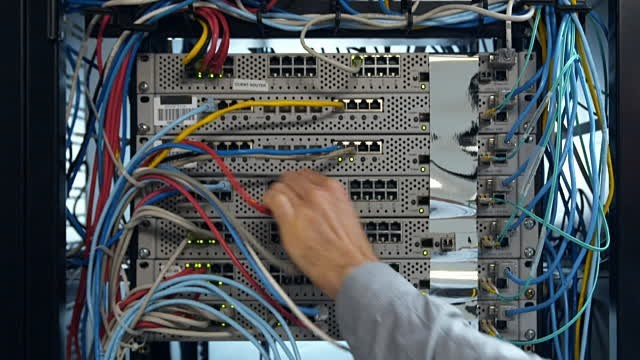

Установить стойку для серверов — это немного больше, чем закрутить несколько болтов. Надлежащий менеджмент кабелей невозможно переоценить, так как почти каждый элемент в стойке связан с кабелями Ethernet. Поэтому будет хорошей идеей использовать разные цвета проводов для Ethernet LAN, IP видеокамер и других сетевых подключений.

Лучший способ управлять всеми проводами — использовать патч-панель (коммутационная панель) RJ-45 для Ethernet. Типичная патч-панель устанавливается в пространство 1U для обслуживания 24 портов. Использование патч-порта предполагает немного работы руками — протягивание кабеля к патч-панели, встраивание их в устройство, а также использование тест-устройства для проверки соединения. Если бюджет позволяет, можно нанять специалиста, который сделает всю работу меньше, чем за день.

В дополнении к коммутационной панели всегда держите запасные кабели в пластиковом мешочке на застежке, чтобы уберечь провода от вредителей. Стандартные пакеты для кабелей дешевы, если покупать их оптом, кроме этого, каждый пакет можно использовать много раз, что делает их себестоимость еще дешевле.

Разметьте оборудование

Наконец, не скупитесь на маркировку оборудования и документирование настроек, даже касательно простых. Настройки могут быть очевидными для работодателя, но могут стать головной болью для нового ИТ-сотрудника в компании. Маркировка не только экономит время, но и снижает вероятность критических ошибок в случае отключения оборудования от сети или перегрузки.

Какой самый простой способ разметить серверную инфраструктуру? Купить маркировочный принтер. Сервера и сетевые коммуникации помечают уникальными именами с указанием IP-адресов. То же самое следует сделать и с другим оборудованием: переключателями клавиатур, камер и мышек (KVM), роутерами, жесткими дисками.

Подробные описания и инструкции по использованию должны висеть в серверной рядом с соответствующим оборудованием. В инструкциях указывают информацию об эксплуатации сети, резервном копировании и запуске оборудования в случае отключения энергии.

Таким образом, следуя этим простым рекомендациям, даже те компании, которые не сталкивались прежде с ИТ-инфраструктурой могут сделать свою серверную комнату. А каким правилам следуете вы, чтобы сделать свою серверную лучше?

Комментарии (50)

i360u

20.10.2016 16:47+4Чтобы обезопасить ваши сервера от главной опасности — проверяющих органов — лучше не делайте своих серверных.

Wedmer

20.10.2016 17:29+1Или держите серверную в засекреченном и удаленном месте.

LoadRunner

20.10.2016 17:53+2Или работайте админом в проверяющих органах.

dmitry_ch

20.10.2016 18:17+1Можно и не «админом». Но это вопрос личного отношения, не всем по сердцу.

roscha

21.10.2016 19:10+2У меня на мясокомбинате было 2 серверных. Первая — с опенсорсом, вторая — с варезом. Ну и плюс отказоустойчивость.

Вторая была на «складе специй», полностью герметичная с фильтрами на воздухозаборнике кондея.

Wedmer

21.10.2016 22:40Круто. Но проблема не в варезе чаще всего) Защита от последствий маски-шоу так сказать.

Dimd13

20.10.2016 18:03-2Сервера могут стоять в красивой стойке и красоваться брендами. Кабеля могут быть уложены так, что любой перфекционист будет завидовать. И охлаждение будет на уровне. Но данные ваши это никак не защитит ни от вирусов, ни от кражи и потери если у вас рукожоп вместо квалифицированного админа, с которого в случае полной потери данных и спросить то нечего.

И тут стоит 10 раз подумать своя комната или проверенный провайдер услуг.

muon

21.10.2016 03:11+3Проблема не в рукожопом админе, спасение не в проверенном провайдере услуг. Оба варианта создают риски, которые нужно учитывать. С подходом «серверная — плохо, облако — хорошо» руководство рано или поздно останется у разбитого корыта, потому что «хорошо/плохо» — это не подход делового человека. В принципе.

Dimd13

21.10.2016 08:49Заметьте, я не говорил, что своя серверная это плохо или хорошо. Я лишь прочитав статью в разделе Администрирование, не встретил в ней, кроме тэгов, ни слова про администрирование, а лишь «поставьте к себе», «сделайте всё красиво»…

Свое оно хорошо. Доступ к “телу” в любое время, а не “по предварительной записи” с описанием всех манипуляций.

Но!

Оборудование это не: купил поставил и все работает… Смотрите, у нас тут серверная комната… Красота, диодики мигают… и забыл! За всем этим хозяйством надо следить, ухаживать, обновлять, менять оборудование и комплектующие которые вышли из строя, и лучше когда они только еще начинают как бы намекать, например бэды на жестких дисках появились, надо менять пока полностью не рассыпались. Но как это обычно бывает: “Денег нет, но вы там держитесь, работает ведь!”. Скупой платит дважды.

В статье написано про пару бесперебойников, да они помогут, практически безболезненно отключить ваши сервера, когда свет вдруг погаснет. Вопрос как долго здание вашего офиса будет сидеть без света и что будут делать пользователи которые не смогут получить доступ к сервису. Да, и по хорошему батареи в них надо менять раз в несколько лет, не дешевое удовольствие. И питание должно быть независимым от общего рубильника. И желательно с резервом.

Каналов связи тоже должно быть несколько. Но, как показывает практика, в офисных зданиях сейчас арендодатель предлагает услуги провайдера с которым у него есть договор и затянуть еще пару сетей задача не из легких. Да и стабильность предлагаемой сети оставляет желать лучшего. Опять же: Свет погаснет, связи нет.

Малому и среднему бизнесу проще и выгоднее купить пакет услуг у проверенных временем провайдеров. Здесь им будет предложена и поддержка 24/7/365, и резервирование данных, и стабильные каналы связи, и защита от атак, бекапирование, своё оборудование и ПО провайдер обновляет так что пользователь этого даже не замечает, и резервирование питания с аварийными генераторами, и системы пожаротушения. А главное ответственность!

Ernado

20.10.2016 18:11Я понимаю, зачем может понадобиться серверная в крупной компании, где своя инфраструктура действительно может быть востребована. Но малому бизнесу как раз гораздо проще и пользоваться облачной информаструктурой. Тот же Azure/AWS/DO обойдутся гораздо дешевле, чем покупка всего необходимого оборудования, найм системного администратора (а возможно даже и нескольких) и собственно оборудование комнаты. Плюс еще переезды, которые у малого бизнеса могут случаться довольно часто — еще один фактор против такой вот "серверной в чулане".

u_story

20.10.2016 18:49+2Можете расчёты привести, почему это дешевле?

Допустим сервера обновляются раз в 3-5 лет, админ приходящий, в комнате 2 метра квадратных есть.

mexanism

20.10.2016 22:35-1Масштабируемость от ~1000р/мес до ~30000р/мес — от 0.25ядра 0.75Гб Озу до 8 ядер 14Гб Озу в несколько кликов. Также можно выключить сервер и платить только за занятое дисковое пространство. Стабильный коннект сервера с интернетом и электричеством. В РФ сервера можно дешевле найти. Приходящий админ может спать, а саппорт из Бангалора онлайн 24/7, но желательно знать английский. Пользуюсь azure — сначала по bizspark, а потом лень было, что-то другое искать

Ernado

21.10.2016 16:39-2Давайте по другому поступим. Вы приведете расчеты для серверной, со всем необходимым, оборудованием системой пожаротушения, охлаждения, сигнализацией, с учетом замены комплектующих, с возможностью делать бэкапы на расположенный в географически удаленной точке сервер бэкапов, с оплатой системного администратора, который действительно администратор, не приходящий эникей, который картридж умеет починить, а потом я вам представлю примерные затраты на тоже самое в облаке. Поверьте, дешевле будет.

muon

24.10.2016 04:37То есть вы утверждаете, что облако обойдётся дешевле, а вместо аргументов предлагаете собеседнику посчитать самому? Это, как минимум, неуважительно, даже без учёта фактологической стороны вопроса.

macbookpro

21.10.2016 19:11+1Практика показывает, что «облаками» (дурацкое слово кстати) нельзя обойтись полностью даже малому бизнесу.

Вот пример: офис 60 человек, VoIP телефоны у каждого + 4 конференц комнтаы, 15 принтеров (3 из которых общего польнования), пачка wifi точек по офису, видеоборудование. Не сложно догадаться, что есть точка всей этой сети, где это всё хозяйство должно собраться. Место не нужно? Даже самая маленькая стоечка не нужна? А куда сканы складывать от сканеров общего пользования? А пользователям обмениваться файлами, что бы лишний раз не грузить интернет канал (он знаете ли не безграничный), да и в целом не зависеть от доступа в интернет?

Вот то, что я описываю — это самый обычный клерко-офис. Программистов нет ни одного. И вот есть деятель «сложить всё в облака» в итоге сложили, а теперь выясняется, что без внутренней инфраструктуры пусть даже в её минимальном варианте жить как-то сложно. Управлять компьютерами пользователей без AD сложно, а Azure AD стоит ваще-то конских денег, 12.5 долларов в месяц / 1 пользователей и так далее и тому подобное. Поэтому я пока не могу себе представить (исходя из реальной эксплуатации в эту секунду) как полностью вывалиться в облака и нужно ли это вообще.

Да, есть преимущество — масштабируемость ресурсов в пару щелчков мыши. Что для разработчиков может быть очень актуально. Но нужно ли это для клерко-офиса?

alcohollica

24.10.2016 10:41Вы так говорите, как будто пользование облачной архитектурой Azure/AWS/DO исключают найм системного администратора.

Ernado

24.10.2016 11:24+1Как минимум, значительно сокращает объем работы выполняемой администратором.

Sevmixser

20.10.2016 18:52+1Здорово советовать все делать в облаке, в крупных городах может быть и прокатит, а в областях, а в глубинке? Везде быстрый и стабильный интернет? Да обрыв электричества нужно ждать устранения до нескольких дней, про интернет я уже молчу.

Советы «в облако» годны только для самых крупных городов.

Valeriy_Squadra

20.10.2016 19:21+1Поддерживаю эту идею — сделать внутренние сервисы (эл.почта, базы данных, прикладное ПО, файлообмен) компании более доступными и менее зависимыми от провайдера той или иной услуги.

Зачастую в нашей необъятной стране доступ к широкой полосе ограничен, крупные города — не исключение, к примеру промышленные зоны.

macbookpro

22.10.2016 00:04Я поддерживаю это не только в России, даже в загнившей США проблемы имеются. Электричество скачет, ураган может оборвать провода, которые будут ремонтировать до 30 дней! интернет пропадает, провайдер только один и макс 300мбит и это ещё не самый задрипанный штат… Хотя вот email я всё же предпочёл платить $5 user/monthly облакам.

БД накорячил сейчас в облако, пока тестирую на пользователях задержку, но в запасе держу план по быстрой миграции в офис

Прикладное ПО, как оказалось… эксплуатировать через RemoteApp — это дорого и больно.

По-моему личному мнению — облака это хорошо, но взять и отдаться им беспамятства есть сущее безумие и безответственность к бизнесу компании.

И кстати, мне тут приводили аргумент, мол «там спецы в любом случае лучше, если что-то случится». Лучше, без проблем. У Гугл Клаудс минимальная поддержка стоит $300/monthly, так что может она и лучше, но кусаеЦЦо.

IgorEnot

20.10.2016 19:09для очень «малого» бизнеса (1-10 человек) такой подход будет не по карману, хоть и правильный по сути…

Valeriy_Squadra

21.10.2016 14:07Согласен, эта история больше про малые (годовая выручка 800 млн.руб.) и средние предприятия (годовая выручка 2000 млн.руб.) со штатом от 30 человек и выше, где тех. и бизнес процессы формализованы.

Чем больше штат и направлений деятельности у предприятия, тем больше сервисов прикручено к железу, тем выше требования к отказоустойчивости. И каждая минута простоя может стоить от нескольких тысяч до сотен тысяч рублей.

В этом случае удобнее обслуживать серверную внутри своей IT структуры. Где, помимо всего прочего, десятки десктопов/лэптопов и прочей сетевой обвязки.

jaredhared

21.10.2016 01:49+1Самый простой способ и дешевый способ маркировки — купить в канцелярском магазине рулон с ценниками. Просто, дешево и заметно. Желательно взять ценники такого размера, чтобы могли обернуться вокруг кабеля и прилепиться сами к себе.

HiMem-74

21.10.2016 11:54Замечательно подходят наклейки-этикетки для печати штрих-кодов. Есть разных размеров, замечательно писать, стоят дешево.

dklm

21.10.2016 08:19+3… стоит оставлять интервалы в 1U для того чтобы обеспечить дополнительный поток воздуха.

Извините но, что за чуш?

Дополнительный поток воздуха между чем и чем?

Вендоры «заставляют» все промежутки между оборудованием заполнять заглушками, именно для того чтобы был «правильный» поток воздуха, и если вы будете сертифицироваться — нужно отвечать на такие вопросы правильно ;-)

fanya249

21.10.2016 09:43+3Писали какието балбесы которые серверные видели только на картинках.

1) Стойки это стойки. Стойки не могут быть звукопоглощающими по определению. Стойки бывают однорамные и двухрамные. Все что с панелями и «звукопоглощением» это ШКАФЫ.

2) Стойки и шкафы бывают не только 19", есть еще 23".

3) Когда покупаешь шкаф мерять нужно не только войдет ли юнитовый сервер в раму, но и полное расстояние от дверей потому что сервер то войдет, а провода уже нет. Большинство шкафов позволяют выставить раму под нужную глубину, но при этом имеют фиксированную глубину по дверям.

4) Ни о каком Dell/HP начинающим серверостроителям даже думать не надо. Это пустая трата денег. Ваш выбор только Supermicro. Выбирайте мат.платы с IPMI.

5) В юнитовых серверах ровно также скапливается пыль, они точно также подвержены воздействию со стороны и т.д.

6) Если вы молодая компания даже не думайте вкладывать деньги в rackmount и т.д. Покупайте Supermicro в тауерах и superquiet шасси. Если вам в конце концов приспичит — это легко засовывается в стойку или шкаф, большие корпуса имеют опционально шасси для преобразования в рэкмаунт.

7) Если вы доросли до шкафа и юнитовых серверов — покупайте PDU, кабельные органайзеры, мешок velcro, заглушки (бывают сразу на много юнитов), мешок болтов, и хотябы градусник/snmp модуль в UPS. Если сервера без IPMI(iDRAC/inSight) покупайте еще IP KVM.

8) Полки для клавиатуры колхоз из прошлого.

9) Не думайте об охлаждении если купили сервера. Думайте об ЭЛЕКТРОСНАБЖЕНИИ. Хороший UPS сопоставим по цене с сервером, а от перегрева большинство серверов защищено аппаратно.

10) Шкафы бывают антивандальными. При острой необходимости оборудование можно размещать в общедоступных местах.

11) Самый дешевый способ маркировки — фломастер.

12) «Поэтому не стоит заполнять полноформатную полку 42U оборудованием 1U до отказа, поскольку это создаст путаницу из кабелей и затруднит вентиляцию оборудования.» Вы датацентр хоть раз видели? Они именно так и делают. 48U заполняют 1U оборудованием до отказа. Именно для этого стойки и шкафы и предназначены.

13) «Стойки немного дороже напольных и не-стоечных аналогов, но с установленными в них серверами проще работать.» вы пробовали обслужить 1U сервер не на выдвижных салазках прикрученный в стойке? Тауер — со своим снял боковую крышку просто рай для обслуживания.

14) «Лучший способ управлять всеми проводами — использовать патч-панель (коммутационная панель) RJ-45 для Ethernet. Типичная патч-панель устанавливается в пространство 1U для обслуживания 24 портов. Использование патч-порта предполагает немного работы руками — протягивание кабеля к патч-панели, встраивание их в устройство, а также использование тест-устройства для проверки соединения. Если бюджет позволяет, можно нанять специалиста, который сделает всю работу меньше, чем за день.» А лучше купите кроновский пистолет и посмотрите видео на youtube.

15) Не слушайте никого

извините, мне лень продолжать

Sevmixser

21.10.2016 10:48+1По пункту 6, да не покупайте сервера rackmount и через некоторое время ваша серверная будет выглядеть так:

fanya249

21.10.2016 11:00Трололо. Рэкмаунт от свиней не спасет. На фото серверов нет. Есть бытовые системники, да еще прошлого века с IDE шлейфами. Читаем пункт 15.

Sevmixser

21.10.2016 15:29+1Хорошо, что вы представились :)

На фото доносился смысл того, как оборудование обрастает проводами, находясь не в стойке, а хаотично поставленное в серверной, аллегория, понимаете? :)

navion

21.10.2016 18:39Ни о каком Dell/HP начинающим серверостроителям даже думать не надо.

Зависит от специфики, когда мало серверов с ответственными задачами tier 1 выручат быстрой квалифицированной поддержкой и простотой обслуживания. С траблшутингом Микры, Интела и Кванты всё не так гладко даже у «местных вендоров», а тариф на четырёхчасовой ремонт у них дороже контрактов IBM.

У разработчиков — другое дело, им нужно много максимально дешевых железок.

fanya249

21.10.2016 23:53+11) Квалифицированная поддержка. Индусы level1, Индусы level2 и т.д… За 12 лет никакой помощи кроме «присылайте на замену», «попробуйте обновить»

2) SLA c 4мя часами dell и hp тоже не дают просто так и бесплатно.

3) В чем проявляется простота обслуживания у брендов которая недостижимая на supermicro?

Теперь о преимуществах Supermicro над dell/hp/lenovo(ibm)/cisco и т.д.:

1) У supermicro адекватная цена. «крутые» бренды продают свое железо с дикой наценкой абсолютно без каких либо на то причин. Можно резервировать железо по принципу n+1 просто покупая supermicro вместо «тируанов» и экономить.

2) У supermicro нет vendor-lock-in. «крутые» бренды прописывают ID устройств в bios/efi, лепят кастомные сокеты под процессоры, кастомные прошивки hdd/sdd. В общем делают вашу жизнь яркой и насыщенной при любой попытке изменить конфигурацию.

3) У supermicro бесплатный IPMI. Цена лицензий на iDRAC/iLO неимоверно радует и соизмерима с ценой Windows.

Вся эта суета вокруг больших вендоров раздута только на мифе «они крутые» «у них надежнее» «у них качественней» и т.д. По факту это железо выпускается на одних и тех же заводах foxconn/quisda и т.д.

Для маленьких компаний все эти мифы про надежность и суппорт не работают ВООБЩЕ. Вас просто обдерут как липку.

navion

24.10.2016 17:38Индусы level1, Индусы level2 и т.д… За 12 лет никакой помощи кроме «присылайте на замену», «попробуйте обновить»

Не знаю с какими индусами вам приходилось иметь дело, но меня русскоязычная поддержка Dell и IBM пока не разочаровывала.

В чем проявляется простота обслуживания у брендов которая недостижимая на supermicro?

Обновления прошивок, драйверов и дистрибутивов ESXi. Стандартизация запчастей и хоть какая-то гарантия совместимости с ПО. База знаний и статистика по неполадкам у поддержки, благодаря десяткам тысяч проданных серверов (чего очень не хватает местным сборщикам), плюс готовность отвечать на тупые вопросы.

К SMC нужен ЗИП и специалисты, а в мелких компаниях с ними беда. Это называется непрофильная деятельность, которую бизнес старается отдать подрядчикам.

mav5555

21.10.2016 10:50+12003-2011 год. Брутальный файл-серверок HP tc2100 с локальной CRM системой на 30-ть рабочих мест в инжиниринговой компании. Работал безотказно. Питер.

Два фото

fanya249

21.10.2016 11:24Монитор прекрасен. Владел аналогичным 9" ч/б CRT… Он был на маленьком сервировочный столике вместе с клавиатурой и мы его катали по ДЦ :)

mav5555

21.10.2016 12:19+1Забыл указать, может кому-нибудь будет полезно.

Внизу находился нагнетательный вентилятор с фильтром. Включался при температуре выше 25С. Нагнетал отфильтрованный воздух внутрь шкафа, т.е. шкаф был под небольшим давлением (по танковому принципу). Воздух охлаждал всё железо и уходил через вентиляционные отверстия вверху на задней стенке шкафа-сейфа. Датчик температуры находился чуть выше монитора. Таким образом поддерживалась температура и не допускалась пыль внутрь шкафа. Так же ограничивался шум от сервера. SCSI диски тех времен всё-таки были шумноваты.

В самом помещении (4 кв.м) вверху находилась вытяжная вентиляционная решетка бизнес-центра. Там же был установлен датчик потока, который давал сигнал аварии, если центральная вытяжная система бизнес-центра вдруг по каким-то причинам переставала работать. Кроме этого была простейшая световая и звуковая сигнализация по перегреву или отсутствию электричества. Бумажная инструкция по типу «что делать» под всей этой «свето-музыкой» была наклеена на шкаф. Так же всё это мониторилось дистанционно. В штате сисадминов не было, т.к. была компания на аутсорсе, которая по-графику приезжала, проверяла состояние офисных компьютеров и самого сервера. Скидывала на ленту месячный бекап.

В самом офисе компании было своё автономное кондиционирование. Летом температура была в пределах 23С, зимой 21С. Поэтому шкаф с сервером «засасывал» для своих нужд приемлемую температуру.

Dimd13

21.10.2016 11:28Какой самый простой способ разметить серверную инфраструктуру? Купить маркировочный принтер.

Вы серьезно? Самый простой? Купить маркировочный принтер?

Админ (А): Нужен маркировочный принтер

Директор (Д): Это что такое?

А: Это такая штука которая печатает наклейки.

Д: Для чего?

А: На кабеля бумажки с IP наклеить, на сервера…

Д: Он что-то еще умеет, кроме наклеек печатать? Где мы его еще сможем применить? Как часто вам придется им пользоваться?

А: Ммм…

Д: Сколько стоит?

А: Я смотрел на я.маркете от 8000

Д:

1. Скотч + ножницы + бумага + принтер.

2. Ножницы + бумага для наклеек + принтер.

3. Малярный скотч + ручка

Вы уверенны в своем утверждении про самый простой способ?

mxms

22.10.2016 00:30От 3.5 килорублей на самом деле. А маркировать можно что угодно.

См. Brother P-Touch.

Valeriy_Squadra

24.10.2016 10:38+1Стоимость принтера ниже 3к рублей, для компании средней руки это вполне посильные затраты.

Помимо маркировки кабелей, принтер может работать на благо инвентарных объектов: наклейка плотная, не стираемая и вследствие этого долговечная, в отличие от дедовского способа «Ножницы/бумага/скотч».

Директора выбирают порядок и долгосрочную перспективу.

Alligattor

21.10.2016 17:20Ок, Краснодар, торговая организация: 15 рабочих мест, 2 сервера. Задача: обустроить серверную — причесать кабеля, прикрепить новые короба, заменить 4 системника-типа-сервера на 2 сервера HP с миграцией данных и т.п. Считаю по минимуму, клиент офигивает и начинаем «колхозить» для экономии. Знаем я и клиент, что ПОТОМ этот колхозинг аукнется (если до этого момента доживет), но…

В данном случае бизнес не уверен в своих вложениях на перспективу и таких всё больше — все экономят.

Но есть и другие непечальные истории, но уже не так часто.

dklm

24.10.2016 09:0115 рабочих мест по 500 уе = 7500 уе в месяц на зп… и это только на зп сотрудников у которых есть ПК… я не ошибся?

сервера покупаются из расчета 5+ лет работы, два новых тауера от HP будут стоить примерно 2-3к уе.

в таких случаях я не не могу понять где хочет «сэкономить» владелец.

macbookpro

22.10.2016 00:10А есть у вас практические или хотя бы теоретически рекомендации по правилам наименований узлов в сети, их маркировке. Пример журналов маркировки, настроек и так далее. С железом всё понятно, а вот с документацией, логическим построением и разного рода рекомендациям (персональные сетевые шары там, сканеры и т.д.) по реально боевым условиям эксплуатации — вот чего действительно не хватает.

equand

"уберечь провода от вредителей" — эти вездесущие эко-менеджеры.