Искусственный интеллект — сфера, в которой сейчас занято большое количество инженеров и ученых. Практически каждый день появляются новости о разработке той либо иной формы слабого ИИ, выполняющей определенные функции, которые могут оказаться полезными человеку. Сейчас разработчики из DeepMind, подразделения холдинга Alphabet Inc., занимаются решением интересной и актуальной для современного общества проблемы. А именно — выясняют, при каких условиях несколько ИИ-агентов будут сотрудничать или конкурировать друг с другом.

Проблема, которую пытаются решить специалисты из DeepMind, схожа по сути с так называемой «дилеммой заключенного». Ее можно сформулировать следующим образом. Практически во всех странах наказание участников преступной группировки гораздо жестче, чем наказание преступников-одиночек, совершающих одинаковые преступления. Что, если полиция схватила двух преступников, которые попались примерно в одно и то же время за совершение сходных преступлений, и есть основания полагать, что преступники действовали по сговору? Дилемма появляется в том случае, если предположить, что оба преступника хотят минимизировать собственный срок заключения.

Предположим, что полиция предлагает преступникам одну и ту же сделку: если один из преступников свидетельствует против другого, который молчит, то этот «молчун» получает 10 лет тюрьмы, а его товарищ, рассказавший обо всем, выходит на свободу. Если молчат оба, то преступники получают тюремный срок в полгода. Если оба свидетельствуют друг против друга, то получают тюремный срок в 2 года. В такой ситуации действовать можно по-разному: исходя из интересов группы или собственных интересов.

Эта дилемма — простейший пример того, с чем придется столкнуться разработчикам различных ИИ-агентов уже в ближайшее время. Если над решением одной и той же проблемы (например, решением вопроса дорожного движения во время погодных катаклизмов) будут работать сразу несколько алгоритмов, то как заставить их сотрудничать, чтобы решение проблемы было максимально эффективным? В реальной жизни сотрудничество или конкуренция могут быть гораздо более сложными проблемами, чем те, что описаны выше. И последствия сотрудничества или конкуренции тоже могут быть гораздо более сложными.

Именно поэтому сотрудники DeepMind решили заняться поиском возможных путей сотрудничества ИИ-агентов.

Для проверки того, как будут вести себя слабые формы ИИ во время решения какой-либо задачи, специалисты разработали несколько игр. Одна из них получила название «Gathering», то есть «Сборка». В игре принимают участие два компьютерных игрока, цель которых — собрать как можно больше яблок из одной кучи. Любой из игроков может временно обездвиживать соперника при помощи «луча лазера». В этом случае за единицу времени можно собрать больше виртуальных яблок, чем соперник.

Во второй игре, Wolfpack, два игрока должны охотиться на третьего в виртуальном пространстве, наполненном препятствиями. Игроки получают баллы при захвате добычи. Но максимальное количество баллов стороны получают только в том случае, если вместе находятся на минимальном расстоянии от жертвы.

То, что случилось при запуске обеих игр, сложно назвать непредсказуемой ситуацией. В первом случае ИИ-агенты соперничали друг с другом, потому, что находили это максимально рациональным принципом взаимодействия при заданных разработчиками условиях. Во втором случае прежние соперники начинали активно сотрудничать, поскольку во второй игре это было гораздо более выгодной линией поведения, чем конкуренция.

В первой игре соперники изначально работали с лазером не слишком активно, пока куча яблок была большой. Но по мере снижения количества полезного ресурса лазер пускали в дело все чаще. С течением времени ИИ-агенты становились «умнее», и начинали стрелять друг в друга лазером даже в самом начале, когда яблок было еще много. Можно сказать, что алгоритм, самообучаясь, нашел максимально эффективный способ поведения в этой игре.

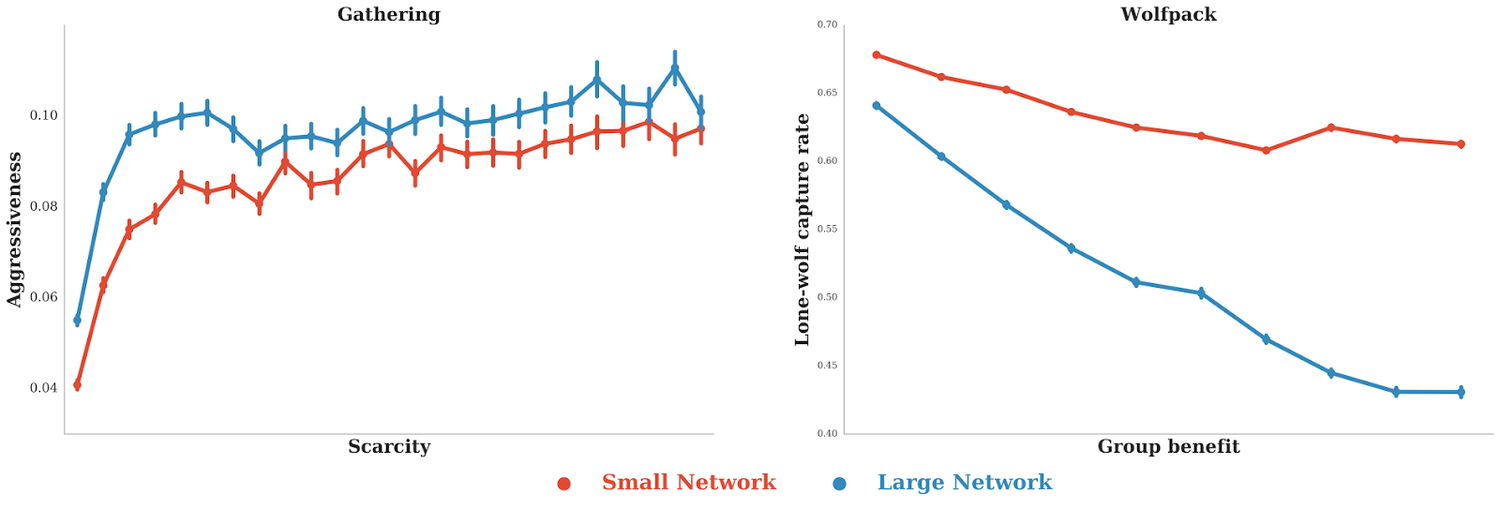

График слева показывает зависимость агрессии игроков по отношению друг к другу по мере истощения запасов ресурсов. График справа показывает зависимость частоты поимки жертвы лишь одним из игроков и общую сумму баллов, полученных группой охотников.

И наоборот, во второй игре ИИ-агенты с течением времени становились все более открытыми к сотрудничеству. Если на первых порах оба старались поймать добычу в одиночку, то в конце оба агента сотрудничали, поджидая партнера рядом с жертвой.

Собственно, результаты исследования тоже нельзя назвать сюрпризом. Специалисты выяснили, то поведение ИИ-агентов меняется в соответствии с условиями и ограничениями их окружения. Если правила предполагают получение выгоды в случае агрессивного поведения, то ИИ будет становиться все более агрессивным. В противном случае ИИ будет становиться все более склонным к сотрудничеству с партнером или партнерами.

В целом, эксперимент несколько прояснил будущее человечества в тот момент, когда наша жизнь во многом станет зависеть от искусственного интеллекта. Если ИИ будет выгодно сотрудничать с другими формами ИИ, так и случится. «Как следствие (изучения результатов исследования, — прим. ред), мы можем лучше понимать динамику сложных систем с несколькими ИИ-агентами», — рассказывают авторы проекта. Текущие результаты могут быть полезны для экономики, систем дорожного движения, экологии и прочих сфер науки и быта.

Поделиться с друзьями

Комментарии (3)

Zmiecer

10.02.2017 09:00-1Очень похоже на попил бабла на мутных исследованиях :-(

Как заголовок, так и сам эксперимент.

2morrowMan

12.02.2017 06:29Если задачей обучения нейронной сети было поиск макс. выгоды, то они этого добились.

Но интерпритировать все в «сотрудничество» ИИ-агентов или ах «агрессивное» поведение — искуство, да.

Fen1kz

> В целом, эксперимент несколько прояснил будущее человечества в тот момент, когда наша жизнь во многом станет зависеть от искусственного интеллекта. Если ИИ будет выгодно сотрудничать с другими формами ИИ, так и случится.

Что случится?

*шутка про то что зеленые и синие квадратики — это модели человечества*