Но что делать, если у тебя в компе стоит GT 240 512Mb, на которой с горем пополам работает Civilization V? Если даже на планшете с убогим Z8300 эта игра идет лучше? В общем апгрейд назревал уже давно, а выход летом/осенью прошлого года новых ускорителей сказал: Пора.

Почему именно Radeon?

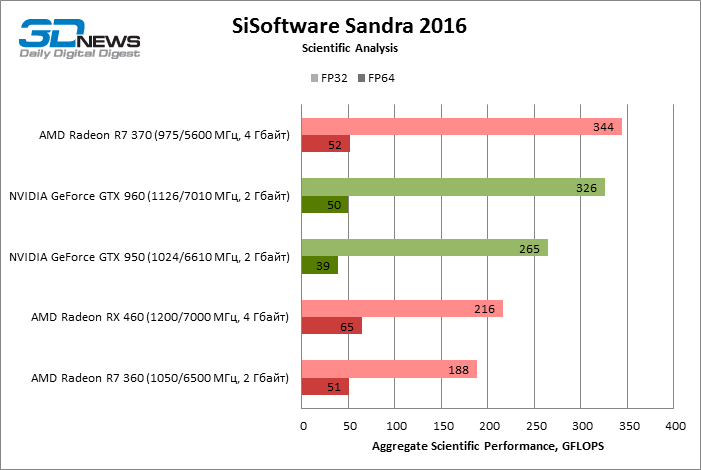

Первая причина это монитор. По счастливому стечению обстоятельств был приобретен экземпляр с FullHD и FreeSync-ом за смешные деньги. Имев возможность ранее опробовать эту технологию у знакомого, удивлялся, как я раньше жил то. Вторая причина, это как ни странно работа. Разрабатываю приложение с довольно высокой нагрузкой, часть которой перекидываю на встройку интела. Но есть несколько неприятных нюансов. Вычислительных юнитов у неё не так много, а в двойную точность на OpenCL умеет только предпоследнее поколение. А добавить видеокарту намного проще чем менять мать+проц на всех объектах. Nvidia, как известно, хорошенько режет скорость FP64 вычислений в игровых решениях, для лучшей продажи Quadro серии, AMD в свою очередь старается хоть как-то увеличить продажи и такого безобразия себе позволить не может. в доказательство могу привести тесты SiSoftware Sandra с сайта 3dnews:

С производителем определились, что же с ценой?

Тут все просто. Чем дешевле, тем лучше. Неприятный опыт покупки б/у комплектующих говорит что надо брать свеженькое, а из свеженького и дешевенького у нас только 460ая. Казалось бы, осталось выбрать только подходящий кастом, но остается вопрос, а что же я собственно получу? И вот ты уже с головой окунулся в десятки и сотни обзоров видеокарт.

Чем плохи существующие обзоры?

Есть ряд огорчающих меня факторов. Первый: я люблю читать текст, читаю быстро и с упоением. А большинство обзоров сейчас выходят на Ютубах и слушать как кто-то гнусавым голосом разжевывает всем очевидные вещи и старательно переливает из пустого в порожнее я не люблю. Второй фактор: Нормальные обзоры выходят на средне-топовое железо. Производители хотят продать железо подороже и рассылают соответствующие экземпляры обзорщикам. Винить их в этом сложно, но как итог есть обзоры Rx480 летом и сейчас, и указано насколько таки поднялась производительность после ~~уборки мусора~~ в коде оптимизации драйвером AMD, а по Rx 460 я такой информации не нашел. Третий фактор: Карты тестируют в неправдоподобных условиях. Это частично завязано на предыдущей проблеме, потому что каждый сайт хочет набрать некую базу и тестирует всех под одну гребенку. В итоге мы имеем 100500 fps на Titan X и 10 на сегодняшнем герое. Но где с одной стороны стандартизация, там с другой анархия. Каждый обзорщик выдумывает свое название для выкрученных настроек графики. High, Ultra, Very High, Max и т.д. А самое печальное, что сглаживание большинство указать забывают. Многие к тому же не считают своим долгом (или не умеют) указывать минимальный FPS. А он на бюджетных решениях играет много больше чем некий “средний”. Ведь толку тебе с 30 средних, если при беге вперед у тебя 60+, а при резком развороте 5? Но приходится работать с тем что есть, а есть у нас вот что:

Хватит воды, даешь цифры.

www.overclockers.ua/video/asus-rog-strix-rx460-o4g-gaming/all

ru.gecid.com/video/asus_strix-rx460-o4g-gaming

ru.gecid.com/video/sapphire_nitro_radeon_rx_460_4g_d5/?s=all

www.tomshardware.com/reviews/amd-radeon-rx-460,4707.html

www.techpowerup.com/reviews/ASUS/RX_460_STRIX_OC/10.html

3dnews.ru/938654

itc.ua/articles/obzor-videokartyi-asus-rog-strix-rx460-o4g-gaming

www.thg.ru/graphic/obzor_amd_radeon_rx_460/obzor_amd_radeon_rx_460-01.html

www.ferra.ru/ru/system/review/sapphire-nitro-radeon-rx-460-4g-d5

www.guru3d.com/articles_pages/asus_radeon_rx_460_strix_gaming_4gb_review,10.html

www.pcworld.com/article/3109542/components-graphics/sapphire-nitro-rx-460-oc-review-a-classy-capable-low-cost-graphics-card.html?page=2

occlub.ru/testodrom/2730-obzor-asus-radeon-rx-460-strix-kakoj-on-mladshij-polaris?showall=1

www.ixbt.com/video4/asus-radeon-rx-460-strix.shtml (сдесь замеры в разрешени 1920/1200, нормализованы до 1920/1080)

www.osp.ru/pcworld/2016/09/13050201

root-nation.com/featured/sapphire-nitro-radeon-rx-460

hexus.net/tech/reviews/graphics/101773-asus-gigabyte-sapphire-xfx-radeon-rx-460-compared

и гость сегодняшней программы: обзор с nvidia-ориентированного сайта:

nvplay.ru/videocards/geforce-gtx-1050-protiv-radeon-rx-460-sravnitelnoe-testirovanie

В большинстве своем видеокарты протестированы на топовых процах Intel с бешеным количеством ядер и частотой выше 4.0Ghz. Самый убогий затесался i5-3xxx с частотой 3.3, но у не думаю, что остальные комплектующие хоть как-то влияли на карту этого уровня. Свои кастомы рассылали Sapphire и Asus, частоты которых выше референсных, но итоговые FPS я привел нормализованные до 1200 МГц. Карты я рассматривал с объемом памяти 4Gb, младшие версии в текущих реалиях не интересны.

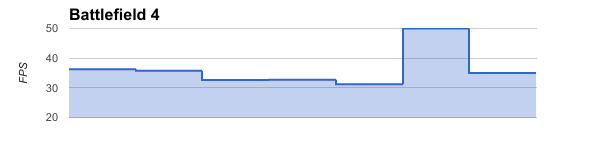

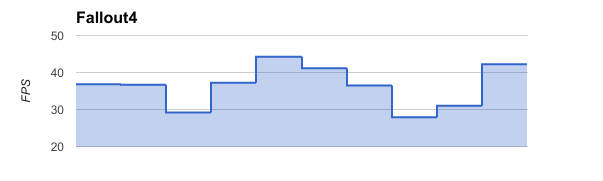

*Настройки:Ultra MSAA x2, Ultra, Max, Ultra 4x MSAA*

Пиковое значение у обзорщика с 3dnews, который догадался убрать сглаживание, в остальном разница не критична и картинка одинакова у всех

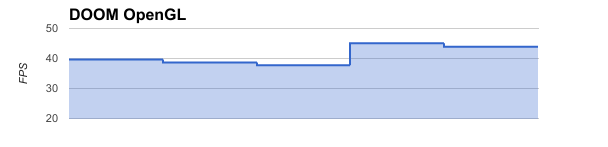

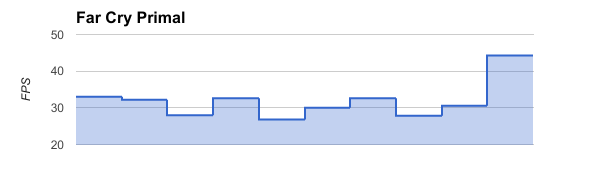

*Настройки: Ultra FXAA,HIGH TSSAA 8TX, а некоторые просто постеснялись указать*

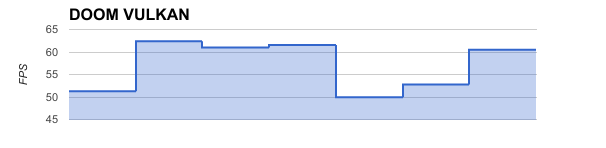

Разница некритична, тем более, что под вулканом картина много лучше:

Первый приличный разброс. Можно предположить, что пиковая середина это отсутствие сглаживания, а авторы не пожелали нужным указать было ли оно использовано. Примечателен самый последний результат. Обзор за январь этого года, а настройки те же, что и в предпоследнем: Ultra TSAA 8x

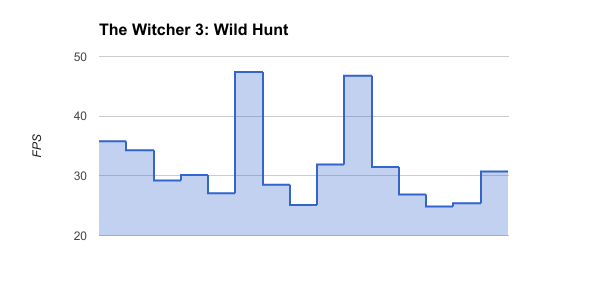

*Настройки: Ultra HBAO+, Max (ray medium), TAA 16xFA, Ultra TAA 16xAF HBAO+, Max*

Разница доходит до 15 кадров. Неплохо? Первый провал это обзор с сайта nvplay.ru. Кроме низкого среднего количества кадров у них еще и минимальные упали до 21. Второй провал — это результаты ixbt.com, потому-что они замеряли при разрешении 1920х1200. Следующий за провалом столбец это нормализация этого результата.

Тут у всех более менее одинаково, а osp.ru просто решил поставить настройки в Normal. Естественно остальные поголовно Max, Ultra и прочее.

20 кадров разницы! Все обзоры по данной игре за август/сентябрь так что влияние драйверов минимально. У всех поголовно Max, ultra и куча сглаживаний. Самые большие результаты у www.tomshardware.com, самые маленькие у ixbt.com, хотя настройки у них не самые выкрученные. Кому верить — непонятно.

Еще одна радость это Ведьмак разница чуть ли не в половину, естественно самый худший результат у nvplay.ru. Самый высокий опять у www.tomshardware.com.

Итоги по обзорам

Никому доверять нельзя. Честно говоря, просмотрев тучи обзоров я уже не сильно верю, что кто-то еще честно гоняет все тесты. максимум включают карту, чтобы посмотреть на нагрев/потребление и прогнать бенчмарки. Те игры, которые имеют встроенный бенч выдают +- одинаковые результаты у всех, остальные смотрят другие обзоры и накидывают случайно +- пару кадров. Очень надеюсь, что это не так, но ощущение складывается именно такое.

Итог по карте: карта в целом хороша за свои деньги, а поскольку близорукость автоматически добавляет сглаживание к картинке, то я смогу позволить поиграть даже на весьма высоких настройках, чего не позволял уже давно. А вычисления пока ждут, так как драйвера AMD под линукс упорно не встают.

UPD:Обновил большинство графиков от условно-неиграбельных 20 кадров до потолка в большинстве игр 50

Комментарии (109)

grvelvet

13.02.2017 12:38Varfalomey, надо было брать 480 — 70, 60 жуткий урезок. Моя 470 в паре i5 3470, выдает вполне приличный результат, на максимуме практически все игры 2014 — 2016.

Varfalomey

13.02.2017 12:50А еще лучше брать Titan X. Вопрос стоял в том, достаточно ли здесь и сейчас этого конкретного огрызка

grvelvet

13.02.2017 14:50Ответ очевиден — нет.

Varfalomey

13.02.2017 15:01+2Вот почему я и огорчен существующим форматом обзора бюджетных карт. Потому-что не ультра настройки их удел, а часто и разрешение меньше чем FullHD, а чешут их под ту-же гребенку, что и топовые. Разницы со сглаживанием/без я не вижу, а для поиграть пару часов раз в неделю я смысла тратиться не вижу.

RaymanOne

14.02.2017 13:46Что может Radeon RX 460 2gb в современных играх? Вот здесь обзоры и сравнения самые правдивые из всех что видел, ведущий на любителя, но цифры годные.

TerraV

13.02.2017 12:41+6Имхо трудности выбора бюджетной видеокарты это нонсенс. Берешь младшую модель последнего семейства и все. Если по каким-то причинам такая формулировка не работает, решаешь задачу «трудности выбора работы».

UJIb9I4AnJIbIrUH

14.02.2017 14:38+1занятно ещё и то, что бюджетный RX460 сейчас стоит около >8к рублей, а то и все 9500р, хотя ещё несколько лет назад это было нонсенсом. Я в своё время купил предфлагман GTX275 за 9000, а мой друг брал GTX570 за 10500р. Сейчас же предфлагман 1070 за 24000р торгуется. Спасибо курсу доллара, вот такой вот закон развития рынка электроники In Soviet Russia =)

Fllash

13.02.2017 13:00+3Ведь толку тебе с 30 средних, если при беге вперед у тебя 60+, а при резком развороте 5?

А вот этот момент как раз уже не от видеокарты зависит.

Кстати, отчасти именно поэтому видеокарты тестируются на сборках с околотоповыми процессорами и прочим фаршем — дабы не портили картину «провисы» в прочем железе, и был виден потолок самой видюшки.

Грубо говоря, 5 фпс при развороте — это уже может быть проблемой оперативки, если не харда. Внезапная подгрузка, подвис на секунду-полторы, и вуаля — вот оно, значение в 5 фпс, которое довольно быстро возвращается к нормальным 50-60.

UJIb9I4AnJIbIrUH

14.02.2017 14:31и наверно вы даже можете привести пример тестов, которые наглядно демонстрируют критичной зависимость fps от типа оперативной памяти и харда?

Fllash

14.02.2017 17:47Не столько «типа» оперативной памяти, сколько её количества. Да вы и сами, скорее всего, легко можете произвести такой тест, и не один.

В качестве примера могу привести игру ArcheAge. Достаточно запустить ее, имея на борту 4гб оперативки — и вам обеспечены как раз те проблемы, о которых писал автор. При переходе из одной локации в другую, при резком повороте камеры — грубо говоря, каждый раз, когда идет подгрузка новых текстур, объектов и т.п. Из лесочка зайти в город — кошмар обеспечен. Но после «прогрузки» можно спокойно вертеть камерой, двигаться туда-сюда, и подобного уже не будет.

Как только я увеличил оперативку до 8гб — эти симптомы практически исчезли.UJIb9I4AnJIbIrUH

14.02.2017 18:00так графика хранится в памяти видеокарты, ОЗУ то тут каким боком. Вообще характеристики ОЗУ влияют только тогда, когда для игр используется APU, но тут уж грех жаловаться

vladvalmont

14.02.2017 18:23Рискну предположить, что видеокарта использует ОЗУ при нехватке своей видеопамяти. На системе с 4 гигабайтами ОС сжирает почти 2, оставшиеся 2 отдаются под игру. Сама игра расходует часть памяти и при попытке видеокарты сбросить текстуры в ОЗУ — наблюдаются тормоза.

Даже не так. При резком развороте камеры видеокарта как раз загружает новые текстуры и если её основная память забита — пробует сбросить текстуры в ОЗУ, а если там места нет — текстуры уходят в своп на HDD. Вот вам и 5 кадров в секунду :)

Fllash

14.02.2017 20:58Вот да. Что-то в этом роде, с одной оговоркой — если память видеокарты забита, а она пытается подгрузить в нее новые текстуры, то при резком повороте камеры (ну, или резкой смене локации) первые доли секунды (а иногда и несколько секунд) вместо текстур может выдаваться просто черный цвет. Однако, описываемые «подтормаживания» имеют место быть и в том случае, когда текстурки-то отображаются корректно, но обращения к харду в этот момент, мягко говоря, повышенные.

Впрочем, подозреваю, что тут намного больше нюансов, чем мы сможем охватить. И от движка игрули это наверняка зависит далеко не в последнюю очередь, и много еще от чего.

UJIb9I4AnJIbIrUH

14.02.2017 18:15я понял ваши доводы. Но тут не совсем так: прогрузка локаций это ОЗУ+процессор, а вот поворот камеры это уже сфера ответственности видеокарты

Fllash

14.02.2017 21:11Да, при условии, что всё, попадающее в поле зрения, уже подгружено. Юмор именно в том, что озвученные подтормаживания проявляются только в первый раз, при первом, так сказать, посещении локи. Повертев камеру, «прогрузив» всё окружение, они пропадают — и да, вот тогда за фпс во время последующих поворотов отвечает именно видеокарта.

Я специально упомянул именно ArcheAge в примере — казалось бы, тот же DOOM (2016) просто обязан нагружать видеокарту ощутимо сильнее, чем игра 2013года, сделанная на движке CE3. Однако — нет.

На самом деле, имея в наличии далеко не топовые компьютеры, но со сравнительно неплохой видеокартой (особенно если такая тенденция соблюдалась лет эдак 15), визуально даже элементарно определить, из-за чего проседает фпс. Если упирается в видюшку — то фпс стабильно будет держаться на маленьких значениях (в пределах определенной локации, разумеется). Если же, как автор и писал изначально, речь идет о 50-60 фпс, резко падающих до 5 при совершении неких определенных действий (тот же резкий поворот, к примеру) — это уже не видео. Эта именно что ОЗУ, в меньшей степени процессор, а сама нехватка озу добавляет в наше уравнение своп-файл — а тут уже и хард подключается.

Как-то так, видимо.

darthslider

15.02.2017 10:52Doom, кстати, отлично оптимизирован. Dishonored 2, который практически на том же движке едва ползает там, где дум летает.

jetexe

15.02.2017 11:06это же дум от Кармака. Про его оптимизацию легенды ходят

slafniy

15.02.2017 13:02Ну и DOOM — коридор, в играх с большим открытым миром всё намного хуже и требования к процессору много больше.

darthslider

15.02.2017 13:36В новом Думе достаточно открытых пространств, на самом деле, да и уровни не маленькие. Не уверен, что в Dishonored 2 сильно больше, на самом деле.

slafniy

15.02.2017 13:44-1«Открытые пространства» это не «открытый мир» с кучей юнитов и объектов.

Пример: World of Warcraft. Находишься в столице где скопление людей — процессор не справляется, еле еле 40-50 фпс, независимо от настроек графики. Тот же WoW, только когда ты в инстансе на 5 человек — 90+ фпс.

Вот дум он как WoW в инстансе на одного человека =)

darthslider

15.02.2017 13:51Я сравниваю именно с Dishonored 2, который тоже на ID Tech, только следующей версии, и который оптимизирован просто ужасно. Там такой же «коридор» фактически ведь, разве нет? Да и NPC там сильно меньше на уровень.

slafniy

16.02.2017 01:56Не играл в него, не могу ничего сказать.

Коридоры тоже криво умеют делать, Call of Duty один из недавних недобром словом поминали…

VertiBird

14.02.2017 17:536Гб опертивки на ноуте: GTA5 стабильно отрисовывает 40-50 fps на заранее прогруженной области карты. Если из области уйти — постоянные просадки до 1-2 fps, играть невозможно.

8Гб оперативки на ноуте: GTA5 стабильно отрисовывает 40-50 fps чтобы я не делал.

Soul_in_Gun

16.02.2017 09:35+1Вклинюсь — Прямо сейчас наблюдаю подобные вещи — начал планомерный апгрейд своей старой по нынешним меркам машинки и начал с видеокарты. В итоге в пару к i3-3240 вместо 560Ti который тянул R6:Siege на низких в 40-70fps в 1680х1050 было доткнуто монструозное 1060. В итоге на любых настройках кроме самых низких наблюдается забавная картина — в статичных сценах фпс равняется ~70к\с даже на самых ультра-с-дополнительными HD текстурами при том же разрешении. А вот как только начинается «движуха» чем выше настройки тем сильнее идут просадки — вплоть до совершенно неиграбельных 10к\с. А виной всему недостаточно шустрый проц, который просто не способен нагрузить данную карту (и это при достаточно бодрой даже по нынешним меркам single-thread производительности — видимо всё-же игре нужен multithread в том числе).

Вот и думайте как говорится. Не то чтоб прям «тест», но IRL-тестирование в погоне за плавным апгрейдом и надеждой на singlethread.

Akuma

13.02.2017 13:42+1Хм. Как раз недавно выбирал видеокарту. Не сказать, чтобы прям «для игр», но и не для ворда с экселем.

Начал с 1050ti и в итоге остановился на 1060 OC. Которую нашел за 18900, кажется. Краснодар.

Она вместе с i5-6600 и 16GB DDR4 выдает отличный FPS на всех современных играх. Настройки на ультру.

Разме что в ROTR пришлось сглаживание снижать, потому как оно у всех забирает 20 FPS за просто так.

Так вот, к чему это я. Если уж вы в выборе, хоть и бюджетной видюхи, ориентируетесь на FPS в современных играх — берите ту, которая их нормально тянет. rx460 их не тянет. И, скорее всего, вам не удастся поиграть во что-то чуть более новое. А тогда какой смысл от этой модели? Докинули бы 3-4 тыс. и взяли ту же 1050ti.

Кстати, зачем нужен FreeSync, если у вас все равно до 60 FPS не дотягивает?

a553

13.02.2017 15:10+1зачем нужен FreeSync, если у вас все равно до 60 FPS не дотягивает?

Так для того и нужен, чтобы картинка ниже 60 кадров выглядела нормально.

Akuma

13.02.2017 15:24А чем обычная верт. синхронизация не устраивает? Она залочит fps на 60, но у автора оно все равно не дотягивает до 60.

a553

13.02.2017 15:28Тем, что она не FreeSync, очевидно же. Почитайте, что это такое.

Akuma

13.02.2017 16:35Почитал. Второй раз уже. Может я что-то не так понимаю.

Верт. синхронизация нужна чтобы устранить «разорванное» изображение, когда кадры рендерятся быстрее, чем монитор успевает обновляться. Впрочем, это реально заметно только игра у вас может рендерится более 60 FPS на мониторе 60 герц. При других условиях вкл/выкл v-sync не меняет ровным счетом ничего (по крайней мере на своем опыте могу именно так сказать).

У автора на rx460 игры не будут рендерится более 60 fps. Соответственно, разрывов и так не должно быть. Поэтому наличие или отсутствие FreeSync или G-Sync картинку не изменят, скорее всего.

Может быть я ошибаюсь в том, что не будет разрывов ниже 60 fps, но вот сколько я не тестировал игры, у меня их никогда небыло на бюджетных видеокартах, т.к. они обычно просто не тянут игру.

a553

13.02.2017 16:43При других условиях вкл/выкл v-sync не меняет ровным счетом ничего

Это не так, вертикальная синхронизация синхронизирует вывод кадров видеокарты до какого-то частного частоты монитора и/или равномерно распределяет кадры по времени. Что имеет очень печальные последствия.Соответственно, разрывов и так не должно быть.

Это тоже неверно, разрывы происходят из-за различия частоты кадров вывода видеокарты и монитора.Поэтому наличие или отсутствие FreeSync или G-Sync картинку не изменят, скорее всего.

Разумеется, Adaptive Sync кардинально меняет картину в данном случае. Adaptive Sync синхронизирует частоту монитора с выводом видеокарты, устраняя пропуски кадров монитором, отображая новый кадр только тогда, когда он на самом деле срендерен. Это предотвращает разрывы экрана и делает игру гораздо более плавной. G-SYNC работает немного по-другому, но суть схожа.

Akuma

13.02.2017 18:05Вы описали как это должно работать. И я это понимаю, но на деле результат не так красив. Почитайте форумы, например. Очень многие как и я, просто не видят разницы, т.к. «и так все хорошо». А кто-то даже про v-sync не знал, т.к. проблем у него и небыло.

Я не знаю от чего это зависит, но включение того же Adaptive Sync у меня, например, не поменяло ровным счетом ничего. Картинка и без него хорошая, без багов и полос.

Возможно у вас и автора эти технологии реально помогли улучшить картинку. Я же, например, считаю их очередной маркетинговой фишкой.

Предлагаю закончить дискусию, а то я из-за минусов могу писать только раз час — дикость какая-то ))

a553

13.02.2017 18:22+1Возможно вы эти полосы просто не замечаете. Мой мелкий пятнадцатилетний геймер тоже не видит их, а я как ни посмотрю к нему в экран, сразу голова болеть начинает. (А некоторые ещё и без антиалиазинга живут. Жуть!)

Когда я купил себе Adaptive Sync монитор, первое время не понимал, работает ли вообще технология. Даже «мельницу» скачивал. А потом решил выключить, и понял, что действительно работает. (Похожий эффект даёт повышение частоты кадров – переход с 60 на 75 или даже 120 может казаться незначительным или незаметным, а вот обратно – фу-фу-фу.)

А ещё я после экпериментов нашел стопроцентный способ получить очевидную полосу разрыва – надо установить частоту кадров на единицу выходящую за пределы Adaptive Sync диапазона. У меня монитор имеет диапазон 40-60, и установив частоту кадров в 61, можно наблюдать красивую такую, стабильную полосу, медленно ползущую сверху вниз. :)

TerraV

13.02.2017 18:23-2этот v-sync был востребован только на ЭЛТ мониторах, т.к. картинку формировал луч (строчная развертка) и могла быть ситуация когда верхняя половина монитора нарисована от одной картинки, а нижняя от другой. В ЖК мониторах ничего подобного нет, там управление идет всеми пикселями разом и для ЖК мониторов важно время отклика.

Alexmaru

14.02.2017 03:06+1именно, меняется весь экран и видеокарта за это время отдаёт два-три-больше кадров.

Неужели так сложно в гугле посмотреть картинки по слову Tearing? Или V-Sync problems?

Black_Shadow

14.02.2017 12:57+2Да ну? И в кабель между видяхой и монитором попадают все пиксели сразу? Или нет? Тиринг возникает в видяхе, а не в мониторе. Сигнал попадает в кабель уже испорченный.

slafniy

15.02.2017 13:06Включенный V-sync очень сильно увеличивает время между тем, когда ты двинул мышь, и тем, когда монитор это отобразил. Это невероятно сильно раздражает, поэтому V-sync чаще всего вырубают, чтобы убрать «желеобразное» управление. Фрисинк/гсинк работает мягче, почти не добавляя этот лаг.

jafariuse

15.02.2017 14:01Вы переплатили вдвое по сравнению с 1050ti за менее чем 25% прирост производительности «не для игр».

Akuma

15.02.2017 14:12Я не писал «не для игр». Я писал, что не много играю, но когда все же хочется отвлечься от веб-разработки — хочется играть с комфортом. И 1050ti, судя по тестам и отзывам, сильно уступает 1060. 25% — это может быть 10-15 fps, что при среднем значении 60 fps на ультрах — довольно существенно.

Да и переплата там всего 10к. Это не так уж прям и много, учитывая, что я комп обновляю раз в 7-8 лет.

c_kotik

13.02.2017 14:00Трудно может быть собрать полностью ПК под определённые цели и определённый (урезанный) бюджет. А с одной видеокартой и мороки особо нет. Как писали выше — начать осмотр с современных младших моделей.

lSDriim

13.02.2017 15:26+1А вычисления пока ждут, так как драйвера AMD под линукс упорно не встают.

Вот по-этому я уже давно отказался от видеокарт Radeon.

BubaVV

13.02.2017 17:04То есть с переходом на AMDGPU существенно лучше не стало?

dartraiden

13.02.2017 18:48У них там проблемы возникли.

В ядро Linux не будут приняты изменения с поддержкой новых GPU AMD

Компания AMD подготовила достаточно большой патч для поставляемого в составе ядра Linux модуля AMDGPU, переработав код управления отображением (DC, Display Core) для обеспечения поддержки будущего поколения GPU (uGPU), а также добавив ряд новшеств, таких как средства для организации вывода звука через HDMI и DisplayPort. Размер изменений составил около 100 тысяч строк кода.

В ответ на предложенный патч, Дэвид Эйрли (David Airlie), работающий в компании Red Hat и отвечающий в Linux-ядре за поддержку DRM (Direct Rendering Manager), отказался принимать подобные изменения, пояснив, что AMD пытается вместо использования унифицированного для всех драйверов интерфейса интегрировать свой собственный слой для обеспечения взаимодействия с оборудованием (HAL). Подобные специфичные решения затрудняют понимание логики работы кода и замедляют развитие DRM (Direct Rendering Manager). Эйрли не может принять такие изменения, так как это подорвёт доверие Линуса, сообщества разработчиков графических систем и участников разработки DRM-драйверов.

Вместо того, чтобы работать вместе с сообществом и с учётом его интересов, компания AMD продолжает замыкаться на своих внутренних надстройках, необходимых для решения частных проблем компании (попытка унификации с драйвером для Windows). По мнению Эйрли, если AMD необходимо обеспечить поддержку дополнительной функциональности, такой как FreeSync или новых возможностей HDMI, это следует делать совместно, путем расширения существующих интерфейсов и консультируясь с другими разработчиками, а не за закрытыми дверями придумывать новые уровни абстракции и создавать специфичные для одного драйвера ioctl. AMD по сути не участвует в развитии Linux-стека и не использует его, продвигая свои специфичные решения. Если эти решения нужны только AMD, а для других они бесполезны, нет смысла включать такие изменения в основное ядро.

vovochka404

14.02.2017 02:52Это временно :) В этом году скорее всего все это (в измененном виде) таки въедет в ядро :)

vovochka404

14.02.2017 02:50Автор наверное имеет в виду либо amdgpu-pro, либо rocm. amdgpu — просто работает.

Prometheus

13.02.2017 16:33Лучше взять RX-470 c 4 Гигами. не турбину.

https://www.computeruniverse.ru/list.asp?searchname=rx+470

Для гейм-задач — минималка это GTX1060 с 6Г или RX480 с 8Г

UJIb9I4AnJIbIrUH

14.02.2017 16:02На самом деле разница с 1060 в версии 3Гб минимальная, если не считать того, что некоторые игры за редким исключением не позволяют ставить самую супер-пупер высокую графику при таком объёме памяти.

Вообще если бы я сейчас собирал игровой на 1080р я бы рекомендовал начинать с конфигурации на основе Pentium Kaby Lake и 1060 3Гб, на такой сборке запросто можно поиграть во всё на свете.

darthslider

15.02.2017 10:24Взял 480 4гб недавно, доволен как слон. Соотношение цена/качество прекрасное.

8гб для 1080p имхо не нужно, а для 1440p rx480 уже не хватает.

Prometheus

15.02.2017 11:45дело не в 1080p, дело в том какое кол-во видеопамяти расходует игра.

одним играм хватает 4гб, другим нет.

darthslider

15.02.2017 11:53Хотите сказать, что требуемое количество видеопамяти не коррелирует с разрешением?

Ок, перефразирую, 4гб хватает почти для всех игр при разрешении 1080p.

Prometheus

15.02.2017 12:06Мы сейчас говорим про 1080p.

Даже на этом разрешении играм может не хватить 4Г.

darthslider

15.02.2017 12:09Может. Но на примере rx480, восьмигигабайтная модель которой стоит примерно на 20-25% дороже чем версия с 4гб, по соотношению цена/производительность, на мой взгляд, 4гб версия ощутимо выигрывает. Примерно это я и имел ввиду.

Prometheus

15.02.2017 14:34просто для инфы, какая игра сколько видеопамяти кушает для 8Гб карт

https://www.youtube.com/watch?v=XNqZ1K2Y-Do

Строчка MEM — частота и объем используемой видеопамяти.u010602

15.02.2017 15:56КМК, всегда можно уменьшить детализацию текстур на 1 пункт и не заметить ни какой разницы. Скорее всего там текстуры идут в сумасшедшем разрешении «прозапас» превышающем разрешение экрана, хотя потом сам объект будет занимать 5% экрана. И еще мне кажется что когда видеопамяти 8 ГБ, то просто сборщик мусора не удаляет ненужные текстуры, даже если они больше ни разу не понадобятся.

Prometheus

15.02.2017 16:05да, понятное дело

можно поставить средние настройки и поиграть на видео-карточке с 1Гб и все будет пучком.

dartraiden

13.02.2017 18:41RX 460 ещё можно разлочить, поскольку часть ресурсов там заблокирована, чтобы был побольше разрыв между 460 и 470.

В базовом варианте они обладают только 896 потоковыми процессорами и 56 блоками выборки текстур. Немецкие коллеги нашли способ модифицировать BIOS видеокарт таким образом, чтобы активировались 1024 потоковых процессора и 64 блока выборки текстур.

источник

Прирост производительности будет в районе 10%.

25080205

13.02.2017 22:10Есть такой магазин — NIX точка ру. Там цены не особо хорошие, хоть и не самые плохие, но замечательное представление железа и тесты. Это некоторое свинство, но я давненько уже выбираю и подбираю железо на их сайте… А покупаю где дешевле, да… В общем, фотографии — много и в хайрезе — что не понятно, можно посмотреть будто «повертел в руках». Подробные характеристики, причем кое-что явно получено именно включением железки, а не просто перепечаткой ярлычка. Главное — тесты, по единой методике для всех, можно сортировать, есть параметр КПД — в процентах, отношение эффективности к цене. Помощь в выборе — быстрый ответ на вопрос, сколько стоят подобной производительности соседние железки, какая производительность у соседей за те же деньги?

VanyaKokorev

14.02.2017 01:40И именно этому магазину потребовалось привезти мне железку из Москвы в другой город, чтобы посмотреть на наклейке номер ревизии и понять, что она мне не подходит. Бюрократия, видимо, не позволила попросить кладовщика в Москве посмотреть на наклейку, как я просил

25080205

14.02.2017 02:00У всех бывают накладки… У меня был случай, когда я заказал видяхи R9 290X (икс на конце), а магазин «Сотмаркет» прислал R9 290 (без «икс»). Совершенно различные и со значительной разницей в цене. Таким образом они были в топе Я-Маркета, но присылали по неадекватно завышенной цене дешевую модель, за реально заказанную требовали доплату, вольно меняли параметры заказа до полного исчезновения его из ЛК, зачислили деньги на какой-то «внутренний счет покупателя» и отказывались возвратить их — процесс тянулся четыре месяца… На фоне такого фильма ужасов мелкие косяки нормального магазина не особенно злят.

Gorodnya

14.02.2017 01:37+1Скажу так. В последнее время интересовался, менять ли полностью компьютер, которому около 6 лет, или для относительно старых игр (серия Metro, STALKER, Dirt) на не_максимальных настройках графики достаточно купить только видеокарту.

Большинство решило, что нужно менять всё.

Я же купил одну из RX460 4GB и погонял в вышеуказанных играх. В принципе, 50 FPS на максимальных настройках есть.

В итоге: ситуация со сменой комплектующих выглядит так, что это больше маркетинговый ход.

Для старых игр полная смена платформы для нетребовательных (не)игроков необязательна. Для новых игр — бесспорно, компьютер нужно обновлять.u010602

14.02.2017 13:51Схожая ситуация у знакомых на АМ2+ платформе. Изначально там был Атлон на 2 ядра и geforce 7050 в чипсете и 1 гиг озу. Сейчас 4 ядра, 6 гигов озу и RX460 4GB, игры тянет лучше чем ноут на Core i7-2630QM GeForce GT 550M, разница в цене огромная :) Все ищу повод для апгрейда своего компа на и7 3770К и не могу найти, разве что экстрим версию взять и до 128гб озу и на 64 линии pcie.

vladvalmont

14.02.2017 14:14У меня i7 2600K/16Gb RAM/GTX 780Ti — поводов для замены пока тоже найти не могу :) разве что 780Ti заменить на 1080Ti, когда та выйдет.

Slonyxia

14.02.2017 10:34Новые карты в бюджетном сегменте не актуальны. Стоило смотреть в сторону б/у gtx 680 и близкий аналогов, они стоят где-то так. Недавно даже видел gtx 780ti от evgaза 11500.

darthmaul

14.02.2017 15:59780 Ti все ещё на плаву — обходит RX 480 и gtx 1060 6 gb (но много жрет энергии и греется), 680-я же устарела безнадёжно и уступает rx 470 в любых режимах.

Maddreg

17.02.2017 17:38может быть речь о 1060 3гб? Судя по тестам что я посмотрел, 780Ti в большинстве случаев немного проигрывает 1060 6гб или наравне с ней (бывают конечно моменты когда фпс на 780ti выше, но это происходит нечасто)

darthmaul

17.02.2017 17:48Когда как. Плюс, всё зависит от разрешения, на FullHD трёх гигабайт хватает.

vladvalmont

14.02.2017 15:12+1По поводу того, что никому доверять нельзя — согласен.

На днях читал статейку про подбор комплектующих для сборки нового ПК — «компьютер месяца». Автор статьи предлагает сборки, подогнанные под определённый бюджет: стартовая — 30-35 тыс. руб., базовая — 50-55 тыс. руб., оптимальная — 75-80 тыс. руб., продвинутая — 100 тыс. руб. и экстремальная — 150 тыс. руб.

Каждая из этих сборок сопровождается кратким описанием её возможностей:

1. Бюджет — 30-35 тысяч рублей. Системы актуальны для современных игр в разрешении Full HD со средними/высокими настройками качества графики.

2. Бюджет — 50-55 тысяч рублей. Системы актуальны для современных игр в разрешении Full HD с высокими/максимальными настройками качества графики.

3. Бюджет — 75-80 тысяч рублей. Система актуальна для современных игр в разрешениях Full HD и WQHD с высокими/максимальными настройками качества графики.

4. Бюджет — 100 тысяч рублей. Система актуальна для современных игр в разрешениях Full HD и WQHD с высокими/максимальными настройками качества графики.

5. Бюджет — 150 тысяч рублей. Система актуальна для современных игр в разрешениях WQHD и Ultra HD с высокими/максимальными настройками качества графики.

Т.е. стартовая сборка с AMD Radeon RX 470 может тянуть какую-то часть современных игр в разрешении Full HD со средними/высокими настройками? Вау, ничоси!

Текст статьи напичкан ссылками на обзоры предлагаемых железок, но нигде нет графиков — как эти сборки поведут себя в реальных условиях. Т.е. из тучи обзоров на каждую железку в отдельности, должно сложиться общее впечатление — на что способна та или иная сборка.

Последняя, экстремальная сборка, за 150 тыс. руб. — вообще удивила: раздутая продвинутая сборка, разбавленная SSD на терабайт за 20 тыс. руб., дополнительными 16 гигабайтами оперативы, различными свистелками/перделками в виде цветастых корпусов. Единственное, что здесь действительно к месту, так это GTX 1080 вместо GTX 1070. Но у автора статьи, судя по всему, стоит задача — просто подогнать как можно больше всякого дорогого барахла под определённый бюджет. Он не пишет: зачем нужно покупать SSD на 1 терабайт; в чём разница между ASUS PRIME Z270-A в продвинутой сборке и ASUS STRIX Z270F GAMING — в экстремальной; почему в продвинутой БП на 600Вт, а в экстремальной — 750Вт при практически одинаковых комплектующих; почему продвинутая сборка тянет игры в Full HD и WQHD с высокими/максимальными настройками, а экстремальная — в WQHD и Ultra HD с высокими/максимальными настройками. Наверно за счёт SSD на терабайт.

Поэтому, я соглашусь — честных обзоров действительно не осталось. Все только и пытаются впарить как можно больше разного железа, не объясняя толком — зачем.Varfalomey

14.02.2017 15:25Про этого конкретного товарища скажу, что рубрику он ведет уже довольно долго, а описание просто копирует из раза в раз. В прошлом месяце у него в стартовой стоял еще 1050, для которого это справедливо. То-же самое и про экстрим, раньше она отличалась сильнее от продвинутой.

vladvalmont

14.02.2017 16:02+1Сейчас он ведёт её уже в другом месте, про уход с предыдущего — старается умалчивать. На новом месте его засыпали комментариями с поздравлениями, а я сижу и плачу — от того, сколько же народу читает подобные статьи и восхищается авторами, выдающими всякую маркетинговую шелуху.

Раньше можно было понять: стоит ли брать ту или иную железку; чем они отличаются между собой; есть ли смысл переплачивать и т.д.

Сейчас всё просто: за эти деньги — покупайте то-то; чем дороже — тем круче; чем отличаются — не важно.

Плюс ко всему, как оказалось, автору совершенно побоку чужое мнение. Когда несколько человек пишет в комментариях, что в первых двух бюджетных сборках неплохо было бы видеть SDD вместо кулеров на ЦП, которые там, мягко говоря, вообще не нужны — он шлёт всех лесом, объясняя это тем, что в бюджет первых двух сборок SSD ну никак не вписывается; что его можно будет докупить потом — с последующим перекатом всей системы, программ, игр и т.п. Весьма рационально.

А на вопрос — «зачем нужен SSD на 1Тб?» — автор скидывает скриншот папки Steam, весом почти в 500Гб и объясняет, что нынче тенденция такая — игры много весят. Зачем их все ставить на SSD — автор затруднился внятно ответить. Говорит — Battlefield'у плохо, когда он на HDD.

Читал бы я подобные статьи, не имея опыта — собрал бы себе комп с красивой подсветкой матери, памяти, корпуса — за космическую тучу денег, понятия не имея, что на сборке ПК можно было сильно сэкономить, просто выбрав другие комплектующие — без ущерба производительности.u010602

14.02.2017 17:20Вопросов к тому автору много, и ваш подход тоже субъективен и вызывает вопросы тоже. Например что считать современными играми? Те что вышли в этом году? Самые тяжелые для железа в этом году? А может самые популярные? Что у нас сейчас самое популярное? Это танки, дота 2, контра, тим фортресс, старкрафт, майнкрафт, овервотч. Именно в эти игры играют одноклассники и знакомые брата. RX470 действительно позволит играть в эти игры на высоких настройках. И тут немаловажен бюджет, ну нету у армии школьников денег на дорогое железо, и не будут они играть от того в ААА игры с крутой графикой, а будут в то, что могут и через интернет. Выходит цикл зависимости Цена-Железо-Игры который формирует мейнстрим сегмент под который и статьи пишут в том числе.

Насчет SSD на терабайт, ну аргумент у человека вполне адекватный на самом деле. Кому нравится когда игры грузятся дольше чем у соседа? У меня например Intel 750, и Стар Крафт у меня стоит на нем, когда у меня игра открывается на несколько секунд или десятков секунд быстрее чем у малого сидящего рядом — он очень печалится, для него это важный субъективный параметр тормознутости ПК, думаю у других школьников так-же. В итоге все что является предметом «мерянья крутостью» должно быть установлено на SSD, а то «пацаны не оценят». Отличия между 1070 и 1080 возможно не так заметны, опять же судя по школьникам они не особо понимают что такое FPS, все что выше 40 им одинаково. Если 1070 выдает 40 кадров во всех популярных играх то смысла усиливать видеокарту нет, SSD важнее будет.

Кол-во озу, мощность БП — это все то, что можно выразить в числах, а числа хорошо подходят для понтования. А главная задача школьника показать что его комп дороже и круче. То что он выдает на пару кадров больше звучит совсем не круто. Потому да — красивый корпус, много больших цифр и специальная мышка и клава с логотипом любимой игры — это предел мечтаний среднего читателя обзоров в журналах.

Киберспорстмены и взрослые дядьки с большими зарплатами читают другие журналы и издания. И под них пишут статьи по другому.

Под тех кто хочет максимально сэкономить обычно почти ни кто не пишет, это самый не денежный сегмент для рекламодателей.

vladvalmont

14.02.2017 18:04Я понимаю, о чём Вы. И Вы абсолютно правы, особенно в последней фразе. Это и удручает.

Вопрос про игры у меня был и к автору той статьи. Он привёл мне в пример скриншот со следующими играми:

Deus Ex: Mankind Divided

DOOM

Fallout 4

Far Cry 4

Far Cry Primal

Grand Theft Auto V

Hitman

Rise of the Tomb Raider

Sid Meier's Civilization VI

The Witcher 3

Total War WARHAMMER

Автор, судя по всему, считает, что все эти ААА игры — и есть современные. И что каждый школьник имеет их все — одновременно. Сборки, соответственно, предлагаются под них. И SSD на терабайт — тоже.

Вы абсолютно верно подметили, что есть и другие современные игры: танки, дота 2, контра, тим фортресс, старкрафт, майнкрафт, овервотч. Все эти игры, при желании, можно впихнуть на SSD, ёмкостью, например — 256 Гб, который, к слову, стоит в четыре раза дешевле.

Я прекрасно понимаю, что игры на SSD грузятся быстрее. И что SSD на терабайт — это ох, как круто. Но когда речь идёт о покупке SSD на терабайт за 20 тыс. руб., я бы задумался — а стоит ли оно того? Не проще ли взять обыкновенный SSD, ёмкостью 256 — 512 Гб и ставить на него только те игры, которые действительно сильно зависят от скорости загрузки, а остальные — запускать с обыкновенного HDD?

Я сам фанат Skyrim. Установлена туча модов под Skyrim, половина из них — графические. Перекинул Skyrim на SSD — игра грузится быстрее. Все остальные 139 игр из библиотеки Steam остались на HDD. Я обошёлся SSD всего лишь на 128 Гб.

Автор же предлагает полный фарш, не объясняя — зачем. И при этом в комментах пишет, что он за «рациональную экономию» :) Никому не нужные 32 гига оперативы и вышеупомянутый SSD + мамка и корпус с подсветкой + БП на 100Вт больше, чем в предыдущей сборке — очень рациональная экономия…

Статьи читают не только школьники, но и взрослые, которые не сильно разбираются в компах. Что им теперь — покупать всё то барахло, которое порекомендовал автор? Повторюсь — раньше можно было во всём разобраться, а теперь — нет. Кругом одна реклама.UJIb9I4AnJIbIrUH

14.02.2017 19:20ну справедливости ради я встречал, в том числе и на наших ресурсах, статьи о том какой процессор какую видеокарту способен раскрыть, типа такого.

http://www.ixbt.com/cpu/amd-intel-260-280.shtml

https://3dnews.ru/914336

https://3dnews.ru/929285

Но они в меньшинстве, это да

vladvalmont

14.02.2017 20:08+1Ну вот, например, у меня сейчас встал вопрос — какую мать выбрать под i7 7700K — с M.2, с хорошим потенциалом для разгона, стабильную, надёжную, без подсветки, без лишних наворотов в виде Wi-Fi/Bluetooth и доп. карточек.

Выходит статья про ASUS ROG STRIX Z270G Gaming. Что мы видим:

— Текстолит почти чёрного цвета дополнительно раскрашен светло-серыми линиями с лицевой стороны, с которыми удачно гармонируют радиаторы на силовых цепях и чипсете.

О-о-о-о, у-у-у-у-м. Ок. Читаем дальше:

— На одном из радиаторов силовых цепей питания процессора нанесено название серии STRIX, а радиатор чипсета украшен логотипом ROG.

В-а-а-а-у. Ладно, читаем дальше:

— В целом плата выглядит аккуратно и современно. На ней нет ярких выделяющихся деталей, но при этом скучным или банальным её дизайн назвать нельзя.

А-а-а, понятно… плату для красоты покупают. Ясно.

— … сразу же понятно, что ASUS ROG STRIX Z270G Gaming – не просто компактная материнская плата с беспроводными сетевыми интерфейсами, а полноценный комбайн для игровой или рабочей системы практически любого класса.

Что?

Wi-Fi, Bluetooth, USB3.1 Gen2 Type-C и Type-A… — как это всё мне поможет в играх? Зачем вообще Wi-Fi, если есть гигабитный порт? Кто в здравом уме будет играть в сетевые игры по Wi-Fi — для кого всё это?

Мне нужна мать, которая просто будет стоять в корпусе и гнать мой камень по максимуму — зачем мне все эти свистелки/перделки?

После всего вышеописанного:

— ASUS ROG STRIX Z270G Gaming на сегодняшний день является одной из наиболее привлекательных моделей на чипсете Intel Z270 Express, и мы со спокойной совестью можем рекомендовать её к приобретению в качестве основы для надёжной оверклокерской платформы.

Ага, спасибо. Потратить около 20 штук на эту красоту, когда есть железо точно с такой же начинкой, но без лишних наворотов — за гораздо меньшую цену.

У меня всё.u010602

15.02.2017 01:24Ну так это-ж mATX, а кто берет mATX? Те кто собирает малогабаритную систему ака баребон. А такие системы часто собирают для всяких пати, когда каждый приходит со своим компом с прозрачной боковиной и блещет красотой подкапотного пространства. На таких пати не всем может хватить гигабитных шнурков, вот и выходит что добавляют вайфай и блютус для мышки или колонок. Т.е. такая плата имеет право существовать. Тем не менее у асуса целая линейка схожих плат. Вот например ROG STRIX Z270F GAMING уже без вайфая и блютуса.

Есть еще TUF Z270 MARK 2 в формате АТХ, там вроде тоже нет ни чего лишнего и аж два м.2 и два нормальных ПСИ-Е под два видика. И еще целая линейка праймов которые отличаются мелочами.

Но скорее всего цена на них на всех примерно одинаковая около «20 штук», т.к. это асус, бренд известный и один из топовых, они и качество обещают хорошее, и рекламы у них он сколько на сайте сплошные 5х, 10х, 1.5х За все за это нужно платить. Насчет более дешевых брендов — тут как повезет, бывают платы от асрок работают по 10 лет, а бывает и от асуса за год дохнут. Тут скорее вот какой момент, если вы подросток геймер из США скажем, то у ваших родителей скорее всего вы один, а доход на семью около 200 тыщ уе в год, и даже 100-200 баксов экономии на материнке из топ сегмента не стоят ни чего, особенно возможных нервов из-за поломки или из-за высмеянного чада на вечеринке геймеров. Отсюда и дизайн, и шильдики и вообще бренд ROG.

Как то так, главное не принимайте это на свой счет, есть разные таргет группы и все они состоят из людей с разной мотивацией и жизненными условиями.

vladvalmont

15.02.2017 02:00Вот подобные объяснения я и хотел бы видеть в статье: про то, для кого эта плата — с примерами, как у Вас.

Согласитесь — то, что Вы описали — мало подходит для среднестатистического пользователя, к коим я себя могу отнести (хоть я и малость — продвинутый :) ). Wi-Fi и Bluetooth в 90% случаев — не нужен. Нужна хорошая плата, которую Вы и привели в пример — TUF Z270 MARK 2.

ASUS TUF Z270 MARK 2, кстати, я привёл в пример автору той статьи, что про сборки ПК, как альтернативу той, что он выбрал для экстремальной сборки. Стоит она ~10 тыс. руб. против 14 тыс. за ASUS STRIX Z270F GAMING. Она без подсветки — мне она не нужна. Экономия ~4 тыс., результат — тот же. Если бы я брал сейчас ПК, то взял бы именно TUF Z270 MARK 2.

У меня у самого сейчас плата от ASUS, правда старая и не топовая — P8Z68-V PRO/GEN3. В ней, кстати, есть Bluetooth — ни разу им не пользовался. Гнал на ней i7 2600K до 4.8ГГц, но оставил 4.4ГГц для режима 24/7. В таком режиме ПК работает уже 6 лет.

Даже не топовые платы могут хорошо гнать проц — это важно. Где статьи, в которых написано об этом? Я не видел. Есть статьи, где написано… про надписи на радиаторах… совсем не то.

В своё время отдал за ПК чуть более 100 000 руб., пока был ещё старый курс. Сейчас бы это вышло, наверно, как раз в 150 тыс. руб., если не больше…

У меня и видеокарта — ASUS — GTX780TI-DC2OC-3GD5. Отличная, тихая карта. Не жалко было отдавать за неё 26 000 руб.

Я к тому, что я готов отдать немалую сумму денег за ту или иную железку, при условии, что я увижу в ней толк. Я пытаюсь найти инфу о той или иной железке, но не могу её найти.

И я не понимаю — для кого пишутся статьи про светящиеся мамки с вайфаем и где статьи про мамки по-проще, но с неплохим потенциалом для разгона.

Да и убивает больше всего то, что в конце статьи эту мамку смело рекомендуют «в качестве основы для надёжной оверклокерской платформы.». Что? Вы серьёзно? 20 тыс… Ничего себе основа…u010602

15.02.2017 03:37Я тоже помню времена когда на хоботе(IXBT) и оверклокерах и ITC.UA публиковались настоящие обзоры, причем часто фундаментальные. Но только тогда интернет читало 1.5 землекопа, от того что эти 1.5 человека совершали «best deal» особого вреда не было, а многие авторы писали на чистом энтузиазме или же на продажах рекламы. С тех пор ресурсы выросли, укрупнились, завоевали себе аудиторию, их стали читать все подряд. В итоге спрос стал «не оптимальным», все хотели хорошо и дешево. В итоге эти издания просто купили, а сместить их с рынка очень не просто, да и зачем? Раньше гик сидел по диалапу и работали инженером за копейки, свободное время имел и тратил как хотел. Сейчас гик легко может пойти в айти и получать тысячи условных, при этом его время будут покупать в любых объемах. С другой стороны полно «маминых обзорщиков» которые готовы душу продать за халявный образец.

Вот и получается что хитрых не может быть сильно много, а умные сами во всем разберутся, но писать ни чего не станут. Годные обзоры нужно искать по дальше от первых страниц гугла, в более менее изолированных общинах.

Я так это вижу.

slafniy

15.02.2017 12:47По всяким там персональным страницам и малопопулярным каналам ютуба можно найти что-то, что выглядит честно.

А так — действительно, раздражают современные «обзоры», половина обзора разглядывание упаковки, вторая половина — сомнительные графики и такие же сомнительные выводы. И так почти везде.

Насчет неподкупности и нейтральности авторов есть даже свои мемы локальные, как «Excel-обзоры», когда автор выкладывает 100500 графиков, в которых он «протестировал» 10 процессоров и 10 видеокарт в 10 играх на трех наборах настроек. А потом еще всё разогнал и еще раз повторил!

Человеку, умеющему перемножать, сразу понятна ценность такого «обзора».

Остается вылавливать статьи авторов, которые себя еще пока не дискредитировали, но тут без знания предметной области все равно никак.

Среди обзоров мобилок то же самое, только хуже, людям впаривают чушь что на 5" нужно не менее чем 1080р экран, и что алюминий и стекло — круто и премиум, а софт-тач пластик это «бюджетно и бедно», и попугаи, много попугаев, бессмысленных и беспощадных.

Иногда хочется самому купить железки да протестировать, но понимаю, что продать без потерь я потом их не смогу.

u010602

14.02.2017 20:18Ну да, им всем покупать то барахло что нужно продавать, для того маркетинг и работает :) Я вот себе видеокарту выбирал, тоже долго и упорно читал обзоры, и заметил подвох, оказалось что большая часть видеокарт это ребрендинг старого железа, с новыми тепловыделением и частотами. Тот же rx460 ни чем не новый, разве что тех процессом. В итоге я взял себе 7970 с выходом на 6 мониторов. Да потребляет больше, но мне не принципиально и запас по БП есть. Зато по цене вышло как новый rx460, а по производительности лучше чем 470, ну и выход на 6 мониторов тоже радует. Все что мне нужно тянет на ультрах без разгона.

Что-то я отвлекся. Так вот я к тому что особо прогресса в нижнем и среднем сегментах нет, есть кое какой прогресс в верхнем сегменте, там где 1070 и 1080, но цены для энтузиастов шутеров с реалистичной графикой. Я себе не могу позволить откусить такой кусок бюджета на игры, а ребенку так тем более не стану покупать, ибо вообще не одобряю современные ААА шутеры, особенно чисто сетвые.

Т.е. получается что в массовом сегменте железа — стагнация, отличий почти нет, и цены почти одинаковые, а продавать нужно, вот и пишут статьи и обзоры. А что делать? Если перестать платить то прогресса и не будет, сейчас нужно вкладывать в будущее в надежде на прорыв, а значит нужно продолжать платить и делать «апгрейд без улучшений».

Насчет размера ССД, я вот купил малому в подарок 120 гигов диск, но по факту он 100 из-за математического трюка. Перелил туда систему и поставил старкрафт (30 гигов), осталось свободных 15 гигов, это рекомендуемые минимум который советуют оставлять свободным для обслуживания. Но уверен защита системы сожрет это место очень быстро. Т.е. минимум нужно 250 гигов, и туда влезет 2-3 игры. Такое положение далеко от громкого слова «ультра». Все таки ультра это — выше только облака. В мое понятие ультра не попадают компы с 32 гб озу например, для статуса ультра нужно 64 и ссд в PCI-E из топовых, и рейд 10 на 2ТБ, и процессор серии экстрим. И обязательно отдельная гигабитная серверная сетевуха тоже в PCI-E и рейд отдельный взрослый и с батарейкой :) Вот это будет ультра, всем на зависть так сказать. :)

Ну и вообще самый топ любого рейтинга это всегда долой разумные аргументы и экономию, это претензия на зе бест оф зе бест. Если идти от такого ультра вниз — то я бы прежде всего сэкономил на видеокарте, ибо она только для игр, а все остальное и в работе может пригодится. Потому вариант 32 гига озу и ссд на терабайт не выглядит таким уж глупым для меня, мне для работы как раз такой конфиг и нужен :)

vladvalmont

14.02.2017 20:54Я предлагал автору той статьи сборку с бюджетом в 300к+ — собрать конфиг из 4х Titan X и 4х SSD на 1Тб, объединённых в raid — чё, круто же :) Ещё водяное охлаждение с подсветкой туда воткнуть — вообще шик.

Вот это действительно экстремальная сборка — в топку разумные аргументы и экономию! :)

А та, что за 150 тыс. — бред, а не сборка. Она практически ничем не отличается от продвинутой сборки. Кто захочет SSD на терабайт — тот всегда его купит. Но рекомендовать такое я бы не стал.

slafniy

14.02.2017 22:51Да, именно что каждый школьник имеет все или почти все эти игры, т.к. это хиты.

Смысл «максимальных» сборок — в том числе и понты, но SSD к голым понтам уж точно не относится, в том же DOOM и The Witcher 3 здорово ускоряет загрузку. Особенно полезно на высокой сложности, когда часто умираешь =)

От этого же автора на этом же сайте было много годных обзоров, а «компьютер месяца» — обновляющаяся статья для тех, кому лень разбираться.

Если вам лень подробно разобраться, но есть деньги — вы не пожалеете, купив прдложенное. Если хотите максимально сэкономить, то придется разобраться. Учитывая, что у каждого свои потребности, может и сборка различаться, и тут просто нет и не может быть универсального ответа.

vladvalmont

15.02.2017 00:31В игры играют не только школьники :) мне за 30 — играю в разные игры, не только в хиты. Я не понимаю — зачем мне SSD на терабайт. Я понимаю, что это моя проблема. Но ведь статью пишут для всех или исключительно для школьников?

Мне не лень разбираться — разбираться негде. Читать сухие спеки без тестов — мне это ничего не даёт. Хочется видеть нормальные статьи, где главная цель — разобраться, а получаешь рекламу под видом статьи.

Ниже я привёл пример того, что можно сэкономить ~20 — 27 тыс. руб. — просто выбрав другие комплектующие. В статье об этом — ни слова.

Не имея опыта — человек возьмёт себе комп, а потом поймёт, что, к примеру — 32 гига оперативы и топовая мамка — ему ничего не дают, кроме чувства, что он заплатил за них больше, чем мог бы.

В общем — это долгий разговор. Вы правы — универсального ответа быть не может.

sjxard

14.02.2017 22:52Доброго времечка. Наткнулся тут на интересную публикацию, а тут в комментариях все знакомые люди :). Жаль, что в 3DN комменты закрываются по истечении определенного времени.

Текст статьи напичкан ссылками на обзоры предлагаемых железок, но нигде нет графиков — как эти сборки поведут себя в реальных условиях. Т.е. из тучи обзоров на каждую железку в отдельности, должно сложиться общее впечатление — на что способна та или иная сборка.

Все будет, не переживайте вы так ;). Или вы думали, что первый выпуск должен включать в себя все и сразу?

Последняя, экстремальная сборка, за 150 тыс. руб. — вообще удивила: раздутая продвинутая сборка, разбавленная SSD на терабайт за 20 тыс. руб., дополнительными 16 гигабайтами оперативы, различными свистелками/перделками в виде цветастых корпусов.

Только вы почему-то умалчиваете, что вы эту сборку раздули потом в комментарии до +170 рублей. SSD на терабайт у вас почему-то понты, а две GTX 1080 — нет :).

в чём разница между ASUS PRIME Z270-A в продвинутой сборке и ASUS STRIX Z270F GAMING — в экстремальной; почему в продвинутой БП на 600Вт, а в экстремальной — 750Вт при практически одинаковых комплектующих

Про платы, да, надо было уточнить. Косяк Но все на поверхности, стоит лишь сравнить характеристики, да и те же обзоры. Про блок питания написано, читайте внимательнее.

vladvalmont

15.02.2017 00:21+1Доброго :)

Только вы почему-то умалчиваете, что вы эту сборку раздули потом в комментарии до +170 рублей. SSD на терабайт у вас почему-то понты, а две GTX 1080 — нет :).

В тех же комментариях я предлагал автору сборку 300к+ :) Так что я ничего не умалчиваю.

Автор статьи просил меня составить свой вариант, вот я его и составил:

— сначала предложил то, что взял бы себе лично — вышло на 132 тыс. руб.;

— затем расписал то, на чём из этого можно было бы сэкономить и предложил альтернативу некоторым комплектующим — вышло на 123 тыс. руб… Это, простите, минус 27 тыс. руб. от конфига в 150 тыс. — неплохо?;

— в конце добавил вторую GTX 1080 — вышло 172 тыс. руб. — это для лютых экстремалов :)

Это выбор, который автор не предоставляет в своей статье.

Автор статьи ответил просто: — «Я так и не увидел сборки за 150 000 рублей. Увидел/прочитал за 132к, 123к и за 172к.», «В материале рассмотрена стоимость системного блока за определенную сумму. Так что не аргумент.».

Что значит «не аргумент»? Погодите, я не понимаю. Задача автора — уложиться ровно в 150 тыс. руб. — ни больше ни меньше??? Т.е. сборки за 120 и за 130 тыс. руб. — никому не интересны и никому не нужны? Для этого автор пихает в свою продвинутую сборку в два раза больше оперативы и дорогущий SSD — только чтобы получить бюджет в 150 тыс. руб.? Что за бред.

Это и есть понты — никому не нужный объём оперативы, мать с подсветкой, SSD на терабайт — это когда вместо него можно взять, к примеру — HDD на 8Тб… или WD Black, объёмом меньше, но скоростью и гарантией повыше.

Существует уйма вариантов, о которых автор в своей статье не пишет. А самое неприятное, что автор не пишет — в чём существенная разница во всех этих комплектующих. Вдвойне неприятно — автор совершенно не воспринимает чужое мнение и настаивает лишь на своём, считая других за идиотов.

Про блок питания написано, читайте внимательнее.

Написано, да. Цитата из статьи: «Выбор в пользу Kaby Lake открывает возможность покупки емкого твердотельного накопителя. А мощности блока питания достаточно для установки второй GeForce GTX 1080.».

Про первое я промолчу, хоть и не понимаю до сих пор… при чём здесь зависимость SSD на терабайт от центрального процессора???

А вот про второе — я сразу добавил вторую GTX 1080 и получил бюджет в 170 тыс. руб. Почему Вы считаете, что это я предложил понты, если автор об этом сам пишет в своей статье?

Ну добавил я карту в свой экстремальный конфиг. Прибавьте вторую GTX 1080 к бюджету в 150 тыс. руб. из статьи — получим бюджет в 195 тыс. руб. Лично у Вас эта цифра не вызывает дискомфорта? :)

Я сэкономил 20 тыс. руб., просто предложив другой конфиг, с двумя GTX 1080 — вот это круто. Нужна ли вторая карта — задача автора это объяснить, а не моя — я лишь выбираю себе комп.

А где все слова — про 80 PLUS Gold, Platinum и т.д.? Почему в продвинутом конфиге предлагается блок, с которым нельзя будет поставить вторую видеокарту? Где тут расчёт на будущее? В чём экономия?

Кстати, об экономии. В статье об экономии — ни слова. И никаких рациональных подходов там нет.

Вспомним про SSD для первых двух сборок. Нет ничего страшного, если бюджет подвинется на 1 000 — 2 000 руб. Главное, чтобы читатель понял, что SSD сразу даст ему ощутимую пользу, которую никогда не дадут ему кулеры на бюджетных сборках. В статье предлагается сразу взять кулеры, т.к. боксовые чем-то (не пойми — чем) не устраивают автора, а SSD — взять потом, когда деньги будут. А систему перекатать с одного диска на другой — для автора статьи это не проблема. А раз для автора не проблема — остальные, по идее, тоже должны легко справиться. Некоторые даже дрова нормально устанавливать не научились, а тут им предлагают клонировать диск… без комментариев.

Есть ещё куча вопросов к автору той статьи, но я уже закидал здешние комментарии километрами букв так, что автор этой статьи, наверно, меня уже тихо ненавидит :)

Все будет, не переживайте вы так ;). Или вы думали, что первый выпуск должен включать в себя все и сразу?

Я очень надеюсь, что в будущем увижу подробные статьи, где будут расписаны все плюсы и минусы тех или иных железок, которые помогут выбрать правильную — как по деньгам, так и по потребностям. Мне нравится читать статьи на 3DN, но очень хочется получать ту информацию, которую нужно — с адекватными комментариями. А не потому, что просто нужно вписаться в 150 тыс. руб. — зачем? :)u010602

15.02.2017 04:40Мы уже с вами многое обсудили. Добавлю лишь что формат «выбираем на 150 тыщ» имеет право на существование, очень часто не технари так и выбирают — есть определенная сумма и ее нужно освоить, ибо если не освоить — то все равно жена или босс заберут. Ну или если на подарок — то тоже все идет от суммы а не от конкретных задач. И так во многих сферах, типа посоветуй «хороший телефон за 150 баксов», а что нужно? — да просто чтоб хороший был и камера норм. Ну или «посоветуй бу комп за 300 баксов чтоб без игр но вк не тормозил», можно собрать и дешевле — но прослужит он меньше чем за 300, в итоге человек будет менее доволен советом, чем если бы вы освоили всего его 300 баксов.

Насчет процессора и ССД, скорее всего автор слышал звон, но не знает где он. Там все дело в версии PCIE и количестве линий. Например в мамке что у вас (и у меня) во второй слот х16 можно вставить интел 750, и он будет работать на полную скорость. А такая-же материнка но без ГЕН3 — уже будет резать ссд по скорости вдвое. Аналогично будет с процами 2ххх, с 3ххх — все ок. А размер тут совершенно не причем.

У современных плат схожая проблема с м.2 слотами, если туда подходят линии от проца — то там шикарно, если от чипсета — то все плохо. Но от проца тут уже ни чего не зависит. Хотя возможно вы это и сами знаете, но хотели услышать от автора :)

По поводу выбора БП — имхо лучше брать модульный и с запасов в 2 раза, ибо чем дальше от номинала тем ниже нагрузка, меньше обороты и нагрев. При половинной загрузке они служат походу вечно, даже электролиты не сохнут. А вот КПД падает, но кому оно вообще важно? :)

sjxard

15.02.2017 15:30Есть ещё куча вопросов к автору той статьи, но я уже закидал здешние комментарии километрами букв так, что автор этой статьи, наверно, меня уже тихо ненавидит :)

Неа, я в интернет-дискуссиях уже давно постиг дзен. Вообще ноль эмоций ;).

Вообще на Гиктаймсе никогда (до вчерашнего дня) не комментрировал. И вряд ли буду. Так что до встречи в мартовском выпуске! :).

molnij

15.02.2017 12:27Не нашел упоминания, но чем вас не устроил http://www.ixbt.com/3dv/3ditogi/?

Сборные тесты с детальной методикой тестирования (периодически изменяется) и сотнями карт на протяжении многих лет…

Провалы-различия в тестах к сожалению неизбежны по многим факторам. Драйверы, версии игр, настройки игр и драйверов — всё это сильно влияет на результаты, поэтому сранивать результаты с разных сайтов — на мой вкус совершенно бесполезное занятие (если вы не готовы убить море времени на выяснение всех деталей, различающихся от игры к игре)

И, как уже кто-то упоминал — муки выбора в лоу-сегменте это действительно мягко говоря странно. Ладно в топе — когда надо использовать каждый рубль из большой суммы, бонусом — там потери со временем максимальны, но что терять в лоу?

slafniy

15.02.2017 13:16Хобот один из немногих ресурсов, где еще сохраняется методика, и они стараются не менять набор тестов как можно дольше, дабы можно было сопоставлять прошлые результаты. При изменении тестов накопленные данные «сбрасываются» и т.д.

муки выбора в лоу-сегменте это действительно мягко говоря странно. Ладно в топе — когда надо использовать каждый рубль из большой суммы, бонусом — там потери со временем максимальны, но что терять в лоу?

С точностью до наоборот — когда ты, например, студент и твои деньги ограничены, никакие «ну, докину 2к сверху» не работают, у тебя их просто нет и в разумный срок не появятся. В такой ситуации выдавливаешь всю производительность, какую можешь.

А когда выбираешь топ — ну какая разница, 105 тысяч потратить на процессор или 110? Что то, что другое — невероятно дорого и по цене/производительность невероятно невыгодно.

molnij

15.02.2017 17:28Да, возможно я неправ, но когда вся производительность — это 7 или 10 фпс — не очень понятно, зачем их выдавливать.

Впрочем, я тут подумал… Я был в обоих ситуациях и в обоих долго и тщательно выбирал карту, так что возможно, это скорее личностный фактор — пытаться добиться максимума, или просто взять с полки в ближайшем магазине :)

Jackhetfield

17.02.2017 15:17Внесу вопрос в ряды, сейчас на борту i3 — 3220, 16г ддр3, ссд + все это под GTX650

Баттлфилд 1 показал оч качественные лаги на роликах, ну и в сюжетке. ФПС до 5 и ниже.

Планирую заменить на 1050, потестил ее — не скажу, что прямо все стало ультра.

в чем же подвох? неужели проца не хватает?u010602

17.02.2017 15:58Прежде всего 1050 это не ультра плата, это лоу энд последнего поколения. Кроме того 2гб видеопамяти не достаточно для игры на ультра или высоких. Судя по обзорам в сети этой игре нужно 3.5гб видеопамяти. Это 1050 Ти, она может выдавать 50 кадров если не упираться в процессор.

Касательно процессора — нашел сравнение на примере i5-2400 vs i5-4440 vs i5-6400, Загрузка процессора на i5-2400 100% и частота кадров проседала у автора до 30 в сложных сценах. На двух других загрузка процессора в пределах 70-85%. Ваш процессор значительно слабее даже 2400. Вам бы проц проапргейдить до Core i5-3570 или и7 3770.Jackhetfield

17.02.2017 16:04спасибо! задумывался об этом уже. Тогда есть смысл в 4г версии?

u010602

17.02.2017 16:23Зависит от ваших желаний, сейчас минимум это 3гб, 4гб это впритык, которой очень быстро станет не хватать, т.е. при возможности уже можно смотреть в сторону 8гб версий, хотя больше 5гб навряд-ли будет задействовано. У вашей платформы имхо хороший потенциал для апгрейда, и7 3770 + разгон + 32гб озу + ссд будут актуальные еще несколько лет, а видик с 2гб уже не актуален, с 4гб будет не актуален через год два.

Что-бы снизить нагрузку на видеопамять нужно снижать детализацию текстур, условно 8г — ультра, 4г — высокие, 2г — средние, 1г — низкие. Хотя конечно есть игры у которых нет больших текстур.

Fllash

17.02.2017 16:25Недавно как раз поставил на борт аналогичную 1050Ti (MSI).

Что могу сказать — она неплохо справляется с Ведьмаком 3, DOOM, GTA V. Хотя в ГТА настройки уже не все на ультрах, и периодически фпс выдавался 35-37. Редко, но все же. Чаще — 45-50.

А ёё потолок, кажется — Rise of the Tomb Raider (на высоких настройках уже есть, к чему прицепиться), Resident Evil 7 (тоже для комфортной игры приходилось снижать графику).

Всё это смотрелось при 8гб оперативки, без ssd, проц — AMD, дай бог памяти, fx-чо-то-там (4х3400 Mhz, если не путаю)

Возможно, на нормальной сборке от интела показатели были бы приятнее — но по ощущениям через годик-другой ее уже не будет хватать.

Jackhetfield

20.02.2017 10:53Почитал обзоры, не сказал бы что 3220 существенно отстает от 2400 и даже 2500 :)

но совет про Е3-1220 (описанный ниже) приму к сведению с з\п.u010602

20.02.2017 15:27Вдвое меньше кеша, ядер вдвое меньше, нет турбо буста. Для меня лично это «существенно». Я довольно много процов перепробовал за последние два года, количество ядер очень важный параметр, если их меньше 3 то работать не реально, если 3 то так-сяк. 2 виртуальных ядра условно дают аналог одного реального, потому почти все i3 я воспринимаю как базовый проц, от которого ни чего ждать не стоит, даже если там частота будет 5ггц на ядро, он все равно будет подлагивать из-за слабой поддержки многозадачности. Почему это так происходит я не знаю — но равные по бенчмаркам процессоры — совершенно по разному ощущаются в работе, я всегда предпочту «4 ядра помедленнее».

Jackhetfield

22.02.2017 10:41спасибо за инфу! я потерял нить тренда где-то со второго поколения Коров и перестал следить за фактом, т.к. прекратился доступ к неограниченному железу :)

зато до этого все Коры Дуо, квады и прочие интелы протестированы были вдоль и поперек.

а что скажете по критичности разницы например 2500 и 2600?u010602

22.02.2017 16:55Основное отличие в +4 дополнительных потоках у 2600, 4 вирт ядра в моих задачах примерно равны 2ум реальным, т.е. условно 2600 это «шести ядерный», а 2500 четырех. В играх это не сильно важно, в работе смотрите сами, если есть виртуалки или много разного софта одновременно — то чем больше ядер тем отзывчивие система. Я себе бы взял однозначно 2600.

darthmaul

19.02.2017 04:00Я бы докупил б\у E3-1220 на ebay (за 70 долларов можно взять) — производительность на уровне Intel Core i5-4690 за скромную цену и gtx 1060. Если бюджет не расширять, то 970 (бу).

Solegor

17.02.2017 17:39Если очень сильно стесняет бюджет — есть смысл обратиться к вторичному рынку. По соотношению цена/производительность б.у. Radeon R9 280x 3gb (он же 7970 Ghz Edition) наголову разобьёт этот обрезок в пух и прах. Но freesync нету, так что в данном случае мой совет мимо.

u010602

19.02.2017 01:26Да, вы совершенно правы, но есть и минус кроме freesync, энергопотребление 300вт без разгона и часто трехслотовое исполнение. У 460 75вт всего и два слота всегда. Для многих 7970 обернется апгрейдом БП до 600вт, что тоже не дешево.

Solegor

20.02.2017 09:31Насколько мне известно, редкий экземпляр выходил за 250 Вт даже в разгоне.

У меня R9 290X c i5 3470, 4 плашки памяти, дискретное аудио в pci-e, ssd, нжмд и несколько постоянно подключенных usb-устройств — на всё хватает 550W. Это, конечно, не самый дешёвый БП, сертифицирован по 80+ Gold, но тем не менее.

Больше может напрягать шум, чем потребление — в РФ не особо дорогое электричество :)u010602

20.02.2017 13:51Ну так вы только подтвердили мои слова :) 50 вт разницы в рамках погрешности. Суть в том что цену БП нужно добавлять к цене бу R9 290X, ибо нет у обывателя такого БП изначально, скорее всего там 350-400вт среднего качества.

П.С. Я потребление не измерял, отталкиваюсь от того, что пишут в интернете.

П.П.С У меня ASUS HD7970-DC2T-3GD5 проблем с шумом нет.

Eldhenn

Нулевую точку на графиках вы по каким принципам выбирали?

Varfalomey

Поправил графики