В Конспекте мы часто обходим стороной enterprise-технологии из-за их малой применимости в не столь масштабных проектах. Но сегодняшняя статья – исключение, потому что речь пойдет о модульных системах, "блейдах".

Не так много архитектурных изысков в IT-мире, которые были бы окутаны большим ореолом "невероятной крутости" и сравнимым набором мифов. Поэтому не буду усложнять еще больше, и просто расскажу об особенностях и применимости такого рода систем на практике.

LEGO для инженера

Блейд-сервер почти обычный сервер, в котором есть привычная материнская плата, оперативная память, процессоры и множество вспомогательных систем и адаптеров. Но "почти" заключается в том, что такой сервер не предназначен для автономной работы и поставляется в специальном компактном корпусе для установки в специальное шасси.

Шасси – или "корзина" – ни что иное, как большой короб с посадочными местами для серверов и дополнительных модулей. Все серверы и компоненты соединены при помощи большой коммутационной платы (Backplane) и образуют блейд-систему.

Если разобрать всю систему на составляющие, то на столе окажется следующая горка:

Блейд-серверы (лезвия) – серверы без блоков питания, вентиляторов, сетевых разъемов и модулей управления;

Шасси – корпус и бэкплейн;

Системы питания и охлаждения для всех компонентов системы;

Коммутационные устройства для связи с внешним миром;

- Модули управления (различные вариации на тему IPMI).

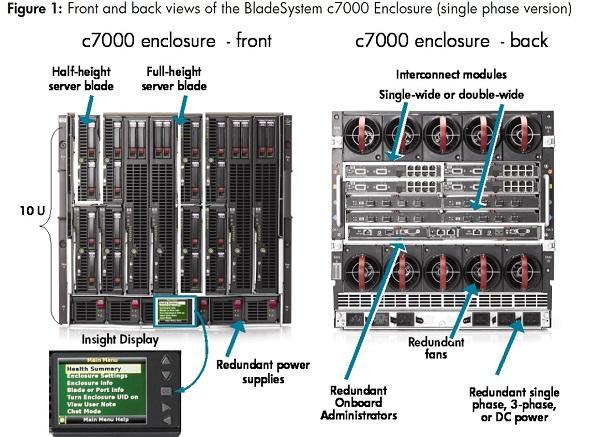

От обычного серверного шкафа все это добро отличается компактными размерами (обычно 6-10U) и высоким уровнем надежности, так как все компоненты могут быть зарезервированы. Здесь, кстати, кроется один из мифов: десяток лезвий не собирается в один большой сервер. Это будет просто десяток серверов с общей инфраструктурой.

К слову, у HPE есть решения, напоминающие традиционные blade-серверы – HPE Superdome. В качестве лезвий там используются процессорные модули с оперативной памятью. В таких решениях вся система действительно представляет собой один высокопроизводительный сервер.

Нюансы архитектурных решений разных производителей блейд-систем уже обсуждались на Хабре (статья хоть и старая, но в своих основах актуальная), поэтому я для иллюстрации использую блейд-систему от HPE – BladeSystem c7000.

В роли лезвий могут выступать:

Обычные серверы, вроде HPE ProLiant BL460c Gen9 (аналог стоечного HPE ProLiant DL360 Gen9);

Дисковые массивы – например, HPЕ StorageWorks D2200sb, в который можно установить до 12 дисков 2,5’’. Так легко и непринужденно нескольким серверам можно выдать общее DAS-хранилище;

Коммутаторы SAN для доступа к внешним системам хранения и полноценные NAS-серверы – например, HPE StorageWorks X1800sb;

- Ленточные устройства.

На картинке ниже изображена полностью укомплектованная система HPE BladeSystem c7000. Расположение компонентов понятно и так – обратите только внимание на секцию Interconnect modules. В каждый ряд устанавливается отказоустойчивая пара сетевых устройств или pass-thru модулей для простого проброса серверных сетевых интерфейсов наружу.

В компактное лезвие HPE ProLiant BL460c Gen8 помещается только два диска 2,5’’. Для большей красоты вместо дисков можно использовать сетевую загрузку с дисковой системы SAN или PXE.

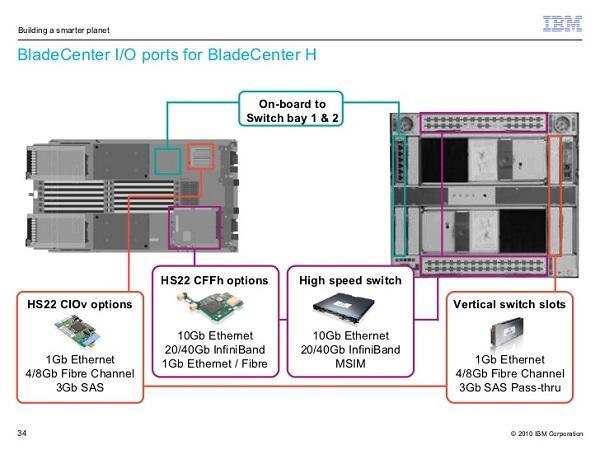

Ниже изображена более компактная блейд-система от IBM. Общие принципы те же, хоты расположение узлов тут отличается:

Интереснее всего в блейдах, на мой взгляд, сетевая составляющая. С использованием модных конвергентных коммутаторов можно творить настоящие чудеса с внутренней сетью блейд-системы.

Немного сетевой и Enterprise магии

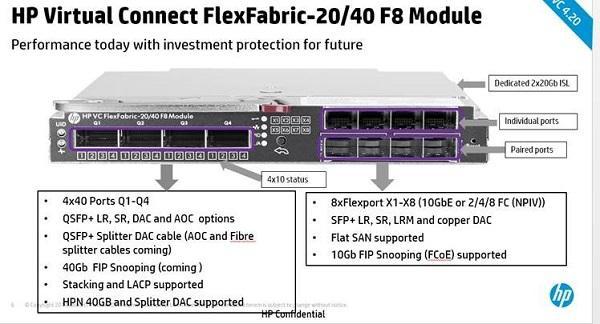

В качестве сетевых модулей могут выступать специальные коммутаторы Ethernet или SAS, либо умеющие и то и другое. Разумеется, в блейд-систему нельзя установить обыкновенный коммутатор, но совместимые модели производятся привычными брендами. Например "великолепной тройкой" HPE, Cisco, Brocade. В самом простом случае это будут просто модули доступа к сети, выводящие все 16 лезвий наружу через 16 портов Ethernet – HPE Pass-Thru.

Такой модуль не уменьшит количество сетевых проводов, но позволит подключиться к корпоративной LAN с минимальными вложениями. Если же вместо него использовать недорогой Cisco Catalyst 3020 с 8 портами 1GbE Ethernet и 4 портами 1GbE SFP, то к общей сети нужно будет подключить лишь несколько общих портов шасси.

Такие сетевые устройства своими возможностями не отличаются от обычных. Значительно интереснее выглядят модули HPE Virtual Connect (VC). Главная их особенность – возможность создавать несколько отдельных сетей с гибким распределением полосы пропускания LAN и SAN. Например, можно подвести к шасси 10GbE и "нарезать" из него 6 гигабитных LAN и один 4Gb SAN.

При этом VC поддерживает до четырех подключений к каждому серверу, что открывает определенные просторы для творчества и сборки кластеров. Подобные решения есть и у других производителей – нечто подобное от Lenovo называется IBM BladeCenter Virtual Fabric.

Вопреки расхожему мнению, сами по себе блейды не отличаются от обычных серверов, и никаких особых превосходств в плане виртуализации не предоставляют. Интересные возможности появляются только с использованием специальных, vendor-locked технологий, вроде VC от HPE или LPAR от Hitachi.

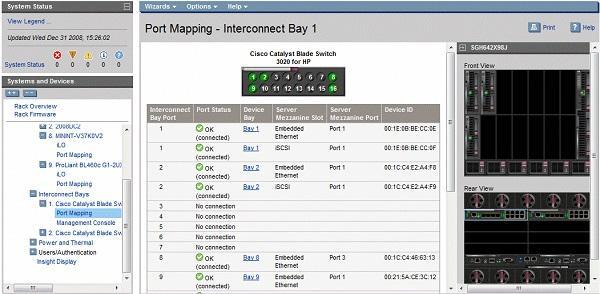

Несколько IPMI из одной консоли

Для настройки блейд-серверов можно использовать встроенные модули аппаратного управления BMC (iLO в случае HPE). Механизм администрирования и удаленного подключения мало отличается от обычного сервера, но сами управляющие модули Onboard Administrator (OA) могут резервировать друг друга и предоставляют единую точку входа для управления всеми устройствами в шасси.

OA могут быть со встроенной консолью KVM для подключения внешнего монитора, либо с одним лишь сетевым интерфейсом.

В общем и целом, администрирование через OA выглядит следующим образом:

Вы подключаетесь к веб-интерфейсу консоли Onboard Administrator. Здесь можно посмотреть состояние всех подсистем, отключить или извлечь лезвие, обновить прошивку и т.п.

Если нужно добраться до консоли конкретного сервера – выбираете его в списке оборудования и подключаетесь к его собственному iLO. Тут уже весь привычный набор IPMI, включая доступ к образам и перезагрузку.

Еще лучше – подключить блейд-систему к внешнему управляющему ПО вроде HPE Insight Control или сменившей ее OneView. Тогда можно настроить автоматическую установку операционной системы на новое лезвие и распределение нагрузки кластера.

К слову о надежности – блейды ломаются точно так же, как обычные серверы. Поэтому при заказе конфигурации не пренебрегайте резервированием компонентов и внимательным изучением инструкций по прошивке. Если подвисший Onboard Administrator доставит лишь неудобства администратору, то неправильное обновление прошивок всех элементов блейд-системы чревато ее неработоспособностью.

Но за всей этой магией мы совсем забыли о приземленных материях.

Нужен ли блейд в вашей компании

Высокая плотность, небольшое количество проводов, управление из одной точки – это все хорошо, но оценим и стоимость решения. Предположим, в абстрактной организации нужно запустить разом 10 одинаковых серверов. Сравним стоимость блейдов и традиционных стоечных моделей HPE ProLiant DL. Для простоты оценки не беру в расчет стоимость жестких дисков и сетевого оборудования.

Блейды:

| Наименование | Модель | Количество | Стоимость |

| Шасси | HPE BladeSystem c7000 | 1 | 603 125 ? |

| Блок питания | 2400W | 4 | - |

| Модуль управления | HPE Onboard Administrator | 1 | - |

| Модуль сети | HPE Pass-Thru | 2 | 211 250 ? |

| Лезвие | HPE ProLiant BL460c Gen8 | 10 | 4 491 900 ? |

| Процессор | Intel Xeon E5-2620 | 20 | - |

| Оперативная память | 8 Гб ECC Reg | 40 | - |

| Итого: | 5 306 275 ? |

Цены актуальны на 06.02.2017, источник – STSS

Аналоги – HP ProLiant DL360p Gen8:

| Наименование | Модель | Количество | Стоимость |

| Платформа | HP ProLiant DL360p Gen8 | 10 | 3 469 410 ? |

| Процессор | Intel Xeon E5-2620 | 20 | - |

| Блок питания | 460W | 20 | - |

| Оперативная память | 8 Гб ECC Reg | 40 | - |

| Итого | 3 469 410 ? |

Цены актуальны на 06.02.2017, источник – STSS

Разница почти в два миллиона рублей, при этом я не закладывал полную отказоустойчивость: дополнительный модуль управления и, в идеале, еще одно шасси. Плюс, лишаемся удобной сетевой коммутации из-за использования самых дешевых pass-thru модулей для простого вывода сетевых интерфейсов серверов наружу. VIrtual Connect был бы здесь более уместен, но цена…

Получается, что "в лоб" экономии не выйдет, поэтому перейдем к остальным плюсам и минусам блейдов.

Еще немного аргументов

К очевидным плюсам блейд-систем можно отнести:

Плотность установки. Если нужно много-много серверов в одном ДЦ, блейды похожи на спасение;

Аккуратная и компактная кабельная инфраструктура за счет гибкой внутренней коммутации блейдов;

Удобство управления – всей корзиной можно управлять из одной консоли и без установки дополнительного ПО;

Легкая установка новых лезвий, пока есть место в шасси – прямо как с дисками в корзинах с горячей заменой. В теории, можно сразу при установке лезвия загружать настроенную систему по PXE и распределять ресурсы в кластере;

- Надежность. Практически все узлы могут быть зарезервированы.

Но как же без минусов:

Ограниченность лезвия. Если нужен сервер с четырьмя процессорами и большим количеством локальных жестких дисков (например, NMVE SSD), то установка столь крупного лезвия в четверть всей емкости шасси делает бессмысленным использование корзины высокой плотности;

Надежность. Несмотря на дублирование компонентов присутствует единая точка отказа – коммуникационная плата (бэкплейн) шасси. При сбое могут отказать все лезвия;

Невозможность разделения. Если нужно создать территориально распределенный кластер, нельзя просто вытащить и перевезти половину серверов – потребуется еще одно шасси;

- Стоимость. Само по себе шасси стоит как три лезвия, а лезвие стоит как полноценный сервер.

Так что же выбрать

Блейды очень органично смотрятся в действительно крупных ЦОД, вроде хостинговых компаний. В таких сценариях на первое место выходит скорость масштабирования и максимальная плотность размещения оборудования – экономия на пространстве и администрировании вполне может окупить и корзину, и всякие Virtual Connect.

В остальных случаях более разумным и универсальным видится применение обычных стоечных серверов. Кроме того, широкое распространение быстрых систем виртуализации еще больше снизило популярность блейдов, так как большинство приложений можно "уплотнить" и с помощью виртуальных серверов. Что уж говорить, управлять виртуальными машинами еще удобнее, чем блейдами.

Если вам доводилось использовать блейд-системы в не самых крупных компаниях – поделитесь впечатлениями от администрирования.

Комментарии (21)

dklm

07.03.2017 12:48+1в «больших дата центрах» не используют блейды, блейды всегда был продуктом для «корпораций»

с7000 это уже не актуальное шасси =), в новом шасси плотность серверов уменьшили…

на блейды HP под проект всегда дают скидку, и в этом случаи на прайс смотреть не правильно.

когда придет время менять сервера — рековые сервера легко можно продать, блейды вы никому не впарите ))))

lolhunter

07.03.2017 13:04С другой стороны б/ушный с7000 стоит откровенные копейки. Как и лезвия к нему. По сравнению с б/у серверами лезвия прям рвут в клочья. Особенно если задумал свой хостинг на коло.

DaemonGloom

07.03.2017 13:43+1А теперь берём и открываем какого-нибудь другого поставщика HP. И видим такие цены за штуку: блейд-сервер стоит примерно 120 тысяч, классический — 140 тысяч. Те же модели, что и в статье, но 16GB памяти. И, внезапно, разница в цене за полный комплект стала не такой уж и большой.

ildarz

07.03.2017 16:04+2Аналоги – HP ProLiant DL360p Gen8:

Прямое сравнение цен с учетом любимых корпоративных игр со скидками не слишком осмысленно, но, если уж подбираете "аналог", хотя бы на конфиг внимание обращайте, пожалуйста. В блейде из коробки 2x10Gbit конвергентная сеть, в стоечном сервере — 4xGbit Ethernet, какие уж тут аналоги...

kotobanvv

07.03.2017 16:07И кстати, некоторые производители делают блейды, которые можно объединять в один большой сервер несколько лезвий. Например Hitachi позволяет до 4 лезвий объединять.

AndreySafu

07.03.2017 16:07-4Дружественная контора хостила у нас свою корзину с лезвиями. Впечатления самые негативные. В аппаратной невозможно стало разговаривать, т.к. ревет корзина как реактивный двигатель; пришлось ставить ей отдельный UPS, т.к. мощности стандартного в стойке не хватало; тянуть к новому UPS отдельный кабель питания. Ну и судя по активности светодиодов на лицевой панели работал у них всего один сервер. Съехали и слава Богу.

Pinkkoff

07.03.2017 17:12+5Друг купил машину на замену своей лошади. Впечатления самые негативные. Пытался засыпать овёс в бак — он размок и забил бензонасос. Пришлось чинить. Попытался поставить в стойло — не влезает, пришлось перестраивать всю конюшню, да и асфальт класть до нее.

Чтобы ветер обдувал лицо надо опускать все стекла, причем дует только сбоку, лобовое не опускается. Поменял обратно на лошадь и слава Богу!

По теме:

Аппаратная не для того, чтобы разговаривать. Если вы хотите увеличить плотность компоновки, очевидно, что придется подводить туда больше питания и охлаждения. Как вы хотели иначе? Просто думать об этом надо до проекта, а не после.

AndreySafu

07.03.2017 17:17-4Спасибо, посмеялся. Я ж про эффективность писал. Корзина ела ~5кВт, а задачи выполняла как 300Вт сервер.

Pinkkoff

07.03.2017 17:35+2Коллега ниже прав, в случае ошибок в системе управления (management платы, например) или в системе охлаждения (вентилятор вышел из строя) система автоматически включает охлаждение на полную. В этот момент даже стоять рядом неприятно=)

Если в корзине работает только один сервер, то электричество будет кушать он, блоки питания и коммутаторы шасси. Это не 5кВт. Раз корзина ест 5кВт — значит работают все лезвия, но что-то с ними не так.

В общем дело не в том, что это блейд-корзина, а в правильной настройке и эксплуатации=)

foxmuldercp

08.03.2017 00:05У нас в стойке 2U Juniper стоит. на включении и продувке под вентиляторами стоять нереально — сдувает не только меня, но и сотрудника который весом под 120кг...

sizziff

07.03.2017 17:15+1Скорее всего, та корзина работала в нештатном режиме (ошибки в системе на которые забили) и неуправляемые вентиляторы работали на полную катушку. К питанию корзины конечно предъявляются большие требования чем к обычному серверу т.к. в ней по сути может быть установлено 16 обычных серверов + коммутаторы. Из того что видел я, обычно не переваливало за 2-3 кВт для полностью забитой корзины.

autuna

07.03.2017 17:56+2Надежность. Несмотря на дублирование компонентов присутствует единая точка отказа – коммуникационная плата (бэкплейн) шасси.

Простите, немного поправлю Вас.

Плата стоящая посреди корпуса обычно называется midplane. Хотя в с7000 есть И midplane И backplane… 8-)

Касательно надёжности.

Обычно, при проектировании подобных систем стараются с midplane и backplane вынести всю активку, чтобы в них просто нечему было ломаться. В c7000 именно так и сделано (стр 4).

Невозможность разделения. Если нужно создать территориально распределенный кластер, нельзя просто вытащить и перевезти половину серверов – потребуется еще одно шасси;

Стоимость. Само по себе шасси стоит как три лезвия, а лезвие стоит как полноценный сервер.

Добавлю — шасси с аналогичной набивкой (коммутаторы, блоки питания и т.п.), которая стоит недёшево.

Само по себе шасси задёшево купить не очень сложно — у вендоров регулярно бывают акции типа «купи два лезвия и получи шасси за $1». Ну а в общем случае — если есть время, а у работодателя есть деньги — можно устроить красивую развлекуху под названием «торг с вендором» и существенно снизить общий ценник.

К минусам я бы добавил, что blade системы это классический случай vendor lock. «Неродные» компоненты в blade шасси в большинстве случаев не воткнёшь из-за нестандартных посадочных размеров. Использовать возможности интегрированной периферии (коммутаторов и пр.) внешними серверами также бывает сложно из-за малого количества внешних портов.

Tomatos

09.03.2017 08:40Еще одно уточнение, чаще всего в блейдах два мидплейна, т.ч. единой точкой отказа становится админ :)

ToSHiC

07.03.2017 23:55Меня всё время вот какой вопрос интересовал: про блейды пишут часто, что мол плотность установки высокая и т.д., но они же жрут при этом много. Пусть даже 10 юнитов в стойке, и 5кВт — это же половина мощности, подводимой к стойке в среднестатистическом датацентре. Получается, что реально то занять можно 20 юнитов всего, а ещё 20 будут простаивать. Ну и где тут обещанная высокая плотность?

phprus

08.03.2017 15:09Так это и есть высокая плотность. Больше единиц оборудования в меньшем объеме (В С7000 16 серверов на 10 юнитов) и следовательно, больше энергопотребление в меньшем объеме.

Другое дело, что среднестатистические датацентры рассчитываются на малое энергопотребление, а не на высокую производительность оборудования, отсюда и лимиты в 10кВт на стойку.

Что по охлаждению, то воздухом можно снять 20-25кВт со стойки. Системами на подобие с водяной дверью порядка 40кВт, а водой до 400кВт (рекорд РСК).

Так что если Вы лимитированы питанием и/или охлаждением, то высокоплотные системы просто не для Ваших задач, а если Вам нужна высокая плотность, то Вас уже не заботят стандартные датацентры, а инженерная инфраструктура подгоняется под используемое оборудование.

Dr_Wut

08.03.2017 00:35Идея блейдов конечно красивая, но вот реализация подкачала. Отдавать 6 юнитов под корзину, когда тебе чаще всего не все забивать… жесть. Лично для себя сейчас нашел fx2 от Dell-а. Вот тут действительно на мой взгляд хорошее совмещение и экономия места.

dimagolov

08.03.2017 12:48В реальности в стандартный шкаф в датацентре можно поместить 2, максимум 3 блейд центра, в первую очередь из соображений теплоотвода. Причём с учетом подачи холодного воздуха через люк под шкафом, чем выше стоит блейд центр, тем хуже у него температурный режим. Для обычных серверов это тоже актуально, но за счёт большей плотности компонент у блейдов эффект проявляется много раньше. Если шасси 10U, то больше 3х не поставишь ещё и потому что в шкафу 42U, и 2U будет явно не хватать для подачи воздуха снизу в шкаф. С питанием тоже отдельная песня, БП мощные и рассчитаны на высокие токи, которые весьма сложно коммутировать и для питания необходимо будет покупать дополнительно компоненты, так как штатные, предоставленные датацентром, будут не проходить по токам. Ещё и модернизация сети питания шкафов в датацентре может оказаться необходимой

sergeysakirkin

08.03.2017 15:51Сравнивание BL460c vc DL360p произведено в принципе в равновесном обвесе

Но есть несколько моментов:

В классику можно воткнуть горячие процессора с TDP вплоть до E7-8894 v4 / E5-4669 v4

Можно GPU вставить правда в DL360e

Цена $/юнит и энергоэффективность не в пользу классики

SchmeL

09.03.2017 12:21А диски в эти блейды фирменные ставятся, или обычные sata тоже подойдут?

А то тут понакупали у нас «фирменного» оборудования пару лет назад, теперь плачут, что диски стоят как чугунные мосты и покупают теперь не vendor lock-in железку из-за этого…

mikkisse

Изображение подобрано просто великолепно.

mikkisse

Ну и чтобы не отвлекаться от темы: впечатления от использования c7000 и BladeCenter-H только положительные. Хотя, как по мне, блейды от HPE более просты и приятны в управлении.