— М. Ларни

В этой статье я, используя Википедию да несколько картинок из интернета, попытаюсь оценить ближайшее будущее графических ускорителей.

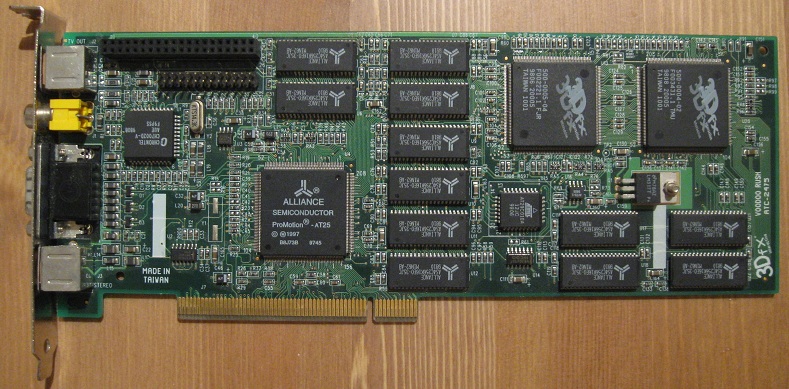

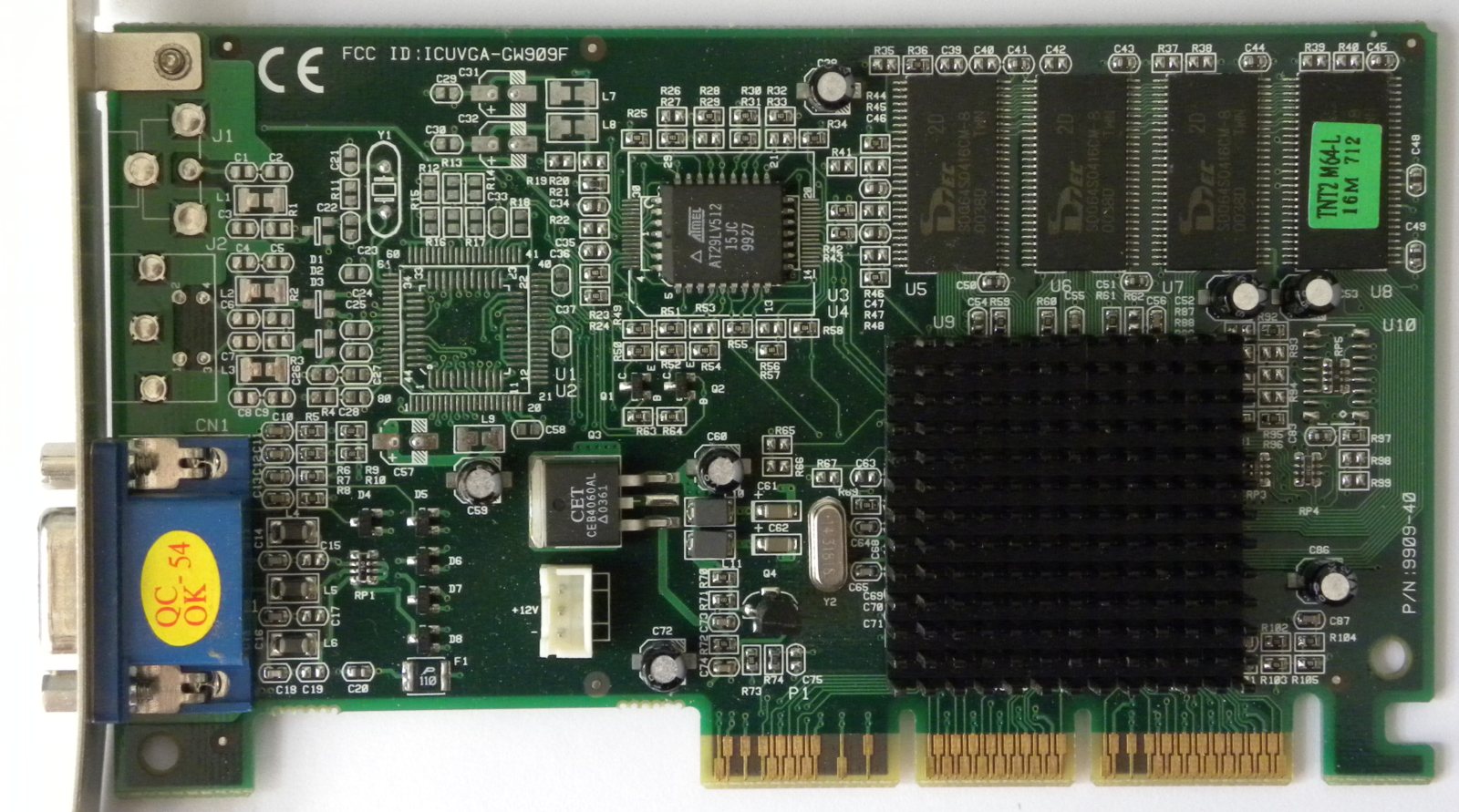

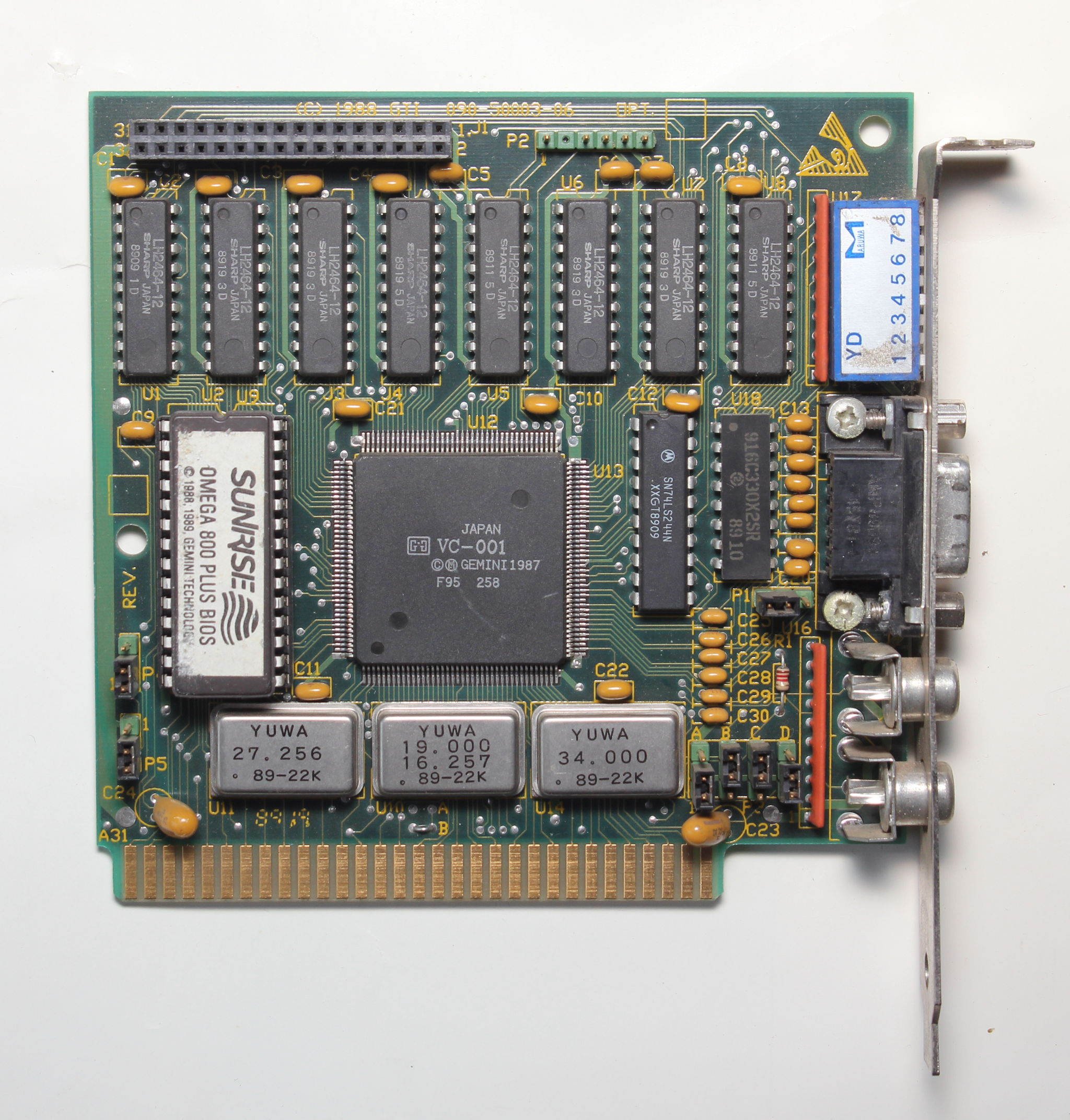

Давайте посмотрим на актуальную 20 лет назад видеокарту серии S3 Trio.

Серьезно, давайте оценим ее.

1. Минимальная электрическая мощность порядка ватт.Давайте теперь посмотрим на один из текущих топов, а именно на MSI GTX 1080 Ti Lightning Z.

2. Из п.1. следует отсутствие системы питания ядра, плата очень компактна.

3. Из п.1 следует также и отсутствие необходимости мощной системы охлаждения. Не нужно громадного радиатора, как и вентиляторов. Полная тишина.

4. Модульная память. Каждый может купить видеопамяти сколько ему нужно, а потом установить на видеокарту. Можно докупить видеопамять, когда будут деньги или, когда потребуется расширить ее объем.

5. Вывод видеосигнала осуществляется через VGA, который тогда был стандартным. Один тип передачи сигнала, один вывод и т.д.

6. Подключение видеокарты осуществляется через распространенный даже сейчас разъем PCI. Эту видеокарту можно подключить к любому компьютеру с таким разъемом даже сейчас и работать она будет.

7. На плате почти отсутствуют радиодетали, подверженные порче или вызывающие проблемы. Нету мощных дросселей, которые могут начать свистеть, конденсаторов всего несколько — и те с минимальной емкостью.

Длина видеокарты составляет 32см

Она занимает 3 слота, что в целом стало уже явлением, не вызывающим удивления на данный момент

Видеокарта использует три стандартных разъема питания PCI-E

и по идее потребляет лишь 250Вт, что вызывает определенные сомнения, судя по системе питания и охлаждения. О системе охлаждения, конечно, нужно упомянуть в отдельности

Всего 5 тепловых трубок не кажутся чем-то исключительным. Ну, 3 вентилятора вы уже видели.

Если у кого-то завалялись S3 Trio и GTX1080ti, предлагаю провести простой эксперимент – сотрите с первой пыль, выровняйте смятые за время лежания видеокарты в мусоре конденсаторы. Ознакомьте с обеими видеокартами человека, абсолютно далекого от компьютеров, какого-нибудь пенсионера. А потом поинтересуйтесь, какая видеокарта, по его мнению, новее. Если ржавчина на планке S3 Trio вас не подведет, ответ будет в ее пользу.

Как же мы до такого докатились?

Очевидно, что к столь критическому росту размеров платы и тепловыделения привел процесс роста электрической мощности видеокарты. Ядро требует большей мощности, для ее обеспечения необходимо конструировать все более сложную подсистему питания, т.к. напряжение на ядре очень мало. Кроме того, выделяющееся тепло приходится еще и рассеивать, что в свою очередь требует повышения эффективности системы охлаждения. Т.к. рассеяние сотни-другой ватт (вспоминаем паяльник на 60Вт), да еще и в ограниченном пространстве гипотетического корпуса, уже непростая задача, приходится увеличивать воздушный поток (рост числа вентиляторов), площадь теплообмена и теплопроводность самого радиатора (рост числа и размеров тепловых трубок). Когда это началось? Первые поколения распространенных графических ускорителей обходились даже без радиаторов, как мы видим на примере S3 Trio. При дальнейшем развитии видеокарт понадобилась установка небольших радиаторов

ATI Rage 128 Pro 32Mб

К самому началу текущего столетия уже многие видеокарты в линейке оснащались не просто радиатором, а уже и радиатором с маленьким вентилятором

ATI Radeon 8500LE 64Мб

Если кто-то экспериментировал с установкой маленьких вентиляторов куда-либо, то он отлично знает об их крайне низкой эффективности. Воздушный поток из-за размера их лопастей ничтожен, а шума такой вентилятор создает очень много за счет порядочной скорости вращения. Т.к. при этом энергопотребление видеокарт продолжало расти, даже в референсных (образцовых) видеокартах пришлось перейти к турбинам. Примерно после 2010 охлаждение типа турбины стало стандартным для образцовых видеокарт, и хотя мы живьем видим его все реже и реже, сами разработчики видеочипов представляют свои видеокарты по умолчанию с ним. Небезынтересно отметить, что в начале текущего столетия турбина, как тип охлаждения, могла продаваться отдельно для желающих проапгрейдить свою видеокарту с обычным маленьким радиатором. Сейчас их, конечно, уже не продают. Собственно, почему турбина?

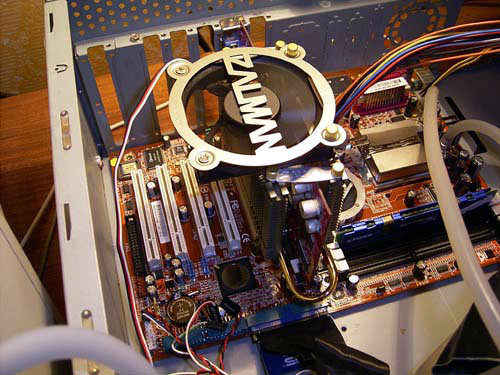

Типичная система охлаждения типа турбины со снятым кожухом на GTX670

Как видно, сама турбина захватывает воздух сверху, перенаправляет его в стороны, после чего воздух проходит через радиатор и охлаждает его. В идеале горячий воздух полностью выбрасывается за пределы корпуса. Нельзя не отметить, что со снятым кожухом турбина работать едва ли будет. Теоретический предел рассеиваемой мощности турбиной весьма велик – достаточно увеличить число ребер радиатора, приделать к нему пару тепловых трубок, и можно будет добиться рассеяния даже 450Вт тепла (HD6990). Однако, главным недостатком турбин является шум, т.к. сама турбина должна вращаться на больших скоростях. Поэтому примерно с 2008 года начался выпуск уже ставших привычными сейчас систем воздушного охлаждения, состоящих из тепловых трубок, относительно компактного радиатора и нескольких полноразмерных вентиляторов, дующих в направлении видеокарты через радиатор. Типичный пример, одна из первых ласточек

Thermalright HR-03 на 8800GT

На данный же момент этот тип охлаждения стал уже вполне стандартным – странно покупать видеокарту с турбиной, на самом деле. Так что ситуация повторяется. Первоначально турбины продавались в качестве кастомного варианта охлаждения, затем стали стандартом. Затем радиаторы на тепловых трубках с вентилятором повторили их судьбу и стали фактическим стандартом. Остается надеяться, что дело не дойдет до компактной СВО на каждой видеокарте по умолчанию.

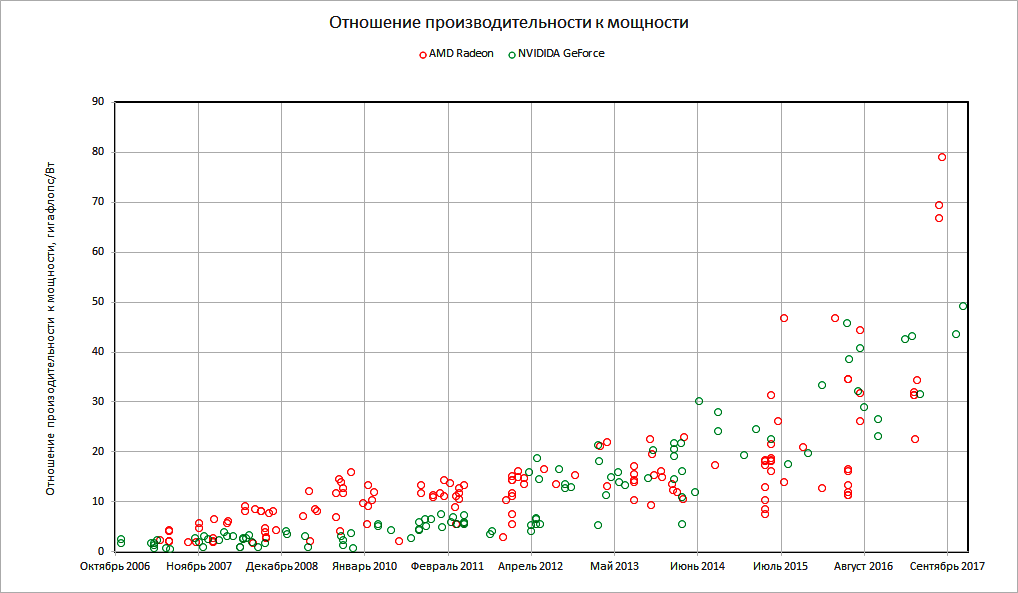

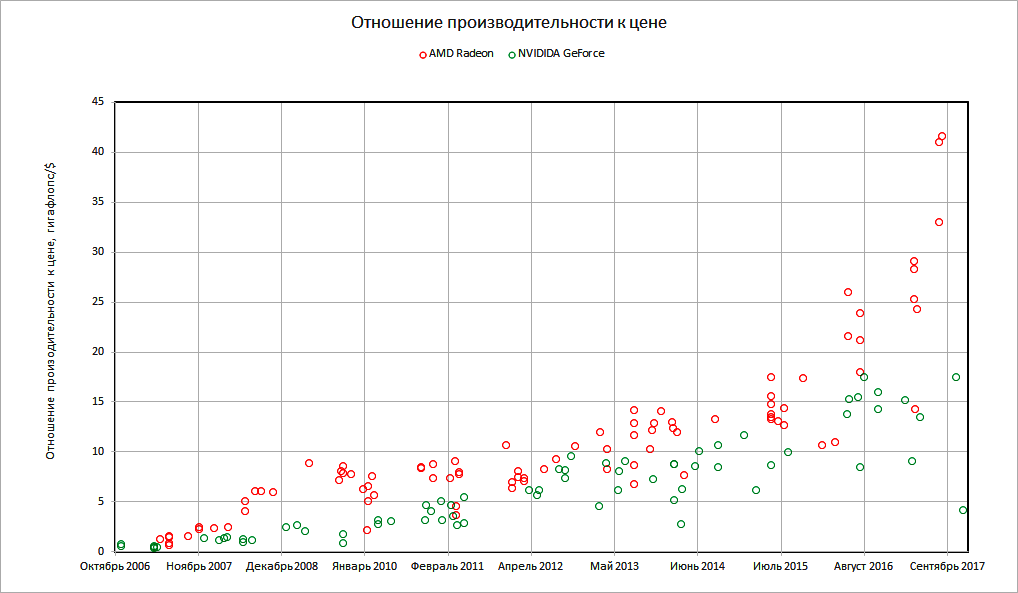

Это лишь примерная оценка роста мощности видеокарт, что называется «на глаз». Теперь предлагаю сделать оценку по более строгим критериям, а именно по графикам. Для построения этого и следующих графиков я пользовался по больше части данными из Вики по видеокартам AMD и NVIDIA, однако, некоторые данные я заполнял сам на основе сохранявшихся в интернете данных. К большому сожалению, TDP старых видеокарт выпуска до 2007 года неизвестен. В графики включены почти все серии GeForce и Radeon примерно за 10 лет, кроме 100-й и 300-й серии GTX и 8000-й серии HD Radeon. Точки на графиках принадлежат видеокартам, по оси абсцисс отложена дата выхода видеокарты, по оси ординат – изменение тех или иных значений.

Итак, давайте внимательно изучим график изменения теплот, выделяемых видеокартами в работе примерно за последние 10 лет.

Напрашиваются следующие выводы:

1. Уменьшение техпроцесса не произвело ожидаемой революции в тепловыделении графических ускорителей.Ну может, мы не зря терпим повышение тепловыделения, наверняка это оправдывается повышением вычислительной мощи? Попробуем это проверить. Конечно, нету способа однозначного найти точную производительность видеокарты, а потому я обратился к максимальной теоретической производительности для вычислений с одинарной точностью.

2. Несмотря на крупный техпроцесс, самые холодные видеокарты выпускались до 2007 года. Первый крупный скачок тепловыделения произошел ок. середины 2006 – начала 2007. Это однозначно указывает, что тепловыделение в первую очередь задается требованием рынка. Когда видеокарты сами по себе уже плохо тянут игры, производителям приходится завышать частоты и напряжение, что приводит к очень сильному росту тепловыделения.

3. Выход максимального тепловыделения на плато произошел ок. 2009 года, плюс минус.

4. Плато максимального тепловыделения мощных моделей стойко держится с тех пор ок. 250Вт. Это, видимо, максимум, который позволяют объективные свойства видеокарты как устройства в современном его виде. Если бы можно было и дальше повышать тепловыделение, то, вне сомнений, производители видеочипов и дальше бы повышали частоту и напряжение. Однако, охлаждение видеокарты с тепловыделением выше 300Вт уже трудная задача, и в плохом корпусе она зажарится, да и шум вентиляторов либо турбины будет выше всяких норм.

5. Средние и слабые модели тоже медленно, но верно повышают свое тепловыделение. Если, правда, старшие модели уперлись в максимум (плато) около 2009 года, то средние уперлись в примерно 150-180Вт еще раньше. Слабые идут той же дорогой.

6. Наблюдается уменьшение числа представленных моделей с 2012 года. Особенно это заметно относительно моделей с низким тепловыделением. Их становится все меньше.

7. Списать последний довольно долгий застой на внимание к рынку мобильных решений, как это делали раньше, конечно же нельзя. Более того, как раз на момент максимальной популярности планшетов наблюдается достаточно высокая частота выпуска новых видеокарт.

8. Не менее парадоксальным и кажется то, что в годы мирового экономического кризиса выпуск новых моделей происходил значительно чаще, чем сейчас.

9. Последние два вывода снова нас приводят к главенствующей роли требований рынка перед объективными возможностями видеокарт.

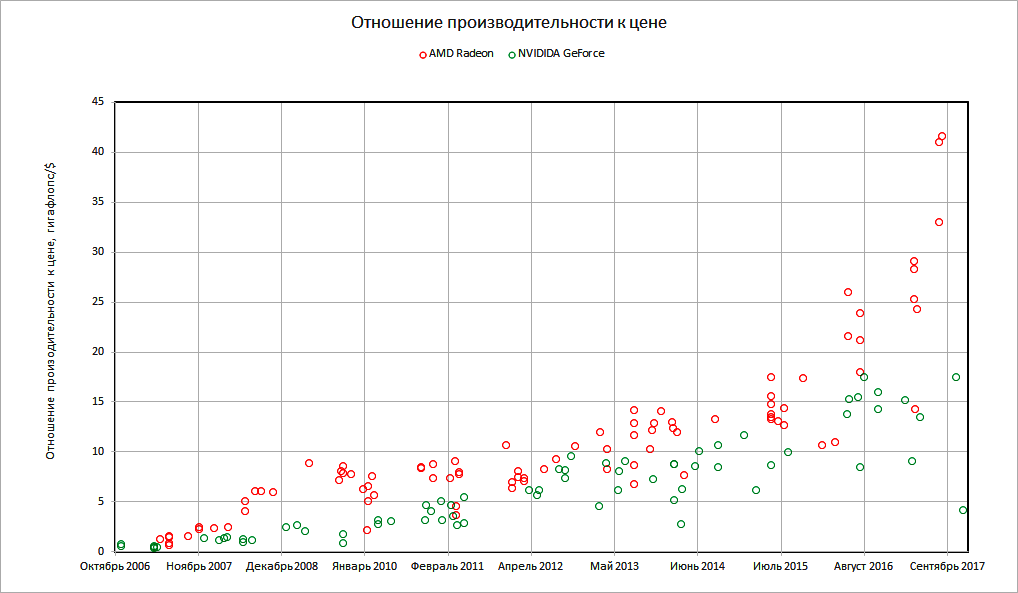

Тут довольно приятно видеть вполне экспоненциальный рост. Лично для меня оказалось неожиданностью заметно более высокая теоретическая производительность у видеокарт Radeon. Что ж, вероятно старая шутка про отсутствие драйвера

оказалась правдой. Не исключено, что дело и в оптимизации самих игр.

Теперь давайте сопоставим график изменения TDP и производительности. Тут несложно прийти к выводу, подтверждающему п.2:

10 Рынок требует экспоненциального роста производительности, при том, что производители видеочипов за этим требованием, очевидно, еле-еле поспевают. На это указывает рост TDP.Теперь почему бы нам не соотнести производительность к мощности.

Сказать точно, какая тут функция задает кривую, трудновато. С одной стороны, у GeForce вроде видна степенная функция, а Radeon кривая имеет S-образную форму. Если мы отбросим оптимизацию драйвера и игр, то найдем, что AMD ок. 2009 достигла хорошей по эффективности архитектуры, которую использовала на протяжении многих лет и последние модели которой вышли еще в начале 2016. Это плато на S-образной кривой. Хорошо ориентируясь в выходивших видеокартах, несложно понять, примерно о каких моделях идет речь. У NVIDIA же скачок эффективности наблюдается с 2012 – скорее всего, принятие некой полностью новой архитектуры. За GeForce следует и экспоненциальный скачок у Radeon с 2015 года.

Предлагаю теперь обратиться к росту числа транзисторов. Попробуем проверить закон Мура.

Нелишним, кстати, будет упомянуть, что т.н. закон Мура — это лишь наблюдение, которое было сделано в 1965, т.е. на заре современной электронной промышленности. Причем наблюдение делалось на процессорах Intel. Сам закон гласит:

Количество транзисторов, размещаемых на кристалле интегральной схемы, удваивается каждые 24 месяца.Проблематика при длительном прогнозировании по закону Мура в точке отсчета, а именно, какое число транзисторов брать. Я взял 110 млн. для средней-слабой видеокарты. Как видно, закон Мура выполняется, число транзисторов растет, как и должно. Но тут уместно будет задать вопрос – а не за счет ли площади кристалла оно растет? Смотрим на размер кристалла (или их суммы, если речь идет о двухпроцессорных решениях)

В данном случае мы видим приятное глазу постоянство. Производителям банально невыгодно увеличивать площадь кристалла. Но хотелось бы напомнить, что при прогрессе желательно было бы видеть уменьшение площади кристалла. Попробуем сформулировать выводы:

11. Отношение производительности к TDP зависит почти полностью от текущей архитектуры (либо от каких-либо еще не очевидных факторов).А теперь давайте посмотрим на самое интересное, а именно на цену. Т.к. в Википедии данных о релизной цене было в обрез, мне пришлось искать их в интернете, но это все равно не большой секрет. Т.к. цена — штука весьма размытая (релизная цена может отличаться от вскоре установившейся рыночной, сами релизные цены не всегда доступны и т.д.), ее неточность требует применения и более размытого маркера.

12. Архитектуры, вопреки маркетинговым сменам названий из поколение в поколение, на самом деле в реальности меняются принципиально редко. Не чаще чем раз в 6-7 лет.

13. Использование той или иной архитектуры очень хорошо видно по кривой, описывающей отношение производительности к TDP.

14. Большая часть изменений отношения производительности к TDP не могут быть описаны степенными функциями. Увы, эти изменения не имеют вида линейной функции и вообще годами могут стоять на месте почти без изменений.

15. Техпроцесс не влияет на отношение производительности к мощности, т.к. уменьшение размера транзистора сопровождается лишь занятием его места новыми транзисторами. Это связано с п.10, т.е. с завышенными требованиями рынка.

16. Площади кристаллов не меняются.

17. Увеличение числа транзисторов продолжает соответствовать закону Мура.

Подводим итоги и тут:

18 Цена медленно растет.Подводя итог сказанному, попробуем создать прогноз на ближайшее будущее графических ускорителей. Да, только глупец может лезть в будущее, и любой мало-мальски уважающий себя человек никогда не опускается до прогнозов (ибо обязательно ошибется в них, так или иначе). Ну а если и делает их, то крайне размытыми, чтобы попасть, как говориться, пальцем в небо. Однако же, я готов рискнуть:

19. Общую тенденцию роста цен можно соотнести с инфляцией американского доллара (спасибо американским и британским экономистам). Для массы моделей это можно объяснить очень просто – компании-разработчики чипов родом из Силиконовой долины. Инфляция американской национальной валюты, естественно, будет отражаться на них.

20. Однако, отдельные плато образуют высшие модели видеокарт. В частности, для NVIDIA мы видим несколько S-образных подъемов цен — цены на топы поднимались в начале 2012 и к лету 2016. У AMD, перешедшей в пред-топовый модельный ряд с эпохи HD7970, таких скачков нет.

21. Стоящие особняком точки цен на двухчиповые решения отдельного рассмотрения не заслуживают сами по себе. Однако же, в конце к ним впервые присоединилось и одночиповое решение — NVIDIA TITAN V.

1. TDP видеокарт будет продолжать увеличиваться для слабых и средних моделей. Это будет очень медленный процесс, но, скорее всего, неизбежный.

2. Для старших и старше-средних моделей TDP останется ок. 250Вт – объективный предел для современных систем охлаждения. Дальнейшее повышение тепловыделения попросту потребует установки неоправданно дорогой системы охлаждения, да и снизит срок жизни устройств.

3 В производительности видеокарт первичным оказываются требования рынка. Так или иначе, а видеокарты им не удовлетворяют или удовлетворяют, но с трудом. Если мы предположим, что рынок не сократит свои требования, то и ожидать уменьшения TDP, сокращения размера чипа и т.п. нельзя.

Однако, заявления о достаточности ядра GP107-300/400 неверны, эти видеокарты лишь демонстрируют более-менее удовлетворительную производительность в ряде игр, да еще и при наличии мощного ЦП. И то не на текущий момент, а лишь на время выпуска. Ситуация, на самом деле, не новая, так бывало почти каждое поколение видеокарт, когда при поверхностном взгляде казалось, что средней-слабой видеокарты достаточно для всех игр. Но на практике они всегда очень быстро устаревали. Дело в том, что игры выходить не перестают, как и требования расти, а потому сказать, что для современных игр в 1920х1080 достаточно бюджетных видеокарт, нельзя никоим образом. Вот если бы видеокарты на чипе GP104-200/300/400 занимали низшую ценовую категорию, то только тогда можно было бы заявить о победе над разрешением 1920х1080.

4. Увеличение числа транзисторов и совершенствование архитектуры не даст улучшения эргономических свойств видеокарт, а полностью уйдет на то, чтобы догонять требования рынка по увеличению производительности.

5. Скорее всего, следует готовиться к сокращению модельного ряда видеокарт. Помимо коммерческих ходов, производители чипов будут разрабатывать всего несколько ядер, которые в зависимости от качеств уже будут подвергаться сортировке. Это будет делаться ради сокращения затрат на разработку.

6. Цена на видеокарты будет медленно расти, возможно, будет оставлена буквально одна низшая модель по минимальной цене (напр. младшая видеокарта предыдущего поколения), но рост цен в долларах будет продолжаться.

7. Особого беспокойства будут заслуживать цены на сильные и средне-сильные видеокарты. Т.к. NVIDIA уже давно вышла на плато, можно ожидать очередного скачка цен на вышеозначенные видеокарты в новом поколении, или в следующем. Как бы то ни было, скачок цен на топы не за горами.

Так что ничего обнадеживающего в ближайшее время ожидать, скорее всего, не стоит. Лишь наивный человек может думать, что получит за стоимость GT1030 быстродействие GTX1060 в следующем поколении. Одним словом, прогноз можно выразить просто «держимся за свои старинные топы и ожидаем лучшего».

Небольшое дополнение:

Спасибо пользователю Edil0 за идею. Отношение теоретической производительности для вычислений с одинарной точностью к цене.

Комментарии (305)

zookko

17.03.2018 19:307 Особого беспокойства будут заслуживать цены на сильные и средне-сильные видеокарты. Т.к. NVIDIA уже давно вышла на плато, можно ожидать очередного скачка цен на вышеозначенные видеокарты в новом поколении, или в следующем. Как бы то ни было, скачок цен на топы не за горами.

Хуанг уже давно озвучил и повторил, что след.поколение 100% будет дороже, из-за дорогих НИОКР и неудержимого роста цен на оперативную память.

И дороже будет всё, не только топы.

JohnHenry89 Автор

18.03.2018 13:30У меня такое впечатление, что GT1030 они ничем заменять не будут или у GTX1050 поменяют название, а обновят ряд начиная со средних только.

arheops

17.03.2018 20:14Гдето с 12го года рынок видеокарт испытывает давления рынка криптовалют. Странно, что этот факт не влияет на рассуждения автора.

Exchan-ge

17.03.2018 20:33Странно, что этот факт не влияет на рассуждения автора

Ой. Автор не заметил процесс вытеснения недорогого ценового сегмента видеокарт — встроенными в процессор решениями, а вы требуете внимания к криптовалютам )

JohnHenry89 Автор

18.03.2018 13:37А что их замечать-то?

1 Встроенные видеоядра широко предлагаются покупателям с 2010 года и даже раньше (встроенные в чипсет были). Но популярности они никогда не имели. Почему?

2 Их низкая популярность обусловлена низкой производительностью. Видеоядра нужны не для игр, а для обработки и отображения 2d. В 3d режиме тягаться с видеокартами они не могут.

3 Следовательно встроенные видеоядра не составляют конкуренции видеокартам и на их рынок влияния оказывать не могут.

Exchan-ge

18.03.2018 14:01Их низкая популярность обусловлена низкой производительностью.

Я с 2005 года не встречал бюджетно-офисных компьютеров с отдельной видеокартой.

А их только в нашей организации сотни.

Когда появились магазины электроники — большая часть ПК «для дома» в них имела низкую цену и встроенную графику.

Недорогие видеокарты сейчас берут, в основном, на замену вышедшим из строя, или слишком «горячим» видеокартам в старых компьютерах.

JohnHenry89 Автор

18.03.2018 15:09-1Я с 2005 года не встречал бюджетно-офисных компьютеров с отдельной видеокартой.

Офисных. Бюджетных полным полно. Но даже в случае офисного компьютера по любому лучше запихнуть какую-нибудь старинную GF8800, чем сидеть на встроенной графике. Ведь это так или иначе нагрузка на кристалл, а умрет GF8800 ее не жалко.

Когда появились магазины электроники — большая часть ПК «для дома» в них имела низкую цену и встроенную графику.

Но ПК из Эльдорадо конечно плохой пример, разве не так? Я бы сказал, очень, очень плохой.

Exchan-ge

18.03.2018 15:21+1Но даже в случае офисного компьютера по любому лучше запихнуть какую-нибудь старинную GF8800

У нас около 850 ПК.

Найдите GF8800 хотя бы для 1% из них )

Но самое главное — в этом нет никакого смысла, так как GF8800GT — это уровень встроенных видео HD Graphics 4200, 4400, 4600, P4600 и P4700 — уровень 2013 года.

Но ПК из Эльдорадо конечно плохой пример, разве не так? Я бы сказал, очень, очень плохой.

Ну, вам не угодить. Сейчас люди предпочитают ноуты и планшеты, в которых другой графики, кроме встроенной вообще нет.

JohnHenry89 Автор

18.03.2018 15:26Найдите GF8800 хотя бы для 1% из них )

Но зачем? Если они все закупались вместе с одинаковым набором комплектующих, там GF8800 неоткуда взяться.

GF8800GT — это уровень встроенных видео HD Graphics 4200, 4400, 4600, P4600 и P4700 — уровень 2013 года.

Не стоит преувеличивать возможности Интелловской графики.

Ну, вам не угодить. Сейчас люди предпочитают ноуты и планшеты, в которых другой графики, кроме встроенной вообще нет.

Зависит от возраста. Планшеты люди предпочитали покупать несколько лет назад, а сейчас уже распробовали что это такое (у меня напр. планшеты были только для чтения книг и походов на пляж, да и то изредка).

fatronix

18.03.2018 17:41Не стоит преувеличивать возможности Интелловской графики.

Тем не менее, современные встроенки от интела на голову выше даже середняков нвидии 400-го поколения.

Areso

18.03.2018 21:00+1gpu user benchmark с вами не согласен. Intel HD 630 не дотягивает даже до GTS 450 (+20%), и существенно отстает даже от дешевых GTX 460 SE (+65%) плат, в то время как референс GTX 460 (+93%) вообще кажется чем-то недостижимым.

JohnHenry89 Автор

18.03.2018 21:07Как заметили ниже, это преувеличение. А GTS450 это дальний потомок GF8800. Так что даже GF8800 как решение может быть актуальна, тем более что может быть получена даром.

vitalyvitaly

19.03.2018 12:26И 630, и часть 730 — все та же архитектура Ферми в еще более урезанном виде. Ну, сижу на 630 DDR5 как раз, для офисного использования и видео пока хватает, но в играх пока не проверял (не играю особо). Не знаком с уровнем 450, но GTX 460 вроде бы по производительности примерно на уровне более поздней 1030, только конечно более горячая. Но по цене такой апгрейд будет вероятно выгоднее, если захочется менять видеоплату и получится ее найти.

JohnHenry89 Автор

19.03.2018 14:18А если вообще вспомнить о БУ GTX680 или HD7970? Самая выгодная покупка ведь сейчас.

Soul_in_Gun

18.03.2018 23:23Не стоит преувеличивать возможности Интелловской графики.

Однако на свежем NUC-е (7-го поколения Core-ей) вполне можно было играть «на минимальных 1080@30» в свеженький к тому моменту BF1, что недоступно для 8800GT ни под каким соусом. Так что — встроенной графики вполне хватит под «кинцо» и прочие непроизводительные вещи и старые игрули лет десяти от роду.

JohnHenry89 Автор

18.03.2018 23:31И внезапно можно добиться 38 средних ФПС на GF8800gt

Exchan-ge

19.03.2018 23:56+1Планшеты люди предпочитали покупать несколько лет назад, а сейчас уже распробовали что это такое

Это у вас были неправильные планшеты.

У меня Surface Pro 4 (i5) — это второй полноценный компьютер у меня на столе.

При всех сохранившихся плюсах планшета.

И да, на этом планшете видеокарта быстрее, чем 8800 GTS 320 MB 2007 года

(время от времени запускаю на этом планшете Fallout 3 :)

JohnHenry89 Автор

20.03.2018 00:05У меня Surface Pro 4 (i5) — это второй полноценный компьютер у меня на столе.

При всех сохранившихся плюсах планшета.

Насчет полноценности нельзя согласится. Полноценность компьютера это прежде всего его функциональность — способность выполнять задачи. А рабочие задачи планшет наравне с компьютером ATX выполнять не может — нет клавиатуры и мышки. А если они появятся, то планшет тут-же превратится в обрезанный ультрабук. Что удобно делать на планшете не превращая его в ультрабук? Книги читать, да по интернету серфить, музыку послушать, в игру примитивную поиграть. Но о серьезной работе, даже о написании статьи тут речи нет.

И да, на этом планшете видеокарта быстрее, чем 8800 GTS 320 MB 2007 года

(время от времени запускаю на этом планшете Fallout 3 :)

Запустить можно много что, но как играть в шутер, созданный под клаву и мышку? Нужно добавить клаву и мышку, поставить планшет на стол вертикально, да еще и в зарядку бы воткнуть, чтобы батарея не села. А это будет уже концептуально не планшет, а ультрабук. С таким успехом можно прикупить дешовый ноутбук который ту-же игру потянет без проблем.

Это конечно мое мнение, но считаю его полностью обоснованным. Планшеты стали популярными и будут занимать свою нишу не потому что они функциональны, а потому что их функциональности с головой хватает определенной группе людей.

Exchan-ge

20.03.2018 00:25Полноценность компьютера это прежде всего его функциональность — способность выполнять задачи.

Похоже, что вы просто незнакомы с Surface Pro 4 )

Единственное принципиальное отличие от моего десктопа — ограниченный конструктивом (неразборный девайс) объем оперативной памяти. Даже с обычными дисками проблем нет — к док станции самого Surface подключен док для двух HDD (да и Apple USB SuperDrive — тоже :)

нет клавиатуры и мышки.

Есть, и в отличии от ультрабуков — клавиатура отстегивается (мышь блютуз)

но как играть в шутер, созданный под клаву и мышку?

Я же сказал, что у вас были неправильные планшеты ) С клавой и мышкой все в полном порядке, как и с графикой в Нью-Вегас.

поставить планшет на стол вертикально,

У Surface встроенная откидная подставка. Не каждый монитор позволяет регулировать угол наклона — Surface это позволяет.

Планшеты стали популярными и будут занимать свою нишу

Это было первое поколение планшетов (iPad и его клоны)

Surface Pro — это второе.

И клонов у него уже тьма-тьмущая, Samsung Galaxy Book 12 например.

JohnHenry89 Автор

20.03.2018 00:37Единственное принципиальное отличие от моего десктопа — ограниченный конструктивом (неразборный девайс) объем оперативной памяти. Даже с обычными дисками проблем нет — к док станции самого Surface подключен док для двух HDD (да и Apple USB SuperDrive — тоже :)

Так дело не в начинке — многие ноутбуки за свою жизнь вообще никогда не испытывают смены каких-либо комплектующих.

Есть, и в отличии от ультрабуков — клавиатура отстегивается (мышь блютуз)

Главное не в наличии или возможности, а в практическом применении. Практическое применение клавиатуры и мыши у планшета будет такое-же как и у ультрабука — ноутбука. И планшет превратится в урезанный ноутбук. Вины самого планшета тут нет, просто задача которую он выполняет (напр. игра в шутер) требует именно ноутбука/ стационарного компьютера и ограничивается вовсе не железом внутри.

Я же сказал, что у вас были неправильные планшеты ) С клавой и мышкой все в полном порядке, как и с графикой в Нью-Вегас.

Смтр. выше. Ну если точнее — как выглядит игровой процесс в Fallout 3 на планшете? Можно получить описание?

У Surface встроенная откидная подставка.

Да знаю я это! Речь идет не о возможности, а том что для игры планшет будет превращен в ноутбук.

Не каждый монитор позволяет регулировать угол наклона

По-моему каждый. Даже ЭЛТ мониторы.

Это было первое поколение планшетов (iPad и его клоны)

Surface Pro — это второе.

И клонов у него уже тьма-тьмущая, Samsung Galaxy Book 12 например.

Ну вообще было еще более старое поколение, просто планшеты не получили распространения до мощной рекламной акции Эппл, да и железо за ними не поспевало. Вспоминаем Microsoft Tablet PC.

Однако, дело не в поколениях — функциональность и концепция устройства не меняется между поколениями. В противном случае, устройство сменило бы название. Если на планшете по определению нельзя было играть в шутеры, созданные для клавиатуры + мышь, не превращая его в аналог ноутбука (т.е. уже выводя из класса) то ни на каком поколении этого нельзя будет делать.

Exchan-ge

20.03.2018 01:02многие ноутбуки за свою жизнь вообще никогда не испытывают смены каких-либо комплектующих.

Мой старенький Mac-F2268AC8 еще будучи гарантийным — проапгрейдил память. А количество замен HDD и SSD я уже не помню. Плюс поменяли батарею. Потому какНургалиевДжобс разрешил — в мануале даже была инструкция по замене самим пользователем.

Потом Эппл прикрыло лавочку.

Для ноутбуков возможность замены чего-либо ограничена искусственно.

И планшет превратится в урезанный ноутбук

Почему- урезанный? Там полная функциональность ноута, включая практически полноразмерную клаву с тачем.

И время работы больше, чем у большинства «полноценных» ноутов.

как выглядит игровой процесс в Fallout 3 на планшете? Можно получить описание?

Так же как и на десктопе — одна рука на клаве, другая на мышке.

(Там другая проблема — свободного времени мало )

По-моему каждый. Даже ЭЛТ мониторы.

Это вам в жизни повезло.

Вспоминаем Microsoft Tablet PC.

У меня был в руках UMPC от самсунг — Q1

Технически интересная штучка, но совершено бесполезная в реальной жизни. Потом подался какой-то таблет от НР на шарнире — по факту это был обычный нетбук со всеми присущими нетбукам недостаткам.

Сейчас совсем другое.

В противном случае, устройство сменило бы название.

Это как маркетологи решат )

Если на планшете по определению нельзя было играть в шутеры, созданные для клавиатуры + мышь, не превращая его в аналог ноутбука (т.е. уже выводя из класса)

Тем не менее — Surface Pro это планшет, а не ультрабук.

Планшет, на котором можно играть в шутеры.

JohnHenry89 Автор

20.03.2018 01:13Мой старенький Mac-F2268AC8 еще будучи гарантийным — проапгрейдил память.

С потерей гарантии.

Для ноутбуков возможность замены чего-либо ограничена искусственно.

Скорее просто отработали свою жизнь а там на органы как донора.

Так же как и на десктопе — одна рука на клаве, другая на мышке.

(Там другая проблема — свободного времени мало )

Вот об этом и речь. Для игры планшет нужно превращать в ноутбук и даже более — аналог стационарного компьютера. По-другому никак. Вот и ограничение функциональности планшета как отдельного устройства которое требовалось доказать — чтобы играть в игры напр. нужно перевести его в состояние ПК. По-другому никак.

Тем не менее — Surface Pro это планшет, а не ультрабук.

Безусловно. Но в виде планшета он не может выполнять большое число функций и чтобы их выполнить приходится переводить его в состояние ноутбука или ПК.

Планшет, на котором можно играть в шутеры.

Но только если есть клавиатура и мышь. Как на планшете сыграть не получится.

JC_IIB

20.03.2018 09:32С потерей гарантии.

С какого перепугу? Читайте внимательнее, там написано, что даже в официальной инструкции есть раздел, как это делать. У моих MacMini та же штука.

sumanai

20.03.2018 04:21Это было первое поколение планшетов (iPad и его клоны)

Surface Pro — это второе.

У вас какие-то странные представления о поколениях планшетов. То, что вы назвали первым, живёт и здравствует, а что вы назвали вторым — загнивает на задворках истории (к сожалению), и никак не может быть продолжателем «первого».

sumanai

18.03.2018 16:13+2Но популярности они никогда не имели.

Именно что в прошедшем. Сейчас они бодро вытесняют нижний сегмент. Отсюда и рост характеристик и цен самых дешёвых образцов — делать более дешёвые и слабые просто не имеет смысла, встройка их перекроет. Поэтому через некоторое время нижний ценовой сегмент исчезнет как класс.

ToshiruWang

19.03.2018 13:462. Современные ядра в 3д вполне тягаются с безвентиляторными видеокартами 5летней давности (сравнивали), так тягаются, что осталяют позади.

Вы просто проспали этот момент.

JohnHenry89 Автор

19.03.2018 14:23От производителя зависит, но то что встроенным решениям легко будет превзойти HD7850 я сомневаюсь.

Exchan-ge

20.03.2018 00:04+1но то что встроенным решениям легко будет превзойти HD7850 я сомневаюсь.

Эту уже превзошли:

(ASUS Dark Knight Radeon HD 4870)

JohnHenry89 Автор

20.03.2018 00:08У меня такая была лет 10 назад, только синяя (от той-же фирмы). Прогресс движется семимльными шагами — всего через 10 лет…

JohnHenry89 Автор

18.03.2018 13:33Это не видно никак. Предлагаю посмотреть на графики — на карты AMD на которых по большей части майнили всегда почти не растут в цене, а видеокарты NVIDIA испытывают естественный рост цен S-образной формы. Смешно ли сказать, но майнинг никак не сказался, вопреки расхожему мнению. На пост-советском пространстве популяризацию майнинга (а до нас все доходит с маленьким опозданием) совпала с падениями национальных валют в результате политического кризиса, вот все майнеров и обвиняют.

arheops

18.03.2018 15:39Ну как же не видно, если с декабря прошлого года скачек стоимости составил 100%+ и большая часть его изза крипты.

Просто у вас все округленно тем, что погрешность графика у вас 200% и «экспоненциальный рост цены».

ToshiruWang

19.03.2018 13:50Они не растут в цене, т.к. просто нет в наличии, кроме самых топовых. Выросли с 35к до 60к и почти исчезли из продажи в наших широтах (а теперь уже и в соседней стране).

PS. Процессоры как-то так не выросли в то же время.

MAXInator

17.03.2018 20:27Я, конечно, заподозрил, что что-то не так, примерно на «дайте сравнить», но пересилил себя. А потом автор назвал кулер с радиальным вентилятором «турбиной». К чертям таких диванных экспертов и их рассуждения.

JohnHenry89 Автор

18.03.2018 13:40Турбина — устоявшееся и закрепившееся название как для самого типа систем охлаждения, так и для характерного типа вентилятора в этих системах. Оно всем понятно и нету никаких причин применять иное.

MAXInator

19.03.2018 19:28Устоявшееся, видимо, где-то в каком-то узком кругу. Даже сленговое «крыльчатка» (применительно к кулеру) гораздо ближе и адекватнее «турбины». Так что оно не всем понятно и есть как минимум две причины применять иное — существование двухвентиляторных кулеров, более похожих на турбину, и малорастространненость названия «турбина» применительно к сабжу.

Turbojihad

19.03.2018 19:52Да все называют такую СО турбинной, хватит умничать. В английском варианте — Blower.

MAXInator

19.03.2018 21:02Ну, вас таких шестеро, значит. До «все» все равно не дотягиваете.

Turbojihad

19.03.2018 22:55+1Попробуйте ввести в гугле «видеокарта турбина», и посмотреть найденные картинки, статьи.

Посчитайте пожалуйста сколько таких там еще.

JC_IIB

19.03.2018 21:37хватит умничать

Отличный аргумент на IT-ресурсе, чо уж там. Так мы и до «чё, самый умный штоле?» докатимся.

p.s. он прав, называть эту конструкцию «турбиной» — безграмотная чушь, распространненость которой никак ее не оправдывает.

Alexeyslav

19.03.2018 23:07+1Вообще это центробежный насос. Если верить википедии, по большому счету ЭТО называется вентилятором/компрессором. Скорей всего вентилятор вне зависимости от конструкции — Вентилятор — устройство для перемещения газа со степенью сжатия менее 1,15 а до звания компрессора надо добавлять мощности прилично чтобы создать перепад давлений больше 15кПа.

Турбина, вне зависимости от конструкции, это устройство обратного преобразования — потока воздуха в механическую энергию.

Neuromantix

17.03.2018 20:33Если бы лет 20 назад кто-то пересмотрел компоновку компьютерных плат таким образом, чтобы конвективные потоки улучшали охлаждение… Хотя бы разместить видеокарту греющимися элементами вверх, чтобы они не жарились в собственном тепле (а если стоит несколько плат расширения — то все становится еще хуже). Почему-то интерфейсы и прочее менялось уже хз сколько раз, а эта дурацкая, на мой взгляд, компоновка до сих пор из 90-х откуда-то идет.

Meklon

17.03.2018 22:17+1Положите системный блок на бок)

Exchan-ge

17.03.2018 22:51-1Положите системный блок на бок)

Будет еще хуже. Проверено в эпоху всеобщего увлечения HTPC корпусами (около 2007 г.)

Именно тогда в ход пошли «слотовые» кулеры (см. ниже) — без них такие корпуса вообще превращались в «буржуйку»

keishi

18.03.2018 01:07+1Что любопытно, когда системный блок ставили на бок в первый раз, с горизонтального (типа desktop) в вертикальный (tower), компоненты плат как раз смотрели вверх (ISA/VLB на тот момент).

quwy

18.03.2018 19:42Ничего удивительного. Когда переходили с ISA на PCI, решили сэкономить одну прорезь в корпусе на стыке разных шин. Чтобы ее можно было использовать для обоих типов карт расширения. Вот тогда PCI и оказался головой вниз, а за ним и PCIe.

Exchan-ge

17.03.2018 22:27Если бы лет 20 назад кто-то пересмотрел компоновку компьютерных плат таким образом

Как раз 20 лет назад эта компоновка и была пересмотрена- на смену АТ пришел АТХ.

В качестве довода для смены стандарта как раз приводилось улучшение охлаждения элементов материнской платы и карт расширения )

Barnaby

17.03.2018 23:07Это все из-за плоского PCI-E. Когда его заменят на что-то современное тогда и будут клепать видюшки любой массы и размера, хоть на 1000 Ватт.

Exchan-ge

17.03.2018 23:17Это все из-за плоского PCI-E. Когда его заменят на что-то современное тогда и будут клепать видюшки любой массы и размера, хоть на 1000 Ватт

Скорее всего — перейдут к исполнению мощных видеокарт в виде отдельного выносного блока со своим охлаждением и питанием.

И тогда в основном системнике снова станет тихо, прохладно, сухо и комфортно.

(Да и сам системник будет много меньше по размерам, чем внешняя видеокарта )

Alex_Q

18.03.2018 02:15Тогда столкнутся с проблемами индуктивности и наводок в PCI-E или что там его заменит.

15432

18.03.2018 02:59Уже есть внешние боксы под видеокарту. С охлаждением и всем прочим. Подключаются по Thunderbolt.

JC_IIB

18.03.2018 04:00Да, только сам бокс пустой стоит как видеокарта миддл-класса.

Kain_Haart

18.03.2018 08:21У Gigabyte есть модели «Gaming box» идущие с внешним боксом в комплекте и по вполне сопоставимой цене

Konachan700

18.03.2018 23:24Так сколько этих боксов делают, десятки тысяч в год в лучшем случае… Вот и цена высокая. Будут тиражи в миллионы — бокс будет стоить копейки.

JohnHenry89 Автор

18.03.2018 13:47Увы, его еще не скоро заменять. Старый AGP заменяли, заменяли, но у меня не могли не вызывать улыбки, даже через 10 лет после замены AGP, шины PCI-E на средних видеокартах с уменьшенным числом контактов. PCI-E все еще глубоко избыточен для современных игровых требований.

JohnHenry89 Автор

18.03.2018 13:44ATX, да, безусловно устарел. Его проблема в том, что стандарт разрабатывался когда тепловыделение всего компьютера шло максимум на 100Вт, а блоки питания в 230Вт считались мощными и достаточными. Когда сейчас тепловыделение во время нагрузки подскакивает выше 300Вт, он создает трудности для охлаждения. Ну и плюс башенные кулеры которых не было тогда.

Вообще я сам по себе твердый сторонник полностью открытого корпуса, без всяких крышек, собранном полностью на алюминиевом профиле. Пусть даже расположение компонентов остается ATX.

balamutang

18.03.2018 15:23+1Дык интел придумали BTX, в том числе и для того чтоб оптимизировать охлаждение. Но как-то не пошло и сам же Интел все это свернул первый

irnis

18.03.2018 21:02охлаждение воздухом всяко имеет ограничение по плотности отводимой мощности…

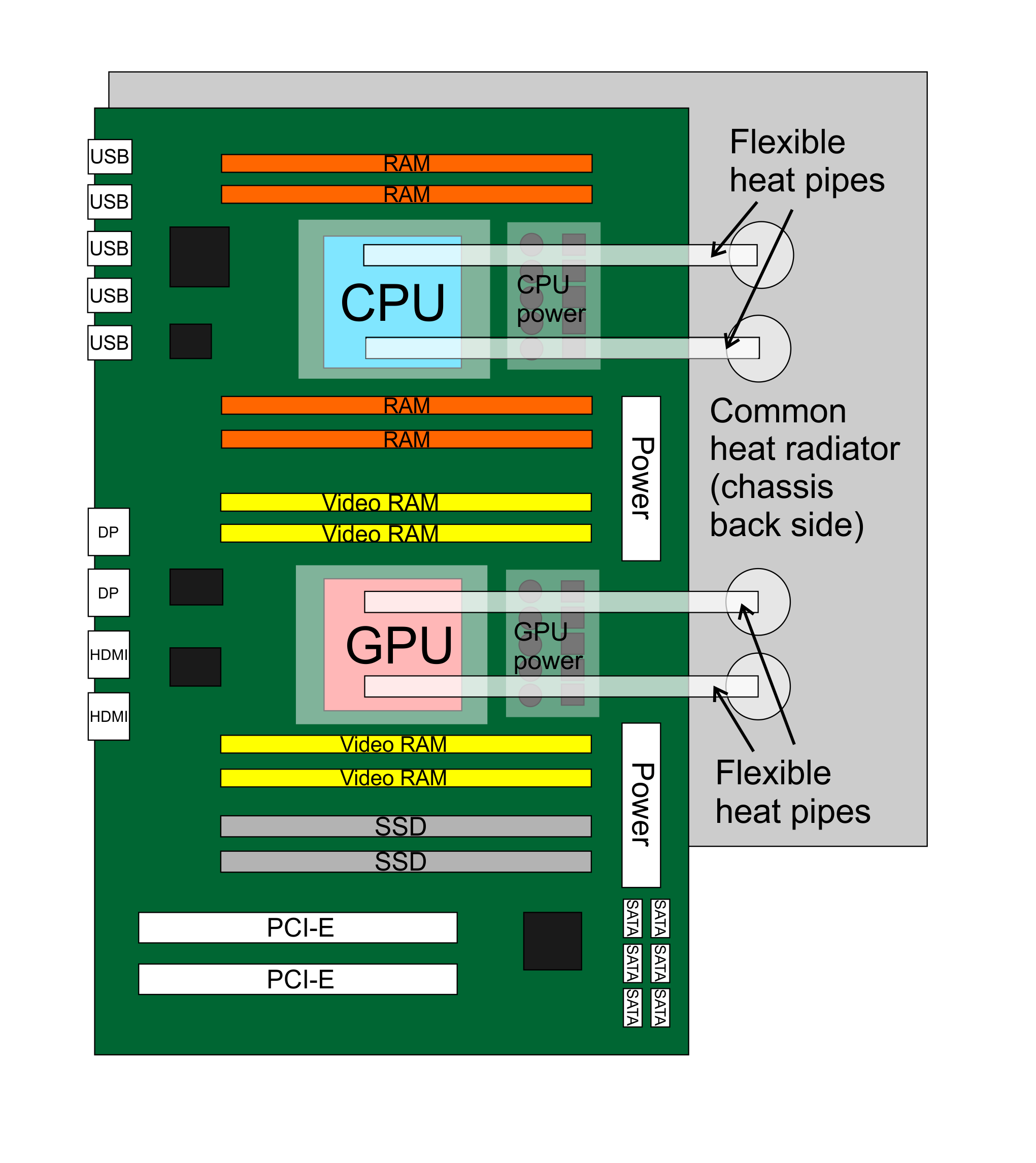

если бы разработали стандарт для плат с двумя сокетами — для CPU и GPU и годный для удобного жидкостного охлаждения…

JohnHenry89 Автор

18.03.2018 21:04Однако принципиально жидкостное охлаждение слабо отличается от воздушного — все равно воздух продувается вентилятором через радиатор. Отличается лишь теплоноситель и в СВО появляется возможность вынести радиатор с вентилятором подальше, в более удобное место. А так-то там все тоже самое.

irnis

18.03.2018 21:38да, но например, радиатор можно будет вынести на заднюю стенку корпуса и сделать его на всю высоту. Или задействовать холодную воду из водопровода :), или в свете современных «зеленых» тенденций — «сливать» это тепло в тепловой аккумулятор дома (это для частных домов, разумеется).

Или наоборот — расточительный, но компактный в плане места вариант — охлаждать теплоноситель элементами Пельтье, более высокая температура выносного радиатора позволит более эффективно отдавать тепло при меньших размерах, но за счёт того, что и радиатор будет сколько-то потреблять :)

Про то, что при этом кардинально улучшится температурный режим внутри корпуса, я уже и не говорю.

Ниже, кстати, почти один в один предложили вариант — geektimes.ru/post/299135/#comment_10670797 :)

JohnHenry89 Автор

18.03.2018 21:50Или задействовать холодную воду из водопровода

Я на полном серьезе рассматривал эту идею, вода-то не по счетчику. Меня остановили прежде всего цены на ватерблоки тогда ну и плюс если не будет воды, не будет и компьютера. А в остальном все несложно — фильтр из ваты против взвешенных частиц, трубки с катионитом и анионитом, на выходе деминерализованная вода.

или в свете современных «зеленых» тенденций — «сливать» это тепло в тепловой аккумулятор дома

По секрету — 400Вт которые валят из самого горячего ЦП и видеокарты мало для обогрева даже небольшого помещения. Они только летом хорошо подогревают воздух, когда в нем под 35 град.

Или наоборот — расточительный, но компактный в плане места вариант — охлаждать теплоноситель элементами Пельтье

Но это опять-же слишком дорого, даже с пост-советскими ценами на электричество. У элемента Пельте КПД ок. 30%, так что для охлаждения устройств с тепловыделением 400Вт нужна 1.2 кВт батарея элементов Пельте.

Про то, что при этом кардинально улучшится температурный режим внутри корпуса, я уже и не говорю.

Обдумывая все это я пришел к идее полностью открытого корпуса, без каких либо стенок. Уже год эксплуатирую черновой вариант, в конце лета наверняка соберу себе окончательный вариант из оксидированного и окрашенного в черный цвет алюминиевого профиля, специальных пластиковых уголков для него и даже не поленюсь заворонить стальной крепеж в смеси NaNO3 и NaOH.

Я считаю, что полностью открытый корпус — лучшее что сейчас можно сделать из реального.

Ниже, кстати, почти один в один предложили вариант

Я видел. Влияние ноутбучных технологий прослеживается. На практике несложно сделать почти тоже самое если взять вместо тепловых трубок общую СВО.

irnis

19.03.2018 00:20> Меня остановили прежде всего цены на ватерблоки

да, из-за того, что водяное охлаждение считается чем-то элитным — цены на компоненты запредельные. А было бы это чем-то массовым — было бы совсем другое дело.

> если не будет воды, не будет и компьютера.

если не будет электричества — тоже :), а теплоёмкость у воды неплохая, чтобы воду в офисном кулере 20л нагреть на 20 градусов — надо полкиловатта в течении часа…

> 400Вт которые валят из самого горячего ЦП и видеокарты

> мало для обогрева даже небольшого помещения

это я понимаю.., но сам смысл «зеленых» технологий именно в том, чтобы собирать «уходящее» тепло везде понемногу — на вентиляции, на сточных водах, на охлаждении компа…

> что полностью открытый корпус — лучшее что сейчас

> можно сделать из реального.

есть мнение, что это не так — в открытом корпусе очень сложно управлять воздушными потоками. Как-то видел даже статью о том, что для тех же майнинговых ферм лучше ставить ограничители, которые разделяют воздушные потоки и гарантируют, что к каждой видеокарте подводится холодный воздух «снаружи», а не уже подогретый соседом.

> На практике несложно сделать почти тоже самое если взять

> вместо тепловых трубок общую СВО.

опять же всё упирается в массовость и, соответственно, в цену, да и то, что сокеты CPU и GPU лежат в ортогональных плоскостях, делает систему «сильно трехмерной», а будь они в одной плоскости — система получилась бы более компактной.

JohnHenry89 Автор

19.03.2018 13:50если не будет электричества — тоже :), а теплоёмкость у воды неплохая, чтобы воду в офисном кулере 20л нагреть на 20 градусов — надо полкиловатта в течении часа…

Дык 20 литров-то. В случае с проточной водой главное преимущество — не нужно охлаждать теплоноситель. Ну и в конце концов пойду я помыться — напор-то упадет, а бывают моменты когда напор вообще слабый и его хватает только на включение колонки. Тогда опять-же компьютер становится нефункциональным.

есть мнение, что это не так — в открытом корпусе очень сложно управлять воздушными потоками.

Там в этом необходимость отпадает. Во-первых, каждый компонент имеет свое воздушное пространство и его кулер охлаждает именно его. Во-вторых, в отличии от закрытого корпуса, вокруг всегда находится неограниченный объем свежего холодного воздуха.

опять же всё упирается в массовость и, соответственно, в цену, да и то, что сокеты CPU и GPU лежат в ортогональных плоскостях, делает систему «сильно трехмерной», а будь они в одной плоскости — система получилась бы более компактной.

Однако, дело как раз в том, что мы возвращаемся как раз к ATX, просто с системой водяного охлаждения.

oren

17.03.2018 20:36+3Первые поколения распространенных графических ускорителей обходились даже без радиаторов, как мы видим на примере S3 Trio

У вас неточность в сравнениях. S3 Trio была 2D ускорителем.

3D/2D ускоритель тех времён выглядел вот так:

Exchan-ge

17.03.2018 22:36У вас неточность в сравнениях. S3 Trio была 2D ускорителем.

3D/2D ускоритель тех времён выглядел вот так:

Voodoo Rush вышел в 1997, когда S3 Trio (пик популярности — 1995) уже была архаизмом

(в реалиях ВТ того времени — год надо считать за пять нынешних )

dimanhursky

18.03.2018 10:40Жаль что ISA видео адаптер не сохранил. Тоже монстры были. Потом микроэлектроника их маленькими сделала.

Ну на фото разница 10-12 лет от 1995 к 2007 году. Обычная видуха и 3Д комбайн.

tSmoker

19.03.2018 10:57+1Вы в какой стране жили, если не секрет?

В 1997 и на 486-ом можно было комфортно жить, не говоря уже о «устаревшей» S3 Trio, о производительности видеокарт в те времена массовый покупатель вообще не думал. Тогда оперативки бы не 8 а 16Мб… вот это да — апгрейд. А видеокарта — просто есть и всё.

Exchan-ge

20.03.2018 01:13В 1997 и на 486-ом можно было комфортно жить

Всегда есть люди, готовые жить и работать в спартанской обстановке.

Но «486» и «комфорт» для 1997 года уже не были синонимами.

1997 — это время TX97-E i430TX и Pentium 266MMX. Да и память к этому времени подешевела, насколько я помню. Плюс винты уже были от 1,6 Гб (Caviar AC31600) до 3,2 Гб (Caviar AC33100).

tSmoker

20.03.2018 01:32Я в смятении, серьёзно. Судя по тому, что вы игнорируйте мой вопрос о стране проживания, вы наверное жили в России и наверное в Москве.

Я сам просто в Москве не жил, и может у вас там в 1997 (а особенно в 1998, август, да) и покупали массово новые процессоры на старте продаж… может быть, но поверьте остальная страна жила по другому. И еще раз повторю — массовый покупатель не смотрел на видеокарту вообще (она просто была и всё), максимум учитывалась доступность драйверов в условиях недоступности интернета.

… для кого-то просто любой «персональный компьютер» и «комфорт» уже были синонимами. Но я понимаю что страна в 90-ых оч по разному жила.

JohnHenry89 Автор

20.03.2018 01:34+1Но я понимаю что страна в 90-ых оч по разному жила.

А сейчас нет?

dragonnur

17.03.2018 22:38можно вспомнить Virge 3d

Exchan-ge

17.03.2018 23:05можно вспомнить Virge 3d

Разве что в контексте появления термина «видеоускоритель» и «3D» применительно к видеокартам.

3D, как явление — появилось в 1996 г., вместе с Voodoo Graphics.

Я еще помню восторги по этому поводу в «Мире игрушек» и как чертыхались люди, купившие себе перед этим довольно дорогие видеокарты, на которых из 3D-игрушек ничего не запускалось )

Но Voodoo Graphics было редким и дорогим удовольствием, и 3D реально пошел в массы как раз начиная с более дешевого и глючного Voodoo Rush.

vaim

17.03.2018 20:38вспомнился мой радеон 9800SE успешно разлочившийся и получивший сверху Zalman ZM80C-HP. Это был 2003 или 2004 год, примерно. Под DOOM 3 комп апгрейдился.

Картинки отсюда

JohnHenry89 Автор

18.03.2018 13:49Однако по современным меркам все равно СО кажется слабой.

vaim

18.03.2018 14:22Но тогда то она была зашибись, позволяла нещадно гнать. Опять же это сейчас мы тепловыми трубками зажрались, а тогда у меня в компе стоял вот этот монстр и на проце scythe katana, что, в целом, было редкостью. Родной радиатор на 9800 был по сегодняшним меркам вообще смешон.

JohnHenry89 Автор

18.03.2018 15:14Мне вообще всегда было интересно на что способны видеокарты тех поколений с современным СО. Тут проблема только в том, что программно вольтмод не так просто на них сделать.

У меня в те времена, кстати была Сапфировская Radeon 9600.

vaim

18.03.2018 15:27А смысл? Для экстремального разгона тогда и водой охлаждали и жидким азотом.

Опять же сегодня агпшная карта? ну не знаааююю...

JohnHenry89 Автор

18.03.2018 15:29Ради эксперимента, просто посмотреть на что они способны даже задним числом. Но речь идет скорее не об экстремальном разгоне, а об обычном разгоне с умеренным, разумным, повышением напряжения.

vaim

19.03.2018 14:23ну, тогда, флаг в руки.

именно по 9800se в плане вольтмода особых проблем не наблюдается

JohnHenry89 Автор

19.03.2018 14:2710% по частоте всего при повышении напряжения вдвое (а тепловыделение вообще в кубе вырастет) — не очень хороший результат. Но в смысле техноблогинга тема благодатная — старые видеокарты продаются чуть ли не на вес, а потому доступны. И их не жалко если что.

vaim

19.03.2018 18:21ну вот я повторю: 9800SE, разлочка, залман вот этот и на память радиаторы наклеил алсилом, вентилятор залмановский вполне удачно весь этот конструктив обдувал, позволяя гнать. Вольтмодом не морочился.

Conscience

17.03.2018 21:45Прогнозы ниочень, вы совершенно не учитываете развитие облачных сервисов (GeForce Now например).

pda0

18.03.2018 01:08+2Что-то я не верю в них. Попытки вернуться к модели мейнфрейм-терминал предпринимаются с 90-х (если не раньше). Увы, все мечтатели забывают о том, почему от этой модели ушли. Латентность сети всегда будет выше локального устройства. Плюс, первопроходцы виртуальных игровых консолей не учли, что пережатие картинки для стримминга замылит её и снабдит артефактами, на что обращали внимание все, кто пробовал пользоваться этими сервисами.

Плюс аппаратные консоли, с их железом ниже себестоимости. Плюс из-за паритета в железе с PC, консоли уже выходили слабее, чем топовые PC на момент их выпуска. Но игроделы оказались вынуждены подстраиваться под них, тем самым ограничивая аппаратные требования.

Т.е. целевой аудиторией облачного гейминга оказалась очень странная прослойка людей, которые имеют компьютер с Intel вместо видеокарты, не имеют приставки, но хотят играть. А если вспомнить про ограничение требований под консоли, то уже через пару лет после выпуска очередного поколения, проблема «поиграть» решается покупкой самой бюджетной видеокарты, которая там не менее перекроет по качеству картинки и латентности облачный сервис.

farcaller

18.03.2018 01:29> которые имеют компьютер с Intel вместо видеокарты

или мак головного мозга

На самом деле я в восторге от GeForce Now — можно спокойно побегать в современный шутер на рабочей машинке. Не надо игровое железо. Работает в командировке. Ну это все правда пока оно бесплатно (впрочем Parsec + AWS не сильно дорогой)

pda0

18.03.2018 13:14Ну, здорово, что это вам помогает. Но по моему мнению, командировочные, хотящие поиграть и те, у кого есть время играть на работе — слишком маленькая клиентская база, чтобы оправдать содержание дорогого железа. По крайней мере все предыдущие попытки открыть такие сервисы закрывались именно по причине низкой популярности.

Areso

18.03.2018 13:33Закрывались они и по другим факторам. Во-первых, во многих нужно было или покупать игры заново, или играть в то, что дают по подписке. Во-вторых, никаких модов. В третьих, высокие сетевые задержки. Наконец, командировочные (особенно вахтовики) часто работают в таких местах, где интернет работает медленно, видеопоток по такому соединению не передать.

Из условно отечественных: Playkey и Loudplay. Первый, правда, Linux до сих пор не поддерживает как клиента, а жаль.

Наконец, я знаю как минимум двух человек, отказавшихся от облачного стриминга, потому что он пережимает аудиопоток с большими потерями(!). Как хорошо, что я не меломан)

Кроме латенси, тут другая модель: OPEX vs CAPEX. Вот так взять и вывалить тысяч 50 за игровой компьютер могут далеко не все работающие люди, а платить подписку — около тысячи рублей в месяц — доступно даже студентам и школьникам (хоть и не всем).

farcaller

18.03.2018 17:02Тот же GeforceNow не содержит железо, а арендует у Amazon. Естественно какую-то часть они бронируют на долгие периоды для снижения стоимости, но в целом расходов по железу у них нет. А что делать с видеокартами амазону — это проблема амазона уже.

JohnHenry89 Автор

18.03.2018 13:50Их невозможно учитывать т.к. никакого влияния они пока не оказывают на рынок.

Conscience

18.03.2018 15:14+1Майнеров тоже никто не учитывал, а потом бабах, и средние видяхи по 500 баксов.

ClearAirTurbulence

17.03.2018 22:34«Быстрый выход из строя видеокарт при майнинге, происходящий задолго до истечения гарантийного срока, подтверждает эти выводы.»

Странно в очередной раз слышать это предположение (если это факт, просьба дать пруфы). Особенно учитывая, что (а) часто для техники предпочтителен постоянный режим работы, и (б) для майнинга карты часто подвергают андерклокингу.

Marwin

17.03.2018 22:57имею опыт сгорания карты с андерклокингом… понятно, что 1 карта — не показатель, но всё же интересно. Сгорела гигабайтина 1070 после примерно полугода майнинга. Пара резисторов на цепях питания. Перепаяли, поставил обратно на 70% TDP уже в другой комп. Температуры были на ~15-20 градусов ниже. Один фиг через месяц перегорели еще пара резисторов в другом месте.

stalinets

18.03.2018 01:39У меня тоже было в своё время. Майнил на разогнанной Radeon 5770, сначала через несколько месяцев пошли артефакты, потом вообще отказалась стартовать. Поменял на 7770, тоже разогнал (но менее люто), помайнил на ней ещё несколько месяцев, пока сложность не сделала это невыгодным, и эта карта и сейчас работает у меня.

JohnHenry89 Автор

18.03.2018 13:52Но ведь видеокарты при майнинге ломаются чаще чем при своей стандартной работе. Факт?

slonopotamus

18.03.2018 14:18Вы сейчас сделали некоторое утверждение и хотите чтобы оппонент нашел ему подтверждение? Это так не работает. Но статья интересная, спасибо.

JohnHenry89 Автор

18.03.2018 15:12Спасибо.

Нет, я вполне серьезно спрашиваю насчет того факт ли это или нет. Просто если бы лично меня спросили о выходе из строя видеокарт при майнинге, я бы все-таки отнес это явление к факту.

TrllServ

19.03.2018 04:12Можно ли считать проданные недавно 3шт 780 отработавшие 24/7 почти 3 года опровержением?

JohnHenry89 Автор

19.03.2018 14:13Можно конечно. Поразительно.

Hellsy22

19.03.2018 19:55Почему? Равномерная нагрузка, чаще всего еще и в температурном режиме до 80 градусов. Карты регулярно чистят.

JohnHenry89 Автор

19.03.2018 20:42Все равно ахиллесовой пятой видеокарт являются элементы системы питания, очень часто транзисторы выгорают.

Mad__Max

20.03.2018 07:25Это скорее норма.

У меня из 10 карт еще 7 штук вполне живы после больше 4 лет почти непрерывной круглосуточной работы под полной нагрузкой (около 2х лет майнинг, дальше научные распределенные вычисления в основном).

Причем 3 шт накрылись в первые год-полтора работы — отсеился брак, а прошедшие отсев с тех пор работают без проблем.

В одной производитель вместо смазки в вентиляторах применял какое-то дерьмо, которое при длительных работах при повышенных температурах густело до тех пор пока вентилятор не «вставал колом» — в холодном виде даже пальцем с трудом можно было провернуть (вот кто-то бы мог подумать что для смазки деталей изначально предназначенных для охлаждения горячих чипов нужно использовать смазку не боящуюся высоких температур?!)

Можно было бы не сложно починить (поменять вентиляторы или даже попытаться разобрать и спазать), но я сдал это дерьмо обратно производителю и получил деньги назад.

В 2х других что-то выгорело в цепях питания.

vitalyvitaly

18.03.2018 00:33Автору повезло, что он не видел полноразмерных плат CGA или EGA в исходном виде, или например более древний S3 928, или например IBM PGA. Со временем всех этих упаковали в мелкий чип, но конечно далеко не сразу. Вероятно, так будет и в будущем, если вообще будут отдельные бюджетные видеокарты. Но альтернативных производителей чипов больше нет и чем дальше, тем больше рынок бюджетных карт превращается в зоопарк доисторической эпохи — вот у нас в магазинах электроники год за годом продают Geforce 210, Radion 6450 и компанию, причем в коробках без указания на этот факт, а под названием вроде «Супер Мега Video Card». Грустно это.

keishi

18.03.2018 01:21+1полноразмерных плат CGA или EGA в исходном виде, или например более древний S3 928, или например IBM PGA.

Как-то так?

Mad__Max

20.03.2018 07:30Да, типа такого.

В моем первом x86 компьютере CGA карта под ISA шину по размеру была равна материнской плате (и располагалась прямо над ней формируя «2й этаж» и соединяясь с материнской платой через «елочку»). Еще даже больше чем на этом фото (длина примерно такая, только шире).

Следующая (сразу VGA минуя EGA) была уже раз в 5 меньше по размеру.

Deaddy

18.03.2018 08:40Да, помню, специально для таких карт были направляющие на передней стенке корпуса.

Exchan-ge

18.03.2018 10:32Автору повезло, что он не видел полноразмерных плат CGA или EGA в исходном виде

Карты для VESA local bus тоже не были маленькими, но встречались чаще.

Cirrus Logic CLVGA542XVL/H

JohnHenry89 Автор

18.03.2018 13:54Однако-же их никто и не покупает сейчас. Но в нынешней ситуации да, все взгляды устремлены на Авито и вторичный рынок.

firk

18.03.2018 18:04Что тут грустного? Видеокарты достигли разумного максимума, который от них требуется для бытовых нужд, ещё более 10 лет назад, вот и продают одни и те же модели. И скажите спасибо, что их вообще продают, а не предлагают вместо них всякий навороченный «современный» игровой шлак задорого и безальтернативно.

vitalyvitaly

19.03.2018 10:47+1Моя бюджетная плата 10 лет назад — это Geforce 7100GS, с ним как-то было совсем уж уныло, тем более, что попался китайский вариант карты с 32-разрядной(!!) шиной (были сильные подозрения, что там именно 32 бита). Абсолютная бутафория…

Hellsy22

18.03.2018 00:50давайте оценим ее

«Давайте сравним садовую тачку и Белаз...»

Почему бы вам не сравнить S3 Trio с современными интегрированными видеокартами?

Напрашиваются следующие выводы:

1. Автор сравнивает теплое с мягким.

2. Если уж сравнивать мощность, то лишь удельную — на единицу производительности при равных задачах.

3. В линейке Nvidia хорошо прослеживается тренд отношения производительности к потребляемой мощности:

GTX 670 (170W, 5.4k pm) = 32

GTX 770 (230W, 6.1k pm) => 26 — тот же техпроцесс, что и в 670 (28нм)

GTX 970 (145W, 8.5k pm) = 59

GTX 1070 (150W, 11k pm) = 73

Nikobraz

18.03.2018 06:25Еще ярче пример с x50 линейкой

(в качестве мерила производительности использовал результат в 3DMark11 с процессором i5-2500 на штатных частотах)

GTS 250 (150W, 2.5k) = 16.6

GTS 450 (106W, 2.5k) = 23.5

GTX 650 (65W, 3.5k) = 53.8

GTX 750 (55W, 5.5k) = 100(таже архитектура и техпроцесс, что и у 950)

GTX 950 (90W, 9k) = 100

GTX1050 (75W, 9.8k) = 130.6

JohnHenry89 Автор

18.03.2018 14:00Почему бы вам не сравнить S3 Trio с современными интегрированными видеокартами?

Потому что это разные устройства.

1. Автор сравнивает теплое с мягким.

Где? Однако же при желании можно и материю с энергией сравнивать, почему бы и нет.

Если уж сравнивать мощность, то лишь удельную — на единицу производительности при равных задачах.

Чтобы собрать такие данные нужно не просто обладать горой видеокарт и полугодом времени. Нужно еще и обладать неким тестом, который не будет оказывать преференций не GeForce не Radeon.

В линейке Nvidia хорошо прослеживается тренд отношения производительности к потребляемой мощности

А теоретическая производительность у них разная, вот и все. За счет этого у них есть экспоненциальный рост отношения производительности к TDP. Значит, 970 и 1070 поспевали еще кое-как за требования рынка, а 770 нет (очевидно кстати).

EviGL

18.03.2018 01:17Всегда было интересно, почему производители процессоров не подхватили эту эстафету: сделать всё огромным, жрущим кучу электричества и более быстрым?

Тот же i7 от поколения к поколению прирастает этак на 10% производительности. Как такое продавать? Если купили топовый i7 первого поколения, то можно и сидеть на нём по сей день. Где же тут гнусный маркетинг?

Почему не сделать процессор большим или не ввести в консьюмерский рынок многопроцессорные системы? Рассказать как это круто-модно, добиться поддержки виндой.

Наверняка есть какая-то логичная причина, почему так не делают?

stalinets

18.03.2018 01:41Ну у AMD не так давно был процессор с TDP 220 Вт. Кто-то покупал его)

vitalyvitaly

18.03.2018 01:48Топовые Прескотты П4 были жуткими печками. i7 первого поколения немного не дотягивает, там всего лишь 130 Вт. Мультипроцессорность кстати поддерживал еще Intel 8086.

stalinets

18.03.2018 02:50Вроде самыми горячими тогда были Pentium D, это ведь два ядра Prescott в одном проце.

vitalyvitaly

18.03.2018 08:30Скорее всего о них я и вспомнил, уже Socket 775, последнее поколение перед Conroe. Что-то из серии Presler 960.

JohnHenry89 Автор

18.03.2018 14:03Я кстати думал купить что-то из 9-й серии FX, почему бы и нет. Но потом решил, что FX8350 и так можно разогнать до частот 9-й серии при повышении напряжения. Кристаллы-то одни и те же.

Marwin

18.03.2018 01:46потому что не производители процессоров решают, какие процы продавать. А потребности консьюмерского софта. Который совершенно прохладно относится к тем самым огромным и жрущим кучу электричества процам, которые уже благополучно работают в серверах. Вы и сейчас вполне можете купить 28 ядерный 200 ваттный xeon. Но толку-то от него дома?

PS ну а то, почему консьюмерский софт прохладно относится к огромным процам — банальная техническая невозможность дальнейшего роста тактовых частот на ядро процессора. А в мультиядра консьюмер софт (за исключением рендеринга видео части) пока не придумали как просто раскладывать.

Kain_Haart

18.03.2018 08:27Firefox с их переходом на Servo вроде вполне успешно начали освоивать многоядерность

Marwin

18.03.2018 12:38с таким же успехом, как Хром с отдельным процессом на вкладку. Но это же капля в море. Всё равно модель использования браузера — одна активная вкладка, и распараллелить её рендеринг можно всего лишь на пару-тройку потоков (браузерный майнинг в расчёт не берем ))) В играх та же история, 4-8 активных потока пока максимум, на что получается разложить функции движка. Это ничто по сравнению с возможностью раскладывать рендеринг картинки на тысячи (а в теории хоть миллионы, лишь бы размер экрана был таким большим) независимых фрагментов в видеокарте под каждое ядро в чипе. До тех пор пока существует идеологическая разница в подходе к раскладыванию задач вычислений у процов и видеокарт, монструозных процов можно не ждать ))

dzikar

18.03.2018 13:16Игра на юнити Stationeer раскорячила мой проц 28 потоками. Так что подвижки есть в многопотоке.

xMushroom

18.03.2018 16:53Опять же, зависит как использовать эти потоки. Очень может статься, что 27 потоков 100 условных единиц времени ждут 28-го, 1 единицу работают, потом опять ждут. Формально 28, но толку от такого распарелелливания мало.

sumanai

18.03.2018 16:22Почему все упорно считают, что утилизировать много ядер можно только несколькими процессами? По крайней мере в Windows планировщик работает на уровне потоков, и одним процессом можно утилизировать любое количество ядер.

a5b

18.03.2018 02:03Если кристалл жрет много электричества, то всю полученную энергию с кпд около 100% он превращает в тепло. А отводить сильно больше 100-200 Вт с площади кристалла в сотни кв.мм не получается.

См. Harnessing the Four Horsemen of the Coming Dark Silicon Apocalypse и другие публикации Dark Silicon: https://en.wikipedia.org/wiki/Dark_silicon ftp://ftp.cs.utexas.edu/pub/dburger/papers/ISCA11.pdf http://darksilicon.org/

The study shows that regardless of chip organization and topology, multicore scaling is power limited to a degree not widely appreciated by the computing community.…

While transistor dimensions continue scaling, power limitations curtail the usable chip fraction. At 22 nm (i.e. in 2012), 21% of the chip will be dark and at 8 nm, over 50% of the chip will not be utilized using ITRS scaling

Neither CPU-like nor GPU-like multicore designs are sufficient to achieve the expected performance speedup levels. Radical microarchitectural innovations are necessary to alter the power/performance Pareto frontier to deliver speed-ups commensurate with Moore’s Law.Увеличивать площадь чипов сложно и дорого (но делают всяческие сверхдорогие Xeon/Xeon Phi, в т.ч. на 200-300Вт и Виндой на 64+ ядрах с площади в 683 мм2).

Размер чипов и микросборок на Silicon Interposer ограничен (максимальный размер одного кристалла задается лимитом степперов. У всех производителей ASML, Nikon, Canon — степпер засвечивает за 1 проход "Field Size" — не более чем 26x33 мм=850 кв.мм., у EUV заявлены те же 26x33).

Есть варианты и продукты с использованием микросборок без Silicon Interposer на всю площадь — EMIB от Интела, MCM(MCM-L?) у AMD c EPIC. Некоторые считают, что оптику следует интегрировать ближе к чипу, чтобы можно было создавать многочиповые решения/снижать затраты энергии на передачу данных.

JohnHenry89 Автор

18.03.2018 14:06Да. Xeon Phi кстати стоит смешные для себя деньги на вторичном рынке, крайне жаль только что практически его применить обычному человеку абсолютно некуда. Тем не менее, Xeon Phi, если бы его можно было применять, был бы чудесным решением для большинства пользователей — его мощи при небольшом TDP и избытке оперативки хватило бы еще очень на долго.

DustCn

19.03.2018 02:04+1Тут про троллейбус из буханки только в голову приходит.

У видяхи мощи больше, при сравнимом TDP, если в абсолютных цифрах.

Для домашнего применения он малоприменим, жует он только красиво распараллеленый и векторизованный код, на обычном ветвлении или скалярном коде его производительность хуже i3 будет.

JohnHenry89 Автор

19.03.2018 13:58Нет, конечно Xeon Phi не может заменить видеокарту т.к. последняя строго оптимизирована для 3d вычислений, никакой ЦП с ней тягаться не может по определению. Речь идет об использовании Xeon Phi в качества дополнения к основному ЦП и основной памяти. За те деньги которые он стоит на вторичке и с его громадной вычислительной мощью, объемом памяти и т.д. это была бы замечательная покупка, будь ей применение.

Hellsy22

18.03.2018 18:08Ну как не подхватили:

Pentium 200 — 15.5W

Pentium II 450 (250нм) — 27.1W

Pentium III 1133 (180нм) — 39.55W

Pentium 4 HT 3.4 (130нм) — 89W

Pentium 4 HT 3.8 (90нм) — 110W

Pentium D 960 (65нм) — 130W

Core 2 Extreme QX9775 (45нм) — 150W // и вот это похоже предел

Core i7 3970X Extreme Edition (35нм) — 150W

Core i7-5960X Extreme Edition (22нм) — 140W

Core i7-6950X (14нм) — 140W

JohnHenry89 Автор

18.03.2018 21:54125Вт, скорее всего, предел для ЦП при их создании т.к. 140Вт будут уже создавать проблемы — тепла много, цепи питания в мат.платах слабые и т.д.

EviGL

18.03.2018 22:09Ну я имею в виду скорее то что с Core происходит. До неё всё в порядке было с быстрее-выше-сильнее, понятно было, что не обновишься — пролетишь.

А в этом году будет 10 лет первым i7 и по сути можно так на них и сидеть всё ещё.Hellsy22

19.03.2018 06:19Intel Core i7-975: 45нм, 2009г, 130W ~600$, 6133 cpumark

Intel Core i7-7820X: 14нм, 2017г., 140W, ~450$, 18646 cpumark

Полагаю, что скорость процессора перестала так уж сильно влиять удобство работы с компьютером — для типовых задач хватает с запасом. А те, кому нужна высокая производительность (3D-графика, работа с видео), часто смотрят в сторону серверных многопроцессорных решений или специализированного железа.

Areso

19.03.2018 21:53Да, но это привели топ сегодняшний.

А если взять начальный уровень, то, к примеру, современный G4560 4899 cpumark-попугаев. Или i3-7100 — 5811. Так что купив систему с процом за 600 зелени, вполне можно и сегодня комфортно ощущать. И Лишь i5-7400 и i3-8100 обгоняют пожилого старичка, да и то, не настолько радикально, чтобы побежать за ними с криком Shut up and take my money.Hellsy22

20.03.2018 04:10G4560 — 54W

i3-7100 — 51W

Это процессоры с пониженным энергопотреблением и интегрированной видеокартой. Для ноутбуков, в общем.

i5-7400 — 65W, i3-8100 — 65W и тоже интегрированные видеокарты.

Если у вас нет цели радикально снизить энергопотребление, например — для перехода на пассивное охлаждение, то разумеется нет смысла менять мощный хоть и устаревший десктопный процессор на экономичный, но слабый современный.

JohnHenry89 Автор

19.03.2018 22:56-1Как сказать. Напр. i3 вне зависимости от поколения и индекса я нахожу весьма неудобными в работе из-за способности грузиться на 100% без причины и с причиной. Бенчмарк это одно, реальная работа другое, а игры третье.

vitalyvitaly

19.03.2018 10:52Там есть возможность дешевого апгрейда на Six-Core Xeon 56xx — по скорости примерный аналог i7 поколения Ivy Bridge, то есть еще на пару-тройку поколений вверх.

rogoz

19.03.2018 14:05+1Core 2 Extreme QX9775 (45нм) — 150W // и вот это похоже предел

i9-7980XE (14нм) — 165W

Threadripper 1950X (14нм) — 180W

Xeon 8168 Platinum (14нм) — 205W

FX-9590 (32нм) — 220W

ToshiruWang

19.03.2018 14:45Ответ прост — тепловыделение. отвод тепла из центра кристалла — та ещё задача.

Почему не сделать процессор большим

Цена и отвод тепла. Это очевидно.

или не ввести в консьюмерский рынок многопроцессорные системы?

Цена X2 за плату, цена X2 за пару процессоров, отсутствие каких-то реальных приложений, способных загрузить 16 ядер в быту (хотя можете взять 8е поколение — там 6-8 ядер не в X-серии).

добиться поддержки виндой.

Можете просто сменить свой 3.11 на что-то посовременнее — там поддержка есть.

dron41k

19.03.2018 17:17Где-то видел предположение, что у Интела скорость роста производительности резко замедлилась с 2008, это последний год, когда у АМД был конкурентоспособный топовый проц.

stalinets

18.03.2018 01:32Мне вот как человеку, очень редко собирающему новые компьютеры, интересно, что сейчас происходит со встроенной в процессоры графикой.

Одно время, с появлением у AMD серии FX, вроде вообще процов без графического ядра почти не осталось. И у Интела, и у АМД массово шли процы со встроенным видео. Но вот новые Райзены и Тредрипперы без графики же?

Раньше считалось, что встроенная графика в процах AMD мощнее, чем в процах Интела, это следствие ещё со времён покупки ATI. А что сейчас?

Если я соберу игровой компьютер с дискретной видеокартой и процессором с видеоядром, как они взаимодействуют сегодня? Объединяют вычислительную мощность? В норме работает ядро проца, а под нагрузкой сама включается дискретная видеокарта? Или это надо переключать в биосе? А если проц и видеокарта от разных производителей, скажем, проц AMD со встроенной графикой, а видеокарта nVidia?

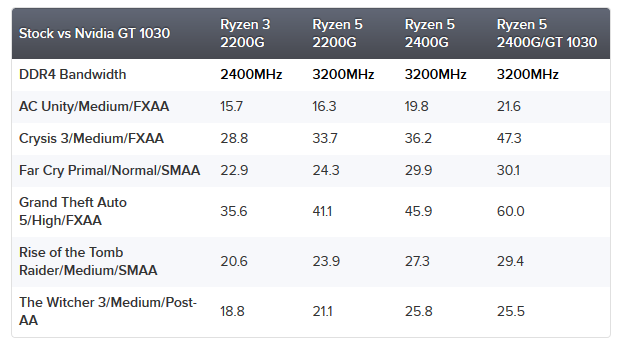

Если я захочу собрать максимально приближенный к игровому комп не покупая видеокарту, полагаясь только на видеоядро процессора, на какие модели смотреть? Что сможет такой комп, какие известные игры в каком разрешении потянет (примерно)?

Как сейчас связано наличие встроенной графики в процессоре и наличие видеовыхода на самой материнке? То есть может ли быть ситуация, что на материнке стоит сокет для процессора, опционально имеющего видеоядро, а материнка без видеовыхода? Как тогда задействовать это ядро? Или сейчас видеовыход есть всегда, если проц подразумевает видеоядро?

Или вот наоборот. Раньше были материнки для офисной работы и для начальных компов, со встроенной простейшей графикой (обычно от Intel) при отсутствии в процессоре видеоядра, а как сейчас устроена видеоподсистема в этой нише, ну если видеовыход на материнке есть, а процессор стоит без видеоядра. Как тогда будет работать графика? Остаётся ли в материнке простейшее встроенное видео, или просто при установке проца без видеоядра монитор, подключённый к такой материнке, работать не будет?

Было бы интересно, если б кто-то ответил) А то у меня что-то по этим вещам путаница.

Alexsey

18.03.2018 02:12+2Одно время, с появлением у AMD серии FX, вроде вообще процов без графического ядра почти не осталось. И у Интела, и у АМД массово шли процы со встроенным видео. Но вот новые Райзены и Тредрипперы без графики же?

Райзены с приставкой g — с графикой. Все остальное у амд — без графики.

Раньше считалось, что встроенная графика в процах AMD мощнее, чем в процах Интела, это следствие ещё со времён покупки ATI. А что сейчас?

С приходом райзенов со встроенной графикой — амд снова уделывает интел по встроенной графике (как-никак, но у них все же хоть и урезанная, но все еще vega)

Если я соберу игровой компьютер с дискретной видеокартой и процессором с видеоядром, как они взаимодействуют сегодня? Объединяют вычислительную мощность? В норме работает ядро проца, а под нагрузкой сама включается дискретная видеокарта? Или это надо переключать в биосе? А если проц и видеокарта от разных производителей, скажем, проц AMD со встроенной графикой, а видеокарта nVidia?

Каждая работает отдельно от другой. Максимум — рабочий стол можно расширить на мониторы не зависимо от того к какой видеокарте они подключены.

Если я захочу собрать максимально приближенный к игровому комп не покупая видеокарту, полагаясь только на видеоядро процессора, на какие модели смотреть? Что сможет такой комп, какие известные игры в каком разрешении потянет (примерно)?

Разрешение 1080p:

может ли быть ситуация, что на материнке стоит сокет для процессора, опционально имеющего видеоядро, а материнка без видеовыхода? Как тогда задействовать это ядро? Или сейчас видеовыход есть всегда, если проц подразумевает видеоядро?

Может, но редко. Никак не задействовать если видеовыхода нет.

Или вот наоборот. Раньше были материнки для офисной работы и для начальных компов, со встроенной простейшей графикой (обычно от Intel) при отсутствии в процессоре видеоядра, а как сейчас устроена видеоподсистема в этой нише, ну если видеовыход на материнке есть, а процессор стоит без видеоядра. Как тогда будет работать графика? Остаётся ли в материнке простейшее встроенное видео, или просто при установке проца без видеоядра монитор, подключённый к такой материнке, работать не будет?

В матерях сейчас ничего не встроено и без соответствующего процессора ничего работать не будет.

ns3230

18.03.2018 02:31+1Одно время, с появлением у AMD серии FX, вроде вообще процов без графического ядра почти не осталось

Они просто по сегментам разделили. AM3 платформа для тех, кому нужны мощные ЦП и ГП, а втройка ни к чему, FM2 — для офиса и тех, кому встройки хватает.

Но вот новые Райзены и Тредрипперы без графики же?

Опять то же самое: разделение сегментов. В топах редко кому встройка нужна, поэтому на TR4 (платформа под Threadripper) встроенной нет, а вот на AM4 есть как процы без встройки, Ryzen 3, 5 и 7, так и со встройкой средне-бюджетные Ryzen 3 и 5, у которых встройка по уровню примерно как GT 1030, если память нормальная.

Раньше считалось, что встроенная графика в процах AMD мощнее

И сейчас все так же. У Интел была Iris Pro, но она в основном в процах для дорогих тонких ноутов используется. А обычная HD Graphics по уровню как встройка в бюджетных процах АМД. Да и на Ириску Интел подзабил, скоро должны появиться процы Интел для ноутов и миниатюрных ПК со встройкой АМД.

Объединяют вычислительную мощность?

Не взаимодействуют. АМД уже не поддерживают такого, последние процы с гибридным кроссом — на сокете FM2+. А переключать дискретку и встройку, в зависимости от нагрузки, умеют только ноутбуки. А в десктопе попросту малость проблематично пробрасывать на выход одной видяхи картинку с другой, особенно если они разных фирм, вот и не реализуют.

Если я захочу собрать максимально приближенный к игровому комп не покупая видеокарту, полагаясь только на видеоядро процессора, на какие модели смотреть?

Пока что только две модели Ryzen: Ryzen 3 2200G и Ryzen 5 2400G. У них встройки в HD (1280х720 или 1366х768) на высоких почти все потянут с приемлемым FPS, а в FullHD — средние, самые тяжелые — на низких.

То есть может ли быть ситуация, что на материнке стоит сокет для процессора, опционально имеющего видеоядро, а материнка без видеовыхода?

Все модели не изучал, но в теории возможно. В таком случае встройку попросту никак не выйдет юзать. Но если такие мамки и есть — это наверняка топы, на чипах вроде Z270, брать подобную по цене намного дороже бюджетного игрового проца, который в ней будет стоять, глупо, лучше чутка добавить и взять мамку на H110 и GTX 1050 Ti.

ну если видеовыход на материнке есть, а процессор стоит без видеоядра. Как тогда будет работать графика?

Никак. Если встройки нет — выход на мамке бесполезен, только дискретку надо.

mistergrim

18.03.2018 07:49Раньше считалось, что встроенная графика в процах AMD мощнее, чем в процах Интела, это следствие ещё со времён покупки ATI. А что сейчас?

А сейчас — графика AMD в процессорах Intel.

https://ark.intel.com/products/130411/Intel-Core-i7-8705G-Processor-with-Radeon-RX-Vega-M-GL-graphics-8M-Cache-up-to-4_10-GHz

Areso

18.03.2018 11:44А в реальной жизни эти процессоры продаются? Видел всего одно устройство с таким процессором — и опять же, которого нет в продаже — NUC Skull

Да и странно пихать такое мощное видеоядро в i7, к i7 пользователь ну всяко насобирает денег на 1050 или аналог.

Exchan-ge

18.03.2018 13:04Да и странно пихать такое мощное видеоядро в i7, к i7 пользователь ну всяко насобирает денег на 1050 или аналог