Виртуальная реальность, распознавание эмоций и айтрекинг — три независимо развивающиеся области знаний и новые, привлекательные с коммерческой точки зрения технологические рынки — все чаще в последние годы рассматриваются в фокусе конвергенции, слияния, синтеза подходов с целью создания продуктов нового поколения. И в этом естественном процессе сближения едва ли есть что-то удивительное: кроме результатов, о которых можно говорить с долей осторожности, но и немалым пользовательским восторгом (к слову, недавний фильм «Первому игроку приготовиться» Стивена Спилберга в буквальном смысле визуализирует многие ожидаемые сценарии). Давайте обсудим подробнее.

Виртуальная реальность – это, прежде всего, возможность ощутить максимально полное погружение в фантастический, прямо скажем, мир: воевать с нечистью, дружить с единорогами и драконами, вообразить себя огромной сороконожкой, отправиться сквозь бескрайний космос к новым планетам. Однако для того, чтобы виртуальная реальность воспринималась — на сенсорном уровне — действительно как реальность, вплоть до смешения с окружающей действительностью, в ней должны присутствовать элементы натуральной коммуникации: эмоции и зрительный контакт. Также в VR человек может и должен обладать дополнительными сверхспособностями (например, перемещать взглядом предметы) как чем-то само собсой разумеющимся. Но все не так просто — за реализацией данных возможностей стоит немало возникающих проблем и интересных технологических решений, призванных снять их.

Игровая индустрия очень быстро берет на вооружение множество технологических ноу-хау. Положим, простые айтрекеры (в виде игровых контроллеров) уже стали доступны широкому кругу пользователей компьютерных игр, тогда как в других областях повсеместное применение этих разработок еще только предстоит. Очевидно в это связи, что одним из наиболее стремительно развивающихся трендов в VR стало совмещение систем виртуальной реальности и айтрекинга. Недавно шведский айтрекинговый гигант Tobii вступил в коллаборацию с Qualcomm , о чем подробно сообщалось , разработчик систем виртуальной реальности Oculus (принадлежащий Facebook) объединился с известным стартапом low cost айтрекеров The Eye Tribe (демонстрацию работы Oculus со встроенным айтрекером можно посмотреть тут), Apple в традиционно секретном режиме приобрел крупную немецкую айтрекинговую компанию SMI (правда, пока никто не знает мотив и чем именно был обусловлен выбор…).

Интеграция функции игрового контроллера в виртуальную реальность дает возможность пользователю управлять предметами взглядом (в простейшем случае, чтобы что-то «схватить» или выбрать пункт из меню, нужно просто чуть дольше пары мгновений посмотреть на данный объект – применяется пороговый метод длительности фиксаций). Однако это порождает т.н. проблему Мидаса (The Midas-Touch Problem), когда пользователь хочет только внимательно рассмотреть объект, а в итоге невольно активирует какую-либо запрограммированную функцию, которую вовсе не желал задействовать изначально.

Ученые из университета Гонконга (Pi & Shi, 2017) для решения проблемы Мидаса предлагают использовать динамический порог длительности фиксаций, применяя вероятностную модель. Данная модель учитывает предыдущие выборы испытуемого и рассчитывает вероятность выбора для следующего объекта, при этом для объектов с высокой вероятностью устанавливается более короткая пороговая длительность фиксаций, чем для объектов с низкой вероятностью. Предложенный алгоритм продемонстрировал свои преимущества в плане скорости по сравнению с методом фиксированного порога длительности фиксаций. Следует отметить, что упомянутая система была разработана для набора текстов при помощи взгляда, то есть может быть применима только в интерфейсах, где количество объектов не изменяется с течением времени.

Группа разработчиков из Мюнхенского Технического университета (Schenk, Dreiser, Rigoll, & Dorr, 2017) предложила систему взаимодействия с компьютерными интерфейсами при помощи взгляда GazeEverywhere, в состав которой вошла разработка SPOCK (Schenk, Tiefenbacher, Rigoll, & Dorr, 2016) для решения проблемы Мидаса. SPOCK представляет собой метод выбора объекта, состоящий из двух шагов: после фиксации на объекте, длительность которой выше установленного порога, сверху и снизу объекта появляются два круга, медленно перемещающиеся в разные стороны: задача испытуемого состоит в том, чтобы прослеживать движение одного из них (детекция медленного прослеживающего движения глаз как раз и активирует выбранный объект). Также система GazeEverywhere любопытна тем, что включает в себя алгоритм онлайн-рекалибровки, что значительно улучшает точность локализации взора на объекте.

В качестве альтернативы пороговому методу длительности фиксаций для выбора объекта и для решения проблемы Мидаса группа ученых из Веймара (Huckauf, Goettel, Heinbockel, & Urbina, 2005) считает корректным использовать анти-саккады в качестве действия выбора (анти-саккады – это совершение движений глаз в противоположную сторону от цели). Данный метод способствует более быстрому выбору объекта, чем метод порога длительности фиксаций, однако обладает меньшей точностью. Также его применение вне лаборатории вызывает вопросы: все-таки смотреть на нужный объект для человека более естественное поведение, чем специально не смотреть в его сторону.

Wu et al. (Wu, Wang, Lin, & Zhou, 2017) разработали еще более простой метод для решения проблемы Мидаса – в качестве маркера для выбора объектов они предложили использовать подмигивание одним глазом (т.е. явный паттерн: один глаз открыт, а другой закрыт). Впрочем, в динамичном геймплее интеграция такого способа выбора объектов вряд ли возможна в силу её дискомфортности, как минимум.

Pfeuffer et al. (Pfeuffer, Mayer, Mardanbegi, & Gellersen, 2017) предлагают уйти от идеи создания интерфейса, где выбор и манипуляция с объектом осуществляются только посредством движений глаз, и использовать вместо этого Gaze + pinch interaction technique. Данный метод базируется на том, что выбор объекта осуществляется за счет локализации взора на нем в сочетании с жестом сложенных пальцев в «щепотку» (как одной руки, так и обеих рук). Gaze + pinch interaction technique обладает преимуществами как по сравнению с «виртуальными руками», поскольку позволяет манипулировать виртуальными предметами на расстоянии, так и с девайсами-контроллерами, ибо освобождает руки пользователя и создает опцию расширения функционала за счет добавления других жестов.

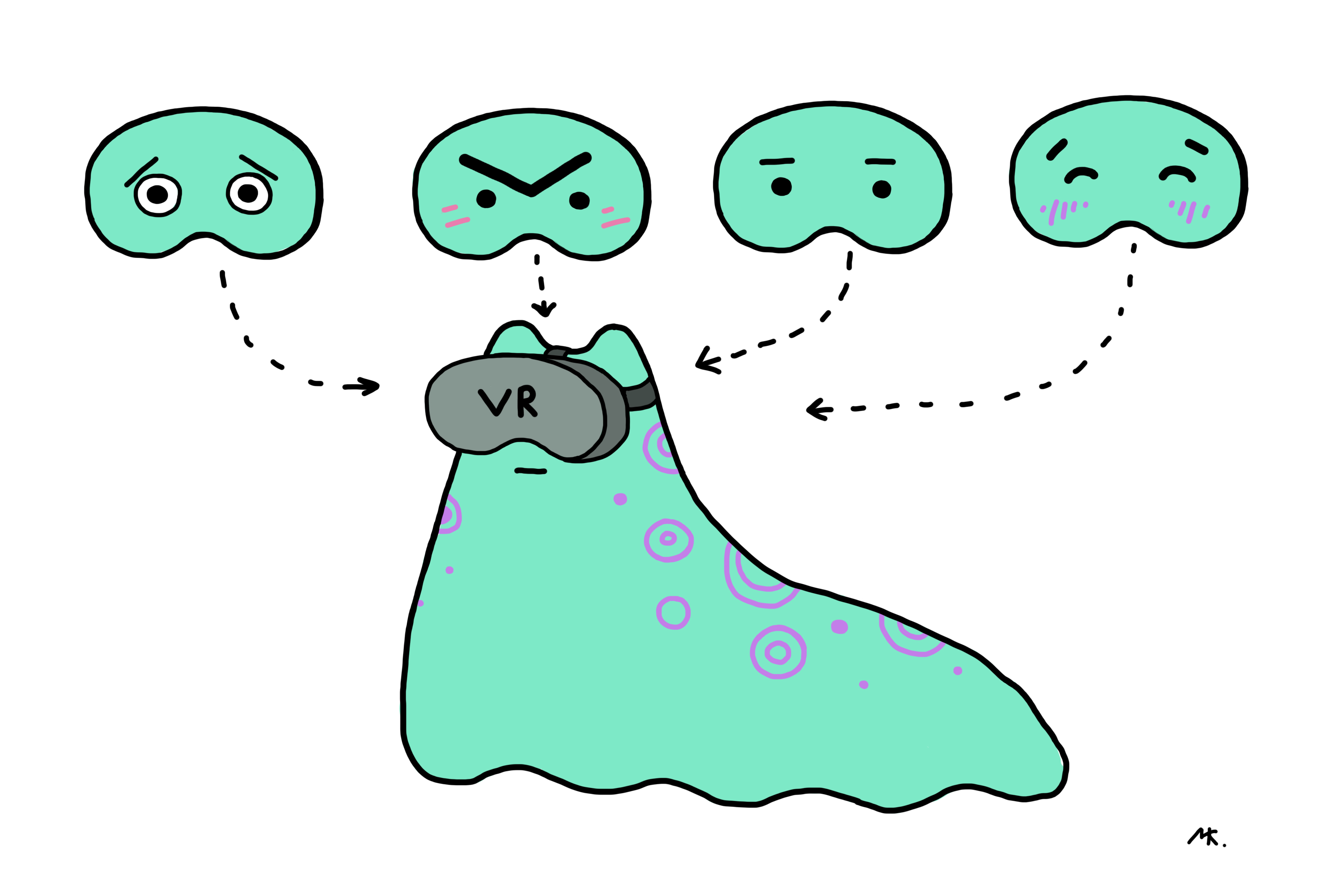

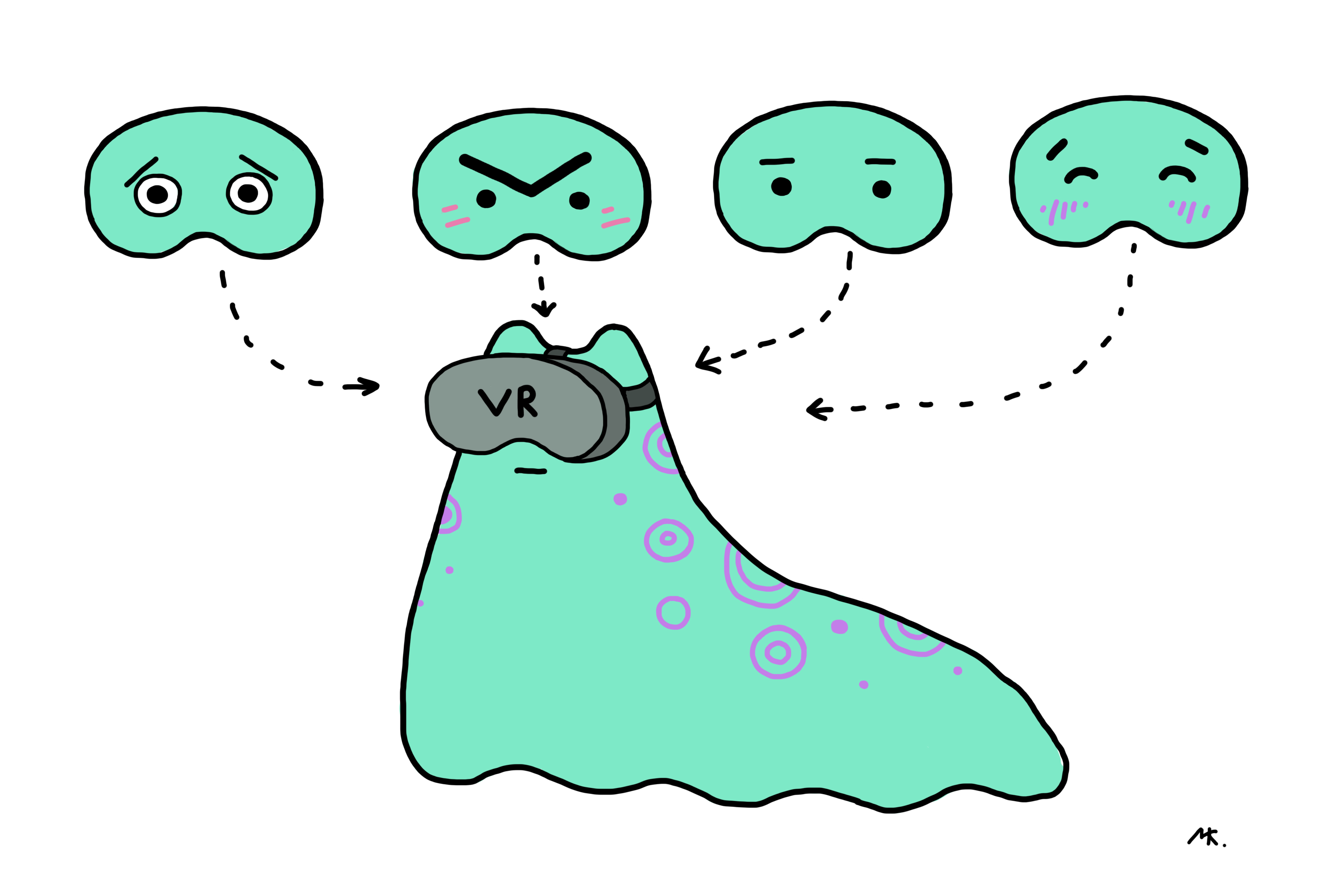

Для успешного виртуального общения, социальных сетей и многопользовательских игр в VR, в первую очередь, аватары пользователей должны быть способны к естественному выражению эмоций. Сейчас можно выделить два типа решений для добавления эмоциональности в VR: установка дополнительных девайсов и чисто программные решения.

Так, проект MindMaze Mask предлагает решение в виде датчиков, которые измеряют электрическую активность мышц лица, располагающихся внутри шлема. Также его создатели продемонстрировали алгоритм, который на основе текущей электрической активности мышц способен предсказывать мимику для качественной отрисовки аватара. Разработка от FACEteq (emotion sensing in VR) построена на схожих принципах.

Стартап Veeso дополнил очки виртуальной реальности еще одной камерой, регистрирующей движения нижней половины лица. Совмещая изображения нижней половины лица и области глаз, они распознают мимику всего лица целиком для перенесения её на виртуальный аватар.

Команда из Технологического Института Джорджии в партнерстве с Googlе (Hickson, Dufour, Sud, Kwatra, & Essa, 2017) предложила более изящное решение и разработала технологию распознавания эмоций человека в очках виртуальной реальности без добавления каких-либо дополнительных хардверных девайсов в оправу. Данный алгоритм основан на базе сверточной нейросети и распознает лицевые экспрессии («гнев», «радость», «удивление», «нейтральное выражение лица», «закрытые глаза») в среднем в 74% случаев. Для ее обучения разработчики использовали свой собственный датасет изображений глаз с инфракрасных камер встроенного айтрекера, записанных во время визуализации той или иной эмоции участниками (всего их было 23) в очках виртуальной реальности. Кроме того, датасет включил в себя эмоциональные экспрессии всего лица участников исследования, записанные на обычную камеру. В качестве метода детекции лицевых экспрессий они выбрали известную cистему на базе распознавания action units — FACS (правда, взяли только action units верхней половины лица). Каждый action unit распознавался предложенным алгоритмом в 63.7% случаев без персонализации, и в 70.2% — с персонализацией.

Подобные разработки в сфере детекции эмоций только по изображениям области глаз есть и без привязки к виртуальной реальности (Priya & Muralidhar, 2017; Vinotha, Arun, & Arun, 2013). Например, (Priya & Muralidhar, 2017) тоже сконструировали систему на базе action units и вывели алгоритм распознавания семи эмоциональных лицевых экспрессий (радость, грусть, гнев, страх, отвращение, удивление и нейтральное выражение лица) по семи точкам (три вдоль брови, две в углах глаза и еще две по центру верхнего и нижнего века), который работает с точностью 78.2%.

Глобальные исследования и эксперименты продолжаются, и рабочая группа Neurodata Lab по айтрекингу обязательно расскажет вам о них. Оставайтесь с нами.

Библиография:

Hickson, S., Dufour, N., Sud, A., Kwatra, V., & Essa, I. (2017). Eyemotion: Classifying facial expressions in VR using eye-tracking cameras. Retrieved from arxiv.org/abs/1707.07204

Huckauf, A., Goettel, T., Heinbockel, M., & Urbina, M. (2005). What you don’t look at is what you get: anti-saccades can reduce the midas touch-problem. In Proceedings of the 2nd Symposium on Applied Perception in Graphics and Visualization, APGV 2005, A Coruna, Spain, August 26-28, 2005 (pp. 170–170). doi.org/10.1145/1080402.1080453

Pfeuffer, K., Mayer, B., Mardanbegi, D., & Gellersen, H. (2017). Gaze + pinch interaction in virtual reality. Proceedings of the 5th Symposium on Spatial User Interaction — SUI ’17, (October), 99–108. doi.org/10.1145/3131277.3132180

Pi, J., & Shi, B. E. (2017). Probabilistic adjustment of dwell time for eye typing. Proceedings — 2017 10th International Conference on Human System Interactions, HSI 2017, 251–257. doi.org/10.1109/HSI.2017.8005041

Priya, V. R., & Muralidhar, A. (2017). Facial Emotion Recognition Using Eye. International Journal of Applied Engineering Research ISSN, 12(September), 5655–5659. doi.org/10.1109/SMC.2015.387

Schenk, S., Dreiser, M., Rigoll, G., & Dorr, M. (2017). GazeEverywhere: Enabling Gaze-only User Interaction on an Unmodified Desktop PC in Everyday Scenarios. CHI ’17 Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems, 3034–3044. doi.org/10.1145/3025453.3025455

Schenk, S., Tiefenbacher, P., Rigoll, G., & Dorr, M. (2016). Spock. Proceedings of the 2016 CHI Conference Extended Abstracts on Human Factors in Computing Systems — CHI EA ’16, 2681–2687. doi.org/10.1145/2851581.2892291

Vinotha, S. R., Arun, R., & Arun, T. (2013). Emotion Recognition from Human Eye Expression. International Journal of Research in Computer and Communication Technology, 2(4), 158–164.

Wu, T., Wang, P., Lin, Y., & Zhou, C. (2017). A Robust Noninvasive Eye Control Approach For Disabled People Based on Kinect 2.0 Sensor. IEEE Sensors Letters, 1(4), 1–4. doi.org/10.1109/LSENS.2017.2720718

Автор материала:

Мария Константинова, научный сотрудник в Neurodata Lab, биолог, физиолог, специалист по зрительной сенсорной системе, окулографии и окуломоторике.

Виртуальная реальность – это, прежде всего, возможность ощутить максимально полное погружение в фантастический, прямо скажем, мир: воевать с нечистью, дружить с единорогами и драконами, вообразить себя огромной сороконожкой, отправиться сквозь бескрайний космос к новым планетам. Однако для того, чтобы виртуальная реальность воспринималась — на сенсорном уровне — действительно как реальность, вплоть до смешения с окружающей действительностью, в ней должны присутствовать элементы натуральной коммуникации: эмоции и зрительный контакт. Также в VR человек может и должен обладать дополнительными сверхспособностями (например, перемещать взглядом предметы) как чем-то само собсой разумеющимся. Но все не так просто — за реализацией данных возможностей стоит немало возникающих проблем и интересных технологических решений, призванных снять их.

Игровая индустрия очень быстро берет на вооружение множество технологических ноу-хау. Положим, простые айтрекеры (в виде игровых контроллеров) уже стали доступны широкому кругу пользователей компьютерных игр, тогда как в других областях повсеместное применение этих разработок еще только предстоит. Очевидно в это связи, что одним из наиболее стремительно развивающихся трендов в VR стало совмещение систем виртуальной реальности и айтрекинга. Недавно шведский айтрекинговый гигант Tobii вступил в коллаборацию с Qualcomm , о чем подробно сообщалось , разработчик систем виртуальной реальности Oculus (принадлежащий Facebook) объединился с известным стартапом low cost айтрекеров The Eye Tribe (демонстрацию работы Oculus со встроенным айтрекером можно посмотреть тут), Apple в традиционно секретном режиме приобрел крупную немецкую айтрекинговую компанию SMI (правда, пока никто не знает мотив и чем именно был обусловлен выбор…).

Интеграция функции игрового контроллера в виртуальную реальность дает возможность пользователю управлять предметами взглядом (в простейшем случае, чтобы что-то «схватить» или выбрать пункт из меню, нужно просто чуть дольше пары мгновений посмотреть на данный объект – применяется пороговый метод длительности фиксаций). Однако это порождает т.н. проблему Мидаса (The Midas-Touch Problem), когда пользователь хочет только внимательно рассмотреть объект, а в итоге невольно активирует какую-либо запрограммированную функцию, которую вовсе не желал задействовать изначально.

Виртуальный Царь Мидас

Ученые из университета Гонконга (Pi & Shi, 2017) для решения проблемы Мидаса предлагают использовать динамический порог длительности фиксаций, применяя вероятностную модель. Данная модель учитывает предыдущие выборы испытуемого и рассчитывает вероятность выбора для следующего объекта, при этом для объектов с высокой вероятностью устанавливается более короткая пороговая длительность фиксаций, чем для объектов с низкой вероятностью. Предложенный алгоритм продемонстрировал свои преимущества в плане скорости по сравнению с методом фиксированного порога длительности фиксаций. Следует отметить, что упомянутая система была разработана для набора текстов при помощи взгляда, то есть может быть применима только в интерфейсах, где количество объектов не изменяется с течением времени.

Группа разработчиков из Мюнхенского Технического университета (Schenk, Dreiser, Rigoll, & Dorr, 2017) предложила систему взаимодействия с компьютерными интерфейсами при помощи взгляда GazeEverywhere, в состав которой вошла разработка SPOCK (Schenk, Tiefenbacher, Rigoll, & Dorr, 2016) для решения проблемы Мидаса. SPOCK представляет собой метод выбора объекта, состоящий из двух шагов: после фиксации на объекте, длительность которой выше установленного порога, сверху и снизу объекта появляются два круга, медленно перемещающиеся в разные стороны: задача испытуемого состоит в том, чтобы прослеживать движение одного из них (детекция медленного прослеживающего движения глаз как раз и активирует выбранный объект). Также система GazeEverywhere любопытна тем, что включает в себя алгоритм онлайн-рекалибровки, что значительно улучшает точность локализации взора на объекте.

В качестве альтернативы пороговому методу длительности фиксаций для выбора объекта и для решения проблемы Мидаса группа ученых из Веймара (Huckauf, Goettel, Heinbockel, & Urbina, 2005) считает корректным использовать анти-саккады в качестве действия выбора (анти-саккады – это совершение движений глаз в противоположную сторону от цели). Данный метод способствует более быстрому выбору объекта, чем метод порога длительности фиксаций, однако обладает меньшей точностью. Также его применение вне лаборатории вызывает вопросы: все-таки смотреть на нужный объект для человека более естественное поведение, чем специально не смотреть в его сторону.

Wu et al. (Wu, Wang, Lin, & Zhou, 2017) разработали еще более простой метод для решения проблемы Мидаса – в качестве маркера для выбора объектов они предложили использовать подмигивание одним глазом (т.е. явный паттерн: один глаз открыт, а другой закрыт). Впрочем, в динамичном геймплее интеграция такого способа выбора объектов вряд ли возможна в силу её дискомфортности, как минимум.

Pfeuffer et al. (Pfeuffer, Mayer, Mardanbegi, & Gellersen, 2017) предлагают уйти от идеи создания интерфейса, где выбор и манипуляция с объектом осуществляются только посредством движений глаз, и использовать вместо этого Gaze + pinch interaction technique. Данный метод базируется на том, что выбор объекта осуществляется за счет локализации взора на нем в сочетании с жестом сложенных пальцев в «щепотку» (как одной руки, так и обеих рук). Gaze + pinch interaction technique обладает преимуществами как по сравнению с «виртуальными руками», поскольку позволяет манипулировать виртуальными предметами на расстоянии, так и с девайсами-контроллерами, ибо освобождает руки пользователя и создает опцию расширения функционала за счет добавления других жестов.

Эмоции в VR

Для успешного виртуального общения, социальных сетей и многопользовательских игр в VR, в первую очередь, аватары пользователей должны быть способны к естественному выражению эмоций. Сейчас можно выделить два типа решений для добавления эмоциональности в VR: установка дополнительных девайсов и чисто программные решения.

Так, проект MindMaze Mask предлагает решение в виде датчиков, которые измеряют электрическую активность мышц лица, располагающихся внутри шлема. Также его создатели продемонстрировали алгоритм, который на основе текущей электрической активности мышц способен предсказывать мимику для качественной отрисовки аватара. Разработка от FACEteq (emotion sensing in VR) построена на схожих принципах.

Стартап Veeso дополнил очки виртуальной реальности еще одной камерой, регистрирующей движения нижней половины лица. Совмещая изображения нижней половины лица и области глаз, они распознают мимику всего лица целиком для перенесения её на виртуальный аватар.

Команда из Технологического Института Джорджии в партнерстве с Googlе (Hickson, Dufour, Sud, Kwatra, & Essa, 2017) предложила более изящное решение и разработала технологию распознавания эмоций человека в очках виртуальной реальности без добавления каких-либо дополнительных хардверных девайсов в оправу. Данный алгоритм основан на базе сверточной нейросети и распознает лицевые экспрессии («гнев», «радость», «удивление», «нейтральное выражение лица», «закрытые глаза») в среднем в 74% случаев. Для ее обучения разработчики использовали свой собственный датасет изображений глаз с инфракрасных камер встроенного айтрекера, записанных во время визуализации той или иной эмоции участниками (всего их было 23) в очках виртуальной реальности. Кроме того, датасет включил в себя эмоциональные экспрессии всего лица участников исследования, записанные на обычную камеру. В качестве метода детекции лицевых экспрессий они выбрали известную cистему на базе распознавания action units — FACS (правда, взяли только action units верхней половины лица). Каждый action unit распознавался предложенным алгоритмом в 63.7% случаев без персонализации, и в 70.2% — с персонализацией.

Подобные разработки в сфере детекции эмоций только по изображениям области глаз есть и без привязки к виртуальной реальности (Priya & Muralidhar, 2017; Vinotha, Arun, & Arun, 2013). Например, (Priya & Muralidhar, 2017) тоже сконструировали систему на базе action units и вывели алгоритм распознавания семи эмоциональных лицевых экспрессий (радость, грусть, гнев, страх, отвращение, удивление и нейтральное выражение лица) по семи точкам (три вдоль брови, две в углах глаза и еще две по центру верхнего и нижнего века), который работает с точностью 78.2%.

Глобальные исследования и эксперименты продолжаются, и рабочая группа Neurodata Lab по айтрекингу обязательно расскажет вам о них. Оставайтесь с нами.

Библиография:

Hickson, S., Dufour, N., Sud, A., Kwatra, V., & Essa, I. (2017). Eyemotion: Classifying facial expressions in VR using eye-tracking cameras. Retrieved from arxiv.org/abs/1707.07204

Huckauf, A., Goettel, T., Heinbockel, M., & Urbina, M. (2005). What you don’t look at is what you get: anti-saccades can reduce the midas touch-problem. In Proceedings of the 2nd Symposium on Applied Perception in Graphics and Visualization, APGV 2005, A Coruna, Spain, August 26-28, 2005 (pp. 170–170). doi.org/10.1145/1080402.1080453

Pfeuffer, K., Mayer, B., Mardanbegi, D., & Gellersen, H. (2017). Gaze + pinch interaction in virtual reality. Proceedings of the 5th Symposium on Spatial User Interaction — SUI ’17, (October), 99–108. doi.org/10.1145/3131277.3132180

Pi, J., & Shi, B. E. (2017). Probabilistic adjustment of dwell time for eye typing. Proceedings — 2017 10th International Conference on Human System Interactions, HSI 2017, 251–257. doi.org/10.1109/HSI.2017.8005041

Priya, V. R., & Muralidhar, A. (2017). Facial Emotion Recognition Using Eye. International Journal of Applied Engineering Research ISSN, 12(September), 5655–5659. doi.org/10.1109/SMC.2015.387

Schenk, S., Dreiser, M., Rigoll, G., & Dorr, M. (2017). GazeEverywhere: Enabling Gaze-only User Interaction on an Unmodified Desktop PC in Everyday Scenarios. CHI ’17 Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems, 3034–3044. doi.org/10.1145/3025453.3025455

Schenk, S., Tiefenbacher, P., Rigoll, G., & Dorr, M. (2016). Spock. Proceedings of the 2016 CHI Conference Extended Abstracts on Human Factors in Computing Systems — CHI EA ’16, 2681–2687. doi.org/10.1145/2851581.2892291

Vinotha, S. R., Arun, R., & Arun, T. (2013). Emotion Recognition from Human Eye Expression. International Journal of Research in Computer and Communication Technology, 2(4), 158–164.

Wu, T., Wang, P., Lin, Y., & Zhou, C. (2017). A Robust Noninvasive Eye Control Approach For Disabled People Based on Kinect 2.0 Sensor. IEEE Sensors Letters, 1(4), 1–4. doi.org/10.1109/LSENS.2017.2720718

Автор материала:

Мария Константинова, научный сотрудник в Neurodata Lab, биолог, физиолог, специалист по зрительной сенсорной системе, окулографии и окуломоторике.

volkodav01

Вот как можно было написать по-русски eye tracking, это давно стало устойчивым выражением?

IgorLevin Автор

Да, это допустимо. В словарях уже приводится калька с английского термина. Формально стоит писать «окулография», но это усложняет понимание.