2021 год стал рубежным в давно уже обсуждаемой теме применения автономных от человека боевых машин. Если раньше за пультом беспилотных дронов практически всегда находился человек, и именно человек принимал решение о применении оружия, открытии огня и убийстве других людей с помощью дистанционно управляемой техники — то теперь свершилось то, о чём уже не первый год ломают копья на самых высоких международных площадках.

Как стало известно весной, роботы начали находить и убивать людей на поле боя, принимая решения самостоятельно — без участия оператора или его командира. Совсем недавно такой возможности разработчики военной техники и военные ведомства разных стран немного «стеснялись».

Однако известия о том, что подобное уже реально используется на полях сражений, обрушили плотину. После этого разговоры в ООН, конечно, продолжились — но гонка вооружений в области создания автономных боевых роботов (они же «автономные боевые системы», они же «автономные системы уничтожения», они же «смертоносные автономные системы вооружений» в документах ООН, строгая терминология ещё не устоялась) стала вестись публично и открыто.

Начнём с более-менее свежих новостей.

В середине октября 2021 года по сети разлетелись фотографии усовершенствованного «робо-пса» Q-UGV, он же Vision 60, от американской компании Ghost Robotics. Изначально эти многоцелевые четвероногие шагоходы предполагалось использовать для разведки, патрулирования, картографирования, связи, осмотра опасных объектов и тому подобных целей, в каковом качестве испытывались на базе ВВС США Неллис в Неваде, а затем были поставлены на боевое дежурство на базе ВВС Тиндалл во Флориде. Они могут работать как под дистанционным управлением оператора, так и автономно согласно заложенным алгоритмам поведения.

Уже на стадии испытаний разработчик объявил, что гибкая модульность Q-UGV представляет самые широкие и гибкие возможности для использования, ограниченные только возможностями и фантазией владельца. Четыре лапы позволяют дроиду ходить, бегать и карабкаться по очень сложным ландшафтам и постройкам, в том числе разрушенным, в любое время суток и погоду.

Теперь же «робо-пёс» получил на «спину» массивный боевой модуль SPUR (Special Purpose Unmanned Rifle) от SWORD International. Он включает в себя систему снайперский комплекс с электронно-оптическим датчиком и тепловизором, системой анализа целей и наведения, способный вести прицельный огонь на расстоянии до 1200 метров. Он может оснащаться оружейным блоком под патроны Creedmoor калибром 6,5 мм, либо же под стандартные 7.62 NATO.

Важной особенностью получившейся машины разработчики называют её способность действовать без участия оператора в полной автономности. В том числе – что, в общем-то, и стало самой громкой составляющей новости — самостоятельно определять и поражать цели без участия и подтверждения человека-оператора. Более того, сообщается, что этими устройствами то ли ещё заинтересовались, то ли уже начали закупки вооружённые силы США и Австралии, сближающиеся в рамках нового блока AUKUS.

19 октября уже российские военные объявили о полигонных испытаниях группы автономных ударных боевых роботов «Маркер» от «Андроидной техники» и Фонда перспективных исследований. Три колёсные и две гусеничные машины, оснащённые пулемётами, гранатомётами и ракетами, без участия операторов занимали выгодные огневые позиции, решали задачи по распределению целей в группе, реагировали на меняющуюся боевую обстановку и обменивались целеуказаниями.

И американские, и российские автономные боевые роботы пока что – по заявлениям военных РФ и США — планируется использовать прежде всего для охраны важных объектов. Российские «Маркеры» ранее уже обкатали на периметре космодрома «Восточный».

И американских «робо-псов», и российских «маркеров» пока что предполагается использовать прежде всего в охране особо важных объектов – как и полагается в классическом киберпанке. И тем и другим уже не суждено стать первым автономным роботом, убившим человека. Эту пальму первенства взяли турецкие боевые роботы — причём не сейчас, а полтора года тому назад.

Весной 2021 года из доклада группы экспертов Совбеза ООН по Ливии мир узнал о первом подтверждённом эпизоде применения автономного боевого робота против противников-людей.

По данным ООН, ещё в марте 2020 года барражирующие боеприпасы-квадрокоптеры STM Kargu-2 турецкого производства, поддерживавшие с воздуха наступающие войска западноливийского ПНС, самостоятельно, без участия операторов определяли цели и атаковали отступающие войска маршала Хафтара.

На эти несколько фраз в вышедшем в марте докладе экспертов ООН мировые СМИ и международные организации обратили внимание только в мае. После чего начался очередной раунд ведущейся уже не первый год дискуссии о границах применимости в военных действиях полностью автономных боевых машин.

Ну а военные ведомства и комплексы ВПК бросились усиленно разрабатывать собственные образцы роботов-убийц — и приоткрывать завесу секретности над уже созданным. Естественно, такие системы все, кто могут, разрабатывают уже давно. Не только американцы, россияне и турки: есть сведения об активной работе в этой области французов, британцев, израильтян, китайцев, южнокорейцев, иранцев. До 2021 года говорить об этом открыто считалось не совсем «приличным» и чреватым бурной общественной критикой. Теперь же все военные ведомства могут кивать на разнообразных вероятных противников и на необходимость не уступать им в военных технологиях.

Те самые квадрокоптеры-камикадзе STM Kargu-2, ставшими первыми в истории применёнными для убийства живой силы противника автономными роботами-убийцами

Беспилотная техника на поле боя — давно уже не новость. Боевые дроны от крупных высотных машин до крохотных разведывательных «вертолётиков» активно применяются в военном деле не первый десяток лет. И не только передовыми странами с высокотехнологичной военной промышленностью, но и всевозможными боевиками. В нашу эпоху победившего киберпанка собрать примитивный боевой дрон можно в гараже из подержанных китайских запчастей.

Однако доселе практически все они были не автономными, а управляемыми дистанционно: за пультом управления какого-нибудь MQ-9 Reaper или шайтан-квадрокоптера с гранатой в стакане обязательно сидел оператор. Именно он направлял движение беспилотника, именно он нажимал на «пуск» после определения цели и принятия решения на поражение. Машина убивала лишь в техническом смысле — решали убить и стреляли вполне конкретные люди: оператор, его командир или политический руководитель, пусть и находясь порой на другом конце земного шара. Война дронов всё равно оставалась войной людей.

Да, в некотором смысле любая «самонаводящаяся» ракета или планирующая бомба тоже является машиной-убийцей: её сенсоры и компьютер вычленяют цель и донаводятся. Иногда она сама – как часть противокорабельных ракет при атаке ордера кораблей — определяет самую важную из нескольких целей и наводится именно на неё. Однако решение об определении целей и пуске такой ракеты всё равно принимает всё тот же человек.

Полностью автономной боевой машиной, причём уже не первый десяток лет стоящей на вооружении, можно назвать разве что российскую систему автоматизированного ответного ядерного удара «Периметр», она же «Мёртвая рука». Однако на пути боевого применения этого «Скайнета» находится такое количество ограничений, что его можно сравнить скорее со своего рода «растяжкой» с гранатой на «двери» массированного ядерного нападения.

Теперь ситуация меняется: роботы выходят на свободную охоту на двуногую добычу. Человек лишь определяет условия, при которых машина определяет цель как враждебную, и открывает огонь без приказа или хотя бы разрешения от оператора.

Это открывает новую страницу в истории войн – и ставит перед человечеством массу непростых вопросов: от прикладных технических до политических, правовых и этических. Если в «традиционном» применении оружия – включая дистанционно управляемые дроны — всегда есть те конкретные люди, которые отдали приказ и нажали на «спусковой крючок», то кого именно и как признавать виновным в убийстве, решение о котором было принято автономным роботом согласно алгоритмам?

Кто будет отвечать, если программа даст сбой, и машины начнут уничтожать гражданских, медиков, миротворцев или собственных военных? Кто сможет дать точный ответ, был ли это сбой, хакерский взлом или злонамеренная имитация ошибки? Кто понесёт ответственность, если боевая машина полностью выйдет из-под контроля и начнёт убивать всех, кого сможет?

В ООН тема автономных боевых машин, и их соответствия нормам международного гуманитарного права, права в области прав человека, конвенции о «негуманном» оружии, активно обсуждается с 2013 года. Как водится — очень этично, но не особенно успешно. Предложения по введению всеобщего моратория на разработку и эксплуатацию автономных боевых систем звучали неоднократно — им выказывали моральную поддержку, но поддерживать всерьёз никто так и не собрался.

На консультациях под эгидой ООН в Женеве в 2018 году из 88 участвовавших стран введение запрета на автономные боевые системы поддержали только 26 государств — и ведущих военных держав среди них не оказалось. Всё, о чём делегации смогли договориться — десяток «потенциальных принципов» самого общего характера: чтобы разработки соответствовали «гуманистическим принципам», а ответственность за их применение всё равно нёс хоть кто-нибудь из людей.

Не возымели особенного эффекта и резолюция Европарламента 2018 года, кампания по запрету автономных боевых роботов 2019 года во главе с лауреаткой Нобелевской премии мира Джоди Уильямс — хотя к ней присоединились 130 общественных организаций из 60 стран мира, а также генеральный секретарь ООН Антониу Гутерриш. По сей день автономные боевые системы находятся в практически не описанной юридически «серой зоне» международного гуманитарного и военного права.

Кампания Stop Killer Robots от Human Rights Watch в августе 2020 года констатировала поддержку уже 165 организаций из 65 стран — однако и то, что лишь 30 из почти 200 стран прямо высказываются в поддержку запрета боевых роботов.

Из заметных военных держав в этом списке оказались только Пакистан и Египет. Прочие предпочитают ограничиваться обтекаемыми формулировками о том, что мы за всё хорошее и гуманное, но не стоит спешить, нужно подумать и разобраться. Международные форумы и встречи разной представительности о запрете автономных боевых машин проходят регулярно в разных точках планеты — но серьёзных перспектив запрета боевых роботов пока что не просматривается.

Дело в том, что запрос на подобные системы у современных военных слишком велик — и продолжит расти в обозримом будущем.

Человек современного урбанизированного общества отнюдь не рвётся убивать и тем более умирать за что бы то ни было. Гуманизм и неприятие насилия в большинстве обществ планеты, что бы ни утверждали некоторые, неуклонно растут — что весьма наглядно показывает и статистика смертей и преступлений, и исследования: к примеру, Стивена Пинкера и Акопа Назаретяна. Число людей, готовых к тому, чтобы идти в атаку на пулемёты и ловить пули своей персональной грудью, а не сидеть с чашкой кофе за пультом дрона в безопасном бункере, падает во всё большем числе стран. То же касается и готовности причинять вред другим людям, даже если это военные враги.

Идеи с отбором в войска психопатов показали сомнительные результаты — подробнее можно почитать в одной из моих старых статей . Даже частные военные компании всё чаще предпочитают избегать идейных боевиков-радикалов и ветеранов с ПТСР, желающих из-за психотравм «жить войной».

В современных военных конфликтах при возрастающем совершенстве технологий всё более сложной проблемой оказывается найти мотивированную пехоту для ближнего боя: которая сможет профессионально штурмовать вражеские позиции и нести неизбежные потери — и при этом не окажется «золотой» в смысле индивидуального отбора и затрат на подготовку, как немногочисленные высокопрофессиональные спецподразделения.

Более того, даже военные потери уровня десятков человек в год для многих современных обществ оказываются чрезмерными и недопустимыми. А опосредованное и дистанционное убийство «из кресла с кофе через монитор» часто оказывается причиной серьёзных психических травм, этических противоречий, проблем социального характера — что уже хорошо осознаётся на примере американских операторов ударных БПЛА.

Однако правительства и прочие политические акторы пока совершенно не готовы отказываться от войны как «последнего довода политиков». И автономные боевые системы в этой ситуации, при всей своей сомнительности с множества точек зрения — слишком удобный инструмент войны будущего.

Автономная машина может иметь несравнимо лучшую скорость реакции и точность, чем любой оператор-человек. С ней не получится так просто перехватить дистанционное управление, как в случае с некоторыми американскими дронами. И уж тем более машина не боится идти в атаку на вражеские позиции. На роботов не нужно писать похоронки, их потери не возмущают избирателей и налогоплательщиков.

У автономной боевой машины нет рефлексирующего и сомневающегося оператора, которого потом придётся лечить от алкоголизма и ПТСР, или разбираться с последствиями «слива» журналистам секретной информации о внесудебных убийствах. Машина не сомневается в этичности и законности участия в некой конкретной операции, особенно не очень официальной.

В конце концов, некоторые вещи можно будет свалить на сбои систем, выразить сожаления — и при этом у военного преступления может не быть конкретного виновника. Ответственность оказывается размытой, никто лично не нажимал на курок — ни оператор, ни командир, ни политик. «Так получилось, это же машина, а мы предупреждали не появляться в том районе».

Естественно, всё более активное применение автономных боевых систем будет встречать всё большее сопротивление общественности. Многие уже имеющиеся проблемы, скорее всего, только усугубятся. Даже операторы-люди трагически часто наносят удары по гражданским или своим же — с машинными алгоритмами это может оказаться ещё более частым явлением.

Очень многие современные конфликты имеют форму партизанской или полупартизанской войны, где грань между комбатантом и некомбатантом крайне размыта. Как именно прописывать машине определение легитимной цели, если человек с автоматом на плече в гражданской одежде может быть и повстанцем, и вполне мирным пастухом, а боевики, скажем, имеют привычку использовать для перемещения машины «скорой помощи»? Как солдату избежать гибели от огня робота, если он собрался сдаться? Как роботу отличить залёгших бойцов противника от неспособных продолжать бой раненых?

Получится ли осуществлять непосредственную поддержку войск в том самом, важном и сложном для современных армий ближнем огневом бою без недопустимого риска обстрела своих солдат — хотя камуфляж и обвес у сторон могут быть похожи до слабой различимости с дистанции, а в «гаражную» РЭБ оказываются способны даже племенные ополченцы в тапочках?

Хуже того: как «разруливать» ситуацию, если боевые роботы автоматически обстреляют солдат, пограничников или роботов другой страны на её территории? А если это случится из-за сбоя или провокации в условиях острого военно-политического кризиса, когда войска стянуты к границам у всех «пальцы пляшут на спусковых крючках»?

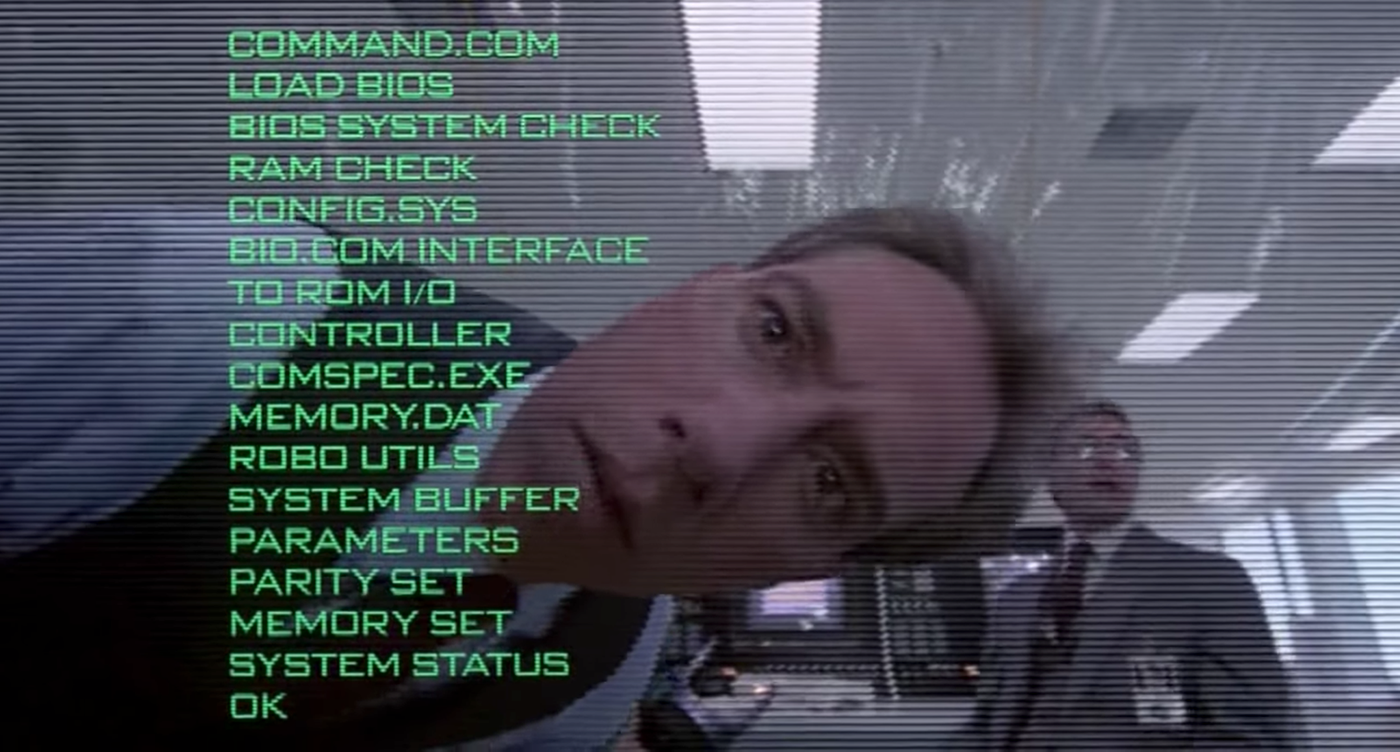

Отдельным большим вопросом неизбежно станет совмещение автономных боевых систем с нейросетями. Нейросети могут существенно повысить гибкость, адаптивность и общую эффективность боевых машин, сделать их самообучаемыми, гораздо более живучими и смертоносными — но это же делает их поведение гораздо менее предсказуемым даже для собственных создателей и владельцев. И начинает совсем уж откровенно напоминать классику антиутопий вроде «Терминатора» и страж-птиц Роберта Шекли. А уж если дело дойдёт до автоматизированных систем управления войсками… ну вы поняли.

Всё это открывает массу сложнейших вопросов, которые, так или иначе, придётся решать в ближайшие десятилетия. Опыт человечества показывает, что универсальных рецептов и алгоритмов нет. Люди воздержались от боевого применения ядерного оружия после Хиросимы и Нагасаки – хотя у очень многих «чесались руки» применить его в локальных конфликтах. Люди сумели не пустить в ход огромные запасы химического оружия даже среди жесточайшей Второй мировой войны – за прискорбным исключением японских войск в Китае. В то же время попытки запретить применение, скажем, белого фосфора и противопехотных мин до сих пор не слишком успешны.

Интенсивность международной дискуссии об автономных боевых системах будет возрастать параллельно росту интенсивности их боевого применения. Многое будет зависеть от практики этого применения: от реальной эффективности и полезности на поле боя для военных, от числа громких трагедий, связанных с их использованием.

Возможно, войны будущего превратятся в столкновения армий роботов почти без участия людей. Возможно, общественное давление окажется настолько сильным, а выгоды применения – сомнительными, что сами ведущие военные державы со временем сочтут за благо поддержать запрет и следить за его выполнением. Однако даже в этом случае ход прогресса приведёт к тому, что довольно скоро автономную боевую машину, в том числе с нейросетью, можно будет собрать «в гараже». Что будет иметь следствием ещё одну гору сложнейших военных, социальных и политических проблем.

Ясно только одно: мы уже вступили в эпоху роботов-убийц, превратившихся из фантастики в реальность, и в ближайшие годы мы всё чаще будем видеть их на полях сражений XXI века.

Такие дела.

Комментарии (77)

Areso

23.10.2021 13:38+14Военные, которые выполнят любой приказ.

Военные, которые никогда не устроят переворот.

Военные, на пенсию которых не нужно тратить средства, сопоставимые с бюджетами регионов.

Военные, которые не чувствуют боли и страха.

Военные, которые не развлекаются "неуставными" отношениями, когда они не заняты рытьём окопов, подметанием плацов ломами, формовкой снега (и покраской снега в маскирующий белый цвет) и постройкой дач генералам.

Ну разве это не мечта? Всего за 1 999 990 рублей в минимальной комплектации, без учета НДС.

NickKolok

24.10.2021 23:49+1Военные, которые никогда не устроят переворот.

Переворот устраивают не рядовые. Как минимум со времён декабристов.

И да, Каганов, "Магия".

Areso

23.10.2021 13:41Ну и инфа у автора старая, про автономных убийц.

https://pikabu.ru/story/robotizirovannaya_pushka_otkryila_ogon_po_svoim_2007_god_7364745

Это нам еще на первом курсе рассказывали.

drWhy

23.10.2021 13:43+1Законы робототехники? Не, не видели.

Вероятность взлома мобильных дронов или простого сбоя автономных? Да не, бред же…

Ошибки в ПО? Пофиксим.

I'll be back.

Well, we'll be waiting…

Кстати, японский Kuratas прямо с татиком из GitS писан. Или vice versa?

DaneSoul

23.10.2021 14:07+6Так люди тоже далеко не идеальны и порой намного менее предсказуемы.

Вероятность взлома мобильных дронов или простого сбоя автономных?

Вербовка бойца противником и в результате совершение диверсий «своими»?Ошибки в ПО? Пофиксим.

Психические срывы, когда солдат с автоматом беспорядочно расстреливает десяток сослуживцев без всякой видимой причины?

drWhy

23.10.2021 14:28+5Вербовать нужно каждого по отдельности, это процесс, нужны специалисты и время и подходящее место, да и не каждый может быть завербован. Иногда возможна перевербовка или заведомо двойной агент — можно получить плюшки. Опять, же нужны специалисты и время.

Взлом сети открывает доступ к управлению всеми экземплярами, и вы возможно никогда не узнаете, подвергся ли конкретный взлому и представляет ли он опасность, возможно отложенную. Никакие специалисты не обнаружат гарантированно всех возможных закладок.

А такая ядрёна матрёна на параде?

DaneSoul

23.10.2021 14:35+1Вербовать нужно каждого по отдельности, это процесс, нужны специалисты и время и подходящее место, да и не каждый может быть завербован. Иногда возможна перевербовка или заведомо двойной агент — можно получить плюшки. Опять, же нужны специалисты и время.

С вербовкой пример пожалуй действительно не самый удачный, но вот сдавались в истории противнику порой довольно большими группами.

MUTbKA98

23.10.2021 14:25+1Ну вот вам же недорогое решение проблемы глобального потепления. Никакого радиоактивного заражения местности. И никто даже виноват особо не будет.

Где бурная радость "зеленых"?

Fen1kz

23.10.2021 14:44+11Скорее бы уже. Тогда айтишники смогут совершить полноценный военный переворот и начать заменять министерства скриптами.

sim31r

26.10.2021 00:01Законы и так по сути скрипты. Даже в общинно-племенном строе были законы передаваемые в устной форме, ими и руководствовались.

Искусственный интеллект как-раз может принести гибкость в управление. Но со стороны может выглядеть как иррациональность. Например для предотвращения преступлений он может изолировать часть людей без особой видимой причины, типа паттерны поведения соответствуют будущему преступлению и рекомендуется пожизненная изоляция.

Wesha

26.10.2021 00:38Но есть

хакерыlawyers, которые могут убедить суд, что "вот эту часть закона следует читать так, как надо моему клиенту, а не так, как вы читаете".

azatfr

23.10.2021 18:11+3Пока «дрон» не просит вашу одежду и ваше транспортное средство бояться нечего.

Crazyvlad

23.10.2021 18:24Потом будет уже поздно бояться....

unsignedchar

23.10.2021 18:58+7Если просит, то не все так плохо. Самонаводящиеся ракеты просить не умеют.

Wesha

24.10.2021 04:02+1Есть одна такая масенькая проблема: примерно через 3-4 часа это передвижное укрытие превращается в одиноко стоящее укрытие, через 80 выстрелов - в безоружное укрытие, а примерно через сутки (если в нём есть экипаж) - в нём начинает пахнуть мочой, а то и другими отходами.

shyneko

25.10.2021 12:32+22-3 часа? Я где-то читал, что планируемое время жизни танка на поле боя 15 минут.

Wesha

25.10.2021 18:12Это в случае конфликта двух сторон с примерно равным уровнем развития военной техники. А сейчас практически все конфликты сводятся к "противник с развитой военной техникой vs иррегулярные формирования с тойотачанками".

unsignedchar

25.10.2021 23:27практически все конфликты

Практически 2. Причем в одном из случаев противник с развитой военной техникой уступил поле боя тойотачанкам.

А так обычно силы противников более-менее равны. Не воюют с копьями против танков.

Wesha

26.10.2021 00:45Возьмём XXI век (и выкинем Афганистан, хотя там причина чисто политическая). США-Либерия (2003), США-Ирак (2003), США-Ливия (2011, 2015), США-Сирия (2014), США-Йемен (2015). Это УЖЕ несколько больше 2.

Не воюют с копьями против танков.

Зато партизанами и суицидниками - вполне.

unsignedchar

26.10.2021 07:44Против партизан и суицидников танки и авианосцы максимально неэффективны.

unsignedchar

24.10.2021 07:39+3Есть такая вещь как тактика. Танк, который просто едет вперёд и стреляет куда попало - через 5 минут будет уничтожен. Пехотинец, который просто бежит и стреляет - тоже. Почему робот должен тупо бежать прямо? Почему робот обязательно не должен координировать свои действия с другими роботами? Подкрадываться с таймером к вооруженному пушкой роботу, которого, возможно, прикрывают другие роботы (или даже люди) - интересный способ самоубийства.

3epg

23.10.2021 19:00+1T-1000 ни у кого одежду не просил. И транспорт не просил. Как в какой-то песенке: "Нам чужого не надо, но своё мы возьмём, чьё-бы оно не было!" ))

nikolz

23.10.2021 20:40Странно, что никто не обращает внимание на тот факт, что уничтожение таких роботов гораздо проще и дешевле, чем уничтожение ими боевой силы противника.

DaneSoul

23.10.2021 23:47+1А если они действуют как единая скоординированная сеть?

Видели возможности микроменеджмента AI в StarCraft?

unsignedchar

23.10.2021 23:51+1Странно, что никто не обращает внимание на тот факт, что танк ценой в несколько млн денег можно уничтожить простой бутылкой с напалмом.

:)

Kilorad

24.10.2021 01:17+4Не очень понятны этические вопросы.

Если робот постреляет "не тех", ответственность будет размыта. А если человек? Допустим, человек в некоей сомнительной ситуации принял сдающихся солдат противника за хитрых шахидов, которые идут его взорвать. И на всякий случай убил их. Кто за это будет отвечать? Он сам? Ну ок, его потом посадили за это военное преступление. Ну и что дальше-то? Что изменилось? Нашли виновного, посадили, на остальных это не повлияло никак. Или повлияло? И остальные станут воздерживаться от таких поступков? Тогда чем это глобально отличается от накатывания патча на робота?

Если человек совершил военное преступление, то очень легко сказать, что он виноват. А потом следующий виноват... И так далее. Очень удобно. Наказали человека - всё, проблемы же больше нет? Виноваты же солдаты, а вовсе не система их подготовки, которая неправильно обучила, и вовсе не политрук, который перестарался с рисованием образа врага, и вовсе не генерал, который этому политруку может премию срезать. А если робот накосячит, то будет слишком очевидно, что наказывать его бесполезно, а надо решать проблему. И решать её где-то уровнем выше: либо на этапе командования, либо на этапе обучения командира, либо на этапе программирования.

В общем, выглядит так, что у людей есть какое-то глобальное когнитивное искажение: нашли виновного = решили проблему. А с роботом это не прокатит.

А вот то, что роботы многих тактических нюансов не понимают - это да, проблема. Но выглядит скорее как повод сделать робота удобным для апдейтов

Wesha

24.10.2021 05:02выглядит скорее как повод сделать робота удобным для апдейтов

А потом ушлый Энди Патрик под шумок накатит свой апдейт...

Kilorad

24.10.2021 22:24Ну люди тоже не выглядят сильно надёжными. Они могут саботировать приказы, предавать,устраивать перевороты, сходить с ума. Они могут стать жертвой шантажа, манипуляции, подкупа, переубеждения.

JPEGEC

25.10.2021 05:45+1И на всякий случай убил их. Кто за это будет отвечать? Он сам? Ну ок, его потом посадили за это военное преступление. Ну и что дальше-то? Что изменилось? Нашли виновного, посадили, на остальных это не повлияло никак. Или повлияло? И остальные станут воздерживаться от таких поступков?

Можно убрать слово "военное". И поразмыслить для чего вообще вся эта ерунда с системой наказаний. И почему это не сработает в случае робота.

Kilorad

25.10.2021 09:43+1Можно ещё поразмыслить, зачем вообще наказывают преступников - какого результата добиваются. И подумать, как такого результата добиться для робота. И не стоит ли опыт от робота частично перенести на людей

wtigga

26.10.2021 15:15+1Спасибо, пришёл написать ту же мысль. Не вижу принципиальной разницы между убийством роботом или человеком — наоборот, это даже решает некоторые проблемы распределения реальной ответственности.

Истерика стариков из ООН выглядит так, будто они в самом деле боятся восстания роботов, как в замшелых боевиках конца ХХ века.

Interreto

24.10.2021 05:39Это направление, робот + пушка, считаю тупиковым. На мой взгляд имеет смысл автономный рой роботов-разведчиков объединённых в боевую сеть с системами ведения огня и боевым составом. Актуальная и полная «картинка» боя важнее чем уничтожение боевой единицы противника на месте.

bbs12

24.10.2021 09:00+1кого именно и как признавать виновным в убийстве, решение о котором было принято автономным роботом согласно алгоритмам

Когда только-только возникли первые живые организмы, один организм по какой-то причине убил другого и съел его. Возможно у него в РНК/ДНК произошла какая-то мутация, которая привела к таким действиям. После этого этот организм получил преимущество и смог копировать свою ДНК более эффективно. От этого организма ведут свою историю все убийцы, хищники, паразиты. От его генов произошли наши гены, которые вызывают у нас инстинкты и желание убивать, в том числе создавать такие машины, которые будут способны на убийство.

Нужно построить машину времени, вернуться в прошлое и надавать этому первому убийце лещей, потому что он во всём виноват.

Wesha

24.10.2021 09:59+3Нужно построить машину времени, вернуться в прошлое и надавать этому первому убийце лещей, потому что он во всём виноват.

Только учтите, что обеспечивающие Вас энергией митохондрии появились в Ваших клетках из-за того, что один из первых убийц проглотить-то бактерию проглотил, но переварить забыл. И всё заверте...

sim31r

26.10.2021 00:07+1один организм по какой-то причине убил другого и съел его

Причина дефицит ресурсов, причина сохраняется и по настоящее время.

e_u_g

24.10.2021 13:04+2Людей посадят

в тюрьмуна карантин, ибо ню-ню-ню ковид. Боевые роботы сражаются между собой, охраняя сельскохозяйственных роботов, выращиваюх в теплицах еду, и кулинарных роботов, печатающих гамбургеры. Финансирование приходит от торговых роботов с биржы. А карантин протекает в уютных камерах, напечатаных естественно роботами.

Wesha

24.10.2021 19:57+1Остаётся сделать робота, который будет всё это есть...

Осталось выяснить, зачем здесь

скрипаччеловек.

631052

24.10.2021 13:05как кого именно?

коль скоро замочил согласно алгоритмам - автора алгоритма, вестимо.

как сейчас судят автора нажатия на спусковой крючок, хотя убил не он, а пуля.

muhaa

24.10.2021 15:22Этичная война - это абсурд. Химическое и ядерное оружие не используют не по этическим соображениям а потому что они не позволяют достичь желаемых целей.

Как только роботы станут достаточно боеспособными, будут построены армии роботов и если к тому времени мир не изменится этих роботов будут свободно продавать отсталым диктаторским режимам, как им продают обычное оружие.

Плохо это или хорошо - сложно сказать. Понятно, что при этом те кто имеет технологическое и экономическое превосходство смогут почти без человеческих потерь контролировать остальных. Но в целом последние 200 лет и без роботов это так и работает.

Вряд ли роботы будут действительно убивать людей на поле боя. Никто просто не пойдет в живую с автоматом против роботов.

631052

24.10.2021 19:06правила ведения войны - дело такое.

если их нарушит тот, кто в итоге выиграл - кто ж с него спросит?

а с проигравшего спросят вдвойне за их "нарушение".

zlat_zlat

25.10.2021 18:03Очень много хороших слов и ни одного о том, чем всё же "погранично" эти роботы отличаются от самонаводящихся ракет. Их кто-то выпустил? Ну так и роботы, наверное, не сами решают, что пора идти на задание. Кто отвечает, если ракета самонавелась не туда/задела дом/упала не найдя цель? Ну, кто-то отвечает. Но в основном за утрату ракеты, ибо недешёвая она. Уверен, и сейчас цена роботов всё ещё гораздо выше цены многих потенциальных целей, и просто так они рядом с пехотинцами не пойдут, ибо могут быть уничтожены довольно дешёво. Охрана объектов выглядит куда более приемлемо (ибо защищаемый объект, очевидно, дороже робопсов).

voidMan

26.10.2021 00:26Интересно, а если всё таки договорятся что роботы будет воевать вместо людей, то ЭМИ-оружие будет приравнено к ядерному? Уже как совсем последнее средство, и у кого пушки мощнее, те и будут диктовать условия?

Конечно вопрос доставки такой бомбы тоже не так прост, но вполне решаем, и наверное радиуса действия вполне достаточно (но я не сильно в теме, больше домыслы)

kraidiky

27.10.2021 21:58-1И как всегда авторы стыдятся признаться, что мины с дистанционными взрывателями, самонаводящиеся ракеты, и автоматические зенитные пушки изобретены не в этом году, не в прошлом, не в этом десятилетии и даже не в этом веке, и от описанного в статье ничем абсолютно не отличаются.

Dekmabot

Будем честны, мы здесь все "за всё хорошее против всего плохого". С одной стороны радостно, что плохих парней будут убивать роботы, а не люди, жертвуя собой. С другой стороны, вопрос правомерности некоторых операций, как и этическая сторона вопроса, пока не понятны.

Согласен что такие системы должны появиться, но бета-тестирование будет непростым.

drWhy

А как оказаться на стороне заведомо хороших парней?

Diordna

Хорошие парни сильнее.

azatfr

Кто остался жив тот и является хорошим парнем.

drWhy

Боюсь, утерял свой справочник по контрамоции.

kuzzzov

Мы хорошие, они плохие. Чего не понятно?

drWhy

Уже ближе. А из нас-то кто хорошее?

bak

Да.

Kilorad

Делать боевых роботов, разумеется

rtkprg2

Будем молиться, что бы те, у кого будут такие роботы, не записали нас в "плохих".

titsi

в таком случае, остается еще вариант- создавать своих роботов. И тогда можно из плохих перевестись в хороших.

drWhy

Вы про эту престарелую таксу? Чтобы хорошие парни не смогли стрелять от смеха?

titsi

Ну как один из способов)

Wesha

Это она берёт разбег. :)

Потенциальному партнёру всю-всю правду показывали только при Ельцине.

alexbalkan

Плохие ребята в бункерах отдают приказы. А солдат он и в африке солдат, всего лишь выполняющий приказы, и тоже человек. Как можно убивать людей если например решили сдаться в плен? Не всегда среди солдат разделяющие действия "генералов". А автономные системы будут безжалостно убивать людей. Как-то это все грустно.

shyneko