Как холодная война между США и СССР породила современный интернет, запустила эволюцию серверов и раскрутила рынок вычислительных мощностей.

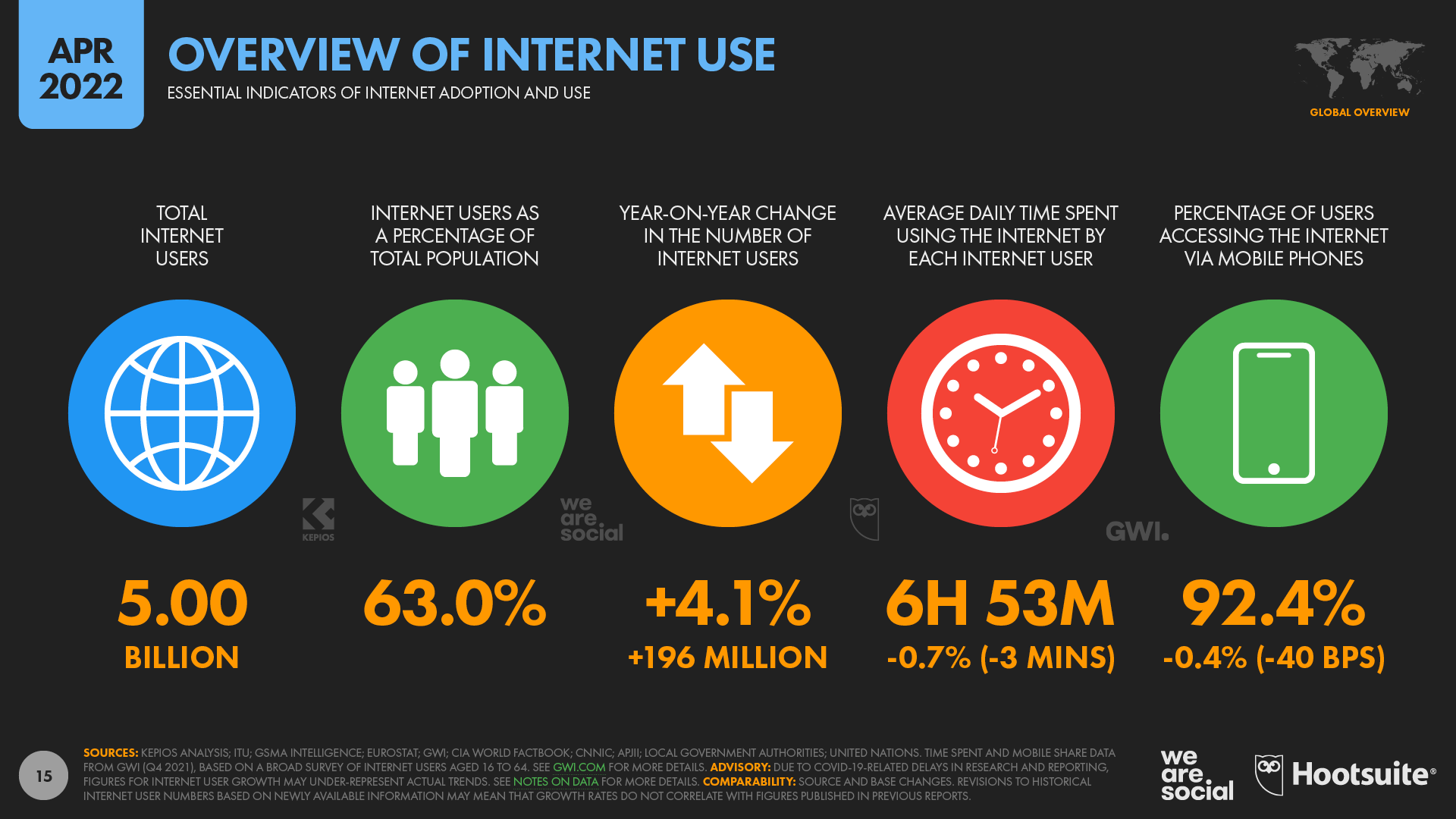

Согласно данным Hootsuite за апрель 2022 года, в мире насчитывается свыше 5 миллиардов пользователей интернета — это около 63% населения планеты. Только за последний год их количество выросло на 4% — почти на 200 миллионов человек. В среднем они проводят в сети по 7 часов в день.

Самые посещаемые ресурсы — чаты и мессенджеры. На них приходится 95,7% пользователей. Второе и третье место занимают социальные сети (95,2%) и поисковые системы (82,4%). При этом, минимум 57% пользователей совершали покупки в интернете за последний месяц. Мобильные телефоны есть у 5,32 миллиардов человек или 67% населения мира — это даже больше, чем количество людей в интернете.

Обучающие материалы, смешные видео, компьютерные игры, видеозвонки, денежные переводы — тысячи дата-центров и миллионы серверов ежесекундно обрабатывают миллиарды сетевых запросов, выдавая необходимую информацию.

Но так было не всегда. Каких-то 50 лет назад всего 2 компьютера, подключенных к сети, длина которой не превышала и 1000 километров, едва могли передать друг другу слово.

Сперва Бог создал землю, свет и… Интернет

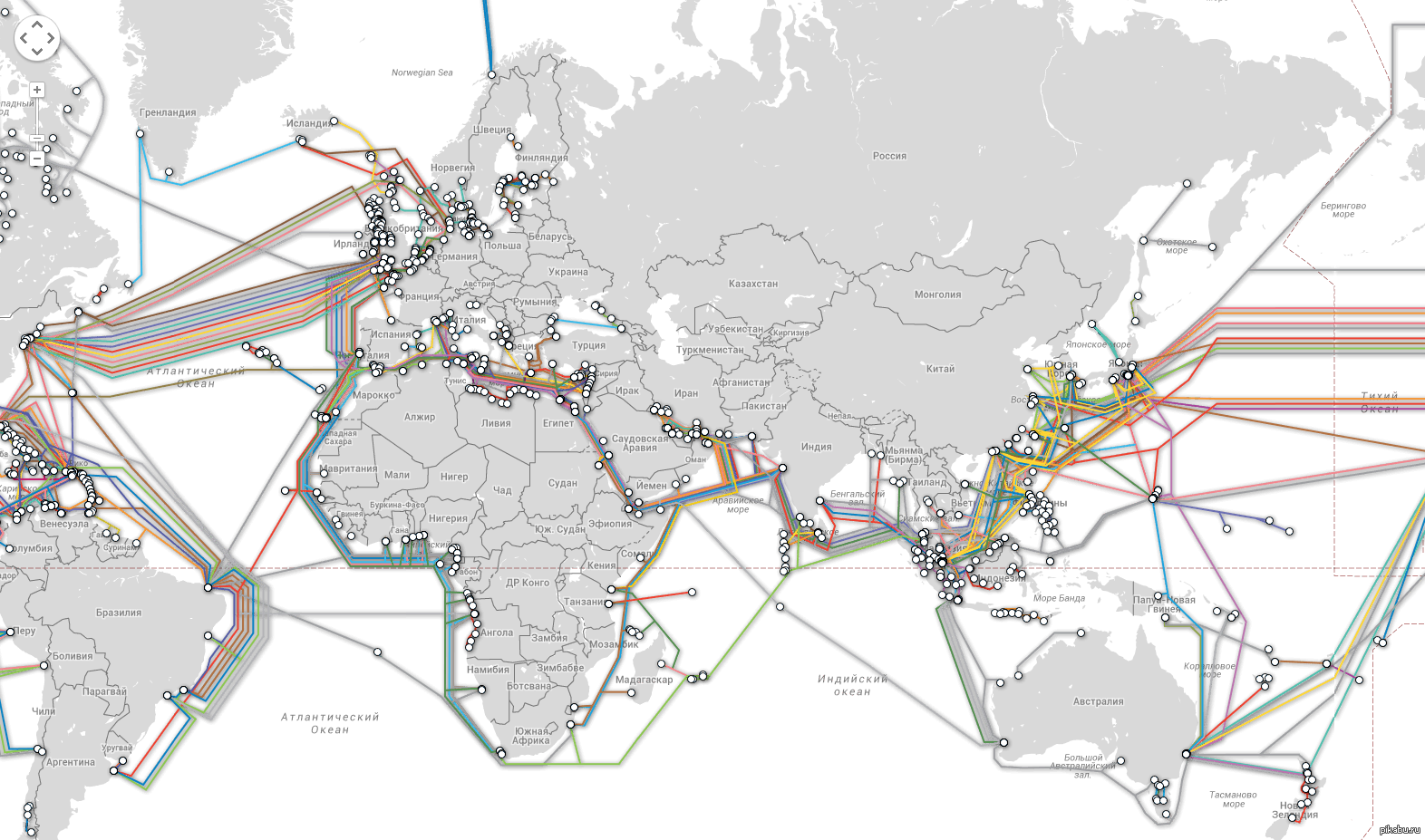

Перед тем, как огромные дата-центры стали сдавать свои мощности в аренду, формируя отдельную индустрию, интернет эволюционировал десятки лет от военной сети без маршрутизации до огромной инфраструктуры с подводными кабелями и распределенными центрами обработки данных.

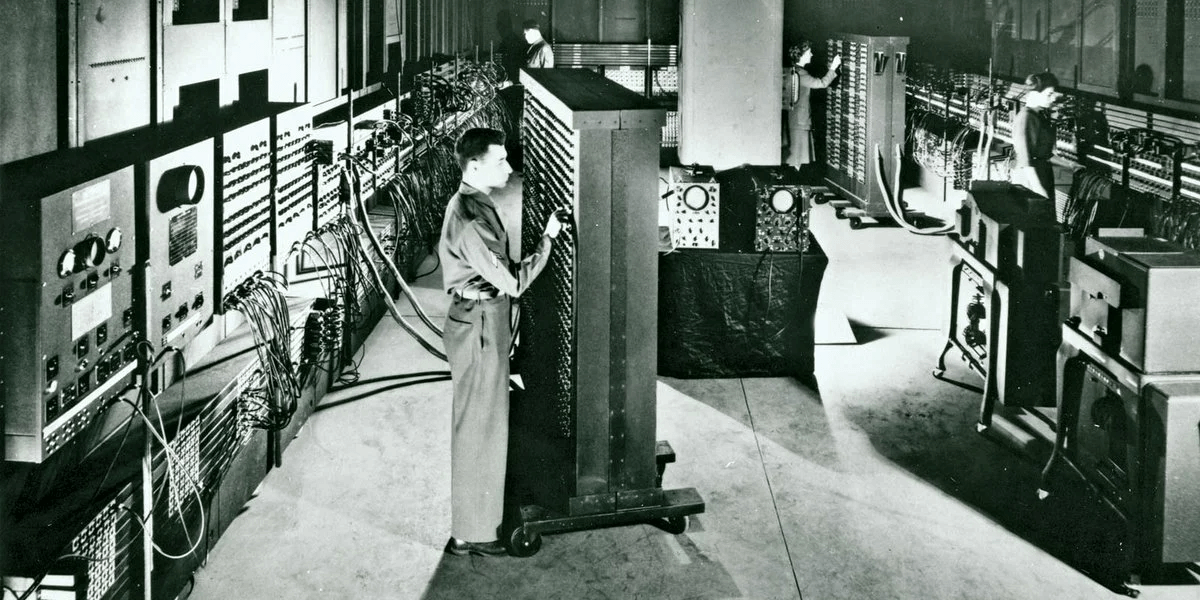

Еще в далеком 1969 году управление DARPA (Defense Advanced Research Projects Agency) Министерства обороны США разработало сеть ARPANET — именно она послужила прототипом современного интернета.

Шла холодная война. Передавая данные на перфокартах физически, США считали себя достаточно уязвимыми, поскольку росли опасения ядерной атаки. При попадании ракет в стратегические объекты критически важная информация могла бы оставаться сохранной, распределяясь по сетевым узлам с достаточно высокой скоростью — оперативность передачи данных в такой ситуации является еще одним преимуществом.

Основными разработчиками новой технологии выступили Калифорнийский университет в Лос-Анджелесе и Стэнфордский исследовательский центр. Именно тогда была придумана концепция иерархии протоколов передачи данных — уровни взаимодействия частей компьютеров в сети делились на аппаратный, программный, модемный и другие. Кстати, на этом этапе был придуман всем известный протокол FTP для передачи данных — задолго до появления HTTP и даже TCP/IP. Для управления компьютерами в качестве терминального протокола был создан Telnet — сегодня он уже утратил свою актуальность.

При первом запуске сеть состояла из двух терминалов, максимально удаленных друг от друга, чтобы проверить систему в предельных состояниях. Первый терминал находился в Калифорнийском университете, а второй на расстоянии 600 км от него — в Стэнфордском университете. В качестве теста оператор вводил слово «login», а второй подтверждал, что он видит его у себя на экране. Первая попытка потерпела неудачу — отобразились только буквы «l», «o». Но уже через час сеанс провели повторно и все получилось.

Короче говоря, первоначально ARPANET предназначалась исключительно для целей военных и спецслужб.

В такой сети сообщения можно было отправлять только между двумя одновременно подключенными компьютерами. Однако, в 1971 году, программист ARPANET Рэймонд Томлинсон создал систему, которая отправляла сообщения между несколькими хостами. Кстати, Томлинсон официально признан изобретателем электронной почты в том виде, в каком мы ее знаем сегодня. Например, он представил современный синтаксис, который включает знак «@» для отделения имен пользователей от имен хостов. Уже в 1973 году общение по электронной почте занимало 75% всей активности в сети.

Спустя 10 лет ARPANET перешла на маршрутизацию пакетов данных. Уже тогда в качестве протокола использовался TCP/IP — с некоторыми изменениями он по-прежнему является основным протоколом передачи данных.

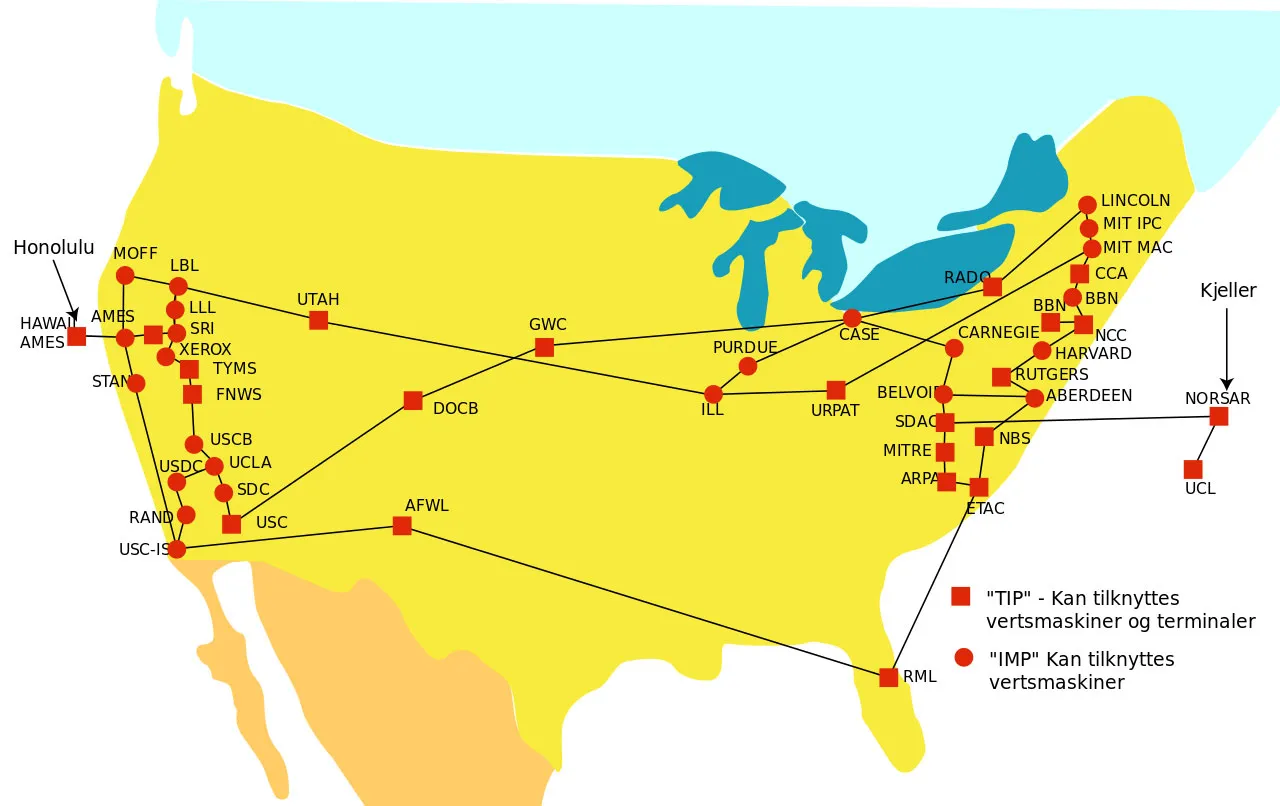

ARPANET активно росла — её использовали учёные из разных областей науки. Если в 1971 году к сети было подключено около 20 терминалов, то уже к 1983 году — 4000. Более того, через ретранслирующие спутники была налажена связь с Гавайями и Европой.

Первым провайдером, который получил право предоставлять желающим сеть ARPANET стал Telenet. Для этого появился даже отдельный термин — Internet Service Provider (ISP).

Это произошло, когда научно-исследовательская компания Bolt Beranek и Newman, будучи частным подрядчиком ARPANET, решила создать версию сети для частного сектора. Поэтому в 1975 году Telenet запустил первую общедоступную сеть с маршрутизацией пакетов.

Впоследствии у ARPANET появился серьёзный конкурент — Национальный фонд науки США (NSF) и его межуниверситетская сеть NSFNet, имеющая гораздо большую пропускную способность.

NSFNet по всем параметрам выигрывала у ARPANET — была быстрее, дешевле и связывала больше компьютеров. В конце концов, ARPA передали входящее в сеть оборудование проекту NSFNet. Прожив 22 года, ARPANET прекратила своё существование в июне 1990 года, а на ее место постепенно пришел привычный нам Интернет.

Пузырь доткомов лопнул, а на его месте появилось облако

С 1980-х годов начинается распространение персональных компьютеров среди обычных людей — массовый спрос на сети стремительно растет. Основной интерес — общение и пересылка популярных текстов.

Появление операционной системы Unix от AT&T в 1970-х годах коренным образом повлияло на вычислительные системы. Сотрудники Bell Labs (часть AT&T) Кен Томпсон, Деннис Ритчи и Дуглас Макилрой начали разрабатывать замену используемой на тот момент операционки разделяемого времени Multics.

Новая система, созданная под мини-компьютер PDP-7, изначально называлась Unics — Uniplexed Information and Computing Service, по сути, отсылка к Multics — Multiplexed Information and Computer Services. В итоге во избежание нежелательных аллюзий последние две буквы заменили на «x» — Unix.

Unix изначально задумывался как открытая и свободная ОС, внести вклад в которую может любой программист, подстроив систему под свои задачи. Поэтому Томпсон и помогающий ему Ритчи разработали язык B — более упрощенную итерацию интерпретируемого языка BCPL. Вторая редакция Unix была написана именно на нем.

К третьей редакции системы, выпущенной в 1973 году, язык B был усовершенствован, а его новая версия получила незамысловатое название C. В этом же году ядро ОС было повторно переписано на новом языке. И несмотря на то, что многие составные части операционной системы все еще были написаны напрямую на ассемблере, Unix имел достаточно высокую портируемость.

В 1991 году настал момент, когда NSF все-таки разрешил другим коммерческим локальным сетям использовать свою магистральную сеть NSFNET, которая ранее использовалась только для обучения и исследований.

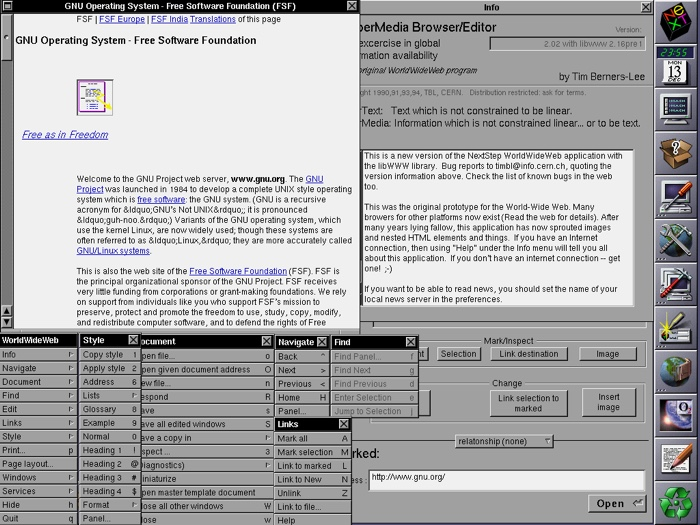

Примерно в это же время Тим Бернерс-Ли со своими коллегами из CERN разработал модель Всемирной паутины — гипертекстовые документы, связанные между собой гиперссылками. Реализация уже тогда имела знакомые нам конструкции вроде идентификаторов URI (и URL), протокола HTTP, языка HTML, страницы 404, веб-браузера и т. п.

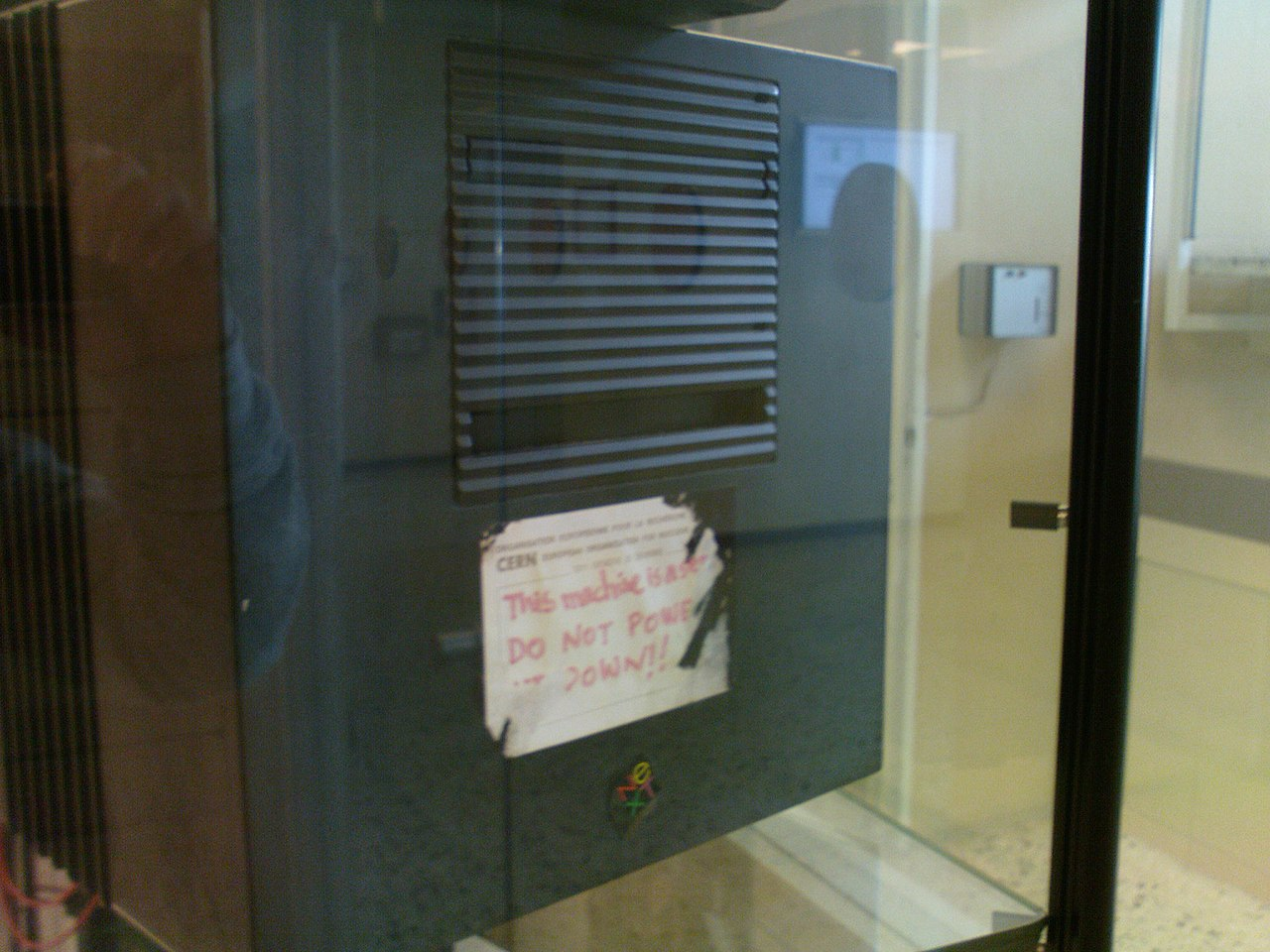

В своей лаборатории Тим Бернерс-Ли использовал рабочую станцию NeXTcube. На языке C он написал первый в мире HTTP-сервер — CERN httpd. Впоследствии на его место пришли Nginx и Apache. Сама станция работала под управлением операционной системы NeXTSTEP.

На этой же платформе был создан первый в мире браузер WorldWideWeb (да, в одно слово), который позже был переименован в Nexus, чтобы не путаться с названием «Всемирной паутины».

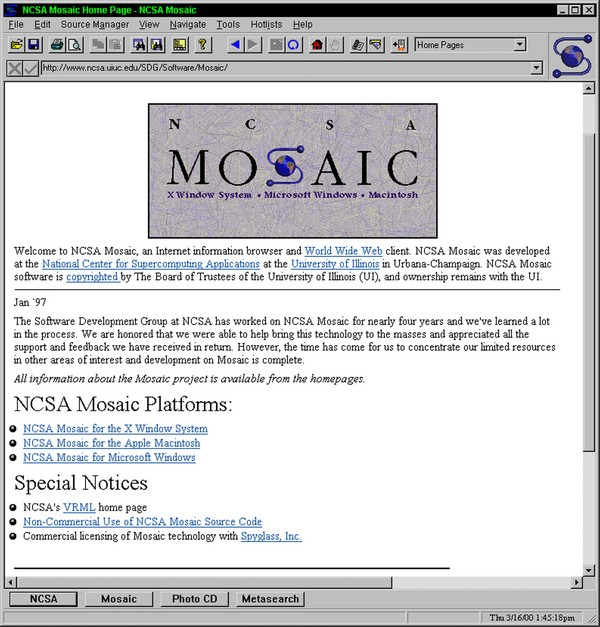

Спустя 3 года появился более популярный и удобный браузер NCSA Mosaic, разработанный Марком Андриссеном и его командой из Иллинойского университета. Mosaic был кросс-платформенным — он запускался на всех популярных операционных системах, включая Windows и Mac.

Кстати, изначально доступ к серверам можно было получить, только введя их числовой IP-адрес. С ростом количества хостов, подключенных к сети, запоминать их адреса становилось все труднее, поэтому на помощь пришла система доменных имен — DNS. В те времена было всего семь доменов верхнего уровня — com, net, org, int, mil, gov и edu. И самым первым зарегистрированным доменом был symbolics.com — он до сих пор доступен.

Получить доменное имя мог абсолютно каждый, просто запросив его у NSF по почте или телефону. Когда количество доменов значительно увеличилось, NSF наняла Network Solutions в качестве частного подрядчика для управления адресами. Поэтому они перестали быть бесплатными — в 1995 году домены продавались по 100 долларов за двухлетнюю регистрацию.

Как было сказано ранее, появившийся в 70-х Unix заложил некий вектор, по которому развивались многие другие операционные системы — их не случайно начали называть Unix-подобными. Одна из таких систем — Linux, созданный в 1991 году. Linux был разработан Линусом Торвальдсом, а также Ричардом Столлманом, чей проект GNU также стал частью ОС.

Споры на тему того, как правильно называть эту операционную систему (Linux, GNU или GNU/Linux) из-за используемого в ней кода — отдельная тема. Если кратко, GNU — это программное обеспечение и периферия операционки, а Linux — ее непосредственное ядро.

Однако, важно другое — GNU/Linux выпускалась (и выпускается) под свободной лицензией и быстро распространилась среди бизнеса и хостинг-провайдеров.

Количество пользователей сети росло. Однако, если ты хотел разместить сайт в Интернете, тебе приходилось держать собственный компьютер или сервер. В 90-х годах это было не так уж просто — техника стоила дорого и требовала экспертности для обслуживания.

Держать собственные серверы могли позволить не все — на момент 1993 года в Интернете было всего 623 сайта. Поэтому компании, сдающие в аренду собственную инфраструктуру для размещения страниц, появились довольно быстро. К 1995 году уже работали GeoCities, Angelfire и Tripod — все они предлагали бесплатный хостинг, получая доходы от баннерной рекламы.

Самый интересный — GeoCities. Платформа имела несколько тематических разделов-городов. Веб-адрес публикаций пользователя включал название города и уникальный номер «дома». Да, сайты, созданные на GeoCities, имели примитивные макеты, однако именно они стали первым опытом использования хостинга для миллионов людей. Angelfire и Tripod следовали той же бизнес-модели.

Другие компании, вроде 50megs и Hostmonster, запущенные в 1996 году, стали предлагать полноценные платные пакеты хостинга с большим количеством дополнительных функций.

Во многом появление в 1995 году свободного HTTP-сервера Apache повлияло на ход развития истории хостинга. Apache («a patchy» — «в заплатках») пришел на замену популярного тогда NCSA HTTPd.

Особенностью сервера была возможность создания виртуальных хостов, когда множество сайтов находятся на одном IP-адресе. В таком случае они распознаются либо по доменному имени, либо по выделенному IP-адресу, являющимся уникальным для конкретного сайта.

Кстати, в 1995 году появился язык, добавляющий большую пластичность в сеть и ее контент — PHP, который динамически генерирует HTML-страницы на стороне сервера.

Датский программист Расмус Лердорф изначально создал простой набор CGI-скриптов на языке C для учета посетителей в своем онлайн-резюме. По сути, это был небольшой тулсет для внутреннего использования, который так и назывался — «PHP Tools», сокращенно от «Personal Home Page».

Впоследствии Расмус расширил PHP Tools до более богатой реализации и открыл исходный код. На 2-ой версии языка к проекту подключились сотрудники израильского технологического института Технион — Энди Гутманс и Зеев Сураски.

Apache (впрочем, как и другие HTTP-серверы) взаимодействует с приложением PHP (его скриптами) через интерфейс общего шлюза CGI — по сути через консоль ввода и вывода, служащей своего рода медиатором между программами. За счет этого можно использовать любой язык программирования, умеющий работать со стандартным вводом-выводом.

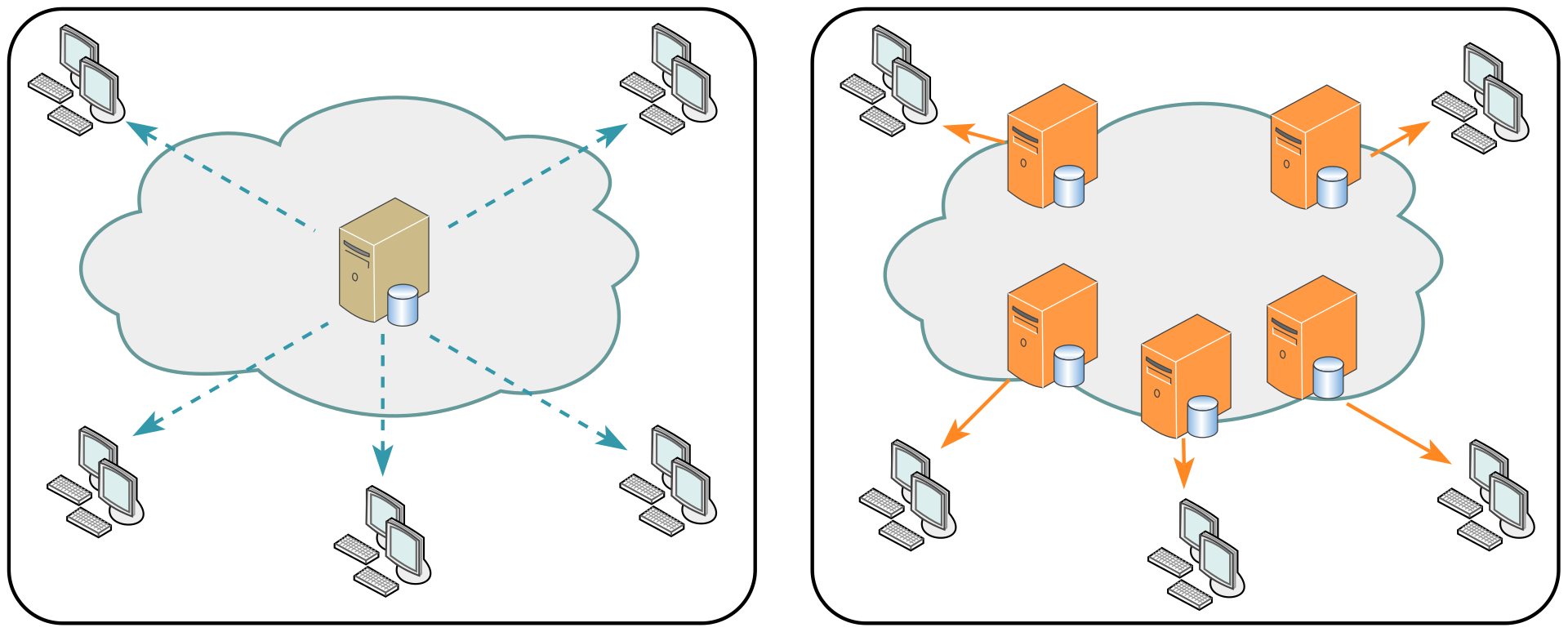

Когда количество дата-центров и серверов в разных частях планеты стало расти, начал зарождаться рынок CDN (сеть доставки содержимого) — географически распределенная инфраструктура, ускоряющая доставку контента пользователям.

В CDN контент децентрализованно хранится в разных точках мира, отправляясь по запросу пользователя с ближайшего к нему сервера. Это сокращает количество маршрутизаций, увеличивая скорость передачи данных. К тому же, информация, кэшированная в разных дата-центрах, более сохранна — в случае ее потери в одной точке, ее всегда можно найти в другой.

В 1998 году лидером CDN стала компания Akamai. Впоследствии были запущены и другие сервисы — Limelight Networks, Amazon CloudFront, Fastly и т. д.

Интересно, что события 11 сентября во многом повлияли на дискуссию о CDN и количество вкладываемых в технологию средств — в те дни масса интернет-пользователей попытались одновременно получить доступ к новостным сайтам, что вызвало серьезные проблемы в их работе — более развитая сеть CDN распределяет запросы по серверам в разных частях мира, снижая нагрузку. Кстати, это одна из причин, почему CDN достаточно устойчива к DDoS-атакам.

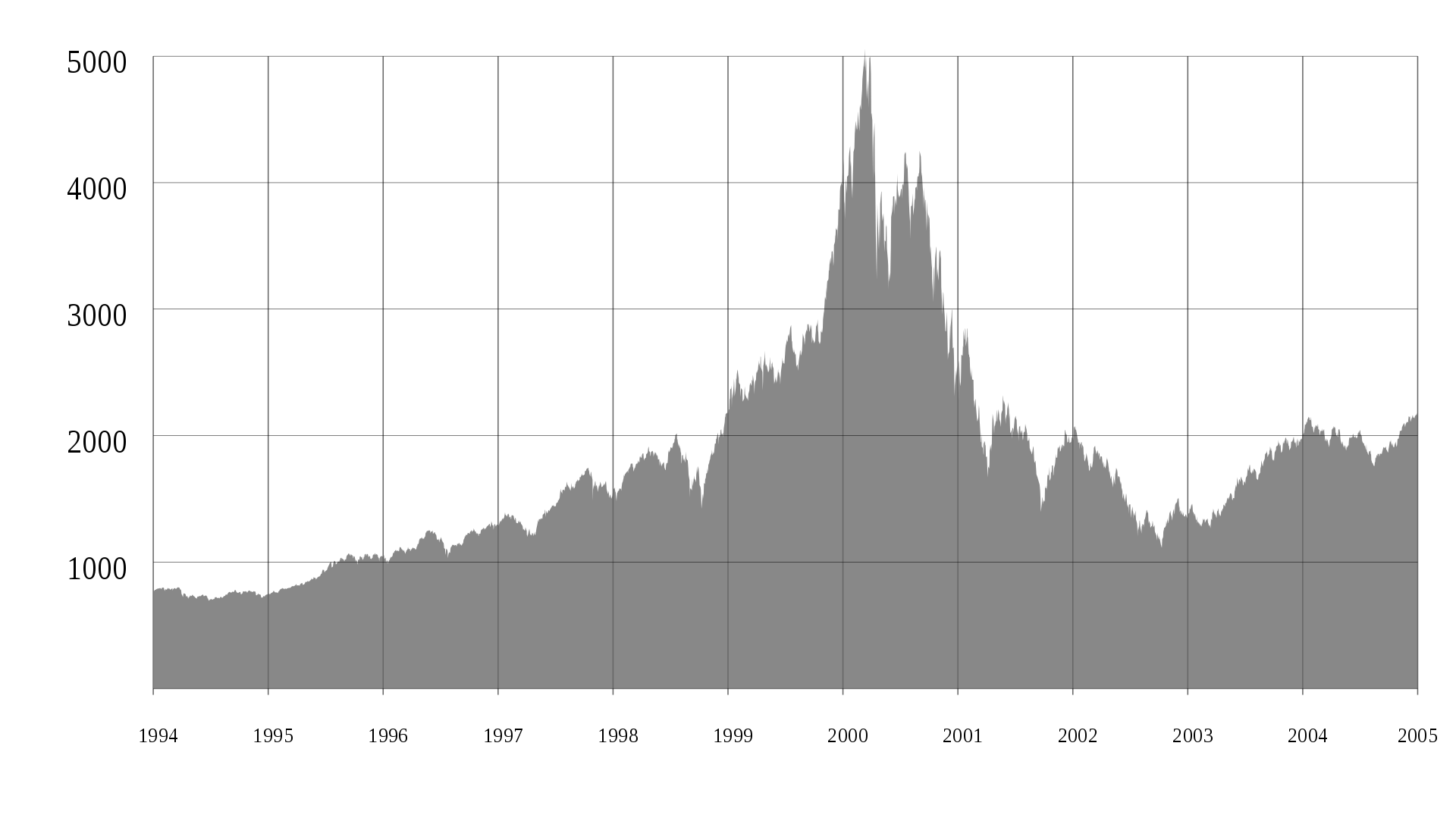

В общем, Интернет набирал обороты. И во многом, столь высокие темпы развития привели к созданию пузыря доткомов — с 1995 по 2001 год возникало все больше организаций, предлагающих использовать Интернет для получения дохода. Комментаторы и экономисты называли это эрой «новой экономики», а общество было в предвкушении кардинальных изменений и появления совершенно новых бизнес-моделей. Банки давали кредиты, медиа-машина крутила дорогую рекламу, однако все это закончилось ничем.

10 марта 2000 года индекс NASDAQ пробил 5132 пункта, после чего упал почти в два раза. По рынку, переполненному пустыми проектами, прошла волна банкротств — в живых осталась небольшая горстка компаний с более-менее рабочим продуктом, многие из которых сегодня стали многомиллиардными корпорациями.

А все потому, что стремительное развитие сетей привело к когнитивной ошибке апологетов тогдашнего интернета. Сеть, серверы и дата-центры — не самостоятельная экономическая вселенная, а лишь инструмент для осуществления классических бизнес-процессов, многие из которых по-прежнему консервативны. Но тогда многие думали иначе...

В дальнейшем Интернет становился все более распределенным и децентрализованным. Улучшение сетевой инфраструктуры, скорости передачи данных, мощности и разнообразия оборудования привело к тому, что разбросанные по миру серверы стали объединять в единые вычислительные мощности. Стало зарождаться то, что мы сегодня называем «Облаком» или «Облачными вычислениями».

Впервые эту метафору использовали General Magic и AT&T, описывая свои технологии Telescript и Personal Link. В 1994 году в статье журнала WiredЭнди Херцфельд, говорил о языке программирования Telescript следующим образом:

Энди Херцфельд, старший архитектор ОС для Macintosh в 1981 году

«Прелесть Telescript в том, что теперь, вместо того, чтобы просто программировать устройство, у нас есть целое Облако, где одна программа может обращаться к множеству различных источников информации и создавать своего рода виртуальный сервис».

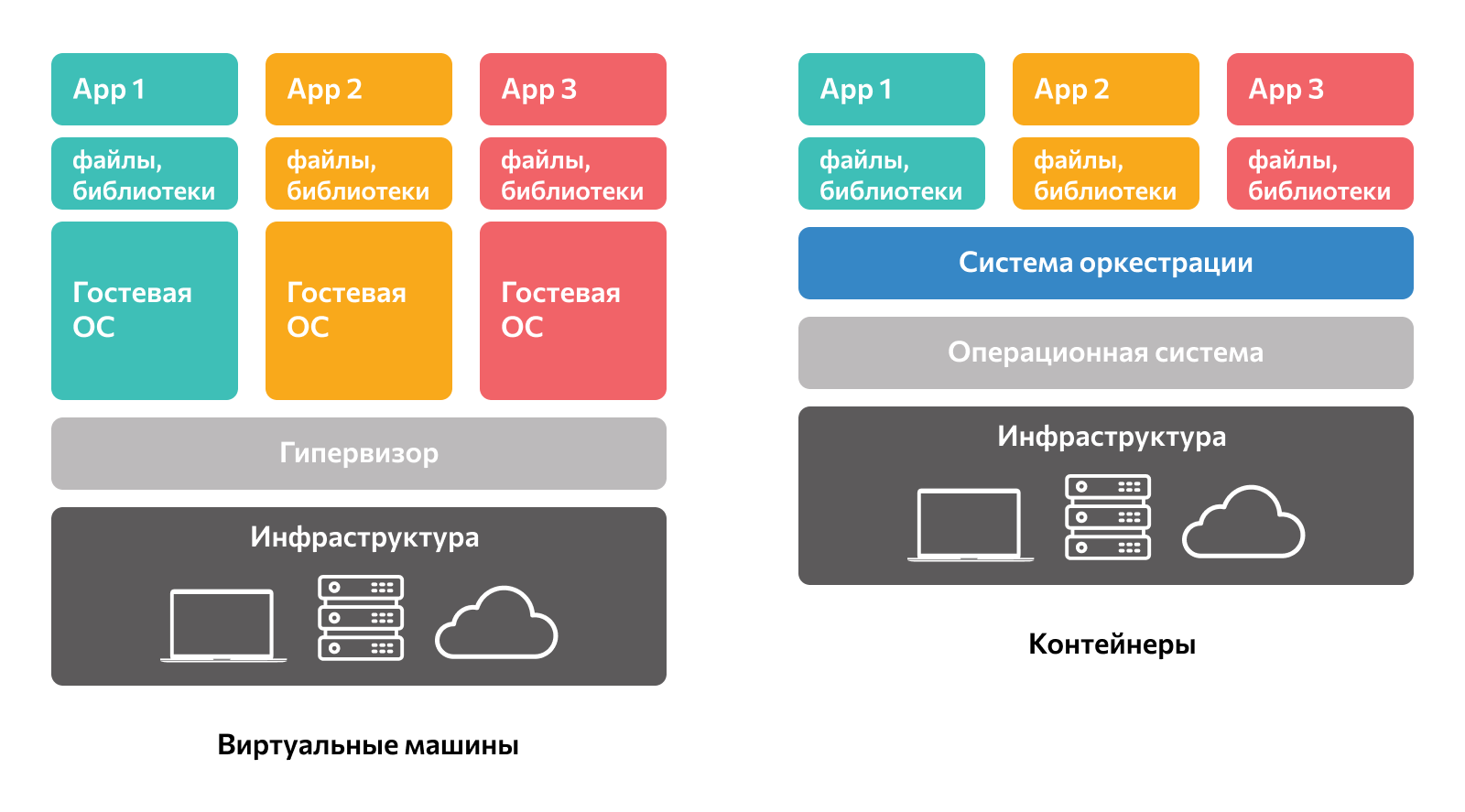

Кстати, во второй половине 2000-х годов были выпущены такие средства виртуализации, как KVM и Xen. Виртуализация создает представление нескольких серверов на базе одного физического компьютера, что довольно важно для облака. Например, гипервизор Xen применяется в облачных платформах Amazon Compute Cloud, Liquid Web, Fujitsu Global Cloud Platform и Rackspace Cloud.

Для справки гипервизор – специальное программное обеспечение, позволяющее создавать виртуальные машины и управлять ими. Под виртуальной машиной в этом случае понимается изолированная система, которая представляет собой логический сервер внутри физической машины со своим набором вычислительных мощностей и операционной системой.

Существует два типа гипервизоров, однако самые производительные — гипервизоры 1 типа, иначе гибридного. Они запускаются непосредственно на «железе» и не требуют установки операционной системы, например, ESXi или Xen. Среди гипервизоров второго типа, требующего установки ОС, так как они являются либо ее частью, либо частью ядра, сегодня самыми популярными являются Hyper-V и Linux KVM.

Здесь нельзя не упомянуть технологию контейнеризации. Примитивные контейнеры, по типу Solaris Containers, FreeBSD Jail, Virtuozzo Containers, существуют с 2004 года. Но в те времена они были ограничены и поддерживали лишь небольшое количество компьютерных систем.

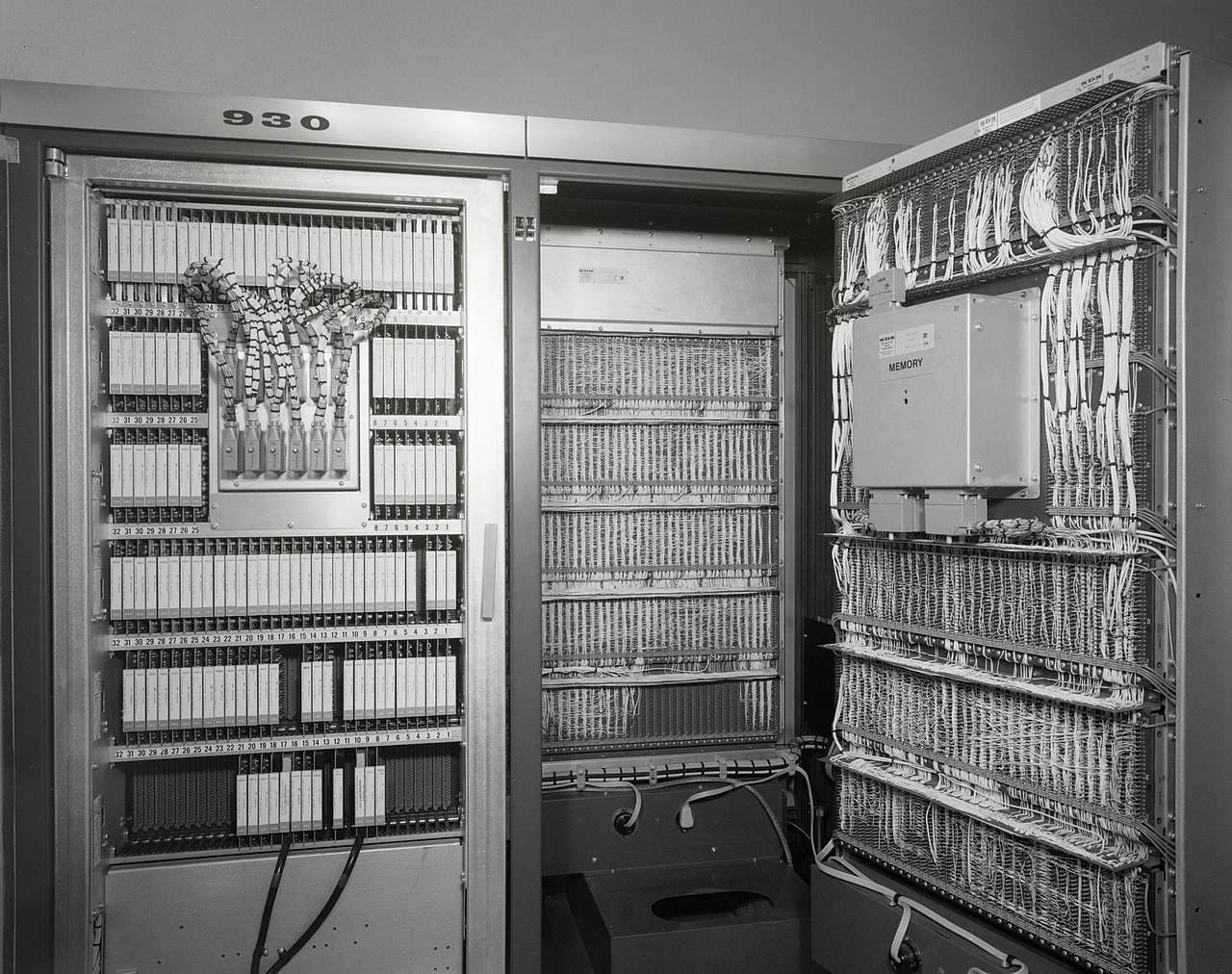

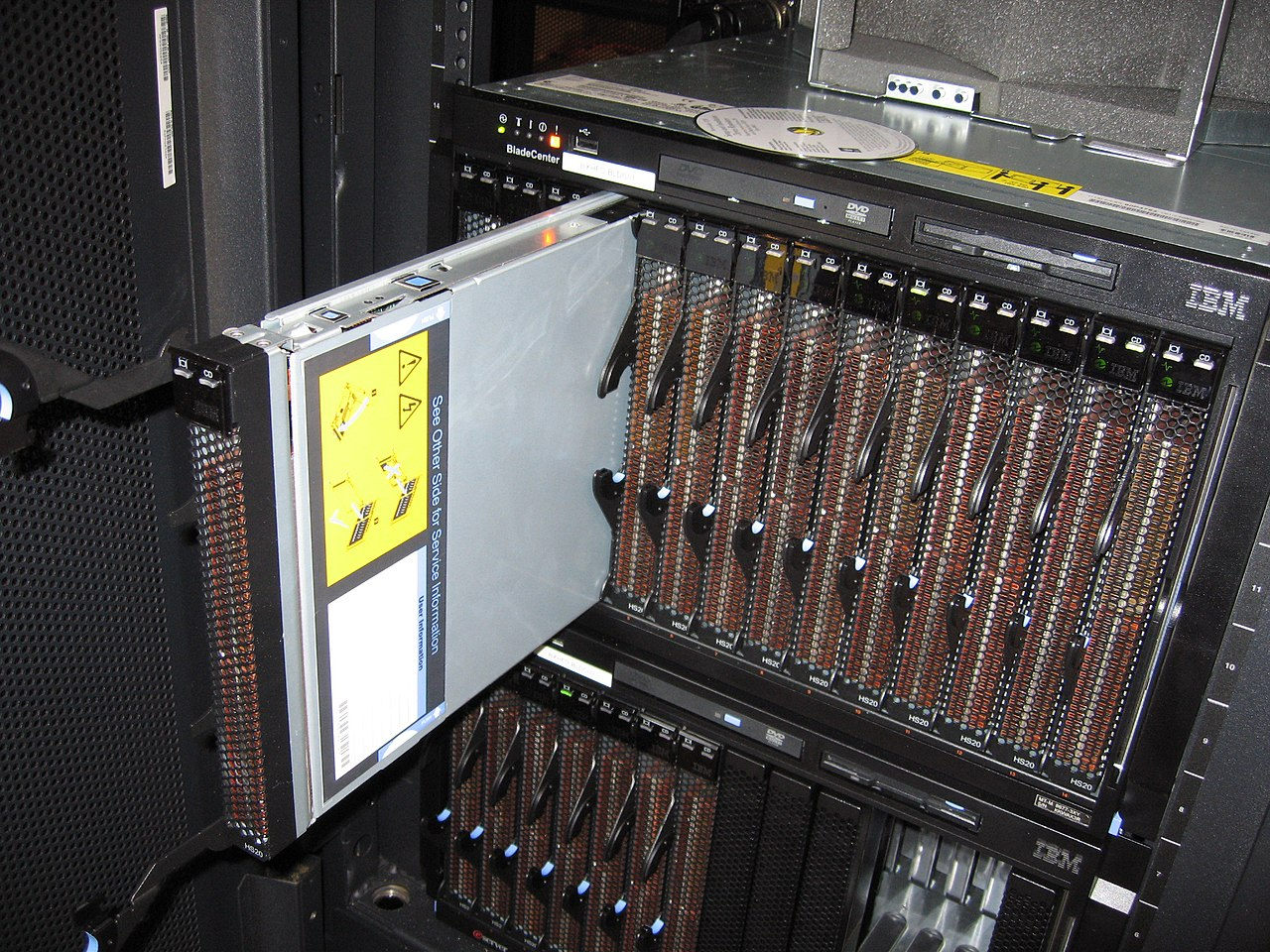

Интересный факт. В 2001 году Кристофер Хипп и Дэвид Киркеби получили патент на конструкцию блейд-сервера, который вставляется в так называемую корзину, уменьшая занимаемое пространство.

Блейд-серверы стали поворотным моментом в истории серверного оборудования, поскольку они устранили многие недостатки стоечных серверов. Да, в блейд-серверах меньше компонентов, чем в стоечных серверах, однако они потребляют меньше энергии и занимают меньше места.

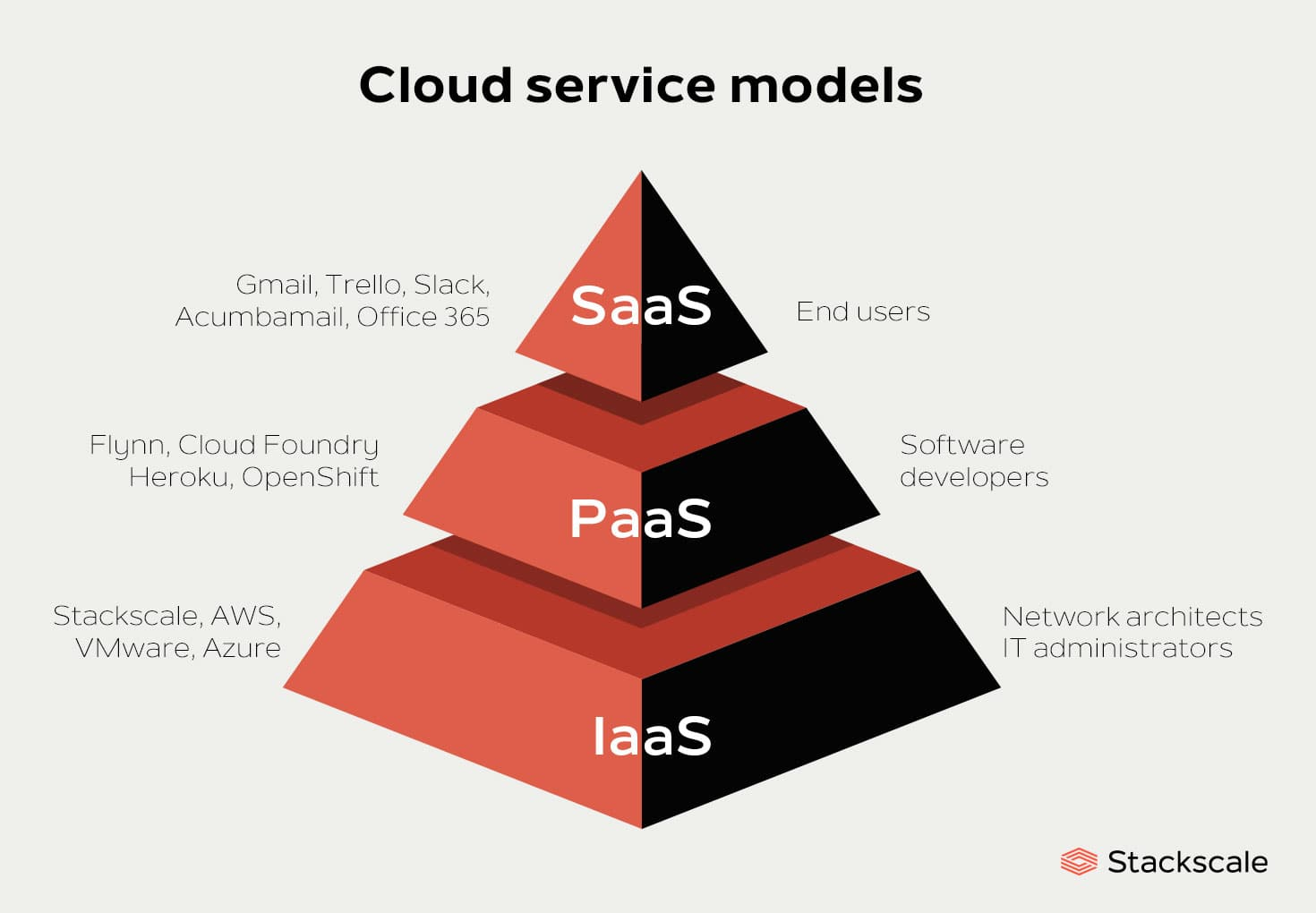

И вот уже в 2002 году Amazon запускает Amazon Web Services для реализации собственной платформы облачных вычислений. Далее появились Simple Storage Service и Elastic Compute Cloud — продукты, которые первыми использовали виртуализацию серверов для предоставления IaaS (инфраструктура как услуга).

Спустя 5 лет Google выпустила Google App Engine. Это был один из первых в своем роде PaaS, который предоставлял полностью поддерживаемую платформу для создания веб-приложений на популярном технологическом стеке: Python, Node.js и PHP. Впоследствии он был переименован в Google Cloud Platform.

В отличие от IaaS, который предлагает только вычислительные мощности (виртуальные серверы, хранилища, сети, операционную систему), PaaS имеет дополнительный высокоуровневый инструмент: базы данных, среды машинного обучения, контейнерные технологии, программы аналитики — все работает из коробки. Если совсем грубо, PaaS — это надстройка над IaaS. Выше только SaaS — полностью готовые пользовательские сервисы и приложения.

В общем, облако действительно прижилось и начало завоевывать общественное сознание — особенно внимание малого и среднего бизнеса. Отличная масштабируемость и гибкая система цен, привязанная к мощности, позволили облаку стать самой распространенной услугой в мире хостинга. Например, Cloudwards считают, что около 94% предприятий используют облачные сервисы в своей работе, в то время как 48% бизнесов уже доверили свои данные облачным поставщикам на хранение.

Некоторые опасения по поводу безопасности привели разработчиков к идее частного облака — закрытой инфраструктуре с полным контролем над собственным оборудованием. В этом случае организация использует свое облако, как если бы это была обычная локальная сеть, но на «облачном» технологическом стеке.

К 2011 году появляются уже вариации, где границы между типами облаков размываются — компоненты частного и общедоступного облака объединяются в так называемое «гибридное облако».

Схемы организации самые разные. Например, компания может хранить конфиденциальные данные в собственном облаке на своих серверах, и подключать эти данные к своим сервисам, которые работают в общедоступном облаке другой компании.

В другом случае core-приложение работает в частном облаке, но во время пиковых нагрузок используются ресурсы общедоступного облака. Обычно используется пакетная передача между несколькими облаками, образуя структуру более высокого порядка. Преимущества очевидны — компания платит за дополнительные мощности только тогда, когда они необходимы.

При таком подходе появляется большая гибкость и возможность абстрагироваться от серверной реализации. Например, можно создать кросс-платформенное гибридное облако, соединяющее разные аппаратные архитектуры в единое вычислительное пространство — например, x86 и ARM.

В общем, облака стали появляться как грибы после дождя и расти как на дрожжах. В 2011 году IBM запустила свой SmartCloud. В 2012 году Oracle представила Oracle Cloud, предлагая три модели для бизнеса: IaaS, PaaS, SaaS. Microsoft тоже не отставала, и даже начала крутить по телевидению забавный рекламный ролик своей cloud-системы для хранения фото и видео.

Кстати, Apple iCloud — это тоже облако, фокус которого направлен на хранение большого количества личных медиаданных: фотографий, музыки, видео.

Однако основные пользователи облачных технологий — разработчики приложений, а не традиционный бизнес. Это значит, что почти весь инструментарий поставщиков облачных решений заточен под задачи разработки, а рядовой пользователь использует различные сервисы, которые «стоят» на облаке, словно на трех китах.

Серьезные изменения произошли в 2013 году, когда Docker придумали наиболее функциональные и кросс-платформенные контейнеры, которые смогли завоевать популярность. По сути, Docker повлиял на развитие контейнеризации как явления в целом.

Контейнеризация — это метод виртуализации, когда операционная система обрабатывает несколько изолированных пространств пользователя вместо одного.

В отличие от полноценной виртуальной машины со своей операционной системой, которая запускается внутри другой ОС, контейнер — это лишь изолированный механизм запуска приложения.

Можно провести аналогию с объектами реального мира, например, морскими контейнерами или контейнерами для еды. Инкапсулирование функциональных сущностей — достаточно распространенный и эффективный прием, к которому прибегает человечество. Да что там, даже живые организмы состоят из отдельных клеток. Точно также устроены и программные контейнеры — модули с кодом, выполняющие специфическую задачу.

Контейнеры довольно просто развертываются в облаке, обеспечивают кроссплатформенный запуск и консистентность сборок приложения и его зависимостей. А системы оркестрации контейнеров, например, Kubernetes и Docker Swarm, только повысили масштабируемость и автономность подхода — они работают как бы над контейнерами, управляют ими: запускают, выполняют и останавливают в зависимости от условий.

Типичные задачи таких систем: установка приложений и их зависимостей на сервер, распределение нагрузок между отдельными контейнерами и мониторинг их состояния, автоперезапуск или завершение работы отказавших контейнеров и т. д.

Можно сказать, что система оркестрации — это персонал большого грузового судна, распределяющий на борту контейнеры в правильном порядке с помощью подъемных кранов.

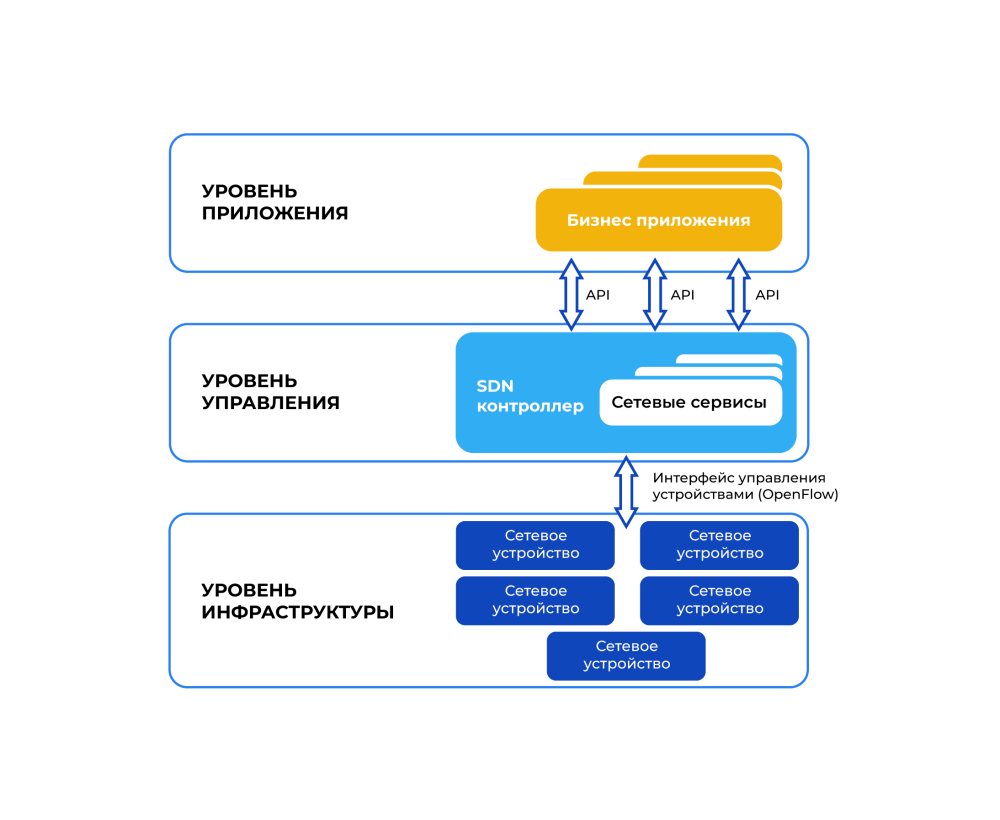

Последние 20 лет сеть становилась сложнее и больше. Росла необходимость в разделении управления передачей данных и непосредственно самой передачи данных. Это позволило бы контролировать сеть более централизованно, реализуя логику как бы поверх аппаратной части.

Ведь когда в 60-х годах ARPANET создавала «высоко живучую» сеть на фоне внешних угроз, ее узлы решали сразу две задачи — строили маршрут для пересылки пакетов и выполняли отправку, т. е. коммутировали. Управлять такой сетью централизованно было невозможно. В общем-то, в течение полувека сеть такой и оставалась. В качестве решения этой проблемы стали зарождаться сети нового поколения — программно-определяемые сети (SDN).

В SDN программное обеспечение отделено от аппаратного, образуя две плоскости сетевых устройств: программный уровень, направляющий трафик на основе определенных переменных или условных операторов, и аппаратный уровень, выполняющий отправку трафика. Поверх них существует уровень самого приложения, которое взаимодействует с сетью через интерфейс API.

По сути, SDN имеет специальное ПО, которое управляет типичными для традиционных сетей роутерами в более гибкой манере. В это случае вся логика управления выносится в так называемые контроллеры, которые способны отслеживать работу всей сети.

Поэтому SDN можно программировать в достаточно широком диапазоне, централизованно контролируя сеть с помощью единой консоли управления, а не на уровне отдельных маршрутизаторов. В этом смысле, концепция SDN воплощает в жизнь подход «сеть как сервис».

В итоге провайдер получает гибкую, контролируемую, настраиваемую и безопасную сетевую инфраструктуру. Точки, выполняющие пересылку пакетов, теперь не статичны, а более вариативны в плане принятия решений по обработке данных, и при этом могут управляться дистанционно из единого центра.

Во многом именно виртуализация и рост популярности облака повлияли на распространение SDN. Граница между серверами, выполняющими логику приложений, и сетевыми коммутаторами, направляющими трафик, стала размываться.

Индустрия аренды вычислительных мощностей продолжит развиваться в ближайшие годы. Однако последние 30 лет научили нас тому, что общие подходы остаются постоянными — меняются только методы и технологии.

Почти наверняка серверное оборудование будет становится более портативным, упрощенным и энергоэффективным — преимущественно с упором на виртуализацию.

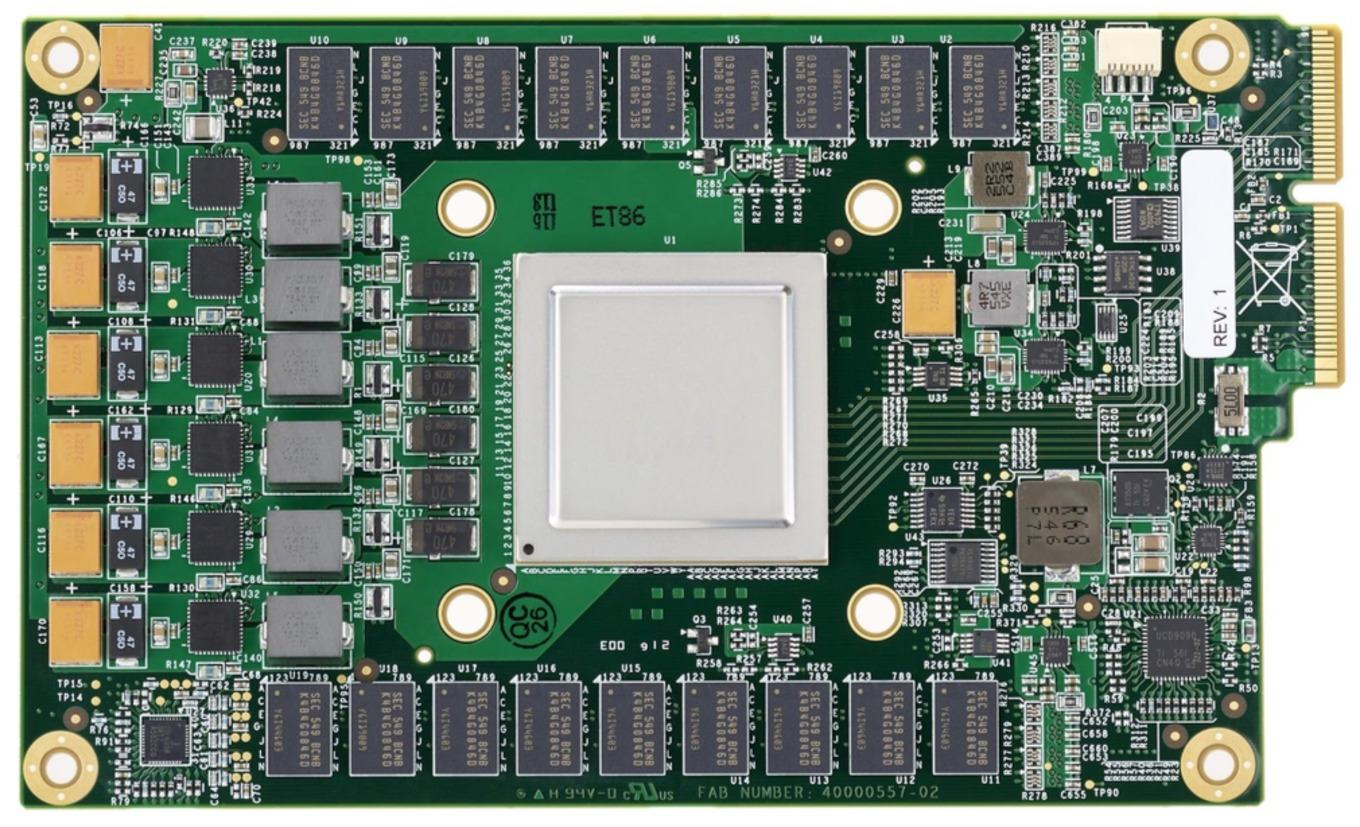

Это значит, что гибкость компонентов и возможность программной настройки окажется в приоритете. В то же время более низкоуровневые аппаратные части будут выполнять узкоспециализированные задачи — например, с 2016 года Google использует аппаратные акселераторы для машинного обучения «Tensor Processing Unit» (TPU) вместо обычных процессоров.

Кстати, использование искусственного интеллекта в облачных вычислениях будет только расти — машинное обучение требует существенных мощностей, и именно облако может их предоставить.

Еще несколько лет назад для обучения модели разработчикам приходилась тратить много денег на покупку серверов, которые простаивали остальное время. Облако позволяет получить высокую мощность на короткий срок, чтобы обучить нейросеть и «вернуть» вычислительные ресурсы обратно провайдеру, при этом разработчик платит только за необходимое время использования мощностей.

Благодаря этому, сегодня ИИ-модели могут использовать стартапы и небольшие компании, финансы которых не настолько огромны, как у крупных инвесторов в центры обработки данных и искусственный интеллект. К тому же, современные облака предоставляют необходимый тулсет прямо из коробки, что снижает порог входа в разработку сложных сервисов и технологий.

Grand View Research предсказывает рост мирового рынка облачных вычислений на 15,7% ежегодно с 2022 по 2030 год — в 2021 году он оценивался в 367 миллиардов долларов.

Интересно, что развитие облака уменьшает темпы роста новых дата-центров. На рынке оформились ключевые игроки, имеющие большие центры обработки данных, которые постоянно расширяются. Более мелким компаниям уже невыгодно держать серверы в своих зданиях — дешевле воспользоваться услугами крупного облачного поставщика.

Например, Statista прогнозирует уменьшение расходов на традиционные дата-центры с 41% до 36% за период с 2022 по 2024 год. При этом количество инвестиций в публичное и частное облако продолжит расти.

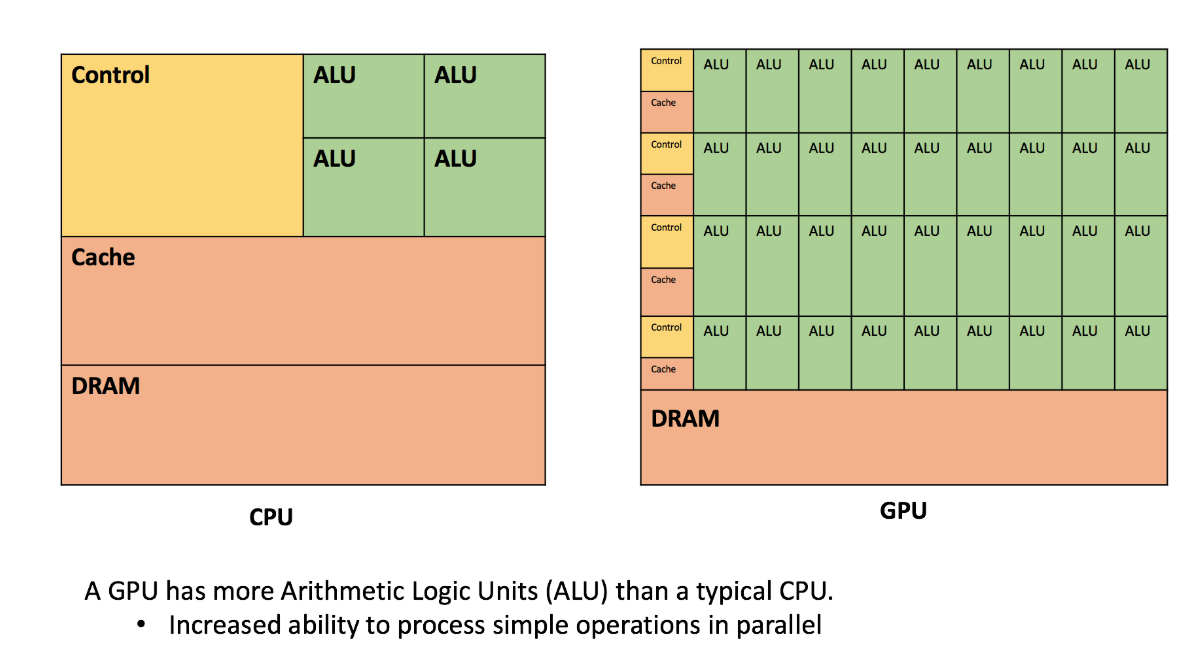

Облачная инфраструктура потребляет много энергии, а значит выбрасывает приличное количество CO2. В особенности это касается инфраструктуры, построенной на GPU, которая имеет ряд преимуществ над CPU.

Из-за того, что графический процессор обладает более мелкими логическими ядрами, но в большем количестве, он идеально подходит для параллельной обработки идентичных и простых операций.

Очевидно, больше мощность — больше энергопотребление, выделение тепла, выбросы CO2 и вред окружающей среде. Да, частично эти минусы решаются в процессе эволюции вычислительных систем — со временем они становятся более энергоэффективными, впрочем, как и целые серверы (PUE)

Однако провайдеры продолжают переход на возобновляемые источники, к тому же энергетическая политика некоторых государств поощряет использование зеленой энергии. Например, США выдают «Сертификаты возобновляемой энергии» за инвестиции в возобновляемую энергию, а «Сертификаты компенсации выбросов углерода» помогают аккредитовать хостинговую компанию, как сокращающую выбросы CO2.

За последние 20 лет хостинг становился все более безопасным. Несмотря на то, что в 60% случаев компании отказываются от использования облачных услуг в пользу собственных решений из-за опасений, связанных с конфиденциальностью данных, облачные провайдеры вкладывают значительно больше ресурсов в информационную безопасность (ИБ), чем их клиенты — ведь это основа их бизнеса. На тысячу сотрудников может приходиться по одному специалисту по ИБ.

Тем не менее, риски всегда есть. В апреле 2022 года команда исследователей Unit 42 из организации Palo Alto опубликовала отчет, утверждающий, что более 600 тысяч облачных учетных записях в более чем 200 различных организаций предоставляют «чрезмерные разрешения» доступа, которые на самом деле не использовались последние 60 дней. Хакеры могут использовать такие разрешения для расширения радиуса атаки на сеть компании-жертвы.

Сегодня в облако переходит не только бизнес, озабоченный сохранением коммерческой тайны, но и множество государственных сервисов по всему миру. Поэтому облачные провайдеры предоставляют соответствующий функционал, помогающий сузить спектр возможных несанкционированных доступов к важным данным. Как правило, это тонкая настройка прав доступа к системе, открывающая сотрудникам только необходимую для работы информацию, а в некоторых случаях только с разрешенных IP-адресов.

Как было сказано выше, подобные риски можно частично снять, используя гибридное облако, когда важная информация или ПО находятся на собственных серверах организации, а остальная инфраструктура — в публичном облаке.

В общем, как и любой другой рынок со своим продуктом, веб-хостинг продолжает изменяться и эволюционировать. Что-то исчезает, что-то появляется, а что-то существует долгое время, не меняясь.

НЛО прилетело и оставило здесь промокод для читателей нашего блога:

— 15% на все тарифы VDS (кроме тарифа Прогрев) — HABRFIRSTVDS.

Комментарии (7)

Exchan-ge

19.10.2022 13:31+1И вот уже в 2002 году Amazon запускает Amazon Web Services для реализации собственной платформы облачных вычислений.

Насколько я помню — в 2002 году термин «облачные вычисления» еще не использовался.

И вообще, по слухам — сам этот термин придумали не компьютерщики. а маркетологи.

LordDarklight

19.10.2022 16:26серверное оборудование будет становится более портативным, упрощенным и энергоэффективным — преимущественно с упором на виртуализацию.

Мне одному кажется, что тут противоречие. Ведь серверная виртуализация - это концентрация больших мощностей в нескольких (на самом деле число не важно, но больше 1) крупных, условно, мейнфреймах (больших мощных серверных компьютерах) - и распределением по ним куда большего количества виртуальных систем.

А упрощение и портативизация, а-ка блейд сервера - это скорее докер-оркестрация - когда на одном аппаратном устройстве редко когда висит более одноног сервиса (но да - они по-прежнему распределяемые по устройствам), зато один сервис может быть поднять на нескольких физических устройствах - но это уже гетерогенные вычисления и распределения нагрузки - кстати, про них в статье даже ни слова не сказали! Хотя развитие облачных вычислений как раз строится на гетерогенном распределении этих вычислений!

Exchan-ge

Забавно, на советских станциях военного назначения я точно такой же способ размещения электронных блоков видел еще в 1981 году :)

Разве что назначение у блоков было другое.

d2ab

"Это другое" - конструкция с шиной и вставляемыми различными электронными блоками известна очень давно, но только в блейд-серверах начали вставлять именно процессорные модули.

Exchan-ge

Так что, можно бежать патентовать идею вставлять в корзину внешние видеокарты? :)

LordDarklight

Зачем внешние? А внутренние вроде бы уже вставляют (не игровые - а профессиональные)

Exchan-ge

Ну так по сути своей, нынешние видеокарты и есть этакие специализированные компьютеры, которые и по размерам и, особенно, по цене могут дать фору заметной части обычных ПК.

Пора их выделять в отдельный корпус (охлаждение и мобильность :), а с учетом еще и БП — современный комп уже смело можно составлять из двух блоков, по образцу и подобию радиоаппаратуры 70х (те робкие попытки создать внешние видеокарты пока не в счет — дизайн корпусов самого ПК и внешней видеокарты должен быть един, иначе не взлетит :)

Ну и для ЦОД все это справедливо вдвойне — отдельные блоки можно легко и быстро заменить.

Военные именно так и поступают — неисправный блок извлекается из стойки и заменяется аналогичным из ЗИПа (неисправный отправляется в спецподразделение на ремонт).

Процесс восстановления работоспособности занимает буквально секунды (я сам это делал :)

Я тут давеча поменял «игровую» карту на профессиональную (Квадро), причем из того же ценового диапазона.

Сижу и радуюсь. Единственный вопрос — почему я не сделал этого раньше? :)