В численной линейной алгебре нас интересуют точное и эффективное решение задач и понимание чувствительности задач к возмущениям. К старту флагманского курса по Data Science делимся материалом от профессора Ника Хигэма о семи грехах линейной алгебры, из-за которых теряется точность/эффективность или информация о чувствительности [к возмущениям] оказывается недостоверной.

1. Обращение матрицы

На курсе линейной алгебры мы узнаём, что решение линейной системы, состоящей из

уравнений, содержащих

неизвестных, можно записать в виде

, где

— обратная матрица. При этом не всегда подчёркивается, что случаев, когда следует вычислять

, очень мало. На самом деле, (

) скалярную систему

нельзя решить, вычислив

. Вместо этого лучше выполнить деление

[прим. ред. — мы помним, что 7 в минус первой степени — это одна седьмая единицы, и, конечно, помним о свойствах умножения и деления дробей. Возможно, здесь имеется в виду разница в подходе к вычислениям в контексте вычислительной машины]. В случае

быстрее и точнее будет решение линейной системы (методом Гаусса) путём выбора ведущего элемента столбца, а не обращения

, которое в любом случае потребует LU-разложения матрицы).

Случаи, когда требуется использовать , редки, но возможны, когда диагональные элементы обратной ковариационной матрицы являются значимыми величинами, а также в некоторых алгоритмах вычисления матричных функций.

2. Формирование перекрёстного произведения матриц ![$A^TA$]()

Решение линейной задачи наименьших квадратов , где

— матрица полного ранга

, где

удовлетворяет нормальным уравнениям

. Поэтому естественно сформировать симметричную положительно определённую матрицу

и решить нормальные уравнения с помощью разложения Холецкого. Хотя этот метод быстрый, он численно неустойчив при слабообусловленной

. В противоположность этому решение задачи наименьших квадратов с разложением QR матрицы всегда численно устойчиво.

Что не так с перекрёстным произведением матриц (известным как матрица Грама)? Она возводит данные в квадрат, что может привести к потере информации в арифметике с плавающей точкой. Например, при

где — единичная ошибка округления для плавающей запятой, то

является положительно определённой, но, так как в арифметике с плавающей точкой

округляется до

, получается вырожденная

,

при этом информация в потеряна.

Другая проблема с перекрёстным произведением матриц заключается в том, что — нормальное число обусловленности

— является квадратом такового для

. Это приводит к численной нестабильности алгоритмов, которые работают с

, если число обусловленности велико.

3. Неэффективный порядок действий при определении произведения матриц

Число действий при определении произведения матриц зависит от порядка его определения (если принять, что не все матрицы ). Иными словами, умножение матриц ассоциативно, поэтому

. В общем случае число действий при определении произведения матриц зависит от того, где поставить скобки. Один порядок может быть намного лучше других, поэтому не следует просто оценивать произведение в фиксированном порядке слева направо или справа налево. Например, если

,

и

—

— векторы, то

можно определить так:

-

: внешнее произведение векторов с последующим матрично-векторным произведением, которое требует

операций, а

-

: скалярное произведение векторов с последующим масштабированием вектора требует всего

действий.

Словом, определение места скобок в матричном произведении для минимизации числа действий — это сложная задача, но для многих случаев на практике хороший порядок определить легко.

4. Предположение, что матрица является положительно определённой

Симметричные положительно определённые матрицы (симметричные матрицы с положительными собственными значениями) широко распространены, в том числе, потому, что они возникают при решении многих задач минимизации. Однако матрица, которая должна быть положительно определённой, может не быть таковой по целому ряду причин. Отсутствие или несоответствие данных при формировании ковариационной или корреляционной матрицы может привести к потере определённости, а ошибки округления могут сделать крошечное положительное собственное значение отрицательным.

Определённость подразумевает, что:

- диагональные элементы матрицы положительны;

-

;

-

для всех

.

Тем не менее ни одно из этих условий, равно как и все условия в совокупности, не может гарантировать, что матрица имеет положительные собственные значения.

Лучший способ проверить определённость, который зачастую может потребоваться сам по себе — рассчёт разложения Холецкого. функция MATLAB chol возвращает сообщение об ошибке, если разложение не удалось. При этом может быть запрошен второй выходной аргумент, в этом случае ему задаётся номер этапа, на котором случилась неудача факторизации, или 0, если факторизация прошла успешно. В случае неудачи частично вычисленный фактор возвращается в первом аргументе, и его можно использовать, например, для вычисления направления отрицательной кривизны, как это необходимо для оптимизации.

Этот грех занимает первое место в «Семи грехах оптимизации портфеля» (Seven Sins in Portfolio Optimization) Шмельцера и Хаузера, поскольку в этом случае отрицательное собственное значение в ковариационной матрице может определять портфель с отрицательной дисперсией, обещая при этом условно высокие инвестиции без риска!

5. Неиспользование структуры матрицы

Один из фундаментальных постулатов численной линейной алгебры заключается в необходимости использовать любую структуру матрицы. Особенно важно использовать разреженность (матрица с большим количеством нулей), поскольку алгоритмы, предназначенные для плотных матриц, могут оказаться непрактичными для разреженных матриц из-за обширного заполнения (нули становятся ненулевыми). Вот два примера структур, которые можно использовать.

Для задач нахождения седловой точки матрицы являются симметрично неопределёнными и имеют вид:

где является симметричной положительно определённой. Разработка числовых методов для решения

с использовании блочной структуры и возможной разреженности

и

оказалась весьма трудоёмкой задачей. Ещё один пример — циркулянтная матрица:

Важное свойство циркулянтных матриц — диагонализируемость унитарной матрицей дискретного преобразования Фурье. При помощи этого свойства можно решить за

, а не

операций, что потребовалось бы при игнорировании циркулянтной структуры.

В идеале программное обеспечение линейной алгебры должно обнаруживать структуру в матрице и вызывать алгоритм, использующий эту структуру. Ярким примером такого мета-алгоритма в MATLAB является функция x = A\b с обратным слешем для решения . Функция с обратным слешем проверяет, является ли данная матрица треугольной (или преобразованной треугольной) матрицей, верхней матрицей Хессенберга, симметричной или симметричной положительно определённой. После такой проверки применяется подходящий метод. При этом

также может быть прямоугольной. При этом задача наименьших квадратов решается, если строк больше, чем столбцов, или недоопределённая система, если столбцов больше, чем строк.

6. Определение приближения вырожденности с помощью определителя

матрица

является невырожденной только при ненулевом детерминанте. Поэтому можно ожидать, что малое значение

указывает на почти вырожденную матрицу. Однако размер

ничего не говорит о вырожденности. Действительно, поскольку

, мы можем получить любое значение определителя, умножив его на скаляр

, однако

имеет приближение вырожденности не больше и не меньше, чем

для

.

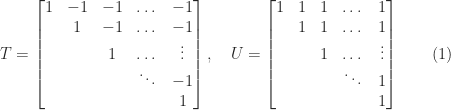

Ещё одно ограничение для определителя показано на примере двух матриц:

В обеих матрицах есть единично диагональные и внедиагональные элементы, ограниченные по модулю . Поэтому

, но

Таким образом, является слабообусловленной для большого множества

. Фактически при изменении элемента

матрицы

до

матрица становится вырожденной! В противоположность этому

всегда хорошо обусловлена. Определитель не позволяет отличить слабообусловленную

от хорошо обусловленной

.

7. Определение обусловленности при помощи собственных значений

Для любой матрицы

и любой нормы согласованной матрицы справедливо, что

для всех

, где

являются собственными значениями

. Поскольку собственные значения

— это

, число обусловленности матрицы

ограничено снизу отношением наибольшего собственному значению к наименьшему по абсолютной величине, т. е.:

Но, как показала матрица в (1), эта связь может быть очень слабой.

Число обусловленности характеризует вырожденные, а не собственные значения 2-нормальной матрицы. В частности

где — сингулярное разложение матрицы с

и

ортогональностью и

,

. Если

симметрична, то, например, множества

и

идентичны, но в целом собственные

и вырожденные

значения могут заметно различаться.

А мы разобраться с математикой, чтобы вы прокачали карьеру или стали востребованным IT-специалистом:

Чтобы посмотреть все курсы, кликните по баннеру:

Data Science и Machine Learning

- Профессия Data Scientist

- Профессия Data Analyst

- Курс «Математика для Data Science»

- Курс «Математика и Machine Learning для Data Science»

- Курс по Data Engineering

- Курс «Machine Learning и Deep Learning»

- Курс по Machine Learning

Python,

- Профессия

Fullstack-разработчик на Python - Курс «Python для

веб-разработки » - Профессия

Frontend-разработчик - Профессия

Веб-разработчик

Мобильная разработка

Java и C#

- Профессия

Java-разработчик - Профессия

QA-инженер на JAVA - Профессия C#-разработчик

- Профессия Разработчик игр на Unity

От основ — в глубину

А также

Комментарии (14)

AAngstrom

22.10.2022 04:08+13По поводу пункта 1: извините, но как же задолбала эта хрень, распространяемая людьми скорее по привычке, чем от каких-то тайных знаний. Во-первых, утверждение "решать систему уравнений методом Гаусса проще, чем делать LU-разложение" -- это какой-то логический парадокс. Стандартный метод LU-разложения (например в LAPACK'е) -- это и есть метод Гаусса. Во-вторых, обращение матрицы -- это решение системы уравнений с правой частью равной единичной матрице. Поэтому, в-третьих, если матрица А не является почти вырожденной, а правая часть не отличается на много порядков от единичной матрицы, нет никакой разницы, решаете ли вы систему уравнений или сначала считаете обратную матрицу, а затем умножаете на правую часть. В-четвёртых, бывают ситуации, когда нужна именно обратная матрица, которая является конечным результатом, и тогда смотри пункт 2.

Не знаю, может и были когда-то времена, когда обратную матрицу считали методом Крамера (или бог его знает, какими ещё методами), и кто-то мудрый возвестил, что вместо обращения матрицы надо решать систему линейных уравнений, но в нынешнее время эти задачи решаются эквивалентными методами, и нет никакой разницы, как именно получать численное решение системы уравнений Ax = B.

domix32

22.10.2022 16:12которое в любом случае потребует LU-разложения матрицы

не знаю где вы увидели "проще, чем LU-разложение"

masai

22.10.2022 17:23Во-первых, утверждение "решать систему уравнений методом Гаусса проще,

чем делать LU-разложение" -- это какой-то логический парадокс.

Стандартный метод LU-разложения (например в LAPACK'е) -- это и есть

метод ГауссаТакого утверждения нет, виноват кривой перевод. В оригинале было: «it is faster and more accurate to solve a linear system by LU factorization (Gaussian elimination) with partial pivoting than by inverting A (which has, in any case, to be done by LU factorization)».

Во-вторых, обращение матрицы -- это решение системы уравнений с правой частью равной единичной матрице.

В статье речь идёт о системе, где правая часть — вектор. С точки зрения количества вычислений есть разница между решением системы, у которой правая часть матрица, и системы, у которой правая часть — вектор.

нет никакой разницы, решаете ли вы систему уравнений или сначала считаете обратную матрицу, а затем умножаете на правую часть

На практике разница есть. Я ради интереса попробовал решить систему с матрицей 10000x10000 на своём ноутбуке. Обращение матрицы с умножением в среднем заняло 20 с, а решение системы напрямую — в среднем 5 с. Так что разница очень даже ощутимая.

AAngstrom

22.10.2022 19:52Если в правой части вектор, то понятно, что решать систему просто быстрее, но вся эта телега про "решайте систему, а не инвертируйте матрицу" обычно также повторяется для случая, когда в правой части стоит матрица. И аргументы идут именно как раз в духе того отрывка, что Вы привели: "it is faster and more accurate to solve a linear system than by inverting". Да, оно может быть "faster" (максимум в 4 раза по умножениям), но только в случае вектора в правой части, а про "more accurate" я как раз и писал, что это не так, кроме клинических случаев, в которых в любом случае LU-разложение не подходит.

Меня это задело, потому что я регулярно встречаю на форумах эти "лекции" (как правило вместо ответа на соврешенно другой вопрос) на тему того, как это плохо обращать матрицу, вместо этого надо решать систему уравнений. Но если в правой части тоже матрица, то просто так, в общем, нельзя сказать, что лучше. Выбор метода должен зависеть от того, что конкретно нужно посчитать, и нередко оказывается, что лучше сначала инвертировать матрицу.

masai

22.10.2022 22:11Я понимаю. Лишь хотел заметить ради справедливости, что эта статья всё же ничего такого криминального не утверждает.

AAngstrom

22.10.2022 22:33На самом деле, Хайэм -- крутой вычматист (приходилось разбираться в его статьях по интерполяции), и если отбросить пункт 1, то на остальные пункты (особенно 2, 5, 6 7) действительно стоит обратить внимание.

sunnybear

22.10.2022 06:32+2"При этом задача наименьших квадратов решается, если строк больше, чем столбцов, или недоопределённая система, если столбцов больше, чем строк." -> "При этом, если строк больше, чем столбцов, то решение ищется по методу наименьших квадратов. А если столбцов больше, чем строк, то решается задача недоопределенной системы."

N-Cube

22.10.2022 08:04+8Просто адский гуглотранслейт, читать невозможно. Для практического использования все базовые алгоритмы реализованы в библиотеках и там же сделаны необходимые проверки на вырожденность матриц и прочее, а вот частные случаи чтобы решить, нужно знать теорию. Например, в библиотеке Python numpy предлагается реализация алгоритма наименьших квадратов (МНК), но нет взвешенного МНК, который часто бывает нужен. К счастью, это легко обходится с помощью нормирующей матрицы (которая постоянно нужна для реальных задач, но в статье выше о ней вообще не упомянули) - легко, при определенных ограничениях на коэффициенты. К примеру, я об этом писал в статье на хабре «Линейная алгебра для спутниковой интерферометрии» https://habr.com/ru/post/597227/

Codenamed

22.10.2022 11:32+5Я понимаю, что это перевод, но уж если вы переводите специализированную статью для широкой аудитории, то стоило хотя бы не самые базовые определения, вроде обусловленности, привести в начале статьи или в соответствующей части. А то это неуважение к аудитории просто.

thevlad

22.10.2022 18:02Еще бы хорошо, написать про регуляризацию, когда на практике, если матрица может быть вырождена, заместо: M*b=a, стоит решать min ||M*b - a|| (если система имеет хотя бы одно решение, то будет 0, иначе ближайшая точка), (псевдо-инверсии тоже из этой оперы)

homocomputeris

22.10.2022 20:46+1Ника Хигэма

ААААААА

перекрёстного произведения

Это шо за зверь?

определении произведения матриц

Называется "вычисление".

omxela

22.10.2022 21:53Библиотеки, конечно, хорошо. Но тот, кто использует численные методы, знает, что каждая задача особенная в том или ином смысле. Эти особенности могут испортить жизнь при стандартном подходе. С другой стороны, они же могут позволить что-то улучшить и ускорить, иногда существенно. По всем вопросам, затронутым в статье, есть давняя и обширная литература. Помню, на меня сильное впечатление произвела книжка Форсайта-Малькольма-Моулера "Машинные методы математических вычислений" издательства МИР 1980 г.

AndrewSu

22.10.2022 22:10В противоположность этому решение задачи наименьших квадратов с разложением QR матрицы всегда численно устойчиво.

Очень сильные сомнения в верности этого утверждения.

fire64

Очень интересно, но ничего непонятно.

Спасибо за статью, к сожалению слабость математического аппарата, не позволяет оценить всю красоту статьи, но все равно спасибо.