Попробуем с помощью нейросетей создать концепт персонажа и окружения, перевести концепт в модель и создать текстуры!

Будем использовать только самые крутые инструменты на базе AI, причем большинство из них бесплатные, а остальные имеют аналоги. В результате выясним, что умеют и чего не умеют нейросети в середине 2023г. с точки зрения работы 3D-художника.

Итак, рассмотрим, насколько сильны нейросети на следующих этапах:

концепт персонажа

концепт окружения

создание моделей

текстурирование

Концепт персонажа

Все начинается с 2D-изображения, чтобы визуализировать идею, оценить ее и, при необходимости, доработать. Нерационально было бы тратить время на моделирование каждой идеи, пришедшей в голову, поэтому протестируем нейросеть на понимание концепции и стилистики.

Цель: создать образы разных персонажей и передать атмосферу в кадре.

Проработку исходного прототипа персонажа доверим Midjourney, она сегодня считается лучшей и чтобы в случае неудач не думать, что какая-то другая нейросеть справилась бы лучше.

Женские персонажи:

Амазонка в джунглях

Женщина-ниндзя в мегаполисе, стоящая на крыше небоскреба

Обитательница пустыни в привычной среде

Женщина ацтек, пусть тоже будет в джунглях

Мужские персонажи:

Викинг в меховой накидке

Восточный борец в стиле 3D-игры

Самурай в горах

Китайский воин на фоне храма

Дополнительно были заданы: стилистика изображения и цвета.

???? Промпт для этих изображений был использован такого типа: realistic high quality front view Asia looking armed warrior in a helmet, black and yellow colors, destroyed city as a background

→ Проанализируем результат: результат устраивает в части качества изображения и соответствия стилю, пожелания по цветам и фактурам также соблюдены и переданы отлично. Но в большинстве случаев персонаж показан лишь до середины бедра, т.е. не в полный рост.

Проверим, будет ли все хорошо с ногами. Опишем, что хотим кожаные сапоги выше колена с металлическими элементами. Вот что получилось:

???? Оказалось, что получить персонажа в полный рост не так то просто, но получилось составить работающий промпт: a full body shot, destroyed city as a background, Asia looking armed warrior in a helmet, black and yellow colors, black helmet and boots, photorealistic --ar 1:2

Все части промпта использовать обязательно (только изменить под ваш запрос) кроме:

photorealistic — этот запрос делает изображение более фотореалистичным

--ar 1:5— это делает "портретное" соотношение сторон

black and yellow colors — цвета картинки

А что если наш персонаж и не человек вовсе, а, скажем, добрый гном в красном костюме, который катается на качели? И тут начинается интересное: нейросеть не понимает, как такое возможно. Сначала выдает хмурых гномов, причем, модификация промпта лишь утвердила в мысли о том, что, видимо, по представлениям нейросети гном – это вообще не очень-то доброе существо. Добрый гном – это, в лучшем случае, просто грустный.

Гном был выбран не случайно – он пригодится нам для тестирования другого сервиса на следующем этапе работы.

Чтоб хоть как-то исправить ситуацию, пришлось добавить в промпт «смеющийся гном» и после многочисленных итераций появились изображения, которые уже можно считать приемлемыми:

→ Вывод: уже сейчас нейросети можно использовать для отрисовки прототипа персонажа. Сколько потребуется итераций для получения нужного результата зависит от того насколько хорошо вы составляете промпты и насколько персонаж является нестандартным.

Концепт окружения

Окружение – тоже важная часть работы. Продумаем нашу сцену.

Поставим 4 задачи и посмотрим, какие результаты выдаст Midjourney:

1. Окружение в стиле и цветах Аватара

Также хотим, чтоб была вода, статуя и ступени. Результат соответствует ожиданиям, вот только все в разных картинках:

2. Дорога к храму Ацтеков

К запросу добавлен в качестве освещения вечерний свет:

3. Двор около египетского храма

Весьма интересные детали, также очень удачна в данном контексте дымка в воздухе:

4. Тайский храм

Тайская архитектура имеет множество замысловатых деталей, но все получилось вполне неплохо:

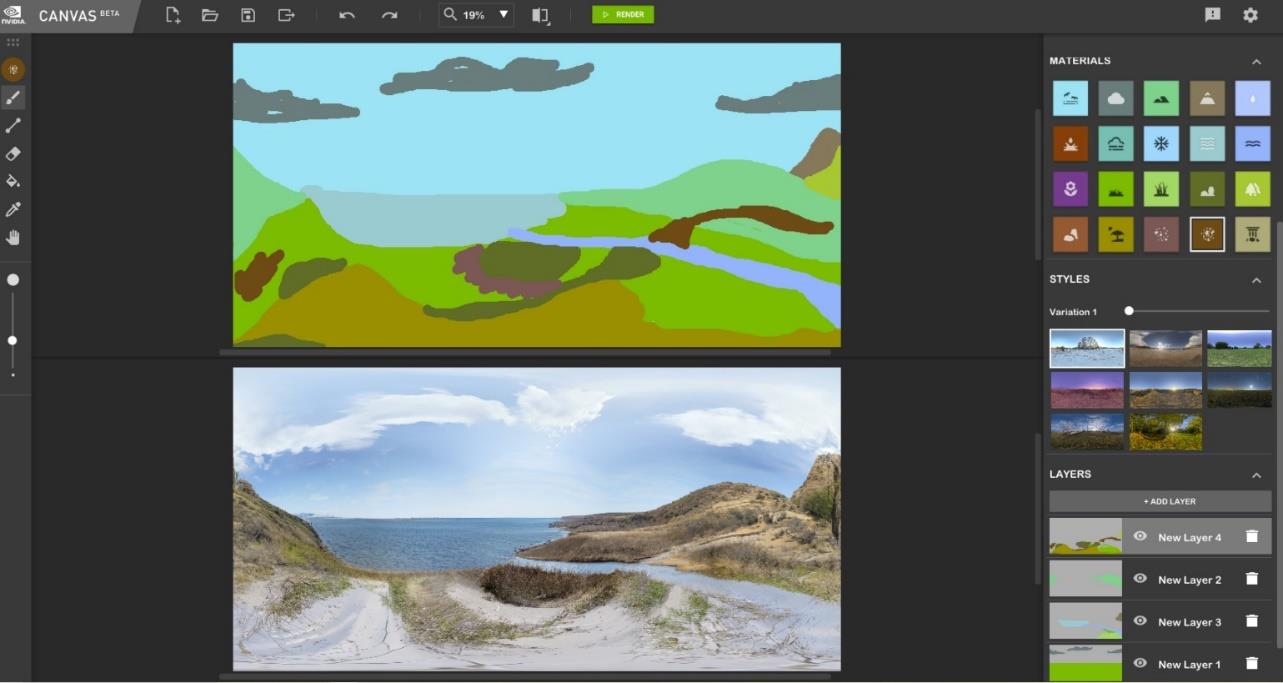

Но что если нужна не одна сцена, а целый мир?! Здесь помогут уже совсем другие инструменты. Совершенно бесплатный инструмент NVIDIA Canvas обновился: теперь можно создавать панорамы из рисунка с помощью базовых инструментов «Море», «Горы», «Пляж», «Облака» и пр. (панель справа с квадратными цветными кнопками):

Достоинства инструмента – можно рисовать по слоям, затем их редактировать, интерфейс предельно понятный, для доступа нужно лишь скачать бета-версию NVIDIA Canvas с официального сайта.

Полученное изображение уже можно установить как HDRI Backdrop в Unreal Engine и вот наш персонаж уже в весьма реалистичной среде!

Этот инструмент идеально подойдет для разработки концепта и когда в рамках проекта не подразумевается интерактивное взаимодействие персонажа с окружающей средой:

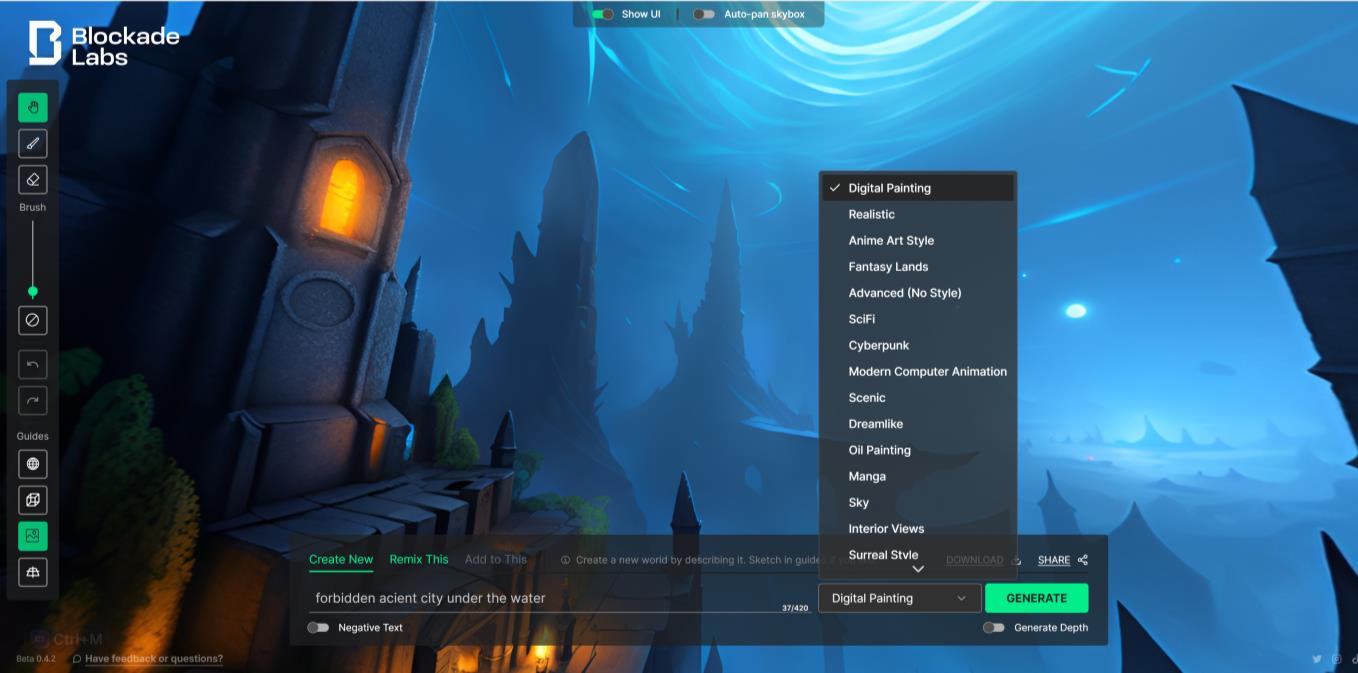

Но порой нам нужно создать что-то фантастическое или фантазийное. Идеально было бы описать наш воображаемый мир словами, чтоб он потом взял и материализовался прямо из описания.

Такой инструмент тоже есть, на этот раз от студии Blockade Labs. Это очень крутая штука, попробуйте обязательно. Сервис позволяет создавать панорамы миров в разных стилях. Он создает панораму подобно тому, как это делает NVIDIA Canvas, на основании описания, работает на базе Stable Diffusion, причем, можно выбрать стилистику из предложенных в выпадающем списке:

Что еще круто – в отличие от ранее запущенного сервиса Latent Labs, здесь стык границ панорамы не виден.

→ Вывод: на сегодняшний день эти сервисы пока не трансформируют исходную идею в трехмерное пространство, однако, это ранний уровень развития технологии, которая уже позволяет сделать часть работы и существенно ускорить процесс, не делая, например, в ряде случаев лишних моделей, расположенных на дальнем плане.

Создание моделей

В 2020г. PIFuHD анонсировала сервис, позволяющий с помощью нейросетей идентифицировать образ одетого человека и трансформировать его в 3D модель. Прошло 3 года – что же изменилось, насколько продвинулась технология, давайте посмотрим.

С тех пор появились новые сервисы. Качество их работы представлено на картинке ниже:

На сегодняшний день лучшие результаты выдает ICON (четкий образ, детали складок одежды, лица). Также интересно, что эта технология позволяет достраивать изображение с обратной стороны, которое на исходной картинке не видно (см нижний ряд в красной рамке):

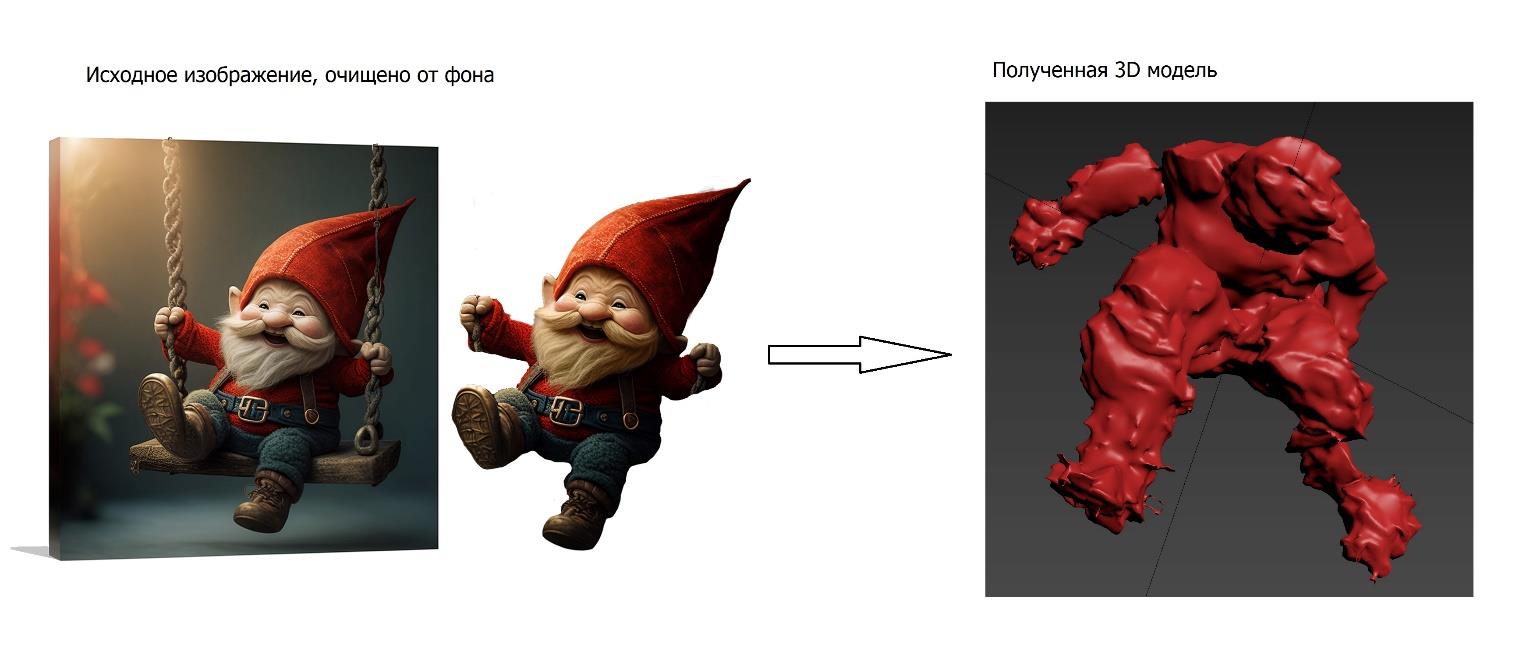

Применим этот сервис к нашему гному и попробуем получить 3D модель.

После загрузки изображения полученную модель можно скачать. Итак, исходное изображение гнома слева, а полученная скачанная модель – справа:

Как будто нейросеть нам подсунула что-то из имеющихся у нее поз, хоть как-то похожих на позу нашего персонажа. Хотя, гном не так уж сильно отличается от человека, разница, в основном, лишь в пропорциях.

Что ж, похоже, гнома пока придется лепить в ZBrush самостоятельно.

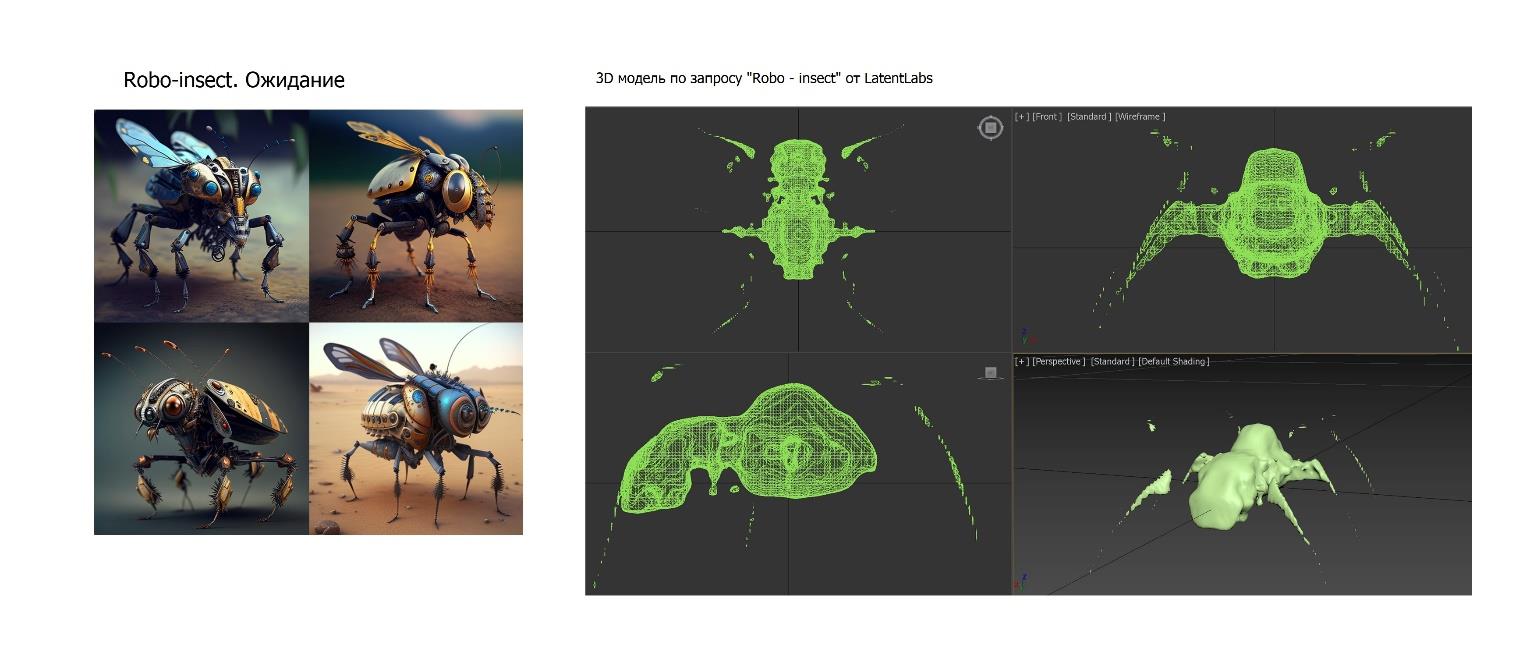

А что если наш персонаж это робот-насекомое. Сервис Latent Labs предлагает создать 3D-модель и скачать ее. Посмотрим на результат:

Далеко до хорошего результата, но уже что-то: бесплатно, на генерацию ушло меньше 1 минуты. Перспективный сервис – нужно за ним наблюдать и держать руку на пульсе.

Если же персонаж это что-то физически существующее (например, трансформер который у вас есть), то здесь все лучше: с помощью нейросетей LumaLabs можно воссоздать объект в 3D.

⚡ В сети также много шуму наделала платформа KAEDIM. Генерирует изображения даже из Вашего скетча. Правда, быстро эта платформа обросла слухами. И вот почему. Чтобы сгенерировать 1 изображение нужно 20$ и около часа времени. Оказалось, что к нейросетям этот сервис не имеет никакого отношения – по слухам, компания ищет сотрудников, которые умеют быстро моделировать. Получается такой Upwork с приоритетным принятием заказов, ибо желающих тестировать технологии много и они даже готовы платить.

→ Вывод: пока у нейросетей не получается создавать пригодные для использования 3D модели, хотя бы на уровне тех же smoothie-3D и MonsterMash (которые работают без них).

Текстурирование

Изображения, которые генерирует Midjourney, прекрасного качества и функция тайлинга работает достаточно хорошо, но эти результаты пока нельзя использовать для получения реалистичных текстур, так как Midjourney слишком творческий – по запросу «бетон» результаты следующие:

Если же нужны какие-то фантазийные текстуры, то здесь другое дело:

В Dall-e мы получим бетон, который ожидаем, но там другая проблема – разрешение не может быть более 1024x1024 и тайлинг не так хорош.

Есть и общая проблема – контролировать перспективу достаточно сложно даже текстом промпта, не говоря уже о том, что для получения всех необходимых карт нужно использовать стороннее ПО.

Но сколько времени уходит обычно на то, чтобы сделать из текстуры бесшовную. Даже в Substance Sampler это часто занимает намного больше времени, чем хотелось бы, более того – уже бесшовную текстуру он умудряется порой наложить как материал все равно с артефактами.

В качестве решения обозначенных проблем, попробуем сервис WITHPOLY, который и генерирует картинки, и делает бесшовные структуры. И здесь мы сразу получаем все нужные карты для материала!

У сервиса есть своя библиотека, но зачем нам стандартные решения, когда мы хотим создать свое. Попробуем что-то нестандартное: первый - рис с овощами, второй – павлиньи перья. Результаты приведены ниже:

Если нажать на 4 серых квадрата, выдаст еще 3 генерации по этому запросу, т.е. будет плитка из 4х вариантов. Также в правом верхнем углу можно включить опцию «Seamless Canvas», тогда все черное поле будет залито этой текстурой, чтобы посмотреть сразу. В бесплатном варианте доступно к генерации разрешение 1К и 2К.

→ Выводы: в текстурировании нейросети уже наступают на пятки классическим лидерам индустрии.

→ Подведем итоги

Нейросети уже можно использовать для создания концептов и текстурирования, но все еще нельзя генерировать пригодные для использования 3D модели.

Нейросети пока не заменят 3D-художников, но уже могут им помочь. Это значит, что 3D-художник, который работает с нейросетями, будет обладать преимуществом перед тем, кто с ними не работает.

Так же не стоит забывать, что нейросети активно развиваются и стоит как минимум за ними следить ;)

Следить можно на нашем тг-канале Нейрокульт ???? — там рассказываем как применять нейросети на практике.

saboteur_kiev

Вопрос. Нейросети используют же какие-то базовые рисунки чтобы научиться рисовать.

Насколько сгенеренные изображения отличаются от оригинальных? Насколько велик риск получения исков за использование чужих (коммерческих или защищенных иным правом) материалов, если схожесть будет доказана на каком-то проценте (90%? 80%? как это считать).

Не уверен что сейчас это легко оценить, но в перспективе если нейросеть сгенерит какого-нибудь маскота или персонажа, а пользователь нейросети не будет с ним знаком, и просто начнет использовать, то может оказаться в суде?

Aheeel Автор

Надо читать соглашения сервисов, в которых генерируешь изображения. Сейчас в большинстве написано, что работы принадлежат тебе (тому, кто создавал), либо это доступно в платном тарифе.

Но конечно, лучше не использовать популярных персонажей. То есть если ты сгенерировал Марио и даже в соглашении написано, что теперь ты его можешь использовать в коммерческом плане — вряд ли это соответствует действительности :)

Вообще сейчас судебной практики пока нет, думаю в будущем уже появятся четкие правила и кейсы.

Str5Uts

А если мясной художник такой же финт ушами сделает? По идее если вы используете сервис — это должна быть проблема сервиса, а не ваша.

Aheeel Автор

мясной художник это смешно ))

saboteur_kiev

Вряд ли ко мне могут прийти из Диснея за то что я нарисовал с ребенком рожицу Дональда. А вот если я опубликую эту рожицу на сайте своего интернет-магазина, могут уже прийти за коммерческое использование.

Сервис может просто предупреждать, что "не используйте это публично", но кто сейчас читает мелкий шрифт?

Refridgerator

Здесь есть более очевидная проблема — разные пользователи на схожие запросы будут получать одни и те же результаты. Мне хватило даже гостевого аккаунта на Миджорне, чтобы уткнуться в ограничение результата. Нейросеть же не умеет фантазировать по-настоящему, всё его творчество это компиляции с Девиан-арта прежде всего. Ну а на пикабу уже была история (ссылку не сохранил), где один любитель рисовать улучшал свои рисунки и получил на выходе какую-то известную в узких кругах медийную личность.

saboteur_kiev

Вот я про это и говорю, что вместо реальной генерации идет некое усреднение среди того, что скормили нейросети во время обучения, и это может вызывать проблемы копирайта