Музыка — это универсальный язык, для которого нет границ. Стремительный прогресс больших языковых моделей (Large Language Model, LLM) привёл к тому, что нейроучёные продемонстрировали острый интерес к исследованию представления музыки в человеческом мозгу.

Команда учёных из Google, Осакского университета, NICT и Araya Inc., движимая этим интересом, провела исследование, результаты которого изложены в публикации «Brain2Music: Reconstructing Music from Human Brain Activity». В исследовании используется конвейер обработки данных, названный Brain2Music, в состав которого входит модель MusicLM, реконструирующая музыку, которую слышит человек, на основе его мозговой активности. Система генерирует композиции, которые напоминают исходные музыкальные раздражители. Этот новый метод даёт ценные сведения о взаимоотношениях мозговой активности с когнитивным и чувственным опытом людей.

Учёные сделали следующие основные выводы:

Мы восстановили музыкальные произведения из результатов фМРТ‑сканирования путём прогнозирования высокоуровневых семантически структурированных музыкальных эмбеддингов и используя глубокую нейронную сеть для генерирования музыки на основе этих признаков.

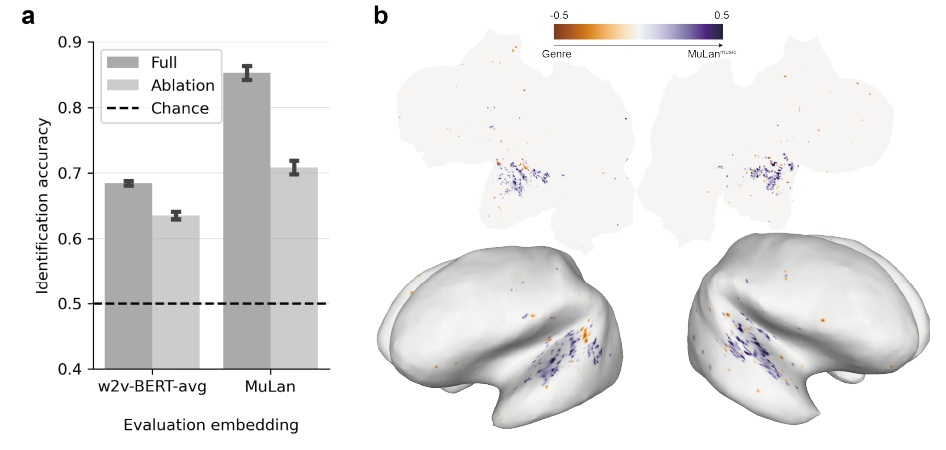

Мы выяснили, что различные компоненты нашей модели для генерирования музыки позволяют прогнозировать активность в слуховой коре мозга человека.

Мы предлагаем новые выкладки, согласно которым в слуховой коре мозга имеется значительное совпадение вокселей, состояние которых можно спрогнозировать на основе (a) исключительно текстового описания музыки, и (b) на основе самой музыки.

Сначала учёные подвергли предварительной обработке набор данных, состоящий из музыкальных произведений различных жанров. В частности, этот набор содержал композиции 10 жанров, в число которых входят блюз, классика, кантри, диско, хип‑хоп, джаз, метал, поп, регги и рок. Музыку дополнили текстовыми описаниями на английском языке, содержащими сведения о жанре, инструментовке, ритме и настроении записей.

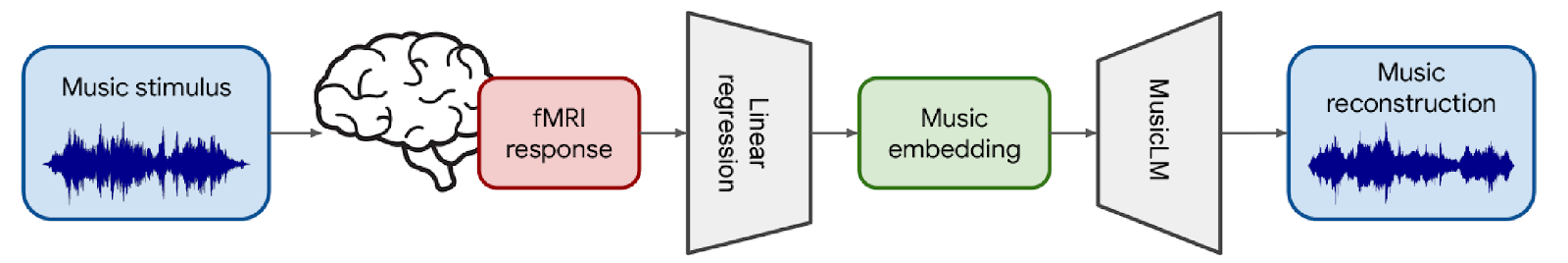

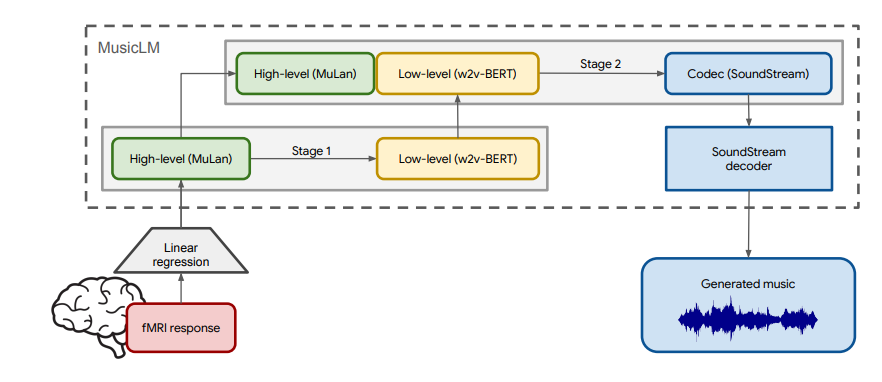

Работа конвейера Brain2Music начинается со сворачивания высокоразмерных данных фМРТ‑сканирования в семантические данные, 128-мерные музыкальные эмбеддинги MuLan, посредством линейной регрессии. Далее применяется MusicLM — модель для генерирования музыки, которая реконструирует музыкальные произведения, представляющие исходные звуковые раздражители.

В MusicLM применяется двухступенчатый процесс генерирования музыки. На первом шаге работы модель учится мэппингу эмбеддингов MuLan на низкоуровневое представление токенов w2v‑BERT с темпоральной информацией. А на втором шаге сгенерированные токены конвертируются в звуковые данные с использованием декодера SoundStream.

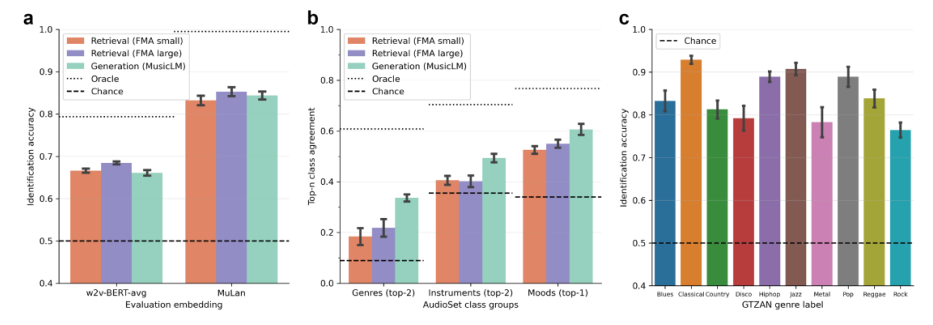

В своём эмпирическом исследовании команда оценила схожесть реконструированных и исходных музыкальных произведений, имея в виду точность идентификации произведений и совпадение топ‑n классов AudioSet. Полученные результаты подтверждают то, что предложенный подход обладает возможностью извлечения музыкальной информации из результатов фМРТ‑сканирования, а так же то, что он отличается высокой точностью реконструкции исходных произведений. Более того, Brain2Music демонстрирует хорошие результаты при реконструкции музыки, относящейся к жанрам, работе с которыми система ранее не обучалась.

В целом можно сказать, что эта работа — лишь первый шаг в сфере реконструкции музыки из результатов фМРТ‑сканирования. Описанная здесь система Brain2Music способна генерировать музыку, напоминающую исходную на семантическом уровне. В будущем вполне могут появиться другие исследования, развивающие то, что было сделано здесь. В них, в частности, может быть сделана попытка улучшить соответствие временных характеристик реконструированной и исходной музыки, а так же — попытка генерировать музыку на основе чистого воображения.

О, а приходите к нам работать? ???? ????

Мы в wunderfund.io занимаемся высокочастотной алготорговлей с 2014 года. Высокочастотная торговля — это непрерывное соревнование лучших программистов и математиков всего мира. Присоединившись к нам, вы станете частью этой увлекательной схватки.

Мы предлагаем интересные и сложные задачи по анализу данных и low latency разработке для увлеченных исследователей и программистов. Гибкий график и никакой бюрократии, решения быстро принимаются и воплощаются в жизнь.

Сейчас мы ищем плюсовиков, питонистов, дата-инженеров и мл-рисерчеров.

KhodeN

Без живых примеров статья неполная:

https://google-research.github.io/seanet/brain2music/