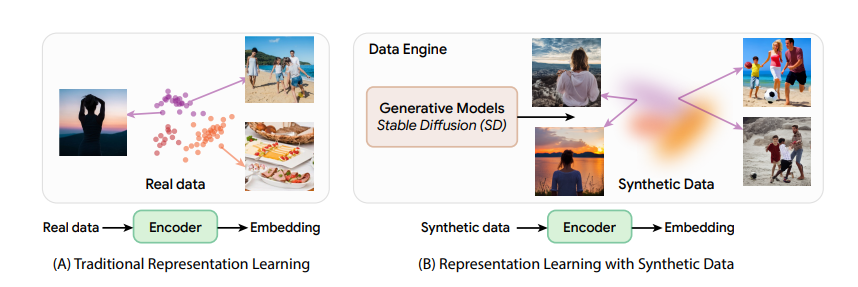

Как известно, данные - это новая почва в мире AI. И товарищи-исследователи из MIT CSAIL нашли оригинальный способ вырастить на этой плодородной земле нечто большее, чем просто пиксели. В своем новом исследовании, они использовали синтетические изображения для обучения моделей машинного зрения и значительно превзошли результаты традиционных подходов с "реальными" картинками. Такое обучение оказалось более эффективным и свободным от предубеждений машинного обучения.

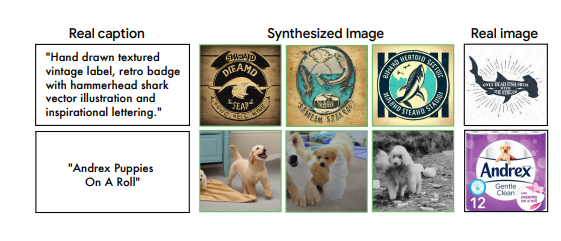

В основе описываемого подхода лежит система StableRep. Это не просто очередной софт для генерации синтетических картинок. StableRep использует самые популярные в последнее время модели вроде Stable Diffusion, которые создают изображения на основе текста.

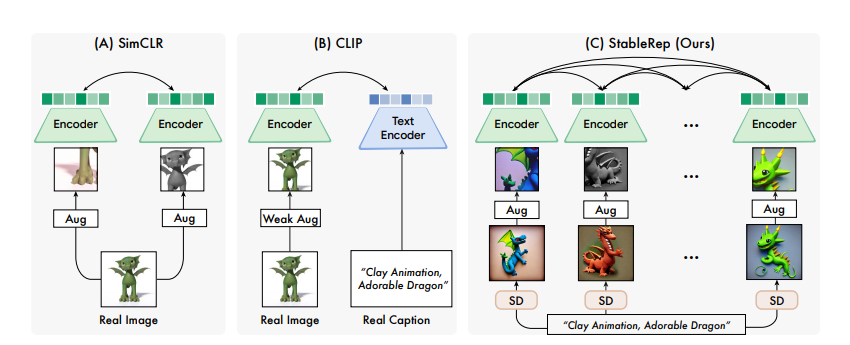

Ее фишка в уникальной стратегии обучения под названием "мультипозитивное контрастивное обучение" или контрастивное обучение с множественными положительными примерами, если говорить понятнее.

По словам Лайджи Фана, ведущего исследователя работы и сотрудника лаборатории компьютерных наук и искусственного интеллекта (CSAIL), суть в том, что система учится глубже понимать изображения. Ей не просто скармливают данные, а учат узнавать больше о высокоуровневых концепциях через контекст и вариативность. Когда нейросеть видит много разных изображений, сгенерированных из одного и того же текстового описания, она начинает рассматривать их как примеры одного объекта или концепции. То есть анализирует общее, абстрактное понятие за набором конкретных изображений, а не просто отдельные пиксели.

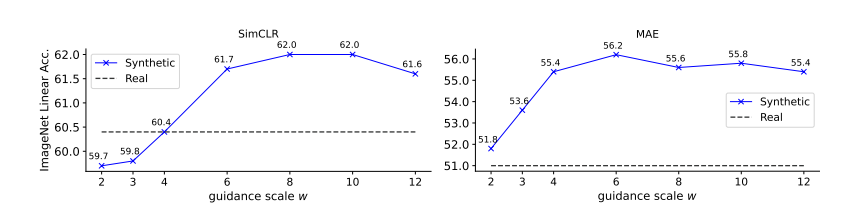

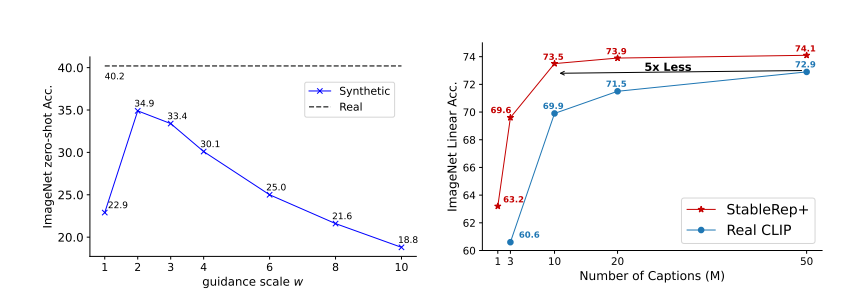

Этот подход рассматривает множество изображений, порожденных идентичными текстовыми запросами, как положительные пары, предоставляя дополнительную информацию во время обучения, не просто добавляя разнообразие, но и указывая системе зрения, какие изображения похожи, а какие различны. И на данный момент результаты уже удивляют - модель StableRep превзошла по точности распознавания такие передовые алгоритмы как SimCLR и CLIP, обучавшиеся на реальных данных.

Система StableRep не только помогает решить проблему нехватки данных для обучения ИИ, но и открывает путь к принципиально новым подходам в этой сфере. Поясню на примере. В 90-е перед исследователями стояла непростая задача: чтобы обучить алгоритм распознаванию объектов, требовалось вручную сфотографировать тысячи образцов. Процесс этот был крайне трудозатратным и дорогостоящим. Сырые, необработанные данные часто содержали расхождения с реальными сценариями и отражали общественные предубеждения, представляя искаженный вид реальности. А чистить датасеты было еще сложнее и дороже.

Теперь же этот нудный процесс сводится к простой команде на естественном языке.

StableRep кардинально упрощает дело. Она способна генерировать практически неограниченное количество реалистичных изображений на основе текстовых описаний. Разработчикам удалось добиться идеального баланса между разнообразием и качеством синтетических данных. Причём ключевым моментом является точная настройка параметров внутренней генеративной модели. При соблюдении этого условия, синтетические изображения, используемые при обучении, работают не хуже, если даже не лучше, чем реальные изображения.

Разработчики пошли дальше и добавили в систему языковой надзор, создав усовершенствованную версию StableRep+. Обучив её на 20 миллионах синтетических изображений, они не только достигли максимальной точности, но и продемонстрировали впечатляющую эффективность по сравнению с моделью CLIP, обученной на 50 миллионах реальных картинок.

Ограничения и вызовы

Тем не менее, путь не без своих подводных камней. Исследователи честно указывают на ряд ограничений. Это и низкие пока темпы генерации изображений, и семантические нестыковки текстовых описаний с результатами, и потенциальное усиление скрытых предубеждений, и сложности с атрибуцией картинок. Всё это предстоит решить для дальнейшего прогресса.

Ещё одна проблема в том, что сначала StableRep необходимо обучить на большом объёме реальных данных. Хочешь-не хочешь, это пока остаётся обязательным условием. Но зато после создания качественной генеративной модели её можно многократно переиспользовать для новых задач вроде распознавания и формирования визуальных представлений.

Хотя система StableRep и предлагает решение проблемы нехватки данных для обучения ИИ, а именно обширных коллекций реальных изображений, она подсвечивает другой серьёзный вопрос - наличие скрытых предубеждений в сырых данных. Дело в том, что текстовые подсказки, важные для генерации изображений, тоже могут нести предвзятость. По словам Лайджи Фана, это указывает на важность тщательного отбора текстов или даже ручного курирования.

Но все же успехи нельзя отрицать. Используя последние тексто-графические модели, разработчики получили беспрецедентный контроль над созданием картинок - разнообразные визуальные образы из одного текстового ввода. Это выигрыш и по эффективности, и по универсальности по сравнению с реальными данными.

Особенно отмечается полезность для специфичных задач вроде распознавания редких объектов. StableRep - практичное дополнение к реальным датасетам. Но требуются доработки - и в плане качества данных, и синтеза изображений.

Взгляд в будущее

По мнению Дэвида Флита, исследователя из Google DeepMind и профессора компьютерных наук Торонтского университета, данная работа имеет большое значение для всего направления генеративного обучения ИИ.

"Одна из давних мечт в этой сфере - научиться создавать синтетические данные, полезные для тренировки нейросетей. И хотя были определённые успехи, эта цель казалась недостижимой для сложных задач вроде распознавания изображений", - отмечает эксперт.

Однако этот проект впервые предоставляет убедительные доказательства, что эта мечта может сбыться. Обучение на огромных объёмах сгенерированных данных приводит к представлениям, которые даже превосходят обучение на реальных данных. А значит, есть большой потенциал для улучшения множества последующих задач компьютерного зрения.

На этом все! Будем рады почитать ваше мнение и обсудить новость в комментариях!

Hungryee

Когда-то эти все нетерпеливые «двигатели прогресса» поймут, что тренировать черную коробку на материале из другой черной коробки и ожидать человеческую конфетку - как минимум наивная, как максимум глупая и опасная идея; и больно-больно ударятся, когда все эти новые модели в продакшене начнут творить херню

RichardMerlock

Во всём нужен оптимум. Если метод даёт прирост показателей - надо брать. Если коробка начала творить херню - откатывать на предыдущую итерацию. Если процент херни в продакшене закрывается дёшево, то тоже норм, юротделу тоже надо работать - жопу корпоративную прикрывать.