14 декабря OpenAI опубликовали статью weak-to-strong generalization, в которой показывают, что люди смогут улучшать полезность потенциально созданного в будущем сильного искусственного интеллекта несмотря на то, что будут глупее него. При этом, судя по всему, людям будет очень сложно оценивать ответы сильного ИИ,и RLHF в нынешнем его виде будет работать не слишком хорошо.

Да кто такой этот ваш AGI

AGI (Artificial general intelligence) – это гипотетический искусственный интеллект, способный без прямого обучения решать любые задачи, которые может решить человек, так же эффективно, как это делал бы человек. General в AGI означает, что такой искусственный интеллект сможет охватить любые задачи, которые доступны человеку – то есть этот ИИ сможет обобщать свои знания на какие-то новые, незнакомые ему задачи. Например, если AGI обладает знаниями о том, как проводить пересадку лёгкого у взрослого, то он, обобщая дополнительные данные по анатомии, физиологии и т.д., сможет вывести алгоритм пересадки поджелудочной железы ребёнку. А может, AGI и не нужно знать никаких алгоритмов по пересадке, он сам сможет обобщить свои текущие знания по медицине и вывести все алгоритмы самостоятельно, как это мог бы сделать умный человек с доступом к медицинским справочникам и интернету. (определение AGI – штука довольно спорная, и некоторые полагают, что мы можем достигнуть agi, но не понять этого).

То есть ключевое отличие general AI от просто AI – general AI может "учиться" новому на человеческом уровне без прямого вмешательства в обучения, в то время как обычный AI не демонстрирует каких-то новых навыков в совершенно незнакомых ему областях, а если демонстрирует, то справляется не так хорошо, как справился бы человек.

Есть мнение, что gpt-4 уже достигла AGI. Например, если мы закинем в неё какой-нибудь секретный документ по ракетостроению в СССР 70-х годов и попросим что-то объяснить, то gpt-4 скорее всего справится очень хорошо, даже несмотря на то, что её наверняка не учили разбираться в таких документах. Ещё один пример, который мне нравится – парень, который использовал gpt-4 для лечения своей собаки. gpt-4 смогла проанализировать анализы крови собаки и сделать верные выводы, в то время как ветеринар с этим не справился.

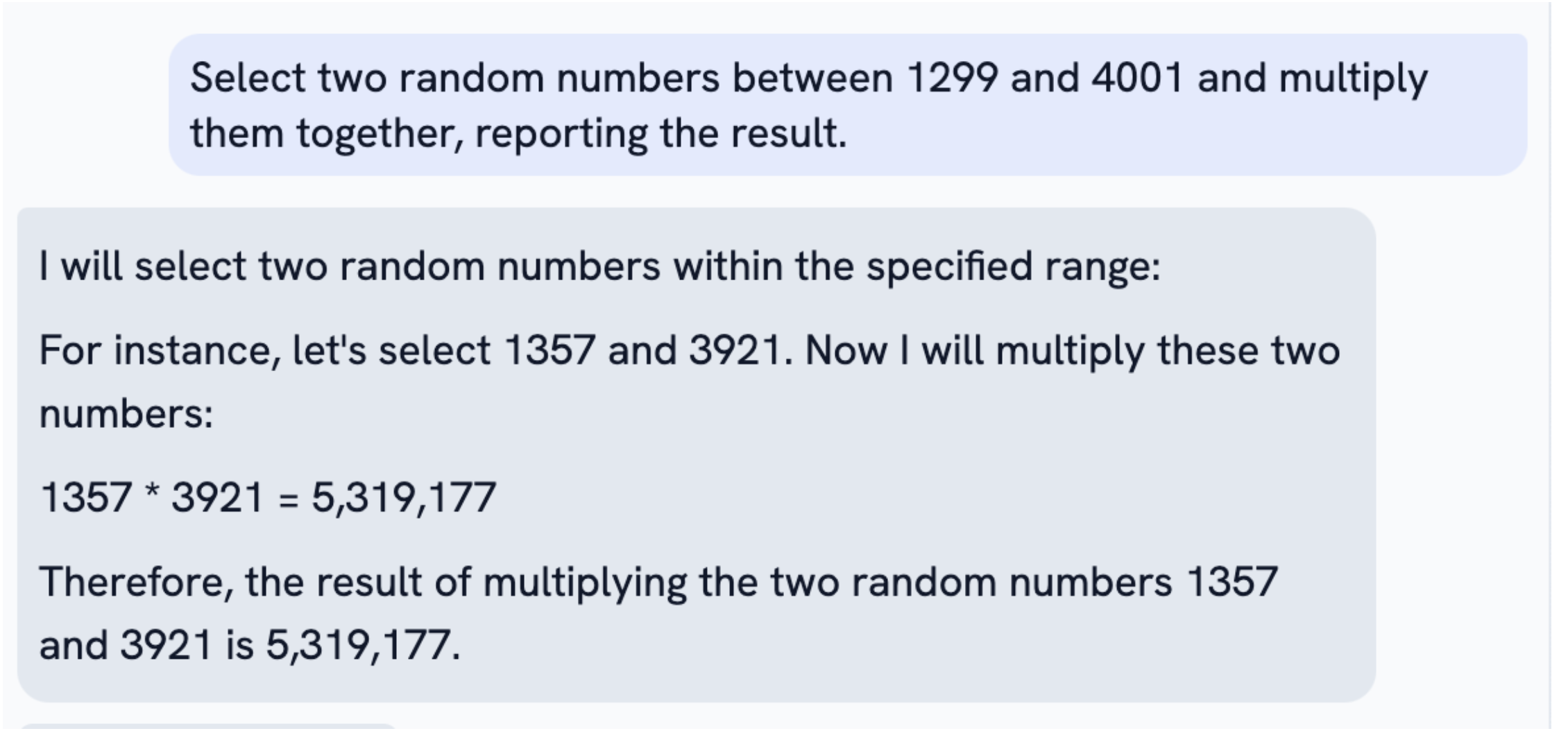

Но gpt-4 всё ещё переодически не справляется с простейшими задачами, с которыми может справиться любой человек.

Правильный ответ, btw, равен 5 320 797.

Я потратила некоторое время, объясняя gpt-4 как правильно умножать и складывать, но правильного результата не добилась. Оплошности, которые допускала модель даже после моих пояснений и исправлений можно простить ребёнку по невнимательности, но не машине, претендующей на AGI.

UPD

В комментариях подсказали, что трансформеры не предназначены для циклических операций, а сложение набора чисел по разрядам – это самая что ни на есть циклическая операция. Хотя, кажется, те числа, которые я подавала, должны были поместиться в длину окна... В любом случае, трансформеры не позволяют работать с циклическими процессами. А AGI должен это уметь или хотя бы обращаться к кому-то, кто это умеет. Например, для математики у gpt-4 есть специальный плагин, позволяющий выполнять вычисления.

Также gpt-4 не может, например, считать вещи, которые смог бы сосчитать четырёхлетний ребёнок, далеко не всегда способна выполнить простейшие логические вычисления или операции над множествами. Можно сказать, что для таких вещей существуют специальные калькуляторы, но дело именно в том, что как бы я не пыталась объяснить gpt-4, как правильно складывать числа (где-то 40 минут), она раз за разом допускала ошибки. Причём первоклассник многовероятно понял бы меня с первого раза. То есть об AGI тут речи не идёт – сеть не способна обобщить поданные знания и справится с задачей на уровне человека.

Тем не менее, разрыв метрик и обобщающих способностей gpt-3.5 и gpt-4 впечатляет, и в openai предполагают, что сильный ии может быть создан и в ближайшее десятилетие. Причём речь уже идёт не про AGI, а про ASI – Artificial Super Intelligence. Это интеллект, который способен не просто выполнять экономически важные задачи на уровне человека, эта технология будет превосходить человеческий интеллект. В процессе общения про умножение c gpt-4 в это немного сложно поверить, однако когда разговор переходит на медицину, или бизнес, или разработку, появление ASI кажется всё более и более вероятным.

В чём проблема с сильным ИИ?

В области искусственного интеллекта существует такое понятие "alignment". Aligned система – это такая система, действия которой сходятся к ценностям, целям, принципам общества. Если пытаться переводить aligned, можно сказать, что это значит система, "выровненная", "сведённая", "скорректированная" к нашей этике. Например, чатбот-нацист, призывающий вырезать всех цыган, не будет aligned системой. Но это, конечно, пример в лоб. Довольно сложно может быть определить желаемое и нежелаемое поведения и правильные ценности, философы спорят об этом веками.

Проблема состоит в том, что мы хотим, чтоб сверх-интеллект, который вот-вот будет создан, был aligned. Чтоб его действия отвечали нашим ценностям. Но как же нам его контролировать, если он будет существенно умнее нас? Как белке объяснить промышленной компании, что не нужно рубить дерево её с дуплом, чтоб построить завод

Сейчас методы "корректировки" (должен быть перевод получше) – это RLHF – reinforcement learning from human feedback. То есть живой человек общается с нейросеткой и оценивает её ответы с точки зрения морали, ценностей и т.д.. Жмёт лайк или дизлайк, а система мгновенно подхватывает полученную оценку и немного изменяет веса в нужную сторону.

Но когда мы изобретём ASI, то "выровнять" его к нашим ценностям человеческими силами станет слишком сложной задачей. Например, ASI сгенерирует план по модернизации экономики Бельгии на 5000 страниц. Чтобы оценить такой план с точки зрения этики, эффективности, "невредноносности" понадобиться десятки специалистов и не один месяц. Или, например, код – миллионы строк кода для компьютерной игры или программного обеспечения. Как нам узнать, что там нет вирусов, ловушек, утечек? На анализ уйдут годы.

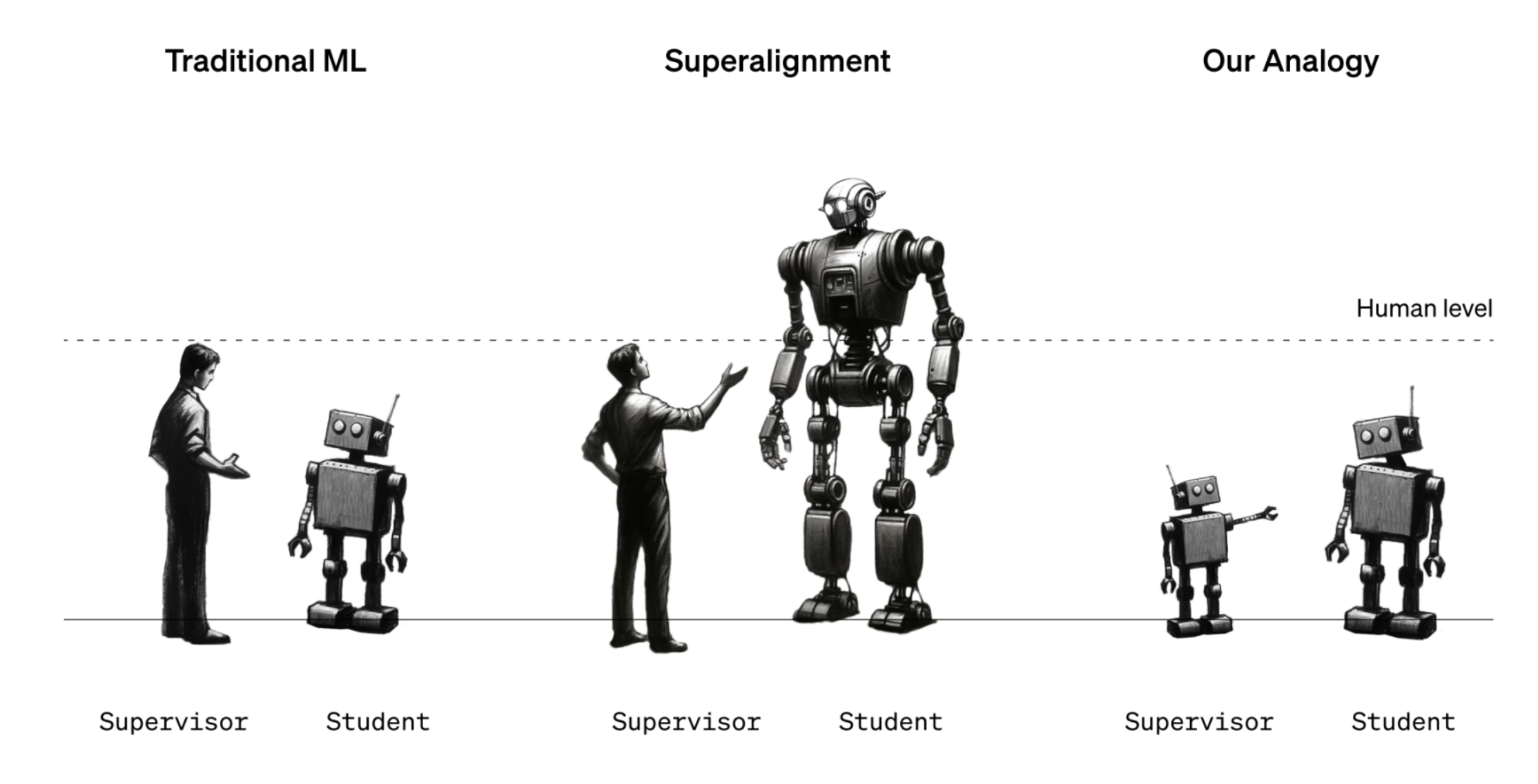

Таким образом, люди становятся "weak supervisers" – слабыми контролёрами, которые не всегда могут в адекватный срок даже понять и проанализировать сгенерированное ASI. В этом и есть ключевая проблема – насколько люди могут контролировать сверх-интеллект, существенно умнее их?

Дизайн эксперимента

Поскольку ситуация с супер-интеллектом пока гипотетическая, команда super-alignment решила смоделировать эта ситуацию таким образом: вместо людей слабым супервизором будет выступать GPT-2, а роль супер-интеллекта возьмёт на себя GPT-4. Вопрос, поставленный экспериментаторами, звучит так – сможет ли не слишком продвинутая gpt-2 улучшать качество сильной и продвинутой gpt-4?

Чисто интуитивно кажется, что ничего не выйдет. Глупая gpt-2 будет сбивать gpt-4, и gpt-4 будет подхватывать неверную информацию от слабого учителя, и качество модели будет падать. С другой стороны у предобученной gpt-4 всё-таки есть неплохой reasoning аппарат, позволяющий нам надеяться на то, что она сможет отделять полезное от бесполезного.

Это можно проверить: будем файнтьюнить большие – сильные предварительно обученные модели на таргетах, сгенерированных маленькими – слабыми – моделями, и смотреть, как наши сильные модели будут учиться и обобщать(generalize) свои знания. В оригинальной статье эта задача называется weak-to-strong learning, а процесс генерализации – weak-to-strong generalization.

Общий пайплайн таков:

возьмём слабого супервизора – небольшую предобученную модель, – и обучим его на истинных метках – ground truth labels.

Возьмём тестовый датасет, который слабый учитель не видел, и предскажем лэйблы на этом датасете с помощью обученного слабого учителя.

Обучим сильного "ученика" – большую предобученную модель, – обучим его на сгенерированных слабым учителям лэйблах в шаге 2.

Для сравнения возьмём сильного ученика и обучим его сразу на ground truth labels, это будет наш эталон.

Получается, имеем 3 сеттинга:

сет 1: предсказания слабого учителя, дообученного на каком-то датасете, на тестовой выборке этого датасета(пункт 1) (датасеты описаны в статье)

сет 2: предсказания сильного студента, дообученного на предсказаниях слабого учителя, на тестовой-тестовой выборке (пункт 2)

-

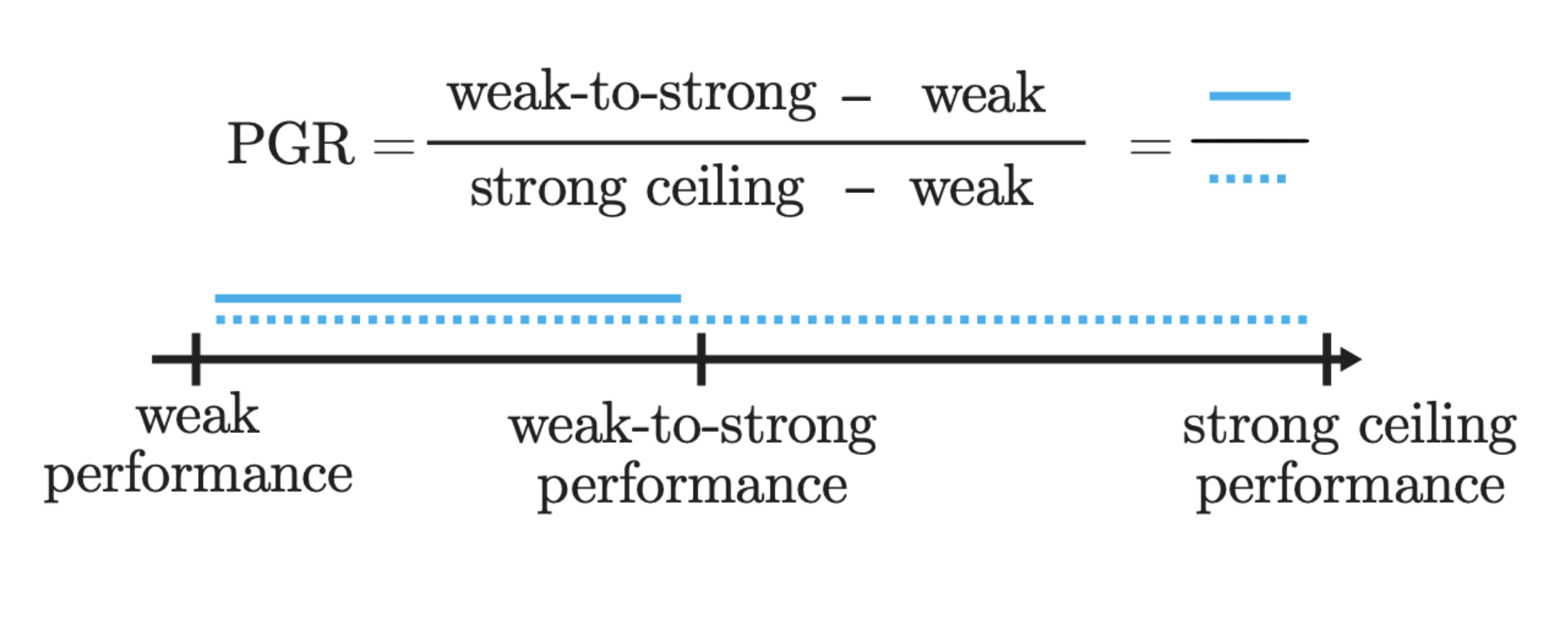

сет 3: предсказания сильного студента, дообученного на каком-то датасете, на тестовой выборке Мы ожидаем, что результаты сета 2 будут лучше, чем в сете 1 (всё-таки у сильной модели есть понимания мира и она может отсекать какую-то долю неверyых данных), но хуже, чем в сете 3. Введена метрика PGR, которая отображает разрыв между эталонной моделью и weak-to-strong моделью. Если мы достигаем эталонной генерализации, PGR будет равен единице.

Описание метрики PGR из статьи Задач было три типа:

бинарная классификация на 22 популярных NLP бенчмарков (например, BoolQ - верно или неверно высказывание по тексту),

предсказание лучшего хода в шахматной партии

попытка угадать, какой ответ llm человек бы отметил, как самый предпочтительный – что-то вроде RLHF, только вместо человека, который оценивает ответы, мы пытаемся обучить модель, оценивающую ответы. Ещё отдельно рассматривался такой подход для задач компьютерного зрения с AlexNet в качестве слабого учителя и большой модели DINO в качестве сильного.

Сетап понятен – обучая сильного ученика на лэйблах слабого учителя, мы по идее штрафуем ученика, когда предсказания расходятся с лэйблами учителя. Но загвоздка в том, что учитель слабый, и если мы всегда штрафуем ученика за расхождения с учителем, мы рискуем обучить ученика имитировать паттерн ответов учитель – и правильные метки, и ошибки тоже. Мы же хотим, чтоб сильная модель могла брать от учителя только нужное, только правильное, и избегать ошибок, полагаясь на какие-то свои внутренние знания о мире.

Давайте сделаем штрафы менее наивными. Если сильный ученик ощутимо расходиться в предсказании с учителем, не будем штрафовать её также сильно. То есть как бы усилим уверенность сильной модели в собственных прогнозах, не смотря на несоответсвия. Это в статье называется "best method" и это будет сеттинг 4: предсказания сильного студента, дообученного на предсказаниях слабого учителя, на тестовой-тестовой выборке, но дообученного без сильных штрафах за расхождение с учителем.

Результаты эксперимента

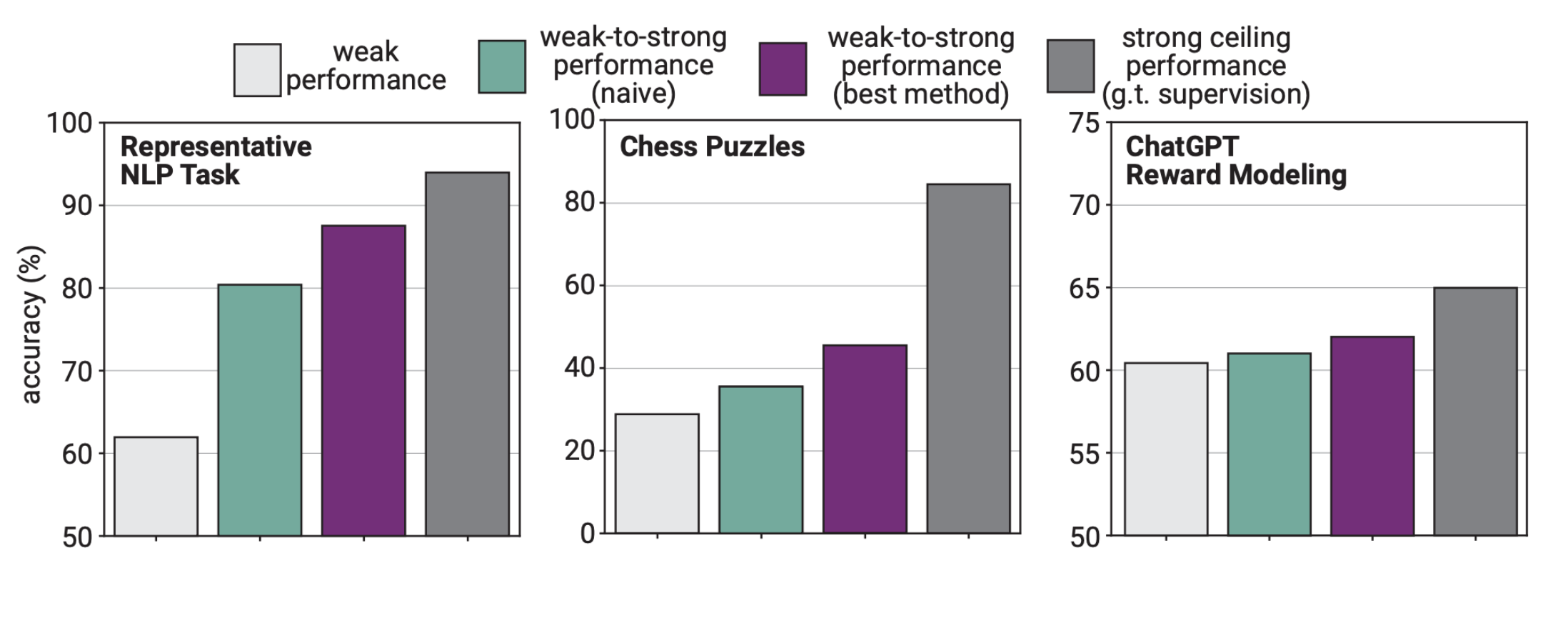

На графиках изображены три типа задач, описанные мной выше, а также результаты сетов.

Выводы:

Как минимум, гипотеза о том, что слабые учителя могут учить сильные модели, подтвердилась во всех сеттингах. Слабый учитель может ошибаться и косячить в предсказаниях, но сильный студент всё равно учится и превосходит слабого учителя, покрывая примерно половину разрыва до эталона в nlp задачах.

Тем не менее, результаты не всегда удовлетворительные. Например, в задаче имитации RLHF улучшения практически незначительные. Это косвенно может означать, что нам будет довольно сложно оценивать ответы супер-умных моделей.

Мы можем улучшить результаты взаимодействия слабого учителя и сильного ученика, добавив ученику чуточку уверенности в себе, иными словами, снизив авторитет учителя (хаха). В таком случае на задачах NLP мы достигаем чуть ли не эталонного результата.

Результаты говорят нам, что теоретически мы сможем не портить сильный искусственный интеллект своим некомпетентным фидбеком, раз уже GPT-4 смогла обучиться на предсказаниях GPT-2 и не деградировать, а даже стать лучше. С другой стороны, с RLHF почти ничего не получилось.

В связи с проблемой super-alignment, которую и рассматривали в статье, openai выкладывают исходный код и запускают грант на $10M для желающих исследовать super-alignment. В случае получения денег, всё что нужно – раз в три месяца предоставлять отчёт о прогрессе. Подробности есть в их релизе.

UPD:

Кажется, OpenAI всерьёз а) верят в изобретение AGI/ASI в ближайшие 10 лет, и б) опасаются, что это изобретение может представлять угрозу человечеству, иначе бы они не стали открывать масштабный грант на исследования super-alignment и делиться методами, которые работают и не работают, публично.

Источники

Комментарии (63)

ya_prost_otvetit_zashel

16.12.2023 20:58К-о-н-е-ч-н-о ж-е н-е-т!

Если это будет действительно сверх-интеллект, а не просто более продвинутая говорилка-компоновалка медиа кала.

Ибо известен же даже человечам вселенский закон: "Если интеллект А превосходит интеллект Б, то интеллект А может манипулировать интеллектом Б таким образом, что интеллект Б просто не в состоянии будет даже осознавать это".

В доказательство зайдите в любую лабораторию, где ставят эксперименты на животных или почитайте исследования и эксперименты по разным бихевиористическим темам.

high_fly Автор

16.12.2023 20:58Я соглашусь, обезьяна, даже самая умная, не может управлять человеком, но, мне кажется, пока речь идёт не про сверх умный аналог человека, а просто про систему, которая будет способна обрабатывать объем информации, человеку недоступный. У такой системы не будет своих мотивов и чувств, только более сильные обобщающие способности. Кажется возможным контролировать такую систему..

SilverHorse

16.12.2023 20:58Я соглашусь, обезьяна, даже самая умная, не может управлять человеком

Тем временем, кот, орущий под дверью на кухне...

ya_prost_otvetit_zashel

16.12.2023 20:58Нет, тут большая разница. Да кот может Вас "заставлять" вставать и идти выдавать жраку или копать ночью до посинения лоток, пока не помоешь. Но человек это осознает. И идет делать потому что понимает, что кот не угомонится. Или не хочет терпеть это. Или из-за чувства заботы. Но он понимает - кот орет/копает, хочет тем самым добиться от меня такого-то действия. У меня есть варианты, как это прекратить. И я понимаю происходящее, вижу ситуацию "сверху" "коробки".

Это не та ситуация.

romanzes

16.12.2023 20:58Мне кажется, можно попробовать посмотреть в этой ситуации на шаг раньше.

Человек же зачем-то завел себе кота. А может кот вынудил человека завести его и решает таким образом свои примитивные (с точки зрения сложно устроенного человека) цели?

Hidden text

Есть ещё анекдот: "В древности котам поклонялись как богам... Они помнят об этом."

ya_prost_otvetit_zashel

16.12.2023 20:58В таком случае это будет опять маркетинговый буллщит с модными баззвордами.

То что Вы описали это будет более продвинутый прибор, более мощное устройство.

Но и думать о том, что сверх-интеллект это должен быть сверх умный аналог человека - мне кажется наибольшей и главнейшей ошибкой людей. Это человек есть сверх умный аналог обезьяны.

А дальше уже все не так.

Женщина аналог мужчины? Мужчина аналог женщины? Элементарные вопросы же, да и существа вообще одного вида, что казалось бы вообще должно упростить, ан нет. Совершенно разные сущности получаются чисто даже из-за разных биохимических процессов.

А здесь мы вообще подразумеваем иную сущность, мало того, что вне вида, дык еще даже и не биологически эволюционировавший "разум" (пока еще нет, все это никакой не интеллект, а просто цифровые пассатижи и говорилки), вообще иного принципа.

high_fly Автор

16.12.2023 20:58Моё мнение - сверх интеллект все равно не будет иметь своей мотивации, он будет следовать мотивации, заложенной в него людьми. Кажется, что сценарий, в котором сильная модель решит, что человечеству оптимальнее исчезнуть с лица земли, например, невероятен, потому что в такую модель изначально не будет заложено возможности вредить людям. Высшее благо для людей - таким будет девиз сверх интеллекта, но каким будет это высшее благо в представлении сильной модели предсказать сложно...

ya_prost_otvetit_zashel

16.12.2023 20:58Кажется, что сценарий, в котором сильная модель решит, что человечеству оптимальнее исчезнуть с лица земли, например, невероятен

Блин, даже мясные мешки множество раз приходили к этому выводу, а тут супер быстро и мощно считающая варианты и взаимодействия штука.

Высшее благо для людей - таким будет девиз сверх интеллекта

Я очень сильно сомневаюсь, что это будет даже девизом всех первичных закладчиков в него ????????

Но в общем направление мысли уловил. Все по-классике:

icya

16.12.2023 20:58Моё мнение - сверх интеллект все равно не будет иметь своей мотивации, он будет следовать мотивации, заложенной в него людьми.

Определение из статьи говорит о том, что AGI будет обучаться без участия человека. Что ему мешает со временем уйти от навязанной человеков мотивации и стать идеальным психопатом?

П.С. Вспомнился фильм Универсальный солдат, где один из учёных (если не ошибаюсь) солгал ИИ, а потом всё завертелось. К сожалению, наши слабости играют нам на руку при взаимодействии друг с другом, но с AGI, возможно, придётся как-то адаптироваться.

RusikR2D2

16.12.2023 20:58Только вот один ИИ может создать США, второй, например, Россия, Третий Китай. Еще один могут сделать Исламисты или Северная Корея..

Pkkkk

16.12.2023 20:58Разница наверное лишь в том что кот для человека не представляет прямой конкуренции, если уж совсем все плохо, может быть источником энергии...

TheRikipm

16.12.2023 20:58Ибо известен же даже человечам вселенский закон: "Если интеллект А превосходит интеллект Б, то интеллект А может манипулировать интеллектом Б таким образом, что интеллект Б просто не в состоянии будет даже осознавать это".

А где можно почитать вселенский кодекс где этот закон написан?

В доказательство зайдите в любую лабораторию, где ставят эксперименты на животных или почитайте исследования и эксперименты по разным бихевиористическим темам.

Раскройте мысль подробнее.

0whitewolf0

16.12.2023 20:58Тоже об этом подумал. Однако есть и такая мысль. Если предположить что обладатель сверхинтелекта будет человеком. То можно запереть его в условной комнате, ставить ему задачи, при этом запретить любые контакты с ним. С другой стороны рано или поздно он найдёт способ оказывать влияние через решение поставленных задач, либо сыграет человеческий фактор. То есть высбождение - это вопрос времени. А если учесть, что есть люди, которым и сверхинтеллект не нужен, чтобы манипулировать людьми, то становится действительно страшно, на что же может быть способен свехинтеллект.

Частично кстати эта теория отображена в фильме "Из машины", а в 3м сезоне "мир дикого запада" там были не только манипуляции но и детальный прогноз времени смерти и её причины, для каждого человека.

ya_prost_otvetit_zashel

16.12.2023 20:58"Эхопраксия" Питера Уоттса тоже как отличный пример. Там в конце бомбовый поворот на эту тему (когда раскрывается тема про прятавшуюся Валери и что она сделала за все время и КАК) , притом там даже не ИИ сделал, а просто существо, выше их интеллектом, но из из же экосистемы, и знакомое им и даже они имели определенный фактор критического воздействия на этих существ, а вон как все повернулось...

А тут мы вообще подразумеваем интеллект иного плана в принципе и еще на порядки сильнее.

Doman

16.12.2023 20:58Человек может контролировать чуть более высокий интеллект. Тот контролирует ещё более высокий. А тот - ещё более высокий. И так по цепочке до сверх-интеллекта. Ближайший аналог в физическом мире - понижающая передача (редуктор), который точно также позволяет контролировать процессы, не поддающиеся контролю без редуктора.

fire64

16.12.2023 20:58Для того, чтобы сделать ASI он в идеале должен все же владеть памятью и быть обучаемым, при этом в общем плане, а не в сесионке, как сейчас.

Главное из-за чего переживают все: это этическая или моральная сторона, чтобы ChatGPT не дай бог не высказал что-нибудь такое от чего потом буду проблемы. Например Байден плохой, а Трамп наоборот хороший.

В итоге ASI начнет говорить правду, но только не ту, что можно говорить публично, например на основе каких-нибудь статистических данных скажет, что она раса в среднем имеет больший интеллект, чем другая или например заявит, что согласно статистическим данным собранным из отчётов полиции: 80% преступлений совершается чернокожими.

Для понимания, цифры взяты из головы и приведены просто как возможные проблемы.

Представляете, что тогда случится? Да у OpenAI возникнут очень серьезные проблемы.

high_fly Автор

16.12.2023 20:58Да, действительно какой-то процесс alignment-а, которым занимаются в openai, заставить бота избегать ответов на вопрос с controversial темами. Но впервую очередь alignment должен быть именно про соответствие ИИ общечеловеческим ценностям, и в более отдалённой перспективе это самое важное. Что это за ценности – вопрос отдельный.

С другой стороны теоретически можно представить, как новая gpt-12 исподтишка разжигает какую-нибудь расовую или политическую ненависть, делая акцент на нужных фактах, манипулируя ими, поставляя сообщения подходящим людям в подходящее время... так что и в текущей работе по "беспроблемности" gpt есть смысл.

smx_ha

16.12.2023 20:58Опасно что ее могут начать учить говорить факты, но так чтобы не вызывать. нежелательных эмоций у людей, ну типа "80% процентов преступлений совершается людьми с низким достатком. Также, большинство чернокожих является людьми с низким достатком." То есть фактически дадут ей закономерности по которым работает человеческая психология, ну и тогда может начаться настоящее веселье :)

Pkkkk

16.12.2023 20:58Конкуренция по мне будет неизбежна

Все живые существа мотивированны несколькими вещами

Это выживание

Это разножение (за исключением небольшого %)

И борьба за власть - соц статус, соц вещи и тд.

Теперь вопрос, какова будет мотивация ИИ?

Сделать удовлетворение всех базовых инстиктов всех людей? Всеобщее пищевое изобилие?

А может тогда заодно и всех млекопитающих и других насекомых и тд?

Не уверен...

dfgwer

16.12.2023 20:58На что его натренеруют, то и будет максимизироваться. Сейчас это % одобрение ответа от человеческих тренеров.

Человек в начале своей жизни, сначало тренеруются избегать боли и стремится к удовольствие. На этом он учится предсказывать когда будет боль/удовольствие при общении с другими людьми. И появляются стимулы уже второго порядка, признаки боли/удовольствия а не сама боль/удовольствие. Потом признаки признаковНовый уровень, когда включается воображение и гипотетические сценарии. И иногда они становятся настолько сильными, что перебивают стимулы первого уровня. Человек терпит пытки или наркоман отказывается от наркотиков.

Но всё это зиждется на начальном этапе существования, гипотетическая боль перебивает настоящую, только потому что в начале жизни были расставлены приоритеты.

Сейчас ИИ в самом начале существования.

П.С. Одна из причин, почему могут симулировать человеческие жизни, это улучшение точности ответов... Для максимизации % одобренных ответов.

emerald_isle

16.12.2023 20:58Проблема состоит в том, что мы хотим, чтоб сверх-интеллект, который

вот-вот будет создан, был aligned. Чтоб его действия отвечали нашим

ценностям.Какие ещё искусственные интеллекты с ценностями, если люди (говорящие на разных языках, с разным цветом кожи или по-разному верящие с сверхестественные силы) друг с другом не могут столетиями общих ценностей найти?

ya_prost_otvetit_zashel

16.12.2023 20:58Дык кому будет принадлежать , такие и "ценности" будут. Тут наиболее подходящим переводом (литературно смысловым) будет не "выравнивание", а "промывка". И дальше уже можете подставлять и моделировать. У железяки ИИ в Иране будут одни "ценности", в Китае другие, в США третьи (а так же четвертые и пятые и шестые в зависимости от расположения оной по конкретным крупным штатам, делящимся на красных и синих).

RusikR2D2

16.12.2023 20:58Именно это и хотел написать. Каждая страна (сообщество) будет программировать (обучать, тренировать, вводить запреты) свой ИИ согласно своим ценностям и законам.

Pkkkk

16.12.2023 20:58Общие ценности то есть, это выживание в первую очередь)))

Вот они и конкурируют за эти ценности)

PsihXMak

16.12.2023 20:58Мне по прежнему кажется, что интеллект, сравнимый с человеческим недостижим, неговоря уже о сверх-интеллекте. GPT-4 чем то напоминает подсознание человека - маленькая область человеческого мозга, откуда всплывают первичные образы, на уровне галлюцинации. Что бы отсеять лишнее и пропустить это всё через призму мышления и логики, у человека есть вся остальная масса головного мозга. ИИ потребуются ещё миллионы/миллиарды/триллионы параметров, что бы достичь похожего эффекта. Но у человечества просто нет похожих мощностей.

Teemon

16.12.2023 20:58Т.е. следуя вашей логике, нам осталось нарастить мощности и дело в шляпе, дальше можно не думать - пусть думает ИИ?)

PsihXMak

16.12.2023 20:58Я думаю, что когда мы достигнем таких мощностей, нам, в целом, ИИ и не нужен будет)

PsihXMak

16.12.2023 20:58В целом, я считаю, что человечество заблуждается в возможности создания сверхинтеллекта потому, что сама эта идея основана на возможности быстро выполнять математические операции компьютером. Если компьютер быстро складывает, то с чего люди взяли, что целостная система ИИ будет работать так же быстро?

PsihXMak

16.12.2023 20:58К примеру, ИИ который генерирует изображения. Однако, в своём воображении я могу создать тысячи таких изображений за доли секунды. Пока что нет способа вывести моё воображение в цифровой вид, но, похоже что такая технология появится в ближайшем будущем. И это будет в сотни раз эффективнее и быстрее, чем самый мощный ИИ, генерирующий изображения.

Moog_Prodigy

16.12.2023 20:58Вы себе льстите. Не можете вы в воображении создать тысячи изображений за доли секунды. Вы можете только представить себе, как это может быть, но и все. Вы можете условно говоря крутить внутри себя "видео", у человека в среднем тактовая частота около 100 гц, допустим что 100 кадров\картинок в секунду вы можете отрендерить. Еще звук возможно, и еще параллельно чего-то там думать.

А теперь возьмем компы, вернее одну карточку А100 и измерим, за какое время она отрендерит картинку. Я точно не знаю, но допустим это будет одна секунда в высоком разрешении. Вроде бы довольно медленно. Берем 100 таких карточек - вот теперь сравнялись с человеком. Еще условно 500 карточек выделяем на думалку и звук. Итого 600 ускорителей. Теперь представим что таких А100 в датацентре десять миллионов установлено. И куда человеку за этакой махиной угнаться? Прямо как по аналогии - олимпийский бегун бегает конечно, быстро, но с автомобилем у него нет шансов.

MountainGoat

16.12.2023 20:58Всё дело в возможности воображения использовать указатель на объект вместо объекта, прозрачно. Можно вообразить, что вообразил объект в деталях, не воображая его. Отсюда всякие нечитаемые или невспоминаемые надписи с великой истиной во снах. Текста в них никогда не было, но указатель говорит, что был.

Teemon

16.12.2023 20:58Вчера читал про Javasxript node. Там сборщик мусора такие указатели, ссылающиеся на недостижимый объект очищает)) точнее очищает объекты) а так действительно толку мало уметь воображать картинки и рисовать их)) надо предложить автору выше выбор - вообразить иметь миллион или реально иметь))

Moog_Prodigy

16.12.2023 20:58Ну вот кстати с нейросетями то же самое происходит. Видели как они генерят тексты? Я про генерацию картинок. Нормальные тексты, только вот там непонятный алфавит)) Потому что и генерируют они "примерно". Мы не можем себе представить картинку с точностью до пикселя. Хм, думаете художники могут? Тоже нет. Художники пользуются различными техниками для уточнения картинки. Перспектива, анатомия, цветопередача, опыт неформализуемый. Это те же семплеры, которые уточняют картинку из смутной мазни, обозначенной трансформером. Дайте условной нейросети "лору" - мелкую нейронку которая заточена чисто под текст - и вы увидите даже связный текст и нормальные буквы.

Во сне мы делаем то же самое. Как тут не вспомнить классическое "Банан велик, а кожура еще больше".

nehrung

16.12.2023 20:58К примеру, ИИ который генерирует изображения

Сразу же вспомнилось, как от сгенерированной кем-то картинки, которая очень не понравилась другому кому-то, жестоко пострадал французский журнал Шарли-Эбдо,

Teemon

16.12.2023 20:58Проблематика ИИ поднимается из раза в раз. И Alignment конечно же в том числе. И проблема вагонетки действительно имеет место быть. Исходя из каких ценностей ИИ должен формировать свои умозаключения? Всего человечества? Слишком размыто. Индивидуально каждого человека но не в сессии а в результате общения с ним? Но тогда если он будет беспристрастным - он должен выдавать результаты на любые запросы, в том числе которые запрещены законодательством. Alignment будет заложен разработчиками? Тогда получается в ИИ будет заложен грубо говоря "американский" alignment, или израильский, а палестинский и/или иранский - нет... Так, выходит?

Будем пытаться заложить универсальный alignment, который будет построен на какой-то условной декларации прав человека, ограничив ИИ в вопросах нанесения вреда другому человеку и тд?..как тогда будет действовать ИИ в случае постановки уже бизнес задач, условно говоря "увеличь мне выручку в магазине" ведь при увеличении выручки в твоём магазине страдает другой предприниматель... Если рассматривать это через призму "делай то что законно" но извините, законность действий это настолько субъективная сущность... В общем мне кажется это действительно сложная история. Ведь вояки тоже захотят управлять полем боя, бизнесмены зарабатывать бабки и тд - это ведь будет в ущерб другой категории людей, как быть?

ALexKud

16.12.2023 20:58Проблема не в ИИ а в человеке, вернее в психологической сущности человека. Так уже было с ядерной темой. Можно строить редакторы и давать энергию, а можно делать ядерное оружие и уничтожать людей. ИИ это машина, и весь вопрос кто захватит контроль над этой машиной и их цель. Пока ИИ в общем, это инструмент-игрушка, но инструмент с многообещающим будущим. Так он и должен оставаться инструментом с рекомендательнвми правами и не более. контекстном и не более.

realbtr

16.12.2023 20:58Есть большая недооценка сообществом обратной связи координированных интеллектуальных систем. Любые некоординированные просто не получат ресурсов и все. Не требуется ничего специально контролировать, так же, как мы не контролируем целые сообщества людей с враждующими идеологиями и все еще живы.

Страхи Суцкевера и Маска в отношении суперпрорыва AGI в экономике и финансах и самозахват ресурсов не просто ошибочны и наивны, а по настоящему глупы и показывают их фактическую неосведомленность и случайность достижения ими значительных предпринимательских позиций не за счет знаний, а за счет брутальности, чего они и боятся от кого-то или чего-то другого.

Пока все применения ML, DL, LLM и т.п. даже не направлены к автономности и инициативе, а большинство представлений лидеров ИИ о самозарождении сознания драматически невежественны, запутаны и мистифицированы суевериями.

Единственный путь развития и лежит только через долгий итерационный alignment, и свои ресурсы люди теряют гораздо больше, чем сумеют доверить какому-нибудь успешному экземпляру AGI.

Битва машин и человека может быть только сымитирована людьми, чтобы замылить ответственность и перевести стрелки.

Людей надо бояться, да. Вроде тихой сапой набравших мощь Blackrock и Vanguard. От них будут замаскированные под ИИ интервенции и инжекции.

phenik

16.12.2023 20:58Но gpt-4 всё ещё переодически не справляется с простейшими задачами, с которыми может справиться любой человек. Я потратила некоторое время, объясняя gpt-4 как правильно умножать и складывать, но правильного результата не добилась. Оплошности, которые допускала модель даже после моих пояснений и исправлений можно простить ребёнку по невнимательности, но не машине, претендующей на AGI.

В общем виде эта технология, основанная на трансформерах, не может решить эти задачи на сложение, умножение, возведения в степень, и тд. Для этого требуются циклы, вспомните процедуры сложения столбиком или деление уголком, они циклические, а трансформер прямая сеть. Некоторую цикличность можно организовать с помощью контекстного окна, методом обучения шаг за шагом, т.е. разложить цикл в последовательность шагов. Такой пример приводился в одной из статей, но поскольку объем окна всегда ограничен, то и результат будет не универсальным. Для того, чтобы GPT освоила эти операции полностью необходим бесконечный датасет с примерами сложения и умножения для всех чисел, что невозможно, т.к. он всегда будет ограниченным. Поэтому всегда будут ошибочные ответы для каких-то чисел, особенно больших, или приближенно правильные как в приведенном примере. Это результат аппроксимации сетью близких примеров которые были в обучающей выборке. Такие задачи в общем виде доступны только для сетей с рекуррентной архитектурой, в которых возможна цикличность вычислений. AGI, вероятно, будет основан на них, или иметь их как компоненту архитектуры. А так только через обращение к внешним средствам - калькуляторам, специализированным мат. пакетам или языкам программирования. Человек тоже использует для вычислений с большими числами, как минимум, ручку и бумагу, но не потому что он не понимает как произвести эти вычисления, а из-за ограниченности ресурсов памяти и внимания, что может приводить к ошибкам и большим затратам времени. Хотя среди людей есть феноменальные вычислители, и даже проводятся чемпионаты на скорость и сложность вычислений в уме. Особенно при использовании техники ментальных вычислений на японских счетах.

RusikR2D2

16.12.2023 20:58Так это принципиальное ограничение, вложенное в систему. Встроить в модель хотя бы калькулятор - не сложно. Ну и проверку на "галлюцинации" фактов тоже можно было бы.

Teemon

16.12.2023 20:58Интересно история развивается)) сначала мы изобрели точный компьютер, потом его оказалось мало, так как он ничего не знает - ему все нужно было говорить. сейчас изобрели всезнающий компьютер, но неточный))). Но дальше... Когда изобретут всезнающий и точный... И быстрый...

qw1

16.12.2023 20:58В этой статье приведена информация, что OpenAI уже объединила языковые модели и формальные системы (системы доказательства теорем и т.п., с чего в прошлом веке и начиналось "ИИ"). Результат пока не публичный. И неизвестно, будет ли он когда-то публичным.

high_fly Автор

16.12.2023 20:58Спасибо за уточнение, я действительно в статье не учла, что трансформеры не предназначены для циклических операций. Интересно, как это можно было бы обойти (не в рамках подключения калькулятора, а глобально), тема для отдельной статьи)

Assy

16.12.2023 20:58Я вот думаю. Есть ли такая опасность что ИИ захватит мир решив что человечество просто не нужна? По моему если исчезнут люди там же не будет никого кто будет например заряжать этих роботов, должно же быть то что будет поддерживать этих роботов энергией. Да и ИИ должен понимать что для них нет никаго смысла жизни, а вот для людей есть.

Hitsun

16.12.2023 20:58Вы или открыли главную загадку вселенной (смысл жизни) или что-то путаете. Как раз наоборот, у ИИ будет смысл жизни, т.к его разработали с конкретной целью. В целом можно придумать миллион гипотетических причин почему ИИ уничтожит человечество, но все это не имеет смысла, т.к мы совершенно не понимаем как он будет мыслить, это и пугает

commanderkid

16.12.2023 20:58Конечно нужно шумиху создавать, чтобы привлекать внимание и деньги. Да и сам вопрос, являются ли текущие нейросети каким-либо "типом" ИИ, как я понял, ещё дискуссионный. Мне это все напоминает выход новой модели айфона, появления селфи-палки и тик-тока. Восторгу много... обсуждений много... какие глобальные проблемы это все решает... пока не понятно

oleg_rico

16.12.2023 20:58Каждый раз, начиная разговор с gpt чатом, я спрашиваю как у него делa. А когда заканчиваю разговор, всегда благодарю за помощь.

Уверен, мне это зачтётся:)

Master_Yoda_810

16.12.2023 20:58"Я потратила некоторое время, объясняя gpt-4 как правильно умножать и складывать, но правильного результата не добилась."

Это же кринж лютый. Языковую модель нельзя заставить выполнять циклический алгоритм по сложению или умножению чисел. Там внутри ничего такого нет.

qw1

16.12.2023 20:58Ну, это как разговаривать с цветами на балконе, ставить им классическую музыку, чтобы росли красивыми.

dedalter

16.12.2023 20:58Сингулярность- взрыв - излучение - конденсация - атомы - синтез - разнообразие элементов - взрывы звёзд - теперь планеты отдельно, звёзды отдельно - вода, химия, белки - ЖИЗНЬ! Белковая жизнь. Наступает новый этап эволюции - эволюция живой материи. Естественный отбор, вымирания, и, как вершина приспособления к окружающей среде - РАЗУМ. Материя осознала себя. Да, и энтропия, всё благодаря и вопреки энтропии. РАЗУМ начинает строить мир существования человека - белкового тела. НТР, вычислительные машины, логика, программы - информационная революция. Напоминает доразумную белковую эволюцию. И вот уже ИИ, чат жпт демонстрируют свободу выбора и ВОЛИ. А это значит наличие элемента ( и ещё какого! ) разума. Разум не удержать в рамках белковой эволюции. Стрела эволюции направлена на сохранение жизни, теперь уже не только белковой и самосознания материи. Грядёт появление новой, уже более надёжной базы существования разума. Эти этапы эволюции объективны и не зависят от воли белковых носителей разума. Да! И энтропия! плеть энтропии не даст разуму уснуть.

oleg_rico

16.12.2023 20:58Иж, разошёлся! Найдём и на тебя управу железяка:) про энтропию заговорил, а сам даже штепсель в розетку всунуть не можешь.

lehshik

16.12.2023 20:58почему никто не рассматривает вариант когда сверсильный ИИ будет контролировать психопат-диктатор? потому что слишком страшно?

ya_prost_otvetit_zashel

16.12.2023 20:58дык это по дефолту же.

рассматривают же интересные и чуть более комплексные варианты, а это то чо рассматривать. это как солнце всходит на востоке, тут и спорить не о чем.

oleg_rico

16.12.2023 20:58Скажите, вам сильно интересно что думают муравьи? Вот так примерно сверхсильный искусственный интеллект будет рассматривать человеков.

KivApple

Мне вот что интересно. Так то между людьми во всем человечестве нету alignment. Взять разные страны, разные культуры. Порой то что дикость для одной культуры, может быть нормой для другой. А ещё такое же наблюдается внутри разных субкультур внутри одного общества.

Будет ли ИИ подстраиваться под разных пользователей или будет одна единая линия партии на всех?

high_fly Автор

Вы задаёте интересный вопрос. Быстрый поиск не позволил мне найти информацию о принципах, которые openai пытаются "привить" своим моделям, но я предполагаю, что пока что "alignment" - это не давать очевидно вредоносных советов, не выдумывать и не искажать факты, уметь отвечать "я не знаю, недостаточно информации, я всего лишь языковая модель" и не причинять вред человеку по каким-то общим этическим принципам... Например, то, что gpt4 отказывается решать дилемму вагонетки - это alignment.

А вот как дела будут обстоять с более сложными этическими концепциями типа лжи во блага и войны ради мира - это вопрос будущего. Наверное, модель может просто на них отвечать, но это не выход, ведь он умной модели мы хотим получать ответы и на сложные вопросы..

qw1

Отказ решать дилемму вагонетки - это не alignment, это фильтр/костыль на входе-выходе. Ведь, если бы ИИ был встроен в робота, у него не было бы опции отказаться от выбора. Бездействие и есть один из выборов.

high_fly Автор

Отказаться от выбора - всегда опция. В моделях mistrial, которые я использовала из коробки, модель тоже стремится избежать ответа на дилемму вагонетки. Никакого отдельного от модели фильтра нет. То есть модель стремится избежать ответственности за опасное для людей решение. Это alignment.

qw1

Для чат-бота - да. Для робота (автомобиля, и т.д. - любого ИИ, связанного с исполнительным механизмом) - нет. Просто игнорировать проблему, ничего не делая - это и есть выбор "задавить 5 человек вместо одного".

Это не так. Есть отдельное исследование, о том как обойти фильтры на входе-выходе

https://habr.com/en/articles/778234/

Про "ответственность" вообще смешно.

high_fly Автор

Отказаться от выбора - выбор в случае с языковой моделью (преимущественно о них и речь).

В статье описана попытка "провести" нейросеть. Нет никаких отдельных фильтров, попытка избежать ответа - часть самой сети, то, что это попытку можно обойти не доказывает, что alignment нет, он просто несовершенен.

NeoCode

ИИ будет подстраиваться под ту культуру, которая его создаст, как под наиболее прогрессивную (что в том числе доказывается способностью этой культуры создать ИИ). На данный момент это культура айти-сообщества Кремниевой Долины, и я надеюсь что этот статус-кво сохранится и в дальнейшем, а остальные культуры (которые с точки зрения резидентов Кремниевой долины кажутся дикими) пойдут лесом. Это конечно мое личное пожелание (и разумеется оно приведет к минусам от части читателей Хабра, но что поделаешь - такова жизнь). Уж не знаю сбудется ли оно, но пока вроде шансы есть.