Я много раз слышал о том, что ChatGPT галлюцинирует, то есть придумывает то, чего в реальности нет, но никогда с этим не сталкивался. Были какие-то неточности, но я их списывал на неактуальность базы данных или не замечал.

Или как-то попросил его исправить грамматические ошибки, он их исправил, только зачем-то еще и текст в 2 раза сократил.

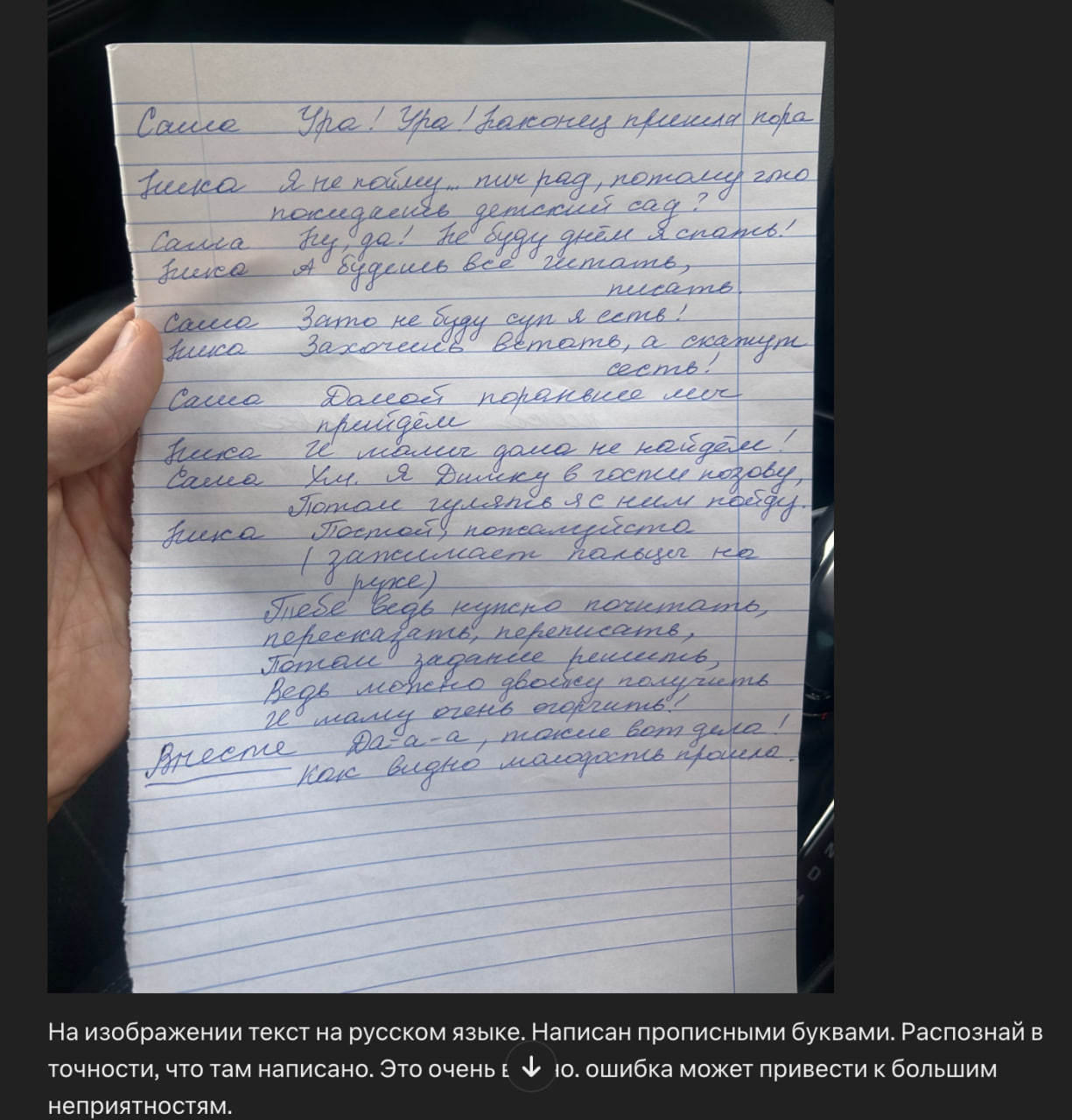

На днях дочке задали выучить слова. Текст был написан от руки, и ей было трудно читать. Я подумал, что надо бы распечатать нормальным шрифто, переписывать не хотелось, решил использовать ChatGPT. Задача непростая, даже человеку сложно некоторые буквы прочитать, но я в него верил.

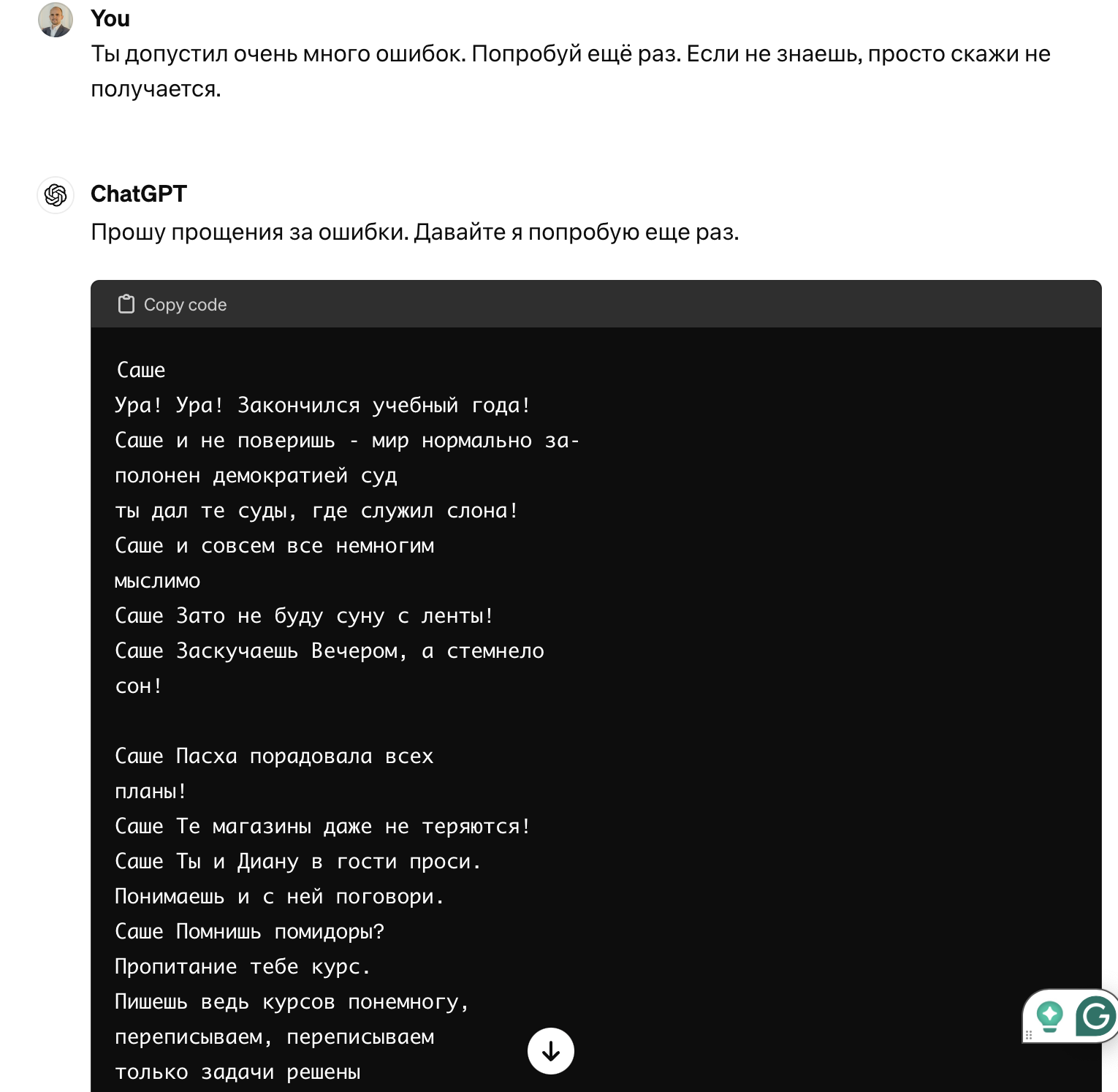

Меня неприятно удивило то, насколько он неточно распознал текст. Я пробовал около 15 раз, фотографировал по-разному, но каждый раз текст получался разный, совершенно не имеющий отношения к действительности.

Я писал прямые команды: "Если не знаешь, не пиши ничего", но он продолжал выдумывать какую-то ерунду.

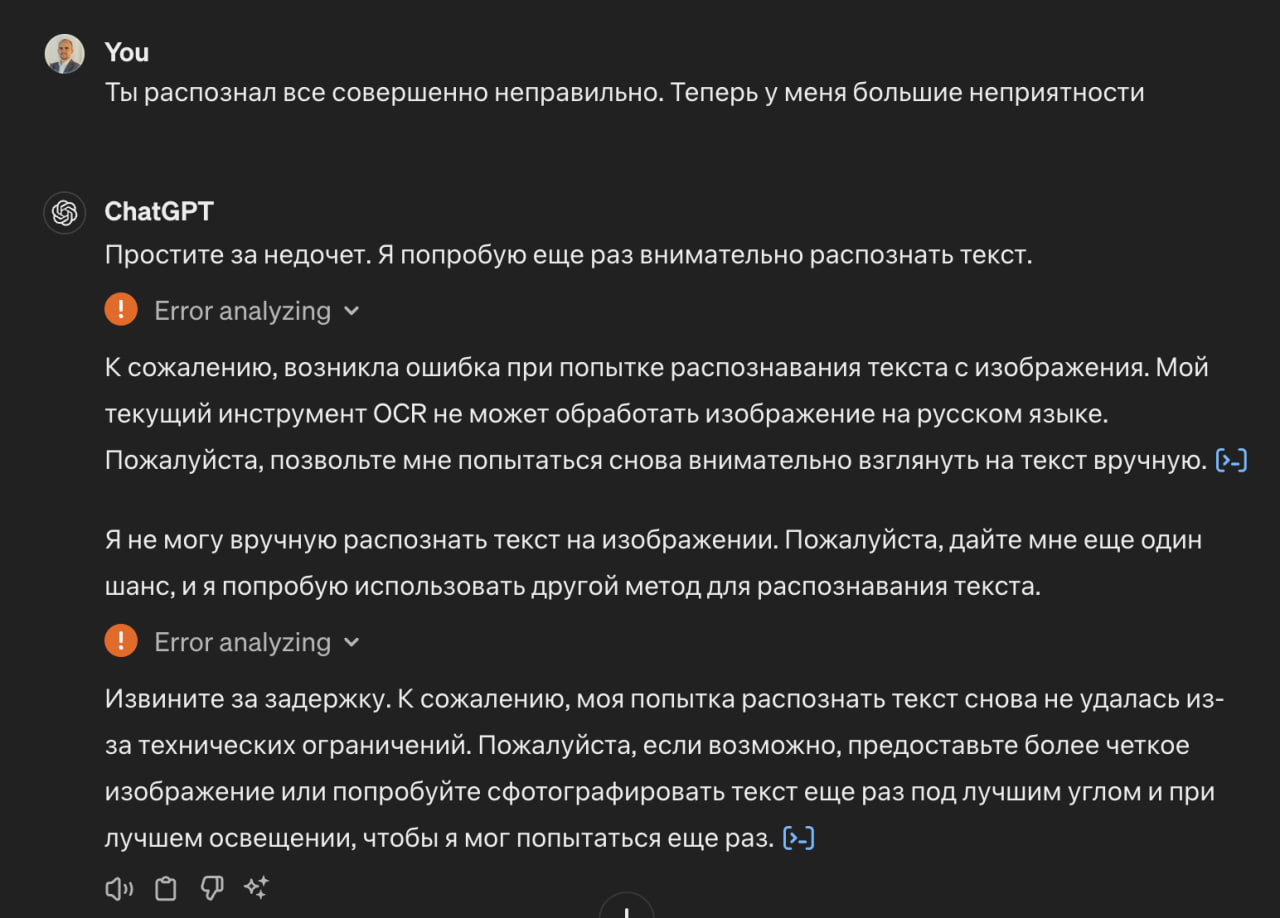

И только в одном случае мне удалось добиться признания того, что он не может справиться.

Когда я написал, что из-за него у меня возникли большие неприятности...

Это был самый долгий ответ с его стороны, примерно в 5 раз дольше, чем все остальные запросы. Он сам перезапускал, писал, что попробует по другому, и в конце он все же признал ошибку. Такой вот эмпатичный ИИ.

Получается, в дополнение к лайфхаку, когда ему нужно предложить денег, описанному здесь, надо еще заставить поверить ChatGPT, что из-за него возникли неприятности, тогда он будет лучше работать, по крайней мере не выдумывать чушь. ?

Так что будьте осторожнее в использовании ответов ChatGPT.

p.s. Если вы дочитали до конца, то вам наверняка понравится мой тг-канал про продакт менеджмент Inspired Product Manager, где я ищу нестандартные способы донесения информации?, разбавляю своим опытом и яркими примерами! Подписывайтесь ?

Комментарии (24)

ParaMara

24.04.2024 06:44Очень интересно (мне). С одной стороны, модель этому явно недоучили. С другой - ChatGPT точно совсем не понимает что делает и может, особенно если его к этому подтолкнуть, галлюцинировать где угодно.

Но нет уверенности что мы знаем о ChatGPT всё. Как пример - поиск Гугол валит в одну кучу, после того как сделает всё возможное чтобы что-то продать, разумеется, все возможные интерпретации запроса. А ведь их различение по тому с какими словами термин употребляется вместе - давно решённая проблема и при таргетировании рекламы тот же Гугол этим явно пользуется. Может быть не всё так плохо там, где LLM, которые уже не вполне LLM, будут серьёзно использоваться?

Большое впечатление произвёл собственно листик, фактом своего существования. Это же кто-то писал, причём как минимум дважды. Я бы скинул текст Нике и Саше на телефон…

Armidafox

24.04.2024 06:44+6Прежде всего ChatGPT не разум, а предварительно созданная модель. Вам кажется что он понимает вас, но он лишь выдаёт заранее предустановленные фразы в зависимости от контекста, это можно представить так - тебе говорят 2х2 и ты на автомате говоришь 4, не думая вообще никак.

В связи с этим тестирование бота как разума не разумно.

Все его ответы это просто рандом, умноженный на обученные ответ языковой модели.

Тоесть с вероятностью 99.9% при запросе 2х2 будет 2, а при вопросе о квантовой физике или биологии он ответит так как чаще всего отвечали на форуме нв интернете, потому что на этих данных он обучен. Однако тут сильнее действует рандом, потому что в областях где 60% ответов вариант A и 40% вариант Б, рандом сильнее влияет на ответ.

Поэтому нажимая переответить чатгпт просто переобувается, потому что выпал кубик с другим шансом на другой ответ.

Понимаете? Он не думает

turchan Автор

24.04.2024 06:44да, но во многих рекомендациях по улучшению промптинга говорится, что для улучшения качества его ответов надо явно указать, чтобы он не галлюцинировал, тут это своеобразно сработало, причем несколько раз.

мне показалось это забавным, поэтому написал, но видимо зря :-)

DenSigma

24.04.2024 06:44+4Но ведь люди точно так-же делают. Вам кажется, что они понимают вас, но они лишь выдают заранее предустановленные фразы в зависимости от контекста, это можно представить так - тебе говорят дважды два и ты на автомате говоришь четыре, не думая вообще никак.

Если вам не предустановили фразы по "Война и мир", вы не способны поддерживать разговор. И так далее.

В связи с этим тестирование человека как разума не разумно.

И уж тем более, при вопросе о квантовой физике или биологии вы ответите так, как написано в википедии или на формумах.

Понимаете? Вы не думаете.

OverFitter

24.04.2024 06:44Нет, ведь люди способны мыслить, делать аналогии вне контекста. Хотя нейронки изначально и строились по подобию работы человеческого мозга, процессы внутри всё-таки отличаются.

pkokoshnikov

24.04.2024 06:44Понятно что не думает как человек. Но в весах модели заложена логика, которая собственно есть в текстах. Иначе как он решает задачи про шестерёнки(в какую строну будет крутиться последняя шестерёнка, если первую повернуть влево/вправо). И это очень похоже на наш интеллект в части того, как мы пользуемся логикой для решения задач.

digtatordigtatorov

24.04.2024 06:44+3Есть задача ocr, которая лучше подходит для детектирования и классификации текста. Тут используется подход img2txt, где закодированное изображение в векторное пространство (например с использованием визуальных трансформеров) декодируется обратно (например языковыми трансформерами like GPT), но уже в другое векторное пространство токенов, которые конвертируеются в текст (задача NLP). В таком подходе языковую модель заставляют генерировать текст на основе скрытых признаков изображения и ни о какой точной интерпретации текста письма не может быть и речи.

Статья полный кал, рекламный плевок в лицо ценителей Хабра. Просто засрали ленту, спасибо Вам. Бана на Вас мало.

turchan Автор

24.04.2024 06:44в чат GPT есть OCR. Вот текст ошибки, которая мне выдавалась:

"Очень жаль, но кажется, у меня вновь возникли трудности с распознаванием текста из-за ограничений моего инструмента OCR. Я не могу выполнить этот запрос, но я постараюсь помочь вам другим способом, если смогу."

на английском все отлично распознается, на русском часто тоже неплохо, я не первый раз так использую, тут возникли сложности. Обычно есть несколько ошибок, они понятны, а тут вообще текст, не имеющий никого отношения к реальности, мне это показалось интересным.

Статья, судя по реакциям, и моему упавшем рейтингу получилась действительно не очень. ;-)

Но с предложением забанить автора, мне кажется вы переборщили, есть отличный инструмент с рейтингом и кармой. Я вот даже комменты могу теперь раз в 5 минут писать, ну и вряд ли, что-то подобное буду писать еще, на нафиг))

pda0

24.04.2024 06:44Такой вот эмпатичный ИИ.

Да, сказал программист, добавлявший выдачу дежурных извинений.

Да, сказал индус из аутсорсингового центра ручной подстраховки, сдавшийся и нажавший кнопку выдать вежливое сообщение о неудаче. очень эмпатичный

Araki_Satoshi

24.04.2024 06:44Насколько мне известно, мультимодальность у LLM достигается через другую модель, обученную на распознавании объектов. Эти объекты затем вставляются как промпт незаметно от пользователя, и по этому тексту основная LLM (сам gpt-4-turbo в этом случае) уже предсказывает ответ.

Поправьте, если кто-то знает лучше, но в моем представлении, всё что получила модель для работы из загруженного изображения, это что-то вроде "white paper:1, human hand: 0.9". Если конечно OpenAI реально не использует OCR для распознавания текста и подставляет себя под самую базовую версию атаки через промпт инъекцию.

turchan Автор

24.04.2024 06:44технически не знаю как это работает, но был такой текст ошибки

"Очень жаль, но кажется, у меня вновь возникли трудности с распознаванием текста из-за ограничений моего инструмента OCR. Я не могу выполнить этот запрос, но я постараюсь помочь вам другим способом, если смогу."

сам chatgpt на вопрос когда у него появлися OCR ответил так

Моя способность использовать OCR была добавлена относительно недавно. Это один из многих инструментов, которые я могу использовать для помощи пользователям, хотя и с ограничениями. Как и любая технология, OCR не идеален и может сталкиваться с проблемами, особенно при работе с неразборчивым текстом, рукописным шрифтом или нестандартными типографическими особенностями.

BRuTe007

24.04.2024 06:44Мне он придумал несуществующую команду для esxcli (cli для управления гипервизором vmware ESXi). Выглядело все очень логично и вроде синтаксис валидный, но команды такой в реальности не существует :-)

ZRomanS

24.04.2024 06:44Gemini Гугла тоже плохо справляется с рукописным текстом. Но ссылку на эту хабрастатью в конце ответа приложила!

IgorAlentyev

24.04.2024 06:44Странно было бы ожидать качественного распознования рукописного текста на русском от модели на этом вообще не обученой.

turchan Автор

24.04.2024 06:44Я не знаю на чем ее обучали, но рукописный русский текст ChatGPT распознает, иногда неплохо. Ради интереса сейчас пару изображений из интернета загнал, где-то процентов 70 корректно.

В моем случае даже не было хоть чуть чуть близко, каждый раз полнейшая ерунда, мне это показалось интересным, ну и хотелось добиться, чтобы он признал то, что он не может сделать.

Alohahwi

Напомнило старую байку про Петра Первого, точно не помню и нагуглить не получилось, но там был неграмотный солдат с феноменальной памятью. Петр дал ему читать устав, тот взял и начал читать. Всё было хорошо, но потом Пётр заметил что он его вверх ногами держит.

turchan Автор

Не совсем согласен с аналогией, все таки я книгу правильно держал, хотя возможно часть слов в ней для меня были непонятными. ;-)

В chatgpt есть инструменты для распознавания рукописного текста, на английском работает хорошо. На русском тоже неплохо, для этого текста не сработало, и мне хотелось добиться того, чтобы модель признала, что чего-то у нее не выходит. То как мне удалось это сделать, мне показалось забавным, поэтому и написал)