Часть 2 — Гермозона

Часть 3 — Переезд

Поехали

В 2015 году, в Украине была создана хостинг-компания с большими амбициями на будущее и фактическим отсутствием стартового капитала. Оборудование мы арендовали в Москве, у одного из известных провайдеров (и по знакомству), это и дало нам начало развития. Благодаря нашему опыту и отчасти везению, уже в первые месяцы мы набрали достаточно клиентов, чтобы купить собственное оборудование и обзавестись хорошими связями.

Мы долго выбирали оборудование, которое нам нужно для собственных целей, выбирали сначала по параметрам цена/качество, но к сожалению большинство известных брендов (hp, dell, supermicro, ibm) все очень неплохи по качеству и схожи по цене.

Тогда мы пошли другим путем, выбирали из того что есть в Украине в наличии в больших количествах (на случай поломок или замены) и выбрали HP. Супермикро (как нам казалось) очень неплохо конфигурируются, но к сожалению их цена в Украине превышала всякий адекватный смысл. Да и запчастей было не так много. Так мы и выбрали, то что выбрали.

Первое железо

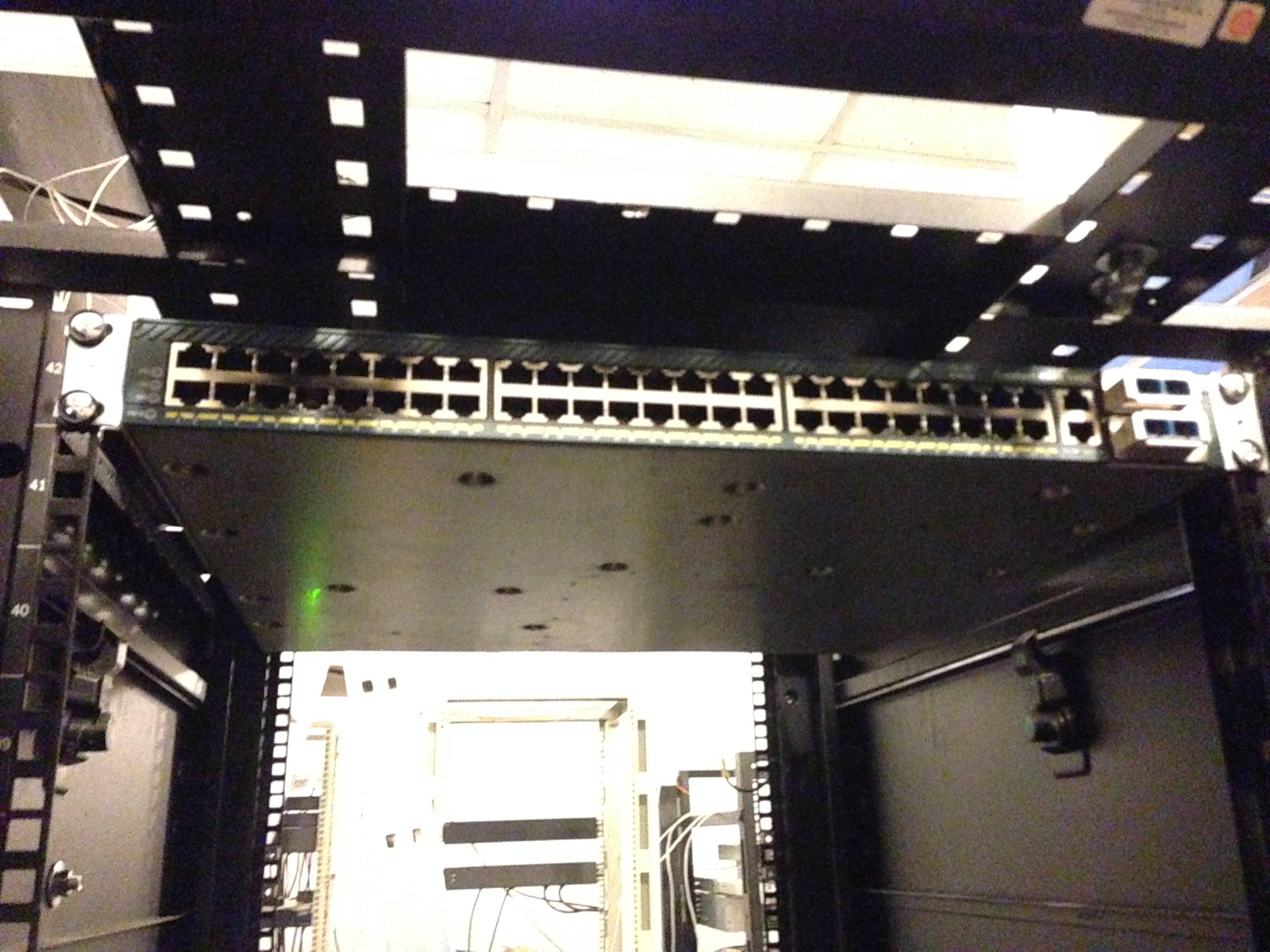

Мы арендовали шкаф в Днепропетровском дата-центре и приобрели Cisco 4948 10GE (на вырост) и первые три сервера HP Gen 6.

Выбор оборудования HP, впоследствии нам очень помог, за счет своего низкого энергопотребления. Ну а дальше, пошло-поехало. Приобрели управляемые розетки (PDU), они нам были важны для отсчета энергопотребления и управления серверами (авто-инсталл).

Уже потом мы поняли что взяли не те PDU которые управляются, а просто измерительные. Но благо HP имеет встроенное iLO (IPMI) и это нас спасло. Мы сделали всю автоматизацию системы при помощи IPMI (через DCI Manager). После был приобретен некоторый инструментарий для прокладки СКС и мы потихоньку начали строить нечто большее.

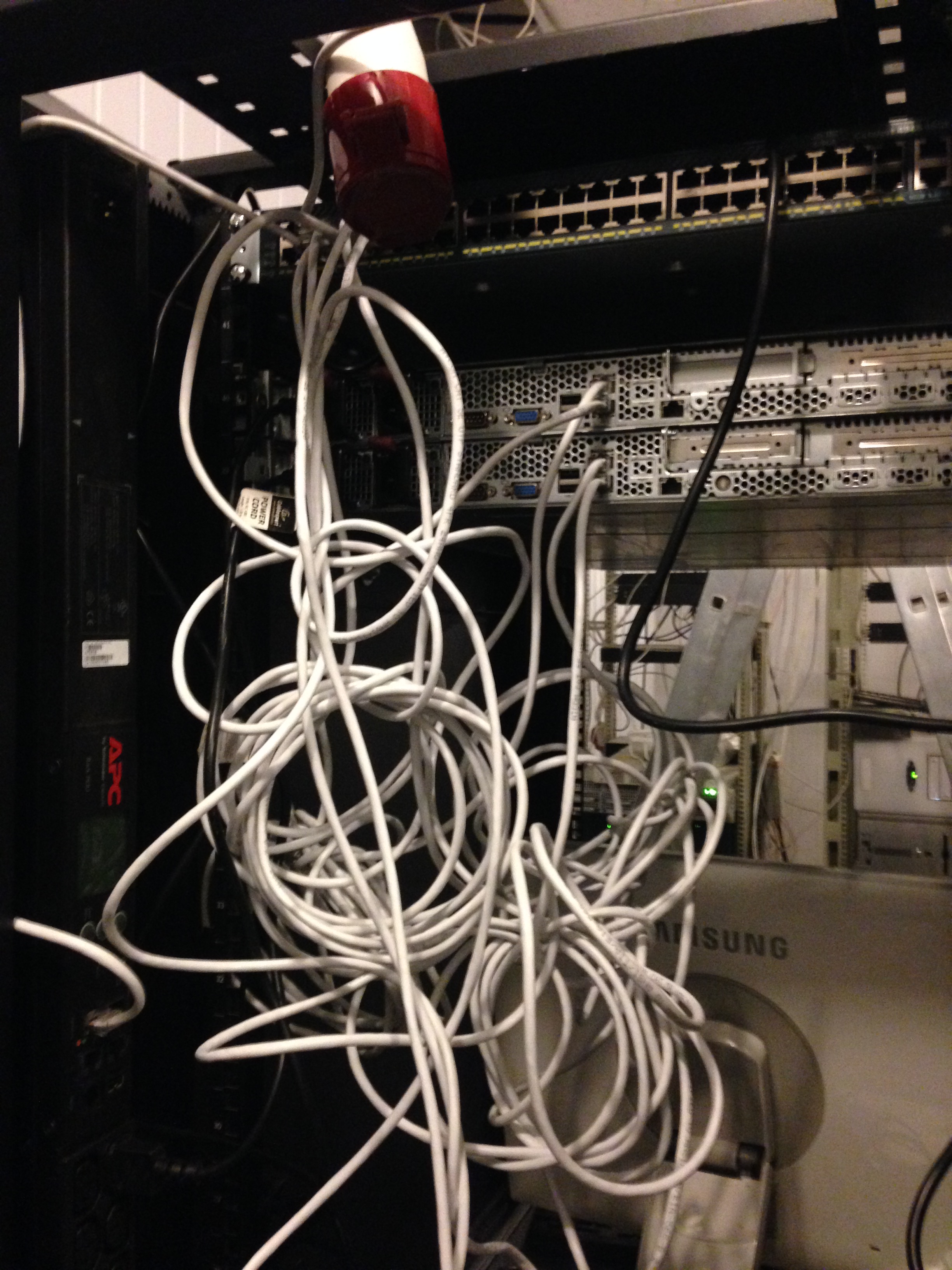

Здесь мы видим APC PDU (которые оказались не управляемыми), подключаем:

Вот так, кстати мы установили третий сервер и PDU (справа и слева). Сервер долго служил нам подставкой под монитор и клавиатуру с мышкой.

На имеющемся оборудовании мы организовали некий Cloud сервис при помощи VMmanager Cloud от компании ISP Systems. У нас было три сервера, один из которых был мастером, второй — файловым. Фактическое резервирование у нас было на случай падения одного из серверов (за исключением файлового). Мы понимали что 3 сервера для облака это мало, поэтому доп. оборудование уже было в пути. Благо «доставлять» в облако его можно было без проблем и особых настроек.

При падении одного из серверов (мастера, или второго резервного) — облако спокойно мигрировало туда и обратно без падений. Мы специально тестировали это перед вводом в продакшн. Файловый сервер у нас был организован на неплохих дисках в аппаратном RAID10 (для скорости и отказоустойчивости).

На тот момент у нас было несколько нод в России на арендованном оборудовании, которые мы бережно начали переносить на наш новый Cloud сервис. Очень много негатива было высказано поддержке компании ISP Systems, т.к. адекватной миграции из VMmanager KVM в VMmanager Cloud сделано ими не было, а по итогу нам вообще сказали что этого и не должно быть. Переносили ручками, долго и кропотливо. Разумеется перенесли лишь тех кто согласился на акционное размещение и перенос.

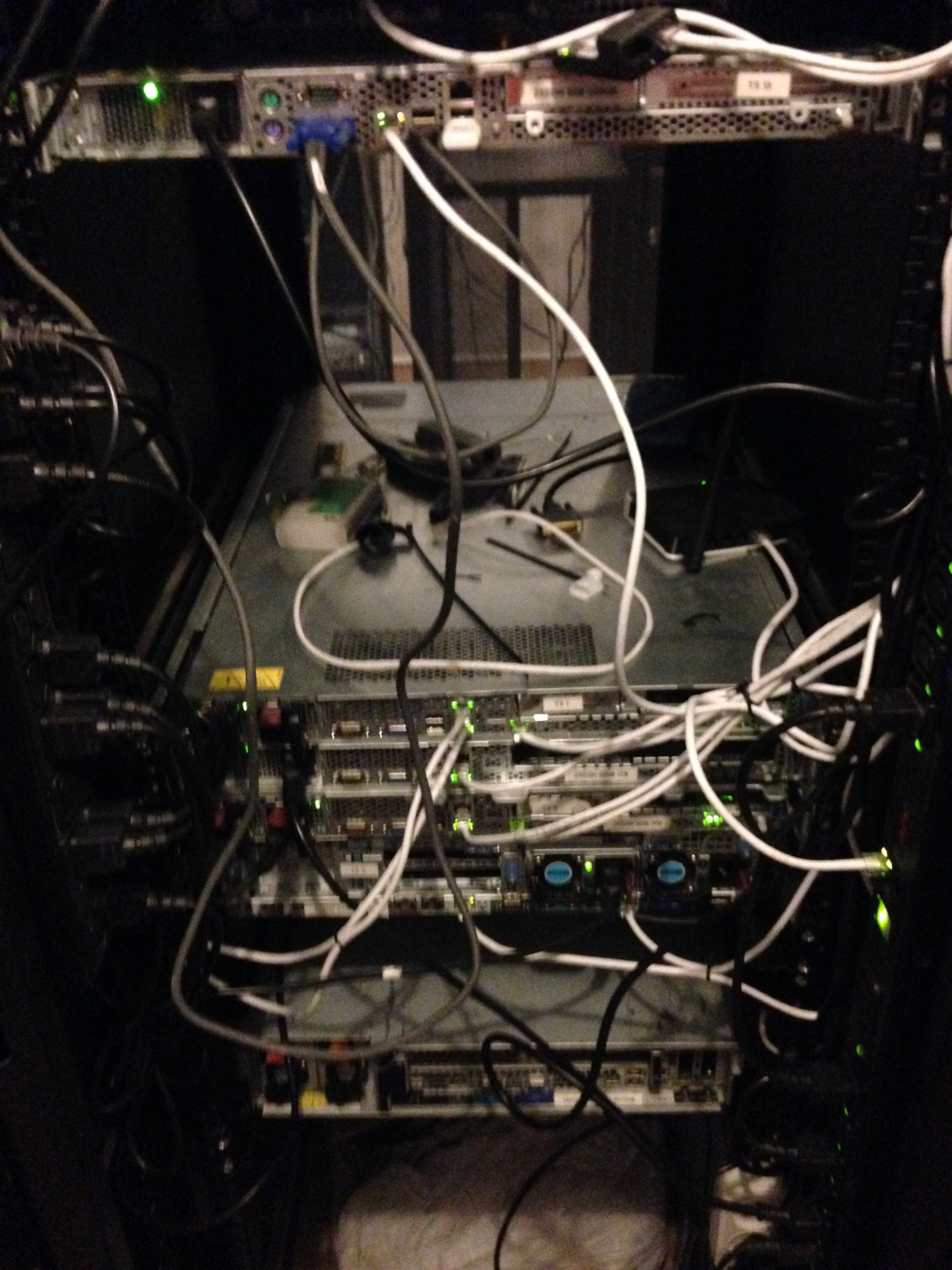

Примерно так мы работали еще около месяца, пока не заполнили оборудованием пол шкафа.

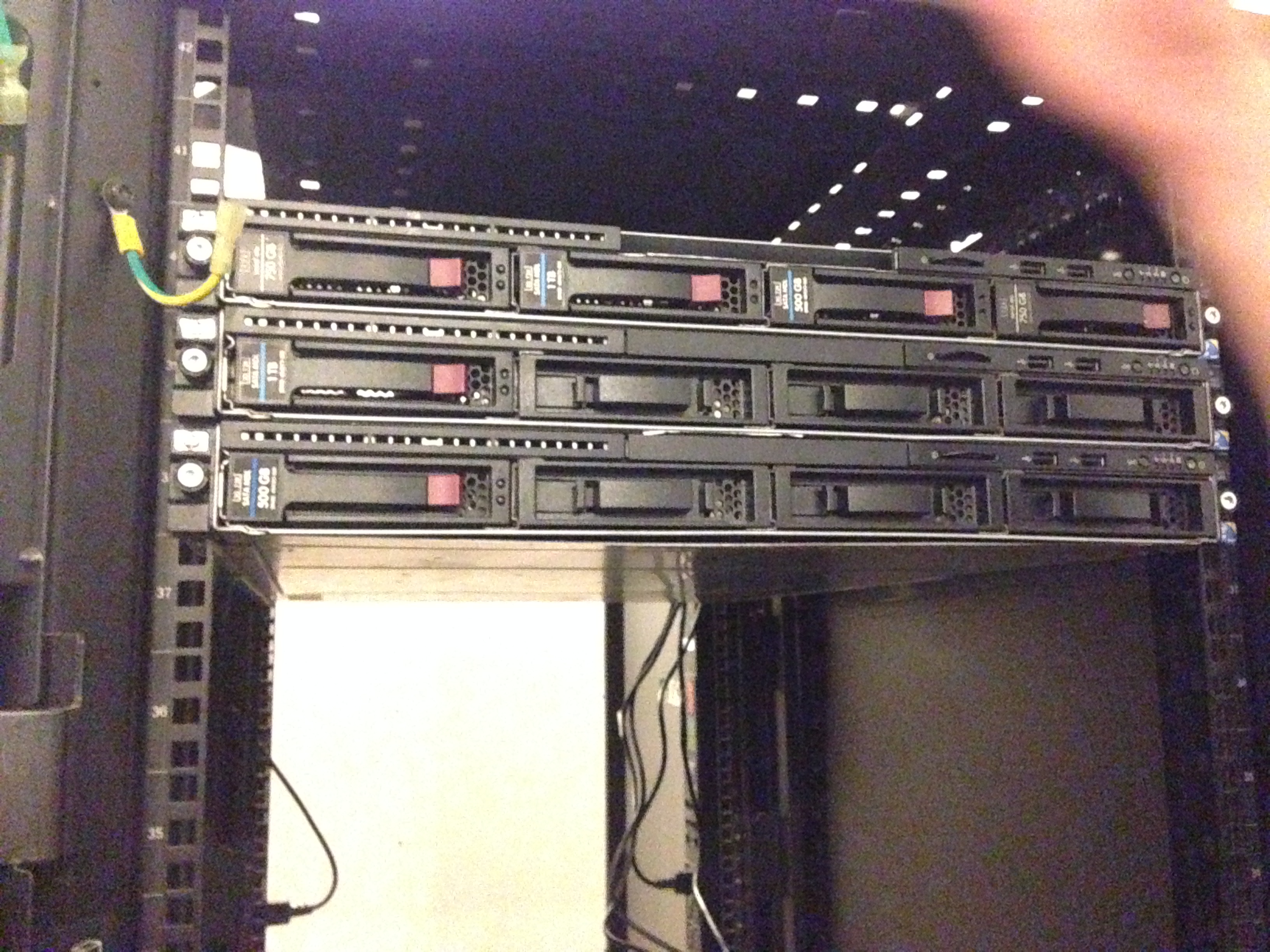

Так мы встречали вторую партию нашего оборудования, опять же HP (не реклама). Просто лучше иметь серверы которые взаимо-заменяемы, чем наоборот.

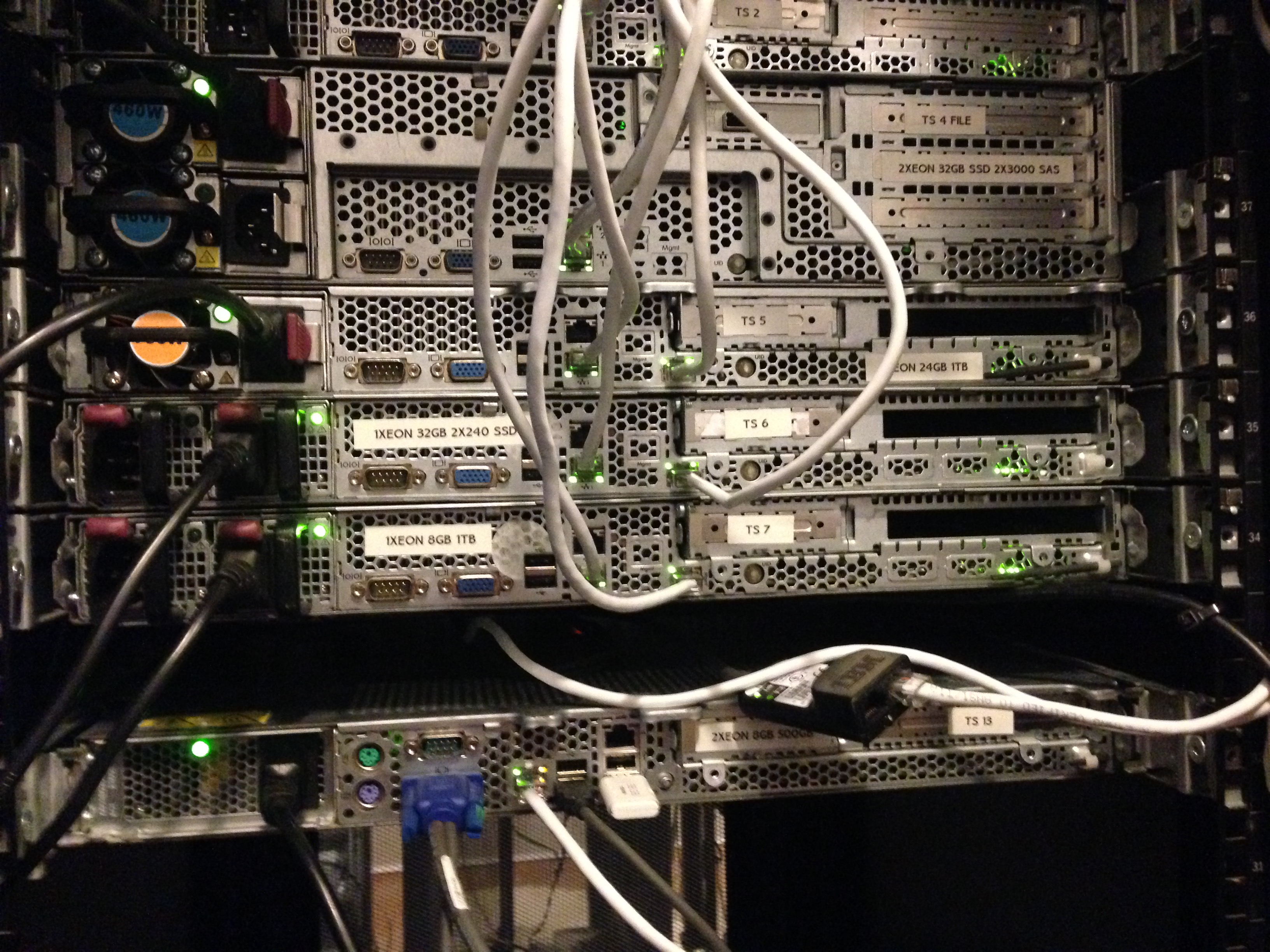

Исходя из того, что ни у кого из нас нет огромного опыта прокладки СКС (кроме администраторов, которые как обычно не там где нужно) — приходилось учиться всему на лету. Так у нас лежали провода первое время (около дня) когда мы устанавливали серверы.

Примерно так — стало уже после установки всего пришедшего оборудования и прокладки.

По мере роста компании мы все чаще сталкивались с определенными трудностями. Были и проблемы с оборудованием (отсутствие в быстром доступе кабелей SAS-SATA), его подключением, разными тонкостями и с DDoS атаками на нас (прилетали и такие что клали весь ЦОД). Но одна из главных, по нашему мнению — нестабильность ЦОДа в котором мы арендовали шкаф под оборудование. Мы и сами то были, не сильно стабильны, но когда падает и цод в котором ты размещаешься — это совсем плохо.

Исходя из того что ЦОД находился в старом полу-заброшенном здании производственного комплекса — работал он соответственно. И несмотря на то, что его владелец прикладывал все усилия чтобы он работал стабильно (а это истинная правда, Александр действительно молодец и во многом нам помог по началу) — отключали то свет, то интернет. Наверное это нас и спасло. Это стало причиной, которая побудила нас (без имеющихся на то финансов) приступить к поиску помещения для собственного дата-центра и организовать переезд в него менее чем за 14 дней (с учетом подготовки помещения, протяжки оптики и всего прочего) Но об этом, уже в следующей части нашего рассказа. О спешном переезде, поиске помещения и строительстве мини-цода в котором мы сейчас и обитаем.

Как мы строили свой мини ЦОД. Часть 2 — Гермозона

P.S. В следующей части много интересного. От сложностей с переездом, ремонтом, протяжкой оптики по жилым кварталам, установкой автоматики, подключением ИБП и ДГУ и т.п.

Комментарии (52)

Prous

11.10.2016 17:45Да, рентабельность у проекта должна быть! Посмотрел сколько стоят эти управляемые розетки. Сразу понял, что в текущей экономической ситуации к шефу со счётом на эти розетки лучше не подходить. Может на досуге заняться на малинке самому собрать, по цене наверное будет всего процентов 10%.

TakeWYN

11.10.2016 17:50Мы просчитывали сбор розеток самостоятельно. Самая затратная часть для нас вышла это п.о. Его написать не дешево, а потом еще и интегрировать через API — еще сложнее. В штате нет разработчиков п.о. Пришлось брать дорогие, но готовые.

Prous

11.10.2016 18:54Возможно в Вашем случае надо писать сложную софтовую обвязку. В моём случае достаточно немного изменить готовые уже написанные решения (например для дистанционного кормления рыбок)

TakeWYN

11.10.2016 19:06Тогда я думаю можно заморочить себя собранием собственной пду, выйдет дешевле однозначно.

KorP

12.10.2016 10:11В 2015 году

сервера HP Gen 6

б/у что ли закупились и на них работаете?

я, как обладатель домашней стойки с такими же серверами сейчас поулыбался :) правда у меня ещё и san есть с схд и лентой :)

TakeWYN

12.10.2016 11:03+3Серверы HP G6, с конфигурацией, к примеру 2x X5670 (6 ядер 12 потоков в каждом процессоре) 3.33 GHz в бусте, до 288 GB RAM DDR3 мы считаем вполне современным решением. Дисковый массив естественно весь новый.

Платить на старте в 10 раз больше за серверы G8 с процессорами E3/E5 которые зачастую уступают по производительности — смысла не видим абсолютно.

Если не правы — готовы обсудить и принять Вашу позицию :)

KorP

12.10.2016 11:06Вопрос не только в быстродействии, но и в поддержке, особенно учитывая что разговор идёт о 3 нодах

массив естественно весь новый

ну про него вы ни слова не сказали и фоток его нет

TakeWYN

12.10.2016 11:09+2В Украине ожидать чьей то поддержки — губительно для себя. Это мы на личном опыте с Canon испытали. А диски, ставить б.у. себе дороже, по итогу. Постараемся в следующей статье более подробно уделять время деталям.

KorP

12.10.2016 11:17Да я на самом деле вообще не понимаю как вы там живёте… бизнес новый начинаете, или когда анонсы IT-конференций тут на хабре публикуют… ощущение что есть 2 Украины

TakeWYN

12.10.2016 11:27+2Мы из Днепра, а большинство представителей крупных компаний в Киеве. Я уже упоминал Canon, как я приобрел у них машинку (для полиграфии) за 7 тыс. долларов по старому курсу и она пришла в разобранном виде… а никто из представителей в Киеве в Днепр ехать не хотел её собирать. Соберешь сам — гарантии нет. В Днепре представители приехали, посмотрели, сказали мы такое не делаем и уехали. Везти в Киев чтобы собрали и потом обратно собранную? Не вариант. Так и собирали сами.

Я думаю HP это не касается, но такой вот, неприятный опыт был. Посему в поддержку по всему миру я верю скудно.

KorP

12.10.2016 11:35Ну всё-таки сервер это менее специфичная железка, нежели машинка для полиграфии, да и серверы в разобранном виде не приходят, а саппорт в данном случае больше сводится к оперативной доставке запасной части, взамен вышедшей из строя. Но конечно вам там виднее какой из вариантов лучше — иметь ЗИП или саппорт

TakeWYN

12.10.2016 11:44У нас есть очень хороший поставщик по оборудованию которое мы используем, в Украине. Поэтому собственно оперативная доставка обеспечивается за счет него. Кстати за год использования оборудования от HP у нас ничего не выходило еще из строя. (тьфу тьфу). А вот десктопное железо — да, уже дважды ломалось.

navion

14.10.2016 16:41да и серверы в разобранном виде не приходят

Если бы… Базовые модели собраны, а остальные опции без заказа сборки (CTO) привезут в виде горы коробок.

heleo

12.10.2016 12:56А монитором и я так понимаю отдельно KVM, сразу взять готовое решение в стойку не решились по каким причинам?

TakeWYN

12.10.2016 13:00Сложно было предусмотреть все сразу. Монитор был временной мерой пока мы «разбирались» и настраивали все. Без него тот же KVM тоже не настроить. В следующей части расскажем и о KVM и о сопутствующих ему проблемах.

Chromex

12.10.2016 13:47Я думаю, что heleo спрашивает почему не взяли KVM-консоль .

DaemonGloom

12.10.2016 15:00+1Не всегда есть смысл тратить 100 тысяч на решение, которое нужно короткое время. А старые монитор/клавиатура/мышь есть всегда под рукой. Далее всё равно всё управляется через iLo, который есть в сервере.

avlag

12.10.2016 15:16Цитата:

«Но благо HP имеет встроенное iLO (IPMI) и это нас спасло.»

iLO на серверах HP отлично выполняет функции KVM-консоли.

PartisanBLR

12.10.2016 18:56Это же дешевые Gen6…

Тамошний ILo 2 не то чтобы выполнял функции KVM консоли, не говоря уже про отлично отлично. А если еще вспомнить про лицензирование.

TakeWYN

12.10.2016 18:57+1Уже был вопрос про дешевое железо. Выполняет функции KVM лучше любого KVMа, это из собственного опыта. Не знаю работали ли Вы с iLO или нет, но оно нас полностью устраивает. Возможно Вы путаете с совмещенным iLO на дешевых серверах, там да, адские мучения. А отдельный managment iLO удобная штука, с выделенным портом.

avlag

13.10.2016 07:58Для общения с консолью хватает даже iLO100.

Не знаю какие задачи для консоли есть у вас, но мне она нужна на этапе установки системы. Или посмотреть на консоль в случае отпадания сервера по обычным каналам и переобуть его. Для всего остального есть средства операционной системы.

Единственная проблема, которая подкрадывается потихоньку, так это блокирование Java в броузерах.

А лицензирование сразу перестанет казаться дорогим, как только придет понимание стоимости комплекта KVM под пару-тройку стоек, забитых одноюнитовыми серверами. А если потребуется KVM по сетке, чтобы не бегать к консоли в серверную, то iLO вообще становится вне конкуренции.

Sane4i4ek

12.10.2016 15:19Интересно, а сколько стоит оптоволокном широкий канал в ЦОД получить?

Какие у вас там скорости и за какие деньги дают?

TakeWYN

12.10.2016 15:29Выходит достаточно дорого. Все предлагают в районе 1$ мегабит. т.е. 2 канала по 1000 мегабит = 2 000$. Дорого, но как есть. Ну правда тут еще торговаться нужно, некоторые спускаются, некоторые нет.

RicheeRich

13.10.2016 17:24Цена гигабитного порта в серьезных ЦОД-ах Украины варьируется от 120 до 300 USD.

Место (2U) в стойке (в готовой инфраструктуре за которую болит голова у операторов) от 35 до 70 USD.

К чему такие потуги, не объяснимо. Хотя, вероятно, это вам нравится :)

TakeWYN

13.10.2016 17:26Гигабитный порт и гарантированный гигабит абсолютно разные вещи. Никто из дата-центров не может сдать дешевле чем продает оператор. Тот же ЕвроТрансТелеком не сделает за гигабит такую цену даже при большом опте.

Место 2U 35-70$? Скажу что дешевле, но даже это ОЧЕНЬ дорого в рамках 48U + железа.

miha2

13.10.2016 09:07+1Вот не хватает на хабре таких легко написанных статей. Продолжайте в том же духе. И успехов вашему проекту!

Собрать решение, — это одно. А запустить его в работу и найти клиентов — это уже другое.

Вы похоже и маркетинг и продажники и технари — всё в одном лице.

TakeWYN

13.10.2016 10:21Спасибо большое, это очень приятно. Признаюсь — статью я писал в своей жизни в первый раз и действительно старался сделать её как занимательный рассказ о пережитом, с кусочками полезной информации и казусов. Сегодня будет вторая часть, о поиске и «постройке» самого ЦОДа.

Softer

13.10.2016 14:02Весьма интересная тема для меня. Особенно с учетом Днепра :)

Если не секрет — что за ДЦ был на 2-м этапе (аренда стойки)?

TakeWYN

13.10.2016 14:03Учитывая наши статьи, не очень бы хотелось делать кому-то рекламу или антирекламу. В Днепре дата-центров не много, хватит пальцев одной руки (те которые сдают в аренду места). Я думаю Вы найдете верный ответ)

VioletGiraffe

Это какая же рентабельность у хостинга, что за год можно накупить столько серьёзного оборудования? Или вы зарплату не платили, на всём экономили, чтобы всё вложить в развитие?

TakeWYN

Будем говорить честно, лично я зарплату не получаю до сих пор, хотя я со-основатель проекта. И здесь вопрос не в отсутствии средств, а в желании ре-инвестировать заработанное. Как из ничего, вырастить нечто большее.

В следующей статье я постараюсь раскрыть информацию по рентабельности и само собой по «стройке», переезду, массе негативных моментов которые приключились во время и после переезда. Все было спонтанно, никто не был готов, все делалось «на вчера».

Loxmatiymamont

А кушаете вы на что, если зарплату не получаете?

Dolbe

Можно подумать, что все, особенно IT-шники, живут на одну зарплату?

TakeWYN

Идеей питаемся :) На самом деле это не единственный источник дохода и чтобы бизнес приносил в последствии прибыль — лучше ре-инвестировать заработанные средства.