В продолжение Части 1 — Colocation

В продолжение Части 2 — Гермозона

Здравствуйте! Судя по отзывам, письмам и комментариям к прошлым двум частям нашей статьи — Вам понравилось, а это главное. Напоминаю, постройкой собственного мини-ЦОДа мы обязаны именно «жителям» Хабра, именно Вы помогли нам с реализацией наших идей — своими статьями. Поэтому данный цикл статей благодарность пользователям и комментаторам, из идей которых мы и «черпали» вдохновение.

Сразу хочу сказать. Мы не претендуем на сертификацию по классу TIER (мы попросту не можем), мы не говорим что сделали нечто новое или идеальное, мы повествуем лишь о том, что у нас получилось, за короткий срок в менее чем 14 дней с нашими потребностями и возможностями. Отнеситесь к данной статье как к «наглядной пище для мозгов», это не идеал, это лишь опыт одного проекта, который возможно поможет Вам избежать ошибок в своем бизнесе. У нас их было допущено не мало.

Итак, начнем. У нас оставалось буквально пару дней до физического переезда всего оборудования, в нашем мини дата-центре было готово практически все, кроме основного — интернет-каналов. Мы спешно договорились о подключении двух независимых провайдеров, но как мы и писали раньше — они ставили нереальные для нас сроки, вплоть до 6 месяцев. Так вышло что мы выбрали место дислокации рядом с группой провайдеров и усложняло протяжку лишь согласование с владельцами колодцев/опор.

Поговорив с техническим директором первого провайдера, мы все-же убедили его сделать «быстро» и подать линк в кратчайшие сроки. Бригада выехала и буквально на следующий день подписания договора протянула нам оптику (тянуть им было, к слову, метров 100). Весь процесс фотографировать я не мог, ездил между дата-центами, решал сопутствующие вопросы.

Второй же провайдер имел центральный офис в Киеве и это связывало нас по рукам и ногам. Извините за подробности, но они без центрального офиса даже «чихнуть» не могут, не то что протянуть кабель. Нам был озвучен окончательный срок в 11 месяцев и мы окончательно оцепенели. Поговорив с провайдером, менеджер подсказал выход из ситуации. А именно — подрядчики. Они могут протянуть быстро и качественно без дополнительных бумаг (т.к. у них разрешения уже есть). Связались с ними.

В отличии от первого провайдера (канализация), они предложили протянуть по «воздушке». В целом — нам все равно, это резервный канал и мы на него особо не рассчитывали, но все-же его отсутствие не давало нам возможности старта, т.к. все должно быть «по уму». Заплатили, договорились — пошла работа. Сначала предлагали тянуть через дома, потом через столбы, потом через то и другое, в итоге из-за создания ОСМД вынужденны были делать только через столбы (на крыши не попасть и не согласовать), по кронам деревьев, прыгая с ветки на ветку. Действительно, эту протяжку нужно было видеть, ребята рисковали жизнью буквально каждую секунду, прокидывая кабель через дерево, залезая на него без страховок и прыгая при этом на соседнее. Нужно отдать должное, ребята — профессионалы.

И вот казалось бы все, оптика проложена, по первому провайдеру есть линк, по второму они еще утверждают и ждут людей на «базовую станцию» чтобы включиться там, заявили что это вопрос 1-2 дней. Мы в целом довольны и думаем о переезде.

День переезда

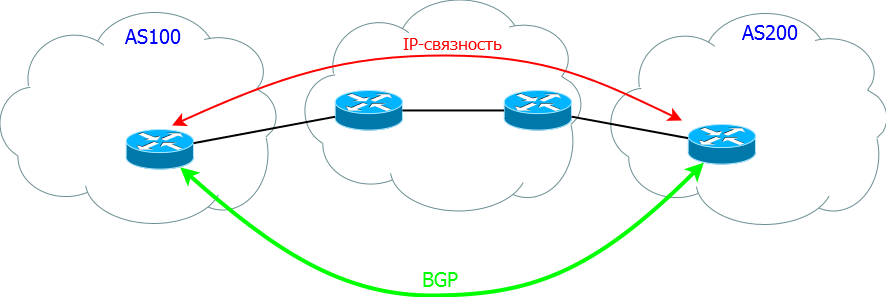

Наверное самое сложно для нас — это было продумать как с минимальным даунтаймом переехать. Так вышло что переезжали мы в пятницу. Одна из самых сложных вещей это поднять BGP тунель. Постараюсь пояснить что это такое на пальцах. BGP — Border Gateway Protocol, протокол по которому один провайдер со своей AS (автономной сети) обменивается информацией с другим провайдером и с его AS (автономной сетью). Грубо говоря это стык, который позволяет передавать трафик от одного провайдера другому и так по цепочке.

Сложность в данной ситуации возникла в том, что у нас на тот момент была одна AS на которую были привязаны наши IP. Чтобы сменить данные с одного провайдера на другого — нужно для начала перенастроить основной маршрутизатор (нашу Cisco), а потом еще и внести изменения в RIPE и у провайдера. Таким образом сделать это до переезда — нельзя, сляжет все. А делать во время — есть риски большого даунтайма. Исходя из того, что мы переезжали планово — мы предупредили всех пользователей заранее рассылкой, в твиттере и на форумах. Поэтому мы решили менять настройки уже после переезда. Но об этом немного позднее.

Итак, мы начали отключать оборудование. Вытаскиваем железки.

Протираем от пыли.

Учитывая что заезжали мы туда с тремя серверами и добавляли их понемногу (нося на руках на 5-6 этаж) — мы не знали на сколько не просто будет это все отключать и носить, т.к. серверов на момент переезда уже было 14 штук, плюс IP-KVM IBM. Но благо мы прихватили с собой ребят в помощь и еще одну машинку (т.к. в мой легковой автомобиль все бы не влезло).

Несколько раз побегав между этажами, мы поняли что на руках мы это все не спустим, и попросили включить грузовой лифт (чтобы его включить нужно искать владельца здания, брать ключи, договариваться и т.п.), в общем это был как раз тот случай когда это было нужно. Спасибо за это ребятам.

Хлама накопилось не мало, 14 серверов, 1 клиентский, PDU розетки, диски и прочее барахлишко для укладки СКС. Грузимся и в путь.

Ехать не так далеко, около 5-8 КМ, поэтому едем не спеша, аккуратно. В нашем новом мини-цоде нас уже ждут коллеги для разгрузки и подключения. Приехали, разгрузили железо на стол.

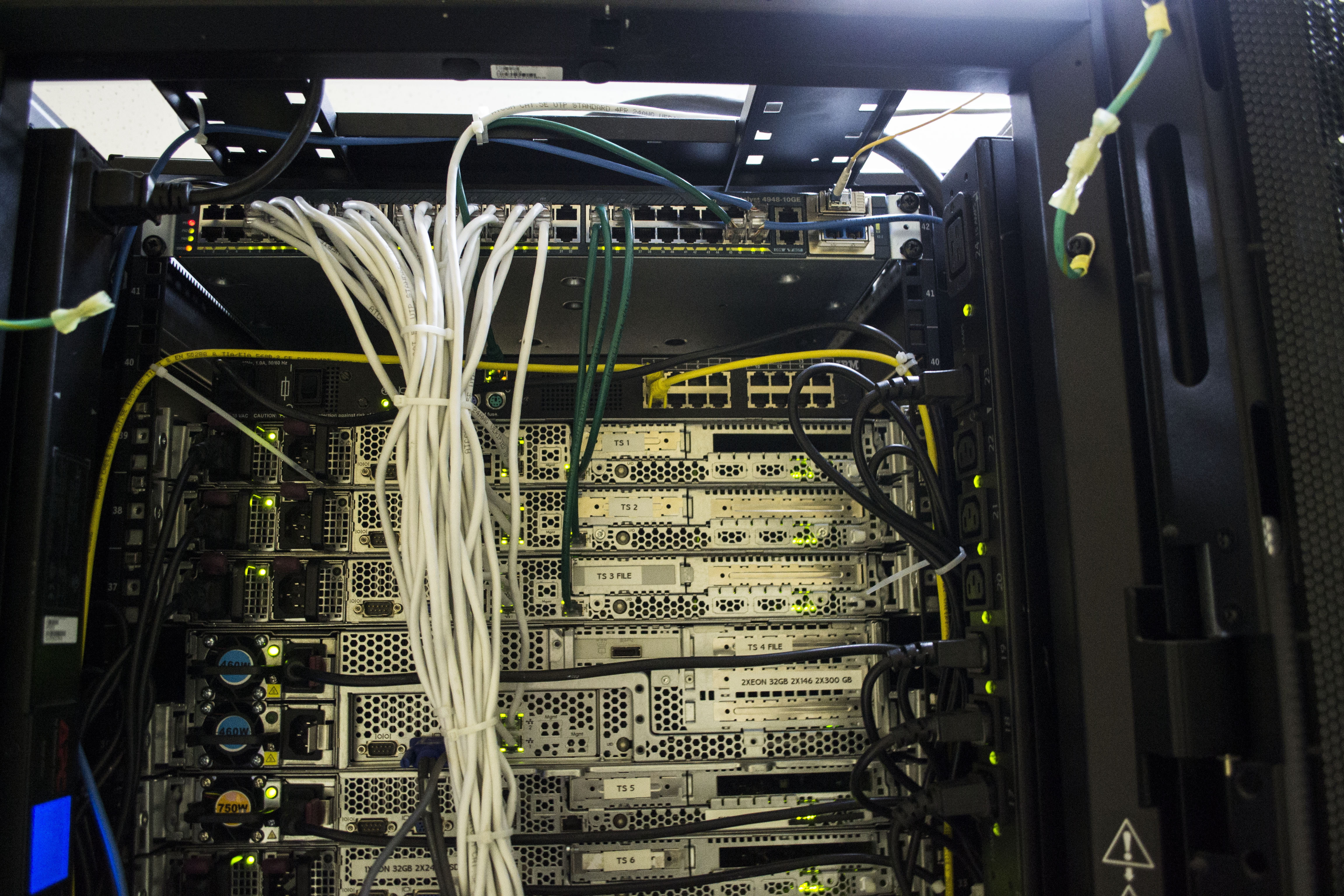

Начали заниматься установкой сетевого оборудования, его подключением, протяжкой и укладкой кабелей. Для этого дела так-же прикупили хомутики. С ними очень удобно.

Монтируем APC PDU (благо одну именно управляемую мы уже прикупили).

Начинаем наполнять шкаф.

Вставили железки, циску, пока тестово кинули кабель только к циске.

Приступили к настройке циски. Это были еще те извращения.Монитор на полу, системник на стуле, все в «подвешенном» состоянии. Да, бывает и такое :)

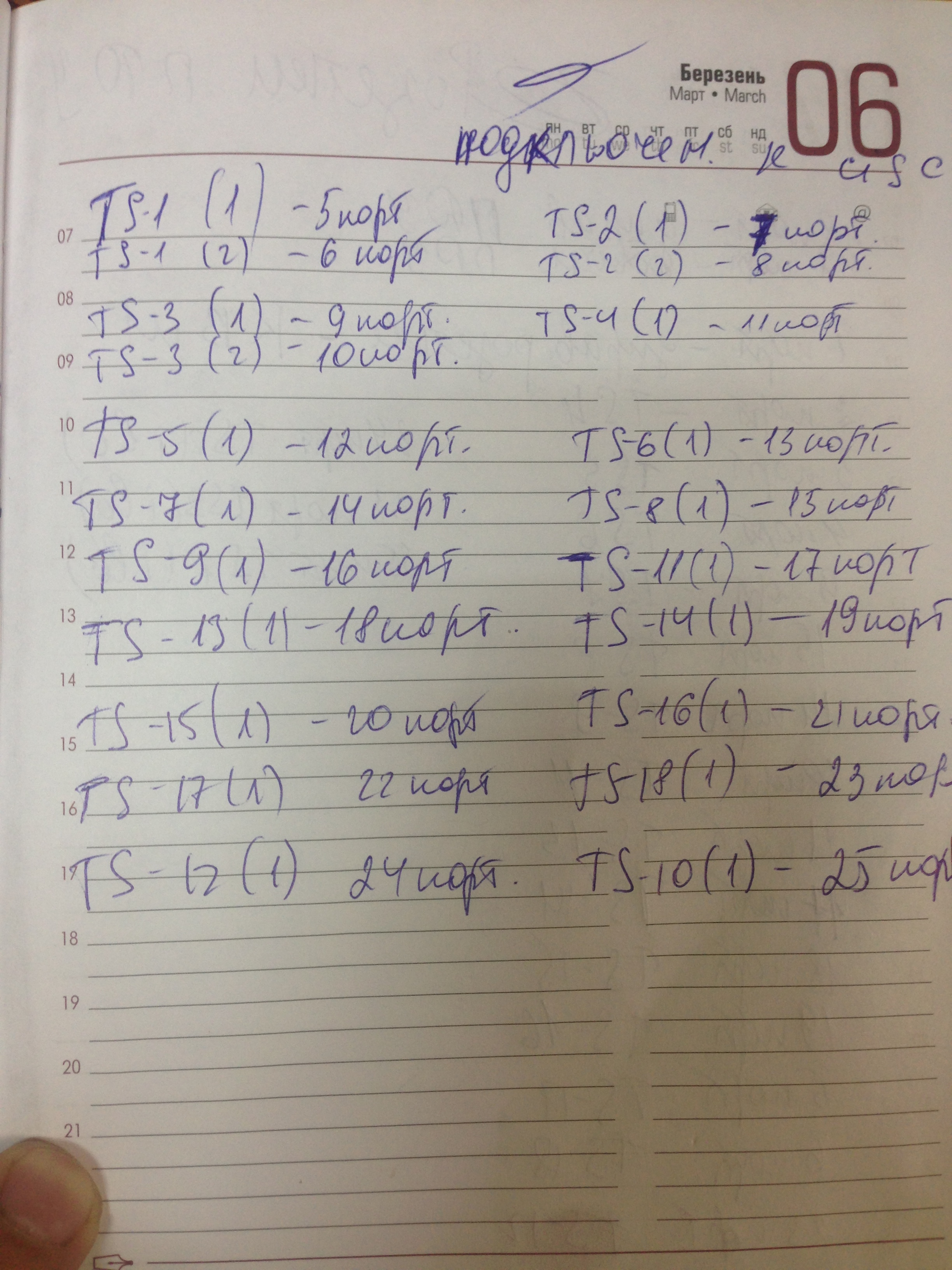

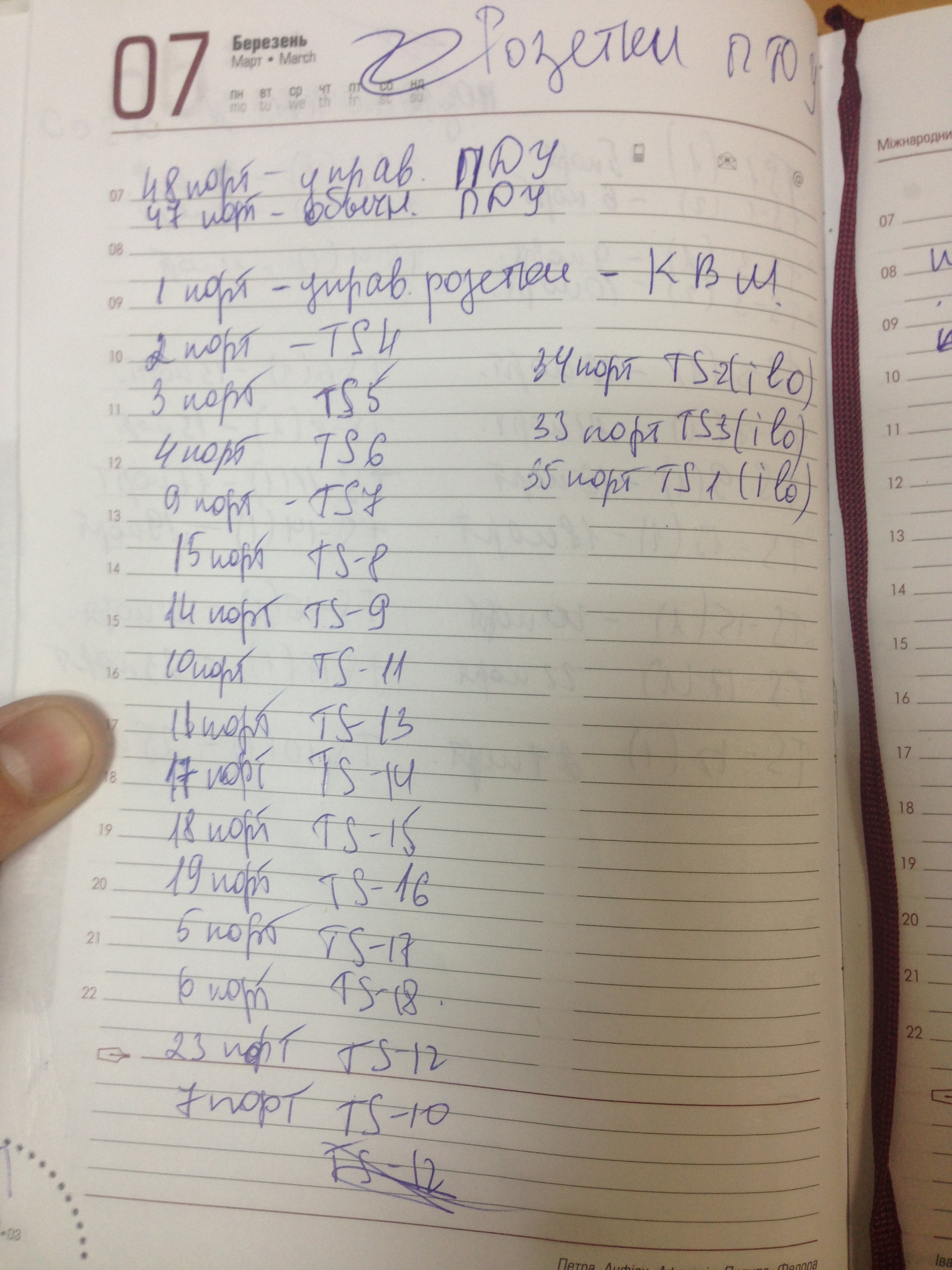

Пока настраивали циску, начали перепись оборудования, портов Cisco и портов APC PDU. Это очень важный момент, нам это потом помогло не раз.

Уже вечерело, часа 4, может половина пятого… казалось бы основная работа сделана.., но если бы мы знали как ошибались… Приступили к поднятию BGP туннеля (заранее получили настройки) — а фиг… Линк есть, а работать он не хочет. Проблема выявилась быстро и получилась из-за нашей неопытности. Нам подключили гигабитный линк через оптоволокно. Наша Cisco поддерживает 2x10GB. Мы смело вставили оптику в неё (собственно это мой косяк, не посоветовался с админами нашими, они еще долго меня ругали) — и ничего. Оказалось что если порт гигабитный, а модуль у нас 10 гигабитный он работать не будет. Начали срочно вызванивать провайдера, с просьбами о помощи, как и что делать… но тут оказалось что все ушли домой (пятница, перед 3-мя выходными и праздником)… и мы стали в ступор.

Был вариант подключить все через медиаконвертер (как мы и сделали в перспективе), входит оптика — выходит витая пара, но его у нас не было, а магазины были все закрыты, и работать начнут лишь через 3 дня. Пришлось через знакомых вызванивать тех. директора компании, срывать его сотрудника из дому, чтобы он в офисе взял модуль 10G для их узла и подключил. И только тогда, наша циска начала воспринимать линк адекватно и все заработало (стык).

Мы закончили все работы и стали ждать… когда обновятся записи, маршруты и все заработает. Уже было 8 вечера, все уставшие, одному парню даже скорую вызывали, один из наших поцарапал руку, а другой из ребят которых мы позвали на помощь в качестве физ. силы — плюхнулся от вида крови носом об порог и рассек себе подбородок.

Примерно в 3-4 часа ночи у нас потихоньку начал подниматься трафик. Все заработало, мы бегали и устраняли неполадки «на ходу». Но IPv6 так и не заработал. Ни утром, ни через день… При общении с провайдером, выяснилось что менеджер заключил договор (в том числе на IPv6) не зная что провайдер физически не имеет IPv6 сетей, и тем более возможности их маршрутизировать. Это был коллапс. Но благодаря опять-же связи с тех. директором провайдера, он нашел способ как «прокинуть» трафик мимо них через соседнего провайдера с IPv6 и у нас все заработало, правда было уже немного поздно, часть клиентов нас покинула.

По завершению всех работ наш дата-центр выглядил примерно вот так:

На этом и закончился наш переезд. Как видите, было много мелочей о которых мы не подумали сразу, совершили много ошибок за которые в последствии и заплатили. Мы искренне надеемся что данная статья поможет избежать наших ошибок — другим людям которые попытают счастье в подобном деле.

Ну и как всегда, есть один приятный бонус. Мы планируем написать отдельную статью по финансовой части нашего проекта (возможно без конкретных цифр, но в сравнительном анализе будет понятно). Из неё Вы поймете что рентабельно, что нет, на чем можно сэкономить и многое другое.

Мы также будем продолжать публиковать статьи на Хабре о работе нашего мини дата-центра, о сложностях которые возникают и о наших нововведениях. В одной из ближайших статей Вы увидите как мы подбирали «самосборное» оборудование для специфических целей и что в итоге выбрали. Спасибо за внимание!

Комментарии (57)

Zagrebelion

17.10.2016 19:53+1Переезд — это круто, можно с нуля сделать что-то по-другому, что на старом месте слишком сложно переделывать.

Несколько комментариев:

1. Переезжать в пятницу перед тремя выходными — идея для храбрых сердцем.

2. С ноутбуком гораздо удобнее настраивать коммутаторы/маршрутизаторы.

3. Подпишите, пожалуйста, патчкорды, будет легче определять, где какой конец. А учитывая, как неаккуратно обжата витая пара на нечётных и на 46-47-48 портах коммутатора (остальные порты плохо видно), то вероятность замены патчкорда велика.

TakeWYN

17.10.2016 22:271. У нас не было выбора. К сожалению.

2. Да, если в нем есть ком порт.

3. Обжимали во время переезда и торопились. Сейчас там уже другие кабели идут.

А так — да, все по делу говорите. Подписать… с одной стороны можно, маркировщик есть. С другой стороны они все как на ладони, в одном шкафу.

TaHKucT

17.10.2016 23:11+32) usb2com стоит копейки и нужен только первые 2 минуты, потом обычного ethernet вполне хватает

3) Стойки у вас были заранее. Обжимать (а лучше покупать) патчи тоже можно было заранее в спокойной обстановке (или даже из старого ДЦ привести). Так же не понятно зачем зажимать кабеля в не разборные стяжки и почему они одной колбасой идут, а не уходят в право (в лево), а потом возвращаются на уровне свича.

Ps кмк свич практичнее ставить в середину стойки, а не сверхку(снизу). Так провода менее кучно к нему подходят. Если хотите — сделаю завтра пару фото как это в реале выглядит.

TakeWYN

17.10.2016 23:151. Может usb2com и стоит копейки, но не в пятницу перед праздником в 5 вечера.

2. Поясню почему делали именно так. Справа и слева мы укладывали кабели к PDU, нам так казалось и кажется удобнее.

На счет KVM свитча не соглашусь. Его ограничивает только витая пара к нему подключенная, мы его тягали даже во второй шкаф, спокойно. Кстати этот KVM уникален, к нему каскадом можно подключить сотни машин.

pwrlnd

18.10.2016 11:151. Может usb2com и стоит копейки, но не в пятницу перед праздником в 5 вечера.

Так об этом и говорят вам, что нужно готовиться заранее. Особенно к таким серьезным перестановкам. Также заранее можно было протестировать линк и ipv6. Такое чувство, что если бы кто-то у вашего провайдера накосячил и линк был бы вообще неработоспособный, то вы бы потратили время на решение и этого вопроса.

TakeWYN

18.10.2016 12:12Как можно подготовиться заранее если съезжать нужно было из дц через день после того как нам протянули линк. Съезд не отложить (планировалось у них тушить дц владельцами здания). Приходилось делать все «на ходу». И как мне кажется получилось очень неплохо.

Если бы мы готовились заранее мы бы на переезд час потратили.

TaHKucT

19.10.2016 12:44Я про KVM ничего не говорил, его действительно удобнее держать сверху, при необходимости подключение серверов из соседней стойки («кмк» это сокращение фразы «как мне кажется»).

Я про обычный свич: выглядит примерно так

buro73

19.10.2016 18:26Доброго дня.

А не подскажете схему (или как ее еще назвать) маркировки и если есть шаблон журнала.

Спасибо.

TakeWYN

19.10.2016 18:26Ниже коллеги написали :)

У нас маркировка следующим образом:

все коммутаторы имеют маркировку вида sw1-sw2-sw55

сервера маркировку R2-44, R5-11 R2-34 где цифра правее R означает номер стойки а цифра после дефис — номер нижнего юнита занимаемого сервером(на случай если сервер более чем 1 юнит)

в итоге на пачкорде со стороны сервера мы видим маркировку вида SW2-23 (sw2 номер свича, 23 номер его порта).

а со стороны свича видим маркировку R2-09 (вторая стойка, девятый юнит) (в наших шкафах юниты пронумерованы)

Zagrebelion

20.10.2016 19:17не думали, чтобы маркировку с обеих сторон делать одинаковой? тТобы при замене коммутатора, например, не стоял вопрос «как рассовать эти 48 патчкордов?»

darkangel66

20.10.2016 19:20обычно коммутаторы заменяют по принципу «из порта в порт»

да и есть же кабельные журналы… какие тут могут вопросы возникнуть?

Vasily_Pechersky

17.10.2016 22:32Я вот чего то не понимая клиентов, которые из за чуть более чем короткого даунтайма начинают покидать провайдера… Как будто у них самих никогда не возникает технических накладок…

TakeWYN

17.10.2016 22:32Ну… это право и выбор каждого, многие потом возвращаются, понимая что в другом месте не лучше.

darkangel66

17.10.2016 22:32Мужики а почему cisco 4948 10G а не комбаин ввиде cisco 65хх-E или 76хх-S

? дешевле же и универсальные намного.

иии чем вы BGP принимаете? не 4948 же надеюсь.

TakeWYN

17.10.2016 22:33Мы взяли 4948 10GE именно для BGP для старта. Дороже чем комбайн, но при этом она была в наличии рядом с нами. Сейчас ждем джунипер на прием и арбор на фильтрацию. Но это пока спойлер :)

darkangel66

17.10.2016 23:02МХ40? а вот про арбор ОЧЕНЬ интересно. Надеюсь увидеть статью о фильтрации.

А и хотя бы примерные цифры калькуляции арбора… тема достаточно злободневная.

V0ldemar

17.10.2016 23:07MX40?

А чем хуже MX5-T? По сути можно апргрейдить вплодь до 80го.

darkangel66

17.10.2016 23:13Ну как минимум отсутствием слотов DPC и MPC

да и 4 портовую 10G плату не воткнуть. да и MIC всего 2

V0ldemar

17.10.2016 23:261) А давно ли MX40 начал обладать слотами для MPC\DPC? :o

2) А давно ли линейка MX5-T, MX40, MX80, MX104 начали поддерживать 4x10G MIC? (proof)

3) А давно ли MX5-T стал визуально отличаться от того же MX80? 1x40G встроенный MIC + два разъема на фронтальной панели и один сзади (итого 4).

darkangel66

17.10.2016 23:30да вы правы написал МХ40 а МХ240 в уме.

V0ldemar

17.10.2016 23:32В таком случае дальнейшая полемика бесполезна. Не подумал про схожесть моделей, прошу прощения.

TakeWYN

17.10.2016 23:07Нужно сначала все получить а потом можно и описать) ждем, надеемся. Пока нечем хвастаться.

V0ldemar

17.10.2016 23:03А что за провайдеры у вас, если не секрет?

Also, да и не многие арбор дают, или сами лицензию покупаете?

balyko

17.10.2016 23:07SFP модуль действительно не встает нормально с разными скоростями на разных сторонах, но обычно «ужимка» порта до нужной скорости помогает. У Вас даже так не встал канал?

Night_Snake

24.10.2016 14:42Увы, но 1G на 10G модулях не запустится. Вот 1G модуль можно переключить в 100М режим, это да

yakov_cyb

18.10.2016 09:08+11. у вас в серверах 2 БП, а подключен только один. подключите 2 БП в грязное питание, таким образом защитите себя от выхода из строя ИБП. Используйте кабеля питания разного цвета

2. ilo/ipmi/drac не на всех серверах подключен

3. Используйте для ilo/ipmi/drac ( и всего остального менеджмента) отдельный коммутатор и полностью отдельную сеть ( тем более, что он у вас есть в стойке). Сделайте для нее доступ через 4G, aDSL или другой дешевой технологии, которая не будет ходить через ваше bgp

4. подпишите ip-адрес каждой железки(1й адрес менджмента, 2й ilo)

5. подпишите патчики

TakeWYN

18.10.2016 09:111. В перспективе обязательно подключим.

2. Да, хотя есть на практически всех. Этот момент уже почти устранили, отключали от упр. розетки и подключали iLO, освободили много портов в PDU для десктопов.

3. Сделано, правда 4G у нас нет, но 3G и третий, резервный провайдер сделан.

4.,5., все подписано но в наших документах. Каждый кабель подписывать смысла пока нет. В масштабах пары шкафов это не имеет смысла, они идут достаточно прозрачно. Но когда их станет больше — обязательно подпишем.

darkangel66

18.10.2016 14:22по 5 пункту очень и очень с вами не согласен и прям сильно от чистого технического сердца рекомендую вам таки подписать каждый пачкорд.

Пройдет год и то что сейчас очевидно… станет совсем не очевидно…

2 шкафа это 84 юнита… это около 60-70 единиц серверного оборудования а значит 120-140 пачкордов…

подписать сейчас… это час времени.

разобратся потом… лучше даже не думать как это может быть потом…

TakeWYN

18.10.2016 17:35Вы правы, я то разберусь, а вот кто то другой — с трудом. Будем маркировать. Тем более что маркировщик есть.

Может есть соображения как маркировать правильно? Вида S01>49 CISCO или как? Если Вы уж с этим работаете.

yakov_cyb

18.10.2016 17:52+1На каждый патч делается 2 разных наклейки(меняется источник->назначение местами). источник — железка рядом с которой клеится наклейка.

1 строка — порт источника -> порт назначения, как он виден в консоли.

2. строка — hostname источника -> hostname назачения

darkangel66

18.10.2016 18:06+1У нас маркировка следующим образом:

все коммутаторы имеют маркировку вида sw1-sw2-sw55

сервера маркировку R2-44, R5-11 R2-34 где цифра правее R означает номер стойки а цифра после дефис — номер нижнего юнита занимаемого сервером(на случай если сервер более чем 1 юнит)

в итоге на пачкорде со стороны сервера мы видим маркировку вида SW2-23 (sw2 номер свича, 23 номер его порта).

а со стороны свича видим маркировку R2-09 (вторая стойка, девятый юнит) (в наших шкафах юниты пронумерованы)

пока что недостатка такого подхода не заметили.

buro73

20.10.2016 08:38а если используется кросировка через шкафы? как в таком случае делать — писать на патч-корде в кукую патч панель — номер порта панели?

yakov_cyb

18.10.2016 17:42и ещё, порекомендую мониторить очереди на 4948-10G на наличие дропов, ибо у вас трафик идет в 10G->1G и размер буферов ограничен, при большом трафике, надо крутить buffer allocation.

TakeWYN

18.10.2016 18:24У нас уже другая схема сети, прошло уже пол года) и не один маршрутизатор. Но все равно спасибо!

akuvshinov

20.10.2016 10:20В 4948 для конвертации порта X2 10Gb в два 1Gb нужен конвертер CVR-X2-SFP. Если вы купили этот свитч новым, то в коробке с ним по умолчанию их идёт две штуки (по количеству X2 портов). Они превращают два десятигигабитных порта в четыре гигабитных. Если покупали б/у, то обычно народ их вытаскивает, т.к. думают, что они продаются отдельно.

После установки конвертеров не забудьте в конфигурацию добавить:

hw-module module 1 port-group 1 select gigabitethernet

hw-module module 1 port-group 2 select gigabitethernet

Ну и таки да, использовать 4948 в качестве BGP маршрутизатора… Обновитесь как только будут деньги :).

yosemity

20.10.2016 13:21Как видите, было много мелочей о которых мы не подумали сразу

Ребят надо было покрепче брать :)

TakeWYN

20.10.2016 20:11Кто был — того и взяли)

yosemity

21.10.2016 00:42Кстати, каммент к прошлой статье. раз уж вы колхозили ИБП, то расскажу, что и мы колхозили. Но не на базе обычных наливных стартерных, а на базе гелевых MNB MNG-100-12, т.к. отдельного помещения нет, а устраивать в мелкой серверной газенваген я категорически против, да заморачиваться с обслугой АКБ нафиг. Берем обычный АРС на 24В, типа старого, но проверенного парня 1500, цепляем к нему последовательно пару батарей выше и через телнет по СОМ-порту говорим, что, у тебя, бро не 0 доп батарей, а 3. К слову, у таких АРС нет возможности цеплять доп батареи, но в прошивке такая штука заложено. Кол-во «дополнительных» блоков выбирается эмпирически с помощью измерений, т.к. ИБП, сколько его через ГУЙ не калибруй и какой бы вольтаж не был, все равно уходит в даун при почти полных батареях. Результатом довольны, при нагрузке в 70% все подопытные (1400 и 1500) держат час до 50% разряда. 2 года полет отличный, хотя отключения только для теста гены и самого ИБП. Сейчас едет еще 4 штуки каких-то AGM «Восток», по цене дешевле дельты и даже MNB, будем тестить уже на 48В.

Night_Snake

24.10.2016 14:46Касаемо сети (за остальное не скажу)

1) Про usb2com вам уже сказали — они должны быть по умолчанию у саппорта и у каждого админа, который бывает на сайте

2) Админы-сетевики у вас удаленные, как я понимаю? Иначе непонятно, как они сопровождали переезд

3) BGP-связность можно проверить заранее, как и прописать в RIPE, что у вас два(три, четыре, пять) аплинков, а не один. Насчет IPv6 — целиком и полностью косяк ваших админов, что они не проверили заранее.

4) Часть про прокладку оптики… без комментариев :) обнять и плакать.

Пишите мне в личку, могу еще чего подсказать по сетевой части.

vel

Почему у серверов используется только один блок питания из двух?

TakeWYN

На данном этапе мы не предоставляем SLA и в случае выхода из строя одного — переключаем во второй в ручном режиме. В планах на пару месяцев задействовать и резервные тоже, но пока только в планах.

ultraElephant

Неужели это так хлопотно — подсоединить ещё один БП?

TakeWYN

Нет, но пока в этом нет крайней необходимости или обязанности — мы этого не делаем. За почти год работы ни один БП не вышел из строя.

degas

А электричество сколько раз отключали?

TakeWYN

Оба ввода — 1 раз, и то это было ЧП на подстанции центральной. Там весь район погас. Но 2 БП нас бы никак не спасли. А вот ИБП — спасло)