Итак, поехали. EMC уже много лет неравнодушна к флешам, но в прошлом году конкретно заморочилась, решив, что будущее за ним. И выпустило рабочую и не очень дорогую штуку. Это почти что обычный мидрейндж с SSD-дисками (нюансы чуть позже). Никаких «втыкаем лом, а она продолжает работать», но зато внушительная производительность под базы данных и виртуалки плюс разные мелкие фишки.

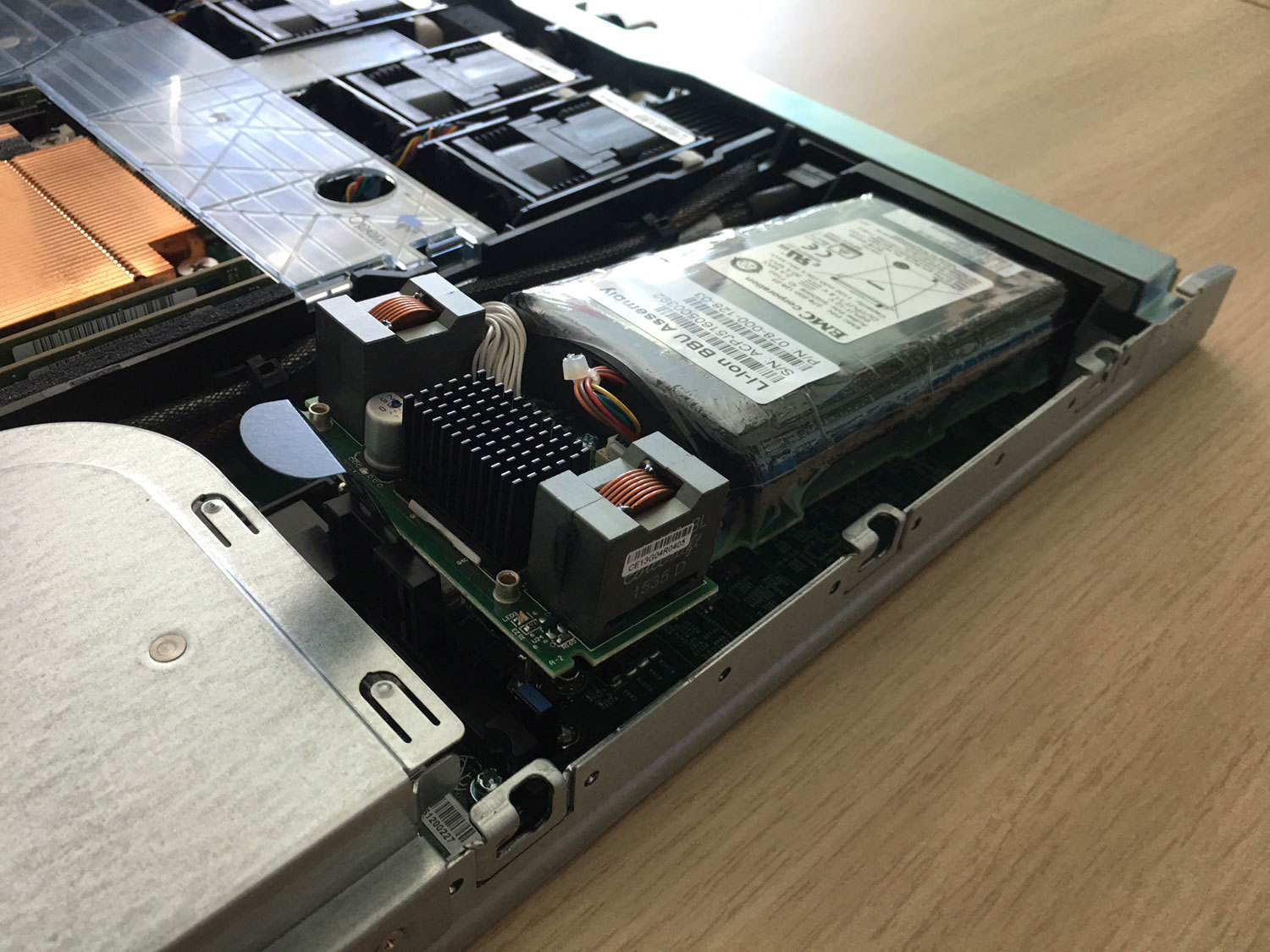

Вот яркий пример оптимизации — раньше тут был отдельный ИБП-модуль в своём кожухе, и он менялся «на горячую». А теперь — Li-ion батарея с полиэтиленовой защитой от протечки внутри контроллера.

А ещё они наступили многим вендорам на любимую мозоль и сделали цену поддержки одинаковой на всё время. А то, знаете ли, многие большие вендоры любят ставить такую цену на 4-й и 5-й год, что проще заменить железо на новое. Ну и да, у этих ребят выход из строя диска по износу считается гарантийным случаем, не в пример некоторым любителем звездочек и мелкого шрифта в гарантийной политике.

Всё, теперь пошли втыкать в неё лом и тестировать. Забегая вперёд скажу, что с 9 дисков сняли 80 тысяч иопсов.

Объединение Dell и EMC

Главный вопрос — что будет с линейкой СХД после объединения. Больше всего спрашивали, причём звонили даже те, у кого железки трёхлетней давности. Официального сообщения пока нет, но ЕМС в сегменте мид-рейнджа всегда лидировала, и здесь Делл не будет рубить курицу, которая несет золотые яйца. И выход нового Юнити — этому подтверждение.

Что за железка и как сделана

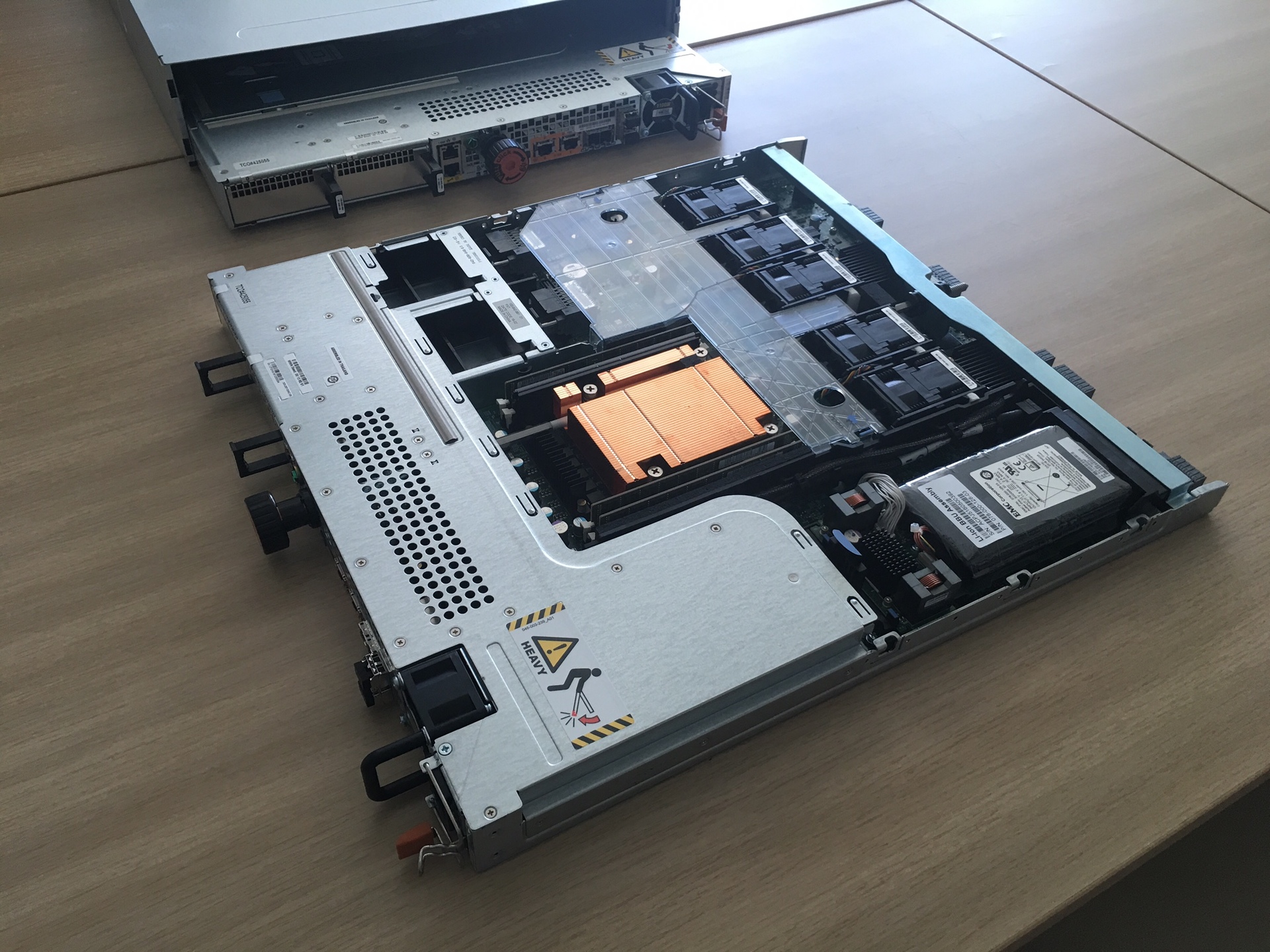

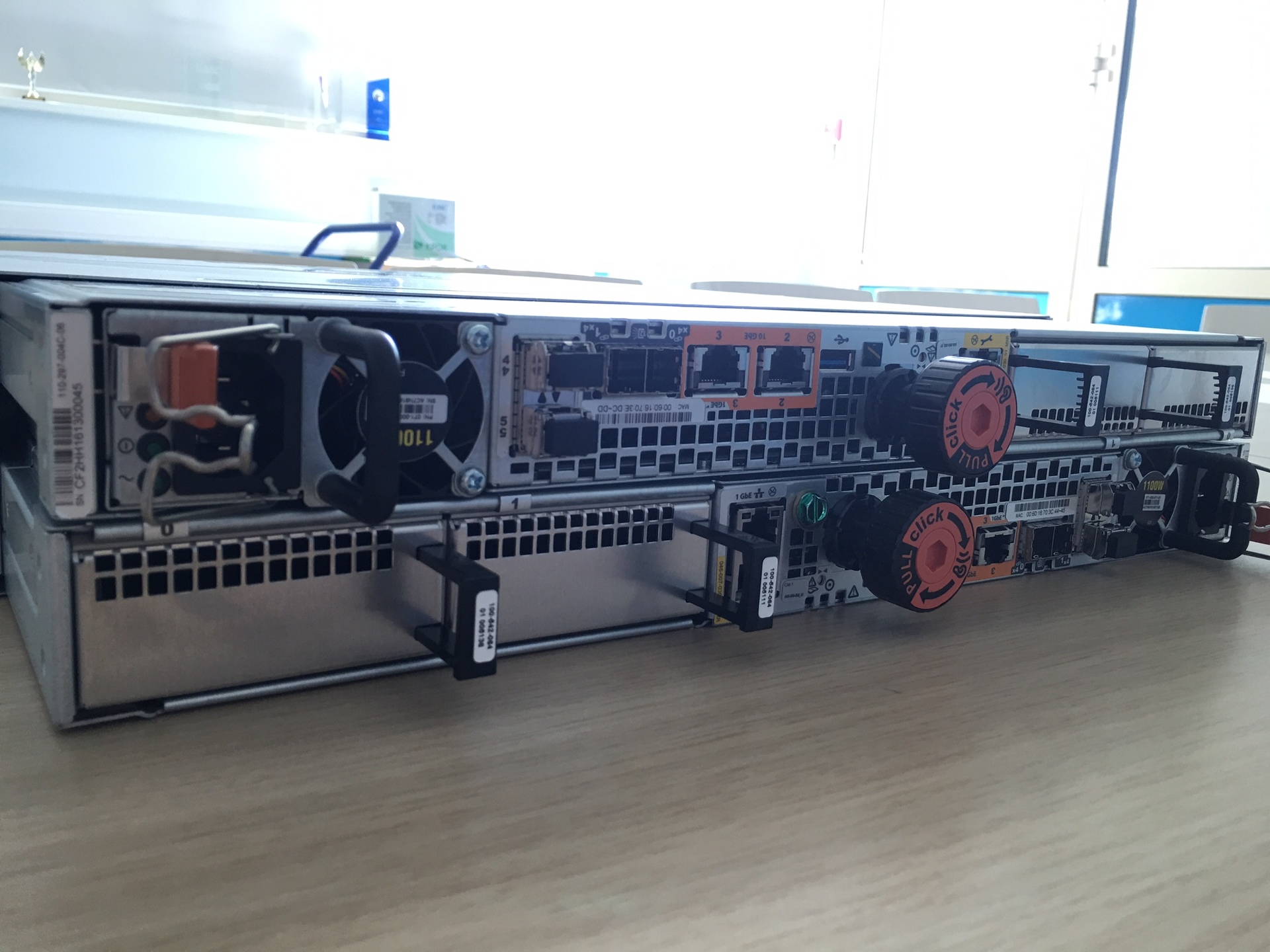

Чёрные блоки справа вверху — охлаждение (флеш-штука горячая, постоянно нужно дуть), дальше батарея, в середине вся начинка и процессор (вот видно DIMM около оранжевого блока), левее в Г-образном кожухе — блок питания, еще вентиляторы (не забываем дуть на проц) и место под IO-модули.

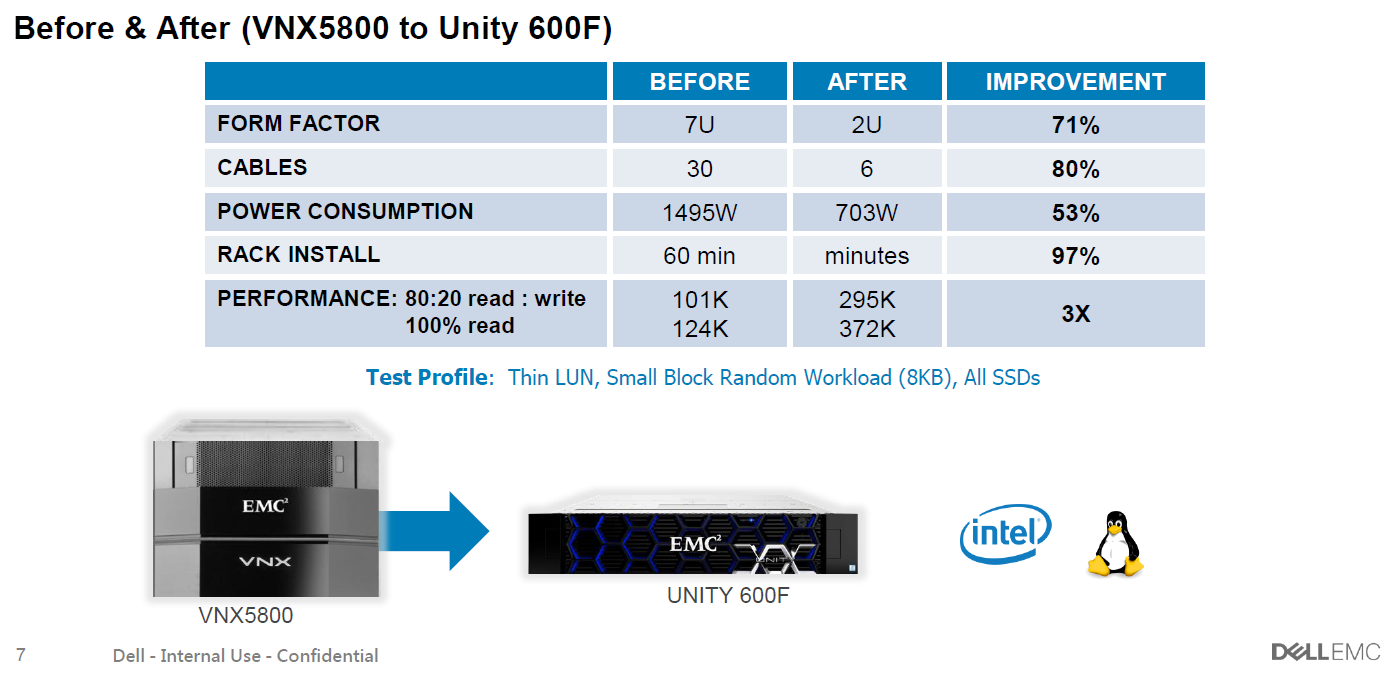

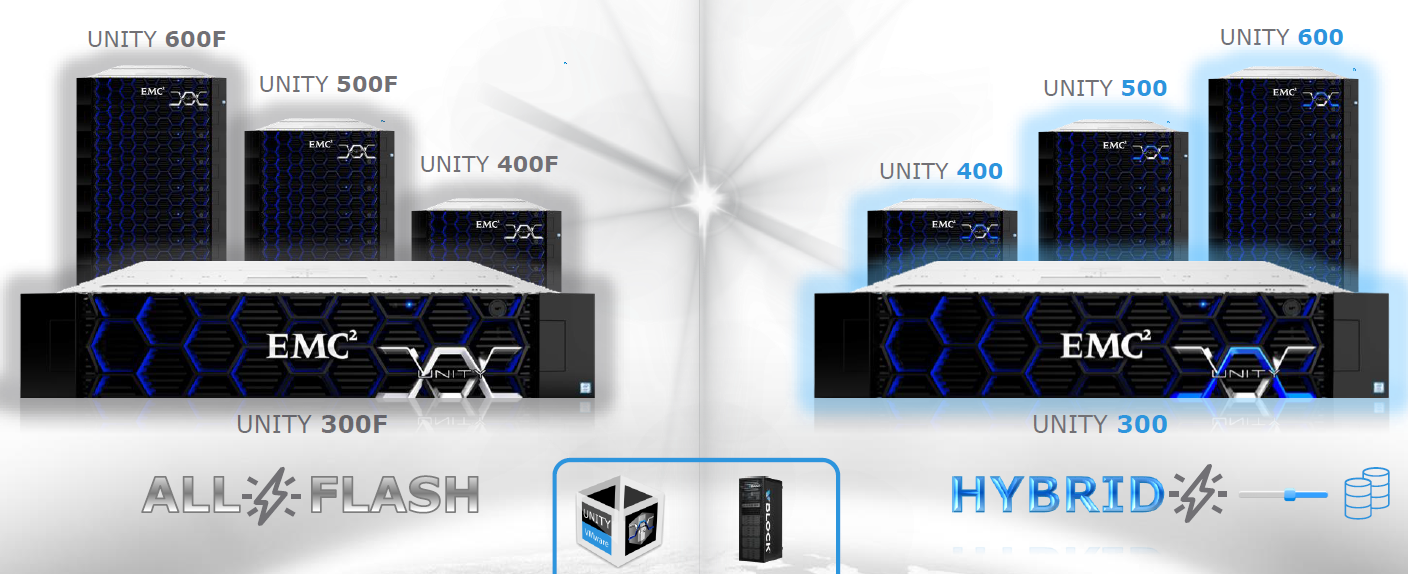

Юнити сама по себе — это замена текущих VNX с точки зрения маркетинга. Железо тут стандартное, два контроллера на базе процессоров х86 плюс полки с SSD-дисками, подключаемые по шине SAS3. А вот микрокод здесь сильно переработанный (причем его частично писали русские программеры из Питера), ровно как и новые алгоритмы работы с дисками. Подход был нестандартный: хоть в линейке и есть и флешовые, и гибридные системы, разработка шла от all-flash, а уже потом делалась совместимость с HDD (благо это вопрос изученный). То есть оверхед, конечно, поверх SSD есть (нет его только там, где вместо дисков используются голые микросхемы флеш-фабрики, а это вообще другие цены), но задержки и производительность очень хорошо получилось оптимизировать.

Только не читайте мелкую подпись :)

Главная мотивация распрощаться со шпинделями — это цена. На досуге я считал цену на гибридную СХД и all-flash — разлёт получается 30-40% с учетом скидок (на флеш они больше). Это уже не порядок, как раньше, и, значит, можно думать об использовании их там, где раньше бегали НЖМД. Да и дико это — вспоминаю, как приходилось по 100 шпинделей набирать для производительности, а потом еще их объем резать, т.к. получались лишние терабайты. И еще штрафняки на RAID не забыть вычесть. А бывает, приходит заказчик с запросом на 10-15 тысяч IOPS с базенки на 3-4 Тб. И что прикажете – 300Гб 15к в зеркало??? Сейчас в линейке SSDшки от 400 ГБ до 15 (!) ТБ. В общем, считать нужно под задачу. Обращайтесь, контакты внизу. Но что-то я отвлекся.

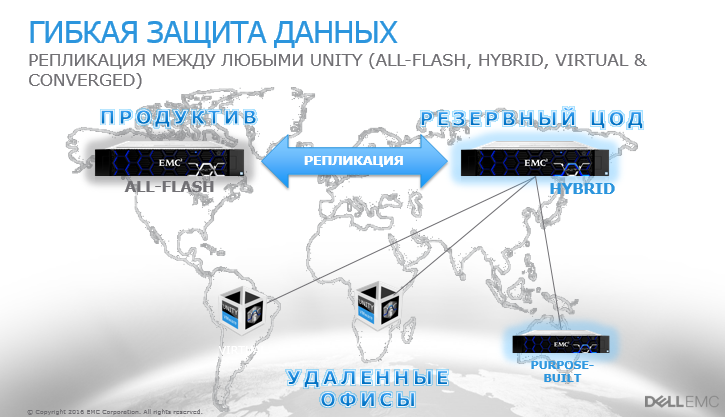

Не забыли архитекторы и про мелкие филиалы компаний. Есть версия в виде виртуальной машины под Vmware (обещают и другие гипервизоры подтянуть, если будет спрос), которая ставится в далёкий маленький филиал поверх сервера с дисками или совсем простой полкой, и после этого всё его пространство будут видеться как полноценная СХД Unity. это дает такие возможности, как репликация из филиалов, снапшоты и управление из единого окна. Потому и Unity, собственно.

Раньше к железу надо было отдельно докупать лицензию на ёмкость. Для многих заказчиков это было неудобно. Сейчас этого нет. И нету отдельных продуктов — репликация, блочные и файловые протоколы, снепшоты, тиринг и фасткэш (для гибридных систем) включены в поставку.

На all-flash постоянно спрашивают про надежность — и вот EMC сделали вывод, что флешовые системы поддерживать вполне себе нормально, потому что флеш почти вечный, ибо без движущихся частей и изнашивается ну очень медленно. И потому цена одинаковая для каждого года поддержки, как я уже говорил (но это не относится к гибридным хранилищам). Ещё вкусное — опять же, упоминал, пока массив на гарантии или расширенной гарантии — если диск выйдет из строя по причине износа, они его поменяют неважно на каком году. У другого небезызвестного вендора это считается за проблему заказчика и негарантийным случаем. Тоже нашли кому наступить на мозоль.

Очень удобно по объёму — можно хоть 200 Тб в одну полку запихнуть, если надо. В сравнении со шпиндельными хранилками очень даже приятно.

Есть у нас уже и боевые внедрения — несмотря на майский релиз железки. Заказчик раскинул ROI, TCO и понял, что гибрид брать не выгодно. В итоге там Юнити 400F (F – значит Flash) 47 SSD по 1,6, получается около 60 Тб полезного места в RAID5. Всё это в 4 юнитах. Выдаёт 140 тысяч iops.

В целом система, как обычно, сделана по-ирландски (у них завод в Корке в Ирландии). Сборка аккуратная и красивая, но очень своеобразная по решениям. Например, контроллеры (два лезвия) крепятся к шасси здоровенным болтом, который проходит через весь массив. Благодаря этой оси все разъемы ровно входят друг в друга на бэкплейне.

Вот эти болты. Пока их аккуратно докручиваешь на последнем сантиметре, ощущение как при стыковке с МКС.

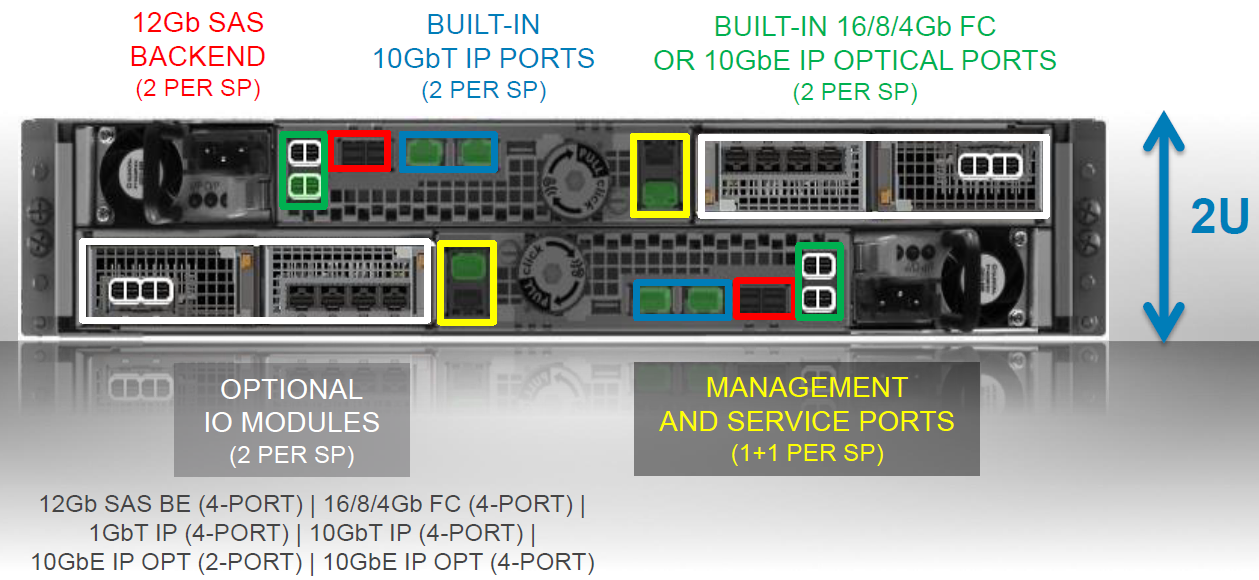

На борту есть встроенный 10 BASE-T для раздачи по файловым протоколам или блочного iSCSI. Он дешёвый, поэтому не удорожает конструкцию, но пользу несомненно принесет. А вот основной коммуникационный порт вы выбираете под свою инфраструктуру. При заказе можно выбрать какие трансиверы пойдут в конвергентный разъем ввода-вывода (16 FC либо 10 Eth / ISCSI). Их по 2 на контроллер. Надо больше — есть модуль расширения, куда этих портов можно добить. См. схему ниже. И никаких отдельных файловых контроллеров — всё уже на борту. Это чертовски удобно, надо сказать, хотя скорее актуально для гибридных моделей, чем полностью твердотельных. Всё-таки для файлопомоек флеш пока еще дороговат. Ну или же для любителей строить Vmware на NFS, что очень популярно в последнее время.

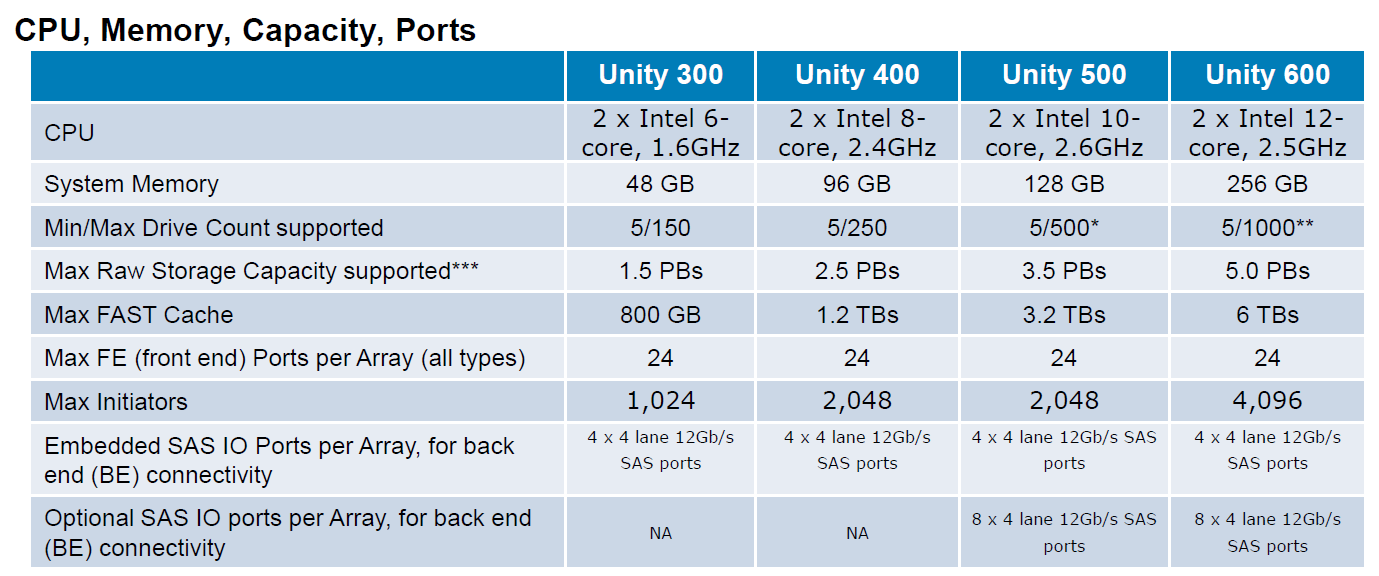

Процессоры и память не вызывают удивления — старый добрый Интел.

Внутри два SSD для сброса грязного кэша при отключении питания, в каждом контроллере они свои. ОС ставится на первые 4 диска. Порадую тех, кто знаком с предыдущими линейками от ЕМС: эти диски теперь можно объединять со всеми остальными в пул под данные. Раньше они часто становились мертвым грузом, на которые кроме образов виртуальных машин нечего было положить. Да и вендор крайне не рекомендовал их нагружать. Сейчас — пожалуйста. Только для высоконагруженных инсталляций мы всё же рекомендуем придерживаться этого старого правила. Они поэтому и системные, что важные. А без нагрузки ребилд всегда быстрее проходит. Ребилд 1.6Тб диска под нагрузкой 50т IOPS, кстати, занял чуть меньше двух часов. Результат этот видится мне вполне достойным.

2 кабеля питания (чёрный и серый по краям), 2 управляющих (по зелёному в юнит), 2 frontend (синие).

Линейка

У хорошего джедая меч синий, а у очень хорошего — серебистый: обратите внимание на логотипы. За внимание к деталям производителю отдельный плюс в карму.

Тесты

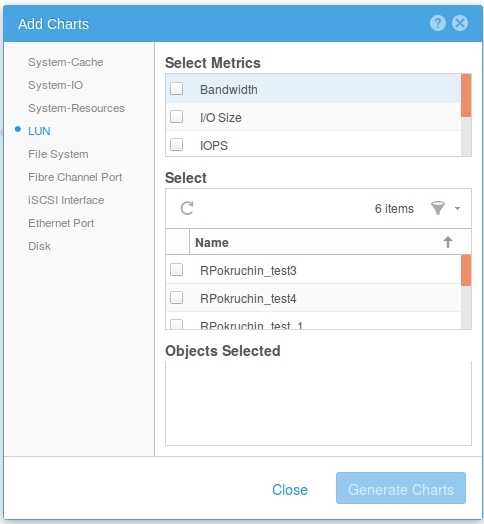

Тестировали стандартным в последнее время для нас методом от rpokruchin.

Результаты получились следующие:

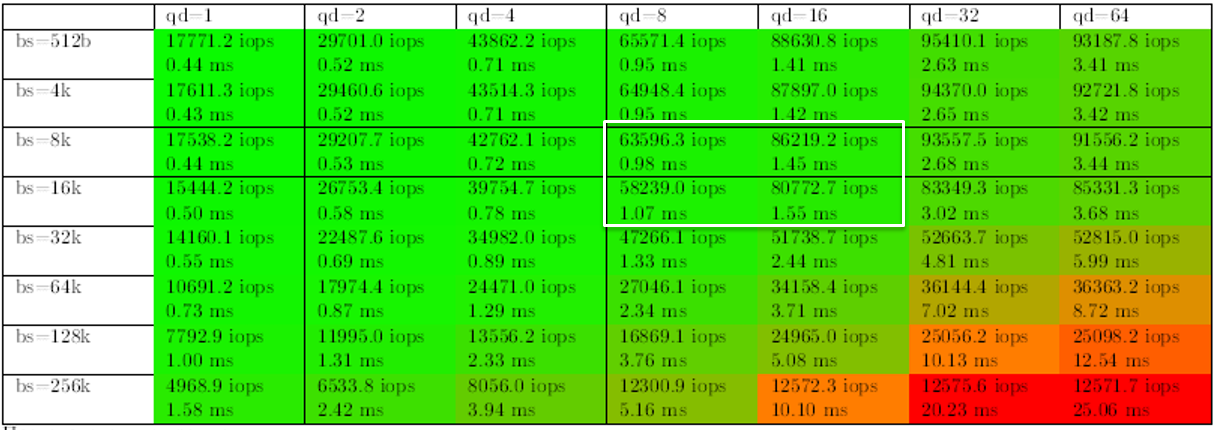

1. Начнем с характерных для SSD нагрузок – случайного чтения и записи. Выделил значения, которые можно принять за эталон. Кстати, видно, что система внутри себя работает блоком 8К, т.к. количество IOPS начинает уменьшаться только при бОльшем размере, а на меньших показывает практически тот же результат. Если подходить к вопросу строго, то результат на случайном чтении – 63,5 тысячи IOPS (когда принимаем 1мс за отсечку и всё, что выше — не в счет). Если на это внимание не акцентировать, то можно считать, что 86 тысяч мы из нее выжали. Хотя каждый волен решать сам, какие результаты считать правильными. Для этого и приведена вся таблица на разных блоках и очередях:

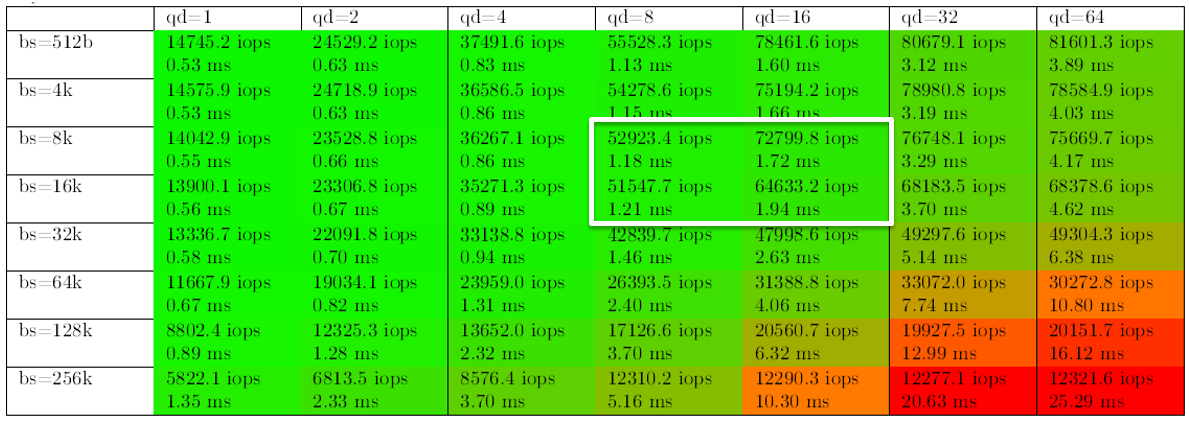

Что интересно, на случайной записи результаты оказались лучше, чем мы думали. Производительность получилась хуже только на 20%. Может быть, конечно, кэш СХД отработал на пятерку, хотя всячески старались его обойти разве только что не выключали. Но это было бы неверно, т.к. его не для того включили в дизайн, чтобы лихие парни из КРОКа его гасили. Да и в продуктиве всё равно он будет включен.

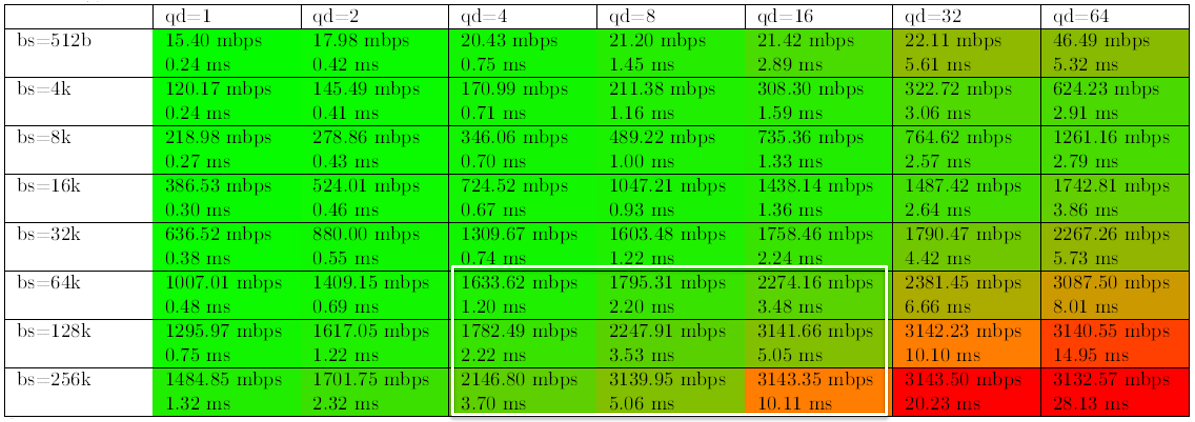

Не оставили без внимания также нагрузки при бэкапах, когда идет последовательное чтение большим блоком и важна скорее пропускная способность, нежели время отклика и иопсы (кто захочет кинуть в меня кирпичом, заранее соглашусь, что да, при бэкапах блок может быть еще больше, но общей картины это не меняет):

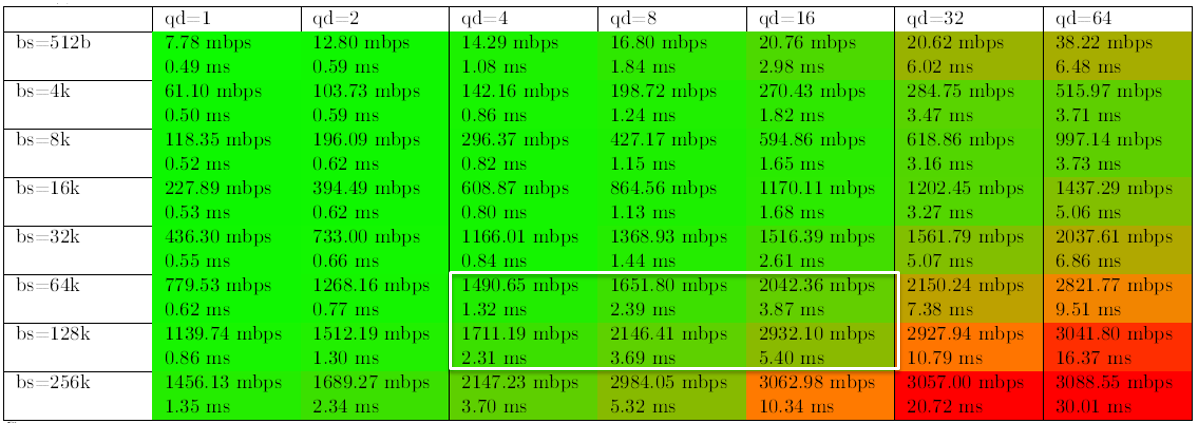

И, наконец, нагрузка, характерная для заливки данных — последовательная запись большими блоками.

Из таблицы можно заметить, что после определенного момента производительность уже не растет, а вот время отклика увеличивается. Тут приходится вспомнить, что всё-таки система мидрейнджовая, и звезд с небес не обещала. Тем более на 9 дисках, из которых 4 системных (Да, мы плохие ребята, не следуем своим же лучшим практикам). Просто нужно знать с самого начала ее потолок и следить за своим продуктивом. Чем выше модель в линейке — тем выше её потолок. Он, кстати, почти честно указан в даташите (есть в ссылках ниже). Это нужно учитывать при покупке.

Что интересно, конечно, на высокие показатели она выходит на небольшом количестве дисков — с увеличением количества дисков она быстро упрется в обозначенный потолок и дальше производительность расти не будет, но зато за свои деньги работает. Как мы поняли — причина в том, что система упирается в мощность контроллера. На логичный вопрос был получен ответ — за все в этой жизни надо платить. В случае если нужна производительность больше — нужна большая модель.

Конечно, когда смотришь на свободные слоты для плашек памяти на материнке, хочется добавить туда несколько серверных планок по несколько сотен долларов и получить дополнительный кэш (кэш там – обычные DIMM по 16 Gb). Или поменять процессоры тоже заодно (в младшей модели шестиядерные 1,6 Ггц). Но такое действие снимет желзку и гарантии сразу, увы. Правда, я знаю человека, который как-то умудрился снять со своей СХД систему магнитного уничтожения дисков и выдать полный отказ за гарантийный случай, поэтому, может, кто-то их и будет переставлять перед приездом инженеров, но что-то маловероятно.

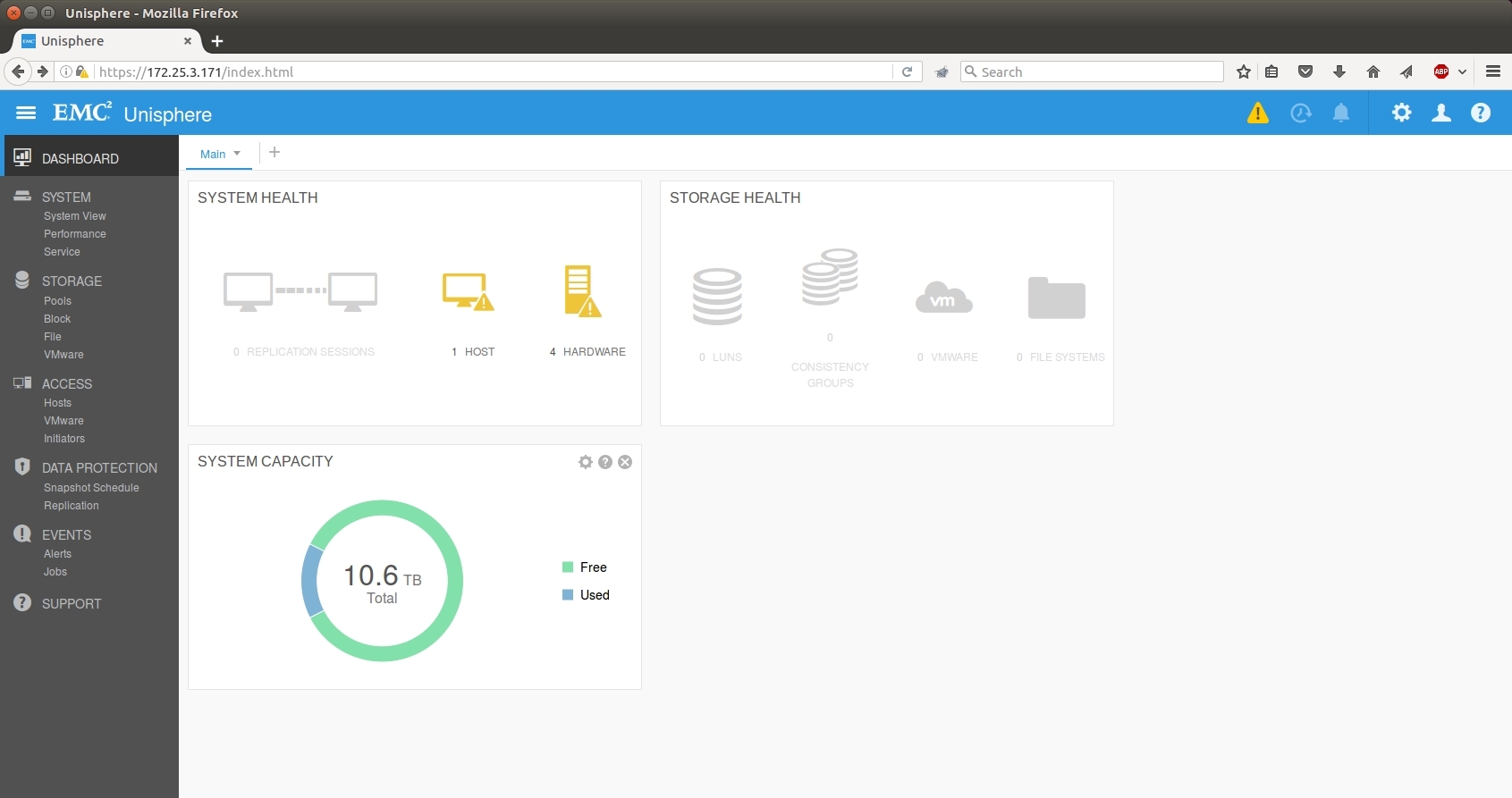

Интерфейс

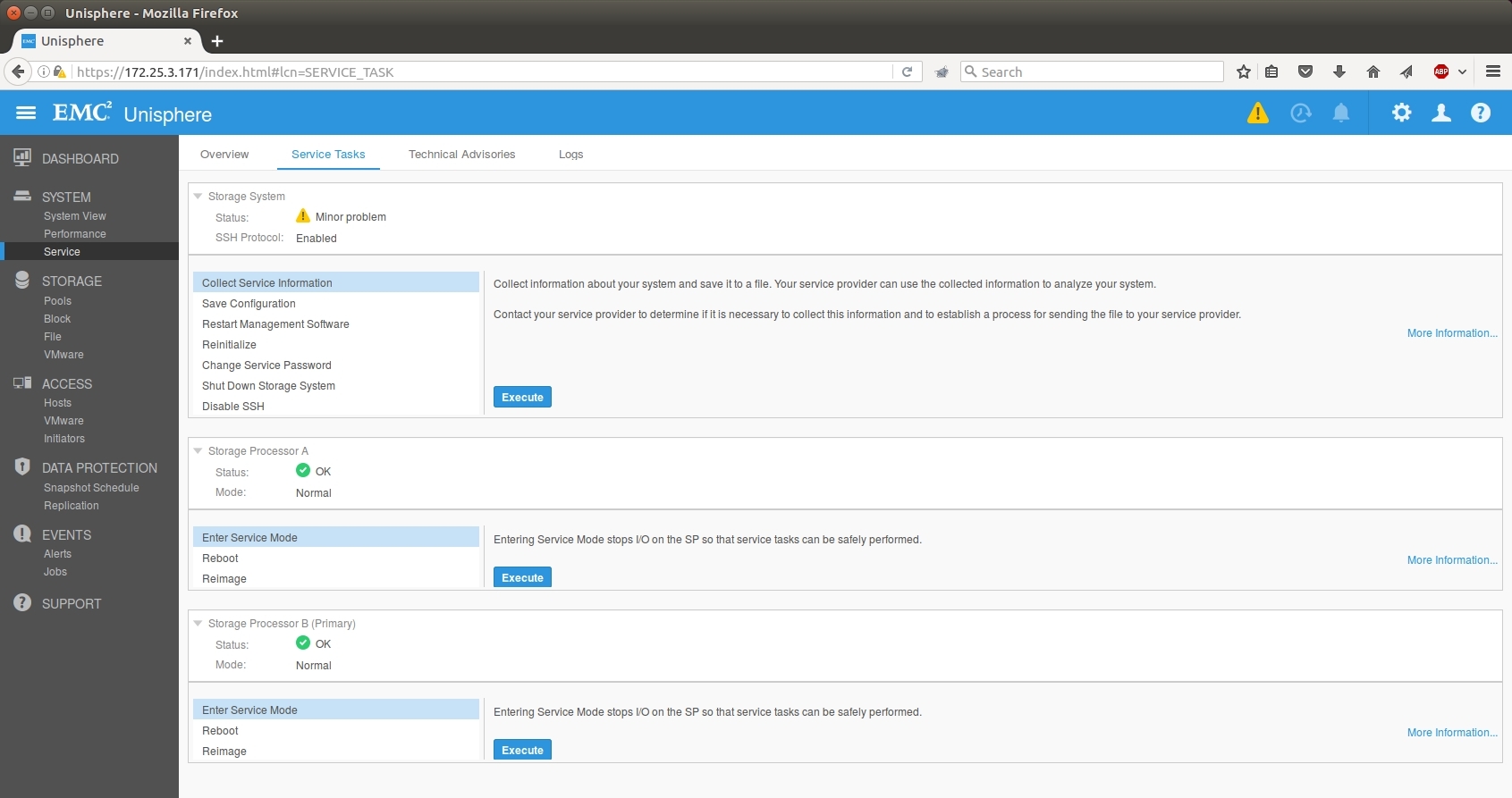

Теперь на HTML 5. GUI отлично работает на Windows и Linux, для ценителей автоматизации есть cli и REST API. Очень много сил было приложено к оптимизации. Выполнение задач реально легче. Удобные визарды пришли на смену беготне по нескольким вкладкам. Realt-time и историческую статистику производительности можно смотреть в онлайн режиме без использования дополнительных утилит. Графики настраиваются в том же интерфейсе, управление очень гибкое.

Помимо административных задач очень упростились сервисные операции. Все они теперь собраны в одной вкладке. Логи с массива собираются быстрее и сразу с обоих контроллеров. В Web GUI появились такие операции как Reimage и обновление кода массива \ дисков.

Есть управление из облака: при желании можно зарегаться в специальном сервисе, куда система будет сливать свои счетчики — будут предлагаться советы по оптимизации ресурсов и управлению. Сделано это, конечно, для того, чтобы вы не пропустили апргейд и дозакупку железа, но, вроде, польза тоже есть.

Есть еще классные тулзы у партнеров по оценке текущей инфраструктуры — можно собрать логи с ваших массивов, проанализировать и на выходе узнать, какая Юнити с учетом роста на 3-5 лет заменит все текущие массивы. И плюс к этому можно понять, нужен ли allflash или гибридной достаточно.

С виртуальной Unity можно поиграть — она скачивается в виде демки с лицензией на некоммерческое использование бесплатно по этой ссылке.

Резюме

Производитель поставил себя на место заказчика и учел свои ошибки: выпустил достойную по производительности хранилку, упростил интерфейс и лицензирование и обеспечил прогнозируемую стоимость владения за счет фиксированной стоимости поддержки.

В дополнение к традиционно высокому качеству продуктов и сервиса можно смело говорить, что система достойна внимания корпоративных заказчиков практически любого уровня. Единственный вопрос — что будет с EMC в свете объединения с Dell. Лично я думаю, что всё так и останется, но это, как говорится, одному Деллу известно.

Вот так сейчас может выглядеть 100Тб флеша

Система была выпущена в мае, у нас есть положительный опыт месячных тестов и внедрения у заказчиков (один из примеров выше). По секрету скажу, что помимо тестовой мы «под шумок» еще купили для своей инфраструктуры одну гибридную и одну флешовую систему и уже эксплуатируем их под внутренние задачи.

Ссылки

- Старый обзор VNX

- EMC ScaleIO – упомянутая программно-определяемая СХД

- Моя почта для вопросов и для запроса акционных цен (увы, каждого участника EMC согласовывает под промо-цены отдельно, поэтому процедура такая нетривиальная) – vbolotnov@croc.ru

- Ну и для любителей даташитов: флешовой и гибридной линеек систем хранения

Комментарии (41)

OstaninKI

29.11.2016 12:03+1С виртуальной Unity можно поиграть — она скачивается в виде демки с лицензией на некоммерческое использование бесплатно по этой ссылке.

и как обычно ссылка на «поиграться» отсутствует. Еще бы было интересно посмотреть на тулзы по оценке текущей инфраструктуры, дабыоценить своюпоказать руководству хоть какое-то обоснование…

BoVados

29.11.2016 12:55Сорри, вот ссылка http://www.emc.com/products-solutions/trial-software-download/unity-vsa.htm

Там же видео по установке и FAQ. Нужно будет зарегистрироваться на портале, если вы еще не являетесь заказчиком ЕМС. Регистрация простая и доступна всем.

По утилитам, инженерам DELL EMC и партнеров доступна MiTrend assessment tool (https://mitrend.com), которая анализирует логи с различных элементов инфраструктуры. Мы обычно используем её в сочетание с сайзером для Unity (или других хранилок). Но у заказчиков доступа нет. Если интересно, напишите в личку. Попробуем помочь с оценкой.

strelec7

29.11.2016 13:10А есть что-нибудь подобное для установки на железо?

или возможно лидевиртуализироватьперенести апплианс на железо?

Интересует не распределенное виртуальное хранилище между несколькими хостами, а именно создание «хранилки» на базе одного сервера. Типа FreeNAS только от более именитых производителей (EMC, HP, ...)

BoVados

29.11.2016 15:45Посмотрите вот это https://habrahabr.ru/company/croc/blog/269289/. Возможно, это более подходящее решение. Хотя и небесплатное, конечно.

strelec7

29.11.2016 16:03Спасибо, но не то о чем я спрашивал. ScaleIO опять же апплайнс, который ставится на гипервизор. Меня интересует установка на голое железо.

BoVados

29.11.2016 16:07Не ту ссылку дал. Конечно, вот это имел в виду https://habrahabr.ru/company/croc/blog/246155/

AntonVirtual

30.11.2016 02:59Почему на гипервизор? Берется обычный Linux, на него ставится ScaleIO.

Последний раз, как я читал документацию к нему — его можно было ставить вообще на все, что шевелится, включая ARM.

darthslider

01.12.2016 16:03Мы вот смотрим в сторону Datacore. Я тут плавно готовлюсь к тестированию, на бумаге все выглядит интересно.

BoVados

01.12.2016 16:34Оставьте контакты в личку, если интересно наше мнение. Передам ответственным за него ребятам. У них уже есть опыт работы с этим софтом

BoVados

29.11.2016 13:00Плюс, конечно! Во-первых, русские программеры пишут качественный код, во-вторых, к ним можно доехать за 4 часа на сапсане и физически спросить.

KorP

29.11.2016 13:14+1Про качество кода не буду комментировать, у меня тут своих примеров плачевных много :)

Ну а то что физически можно приехать и спросить — это да, плюс :D

iAlex

29.11.2016 13:03Черт подери, как же я вам завидую, по белому конечно.

Не сидишь и не тупишь, пока железка сообразит, а тут все на лету получается.

navion

29.11.2016 17:17+1Не очень впечатляет: производительность ниже чем у одного NVMe SSD, архитектура как у обычного писюка и без erasure coding с компрессией-дедупликацией, которая есть у основных конкурентов (как и замена при износе).

BoVados

29.11.2016 18:00“производительность ниже чем у одного NVMe SSD” — да, но это совсем другая история. Там свои минусы, хотя технология классная.

Про архитектуру, хотел бы я такой писюк. Отсутствие EC жить не мешает, ну а компрессия есть и может быть включена на уровне томов.

amarao

29.11.2016 17:24+1Какая максимальная latency при однопоточном random write 4к блоками после часа-полутора тестов?

BoVados

29.11.2016 18:10+2Такая же, как и в начале тестов. По таблице порядка 0,45мс. Цикл теста проходил порядка 6 часов.

amarao

29.11.2016 18:19+1Вы уверены, что это max, а не mean/avg?

(Я это пишу по мотивам срачика с одним вендором, у которого avg, mean, 99.9% < 1ms, а max = 2.5s. Редко-редко, а бывает).

BoVados

29.11.2016 18:41+1Да, это средняя. Max 0,68мс.

amarao

29.11.2016 18:59+1Точно-точно-точно? Потому что это довольно крутой показатель. По какой шине/протоколу оно подключалось? iscsi? SAS? FC? Если iscsi, то через какие коммутаторы.

BoVados

29.11.2016 19:50FC напрямую, без коммутаторов.

AntonVirtual

30.11.2016 02:19-2— Штурман, приборы!

— 36!

И что эти цифры тогда показывают? У заказчиков еще 2Гбит макдаты не все кончились. Несколько хопов, да по загруженным путям, да еще кабели то работают, то не работают.

140 тыщ иопсов при прямом подключении. Серьезный аргумент.

Но в этом случае проще сразу в сервер SSD ставить — оно и быстрее будет в несколько раз, и дешевле.

ximik13

05.12.2016 10:07Так и не понял из статьи какая именно модель Unity тестировалась. 300F или 400F?

140 тыс IOPS достигаются на Unity400 и через FC-коммутаторы (в том числе старые на 4G). Причем это IOPS, которые получают хосты, а не что-то измеренное на бэкенде на дисках массива без учета оверхеда на RAID. Тут просто вопрос количества портов на СХД, серверах и FC-коммутаторах. 2G по FC на Unity не поддерживается, только 4G,8G,16G. Один порт 4G вполне себе может давать 50k IOPS, т.е. достаточно балансировать трафик через 3 порта на Unity. Но в связи с архитектурой FC скорее это будут 4 порта.

Как и предположил автор статьи, в итоге все упирается в производительность CPU в контроллере.

Кстати один TLC SSD диск на Unity вполне может выдавать 36к IOPS. Хотя вендор рекомендует для расчетов использовать значение 20k IOPS. Т.е. и минимальный набор дисков для UnityF (9 дисков + 1HS) может позволить загрузить CPU контроллера полностью.

Botkin

30.11.2016 07:43Производитель со звездочками, который износ не считает гарантийным случаем — это HP?

pauliusm

30.11.2016 12:09встроенный 10 BASE-T для раздачи по файловым протоколам

шо?

BoVados

30.11.2016 12:09+2Система работает по файловым и блочным протоколам. Т.е. внутри СХД можно запустить виртуальный файловый сервер, назначить ему IPшник, отдать часть места и ходить на него через эти Ethernet порты.

phprus

03.12.2016 23:04Подсказка:

10BASE-T — это 10 Мбит/с.

Странно видеть такого гостя из мезозоя в современной СХД :)

А стандарт на 10Гбит/с по витой паре называется 10GBASE-T.

ximik13

05.12.2016 11:03В статье по поводу M.2 SSD дисков в контроллерах дана ошибочная информация. В документации вендор пишет, что данный SSD используется для загрузки OS контроллера, имеет раздел для сохранения состояния ОЗУ в случае отключения электропитания и еще ряд служебных разделов. Вот одна из цитат.

The M.2 SSD device is located inside the Storage Processor and serves as a backup device in the event of an SP failure. In the event of an SP failure, the memory contents of the SP’s cache is written to the M.2 SSD device so it can be recovered once the SP is restored. If the M.2 SSD device itself encounters a failure, cache data can be recovered from the peer Storage Processor. The M.2 SSD device also holds a backup copy of the boot image that is used to boot the operating environment.

Тем не менее от первых четырех дисков по прежнему отрезается пространство (около 107Gb с каждого). Это пространство используется для хранения кластерной конфигурации контроллеров и хранения образов OS для реимиджа контроллеров. Н-р если внутренний SSD в контроллере был заменен по неисправности и нужно восстановить загрузку OS на контроллере. Первый 4 диска можно включать в дисковый пул в отличии от массивов VNX/VNX2. Как то так.

madfly

Так всё-таки «поделка» или достойное изделие? Я о заголовке. Это ведь «две большие разницы».

BoVados

Мне понравилось.