Слева: попытка распознать место действия и объекты только по звуку. Справа: реальный источник звука

В последнее время нейросети добились немалого прогресса в области распознавания объектов и сцен на видео. Такие достижения стали возможны благодаря обучению на массивных наборах данных с размеченными объектами (например, см. работу "Learning deep features for scene recognition using places database". NIPS, 2014). Глядя на фотографии или видеоролики, компьютер может практически безошибочно определить место действия, выбрав одно подходящее описание из 401 сцены, например, «захламлённая кухня», «стильная кухня», «спальня подростка» и т.д. А вот в области понимания звуков нейросети пока не демонстрировали такого прогресса. Специалисты из Лаборатории информатики и искусственного интеллекта (CSAIL) Массачусетского технологического института исправили этот недостаток, разработав систему машинного обучения SoundNet.

В самом деле, возможность определить место действия по звукам — такая же важная задача, как и определение места по видеоматериалу. В конце концов, картинка с камеры зачастую может быть смазанной или не давать достаточно информации. Но если микрофон работает — робот уже сможет сориентироваться, где он находится.

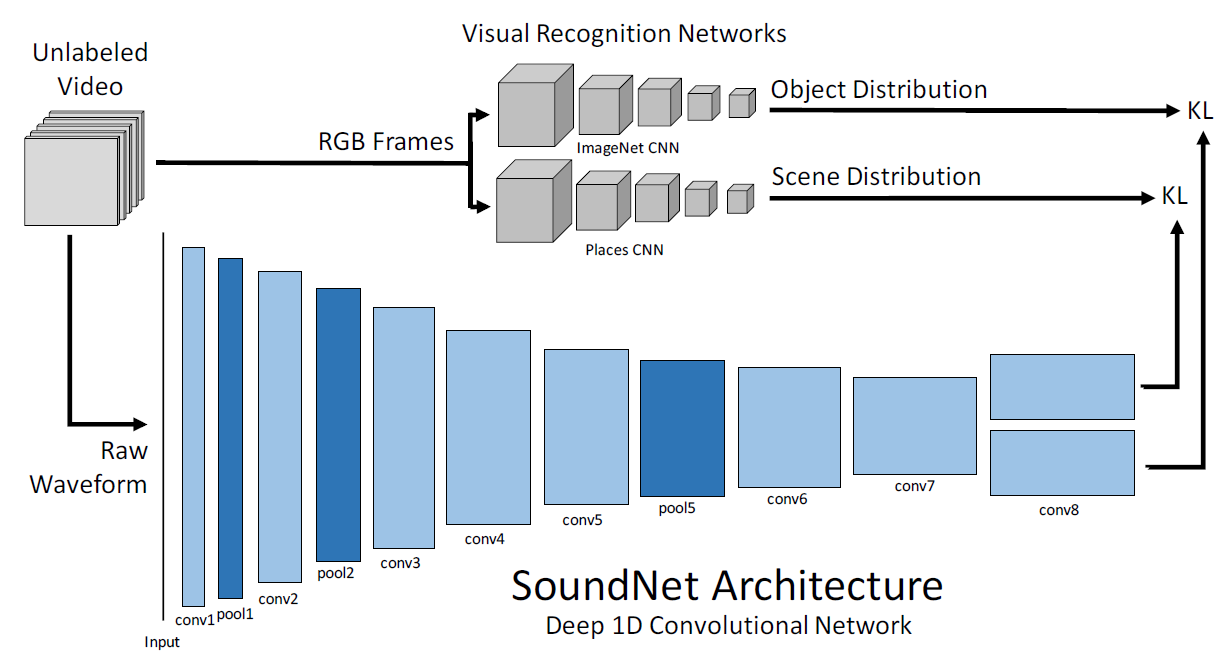

С точки зрения науки обучение нейросети SoundNet — вполне банальная задача. Сотрудники CSAIL использовали метод естественной синхронизации между машинным зрением и машинным слухом, научив нейросеть автоматически извлекать звуковую репрезентацию объекта с неразмеченного видеоматериала. Для обучения использовали около 2 млн видеороликов Flickr (26 ТБ данных), а также базу аннотированных звуков — 50 категорий и примерно 2000 образцов.

Архитектура нейросети SoundNet

Хотя обучение нейросети происходило под визуальным наблюдением, но система выдаёт отличный результат в автономном режиме по классификации минимум трёх стандартных акустических сцен, по которым её проверяли разработчики. Более того, проверка нейросети показала, что она самостоятельно научилась распознавать характерные для некоторых сцен звуки, а ведь разработчики не предоставляли её образцов для распознавания конкретно этих объектов. По базе неразмеченных видеоматериалов нейросеть сама усвоила, какой сцене соответствует звук ликующей толпы (это стадион) и птичий щебет (это лужайка или парк). Одновременно со сценой нейросеть распознаёт и конкретный объект, который является источником звука.

На видео показаны некоторые примеры распознавания объектов по звуку. Вначале звучит звук и показывается результат распознавания, а сама картинка размыта — так что вы можете попробовать проверить себя сами. Сможете ли вы понять место действия и присутствие определённых объектов только по звуку настолько же точно, насколько это делает нейросеть. Например, что с большой вероятностью означает песня "Happy Birthday To You!", которую поют несколько человек хором? Правильный ответ: объект — горящие свечи, место действия — ресторан, кафе, бар.

«Машинное зрение стало работать настолько хорошо, что мы можем перенести эту технологию на другие области, — говорит Карл Вондрик (Carl Vondrick), студент Массачусетского технологического института по электротехнике и информатике, один из авторов научной работы. — Мы использовали естественную взаимосвязь между компьютерным зрением и звуком. Добиться большого масштаба удалось за счёт множества неразмеченных видеоматериалов, чтобы нейросеть научилась понимать звук».

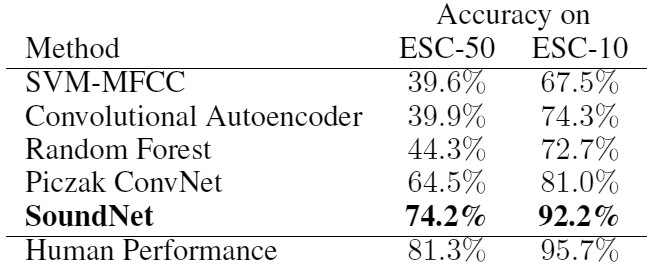

Проверка SoundNet осуществлялась на двух стандартных базах звуковых записей, и она показала на 13?15% более высокую точность распознавания объектов, чем лучшая из подобных программ. На наборе данных с 10 различными категориями звуков SoundNet классифицирует звуки с точностью 92%, а на наборе данных с 50 категориями показывает точность 74%. Для сравнения, на тех же наборах данных люди показывают точность распознавания, в среднем, 96% и 81%.

Даже люди иногда не могут точно определить, что конкретно они слышат. Попробуйте самостоятельно провести такой эксперимент. Пусть коллега запустит произвольный видеоролик с YouTube — а вы попробуйте не глядя на монитор сказать, что происходит, откуда звуки и что показано на экране. Далеко не всегда вы сможете угадать. Так что задача для искусственного интеллекта действительно непростая, но SoundNet удалось достаточно хорошо с ней справиться.

В будущем такие компьютерные программы могут найти прикладное практическое значение. Например, ваш мобильный телефон будет автоматически распознавать, что вы зашли в публичное место — кинотеатр или театр, и автоматически приглушать громкость звонка. Если начался фильм и зрители затихли, то телефон автоматически отключит звук и включит виброзвонок.

Ориентирование по местности по звуку поможет в программах управления для автономных роботов и других машин.

В системах безопасности и умных домах система может специфическим образом автоматически реагировать на конкретные звуки. Например, на звук разбитого окна. В «умных городах» будущего распознавание шума на улицах поможет понять его причины и бороться со звуковым загрязнением.

Научная статья опубликована 27 октября 2016 года в открытом доступе на сайте arXiv.org (arXiv:1610.09001, pdf).

Поделиться с друзьями

Комментарии (5)

ZOXEXIVO

04.12.2016 23:03Долго вы еще будете тиражировать заслуги нейронных сетей? Зачем нагоняете хайп там, где его не должно быть?

Хватит уже надувать этот пузырь.

Vinchi

04.12.2016 23:53Причем тут хайп? В конце ссылка на статью, народ провел работу по анализу данных. Вам что завидно? Может сами попробуете?

aapazhe

13.12.2016 17:22То есть телефон будущего будет постоянно слушать звуки моего окружения и передавать их куда-то для обработки нейросетью?

Спасибо, не нужно. Мой даже на "окей гугль" не откликается, отключено нахрен.

RealFSA

Ждем «Машинный нюх» чтоб распознавать опасные загрязнения, и прочие сложные молекулярные соединения, например в выдохе человека.

kellakilla

Да это уже давно существует, называется «электронный нос».