История знает много примеров преждевременных открытий и изобретений. Хочу рассказать об одном из них.

Речь пойдет о визуальном поисковике, получившим первые западные венчурные инвестиции в области ИТ в России, построенном на основе активных семантических нейронных сетях. Под катом мы расскажем об его основных принципах работы и архитектуре.

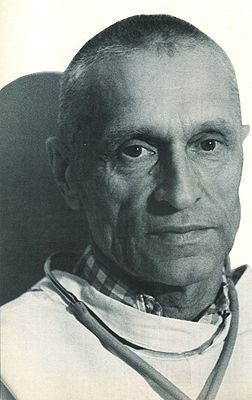

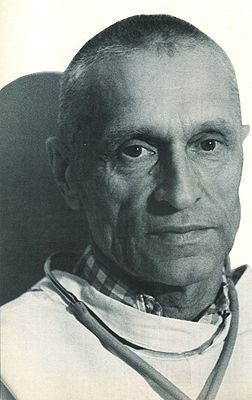

Мне крупно повезло в жизни – я учился у Николая Михайловича Амосова, выдающегося человека, кардиохирурга и кибернетика. Учился заочно — развал СССР не дал мне возможности встретиться лично.

О Николае Михайловиче можно говорить много, родился в крестьянской семье в деревеньке под Череповцом и при этом получил второе место в проекте «Великие украинцы» уступив первое место Ярославу Мудрому. Выдающийся кардиохирург и инженер-кибернетик, самостоятельно разработавший первый в СССР искусственный клапан. Его именем названы улицы, медицинское училище, колледж, курсирующий в Иваньковском водохранилище катер.

Об этом много написано и в Википедии, и на других сайтах.

Хочу затронуть не так широко освещенную сторону Амосова. Широкий кругозор, два образования (медицинское и инженерное) позволило ему разработать теорию активных семантических нейронных сетей (М-сетей), в рамках которой более 50-ти лет назад были реализованы вещи, которые и на сегодняшний день поражают своей уникальностью.

И если бы в то время были достаточные вычислительные мощности, возможно, сегодня бы уже был реализован сильный ИИ.

В своих работах Амосов сумел выдержать баланс между нейрофизиологией и математикой, изучая и описывая информационные процессы интеллекта. Результаты его работ представлены в нескольких трудах, заключительной была монография «Алгоритмы разума», изданная в 1979 году.

Приведу краткую цитату из нее об одной из моделей:

«…(нами) проводилось исследование, цель которого состояла в том, чтобы изучить возможности М-сетей в области нейрофизиологии и нейропсихологии, а также оценить практическую и познавательную важность таких моделей. Был разработан и исследован М-автомат, моделирующий механизмы речи. В модели представлены такие аспекты устной речи, как восприятие, осмысливание, словесное выражение.

Модель предназначена для воспроизведения относительно простых речевых функций (!!!) — ответов на вопросы ограниченного типа, повторения, называния. Она содержит следующие блоки: слуховых восприятий, сенсорный речевой, проприоцептивный речевой, понятийный, эмоций, мотивационный, двигательный речевой, артикуляторный и блок СУТ. Блоки модели соотнесены с определенными мозговыми образованиями…

… На вход модели подавались буквы русского алфавита, объединенные в слова и фразы, а также специальные объекты, соответствующие образам предметов. На выходе модели, в зависимости от режима ее работы, наблюдались последовательности букв русского алфавита, которые были либо ответами на входные вопросы, либо повторением входных слов, либо названиями предметов.

То обстоятельство, что при создании модели широко использовались данные нейрофизиологии, позволило в экспериментах имитировать ряд поражений мозга органического и функционального характера, приводящих к нарушениям функций речи».

И это лишь одна из работ.

Другая — управление мобильным роботом. “… система управления роботом предполагает осуществление целенаправленного движения с обеспечением собственной безопасности (объезд препятствий, избегание опасных мест, поддержание внутренних параметров в заданных пределах) и минимизацию временных и энергетических затрат”.

Также, в монографии описаны результаты моделирования свободного поведения “некоего субъекта в среде, которая содержала полезные и опасные для него объекты. Мотивы поведения субъекта определялись ощущениями усталости, голода и стремлением к самосохранению. Субъект изучал среду, выбирал цель движения, строил план достижения этой цели и затем реализовал его, выполняя действия-шаги, сравнивая результаты, получаемые в ходе движения, с запланированными, дополняя и корректируя план в зависимости от складывающихся ситуаций”.

В своих работах Амосов предпринял попытку создать информационно/алгоритмическую модель как мы сейчас говорим “сильного интеллекта” и на мой взгляд, его теория наиболее близко описывает то, что реально происходит в мозге млекопитающих.

Основными особенностями М-сетей, кардинально отличающие их от других нейросетевых парадигм является строгая семантическая нагрузка каждого нейрона и наличие системы внутренней оценки своего состояния. Есть нейроны-рецепторы, нейроны-объекты, нейроны-чувства, нейроны-действия.

Обучение происходит по модифицированному правилу Хебба с учетом своего внутреннего состояния. Соответственно и принятие решения происходит на основе понятного распространения активности семантически обозначенных нейронов.

Сеть обучается «на лету», без многократного повторения. Одни и те же механизмы работают с различными видами информации будь то речь или восприятие визуальных данных, двигательная активность. Данная парадигма моделирует как работу сознания, так и подсознания.

Желающие смогут найти книги Амосова с более подробным описанием теории и практических реализаций различных аспектов интеллекта, я же расскажу про наш опыт построения визуальной поисковой системы Quintura Search.

Компания Quintura была создана в 2005-м году. На собственные деньги был реализован прототип десктопного приложения, демонстрирующего наш подход. На ангельские деньги Ратмира Тимашева и Андрея Баронова (позже фонд ABRT) была произведена доработка прототипа, проведены переговоры и получены инвестиции от люксембургского фонда Mangrove Capital Partners. Это была первая западная инвестиция в России в области ИТ. Все три партнера фонда приехали в Сергиев Посад посмотреть нам в глаза и принять решение об инвестировании.

На полученные средства за шесть лет был разработан полный функционал веб-поисковика — сбор информации, индексирование, обработка запросов и выдача результатов. Ядром была М-сеть, точнее множество М-сетей (одна понятийная сеть и сети для каждого документа). Сеть обучалась за один проход по документу. За пару-тройку тактов пересчета выделялись ключевые слова, находились документы совпадающие с запросом по смыслу, строились их аннотации. Сеть понимала контекст запроса, точнее позволяла пользователю уточнить его, добавляя нужные смыслы для поиска и удаляя из выдачи документы, имеющие нерелевантные контексты.

Как было отмечено выше, каждый нейрон сети имеет свою смысловую нагрузку. Для иллюстрации патентов, нами была предложена визуальная картинка (прошу извинить за качество – оригиналы картинок не сохранились, здесь и далее использованы картинки со сканов наших патентов и из статей о нас с различных сайтов):

Упрощенно, понятийная сеть представляет собой набор нейронов-понятий связанных друг с другом связями, пропорционально частоте встречаемости их друг с другом. Когда пользователь вводит слово запроса, мы «вытягиваем» нейрон(нейроны) этого слова, а он, в свою очередь, тянет за собой связанные с ним. И чем сильнее связь, тем ближе будут к нейрону запроса другие нейроны.

Если слов в запросе несколько, то и «вытягивать» за собой будет все нейроны, соответствующие словам запроса.

Если же мы решим удалить нерелевантное слово, мы как бы вешаем на него груз, тянущий вниз как удаляемое понятие, так и связанные с ним.

В результате мы получаем облако тегов, где слова запроса находятся наверху (самый крупный шрифт), а связанные понятия располагаются рядом, чем больше связь, тем крупнее шрифт.

Ниже смысловая карта документов, найденных по запросу «beauty».

При наведении мыши на слово «fashion» карта перестраивается:

Если перевести указатель мыши на слово «travel», получим другую карту:

Таким образом, мы можем уточнять запрос указывая нужное нам направление, формировать нужный нам контекст.

Одновременно с перестраиванием карты мы получаем и документы, которые наиболее релевантны заданному контексту, а ненужные ветки мы исключаем, удаляя нерелевантные слова.

Индекс документов мы строим по следующему принципу:

Существует 4 слоя нейронов. Слой слов, слой понятий (их можно объединить в один слой), слой предложений, слой документов.

Нейроны могут быть связаны между собой двумя типами связей – усиливающими и тормозными. Соответственно каждый нейрон может быть в трех типах состояний активном, нейтральном и подавленном. По усиливающим связям нейроны передают активность по сети, тормозными «якорят». Слой понятий полезен для работы с синонимами, а также выделения «сильных» или значимых понятий над остальными, определения категорий документа.

Например, слово Apple в слое слов будет связано с понятиями фрукта, анатомического термина и компании. Oil – с нефтью и маслом. Русское слово “коса” с прической, орудием труда, оружием, рельефом. И т.п.

Связи мы устанавливаем двунаправленные – как прямые, так и обратные. Обучение (изменения связей) происходит за один проход по документу на основе правила Хебба – мы увеличиваем связи между словами, располагающимися близко друг к другу, также, дополнительно связываем меньшими связями слова, находящиеся в одном предложении, абзаце, документе. Чем чаще слова встречаются рядом как в пределах одного документа, так и группы документов, тем больше становится связь между ними.

Данная архитектура позволяет эффективно решать следующие задачи:

Рассмотрим реализацию каждой задачи.

Этот кейс был проиллюстрирован ранее. Пользователь вводит слова запроса, эти слова возбуждают все связанные с ними, далее, мы можем либо выделить ближайшие понятия (имеющие максимальное возбуждение), либо и дальше передаем возбуждение по сети уже от всех возбужденных на предыдущем шаге нейронов и так далее – в этом случае начинают работать ассоциации. На карту выводятся некоторое количество самых возбужденных слов/понятий (также можно выбирать что показывать – слой слов, понятий, либо оба). При необходимости нерелевантные слова удаляются (удаляя с карты связанные с ними понятиями), тем самым производится точное описание требуемого поискового контекста.

Состояние первых двух слоев сети на этом шаге передают свое возбуждение на следующие слои, нейроны которых ранжируются по возбужденности и мы получаем список документов, ранжированных по релевантности не просто словам запроса, а сформированному контексту.

Таким образом, в выдачу попадут не только документы содержащие слова запроса но и связанные с ними по смыслу. Полученные документы можно использовать для изменения поискового контекста либо усиливая понятия, содержащиеся в «нужных» нам документах, либо понижая вес понятий, связанных с нерелевантными документам. Так можно легко и интуитивно уточнять запрос и управлять поисковой выдачей.

Передача возбуждения в обратную сторону, от нейронов-документов к нейронам понятиям/словам позволяет получить наглядную карту того, какие смысловые контексты присутствуют в наборе документов. Это альтернативный способ получения смысловой карты тегов и навигации в пространстве смыслов. Данный процесс можно выполнять итеративно меняя направление возбуждения – получая документы по поисковым контекстам, либо изменяя поисковый контекст по активным документам.

Обычно, сценарий работы поисковика следующий – начальная карта формируется либо на основе последних новостей, популярных статей, запросов или их комбинации. Далее пользователь может либо начать формировать запрос кликая на слова с карты, либо создав новый запрос введя интересующие его слова в поле ввода.

В нашем детском сервисе Quintura Kids могли работать и искать нужную информацию даже не умеющие писать дети (или имеющие затруднения с этим).

Так выглядела начальная карта

А это пользователь видел после клика на слово «Космос».

Детский сервис был построен на вручную отобранных и допущенных сайтах, поэтому ничего взрослого ребенок увидеть не мог. Этим объясняется и небольшое количество найденных документов. Англоязычная версия содержала в разы большее количество документов — спасибо детскому каталогу Yahoo.

Собственно те слова и понятия, которые становятся активными при передачи возбуждения от слоя документов или слоя предложений и являются ключевыми словами. Они также ранжируются по активности, далее от них отрезается определенное количество, которое и отображается.

Тут мы применили еще одно решение. Считаем, что суммарное возбуждение всех слов или понятий равно 100%. Тогда мы можем легко управлять количеством слов, которые будем считать ключевыми задавая процент активности в качестве порога.

Например, представим, что есть документ, в котором рассматривается контракт с хедлайнером Боинга. При передаче возбуждения от нейрона этого документа к слою слов/понятий возбудились слова, представленные на этом рисунке. Взвешенное суммарное возбуждение, приведенное к 100%, дало нам индивидуальный вес каждому слову. И если мы хотим получить 75% «смысла» ключевых слов, то мы увидим слова «BOEING», «787», «DREAMLINER», а если захотим увидеть 85% «смысла», то к этим словам добавиться еще и «SALES».

Этот способ позволяет автоматически ограничивать количество отображаемых ключевых слов и предложений/документов.

Получение сниппетов также осуществлялось вышеописанным способом. Сначала мы получаем ключевые слова документа, после чего прямым распространением возбуждения от ключевых слов получаем список предложений, приводим веса этих предложений к 100% и обрезаем требуемое количество «смысла», после чего отображаем эти предложения в той последовательности, в которой они встретились в тексте документа.

Передача возбуждения от нейрона, соответствующего документу для которого мы ищем похожие по смыслу к слою слов/понятий и после этого в обратную сторону к слою документов позволяет нам находить документы, похожие первоначальному по контексту или смыслу. Если мы сделаем несколько тактов передачи возбуждения в слое слов/понятий, мы можем расширить первоначальный контекст. В данном случае мы можем найти документы, которые не содержат точного совпадения по всем словам, но совпадают по теме.

На самом деле, данный механизм можно использовать для определения похожести чего угодно, например, добавив к сети слой где нейронам будет соответствовать идентификатор пользователя, мы можем находить людей, имеющих схожие интересы. Заменив слой предложений и документов на индексы музыкальных или видео произведений получим поиск музыки/видео.

В данной статье раскрыты лишь базовые принципы визуальной поисковой системы Quintura. За шесть лет жизни Компании было решено множество сложных задач, как связанных с архитектурой активных семантических нейросетей, так и в построении отказоустойчивого, расширяемого кластера. Поисковый индекс состоял из множества нейросетей, работающих параллельно, результат работы этих сетей объединялся, строилась индивидуальная карта интересов пользователя.

В рамках проекта был реализован сервис поиска по сайту, детский поисковик, инструмент для анализа текстов, начаты работы по формированию информационной онтологии мира, построению нейросетевой морфологии, получены 9 патентов США.

Однако, мы так и не смогли монетизировать нашу систему. На тот момент бума нейросетей еще не было, договориться с крупными поисковиками нам не удалось (как нам сказал архитектор одного из них – “у нас слишком разные парадигмы и мы не понимаем как их объединить”).

Проект пришлось закрыть.

Лично у меня так и осталась «недосказанность» — есть огромное желание дать вторую жизнь данному проекту. Информация о том, что бывший глава рекламы Google создает поисковик без рекламы, где пользователи смогут «вырваться из пузыря фильтров персонализации контента и инструментов слежения», лишь укрепляет мою уверенность в актуальности наших разработок.

Еще раз перечислю особенности активных нейронных сетей, построенных на основе теории Николая Амосова:

Надеюсь, данная статья станет первым шагом в открытии реализованных технологий для широкой общественности разработчиков и послужит началом opensource проекта активных семантических нейросетей Амосова.

Речь пойдет о визуальном поисковике, получившим первые западные венчурные инвестиции в области ИТ в России, построенном на основе активных семантических нейронных сетях. Под катом мы расскажем об его основных принципах работы и архитектуре.

Истоки

Мне крупно повезло в жизни – я учился у Николая Михайловича Амосова, выдающегося человека, кардиохирурга и кибернетика. Учился заочно — развал СССР не дал мне возможности встретиться лично.

О Николае Михайловиче можно говорить много, родился в крестьянской семье в деревеньке под Череповцом и при этом получил второе место в проекте «Великие украинцы» уступив первое место Ярославу Мудрому. Выдающийся кардиохирург и инженер-кибернетик, самостоятельно разработавший первый в СССР искусственный клапан. Его именем названы улицы, медицинское училище, колледж, курсирующий в Иваньковском водохранилище катер.

Об этом много написано и в Википедии, и на других сайтах.

Хочу затронуть не так широко освещенную сторону Амосова. Широкий кругозор, два образования (медицинское и инженерное) позволило ему разработать теорию активных семантических нейронных сетей (М-сетей), в рамках которой более 50-ти лет назад были реализованы вещи, которые и на сегодняшний день поражают своей уникальностью.

И если бы в то время были достаточные вычислительные мощности, возможно, сегодня бы уже был реализован сильный ИИ.

В своих работах Амосов сумел выдержать баланс между нейрофизиологией и математикой, изучая и описывая информационные процессы интеллекта. Результаты его работ представлены в нескольких трудах, заключительной была монография «Алгоритмы разума», изданная в 1979 году.

Приведу краткую цитату из нее об одной из моделей:

«…(нами) проводилось исследование, цель которого состояла в том, чтобы изучить возможности М-сетей в области нейрофизиологии и нейропсихологии, а также оценить практическую и познавательную важность таких моделей. Был разработан и исследован М-автомат, моделирующий механизмы речи. В модели представлены такие аспекты устной речи, как восприятие, осмысливание, словесное выражение.

Модель предназначена для воспроизведения относительно простых речевых функций (!!!) — ответов на вопросы ограниченного типа, повторения, называния. Она содержит следующие блоки: слуховых восприятий, сенсорный речевой, проприоцептивный речевой, понятийный, эмоций, мотивационный, двигательный речевой, артикуляторный и блок СУТ. Блоки модели соотнесены с определенными мозговыми образованиями…

… На вход модели подавались буквы русского алфавита, объединенные в слова и фразы, а также специальные объекты, соответствующие образам предметов. На выходе модели, в зависимости от режима ее работы, наблюдались последовательности букв русского алфавита, которые были либо ответами на входные вопросы, либо повторением входных слов, либо названиями предметов.

То обстоятельство, что при создании модели широко использовались данные нейрофизиологии, позволило в экспериментах имитировать ряд поражений мозга органического и функционального характера, приводящих к нарушениям функций речи».

И это лишь одна из работ.

Другая — управление мобильным роботом. “… система управления роботом предполагает осуществление целенаправленного движения с обеспечением собственной безопасности (объезд препятствий, избегание опасных мест, поддержание внутренних параметров в заданных пределах) и минимизацию временных и энергетических затрат”.

Также, в монографии описаны результаты моделирования свободного поведения “некоего субъекта в среде, которая содержала полезные и опасные для него объекты. Мотивы поведения субъекта определялись ощущениями усталости, голода и стремлением к самосохранению. Субъект изучал среду, выбирал цель движения, строил план достижения этой цели и затем реализовал его, выполняя действия-шаги, сравнивая результаты, получаемые в ходе движения, с запланированными, дополняя и корректируя план в зависимости от складывающихся ситуаций”.

Особенности теории

В своих работах Амосов предпринял попытку создать информационно/алгоритмическую модель как мы сейчас говорим “сильного интеллекта” и на мой взгляд, его теория наиболее близко описывает то, что реально происходит в мозге млекопитающих.

Основными особенностями М-сетей, кардинально отличающие их от других нейросетевых парадигм является строгая семантическая нагрузка каждого нейрона и наличие системы внутренней оценки своего состояния. Есть нейроны-рецепторы, нейроны-объекты, нейроны-чувства, нейроны-действия.

Обучение происходит по модифицированному правилу Хебба с учетом своего внутреннего состояния. Соответственно и принятие решения происходит на основе понятного распространения активности семантически обозначенных нейронов.

Сеть обучается «на лету», без многократного повторения. Одни и те же механизмы работают с различными видами информации будь то речь или восприятие визуальных данных, двигательная активность. Данная парадигма моделирует как работу сознания, так и подсознания.

Желающие смогут найти книги Амосова с более подробным описанием теории и практических реализаций различных аспектов интеллекта, я же расскажу про наш опыт построения визуальной поисковой системы Quintura Search.

Quintura

Компания Quintura была создана в 2005-м году. На собственные деньги был реализован прототип десктопного приложения, демонстрирующего наш подход. На ангельские деньги Ратмира Тимашева и Андрея Баронова (позже фонд ABRT) была произведена доработка прототипа, проведены переговоры и получены инвестиции от люксембургского фонда Mangrove Capital Partners. Это была первая западная инвестиция в России в области ИТ. Все три партнера фонда приехали в Сергиев Посад посмотреть нам в глаза и принять решение об инвестировании.

На полученные средства за шесть лет был разработан полный функционал веб-поисковика — сбор информации, индексирование, обработка запросов и выдача результатов. Ядром была М-сеть, точнее множество М-сетей (одна понятийная сеть и сети для каждого документа). Сеть обучалась за один проход по документу. За пару-тройку тактов пересчета выделялись ключевые слова, находились документы совпадающие с запросом по смыслу, строились их аннотации. Сеть понимала контекст запроса, точнее позволяла пользователю уточнить его, добавляя нужные смыслы для поиска и удаляя из выдачи документы, имеющие нерелевантные контексты.

Основные принципы и подходы

Как было отмечено выше, каждый нейрон сети имеет свою смысловую нагрузку. Для иллюстрации патентов, нами была предложена визуальная картинка (прошу извинить за качество – оригиналы картинок не сохранились, здесь и далее использованы картинки со сканов наших патентов и из статей о нас с различных сайтов):

Упрощенно, понятийная сеть представляет собой набор нейронов-понятий связанных друг с другом связями, пропорционально частоте встречаемости их друг с другом. Когда пользователь вводит слово запроса, мы «вытягиваем» нейрон(нейроны) этого слова, а он, в свою очередь, тянет за собой связанные с ним. И чем сильнее связь, тем ближе будут к нейрону запроса другие нейроны.

Если слов в запросе несколько, то и «вытягивать» за собой будет все нейроны, соответствующие словам запроса.

Если же мы решим удалить нерелевантное слово, мы как бы вешаем на него груз, тянущий вниз как удаляемое понятие, так и связанные с ним.

В результате мы получаем облако тегов, где слова запроса находятся наверху (самый крупный шрифт), а связанные понятия располагаются рядом, чем больше связь, тем крупнее шрифт.

Ниже смысловая карта документов, найденных по запросу «beauty».

При наведении мыши на слово «fashion» карта перестраивается:

Если перевести указатель мыши на слово «travel», получим другую карту:

Таким образом, мы можем уточнять запрос указывая нужное нам направление, формировать нужный нам контекст.

Одновременно с перестраиванием карты мы получаем и документы, которые наиболее релевантны заданному контексту, а ненужные ветки мы исключаем, удаляя нерелевантные слова.

Индекс документов мы строим по следующему принципу:

Существует 4 слоя нейронов. Слой слов, слой понятий (их можно объединить в один слой), слой предложений, слой документов.

Нейроны могут быть связаны между собой двумя типами связей – усиливающими и тормозными. Соответственно каждый нейрон может быть в трех типах состояний активном, нейтральном и подавленном. По усиливающим связям нейроны передают активность по сети, тормозными «якорят». Слой понятий полезен для работы с синонимами, а также выделения «сильных» или значимых понятий над остальными, определения категорий документа.

Например, слово Apple в слое слов будет связано с понятиями фрукта, анатомического термина и компании. Oil – с нефтью и маслом. Русское слово “коса” с прической, орудием труда, оружием, рельефом. И т.п.

Связи мы устанавливаем двунаправленные – как прямые, так и обратные. Обучение (изменения связей) происходит за один проход по документу на основе правила Хебба – мы увеличиваем связи между словами, располагающимися близко друг к другу, также, дополнительно связываем меньшими связями слова, находящиеся в одном предложении, абзаце, документе. Чем чаще слова встречаются рядом как в пределах одного документа, так и группы документов, тем больше становится связь между ними.

Данная архитектура позволяет эффективно решать следующие задачи:

- задание и управление поисковым контекстом;

- поиск документов, соответствующих поисковому контексту (не только содержащих слов запроса);

- отображение смысловые контексты набора документов (какие ассоциации у поисковика со словами запроса);

- выделение ключевых слов документа/документов;

- аннотирование документа;

- поиск похожих по смыслам документов.

Рассмотрим реализацию каждой задачи.

Задание и управление поисковым контекстом

Этот кейс был проиллюстрирован ранее. Пользователь вводит слова запроса, эти слова возбуждают все связанные с ними, далее, мы можем либо выделить ближайшие понятия (имеющие максимальное возбуждение), либо и дальше передаем возбуждение по сети уже от всех возбужденных на предыдущем шаге нейронов и так далее – в этом случае начинают работать ассоциации. На карту выводятся некоторое количество самых возбужденных слов/понятий (также можно выбирать что показывать – слой слов, понятий, либо оба). При необходимости нерелевантные слова удаляются (удаляя с карты связанные с ними понятиями), тем самым производится точное описание требуемого поискового контекста.

Поиск документов, соответствующих поисковому контексту

Состояние первых двух слоев сети на этом шаге передают свое возбуждение на следующие слои, нейроны которых ранжируются по возбужденности и мы получаем список документов, ранжированных по релевантности не просто словам запроса, а сформированному контексту.

Таким образом, в выдачу попадут не только документы содержащие слова запроса но и связанные с ними по смыслу. Полученные документы можно использовать для изменения поискового контекста либо усиливая понятия, содержащиеся в «нужных» нам документах, либо понижая вес понятий, связанных с нерелевантными документам. Так можно легко и интуитивно уточнять запрос и управлять поисковой выдачей.

Отображение смысловых контекстов набора документов

Передача возбуждения в обратную сторону, от нейронов-документов к нейронам понятиям/словам позволяет получить наглядную карту того, какие смысловые контексты присутствуют в наборе документов. Это альтернативный способ получения смысловой карты тегов и навигации в пространстве смыслов. Данный процесс можно выполнять итеративно меняя направление возбуждения – получая документы по поисковым контекстам, либо изменяя поисковый контекст по активным документам.

Обычно, сценарий работы поисковика следующий – начальная карта формируется либо на основе последних новостей, популярных статей, запросов или их комбинации. Далее пользователь может либо начать формировать запрос кликая на слова с карты, либо создав новый запрос введя интересующие его слова в поле ввода.

В нашем детском сервисе Quintura Kids могли работать и искать нужную информацию даже не умеющие писать дети (или имеющие затруднения с этим).

Так выглядела начальная карта

А это пользователь видел после клика на слово «Космос».

Детский сервис был построен на вручную отобранных и допущенных сайтах, поэтому ничего взрослого ребенок увидеть не мог. Этим объясняется и небольшое количество найденных документов. Англоязычная версия содержала в разы большее количество документов — спасибо детскому каталогу Yahoo.

Выделение ключевых слов документа/документов

Собственно те слова и понятия, которые становятся активными при передачи возбуждения от слоя документов или слоя предложений и являются ключевыми словами. Они также ранжируются по активности, далее от них отрезается определенное количество, которое и отображается.

Тут мы применили еще одно решение. Считаем, что суммарное возбуждение всех слов или понятий равно 100%. Тогда мы можем легко управлять количеством слов, которые будем считать ключевыми задавая процент активности в качестве порога.

Например, представим, что есть документ, в котором рассматривается контракт с хедлайнером Боинга. При передаче возбуждения от нейрона этого документа к слою слов/понятий возбудились слова, представленные на этом рисунке. Взвешенное суммарное возбуждение, приведенное к 100%, дало нам индивидуальный вес каждому слову. И если мы хотим получить 75% «смысла» ключевых слов, то мы увидим слова «BOEING», «787», «DREAMLINER», а если захотим увидеть 85% «смысла», то к этим словам добавиться еще и «SALES».

Этот способ позволяет автоматически ограничивать количество отображаемых ключевых слов и предложений/документов.

Аннотирование документа.

Получение сниппетов также осуществлялось вышеописанным способом. Сначала мы получаем ключевые слова документа, после чего прямым распространением возбуждения от ключевых слов получаем список предложений, приводим веса этих предложений к 100% и обрезаем требуемое количество «смысла», после чего отображаем эти предложения в той последовательности, в которой они встретились в тексте документа.

Поиск похожих по смыслу документов

Передача возбуждения от нейрона, соответствующего документу для которого мы ищем похожие по смыслу к слою слов/понятий и после этого в обратную сторону к слою документов позволяет нам находить документы, похожие первоначальному по контексту или смыслу. Если мы сделаем несколько тактов передачи возбуждения в слое слов/понятий, мы можем расширить первоначальный контекст. В данном случае мы можем найти документы, которые не содержат точного совпадения по всем словам, но совпадают по теме.

На самом деле, данный механизм можно использовать для определения похожести чего угодно, например, добавив к сети слой где нейронам будет соответствовать идентификатор пользователя, мы можем находить людей, имеющих схожие интересы. Заменив слой предложений и документов на индексы музыкальных или видео произведений получим поиск музыки/видео.

Продолжение следует

В данной статье раскрыты лишь базовые принципы визуальной поисковой системы Quintura. За шесть лет жизни Компании было решено множество сложных задач, как связанных с архитектурой активных семантических нейросетей, так и в построении отказоустойчивого, расширяемого кластера. Поисковый индекс состоял из множества нейросетей, работающих параллельно, результат работы этих сетей объединялся, строилась индивидуальная карта интересов пользователя.

В рамках проекта был реализован сервис поиска по сайту, детский поисковик, инструмент для анализа текстов, начаты работы по формированию информационной онтологии мира, построению нейросетевой морфологии, получены 9 патентов США.

Однако, мы так и не смогли монетизировать нашу систему. На тот момент бума нейросетей еще не было, договориться с крупными поисковиками нам не удалось (как нам сказал архитектор одного из них – “у нас слишком разные парадигмы и мы не понимаем как их объединить”).

Проект пришлось закрыть.

Лично у меня так и осталась «недосказанность» — есть огромное желание дать вторую жизнь данному проекту. Информация о том, что бывший глава рекламы Google создает поисковик без рекламы, где пользователи смогут «вырваться из пузыря фильтров персонализации контента и инструментов слежения», лишь укрепляет мою уверенность в актуальности наших разработок.

Еще раз перечислю особенности активных нейронных сетей, построенных на основе теории Николая Амосова:

- обучение на лету;

- добавление новых сущностей без необходимости переобучения всей сети;

- четкая семантика – понятно почему сеть приняла то или иное решение;

- единая архитектура сети для различных областей применения;

- простая архитектура, как следствие — высокое быстродействие.

Надеюсь, данная статья станет первым шагом в открытии реализованных технологий для широкой общественности разработчиков и послужит началом opensource проекта активных семантических нейросетей Амосова.

VDG

Семантическая сеть, близость слов и т.д. — это всё давно в мозгах поисковых движков. По собственному опыту могу сказать, что такой ответ бывает и в случае «мы втихую работаем над аналогичным собственным проектом».

Вот про опенсорс. После того как рассказали о применённых решениях, наверно стоит упомянуть здесь те из них, которые другим разработчикам теперь применять нельзя из-за закрытия вашими патентами.

Ustas Автор

На самом деле почти так и было. Амосов обратился в ЦК КПСС с предложением использовать свой аппарат для моделирования социальных процессов в обществе и предварительной оценки политических и социальных решений, после чего попал в опалу. Ему пришлось использовать весь свой авторитет (в том числе международный), чтобы сохранить деятельность лаборатории ИИ.

У меня неоднозначное отношение к патентам. Желающих их нарушить не остановить.

Патенты действуют на территории США, остальной мир может использовать описанные идеи свободно. Кроме того, добавление изменений в реализацию описанных идей обеспечит соблюдение авторских прав.

Наверное, могут возникнуть сложности с визуальными картами запроса и точным повторением архитектуры нейросети (но это будет сложно доказать).

В сети есть сравнение облака Quintura с Google Wonder Wheel, появившемся позднее и в настоящий момент закрытым.

При закрытии все патенты были куплены американским патентным брокером и, по слухам, использованы против Google в составе большого пакета.

VDG

Слой Objects и связи с ним, я так понимаю, формировали вручную?

Ustas Автор

Точное повторение того, что описано в патентах не нужно. Базовые принципы патентами закрыты быть не могут, так как описаны в открытых публикациях. А будет ли это 4-х слойная сеть или другая — вопрос архитектуры.

Я писал, что у меня сложное отношение к патентам. С точки зрения развития мысли они крайне-полезны, но обойти их не нарушая всегда можно, тем более, если речь идет об алгоритмах.

Все верно. В рамках Quintura формировали вручную.

Есть понимание, как делать это автоматически на основе «осмысления» текстов и аналогий. Также, как это происходит у человека. Ведь подтверждение «умозаключений» при обучении человеку также необходимо. Сначала чаще, позже реже.

VDG

А что из себя представляют нейроны в слое sentences? Отдельные предложения из документов, или нечто более абстрактное?

Ustas Автор

Да, просто индекс предложения. На основе этого слоя получали аннтотации документов.

Мы предполагали добавить слой смыслов или образов, но до этого не дошло.

VDG

Если удалить слой Объектов, будет пирамида из двусвязных слоёв: Слова <-> Предложения <-> Документы. Будет ли в такой конфигурации возможность воспоминания документа по части строки из него?

Ustas Автор

Восстановление документа было реализовано без нейросети. Парсер прогонял текст через модуль морфологии, в результате мы получали индексы слов. Они-то и подавались в сеть. До нейросетевой морфологии мы не дошли .

kapas19

Александр, у меня к вам 2 вопроса:

1.

«Алгоритмы разума» больше идеологическая работа. Более подробная информация о модели М-сетей содержится в более ранней работе команды Н.М. Амосова:

Амосов Н.М., Касаткин А.М., Касаткина Л.М., Талаев С.А. Автоматы и разумное поведение. Опыт моделирования (Киев: Наукова думка, 1973)

Встречались ли вы с какой-либо более детальной информацией о реализации этой модели? Может быть вы знаете: сохранились ли исходники?

2. В вашей модели явно присутствует семантическая сеть. Непонятно, а в чем ее связь с нейросетями? Вес связи между нейронами-«понятиями»?

Ustas Автор

1. По ряду причин (опала, отсутствие вычислительных мощностей и, как следствие, возможности реализации практических задач), Амосов мог заниматься больше теорией, чем практикой. «Алгоритмы разума», на мой взгляд, подводили итог нейросетевого этапа в жизни Николая Михайловича. Теория была разработана но условий для ее практической реализации не было.

Лаборатория Амосова переключилась на попытку разработки аппаратного нейрокомпьютера на основе стохастических нейронных сетей.

Серьезного результата получить не удалось, последовал развал Союза и эмиграция части лаборатории за рубеж. Фактически школа прекратила свое существование. Сейчас уже нет и института кибернетики им. Глушкова, в котором существовала лаборатория Амосова.

Основные материалы лаборатории издавались единичными экземплярами. Программы писались под существующие компьютеры, на перфокартах. Сомневаюсь, что удастся их разыскать.

Нейросетью считают любую модель, построенную по принципу биологических нейронных сетей. В этом плане сети Амосова на порядок ближе к биологическим, чем популярные сейчас модели. Мне кажется главное свойство, которое объединяет различные парадигмы — параллельная работа множества однотипных элементов. Законы, по которым происходит эта работа и отличают различные парадигмы. Правила формирования и изменения связей, количество одновременно работающих элементов, семантика, интерпретация результатов — это все аттрибуты нейронной сети, а не только вес связи между нейронами-«понятиями».

kapas19

1.

Результаты (и я думаю достаточно интересные на тот момент: например, угадываются некоторые элементы RL) были опубликованы в той работе, ссылку на которую я давал в своем предыдущем сообщении.

По сути в «Алгоритмах разума» излагается та же самая концепция что и более ранних работах. К слову: «Автоматы и разумное поведение...» с моей точки зрения намного более содержательная работа — это по своей сути — отчет о НИР.

Мне показалось что работы были остановлены задолго до этого…

Программы командой Амосова были написаны на Algol:

«Подпрограммы были написаны на входном языке транслятора АЛГОЛ-БЭСМ. Рабочая программа содержит около 11000 команд ЦВМ БЭСМ-6.»

Было бы интересно попытаться воспроизвести результаты команды Амосова.

Конечно программа вводилась с перфокарт, но могли остаться листинги… Да прошло уже немало — полсотни — лет.

2.

Не факт…

Ustas Автор

Цель повторения результатов Амосова была основной в написании этой статьи. Листинги не так важны — формулы и алгоритмы хорошо описаны в «Автоматах». Полезнее было бы полное описание нейронов в информационных блоках.

kapas19

С моей точки зрения, многого недостает…

«Нейрончики» — стандартные? Это как раз стало бы понятно из эталонной реализации.

Ustas Автор

Первую реализацию программ на PC делали на нашей кафедре. Нейроны стандартные. Отличаются лишь семантической нагрузкой. Группируются в блоки (рецепторный, эффекторный, блок чувств и т.п.), в пределах блоков алгоритм работы стандартный, отличается значениями некоторых параметров. Цель архитектора системы сформировать правильное начальное состояние сети, в том числе вручную задав начальные связи. И чем полнее будет описана первоначальная сеть, тем ближе она будет к реальному мозгу.

Ustas Автор

Согласен, в ней подробно рассмотрены несколько примеров реализации. Но более полно мысли про сильный ИИ все-таки описаны в «Алгоритмах разума».

Теория фактически не менялась Амосовым с «Алгоритмов разума». Дальнейшие работы в области стохастических нейрокомпьютеров велись сотрудниками лаборатории вплоть до начала 90-х.

Это ведь не предмет веры?

Аргументы в пользу М-сетей:

В глубоких сетях можно найти аналогию с сетчаткой глаза и зрительными зонами мозга, но как-то с натягом.

kapas19

А это что такое?

Вот именно.

Этого как раз в природной НС не обнаруживается. Есть не только микроколонки (что характерно для коры полушарий).

Они вводятся «руками»?

Каким образом? Я не о теоретических соображениях Амосова, а о модели…

Тут как раз много вопросов к тому как это было реализовано в программе.

Не факт…

Эту аналогию можно обнаружить для сверточных сетей (CNN). Но аналогия очень близкая. А вот LSTM

По моему мнению: модель Амосова направлена на моделирование компонент психики, контролирующих поведение. Может быть я ошибаюсь. Складывается впечатление что его модель близка к обучению с подкреплением (RL).

Ustas Автор

Идея была в том, чтобы использовать для нейросетей устройство, построенное на основе простых логических элементах (те самые К155ЛА3 и ЛЕ1) — то что было под рукой. Для перемножения возбуждения на вес связи требовалось решить вопрос логического умножения. В стохастических нейросетях значение величин кодировалось вероятностью возникновения единицы в каждом разряде (при 0% — получаем все 0, при 100% все единицы, при 50% в байте будут 4 единицы в случайных разрядах). Было доказано, что при логическом сложении таких величин фактически происходит операция умножения. Были произведены отдельные модули, но полностью работы завершены не были.

Природа доказывает обратное. При рождении человек пользуется старым мозгом, а позднее, практически все функции переходят в новую кору. На хабре есть статья на эту тему. Также это хорошо описано Джеффом Хокинсом в работе «Об интеллекте».

Да, структура мозга задается вручную, экспертом. Также как в живом мире определяется генетикой.

С помощью механизма Системы Усиления-Торможения. В «Алгоритмах Разума» об этом пишут на страницах 109-121.

VDG

Если мы некую величину закодируем в случайный набор из 10 бит и затем логически сложим (бинарное ИЛИ) две такие величины, то получим максимум 20 единичных бит, что соответствует математическому сложению величин, но не умножению.

Ustas Автор

Описался — операция логическое «И». В данном случае при равномерном распределении на большом количестве битов пересечение будет соответствовать умножению. В обеспечении равномерного распределения и возникли основные трудности. Но было предположение, что точного умножения для работоспособности не требуется.

VDG

Может быть где-то есть рабочий пример или подробное описание?

Ustas Автор

Поищу.

Я был в стороне этого проекта — больше как наблюдатель. По моему мнению, проект был обречен изначально. Он возник от безысходности — нужны были вычислительные мощности, а персональные компьютеры появились значительно позднее.

VDG

Думаю, я понял, почему умножение давало более разряженный выход чем вход. Просто величины брались из «нормализованного» диапазона [0, 1].

Если оно действительно работало, то в таком случае живой нейрон (дендритное дерево или его сегмент) общее входное возбуждение умножает на вес. Первая величина — входное возбуждение, вторая — синаптическая «карта» дерева (вес). Сам никогда ранее не смотрел на это с такой точки зрения, и у других не встречал.

VDG

Восстановил алгоритм по описанию. Действительно работает. Точность задаётся длиной генерируемой стохастической бинарной последовательности.

length = 1000a = 0.7 : 0.7060

b = 0.4 : 0.3840

a * b = 0.2800 : 0.2850 (err 0.0175)

kapas19

Алексей, т.е. вы полагаете, что некий нейрон такого рода умеет «умножать»? Или, то о чем вы говорите, имеет другой смысл?

VDG

Давно известно, что пара синапсов образуют синаптический кластер, когда они расположены рядом друг с другом. Синхронная активация этих синапсов запускает дендритную волну, волна в свою очередь приводит к спайку нейрона. То есть, кластер работает как логический элемент И для двух «каналов». У нейрона кластеров огромное количество (в N раз больше числа синапсов).

На вход синапсов кластера поступают спайки от других нейронов, что по сути есть — бинарные последовательности разной степени разряженности. Складывая их по И, и генерируя спайк на вход в состоянии «1,1», нейрон тем самым производит собственную последовательность спайков, разряженность которой соответствует перемножению разряженностей входных последовательностей.

Так как перемножение происходит для всех таких пар входов массово и одновременно, то результирующая выходная последовательность нейрона — это сумма всех умножений: «out(t)= n0(t) * n5(t) + n3(t) * n201(t) + n2(t) * n15(t) ...».

kapas19

Красиво…

Это последовательность спайков на аксоне?

Вопрос в том как она потом «декодируется» на постсинаптических нейронах?

VDG

Да. Вот наглядный пример (сгенерированный из кода выше), где последовательность спайков на аксоне соответствует произведению 0,7 * 0,4.

IN1 = 0,7

|_||||_|||||__||__||__||_||__||||||___||_|||_||_|||||_||||||||_|_|||_|||||||||__||||||_||||||__||__|

IN2 = 0,4

__|___||________|_|_|_|__||_______||_||__|_____||_|_|_____|__|__|_|||||||__|___|_|||_|_______|__|___

OUT = 0,28

__|____|__________|___|__||_______|___|__|______|_|_|_____|__|____||_||||__|_____|||_|__________|___

Собственно, эта формула и есть «декодирование» нейрона, — то, чем он и занимается. И вопрос в том, как из таких элементов (нейронов) строятся вычисления.

И в формуле не указал ещё одно слагаемое (по бинарному ИЛИ). Это смещение (или дополнение), которое формируют разрозненные спайки, не попадающие в кластеры. По одному они не способны привести к спайку, каждый из них вносит незначительный вклад в смещение потенциала мембраны, поэтому необходимо по «классической схеме» взять их сумму и сравнить с заданным пороговым значением. При превышении порога формируется спайк.

При этом, как уже писал, это смещение от разрозненных спайков также можно рассматривать как умножение входной активности со всех нейронов на «коэффициент/карту дендрита». Ровно та же картинка, что привёл выше, но строки теперь — это не последовательности спайков, а спайки всех нейронов в один момент времени и синапсы выходного нейрона.

Одномоментная активность всех входных нейронов (70 из 100)

|_||||_|||||__||__||__||_||__||||||___||_|||_||_|||||_||||||||_|_|||_|||||||||__||||||_||||||__||__|

Синапсы выходного нейрона (40 синапсов из 100 возможных)

__^___^^________^_^_^_^__^^_______^^_^^__^_____^^_^_^_____^__^__^_^^^^^^^__^___^_^^^_^_______^__^___

Взвешенный синапсами вход (28 активных синапсов из 100)

__*____*__________*___*__**_______*___*__*______*_*_*_____*__*____**_****__*_____***_*__________*___

После нормализации получаем тоже самое вычисление 0,7 * 0,4 = 0,28. Только производимое не в последовательной форме, а в параллельной.

kapas19

Хорошо.

Попробую, поставить вопрос по другому. Рассмотрим 3 сценария:

1. Классика жанра:

1.1. Не единственный нейрон, а сеть (слой) выдает: «вероятно нечто принадлежит следующим классам 1, 12, 32, ...»

1.2. сеть (слой): «в этом обнаружены след. особенности»

2. «Мультипликативный» (стохастический) нейрон:

2.1. выполнение операции; выдается последовательность спайков на аксоне (или корне дендритного дерева).

2.2. на синаптическом кластере постсинаптического нейрона (далее для простоты забудем про дендритное дерево) к которой подходит синаптическое окончание возбужденного «мультипликативного» нейрона (п. 2.1): для первого подошедшего спайка из указанной последовательности в момент времени t0 --> выполняется операция 2.1 на постсинаптическом нейроне. В момент tk походит k-ый спайк --> выполняется операция 2.1 на постсинаптическом нейроне. Далее работает сеть нейронов (слой) или все дендритное дерево по сценарию 1. И т.д.

Это картинка для одного того же рецептора (рецептивного кластера) на одном и том же постсинаптическом нейроне (в одном и том же месте). Наверно, это сценарий о которой вы говорите. Он достаточно реалистичный.

3. Возможен ли по вашему мнению следующий сценарий (декодирование, демультиплексирование)? Это то что подразумевается под «временным суммированием».

3.1. «Мультипликативный» (стохастический) нейрон выполнят операцию «умножения»; выдается последовательность спайков на аксоне.

3.2. На рецепторе постсинтаптического нейрона «накапливается», учитывается вся пришедшая (под)последовательность s0,...,sn, сгенерированная пресинаптическим нейроном (3.1) в интервале времени от t0 до tn — (прямое задание значения веса, загрузка «данных» в нейрон). Далее вырабатывается какой-то отклик от рецептора (кластера) — спайк или что-то другое (например: перестройка самого рецептивного кластера/поля).

Как то так -(. Сразу скажу: я не сторонник 3-го сценария. Но все же…

Мне кажется что такой подход — «мультипликативный» (стохастический) нейрон — может дать возможность по другому реализовывать модели Хопфилда и АРТ Гроссберга…

Осилит дорогу идущий.

kapas19

Данные нейрогистологии как раз указывает на существование различных типов организации нейронных ансамблей: различная нейронная организация в коре, ретикулярной формации, мозжечке и др. тканях головного мозга. О типологии нейронов даже близко не стоит говорить — в нервной системе обнаруживаются сотни и даже тысячи разных типов нейронов.

Мне кажется, нельзя упрощать, сводить все возможное разнообразие типов организации и функционирования нервной системы к какой-либо одной унифицированной модели (единой топологии). Унифицированное представление удобно для программной реализации. Но даст ли такой подход желаемый результат – большой вопрос.

Может быть, я вас не понял. Тогда, можете пояснить, в каком смысле вы используете оборот единая топология?

А между блоками? А набор самих функциональных блоков? – тоже генетика?

Это вопрос вашей веры (не подкрепленного достаточным количеством фактов утверждения) или доказанный факт?

Морфология — да, механизмы взаимодействия клеток, пластичность связей — да, интеграция отдельных «функциональных блоков» — да, но не организация конкретных межнейронных связей (скорее всего, за исключением нейронных ансамблей в сенсорных анализаторах).

Гипотеза Амосова интересна, красива и на нее можно опираться. Однако, если все так хорошо, почему нет результата – работающий ИР?

Ustas Автор

Все правильно поняли. Амосов в своих работах моделировал различные сферы деятельности мозга на одних и тех же структурах. В своих исследованиях он старался понять информационную (алгоритмическую) сторону процессов мозга. Ведь для того, чтобы перемножить величину возбуждения на проходимость связи не требуется моделировать передачу нейромедиаторов в синапсе. В этом и состоит баланс между нейрофизиологией и математикой.

Что же касается данных гистологии — да, старый мозг состоит из многих образований, но случай с водянкой

дает основание предположить, что для полноценной деятельности мозга достаточно неокортекса, размер которого напрямую связан в живом мире с интеллектом. Это же подтверждает и Джефф Хокинс на основе данных полученных в ходе изучения мозга основанным им институтом.

Однозначно. А можно предположить что-то еще? Начальное состояние формируется вручную (с использованием данных нейрофизиологии), далее сеть изменяется на основе своей деятельности и внешнего окружения. Очень похоже на то, что мы видим в живой природе. Разве нет?

Использую фразу Амосова — мне трудно предположить что-то иное. Факты того, что для полноценной мозговой деятельности достаточно новой коры есть. Факт, что размер коры напрямую зависит с силой интеллекта (среди видов) тоже трудно оспорить. То, что для начала жизнедеятельности требуется четкая структура отвечающая набором врожденных рефлексов — факт. То, что большинство врожденных рефлексов угасает в процессе развития тоже факт.

Конкретные связи в первоначальном состоянии. Как раз связи ансамблей. В М-сетях каждый нейрон рассматривается как модель ансамбля. Амосов в своих работах разделял уровни на А-сети (моделируют один ансамбль) и М-сети. При этом М-сети являются А-сетями для нейронов высшего уровня.

В то время, когда Амосов разрабатывал свою теорию не было необходимых вычислительных мощностей. Сейчас нет Амосова. Но почему бы не повторить его работу нам?

kapas19

Не соглашусь. Надо понимать какие мат. операции могут соответствовать (допустимы) возбуждению или торможению рецепторов на дендритах или на соме нейрона: это не всегда просто взвешанная сумма. И для этого есть веские основания.

Ustas Автор

И тем не менее — одно дело пытаться разобрать все на уровне молекул и химии, другое — понять информационную составляющую. Какая функция моделируется? В теории Амосова у связи есть много параметров, не только проходимость.

kapas19

Я обращаю на это внимание, поскольку считаю, что необходимо по возможности «оптимизировать» «нейронный уровень». То, что реализуется в настоящее время в ИНС – это путь в пропасть. Сеть, построенная из формальных нейронов, ужасно неэкономна. Естественный нейрон – по сути своей эквивалент небольшой искусственной нейросети (слоя), поскольку, и я в этом уверен: часть обработки выполняется на дендритном дереве естественного нейрона. Отсюда и интерес не к химии и биофизике рецептивных кластеров и протеканию процессов в дендритном дереве или на аксоне, а к обработке информации на отдельных участках природного нейрона (рецептивных кластерах, дендритах, аксоне, коллатералях).

Функциональных актов по Амосову (или функциональных систем по Анохину) разного уровня в психике человека огромное количество (а часть из них вообще временная), поэтому если пойти по пути «ручного» построения для каждой из них своей модели – путь гибельный. Так кол-во функциональных актов, перечисленное в вышедшей в этом году книге «Функциональная модель психики» (Сохацкий Л.В. Функциональная модель психики. Москва: Техносфера, 2020; 688 с.), превышает сотню. Кстати сказать, Амосов выделяет в своих работах только их небольшую часть (с моей точки зрения не самые базовые) и достаточно высокоуровневые. С другой стороны повышение абстракции модели приведет к реализации очередного «чат-бота» или эвристическому программированию – это уже проходили много раз за историю ИИ и продолжают наступать на эти «грабли» в настоящий момент.

А вот настройки высокоуровневых параметров хотелось бы избежать.

VDG

Ustas Автор

Это далеко не единичный случай. Мой знакомый невролог рассказывал про случай из своей практики. У ребенка- третьекласника на томограмме также обнаружили поражение мозга водянкой. При этом мальчик учился хорошо и ничем от сверстников не отличался.

kapas19

Александр, а может ваш знакомый невролог сказать,

1. возможно ли обнаружить на томограмме проекционные волокна (аксоны подкорковые отделы головного мозга из/в коры/кору), видны ли они на ней?

2. были ли томограмме (в знакомом ему случае) видны другие анатомические отделы головного мозга, такие как промежуточный мозг, средний мозг, мозжечок, продолговатый мозг?

Этот случай наводит на мысль о выборе неудачных проекций (срезов) МРТ или сбое в работе аппарата в лучшем случае.

> промежуточный мозг, средний мозг

Их невидно, а без этих отделов головного мозга тот пациент не то, что бы не мог говорить, проявлять свой IQ и т.п. — это был бы обездвиженный, находящийся в реанимации препарат или труп. Поэтому, этот случай скорее всего — фальсификация.

Читал, что проводились эксперименты с бескорковыми животными (кажется с кошками, в частности на это ссылался и Амосов). Это были вполне себе подвижные агрессивные существа.

Кстати, вопрос отн. этого случая, задавался К.В. Анохину на одной из его публичных лекций. Его ответ: сильно сдавленная ликвором кора с сохранением подкорковых структур и всех проводящих путей.

Ustas Автор

Спрошу.

Но опять же предлагаю не отбрасывать то, что не вяжется с привычным пониманием.

Давайте предположим, что это реальный случай.

С информационной точки зрения это логично. И получение информации от рецепторов, и управление эффекторами — все это передача и обработка сигналов. Тогда, при медленном угасании активности пораженных участков мозга, корковые структуры могут перенимать функции пораженных.

В случае же травм, происходит резкое нарушение функций и кора не успевает их перенять.

Могу предположить, что одно из фундаментальных свойств сети — обязательный отклик на распространяющийся сигнал. Если отклика нет, формируются новые связи в «свободных» участках коры.

kapas19

Не соглашусь. Но и подкорковые структуры и связи с корой сохранились у пациента с водянкой — это факт. Другое дело подобными случаями много вопросов (в том числе связанных с клиническими исследованиями таких пациентов — они не дают полноценной картины состояния пациента, его когнитивных способностей и пр. Но это уже другая история…): насколько у таких (и не только у таких) пациентов сохраняются когнитивные способности.

Достаточность новой коры: нейронауки (нейрофизиология, нейрогистология) как раз этого не подтверждают.

Например: необходимо отметить существенную роль ретикулярной формации в поддержании (влияние на) активности коры (отключение сознания, кома, регуляция сна).

Др. примеры: Этологи фиксируют сложное поведение птиц (орудийная деятельность, квазимышление), хотя казалось нейроанатомия коры их мозга не позволяет им этого — строение мозга (в том числе коры) птиц существенно отличается от таковой у млекопитающих (а тем более приматов и человека).

Существенна роль нарушения регуляции подкорковых структур в развитии и протекании психических заболеваний (шизофрения).

Коррелирует. Точные, статистически подтвержденные данные отсутствуют – это факт.

Кроме коры, этим требованиям отвечает ретикулярная формация среднего мозга, а еще в большей степени — кора мозжечка (по количеству нейронов сопоставима с корой больших полушарий, а по плотности нейронов на порядок превосходит ее; хотя нейронный состав проще).

Мощностей не было, зато были отличные идеи и люди.

К глубокому сожалению. Это был великий человек и ученый. И время других выдающихся исследователей таких как Цыпкин Я.З., Галушкин А.И., Ивахненко А.Г., Цетлин М.Л., Бонгард М.М. и мн. других.

Реализовать, «пощупать» эталонную модель очень было бы даже неплохо…

Ustas Автор

Остается вопрос организации процесса создания опенсорс-проекта. Осилит дорогу идущий, конечно. Буду рад сотрудничеству.

buriy

Алгоритмам поиска по ключевым словам наподобие TextRank — сто лет в обед, они в научных статьях переизобретаются каждые несколько лет.

Поэтому ваша часть поста про технологии — это какой-то шаманизм. Вы говорите: «мы (… пообщались с духами и...) нашли секретную теорию из прошлого, на основе которой построили технологию, которая перевернёт мир». А на деле получается — «мы называем всё подряд нейронами, потому что очень хорошо видим аналогии», и ничего нового и коммерчески крутого. (Хотя «крутость» обычно идёт от нахождения успешной модели получения денег, а не успешно проделанной домашней работы по реализации поиска… но что ожидать от стартапа 2005 года? все такими были в 2000х).

Мне кажется, в закрытых коммерческих областях люди часто переоценивают значимость собственных идей — ведь они не знают, что все конкуренты уже давно этими технологиями пользуются (или же даже конкуренты давно отбросили эти технологии как неподходящие по какому-то из параметров: скорость, цена, качество работы, время настройки).

Ustas Автор

Не очень понял в чем вопрос?