Стартовавший в 2011 году проект Facebook под названием Open Compute Project (OCP) предполагает создание открытых стандартов и архитектур оборудования для построения энергоэффективных и экономичных ЦОД. OCP начинался как проект по разработке оборудования для дата-центра Facebook в Прайневилле (штат Орегон). В итоге в Facebook решили сделать архитектуру открытой, включая серверные платы, блоки питания, серверные шасси и стойки. Компания выпустила спецификации OCP с рекомендациями по архитектуре компактных и энергоэффективных стоечных серверов и методам охлаждения.

Под катом мы в деталях рассмотрим из чего состоят эти сервера, как они работают и что это дает.

Open Compute Project появился благодаря техническому директору Facebook Фрэнку Фрэнковски. Именно он запустил инициативу, позволившую отраслевому сообществу не только познакомиться с проектом дата-центра Facebook в Орегоне, но и принять участие в дальнейшем развитии новой архитектуры. Конечная цель – усовершенствовать центры обработки данных, сформировать экосистему, чтобы создавать более эффективные по энергопотреблению и стоимости серверы.

В целом идея напоминает сообщество разработчиков программного обеспечения Open Source, которые создает и совершенствует свои продукты. Проект оказался настолько интересным, что его поддержали крупные компании. OCP насчитывает уже более полутора сотен членов.

Архитектуры серверов и СХД создаются в соответствии со спецификациями OCP Open Rack, охватывающими такие аппаратные компоненты как системные платы и элементы системы электропитания. Проект предполагает также разработку стандартов, в частности, стандартов управления. В прошлом году OCP пополнился новыми членами. Сейчас в Open Compute участвуют IBM, Microsoft, «Яндекс», Box.net и многие другие известные компании.

Если архитектура OCP станет стандартом де-факто для центров обработки данных, это может упростить развертывание систем и управление ими. Но главное – экономия, позволяющая предоставлять клиентам более дешевые сервисы и тем самым выигрывать на высококонкурентном рынке. Цели OCP – увеличение наработки на отказ (MTBF), повышение плотности серверов, простота их обслуживания с доступом из холодного коридора, улучшение энергоэффективности, что особенно важно для компаний, эксплуатирующих тысячи серверов.

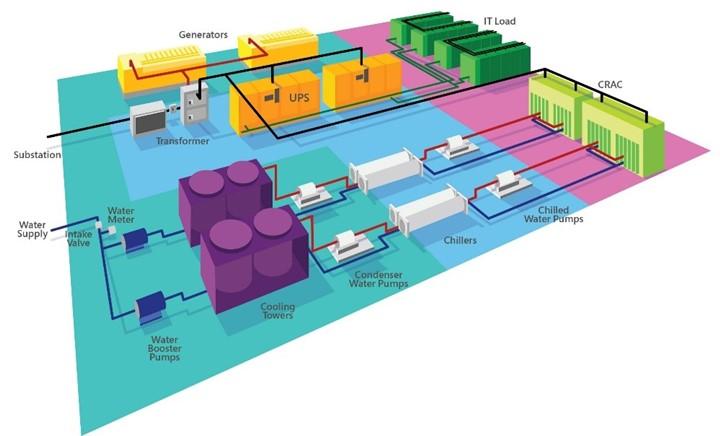

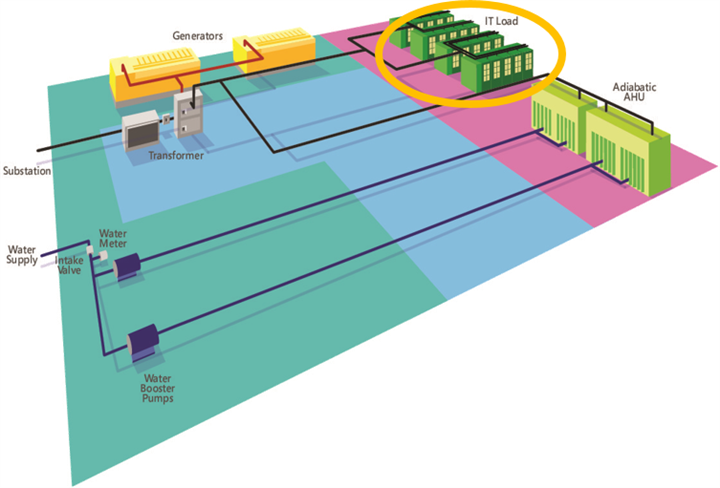

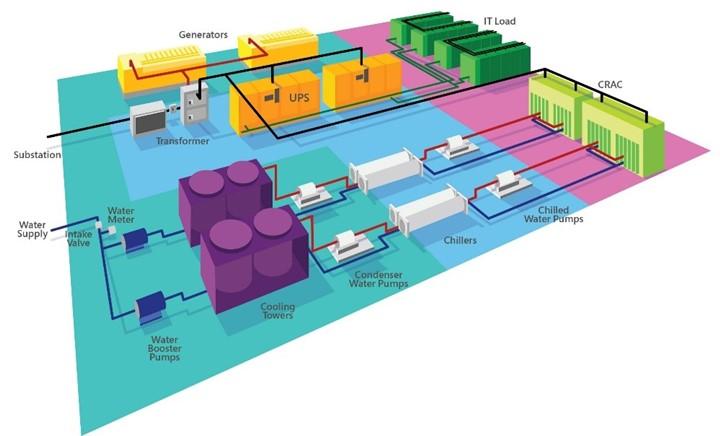

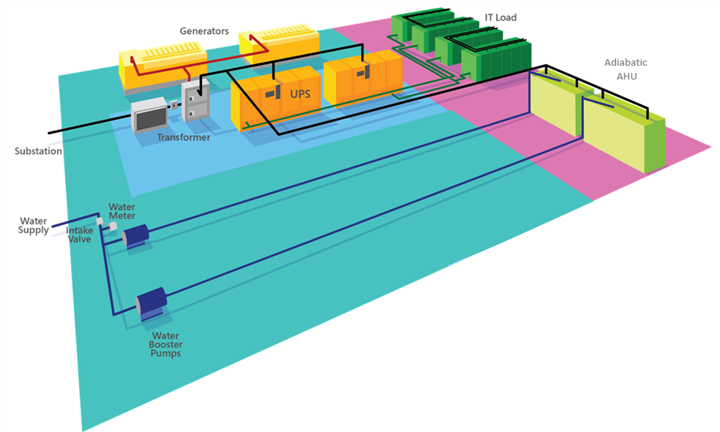

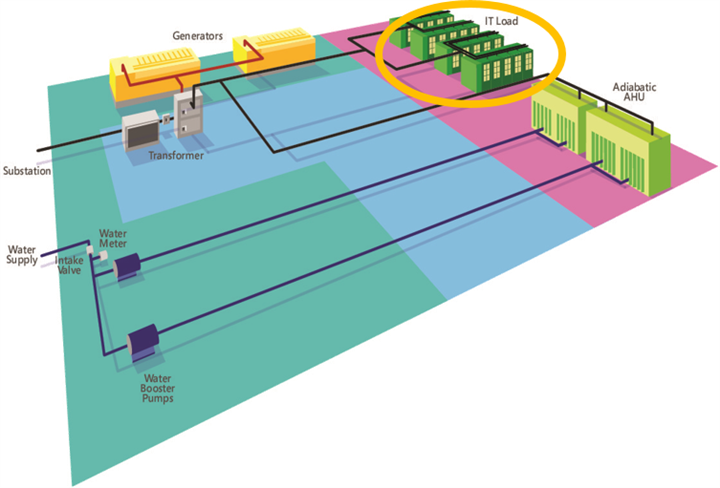

Так, например, ЦОД Facebook в Орегоне потребляет на 38% меньше электроэнергии, чем другие центры обработки данных компании, в нем применяется бесчиллерная адиабатическая система охлаждения, а значение PUE достигло 1,07-1,08 (и это без применения водяного охлаждения), в то время как в среднем по отрасли оно составляет примерно 1,5. При этом капитальные затраты сократились на четверть.

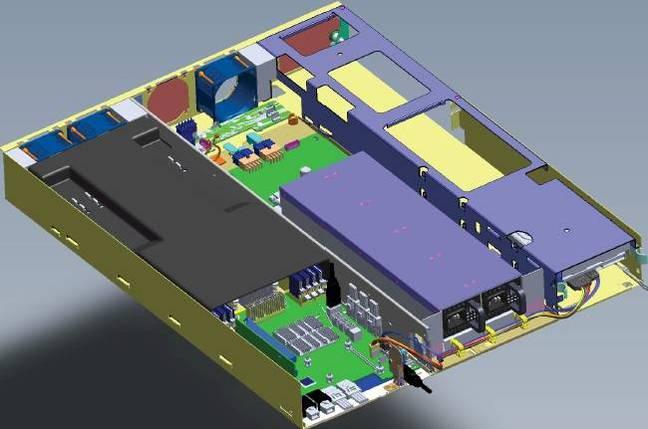

Серверы Open Compute имеют облегченную конструкцию и могут работать при повышенной температуре. Они значительно легче, но крупнее обычного сервера – высота корпуса составляет 1,5U вместо 1U. В них установлены высокие радиаторы и более эффективные вентиляторы. Модульная конструкция сервера Open Compute упрощает доступ ко всем его компонентам – процессорам, дискам, сетевым платам и модулям памяти. Для его обслуживания не требуется инструментов.

К 2014 году спецификации OCP охватывали уже целый пул «открытого» аппаратного обеспечения – от серверов до инфраструктуры дата-центров. Выросло и число компаний, использующих OCP. Как оказалось, многие инновации OCP подходят не только для крупных ЦОДов, но и для использования в решениях для частных/публичных облаков.

В этом году компания Facebook представила еще несколько разработок в рамках проекта OCP. В частности, совместно с Intel идет работа над «сервером на кристалле» Yosemite, а компании Accton и Broadcom участвуют в проекте разработки коммутатора Wedge.

Внедрение созданных в рамках проекта технологий дало Facebook возможность сэкономить за три года более 2 млрд долларов. Однако следует учитывать, что столь весомой экономии удалось добиться и за счет оптимизации программного обеспечения, а для каждого вида приложений было разработано пять типовых платформ.

Сегодня это в основном варианты платформы Facebook Leopard на процессорах Xeon E5. Она стала развитием серверов прежних поколений, таких как выпущенная в 2012 году система Windmill на базе процессоров Intel Sandy Bridge-EP и AMD Opteron 6200/6300.

Одна из проблем серверов Freedom – отсутствие резервного блока питания PSU. Добавление PSU в каждый сервер означало бы увеличение не только CAPEX, но и OPEX, поскольку в режиме active/passive пассивный PSU все равно потребляет электроэнергию.

Логично было сгруппировать блоки питания нескольких серверов в шасси. Это нашло отражение в архитектуре стоек Open Rack v1, где блоки питания расположены на «полках питания» 12,5В DC, питающих «зоны» по 4,2 кВт.

Каждой зоне соответствует своя полка питания (высотой 3OU, OpenUnits, 1OU=48 мм). Блоки питания резервируются по схеме 5+1 и занимают в общей сложности 10OU в стойке. Когда потребляемая мощность мала, часть PSU автоматически отключается, позволяя остальным работать с оптимальной нагрузкой.

Усовершенствования коснулись и системы распределения питания. Здесь нет кабелей питания, которые нужно отключать при каждом обслуживании сервера. Питание подается по вертикальным шинам питания в каждую зону. Когда сервер задвигается в стойку, сзади в него вставляется разъем питания. Отдельный отсек 2OU отводится под коммутаторы.

Спецификации Open Rack предполагают создание стоек высотой 48U, что способствует улучшению циркуляции воздуха в оборудовании и упрощает техническому персоналу доступ к оборудованию. Ширина стойки Open Rack составляет 24 дюйма, но отсек для размещения оборудования имеет ширину 21 дюйм – на 2 дюйма шире обычной стойки. Это позволяет установить в шасси три системных платы или пять дисков 3,5 дюйма.

Для Open Rack v1 потребовалась новая конструкция серверов. Использование шасси Freedom без PSU оставляло много пустого места, и просто заполнить его 3,5" HDD было бы расточительно, да и для большинства нагрузок Facebook столько дисков не требовалось. Было выбрано решение, аналогичное блокам питания. Диски были сгруппированы и вынесены за пределы серверных узлов. Так родилась система хранения данных Knox.

Вообще говоря, OCP Knox – это обычная дисковая полка JBOD, созданная под Open Rack. К ней подключаются HBA соседних серверных узлов Winterfell. От стандартного 19" конструктива она отличается тем, что может вмещать 30 дисковых накопителей 3,5" и очень проста в обслуживании. Для замены диска выдвигается «поднос», открывается соответствующий отсек, диск заменяется, и все задвигается обратно.

Компания Seagate разработала собственную спецификацию «устройства хранения с интерфейсом Ethernet», известную как Seagate Kinetic. Эти накопители представляли собой объектное хранилище, подключаемое непосредственно к сети передачи данных. Было также разработано новое шасси BigFoot Storage Object Open с этими дисками и 12 портами 10GbE в корпусе 2OU.

В Facebook с аналогичной целью создали систему Honey Badger – модификацию Knox для хранения изображений. Она оснащается вычислительными узлами Panther+ на базе Intel Avoton SoC (C2350 и C2750) с четырьмя слотами DDR3 SODIMM и интерфейсами mSATA/M.2 SATA3.

Такая система может работать без головного узла – обычно сервера Winterfell (серверы Leopard компания Facebook с Knox применять не планирует). Несколько модифицированную версию Knox использовали в качестве архивного хранилища. Диски и вентиляторы в ней запускаются только тогда, когда это требуется.

Еще один вариант архивной системы от Facebook с использованием OpenRack вмешает 24 магазина с 36 картриджами-контейнерами, по 12 дисков Blu-ray в каждом. То есть общая емкость достигает 1,26 Пбайт. А хранятся диски Blu-ray до 50 лет и более. Работа системы напоминает музыкальный автомат.

Шасси Freedom без PSU по сути представляет собой просто материнскую плату, вентилятор и диск для загрузки. Инженеры Facebook создали более компактный форм-фактор – Winterfell. Он напоминает сдвоенный серверный узел Supermicro, но на полке ORv1 можно разместить три таких узла. Один узел Winterfell высотой 2OU содержит модифицированную материнскую плату Windmill, разъем шины питания и объединительную панель для подключения к материнской плате кабелей питания и вентиляторов. На материнскую плату можно установить полноразмерную карту x16 PCIe и карту x8 половинного размера, а также мезонинную карту сетевого интерфейса x8 PCIe. Загрузочный диск подключается по SATA или mSATA.

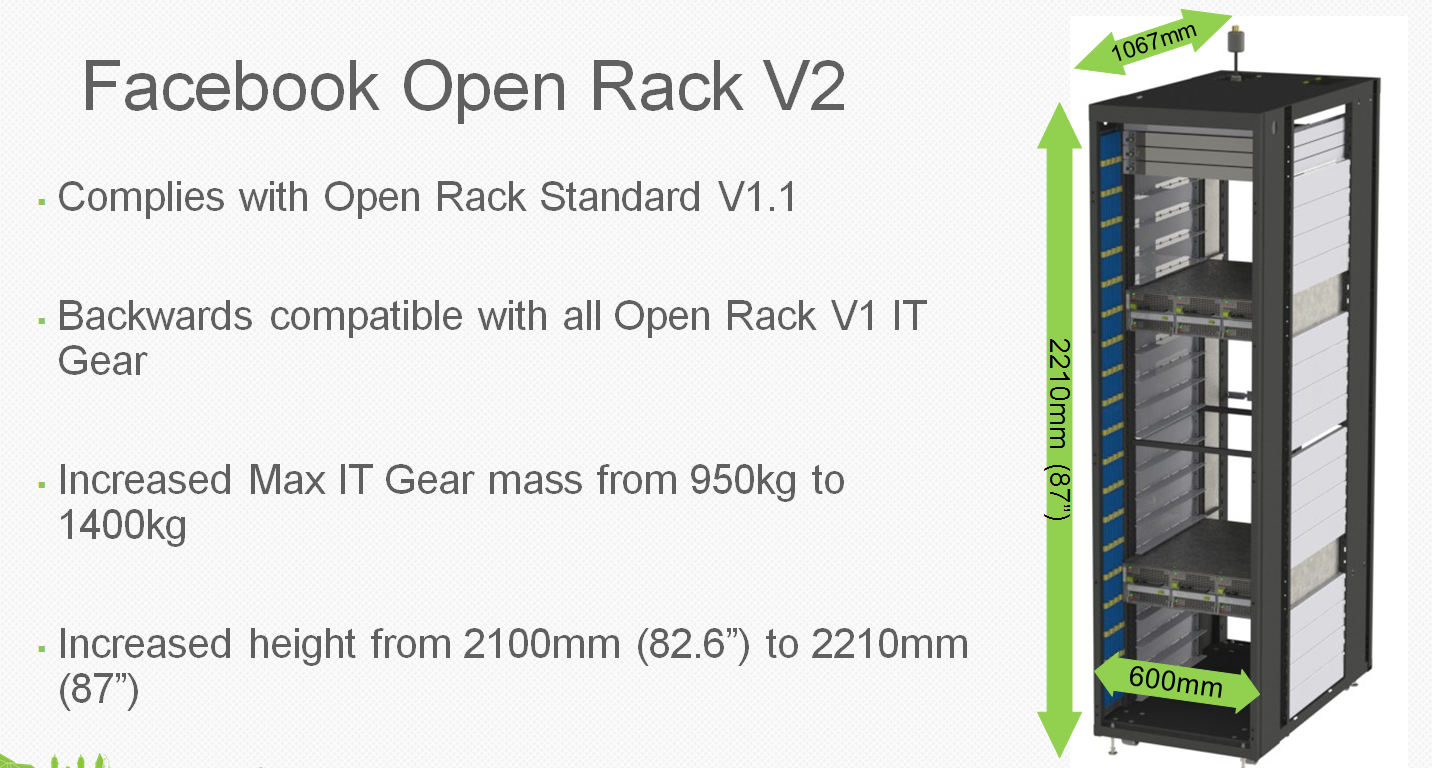

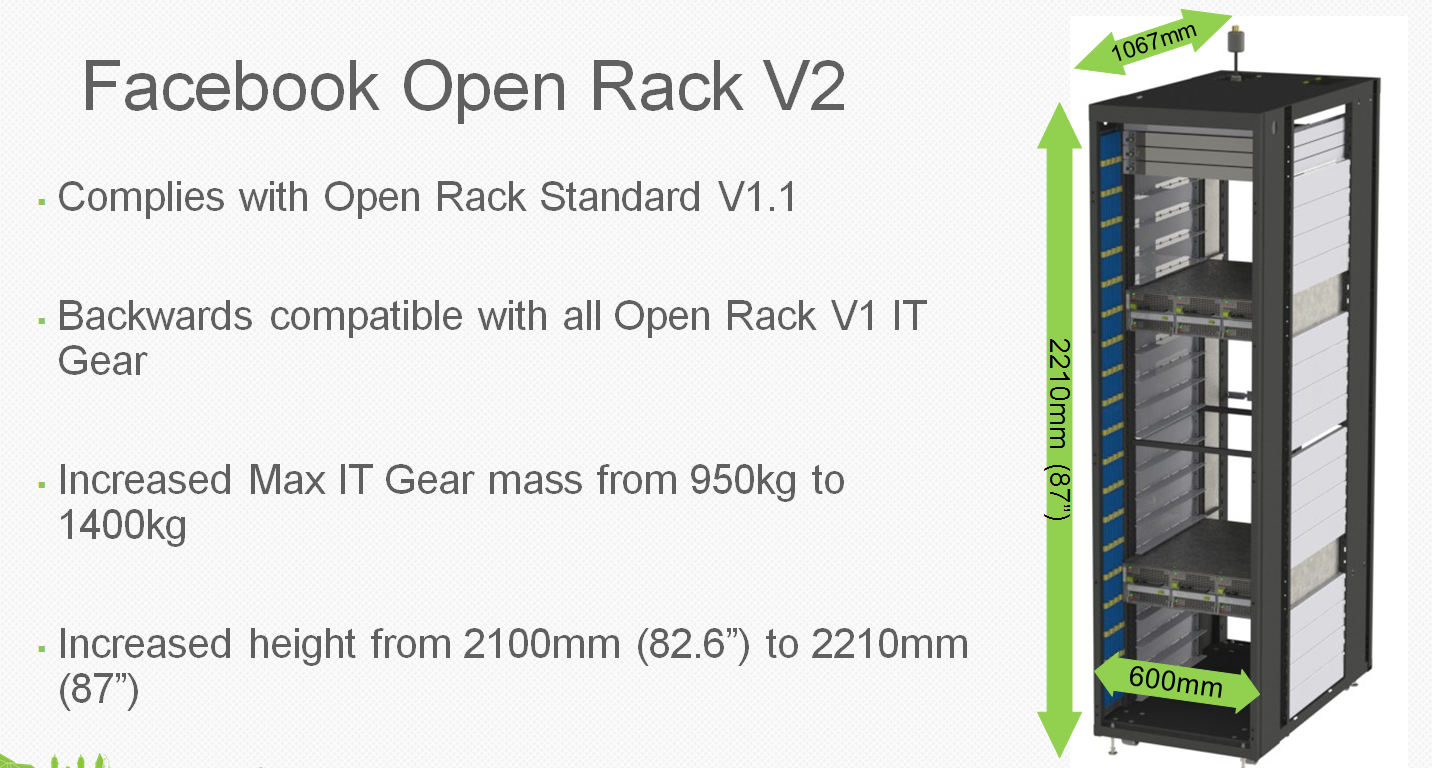

В процессе развертывания ORv1 стало ясно, что три зоны питания с тремя шинами каждая избыточны – столько питания просто не требуется. Появилась новая версия – Open Rack v2 с двумя зонами питания вместо трех и одной шиной на каждую зону. А высота отсека для коммутаторов выросла до 3OU.

Изменения в питании привели к несовместимости с Winterfell, поэтому появился новый проект – Project Cubby. На самом деле Cubby – некое подобие шасси Supermicro TwinServer, но вместо двух встроенных в серверный модуль PSU используется шина питания. В данной конструкции применятся три блока питания (2+1) 3,3 кВт на зону питания вместо шести. Каждая зона питания обеспечивает мощность 6,3 кВт. Нижняя часть стойки может содержать три батареи – Battery Backup Units (BBU) на случай отказов в системе электропитания.

Итак, Leopard. Это новейшее обновление Windmill с чипсетом Intel C226 и поддержкой до двух процессоров E5-2600v3 Haswell Xeon.

Увеличенные радиаторы ЦП и хороший обдув позволяют применять процессоры с термопакетом до 145 Вт, то есть все семейство Xeon, исключая 160-ваттный E5-2687W v3. Каждому процессору доступны 8 каналов DIMM, и DDR4 позволяет в перспективе применять модули памяти по 128 Гбайт, что даст до 2 Тбайт ОЗУ – для Facebook более чем достаточно. Можно также использовать модули NVDIMM (флэш-память в форм-факторе DIMM) и Facebook тестирует такой вариант.

Среди других изменений – отсутствие внешнего коннектора PCIe, поддержка мезонинной карты с двумя QSFP+, слот mSATA/M.2 для накопителей SATA/NVMe и на 8 больше линий PCIe для дополнительной карты – всего их теперь 24. Разъема SAS нет – Leopard не используется как головной узел для Knox.

Важное дополнение – контроллер управления (Baseboard Management Controller, BMC). Это контроллер Aspeed AST1250 с доступом по IPMI и Serial Over Lan. BMC позволяет удаленно обновлять CPLD, VR, BMC и прошивку UEFI. Предусмотрен также контроль питания для управления нагрузкой PSU.

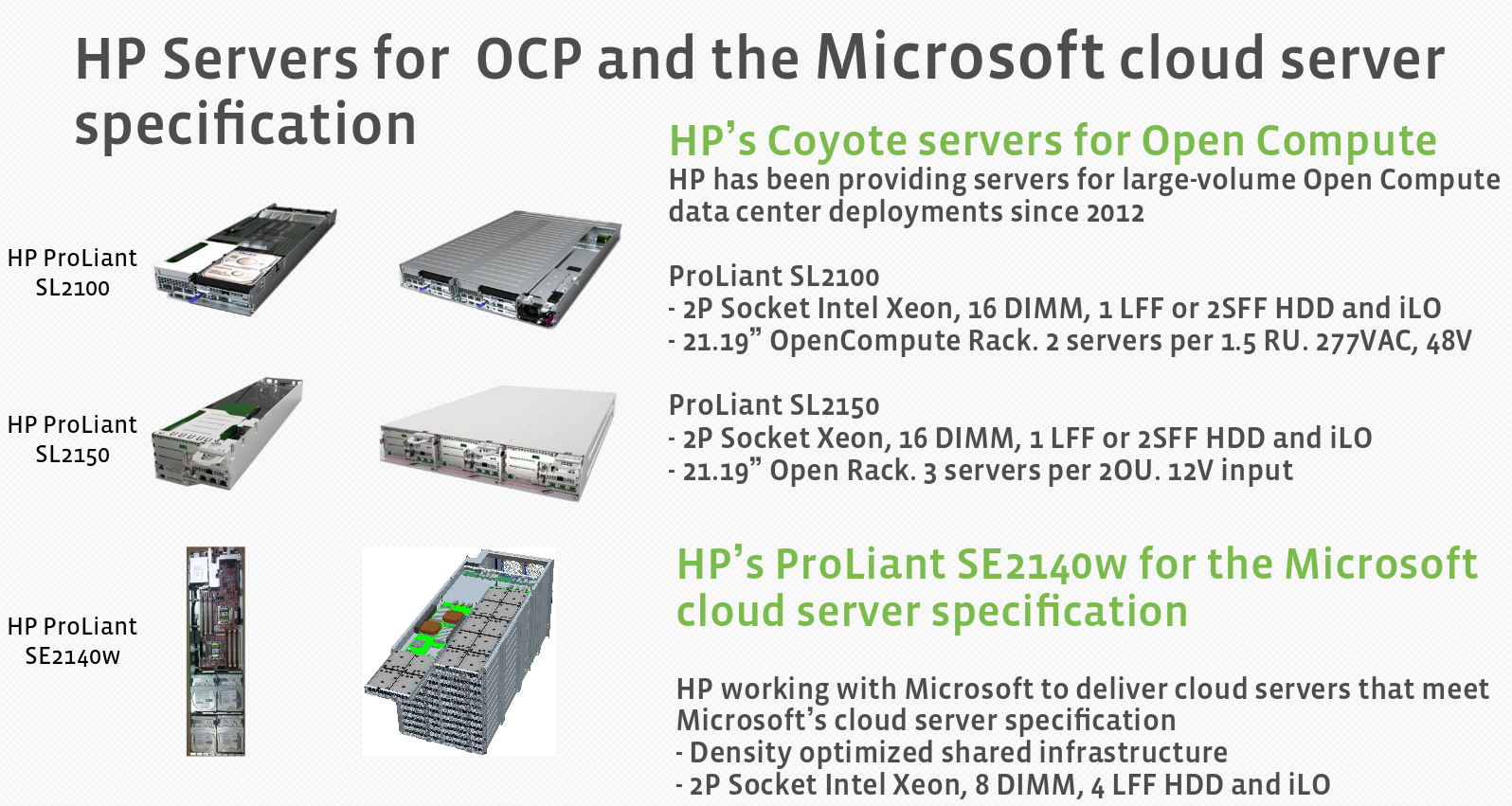

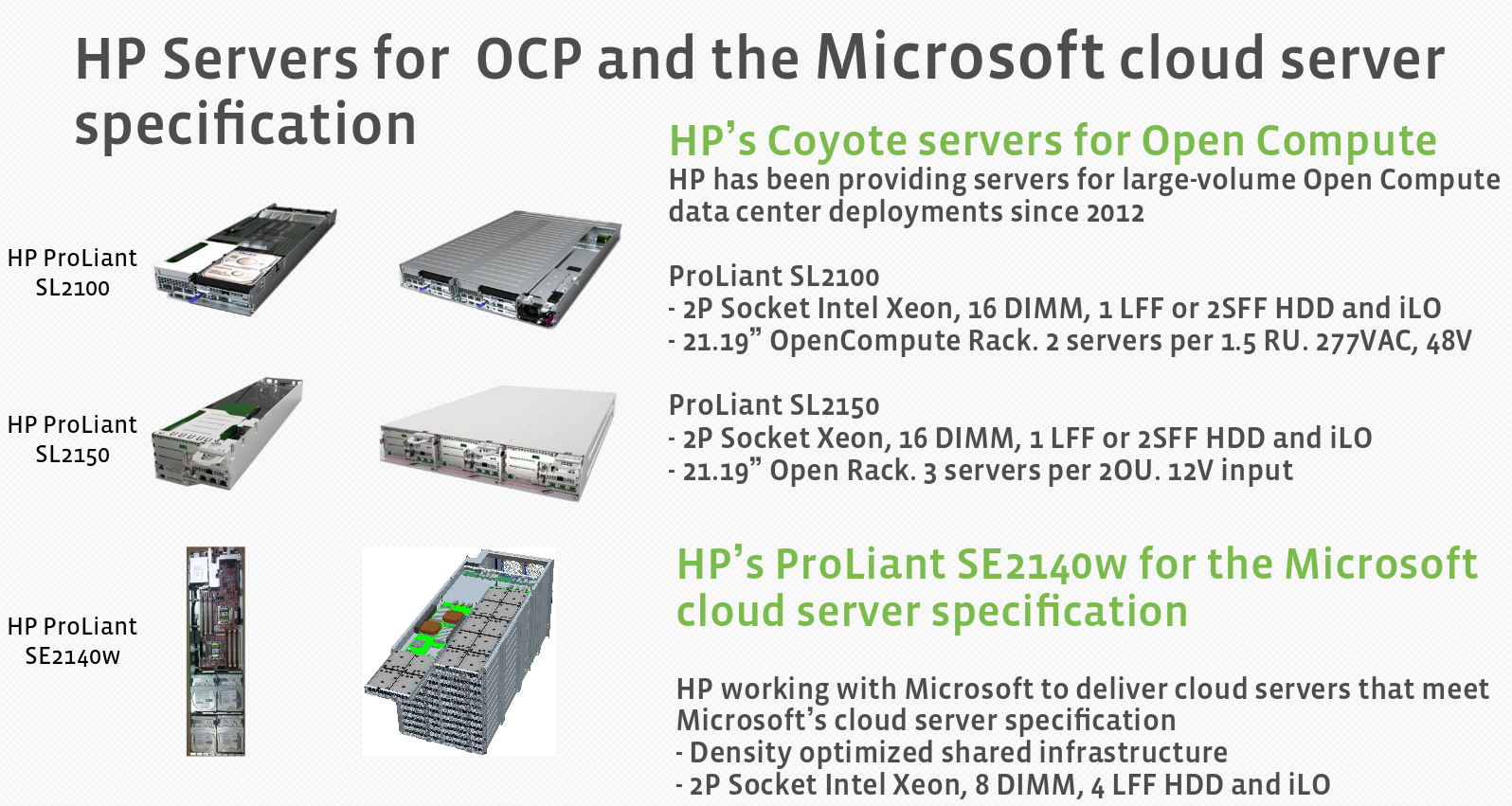

Оборудование OCP обычно изготавливается под заказ. Но есть и «розничные» версии Leopard. Производители предлагают свои модификации. В числе примеров – «облачные» серверы Quanta QCT и системы WiWynn с увеличенным числом дисков. HP, Microsoft и Dell тоже не остались в стороне.

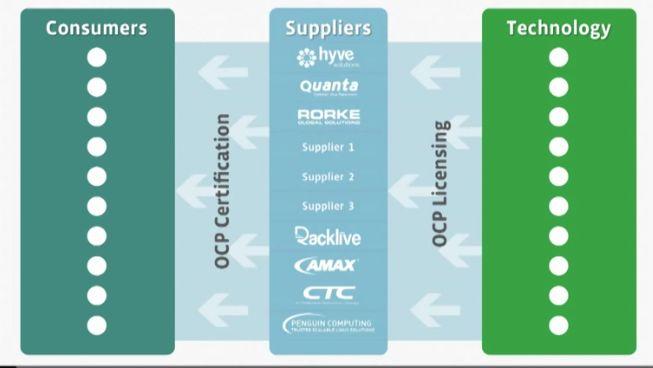

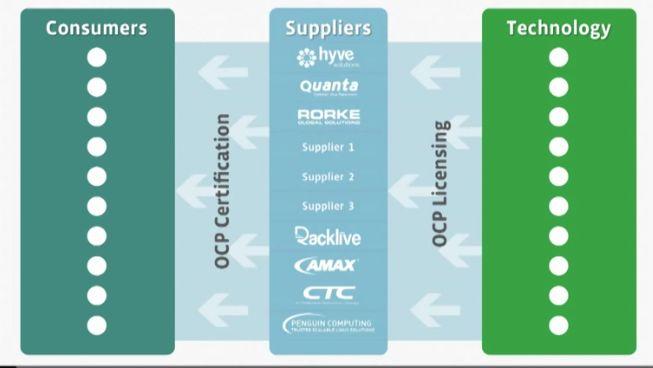

С увеличением числа поставщиков оборудования Open Compute появилась необходимость убедиться в корректности следования ими принятым спецификациям. Появились две сертификации – OCP Ready и OCP Certified. Первая означает, что оборудование соответствует спецификациям и может работать в среде OCP. Вторую присваивают специальные тестирующие организации. Таких всего две – в University Of Texas at San Antonio (UTSA) в США и в Industrial Technology Research Institute (ITRI) на Тайване. Первыми вендорами, сертифицировавшими свое оборудование, стали WiWynn и Quanta QCT.

Инновации OCP постепенно внедряются в ЦОДах и стандартизируются, становятся доступными для широкого круга заказчиков.

Открытые технологии позволяют предлагать заказчикам любую комбинацию вычислительных узлов, систем хранения и коммутаторов в стойке, использовать готовые или собственные компоненты. При этом нет жесткой привязки к системам коммутации — можно применять коммутаторы любого вендора.

Microsoft представила детальные спецификации своих серверов Open Compute и даже раскрыла исходный код программного обеспечения управления инфраструктурой с функциями серверной диагностики, мониторинга охлаждения и электропитания. Она внесла свой вклад в OCP, разработав архитектуру Open Cloud Server. Эти серверы оптимизированы для работы с Windows Server и построены в соответствии с высокими требованиями к доступности, масштабируемости и эффективности, которые предъявляет облачная платформа Windows Azure.

По данным Microsoft, стоимость сервера снижена почти на 40%, энергоэффективность выросла на 15%, а развертывать инфраструктуру можно на 50% быстрее.

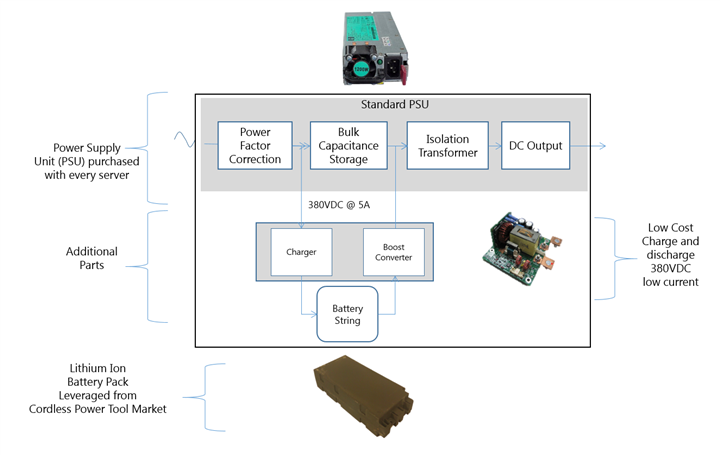

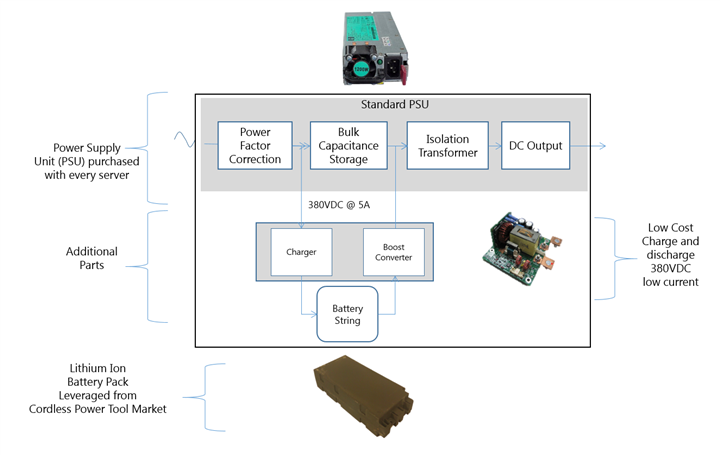

На форуме Open Compute Project (OCP) Summit в США Microsoft показала еще одну интересную разработку – технологию распределенных ИБП под названием Local Energy Storage (LES). Она представляет собой комбинацию модуля питания и батареи, совместимую с шасси Open CloudServer (OCS) v2. Новые модули LES взаимозаменяемы с прежними PSU. В зависимости от топологии ЦОДа и требований к резервированию питания можно выбирать, какой тип PSU использовать. Обычно ИБП размещают в отдельном помещении, а для резервного питания ИТ-оборудования в них используются свинцовые аккумуляторные батареи. По ряду причин такое решение неэффективно. Заняты большие площади, теряется энергия из-за преобразований AC/AC и AC/DC (постоянный/переменный ток). Двойное преобразование и зарядка аккумуляторов увеличивает PUE дата-центра до 17%. Снижается надежность, растут операционные расходы.

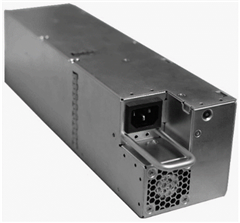

На форуме Open Compute Project (OCP) Summit в США Microsoft показала еще одну интересную разработку – технологию распределенных ИБП под названием Local Energy Storage (LES). Она представляет собой комбинацию модуля питания и батареи, совместимую с шасси Open CloudServer (OCS) v2. Новые модули LES взаимозаменяемы с прежними PSU. В зависимости от топологии ЦОДа и требований к резервированию питания можно выбирать, какой тип PSU использовать. Обычно ИБП размещают в отдельном помещении, а для резервного питания ИТ-оборудования в них используются свинцовые аккумуляторные батареи. По ряду причин такое решение неэффективно. Заняты большие площади, теряется энергия из-за преобразований AC/AC и AC/DC (постоянный/переменный ток). Двойное преобразование и зарядка аккумуляторов увеличивает PUE дата-центра до 17%. Снижается надежность, растут операционные расходы.

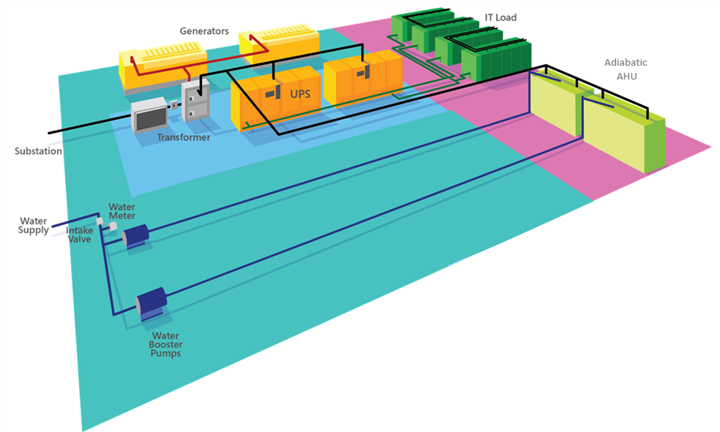

Переход на адиабатическое охлаждение может привести к снижению затрат и упростить операции.

Но как усовершенствовать систему распределения питания и ИБП? Можно ли здесь все радикально упростить? В Microsoft решили отказаться от отдельного помещения для ИБП и перенести модули питания ближе к ИТ-нагрузке, заодно интегрировав батарейную систему с управлением ИТ. Так появилась LES.

В топологии LES изменена конструкция PSU – добавлены такие компоненты как батареи, контроллер управления батареями, низковольтное зарядное устройство.

Батареи используются литиево-ионные, как и в электротранспорте. Таким образом, разработчики LES взяли стандартные элементы PSU, обычные батареи и соединили их в одном модуле. Что это дает? По данным Microsoft:

Инновации Open Compute Project меняют рынок ЦОДов и облачных сервисов, стандартизируют и удешевляют разработку серверных решений. Это лишь один из многочисленных примеров. В следующей серии материалов вы познакомитесь с другими интересными решениями.

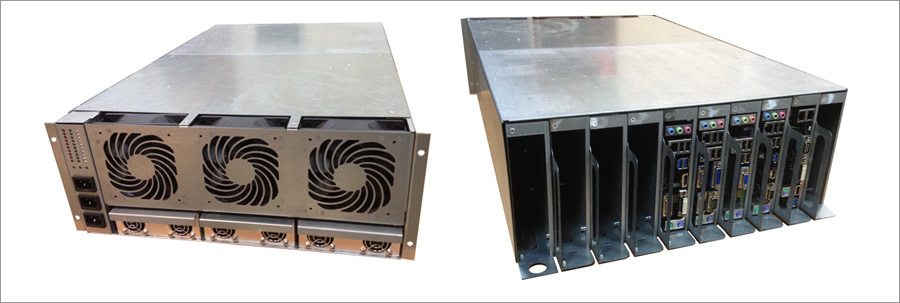

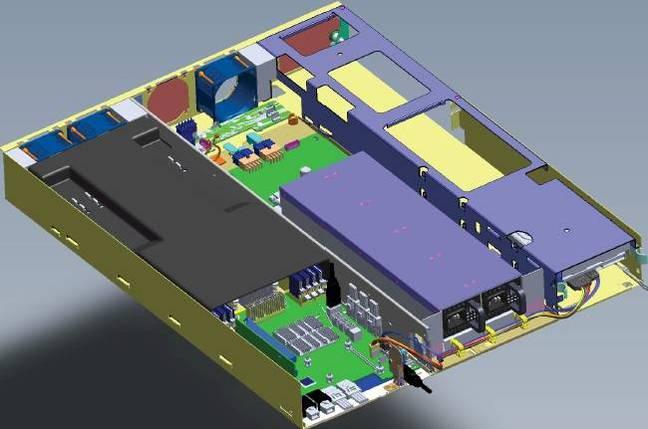

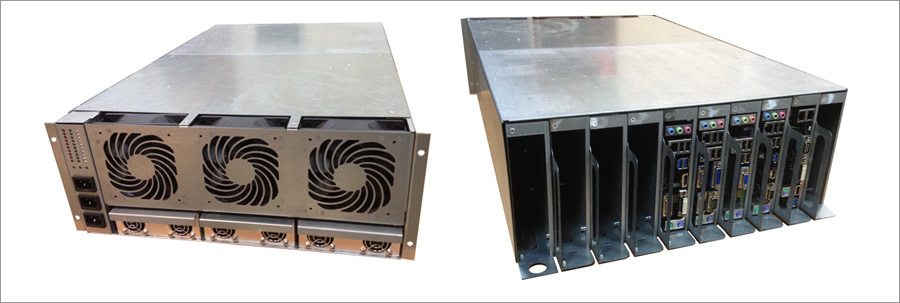

Мы в Хосткей также делаем сами серверы для сдачи их в аренду как выделенные сервера – традиционные решения не позволяют технологично предложить клиентам малобюджетные машины. После многих попыток в предварительную серию пошла 4U-платформа под кодовым названием Aero10: решения на данной платформе полностью удовлетворяют потребность в микросерверах на 2-4 ядерных процессорах.

Мы в Хосткей также делаем сами серверы для сдачи их в аренду как выделенные сервера – традиционные решения не позволяют технологично предложить клиентам малобюджетные машины. После многих попыток в предварительную серию пошла 4U-платформа под кодовым названием Aero10: решения на данной платформе полностью удовлетворяют потребность в микросерверах на 2-4 ядерных процессорах.

Мы используем традиционные материнские платы формата mini-ITX, вся остальная разработка полностью наша – от корпуса до силовой распределительнй электроники и схемы управления – всё сделано локально в Москве. Блоки питания мы пока используем китайские – MeanWell RSP1000-12 на 12V с разделением нагрузки и горячей заменой.

На платформе реализуются выделенные микро-сервера на процессорах Celeron J1800 2x2,4Ghz, Celeron J1900 4x2,0Ghz, i3-4360 2x3,7Ghz и флагманский i7-4790 4x3,6Ghz. В среднем сегменте мы делаем сервера на базе E3-1230v3 с модулем удалённого управления на той же платформе, используя материнские платы ASUS P9D-I.

Использование данного решения позволяет нам снизить издержки на капзатраты до 50%, экономить до 20-30% электричества и развивать это решение дальше. Всё это позволяет нам предложить клиентам конкурентные цены, возможные на рынке РФ в отсутствие кредитования, лизинга, рассрочек на 3 года и прочих инстурментов, доступных нам в Нидерландах.

В проекте уже есть решение на 19 лезвий mini-ITX в тех же 4U и мы постоянно работаем над совершенствованием системы питания и охлаждения. В перспективе для эксплуатации таких серверов традиционный ЦОД не потребуется.

В ближайшее время мы раскажем про эту платформу и прочие наши разработки в деталях, подписывайтесь и следите за новостями.

Под катом мы в деталях рассмотрим из чего состоят эти сервера, как они работают и что это дает.

Open Compute Project появился благодаря техническому директору Facebook Фрэнку Фрэнковски. Именно он запустил инициативу, позволившую отраслевому сообществу не только познакомиться с проектом дата-центра Facebook в Орегоне, но и принять участие в дальнейшем развитии новой архитектуры. Конечная цель – усовершенствовать центры обработки данных, сформировать экосистему, чтобы создавать более эффективные по энергопотреблению и стоимости серверы.

В целом идея напоминает сообщество разработчиков программного обеспечения Open Source, которые создает и совершенствует свои продукты. Проект оказался настолько интересным, что его поддержали крупные компании. OCP насчитывает уже более полутора сотен членов.

Архитектуры серверов и СХД создаются в соответствии со спецификациями OCP Open Rack, охватывающими такие аппаратные компоненты как системные платы и элементы системы электропитания. Проект предполагает также разработку стандартов, в частности, стандартов управления. В прошлом году OCP пополнился новыми членами. Сейчас в Open Compute участвуют IBM, Microsoft, «Яндекс», Box.net и многие другие известные компании.

Удешевляй, а то проиграешь

Если архитектура OCP станет стандартом де-факто для центров обработки данных, это может упростить развертывание систем и управление ими. Но главное – экономия, позволяющая предоставлять клиентам более дешевые сервисы и тем самым выигрывать на высококонкурентном рынке. Цели OCP – увеличение наработки на отказ (MTBF), повышение плотности серверов, простота их обслуживания с доступом из холодного коридора, улучшение энергоэффективности, что особенно важно для компаний, эксплуатирующих тысячи серверов.

Так, например, ЦОД Facebook в Орегоне потребляет на 38% меньше электроэнергии, чем другие центры обработки данных компании, в нем применяется бесчиллерная адиабатическая система охлаждения, а значение PUE достигло 1,07-1,08 (и это без применения водяного охлаждения), в то время как в среднем по отрасли оно составляет примерно 1,5. При этом капитальные затраты сократились на четверть.

Серверы Open Compute имеют облегченную конструкцию и могут работать при повышенной температуре. Они значительно легче, но крупнее обычного сервера – высота корпуса составляет 1,5U вместо 1U. В них установлены высокие радиаторы и более эффективные вентиляторы. Модульная конструкция сервера Open Compute упрощает доступ ко всем его компонентам – процессорам, дискам, сетевым платам и модулям памяти. Для его обслуживания не требуется инструментов.

К 2014 году спецификации OCP охватывали уже целый пул «открытого» аппаратного обеспечения – от серверов до инфраструктуры дата-центров. Выросло и число компаний, использующих OCP. Как оказалось, многие инновации OCP подходят не только для крупных ЦОДов, но и для использования в решениях для частных/публичных облаков.

В этом году компания Facebook представила еще несколько разработок в рамках проекта OCP. В частности, совместно с Intel идет работа над «сервером на кристалле» Yosemite, а компании Accton и Broadcom участвуют в проекте разработки коммутатора Wedge.

От Freedom до Leopard

Внедрение созданных в рамках проекта технологий дало Facebook возможность сэкономить за три года более 2 млрд долларов. Однако следует учитывать, что столь весомой экономии удалось добиться и за счет оптимизации программного обеспечения, а для каждого вида приложений было разработано пять типовых платформ.

Сегодня это в основном варианты платформы Facebook Leopard на процессорах Xeon E5. Она стала развитием серверов прежних поколений, таких как выпущенная в 2012 году система Windmill на базе процессоров Intel Sandy Bridge-EP и AMD Opteron 6200/6300.

Поколения серверов OCP от Facebook |

||||||

| |

Freedom (Intel) |

Freedom (AMD) |

Windmill (Intel) |

Watermark (AMD) |

Winterfell |

Leopard |

| Платформа |

Westmere-EP |

Interlagos |

Sandy Bridge-EP |

Interlagos |

Sandy Bridge-EP / Ivy-Bridge EP |

Haswell-EP |

| Чипсет |

5500 |

SR5650/ SP5100 |

C602 |

SR5650/ SR5670/ SR5690 |

C602 |

C226 |

| Модели |

X5500/ X5600 |

Opteron 6200/6300 |

E5-2600 |

Opteron 6200/6300 |

E5-2600 v1 / v2 |

E5-2600v3 |

| Сокеты |

2 |

2 |

2 |

2 |

2 |

2 |

| Термопакет, Вт |

95 |

85 |

115 |

85 |

115 |

145 |

| ОЗУ на сокет |

3x DDR3 |

12x DDR3 |

8x DDR3 |

8x DDR3 |

8x DDR3 |

8x DDR4 /NVDIMM |

| ~ Ширина серверного узла (дюймы) |

21 |

21 |

8 |

21 |

6.5 |

6.5 |

| Форм-фактор (U) |

1.5 |

1.5 |

1.5 |

1.5 |

2 |

2 |

| Число вентиляторов на узел |

4 |

4 |

2 |

4 |

2 |

2 |

| Размер вентилятора (мм) |

60 |

60 |

60 |

60 |

80 |

80 |

| Число отсеков для дисков (3.5'') |

6 |

6 |

6 |

6 |

1 |

1 |

| Интерфейс диска |

SATA II |

SATA II |

SATA III |

SATA III |

SATA III / RAID HBA |

SATA III / M.2 |

| Число слотов DIMM на сокет |

9 |

12 |

9 |

12 |

8 |

8 |

| Поколение DDRX |

3 |

3 |

3 |

3 |

3 |

4 |

| Ethernet |

1 GbE фикс. |

2 GbE фикс. |

2 GbE фикс. + PCIe мезанин |

2 GbE фикс. |

1GbE фикс. + 8x PCIe Мезанин |

8x PCIe Мезанин |

| Где развернуты |

Орегон |

Орегон |

Швеция |

Швеция |

Пенсильвания |

? |

| Модель PSU |

PowerOne SPAFCBK- 01G |

PowerOne SPAFCBK- 01G |

PowerOne |

PowerOne |

— | — |

| Число PSU |

1 |

1 |

1 |

1 |

— | — |

| Мощность PSU (Вт) |

450 |

450 |

450 |

450 |

— | — |

| Число узлов |

1 |

1 |

2 |

2 |

3 |

3 |

| BMC |

Нет (Intel RMM) |

Нет |

Нет (Intel RMM) |

Нет |

Нет (Intel RMM) |

Да (Aspeed AST1250 w 1GB Samsung DDR3 DIMM K4B1G1646G- BCH9 ) |

Одна из проблем серверов Freedom – отсутствие резервного блока питания PSU. Добавление PSU в каждый сервер означало бы увеличение не только CAPEX, но и OPEX, поскольку в режиме active/passive пассивный PSU все равно потребляет электроэнергию.

Логично было сгруппировать блоки питания нескольких серверов в шасси. Это нашло отражение в архитектуре стоек Open Rack v1, где блоки питания расположены на «полках питания» 12,5В DC, питающих «зоны» по 4,2 кВт.

Каждой зоне соответствует своя полка питания (высотой 3OU, OpenUnits, 1OU=48 мм). Блоки питания резервируются по схеме 5+1 и занимают в общей сложности 10OU в стойке. Когда потребляемая мощность мала, часть PSU автоматически отключается, позволяя остальным работать с оптимальной нагрузкой.

Усовершенствования коснулись и системы распределения питания. Здесь нет кабелей питания, которые нужно отключать при каждом обслуживании сервера. Питание подается по вертикальным шинам питания в каждую зону. Когда сервер задвигается в стойку, сзади в него вставляется разъем питания. Отдельный отсек 2OU отводится под коммутаторы.

Спецификации Open Rack предполагают создание стоек высотой 48U, что способствует улучшению циркуляции воздуха в оборудовании и упрощает техническому персоналу доступ к оборудованию. Ширина стойки Open Rack составляет 24 дюйма, но отсек для размещения оборудования имеет ширину 21 дюйм – на 2 дюйма шире обычной стойки. Это позволяет установить в шасси три системных платы или пять дисков 3,5 дюйма.

OCP Knox и другие

Для Open Rack v1 потребовалась новая конструкция серверов. Использование шасси Freedom без PSU оставляло много пустого места, и просто заполнить его 3,5" HDD было бы расточительно, да и для большинства нагрузок Facebook столько дисков не требовалось. Было выбрано решение, аналогичное блокам питания. Диски были сгруппированы и вынесены за пределы серверных узлов. Так родилась система хранения данных Knox.

Вообще говоря, OCP Knox – это обычная дисковая полка JBOD, созданная под Open Rack. К ней подключаются HBA соседних серверных узлов Winterfell. От стандартного 19" конструктива она отличается тем, что может вмещать 30 дисковых накопителей 3,5" и очень проста в обслуживании. Для замены диска выдвигается «поднос», открывается соответствующий отсек, диск заменяется, и все задвигается обратно.

Компания Seagate разработала собственную спецификацию «устройства хранения с интерфейсом Ethernet», известную как Seagate Kinetic. Эти накопители представляли собой объектное хранилище, подключаемое непосредственно к сети передачи данных. Было также разработано новое шасси BigFoot Storage Object Open с этими дисками и 12 портами 10GbE в корпусе 2OU.

В Facebook с аналогичной целью создали систему Honey Badger – модификацию Knox для хранения изображений. Она оснащается вычислительными узлами Panther+ на базе Intel Avoton SoC (C2350 и C2750) с четырьмя слотами DDR3 SODIMM и интерфейсами mSATA/M.2 SATA3.

Такая система может работать без головного узла – обычно сервера Winterfell (серверы Leopard компания Facebook с Knox применять не планирует). Несколько модифицированную версию Knox использовали в качестве архивного хранилища. Диски и вентиляторы в ней запускаются только тогда, когда это требуется.

Еще один вариант архивной системы от Facebook с использованием OpenRack вмешает 24 магазина с 36 картриджами-контейнерами, по 12 дисков Blu-ray в каждом. То есть общая емкость достигает 1,26 Пбайт. А хранятся диски Blu-ray до 50 лет и более. Работа системы напоминает музыкальный автомат.

Серверы Winterfell

Шасси Freedom без PSU по сути представляет собой просто материнскую плату, вентилятор и диск для загрузки. Инженеры Facebook создали более компактный форм-фактор – Winterfell. Он напоминает сдвоенный серверный узел Supermicro, но на полке ORv1 можно разместить три таких узла. Один узел Winterfell высотой 2OU содержит модифицированную материнскую плату Windmill, разъем шины питания и объединительную панель для подключения к материнской плате кабелей питания и вентиляторов. На материнскую плату можно установить полноразмерную карту x16 PCIe и карту x8 половинного размера, а также мезонинную карту сетевого интерфейса x8 PCIe. Загрузочный диск подключается по SATA или mSATA.

Open Rack v2

В процессе развертывания ORv1 стало ясно, что три зоны питания с тремя шинами каждая избыточны – столько питания просто не требуется. Появилась новая версия – Open Rack v2 с двумя зонами питания вместо трех и одной шиной на каждую зону. А высота отсека для коммутаторов выросла до 3OU.

Изменения в питании привели к несовместимости с Winterfell, поэтому появился новый проект – Project Cubby. На самом деле Cubby – некое подобие шасси Supermicro TwinServer, но вместо двух встроенных в серверный модуль PSU используется шина питания. В данной конструкции применятся три блока питания (2+1) 3,3 кВт на зону питания вместо шести. Каждая зона питания обеспечивает мощность 6,3 кВт. Нижняя часть стойки может содержать три батареи – Battery Backup Units (BBU) на случай отказов в системе электропитания.

Серверы Leopard

Итак, Leopard. Это новейшее обновление Windmill с чипсетом Intel C226 и поддержкой до двух процессоров E5-2600v3 Haswell Xeon.

Увеличенные радиаторы ЦП и хороший обдув позволяют применять процессоры с термопакетом до 145 Вт, то есть все семейство Xeon, исключая 160-ваттный E5-2687W v3. Каждому процессору доступны 8 каналов DIMM, и DDR4 позволяет в перспективе применять модули памяти по 128 Гбайт, что даст до 2 Тбайт ОЗУ – для Facebook более чем достаточно. Можно также использовать модули NVDIMM (флэш-память в форм-факторе DIMM) и Facebook тестирует такой вариант.

Среди других изменений – отсутствие внешнего коннектора PCIe, поддержка мезонинной карты с двумя QSFP+, слот mSATA/M.2 для накопителей SATA/NVMe и на 8 больше линий PCIe для дополнительной карты – всего их теперь 24. Разъема SAS нет – Leopard не используется как головной узел для Knox.

Важное дополнение – контроллер управления (Baseboard Management Controller, BMC). Это контроллер Aspeed AST1250 с доступом по IPMI и Serial Over Lan. BMC позволяет удаленно обновлять CPLD, VR, BMC и прошивку UEFI. Предусмотрен также контроль питания для управления нагрузкой PSU.

Сертифицированные решения

Оборудование OCP обычно изготавливается под заказ. Но есть и «розничные» версии Leopard. Производители предлагают свои модификации. В числе примеров – «облачные» серверы Quanta QCT и системы WiWynn с увеличенным числом дисков. HP, Microsoft и Dell тоже не остались в стороне.

С увеличением числа поставщиков оборудования Open Compute появилась необходимость убедиться в корректности следования ими принятым спецификациям. Появились две сертификации – OCP Ready и OCP Certified. Первая означает, что оборудование соответствует спецификациям и может работать в среде OCP. Вторую присваивают специальные тестирующие организации. Таких всего две – в University Of Texas at San Antonio (UTSA) в США и в Industrial Technology Research Institute (ITRI) на Тайване. Первыми вендорами, сертифицировавшими свое оборудование, стали WiWynn и Quanta QCT.

Инновации OCP постепенно внедряются в ЦОДах и стандартизируются, становятся доступными для широкого круга заказчиков.

Открытые технологии позволяют предлагать заказчикам любую комбинацию вычислительных узлов, систем хранения и коммутаторов в стойке, использовать готовые или собственные компоненты. При этом нет жесткой привязки к системам коммутации — можно применять коммутаторы любого вендора.

Инновации Microsoft

Microsoft представила детальные спецификации своих серверов Open Compute и даже раскрыла исходный код программного обеспечения управления инфраструктурой с функциями серверной диагностики, мониторинга охлаждения и электропитания. Она внесла свой вклад в OCP, разработав архитектуру Open Cloud Server. Эти серверы оптимизированы для работы с Windows Server и построены в соответствии с высокими требованиями к доступности, масштабируемости и эффективности, которые предъявляет облачная платформа Windows Azure.

По данным Microsoft, стоимость сервера снижена почти на 40%, энергоэффективность выросла на 15%, а развертывать инфраструктуру можно на 50% быстрее.

На форуме Open Compute Project (OCP) Summit в США Microsoft показала еще одну интересную разработку – технологию распределенных ИБП под названием Local Energy Storage (LES). Она представляет собой комбинацию модуля питания и батареи, совместимую с шасси Open CloudServer (OCS) v2. Новые модули LES взаимозаменяемы с прежними PSU. В зависимости от топологии ЦОДа и требований к резервированию питания можно выбирать, какой тип PSU использовать. Обычно ИБП размещают в отдельном помещении, а для резервного питания ИТ-оборудования в них используются свинцовые аккумуляторные батареи. По ряду причин такое решение неэффективно. Заняты большие площади, теряется энергия из-за преобразований AC/AC и AC/DC (постоянный/переменный ток). Двойное преобразование и зарядка аккумуляторов увеличивает PUE дата-центра до 17%. Снижается надежность, растут операционные расходы.

На форуме Open Compute Project (OCP) Summit в США Microsoft показала еще одну интересную разработку – технологию распределенных ИБП под названием Local Energy Storage (LES). Она представляет собой комбинацию модуля питания и батареи, совместимую с шасси Open CloudServer (OCS) v2. Новые модули LES взаимозаменяемы с прежними PSU. В зависимости от топологии ЦОДа и требований к резервированию питания можно выбирать, какой тип PSU использовать. Обычно ИБП размещают в отдельном помещении, а для резервного питания ИТ-оборудования в них используются свинцовые аккумуляторные батареи. По ряду причин такое решение неэффективно. Заняты большие площади, теряется энергия из-за преобразований AC/AC и AC/DC (постоянный/переменный ток). Двойное преобразование и зарядка аккумуляторов увеличивает PUE дата-центра до 17%. Снижается надежность, растут операционные расходы.

Переход на адиабатическое охлаждение может привести к снижению затрат и упростить операции.

Но как усовершенствовать систему распределения питания и ИБП? Можно ли здесь все радикально упростить? В Microsoft решили отказаться от отдельного помещения для ИБП и перенести модули питания ближе к ИТ-нагрузке, заодно интегрировав батарейную систему с управлением ИТ. Так появилась LES.

В топологии LES изменена конструкция PSU – добавлены такие компоненты как батареи, контроллер управления батареями, низковольтное зарядное устройство.

Батареи используются литиево-ионные, как и в электротранспорте. Таким образом, разработчики LES взяли стандартные элементы PSU, обычные батареи и соединили их в одном модуле. Что это дает? По данным Microsoft:

- До пяти раз снижаются затраты по сравнению с традиционным ИБП, значительно упрощается система электропитания в ЦОДе, а функцию накопления энергии выполняют коммерчески доступные батареи.

- Перемещение батареи к серверу устраняет 9% потери, характерные для обычных ИБП. У литиево-ионных батарей на зарядке теряется лишь 2%, в то время как у свинцовых – до 8% и 1% на подачу питания. В результате уменьшается PUE.

- Площади ЦОДа сокращаются на 25%, а это радикальная экономия капитальных затрат.

- Значительно упрощается обслуживание — модули LES легко заменяются, никакой кислоты. Последствия отказа сводятся к минимуму и локализуются.

Инновации Open Compute Project меняют рынок ЦОДов и облачных сервисов, стандартизируют и удешевляют разработку серверных решений. Это лишь один из многочисленных примеров. В следующей серии материалов вы познакомитесь с другими интересными решениями.

Мы в Хосткей также делаем сами серверы для сдачи их в аренду как выделенные сервера – традиционные решения не позволяют технологично предложить клиентам малобюджетные машины. После многих попыток в предварительную серию пошла 4U-платформа под кодовым названием Aero10: решения на данной платформе полностью удовлетворяют потребность в микросерверах на 2-4 ядерных процессорах.

Мы в Хосткей также делаем сами серверы для сдачи их в аренду как выделенные сервера – традиционные решения не позволяют технологично предложить клиентам малобюджетные машины. После многих попыток в предварительную серию пошла 4U-платформа под кодовым названием Aero10: решения на данной платформе полностью удовлетворяют потребность в микросерверах на 2-4 ядерных процессорах.

Мы используем традиционные материнские платы формата mini-ITX, вся остальная разработка полностью наша – от корпуса до силовой распределительнй электроники и схемы управления – всё сделано локально в Москве. Блоки питания мы пока используем китайские – MeanWell RSP1000-12 на 12V с разделением нагрузки и горячей заменой.

На платформе реализуются выделенные микро-сервера на процессорах Celeron J1800 2x2,4Ghz, Celeron J1900 4x2,0Ghz, i3-4360 2x3,7Ghz и флагманский i7-4790 4x3,6Ghz. В среднем сегменте мы делаем сервера на базе E3-1230v3 с модулем удалённого управления на той же платформе, используя материнские платы ASUS P9D-I.

Использование данного решения позволяет нам снизить издержки на капзатраты до 50%, экономить до 20-30% электричества и развивать это решение дальше. Всё это позволяет нам предложить клиентам конкурентные цены, возможные на рынке РФ в отсутствие кредитования, лизинга, рассрочек на 3 года и прочих инстурментов, доступных нам в Нидерландах.

В проекте уже есть решение на 19 лезвий mini-ITX в тех же 4U и мы постоянно работаем над совершенствованием системы питания и охлаждения. В перспективе для эксплуатации таких серверов традиционный ЦОД не потребуется.

В ближайшее время мы раскажем про эту платформу и прочие наши разработки в деталях, подписывайтесь и следите за новостями.

ilukyanov

А как так выходит, что в России кредитование и лизинг вам недоступны, а в Нидерландах — да?

ULP

там работает отдельная наша компания с офисом и некоторым персоналом в Амстердаме, у которого все эти возможности есть.

И лизинг на 3-4 года и рассрочка от сборщиков — 4 года уже как. Над кредитами работаем, в самых ближайших планах ;)

К РФ вся эта история имеет опосредованное отношение, русских клиентов там мало на общем фоне.

ilukyanov

А в России просто не ставили такую цель перед собой или лизинг/кредитование совсем мертвые?

ULP

ставили и пользовались, был большой объем лизинга в Прайм-лизинг и РМБ-лизинг и банковские кредиты. В этом месяце проплачиваем последние транши по лизингам и все — эффективная ставка больше 30% годовых на сервера, только от безысходности возьмешь. Кредитную линию нам не продлили год назад, так что нет у нас больше банковских денег в обороте. Сборщики от слова рассрочка падают на пол и ржут как кони, даже в те времена когда это не представляло для них особой проблемы =)

резюме — если в качестве активов сервера, то в РФ лизинг/кредитование совсем мертвые. Были и до кризиса мертвые, а сейчас и подавно.

ilukyanov

Спасибо за подробности.

ULP

собственно я уже писал тут не раз — в РФ я ограничен размером денег в своем кармане и покупаю новые сервера ровно в том объеме в котором могу себе это позволить. Цену сдачи регулирую пропорционально — что бы не заваливать новые заказы… Т.е. бизнес модель — возврат на капитал.

В Нидерландах беря сервер на 3 года в лизинг/рассрочку я сразу имею маржу между лизинговым платежом и тарифом клиента. Т.е. ограничен я только собственной динамикой продаж и лимитом в лизинге. Вот и вся разница — в том числе почему в НЛ дешевле, а в Хетзнере и подавно.

ilukyanov

Ну, есть все таки и в России те, кто находит деньги на демпинг даже в условиях кризиса. Правда не очень понятно чем эти люди руководствуются, выставляя цены в два-три бакса за конфиг который стоит у DigitalOcean пять :) Видимо на трекшон и ретеншон, или как там это называется :)

ilukyanov

Это я к тому, что в Европе уже и не дешевле вроде как.

voooz

А точно 2-3 дохлых президента за аналог 5 баксового ДО? А то что случайно проскакивало из этого, так там и IO и CPU и скорость сети совсем не уровня цифрового океана.

ULP

ДО сейчас это дорогой сервис, новые процессоры, дешевые SSD и память позволяют готовтить это блюдо дешевле и получать больше ресурсов за свои 5 баксов.

ilukyanov

Ну, по мне так DO это просто сервис с нормальной экономикой без демпинга. Все что ниже (особенно в России) — это в той или иной мере кроилово и демпинг. Это сейчас про коммерцию, если делать для себя — безусловно можно сделать и дешевле. Впрочем тема не для этого топика :)

ilukyanov

Формально конфиг будет тем же. Реально — будут некоторые скрытые «компромиссы» в инфраструктуре / избыточности / оверселле :) Ну и не будет гигабитной сети.