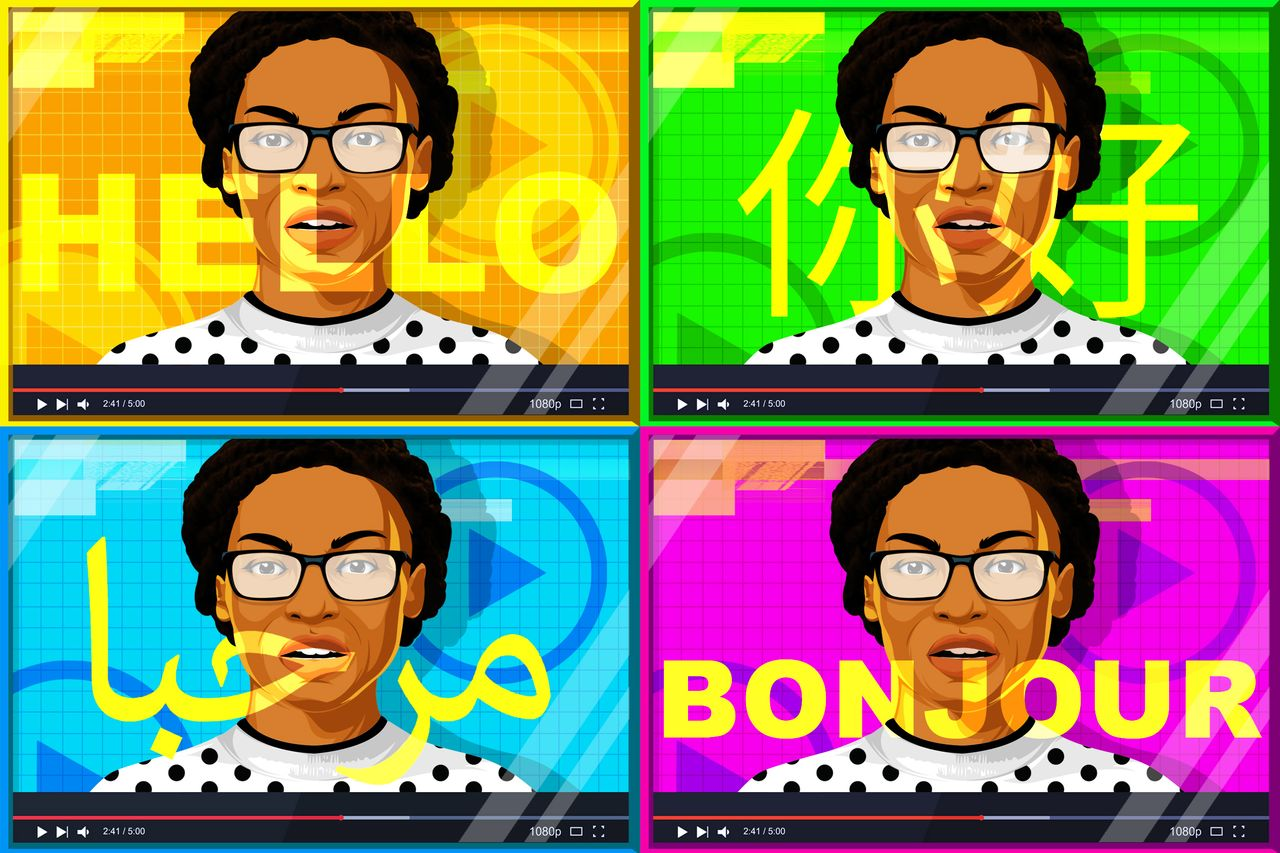

Следующий фильм или ТВ-шоу, которые вы будете смотреть, могут оказаться "работой" искусственного интеллекта. Представьте, что актеры Голливуда, Болливуда или любых других студий говорят на родном для вас языке в любом из новых фильмов или шоу. На самом деле, это вполне реальная история, вот только голоса могут не принадлежать человеку - все это дипфейки, правда, не мошеннические, а созданные самими киностудиями с использованием ИИ.

Уже сейчас видео- и голосовые дипфейки вполне сносно копируют оригинал А в ближайшем будущем эти технологии станут еще более совершенными. Компании смогут получать копии голосов актеров, говорящих на самых разных языках. И это будут не лишенные выражения "голоса" вроде современных цифровых агентов, а очень реалистичные голоса, снабженные эмоциями. Цифровые актеры смогут плакать, смеяться, бормотать - причем максимально близко к оригинальной озвучке.

Все это - не фантазии, а реальность сегодняшнего дня. Чем больше фильмов и ТВ-шоу выходит на экраны, тем более прибыльным становится дубляж. ИИ постепенно проникает в эту отрасль, синтезируя не просто голоса актеров. Технологии позволяют "омолодить" голос, то есть фильм, в котором снимается пожилой актер, может быть снабжен "молодым" голосом этого человека. Кроме того, можно создавать и вовсе искусственные голоса, которые принадлежат уже умершим актерам или тем из них, кто потерял голос. Ну и да, сами актеры при этом могут сидеть дома и пить чай, не утруждая себя выездом на студию звукозаписи. Да и домашняя студия в этом случае совсем не нужна.

При этом производитель фильма вовсе не обязан рассказывать зрителю о том, что голос - синтезированный. Одно дело роботы колл-центра, и совсем другое - озвучка фильмов или ТВ-шоу.

Все, о чем здесь говорится - вовсе не фантастика. Совсем недавно при помощи ИИ был озвучен на разные языки фильм “Every Time I Die” 2019 года. Это была одна из первых попыток заменить голос актера дубляжа цифровым агентом. И все получилось - даже разработчик этой технологии далеко не всегда мог отличить синтезированный голос от настоящего.

Скорее всего, эта тенденция с течением времени будет только усиливаться, так что сама роль актера дубляжа будет становиться все менее востребованной. Обучить нейросеть, которая послужит основой для очередного голоса актера, просто. Для этого нужно всего 5 минут записи, где переводчик наговаривает текст поверх английского оригинала.

Сейчас технология уже используется. Например, она применялась в "Мандалорце", когда показывали Люка Скайуокера. Дипфеком заменили голос настоящего Марка Хэмилла, которому уже 70 лет. Об этом студия особо не распространялась, но это вполне реальный проект. Причем подавляющее большинство зрителей не осознавало, что голос - ненастоящий.

Хэммил сам дал разрешение на использование его голоса. И компания Respeecher. Воспользовалась этим разрешением, обучив нейросеть на основе фрагментов записи голоса актера 40-летней давности. Источниками послужили прежние эпизоды фильма, старое радиошоу и записанный на пленку голос Хэмилла.

По словам создателя технологии, обычно человек улавливает голос, синтезированный ИИ. Его выдает ряд признаков, включая отсутствие эмоций, некая "металличность" и прочее. Сейчас же этих барьеров нет и человеку стало очень сложно отличить настоящий голос от дипфейка.

Подобными проектами параллельно занимается несколько компаний. Например, лондонская компания Sonatic недавно воспроизвела голос Вэла Килмера. Этот известный актер утратил прежний тембр, тональность и т.п. из-за проблем с гортанью. Симуляция оказалась настолько реальной, что его собственный сын заплакал, услышав голос отца. «Идея возможности настраивать голосовой контент, изменять эмоции, высоту тона, направление, темп, стиль, акценты - теперь это возможно там», - говорит генеральный директор Sonantic Зина Куреши.

Дипфейки подобного рода могут использоваться не только для озвучки фильмов, но и для другого контента, включая видеоигры. Переозвучивать можно и старые фильмы с поврежденной или не очень естественной аудиодорожкой. ИИ справляется с этими задачами без особых проблем.

Конечно, здесь не обойтись и без рисков - индустрия дипфейков развивается очень активно. Если не учитывать подделку голосов политиков, глав компаний и т.п., о чем мы расскажем в одном из последующих материалов, все равно можно столкнуться с противозаконными действиями предприимчивых бизнесменов. Недавно голос Моргана Фримена был использован в рекламе, связанной с компанией, которая даже не попыталась связаться с актером.

Но как бы там ни было, искусственные голоса постепенно занимают свою нишу - разрешения актеров на использование их голосов запрашивает все большее количество компаний. Среди них - как киностудии, так и обычные рекламные агентства. В ближайшем будущем, вероятно, ИИ-студии дубляжа станут весьма востребованным сервисов. Если еще не стали - ведь их услугами уже активно пользуются десятки компаний.

Комментарии (15)

Jetmanman

16.10.2021 13:50Думаю актеры дубляжа не только свой голос поставляют на рынок озвучки, но и манеру говорить, интонацию и т.д. Дипфейк здесь может быть применен скорее не поверх ИИ, а поверх голоса актера дубляжа.

Alexey2005

16.10.2021 15:32+1А манера говорить и интонация должны копироваться с оригинала.

Jetmanman

16.10.2021 15:43Сомневаюсь, что есть примеры, где ИИ реально заменил человека, пока это трудная задача.

acsent1

16.10.2021 15:50+1А как решается проблема разной длины слов?

Крикнул актер что-то на своем тарабарском - ТАР. А по русски это будет какой нибудь синхрофазатрон

nktkz

16.10.2021 17:10тут два момента:

- некоторые фильмы сильно лучше в нашей озвучке (многие даже не понимают почему на западе некоторые роли некоторых актеров считаются крайне плохими, так как смотрели в озвучке)

- проблема чаще всего в самом качестве перевода (в некоторых фильмах от этого даже сюжет не считывается из за перевода)

pankraty

17.10.2021 18:30некоторые фильмы сильно лучше в нашей озвучке (многие даже не понимают почему на западе некоторые роли некоторых актеров считаются крайне плохими, так как смотрели в озвучке)

Так-то да, но контрпримеров много больше.

GospodinKolhoznik

16.10.2021 20:56+1Мне кажется будет как с 3Д очками. А именно - сначала хлынут толпы посмотреть что за чудо такое. Через некоторое время им быстро наскучит и ажиотаж спадёт. Зато появится некоторый процент людей, которые из принципа не будут ходить на фильмы озвученные роботом. И таких может быть довольно много - может быть 5%, а может и больше 50%.

Т.е. сначала технология принесет деньги тем, кто первый ей воспользуется, но через некоторое время (примерно год-два) окажется, что выгоднее тратиться на профессиональных переводчеков, чем недополучать прибыль от той части людей, которые не ходят на фильмы переведенные роботами. Даже потеря 5% зрителей это огромные деньги для киноиндустрии.

DaneSoul

16.10.2021 22:08Звучание в разных языках может сильно отличаться: разные наборы звуков, тональности, мелодичность и т.п. Если актер не владеет этим языком и не сможет наговорить набор звуков языка для дальнейшей генерации, то генерировать будут со звуков его родного языка? Что делать с тонами, если язык тональный? Что делать с уникальными звуками?

Вот как эти все вопросы решаются я так в статье и не увидел.

maxwolf

17.10.2021 04:38Давным-давно, когда я первый раз попал в америку, меня здорово удивило, что на первой же попавшейся на приёмнике в машине радиостанции люди (тоже мужчина и женщина) разговаривали теми же голосами, что и на популярном московском (условном) серебряном дорожном радио. Но сейчас я понимаю, что создатели франшизы решили скопировать оригинал поелику возможно точно, включая тембр и интонации ведущих, и у них это прекрасно получилось, ещё до появления deep learning/fake технологий. А сейчас эти вопросы решаются ещё проще, алгоритмически, оптимизацией в сторону уменьшения вектора (или матрицы) ошибки.

Admz

10.11.2021 13:08Полагаю что ИИ в озвучке фильмов далеко (лет так 30) от идеала, то есть того чтобы люди не могли отличить синтезированный голос от естественного. Сюда входит несколько факторов: интонационный рисунок языка и каждого человека уникален. Вы возможно уже сталкивались с тем что один и тот же актёр дубляжа озвучивает различные фильмы которые по жанру отличаются и мы получаем на экране (дублированного) актёра который вроде играет роль любовника, но звучит как бревно, или герой боевика который своей интонацией может разве что котёнка напугать. В идеале, конечно же, иметь на каждого знаменитого актёра/актрису своего звукового двойника, который озвучивает только его/её. Но это не будет выгодно ни прокатчикам, ни самим актёрам дубляжа. Я уж промолчу про тонкую игру голосом и передачу подтекста интонацией: сарказм, устрашение, флирт, доброжелательность и т.п.

Приведённые здесь примеры дипфейков работы ИИ просто уникальны (разовые) в своём роде. Тут участвовали целые коллективы, студии, (которые возможно отшлифовывали каждое слово/звук) так что до массового применения ещё далеко.

Javian

Через сколько лет после смерти актера закончатся авторские права на голос?

LeToan

А если для озвучки использовать пародиста-иммитатора, у кого права на результат? Имеет ли какие-либо права в таком случае обладатель оригинала голоса?

shteyner

Думаю да, если тут будет акцентироваться внимание на то, что это голос конкретного человека т.е. использоваться его имя. Если же просто имитация голоса, то не прикопаешься, мало ли похожих голосов, это же не внешность, которая более уникальна.

LeToan

Но более выделяющееся голоса легче имитировать, и при этом они больше выделяются, например, Морган Фримен. Сымитировать его голос, но не называть имя, будет скандал?