Исследователи из лаборатории SAND Lab при Чикагском университете утверждают, что доступные широкой общественности программы клонирования голоса развиваются угрожающе быстро. В частности, создаваемые при помощи подобных технологий голосовые дипфейки могут сбить с толку как людей, так и смарт-устройства с голосовым управлением. Но не только голосовые, а также и другие дипфейки представляют угрозу. Дипфейки уже используются в рекламе, моде, журналистике и обучении. Однако больше 90% подделок созданы, чтобы навредить репутации, — например с помощью порнографических роликов. В 2019 году общие денежные потери бизнеса из-за дипфейков приблизились к отметке $250 млн в 2020 году.

Примеры атак с использованием дипфейков

- Атака на руководителя энергетической компании: Эта афера с использованием дипфейка в 2019 году является первой известной атакой с использованием данной технологии, и она иллюстрирует «темную» сторону возможностей технологии дипфейков. Как в классическом случае корпоративного вымогательства, генеральный директор энергетической фирмы получил телефонный звонок якобы от своего босса. На самом деле, это был поддельный голос, сгенерированный искусственным интеллектом, но на слух это невозможно было определить, поэтому генеральный директор спокойно выполнил его поручение о переводе 243 000 долларов США в течение часа. Программа смогла сымитировать не просто голос человека, но его тональность, интонации и немецкий акцент. Правда вскрылась, когда мошенники попытались провернуть тот же фокус во второй раз. Увы, полиция не смогла идентифицировать личности преступников, а вместе с ними не удалось найти и деньги.

- Атака на техническую компанию: В этой неудачной попытке аудио-дипфейка в 2020 году сотрудник одной технической компании получил странное голосовое сообщение от кого-то, чей голос был очень похож на голос генерального директора фирмы. В сообщении содержалась просьба о «немедленной помощи для завершения срочной деловой сделки». Однако сотрудник компании, следуя своим подозрениям, сообщил об этом в юридический отдел фирмы. Хотя эта атака с использованием дипфейка в конечном счете не увенчалась успехом, но она является ярким примером тех типов атак, которые мы ожидаем увидеть в большом объеме по мере того, как технологические достижения и инструменты для создания дипфейков будут становиться все более доступными. Письма на электронной почте и голосовые дипфейки оказались частью продуманной мошеннической операции, в которой, по данным полиции ОАЭ, были задействованы не менее 17 человек из разных стран.

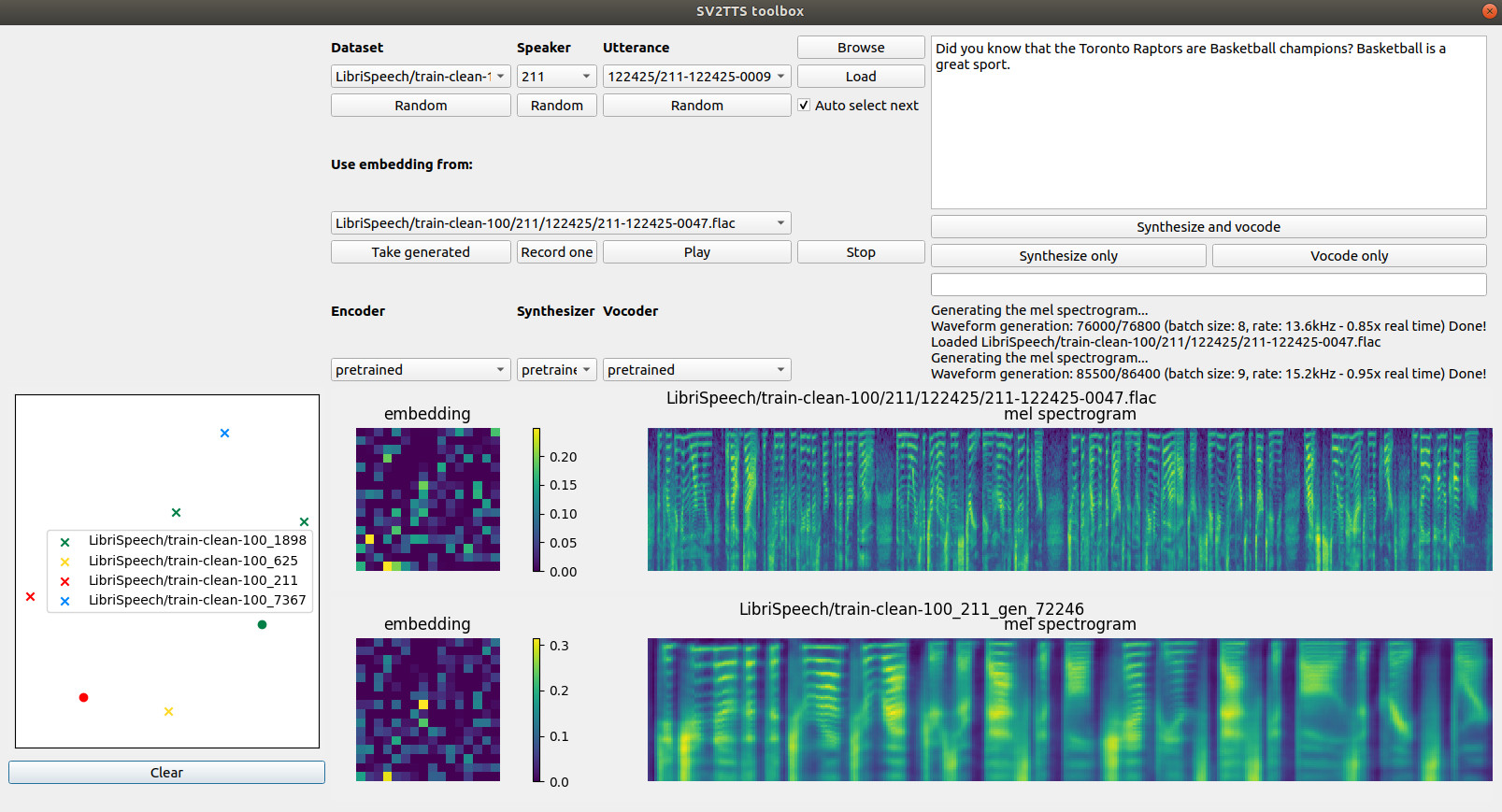

Команда экспертов из лаборатории SAND Lab (Security, Algorithms, Networking and Data Lab) протестировала доступные на платформе Github программы клонирования голоса, чтобы узнать, смогут ли они прорваться сквозь защиту системы безопасности распознавания голоса умных колонок Alexa, WeChat и Azure. Среди множества программ внимание учёных привлекла технология SV2TTS, создатели которой называют её «инструментом для клонирования голоса в режиме реального времени». По словам разработчиков, программа SV2TTS может синтезировать полноценные голосовые дипфейки, основываясь всего на 5 секундах записи оригинального голоса. Имитация голоса в исполнении SV2TTS смогла обойти защиту Azure от Microsoft в 30% случаев, а колонки Alexa и WeChat поддавались обману и того чаще – в 63%. Не менее ошеломляющие результаты показал эксперимент с 200 волонтёрами: примерно в половине случаев люди не смогли отличить голосовые дипфейки от реальных голосов.

Кроме того, исследователи пришли к выводу, что по какой-то причине синтезаторам речи гораздо лучше удаётся имитировать женские голоса, а также речь людей, для которых английский язык не является родным. По словам исследователей, современные механизмы защиты против синтезированной речи развиваются медленнее технологий имитации голоса. Не в тех руках подобные программы рискуют стать инструментом воплощения преступного замысла. При этом мишенью атаки могут стать как реальные люди, так и смарт-устройства. К примеру, колонка WeChat использует распознавание голоса пользователя для обеспечения доступа к платным функциям, например, для проведения транзакций в приложениях сторонних разработчиков вроде Uber или New Scientist.

Впрочем, изначально голосовые дипфейки заинтересовали учёных после новостей об использовании технологий имитации голоса для проворачивания крупных финансовых махинаций, о которых сказано выше.

Джейк Мур – эксперт в отрасли информационной безопасности из компании ESET – считает, что голосовые и видео-дипфейки представляют реальную угрозу безопасности информации, хранения денег и деловых отношений на глобальном уровне. По мнению Мура, в обозримом будущем всё больше предприятий будут становиться жертвами высокотехнологичной преступной деятельности. К счастью, по мере осознания опасности недобросовестного использования ИИ-технологий на рынке стали набирать популярность компании вроде Pindrop Security, которые предлагают клиентам помощь в идентификации звонков, осуществляемых при помощи технологий имитации голоса.

А как дело обстоит с фото или видео дипфейками?

Зачастую — это порнографический шантаж. Жертвами регулярно становятся знаменитости. Например, в числе жертв злоумышленников — Натали Портман, Тейлор Свифт, Галь Гадот и другие. Но подделывают внешность и голос не только известных людей.

В 2021 году в Индии стали все чаще происходить случаи мошенничества с использованием видеозвонков, в процессе которых женщина раздевается на камеру и побуждает мужчину делать то же самое. Жертву записывают на видео и потом шантажируют, вымогая до 2 млн рупий. Полиция города Ахмедабад обнаружила, что в 60% случаев жертвы говорили не с реальными женщинами, а с дипфейками. Мошенники используют программы, которые переводят текст в аудио и, предположительно, видео с порносайтов.

Частое опасение, связанное с дипфейками, — что они будут использоваться в политических целях. Такие примеры уже есть, и речь не про знаменитый дипфейк Обамы, в котором он обзывает Трампа. В феврале 2020 года, за день до выборов в Законодательное собрание в Нью-Дели, дипфейк-видео главы одной из ведущих общенациональных партий Индии стали вирусными в WhatsApp. В одном из них он говорил на диалекте хинди, хариани. Это видео использовалось, чтобы отговорить рабочих-мигрантов голосовать за другую партию. Дипфейки распространили в 5,8 тыс. групп WhatsApp в Дели и Национальном столичном регионе, охватив примерно 15 млн человек.

Другой интересный пример: видео с экс-премьер-министром Бельгии Софи Вильмес, которое опубликовала организация Extinction Rebellion Belgium. Этот дипфейк — модификация предыдущего обращения к нации по поводу пандемии. В вымышленной речи говорится, что последние глобальные эпидемии напрямую связаны с «эксплуатацией и разрушением людьми природной среды». Для воспроизведения голоса и манеры речи использовался ИИ.

Можно ли отличить дипфейк от реального человека?

Раньше можно было спокойно отличить дипфейк по различным признакам, но уже сейчас это не помогает.

- Неестественная интонация речи

- Роботизированный тон

- Неестественное моргание или движение человека на видео

- Движения губ не синхронизированы с речью

- Низкое качество звука или видео

Да, но сейчас — это сложно. Противодействие дипфейкам — игра в кошки-мышки, так как мошенники тоже совершенствуют технологию. Например, в 2018 году выяснилось, что люди в дипфейках не моргают или делают это странно. Особенность сразу же учли в усовершенствованных моделях.

Чтобы стимулировать создание технологий для обнаружения дипфейков, Facebook и Microsoft проводят Deepfake Detection Challenge. В 2020 году в нем приняли участие более 2 тыс. человек. Разработчикам удалось добиться точности распознавания более 82% на стандартном тестовом датасете, но на усложненном (с отвлекающими компонентами вроде надписей) она упала чуть более чем до 65%.

ПО для обнаружения дипфейков можно обмануть, слегка видоизменяя входные данные, так что исследователи продолжают вести работу в этой области. В июне 2021 года ученые из Facebook и Университета штата Мичиган объявили о новой разработке. Обычно детекторы определяют, какая из известных моделей ИИ сгенерировала дипфейк. Новое решение лучше подойдет для практического применения: оно может распознавать подделки, созданные с помощью методов, с которыми алгоритм не сталкивался при обучении.

Еще один способ: поиск цифровых артефактов. У людей в дипфейках могут не совпадать цвета левого и правого глаза, расстояние от центра глаза до края радужной оболочки, отражение в глазах. Встречаются плохо прорисованные зубы и нереалистично темные границы носа и лица. Но в современных подделках увидеть такие артефакты может только машина. Так что самое важное в борьбе с дипфейками — быть настороже и обращать внимание на фото, видео и аудио, которые кажутся подозрительными.

Дипфейк как товар

Доступность датасетов и предобученных нейросетевых моделей, снижение стоимости вычислений и соревнование между создателями и детекторами дипфейков подгоняет рынок. Deepfake-инструменты коммодифицируются: в сети свободно распространяются программы и учебные материалы для создания подделок. Существуют простые приложения для смартфонов, которые вообще не требуют технических навыков.

Повышенный спрос на дипфейки привел к созданию компаний, которые предлагают их как продукт или услугу. Это, например, Synthesia и Rephrase.ai. В Ernst & Young дипфейки, сделанные с помощью Synthesia, уже начали использовать в клиентских презентациях и в переписке. Стартап Sonantic специализируется на озвучке видеоигр и предлагает платформу no-code для генерации голосовых клонов.

Будущее медиа с помощью ИИ

Вместе с рынком коммерческого применения дипфейков будет расти и число мошеннических операций. В сети уже есть маркетплейсы, где публикуют запросы на подделки, например порноролики с актрисами. А некоторые алгоритмы могут сгенерировать deepfake-видео на основе одного изображения или воссоздать голос человека, используя аудио длиной в несколько секунд. Из-за этого жертвой аферистов может стать практически любой пользователь интернета.

С дипфейками борются не только с помощью технологий, но и на законодательном уровне. В США и Китае появляются законы, регулирующие их использование, а в России борьбу с ними в июле 2021 года включили в одну из дорожных карт «Цифровой экономики». Регулирование в этой области будет только усиливаться.

Комментарии (49)

anonymous

00.00.0000 00:00

powerman

09.11.2021 05:00+25Как обычно - им хочется, чтобы только "правильные" люди имели к ней доступ и чтобы обманывать этой технологией можно было только "неправильных" людей. "Друзьям - всё, врагам - закон", вот это вот всё. А тут кто угодно подделывает кого угодно - конечно, кому такое понравится… Вот и ищут способы если не загнать джинна обратно в бутылку, то хотя бы научиться его контролировать.

Ellias

09.11.2021 14:40Думаю в итоге дело идёт к тому чтобы никакие видео и аудио (и другие которые научатся подделывать) материалы не являлись доказательством каких-либо действий (преступных и не очень). Придется доказывать что эти доказательства являются доказательством, а не являются подделкой, хз может их электронной подписью будут подписывать или как-нибудь блокчейн использовать.

pewpew

09.11.2021 03:29+19Почему-то ни слова про биометрию. Однако при аутентификации по голосу дипфейки легко обойдут автоматику. Тем временем Сбербанк всё ещё активно убеждает сдавать биометрические данные. Ну вы поняли.

Moskus

09.11.2021 04:35+2Вообще любая биометрия, которая может быть считана с индивидуума без его согласия и ведома - средство аутентификации с пониженной надёжностью относительно того, что не может быть снято скрытно и без ведома. Потому что единственным препятствием для копирования становится сложность/цена. Плюс, не забываем о невозможности добровольной инвалидации биометрии и возможности случайной (для некоторых случаев) в результате травмы, например.

Wesha

09.11.2021 05:05+4Вообще любая биометрия, которая может быть считана с индивидуума без его согласия и ведома

Примерно так

Только в оригинале там кое-что другое было :)

JerleShannara

09.11.2021 05:05+1Если это можно сделать удаленно через браузер, то можно заранее забить в базу сбера такой адов дипфейк на себя, который просто не удастся никому сгенерировать. Ну а далее просто постоянно отказываться от всяческих логинов по биометрии (типа «нету камеры и микрофона»).

K36

09.11.2021 11:43Возможно потому, что российским банкам биометрия нужна не для идентификации, а с единственной целью внесения ее в общероссийскую базу.

Wesha

09.11.2021 05:00+15программы клонирования голоса развиваются угрожающе быстро.

А ведь нас ещё в Союзе учили:

одного отпечатка голоса мало, нужен ещё shared secret!

yurixi

09.11.2021 07:58+3А как же позитивная сторона? Обратная отдача. Конкретный вид и голос человека обесценится — то есть, общение станет объективным, оно будет влиять только своим содержанием и смыслом.

Следующий шаг — дипфейк содержания и смысла. Ну тут — уж за что боролись, на то и напоролись. Если у бублика откусить и правую часть и левую, то пользоваться оставшейся частью по своему назначению станет только удобнее.

eimrine

09.11.2021 09:00+1Следующий шаг — дипфейк содержания и смысла.

Так это предыдущий же, всякими GPT-3 вроде бы уже налюбовались.

yurixi

09.11.2021 09:26Любоваться ими можно пока они заметны. А вот станут неотличимы, вот это будет другой разговор. Нужно будет прежде чем разговаривать с человеком убеждаться в его адекватности. Это станет не лучшей практикой, а необходимостью.

DaneSoul

09.11.2021 16:34Нужно будет прежде чем разговаривать с человеком убеждаться в его адекватности.

Ммм… Если абсолютно адекватен и без закидонов — значит 100% робот?

Потому как слишком уж много людей тест на адекватность завалят :-)

Tyusha

09.11.2021 08:09+4Скоро будем верифицировать своего босса методом профессора Плейшнера:

— Отто просил передать, что вчера вечером ждал вашего звонка.

— Странно, я был дома, но, видимо, он перепутал номер.

MAXH0

09.11.2021 08:32+10Ну почему же не сулят?

Фильм, в котором можно самому выбрать актеров или, что проще, перевод оригинальны голосом актера. Даже от порно с выбранным образом "звезды" большинство бы не отказались (-;хоть и будут утверждать обратное;-)

Просто надо признать, что видео, где человек похожий на ген. прокурора отдыхает в обществе дам похожих на ... Ну в общем не работает такое видео. Да и, в те времена оно тоже работало тогда и только тогда, когда кому-то это было нужно.

lovermann

09.11.2021 08:37+5Так, весь прикол в том, что через несколько лет какой-нибудь сферический Жириновский в вакууме сможет всё спихнуть на дипфейк при публикации видео в бане в компании молодых мальчиков.

MAXH0

09.11.2021 09:09+11И что? Вы гомофоб? Политиков надо судить по их политическим взглядам, а не по личной жизни! Вот не было бы мальчиков, вы бы пошли за ЛДПР голосовать?

Надо понимать, что компромат работает тогда и только тогда когда кому то надо и проплачивают шумиху в сети. Вон в одной стране поставщик лоли политикам повесился в камере и тишина. Престарелый криптоанархист попытался шум поднять и тоже самоубился в камере. И тишина... В общем то мне параллельно. Если в одной стране можно с 21, а в другой с 14 и кто то решил сделать на этом гешефт, то это их личное дело. И как максимум дело их избирателей. Но вот когда они начинают убивать - это как то не весело.

Поэтому я за то, чтобы политиков не судить по фото из бани. А только за поступки.

ader

09.11.2021 10:51На самом деле политиков (да и иных публичных личностей) судят не по поступкам, а по взаимосвязи их высказываний и заявлений с их поступками. Если человек на словах яростно борется с уничтожением человеком окружающей природной среды и в то же время расстреливает лосей в заповеднике, это вызывает общественное неприятие. Ибо политик созданием законов (или иных правил поведения) принуждает окружающих поступать определённым образом, но сам так поступать не намерен.

Moskus

09.11.2021 11:06+3Лицемерие - довольно серьезный проступок для политика, но явно не основной, а тем более - единственный вид нежелательного поведения, на которое обращают внимание люди. Как минимум, ложь сама по себе покрывает больше негативных ситуаций, включая лицемерие.

drafterleo

09.11.2021 13:43судят не по поступкам, а по взаимосвязи их высказываний и заявлений с их поступками.

Увы, не судят (в юридическом аспекте). Законотворческие инициативы о наказании за невыполнение предвыборных обещаний не проходят дальше первого чтения :).

strlock

09.11.2021 09:02+5Никогда не доверял какой-либо информации независимо от репутации/авторитета источника/субъекта. Дипфейки просто обращают внимание на то что мы существуем в окружении иллюзий и приближают то время когда идеализм перестанет быть самым популярным мировоззрением.

engine9

09.11.2021 10:11+1А мне кажется, что обсуждаемая тема станет еще одной тростинкой в неразрешимом ворохе проблем с которым человечество встретится ближайшее время

перед своим вымиранием.

astenix

09.11.2021 10:08Дипфейк идеально подойдет для новостей на ТВ как иллюстрация события.

Например, можно воссоздать (эскизно, но все-таки) сцену любого происшествия

KivApple

09.11.2021 11:20+3Не вижу какой-то явной угрозы при условии адекватной реакции общества - по факту дипфейки ставят под удар биометрические технологии аунтификации (в том числе аналоговые "вроде знакомый голос начальника в телефоне, значит надо делать то, что он говорит"). Классические технологии аунтификации по паролям, смарткартам, ЭЦП и прочим подобным штукам дипфейки вообще никак не затрагивают. Просто придётся признать, что биометрия для критических вещей (а не неуловимых Джо) - не может быть достаточным средством аунтификации, максимум дополнительным фактором.

В целом во многих развитых странах и так на биометрию на государственном уровне не полагаются. Системы распознания лиц в Европе сильно ограничены (из-за GPDR), в США зарегулированы на уровне отдельных штатов. Системы "оплата взглядом" в Европе вообще не слышал, чтобы внедрялись, в США внедряются опять же как частная инициатива отдельных компаний (то есть от сворачивания программы глобальных последствий не будет). Тот же пограничный контроль в ЕС для граждан ЕС - биометрия только второй фактор, без физической id-карты (на которой есть всякая криптография) тебя через границу не пустят автоматически.

По факту массово внедряют биометрию как основной фактор для идентификации граждан и умных платежей только Китай да Россия. Ну, им, возможно, придётся свернуть инициативу, либо сильно закрутить гайки в области разработки и использования ПО (но это уже будет шаг назад во всех сферах развития, чтобы спасти одну не особо значительнуюс сферу). Гражданам по возможности стоит избегать использования биоматрической идентификации при наличии выбора (в России он пока есть, в Китае не знаю).

Что касается сотрудников фирм, готовых перевести большие деньги по звонку с незнакомого номера просто потому что голос показался знакомым - это во все времена кажется чем-то неправильным, просто потому что бывают люди с похожими голосами, не все люди одинаково хорошо умеют голоса различать и т. д. Дипфейки ничего нового тут опять же не открыли. Идентификация без секрета, просто по принципу "ну вроде выглядит/звучит похоже" by design обречена на провал и годиться только для того, чтобы правильного ребёнка в детсаду забрать - просто потому что вряд ли неправильный ребёнок будет специально мимикрировать под правильного, слишком экзотическая атака (если только речь не о сыне миллиардера, но, мне кажется, они не ходят в обычные детские сады). Но когда очевидна финансовая угроза, атака перестаёт быть экзотической.

pewpew

09.11.2021 13:32+1Так всем это понятно. Но наше доблестное правительство упорно так не считает. В ход идут новые средства по сбору биометрии. Единая база. Госуслуги и все дела. Попахивает новыми возможностями для мошенников. И при этом мошенники не только могут провести через эту систему сделки или получить фиктивные документы но и проголосовать за вас, например.

panzerfaust

09.11.2021 14:56Мне кажется, все эти "достижения" (распознавание лиц, фокусы с нейросетями) однажды будут запрещены международной конвенцией так же, как запрещены сейчас химическое оружие, кассетные боеприпасы и экспансивные пули. Когда-то это все тоже было достижением инженерии и вызывало восторг в определенных кругах. Вопрос, понадобится ли для этого глобальный катаклизм.

ss-nopol

09.11.2021 16:11Пожалуй видеодоказательства потеряли силу ещё в 1997 после выхода фильма "Титаник". Правда тогда это было дорого и доступно далеко не всем. Но ведь до сих пор публикуют какие-то аудио "прослушки", которые кем-то принимаются как доказательства...

Hasan81

11.11.2021 08:37Это как с огнестрельным оружием, убивает не оружие - убивает человек, оружие это инструмент и только человек принимает решение использовать оружие для защиты или для нападения.

Здесь тоже самое. Технология хорошая, вот только в мире негодяев и подлецов многовато. В 90-е было стало модно зарабатывать много не задумываясь о том что такое хорошо и что такое плохо. Сейчас с 90-ми мало что изменилось, во всем мире культ денег, а не чести и справедливости, просто инструменты изменились. Негодяи (мошенники, политики и т.п.) разного пошиба достигают цель любыми способами наплевав на все, в т.ч. на свою же репутацию. Поэтому, что бы любой инструмент не стал оружием, например, вымогательства или фейковых политических новостей, то людей надо воспитывать с самого детства. Дети не рождаются плохими, а становятся такими с возрастом и отсутствием правильного воспитания.

Wesha

11.11.2021 08:55чтобы любой инструмент не стал оружием, например, вымогательства или фейковых политических новостей, людей надо воспитывать с самого детства

Так в СССР с детства и воспитывали,

предупреждая как раз о таких ситуациях

Moskus

Если у подделки есть дефекты, которые можно конкретно описать словами, средний индивидуум распознает такую легко и естественным образом, потому что люди имеют (за редким исключением) механизмы узнавания других людей, которые значительно эффективнее сравнения по формальному описанию.

NikitaCartes

Это если активно пытаться понять реально ли видео. Однако если что-то делать в спешке, слушать запись на фоне, смотреть его на небольшом экране смартфона, то можно просто не обратить внимание на детали которые выдадут поддельность видео.

PereslavlFoto

В спешке можно и в магазине двойную цену заплатить. Однако это не повод запретить магазин.

Moskus

Ваш аргумент лишён смысла в этом контексте, потому что я говорил о том, что один способ определения подделки (естественный) более эффективен, чем другой (поиск визуальных дефектов по описанию). А вы говорите, что если вообще не обращать внимания на видео, можно не заметить, что оно поддельное. Да, можно что угодно не заметить, но это не может быть ни возражением, ни дополнением к сказанному мной.

Areso

Достаточно пожать все до VGA разрешения картинки, как это водится в видеозаписях почти везде. Артефакты сжатия "перебьют" почти все артефакты дипфейка, и будет не совсем ясно - то ли запись плохая, то ли дипфейк.

Напомню, что чат-бот, который смог обмануть большинство людей, прикидывался ребенком, кхм, с некоторыми особенностями развития.

Moskus

Если дефекты нельзя заметить естественным образом, их нельзя заметить и анализируя видео визуально по формальному списку. Я не утверждал, что люди в состоянии видеть дефекты, которые вообще нельзя увидеть, потому что они, например, ниже уровня дефектов сжатия видео.

Wesha

Если мой старый друг будет прикидываться человеком с некоторыми особенностями развития, я думаю, я что-то заподозрю...

sergeyns

Друг может сказать "что он после аварии и лежит в больнице".. и тут уже любые особенности пролетят..

Wesha

Остаётся понять, зачем ему деньги, если он лежит в больнице ;)

JerleShannara

В реалиях ex-USSR — дать на лапу главврачу, чтобы лечили нормально.

DaneSoul

Swill

Помнится, в ЖЖ накатила очередная волна ботов, которые маскировались под обычных пользователей — имели записи в ленте, постили осмысленные реплаи. Но я все равно выкупал их на раз. Очевидно же: Записи либо бессистемны, либо являются репостами, реплаи шаблонны или не попадают в тему беседы.

Но очень многие не могли их определить. Поэтому людская способность выловить дипфейк мне кажется сильно переоцененной.

Moskus

В моём комментарии выше речь шла о визуальном распознавании. Люди очень долго эволюционировали, чтобы узнавать лица, видеть тонкие различия в выражениях и так далее. Феномен uncanny valley - прямой результат этого, например.

qw1

Думаю, будет как с шахматами — задавят грубой силой. Первые программы тоже играли так себе, а когда скорость CPU выросла в 1000 раз, человек окончательно проиграл.

Мы не знаем, на что будут способны сети, если число слоёв/нейронов увеличить в 10 или в 100 раз.

Moskus

Кто-нибудь будет в этой ветке вообще читать исходное сообщение? Кажется, что нет. Потому что сравнивал я два подхода людей к определению поддельных фото и видео с участием других людей.