О дипфейках мы уже писали. Сейчас технологии генерации такого контента достигла очень высокого уровня. Правда, даже очень хорошо подготовленный дипфейк можно (пока еще) отличить с помощью специализированных технологий. Совсем недавно дипфейки делали для развлечений или чтобы досадить кому-то, сейчас же их начинают применять и в интересах разных компаний - телевизионных, кинематографических и т.п. Актерам уже даже не нужно лично озвучить персонажей фильмов или мультиков - технологии позволяют синтезировать любые слова и фразы, произнесенные якобы самим актером (тональность, высота голоса и т.п. синтезируется очень точно).

Правда, есть и другая сторона медали. Кроме индустрии развлечений, дипфейки используются еще и для составления фальшивых видео с участием известных людей. Это могут быть те же актеры, политики, предприниматели - да кто угодно. Комбинация ИИ-технологий с CGI-технологиями дает поистине потрясающий эффект и обширные возможности, использовать которые можно как во благо, так и в не самых законных целях. Как все это работает?

Немного истории

Технологии синтезирования видео и аудио нельзя назвать новыми. Они разрабатываются с конца 90-х годов XX века. Конечно, разные попытки делались и до этого, но мы говорим о тех технологиях, которые получили продолжение. Так, в 1997 году компания Video Rewrite представила технологию, которая позволяла сформировать видео, где артикуляция лица совпадала с синтезированной аудиодорожкой. Т.е. моделировалась артикуляционная мимика лица, которая полностью соответствовала синтезированной компьютером аудиодорожкой.

Но это были лишь первые попытки, которые активно развивались в течение двух десятков лет. Сейчас нам доступны технологии обработки голоса, объединения компьютерной графики с реальными видео и многое другое. Не везде применяется ИИ, но все же самые реалистичные системы сформированы на базе машинного обучения.

Достаточно долгое время эти технологии были известны лишь ограниченному кругу специалистов. Но в 2009 году появился "Аватар", который был достаточно убедительной демонстрацией таких технологий. Затем, в 2014 году, юная Одри Хепберн "снялась" в рекламе шоколада - ее лицо было перенесено на лицо актрисы при помощи специализированного ПО. В 2019 году вышел фильм "Ирландец", в котором лица актеров очень сильно омолодили при помощи искусственного интеллекта. Правда, фильм подвергли критике, поскольку наложить на лицо 3D-маску, пусть и реалистичную - это еще не все.

Как бы там ни было, технология создания дипфейков постепенно эволюционировала и совершенствовалась. Но еще несколько лет назад артикуляционная мимика и другие элементы синтезированных видео были заданы программным путем - в подавляющем большинстве случаев это была "ручная" работа, а не дипфейк с real-time режиме.

Появление "настоящих" дипфейков

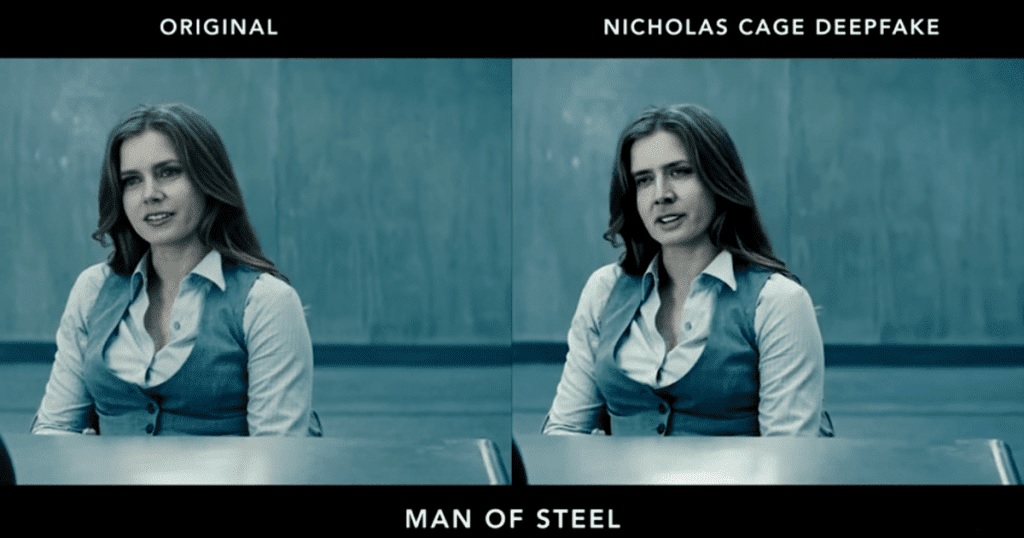

Технология Deepfake упрощает процесс синтезирования изображения и создания звуковых дорожек с заданными параметрами за счет использования нейронных сетей. Они обучаются на сотнях или даже тысячах примеров лиц и голосов, с ними связанными. После этого ИИ показывает весьма впечатляющие результаты.

Почему Deepfake? Эта технология получила свое название в 2017 году. Пользователь Reddit создал несколько не самых приличных видео с лицами знаменитостей. Никней этого пользователя был - Deepfake, так что это слово решили использовать для обозначения схожих по сути технологий. И надо сказать, такие технологии стали очень активно развиваться.

За относительно короткий промежуток времени произошел взрывной рост софтверных компаний, предлагающих решения для синтетической генерации видео и аудио - не только людей, но и целых сцен. Каналы YouTube с Deepfakes, такие как Shamrock и Ctrl Shift Face, получили большое количество подписчиков. Простые в использовании приложения deepfake являются обычным явлением. Индустрия развлечений создает полностью искусственных персонажей, которые становятся известными. Пример -Лил Микела или Микела Соуза.

Нет сомнения, что с течением времени будут появляться все более реалистичные дипфейки. Уже сейчас они никого не удивляют, а в ближайшем будущем и вовсе станут привычным делом. Но кто отвечает за развитие технологий, где они используются, как работают и чего нам ожидать в будущем?

Современные игроки

Большинство крупнейших технологических игроков и развлекательных компаний активно исследуют отрасль "синтетических медиа". Amazon стремится сделать голос Алексы более реалистичным, Disney изучает, как использовать технологию смены лица в фильмах, а производители оборудования, такие как Nvidia, расширяют границы синтетических аватаров, а также услуг для кинопроизводства и телевидения.

Но есть и организации, которые создают технологии, позволяющие отличить подделку от реальности. В их число входят, например, Microsoft и DARPA.

К слову, у большинства ПО по созданию дипфейков открытый исходный код, что дает возможность работать с дипфейками даже небольшим компаниям. Проектов достаточно много. Это, например, Wombo, Аvatarify, FaceApp, Reface, MyHeritage и многие другие.

Локальные и облачные решения предлагают более сложные техноолгии. Synthesia - ведущий поставщик синтетических аватаров, используемых для обучения, обслуживания клиентов, производства видео и многого другого. Пользователи могут выбирать из готового аватара (как в примере выше) или, после 40-минутного сеанса совместной с сервисом работы, сделать реалистичный эквивалент, сделанный по своему образу и подобию.

Все чаще реалистичная генерация голоса находит применение во всем: работе с клиентами, автоматического перевода и т. п. Примеры игроков из этой сферы - Respeecher и Resemble AI. Первый может изменять голос пользователя на голос другого, управлять его возрастом или переводить на другой язык, в то время как второй позволяет пользователям создавать дипфейки своего собственного голоса.

Как создаются дипфейки

Классическая компьютерная обработка изображений использует сложные алгоритмы, созданные при помощи традиционного программного обеспечения. Эти алгоритмы чрезвычайно сложны. Как говорилось выше, совсем недавно дипфейки представляли собой контролируемую модель, которой управляют разработчики. Подавляющее большинство элементом артикуляционной мимики жестко прописывалось в алгоритмах.

Сейчас ситуация изменилась - контролировать все это можно уже не так жестко, специализированное ПО автоматически совмещает речь и движения губ/лица "говорящей головы".

Правда, для того, чтобы создать убедительный дипфейк, требуются большие объемы видео, статические изображения, голосовые записи, а иногда даже сканирование головы реального актера с последующим анализом в качестве обучающих вводных данных. Например, клиенты Synthesia в течение примерно 40 минут снимают на видео, как они зачитывают заранее подготовленную речь, чтобы потом этот контент использовался для обучения нейронными сетями.

Но видео знаменитостей, включая политиков, спортсменов, актеров - полным-полно в интернете. Соответственно, на основе этих материалов можно создавать весьма реалистичные дипфейки.

Несмотря на весьма впечатляющие результаты, дипфейки, создаваемые ИИ, не являются идеальными. У дипфейков есть ряд хорошо заметных (не для человека, для специализированного ПО) признаков, которые пока еще позволяют отличить реальность от вымысла. Это, например, нюансы освещения и теней, мигание, артикуляция, выражение и тон голоса. Для создания убедительного дипфейка все это нужно правильно комбинировать.

Изображения и видео

Достаточно часть в этом направлении используется Variational Autoencoder – VAE. Это генеративная модель, которая находит применение во многих областях исследований: от генерации новых человеческих лиц до создания полностью искусственной музыки. Что касается видео, то VAE позволяет достаточно быстро перенести особенности мимики и артикуляции определенного человека на сформированную объемную модель. VAE используется достаточно давно, но дипфейк, созданный при помощи этой технологии, несложно выявить.

А вот с 2017 года развиваются генеративные состязательные сети (GAN). Здесь в единое целое объединены, по сути, две нейронные сети. Одна, "дискриминатор", определяет реалистичность модели, созданной другой нейросетью. На выходе получается модель, которая была "одобрена" и является наиболее реалистичной.

Но это упрощенное объяснение. На практике все сложнее - используются и другие нейросети и элементы. Результат же действительно впечатляющий. На сайте This Person Does Not Exist можно видеть очень реалистичные лица никогда не существовавших людей. Эта же технология использовалась для того, чтобы показать цифрового двойника Сальвадора Дали. Двойник "работает" в музее самого Дали, рассказывая о деталях жизни и работы этого известного человека.

Что дальше?

Положительных моментов много. Фильмы и мультфильмы можно без проблем переводить на другие языки, делая это быстро и почти без участия человека. При этом голос у перевода будет оригинальный - как будто сам актер говорит на другом языке.

Проблем тоже немало - ведь даже не особо качественные дипфейки политиков и других знаменитостей могут использоваться в не самых добрых целях. А верить им будут, ведь далеко не каждый человек способен понять, что перед ним - подделка или реальный персонаж. С течением времени отличить правду от вымысла будет все сложнее.

Дипфейки вообще могут подорвать доверие зрителей к СМИ - ведь если нельзя отличить правду от вымысла, кому можно доверять? Но сейчас некоторые компании работают над созданием технологий выявления дипфейков. Компания IBM даже попыталась использовать технологии блокчейн для этой цели.

Дипфейки также поднимают множество вопросов о том, кому какой контент принадлежит, что делать с лицензиями и как наказывать нарушителей. Так, уже сейчас актеры заключают контракты с компаниями, разрешая использовать их образ и голос в рекламе или фильмах. Но, вероятно, некоторые компании будут использовать дипфейки знаменитостей в своих целях без всяких разрешений.

Как бы там ни было, рынок технологий такого рода еще только развивается, есть множество незанятых ниш. Так что все это будет продолжать развиваться, невзирая на проблемы, о которых говорится выше. Ну а можно ли будет решить сами проблемы - покажет время.

Комментарии (2)

sundmoon

30.11.2021 02:15Дипфейки вообще могут подорвать доверие зрителей к СМИ — ведь если нельзя отличить правду от вымысла, кому можно доверять?

Я только за.

Пускай доверие к СМИ утратят зрители, которые не могут без СМИ отличить правду от вымысла.

Nikuson

Как круто жить в такое время, где это возможно