О практических проблемах больших разрешений на большой частоте.

Лыдыбр: Я недавно сделал себе небольшой апгрейд и у меня появился монитор 4k@144Hz. Разумеется, на 144Hz он с пол-пинка не заработал. И с пачкой ноутбуков и USB-C кабелей тоже. Потому что нюансы. Мне пришлось в это нырнуть глубже, чем хотелось бы...

Моя старая видеокарта на компьютере сумела завести его на 4k @ 60Hz с помощью Display Port. (Либо 2k @ 144Hz). Я попытался воткнуть в монитор ноутбук (все 5 шт, какие нашлись у меня и знакомых) и обнаружил, что всё настолько сложно, что мне потребовалось несколько заходов чтения спецификации, пока я "это завёл". Выписываю свои наблюдения и эксперименты. Актуальность - первая половина 2022 года. Монитор under study: Gigabyte M32U, хотя, в принципе, это не существенно для обсуждаемого вопроса. У монитора в наличии разъёмы HDMI, DisplayPort (2 шт), USB-C. При том, что с десктопом моя проблема решилась "просто обновлением железа", я решил разобраться с проблемой поглубже, чтобы знать.

Разбирать проблему я буду слоями. Начём с физики и кабелей.

Физика

4k (3840х2160) на частоте 144Hz при глубине 1 байт на цвет (24 бита на пиксел) требует минимум 28665446400 бит в секунду (3840*2160*3*8*144), то есть около 30 гигабит/с, и это не считая накладных расходов кодирования (либо 8/10, либо 128/130), звукового потока, USB для подключения периферии и т.д. Любые кабели, в которых проходит меньше, нам не подойдут. Точнее, если мы сожмём передаваемый сигнал, то сможем "пролезть" в 20Гбит, но наше первое предположение: 20 гигабит - маловато. Про компрессию - см раздел в конце.

Поскольку ситуация очень плохая, то мы так же будем рассматривать как допустимые и 120Hz вместо 144Гц, то есть 23 Гбит/с.

Какие кабели могут нам столько дать (мы не смотрим на протоколы)

Кабели

HDMI 2.0кабель даёт 18.0 Gbit/s. Такой кабель больше 90Гц не может. Названия кабелей (которые не годятся):Standard HDMI Cable,High Speed HDMI,Premium High Speed HDMIHDMI 2.1 имеет подмножество кабелей с условным называнием Ultra High Speed HDMI Cable (UHS), которые умеют 48 Gbit/s. Другие название - Category 3 HDMI, HDMI 8k, HDMI 48G.

Display Port кабели старых поколений:

RBR (reduced bit rate),HBR, HBR2 (High Bitrate). Другие названия:Standard DisplayPort Cable,Full HD.High Bitrate 3 (HBR3) умеет 32.4 Gbit/s. До 120Гц. (144Гц в режиме компрессии). Другие названия: DP4k.

UHBR 10, 13.5 и 20 (Ultra High Bit Rate) Пришёл с display port 2.0. Даёт 40-80 Gbit/s. Наши родные 144Гц без выкрутасов. Альтернативное название: DP8k.

USB-C кабельUSB3 - даже близко нет.USB-C кабель USB4. Куча кабелей разной скорости, все (кроме того, что ниже не подходят)

USB4 Gen 2×1,USB4 Gen 2×2 (?),USB4 Gen 3×1.USB-C кабель USB4 Gen 3×2. В него проходит 40 Гбит. Обратите внимание, все остальные кабели USB4 не годятся (я не уверен про USB4 Gen 2x2, там всего лишь 20Гбит/с, что может быть, хватит для 120Гц с компрессией)

Thunderbolt 3 кабель является прародителем USB4, и по скорости 40Gbit/s должен работать, но ...я не знаю, работает он или нет. Сам TB3 обещает DP 1.2, который всего лишь "(3840 × 2160) at 120 Hz". Терпимо.

Thunderbolt 4 кабель точно работает, потому что 40Gbit/s, и в стандарте есть DP 2.0.

Заметим, я совсем не трогал вопрос с power delivery == PD (не путать с DP == Display Port), это отдельная ортогональная задача. Хотя кабель, который по USB-C делает PD - это мечта для подключения ноутбука. Воткнул один кабель - и готовая док-станция. Однако, по стандарту Thunderbolt 4, power delivery может быть всего 18Вт. Как я обнаружил, многие ноутбуки с питанием работают по схеме "всё или ничего", то есть от 18Вт не заряжаются даже в sleep. Редким исключением являются макбуки. Но это всё оффтопик - мы-то 4k@144 хотим...

Итог: Всё, что не в списке выше, будет или не работать, или будет работать странно (пропадающий сигнал), или будет работать на маленьких частотах (< 100Hz).

Таким образом, в общем случае, USB-C кабель без маркировки - вероятнее всего, не подойдёт.

Лыдыбр. С учётом цены правильных кабелей очевидно, что все usb-c кабели в моём хозяйстве, купленном под телефоны, оказались совершенно далеки от мира 'USB4 Gen 3x2', что объяснило большинсто моих неудач вначале.

Покупка кабелей

Наблюдение за кабелями в магазинах.

Найти правильный DP кабель легко. Найти правильный HDMI кабель ... относительно легко. А вот USB-C - вот тут вот безумие.

Во-первых, как было сказано выше, USB-C бывает кучи версий. Многие - USB3, т.е. для передачи сигнала видео совсем не подходят. Даже если вы найдёте USB4 кабель, то их огромное число и большая часть из них не подходит. Официальное название нужного кабеля - "Gen 3x2", удачи вам пробиться через магазинные поисковики с таким. А большая часть того, что найдено - 0.8м, потому что это максимальная длина пассивного кабеля, насколько я понял. Кабель большей длины - нужны чипы в кабеле, что резко повышает цену и сужает ассортимент.

Причём я говорю не про Али (где в описании кобелей собачье безумство), а про многие благородные магазины, и Амазон, и computeruniverse, и локальные компьютерные магазины Кипра. Наверное, с этим не лучше и в других магазинах.

С огромным скрипом я нашёл правильные названия, и их цена... Впечатлила. В результате я остановился на активном сертифицированном Thunderbolt 4 кабеле за €50. Это слегка оверкилл, но зато точно всё в наличии и всё хорошо. Не-оверкилл с слегка более скромными спецификациями рядом был за €38, плюс €18 доставка...

Но! Этот кабель заработал. Я увидел честные 4k @ 144Hz на одном-единственном ноутбуке из всех доступных.

С кабелями разобрались. Дальше идут протоколы.

Протоколы

У нас есть выбор из двух: HDMI и DP, но всё осложняется тем, что оба из них могут оказаться внутри USB-C кабеля.

HDMI

В спецификации сказано, что:

HDMI 1.4 : 4k @ 30Hz.

HDMI 2.0: 4k @ 60 Hz

HDMI 2.1: 4k @ 120 Hz.

А как же 144 Hz? А никак. Упс... Таким образом, HDMI, даже в самом bleeding edge режиме (по состоянию на 22 год) не может показать желаемое. Хотя, 120Гц, в целом, почти достаточно. Таким образом, для "едва-едва" нам нужен HDMI 2.1 и не ниже. На 2.0 мы получим "обычные 60Гц", а "старый HDMI" нам покажет 30-герцовый кошмарик. При том, что кабель способен, стандарт не осилил.

Лыдыбр: что, собственно и оказалось в переходнике USB-C -> HDMI, который у меня был. Внутри HDMI 1.4. Enjoy your 30 out of 144.

P.S. Оказалось, что всё сложнее и у HDMI 2.1 есть разновдиности. См комментарии.

Display Port

Display Port куда более продвинутая технология:

Display Port 1.0, режим "HBR": 4k @ 30Hz.

Display Port 1.2, режим "HBR2": 4k @ 75 Hz (внезапно!)

Display Port 1.3, режим "HBR3": 4k @ 120Hz (почти...)

Display Port 1.4, режим "HBR3 4k @ 120Hz, но есть DSC или YCrBr 4:2:0, которые, теоретически должны дать 144 Hz...

Display Port 2.0, режим UBHR10: 4k @ 144Hz, UBR20: 4k @ 240Hz. Даже перелёт.

Итого, Display port в версии 1.3 такой же "едва", как HDMI 2.1. Версия 1.4a минимально подходит, а версия 2.0 - это то, что нам нужно.

Thunderbolt

Сам Thunderbolt нас не касается, но он поддерживает некоторые интересные режимы, касающиеся видео.

В Thunderbolt 3 может быть три режима работы интерфейса: DP (это не display port!), SP и LP. Какой достанется вам - загадка. Главное, внутри там может быть Display Port 1.2 или Display Port 1.4. Комбинация поддержки со стороны кабеля и со стороны хоста - получается чистая лотерея. В контексте 4k@120Hz я бы на работоспособность Thunderbolt 3 портов не надеялся.

Thunderbolt 4 резко улучшил ситуацию: мы уже можем быть точно уверены в Display Port 1.4, и, может быть, получим Display Port 2.0 в alt-mode.

USB-C

Я специально назвал этот раздел неправильно (потому что это не протокол, а разъём), потому что всё, что USB-C - это безумие. Если TB3/4 имеет явную маркировку, то с USB-C - катастрофа.

Я считаю, что usb-c кабель давно надо переменовать в 'a cable', чтобы фраза звучала так: 'a monitor is connected to a computer using a cable'. Или так: 'this device uses a cable'. Потому что у USB, помимо самого USB, есть так называемый 'alt mode', который позволяет пропускать по кабелю аналоговый звук, Display Port, Hdmi, чёрта в ступе и даже USB.

Несмотря на все свои поиски я не нашёл USB4 Gen 3x2 нигде, т.к. для "ценителей" есть TB с простыми версиями.

Alt-mode-безумие

Из безумства выше нас интересуют следующие протоколы:

DisplayPort

HDMI

Теоретически, там ещё есть MHL для сотовых телефонов, но я не хочу идти по этой дорожке.

Вопрос: а что реализовано внутри монитора? Либо USB4, и тогда там DP 2.0 (ура!), либо HDMI 2.1 (увы!), либо там TB, и на самом деле там чёрт в ступе (DP от 1.2 до 2.0).

Может быть так, что там реализованы оба протокола, а решает видеокарта?

Спецификация моего монитора говорит:

HDMI 2.1 (support 4K 144Hz 4:4:4 @ DSC enabled or 4K 144Hz 4:2:0) x2

Display port 1.4 (DSC) x1

USB Type-C x1

Это то, что нам обещает производитель. Про содержимое USB Type-C ни слова. Это, хотя бы, USB4?

После практического эксперимента, мой ноутбук сказал, что монитор через USB-C - это DP-0. Значит, Display Port. Я не знаю метода понять, какой вариант используется - alt mode или родной протокол.

Но из спецификации монитора до покупки понять, что внутри USB-С будет DP невозможно.

Хост

Хост, это то, что делает сигнал. Дискретная видеокарта, ноутбук или активный переходник.

Ноутбуки

С ноутбуками (для которых USB-C и задуман) выяснить, что именно он умеет, становится почти невозможно.

В описании одного из ноутбуков написано:

* Thunderbolt 4/USB-C 4.0 Gen3×2 (DisplayPort 1.a: yes, Power Delivery: yes*)

* USB-C 3.2 Gen2×2

Скажите, что такое DisplayPort 1.a? Между 1.2a и 1.4a находится граница между успехом и безнадёжностью... Хотя обещали Thunderbolt 4, и он должен быть DisplayPort 2.0...

И сразу понятно, что второй USB-C порт нам полностью не подходит, потому что он 3.2 (а не 4).

... Когда ко мне таки приехал сертифицированный Thunderbolt 4 кабель, выяснилось, что внутри ноутбука какая-то халтура и монитор с ним 144 Hz получает (ура!) но теряет его почти сразу же. Так что dp оказался действительно "1.a".

Вот, другой ноутбук:

One USB 3.0 (Type-C) port

Thunderbolt 3 (USB Type-C) port

One HDMI 2.0 port

One Mini DisplayPort 1.2

А у Thunderbolt 3 по спецификации DP может гулять от 1.2 до 1.4. Впрочем, рядом упомянут mini-DP 1.2, так что внутри там будет, вероятнее всего, DP 1.2, то есть "ничего больше 75 Hz не светит".

А вот третий:

Ports

(2) Intel® Thunderbolt™ 3 (Type-C)

(2) USB 3.1 Gen 1 (Type A)

(1) HDMI 2.0

Опять Thunderbolt 3 без уточнения что внутри.

Получается, по бумаге вообще невозможно понять, будет оно работать или нет. Боль? Боль!

Хотя с сертифицированным TB4 кабелем он таки выдал честные 144 Hz. К сожалению, это не мой ноутбук, он на винде, так что понять что именно там в выводе xrandr невозможно, ибо Винда. Может быть, это DP 1.4? Интел обещает это в некоторых процессорах/встроенных видеокартах. Монитор говорит, что это USB-C вход, а что там внутри - шут его знает.

Созерцание версий протоколов с хоста

Но, можем ли мы что-то определить про версию протокола в кабеле из линукса? Вообще, мой look-n-feel в отношении кабелей в Linux оставил неприятное ощущение "ничерта не понятно", но это до момента, пока я не посмотрел как те же проблемы выглядят в Windows. Если в Linux трудно ответить "почему в настройках монитора нет такого режима", то в Windows невозможно даже посмотреть список всех режимов монитора, да и режим подключения монитора (через USB-C) не понятен. Это DP или HDMI? В Linux это обнаруживается по типу дисплея в xrandr - HDMI-0 vs DP-0.

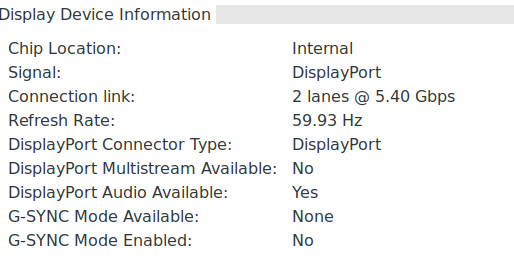

Ещё я обнаружил, что nvidia-settings может чуть-чуть расказать про Display Port.

Откуда она его берёт я так и не понял, даже из strace. Fun fact: HBR2 должен дать мне 4k@75hz. Ограничение 4k@60Hz - это ограничение чипа на моей старой видеокарте.

Дискретные видеокарты

Моя старая видеокарта показала 60-Гц лимит (на практике и в спеках):

Maximum DP resolution: 4096 x 2160 @ 60 Hz

Maximum DVI resolution: 2560 x 1600

Maximum HDMI resolution: 4096 x 2160 @ 24 Hz or 3840 x 2160 @ 30 Hz

Ну старьё, старьё, надо обновлять.

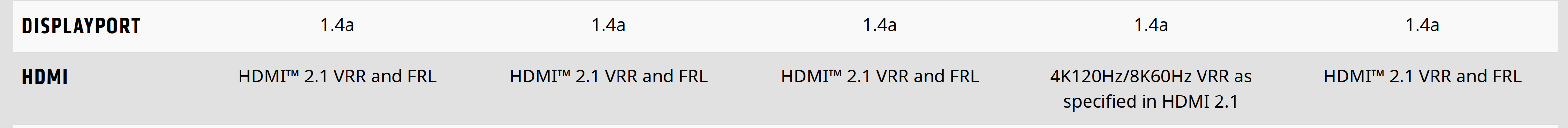

Берём килограмм денег, приносим продавцу и обнаруживаем что...

Вот так вот. Из трёх вендоров только самый задохлик умеет DP 2.0. Остальные ютятся в категории, которую мы забраковали или почти забраковали. Монитор умеет, видеокарты - нет.

С другой стороны, нас ждёт волшебный YCbCr420 и DSC... Но про это ниже.

А пока получается, что в этом скудном режиме надо либо тормознуться на 120Hz (вместо 144Hz), либо надеяться, что DSC (компрессия) реально незаметна. AMD обещает RDNA3 где-то там в марте 2022 года, а сейчас уже апрель заканчивается...

Казалось бы, надо брать Arc, но он только в нотубуках, но мы и без помощи arc увидели 144 Hz у нотубука. А дискретной версии Arc нет.

На выходе победил баланс разума с пошедшими вниз ценами, и я стал обладателем скромной RX 6600 (без всяких "XT") за скромные же €350. Плюс €28 доставка. Кипр, блин. Но с ценой я ждал-ждал и дождался. Три месяца назад эта же скромность мне бы обошлась в €500, а пол-года назад - в €750.

Видеокарта приехала, xrand -r 144 и всё стало хорошо, быстро и ловко. Просто DP8k кабель (я не знаю какой из UHBR'ов). Как оно пролезло в DP 1.4, да ещё и в 10 бит (если верить xrandr --verbose), я не понимаю. Видимо, DSC. Где смотреть состояние DSC я пока не нашёл.

Извращения

Пока я ждал видеокарту, я решил выжать невозможное из своего железа и попробовать нестандартные подходы. Многие из них не заработали, но PBP получился.

PBP-режим

Есть такое извращение - PBP. Когда монитор делит экран на две половинки и каждая половинка показывает картинку со своего источника сигнала. В общем случае монитор можно подключить к двум компьютерам и смотреть с них обоих, но частный случай состоит в подключении монитора двумя кабелями к одному компьютеру

Казалось бы, ура. Но моя (старая) видеокарта в таком режиме работать не любит, и даёт только 60Hz. Более того, HDMI в этом режиме совсем бесится и даёт только такое:

1920x2160 59.93*+

1280x1024 75.02 60.02

1280x960 60.00

...

Т.е. теоретическая возможность есть, но на практике: 1) На Nvidia не работает по причине фашизма в драйверах. 2) На Intel (ноутбуке) работает, но требует два провода для подключения и нетривиальных манипуляций в настройках монитора и xrandr, что крайне далеко от 'plug and play'.

После долгого медитативного чтения я нашёл информацию, что Nvidia можно "уговорить" не фокусироваться на EDID'е (данных, которые отдаёт монитор).

У меня заработала такая конструкция: (`/etc/X11/xorg.conf.d/nvidia.conf`)

Section "Device"

Identifier "Device0"

Driver "nvidia"

VendorName "NVIDIA Corporation"

Option "ModeValidation" "AllowNonEdidModes,NoDisplayPortBandwidthCheck,NoVirtualSizeCheck,NoMaxPClkCheck,NoHorizSyncCheck,NoVertRefreshCheck,NoWidthAlignmentCheck"

EndSection

После этого я сумел сделать невозможное - заставил HDMI (старый-престарый HDMI, который едва-едва умеет 4k@30Hz), сделать вот это "половинное" разрешение заработать на 75Hz. DP тоже согласился. DP может и больше, но у моей старой-престарой видеокарты только один DP, так что мне пришлось его ограничить тоже на 75Hz. На выходе получилось 4k@75Hz и фантастическая ерунда в текстововой консоли при загрузке (когда видеосигнал повторяется дважды на левую и правую половину экрана). Надо сказать, что 75Гц - это предел. Даже 76 не принимаются.

xrandr при этом справедливо считает, что это два монитора и транслирует это в window manager. После чего у нас панель задач только на одной половинке экрана, а окна "липнут" к середине, как обычно липнут к краям. И окно логина в половинке экрана, и перепрыгивает между левой-правой половинками, в зависимости от положения курсора мыши.

Интернеты подсказали, что xrandr'у можно сказать, что "два output'а - это один monitor".

xrandr --setmonitor chimera auto HDMI-0,DP-1Но, как оказалось, у абстракции 'monitor' нет никаких последствий. Так что мимо.

На всякий случай, вот мой скрипт конфигурации PBP для DP-1 и HDMI-0:

xrandr --newmode "1920x2160x75" 335.7 1920 1928 1960 2000 2160 2224 2232 2238 +HSync -VSync

xrandr --output DP-1 --mode 1920x2160x75

xrandr --output HDMI-0 --mode 1920x2160x75Итог: 75Гц и бешенные окна, которые даже толком в fullscreen не развернуть?

Я записал себе победу над спецификациями и здравым смыслом, но этот пост писался в обычном DP-режиме (4k@60Hz).

Компрессия

DSC в Display Port обещает компрессию сигнала и возможность пропихнуть 144 Hz через DP 1.4. К сожалению, моя старая видеокарта не умела такого.

Второе предложение - понижение качества картинки за счёт другого sub-sampling. В иксах sub-sampling настраивается в конфиге (не xrandr). В конфиг выше надо дописать:

Option "ColorSpace" "YCbCr444"Только вот YCbCr444 не даёт эффекта по уменьшению используемой полосы. Для этого надо YCbCr420. А на это моя видеокарта говорит, что 'unsupported mode'. Хотя, наверное, на более новом устройстве будет лучше.

На новой RX 6600, я не нашёл как узнать, что именно включено, что у меня через DP 1.4 пролазит 144Hz... Более того, мне обещали, что DSC будет не заметен, но комбинация redshift и 144Hz начала давать на экране очень странные артефакты. Чаще всего их почти невидно, но в те моменты, когда они появляются, возникает ощущение "это у меня глюки или на экране?", потому что артефакты подозрительно напоминают хроматические абберации от очков на контрастных паттернах.

А оно того стоит?

Зачем мне 144Hz? Особенно, на 4K? Разумеется, не для игрушек.

Я начинал с 13" EGA. После нескольких итераций CRT превратился в LCD.

По мере того, как росли дюймы экрана я не мог отделаться от ощущения, что раньше всё было быстрее (или, как сейчас я могу уточить, "плавнее").

Я долго думал про эту проблему и понял, что она объективная, и не связанная с гигагерцами или bloatware на компьютере.

Если у нас 60 кадров в секунду, то чем больше (физически) экран, тем больше сантиметров проходит между двумя соседними кадрами при движении чего-либо по экрану. А с переходом на 4k - и в пикселях тоже.

Это приводит к дёрганной картинке в самых простых бытовых задачах - редактировании текста, движение окон, скроллинге, время реакции на печатать.

То есть я сделал себе 4k@144 ... для офисной работы. Комфортной офисной работы. И абсолютно, ни секунды не жалею. Переход с старого процессора на новый был приятным, и субъективно я бы сказал, что компьютер стал раза в полтора быстрее и перестал тормозить. Субъективно, конечно.

Вот это субъективное ощущение "всё тормозит" на 60Гц больших экранов вне зависимости от скорости железа и даже скорости софта, именно оно прошло после перехода на 144Гц. Наверное, разница 120-144 не ощутима, но разница 60 -> 120+ - это лучшее, что можно сделать для повышения комфорта работы на компьютере.

Postscriptum

Буквально за несколько дней до публикации (пока я прилизывал текст и исправлял ошибки) вышла новость, что AMD сертифицировала первый чип на DisplayPort 2.0, причём только на самый медленный из UBHR-кабелей.

Комментарии (102)

lgorSL

13.05.2022 12:56+7Кстати, некоторые мониторы поддерживают глубину цвета не 8 бит, а все 10. Но с поддержкой в ОС и стандартизацией тоже всё плохо.

Ionenice

13.05.2022 17:59+2Вот и выходит, что во всех сферах, связанных с графикой, все сидят на apple, а при необходимости других компонентов платят больше

DistortNeo

13.05.2022 19:26Не столько плохо, сколько зачастую не нужно даже в профессиональных приложениях. Всё дело в том, что 10-битный цвет на 8-битном мониторе прекрасно имитируется дизерингом. При высокой плотности пикселей человек в принципе не сможет увидеть разницу. А если нет разницы, то зачем платить больше?

У меня, кстати, 10-битный монитор. Операционная система его поддерживает и я действительно вижу разницу в градиентах в видеоплеере или просмотрщике изображений:

https://github.com/jursonovicst/gradient

Но вот поддержка со стороны софта отсутствует почти полностью.

Да и ещё один фактор — это вычислительная сложность при работе с 10-битным цветом.

Короче, не стоит оно того.

ToSHiC

13.05.2022 21:46В каком цветовом пространстве? Переход на bt2020 должен дать огромное количество новых цветов, особенно в районе зелёного. На специально подготовленных роликах разница потрясающая.

DistortNeo

13.05.2022 22:18В каком цветовом пространстве?

DCI-P3

Переход на bt2020 должен дать огромное количество новых цветов, особенно в районе зелёного.

Новые цвета достигаются не за счёт повышения разрядности, а за счёт расширения цветового охвата.

Смысл в разрядности тоже есть, но немного в другом: для корректного отображения sRGB изображений на таком мониторе придётся делать ужимающее преобразование, градиенты могут выглядеть некрасиво без дизеринга.

ToSHiC

13.05.2022 23:45+1Понятно, что за счёт охвата, но увеличивать охват без увеличения разрядность- это путь в никуда, градиенты будут ужасными.

Am1GO

13.05.2022 13:14+1@amaraoКак красноглазик красноглазику советую https://tomverbeure.github.io/video_timings_calculator чтобы не компилять патченный cvt.

Все современные ЖК поддерживают CVT-RBv2, поэтому на полосе пропускания за счёт сокращения избыточных интервалов синхронизации (которые выражаются в пикселях по вертикали и горизонтали) можно круто сэкономить. На некоторых мониторах можно не следовать стандарту и сэкономить ещё сильнее, но это надо проверять с каждой моделью индивидуально.

YMA

13.05.2022 13:36+3Да, с подключением мониторов всё еще хуже, чем с зарядкой. Опять же, сравнивая со старым добрым VGA, всё стало лучше по качеству, но сложнее.

На днях сапгрейдил домашний компьютер, купил Ryzen 5 5600G и материнку Asus на A520 с выходами HDMI и DP - так столько кривизны повылезало 8-()

Монитор Philips 328P6 - поддерживает HDMI, DP, VGA, USB-C 3.1 Gen 1 (DP alt mode)

- по hdmi почему-то видятся разрешения вплоть до 4К, хотя монитор только 2К.

- при попытке поставить 75 Гц монитор тухнет, хотя на другом компьютере такую частоту выводит отлично;

- пытаюсь включить HDR (монитор это умеет, и 10-бит тоже), получаю блеклую картинку;

- изображение периодически подергивается и моргает;Кабели HDMI поперебирал, эффекта нет. В итоге подключил по DP, всё вроде нормально...

Popadanec

13.05.2022 22:33У меня второй монитор подключён: видеокарта, пассивный переходник DP-HDMI, кабель hdmi-hdmi, пассивный переходник hdmi- dvi-d, монитор.

Если использовать hdmi вход на мониторе, он не выключается вместе с ПК, если использовать выход hdmi на видеокарте(который нормально работает с основным монитором), то периодически появляются обрывы звука на втором мониторе.

Переходники дешёвые китайские.

Vaitek

14.05.2022 09:00+1Если у вас встройка АМД, там в настройках есть виртуальное сверхвысокое разрешение. Те самые 4к на 2к монике. Я так и не понял зачем оно мне, ну кроме как UI на 4к потестить.

WeoM

14.05.2022 22:06Зачем на встройке я не знаю, но на дискретке это используется для некоторых игр, чтобы картинка рендерилась в 4к и даунскелилась в 1440 ну или 1080. Там правда вылазят как раз траблы с UI и шрифтами, но это уже совсем другая история))

Tarakanator

13.05.2022 13:39+4В тему будет упоминуть что HDMI 2.1 бывает ненастоящий.

https://3dnews.ru/1055813/publikatsiya-1055813

P.S. Я вас понимаю у меня 4k 120гц HDMI 2.1 VRR Правда я покупал ради фильмов и игр, но в работе тоже заметил приятную плавность.

А ещё бы я упоминул наличие бесплатного VRR в HDMI 2.1(правда не всегда).

transcengopher

13.05.2022 17:00+3Прочитал.

Да что же это за расстройство такое в последнее время со "стандартами"?! Вместо того, чтобы давать потребителю простую метку, глядя на которую можно сходу определить, что за устройство — меняют обозначения задним числом, делают стандарт "гибким", и порождают целый ворох необязательных "расширений", которые теперь нужно отдельно выискивать.

Ладно консорциум USB, эти уже давно так. Но и HDMI теперь такой же.

transcengopher

13.05.2022 14:04+3Согласно Вики HDMI 2.1 умеет:

для стандартного видео:- 4K (3840x2160) — up to 144Hz (up to 240Hz with DSC (т.е. с компрессией))

- 5K (5120x2880) — up to 60Hz (up to 120Hz with DSC)

- 8K (7860x4320) — up to 30Hz (up to 120Hz with DSC)

- 4K (3840x2160) — up to 144Hz

- 5K (5120x2880) — up to 60Hz (up to 120Hz with DSC)

- 8K (7860x4320) — up to 30Hz (up to 120Hz with DSC)

amarao Автор

13.05.2022 14:35Я сейчас перепроверил - как-то всё странно. Одни говорят - 144Гц, другие - 120. В доках к моему монитору сказано "через HDMI - только 120Гц".

vagonovozhaty

13.05.2022 16:51

Marwin

13.05.2022 14:165k@120 27" с 200% масштабом - мечта последних лет как раз из-за желания плавности в интерфейсе. Пока же сижу на 4k@60 27" 150%. Текущая 1060 явно в пролёте. Скоро обновлюсь на алдерлейк и попробую отказаться от жефорса в пользу встройки. Я не играю вообще, мне нужна только винда и ютуб.

Кто-нить удачно пробовал выводить со встройки UHD 770 именно с десктопных материнок в 4k@120 или в 5k?

amarao Автор

13.05.2022 14:37В оправдание RX6600 скажу, что она очень тихая в десктопных режимах. Интелы тоже тихие, но у них много глюков во время динамического переключения по USB-C (включая битые текстуры после саспенда). Возможно, на DP они не так заметны.

Alex__Green

13.05.2022 16:10Я на 12600k видел у себя 3840*2160, но без HDR (его активация была недоступна)

НО: это было когда я во время перезагрузки переключил кабель HDMI из выхода карты к выходу материнки (хотел проверить работоспособность видеоядра), т.е. данный режим 4k 120 hz был включён ранее. Надо будет попробовать выбрать его из более низкого.

eps

16.05.2022 08:345k@120

Поделитесь моделькой?

Лучшее из бытового, что я видел, это LG Ultrafine 5k, и там всего 5k@60Hz в SDR.

Подключается по Thunderbolt 3, кстати, и подходящий провод в комплекте.

Ещё можно подключить по USB3, но будет всего 4k@60Hz.

Marwin

16.05.2022 10:17так оно потому и мечта, ибо нету )) Вообще удивительно, как в этом направлении медленно движется рынок. 2560х1440 - очень популярное разрешение для 27", равно как и 120/144 стало широко заходить в последние пару лет, но вот явно напрашивающиеся 5k аналог этому для х2 масштаба народ почему-то очень тухло вопрошает.

dvv47

13.05.2022 14:32Утверждение что по hdmi 2.1 может работать не быстрее 120гц не верно

Его пропускная способность 48гбит этого достаточно для 10битной картинки в 144гц. Что бы это заработало надо что бы и монитор/тв это поддерживал. Пример тому lg 27gp950. Все работает. Еще судя по спецификациям заработает и на ag274uxp, 279m1rv

Тем временем по displayport 1.4

без компрессии 10бит - 95гц

Без компрессии 8бит - 120гц

С компрессией хоть 10бит 160гц

Читал что dsc умеет сжимать трафик в 2 раза

В m32u - hdmi2.1 работает на скорости 24gbps, поэтому DisplayPort 1.4 тут предпочтительнее

amarao Автор

13.05.2022 14:39Ага, спасибо. Получается это такая половинка от HDMI 2.1. Невероятно consumer oriented.

Tarakanator

13.05.2022 15:02+2Похоже вы не посмотрели мою ссылку

https://3dnews.ru/1055813/publikatsiya-1055813

vconst

13.05.2022 15:05Немного напоминает бубны с подключением старого монитора к старому ноуту, Nec pa271w к Lenovo x260. Монитор умеет в нечто среднее между 2к и 4к 2560*1440*87, на на ноуте выходы HDMI и mini-DP.

Долго ломал себе башку — как заставить монитор работать на полном разрешении (DP кабеля у меня не было), пока, как в анекдоте «Ну что, сломал?», не заглянул в спеку. Оказалось что 1080 это максимум, что может выдать встроенная графика через HDMI.

После покупки простейшего mini-DP/DP кабеля (у меня же не 4к), и установки новых дров (Леново радует поддержкой, все дрова и BIOS от 22 года) Nec завелся в аппаратном разрешении, хотя на 60 герцах, вместо 87, но это уже мелочи. При этом, одновременно с ним, работает второстепенный 19" на 1280*1024 и 12" экран самого ноута на 1920*1080.

Три монитора (правда, чаще всего один Nec) в полном разрешении — удобная штука. Хотя, друзья меня склоняют к покупке одного длинного. Собственно, благодаря этому я включаю десктоп только чтобы погонять полчасика в PUBG, а в остальном мне хватает ноута, чаще всего он лежит с закрытой крышкой и я подумываю о покупке для него дока.

Бонусом ко всему этому оказалось то, что 27" моник имеет встроенный USB-свитчер и переключение видеовыхода — переключает между компами и воткнутые в него мышку с клавой.

Все таки, раньше с кабелями было проще :)

Tarakanator

13.05.2022 15:10не особо проще

DVI-I

DVI-D

dual-link dvi(это моя последняя задачка, как подключить DVI dual-link монитор к современной видеокарте, где DVI нет) Оказалось проще купить новый монитор.

Хотя конечно именно с кабелями было проще, но со стандартами и раньше приколы были

amarao Автор

13.05.2022 16:12Я как раз с 2560х1440 переезжал на 4k. Стало приятнее.

vconst

13.05.2022 16:15Да, 4к куда приятнее. У меня хорошее зрение и на 27" и 2560 я различаю пиксели — это раздражает

amarao Автор

13.05.2022 16:38А для меня критическим было увеличение вертикального разрешения. Моя история мониторов: ... FHD, 2560x1440, 3840x1440 (работа)... Так что я на почти 10 лет застрял на 1440. А тут 2560 по высоте. Первый апгрейд за 10 лет, прям ощущается.

vconst

13.05.2022 16:40Меня очень радовал Делл на одной работе, 32" и разрешение, я даже не помню сколько, точно больше стандартного 4к. Но и стоит он космически. Четкость такая, что просто за пределами различимого любым глазом. Словно в окно смотришь

13werwolf13

13.05.2022 15:51читал с удовольствием, "лайкнул" бы в карму да не дано мне это

по поводу

А оно того стоит?

это сильно субъективно. я работал с человеком который глянув на монитор буквально на секунду говорил на скольки герцах он работает безошибочно.. а у меня другая ситуация, всё что ниже 75 герц меня нервирует, а выше я просто не вижу разницы, так что 75 для меня идеально, но вот за вменяемые деньги продаются только 60герц...

E_STRICT

13.05.2022 15:53+1А в каких случаях 144 Гц реально нужно? Игры?

vconst

13.05.2022 15:56+5Есть легенда, что некоторые люди ощущают мерцание меньше 10 килогерц

amarao Автор

13.05.2022 16:01+1LCD экраны (хорошие) не мерцают. Тут вопрос в другом - движение мышки из одного угла экрана в другой - это сколько кадров? 15 или 36?

vconst

13.05.2022 16:07+1Честно говоря — не задумывался никогда :)

Может когда попадется экран с частотой побольше — гляну. А на что это влияет?

YMA

13.05.2022 16:23+3Попробуйте от противного ;) - поставить 30Гц.

Я так напоролся на телевизоре, подключив к нему компьютер (ТВ умеет 4К только в 30Гц с внешних источников). Не мог понять, что не так - изображение "дерганое", вроде не мерцает, но глазам неприятно.

vconst

13.05.2022 16:24Ну нет )

30 это уже за гранью комфортного, мерцание физически очень заметно. На 60 хороший монитор уже не мерцает так заметно для глаза

YMA

13.05.2022 16:43Не, не мерцание, подсветка вообще DC, матрица обновляется 400 Гц. А это именно редкое изменение картинки со стороны компьютера - тащишь окошко, а оно "прыгает", а не плавно движется. Мышь тоже - курсор "телепортируется".

Как раньше на пассивных LCD матрицах было, только там еще и след тающий оставался за объектом.

vconst

13.05.2022 16:44Я недавно поработал за монитором, у которого след за мышью… Это было ужасненько

amarao Автор

13.05.2022 16:00+1А что такое "реально"? Например, в каких случаях реально нужно больше 14" экран? Что вы не можете сделать на 14", из того, что можете на 32"?

Исключительно комфорт и удобство.

vconst

13.05.2022 16:08Конечно есть

При работе в Adobe я всегда разворачиваю множество панелей и никогда не скрываю их, потому что порой приходится контролировать сразу много параметров одновременно. И на 14" это физически невозможно

amarao Автор

13.05.2022 16:10+1Вы путаете пикселы и дюймы. 14" 4k экран по количеству пикселов не отличается от 32" 4k экрана. Так почему же 32", а не 13"?

vconst

13.05.2022 16:14+1Еще раз — на 14" физически невозможно сделать то, о чем я говорю. Потому что панели не просто должны быть открыты, на них еще надо что-то разглядеть. На 27" они занимают ровно половину экрана, потому для комфортной работы надо или 32" или второй монитор, чтобы картинка была на весь экран

*.ps

Можно не троллить так примитивно?

amarao Автор

13.05.2022 16:39+2Ну вот вы и сказали главное: "для комфортной работы". Переход между 60 и 144 такой же. В принципе, ничего не поменялось (все пикселы на месте), но стало комфортнее.

vconst

13.05.2022 16:43Я сказал что это «физически невозможно», в принципе нельзя сделать на 14". Это не просто «некомфортно» — а тупо нельзя. А вопрос комфорта — это разница между 24-27 или 32

Ionenice

13.05.2022 17:56+1вы всё ещё путаете пиксели и дюймы, как и сказали выше. Какая разница какого размера дисплей, если в него влезает условно 100 пикселей по ширине. Окно панели будет занимать 50 пикселей что на 32 дюймах, что на 9, разница лишь в dpi. Так что физически это возможно и отличий кроме «масштаба» дисплея не будет

upd. минус (и в карму?), ох, тяжело…

Tarakanator

13.05.2022 18:34+3Такая, что шрифт с низким угловым разрешением я не увижу.

Ionenice

13.05.2022 18:40Он исчезнет или просто восприятие человеком / комфорт поменяется? Человек выше говорит про что-то «физически не возможное»

Tarakanator

13.05.2022 20:59+3если он станет мелким и придётся напрягаться чтобы разглядеть, это комфорт поменяется.

Если станет настолько мелким, что его не видно-работа станет невозможной.

Ndochp

13.05.2022 17:09Ну поставьте линзу, телевизор КВН все же видели ;)

(переведя взгляд на 15" 4К ноут 100% масштаб, 32 пиксельную иконку разобрать можно, но с трудом)

rogoz

13.05.2022 17:32На Nvidia не работает по причине фашизма в драйверах.

Вчерашняя новость: «Компания NVIDIA открыла код видеодрайверов для ядра Linux».

Правда неизвестно, поможет ли это.

transcengopher

13.05.2022 18:03+4Главное "мясо" драйвера по-прежнему остаётся закрытым, открыли по сути только очень малую долю, и непонятно, собираются ли открывать остальное.

Дело-то пошло, но знаменитый средний палец убирать пока ещё рановато.

amarao Автор

14.05.2022 11:53Не поможет, потому что они открыли сырцы кода, который и так компилируется на целевой машине (т.е. это просто смена лицензии). Вся мякотка - в блобах, которые они не открывают.

noodles

13.05.2022 17:49+3По мере того, как росли дюймы экрана я не мог отделаться от ощущения, что раньше всё было быстрее

чем больше (физически) экран, тем больше сантиметров проходит между двумя соседними кардрами при движении чего-либо по экрану. А с переходом на 4k - и в пикселях тоже.

Это приводит к дёрганной картинке в самых простых бытовых задачах - редактировании текста, движение окон, скроллинге, время реакции на печатать.

То есть я сделал себе 4k@144 ... для офисной работы. Комфортной офисной работы

Я именно по этим причинам в своё время "принял и простил" тот факт, что всё что выше 1080p - зло. Мой конфиг - это два "безрамочных" монитора по 27" 1080р. Да, именно, две здоровые балды с большими пикселями. Отодвинул чуток подальше обычного и не нарадуюсь. Всё крупно, супер быстро, никаких лагов, приколов с настройками масштабирования, глаза не напрягаются. Дёшево, сердито, работает везде.

Некоторые работодатели очень удивлялись, когда просил именно 1080p мониторы, и ни в коем случае никаких 2к, или простигосподи 4к\8к. И когда иногда приходится посидеть за мониторами с ультра высоким разрешением - поражаюсь как люди это терпят, весь интерфейс "тормознутый" невозможно.

Есть пару нюансов - нужен не "компьютерный" стол, а нормальный добротный письменный стол. И находить новые мониторы 27"1080р - судя по всему будет всё сложнее..))

amarao Автор

14.05.2022 11:55Так 27" FHD лагает ровно так же, как 27" 4k. Потому что в сантиметрах между объектом на двух соседних кадрах одинаковое расстояние.

Попробуйте высочастотные мониторы. Обратной дороги нет. (Думаю как бы продать эту идею работодателю, потому что 4к - это ОК, а 4к 120-144 - как-то жирновато для рабочего места админа в консоли...)

vconst

14.05.2022 13:27+2«Лагает» — значит тормозит, что-то происходит с задержкой, нажал кнопку и через секунду появилась буква. А здесь совсем другой процесс — «выпадание кадров», но без всяких тормозов

amarao Автор

14.05.2022 13:56Лаг - это perceived delay. Двигаешь мышкой, а изображение появляется рывком. Чем больше дистанция, тем ощутимее рывок. "Двигается рывками" практически синоним к слову "лагает".

vconst

14.05.2022 14:14Лаг - это во всех определениях вообще: задержка, действия или сигнала. Это не просто движение рывками - это именно запаздывание, тормоза, когда действие не дает мгновенной реакции, а вовсе не синоним любому неровному движению.

Монитор же - не тормозит, вообще, он просто показывает меньше кадров между двумя положениями мышки или окна. Никогда не будет так, что на мониторе с низкой частотой - перемещение окна будет происходить через половину секунды от начала движения мышкой, а остановится, через половину секунды после прекращения движения

Скуки ради попробовал на сверхзамедленной сьемке телефона - подергать небольшое окошко через 27" монитор, максимально резко от края до края. Ну да, получается 6 кадров, на 120 герцовом будет 12 кадров. И эти 12 кадров на полуметровом расстоянии не кажется какой-то серебряной пулей, кардинально меняющей восприятие. Но это надо еще затестить в какомнить магазине

amarao Автор

14.05.2022 15:18На 144 будет 14 кадров. А теперь берёте любую игру и смотрите как она будет выглядеть на 6 FPS и на 14 FPS. По своим студенческим временам я помню, что на 10-12 ещё играть можно было, а на 6 - уж совсем никак.

vconst

14.05.2022 15:26Любая игра на 60 фпс выглядит уже абсолютно нормально. Именно 60 фпс является аналогом 60 герц на мониторе, а не «14 кадров»

amarao Автор

14.05.2022 15:39+1В игре у вас скорость перемещения тщательно контролируется дизайном уровней. Если вы возьмёте любую игру без этого контроля (например, происходящее занимает доли секунды), то разница между 140+ и 60 Hz будет "слишком быстро" и "ничего не понял".

Я же говорю про ощущение плавности в десктопной жизни. 6 кадров на перемещение чего-либо на 32-дюймовой поверхности (не говоря уже про 42", на котором я пытался некоторое время работать с 60Hz) слишком мало. В соседнем треде этот феномен правильно назвали "телепортацией". Начиная с определённой дистанции нет иллюзии движения, а есть телепортация, что мешает и сбивает.

vconst

14.05.2022 16:04Я же говорю, могу повторить — что пока сам не тестил и попробую при случае

У меня вопрос не к плавности и необходимости оной — а к тому, что это не является лагом. Я зануда и чту терминологию :) Что-то типа «смотря, что вы называете электроникой» — у меня вызывает рукалицоюжпг

amarao Автор

14.05.2022 16:33Я опираюсь на интуитивное определение. Чувствуешь, что лагает - значит, лагает. Существует целое искусство в UI делать так, чтобы latency была такой же (или даже чуть хуже), а лагов не было.

А насчёт электроники. Электроника - это наука об электронах.

Vsevo10d

13.05.2022 19:08+4монитор делит экран на две половинки и каждая половинка показывает картинку со своего источника сигнала. В общем случае монитор можно подключить к двум компьютерам и смотреть с них обоих, но частный случай состоит в подключении монитора двумя кабелями к одному компьютеру

И тут я понял, что ничего раньше не знал о подключении монитора к компьютеру.

Silverthorne

13.05.2022 20:23+1Что такое "лыдыбр"?

dartraiden

13.05.2022 21:04+4лытдыбр

Представляет собой кириллическую транслитерацию сочетания lytdybr, получившегося при наборе слова дневник на клавиатуре с ошибочно переключенной раскладкой (в режиме QWERTY). Слово пришло в начале 2000-х из обихода русскоязычных пользователей LiveJournal. Первая по времени запись, в которой появляется слово лытдыбр на кириллице, датирована 1 июля 2001 г. (в блоге Р. Лейбова); до неё в этом блоге неоднократно появлялись записи со словом lytdybr. Происхождение слова, быстро ставшего популярным, рассмотрено в блоге А. Воробья уже в марте 2002 г.

amarao Автор

14.05.2022 11:58Заметка из жизни. Сложная ре-русификация клавиатурной перекодировки слова "дневник".

mastan

13.05.2022 23:33+5Если в Linux трудно ответить "почему в настройках монитора нет такого режима", то в Windows невозможно даже посмотреть список всех режимов монитора, да и режим подключения монитора (через USB-C) не понятен. Это DP или HDMI? В Linux это обнаруживается по типу дисплея в xrandr -

HDMI-0vsDP-0.Не претендую на полноту инфы, но вот несколько вариантов, откуда можно выкопать больше информации о мониторе и его подключении в винде:

dxdiag. Запустить, но в его окошки смотреть совсем не нужно, нажать "сохранить все сведения..." и смотреть уже получившийся текстовый файл, раздел "Display Devices". Там много всего, в т.ч. тип подключения.

GPU-Z. На вкладке Advanced в разделе General перечисляет мониторы, тип подключений, и поддержку их форматов. Инфы по сравнению с другими выдаёт мало.

Moninfo aka EnTech Taiwan Monitor Asset Manager. Показывает тип подключения и инфу, вытащенную из EDID монитора. Несколько лет не обновлялся, может в чём-то врать если железо очень свежее.

CRU (Custom Resolution Utility). Внизу посмотреть на строчку в Extension blocks, нажать Edit и посмотреть там внутри, какие флаги включены.

Как это всё поведёт себя в сложных случаях как то подключение по USB-C не знаю, не проверял. В стандартных условиях они все показывают, что мой моник подключен через DisplayPort, а телик через HDMI, ну и там всякое про HDR, битность, цветовые профили и пр.

akhkmed

14.05.2022 01:41+3Офигеть, не думал даже, что в цифровых интерфейсах есть такая нестабильность. Видимо, всякие переходники вроде dvi-hdmi вообще ад.

amarao Автор

14.05.2022 12:09+1DVI уже сильно умирает, потому что там очень узкая полоса пропускания, категорически не совместимая с разрешениями выше FHD. По моим ощущениям DP - самый хороший стандарт для десктопа. USB-C должен был бы быть таким же для ноутов, если бы не (всё, что в статье выше).

namezys

14.05.2022 11:45Не знаю, каким чудом мы выбирали провода. Но у нас 3 USB c кабеля работают в 4к@144.

Ещё и Power delivery работает 100 Вт и USB 2.0

все это в alt mode с использованием DP и 10 бит

Уже месяца 4 использую с MacBook Pro на M1

Так же MacBook 2019 года тоже завёл 4к@144 из под windows, но это не рабочий вариант для меня

amarao Автор

14.05.2022 12:11+1Я рад за вас. Это кабели из комплекта с сотовым телефоном или вы их отдельно покупали? Если вы зайдёте в ближайший магазин и купите "обыкновенный кабель usb-c <-> usb-c", с большой вероятностью там не будет что-то, на чём можно данные передавать, но не больше. Необыкновенные с PD и TB - да, бывают, Например, dell такие прикладывает к своим мониторам. Но они дорогие и они вам либо с каким-то железом достались, либо вы специально их выбирали.

namezys

14.05.2022 12:23Отдельно. 2 с Ali.

Ну мы старались выбрать gen 2, 2x2 и тд. методом тыкай точек

Как-то чудом попадали. Но даже с али они не дешёвые, 15-25$

megahertz

14.05.2022 11:53Из-за таких танцев с бубном я для себя определился что два классических 24" 1920x1080x60Гц мне достаточно. Любой кабель подойдет, любая карта справится. При частых переездах не проблема купить такие мониторы и потом быстро продать за недорого. То что курсор двоиться - не напрягает. Больше всего напрягало использование мониторов с разным DPI. Wayland + KDE + Nvidia до сих пор плохо дружат все вместе.

tigreavecdesailes

14.05.2022 12:00+2Всегда думал, что во времена ЭЛТ за частотой гнались чтобы уйти от мерцания, создаваемого пассивным характером свечения люминофора.

А во времена ЖК/OLED, когда мерцания уже нет (не говорим о яркости через ШИМ), когда подсветка ЖК или диод OLEDa горит постоянно, частота обновления означает фактически частоту обновления изображения на матрице. Показатель чисто информационный, а не электрический. Фактически какой толщины информационный поток моник может размазать по матрице в секунду.

Отсюда следует, что важно лишь чтобы частота обновления экрана была равна/выше частоты обновления изображения. То есть FPS выдаваемого видеокартой. Я не гамер, но FPS 60 вроде даёт достаточную плавность даже в динамичных сценах. Ну а для движения мышки по экрану 60 FPS тем более достаточно, это слишком маленький объект чтобы увидеть его рваное движение.

Или что я не так понимаю?

amarao Автор

14.05.2022 12:04+1Во времена ЭЛТ 21" монитор считался монстром по размерам и там проблемы, о которой я говорю, не было.

Проблему мерцания люминофора решили, но по мере нарастания размеров экранов начала образовываться новая. Во времена 15-17" ЭЛТ 75Hz было более чем достаточно для плавности изображения.

А на 32" экране 60Гц (16мс между кадрами) вызывает ощущение "рваности" движения. Как будто всё тормозит. И чем больше экран, тем сильнее он тормозит субъективно. Я уже написал почему - между обновлениями картинки двигающаяся картинка проходит большую дистанцию в сантиметрах.

И речь не про FPS, а про офисную работу. В основном скроллинг и время реакции на ввод текста.

geher

14.05.2022 14:51+2Восприятие картинки индивидуально. И то, что одного раздражает, другой игнорирует, а третий не замечает.

"Телепортация" курсора мыши и более крупных предметов на экране (когда объект между двумя кадрами успевает пролететь значительное расстояние, что воспринимается уже не как плавное движение, а как прыжки по экрану) мне заметны даже на 15"х75Гц. На значительно большем экране (22" и больше) при частоте обновления экрана 60-75 Гц у меня иногда возникает эффект потери курсора мыши, когда взгляд теряет курсор из-за того, что он между кадрами "прыгает" слишком далеко от предыдущего наблюдаемого места.

Не сказал бы, чтобы оно меня бесило или как-то сильно мешало работать (потеря нескольких секунд на обнаружение "пропавшего" курсора мыши, конечно, печальна, но не настолько, чтобы на это сильно заморачиваться), но я это уже замечаю. А кое-кто из моих знакомых от такого уже просто звереет. И им эти супермегагерцы более чем актуальны.

Конечно, можно отодвинуть дисплей подальше, чтобы угловое смещение курсора стало снова небольшим, как раньше на 12-14", но это такое... Большой монитор хорош именно тем, что на него можно впихнуть больше информации. А чтобы ее можно было разглядеть, особо далеко монитор не отодвинешь.

Svbakulin

14.05.2022 12:41+2То есть я сделал себе 4k@144 ... для офисной работы. Комфортной офисной работы.

Уважаю. Refresh rate дико недооценен. 60гц никуда не годятся, не понимаю как люди этого не понимают :) хуже, по моей версии, пожалуй, только клавиатуры.

amarao Автор

14.05.2022 13:54+1Клавиатура у меня следующая на апгрейд. Это сложнее, чем монитор, потому что картинку можно посмотреть и оценить, а вот печать - сложно, нужно сначала привыкать.

Svbakulin

15.05.2022 16:06Ну, с клвиатурой боюсь все еще хуже :) тут не то что трудно найти подходящие компоненты и совмеситимые состовляющие, а ее просто нет. 144гц на 4к хотя бы с плясками можно уже сделать. А все что есть в клавах - ущербно или недаделано в самой сути. Там и работа мозга, и анатомия, и механика, и 19й век с qwerty, и почти полное отсутствие не то что понимания проблемы, а даже понимания того что проблема есть. Я про то как там все плохо могу часа два говорить, но решения пока к сожалению нет.

Два года назад я перешел на Colemak, пробовал Ergodox EZ и еще штуки 3 разных вариантов, вынужден был полностью забыть печать на кириллице (я реально не мог оставить на хабре двустрочных комментария) и выучить ее полностью заново, но единственное что понял - что все это хоти и лучше чем ANSI с QWERTY, оно все еще довольно далеко от того где как я вижу (а я не факт что вижу правильно) это дожно быть.

Komrus

14.05.2022 14:11+1Мы тут под одну специфическую задачу оснащения переговорной искали обычный десктоп с поддержкой видео через USB-C…

В общем, прикоснулись к тому же мраку и ужясу, что описаны в статье…

В спецификациях Хьюлетов и прочих Деллов обычно указано налие USB-C. Просто USB-C. Без всяких скучных подробностей.

Как выяснилось, даже если в описании конкретного артикула в явной форме говорится про «видео через USB-C» — не факт, что в данной комплектации так оно и будет.

Наиболее лостоверный признак — фото конкретной модели. Если есть значёк DP возле порта usb-c — то есть шанс на успех… :)

amarao Автор

14.05.2022 15:17+1На самом деле проще. Если у вас есть Thunderbolt, у вас есть DP внутри. TB4 обещает всё, что нужно, TB3 - на грани. Значок TB - молния.

Картинки

xJinXx

14.05.2022 22:06аналогично испытал сильную боль, когда вначале февраля уже на низком старте был чтобы купить новый ноут от АСУСов. олед/м2/вес 1,6/11 поколения проц - действительно неплохая обновка моему десятилетнему ноуту. но всю малину обос...перечеркнул HDMI интерфейс версии 1.4 2009 года - и покупка отменилась. очень хотелось чтобы ноут мог прокачивать телек 4K HDR10 60FPS. старый ноут шлет только FullHD. и также при выборе ноута непонятно было что делать этим Thunderbolt и еще чихарда с этим Type-C, то какие-то поддерживают зарядку или еще что-то - очень не понравился такой подход в описании интерфейсов и возможностей устройства.

keenx

По опыту DP 1.4 умеет больше, чем 144 Гц. Мой пример: 5120х1440 на 240 Гц по единственному DP 1.4, причем как на AMD, так и на Nvidia. 5120х1440 всего на 11% меньше, чем 4K.

amarao Автор

Видимо, DSC. Я не знаю как увидеть насколько он "жмёт".