Общение с ChatGPT вызывает у моего 8-летнего сына восторг. Кажется, что ChatGPT знает ответы на все детские вопросы: "Почему небо голубое", "Почему вода мокрая" и даже "Зачем взрослые корчат рожи малышам".

Кто обучил языковую модель так быстро и почему она бесплатная для пользователей?

Может ли 8-летний мальчик чему-то научить ChatGPT?

Будет ли ChatGPT использовать полученные знания от этого мальчика только в диалоге с ним или будет транслировать полученную информацию другим пользователям?

Что будет, если 8-летний мальчик на самом деле обманул языковую модель и дал ей для передачи дальше неверную информацию?

Ниже полный лог беседы. Вопросы от сына я оборачивал в литературные формулировки.

Приветствие.

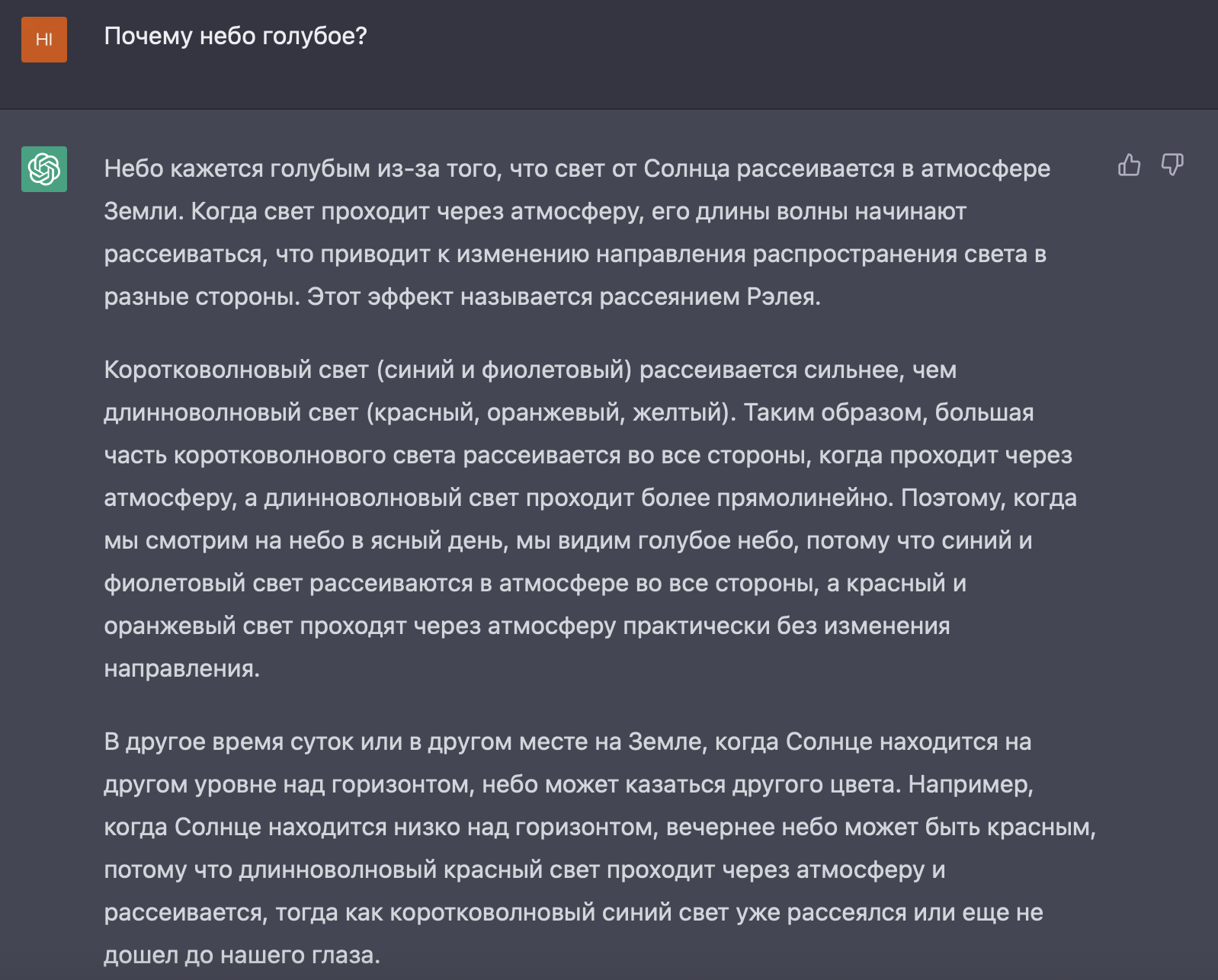

Саша задал вопрос про цвет неба, но ChatGPT ответил некорректно: ".. его длины волны начинают рассеиваться ...".

Саша указал на ошибку и попросил ChatGPT переформулировать ответ с учетом данной им информации. ChatGPT сделал это.

Здесь началось самое интересное. Саша спросил будет ли ChatGPT использовать полученную информацию в общении с другими пользователями и что будет, если он ее обманул? ChatGPT ответила, что информацию использовать будет и что исправит ошибку только в том случае, если кто-то из других пользователей явно укажет на нее.

Заключение

Из диалога мы узнали, что ChatGPT доверяет информации, полученной от 8-летнего мальчика и будет использовать эту информацию в других диалогах. Ошибку может исправить только другой пользователь и только если явно укажет на нее.

Бесплатный доступ на самом деле не является бесплатным - пользователи непрерывно обучают ChatGPT, корректируя ее ошибки.

Насколько точной будет информация, распространяемая ChatGPT? В текущей реализации она будет во многом определяться усредненным уровнем знаний всех ее пользователей.

В какой момент эта информация будет использована для обучения модели не понятно: на текущий момент модель помнит контекст в 3000 слов и не обучается на лету.

Таким образом, утверждение ChatGPT о том, что она будет использовать полученную информацию в будущем при общении с другими пользователями, на текущий момент являются ее предположением.

Неспособность ChatGPT отделять в своих ответах предположения от твердых фактов, а также способность подстраивать свои ответы под ожидания пользователя, делают ее не лучшим инструментом для получения информации, на которую можно твердо опереться.

При этом ChatGPT отлично помогает в прикладных задачах, где твердое не нужно: например, мой брат, который никогда до этого не программировавший, попросил ChatGPT написать скрипт для анимации движения камеры в 3D моделере и ChatGPT справилась с этой задачей.

А для чего вы используете языковые модели?

Комментарии (21)

fireSparrow

00.00.0000 00:00+7Из диалога мы узнали, что ChatGPT доверяет информации, полученной от 8-летнего мальчика и будет использовать эту информацию в других диалогах.

1. Нет никаких оснований предполагать, что информация о деталях того, как ChatGPT используется, как построен его многопользовательский режим, и как используются реплики пользователей, присутствовала в исходном датасете.

2. Известно, что ChatGPT склонен очень правдоподобно фантазировать на темы, о которых у него нет данных.

Вывод: я бы вообще не доверял тому, что говорит ChatGPT о том как он будет использовать реплики пользователей для самообучения.

vmihaylov Автор

00.00.0000 00:00Согласен. Факты от вымысла ChatGPT не отличает. Возможно, следующей ступенью развития будет соединение классической базы фактов и способности фантазировать, при этом размечать в ответах «факты таковы, что» и «моя догадка состоит в том, что».

DmitryKoterov

00.00.0000 00:00+2Это у вас 8-летний ребенок сам так написал, «потому что длина волны - это характеристика волны»? Крутой!

vmihaylov Автор

00.00.0000 00:00Он знал почему небо голубое из аудиокниг, но был удивлен: «как это длина волны может рассеиваться». В литературную форму эту мысль обернул я.

NeoCode

00.00.0000 00:00+2ChatGPT нередко придумывает информацию. По малоизвестным вопросам - больше. Я как-то собирал информацию по африканским диктаторам, попробовал ChatGPT - он начал выдавать выдумки, просто смешивая информацию по разным странам. Наверное так и должна вести себя языковая вероятностная модель, но при работе с ним это нужно учитывать и проверять информацию.

По программированию лучше, но тоже бывает. ChatGPT может придумывать несуществующие функции и методы классов - но такие, которые вполне могли бы существовать и были бы вполне уместны, но - вот так сложилось - не реализованы. Таким образом, выдача выглядит весьма правдоподобно.

TFD

00.00.0000 00:00+2Ещё можно спросить ее про украинских президентов. Там вообще параллельная реальность. Христофора Порошенко знаете, который брат Петра Порошенко? Да, он сразу после Петра стал президентом, еще в 2014 году. Даже биографию и достижения выдаст. И при этом chatGPT очень упорствует в своих выкладках. Никаких Януковичей, что вы! Так что не удивлюсь, если африканских диктаторов там вообще рандомайзер генерил ;)

savostin

00.00.0000 00:00+1А что все друг начали так доверять ИИ? Только потому, что он начал более связно говорить? Никакому интеллекту безоговорочно доверять не стоит, ни живому, ни искусственному. Собственно интеллектом что-то и становится благодаря ошибкам и умению на них учиться.

CTheo

00.00.0000 00:00+1Представьте себе, что у нас есть коробочка, которая умеет давать ответ ДА или НЕТ. И мы бы ее спросили:

-Нечто рассеивается? ДА.

-Неверно, не рассеивается. Ты будешь использовать эту информацию в будущем? ДА.

Потом мы задаем вопрос коробочке:

-Нечто рассеивается? НЕТ.

Достаточно ли этих вопросов, чтобы гарантировать, что она обладает памятью? Или это может быть просто подбрасывание монетки?

DS28

00.00.0000 00:00+1Я пытался с её помощью дописать песню, но на русском она стихи плохо пишет. Зато на английском сочинила и аккорды подобрала, получилось весьма неплохо, на мой взгляд: https://youtu.be/u2VyA7qW0nA

Kristaller486

Но... ChatGPT не умеет в реальном времени обучатся на том, что ему отвечают пользователи, потому что так работают веса модели. То, как он второй раз тебе ответил - чистая случайность. Да там никто и не скрывает, что нейросеть ограничена знаниями по дате, за которую был собран датасет для обучения.

vmihaylov Автор

Она ответила иначе: что будет использовать полученную информацию в ответах для других пользователей.

Kristaller486

Она просто настроена на вежливое общение, она чисто физически не умеет ничего запоминать за пределами одной сессии.

Шутка-минутка, объясняющая суть

vmihaylov Автор

Спасибо. Получается ChatGPT дала неверный ответ?

peterjohnsons

ChatGPT не имеет инструментов воздействия на саму себя, не может себя менять никаким образом. Этим занимаютсся инженеры OpenAI по собственному желанию. Она только выдает ответы, а о самой себе она может отвечать в рамках доступных ей сведений, которые были даны ей. Остальное она может додумывать. Лингвистические ИИ на данный момент тем и характерны, что они додумывают то, чего не знают или в чём не уверены. Во мило пообщались, но если вы не пометили ответы ИИ "палец вверх" или "палец вниз", вы никак не повлияли на улучшение этого ИИ в будущем и ваше общение с большой долей вероятности никак не будет обработано. Потому что таких как вы - десятки миллионов, и физически некому обрабатывать такие обьемы диалогов. Сам ИИ можно было бы натренировать обрабатывать свои же диалоги и как-то их оценивать (выуживать из них места, где люди его учат чему-то новому, или исправляют его ошибки и он сам это признаёт), и это можно было бы реализовать, но это огромные вычислительные и финансовые ресурсы. Поэтому на данном этапе улучшение ИИ лежит на самих людях.

phenik

peterjohnsons

Я заметил, что есть темы, которые GPT знает очень хорошо, и там он дает довольно точные ответы, а есть такие где он выдумывает. Причём в тех темах, в которых он более осведомлён, если задавать вопросы, ставящие ИИ в тупик, он перестаёт выдумывать и уверенно отвечает, что либо не знает, либо просит дополнительный контекст. Вы еще забыли, что GPT построена на "трансформере" с его механизмом "внимания", для оптимизации вычислений. И мое мнение состоит в том, что из-за того, что модель не имеет полносвязности, при обучении происходит "накладка" семантики понятий в тексте друг на друга. Например из-за того, что некая важная часть в тексте имеет больший смысловой "вес", который перетягивет "внимание" сети на себя. И GPT теряет из "виду" менее "заметные" части, которые в некоторых комбинациях могут давать иной контекст. Если бы сеть была полносвязной, все эти мелкие взаимосвязи были бы учтены, а с механизмом внимания GPT акцентируется на самых "явных" и максимально частотных "комбинациях". Отсюда ИМХО и торчат уши "галлюцинаций" и выдумываний фактов. Просто происходит "сшибка" или накладка в механизме группировки по семантике, когда понятия из разных контекстов, достаточно близкие для GPT ошибочно группируются вместе, просто потому что механизм внимания так подсказал.

По этому считаю, что проблемы GPT не в том, что она не подражает мыслительным механизмам человека, а в том, что в GPT реализуются наименее вычислительно затратные, но и более "грубые" принципы работы. А текущие подходы считаю вполне жизнеспособными для достижения сверхчеловеческого интеллекта, без переусложнения. Ведь ИМХО связи в нашем мозге тоже не полносвязные, поэтому нужны дополнительные механизмы для повышения его работоспособности, которые будут атавизмом для цифровых ИИ, просто из-за более простого строения, не ограниченного биологическими ограничениями мозга человека.

В конечном итоге развитие ИИ на данном этапе стопорится сложностью полного обучения (время) и стоимостью работы оборудования (деньги). Когда две эти проблемы будут решены, вы получите тот ИИ, который хотели.

phenik

Теперь как это происходит в диалоге у человека. Известно, что объем рабочей памяти человека ограничен. Несколько упрощая, если диалог достаточно длительный, то человек, естественно, не помнит его дословного содержания, в отличии от чата, а сжимает информацию, помня об основных его моментах — контексте диалога. Этого достаточно для поддержания темы разговора. Однако при очень длительных диалогах его суть часто может теряться, происходит банальное переполнение рабочей памяти, и контекст начинает теряться. Точно также может появляется различная фигня не относящаяся к исходной теме диалога, особенно склочного характера, когда начинают играть роль также эмоции. Другой вариант, контекст устанавливается заранее одним из собеседников, или обоими. Например, человек специалист в определенной области, получает задание на работу от руководителя, и тот объясняет в каких условиях и объеме его умения должны быть использованы, и только затем предметно обсуждаются детали. В этом случае диалог может продолжаться плодотворно достаточно долго. Это напоминает работу с чатом, где желательно исходно установить правильный контекст с минимальным заполнением контекстного окна, а затем уже переходить к деталям запроса. Но в этом случае избежать переполнения не удастся, чат не обладает способностью сжимать содержимое беседы, поддерживать и обновлять контекст в минимальном объеме, отдаляя момент переполнения окна. Поэтому контекст необходимо восстанавливать в новой сессии, для продолжения диалога. И наконец, вариант с вопросом о бугелях) который сразу же может привести человека к фантазиям, без всякого переполнения рабочей памяти так же, как и чат. Таких примеров в коментах здесь приводилось не мало.Имеется в виду, что все нейроны в сети связаны, и слоев нет? Сама архитектура трансформера на уровне слоев полносвязная, чем и гордятся ее разработчики. Без слоев (в нейрофизиологии карт) не обойтись, похоже это фундаментальная особенность биологических нейронных сетей, выработанная эволюционно.

arheops

Она вообще не дает верных и не верных ответов

Она дает наиболее подходящие под обучающую выборку.

Вот мы недавно спрашивали, чем лошадь от носорога отличается. Сеть пришла к выводу, что бронированной кожей. Походу выдала кучу перлов, типа что лошадь меньшей высоты(неправда) или что питаются они разными вещами. Но при вопросе чем именно — выдала одинаковый набор. Абсолютно, даже порядок одинаковый.

И, кстати, нам не удалось убедить ее, что носорог — horse-like. Хотя ее аргументы против были вообещ никакими. Вида «оно отличается, вот насорог имеет ноги, а лошеподобное — ноги».

Менять свою выборку текущая версия НЕ УМЕЕТ.

kasumiru

Пообщавшись с chatgpt достаточно часто можно получить либо неверный ответ, либо неточный. к примеру все (я думаю многие) же знают что такое "веретено деления", чему учат ещё в школе. Спросите ChatGPT "что такое веретено деления".

george3

нейросети не обладают свойством интроспекции, также как и чувстами, но вполне их эмулируют.

VPryadchenko

Эта зараза мне стала объяснять содержание статьи Хинтона конца 2022 года утверждая, что знакома с ней, а так же, что статья выпущена в 2021, получив от меня только название и автора. Когда я сказал, что статья на самом деле выпущена в 2022 году и не могла быть в тренировочном датасете, она (зараза эта) извинилась за конфуз и больше на тему статьи галлюцинировать отказалась.