Привет, Хабр! Сегодня — международный день доступа к информации, поэтому делюсь с вами интересными материалами по ML, AI и дата-аналитике. В новом выпуске вас ждут новинки от Nvidia для LLM, три пути развития аналитического стека, инструменты для анализа данных и другое. Еще больше полезных текстов по DataOps и MLOps — в Telegram-сообществе «MLечный путь».

Используйте навигацию, если хотите выбрать интересующий раздел:

→ Теория

→ Практика

→ Инструменты

→ Мнение

→ Инфраструктура

→ Обзор рынка

→ Видео

Теория

How To Set Up Your Data Analytics Team For Success – Centralized vs Decentralized vs Federated Data Teams

Обзорный материал от Seattle Data Guy о разных способах организации аналитических команд. С первыми двумя — централизованными и децентрализованными — все понятно и без дополнительных комментариев. С федеративными уже интереснее. Появляется единая технологическая платформа с единым стеком для всех, а также команда для ее обслуживания и развития.

Apache Druid: Making 1000+ QPS for Analytics Look Easy

Автор рассказывает об архитектуре Apache Druid с подробными сведениями о highload-аналитике с высоким требованием к QPS. Внутри — хранение данных в правильном формате, грамотная репликация, параллелизация запросов и прочие ухищрения.

Deploying Large Language Models in Production: LLM Deployment Challenges

Компания Seldon делится своим опытом развертывания LLM. В статье комплексно изучили проблемы, связанные с деплоем больших языковых моделей, в том числе оптимизацию памяти GPU. По сути, коснулись всего: от генерации токенов до механизмов внимания и параллелизмов. Получился полноценный чек-лист.

Опыт работы с данными или с чем может столкнуться аналитик

Интересный взгляд коллег из Neoflex на то, с какими проблемами и состояниями данных борются аналитики. Отдельно понравилось определение: «аналитик — это специалист по изменениям». Даже мне было сложно с этим поспорить.

По мнению автора, анализ данных, бизнес-анализ и системный анализ — равноценные области в аналитике.

How to Build a Distributed Inference Cache with NVIDIA Triton and Redis

В продолжение предыдущей статьи о Triton и MIG рекомендую почитать о выгоде использования кэша при инференсе. Ранее мы проверяли кэширование в других сценариях и компонентах — польза была значительной. Пригодится тем, кто планирует делать инференс на Triton.

Практика

How good are your ML best practices?

Статья привлекла меня наличием «A software quality model for machine learning systems». Автор рассказывает, почему не все атрибуты подходят для охвата ML-систем, и предлагает модели качества и приоритезации. Такой подход уже применили в booking.com, так что в эффективности этого метода можем не сомневаться.

Делим неделимое в Kubernetes: шеринг GPU с помощью MIG и TimeSlicing

Вторая часть статьи о повышении эффективности использования GPU. В прошлой DevOps-инженер Антон рассказал о шеринге GPU и показал, как запустить несколько инстансов на одной видеокарте с помощью MIG. В этой — как использовать технологии MIG и TimeSlicing в Kubernetes и настроить автоскейлинг инференса под нагрузками.

Инструменты

Open Source MLOps: Platforms, Frameworks and Tools

Neptune регулярно пишет обзорные статьи о разных инструментах для ML, но я о них редко рассказываю из-за банальных инструментов, которые они приводят. В этот раз Neptune сделали большую подборку с интересными решениями. Одна часть инструментов была мне знакома ранее, другая — никогда не встречалась. Нашел новые для себя инструменты, в ближайшее время планирую изучить Deepchecks и ModsysML.

Apache Arrow’s Rapid Growth Over the Years

Ретроспектива экосистемы для работы с колоночными данными, Apache Arrow. За несколько лет он сильно эволюционировал. Если в самом начале пути никаких удобств и обвязок не было, то теперь вокруг Arrow существует множество библиотек и инструментов.

Эволюция Apache Arrow.

Rust and ScyllaDB for Big Data

Если вам интересны новые инструменты для анализа данных, рекомендую почитать статью о проекте с ScyllaDB и Rust. Авторы выделяют несколько преимуществ его использования:

- Поддержка разных языков программирования: кроме Rust можно использовать Java, Scala, Node.js и другие.

- Преимущества производительности Scylla NoSQL с мощью и возможностями Rust.

- Оптимизация распределения и репликации данных: Scylla DB обеспечивает минимальную задержку и высокую пропускную способность.

Dataherald выпустила одноименный инструмент для поддержки естественного языка в SQL

Вышел новый AI-инструмент для работы с базами данных без знания SQL — Dataherald. Авторы проекта считают, что с его помощью сотрудники без технических навыков смогут оперативно получать данные из базы. Уже представляю ситуацию, когда два бизнес-пользователя по-разному формулируют запрос на одну метрику и забирают в свои отчеты и KPI разные числа. Вот такой self-service будущего.

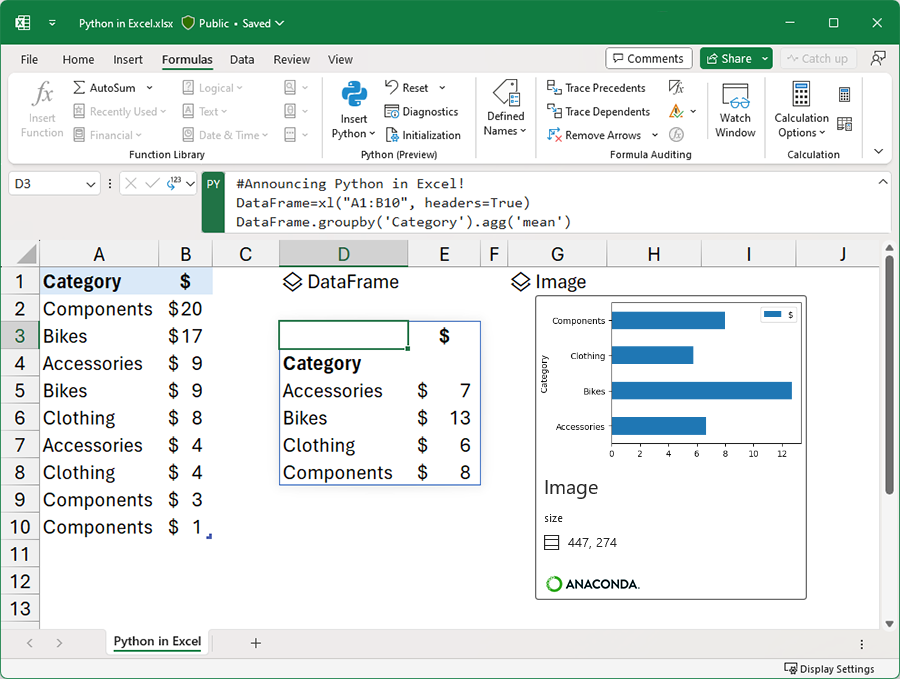

Announcing Python in Excel: Combining the power of Python and the flexibility of Excel

Месяц назад Microsoft добавила Python в Excel для улучшения анализа и визуализации данных. При этом сам код будет запускаться в облачной среде. По функциональности похоже на то, что мы видели в Neptyne. Да и другие аналоги вроде PyXLL существуют уже не первый год.

Data Orchestration Tools: Ultimate Review

Очередное сравнение инструментов для оркестрации аналитических и ML-нагрузок. В этот раз авторы протестировали дюжину решений. Помимо очевидных лидеров рынка есть более нишевые и новые варианты, среди которых — DAGWorks, Shipyard, Kestra, Datorios, MLtwist. Не все одинаково опенсорсное и полезное, но посмотреть интересно.

Мнение

The 100 Most Influential People in AI 2023

Интересный сайт с самыми значимыми деятелями в сфере AI. Уверен, о многих вы даже не слышали. Тут и ученые, художники, генеральные директоры и даже музыканты. У каждого есть своя история: с чего начался их путь в AI и как это повлияло на их работу.

Training LLMs with AMD MI250 GPUs and MosaicML

Почему AMD не может конкурировать на равных с Nvidia? Исследование проводили ребята из компании MosaicML, которая специализируется на оптимизации инференсов и разрабатывает собственную платформу. Летом 2023 года их купил Databricks. На мой взгляд, их тестам можно доверять.

Инфраструктура

NVIDIA TensorRT-LLM Supercharges Large Language Model Inference

Ребята из NVIDIA выпустили отдельную версию SDK TensorRT для Large Language Model (LLM). В своей статье перечислили компании, чей опыт послужил референсом для технологии от Nvidia. Дополнительно поделились бенчмарками производительности: H100 с TensorRT-LLM в два раза мощнее версии без LLM.

Scaling Deep Learning Deployments with NVIDIA Triton Management Service

Nvidia презентовали платный софт для управления Triton Inference Server. Если бы он был бесплатным, в мире произошел бы бум инференс-платформ от компаний, которые хотят улучшить свой GUI.

200 Million People Use ChatGPT Daily. OpenAI Can’t Afford It Much Longer

OpenAI не выдерживает высокую пользовательскую нагрузку, поэтому обучение GPT5 пришлось отложить. Основная причина — нехватка на рынке H100.

Интересно, почему основному драйверу рынка Nvidia не зарезервировали GPU, тогда как Tesla продали около 10 тыс штук?

Обзор рынка

The State Of Data Engineering (yet another one)

Продолжаем коллекционировать отчеты о состоянии рынка инжиниринга данных, на этот раз от Seattle Data Guy. Все по классике: есть рейтинги аналитических платформ, ETL-инструментов, оркестраторов, дата-каталогов и прочих категорий софта. Дополнительно можете ознакомиться со второй частью.

Category collapse

В статье перечислены наблюдения за развитием аналитического стека. Автор выделил несколько направлений:

- укрупнение игроков, которые поглощают небольшие категории софта,

- развитие инструментов в сторону BI-платформы/embedding reporting tool,

- ребрендинг ETL в «enterprise data integration».

Свидетельства существования первых двух трендов регулярно подмечаю в наших дайджестах, а вот о последнем слышу впервые. Буду смотреть внимательнее.

Видео

ClearML + Apache DolphinScheduler: A New Approach to MLOps Workflows

Я уже как-то писал о DolphinScheduler, но теперь есть новый повод — интеграция с ClearML. В видео они презентуют новый подход к рабочим процессам MLOps. При совместном использовании ML-специалисты смогут достичь бесшовной интеграции управления данными и процессами.

Из видео вы узнаете:

- Как эффективно использовать ClearML и DolphinScheduler для автоматизации рабочих процессов.

- Почему интегрированное решение подходит для сложных проектов типа обучения LLM написанию текстов на китайском языке.

- Пошаговый процесс настройки образца пайплайна для fine-tuning LLM.

comma ai | comma supercomputer

Грег Хоган, руководитель отдела инфраструктуры в компании comma.ai, рассказывает, как они с командой строили суперкомпьютер. Дополнительно сопроводили свою историю красивыми иллюстрациями и метриками. Для создания использовали серверы на 8 GPU, 100Gb Ethernet и 400Gb Infiniband.