Разговоры о нейронных сетях не прекращаются. Постоянно выпускают новые программы и приложения на основе ИИ. Специалистам, работающим в области маркетинга, нелегко отслеживать тенденции, и ещё труднее среди большого количества приложений выбрать именно те, которые действительно стоят того, чтобы их использовали.

Конечно, нейронные сети — не панацея. Они ничего не могут сделать без людей. И самое главное здесь — этические вопросы. Нейронные сети практически не способны сгенерировать такой контент, который можно было бы сразу, без опасений, применить в любой отрасли. Между деятельностью человека и технологией всегда должны быть симбиотические отношения: ИИ только набрасывает идеи, а человек их редактирует и дорабатывает.

Чтобы обучить нейросеть, требуется огромный набор данных. Чем больше данных, тем более совершенной будет модель ИИ. Но доступ к информации может быть затруднён из-за проблем с конфиденциальностью и правом на интеллектуальную собственность. Отдельно стоят вопросы этики. Они и будут рассмотрены в рамках настоящей статьи.

Человек или машина?

Сегодня практически ни один онлайн-бизнес не проходит без контента, сгенерированного нейронными сетями.

Технология в значительной степени облегчает труд специалистов: они могут наслаждаться творческим процессом, а не заниматься рутиной. Однако каждый раз, когда мы используем ИИ, в голову приходят следующие вопросы.

1. Кому принадлежит контент или код, созданный нейронной сетью?

Если вы используете ИИ для написания кода или постов в блоге, кому принадлежат авторские права? Вам? Или поставщику нейронной сети? В законодательстве пока нет чёткого ответа на вопрос, кто является собственником результата интеллектуальной деятельности, полученного при помощи нейронной сети.

2. Вы хотите помочь конкурентам?

Если вы создаёте контент с помощью нейронной сети, загруженные вами данные будут использоваться для обучения других моделей ИИ.

Речь идет о ситуациях, когда конкуренты могут быть заинтересованы в данных вашей компании, например, им любопытен закрытый исходный код под NDA или маркетинговая стратегия, превосходящая их.

3. Как быть с риском судебного преследования за использование контента, созданного ИИ?

Известны случаи, когда на людей подавали в суд за использование контента, созданного нейронными сетями. С подобными проблемами сталкивалась даже компания Google.

4. Что, если в будущем отпадёт необходимость в контенте, создаваемом вручную?

Нейронные сети могут генерировать контент, оптимизированный для поисковых систем. Не приведёт ли это к снижению ценности «человеческого» контента? Или сгенерированный и созданный вручную контент будут органично дополнять друг друга?

5. Не опасна ли передача нейронным сетям конфиденциальной и корпоративной информации?

Инструментам искусственного интеллекта для обучения и работы необходимы данные. Какие данные нужны? Как они будут использоваться? Каковы проблемы конфиденциальности при передаче данных искусственному интеллекту?

6. Кто несёт ответственность за некорректную информацию?

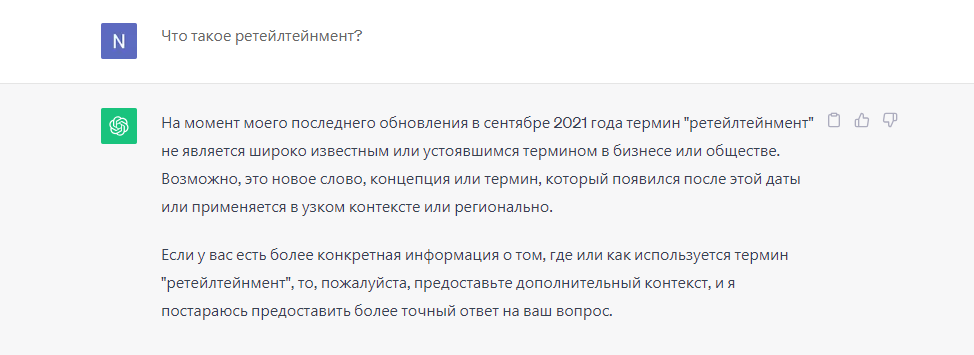

Инструменты ИИ и чат-боты не совершенны. Они допускают ошибки. Что происходит, когда нейронные сети генерируют неточный контент? Кто несёт за это ответственность?

Инструменты искусственного интеллекта во многом зависят от того, на каких данных они обучаются для создания конечного текста. Какие данные были на входе, такие и будут на выходе. Иногда ИИ может обучиться предвзятости и стереотипному мышлению.

7. Сможет ли ИИ заменить человека на рабочих местах?

Неужели нейронные сети заменят маркетологов, когда смогут создавать в 10 раз больше контента, чем люди, используя всего 10% ресурсов. Как изменится процесс принятия решений человеком? Что будет с правами людей?

8. Как внедрение ИИ повлияет на стоимость контента?

Если ИИ сможет создавать контент, неотличимый от человеческого, снизится ли стоимость контента? Люди могут не захотеть платить за материал, если они способны получить его от ИИ бесплатно.

Становятся очевидными проблемы ИИ

Генеративные нейронные сети не всегда точны. Но основная проблема заключается в том, что, загрузив в ИИ «чувствительную» информацию о компании, разработчик ИИ получает доступ к этой информации. И он может свободно использовать её.

Поэтому не следует передавать нейронкам конфиденциальные данные без разрешения владельца. При обучении моделей ИИ важно убедиться, что информация для обучения была получена законным путём и не нарушает никаких законов и нормативных актов. Большинство общедоступных сервисов генеративного ИИ (например, ChatGPT) не раскрывают, на каких наборах данных они обучались. В результате неизвестно, кому на самом деле принадлежат данные.

Ситуация усугубляется тем, что вы никак не сможете проверить, насколько необъективны результаты, а предвзятость ИИ — это реальная проблема. Роботы «хватают» стереотипы из обучающих данных. Они могут очень убедительно лгать. Поэтому не следует доверять контенту, генерируемому ИИ, как единственному источнику информации, особенно когда речь идёт о научных исследованиях.

Выявить проблемы с ИИ несложно. Контент, созданный исключительно нейронными сетями, сильно бросается в глаза:

Длинные, сложные абзацы, повторяющиеся куски контента;

Неуклюжие клише неудобной формы и синтаксически длинные предложения;

Обильное использование прилагательных;

Факты, основанные на субъективном мнении.

Этические правила использования искусственного интеллекта

Использовать генеративный ИИ рекомендуется с лицензией от компании. Это важно с точки зрения ответственности и права собственности. Однако не следует в точности копировать содержимое или код нейронной сети. Обязательно редактируйте, изменяйте и дополняйте материал, чтобы сделать его уникальным.

Защита данных — наиболее важный аспект. Точность информации, генерируемой нейронными сетями, сомнительна, и не следует слепо доверять ей, особенно в случае быстро меняющихся тем.

Выходные данные нейронной сети не должны копироваться дословно. Генерирование контента — это хорошо, но всегда следует помнить о необходимости улучшения выходных данных для получения действительно свежих идей.

Искусственный интеллект отлично подходит для поверхностного исследования и проверки идей по теме. Не следует использовать его для доказательства своего мнения.

Большая часть информации является «чувствительным» контентом. Любая информация, которую вы вводите в нейронную сеть, может быть доступна конкурентам, настоящим и будущим клиентам.

Не делитесь персональными данными с инструментами ИИ, такими как ChatGPT. То же самое относится и к персональным данным клиентов (именам, адресам электронной почты, номерам телефонов и другой персонально идентифицируемой информации).

Использование нейронных сетей: плюсы и минусы

Вы сами решаете, каких этических принципов придерживаться и какие стандарты применять в своей компании. Однако использование нейронной сети для создания контента с нуля — это не выход.

Найдите как можно больше информации по интересующим вас темам. Просмотрите видео, документы, блоги, черновики и т.д. и объедините их, чтобы создать солидную библиотеку информации. Затем напишите часть контента самостоятельно, а остальное пусть доработает искусственный интеллект. Соблюдайте единый стиль написания и добавляйте соответствующие примеры и ключевые слова.

Примеры неправильного использования инструментов нейронных сетей:

Создание контента для маркетинговых писем с использованием именных лицензий

Ввод финансовых данных компании в алгоритм ИИ;

Создание кода с помощью нейронных сетей и использование его без внесения изменений.

Примеры эффективного использования инструментов ИИ:

Использование корпоративных лицензий для создания контента для электронных рассылок; тестирование и тщательное редактирование контента перед публикацией;

обращение к нейронным сетям с просьбой улучшить алгоритмы, не передавая код в руки ИИ;

Придумывать идеи для новых маркетинговых кампаний и анализировать, как они могут принести пользу бизнесу.

Все знают, что ваш контент написан нейронной сетью

Оставим в стороне этические вопросы, связанные с ИИ, конфиденциальность и кибербезопасность. Одна из самых больших проблем, возникающая при неправильном использовании ИИ, заключается в том, что текст, написанный нейросетями, достаточно просто распознать.

Почему это является проблемой?

Допустим, вы используете ИИ для автоматизации всех ваших «холодных» электронных писем. Outlook от Microsoft и Gmail от Google — два крупнейших провайдера электронной почты. Чтобы защитить своих клиентов от спама, они отмечают письма, сгенерированные нейронными сетями, как спам. Способность выявлять такие сообщения улучшилась, и даже если созданное вами послание будет выглядеть впечатляюще, оно окажется бесполезным, когда не попадет в почтовый ящик потенциального клиента.

Может показаться, что это всего лишь электронное письмо. Однако фишинговые атаки на основе искусственного интеллекта становятся всё более распространёнными. Крупнейшие технологические компании, желая защитить своих клиентов от подобных атак, блокируют контент, полностью созданный нейронными сетями.

Люди не заинтересуются вашим письмом, если заподозрят, что всё его содержимое было написано нейросетью. Увеличение объёма текста в ущерб его качеству, скорее всего, дорого обойдётся и вам, и компании в целом.

Однако использование ИИ и алгоритмов машинного обучения не является преступлением. Не весь контент должен генерироваться искусственным интеллектом. Реально использовать ИИ для вдохновения, планирования и создания заголовков, но он не должен полностью заменять работу человека.

Merle79

"Сможет ли ИИ заменить человека на рабочих местах?"

знаете, все технологии, которые сегодня повсеместно внедряются в нашу жизнь, создаются для нашего удобства, комфорта и пр. НО, мы можем получить повышение уровня безработицы, отсюда снижение рождаемости, раннюю смертность (объяснение этой логической цепочки было бы слишком длительное для одного комментария, но все-таки). Поэтому хотелось бы, чтобы прежде, чем ИИ начал заменять человека в тех или иных сферах, человек задумался бы о последствиях. Хотя, справедливости ради стоит отметить, что это совсем не интересно производителю и всем, кто имеет от этого какой-либо доход