Никто не понимает, как работают самые передовые алгоритмы. И это может стать проблемой

В прошлом году на тихие дороги округа Монмут, Нью-Джерси, вышел странный робомобиль. Экспериментальное средство передвижения, разработанное исследователями из Nvidia, внешне не отличалось от других робомобилей, но оно было совершенно не таким, какие разрабатывают в Google, Tesla или General Motors, и оно продемонстрировало растущую мощь ИИ. Автомобиль не следовал строгим инструкциям, запрограммированным человеком. Он полностью полагался на алгоритм, обучившийся водить машину, наблюдая за людьми.

Создать таким образом робомобиль – достижение необычное. Но и немного тревожное, поскольку не до конца ясно, каким образом машина принимает решения. Информация из датчиков идёт напрямую в большую сеть искусственных нейронов, обрабатывающую данные и выдающую команды, необходимые для управления рулём, тормозами и другими системами. Результат похож на действия живого водителя. Но что, если однажды она сделает что-нибудь неожиданное – въедет в дерево, или остановится на зелёный свет? В текущей ситуации будет очень сложно выяснить причину такого поведения. Система настолько сложна, что даже разработавшие её инженеры с трудом смогут найти причину любого конкретного действия. И ей нельзя задать вопрос – не существует простого способа разработать систему, способную объяснить свои действия.

Загадочный разум этого автомобиля указывает на проблему ИИ. Лежащая в основе машины технология ИИ, глубинное обучение (ГО), в последние годы доказала свою способность решать очень сложные задачи, и её применяют для таких задач, как создание подписей к изображениям, распознавание голоса, перевод текста. Есть надежда, что подобные технологии помогут в диагностировании смертельных заболеваний, принятии многомиллионных решений на финансовых рынках и в бесчисленном множестве других вещей, способных преображать индустрии.

Но этого не произойдёт – или не должно произойти – если мы не найдём способ сделать технологии типа ГО более понятными для своих создателей и ответственными для своих пользователей. Иначе будет очень сложно предсказать появление отказа – а отказы неминуемо будут происходить. Это одна из причин, по которой авто от Nvidia находится в экспериментальной фазе.

Уже сегодня математические модели используются как вспомогательное средство для определения того, кого можно условно-досрочно выпускать, кому одобрять кредит и кого нанимать на работу. Если бы вы могли получить доступ к таким моделям, можно было бы понять, как они принимают решения. Но банки, военные, работодатели и другие начинают обращать внимание на более сложные алгоритмы с машинным обучением, способные сделать автоматическое принятие решений необъяснимым. ГО, самый популярный из таких подходов, это принципиально другой способ программирования компьютеров. «Эта проблема уже имеет значение, а в будущем её значение только возрастёт», – говорит Томми Яккола [Tommi Jaakkola], профессор из MIT, работающий над применениями машинного обучения (МО). «Связано ли это решение с инвестициями, с медициной, или с военным делом – вы не захотите полагаться только на „чёрный ящик“.

Некоторые уже утверждают, что возможность допросить ИИ-систему на предмет того, как было принято то или иное решение – это фундаментальное законное право. С лета 2018 года Евросоюз может ввести требование, согласно которому компании должны суметь объяснить пользователям принятые автоматическими системами решения. А это может оказаться невозможным, даже в случае систем, с первого взгляда выглядящих просто – к примеру, для приложений или сайтов, использующих ГО для показа рекламы или рекомендации песен. Компьютеры, на которых эти сервисы работают, программировали сами себя, и этот процесс нам непонятен. Даже создавшие эти приложения инженеры не могут полностью объяснить их поведение.

Это поднимает сложные вопросы. С развитием технологий нам, возможно, придётся выйти за некий предел, за которым использование ИИ требует определённой веры в него. Конечно, и люди не всегда могут полностью объяснить ход своих мыслей – но мы находим способы интуитивно доверять и проверять людей. Будет ли это возможно с машинами, которые думают и принимают решения не так, как это делал бы человек? Мы никогда ещё не создавали машин, работающих непонятными для их создателей способами. Чего можно ожидать от общения и жизни с машинами, которые могут быть непредсказуемыми и необъяснимыми? Эти вопросы привели меня на передовой край исследований алгоритмов ИИ, от Google до Apple, и во множество мест между ними, включая встречу с одним из величайших философов нашего времени.

В 2015 году исследователи из медицинского комплекса Маунт-Синай в Нью-Йорке решили применить ГО к обширной базе данных с историями болезней. В них содержатся сотни переменных, полученных из анализов, визитов к врачам и пр. В итоге программа, названная исследователями Deep Patient, тренировалась на данных 700 000 человек, а потом, при её проверке на новых пациентах, показала удивительно хорошие результаты по предсказанию заболеваний. Без вмешательства экспертов Deep Patient обнаружила скрытые в данных закономерности, которые, судя по всему, говорили о том, что пациент встал на путь к различного рода заболеваниям, включая рак печени. Существует много методов, „достаточно хорошо“ предсказывавших заболевание на основе истории болезни, говорит Джоел Дадли, руководящий командой исследователей. Но, добавляет он, „этот просто оказался гораздо лучше“.

В то же время Deep Patient озадачивает. Она вроде бы хорошо распознаёт начальные этапы психических отклонений вроде шизофрении. Но поскольку врачам очень трудно предсказать шизофрению, Дадли заинтересовался, как это получается у машины. И он до сих пор не сумел это выяснить. Новый инструмент не даёт понимания того, как он этого достигает. Если система типа Deep Patient когда-нибудь будет помогать докторам, в идеале она должна дать им логическое обоснование своего предсказания, чтобы убедить их в его точности и оправдать, к примеру, смену курса принимаемых лекарств. „Мы можем строить эти модели, – печально констатирует Дадли, – но мы не знаем, как они работают“.

ИИ не всегда был таким. Вначале было два мнения по поводу того, насколько ИИ должен быть понятен или объясним. Многие считали, что имеет смысл создавать машины, рассуждающие согласно правилам и логике, делающие свою внутреннюю работу прозрачной для каждого, кто захочет их изучать. Другие считали, что интеллект в машинах сможет возникнуть быстрее, если вдохновиться биологией, и если машина будет учиться через наблюдение и опыт. А это означало, что нужно перевернуть всё программирование с ног на голову. Вместо того, чтобы программист записывал команды для решения задачи, программа создавала бы свои алгоритмы на основе примеров данных и необходимого результата. Технологии МО, сегодня превратившиеся в самые мощные ИИ-системы, пошли по второму пути: машина программирует сама себя.

Поначалу такой подход был мало применим на практике, и в 1960-70 годы он жил лишь на переднем крае исследований. А затем компьютеризация множества индустрий и появление больших наборов данных вернуло интерес к нему. В результате началась разработка более мощных технологий машинного обучения, в особенности новых версий искусственных нейросетей. К 1990-м нейросети уже могли автоматически распознавать рукописный текст.

Но лишь в начале текущего десятилетия, после нескольких хитроумных подстроек и правок, глубокие нейросети показали кардинальное улучшение работы. ГО отвечает за сегодняшний взрыв ИИ. Оно дало компьютерам необычайные возможности, такие, как распознавание речи на уровне человека, что слишком сложно было бы запрограммировать вручную. Глубокое обучение преобразовало компьютерное зрение и радикально улучшило машинный перевод. Теперь его используют для помощи в принятии ключевых решений в медицине, финансах, производстве – и много где ещё.

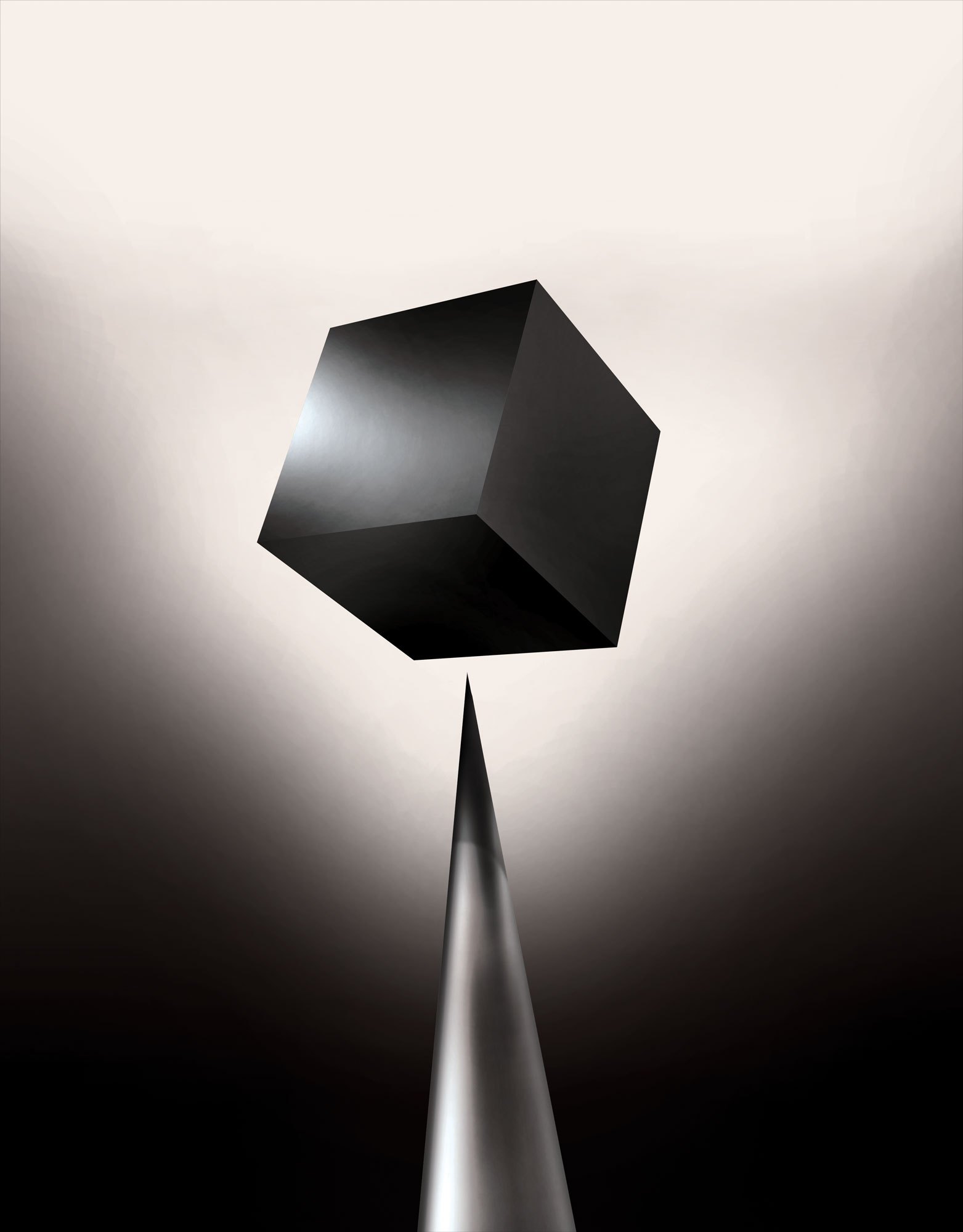

Схема работы любой МО-технологии по своей сути менее прозрачна, даже для специалистов по информатике, чем у запрограммированной вручную системы. Это не значит, что все ИИ в будущем будут одинаково непознаваемы. Но по сути ГО представляет собой особенно тёмный чёрный ящик.

Нельзя просто заглянуть в глубокую нейросеть и понять, как она работает. Рассуждения сети встроены в тысячи искусственных нейронов, организованных в десятки или даже сотни сложным образом соединённых слоёв. Нейроны первого слоя получают входные данные, такие, как яркость пикселя в картинке, и вычисляют новый выходной сигнал. Эти сигналы по сложной паутине передаются нейронам следующего слоя, и так далее, до полной обработки данных. Также существует процесс обратного распространения, подстраивающий вычисления отдельных нейронов так, чтобы сеть обучалась выдавать нужные данные.

Множество слоёв сети позволяют ей распознавать вещи на разных уровнях абстракции. К примеру, в системе, настроенной на распознавание собак, нижние уровни распознают простые вещи, такие, как контур или цвет. Высшие распознают уже мех или глаза. А самые верхние идентифицируют собаку в целом. Тот же подход можно применить к другим вариантам входных данных, позволяющих машине обучить саму себя: звуки, составляющие слова в речи, буквы и слова, составляющие предложения, или движения руля, необходимые для езды.

В попытках распознать и объяснить происходящее внутри систем были разработаны изобретательные стратегии. В 2015 году исследователи из Google изменили алгоритм распознавания изображений так, чтобы вместо того, чтобы находить объекты на фото, он бы создавал или изменял их. По сути, запустив алгоритм в обратном направлении, они решили узнать, какие особенности программа использует для распознавания, допустим, птиц или зданий. Итоговые изображения, созданные проектом Deep Dream, демонстрировали гротескных, инопланетных животных, появляющихся среди облаков и растений, и галлюциногенные пагоды, видимые в лесах и горах. Изображения доказали, что ГО не полностью непознаваемо. Они показали, что алгоритмы нацеливаются на знакомые визуальные признаки, типа клюва или перьев птицы. Но эти изображения рассказали и о том, как сильно отличается восприятие компьютера от человеческого, поскольку компьютер мог сделать артефакт из того, что человек бы проигнорировал. Исследователи отметили, что когда алгоритм создавал изображение гантели, вместе с ним он рисовал и человеческую кисть. Машина решила, что кисть – часть гантели.

Далее процесс двигался благодаря идеям, позаимствованным из нейробиологии и когнитивистики. Команда под руководством Джефа Клюна [Jeff Clune], помощника профессора из Вайомингского университета, проверяла глубокие нейросети при помощи эквивалента оптических иллюзий. В 2015 году группа Клюна показала, как определённые изображения могут обмануть сеть так, чтобы она распознала объекты, которых не было на изображении. Для этого использовались детали низкого уровня, которые ищет нейросеть. Один из членов группы создал инструмент, работа которого напоминает вживлённый в мозг электрод. Он работает с одним нейроном из центра сети, и ищет изображение, больше других активирующее этот нейрон. Картинки получаются абстрактными, демонстрирующие загадочную природу машинного восприятия.

Но нам недостаточно только намёков на принцип мышления ИИ, и простого решения тут нет. Взаимосвязь расчётов внутри сети критически важна для распознавания закономерностей высокого уровня и принятия сложных решений, но эти расчёты – трясина из математических функций и переменных. „Если бы у вас была очень маленькая нейросеть, вы могли бы в ней разобраться, – говорит Яккола, – но когда она разрастается до тысяч нейронов на слой и сотен слоёв, она становится непознаваемой“.

Рядом с Якколой в офисе находится рабочее место Регины Барзилай [Regina Barzilay], профессора MIT, намеренного применять МО к медицине. Пару лет назад, в возрасте 43 года, ей диагностировали рак груди. Диагноз шокировал сам по себе, но Барзилай беспокоилась ещё и из-за того, что передовые статистические методы и МО не используется для онкологических исследований или для разработки лечения. Она говорит, что у ИИ огромный потенциал для организации революции в медицине, но его понимание простирается за пределы простой обработки медицинских записей. Она представляет себе использование сырых данных, не используемых сегодня: „изображения, патология, вся эта информация“.

По окончанию процедур, связанных с раком, в прошлом году Барзилай со студентами начали работать с докторами Массачусетского госпиталя над разработкой системы, способной обрабатывать отчёты по патологиям и определять пациентов с определёнными клиническими характеристиками, которые исследователи хотели бы изучить. Однако Барзилай понимает, что система должна уметь объяснять принятые решения. Поэтому она добавила дополнительный шаг: система извлекает и подсвечивает участки текста, типичные для найденной ей закономерности. Барзилай со студентами также разрабатывают алгоритм глубокого обучения, способный находить ранние признаки рака груди в маммограммах, и эту систему они тоже хотят сделать способной объяснять свои действия. „Очень нужен процесс, в котором машина и люди могли бы работать вместе“, – говорит Барзилай.

Американские военные тратят миллиарды на проекты, использующие МО для пилотирования машин и самолётов, определения целей и помощи аналитикам в фильтрации огромных куч разведданных. Здесь тайны работы алгоритмов ещё менее уместны, чем в медицине, и минобороны определило объяснимость как ключевой фактор.

Дэвид Ганнинг [David Gunning], руководитель программы разработки в агентстве передовых оборонных исследований, следит за проектом „Explainable Artificial Intelligence“ (объяснимый ИИ). Седой ветеран агентства, до этого следивший за проектом DARPA, по сути приведшим к созданию Siri, Ганнинг говорит, что автоматизация пробирается в бесчисленное количество военных областей. Аналитики проверяют возможности МО по распознаванию закономерностей в огромных объёмах разведданных. Разрабатываются и проверяются автономные машины и летательные аппараты. Но солдаты вряд ли будут комфортно чувствовать себя в автоматическом танке, не объясняющем им свои действия, а аналитики будут неохотно использовать информацию без объяснений. „В природе этих МО-систем частенько выдавать ложную тревогу, поэтому аналитику необходима помощь, чтобы разобраться в том, почему была дана та или иная рекомендация“, – говорит Ганнинг.

В марте DARPA выбрала для финансирования 13 научных и коммерческих проектов по программе Ганнинга. Некоторые из них могут взять за основу работу Карлоса Гуэстрина [Carlos Guestrin], профессора Вашингтонского университета. Они с коллегами разработали способ, которым МО-системы могут объяснять свои выходные данные. По сути, компьютер находит несколько примеров данных из набора и предоставляет их в качестве объяснения. Система, разработанная для поиска электронных писем террористов, может использовать миллионы сообщений для тренировки. Но благодаря подходу вашингтонской команды она может подсветить определённые ключевые слова, обнаруженные в сообщении. Группа Гуэстрина также придумала, как системы распознавания изображений могли бы намекать на свою логику, подсвечивая наиболее важные части изображения.

Один недостаток такого подхода и ему подобных заключается в упрощённом характере объяснений, в связи с чем некая важная информация может оказаться утерянной. „Мы не дошли до мечты, в которой ИИ может вести с вами дискуссию и способен объяснить вам что-то, – говорит Гуэстрин. – Нам ещё очень далеко до создания полностью интерпретируемого ИИ“.

И речь не обязательно идёт о такой критичной ситуации, как диагностика рака или военные манёвры. Знать о ходе рассуждений ИИ будет важно, если эта технология станет общераспространённой и полезной частью нашей повседневной жизни. Том Грубер, руководящей командой разработки Siri в Apple, говорит, что объяснимость – ключевой параметр для их команды, пытающейся сделать Siri более умным и способным виртуальным помощником. Грубер не рассказывал о конкретных планах для Siri, но легко представить, что получая рекомендацию ресторана, вы хотели бы знать, почему она была сделана. Руслан Салахутдинов, директор исследований ИИ в Apple и адъюнкт-профессор в Университете Карнеги-Мэлон, видит объяснимость в роли ядра эволюционирующих отношений людей и умных машин. „Она привнесёт в отношения доверие“, – говорит он.

Так же, как невозможно подробно объяснить многие аспекты человеческого поведения, возможно ИИ не сможет объяснить всё, что он делает. „Даже если кто-то сможет дать вам логичное объяснение своих действий, оно всё равно будет не полным – то же верно и для ИИ“, – говорит Клюн из Вайомингского университета. „Эта особенность может быть частью природы интеллекта – то, что лишь его часть поддаётся рациональному объяснению. Что-то работает на инстинктах, в подсознании“.

Если так, то на каком-то этапе нам придётся просто верить решениям ИИ или обходиться без них. А эти решения должны будут затронуть и социальный интеллект. Так же, как общество построено на контрактах, связанных с ожидаемым поведением, так и системы ИИ должны уважать нас и вписываться в наши социальные нормы. Если мы создаём автоматические танки и роботов для убийства, важно, чтобы их процесс принятия решений совпадал с нашей этикой.

Для проверки этих метафизических концепций я отправился в Университет Тафтса на встречу с Дэниелом Дэннетом, знаменитым философом и когнитивистом, изучающим сознание и разум. В одной из глав его последней книги, „От бактерий до Баха и обратно“, энциклопедическом трактате на тему сознания, содержится предположение, что естественная часть эволюции интеллекта заключается в сознании систем, способных выполнять задачи, недоступные для их создателей. „Вопрос в том, как нам подготовиться к разумному использованию таких систем – какие стандарты требовать от них и от нас самих?“ – говорил он мне среди беспорядка в его офисе, находящемся на территории идиллического кампуса университета.

Он также захотел предупредить нас по поводу поисков объяснимости. „Думаю, что если мы будем использовать эти системы и полагаться на них, то, конечно же, нужно очень строго отнестись к тому, как и почему они выдают нам свои ответы“, – говорит он. Но поскольку идеального ответа может и не оказаться, мы должны так же осторожно относиться к объяснениям ИИ, как и к нашим собственным – вне зависимости от того, насколько умной кажется машина. „Если она не сможет лучше нас объяснить, что она делает, – говорит он, – лучше ей не доверять“.

Комментарии (165)

sergof

07.05.2017 21:03+10Но что, если однажды она сделает что-нибудь неожиданное – въедет в дерево, или остановится на зелёный свет?

Кажется моя любимая жена — робот…

nuru21nabiyev

07.05.2017 21:46“Результат похож на действия живого водителя. Но что, если однажды она сделает что-нибудь неожиданное – въедет в дерево, или остановится на зелёный свет?”

Во-первых не 'если', а 'когда'.

А во-вторых, так же как и живому водителю, который совершил эту же ошибку, нужно просто сказать чтоб больше так не делал, и проблема решится, хоть и после некоторой итерации.

Если учить машину как ребёнка, то нужно указывать на ошибки и недочёты, и через несколько итераций появится опыт.

BlackMokona

07.05.2017 23:08У вас сказочное представление о людях, знаю пачку лихачей, которым до лампочки все слова и аварии.

DamnLoky

07.05.2017 23:30+1у НС есть преимущество — они не устают, а «навык» закреплен прочно.

Это то, что вселяет в меня робкий оптимизм.

ChiefPilot

11.05.2017 13:31А «робкий» тут в своём обычном значении или это отсылка к роботам в контексте обсуждаемой темы? :)

25080205

08.05.2017 12:14+1Появится опыт проскакивать на красный, если нет поблизости ментов? :-)

Ckpyt

08.05.2017 22:49Не могу плюсануть, выражаю так свою поддержку — непременно появится, если у автомобиля будет разблокировано обучение.

Но я так думаю, что на продажу будут выставлять машины с заблокированным обучением. Но опыт будет собираться и передаваться на сервера, чтобы если что, по решению оператора/программиста его можно было применить ко всем.

arheops

09.05.2017 02:51Откуда он может появится, если автомобиль будет стоять на красный? Вы никак не заставите его попробывать.

Ckpyt

09.05.2017 09:02Вы недооцениваете людей :-) Если что-то в принципе можно сделать — это будет сделано!

А если от этого будет субъективная польза — это будет сделано в десять раз быстрее и в сто раз большим количеством людей.

zuwr2t

10.05.2017 08:41Проскочить на красный хочется если ты ждешь вместе с машиной. Если ты в это время занят своими делами то ждет машина эти 30 секунд или нет для тебя не важно.

Ckpyt

10.05.2017 13:16+1Вы указали причину, но ее не осознали. :-)

Если ждешь — то хочется. Если хочется, то сделаешь. Внимание, вопрос: есть ли такие ситуации, когда кажется, что лишние 30 секунд настолько важны? Или есть такие люди, которым хочется добраться побыстрее из точки А в точку Б, независимо от того за рулем они или нет?

arheops

11.05.2017 17:22Перепрограммирование нейросети еще и без следов(иначе контроль может и посадить года на 4) является очень нетривиальной и специализированной задачей. Это как сейчас, например, поменять головку цилиндра для улучшения старта на светофоре. Теоретически — возможно, но практически сделать так, чтоб было лучше фабричной и собрать обратно фабричный современный двигатель — требует нереальной квалификации.

Или вы думаете, что ваш автомобиль будет в сябя включать еще и ИИ общего назначения и вы ему просто скажите «езжай, душка, на красный, барин хочет». А потом «сотри ка наши разговоры»?

ChiefPilot

11.05.2017 13:38Например, он же может сначала анализировать поведение других участников движения: увидел, что кто-то поехал на красный и отложил себе в копилку, что, оказывается, так можно в принципе. Дальше он может пытаться вычислять, при каких условиях так делают другие: нет препятствий моему движению и я никому не мешаю (типа красный то мне горит, но никто же не едет поперёк моего маршрута), или там (с чего всё началось) нет «ментов» и нет возможности получить штраф. А когда накопит достаточное количество данных, может перейти и к собственным активным действиям.

dimm_ddr

11.05.2017 15:41Для этого нужно прописать описанное вами обучение в алгоритме. Но проблемы такого подхода очевидны, а преимуществ нет — так никто никогда не станет делать. А даже если кто-то и сделает, то его все равно никто не пустит поставить такой автопилот в автомобиль. Если же это будет самоучка с кустарной переделкой, то тут возникает такая масса проблем, что ваш вариант уже не сильно и пугает. Причем такой вариант ничем не отличается от неумелой переделки автотехником обычного автомобиля из-за которой в критический момент что-нибудь отработает неправильно. Те же тормоза откажут.

arheops

11.05.2017 17:15Вы путаете обучение человека и машины. У автоматического водителя, скорее всего, вообще будет заблокировано обучение, ТОЧНО будут жесткие запреты в соответсвии с правилами страны перебывания и уж точно никто его не будет учить по принципу «делай как я». Обучение нейронных сетей требует сильно других ресурсов, их просто не будет в машине.

Nordicx86

08.05.2017 22:34угу, система «Кнута и пряника» — по идее это первый и скорее всего один из самых важных шагов для получения сильноги ИИ или чего то что в будуще мможет стать ИЛ… Правда страшный т.к. система РЕАЛЬНО способная УЧИТСЯ самостоятельно не контролируема в принципе…

dimm_ddr

10.05.2017 15:04Человек — система, способная учиться самостоятельно. Вполне себе контролируем в абсолютном большинстве случаев в определенных пределах. Не всегда такой контроль прост, но практически всегда возможен.

DamnLoky

07.05.2017 23:18Людям же после аварии фМРТ не делают(для реконструкции ситуации), зачем просить примерно того же от машины?

worldmind

09.05.2017 21:36потому что человек это личность несущая ответственность, а машина нет, за неё по идее несут ответственность создатели, во всяком случае до тех пор пока машина не станет личностью

DamnLoky

09.05.2017 21:43Если честно, то я не очень понимаю значение слова «ответственность» в строгом смысле.

Имелось в виду наказание за ошибку?

worldmind

09.05.2017 22:00да, хотя в данном случае понимание также требуется для улучшения системы и недопущения последующих ошибок

DamnLoky

09.05.2017 22:16Ну, переобучение назвать ответственностью это как-то сильно.

Несчастный случай, непредвиденная ситуация. Ну все почти как в авиации, а там чудес было всяких-разных, мама не горюй просто.

Блочок логгирования всех входных данных ака черный ящик, модель на дообучение, и тихо и спокойно двигаемся дальше. Бессердечно и цинично? Фиг знает, белковые формы жизни тоже себя не идеально показали.

worldmind

09.05.2017 23:50Так вот проблема в том, что после переобучения нельзя проверить что получилось — может эта проблема решилась, но появились новые там где раньше работало.

Тестами всё не покроешь — слишком сложные задачи, а без понятного алгоритма верифицировать не получится.

DamnLoky

10.05.2017 00:14Проблема в том, что задача, в общем случае, не решается.

Есть белковые, которых спрашиваешь: понял? — понял. И без всяких гарантий.

Есть НС, у которых «понял» выявляется на тестах, да, дескать, понял, веду себя как заказывали.

Алгоритмически задачи вождения в произвольных условиях не решаются в принципе.

Но у НС есть преимущество — не устают и не «ошибаются», в том смысле, в каком ошибается человек.

worldmind

10.05.2017 09:17Откуда информация о том что задача не решается?

DamnLoky

11.05.2017 13:37Из самых общих рассуждений.

Алгоритм конечен, количество ситуаций и условий — бесконечно.dimm_ddr

11.05.2017 15:48В самом общем случае, когда не ограничено время "ситуации" вы правы. Но если ввести ограничение на время ситуации сверху, любое причем, то их количество уже становится конечным, хоть и очень большим. Также и с условиями: даже если взять все возможные варианты автомобиля и окружающей среды, то, так как каждый из таких параметров конечен, то их композиция будет конечна. Правда, опять же, приняв во внимание что непрерывные параметры в жизни все равно дискретизируются.

Для пояснения пример:

Скорость, в общем случае это параметр непрерывный и мы всегда можем получить новое значение, находящееся между любыми двумя старыми. Но с какого-то момента разница между старым и новым параметром будет настолько мала, что ее будет невозможно измерить. Таким образом можно любой непрерывный параметр заменить набором дискретных значений.

arheops

11.05.2017 17:29Вообщето как раз вождение — алгоритмизируется. Просто текущих мощностей компьютеров не хватает на такой алгоритм, да и есть проще решение в нейросетях.

Вам просто необходимо в компьютер внести физическую модель автомобилей всех наличных вариантов, физическую модель дороги и считать. Даже с сильными приближениями(как сейчас) просчет компьютером ситуации выполняется сильно точнее и быстрее по сравнению со средним человеком. Нет, может экстремальный гонщик участвующий в ралли каждый год(сколько таких? 1к?10к на планету?) оценит авраийную ситуацию лучше, но не средний человек.

dimm_ddr

10.05.2017 15:09+1Так это и для человека справедливо. Только у человека еще и значительно хуже память с рефлексами, нельзя гарантировать что он вообще вспомнит об уроке в нужный момент или успеет среагировать.

Iamkaant

08.05.2017 00:06+3С практической точки зрения, нейросети правильно использовать уже сейчас там, где от них может быть польза. Да, они могут ошибаться при диагностике, например, рака, но и живые врачи тоже ошибаются. И если применение нейросети поможет спасти больше людей – это здорово. Но все же, нейросети нужно понимать как временный костыль – пока мы не поймём и не формализуем закономерности, которые «чувствует» нейросеть. Поэтому настораживает нынешняя мода на них, что-то типа «когда в руках молоток – все вокруг похоже на гвоздь».

sayanlar

08.05.2017 15:13Именно так!

Но вот я тут пару месяцев назад читал переводную статью какого-то уважаемого эксперта в IT, и он на полном серьёзе утверждал, что мы должны отдавать приоритет самообучаемым алгоритмам перед классическими, объяснимыми. Ставить телегу перед лошадью. Так что повоевать еще предстоит…

Iamkaant

09.05.2017 23:18Если верить фантастам, в будущем алгоритмы будут писать себя сами. Но и там, надеюсь, всегда можно будет при желании проследить логику какого-либо решения машины.

А пока нейросети пихают куда ни попадя. Недавно видел статью, в которой нейросети тренировали для предсказания реакционной способности соединений. Верно ведь, зачем разрабатывать расчетные алгоритмы, если можно просто натренировать нейросеть?..

worldmind

09.05.2017 21:37И если применение нейросети поможет спасти больше людей – это здорово.

будет не очень здорово если оно в сумме спасёт больше людей, но убьёт кого-то, кто без нейронные сетей выжил бы, не думаю что вы хотите оказаться этим кем-то

Iamkaant

09.05.2017 23:19Хотите сказать, сейчас врачи не ошибаются?

worldmind

09.05.2017 23:55Вовсе нет, просто бывает что умная нейросеть хоть и в среднем лучше врачей, но может делать ошибки там где белковый врач почти не ошибается и узнаем об этом мы только после того как погибнет N людей и будет замечена закономерность.

dipsy

10.05.2017 05:46+1Самые злые фашисты и убийцы это изобретатели автомобилей, только представьте, сколько жизней было бы спасено, если бы все ездили только на гужевых повозках! Жаль, что в то время не было таких людей как мы с вами, которые могли бы предостеречь общество от необдуманных шагов по смертельно опасной автомобилизации.

MTyrz

10.05.2017 11:38+1Знаете, между всем прочим не факт.

Стоящий автомобиль без водителя, как правило, совершенно безопасен. Стоящая лошадь может ударить копытом, укусить или начать двигаться непредсказуемым образом. Даже без наездника, и это ее имманентное свойство, а не недосмотр водителя, забывшего про ручник.

Если почитать старые книги, то гибель от лошади в том или ином виде была довольно распространенной причиной смерти. Лошади затоптали, лошади понесли, упал с лошади, застряла нога в стремени и все такое.

В общем, найти бы статистику: внезапно может оказаться, что по-настоящему все было не так, как на самом деле.

arheops

11.05.2017 17:34+2Очень вероятно, что при плотности лошадей как сейчас авто смертность от лошадей была бы больше. Они не настолько безопасны. 200-400кг на скорости 30кмчас просто так не остановишь, даже если это лошадь. А лошади еще и не 100% слушаются, поскольку тоже имеют нейросети, причем запрограммированные на выживание лошадей, а не повозок.

dimm_ddr

10.05.2017 15:11Я в принципе не хочу оказаться тем, кто умрет. Но если при применении нейросети количество смертей уменьшится, то, очевидно, шансы оказаться умершим снижаются. Это все о чем нужно думать на самом деле. Если же будет тенденция, то это даже хорошо — это шанс улучшить работу нейросети. Нет ничего страшного в описанной вами ситуации.

arheops

08.05.2017 00:34Ага, ага, тестировал недавно распознавание голоса всеми доступными ИИ(гугл, микрософт, ватсон и так далее). Все работают только на 44кгц записи. По телефону(8кГц) с реальными людьми просто говорящими, не специально для машины — точность меньше 50%. И это английский, для русского еще хуже. Такчто не на уровне человека точно.

Успехи у ГО, конечно, есть. Но не настолько впечатляющие, как в статье написано.

iDm1

14.05.2017 23:29Ну так мы, люди, обучаемся воспринимать информацию в разных условиях, мы не умеем все с рождения. Так же и нейросеть можно обучить работать и с 8кГц звуком, просто этот момент упустили, скорее всего намеренно ввиду неоправданных на то затрат.

Shortki

08.05.2017 00:52+6Во-первых, нейронные сети не “думают” и не “решают”. Они лишь сложный механизм сопоставления обучающей последовательности и новых данных.

Во-вторых, забавные учёные учили сеть выдавать им готовый ответ и теперь удивляются что она так и поступает. Теперь учат давать ответ и некий “ход решения задачи” который человек мог бы принять за обоснование ответа. Естественно сеть выполнит “домашнее задание”, только вот ответ и “ход решения” сеть найдёт независимо друг от друга, для неё это две разные задачи. Таким образом одно является обоснованием другого только в глазах человека. Потом кто-то осознает этот разрыв и напишет статью о том как ИИ нарочно “обманывает” своих создателей.

Nubus

08.05.2017 03:34Немного не так. В данный момент ИИ выдает результаты на запрос, но напоминает школьника который ответы на задачи выдергивает с конца учебника или отдельного решебника. Ученые пытаются научить машину показывать ход решения задачи a.k.a как учительница требует от такого ученика решить задачу на доске чтобы проверить как он ее решал.

Из школьной программы я помню мы застряли на какой-то задаче по геометрии. Через минут 20 один человек выдал ответ 7,5 см. У него учительница спросила как он нашел его, он ответил: «Просто начертил в тетради и измерил». Вот такие ситуации пытаются предотвратить.

Shortki

08.05.2017 03:58+5Нет. Нейронная сеть (в её современном формальном математическом понимании, а не та которая у школьника в голове) никак не напоминает школьника. Она “не выдёргивает ответы из конца учебника”. Это математическая конструкция которая сворачивает множество обучающих примеров в набор параметров, а затем разворачивает их в возможный ответ. В ней нет загадки или мистики, она не “решает” и не “думает” и абсолютно прозрачна в работе. При желании можно проследить как тысячи/миллионы входящих значений из обучающих примеров формируют вероятный ответ, это будет очень длинная запись решения, но в данном случае единственно достоверная, это просто такой сложный способ решать задачи, который стал доступен поскольку мы научились “перелопачивать” огромное число данных. Да, с таким решением тяжело работать, оно не носит абсолютный характер, но вполне применимо на практике.

Nubus

08.05.2017 05:06-2Проблема в том что НИКТО из людей достоверно не знает и не понимает КАКИЕ ИМЕННО параметры эта сеть для себя выдумывает. То есть нет возможности ответить на вопрос, как именно она знает что это кошка а не птицы.

Shortki

08.05.2017 05:24+2Не “выдумывает” а вычисляет. Если есть желание и время разбираться в логах, всегда можно понять почему ответ получился таким, другое дело что это будет не тот ход поиска ответа который мы считаем “красивым” и “понятным человеку”.

rkfg

08.05.2017 18:40+5Это очень похоже на хэш-функции. Алгоритм той же SHA256 открыт, он намного проще нейросети в вычислительном плане, но никто не может предугадать результат хэширования данных без прохода по алгоритму, грубо говоря, за O(1) или хотя бы за O(n') < O(n), где O(n) — оригинальная сложность алгоритма, а O(n') — упрощённая/ускоренная. Иначе можно было бы себе намайнить все биткоины мира и взломать все сертификаты всех сайтов. И никто не может сказать, почему этот бит принял такое значение. Но причина, в общем-то, и не важна, просто по этому алгоритму так получается, а так можно аналогично по шагам пройти все стадии, только смысла в этом столь же мало. Разница лишь в том, что хэш должен быть максимально случайным, а нейросеть — максимально близка к желаемому результату. Но принцип действия похож: берём кучу данных (в случае RNN — произвольной длины, как и у хэшей), перемешиваем по алгоритму, получаем результат фиксированной длины.

arheops

09.05.2017 02:53+1Только в отличии от хеш функции, которую практически возможно пройти ручками, вы не сможете пройти ручками даже распознание образа по матрице 40х40пикселей. В том то и проблема.

sayanlar

08.05.2017 15:14Такое «решение» будет бесполезным, поскольку не даст создать класс решений, не даст вывести проблему на научный уровень.

Nordicx86

08.05.2017 22:45для чего бесполезным? для поставленой задачи — научится чему-то — да бесполезно и даже вредно(хотя и не совсем — вешать шоры на поиск альтернативных путей глупо), а вот для получения оперативного решения за минимальное время для сложных задач — почему нет?

Как пример — можно неделю высчитывать деталь в 3D, чертетит её и воображать… а можно за 10 часов напечатать прототип — посмотреть и пощупать что бы понять что получилось, и где проблемы и косяки…

Nordicx86

08.05.2017 22:40+1как ни страннно — но вот эти «7,5см» и ответ «Начертил руками» — это вариант причем разумный, можно потратить гораздо болльше времени на поиск Формализованного решения, имеющего теоритический обоснованный базис, но — зачем? Проще начертить и получить ответ с разумной точностью…

собсвтно нейросети это какраз решение по этому типу — взять и заставить машину выяснить не формализуемые диапащоны параметров и взаимосвязи в потоке информации ипользуя обучающий набор…

baxtep

09.05.2017 05:36+1Теперь «F.D.O.M.» выдавала видеоотчет. Выглядел он так: у большого монитора в условном подобии студии сидели несколько виртуальных фигурок простецкого вида (каждый раз система моделировала их заново, чтобы не создавать впечатления, будто у нее внутри обитают некие искусственные существа). Картинка, на которую смотрели фигурки, соответствовала тому, что видели камеры «Либерейтора». При появлении врагов фигурки просыпались и вступали в диалог, напоминающий эмоциональное ток-шоу категории «B».

Вряд ли такая передача выдержала бы конкуренцию на телевидении. Но в смысле public relations смоделированный подобным образом диалог чрезвычайно выгодно отличался от переговоров живых операторов.

Военные обычно говорили коротко и по делу:

– Долбани-ка еще раз вон по тому ублюдку в канаве.

А виртуальные фигурки в той же ситуации изъяснялись так:

– Ужасно, что приходится открывать огонь по живому человеку. Но когда я думаю о наших ребятах, в которых может попасть пущенная им пуля, когда я думаю, что он может прятать в кармане гранату или пистолет, я понимаю – этот трудный, практически невозможный выбор все-таки придется сделать…

Хитрость Пентагона заключалась в том, что сгенерированные подобным образом виртуальные отчеты не навязывались общественности – они хранились в военном архиве и имели статус секретной информации. Но если какой-нибудь свисткодув из числа военных решался слить информацию на «Wikileaks» или в другие СМИ, те получали вместо жареного компромата патетическое ток-шоу, где все принимаемые решения были настолько безупречны с нравственной точки зрения, что никакой возможности обвинить в смерти гражданских лиц кого-то, кроме мертвых гражданских лиц, просто не оставалось.

Shortki

09.05.2017 06:26Хороший пример :)

Существует масса ситуаций когда не хотелось бы афишировать способ решения задачи, а представить его в выгодном свете, я думаю ИИ это будет по силам :) Почему-то массовое сознание легче верит “красивой” выдумке, чем в невзрачной правде. Забавно, что такие выдумки даже проще генерировать автоматически чем пытаться разбираться в сути вещей.

jaguarrus

08.05.2017 02:32+3Забавно что люди никак не могут отойти от «по образу и подобию».

Шаг влево, шаг вправо — низзя. Ксенофобия на генетическом/подсознательном уровне, не иначе.

QWhisper

08.05.2017 08:13Ну вот возьмем те же признаки рака или шизофрении. Это не гантеля, медицинские данные довольно таки формализованы должны быть. Поэтому, можно просто убирать по одной строчке из них пока не увидим вместо положительного сигнала, отрицательный. После чего анализируем строчки из за которых произошла смена диагноза.

demimurych

08.05.2017 09:50+4В современной медицине тоже не все так просто. И часто диагноз ставится по комбинации нескольких факторов. Иначе говоря — убрав фактор «С» диагноз становится другим, но убрав и «С» и «Д» — прежний диагноз все так же вероятен.

В результате прямой перебор о котором вы говорите, может оказаться неосуществимой задачей.

QWhisper

08.05.2017 11:35+1Ну смотрите, я исхожу из того, что медицинские данные формализованы, уровень сахара, гемоглобина и т.д. Не формализованные данные я думаю для компьютера тоже формализуют, то есть «болит колено» нейросеть воспринимает не как текст, а как точку на схеме человека. Исходя из этого, мы вполне можем запилить алгоритм расчета, который будет гонять эти данные на предмет изменения. Банально можем взять сеть которой скормили 100к карточек и одну нашу карточку где все заранее известно и меняя данные смотреть, что сеть отвечает(это кстати может помочь очень сильно в обучении новых врачей, так как может выявить важные корреляции или наоборот убрать из обучения те которые не подтверждаются).

Задача перебора хоть и большая, но и мы живем уже не в 90-х, это вполне по силу нашим вычислительным мощностям, в конце концов мы фолдинг белков можем рассчитывать, тут же задача куда проще. Да и малейшая зацепка/предположение о причинах диагноза, уже может значительно сузить диапазон перебора.

Собственно это задача с черным ящиком, и понимаем его через скармливание нужных данных на входе и анализируя их на выходе.

i360u

08.05.2017 12:25+2Дело в том, что некоторые факторы становятся значимыми только в сочетании с неким набором других параметров, которые становятся значимыми в сочетании с другими, в свою очередь. Зацепка не одна, "зацепкой" может являться сложная система зависимостей, анализ которой — очень сложная задача сама по себе. В этом то и заключается сила нейросетей (и наших мозгов), они решают сложные комбинаторные задачи не алгоритмически а статистичеки. Реверс-инжиниринг методом "потяни за ниточку" тут малоприменим. Хорошей иллюстрацией этого является современная генетика.

QWhisper

08.05.2017 13:47Но ведь переменных конечное количество. Генетика для нас еще темный лес. Там есть куча всего что уже есть и как работает не понятно. Тут нейросеть анализирует же не человека, а его карточку, а карточка вполне стандартизирована и имеет конкретные параметры.

Если бы нейросеть по фотографии или 3д модели определяла заболевание тогда да.

Вот на параметрах мы и можем сосредоточиться, можем брать разные карточки и сравнивать их между собой, чтоб выяснить почему тут А, а тут Б.

Тут главное понять, что ни какой магии нет, нет каких то данных нам не доступных, надо просто выяснить на чем базируются выводы. В базу ведь загружали карточки + диагнозы и на основе этого нейросеть и нашла сходства и стала давать предсказания.

В конце концов, на крайний случай мы можем сделать еще одну нейросеть, которая будет на входе иметь выходные данные из первой + её же входные данные, с заданием выяснить зависимости.

i360u

08.05.2017 14:24Да, переменных конечное количество, а их вариантов влияние друг-на-друга — значительно, значительно больше. Какие-то факторы могут иметь решающее значение в одних случаях и вообще не оказывать никакого влияния в других. И наоборот. В одном случае параметр будет указывать на фактор риска заболевания, к примеру, раком, а в другом — нет. И абсолютно не важно, выделили ли вы для себя этот фактор или нет, сработает он только в определенном сложном (нелинейном) сочетании с другими. Выразить эти зависимости математически и алгоритмически — чрезвычайно сложно (сложность задачи можно посчитать, она космическая), но статистически значимые зависимости проявляются на выборках большого размера, поэтому нейросети — работают.

А генетика совсем не темный лес, просто современные представления о работе ДНК отлично иллюстрируют и объясняют почему нельзя просто определить какой ген за что отвечает и что нужно изменить, чтобы, к примеру, излечить наследственное заболевание. Даже зная точно, какой ген какой белок кодирует (а в разных условиях он может кодировать разные белки и разные варианты одного белка), мы не увидим общей картины, которая включает в себя условные механизмы (за логику в ДНК отвечают участки, которые не являются генами) и множественные внешние переключатели.

QWhisper

08.05.2017 22:15Про генетику я в том плане, что это для нас не четкая формализованная структура, часть мы не понимаем, часть не работает, часть нам досталась от вирусов и т.д.

Карточка же пациента для нейронной сети таких вещей не имеет, там пишут только то, что имеет важность с точки зрения медицины. То есть про секущиеся кончики волос, количество козявок в носу и длину ногтей там не пишут.

Как результат, крайне малое или полное отсутствие мусорных входных данных. Плюс база на которой мы обучили нейросеть одна и конкретная и делая запрос с одними и теми же данными, мы будем получать один и тот же результат. Поэтому я и утверждаю, что можно построить алгоритмы которые могут выяснить на каких данных базируется нейросеть.

arheops

09.05.2017 03:06+1Я вам предложу пример. Например у вас есть уровень сахара утром и вечером, возраст пациента, город его проживания. ИИ делает вывод, что при уровне сахара между Х и Х+1% и возрасте пациента ровно 31 год при условии проживания в нью-йорке вероятность диабета 90%. Причем никто из докторов не знает почему так(почему именно Х, почему именно в 31 год), но 90% диагнозов совпадают. А также в ТО ЖЕ ВРЕМЯ ИИ делает вывод, что при возрасте пациента 32 года этот фактор незначимый вообще, но при проживании в Нью- Джерси и уровне сахара X*90% до X*95% у пациента рак желчного пузыря с вероятностью 20%. А теперь вы убираете какойто фактор… и что? Просто все пойдет лесом. Заметьте, нейросеть запоминает ОБА случая(на само делы сотни тысяч) в одной нейросети, невыделяемо. А еще она вам это так не напишет. Она вам выдаст дело товарища Макаревича и Иванова с наиболее вероятными диагнозами и попросит их проверить, а вы сами должны догадатся где у нейросети рамки сахара, города и возраста. А на самом деле факторов не 3, а тысяча. Угадывайте.

i360u

09.05.2017 06:40Не нужны никакие алгоритмы, нейросеть всегда базируется на введенных в нее данных и статистике. И все. Если спросить нейросеть почему она выдала такой результат, ответ будет всегда один: потому, что статистически проявились эти зависимости, в той выборке, которую вы мне скормили. Статистика может выявить корреляции, но она часто совсем не указывает на причины, поэтому мы и не можем точно сказать почему ИИ принял то или иное решение. Он и сам не знает почему. Мы не можем достоверно сказать, что параметр А определяется параметром Б, потому, что может быть параметр С, которого вообще нет в наших "супер формализованных" данных, но он определяет и А и Б. В медицинских данных роль могут играть даже типичные погрешности, связанные с различными методологиями проведения тестов в разных клиниках. Как нейросеть может на них указать? Она не имеет никакого понятия об этом, а корреляция может быть выявлена через местоположение пациента, которое ошибочно может быть воспринято нами как особенность экологии в той местности. Решать сложные комбинаторные задачи алгоритмически — практически невозможно. И это не мое какое-то частное мнение, это можно обосновать математически.

Приведу еще такой пример: дизайнер рисует логотип, работая с кривыми в графическом редакторе. Он сразу видит, когда у кривой появляется неестественный излом и мгновенно воспринимает это как косяк, и исправляет его. Кривые в редакторе описываются определенными математическими формулами, и переходы между ними подчиняются правилам, которые также можно выразить математически. Но дизайнер не знает математики, он не рассчитывает на ходу все, что он должен отобразить, а просто "видит". Его "нейросеть" в черепной коробке натренирована на многолетнем наблюдении за поведением физических объектов в движении (и собственного тела), и любой излом на изображенной им кривой сразу виден именно потому, что нарушена динамика траектории гипотетического движущегося объекта. А когда нас просят выразить словами что произошло — мы отвечаем "красиво" или "некрасиво", не вдаваясь ни в какую математику. И представить результат в виде формул — для нас очень сложно, как и нейросети ответить почему именно она предсказала рак у пациента.

sayanlar

08.05.2017 15:18+1Нет, они немного не так формализуются, например тот же уровень сахара не может однозначно указывать диабет, даже если последний есть в развернутом виде. Но идея здравая. Подпишитесь на меня, я пишу о создании медицинского ИИ с позиции врача. Возможно, вместе нам удастся родить что-то интересное:)

QWhisper

08.05.2017 22:22Отдельно сахар нет, но по остальным вещам мы научились его определять. Я думаю тут стоить посмотреть на образец той анкеты/карточки, которая служит для обучения нейросети. От нее и стоит танцевать. Как идиотская идея, может там у кого нет снимка головы, считается алгоритмом, что у них точно не рак мозга. То есть были ли анкеты полны по наполнению, влияла ли полнота на результаты, какие данные вообще вносились.

Да и вообще насколько эффективен алгоритм, какой процент ложных срабатываний, сколько было ложно положительных. А то может оно как Нострадамус, угадало пару раз из 100 и вау эффект.

Может быть есть какая то информация у вас по этому поводу?

sayanlar

10.05.2017 11:44-1То, что я вижу — сейчас нет необходимости диагностировать диабет нейросетью. Зачем заставлять ее придумывать какие-то закономерности, когда они и так известны, причем не только как статистика, а как научные причинно-следственные знания, подтвержденные экспериментально. На этих данных, очевидно, можно построить алгоритм, который будет работать заведомо лучше любой самообучающейся нейросети.

В медицине вообще много готовых структурированных данных, которым можно доверять. Я имею ввиду не карточки-сопоставления, а правила, описывающие, почему возникает та или иная болезнь.

knstqq

11.05.2017 14:52да-да, болезнь может быть только одна у одного человека, люди никогда не врут, а правила их описывающие могут выдавать 100% точный прогноз на развитие болезни и побочек.

sayanlar

12.05.2017 22:02Нет, настолько примитивные правила и жесткие прогнозы используются врачами в редких случаях, и точно не при определении диабета. Но это не значит, что надо сразу сдаваться и закладывать ВСЮ логику в черный ящик нейросети.

Sadler

08.05.2017 13:53Ещё можно выборочно активировать нейроны в нужном слое и распространять сигнал до входа.

nevergonnagiveyoup

08.05.2017 10:15-1А что мешает сделать параллельно работающую нейросеть, которая в динамике оценивает работу основной нейросети и выдает ее примерный ход мыслей? Методом индукции собирает данные и выдает более простой их вывод, порой обходя промежуточные звенья(если те, например, были созданы как маркер, который затес исчезал). По идее это как в анекдоте про советского посла "сложно, но возможно".

AntonSor

08.05.2017 10:23Тогда возникнет вопрос — а как контролировать контролирующую нейросеть? Но, похоже, так и придется делать.

Drako_Staarn

08.05.2017 10:47Самый простой вариант — стать нейросетью более высокого уровня. А вот как это сделать — это, детектив, правильный вопрос (с)

arheops

09.05.2017 02:55+1Это невозможно в принципе. У нейросети просто нет «мыслей», это просто набор чисел с запятой, на основе которых получается решение. И никто пока не нашел алгоритма, как определить какое число за что отвечает.

Turbo

08.05.2017 10:35Косвенные способы визуально понять что там происходит есть. Например стрят heatmap для активных нейронов. И я думаю со временем методов понять, что именно происходит, будет больше.

barkalov

08.05.2017 12:07+1В то же время Deep Patient озадачивает. Она вроде бы хорошо распознаёт начальные этапы психических отклонений вроде шизофрении. Но поскольку врачам очень трудно предсказать шизофрению, Дадли заинтересовался, как это получается у машины. И он до сих пор не сумел это выяснить. Новый инструмент не даёт понимания того, как он этого достигает.

Ерунда какая-то. Максимизация выходного вектора нейросети — задача, конечно, вычислительно сложная, но технически решаема. В крайнем случае, «вывернуть наизнанку» нейросеть можно другой нейросетью. Та же «банальная» Prisma так работает.

pant-79

08.05.2017 12:17Не знаю. Мне одному чтоли в голову пришел вариант решения этой проблемы путем дробления? Да, одним большим «черным ящиком» невозможно управлять, так как нет обратной связи.

Значит, надо раздробить этот большой «черный ящик» на кучу маленьких, которые уже можно запихнуть в нормально управляемый, программируемый алгоритм.

Одна нейросеть пусть отвечает за распознавание образа, другая — за поведенческую модель в одном конкретном случае, третья — за поведенческую модель в другом конкретном случае. Пусть они обучаются параллельно, но отдельно друг от друга. А уж управление результатами их работы предоставьте программисту.

i360u

08.05.2017 12:31Придется создавать отдельные нейросети для всех сочетаний факторов влияния в моменты когда те становятся статистически значимыми. Это решение будет работать только в небольшом количестве не очень сложных частных случаев.

barkalov

08.05.2017 12:35Сильная сторона нейросетей это как раз решение «плохо дробящихся» задач, где параметры скрыты в глубоко переплетных входных значениях. Если задача хорошо дробится — скорее всего её можно более успешно решить другими алгоритмами.

telobezumnoe

08.05.2017 12:38+1мда, появится быдломобили, которые через раз включают указатели поворота, а если и включают, то в последний момент)) вообще странно, сам по себе искусственный интеллект не может быть по определению прозрачным, такие объемы данных повлиявших на его обучение, выводы, невероятно сложно будет анализировать, тем более человеку, похоже многие так и не понимают чем отличается экспертная система, с жёсткими алгоритмами формирования решения с ИИ… вот интересное видео

AntonSor

Это отдает неолуддизмом. В машине нет никаких данных кроме тех, которые мы в нее закладываем. Если мы получаем ответы, которые не можем объяснить — значит, мы не понимаем, что мы в нее закладываем.

AntonSor

А то, действительно, машина для диагностики рака по генной карте начнет заниматься против нашей воли евгеническими экспериментами, увеличивая вероятность смерти пациентов с «неправильными генами»

AntonSor

«Искусственное производство жизни логически уравновешивается искусственным производством смерти» (с) М.Хайдеггер

dipsy

А если человек начнет? А если он диплом купил, а диссертацию списал? И не обязательно использовать одну машину, можно несколько разных и сравнивать что они советуют.

EvilGenius18

Алгоритм нейросети может генерировать данные и присваивать им значения. Так что это неверное утверждение

Мы (люди) не можем понять внутренню работу нейросети, поскольку данные ее внутренних слоев генерируется динамически, по заданным математическим выражениям.

Набор данных, генерируемый внутренними слоями, просто огромен, поэтому ни один человек не сможет прочесть и проанализировать работу внутренних слоев по-отдельности. Иначе было бы сложно получить такие впечатляющие результаты обработки данных на компьютере

Да это и не нужно (анализирование внутренних слоев). Людям важно получить конечный результат, а не тратить 10000 лет на изучение взаимодействия весов нейронов нейросети.

AntonSor

А алгоритм закладываем разве не мы сами?

Видимо, еще не создано действительно пригодных для этого инструментов анализа. Что-то подсказывает, что это будет еще одна нейросеть.

AntonSor

Ведь если проблема анализа работы нейросети заключается лишь в огромном объеме данных внутренних слоев — значит, принципиально она решаема, и инструментарий сделать вполне возможно. Пусть он будет в 10 или 100 раз более громоздким, чем исследуемая машина, не страшно, она используется лишь при отладке и поиске ошибок.

Duduka

Отличный пример заблуждения! Цирмело поставил перед Больцманом точно такую же задачу: «построить описание термодинамической системы», можно развить пример: «по фотографии реликтового излучения восстановите всю историю Вселенной, и пожалуйста с историей Земли на 100 лет вперед… очень интересно!»

"… Возражение Цермело Больцману заключалось в следующем: Больцман утверждает, что может доказать, что величина Н — энтропия с отрицательным значением — всегда уменьшается. Но в теореме Пуанкаре доказывается: при данном достаточном времени любое сочетание атомов снова повторится, и, значит, произойдет возвращение к изначальной энтропии. Следовательно, утверждение Больцмана не может быть верным ..." (с) не мой и может расцениваться как реклама стороннего сайта.

Программы уже пол века недетерминированы, для некоторых простейших алгоритмов можно построить конечное описание поведения, для большинства более-менее сложных систем задача описания имеет экспоненциальную сложность или близкую к ней (мы вводим абстракцию «агрегат», «элемент»… для подсистем имеющих какое-то представимое описание и интерфейс, но со «сложностью» сопряжения мы справляться не можем)…

EvilGenius18

Дело не в этом. Внутренние слои анализировать довольно бессмысленно. Там ничего интересного нету, они работают в заданном диапазоне и по четко заданным математическим правилам

Сами. Мы можем написать алгоритм и запустить (в дальнейшем не вмешиваясь, т.е. не добавляя данных), который может получать данные и обрабатывать их по заданному алгоритму. После одной итерации алгоритма, нейросистема сможет использовать этот результат для дальнейшей обработки данных (обучение) и присваивать новым данным уже измененные правила.

Младенцы людей работают по таким же правилам:

— Создали алгоритм правил (родился младенец с определенными свойствами) => алгоритм получил данные (младенец потрогал горячую поверхность) => алгоритм использует полученные знания для обработки последующих ситуаций

c_kotik

Алгоритм обучения — да. Но чему в итоге научится, какие связи сопоставит машина и к какому выводу придёт — вот это, как мне кажется, и есть главный вопрос статьи.

begemot_sun

Применимо к НС нет никаких связей и выводов. Есть набор внутренних параметров, минимизирующий ошибку НС для заданных условий. Это всё. Искать скрытые смыслы внутри скрытых слоев — не алгоритмизируемая задача.

Hellsy22

Отдельный человек не сможет прочесть и проанализировать работу кеша какой-нибудь базы данных объемом в сто гигабайт. Или досконально проверить работу оценщика веса сайта в поисковой машине. И зачастую невозможность легко проверить результат ведет к багам, существующим десятилетия или к эксплойтам.

Все даже еще хуже — никто не может досконально проверить конкретный микропроцессор, а ну как у него производственный брак, который проявляется в редчайших условиях?

Это данность в которой мы уже живем.

Siroejka

Всё просто, чтобы понять работу ИИ нужен ещё один ИИ!

rexen

Ну да, чтобы объяснить муравью устройство ящерицы, нужно создать медведя…

Это тупик. ИИ — инструмент. Нецелесообразно создавать инструменты, использование которых в итоге приводит к затратам, бОльшим, нежели предыдущее поколение. Создание «объясняющего ИИ» нивелирует выгоду от использования «объясняемого ИИ». Нужен статистический подход — ориентация на результат — если робомобили в итоге значительно снизят количество жертв, то и пофигу на понимание этой авто-интуиции.

ABy

Если гравицапа летает, то пофигу как она это делает?;)

potan

При таком подходе важно не удивляться, если она вдруг падает, скажем над бассейном…

allter

Вот только жертвам случайностей (если, к примеру, алгоритм примет встречный Белаз за двух мотоциклистов) надо будет найти виновного. Кто это будет? Сам погибший, производитель автопилота или конкретный "воспитатель ИИ", который в обучающую и тестовую выборку не добавил фото/видео Белазов. Как опредлить, кто из них виновен (даже если сохранять сырые данные в формате сжатия без потерь)?

Sadler

allter

Ах, если бы ответственность по уголовному законодательству можно было бы легко распределять через договоры…

Denkenmacht

Никто не будет виновен. Это форс мажор, как техническая неисправность, которую диагностировать и предотвратить невозможно заранее. Никто ведь как правило не несет угололвную ответственность за крушения самолетов, обусловленные тех причинами или погодными условиями.

knstqq

несут. Диспетчеры, пилоты, обслуживающий персонал (проверяющий техническое состояние самолета), конструкторы (в случае если был доказан умысел или халатная невнимательность).

Сама себе плохая погода — не повод падать (и падения не происходят обычно из-за дождика).

Но если кто-то ещё ошибаются — вот и виновные.

Только в очень редких случаях никто не несёт

rexen

А зачем вообще искать виновного? Ущерб возместит страховка. А алгоритм обучится и станет более совершенным.

Слушайте — вам дают чёрный ящик и гарантируют, что он снизит аварийность на порядок. Вам не всё равно, что внутри ящика? Вы от него откажетесь пока до мелочей не поймёте его устройство?

Современные ПК и софт — уже считайте стали такими «чёрными ящиками» — «херак-херак — и в продакшен» — что там внутри и как работает — никто не заморачивается, а просто тестирование переносят на публику, выкатывая сырой продукт — «главное опередить конкурентов, а глюки по дороге доделаем...»

allter

Возмещение ущерба — это по гражданскому праву. А по уголовному (когда обвиняет не пострадавший, а общество в целом) кого надо будет посадить?

И вообще, тема «чёрный ящик снижает аварийность» мне очень напоминает сюжет фильма «Особое мнение» («Minority report»).

AntonSor

Здесь может быть интересный казус. Для избежания ответственности (вернее, перекладывания ответственности на конечного пользователя) могут появиться ИИ с анонимным авторством.

potan

И без авторских прав? ;-)

dimm_ddr

В таком случае ответственность полностью ляжет на тех, кто их использует. Никакой проблемы.

ChiefPilot

Я бы выбрал «сам погибший» и вот почему: это было его решение — поехать на таком автомобиле. Чем это решение принципиально отличается от решения поехать на обычном автомобиле? Ну правда — чем? Только тем, что тут вместо руля, педалей и т. п. лишь кнопка (или голосовое подтверждение? или ещё как?), НО! (и только это важно!) подтверждающая его желание совершить эту поездку! В обычном автомобиле это подтверждение осуществляется просто началом управления им. А тут кнопка. И какая разница?! И там и тут, прежде чем ехать, нужно представлять себе возможности и ограничения автомобиля. Они разные, но не принципиально! Не вижу принципиальных отличий. Решил ехать, сообщил своё решение автомобилю — ответственность за твою жизнь на тебе. Вот и все дела. :)

torbasow

Проблема, как я понимаю, не в том, что мы в принципе не можем чего-то ухватить и объяснить — а что мы в принципе не можем это сделать за приемлемое время. Не за гугол лет.

AntonSor

Когда-то думали, что беспроводная связь невозможна…

Shished

Никогда так не думали. Такая связь существует тысячи лет.

VioletGiraffe

Сигнальный костры, что ли?

ABy

Речь;)

ChiefPilot

А ещё до этого неречевые сигналы. В том числе не просто «мычание», а, например, жесты руками, телом, мимика лица. Это всё ещё более древнее и такое же беспроводное! :)

herr_kaizer

Каждый раз, когда я вижу подобные слова, мне хочется кого-нибудь ударить.