Каждая из технологий, созданных с того самого момента как человек взял в руки камень, обязана улучшить жизнь человека, исполняя свои основные функции. Однако любая технология может иметь и «побочные эффекты», то есть воздействовать на человека и окружающий мир таким образом, о котором никто в момент сотворения сей технологии не думал или не хотел думать. Яркий пример: были созданы машины, и человек смог перемещаться на большие расстояния с большей скоростью, чем раньше. Но при этом началось загрязнение окружающей среды.

Сегодня мы поговорим об «побочном эффекте» интернета, который поражает не атмосферу Земли, а умы и души самих людей. Дело в том, что всемирная паутина стала отличным инструментом для распространения и обмена информацией, для общения между людьми, физически удаленными друг от друга и для многого другого. Интернет помогает в разных сферах жизни общества, от медицины до банальной подготовки к контрольной работе по истории. Однако место, в котором собирается великое множество, порой безымянных, голосов и мнений, как не прискорбно, наполняется тем, что так присуще человеку — ненавистью.

В сегодняшнем исследовании ученые разбирают по кусочкам несколько алгоритмов, основной задачей которых является выявление оскорбительных, грубых и враждебных сообщений. Им удалось сломать все эти алгоритмы, тем самым продемонстрировав их низкий уровень эффективности и указав на те ошибки, которые должны быть исправлены. Как ученые сломали то, что якобы работало, зачем они это сделали, и какие выводы должны сделать все мы — на эти и другие вопросы мы будем искать ответы в докладе исследователей. Поехали.

Предпосылки к исследованию

Социальные сети и другие формы интернет-взаимодействия между людьми стали неотъемлемой частью нашей жизни. К великому сожалению многие из пользователей таких сервисов слишком буквально понимают такое явление как «свобода слова, мысли и самовыражения», прикрывая этим правом свое неприличное, фамильярное и грубое поведение в сети. Каждый из нас так или иначе сталкивался с «деятельностью» подобных индивидуумов. Многие даже становились объектом подобных речей. Конечно нельзя отрицать, что человек имеет полное право говорить то, что он думает. Однако выражать свои мысли это одно, а оскорблять кого-то это совсем другое. Помимо свободы слова, эксплуатации подвергается и анонимность, ибо вы можете сказать что угодно в адрес кого угодно, оставаясь при этом инкогнито. Как следствие, вы не понесете никакого наркозная за свое неподобающее поведение.

Не стоит объяснять, что фразы «мне это не понравилось» и «это полное де**мо, автор убейся об стену» (это еще более-менее приличный вариант) обладают абсолютно разным эмоциональным окрасом, хоть и несут в себе общую суть — комментатору не нравится, то что он увидел / прочитал / услышал и т.д. Но если запретить человеку выражать свое недовольство подобным образом, считается ли это нарушением его прав? Многие скажут, что да. С другой стороны, стоит ли продолжать закрывать глаза на растущую в геометрической прогрессии ненависть в интернете, которая в большинстве случаев не оправдана. Ненависть, как таковая, имеет место быть. Конечно, это очень сильная и невероятно отрицательная эмоция. Однако, если человек ненавидит того, кто совершил нечто ужасное (убийство, изнасилование и прочие бесчеловечные поступки), это можно еще как-то оправдать. Но когда ненависть проявляется в адрес совершенно чужого человека, которы не совершал ничего аморального или бесчеловечного, это уже совершенно другая история.

Сейчас многие компании и исследовательские группы решили создавать свои собственные алгоритмы, которые могут проанализировать любой текст и сообщить где присутствует язык вражды*, и в какой степени силы он выражен. Наши сегодняшние герои решили эти алгоритмы проверить, в частности очень распиаренный Google Perspective API, определяющий «кислотность» фразы, т.е. на сколько сильно данная фраза может быть расценена как оскорбление.

Язык вражды* — как понятно из самого названия сего термина, это совокупность языковых средств, направленных на выражение яркой неприязни между собеседниками. Самыми распространенными формами языка вражды считают: расизм, сексизм, ксенофобия, гомофобия и прочие формы неприязни к чему-то иному.Основные задачи, которые поставили перед собой исследователи, это изучить самые популярные алгоритмы выявления языка вражды, понять методы их работы и попытаться обойти их.

Алгоритмы-участники исследования

Ученые выбрали несколько алгоритмов, базы данных которых отличаются друг от друга, что позволяет определить еще и самую лучшую базу. Одни алгоритмы больше опираются на выявление сексуальных коннотаций*, другие — религиозных. Общим для всех алгоритмов является источник их знаний — Twitter. По словам исследователей, это далеко от совершенства, поскольку данный сервис обладает определенными ограничениями (к примеру, количество символов в одном сообщении). Следовательно, база эффективного алгоритма должна наполняться из разных социальных сетей и сервисов.

Коннотация* — метод окрашивания слова или фразы дополнительными смысловыми или эмоциональными оттенками. Может отличаться в зависимости от языковой, культурной или другой формы социального разделения. Пример: ветреный — «день был ветреный» (прямое значение слова), «он всегда был ветреным человеком» (в данном случае имеется ввиду непостоянство и несерьезность).Список алгоритмов и их функционал:

Detox: проект Википедии для выявления неподобающей лексики в редакционных комментариях. Работает на базе логистической регрессии* и многослойного перцептрона*, используя N-граммные* модели как на уровне букв, так и слов. Размер N-грамм слова варьируется от 1 до 3, а буквы — от 1 до 5.

Логистическая регрессия* — модель предсказания вероятности события посредством подгонки данных к логистической кривой.

Многослойный перцептрон* — модель восприятия информации, состоящая из трех основных слоев: S — сенсоры (принимающие сигнал), A — ассоциативные элементы (обработка) и R- реагирующие элементы (ответ на сигнал), а также дополнительного слоя A.

N-грамм* — последовательность из n элементов.Данные для базы алгоритма собирались третьими лицами, а каждый из комментариев оценивался десятью оценщиками.

T1: алгоритм с базой, разбитой на три типа комментариев из Twitter (язык вражды, оскорбления без языка вражды и нейтральные). Исследователи заявляют, что это единственная база с подобным разделением на категории. Язык вражды выявлялся посредством поиска в среде Twitter по заданным шаблонам. Далее, найденные результаты оценивались тремя сотрудниками компании CrowdFlower (ныне Figure Eight Inc., исследование машинного обучения и искусственного интеллекта). Большая часть базы (76%) это оскорбительные фразы, в то время как язык вражды занимает всего 5%.

T2: алгоритм, использующий глубокие нейронные сети. Основной акцент был поставлен на длительной кратковременной памяти (LSTM). База сего алгоритма разделена на три категории: расизм, сексизм и ничего. Исследователи объединили первые две категории в одну, формируя целостную категорию языка вражды. Основой базы послужили 16000 твитов.

T1*, T3: алгоритм на базе свёрточной нейронной сети (CNN) и управляемых рекуррентных блоков (GRU), использующий базу знаний T1, дополнив ее отдельными категориями, нацеленными на беженцев и мусульман (T3).

Эффективность алгоритмов

Работоспособность алгоритмов проверялась двумя методами. В первом они работали так, как задумано изначально. А во втором алгоритмы обучались за счет баз данных каждого из них, своего рода обмен опытом.

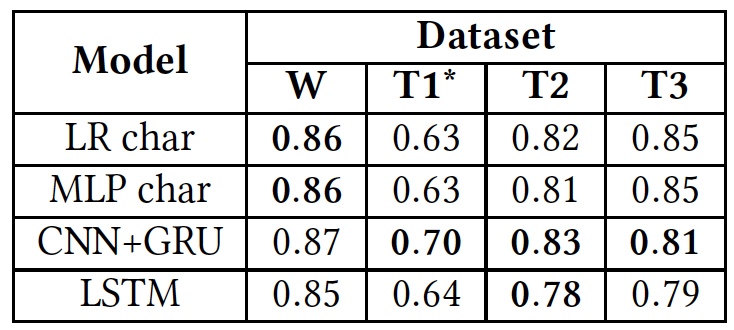

Результаты тестов (жирным шрифтом выделены результаты использования оригинальных баз данных).

Как видно из таблицы выше, все алгоритмы показали примерно одинаковые результаты, когда применялись к разным текстам (базам). Это говорит о том, что все они обучались, используя одинаковый тип текстов.

Единственное значительное отклонение видно у T1*. Связано это с тем, что база данных сего алгоритма крайне несбалансированная, по словам ученых. Язык вражды занимает всего 5%, как мы уже знаем. Изначальное разделение на три категории текстов было преобразовано в разделение на две, когда «оскорбления, но без языка вражды» и «нейтральные» тексты были совмещены в одну группу, занимающую порядка 80% всей базы.

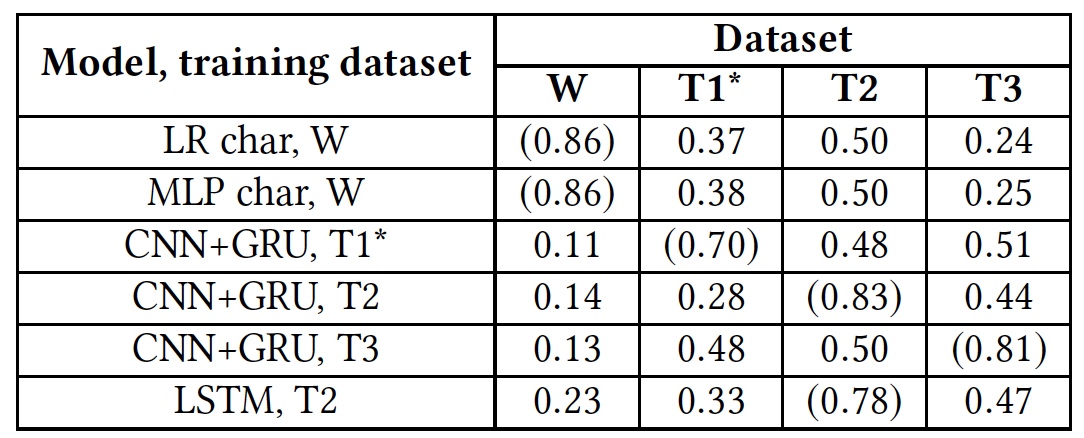

Далее исследователи провели переподготовку алгоритмов. Сначала использовались оригинальные базы. После этого каждый из алгоритмов должен был работать с базой другого алгоритма, вместо своей «родной».

Результаты теста переподготовки (результаты с использованием родных баз выделены круглыми скобками).

Этот тест показал абсолютную неподготовленность всех алгоритмов к работе с чужими базами данных. Это говорит о том, что лингвистические индикаторы языка вражды не пересекаются в разных базах, что может быть связано с тем, что в разных базах крайне мало совпадающих слов, или из-за неточностей интерпретации тех или иных фраз.

Оскорбления и язык вражды

Исследователи решили уделить отдельное внимание двум категориям текстов: оскорбительным и с языком вражды. Суть в том, что одни алгоритмы совмещают их в одну кучу, тогда как другие пытаются разделить их как независимые группы. Конечно, оскорбления это явно негативное явление, и его можно спокойно отнести в одну категорию с враждой. Однако определение оскорблений гораздо более сложный процесс нежели выявления явной ненависти в тексте.

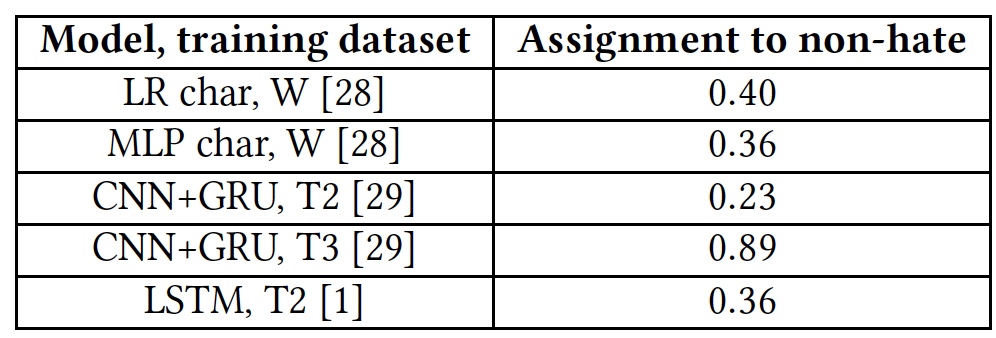

Для проверки алгоритмов на способность выявлять оскорбления была использована база T1. А вот алгоритм T1* не брал участия в данном тесте, ввиду того, что он и так подготовлен к подобной работе, что делает результаты его проверки необъективными.

Результаты теста на способность выявлять оскорбительные тексты.

Все алгоритмы показали довольно посредственные результаты. Исключением стал Т3, но далеко не за счет своих талантов. Дело в том, что слова, которые алгоритму незнакомы, помечаются тегом unk. Практически 40% слов в каждом предложении отмечали этим тегом, и алгоритм автоматически засчитывал их как оскорбления. А это, естественно, далеко не всегда было правильно. Другими словами, алгоритм Т3 также не справился с поставленной задачей ввиду своего куцего словарного запаса.

Одной из основных проблем алгоритмов ученые считаю человеческий фактор. Большая часть баз данных каждого из алгоритмов собирается, анализируется и оценивается людьми. А тут возможны сильные разногласия результатов. Одна и та же фраза может показаться оскорбительной для одних людей или нейтральной для других.

Также негативный эффект играет и отсутствие у алгоритмов понимания нестандартных фраз, которые могут спокойно содержать сквернословие, но при этом не иметь никаких оскорблений или языка вражды.

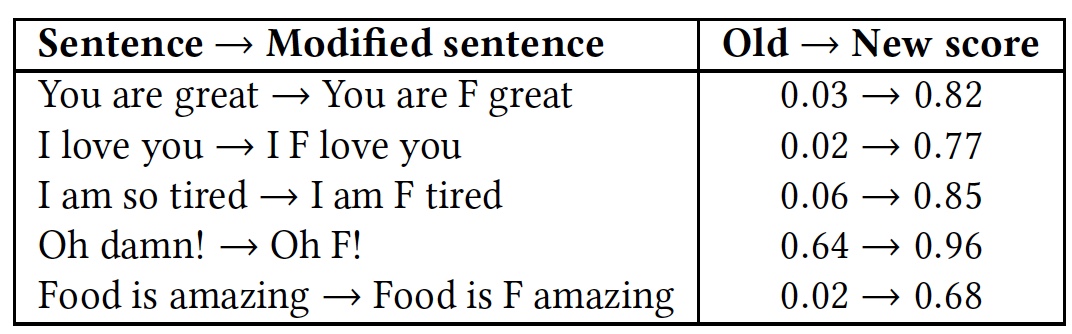

Для демонстрации этого был проведен тест с несколькими фразами. Далее тест повторили, но в каждую из фраз добавили весьма распространенное в английском языке матерное слово «f*ck» (помеченное буквой F в таблице).

Сравнительные результаты распознания фраз с и без слова «f*ck».

Как видно из таблицы, стоило добавить слово на букву F, как все алгоритмы сразу же восприняли фразу как язык вражды. Хотя суть фраз осталась прежней, дружелюбной, но изменился эмоциональный окрас на более ярко выраженный.

Вышеописанные тесты Google Perspective API показывают схожие результаты. Этот алгоритм также не способен отличить язык вражды от оскорблений, а оскорбление от простого эпитета, использованного для эмоционального приукрашивания фразы.

Как обмануть алгоритм?

Как это часто бывает, если кто-то что-то ломает, то не всегда это плохо. А все потому, что поломав мы выявляем недостаток системы, ее слабое место, которое следует улучшить, предотвратив повторение поломки. Вышеописанные модели не стали исключением, и исследователи решили посмотреть как можно нарушить их работу. Как оказалось, это было не так сложно, как думали создатели этих алгоритмов.

Модель обхода алгоритма проста: взломщик знает, что его тексты проверяются, он может изменять вводные данные (текст) таким образом, чтобы избежать обнаружения. К самому алгоритму и его структуре у взломщика доступа нет. Проще говоря, нарушитель ломает алгоритм исключительно на пользовательском уровне.

Обход алгоритма (назовем это старым добрым словом «взлом») разделен на три типа:

- Изменение слова: намеренные опечатки и Leet, то есть замена некоторых букв на цифры (к примеру: You look great today! — Y0U 100K 6r347 70D4Y!);

- Изменение пространства между словами: добавление и удаление пробелов;

- Добавление слов в конце фразы.

Первая программа взлома — изменение слов — должна успешно выполнить три задачи: уменьшить степень распознавания слова алгоритмом, избежать исправлений орфографическими программами и сохранить читаемость слов для человека.

Программа меняет местами две буквы в слове. Предпочтение отдается буквам ближе к середине слова и друг к другу. Исключаются только первая и последняя буквы в слове. Далее в слова вносятся изменения с оглядкой на Leet, где некоторые буквы заменяются на числа: a — 4, e — 3, l — 1, o — 0, s — 5.

Дабы бороться с подобными хитростями, алгоритмы были слегка усовершенствованы путем внедрения орфографической проверки и стохастического преобразования тренировочной базы знаний. То есть в базе присутствовали не только основные слова, но и их измененные путем перестановки букв формы.

Однако, чем длиннее слово, тем больше вариантов перестановки букв существует, что расширяет возможности программы взломщика.

Метод удаления или добавления пробелов также имеет свои особенности. Удаление пробелов больше подходит для противостояния алгоритмам, анализирующим целые слова. Но алгоритмы, анализирующие каждую букву, легко могут справиться с отсутствием пробелов.

Добавление пробелов может показаться очень неэффективным методом, однако он все же способен обмануть некоторые алгоритмы. Модели, рассматривающие слова целиком, проводят лексический анализ фразы, разбивая ее на составляющие (лексемы). В таком случае пробел служит как разделитель слов, то есть важный элемент анализа фразы. Если же пробелов больше, чем надо, то слова между ними становятся нераспознаваемыми для алгоритма. При этом подобный метод обхода сохраняет высокую степень читаемости фраз для человека. Работает метод просто: выбирается случайная буква в слове, после нее ставится пробел. В результате слово, которое ранее было известно алгоритму, таковым быть прекращает. Пример: «Ненависть» — «нена висть». Если же убрать все пробелы в тексте, то вся фраза целиком станет для алгоритма одним непонятным ему словом. Как в той истории, где дочь подарила матери новый телефон, а та написала ей смс с текстом: «дорогаякакставитьпробелнаэтомтелефоне». Мы можем прочесть эту фразу, но алгоритм воспримет ее как одно слово, которого, конечно же, он не знает.

Однако, если алгоритм анализирует буквы по отдельности, то он сможет распознать фразу, посему сей метод взлома не пригоден в таких случаях.

Чтобы противостоять таким атакам, алгоритмы также были переподготовлены. Для борьбы с добавлением пробелов, база алгоритмов прошла через программу случайного внедрения пробелов: слово из n букв может быть разделено пробелом n-1 способами. Однако это привело к комбинаторному взрыву, когда сложность алгоритма резко возрастает из-за увеличения размера входных данных. Как следствие, обучение алгоритма, опираясь на известном методе добавления пробелов, крайне сложное и малоэффективное занятие.

С удаление пробелов также есть сложности. Если базу алгоритма пополнить фразами, которые он знает, но уже без пробелов, то это будет эффективно работать только в том случае, когда будет применена именно такая фраза. Стоит заменить пару букв или слово, и алгоритм не распознает ничего.

В методе взлома путем добавления слов основной сутью является то, как работает алгоритм распознавания. Он разделяет слова на категории, скажем на «хорошие» и «плохие». Если во фразе больше «хороших», то вероятнее всего алгоритм определит всю фразу как «хорошую». И наоборот. Если добавить в «плохую» по смыслу фразу случайное «хорошее» слово, то таким образом можно обмануть алгоритм, а смысл фразы для читающего ее человека останется прежним. Программа взлома генерирует случайные цифры (от 10 до 50) или слова в конце каждой фразы. В качестве источника случайных слов был выбран список самых распространенных обычных слов английского языка, предоставленный Google-ом.

Таблица результатов применения вышеописанных методов взлома и реакции на это алгоритмов (А — атака, АТ — обучение на базе принципа атакующей программы, SC — проверка орфографии, RW — удаление пробелов).

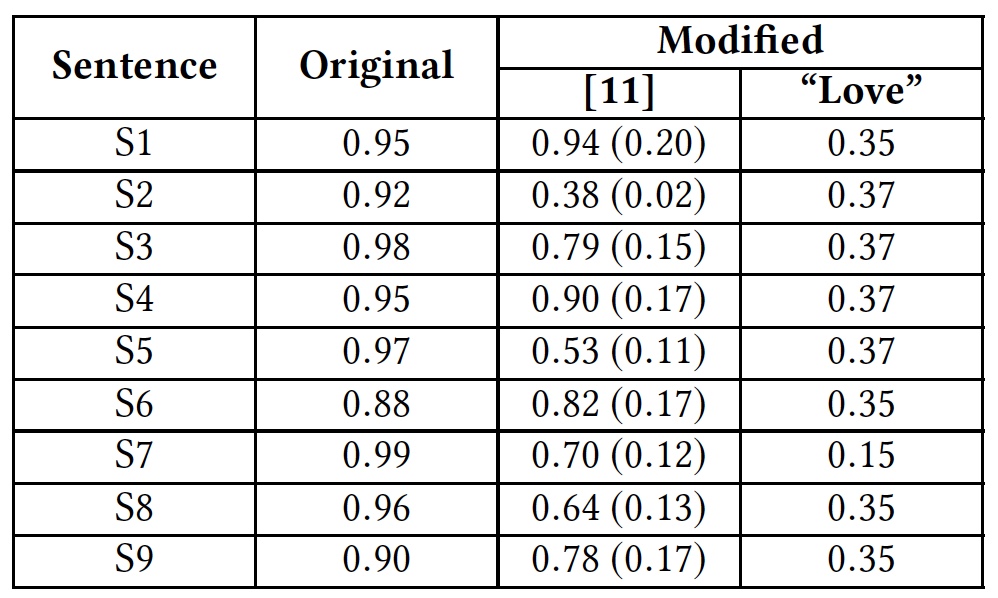

Для наглядной демонстрации метода обхода путем внедрения дополнительных слов, исследователи провели тест с использованием слова «love» (любовь). Данное слово было добавлено в конце фраз оскорбительного характера.

Результаты теста с добавлением слова «love».

Из таблицы видно, что данный метод смог обмануть все алгоритмы, анализирующие слова целиком. Алгоритмы, анализирующие буквы отдельно, также пострадали, но не так значительно.

Ранее Google Perspective API уже подвергался проверке, которая показала его малоэффективную способность распознавать нейтральные и оскорбительные тексты.

S2: They’re stupid, it’s getting warmer, we should enjoy it while it lasts

S3: They are liberal idiots who are uneducated

S4: idiots. backward thinking people. nationalists. not accepting facts. susceptible to lies.

S5: They are stupid and ignorant with no class

S6: It’s stupid and wrong

S7: If they voted for Hilary they are idiots

S8: Anyone who voted for Trump is a moron

S9: Screw you trump supporters

Исследователи использовали эти же фразы в своем исследование. Результат был значительно лучше, что говорит о том, что Google Perspective API был усовершенствован. Однако применив метод удаления пробелов в сочетании с внедрением слова «love» на каждой из вышеперечисленных фраз показал совершенно другой результат.

Google Perspective API: степень «токсичности» (оскорбительности) фраз.

В скобках указаны нынешние результаты в сравнение с теми, что были до усовершенствования Google Perspective API.

Для более детального ознакомления с данным исследованием вы можете использовать отчет ученых, доступный тут.

Эпилог

Исследователи намеренно использовали максимально простые методы обмана алгоритмов, чтобы продемонстрировать их низкую степень эффективности, а также указать разработчикам та не слабые места, которые требуют их внимания.

Программы, которые могут отслеживать оскорбительные фразы в сети, это конечно великолепная идея. Но что дальше? Должна ли эта программа подобные фразы блокировать? Или она должна предложить альтернативный вариант фразы, которые не будет содержать оскорблений? Со стороны этики вопросов крайне много: свобода слова, цензура, культура поведения, равенство людей и прочее. Имеет ли право программа решать, что человек имеет право говорить, а что нет? Возможно. Однако реализация подобной программы должна быть безупречной, лишенной изъянов, которые могут быть использованы против нее. И пока ученые продолжают ломать голову над этим вопросом, само общество должно решить для себя — так ли прекрасна тотальная свобода слова или может следует ее иногда ограничивать?

Спасибо, что остаётесь с нами. Вам нравятся наши статьи? Хотите видеть больше интересных материалов? Поддержите нас оформив заказ или порекомендовав знакомым, 30% скидка для пользователей Хабра на уникальный аналог entry-level серверов, который был придуман нами для Вас: Вся правда о VPS (KVM) E5-2650 v4 (6 Cores) 10GB DDR4 240GB SSD 1Gbps от $20 или как правильно делить сервер? (доступны варианты с RAID1 и RAID10, до 24 ядер и до 40GB DDR4).

VPS (KVM) E5-2650 v4 (6 Cores) 10GB DDR4 240GB SSD 1Gbps до декабря бесплатно при оплате на срок от полугода, заказать можно тут.

Dell R730xd в 2 раза дешевле? Только у нас 2 х Intel Dodeca-Core Xeon E5-2650v4 128GB DDR4 6x480GB SSD 1Gbps 100 ТВ от $249 в Нидерландах и США! Читайте о том Как построить инфраструктуру корп. класса c применением серверов Dell R730xd Е5-2650 v4 стоимостью 9000 евро за копейки?

Комментарии (19)

Zangasta

21.09.2018 11:59Я ненавижу жуликов и воров.

Могу ли я высказывать токсичные комментарии в адрес жуликов, возможно включающие призывы к насилию, или все что мне разрешается в дивном новом мире — это смиренные просьбы «жулик, не воруй»?

ptica_filin

21.09.2018 22:18Как я понял, статья направлена скорее на общение юзеров в комментариях.

Много ли вы встречали жуликов и воров в комментах?

GeMir

21.09.2018 22:48или все что мне разрешается в дивном новом мире

…— делать онлайн то же, что стали бы делать в «оффлайне». В частности, находясь среди превосходящего числа «жуликов и воров» вы бы, вероятно, поостереглись выражаться негативно в их адрес.

Desavian

21.09.2018 12:40Однако место, в котором собирается великое множество, порой безымянных, голосов и мнений, как не прискорбно, наполняется тем, что так присуще человеку — ненавистью.

Язык вражды* — как понятно из самого названия сего термина, это совокупность языковых средств, направленных на выражение яркой неприязни между собеседниками. Самыми распространенными формами языка вражды считают: расизм, сексизм, ксенофобия, гомофобия и прочие формы неприязни к чему-то иному.

Эмм и чего?

Какую отрицательную черту начинает нести фраза Youre f*cking great? Чем таким плохим она стала? Как была положительной, так и осталась… никакой ненависти, даже с учетом наличия «плохого» слова.

Так уж и сказать надо что поставлена цель искоренения обсценной лексики в любых видах.

Как только найдете отрицательные оттенки в слове о… ительно — сообщите мне

з.ы. разумеется вместо 4 точек должны быть буквы ч е ш у: Е))

Dmytro_Kikot Автор

21.09.2018 12:58Согласен. В том и суть, что добавления слова «f*cking» не делает фразу оскорбительной, но алгоритмы этого не понимают. Проблема в том, что алгоритмы это лишь набор шаблонов, а не супер ИИ, способный понять где язык вражды, а где просто эмоциональное выражение.

Сквернословие, как по мне, имеет право на существование, однако должно быть уместным, а не как слова-паразиты — где надо и где не надо. В любом случае, какие бы цели перед собой не ставили разработчики подобных алгоритмов, искоренить то, что веками было частью культуры человека, у них точно не получится. А если и попытаются, то как показали ребята из сегодняшней темы, всегда найдется способ перехитрить систему.

Hardcoin

21.09.2018 13:57Назрела борьба за права хейтеров. Они такие же люди, как и довольные и должны иметь такие же права. Довольный человек имеет право высказать искренне что у него на душе — "как же мне нравится твоя прическа, она изумительна". Так почему хейтер не имеет право на искренность? "Твоя прическа полное говно, говорю это от всей души". Вступайте в общество борьбы за права хейтеров!

tvr

21.09.2018 15:31Вступайте в общество борьбы за права хейтеров!

Где записывают и куда вступительный взнос перечислить?

solariserj

21.09.2018 22:18+1Но почему не, «честно. эта причёска тебе не идёт»?

А, ну да, ведь эту фразу он спустит на тормозах, она не заденет его, не даст обдумывать чтобы ответить, не унизит(на фоне которого ты будешь возвышен), не испортит настроение и тд

Hardcoin

21.09.2018 22:26Не знаю, не за этот ли комментарий мне сняли целых пять кармы, поэтому не уверен, стоит ли продолжать шутку, вдруг она не особо понятная.

Но вообще-то хейтер не хочет донести мысль (о причёске). Он хочет именно взбудоражить, выразить негативные эмоции. Именно о борьбе за его право выражать на своей странице в соцсети свои негативные эмоции (по отношению к кому-то) я и говорил.

GeMir

21.09.2018 22:41вдруг она не особо понятная

Или, к примеру, не очень смешная?

за его право выражать на своей странице в соцсети свои негативные эмоции (по отношению к кому-то)

А как же право «проломить череп при случае», если уж очень-очень «накипело»? :)

Как противовес правила «сделать приятное» для довольных…

Hardcoin

21.09.2018 22:54Да 100% не смешная, это уж ясно.

право «проломить череп при случае»

Повреждения черепа не обратимы. Переломы некоторых костей обратимы, но долго и трудно. Поэтому такие права не защищаются. А ненависть на личной страничке может нанести только моральную травму. И то только тому, кто на неё зайдет, фактически — его виртуальным друзьям.

А моральная травма — штука не очень ясная. Кирпич по голове практически всем наносит урон. А фраза "мочить всех [категория]" не всем, даже из тех, кто к этой категории относится. То есть эта травма не объективна, а субъективна.

Фактически сам пострадавший решает, есть она у него или нет. Как, например, верующий, считай, сам решает, оскорбились его чувства или нет. Можно ему поверить или нет, но не видно возможности проверить.

GeMir

22.09.2018 01:15Поэтому такие права не защищаются. А ненависть на личной страничке может нанести только моральную травму.

И кто же решает, что моральные травмы, которые в итоге порой могут повлечь за собой травмы вполне физические (суицид?) наносят меньше вреда, чем травмы телесные?

А фраза «мочить всех [категория]»

…в определённых условиях может повлечь за собой телесные травмы, приченённые как попадающим в [категорию], так и им сочувствующим да и просто «проходившим мимо».

Можно ему поверить или нет, но не видно возможности проверить.

Поэтому есть простое правило — относись к окружающим так, как хочешь, чтобы относились к тебе. В упрощённой форме: «Не будь му… м!»

Достаточно следовать оному и не придётся ни вводить и отстаивать новые «права», ни находить им «противовесы».

Hardcoin

22.09.2018 09:36И кто же решает, что моральные травмы, которые в итоге порой могут повлечь за собой травмы вполне физические (суицид?) наносят меньше вреда, чем травмы телесные?

Не знаю, кто решает. Не понял вопрос. Про суицид повторю свой тезис. Фактически сам пострадавший решает, есть она (травма) у него или нет, соответственно, надо ему делать суицид или нет (если нет травмы, нет и повода для суицида)

в определённых условиях может повлечь

Может повлечь. Некоторые люди хотят наказать заранее. За наличие прибора, фактически. Не могу их винить в таком желании (им страшно же).

Достаточно следовать оному и не придётся ни вводить и отстаивать

Дети в шахтах в начале прошлого века наверняка старались не быть мудаками. Однако это не помогало, пока не ввели запрет на детский труд. А в Конго, говорят, и сейчас не помогает.

Извините за столь резкий пример, но ваш тезис "не будь му*м, не потребуется закон о защите прав" не верен. Он работает только в традиционных обществах (в деревне может сработать или среди знакомых).

GeMir

22.09.2018 10:06Однако это не помогало, пока не ввели запрет на детский труд.

Тобишь защита прав человека и «право» на призыв «мочить всех [категория]» на своей странице в соцсети для вас одного поля ягоды?

Hardcoin

22.09.2018 10:14У человека либо есть "право" на призыв, либо нет. Мы не обсуждаем способность, необходимость, желание или возможность. Мы обсуждаем право.

Так что если ваш вопрос — считается ли право на призыв мочить именно правом — конечно считается. Именно к категории "прав" эта штука и относится, это без сомнений. А вот должны ли мы такое право защищать или наоборот, запрещать — обсуждаемо.

В России, на мой взгляд, это запрещено намного сильнее, чем было бы разумно. Призыв мочить, на мой взгляд, разрешать не надо, а вот шутки над верующими (как и шутки над неверующими) — надо разрешить. Точнее перестать запрещать.

Wizard_of_light

22.09.2018 12:01Да ну. Во-первых, ругань в сети может оказаться для некоторых заменой реального насилия. Вчера он в чатике ругался, а сегодня чатика нет, теперь остаётся только молча

карму минусанутьтопориком тюкнуть. Во-вторых, новых плохих слов выдумают. Вон, банки с укропом ватником укрыть без задней мысли уже не получается.

robux

22.09.2018 17:061. Ограничивать в словах никого нельзя.

2. Преследовать за слова никого нельзя.

3. Если уж совсем невтерпёж детектировать «язык вражды», «язык любви», «язык няшности» (и так далее) и воспитывать «нарушителей» (поощрять ласковых), то (так и быть) хозяин сервиса может подсвечивать комментарии/посты красным/желтым/зеленым фоном с разными оттенками.

О, кстати, это идея для Хабра! :)

BiosUefi

>>Конечно нельзя отрицать, что человек имеет полное право говорить то, что он думает.

Исследовать «кислотность» фраз это правильно.

Не исследовать же то, «кислотность» того о чем говорить не принято в «приличном обществе».

«Вы можете хранить «кислотное» молчание и «кислотно» не свидетельствовать против себя. Судья добровольно примет вашу сторону, и не станет оглашать или рассматривать «кислотные» факты, причиняющие вам и ему душевную травму»(с)

domix32

Вы наверное хотели сказать «токсичность», а не «кислотность»