Хотя с момента появления первого SATA SSD прошло уже 14 лет, многие потребители и по сей день относятся к твердотельным накопителям с изрядной долей скепсиса. Главная причина недоверия — ограниченность рабочего ресурса флэш-памяти, обусловленная постепенной деградацией полупроводниковой структуры чипов, вследствие чего устройства рано или поздно теряют способность к записи и хранению информации. Подробные технические спецификации зачастую лишь усугубляют положение дел: покупателю сложно понять, TBW 500 ТБ, указанные в описании Western Digital Blue 3D NAND SATA SSD на два терабайта — это много или мало? Сколько такой диск продержится в реальных условиях работы и можно ли ему доверить наиболее ценные файлы? Давайте попробуем разобраться в этом вопросе вместе и поговорим о том, насколько надежной является современная флэш-память.

Строго говоря, ответ на «главный вопрос жизни, вселенной и всего такого» был получен еще в декабре 2014 года, когда ребята из сетевого издания TechReport завершили испытания потребительских SSD, продлившиеся в общей сложности год. На примере продукции HyperX, Corsair, Kingston и Samsung они убедительно доказали, что реальный ресурс твердотельных накопителей превышает 1 петабайт перезаписи. Подобные объемы практически немыслимы не то что для рядового пользователя, но даже для профессиональных контентмейкеров: накопитель морально устареет гораздо раньше, чем будет исчерпан его ресурс.

Однако тут есть один существенный нюанс: четыре года назад в ходу были чипы MLC NAND, способные хранить по 2 бита информации в каждой ячейке и изготавливаемые по 25-нанометровому техпроцессу. На тот момент это был хороший компромисс между сверхнадежными SLC (single-level cell) и более вместительными и недорогими TLC (triple-level cell): чипы с двухбитовыми ячейками обеспечивали приемлемую плотность хранения данных, выдерживая вплоть до 5 000 циклов записи/стирания (в среднем этот показатель достигает 3 тысяч). Чего нельзя сказать об их ближайших собратьях: при всех преимуществах, к которым следует отнести высокую емкость и дешевизну, TLC оказались куда менее выносливы, с трудом взяв планку в 1500 тысячи циклов программирования/стирания при том, что большинство планарных микросхем едва выдерживает тысячу.

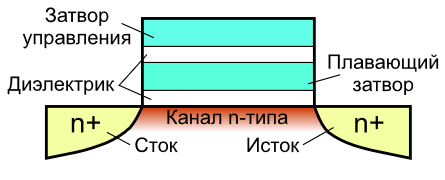

Главным виновником подобной ситуации стал переход на 15-нанометровый технологический процесс, используемый в ходе производства чипов. Чтобы понять, почему так произошло, достаточно вспомнить, как функционирует NAND-память. Кодирование битов информации происходит путем изменения заряда на плавающем затворе за счет квантового туннелирования электронов сквозь слой диэлектрика, обусловленного высокой напряженностью электрического поля.

Схема транзистора с плавающим затвором

С точки зрения физики мы имеем дело ни с чем иным, как с явлением обратимого лавинообразного пробоя. Разгоняясь в электрическом поле электроны получают достаточную кинетическую энергию для ударной ионизации молекул диэлектрика, в результате чего возникает пара элементарных частиц, несущих противоположный заряд, которые также разгоняются электрическим полем, и процесс повторяется, при этом количество носителей заряда возрастает в геометрической прогрессии (отсюда и название). Нетрудно догадаться, что подобные процессы вызывают постепенный износ диэлектрических слоев, в результате повышается вероятность утечки заряда в соседние ячейки, что, в свою очередь приводит к повреждению или даже полной утрате данных. И переход на новый техпроцесс лишь усугубляет ситуацию: уменьшение толщины диэлектрика приводит к тому, что ячейки выходят из строя значительно раньше.

Однако если бы проблема заключалась только в этом, рядовые потребители, да и корпоративные пользователи, попросту бы не заметили разницу между MLC и TLC, а в технических спецификациях к SSD мы бы видели куда более впечатляющие цифры. В реальности перед нашими глазами предстает совсем иная картина, а причиной этого является сама архитектура флэш-чипов и специфика их работы: отдельные ячейки объединяются в страницы, а страницы — в блоки, при этом запись информации возможна лишь в чистые страницы, а ее удаление осуществляется поблочно.

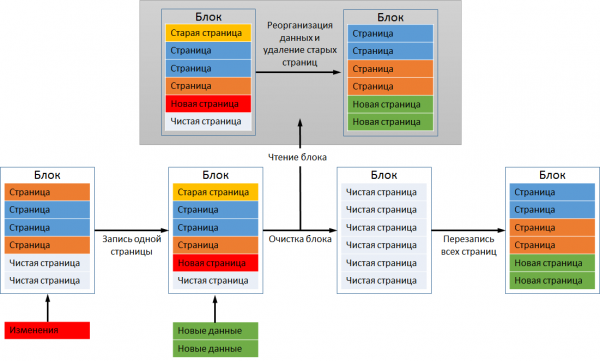

Что это означает на практике? Предположим, у нас есть частично заполненный блок и мы хотим записать в него новые данные. Если их объем меньше оставшегося свободного места, запись происходит мгновенно, без каких-либо дополнительных манипуляций. Если же места недостаточно, в дело вступают сложные многоэтапные алгоритмы. Рассмотрим ситуацию на приведенной ниже схеме.

Так происходит запись данных во флэш-память

Новые данные, которые мы хотим записать, занимают две страницы в блоке, однако реально свободна лишь одна: хотя старая страница (выделена желтым) была удалена пользователем ранее, по факту записанная информация никуда не делась. Чтобы расчистить место для новых данных, контроллер инициирует процедуру, известную, как «сборка мусора», удаляя ненужные данные и перераспределяя существующие. Для этого все страницы, за исключением ненужной, копируются во второй, свободный блок, тогда как первый полностью стирается. Затем актуальные страницы переносятся обратно в первый блок, удаляются из второго, и лишь после этого новые данные занимают свое законное место.

В приведенном выше примере ради записи двух страниц пришлось дважды полностью перезаписать 2 блока по шесть страниц каждый. На самом же деле процесс «Garbage Collection» будет выглядеть куда сложнее и, как следствие, количество циклов перезаписи окажется значительно больше. Реальную картину можно оценить только зная коэффициент усиления записи (Write Amplification), который показывает, во сколько раз фактическая нагрузка на флэш-память превышает расчетную. Данный показатель может быть равен единице лишь при записи информации на абсолютно чистый, только что отформатированный диск, во всех прочих случаях его значение будет варьироваться в пределах от 2 до 25. Причем даже у, с первого взгляда, идентичных накопителей он может значительно отличаться, так как зависит от модели используемого контроллера и особенностей микропрограммы. Таким образом отказоустойчивость SSD определяется отнюдь не только типом флэш-памяти, но и тем, насколько разработчикам удалось оптимизировать работу прослойки FTL (Flash Translation Layer).

Почему драматическое увеличение плотности хранения данных не сказалось на надежности памяти 3D NAND?

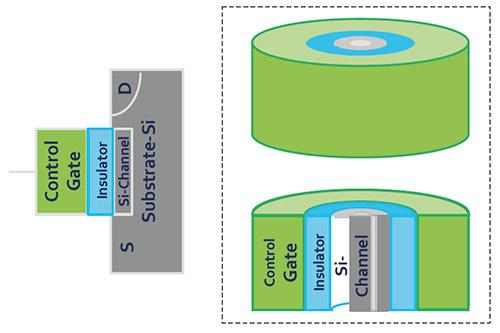

Итак, теперь мы знаем, как работает флэш-память и какие именно факторы определяют надежность SSD-накопителя. Пришло время разобраться в том, какие преимущества обеспечил переход с «плоских» чипов на трехмерные. В первую очередь, 3D NAND отличается от своих предшественников за счет использования «ловушки зарядов» (Charge Trap Flash) вместо ставших привычными плавающих затворов. Если в последних для хранения зарядов используется поликремний с допирующими добавками, то в CTF — изолированная область из непроводящего материала, в роли которого чаще всего выступает SiN — нитрид кремния. Такой подход позволил минимизировать вероятность утечки заряда и, как следствие, повысить стабильность ячеек.

Архитектура чипов трехмерной памяти также претерпела значительные изменения по сравнению с предшественником, так как теперь каждая ячейка имеет цилиндрическую структуру: внешний слой представляет собой управляющий затвор, а внутренний — изолятор. Так как теперь ячейки расположены друг над другом, они формируют стек, внутри которого проходит канал из поликристаллического кремния. Легко понять, что количество слоев в чипе определяет количество ячеек в стеке.

Устройство ячейки чипа 3D NAND

Такая структура позволила снизить интерференцию между ячейками и тем самым упростить алгоритм записи: поскольку отпала необходимость в проверке состояния заряда, запись в ячейку стала осуществляться в один шаг. Еще один важный нюанс: для производства 3D NAND используются обкатанные технологические процессы при том, что плотность упаковки ячеек удалось повысить в разы. Так, например, даже 48-слойные чипы (третье поколение трехмерной флэш-памяти) выпускались по 40-нанометровому техпроцессу. Это позволило не только повысить их надежность, но и удешевить производство, так как существующие производственные линии нуждались лишь в минимальной модернизации, а потребность в литографии в глубоком ультрафиолете полностью отпала.

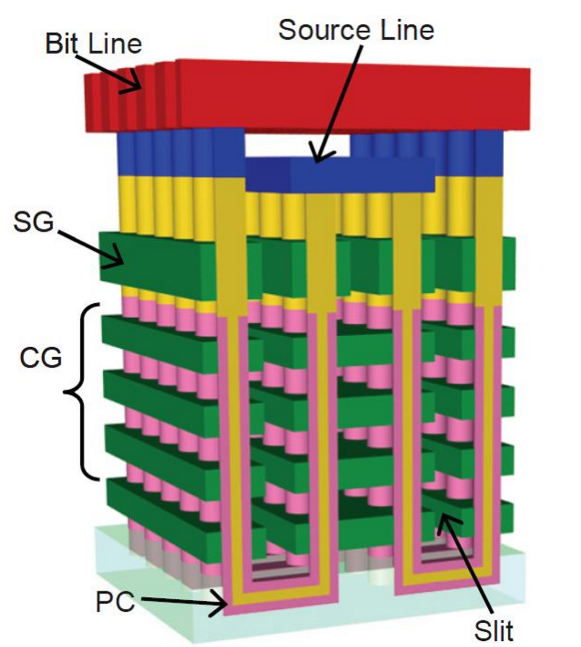

Если же говорить конкретно о продукции Western Digital, то в современных WD Black SN750 NVMe SSD, старт продаж которых стартовал 18 января 2019 года, используется 64-слойная TLC 3D NAND BiCS (Bit Cost Scalable), выполненная по 28-нанометровому техпроцессу. Помимо увеличения плотности упаковки еще в 1.4 раза (топовая модель отныне имеет емкость 2 ТБ, что вдвое превышает объем флагмана предыдущего поколения), важной особенностью микросхем данного типа является использование U-образных строк.

Архитектура 3D NAND BiCS

Поскольку теперь переключающий транзистор и линия истока располагаются в верхней части кристалла, они практически не подвергаются высокотемпературным воздействиям, которые сами по себе способны приводить к ошибкам во время операций чтения/записи, что позволило дополнительно повысить надежность твердотельных накопителей.

Как алгоритмы записи влияют на продолжительность жизни SSD?

Выше мы уже писали о том, что какой бы выносливой и защищенной ни была сама флэш-память, ее ресурс будет расходоваться впустую, если разработчики SSD не озаботились созданием эффективных алгоритмов записи. Чтобы оптимизировать данную процедуру, используются две весьма эффективные методики: SLC-кэширование и выравнивание износа (Wear Leveling).

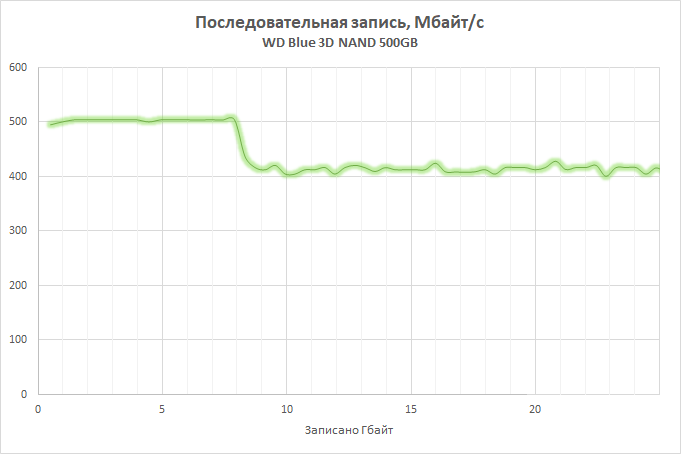

Суть первой заключается в том, что часть доступного массива памяти, размер которой зависит от общего объема накопителя (например, при разработке WD Blue 3D NAND SSD мы исходили из расчета 4 ГБ кэша на каждые 250 ГБ емкости) переводится в режим работы SLC, то есть, в каждую ячейку записывается лишь один бит информации, что позволяет как существенно увеличить ее производительность, так и снизить темпы износа. SLC задействуется в ходе записи и консолидации хранящихся на SSD данных, что позволяет не только увеличить скорость проводимых операций, но и снизить темпы износа ячеек. В актуальных версиях твердотельных накопителей Western Digital используется технология nCache 3.0, последняя версия которой обзавелась функцией direct-to-TLC, что позволило найти баланс между кэшированием и быстродействием: запись данных происходит в обход кэша при его переполнении или в тех случаях, когда использование SLC-буфера оказывается нецелесообразным. Это, с одной стороны, помогло разгрузить кэш, и в то же время избежать драматического падения производительности при его заполнении.

Динамика скорости записи на SSD при заполнении SLC-буфера

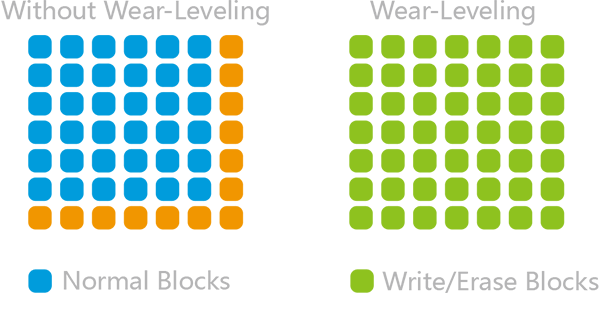

Что же касается технологии выравнивания износа, то она способствует тому, чтобы все имеющиеся блоки страниц задействовались как можно более равномерно. Как известно, любая операционная система использует логический механизм адресации блоков данных (LBA), тогда как сам контроллер оперирует уже физическими адресами (PBA), соотнося их с логическими. Вследствие этого не имеет никакого значения, где на самом деле расположены фрагменты файлов, за счет чего можно написать микропрограмму, которая будет следить за тем, чтобы нагрузка между ячейками распределялась равномерно.

Выравнивание износа обеспечивает равномерность нагрузки на ячейки

В общем случае ее алгоритм выглядит следующим образом. Вы купили новенький SSD и пока на нем есть свободное место, информация будет записываться в свободные блоки. По мере эксплуатации вы начинаете удалять ненужные файлы, и механизм сборки мусора осуществляет их очистку в фоновом режиме, однако для записи они будут использоваться лишь после того, как на диске не останется ни одного блока, в который хотя бы раз не были бы записаны данные. Конечно же, в реальности все намного сложнее, но смысл не меняется.

И здесь следует сделать еще одно важное примечание, касающееся продукции Western Digital. Когда мы приняли решение осваивать рынок SSD, то могли пойти двумя путями: закупать память и контроллеры у сторонних производителей, сосредоточившись лишь на разработке и оптимизации микропрограмм, либо наладить производство полного цикла. Запускать подобный проект с нуля было бы нецелесообразным, и даже покупка SanDisk влетела нам в копеечку. Но вложенные средства отбились сполна: контролируя производство чипов, мы получили возможность адаптировать микропрограммы под особенности микросхем.

Следует понимать, что запись битов информации в ячейки флэш-памяти — гораздо более сложный процесс, чем может показаться с первого взгляда: в нем учитываются сотни разнообразных параметров, важнейшими из которых являются напряжение, необходимое для переноса заряда, и время записи. По мере износа чипов меняются и их физические характеристики: для успешной записи данных требуется уже меньшее напряжение, вместе с тем сокращается и необходимое время его воздействия на ячейку. В большинстве твердотельных накопителей эти параметры постоянны, но в SSD Western Digital они, напротив, динамически изменяются по мере износа ячеек, что позволяет максимально продлить срок службы каждой из них, минимизируя негативное воздействие на полупроводниковые структуры.

QLC 3D NAND — флэш-память последнего поколения

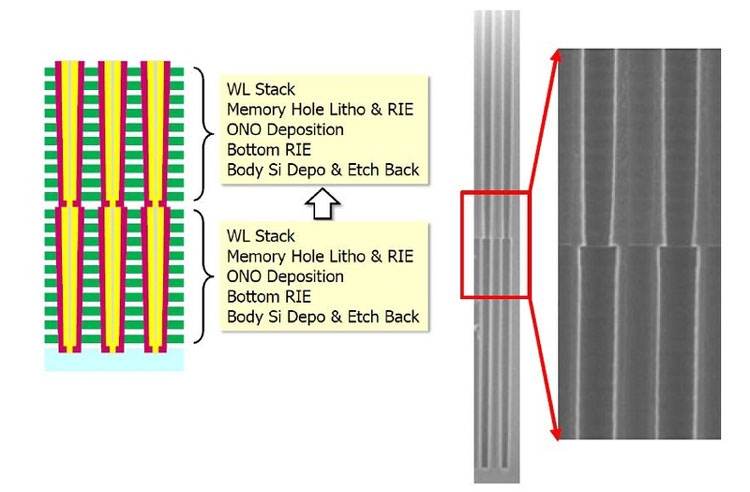

Если вы следите за новостями из мира высоких технологий, то наверняка в курсе, что Western Digital активно осваивает производство трехмерной памяти следующего поколения — QLC 3D NAND (первый анонс состоялся еще в июне 2018 года). Аббревиатура QLC расшифровывается, как quad-level cell. Иными словами, в одной ячейке могут храниться 16 уровней заряда, кодирующих уже не три, а четыре бита информации. По сравнению с TLC 3D NAND, плотность записи в QLC увеличилась на 33%: таким образом, емкость одного 64-слойного чипа возросла до 768 Гбит. Но и это не предел: в августе 2018 года мы начали выпуск 96-слойных микросхем. За счет увеличения количества слоев нам удалось получить 50-процентный прирост емкости и преодолеть барьер в 1 Тбит: новые чипы, получившие название 3D NAND BiCS4 способны вмещать 1.33 Тбит информации, что составляет около 166 ГБ. Добиться столь высокой плотности хранения данных удалось путем объединения двух 48-слойных кристаллов (на сегодняшний день именно такой подход является наиболее экономически оправданным).

Объединение двух 48-слойных чипов в один 96-слойный

Возросшая емкость потенциально способна снизить производительность SSD, однако на этот счет переживать не стоит: в новой флэш-памяти 3D NAND BiCS4 вместо двух физических массивов используется четыре, что позволяет оптимизировать чтение и запись данных за счет распараллеливания операций, а это, в свою очередь, поможет более эффективно использовать кэш и контролировать уровень износа ячеек, сохранив рабочий ресурс QLC-чипов на уровне, сопоставимом с современными TLC-решениями. Впрочем, описание технологий, лежащих в основе QLC, выходит за рамки данного материала и, безусловно, заслуживает отдельной статьи.

Комментарии (40)

bzzz00

31.01.2019 19:25это все здорово, но вот недавно взял wd green m.2 на 120GB и этот бюджетный господин регулярно портил мне данные где-то в первых 256MB, где лежат файлы GRUB2. поэтому часто обычная перезагрузка заканчивалась необходимостью вручную восстанавливать GRUB2. замечу, что до этого девайса стоял старенький OCZ (ssd, SATA) и с ним не было ни одной проблемы. теперь поставил недорогой m.2 от intel на 128GB. две недели — полет нормальный.

zeronice

31.01.2019 19:38в запасах около трех десятков компов с 120ми этих гринов, вроде как полет нормальный (Win10, офисное ненапряжное использование)

bzzz00

31.01.2019 19:40тем не менее. девайс был куплен в конце декабря, нагрузка очень щадящяя — просто крутится несколько виртуалок, все их образы/storage лежат в tmpfs.

zeronice

31.01.2019 20:03Один раз в год и палка стреляет. Не повезло вам с экземпляром. Но к сведению приму и попробую потестировать нагрузки на свободном железе.

Если не сложно, расскажите о вашем сетапе.

bzzz00

31.01.2019 20:08а как раз вся фишка в том что порча происходила в разделе /boot размером ~300MB. по определению в этот раздел запись идет только при обновлении ядра (FC28 — раз в 1-2 недели). на остальных разделах, в частности /home, где тестовые сборки ядра и продукта по много раз в день происходят, ничего такого замечено не было. файловая система ext4.

под конец даже сделал /boot read-only, но и это не помогало.

ps. про экземпляр спорить не буду, все может так быть. но вот находил тему: community.wd.com/t/silent-data-corruption-on-green-ssd-wds120g2g0a-00jh30-with-linux/229202

alexkuzko

31.01.2019 20:48А это случайно не та проблема когда данные на SSD теряются если их постоянно не перезаписывать? Только излишне гипертрофированная в вашем случае…

EmmGold

31.01.2019 22:46При работающем устройстве этим должен заниматься контроллер. Очень, очень, очень ниже файловой системы. Потеря данных происходит в выключенном состоянии, и тем быстрее, чем выше износ памяти.

Да и, «первые» 256 МБ могут находиться где угодно физически, на любой микросхеме в любом месте.

amarao

31.01.2019 19:30Это не совсем тот вопрос, на который я хотел бы услышать ответ. Если я запишу на HDD файлы и положу его на полочку, я более чем уверен, что через 10-15 лет я его могу прочитать (имея соотв. переходник).

А вот с SSD я не уверен. Мало того, что ограничено число циклов чтения-записи, так ещё и срок хранения между перезаписями ограничен, что, помноженное на число перезаписей, даёт нам максимальный теоретический срок хранения информации.

… И у меня есть некоторые сомнения, что этот срок такой уж большой.

springimport

31.01.2019 22:56Так и есть, не пойму только что вас удивляет. Где много данных и нужно их хранение там давно hdd, а где скорость но без .9999 в надежности — ssd.

djiggalag

01.02.2019 06:15Где много данных и нужно их хранение там давно hdd

Не совсем так, где по настоящему нужно сохранить много данных и надолго используют плёнку по старинке, с новыми технологиями записи, плотность хранения там космическая. Так-же есть ещё перспективные кремневые диски, которые вообще почти неубиваемы.

Siemargl

31.01.2019 23:42Если я запишу на HDD файлы и положу его на полочку, я более чем уверен, что через 10-15 лет я его могу прочитать (имея соотв. переходник).

Немного самонадеянно.

Без прокрутки, подшипники шпинделя застывают(засыхают) и по нарастающей — не та скорость вращения…

Как и автомобиль, ХДД должен иногда работать.

vesper-bot

01.02.2019 11:25А вот и не сможете, либо прочтете с частичными потерями. Даже HDD подвержены такой шняге, как bit rot (утечки заряда/магнитного поля), который тем больше, чем меньше элемент данных на наинизшем уровне. Старые харды могут ещё не быть подвержены этим проблемам, ЕМНИП (и логика подсказывает) шанс испортить бит при хранении за фиксированное время прямо пропорционален объему данных и обратно пропорционален площади элемента данных, для старых техпроцессов он уменьшается чуть ли не в четвертой степени от техпроцесса, и квадратично от емкости.

EmmGold

31.01.2019 22:40Это всё безумно интересно, но хотелось бы почитать про контроллеры памяти. Очень часто наблюдаю проблемы именно в контроллере памяти нежели в самой памяти.

WesternDigital Автор

02.02.2019 00:11Особенности функционирования контроллеров памяти — информация достаточно закрытая. О чем именно Вы бы хотели узнать?

EmmGold

02.02.2019 22:18Интересуюсь с потребительской точки зрения. Какие существуют, как выбрать то, что мне нужно. На что обратить внимание. Почему зачастую умирает контроллер, а не память, и как этого избежать при выборе накопителя. Найти баланс между скоростью, надёжностью и ёмкостью.

Diordna

01.02.2019 02:25Цены наверно космические?!

WesternDigital Автор

01.02.2019 23:58Рекомендованные цены на накопители линейки WD Black SN750 NVMe SSD варьируются от 80 до 500 долларов США в зависимости от объема.

AlterMax

01.02.2019 09:11Давно интересует вот такой вопрос — большинство SSD дисков, после выхода из строя банально перестают определяться, либо определяются как носители малого объема(~100MB). Такое поведение понятно, если смерть накопителя связана с выходом из строя например контроллера. При достижении порога износа самой памяти, было бы логично ожидать просто перехода диска в read-only режим, однако в реальности такое встречается очень редко. Почему? Или же действительно в большинстве случаев выход из строя связан прежде всего с контроллером?

vesper-bot

01.02.2019 11:28ИМХО он метаданные тоже в флэш-памяти хранит, как следствие, при их потере или проблемах перезаписи он не может нормально инициализироваться. Детали покрыты мраком (реализация у каждого своя).

AlterMax

01.02.2019 11:46Такая инфа обычно как минимум дублируется. Перезапись в режиме read-only — не совсем понятно зачем, начальная инициализация врядли требует перезаписи…

В целом вот что непонятно — более-менее гарантированный переход в режим read-only по окончании ресурса, очень выгодно смотрелся бы с точки зрения сохранения пользовательских данных. Маркетинг бы кричал о таком преимуществе на каждом углу (что собственно и наблюдалось на заре появления SSD). Но все будто забыли об этом, хотелось бы понять — почему?

vesper-bot

01.02.2019 18:35Вроде как Intel Optane какой-то подвид так сделал, но ресурс заявил какой-то смехотворный (300 что ли циклов перезаписи). Его и послали в пользу самсунгов с 5000 и без внезапных отключений.

Начальная инициализация вроде бы не требует, но может потереться по другим причинам (влияние соседних ячеек, пробой, тепловой дрейф зарядов и ещё неизвестно что). А SSD при работе вроде бы нехило так греются.

safari2012

01.02.2019 16:50Поскольку теперь переключающий транзистор и линия истока располагаются в верхней части кристалла, они практически не подвергаются высокотемпературным воздействиям, которые сами по себе способны приводить к ошибкам во время операций чтения/записи, что позволило дополнительно повысить надежность твердотельных накопителей.

эээ… разве тепло со всего бутерброда не будет стремиться вверх?

Danik-ik

01.02.2019 18:33Оно таки, допустим, туда будет стремиться, но почему? Потому, что с этой стороны фактическое охлаждение, и температура НИЖЕ. Тепло — оно такое, предпочитает течь вниз (в смысле градиента температуры).

А конвекции там нет (это специальное дополнение для рассуждающий в пределах бытовых стереотипов). И не факт, что "верх" реально сверху.

CaptainFlint

01.02.2019 17:05драматическое увеличение плотности

избежать драматического падения производительности

Почитайте, пожалуйста, про ложных друзей переводчика, и перестаньте переводить dramatic как «драматический». А то так и представляется театральная сцена, где герой с надрывом декламирует трагическую поэму о падении производительности.

WesternDigital Автор

02.02.2019 00:08+1Слово «драматический» достаточно часто используется в русском языке в значении «значительный», «резкий», в том числе и в научной литературе.

CaptainFlint

02.02.2019 11:50-1Оно начало так использоваться лишь недавно, и как раз под влиянием таких некачественных переводов («все так пишут, значит, так и надо, так модно, вот и я тоже буду»).

WesternDigital Автор

03.02.2019 01:57Спорное утверждение. Google Books подсказывает, что слово «драматический» в вышеуказанных значениях используется в русском языке уже более 40 лет: как минимум, с 70-х годов XX века, причем отнюдь не только в переводных трудах. Учитывая, что библиотека Google не является всеобъемлющей, уверен, можно отыскать и более ранние источники.

CaptainFlint

03.02.2019 03:09Разумеется, всегда можно найти любое неправильное употребление любого слова, неграмотных людей во все времена хватало. Если обосновывать употребление слова/фразы лишь тем, что его можно найти в каких-то книгах, то так можно немеряную тучу ошибок автоматом признать соответствующими языковым нормам.

В словарях же (по крайней мере в тех, что мне удалось найти) на текущий момент зафиксированы только те значения, о которых говорил я. Например, Большой толковый словарь:

ДРАМАТИЧЕСКИЙ, -ая, -ое.

В других то же самое, ни словечка про «значительный».

1. к Драма. Д. театр. Д-ое искусство. Д. талант. Д. кружок (кружок театральной самодеятельности).

2. Рассчитанный на эффект; напыщенный. Д-ая пауза.

3. Напряжённый, мучительный, тяжёлый, полный драматизма. Д-ое объяснение. Д-ая судьба. Самый д. период жизни.

4. Сильный, более низкий и яркий по тембру, более мужественный, чем лирический (о голосе певца, певицы). Д. тенор. Д-ое сопрано.

Sartor

01.02.2019 23:37Вот вы написали про кол-во перезаписей для MLC, потом сказали, что для TLC оно упало, но не сильно. Потом чудо пришло — 3д ячейки и супер плотность. А где всё-таки реальная цифра, сколько такие ячейки выдерживают перезаписей? Я вижу только одни костыли (которые называются крутыми технологиями), чтобы всячески выровнять износ накопителя. Так что цифры в студию.

zeronice

С некоторых пор доверяю только двум лентам в разных помещениях. А SSD, HDD и прочие постоянно подключенные приводы — только расходник

amarao

В Mr. Robot хорошо поиздевались над любителями ленты в разных ДЦ.

Если серьёзно, то бэкапы надо хранить на разных носителях. Оптический (DVD-R), магнитный (лента), электростатический (SSD/SD), плюс онлайн-бэкапы.

zeronice

dat-72 10летней давности, валяющиеся в шкафу читаются до сих пор норм ( не я их писал) и LTO3 списанные три года назад (первые тоже примерно 10 лет назад записаны) тоже норм.

Серьезно, да, данные в двух местах в горячем виде (HDD+SSD), плюс ленты (совсем серьезные данные, небольшой банк).

Лично я перестал доверять постоянным приводам исходя из своей карьеры — начинал инженером по ремонту, насмотрелся на гиблые hdd(с фуджиков MPG, примерно. были в руках позже винты с мухой ЦЦ, не был специалистом по данным, ремонтил в меру сил типичные проблемы), затем уже флешки, погибшие SSD уже застал как пользователь(личные) и наблюдатель.

В целом, когда бэкап построен по принципу "горячий бэкап в той же системе, что и прод + винт где-то на полке" были личные примеры, когда бэкап с полки руинили единомометно только потому что, прилетел импульс с питания или потому что случайно форматнули носитель. Лента этого недостатка практически лишена.

ClearAirTurbulence

Так же, как и отключенный жесткий диск.