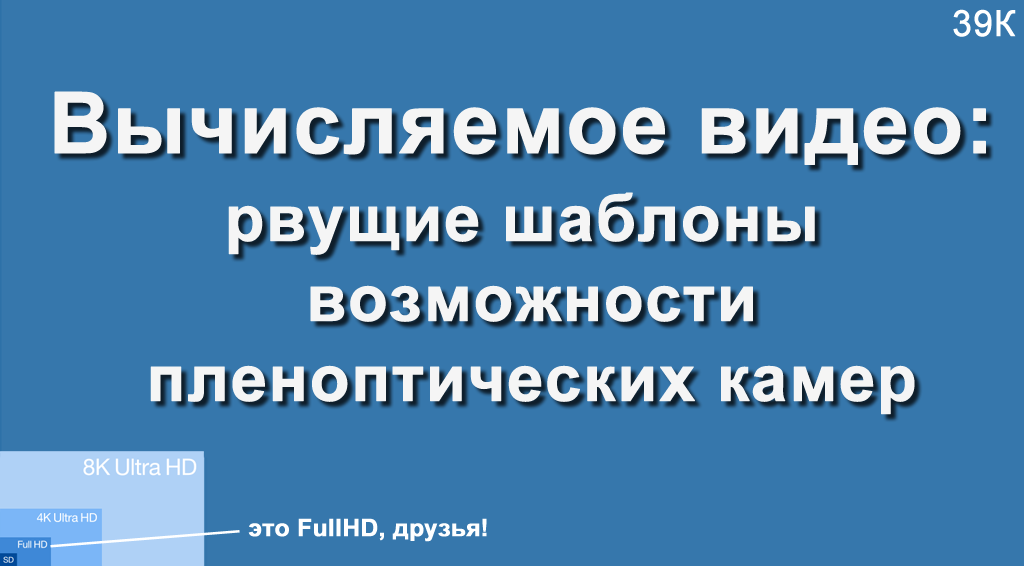

Какое-то время назад автору довелось читать лекцию во ВГИК, и в аудитории было много людей с операторского факультета. Аудитории был задан вопрос: «С каким максимальным разрешением вы снимали?», и дальше выяснилось, что примерно треть снимала 4К или 8 мегапикселей, остальные — не более 2К или 2 мегапикселя. Это был вызов! Мне предстояло рассказать про камеру с разрешением 755 мегапикселей (raw разрешением, если быть точным, поскольку конечное у нее 4К) и какие феерические возможности это дает для профессиональной съемки.

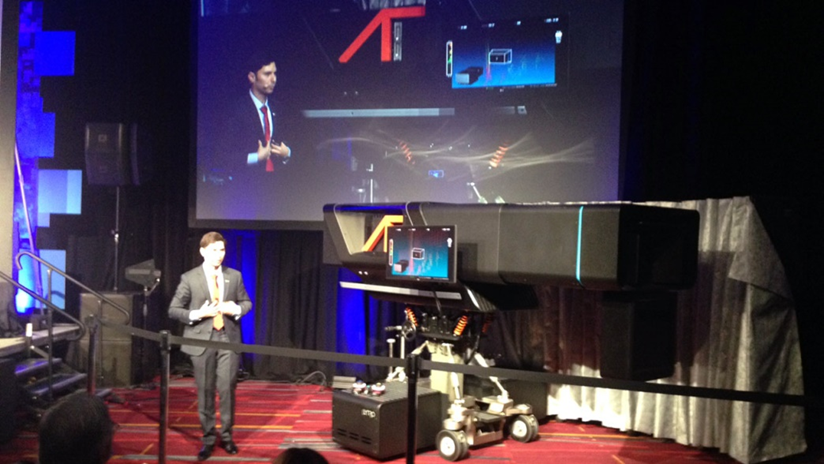

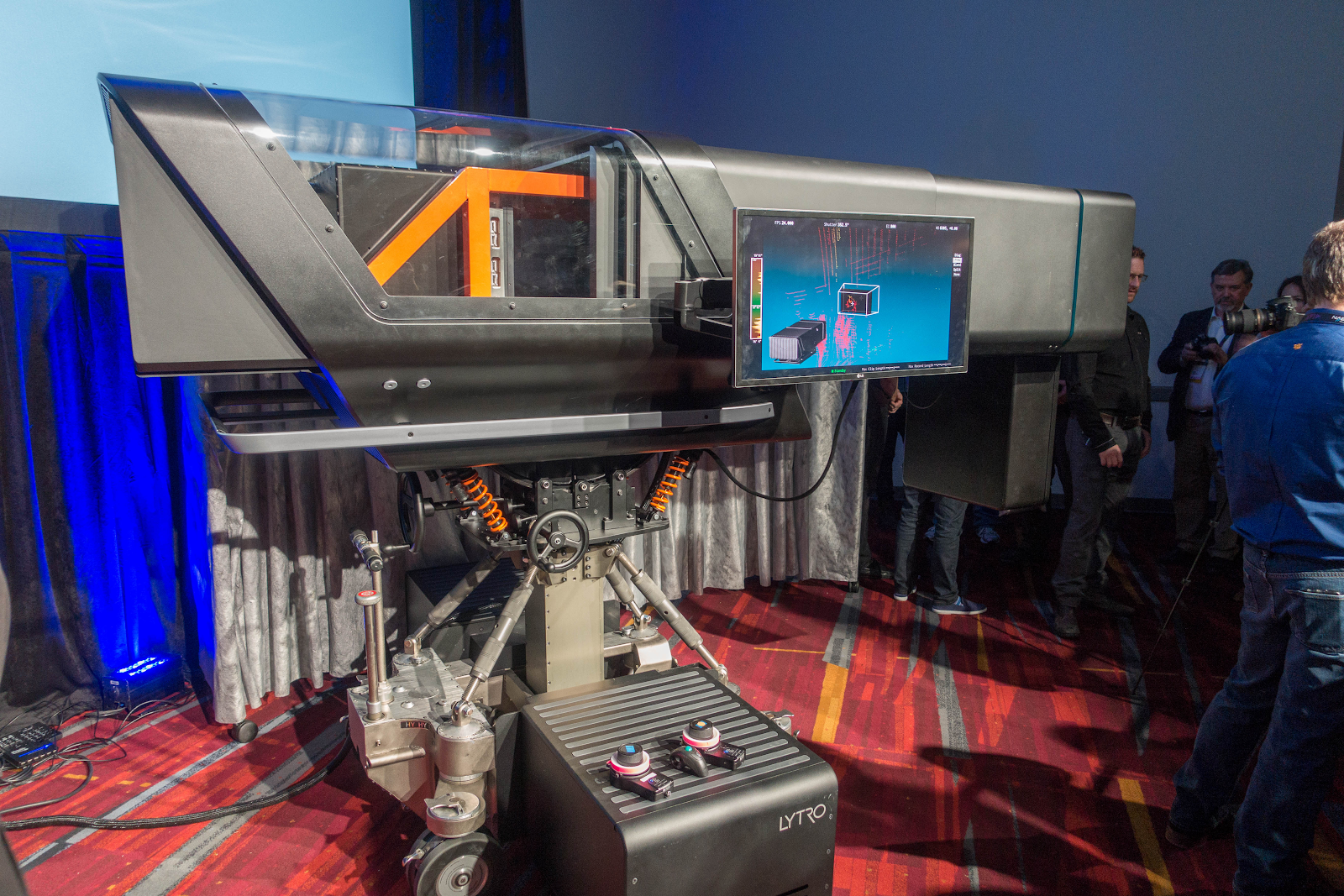

Сама камера выглядит так (этакий маленький слоник):

Причем, открою страшную тайну, чтобы сделать этот снимок искали ракурс получше и человека покрупнее. Мне доводилось щупать эту камеру вживую, скажу, что она выглядит намного крупнее. Снимок ниже с Йоном Карафином, с которым мы примерно одного роста, более точно передает масштабы бедствия:

Кому интересны принципиально возможности вычисляемого видео о которых редко пишут — вся правда под катом! )

Дискуссии на тему возможностей пленоптики напоминают мне дискуссии касательно первых самолетов:

Что говорили люди:

— Оно требует больших затрат...

— ДА!

— Оно совершенно непрактично и сейчас не окупается…

— ДА!

— Оно опасно в использовании…

— Черт возьми, ДА!

— Оно убого выглядит!

— Блин, ДА, но оно ЛЕТАЕТ, понимаете, ЛЕ-ТА-ЕТ!!!

Через 50 лет эти эксперименты породили принципиально новый, удобный и достаточно безопасный способ перемещения через океаны (и не только).

Здесь та же ситуация. Абсолютно та же! Сейчас оно требует неразумных затрат, чертовски неудобно в использовании и убого выглядит, но оно реально УЖЕ ЛЕТАЕТ! И осознавать принципы и открывающиеся перспективы — это просто запредельно вдохновляет (по крайней мере вашего покорного слугу)!

Монстр на фото выше чем-то напоминает первые телекамеры, которые также были крупными, с огромным объективом, и вращались на специальной станине:

Источник: Телесъемка олимпиады в 1936 году на самой заре телевидения

Здесь многое выглядит похоже, тоже огромный объектив (ибо также не хватает света), тяжеленная камера на специальном подвесе, огромные размеры:

Источник: Lytro poised to forever change filmmaking

Из интересного: «чемоданчик» внизу — это система жидкостного охлаждения, при отказе которой камера не может снимать дальше.

Большой прямоугольник под объективом (хорошо виден на первом фото выше) — это не подсветка, а лидар — лазерный дальномер, обеспечивающий съемку трехмерной сцены перед камерой.

Толстый черный жгут внизу слева на заднем плане — это моток оптоволоконных кабелей примерно 4 сантиметра диаметром, по которым камера отдает чудовищный поток информации в специальное хранилище.

Те, кто в теме, уже узнали Lytro Cinema, коих было создано 3 штуки. Первую, которая обычно фигурирует на всех снимках, легко узнать по одному лидару под объективом. Через 1.5 года была создана вторая камера с исправленными конструктивными проблемами первой и двумя лидарами (и о ней, увы, почти не пишут). Причем прогресс в развитии, например, лидаров за 1.5 года был настолько велик, что два лидара второй камеры давали в 10 раз больше точек, чем один лидар первой. Третья камера должна была обладать примерно теми же характеристиками по разрешению (чтобы удовлетворять требованиям киношников), но быть вдвое меньшего размера (что критично для практического использования). Но… но об этом дальше.

В любом случае всячески признавая выдающуюся роль, которую компания Lytro сыграла в популяризации технологии пленоптической съемки, хотелось бы заметить, что свет клином на ней не сошелся. Подобную камеру делали в институте Фраунгофера, благополучно существует производитель пленоптических камер компания Raytrix, опять же мне не давали фотографировать Lytro Cinema, поскольку очень опасались аж нескольких китайских компаний, которые активно работали в этом направлении (свежей информации по ним найти не удалось).

Поэтому давайте по пунктам распишем все плюсы, которые дает пленоптика, и о которых почти не пишут. Но именно из-за которых ее гарантированно ждет успех.

Вместо введения

Только на Хабре и только Lytro упоминается примерно на 300 страницах, поэтому будем кратки.

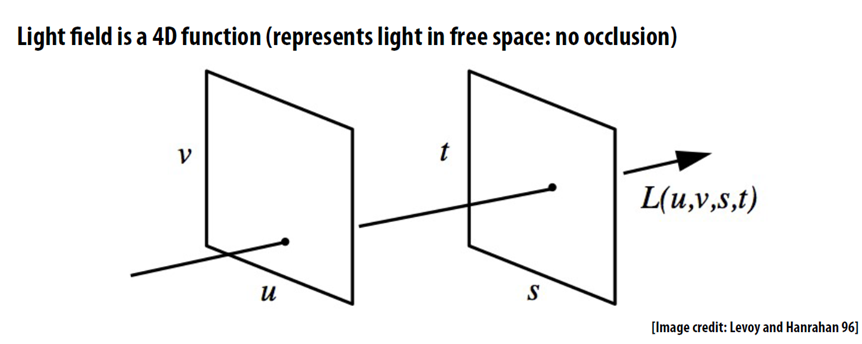

Ключевое понятие для пленоптической съемки — это световое поле, то есть мы в каждой точке фиксируем не цвет пикселя, а двумерную матрицу пикселей, превращая жалкий двумерный кадр в нормальный четырехмерный (обычно пока с очень небольшим разрешением по t и s):

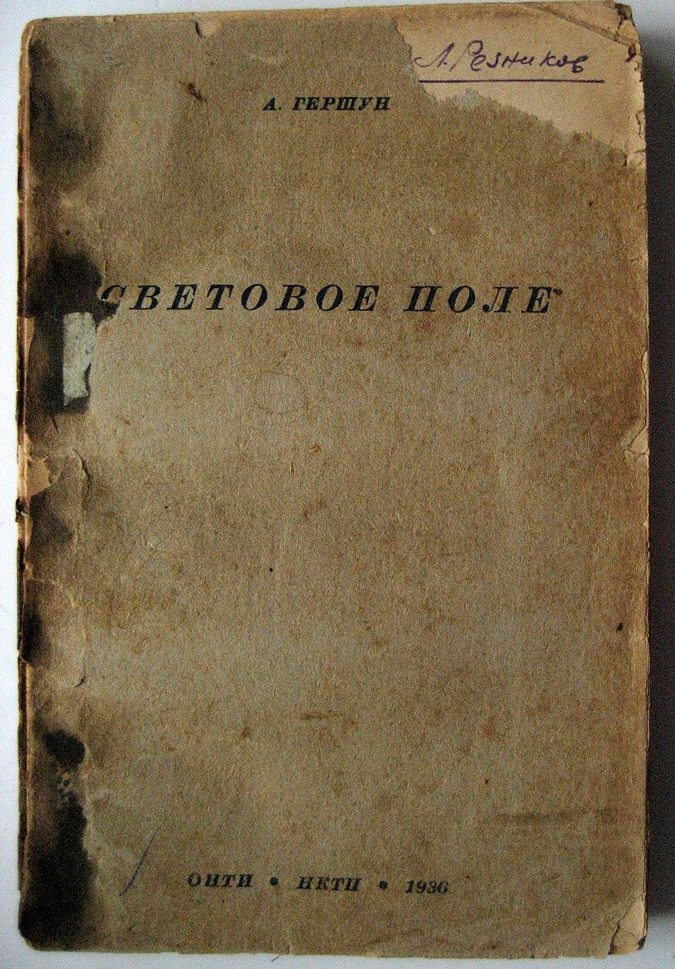

В английской википедии, а потом и в русской в статьях про световое поле сказано, что «Фраза «световое поле» была использована Гершуном А. А. в… 1936 году». Справедливости ради заметим, что это была не

И даже в то время эти работы носили вполне прикладной характер и автор 6 лет спустя в разгар войны в 1942 году получил Сталинскую премию второй степени за метод светомаскировки.

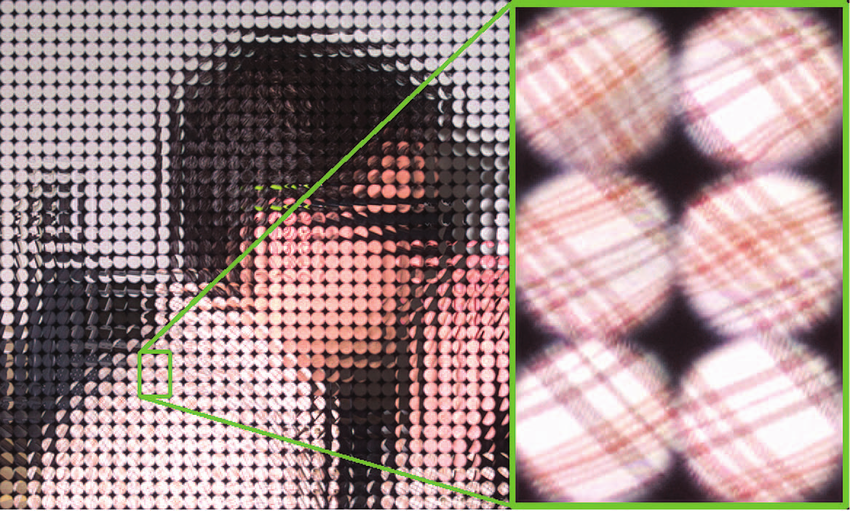

На практике, съемку четырехмерного кадра светового поля обеспечивает массив микролинз, расположенный перед сенсором камеры:

Источник: plenoptic.infо (можно кликнуть и посмотреть в полном разрешении)

Собственно именно благодаря тому, что у нас массив микролинз с небольшим расстоянием между ними и появилась возможность создать Lytro Cinema, сенсор которой был собран из массива сенсоров, границы которых приходятся на границу линз. Жидкостное охлаждение потребовалось собственно для охлаждения сильно нагревающегося массива.

Источник: Using Focused Plenoptic Cameras for Rich Image Capture

В итоге получаем, самую известную возможность пленоптических камер, о которой только ленивый не написал — менять дистанцию фокусировки уже после того, как сделан кадр (эти милые птички не стали бы ждать наведения резкости):

Источник: ныне почивший сайт Lytro

А о том, как пленоптика выглядит в разрешении, пригодном для кино, уже писали мало (открывается по клику):

Источник: Watch Lytro Change Cinematography Forever

Открываю очередную тайну: вычисляемый фокус — это вершина айсберга пленоптики. И оставшиеся ниже уровня интереса журналистов 90% возможностей на мой взгляд даже более интересны. Многие из них достойны отдельных статей, но давайте по крайней мере исправим несправедливость и хотя бы назовем их. Поехали!

Вычисляемая форма диафрагмы

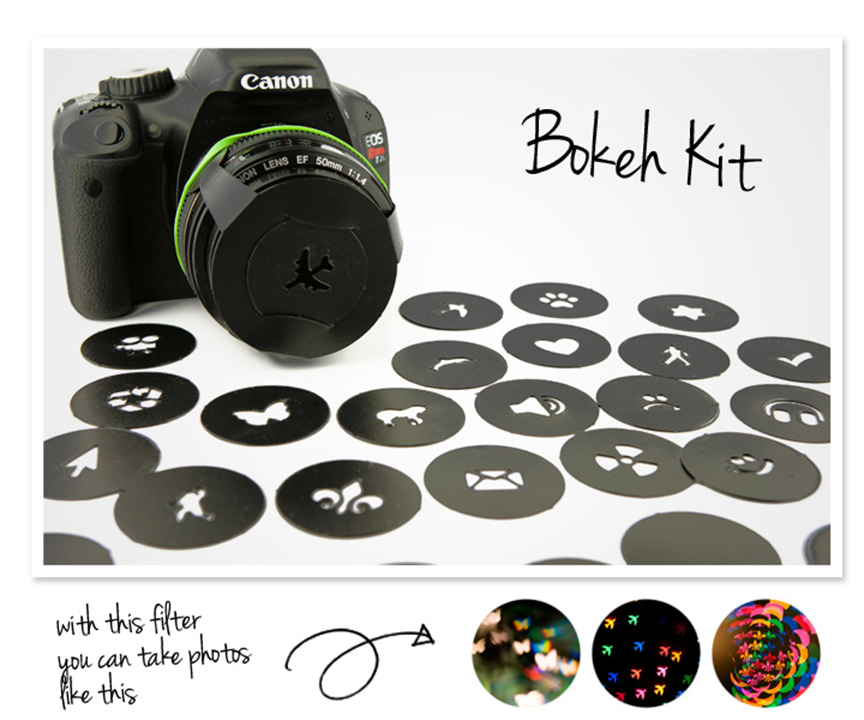

Раз уж мы заговорили про расфокус, стоит упомянуть так называемый эффект боке, при котором блики имеют необязательно круглую форму

Для фотографов выпускаются так называемые Bokeh Kit, которые позволяют получить блики разной формы:

Это позволяет получить довольно красивые картинки, и на фото ниже хорошо видно, что отблески в виде сердечек имеют даже камни на переднем плане, только сердечки меньше. И понятно, что попытаться размыть натурально подобным образом в Photoshop крайне сложно, как минимум желательно использовать карту глубины:

При этом для пленоптики «вычислить» разную диафрагму — это относительно легко решаемая задача:

Итак! Вычислили дистанцию фокусировки, вычислили форму диафрагмы, пошли дальше, там интереснее!

Вычисляемое стерео

Очень полезной возможностью пленоптического сенсора, про которую практически никто не упоминает, но которая уже дает ему вторую жизнь, является возможность вычислять изображение с разных точек. Местоположение точки определяется фактически размером объектива. Если объектив мал — кадр может немного сдвигаться вправо-влево, как на этом примере (что это стерео-фото видно, если смотреть на грудь ближней птицы):

Источник: ныне почивший сайт Lytro

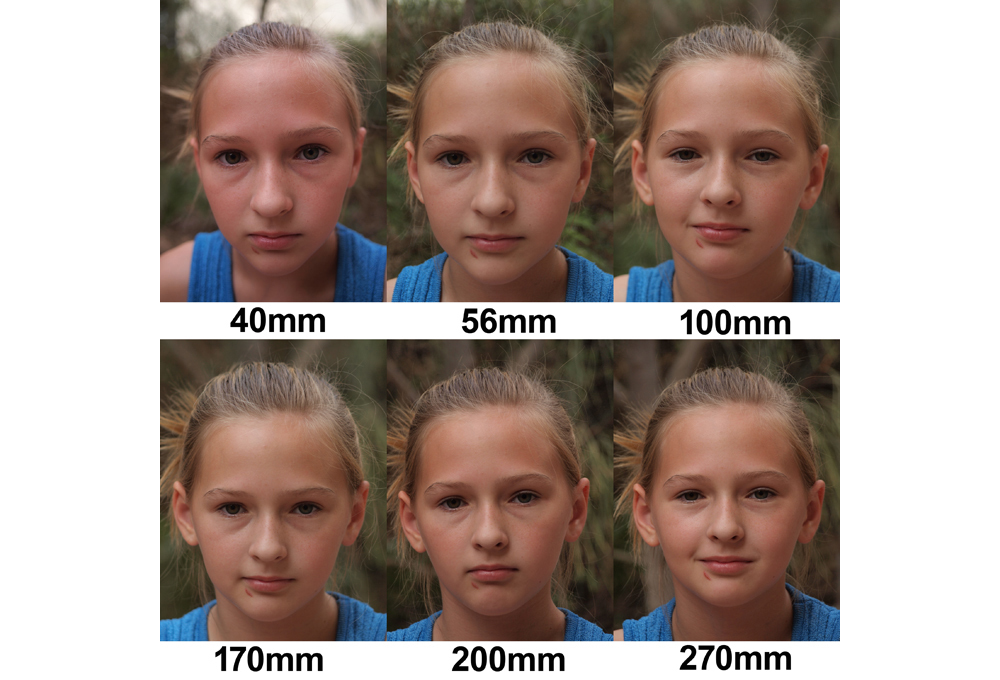

Если объектив большой, как, например, у Lytro Cinema, то точка съемки может сдвигаться на 10 сантиметров. Напомню, между глазами у нас примерно 6.5 сантиметров, то есть с максимальным расстоянием в 10 см. можно снимать и общий план (и он будет «трехмерней», чем если смотреть глазами), и крупный план (с любым параллаксом без дискомфорта). Фактически это означает, что мы можем снимать полноценное стереовидео с одним объективом. Более того, это будет не просто стерео, а стерео с идеальным качеством и, что сегодня звучит как фантастика — с изменяемым расстоянием между оптическими осями виртуальных камер ПОСЛЕ съемки. И то, и другое — совершенно немыслимые возможности, которые могут кардинально поменять ситуацию со съемкой стерео в будущем.

Поскольку будущее так или иначе за трехмерной съемкой, остановимся на этих двух моментах поподробнее. Не секрет, что сегодня большая часть 3D фильмов, особенно блокбастеры, не снимаются, а конвертируются в 3D. Делается это потому, что при съемке возникает длинный список проблем (ниже часть списка):

- Кадры могут быть повернуты, сдвинуты по вертикали или увеличены один относительно другого (не надо говорить, что это легко исправляется, посмотрите, насколько часто подобные кадры попадают в релизы фильмов — это тихий ужас… и головная боль). Так вот — пленоптическое стерео ИДЕАЛЬНО выровнено, даже если оператор решил приблизить план (в силу особенностей механики в двух камерах крайне сложно сделать приближение строго синхронно).

- Кадры могут отличаться по цвету, особенно если для съемки нужно небольшое расстояние между оптическими осями камер и приходится использовать бим-сплиттер (об этом был подробный пост). Получается, что в ситуации, когда при съемке любого бликующего объекта (автомобиля на заднем плане в солнечный день) мы обречены на развлечения на post-production с подавляющим большинством камер, с пленоптической у нас будет ИДЕАЛЬНАЯ картинка с любыми бликами. Это праздник!

- Кадры могут различаться по резкости — опять таки, ощутимая проблема у бим-сплиттеров, которая полностью отсутствует у пленоптики. С какой надо резкостью, с такой и посчитаем, абсолютно ИДЕАЛЬНО по ракурсам.

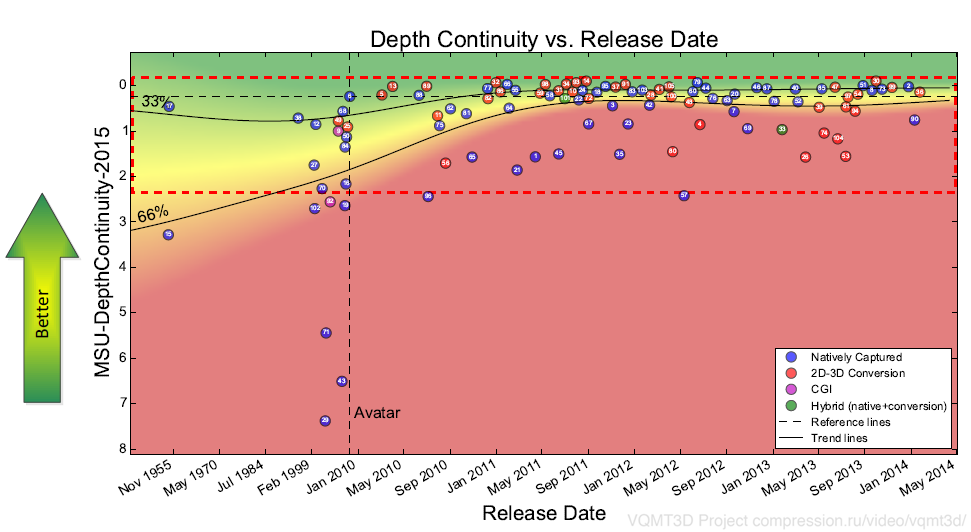

- Кадры могут уплывать по времени. Коллеги, работавшие с материалом «Сталинграда», рассказывали про расхождение таймстемпов дорожек на 4 кадра из-за чего все еще актуальна хлопушка. Мы обнаружили больше 500 сцен с расхождением по времени в 105 фильмах. Расхождение по времени, к сожалению, сложно детектируется, особенно на сценах с быстрым движением, и при этом является наиболее болезненным артефактом по нашим замерам. В случае пленоптики у нас будет ИДЕАЛЬНАЯ синхронизация по времени.

- Отдельная головная боль при съемке 3D — слишком большие параллаксы, которые причиняют дискомфорт при просмотре на большом экране, когда ваши глаза могут расходиться в стороны для объектов, находящихся «дальше бесконечности», или слишком сходиться для некоторых объектов переднего плана. Правильный расчет параллакса — отдельная непростая тема, которой должны хорошо владеть операторы, и случайно попавший в кадр объект может испортить дубль, сделав его дискомфортным. С пленоптикой мы сами выбираем параллакс уже ПОСЛЕ съемки, поэтому любая сцена может быть рассчитана с ИДЕАЛЬНЫМ параллаксом, более того — одна и та же уже снятая сцена может быть без особых проблем рассчитана под экраны большого размера и под экраны маленького размера. Это так называемое изменение параллакса, которое обычно крайне сложно и дорого делать без потерь качества, особенно если у вас были полупрозрачные объекты или границы на переднем плане.

В общем, возможность ВЫЧИСЛИТЬ идеальное стерео — это реальная основа для следующей волны популярности 3D, благо за последние 100 лет выделяют 5 таких волн. И, судя по прогрессу в лазерной проекции и пленоптике, максимум в течении 10 лет (когда закончатся основные патенты Lytro или чуть раньше в Китае) нас ожидают новое железо и новый уровень качества 3D фильмов.

Итак! Идеальное вычисляемое стерео с одного объектива (вещь невозможная для большинства, кстати) получили. И не просто получили, но и параллакс пересчитали постфактум, даже если на переднем плане объект не в фокусе. Идем глубже!

Вычисляемая точка съемки

У изменения точки съемки есть применение и в обычном 2D видео.

Если вы бывали на съемочной площадке или хотя бы видели фотографии, то наверняка обращали внимание на рельсы, по которым ездит камера. Часто для одной сцены нужно проложить их в нескольких направлениях, на что уходит заметное время. Рельсы обеспечивают плавность хода камеры. Да, безусловно, существует стедикам, но во многих случаях у рельсов, увы, нет альтернативы.

Возможность менять точку съемки в Lytro использовали, чтобы продемонстрировать — колес достаточно. Фактически при движении камеры у нас образуется виртуальная «труба» диаметром 10 см в пространстве, в пределах которой мы можем изменять точку съемки. И эта труба позволяет компенсировать небольшие колебания. Хорошо это показано на этом видео:

Более того, иногда нужно решить обратную задачу, то есть добавить колебания во время движения. Например, не хватало динамики и режиссер решил сделать взрыв. Наложить звук — недолго, но камеру желательно синхронно тряхнуть, причем лучше не просто плоско сдвинуть картинку — это будет видно, а тряхнуть «честно». С пленоптикой точку съемки можно тряхнуть совершенно «честно» — с изменением точки съемки, ракурса, motion blur и т.д. Будет полная иллюзия, что сильно тряхнуло камеру, которая мягко и безопасно ехала на колесах. Согласитесь — удивительная возможность! Стедикамы следующего поколения будут показывать чудеса.

Безусловно, чтобы это стало реальностью нужно подождать, когда размер пленоптической камеры сократится до разумного. Но учитывая, какие деньги вкладываются в миниатюризации и повышение разрешения сенсоров для смартфонов и планшетов, ждать, похоже, осталось не так долго. И можно будет создать новую пленоптическую камеру! С каждым годом это становится всё проще и проще.

Итак! Точку съемки вычислили и, если нужно, подвинули, стабилизировав или дестабилизировав камеру. Поехали дальше!

Вычисляемое освещение

Раз уж заговорили о взрыве рядом…

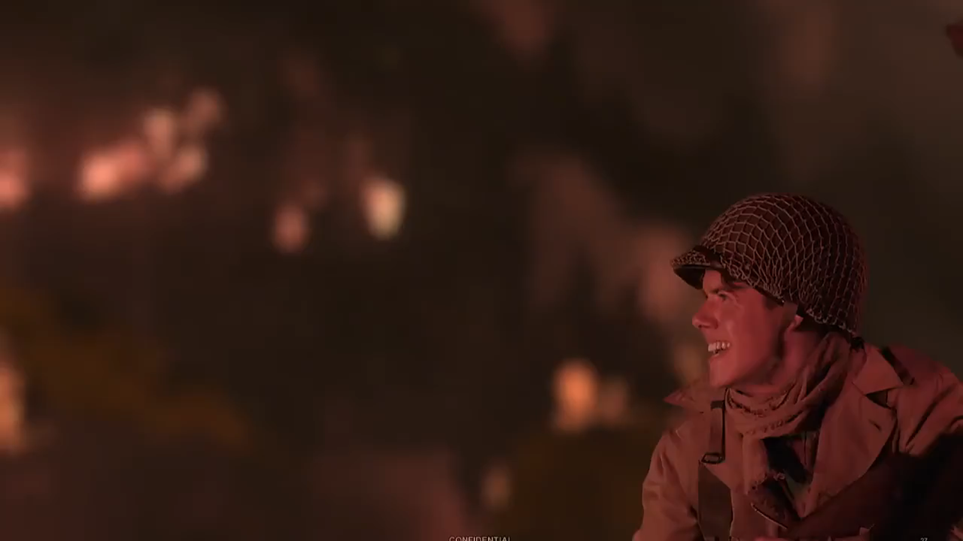

Иногда возникает необходимость изменить освещение объекта съемки, например, реалистично добавить вспышку. В студиях post-production хорошо знают, какая это сложная проблема, даже если одежда нашего персонажа относительно простая.

Вот пример видео с наложением вспышки с учетом одежды, ее теней и так далее (открывается по клику):

Источник: интервью с Йоном Карафином

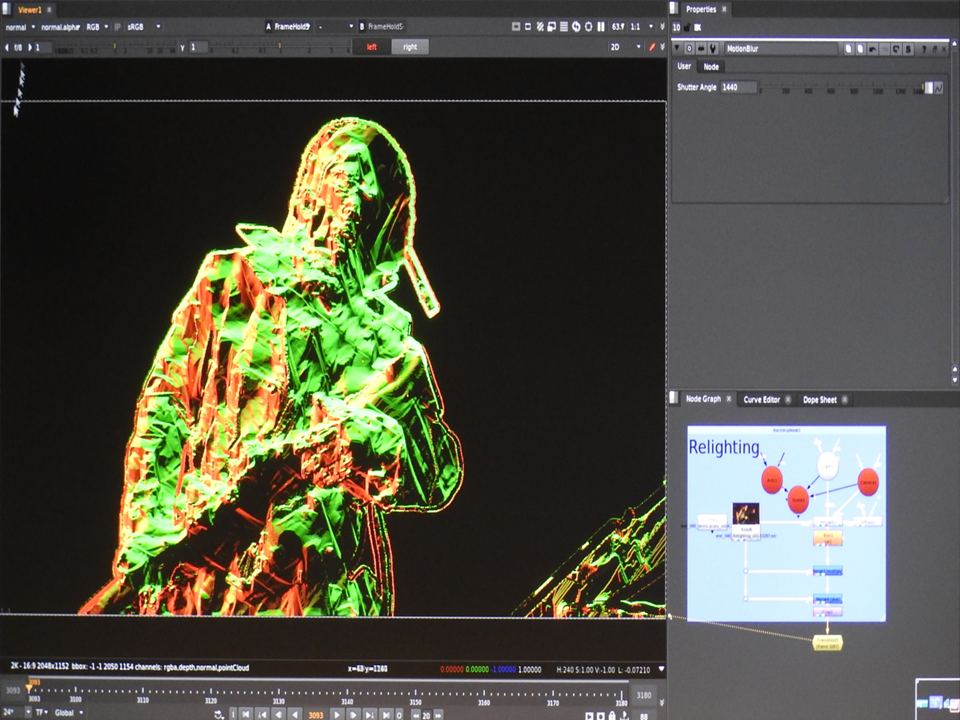

Под капотом это выглядит, как плагин под Nuke, который работает с полной трехмерной моделью актера и накладывает новый свет на нее с учетом карты нормалей, материалов, motion blur и так далее:

Источник: материалы Lytro

Итак! Новое освещение уже снятого объекта вычислили. Поехали дальше!

Вычисляемое разрешение

Те, кто экспериментировал с первыми Lytro часто отмечали — да, игрушка прикольная, но разрешение совершенно недостаточное для нормальной фотографии.

В прошлой нашей статье на Хабр было описано, как небольшие сдвиги точки съемки могут помочь заметно увеличить разрешение. Вопрос: Применимы ли эти алгоритмы к пленоптике? Ответ: Да! Более того — алгоритмам Super Resolution работать на пленоптических изображениях проще, поскольку есть карта глубины, все пикселы сняты в один момент времени, и достаточно точно известны сдвиги. То есть ситуация пленоптики просто волшебная по сравнению с тем, в каких условиях алгоритмы Super Resolution работают в обычном 2D. Результат получается соответствующий:

Источник: Наивное, умное и Super Resolution восстановление пленоптического кадра из Adobe Technical Report «Superresolution with Plenoptic Camera 2.0»

Единственная крупная проблема (действительно крупная!) — объемы данных и объемы вычислений, которые требуются. Тем не менее уже сегодня совершенно реально загрузить вычислительную ферму на ночь и получить назавтра вдвое большее разрешение там, где требуется.

Итак — разобрались с вычисляемым разрешением! Поехали дальше!

Вычисляемое окружение

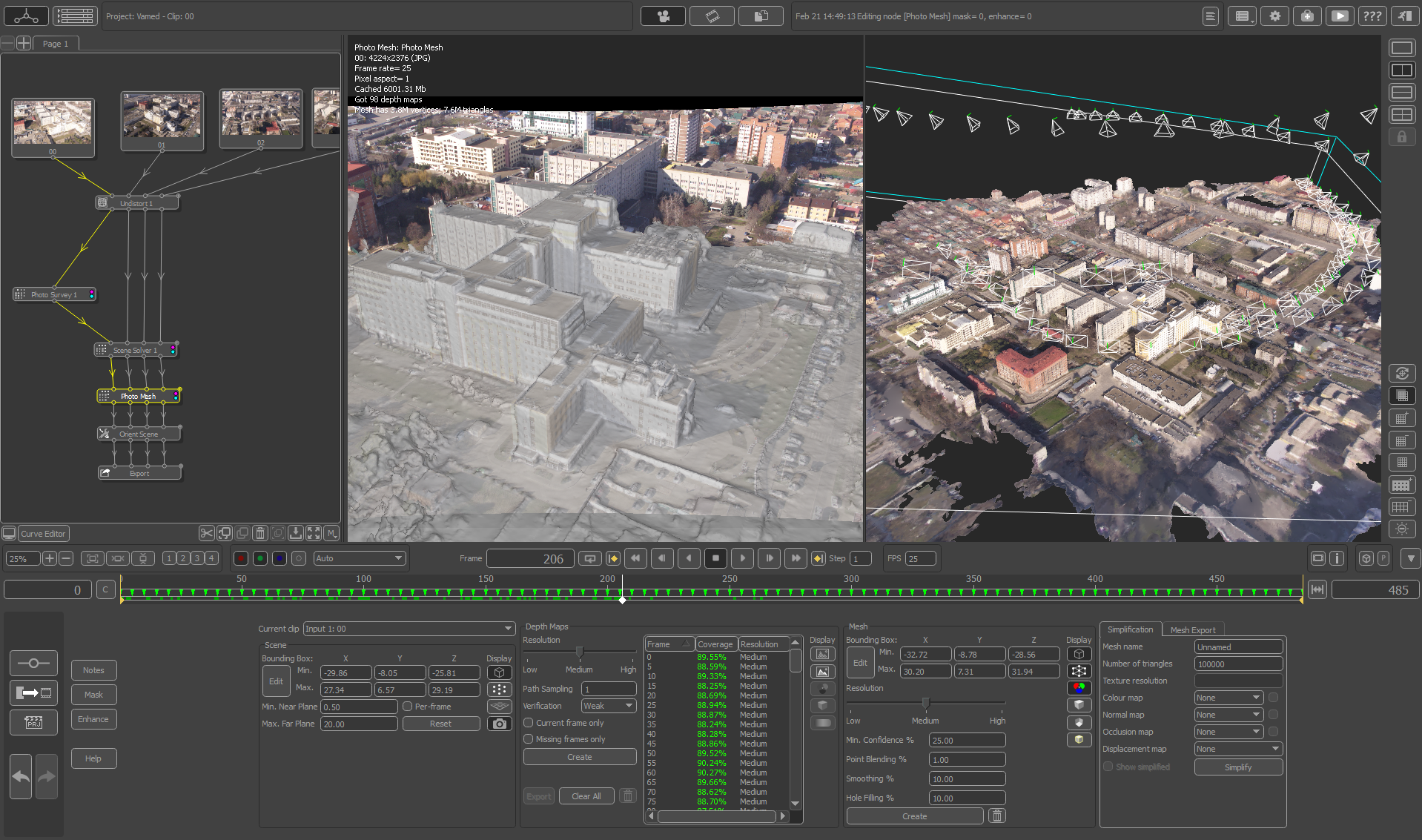

Отдельная задача, которая встает на этапе post-production, особенно если это какой-то фантастический или фэнтезийный проект, это аккуратно вклеить снятые объекты в трехмерную сцену. Глобально большой проблемы нет. Сегодня норма — трехмерное сканирование площадки съемки и дальше остается только аккуратно совместить снятую модель и трехмерную сцену, чтобы не было классики жанра, когда ноги актеров иногда чуть проваливаются в нарисованный неровный пол (этот косяк не очень заметен на малом экране, но может быть хорошо виден в кинотеатре, особенно где-нибудь в IMAX).

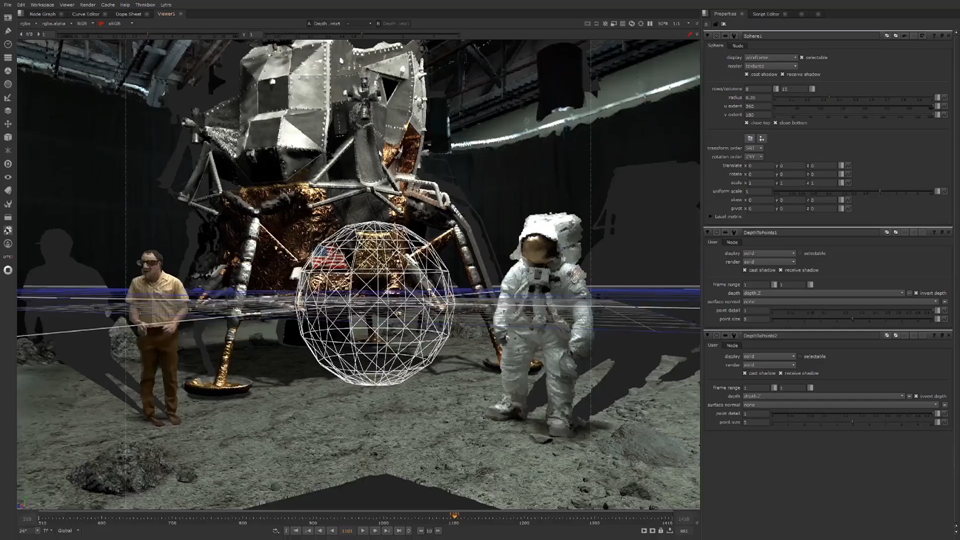

Не без юмора для примера работы камеры была использована сцена съемки посадки на луну (хорошо видны «трехмерные тени» в местах, которые не видит камера):

Источник: Moon | Lytro | VR Playhouse | Lightfield Post-Production

Поскольку в пленоптической камере по определению снимается многоракурсное видео, построить карту глубины — проблема небольшая. А если камера совмещена с лидаром — у нас сразу снимается трехмерная сцена, что категорически упрощает на следующем этапе совмещение реальной съемки и графики.

Итак, трехмерную сцену вокруг посчитали (совместив данные лидара и данные пленоптики). Теперь, как вы догадались, рендеринг лунной съемки будет еще более качественным! Идем дальше.

Вычисляемый хромакей

Но и это не все!

Привычная технология современной съемочной площадки — зеленые экраны (green screen), когда в местах, где предполагается компьютерный фон, ставятся окрашенные зеленым фанерные щиты или натягиваются зеленые баннеры. Это делается для того, чтобы не было проблем на полупрозрачных границах, когда фон будет меняться. А поскольку на 4К при движении объектов у нас большая часть границ становятся полупрозрачными — актуальность зеленых (или синих в зависимости от цвета одежды актеров) экранов крайне высока.

Сие крайне непривычно для киношников, но поскольку мы сами можем изменять резкость объектов, у нас появляется возможность обрабатывать кадры с разной глубиной резкости и, как следствие, считать карту полупрозрачности границ и точный цвет снятого объекта. Это позволяет снимать без использования зеленых экранов, в том числе довольно сложное изображение, а потом восстанавливать карту прозрачности:

Источник: интервью с Йоном Карафином

В Lytro специально сняли ролик, на котором носят лестницы на заднем плане (поскольку при реальных съемках на самых удачных дублях обязательно что-то не то попадает в кадр — это незыблемый закон съемок!), а на переднем плане падают размытые конфетти (что сразу превращает чистку мужиков с лестницами в недетский challenge), но в кадре эти дальние объекты относительно легко обрезаются и у нас остается аккуратный передний план, в том числе с картой полупрозрачных границ (выбран фон, на котором легко оценить качество выделения конфетти, который его не маскирует):

Грамотный читатель спросит, а как же движение или те же волосы? И будет совершенно прав. Свои сложности, безусловно, еще остаются (и очень много). Другое дело, что точно зная фон и имея возможность немного подвигать объект перед фоном у нас открываются совершенно новые возможности по автоматическому и более качественному построению карты прозрачности.

Собственно в силу последних трех моментов можно прогнозировать будущий успех пленоптических камер в съемке сериалов типа «Игр престола», когда большое количество спецэффектов можно будет поставить на поток. Что означает ощутимое снижение их себестоимости. Там не все так просто, но возможности для вычисления карт прозрачности за счет перефокусировки и возможности сдвинуть точку съемки на порядок превышают аналогичные возможности для обычных 2D камер. И инструменты подтянутся.

Итак, с вычисляемой картой прозрачности без гринскринов разобрались, поехали дальше!

Вычисляемая экспозиция

Отдельная важная тема — вычисляемая экспозиция или вычисляемый затвор. Эта тема не имеет прямого отношения к пленоптике, но в современных условиях, когда диагональ, контрастность и разрешение экрана дружно и быстро растут, она становится все более и более актуальна. Проблема в эффекте стробоскопа, который характерен для быстрого движения объектов в кадре при «обычной» съемке.

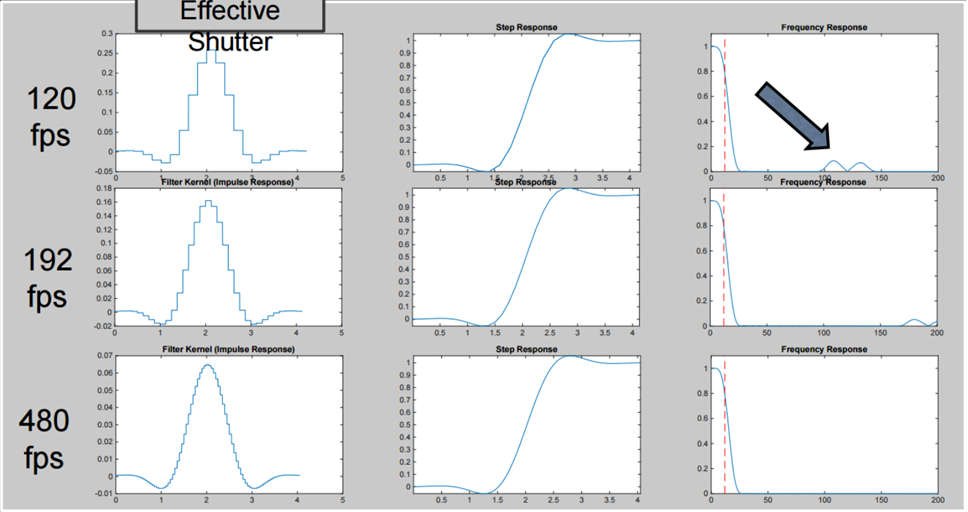

Кардинально снизить этот эффект, сделав движение «мягким» и рассчитав «идеальный» затвор, можно, сняв видео с большей частотой кадров, а потом пересчитать его в меньшую частоту, воспользовавшись разными функциями пересчета, в том числе не только суммируя кадры, но и вычитая (в Lytro Cinema было 300 fps, чтобы было понятно, как интерпретировать эти графики):

Это дает возможность «снять» видео с затвором, который создать физически крайне сложно, а то и вовсе невозможно, но который обеспечивает крайнюю «мягкость» и «приятность» движения объектов в сцене без эффекта стробоскопа от веток, колес и других быстро движущихся объектов (особенно обратите внимание на диски колес, и на то, насколько стала лучше видна машина за препятствиями):

Источник: https://vimeo.com/114743605

Или вот два еще кадр, движение камеры в котором будет намного более приятно восприниматься на глаз, особенно на большом экране:

Источник: https://vimeo.com/114743605

Уф, вычислили экспозицию. Двигаемся дальше!

Пленоптическая камера в смартфоне сегодня

Обычно, когда речь заходит про пленоптику сегодня, то идут типичные разговоры в стиле «Шеф всё пропало: гипс снимают, клиент уезжает!», Lytro в прошлом году задешево купил Google, эксперименты Pelican Imaging в массовое производство не пошли и вообще все осталось лишь красивой теорией…

Источник: Pelican Imaging: Smartphone Plenoptic Camera Modules for 20 Dollars

Так вот! Слухи о смерти пленоптики сильно преувеличены. Очень сильно!

Напротив, ровно сейчас пленоптические сенсоры выпускаются и используются в масштабах, которых ранее никогда не было в истории.

Небезызвестная компания Google без особой помпы выпустила Google Pixel 2 и Google Pixel 3 с пленоптическими сенсорами. Если посмотреть на телефон, очень хорошо видно, что камера у телефона одна:

Однако при этом телефон делает очень даже неплохое размытие заднего плана, в общем-то не хуже, чем его «двуглазые», «трехглазые» и «четырехглазые» коллеги (согласитесь следующее фото особенно сильно выигрывает от этого эффекта):

Источник: AI Google Blog (можно нажать и посмотреть в большем размере, в первую очередь на границы объекта переднего плана)

Как они это делают?!

Применяется неизбывный в последнее время источник волшебных чудес — недетская магия нейросетей?

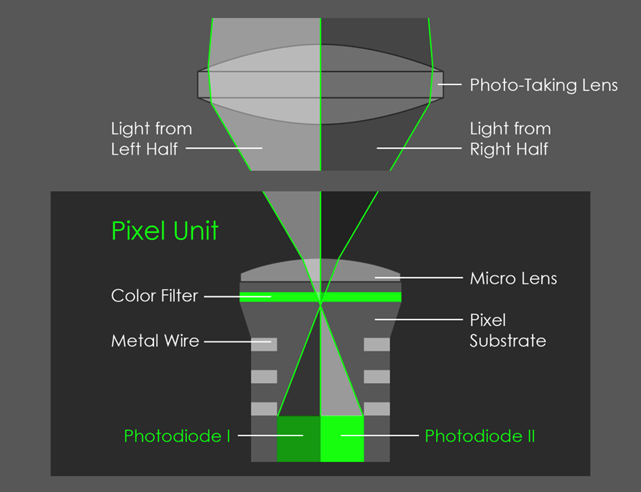

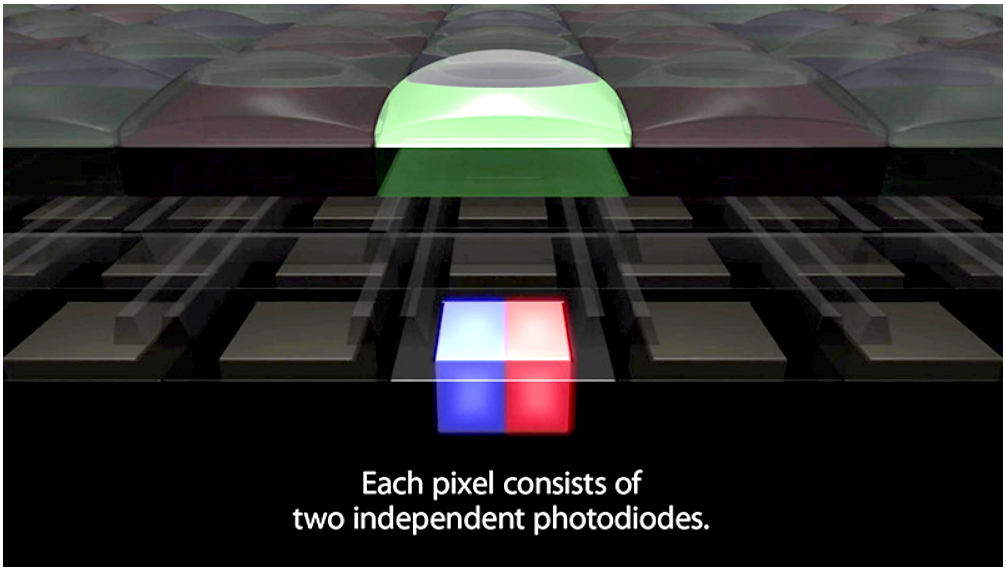

Нейросети, особенно в Pixel 3, в этой задаче тоже активно применяются, но про это дальше. А секрет качества эффекта в том, что сенсор смартфона пленоптический, правда линза накрывает только два пиксела, как показано на картинке:

Источник: AI Google Blog

В итоге у нас получается микро-стерео картинка, здесь по движению виден очень небольшой сдвиг (правая картинка анимирована и движется вверх-вниз, поскольку так держали телефон при съемке):

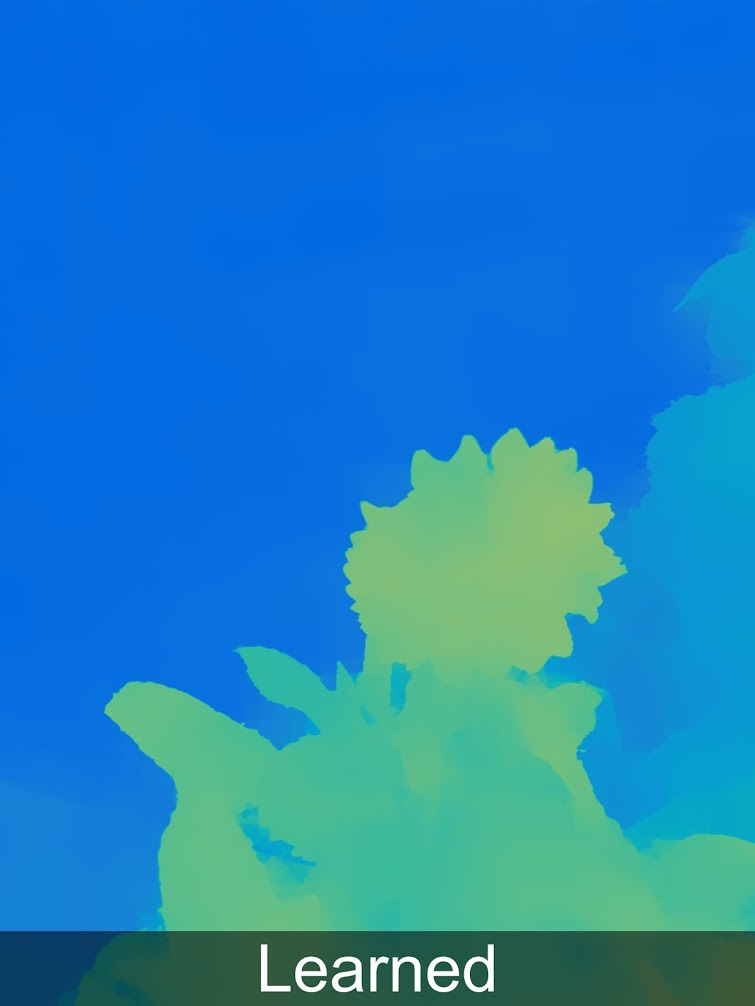

Но даже этого крайне небольшого сдвига хватает для того, чтобы построить карту глубины для снимаемого фото (про использование субпиксельных сдвигов было в прошлой статье):

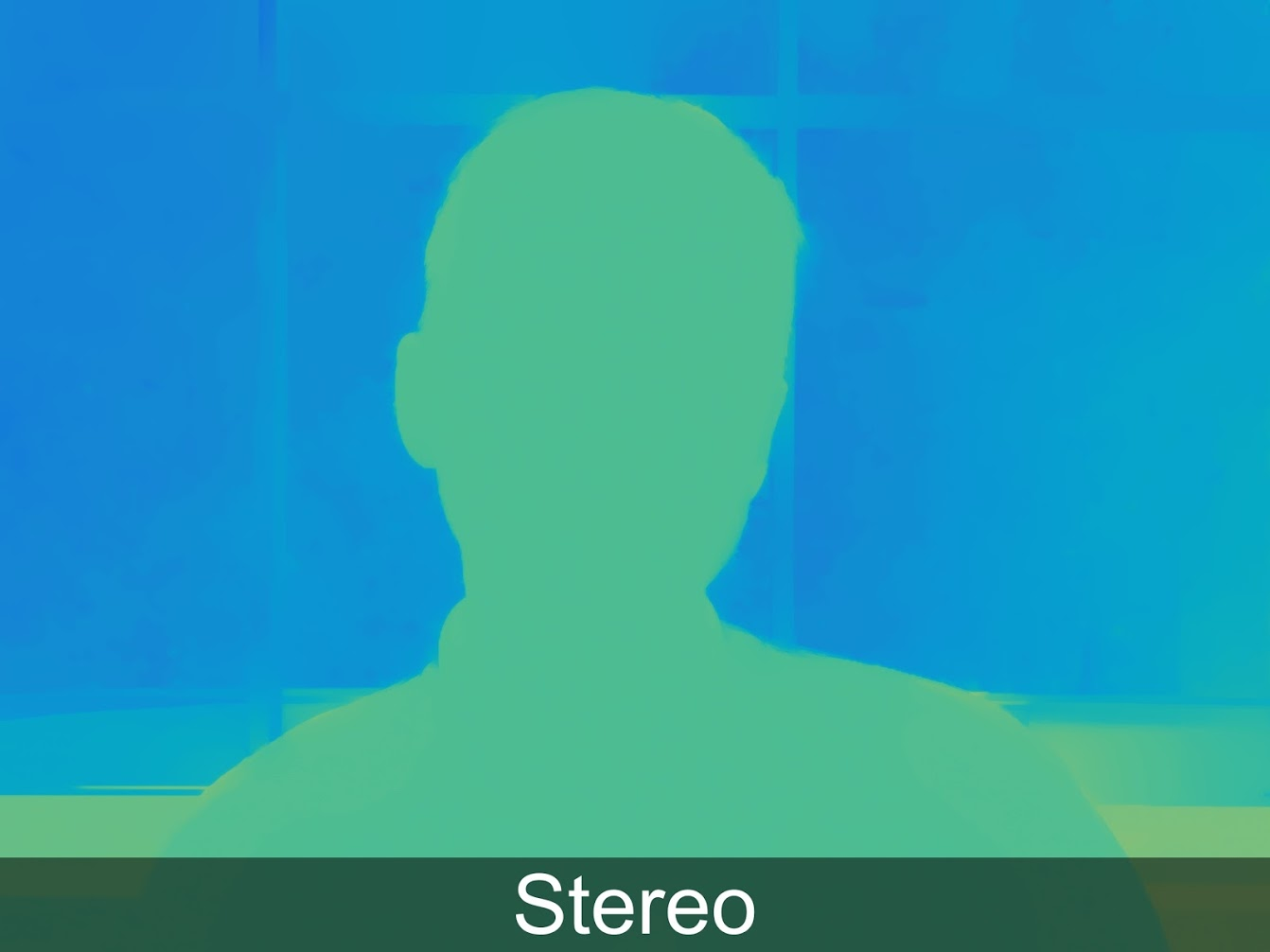

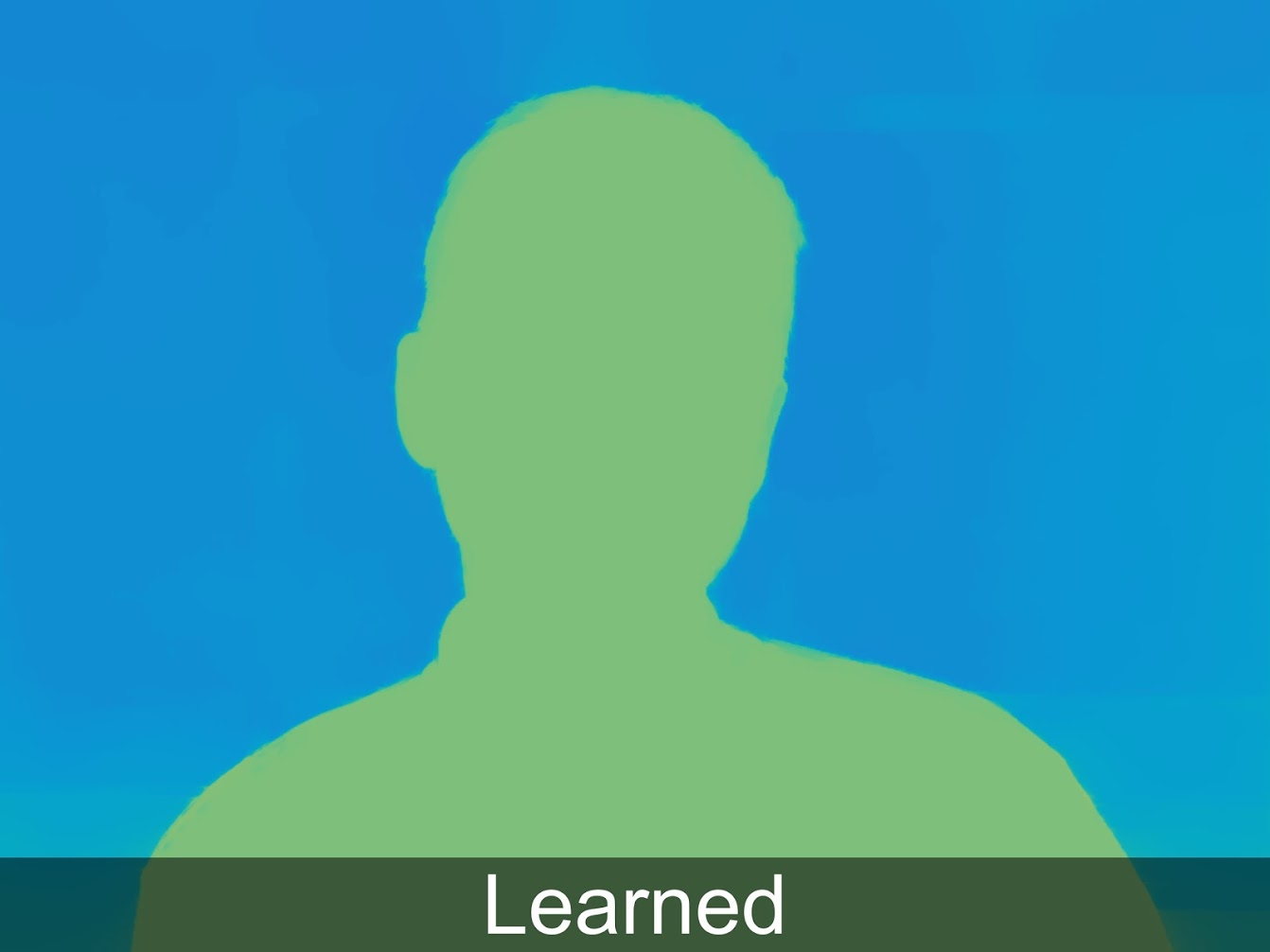

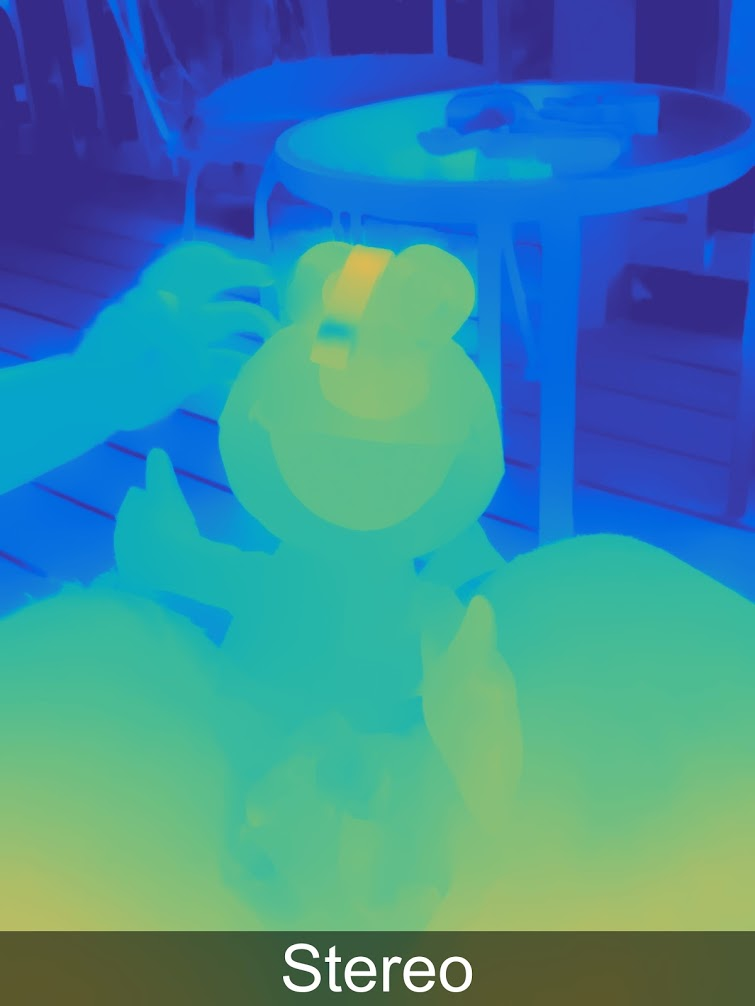

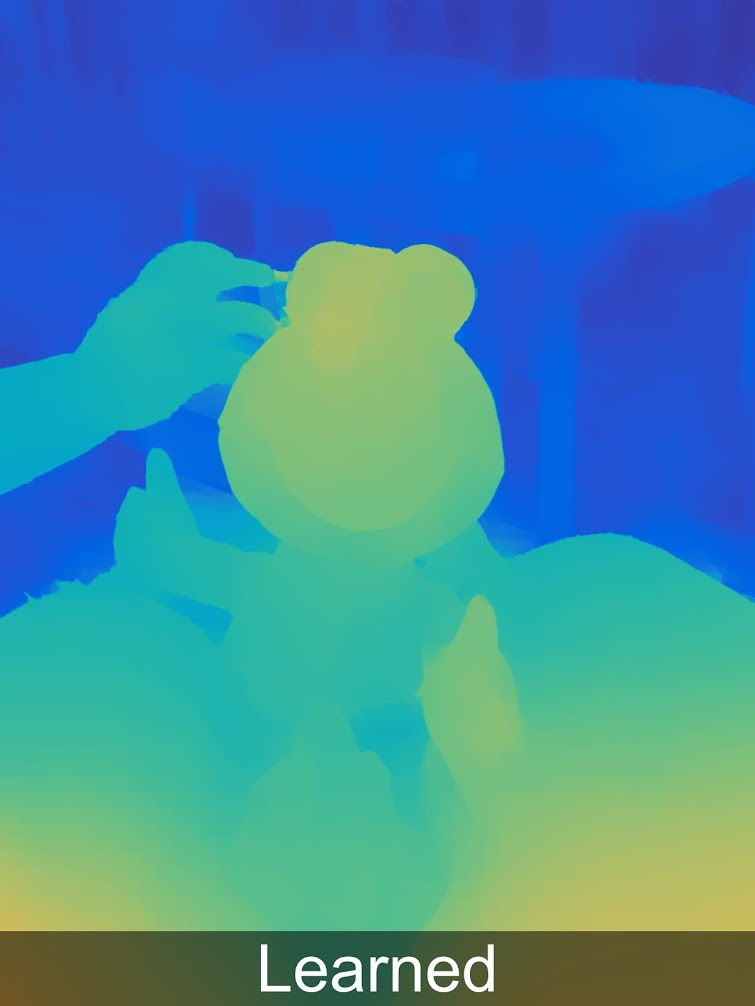

При этом с применением машинного обучения результаты можно заметно улучшить и это уже реализовано в Pixel 3. В примере ниже Learned означает Stereo+Learned, подробнее про это, будем надеяться, будет отдельный пост:

Для любителей разглядывать глубину в полном разрешении больше примеров в специальной галерее.

Хорошо видно, что не все идеально, и у нас есть типичные артефакты, характерные для построения карты глубины из стерео (которые, к слову, вполне в наличии и у двуглазых коллег Pixel), да и маленький параллакс сказывается. Но уже понятно, что качество глубины получается вполне достаточное для того, чтобы уверенно сегментировать изображение по глубине и дальше накладывать разные эффекты, более уверенно добавлять объекты в сцену и так далее. Результаты ИЗМЕРЕННОЙ глубины на порядок лучше результатов на основе разных предположений (сколь угодно нейросетевых).

Так что поздравляю всех, дочитавших до этого момента! Вы живете во время выпуска пленоптических камер в успешном массовом рыночном продукте, пусть даже и не знаете об этом!

История на этом, конечно, не заканчивается:

- Во-первых, интересно, что пленоптика обошлась «почти даром», поскольку в современных камерах смартфонов при миниатюризации сенсора и росте разрешения катастрофически не хватает светового потока, поэтому каждый пиксель накрывают микролинзой. То есть такой сенсор не обходится дороже (это очень важно!), правда мы несколько жертвуем разрешением, которое только что увеличили за счет другой технологии. В итоге применения двух технологий результат становится лучше в 2D (меньше шумов, выше разрешение, HDR) и при этом дополняется измеренной глубиной, то есть становится 3D. Цена вопроса — кардинальный рост количества вычислений на кадр. Но для фото это уже сегодня возможно и уже работает в реальных смартфонах.

- Во-вторых, на одной конференции сотрудник Google говорил, что они думают накрыть линзой 4 пиксела, после чего качество карты глубины будет кардинально выше, поскольку появятся 2 стереопары c в 1.4 раза большей стереобазой (две диагонали), это кардинально улучшит качество карты глубины, в том числе пропадут многие артефакты стерео на границах. Конкуренты смогут достичь такого качества, только поставив минимум 3 камеры не в ряд. Такое увеличение качества важно для AR.

- В-третьих, Google уже не одинок, вот пример описания аналогичной технологии в Vivo V11 Pro, согласитесь, вы только что похожую картинку уже видели:

Источник: What is Dual Pixel technology?

- Наконец, в последние годы количество публикаций по интерполяции данных светового поля выросло просто лавинообразно. И это замечательно, поскольку чтобы кардинально снизить вычислительную сложность нужна будет недетская математика.

Применяется пленоптика и в автофокусе профессиональных фотоаппаратов, например, у Canon (гуглить DPAF — Dual Pixel Auto Focus). Кто бы мог подумать, что теоретический прикол 30-летней давности — возможность снять стерео одним объективом — станет первым массовым применением пленоптики…

В общем — тема пошла в продукты!

Она уже летает! Понимаете, ЛЕ-ТА-ЕТ!

Подводя итоги

Пленоптика в кино

Выше мы разобрали два случая применения пленоптики — в кинопроизводстве и в смартфонах. Это не полный список, например, пленоптика весьма актуальна в микроскопии — можно делать вычисляемые стерео-микроснимки с большой «честной» глубиной резкости; пленоптика актуальна для промышленных камер, особенно если нужно делать фото полупрозрачных многоуровневых объектов и так далее. Но про это как-нибудь в другой раз.

Напомним, для применения в кинопроизводстве актуальны:

- Вычисляемая дистанция фокусировки

- Вычисляемое боке

- Вычисляемое разрешение

- Вычисляемое идеальное стерео

- Вычисляемая точка съемки

- Вычисляемое освещение

- Вычисляемое окружение

- Вычисляемый гринскрин

- Вычисляемый затвор

В ближайшие годы с миниатюаризацией и ростом разрешения сенсоров технологию можно развить до создания практичной принципиально новой кинокамеры, позволяющей быстрее (без гринскрина) и с меньшим числом дублей (больше моментов легче поправить) снять материал для наложения спецэффектов. Новые возможности настолько интересны, что к тому моменту, как пленоптический сенсор с пригодным для кино разрешением можно будет сделать компактным, подобные камеры обречены на успех.

Когда такая камера может появиться?

Осторожный ответ — в ближайшие 10 лет.

От чего зависит срок?

От многих факторов. Хороший вопрос: какова будет ситуация с возможностью лицензировать патенты Lytro, которыми сейчас владеет Google? Это может быть критично. К счастью за 10 лет у ключевых из них истечет срок действия (тут мы вежливо не вспоминаем про китайских коллег Lytro, которые могут ускорить процесс). Также должна упроститься работа с колоссальными объемами данных, генерируемых пленоптической камерой: с современными облаками это становится все проще и проще. Из хороших новостей — в своё время благодаря Lytro в очень популярной программе компоузинга, которая используется в огромном числе студий для обработки стерео был поддержан пленоптический формат данных. Как говорится, Lytro умер, но возможность писать плагины под Nuke с поддержкой пленоптического видео осталась с нами. Это упрощает «вхождение» на этот рынок с профессиональным продуктом, поскольку важно, чтобы студии сразу без обучения персонала и в тех же программах сразу могли работать с форматом новых камер.

Пленоптика в смартфонах

Если говорить про смартфоны, то тут все выглядит еще лучше. Наиболее актуально для этой индустрии возможность пленоптической камеры измерять глубину одним сенсором (потенциально — быстро) и эта возможность скоро будет мега-востребована.

Когда такая камера может появиться?

Уже существует. И завтра технологию повторят другие производители. Причем ключевым драйвером следующего этапа будет дополненная реальность на смартфонах и планшетах, которой сегодня очень не хватает точности и возможности «видеть» трехмерную сцену.

От чего зависит срок?

Возможность измерять расстояние основным сенсором в реальном времени с большой вероятностью скоро появится у Google Pixel, поскольку Google давно ведет разработки в этом направлении (смотри Project Tango, который закрыт, но дело которого живет). И ARCore выглядит очень перспективно, равно как и конкурирующий ARKit. И прорыва, как вы теперь догадываетесь, ждать осталось недолго, благо стоимость пиксела сенсора падает по экспоненте, средней скоростью называют 10 раз за 10 лет, а нам нужно падение в 2 раза. Далее считайте сами. Не завтра, но совсем недолго.

Вместо заключения

Помните, в самом начале речь шла про лекцию в ВГИК? Должен сказать, что совершенно не ожидал той реакции на нее, которая была в итоге. Если описать одним словом, то это был траур. Если двумя словами, то вселенский траур. И я сначала не понял, в чем дело. Очень хорошо мне объяснил ситуацию подошедший после лекции оператор. Дело было даже не в том, что уменьшается операторское искусство. Хотя там был великолепный пример: фрагмент фильма примерно на 6 секунд, когда человек подходит к двери квартиры, стучится, дверь открывает другой человек, здоровается и чуть отодвигается пропуская, а камера в это время фокусируется на коридоре, потом на косяке, потом мгновенно переводит фокус на открывшего человека, а потом в комнату. И оператору нужно великолепно владеть камерой, чтобы при киношной небольшой глубине резкости виртуозно работать трансфокатором, помня о контровом свете, композиции кадра, укачивании при съемке с рук и еще 1000 важных мелочей. Так вот. Дело даже не в том, что это становится делать проще. Это даже хорошо. Меньше дублей будет испорчено из-за того, что оператор где-то не успел или промахнулся. Он рассказал, как недавно снимал сериал в 4К для телеканала. И запас по разрешению получился большой. В результате на post-production режиссер подрезал кадры, а местами на перебивки использовались просто фрагменты кадра. В итоге композиция была просто ужасна и этот оператор хотел снимать свое имя с титров.

Описанные выше возможности камер для киношников означают перевод многих эффектов с этапа съемок на этап post-production. И будет большая печаль, если те, кто будет обрабатывать снятые сцены, будут неграмотными в вопросах композиции, управления дистанцией фокусировки и так далее. Если же будут грамотными — это новые фантастические возможности.

Так пожелаем же всем нам побольше компетентности, что не всегда просто в этом быстро меняющемся мире!

А

Благодарности

Хотелось бы сердечно поблагодарить:

- Лабораторию Компьютерной Графики ВМК МГУ им. М.В.Ломоносова за вклад в развитие компьютерной графики в России и не только,

- наших коллег из видеогруппы, благодаря которым вы увидели эту статью,

- персонально Константина Кожемякова, который сделал очень много для того, чтобы эта статья стала лучше и нагляднее,

- Йона Карафина в бытность его Head of Light Field Video в Lytro, благодаря которому мы чуть не начали работать над улучшением их продукта (и не начали по независящим ни от него, ни от нас причинам),

- компанию Lytro за их вклад в популяризацию световых полей и их возможностей, компанию Google, которая подхватила падающий флаг, и другие компании, которые делают продукты на основе этой интереснейшей технологии,

- и, наконец, огромное спасибо Сергею Лаврушкину, Роману Казанцеву, Ивану Молодецких, Евгению Купцову, Егору Склярову, Евгению Ляпустину и Денису Кондранину за большое количество дельных замечаний и правок, сделавших этот текст намного лучше!

Комментарии (199)

Pablas

19.02.2019 10:29+1Камера есть, осталось найти режисера…

3Dvideo Автор

19.02.2019 11:55Поддержу вас, чтобы не минусовали ). Джеймс Кэмерон известен тем, что реально глубже других режиссеров погружается в предельные на тот момент возможности техники и на уровне сценария (!) учитывает что могут, а что не могут снять самые свежие камеры. На таком уровне работают единицы режиссеров. Увы.

SADKO

19.02.2019 14:22Он вообще прикольный мужик, но при всём при этом, ещё и продюсер, так-что его любовь всё попробовать на своей шкуре, она вполне рациональна. И накопал интересных стерео фишек он много, в аватаре использовано далеко не всё. Некоторые его фишки, действительно оригинальны, в советском стерео кино такого не было…

Но он далеко не единственный и уникальный, просто другие не палятся, Спилберг например, в своё время механикам камеры мастер класс показывал ;-) хотя режиссёр и оперпост, на съёмочной площадке, камеры обычно вообще не касаются, тем более в технических аспектах.

darthslider

21.02.2019 11:00Вот, прочитав вашу статью, подумал, что это как раз то, чем мог бы действительно удивить новый Аватар.

Хорошо написано и интересно, спасибо!

glycol

19.02.2019 10:50+1Отличная статья. На мой взгляд, Lytro подвела спешка, они выпустили камеру со слишком низким разрешением, фактически, не пригодным для фото (видимо, ради сохранения не слишком высокой цены). А эти монстры Lytro Cinema уже применялись где-то в фильмах? Или это пока только тестовые образцы?

3Dvideo Автор

19.02.2019 11:42Они делали что могли, на мой взгляд.

Задача, на которую они замахнулись опережала и возможности техники на тот момент, и возможности алгоритмов.

Их монстры не зашли в кино именно потому, что были слишком монстрообразны, фактически они возможности продемонстрировали, а дальше на рынок реально пойдут образцы следующих поколений, которые будут в разы компактнее и работать с которыми будет технически намного проще.

alexhott

19.02.2019 11:48Также с обычными цифровыми камерами формата HD было.

Помню читал как про космос — «Запись ведется на 8Gb карты памяти», в то время как я в руках держал дискету 1,4Мб(съемного носителя большей емкости на тот момент я не видел), одноклассник несказанно радовался новому жесткому диску на 400Мб.

3Dvideo Автор

19.02.2019 18:45Да-да-да. В областях, где по экспоненте идет процесс улучшения параметров, очень интересные процессы происходят. Пленоптика — на стыке нескольких экспонент.

Al_Azif

22.02.2019 10:02+1Посмотрите отзывы на ихние портативные камеры на Амазоне.

Люди просто не врубаются что они только что купили, у них «разрешение хреновое и фотки мутные». В результате оценка — 2.5-3.

trir

19.02.2019 10:53тема VR не раскрыта www.youtube.com/watch?v=OUU2yGHgPQY

3Dvideo Автор

19.02.2019 11:44Да, и AR только упомянут, хотя он скоро (как только нейроморфные чипы в реальном времени карту глубины пленоптического сенсора строить будут) будет основным драйвером процессе.

Но и так много букв ), про это можно будет скоро отдельные посты, как железо дозреет.

Тут была задача про пленоптику, которая давно на рынке незамеченная рассказать.

Loki3000

19.02.2019 11:09Но ведь если камеры станут миниатюрными, при этом уменьшится стереобаза? Получается, прощай простое и дешевое стерео?

clawham

19.02.2019 11:39ну справедливости ради маленькая матрица и огромній обьектив єто лучше чем огромная камера с огромной матрицей и таким же обьективом. Киношники никогда не пугались F1 на 200 милиметрах. Их пугает стационарность камеры и её вес.

3Dvideo Автор

19.02.2019 11:47Их пугает стационарность камеры и её вес.

Абсолютно так. И именно это утопило даже относительно компактные бим-сплиттеры в пользу конвертации.

SADKO

19.02.2019 14:08Компактные? Таскали-ли вы спилиттер на стэдикаме, а пылинки с зеркал сдували-ли? А объективы парные подбирали-ли ;-)

Да и на сплитерах мир не сошелся, были кастомные камеры, были серийные SI-2K которые можно было поставить близко на параллельных осях, всё упиралось в объективы, но у кого были старые элитовские наборы, это не разу не проблема, тк они меньше современных.

Смысл конвертации в получении контролируемого эффекта без косяков. Буржуи быстро догнали, что объём это символ, такой-же как свет и цвет, он вовсе не обязан быть объективным и более того…

3Dvideo Автор

19.02.2019 14:22Именно поэтому «даже относительно компактные» )

Про конвертацию — мы даже хорошо приложились к теме роста ее успешности и популярности.

3Dvideo Автор

19.02.2019 11:46Но ведь если камеры станут миниатюрными, при этом уменьшится стереобаза? Получается, прощай простое и дешевое стерео?

Кто вам такое сказал? ) Важен размер объектива, и для кино в ближайшие 20 лет точно появятся камеры с одним большим глазом объектива, снимающие великолепное стерео.

alexhott

19.02.2019 11:44Читал лет 15назад об изобретении сего девайса с матрицей микролинз перед матрицей, тогда конечно речь шла о десятках мегопикселей и фото с любым фокусом после съемки.

Только непонятно откуда в названии технологии появилась «пленка», может опять с переводом чего-то не так и подхватили, или маркетологи ничего лучше не придумали.

А так тема знатная, еще если пойдут дальше и соединят матрицу микролинз с фотосенсором которому не нужен объектив, то будет еще копактнее и можно будет на всю ширину смартфона прилепить — и стерео нормальное снимать.

3Dvideo Автор

19.02.2019 11:51Только непонятно откуда в названии технологии появилась «пленка», может опять с переводом чего-то не так и подхватили, или маркетологи ничего лучше не придумали.

от латинского plenus — полный

Камера снимает более полный (четырехмерный) кадр.

trolley813

19.02.2019 13:53Да, вот тоже, когда увидел слово «пленоптика» (и пока не заглянул в статью), долго сомневался — оно от латинского plenum или таки от пленки?

vconst

19.02.2019 16:31Неудачное слово получилось в русском языке. Надо было переводить, как-то типа: «пленусоптическая»…

3Dvideo Автор

19.02.2019 17:01«пленусоптическая» удачнее? Гм…

vconst

19.02.2019 17:03+1А что такого? Возможно у меня из медицины осталась равнодушное к самым заковыристым латинским названиям, но зато звучит так, что с пленкой точно не спутать.

Detuner

20.02.2019 10:49По медицинской латыни Вам должен быть ясен механизм словообразования: взят латинский корень plen без окончания и это правильно, иначе мы вовсю пользовались бы такими словами, как «вербумальный», «доминусировать», «локусолизация», «градусиент» и т.д.

vconst

20.02.2019 11:47Это было так давно, что от знаний латыни — у меня осталась только привычка, о которой я говорил выше :) Теперь понятно, почему термин звучит именно так, спасиб )

trolley813

21.02.2019 09:08+1А вот слово «доминусировать» хорошо подходит для Хабра (в значении «закончить минусировать», т.е. «закончить ставить минусы»).

vconst

21.02.2019 11:59«закончить ставить минусы»

<img src="Нельзя так просто взять, и закончить ставить минусы"/>

vidyakinsergey

19.02.2019 12:48Надеюсь производители 3Д-телевизоров опять начнут их продавать, а то многие убрали их из линеек, т.к. признали не перспективными из-за малого количества 3Д-контента

3Dvideo Автор

19.02.2019 12:50признали не перспективными из-за малого количества 3Д-контента

Качественного 3D контента, я бы добавил )

А так — проблема курицы и яйца — классика при выходе на массовый рынок многих технологий

scream_r

19.02.2019 13:05С 3D огромную свинью подложили создатели спецификации 4к, в которую просто не включили 3D.

SergeyMax

19.02.2019 20:52т.к. признали не перспективными из-за малого количества 3Д-контента

Их признали малоперспективными совсем не поэтому. Внезапно выяснилось, что 3D-фильмы не становятся интереснее от того, что они 3D. В «Аватаре» в лицо зрителю кидали комья земли, в «Алисе» упоротый заяц кинул тарелкой. А дальше стало просто скучно.

vidyakinsergey

20.02.2019 00:13+2Не согласен. Дело не в интересности а впечатлении. Даже обычный фильм приятнее смотреть в 3Д, привыкаешь, что люди объемные и сцена выпуклая. Потом обычное кино кажется плоским

3Dvideo Автор

20.02.2019 00:19+1Однозначно!

У кино непростая ситуация. В условиях разгула торрента нужно сохранить сборы фильмов на уровне.

Проводили эксперименты, сравнивали большее разрешение, 48FPS и стерео. Массовый зритель выше всего оценивает стерео, а ниже всего — разрешение. НО при условии, что не болит голова. )

vconst

20.02.2019 12:14Не соглашусь

Я не большой фанат Питера Джексона, но на Хоббита ходил только для того, чтобы оценить HFR. И это меня так поразило, что обычные 3Д кино смотреть уже не тянет. А Хоббита я смотрел все три части, специально на другой конец Москвы ездил. Эффект погружения — невероятный, пейзажи такие — будто в большое окно смотришь, четкость и плавность — потрясающие. Потом читал, что им грим и костюмы пришлось переделывать, потому что разрешение высокое и халтура сразу вылазит.

artemerschow

20.02.2019 12:25Каждому своё, видимо. Мне наоборот крайне не комфортно было смотреть хоббита в 60 кадров в секунду. Стандартные 24/25 кадров (в кино) мне гораздо приятнее.

З.Ы.: решил загуглить, точно ли HFR это про повышенную частоту кадров

vconst

20.02.2019 12:29Я не про 60 кадров, а про СТЕРЕО на частоте 48 кадров. И для стерео — эффект ошеломительный, мы с женой былы в восторге, хотя не любители 3Д в кино. Гуглится всякая фигня, потому что «hfr» это «рак» в русской раскладке :)

Но я про это: en.wikipedia.org/wiki/High_frame_rate

artemerschow

20.02.2019 12:32а про СТЕРЕО на частоте 48 кадров

Извиняюсь, затупил. Да, я это и имел в виду.

vconst

20.02.2019 12:34Вы смотрели Хоббита в кино с HFR? Не в каждом городе показывали в этом формате, в Москве было меньше десяти кинотеатров, я поехал в Аймакс. Кстати, в некоторых кинотеатрах показывали HFК с косяками, в Аймаксе было идеально.

artemerschow

20.02.2019 13:11Сейчас засомневался. Смотрел в сети silvercinema в Твери. Точно писали, что стерео 48 кадров, точно картинка отличалась детализацией и частотой кадров. Точно ли это выглядело так, как должно было — не уверен

vconst

20.02.2019 13:14Есть подозрение, что тот кинотеатр не очень умел показывать такой формат.

Были и реально негативные отклики. То есть — технология, действительно, не всем понравилась. Но, большинство претензий было к сути, а не к форме, что дескать «слишком высокая детализация, больше похоже на тв, хочу обратно теплую и ламповую муть низкого разрешения».

denisshabr

21.02.2019 12:31Любой хороший телевизор высоких серий умеет интерполировать до 60fps в том числе и 3D. Без этого на 3D смотреть конечно тошнотворно — 24 стробоскопных кадра, только глаза настроятся на объём как бац — следующий кадр, никакой плавности. Для 3D вообще идеально было бы 120fps на каждый глаз, как в реальной жизни, намного меньше болела бы голова и больше эффект погружения.

3Dvideo Автор

21.02.2019 13:02Любой хороший телевизор высоких серий умеет интерполировать до 60fps в том числе и 3D.

А какие при этом артефакты возникают вы видели? ) Тема называется FRC — Frame Rate Conversion. Мы ее делали для телевизоров Samsung, чипов Intel, чипов для приставок Broadcom… Когда у вас экран становится киношного размера там все то, что не видно на телевизоре обычным людям (хотя мне, например, и там режет глаз) — становится видно всем.

И наступает карачун )

denisshabr

21.02.2019 17:07На ТВ лучше ловить артефакты, чем ловить стробоскопные древние 24fps.

Давно уже пора снимать фильмы 48/60/120fps. Олдскульные люди пускай смотрят потом в плеерах пропуском каждого второго кадра, это проще, чем заниматься интерполяцией.

vconst

21.02.2019 17:25Давно уже пора снимать фильмы 48/60/120fps.

Просто посмотрите ссылку в посте, на который ответили в первый раз.

ED-209

21.02.2019 22:47Не знаю как там на телеках, но я смотрю Blu Ray 3D в шлеме в 1920х1080@24Гц (1080p@24p, 3D) на глаз, два микро-дисплея. Никакого стробоскопа не наблюдаю. Формат 24p (23.976Гц) считаю каноном и эталоном для просмотра Blu Ray.

3Dvideo Автор

21.02.2019 23:56+1Интересно! Какая марка шлема и через какой софт смотрите?

И какие впечатления от «трехмерности» картинки?

ED-209

22.02.2019 05:17Шлем Goovis Pro. Он недавно появился, два месяца назад. Продается пока только в Китае, пришлось довольно тернистый путь пройти, чтобы его оттуда вытащить. Производитель NED Optics.

Вообще, это отдельная линейка шлемов специально для просмотра 3D/Video. Возможно помните, в свое время была серия шлемов Sony HMZ, 3D 720p и аппаратный декодер Dolby/DTS 7.1. Шлем на micro-oled, совсем маленькие дисплейчики, размером с монетку. Производит их массово Sony Semiconductor. Вот HMZ выходил в четырех вариациях (каждая чуть лучше другой, ТТХ почти не менялись, в основном фиксили эргономику) вплоть до 2014 года. Потом началась массовая истерия по VR и Sony на данную ветку развития забила. Хотя были практически пионерами и довольно близки к цели, в самой последней модели Sony HMZ-T3Q сделали даже поддержку хедтрекинга (выпускали ограниченным тиражем только в Японии).

У подобных шлемов FOV (угол обзора) составляет в среднем 45-60 градусов. Т.е. получается большой экран висящий в абсолютной темноте и возникает 100% иллюзия просмотра как будто в кинотеатре. Плюс, дисплеи oled и засчет их миниатюрного размера плотность пикселей задрана до запредельных высот. Если не ошибаюсь, у этого Sony HMZ плотность пикселей составляет 2097 на дюйм. Причем, дисплей меньше самого дюйма по диагонали, 0.71' inch. Для сравнения, в современных VR средние PPI (плотность пикселей) составляет всего 600. И это на «смартфонном» экране 5.5" дюймов. Поэтому и видна так называемая «сетка».

В Cinema шлемах пикселей не видно, т.к. PPI в несколько раз больше и угол обзора в два раза меньше. Т.е. даже вот этот Sony HMZ 2011 года выпуска с разрешением 1280х720 по просмотру кино с легкостью даст фору распиаренным современным Pimax'ам 8К.

Так вот. С приходом VR на Западе внезапно начался бум на 3D в Китае.

qz.com/940399/americans-are-over-3d-movies-but-hollywood-hasnt-got-the-memo

И так получилось, что Sony Semiconductor ровно к тому времени, уже в 2016 году, выпустила новые micro-oled, сделали FullHD (1920x1080).

www.sony-semicon.co.jp/products_en/micro_oled/products/index.html

Китайцы, не долго думая, на таких радостях, у себя там взяли и «перезапустили» Sony HMZ и назвали новоиспеченный девайс — QMER V1. Продавался только у них на родине, по какой-то причине (не знаю по какой) проект провалился, на данный момент бред полностью мертв. Но начало было положено…

В 2017 компания вышеназванная компания NED Optics выпустила шлем Goovis G1. Отличная комфортная эргономика, легкий вес всего 200 грамм, независимая аппаратная регулировка межзрачкового расстояния и независимая аппаратная регулировка диоптрий (от -2 до +8), т.е. люди с плохим зрением могут смотреть фильмы без каких-либо очков или контакных линз. В шлем, чтобы совсем идеально было, даже запихнули очень тихие маленькие вентиляторы, линзы не запотевают. И в комплект доложили компактный автономный пульт упарвления на Андроиде. С кнопками, встроенной батареей на несколько часов, Wi-Fi, BT, MicroSD, встроенная память, полноценный разъем USB и аппаратный выход HDMI. В общем, все чего не хватало Sony HMZ, все исправили и даже с хвостиком. Минусов было два. Один не значительный, версия андроида старовата 4.4. И второе минус существеннее, шлем поддерживал 3D в формате только Side-By-Side. Впрочем, учитывая еще большую плотность пикселей (PPI здесь уже 3147), честно сказать, даже стереопары выглядят так, что закачаешься. Ну и опять же, минус относительно блю рей 3D, для сериальчиков/фильмов и стереопар вполне хватает.

Через год появилась модель Goovis G2. Пришли на западный рынок, собирали краундфаундинг на IndieGoGo. Все тоже самое, увеличили внутреннюю память до 32Gb (против 16Gb у предыдущей модели) и добавили на пульт управления тачпад. Внезапно, тачпад. Отличное решение, можно подключиться к Wi-Fi и в шлеме свободно серфить инет. Впрочем, ОС стоит Андроид, можно и так приложений накачать (Youtube, Netflix и т.д.).

Паралельно вышли еще шлемы от производителя HiSpot. Версии H1 и последующая H2. H1, опять, стартовала только в Китае, а вот H2 уже появился на западных интернет-площадках. В нем аналогично сонивские micro-oled, но отличительной особенностью стал увеличенный FOV. Я так на глаз прикидывал, ориентировочно 65 градусов выходит. Субъективно экран воспринимается как IMAX, стандартные же Cinema шлемы воспринимаются как небольшой кинотеатр. В HiSpot H2 сделали аналогичный пульт управления, только более навороченный. Андроид 5.1 уже, плюс USB 3.0 и USB Type-C. К тому же, в этой версии андроид умел воспроизводить BD3D iso… но, шлем тоже Side-By-Side. BD3D iso лучше смотрится, чем стереопары. Так подозреваю, китайцы как-то извратились и умудрились запихнуть полный фрейм с BD3D в Half-SBS. Ну я так полагаю, а там как оно на самом деле, неизвестно.

В этом шлеме я реально прифигел еще над одной штукой, китайцы сделали очень мелкие, еле заметные програмные цифровые часы в верхнем правом углу экрана, которые каждые полчаса появляются на пару секунд во время просмотра фильма (оверлей эдакий, поверх) и также моментально исчезают (вот реально еле заметные, «поймал» их только спустя месяц использования шлема, думал что там мелькает иногда, мерещиться что ли). Но этих пару секунд хватает, чтобы успеть кинуть быстрый взгляд и понять сколько время. Вроде мелочь, но в своей простоте абсолютно гениальное решение. Можно смотреть фильм и контролировать время во внешнем мире: -Ага, 18:30… надо собираться, потом досмотрю.

Просто молодцы, супер фича.

Вопреки всем указанным выше достоинствам, HiSpot H2 получился несколько противоречевый. Есть косяки по конструктиву, эргономике и главное, не очень хорошая оптика. Сложно подстроить под себя, замыливает изображение (наследие большого FOV, при таких микро-дисплеях качественные линзы сделать технологически очень сложно, иначе весь VR давно уже на микро-дисплеях был). Но вау-эффект, в целом, несравненно крутой. Большой экран, реально огромный, действительно впечатляет. Да еще и в 3D, пусть оно и половинчатое. Неискушенному зрителю, так вообще будет чудо из чудес.

Есть еще Cinema-шлемы, коротко напишу хештеги для поиска в гугле:

Royole Moon — 1080p, интегрирован вместе с наушниками. Потестить не довелось, насчет поддержки Frame Packed не могу ничего сказать.

Avegant Glyph — этот 720p, Frame Packed, по-моему, умеет. Из спешл фич, построен на какой-то там лазерной проекции (Laser Field Technology).

CINERA Dual 2.5K — выглядит страшно (детей отвести от экрана), но говорят реально два экрана в разрешении 2.5К. Но вроде LCD, не oled.

И в конце еще про один напишу, пока вернемся к Goovis.

Goovis Pro умеет Frame Packed, Side-By-Side, Top-Bottom. Поддерживает аппаратные Blu Ray плееры, всякие игровые приставки (3D игры работают) и прочее, куда можно воткнуть HDMI, определяется как 3D TV. Интерфейс HDMI 1.4a, я думаю, про него писать не надо. По резолюшену, как и писал выше, 1920х1080 и поддержка разнообразного количества Гц присущих спецификации 1.4а (основные просто напишу):

2D 1920x1080 50/60

3D 1920x1080 23/24

3D 1280x720 50/60 (3DVision да, работает)

3D идеальное. Черный цвет — черный. Для примера, если включить видео с letterbox, то черные полосы вверху и внизу полностью сливаются с окружающей темнотой, видно только само изображение самого фильма. Субъективно воспринимается как небольшой кинотеатр, картинка ровная, не дрожит, не дребезжит, никаких косяков, присущим поляризационным активным/пассивным очкам, нет. Зрение не устает, голова не болит. Свободно и без проблем высиживаю трехчасовые фильмы без перерывов (буквально три дня назад за один заход, наконец-то, посмотрел Blade Runner 2049, 2.5 часа, в конце снял шлем, ушел курить и думать). По комфорту нареканий нет, засвет снизу практически отсутствует, можно без проблем смотреть фильмы в дневное время, будет абсолютная темнота внутри.

3D в таких шлемах все идет «в глубину», смотришь будто в портал. Никаких, так называемых, дешевых «вылетов», когда клюшкой от гольфа тыкают прямо в лицо, в них нет. 3D смотришь и глаза радуются, без вот этой вот мишуры отвлекающей. В 3D все фильмы выглядят отлично, независимо, сконвертирован он или Real 3D. Что ни включишь, все классно, все здорово.

3Dvideo Автор

22.02.2019 14:00Я догадывался, что будет интересно, но не думал, что настолько! ))) Огромное спасибо, что все так подробно!

Я тоже в декабре смотрел свежие шлемы на выставке и был впечатлен прогрессом по качеству даже по сравнению с прошлым годом. Но специализированных киношных там не было.

Вот, как я понимаю G2, www.amazon.com/Virtual-Reality-Theater-Glasses-Advanced/dp/B074DXWG12 но на картинках указан 3147ppi. Чужие картинки?

И, как я понимаю, народ только цена сдерживает. За такие деньги можно хороший проектор с экраном купить и более привычный домашний кинотеатр сделать. Но с ваших слов качество 3D выше всяких похвал, т.е. народ, который может себе позволить, просто не распробовал пока? )

ED-209

22.02.2019 05:17Насчет софта… вот, к сожалению, под рукой только ноутбук с NVidia 1060 и HDMI 2.0 в виде output. Это кошмар, сильно жалею, что нет аппаратного BD плеера или, на худой конец, завалявшейся PS3 в виде крутилки BD3D. Не с чем сравнить софтовые настройки. Т.е. было бы hardware под рукой — ага, вот эталон, кручу под него. А так сложно. Windows 10 + особенно NVidia + особенно HDMI = адово гремучая смесь. Плюс, на самом шлеме никаких настроек нет, только кнопки переключения режимов 3D и кнопки увеличения/уменьшения яркости. И, соответсвенно, шлем из Китая, про всякие 3DLUT, так понимаю, можно забыть. Калибровать приходится на глазок (а сравнить-то и не с чем).

В итоге, две недели мучался с виндой и сочетанием NVidia+HDMI (все еще тот старый прикол, когда по дефолту в NVidia стоит HDMI Range Limited, AMD таким не страдает) плюс нет уверенности в адекватных color profile самой Windows, т.к. про чудеса оные тоже понаслышан. Мучался-мучался, то пересвечено, то слишком темное изображение. И еще там встроенная Intel ходит рядом и посмеивается: -а у меня тоже в драйверах стоит автоконтраст и «улучшалки» видео, не забудь выключить…

Короче плюнул, перенакатил винду, чтоб с чистого листа, апнулся до версии 1809 и аккуратно обновил Nvidia дрова на последние DCH. Смог впихнуть в ноут утилиту ASUS Splendid Video Enhancement, устроил разнос виндовым color профилям, осторожно переключил HDMI Range 0-255 и все стало хорошо. Почти-почти хорошо.

В качестве BD3D софтового плеера использую JRiver Media Center + MadVR. Конфиг на i5 + 1060 6Gb позволяет более менее нормально тонко тюнить изображение. Хотя там разбираться и разбираться, все еще в стадии поиска идеального изображения. Впрочем, после всех экзекуций мне и PowerDVD выдал отличную картинку. Внезапно.

Есть другая проблема. Т.к. на всю морду лица светит здоровенный светящийся OLED (наверное, соразмерно 100" диагональ с двух метров), наблюдаю небольшой color banding. Как лечить, пока еще не знаю, если это возможно конечно. Может это фича шлема, oled'а (тоже самое наблюдал и на Goovis G2 и на HiSpot H2), какой-нибудь не той битности, не совпадения частоты с кадрами, наличие где-нибудь в недрах галочки «оптимизировать видео для быстродействия», да черт его знает что еще может быть, тысяча факторов. В играх вроде как все ок, видео иногда замечаю косяки. Может это и нормально, так и должно быть, не знаю. Нужна аппаратная железка, дабы точно убедиться в оригинальном качестве изображения. Но также, встречал мнение, что у Royole Moon вроде как такой проблемы нет, grayscale не сыпется. Непонятно мне с этим пока.

С другой стороны, сколько на тест-драйв не давал знакомым эту штуку, все в один голос говорят, что придираюсь и девайс абсолютно идеальный, лучше быть уже не может. Может и правда придираюсь. Продавал Goovis G2, так с руками оторвали, а это учитывая, что он 3D Half-SBS.

Про 3DVision.

Работает, но апскейлит 3D 720p@60Гц до 1080p. В принципе, с выкрученным на всю графонием в игре и принудительным Supersampling x4/x8 вполне прилично смотрится. Если вот конкректно только 3DVision хочется, то лучше взять Sony HMZ, там оригинальное разрешение 720p, пиксель в пиксель. Но для Sony HMZ желательно запилить кастомный Comford Mod, эргономика, конечно, плачевная у него…

В плане звука использую по настроению, либо наушники напрямую с ноута и DTS Headphone:X в качестве виртуальных 5.1, либо напрямую с самого шлема (есть выход 3.5" jack) по HDMI и тогда Dolby Atmos. Можно и дефолтный Windows Sonic for Headphones.

Как-то так, наверное. Все грядущие релизы BD3D уже отмечены в календаре с пометкой «Важно!».

item.jd.com/39909147130.html — Goovis Pro (версия Pro без андроид пульта)

www.goovis.cn/new_detail/407 — вот тут что-то написано про RGB 0-255 и YUV 0-255, но на китайском.

www.panelook.com/modelsearch.php?op=advancedsearch&order=panel_id&brand_family=124&inch_low=70&inch_high=71&resolution_pixels=8180 — спеки сонивских микро-олед. Какие точно стоят в шлеме, увы, не знаю.

И еще про один шлем хотел рассказать.

Через месяц на кикстартере стартует краудфаунд на Luci Immers. Аналогично, те же FHD очки для 3D/Video. Рассылка начинается в августе.

luci.one/immers-ks — Luci Immers

www.luci.one/immers/technology — спецификации.

У них первая особенность — интерфейс USB Type-C.

И вторая, заявлен FOV под 70 градусов. Это почти VR (VR стартует от 90 градусов и выше). Т.е экран будет ну очень большой. Здесь лишь бы с оптикой не налажали, больное место для микро-дисплеев.

Увы, пока не ясно, какие режимы 3D поддерживает. Надо ждать начало кампании, укажут или потенциальные бейкеры все с них моментально вытрясут.

В качестве постскриптума: такие очки 3D 1080p ждал 8 лет. С момента выхода Sony HMZ. Дождался. Клевые штуки, реально советую обратить внимание. О них мало кто знает, т.к. VR практически забило весь эфир. Но они существуют, как видите, и не в одном экземпляре. Китайцы, конечно, молодцы. Взяли вот и с легкой руки перезапустили линейку Sony HMZ. Причем, настолько в классном виде, что ранее даже и представить не мог: те же самые фирменные сонивские micro-oled, только уже FHD, отличная эргономика, легкие и удобные, прицепили компактный автономный пульт управления на всеядном Андроиде, тачпад, Wi-Fi, BT, USB, MicroSD, HDMI, аппаратная регулировка линз и диоптрий, и даже впихнули миниатюрные вентиляторы, чтобы линзы не запотевали.

Вот вам и китайцы, остается только восхищаться.

Pro-invader

22.02.2019 10:14Шикарный коммент, спасибо! Статью запилить не хотите?

ED-209

22.02.2019 12:26+1Спасибо. Думал об этом, но пока не протестирую с аппаратным Blu Ray плеером «вот именно так показывает, вот именно так вижу» — никаких статей )) Штука дорогая и для публичного освещения субъективная оценка а-ля «ну я там крутанул в драйверах насыщеность цветов +30% и картинка ваще клэ» не приветствуется. Эксперименты на базе ПК, без сравнения с аппаратными BD-плеерами, валидными не признаю. Но мысль про статью давно ходит, верно подметили :)

3Dvideo Автор

22.02.2019 14:25Готов с ребятами помочь со статьей! В том числе со сравнением.

Вам совершенно правильно пишут, у вас УЖЕ материала на хорошую статью достаточно.

Тема совершенно нераскрыта (везде VR HMD) и даже текущий материал будет безмерно интересен.

trir

22.02.2019 11:54У подобных шлемов FOV (угол обзора) составляет в среднем 45-60 градусов. Т.е. получается большой экран висящий в абсолютной темноте и возникает 100% иллюзия просмотра как будто в кинотеатре.

То есть экран не на всю область видимости?

Никаких линз Фринеля?

ED-209

22.02.2019 12:42Да, экран не на всю область. Так и должно быть. Вы же в VR смотрите видео не растянутое на 110 градусов, так будет каша на экране (за исключением специального 360-видео, конечно). И VR все смотрят фильмы, используя какое-то виртуальное окружение, образно говоря, используя какое-нибудь Virtual Theater IMAX приложение. И размер виртуального экрана, для комфортного просмотра, становится схож с такими же углами обзора 45-60 градусов. Только разница в том, что просматривая фильмы в VR вы их видите на виртуальном экране через физический экран с низким разрешением, а в подобных 3D-шлемах такой вот «виртуальный» экран сделан сразу на аппаратном уровне. Если в VR убрать рюшечки в виде 3D-антуража и оставить пустоту, общий смысл будет ровно такой же. Ровно также, как и если в 3D-шлем между линзами добавить трафарет в виде спинок кресел. В виртуальной реальности, можно сказать, софтовая имитация того, что Cinema шлемы делают аппаратно.

ED-209

22.02.2019 13:24Какие линзы стоят, к сожалению, не подскажу. Надо спецификации смотреть, если еще и будет там указано. Так вот, из опыта, каких-то хроматических аббераций или искажений оптики, совершенно нет. Там все корни растут с Sony HMZ, а он позиционировался для премиум-сегмента (маркетинг: мужик летит в самолете в бизнес-классе и смотрит фильм в Dolby Surround 5.1, 2011 год) и какие-то проколы с линзами, на мой взгляд, были совершенно недопустимы. :)

3Dvideo Автор

22.02.2019 14:22кнопки переключения режимов 3D

Крайне интересно! Что поддерживается?

Короче плюнул, перенакатил винду, чтоб с чистого листа, апнулся до версии 1809

Да-а-а-а! Это эпично!!!)

Вот вам и китайцы, остается только восхищаться.

Ну у них по ряду причин интерес к 3D не падал. В итоге сейчас многие фильмы реально конвертируются в Китае, около десятка компаний (!) производит лазерные 3D проекторы и т.д. Во некоторых областях они скоро будут конкурировать в основном между собой.

3Dvideo Автор

22.02.2019 14:37наблюдаю небольшой color banding. Как лечить, пока еще не знаю, если это возможно конечно.

если шлем берет больше 8 бит на компоненту (что поддерживается с HDMI 1.3) и нормально отдает на oled, то появляются шансы, там самый простой способ — зашумляются младшие биты, более сложный — изменение контента. Со вторым можно поэкспериментировать, это нам ближе ), ибо железо сегодня часто отстает.

denisshabr

21.02.2019 12:05Можно всё сразу завернуть?

Правда, не понимаю, почему мечуться между этим по отдельности, это всё сразу нужно и важно. И 3D, и HFPS (в идеале 120fps), и разрешение. Помню как смотрел Аватар в Imax Капитолий в 2010, и мне не хватало 2 из этих 3 компонентов — видел сплошные пиксели (нехватка разрешения) и стробоскоп (древние убогие 24fps).

3Dvideo Автор

21.02.2019 12:50Вообще в Москве 4К 3D залов очень мало. Помнится пару лет назад всего 4 штуки было (не помню точное число, но что очень мал процент по сравнению с Европой, США или Китаем — это однозначно).

И пипл не очень сильно различает разницу (что 2К, что 4К — все едино), поэтому владельцам залов нет большого резона обновлять оборудование на более дорогое.

denisshabr

21.02.2019 17:09Так тут даже 4k 2D контента то почти нет, весь мастеринг идёт в 2k. То же самое и с 3D, пока слишком мало честного 4k. Может лет через 5-10 раскачается. А 4k/3D/120fps (или даже хотя бы 48fps) вообще лет через 20-30 завезут, судя по инертности мышления киносоздателей.

3Dvideo Автор

21.02.2019 19:071. К счастью не весь.

2. Это не инертность. Это деньги — прямые затраты. Люди реально не слишком готовы платить больше за новые технологии. Соответственно никто не торопится ставить новые 4K яркие HFR проекторы. Как следствие — медленно вкладываются деньги в новое производство.

oracle_and_delphi

20.02.2019 06:22В Аватаре — при всех достоинствах фильма, 3D — ужасное! Всё что не в центре кадра — в жутком мыле, которое ест глаза. :(

Когда мимо взгляда пролетает 3D-бабочка — взгляд пытается на ней сконцентрироваться, но обнаруживает, что камера сфокусированна на другом — а бабочка является мутным 3D-пятном. :(

3Dvideo Автор

20.02.2019 09:31С точки зрения технического качества (геометрия между ракурсами, разница фокуса, цвета, параллаксы и т.д.) — Аватар — лучший фильм на тот момент по сравнению с кучей предшественников.

Даже если брать такие сложные параметры как плавность изменения глубины — до Аватара все было намного хуже (в первую очередь потому, что глубину менять не умели):

На графике метрика плавности изменения глубины между сценами (один из пары десятков параметров, влияющих на комфорт восприятия 3D фильма). Чем выше — тем лучше. Зеленый — 30% лучших фильмов на этот момент времени, красный — 30% худших. Аватар обозначен пунктиром. Перед ним были фильмы кардинально хуже.

И такая ситуация по большинству метрик.

Из хороших новостей — постепенно ситуация улучшается. Медленно )

vconst

20.02.2019 12:15По сравнению с Хоббитом в HFR — Аватар жалкая наколенная поделка.

3Dvideo Автор

20.02.2019 20:04То, что позднее качество стало еще выше — кто бы спорил. ) Конечно! Это прямо из графика следует.

Просто на тот момент это был эффект разорвавшейся бомбы — типа а что, так хорошо тоже можно? ) И меньший процент зрителей, жаловавшихся на головную боль реально сильно помогли сделать бокс-офис.

zerg59

20.02.2019 10:47Точно. Пока ты фокусируешься на том, что задумал режиссёр — всё нормально. Как только начинаешь смотреть по сторонам — у мозга срывает шаблон: «отказ системы фокусировки. Возможная причина — загрязнение поверхности. Надо смыть»

3Dvideo Автор

20.02.2019 20:07Сейчас сильно мешает, что они вынуждены снимать одну версию и для 2D, и для 3D.

При этом для 2D управлять вниманием зрителя с помощью очень малой глубины резкости — норма (и даже красиво), а в 3D — лучше делать максимальную глубину резкости, ибо куда смотреть человек понимает исходя из трехмерности сцены.

И потенциально это еще один огромный плюс пленоптики!

Можно делать 2D и 3D версии — с разной глубиной резко изображаемого пространства!

Для текущего производства это слишком дорого.

excentrisitet

19.02.2019 12:59А как дела обстоят с фундаментальными ограничениями, такими как квантовая эффективность? Ведь даже если мы достигнем заветных 99%, то проблема с размером всё равно остаётся: «Чем больше, тем лучше».

В телефонах нынче стоят матрицы с размером пикселя 1-2 микрона. При этом длина волны красного света 0,7 мкм. То есть делать разрешение ещё выше — бессмысленно, т.к. мы упираемся в волновой предел. Ну и в крупный пиксель, банально напа?дает больше фотонов, чем в маленький. То есть разрешение, которое может выдать телефон при переходе на пленоптику с четырьмя пикселями наверное в лучшем случае «не ухудшится», но вряд ли улучшится.

Ну а большие девайсы для больших фильмов, возможно станут раза в 2-4 поменьше, что конечно тоже не может не радовать.

Получается, что я немного более осторожен в оценке перспектив, но возможности и правда завораживают. :) Спасибо за статью!

3Dvideo Автор

19.02.2019 13:15разрешение, которое может выдать телефон при переходе на пленоптику с четырьмя пикселями наверное в лучшем случае «не ухудшится», но вряд ли улучшится

Но если такой телефон будет давать для ARCore в реальном времени реальную карту глубины — сенсору многое простят, ибо качество AR будет другого уровня.

А про то, как поднимать разрешение смартфонов и как это делается сейчас была прошлая подробная статья. И там далеко не все резервы (смартфонами) использованы ) И просто с ростом вычислительной мощности на борту уже можно будет улучшать результат.

SADKO

19.02.2019 13:54А вы посчитайте дискретность этой реальной карты глубин в зависимости от расстояния в системе с одним объективом…

… в ней есть конечно свои плюшки, но они больше в микроскопии актуальны

3Dvideo Автор

19.02.2019 17:11Ставлю на AR, как на драйвер. Шансы на волну велики скорее всего с Pixel 4 (если успеют на железо ускорение положить).

На юбилейной десятой Stereopsia (которая по подзаголовку вся из себя 3D/AR/XR) в прошлом году были оч интересные доклады на эту тему.

EobardThawne

19.02.2019 13:11Но ведь на смартфон чисто физически уже невозможно сделать сенсор меньшего размера и с улучшением качества из-за простой физики света, на смартфоне сейчас нельзя сделать сенсор такой же как и в тушках фотиков. Разве нет?

oracle_and_delphi

19.02.2019 13:28на смартфоне сейчас нельзя сделать сенсор такой же как и в тушках фотиков. Разве нет?

Видел смартфоны с сенсором как на тушках фотиков.

Но они, увы, не очень продаются как недостаточно плоские. :(

Но, технология из этой статьи позволяет создать большой и плоский фасеточный сенсор.

SADKO

19.02.2019 13:30Да, ребят, уж от кого, а от вас я не ожидал столь восторженного опуса, ведь тут можно многое рассказать по сути, и на бумажке посчитать, как в области больших кино-камер, так и мааленьких сенсоров, у которых правда свои проблемы и своя математика, и причин для восторгов тут нет, растры камер победят, а в потребительских устройствах, это будут ещё не регулярные растры, но не суть…

Будем считать, что вы в курсе, но имеете какой-то резон не палить тему пред лицем вездесущих китайцев.

Я тоже от части промолчу, однако всех практически заинтересованных техникой, математикой и маркетингом данного вопроса, милости прошу ко мне в личку, договоримся, всё что знаю расскажу, покажу, а может и присоединюсь ибо тема сия мне интересна. В прочем умников, раскуривших тему в объёме не сравнимом с литрой не так уж и мало, это-же прикольно…

Литра изначально была мёртворождённой, лишь доказав тезис что математику надо знать и любить, и против неё ну никак не попрёшь. Осознали, сделали нормальную камеру с мозаикой матриц и охладом, которым они пытаются отбиться от некоторых технических проблем сопровождающих такое решение.

Банальные алгоритмы чувствительны к шумам и нелинейностям, а не банальные я и не знаю, раскурили-ли они их, там многие проблемы автоматически решаются. Короче, камера исполин, в некоторых своих качествах не разу не эквивалента микроскопам и даже той, первой, насадке на фантом!

Ребята, серьёзно, если синема-литра так крута, то на фига ей лидар, а?

Но дело, даже не в этом, я ведь тоже кинематографист по образованию, и пообщавшись в роли консультанта с некоторыми "«пионерами» 3D" узнал от них о другой стороне монеты. Наше хорошее, честное стерео, оказалось не нужным, даже с учётом наших знаний, за которые в прочем не плохо тогда заплатили.

Дело в том, что между кино и театром, разницы бездна, и начать надо с того, что кино язык подразумевает сознательное управление точкой зрения зрителя. А эффект присутствия, погружения, для кино всего-лишь эффект, который можно получать дозировано, когда это надо, самыми различными средствами. Ну не нужно в кино переводить фокус постфактум, там каждая сцена, каждый кадр осмыслен, описан и выстроен в сознании опер.поста и режиссёра ещё до съёмки!

Постфактум был-бы интересен на ТВ, и для всяких концертов, театральных постановок итд, НО там обратная задача, как раз-таки присутствие, зритель пересматривает один и тот же концерт, замечая в нём разные детали, тут и стерео за глаза, ну можно несколько ракурсов сделать, и классно…

Короче, сочетание скоростной камер\ы с трэкером\роботом, лидаром и хромакеем, вполне решают большинство проблем современного кино продакшена, про возможность ручной\автоматизированной обработки потока я вообще промолчу. Маркетинговый посыл литры, такой-же как когда-то у меня, что мы запечатлеваем реальность, и можем чего огого… Но ответ Голливуда в том, что у нас тут волшебный мир кино, и реальность не нужен, родной ;-( Как говаривал Джордж Лукас, а у меня лазеры пшикают!

Так-что будущее кино, скорее в изучении потоков данных моушн кэпчи для синтеза идеальных актёров, а вундервафли при всей моей любви к пленооптике, есть гораздо более рациональные и продуктивные пути поиграться с ней (где патенты литры нафиг не упали)… И есть ограниченная область куда это можно продать, на ТВ-бы «пленооптика», а точнее математика из неё, очень-бы пригодилась в виде компактного, законченного решения, но опять-же с оговорками о целях и смыслах.

3Dvideo Автор

19.02.2019 14:17Ждал вас, отличный комментарий, спасибо! )

Ситуации, когда даже (а то и в первую очередь) профессионалы соответствующей индустрии в штыки воспринимают новые технологии — это норма. Далеко ходить не надо — я сам еще совсем недавно нейросети в обработке видео воспринимал предельно скептично (и на то были и остаются серьезные основания). Давно думаю написать про экспоненциальные процессы — это ситуации, когда подавляющее большинство специалистов неверно прогнозируют события. Примеров уйма в куче областей, от первых турбин реактивных самолетов до сопротивления электромобилям, альтенативной энергетике и нейросетям в программировании ) Это нормально! )

Литра изначально была мёртворождённой,

У Лайтры полный комплект всех врожденных заболеваний стартапов Кремниевой. В первую очередь разгон финансирования вперед развития продукта. От чего, собственно, и наблюдается бешеная смертность стартапов. У Теслы проблемы того же рода и далее список длинный.

Я спокойно к этому отношусь. Свою роль они играют. А Карафин не зря ушел из Lytro почти сразу после получения ими очередного транша денег (!) )))

синема-литра так крута, то на фига ей лидар, а?

Все просто. У нее же глубина из стерео. Т.е. как только текстура стала слабо выраженной (по контрасту) ошибка в определении глубины зашкаливает и начинаются проблемы. А лидар наоборот идеален для ровных поверхностей. Они очень хорошо дополняют друг-друга, особенно учитывая что лидар дает слабый FPS.

у нас тут волшебный мир кино, и реальность не нужен, родной

Это да, так и есть ) Но спецэффекты быстро и дешево они хотят. И сейчас рентабельность фильмов в среднем падает, а рентабельность сериалов сериалов растет и в технологии ускорения спецэффектов пошло финансирование.

математика из неё, очень-бы пригодилась в виде компактного, законченного решения, но опять-же с оговорками о целях и смыслах.

Да, массовый продует точно будет не в сфере кино ).

Сейчас интересная тема — промышленные роботы, но там велика конкуренция со стороны сенсоров других типов. Хотя когда что-то многоуровневое и полупрозрачное — пленоптические рулят пусть и рынок пока невелик. Это позволяет развивать сенсоры.

SADKO

19.02.2019 15:56Я не в штыки, я-то вообще большой был фанат, этого дела, и руки у меня впереди головы были, но мои преподаватели которые с пленооптикой реально дела имели (но это секрет), и считать меня учили, и настаивали что бы я считал перед тем, как что-то делать, и большое им за это спасибо. Так что несмотря на то, что я игрался с тем-же самым фантомом, пробовать на нём пленооптику я не стал, хотя и технологическая возможность была. Овчинка выделки не стоила, чего не скажешь про многоракурсную съёмку\проекцию, в связи с которой пленооптика опять-же вспомнилась и…

К обработке сырых данных с пленооптической камеры или растра камер, можно подходить по разному, на качество работы того или иного подхода сказывается качество изготовления системы в целом, ну и выбранная схема конечно. Бытовая пол-литра была в этом плане была редкостным трэшем, почему я и говорю, что она мёртворождённая, тут и простых геометрических каракулей на бумажке и школьной математики достаточно что-бы это понять. Да и прототип\дипломная работа из фантома, как-бы намекала. На что надеялся автор? Понимал ли он? Тут всё не так просто, как кажется.

Вундервафля хороша, в теории, но на практике там есть куча особенностей реализации, от оптики и железа до методов кода, что я-бы не стал строить иллюзий. Да, тут нужен, широкий технический кругозор, да… А что-бы продать продукт, тут чисто технического кругозора мало!

Трэнд к удешевлению, на лицо, я помню как люди места в очереди за первым рэдом продавали, при том, что это было редкостное… А нашествие Сапогов на ТВ продакшены, к чёрту дорогие тв камеры и реальный FullHD, да здравствует мыло в h264 ;-) Вы, точно видите мегаЛайтру в этом ряду?

Если поговорить про эффекты, то обратите внимание как в оптическом потоке камера трэчатся и моушен кэпчится, да это можно сделать круче но нафига. А ещё вместо того что бы трэчить камеру, её можно к старому, списанному, промышленному роботу прикрутить, он сильный и света потянет вписывая живых актёров в 3д декор…

ps.а с картой глубины, это смотря для чего мы её хотим, тут есть варианты, почему мне и думается что это костыль, который и на обычную камеру можно нацепить, (и цепляют-же)как и охлаждение (которое не ставят потому-что пока не надо, хотя есть отдельные образцы)…

3Dvideo Автор

19.02.2019 17:18К обработке сырых данных с пленооптической камеры или растра камер, можно подходить по разному, на качество работы того или иного подхода сказывается качество изготовления системы в целом

Кто бы спорил!

Собственно этот пост появился не благодаря Lytro, а благодаря Google, когда стало понятно, что можно сделать сенсор ОЧЕНЬ качественно и при этом пленоптическим. И маленьким. И массовым.

Вы, точно видите мегаЛайтру в этом ряду?

К сожалению, точно. Именно из-за удешевления при качестве, которое устроит пипл. И тут можно только возглавить процесс, попытавшись поднять качество (благо там есть огромные резервы).

А ещё вместо того что бы трэчить камеру, её можно к старому, списанному, промышленному роботу прикрутить

А удобство использования на площадке?)

а с картой глубины, это смотря для чего мы её хотим, тут есть варианты, почему мне и думается что это костыль, который и на обычную камеру можно нацепить

Пока идет к тому, что глубина будет мастхэв фича.

MaxDamage

19.02.2019 18:38Будем считать, что вы в курсе, но имеете какой-то резон не палить тему пред лицем вездесущих китайцев.

Кроме китайцев, как полагаю? )))

Я тоже от части промолчу, однако всех практически заинтересованных техникой...

А если серьезно, что там можно «спалить» в посте на несколько тысяч слов? Деталей не расскажешь, а идеи не патентуются.

Gryphon88

19.02.2019 14:331. Можно для самых тупых: зачем нужны микролинзы по одной на пиксель, и нельзя ли их заменить апертурами?

2. Про глубину: допустим, мы снимаем под водой коралловый риф через течение. Можем ли мы по одному кадру лайтры восстановить неоднородность плотности среды между объективом и объектом, получить трёхмерную карту фазовых сдвигов и сделать трассировку?

3Dvideo Автор

19.02.2019 17:001. Нельзя )

2. Не можем )

Там возможно много чудес, но они не произвольны

AngReload