Дискретная видеокарта начального уровня Intel Graphics Xe, официальный анонс состоялся 20 марта на игровой конференции GDC 2019

Компания Intel опубликовала документацию на графические процессоры Gen11 с описанием, чем они будут отличаться от предыдущего поколения. Ожидается, что архитектура Intel Gen11 станет основой для будущей архитектуры дискретной видеокарты Xe, поэтому описанные здесь технологии можно рассматривать как предварительный просмотр по крайней мере некоторых функций, которые реализуют в этих видеокартах. Пока что о будущих видеокартах Intel ничего не рассказывала, только показала несколько фотографий (или рендеров).

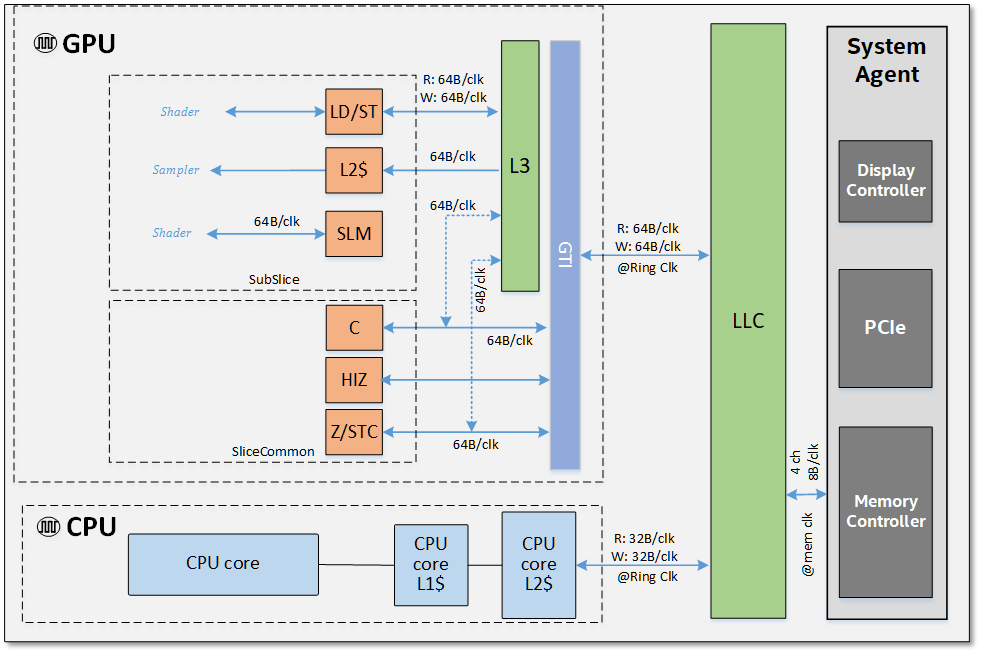

Архитектура процессора Intel Core, системы на кристалле (SoC) и кольцевой системы внутренних соединений (Ring Interconnect)

Исторически сложилось так, что графические процессоры Intel среднего уровня GT2 для настольных компьютеров и некоторые мобильные чипы уступали по производительности чипам от AMD. В таких сравнениях Intel исторически получала преимущество за счёт более мощного процессора по сравнению c APU, производными от микроархитектуры AMD Bulldozer. Теперь ситуация изменилась. Ryzen обладает гораздо более эффективным процессорным ядром, а мобильные процессоры AMD Ryzen гораздо более конкурентоспособны с Intel. Поэтому последней необходимо что-то предпринимать, в том числе решать проблему с производительностью GPU.

Детальная блок-схема Gen11

По технической документации сложно судить о производительности Gen11. Но некоторые специалисты считают, что Intel сможет гораздо эффективнее конкурировать с AMD. По крайней мере эффективнее, чем когда-либо прежде.

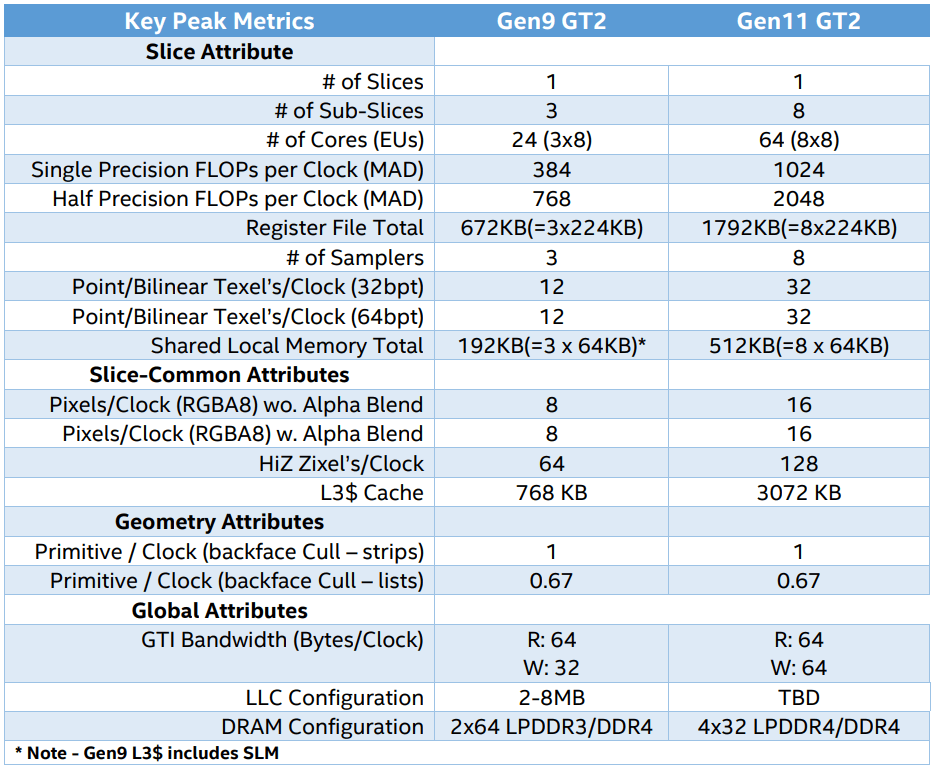

В новой архитектуре Intel GT2 предусмотрено 64 блока исполнения команд (EU, execution unit) по сравнению с 24 блоками в процессорах класса Skylake. Это значительное расширение ресурсов на чипе должно улучшить общую производительность по сравнению с предыдущим поколением. В таблице ниже приведены сравнительные характеристики графических подсистем Gen9 и Gen11.

Ключевые метрики Gen9 и Gen11

Исходя из технических характеристик, производительность вычислений в Gen11 вырастет примерно в 2,67 раза, как и пропускная способность для текстур (texture sampling). Пропускная способность блоков растровых операций (ROP) удвоилась, как и количество тестов high-Z за такт.

Кэш L3 увеличился в четыре раза, а пропускная способность GPU на запись удвоилась до 64 байт на такт. Пропускная способность памяти при использовании DDR4 должна остаться такой же, но поддержка LPDDR4 теоретически допускает более высокие тактовые частоты.

Кэш последнего уровня используется совместно GPU и CPU, чтобы сократить трафик с перемещением данных. Блоки видеодекодера улучшены для уменьшения битрейта. Они позволяют осуществлять одновременное декодирование нескольких потоков 4K и 8K. Добавлена поддержка адаптивной синхронизации и улучшенное декодирование HD-видео.

Теперь у GPU общая локальная память, которая не блокирует доступ к кэшу L3 при чтении. Intel утверждает, что это снижает задержку и повышает эффективность «атомарных операций».

Иерархия памяти на уровне микросхемы SoC и её максимальная теоретическая пропускная способность

Intel утверждает, что значительно улучшила общую пропускную способность памяти в Gen11.

В документации описано две новых технологии, которые Intel реализовала в графическом ускорителе:

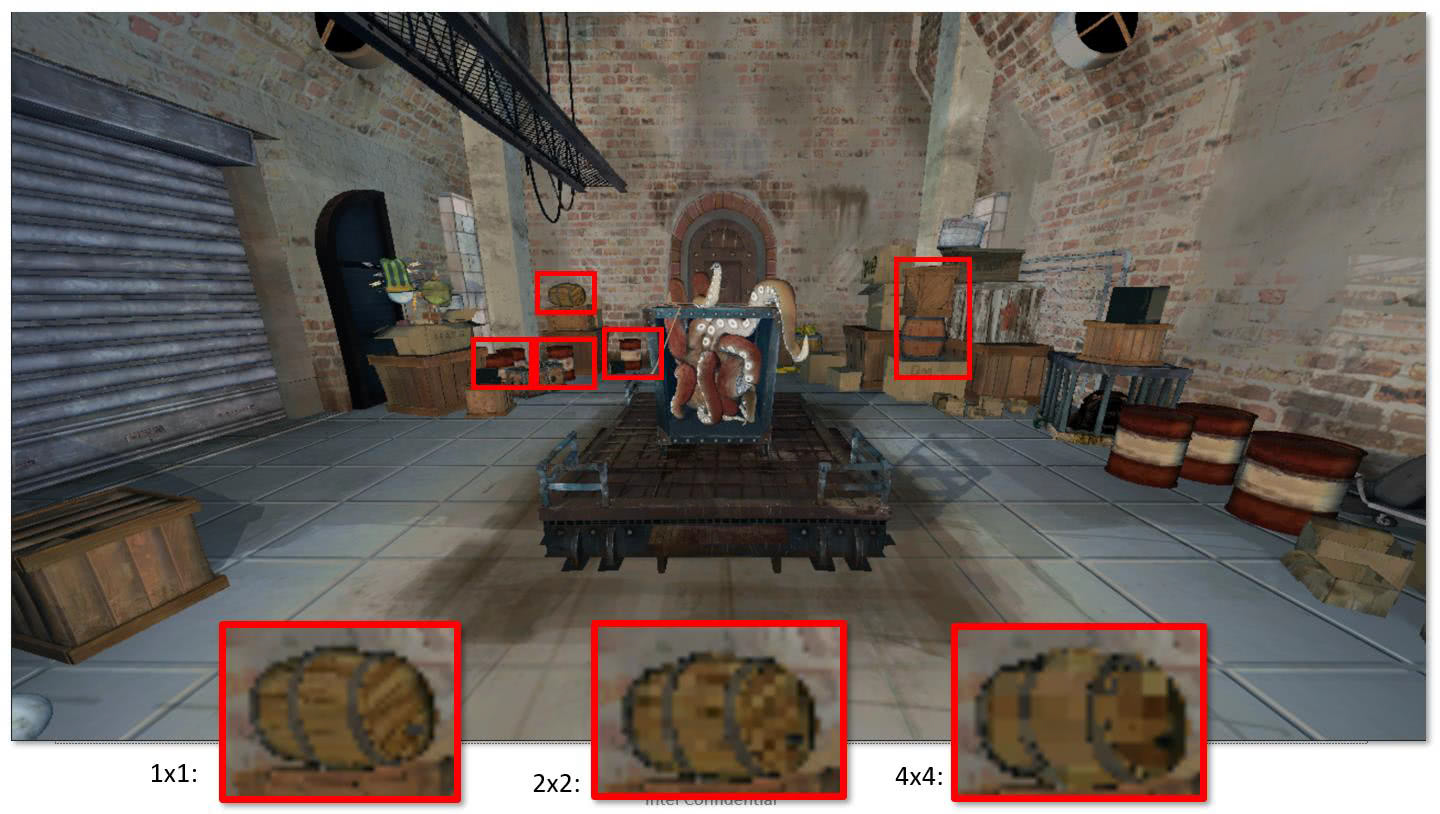

- грубое затенение пикселей (Coarse Pixel Shading, CPS);

- затенение по позиции (Position Only SHading, POSH).

Грубое затенение пикселей снижает нагрузку на GPU, уменьшая количество цветовых сэмплов, которые используются для рендеринга изображения. Скриншот иллюстрирует, что CPS практически не отражается на качестве рендеринга.

Кадр из игры Citadel 1 в разрешении 2560?1440 (слева pixel rate 1?1, а справа 2?2). Хотя грубое затенение пикселей уменьшает количество вызовов шейдеров, на дисплее с высокой плотностью пикселей практически нет заметной разницы. Для сравнения показано также масштабированное изображение без применения сглаживания, в разрешении 1280?720

Уменьшение количества вызовов пиксельного шейдера экономит энергию и повышает производительность, то есть частоту кадров, на 20-40%.

На этом изображении объекты в красных рамках идентифицируется как достаточно удалённые от камеры и имеющие небольшое значение для общего качества изображения, поэтому детализацию можно уменьшить без заметного влияния на качество изображения с последующим повышением фреймрейта

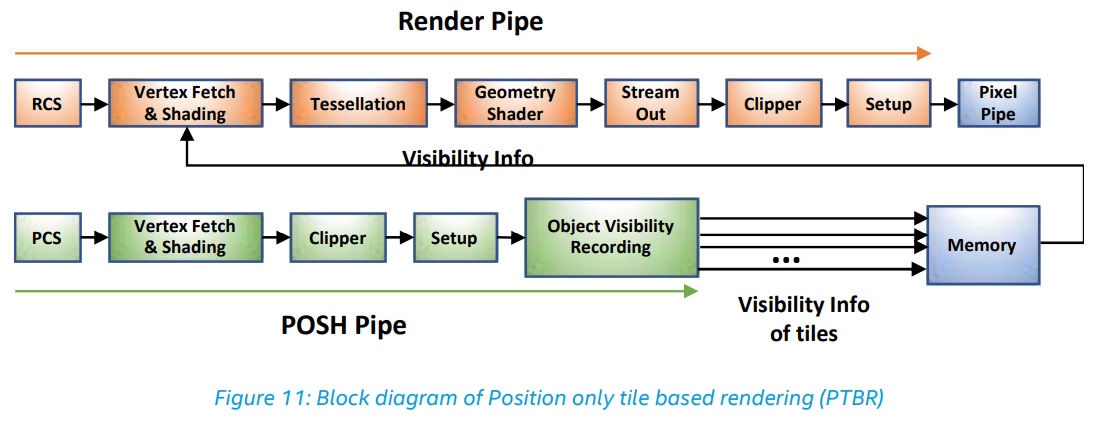

Конвейер POSH запускает позиционный шейдер параллельно с основным приложением, что обычно позволяет генерировать результат намного быстрее, сказано в документации. Это часть системы рендеринга по позиции тайлов (Position Only Tile-Based Rendering, PTBR).

В целом, Gen11 станет значительным обновлением для процессоров Intel. Первые два поколения AMD Ryzen Mobile конкурировали со слабой графикой Skylake. Третьему поколению Ryzen Mobile APU, когда бы оно ни вышло, придётся конкурировать с гораздо более мощным чипом Intel, пишет издание ExtremeTech.

Комментарии (41)

km2

23.03.2019 18:41Представляю как через пару лет геймерам усложнится работа по выбору производителя видеокарт. Вместо 2-х производителей будет три!

RusikR2D2

23.03.2019 18:53+1Больше — лучше, т.к. конкуренция, есть шансы на более быстрое развитие и снижение цен. В свое время производителей чипов было гораздо больше и цены (относительные) были доступнее.

red_andr

23.03.2019 19:22+4Эх, были же времена, когда на рынке было аж как минимум пять равноценных производителей:

Куда все делись?

Eldhenn

23.03.2019 19:46Вуду, помнится, вложился в какой-то жуткий долгострой — и не сумел. Про матрас говорили, что он вообще плохо в 3D умеет.

Exchan-ge

23.03.2019 20:03Про матрас говорили, что он вообще плохо в 3D умеет.

Его любили не за это.

Но после того как нормальный 2D научились делать все производители — карты Matrox стали архитектурным излишеством.

3dfx же был хорош только тем, что был первым. Кстати, с 2D и у него были проблемы (у меня одномоментно были 3dfx Voodoo 3 AGP и Matrox Millennium G400 DualHead AGP — по 2D вуду сливала подчистую)

red_andr

23.03.2019 20:54Судя по этому тесту Матрокс очень даже неплох был в 3D, по крайней мере лучше TNT2. Правда, насколько помню, с драйверами и OpenGL у них были проблемы.

Exchan-ge

23.03.2019 21:27Судя по этому тесту Матрокс очень даже неплох был в 3D

Это Millennium G400 MAX — разогнанная версия G400.

Редкая и дорогая карта, которую можно было увидеть только в обзорах.

При том, что и простая G400 была не из дешевых.

bugdesigner

24.03.2019 08:22Во времена аналоговых (ЭЛТ) мониторов Matrox считался эталоном качества у фотошоперов. Считалось, что он имеет самую точную цветопередачу, что особенно ценилось дизайнерами и фотографами того периода.

Exchan-ge

23.03.2019 19:56+1Куда все делись?

S3 сейчас входит в HTC Corporation, ATI в AMD, 3dfx в NVIDA, сама NVIDA жива и здорова — да и Matrox все еще существует (https://www.matrox.com/graphics/en/)

red_andr

23.03.2019 20:47+1Вопрос был риторический ;)

Проблема в том, что реально на рынке 3D карт осталось только два производителя после всех этих поглощений. А Матрокс схлопнулся в узкую ложу вне этого рынка.

Exchan-ge

23.03.2019 21:22Проблема в том, что реально на рынке 3D карт осталось только два производителя после всех этих поглощений.

Три.

Видео Интел почти в каждом компе. Ну, или какая у них там доля на рынке материнских плат.

red_andr

24.03.2019 07:54+1Ну, строго говоря, Интел 3D видеокарты не делает, только интегрированные решения, не важно в чипсет или сам процессор. Так что не в счёт. А так то да, доля его велика, но просто потому, что фактически бесплатное.

Tyusha

24.03.2019 17:12+1Когда-то Интел любила понтоваться на Intel Developer Forum, вопрос в зал: «кто больше всего мире производит графических процессоров». Типа правильный ответ на тот момент был не nVidia или ATi, а Intel за счёт интегрированных карт.

Exchan-ge

24.03.2019 23:18Так что не в счёт

Ну как же «не в счёт», когда в большинстве новых десктопов никогда не было и не будет дискретной видеокарты.

rPman

23.03.2019 21:43+1Еще есть видеокарты, идущие с arm soc… там несколько производителей но конкуренцией это не назвать, у них своя ниша, в которой кстати intel тоже неплохо присутствует, и только у него как мне кажется, есть силы встать на равных с amd/nvidia.

и это хорошо

p.s. боюсь будет плохо, в смысле с драйверами, потому что бизнес :(

ShadowMaster

24.03.2019 00:31А также производителей процессоров 2 и еще VIA. Производителей жестких дисков 2 и еще тошиба. Производство высокотехнологических изделей усложняется и это ведет к дуополии.

Также можно сказать что производителей памяти три (samsung, hynix, micron) + nanya. Тут хотя бы есть надежда, что их потеснят китайцы.

Достаточно много производителей ARM процессоров и контроллеров SSD, но и их количество сокращается.

Exchan-ge

24.03.2019 01:09+1А также производителей процессоров 2 и еще VIA.

«Процессоры архитектуры ARM, по лицензии, полученной от компании, выпускают следующие компании: Apple, Atmel, Broadcom, Freescale, Marvell, Nvidia, Qualcomm, Samsung, Texas Instruments, VIA, Миландр, ЭЛВИС, STMicroelectronics ARM limited и другие». ©

ShadowMaster

24.03.2019 01:27+1В первом предложении я писал о процессорах архитектуры x86(-64). Ниже где я написал про ARM я имел в виду большие производительные ядра ARM (ARMv7, ARM8), которые пригодны для использования в смартфонах, планшетах, телевизорах, ноутбуках и т.д. Вот как раз оттуда ушли и TI, и NVIDIA и некоторые другие. Всякие M3 сильно проще, поэтому и производителей больше. Чем оно становится сложнее, тем меньше остается независимых разработчиков и производителей. Они либо разоряются, либо объединяются.

Даже если брать софт. Осталось 3 ОС для десктопов (linux, macOS, windows). Никто же серьезно не будет использовать DOS или какую-нибудь BeOS? Осталось 2 ОС для смартфонов и еще несколько с исчезающей долей рынка (вроде windows phone или как там ее сейчас называют или sailfish). А раньше у каждого производителя телефонов была своя ОС для телефонов, а то еще и несколько.

Exchan-ge

24.03.2019 02:52+1Чем оно становится сложнее, тем меньше остается независимых разработчиков и производителей.

Не так давно Apple вообще не выпускала процессоры, а сейчас уже планирует полностью отказаться от продукции Интел.

Так что пока их стало больше.

ShadowMaster

24.03.2019 11:04По этим слухам это будут не x86 процессоры, а ARM.

Производителей x86 процессоров с лицензией осталось 3. VIA целиком отдается китайцам, вряд ли они помогут Apple. Разрабатывать с нуля свой x86 процессор слишком долго и дорого, о чем я и писал выше. Проще купить AMD, для Apple с ее наличностью это копейки. Хотя и стоило бы это сделать пару лет назад.

С ARM интереснее. Apple их успешно их разрабатывает уже больше 12 лет. Они успели забежать на этот уходящий поезд. И что-то я не припомню новых производителей ARMv7, ARM8 процессоров за последние лет 5.

Сейчас мы имеем простую ситуацию: чтобы разработать что-то высокотехнологичное, что уже есть на рынке лет 10 и больше нужны огромные деньги и куча времени. Дешевле и быстрее купить существующего разработчика. И со временем их количество только сокращается.

Кстати, даже если посмотреть на китай-телефоны, то раньше подвальных производителей были десятки и сотни, сейчас их значительно меньше.

LLE

23.03.2019 22:46Слово KYRO кто помнит?

www.vgamuseum.info/index.php/cpu/item/402-stmicroelectronics-kyro-ii

vgamuseum.ru/gpu/powervr/hercules-3d-prophet-4000xt-agp-powervr-kyro-iistg-4000-x

www.ixbt.com/video/kyro-review.html

А SiS?

fcenter.ru/online/hardarticles/videos/5616-Obzor_shesti_bjudzhetnyh_videokart#5

Exchan-ge

23.03.2019 23:55+1А SiS?

Помним, поминая незлым тихим словом — материнки с интегрированным видео этой кампании.

DGG

24.03.2019 09:50У меня была powerVR Kyro2. Неплохая была карта, но вот дрова — жуть.

Собственно PowerVR до сих пор жив как проектировщик видеокарт для телефонных процессоров. Но там сделать единственный необнлвляемый драйвер, прибитый гвоздями к одной криво патченной версии ядра Линукс — норма.

НЯП для выпуска видеокарт для PC уже давно главным препятствием является не умение в "железо", а неумение делать и поддреживать софт под весь зоопарк операционных систем.

S3 savage тоже вроде неумение s3 писать дрова убило

vitalyvitaly

24.03.2019 00:36+1Почти все производители видеочипов ушли с рынка за пару лет в 1999-2000 годах. Ну может быть, Tseng Labs, Number Nine, Video Seven из грандов чуть раньше. Репутация S3, Cirrus и т.д была подорвана уже к концу девяностых — в эпоху Pentium II их изделия были уже просто затычками для пишущих машинок. Чуть позже в начале 200х пыталась пробиться XGI со своим чипом Volari — наверное последняя независимая попытка создать 3D-чип для десктопа.

navion

24.03.2019 16:25+1Неплохо было бы упомнять, что процессоры с Gen11 для настольных компьютеров выйдут не раньше 2020 (в этом году будет ещё одно обновление Skylake).

А также напомнить про кучу отменённых Интелом проектов, так что дискретная видеокарта может вообще не выйти на рынок.

Greendq

25.03.2019 02:32Ещё стоит вспомнить про кучу потентов, украсных и зелёных в этом плане есть кросс-соглашения, у синих и красных тоже есть, но они касаются в основном процессоров обычных, а не графических. Так что действительно, могут и отменить.

RusikR2D2

На фрагменте с бочко-вывеской явно видно, что на PS изображена бочка из отдельных дощечек, тогда как на CPS отдельные дощечки уже не видны.

Как я понимаю, это «железная функция», работа которой не будет зависеть от настройки игры, что приведет к тому, что игра на разных видеокартах будет выглядеть заметно по разному. Если тут дощечки не так важны, то в другой игре это может быть частью головоломки, например.

creker

В первую очередь это приведет к невозможности адекватных сравнительных тестов разных видеокарт. По сути, это грязный чит, который должен отключаться, иначе нормальный тест становится невозможно провести. Одно дело использовать Delta Color Compression без потерь как у всех современных видеокарт. Другое дело банально не вызывать шейдерные программы на свое усмотрение, ухудшая качество изображения. Как бы это не оказалось тем, за счет чего интел хочет нагнать конкурентов. Не можем архитектурой, так считерим.

no404error

В чем заключается «адекватность»? В несоответствии подхода к оптимизации компании A компанией B? Так это «нарушено» много-много лет назад. Практически каждая новая «фишка» «нарушала адекватность». И даже больше, иногда явные «косяки» привносили очередную «фишку», которая «нарушала адекватность», а потом становилась «трендом».

Это как спор hires lossless vs lossless vs lossy для аудио. Разница есть. В некоторых случаях — просто невероятная. Но это при сравнении а-ля «bit-perfect». Для «bit-sample» — уже просто громадная, а статистически — уже вполне укладывается в погрешность (при выборке всего населения планеты с точки зрения физиологии).

p.s. Если следовать вашей логике, то на планете не хватит ресурсов даже для хранения всей неоходимой текстовой информации, куда там медиа…

creker

Чет у вас мысля ушла вообще не в ту степь. Речь о том, что невозможно оценить грамотно скорость железа, потому что одно железо делает всю работу, а другое по своему желанию от части работы, которую она обязана и ее просят выполнить, отказывается. Это если нельзя в дровах отключить и это действительно фишка только интела будет. Это и называется грязный чит.

no404error

Чет «у вас изначально мысль ушла не в ту степь»

Просто к ярким примерам были HAM и S3TC. Оба фичи и оба тренды.

creker

Вы в каком параллельном мире, ей богу. При чем тут вообще сжатие текстур? Вы понимаете в чем суть Coarse Pixel Shading? Это не алгоритм сжатия. В любом случае, тут внизу уже подкинули мысль про variable shading rate, так что можно спать спокойно. Это будет в dx12 и тестам видеокарт ничего не грозит. Все будут в равных условиях.

no404error

Мне кажется, что это вы живете в другом мире. Основополагающей характеристикой выполненной работы является соответствие результата заявленным требованиям. Вы считаете, что все должны сделовать правилу «либо абсолютная точность, либо никак». Но мы говорим не о «критически важных вычислениях с заданной точностью», а о «статической картинке в выборке динамического окружения». Может с NVIDIA хотите подискутировать? У них таких «фишек» — вагон.

p.s. С точки зрения физиологии (но вы же не человек, а робот) для тестирования применяется параметр объективность. Хоть для аудио, хоть для видео, хоть для любого вида данных поступающих к нам через естественные «сенсоры». Можно и 128-bit цвет просчитывать и отображать, но наши глаза его не воспринимают, как и наши уши не воспринимают 96kHz. Вывод: мерятся детородными или выбирать что имеет большее значение при допустимой погрешности: скорость или точность.

SystemXFiles

Уже сейчас наблюдается такая ситуация между AMD и nVidia. Картинки в играх могут сильно отличаться по насыщенности и менее заметно различными деталями. Не узнавал, в чем причина таких отличий, но по сути уже сейчас корректность сравнений давно нарушена.

RusikR2D2

Ага. Кажется, тут была статья про визуальные подсказки для игроков. Плохо же будет, если из-за видеокарты он их не увидит.

mapron

Напомнило историю как в онлайн игре при низких настройках графики кусты, в которых должен был скрываться противник, просто не рендерились =)

creker

Насколько помню, там это связано с динамическими диапазонами. Или баг, или фича, но исправить можно.

chibiryaev

Это программируемая фича, которая будет доступна через DX12 и называется variable shading rate. Коарсность можно устанавливать per-drawcall (как для всей бочки целиком), или с помощью специальной текстуры, в которой зашиты значения коарсности

creker

Вот это уже адекватно выглядит и снимает все вопросы насчет сравнения железа. Сама то идея отличная.