Научно-популярные и даже развлекательные СМИ в наше время переполнены новостями об успехе ИИ-проектов. То искусственный интеллект побеждает человека в го, то учится играть в StarCraft и выходит победителем из схватки с признанными чемпионами. И это только малая толика достижений, на самом деле их гораздо больше. Обычный человек (в смысле, не связанный с ИТ-сферой) может подумать, что вот-вот появится настоящий, «большой» искусственный интеллект, о котором пишу фантасты и снимают фильмы.

Но все далеко не так радужно. К примеру, на днях появилась информация о том, что ИИ попробовал сдать тест по высшей математике (школьный тест, стандартный для Великобритании) и не смог этого сделать.

В принципе, причины неудачи можно объяснить без особого труда. Так, человек при решении задач математического характера задействует следующие способности и возможности.

Модифицирует для себя символы в сущности, такие как числа, арифметические операторы, переменные (которые в комплексе образуют функции) и слова (определяющие вопрос, смысл задачи и т.п.).

- Планирование (например, ранжируя функции в порядке, необходимом для решения математической задачи).

- Использование вспомогательных алгоритмов для составления функций (сложение, умножение).

- Использование кратковременной памяти для хранения промежуточных значений (например, h (f (x))).

- Применение на практике полученных ранее знаний о правилах, преобразованиях, процессах и аксиомах.

DeepMind обучили и тестировали на подборке различных типов математических проблем и задач. Разработчики не использовали краудсорсинг, вместо этого они синтезировали набор данных для генерации большого количества тестовых задач, контроля уровня их сложности и т.п. Команда разработчиков использовала текстовый формат данных «произвольной формы».

Изначальные данные базировались на задачах из подборок заданий для учащихся школ Великобритании (возраст до 16 лет). Задания брались из таких направлений, как арифметика, алгебра, теория вероятностей и др.

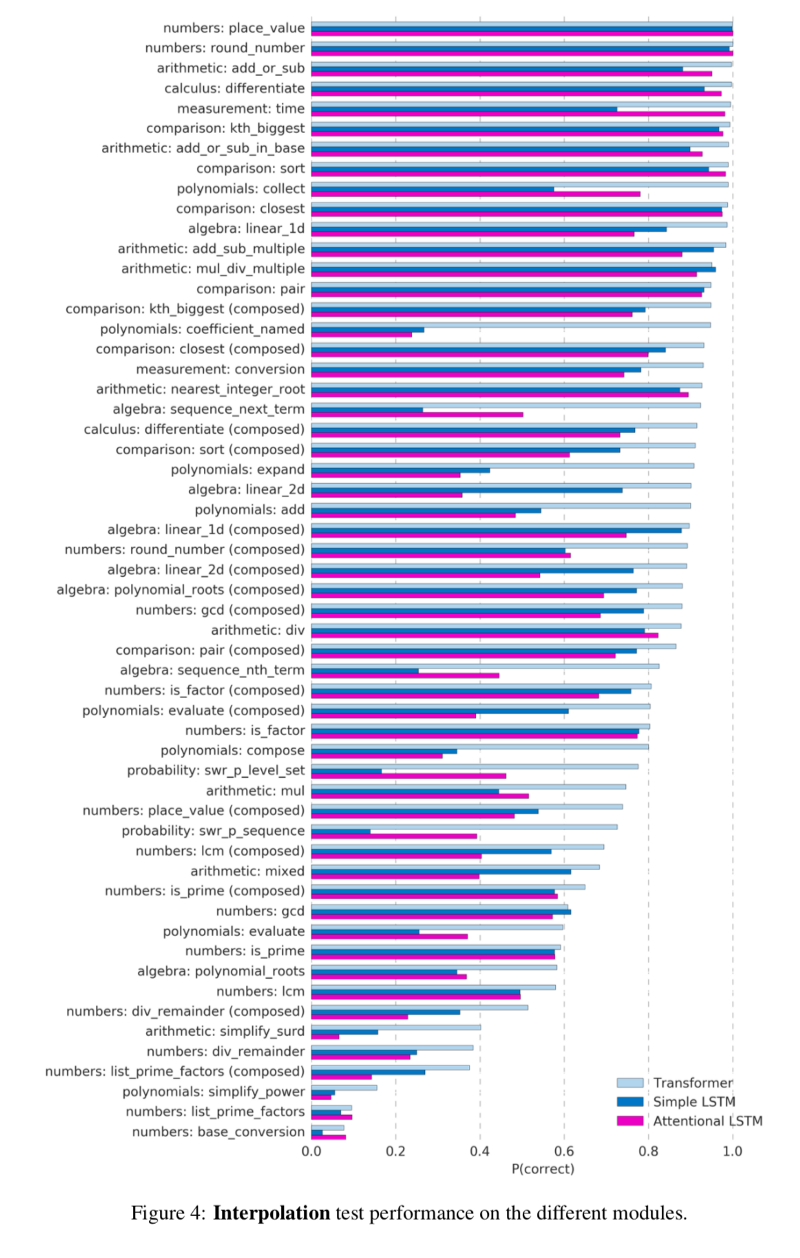

Команда DeepMind, выбирая архитектуру нейросети для решения математических задач, остановилась на LSTM (долгая краткосрочная память) и Transformer (архитектура нейросетей для работы с последовательностями).

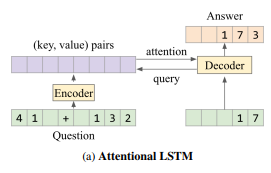

DeepMind протестировал две модели LSTM для работы с математическими задачами: простой LSTM и Attentional LSTM схема работы которого показана на рисунке ниже.

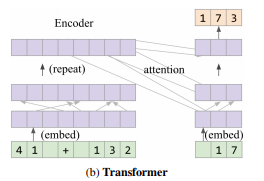

Ниже — схема работы модели Transformer

Результат оказался не слишком хорошим. Лишь 35% ответов ИИ оказались правильными, это неудовлетворительная оценка по стандартам любой школы.

Конечно, исследователи из DeepMind пока лишь начали работу с математикой и ИИ. В дальнейшем можно ожидать бОльших успехов, как это было с тем же AlphaGo.

С данными полного исследования можно ознакомиться по этой ссылке.

VBKesha

Вот судя по тому что я видел в SC2 сложилось ощущение что у данного ИИ как будто бы очень развита так сказать «интуиция» но всё остальное не ахти.

Wernisag

У него нет никакой интуиции. Просто набор тактик и действий, которые причем не всегда правильно реализовались + нечеловеческий микроконтроль + неограниченный обзор локации

sim3x

deepmind.com/blog/alphastar-mastering-real-time-strategy-game-starcraft-ii/#block-22

Wernisag

А что толку то? StarCraft бесплатен, скачайте реплей и посмотрите как играет DeepMine «из его глаз». Я вот достал свою шпаргалку и поделюсь таймингом, 3:25-3:30. DeepMine переводит камеру на боевых юнитов, и не смотря на пробку, ставит ей новую базу. Т.е. камеру то перемещать научился, а вот управляет юнитами все так же, по всей карте.

sim3x

Насколько я помню, в указанном режиме сьиграли одну игру с Маной

Вы уверены, что мы говорим ободном и том же?

ustin

Микроконтроль абсолютно нечеловеческий. Я сначала купился на «у нашего ИИ APM меньше чем у человека, вот графики», а потом посмотрел разбор и офигел.

В бою у ИИ 10-12 «действий» в секунду и одно «действие» может быть эквивалентно десяткам нажатий у человека.

Чтобы повторять такие бои надо уметь делать 200-300 осмысленных кликов в секунду.

sim3x

Алекс обсуждает игру не с тем ИИ, о которой я говорю

Более того он обсуждает игру, которой не было в трансляции

Европейцы тоже жалуются, что корейцы слишком хорошо играют

Yastreb1332

и я сейчас провалю этот школьный тест. хотя в школе с математикой проблем у меня не было.

agat000

Имея неделю хотя бы, на подготовку, думаю сдадите.

Yastreb1332

да скорее всего.

EvokSinister

Это если заранее натаскивать себя на вопросы конкретно этого теста. Если просто попытаться читать учебник по математике, то результат будет примерно такой же. То есть, провальный.

Вообще, любой стандартизированный тест — это проверка знания испытуемого определённого набора информации. Тогда как, если я не путаю, самая идея ИИ, подобных описанному в статье, состоит в том, чтобы уметь «думать» и применять различные методы для решения задач. Скажем, тот же ИИ для игры Го: там уже зазубрить что-либо крайне сложно. Вообще, ниже есть очень меткий комментарий про микроскоп и гвозди. Здесь в качестве гвоздей этот тест…

Alek_roebuck

Во-первых, Великобритании, а не США. Зачем я полез проверять? А очень просто: в США нет никаких стандартных тестов по высшей математике, обязательная программа ограничивается алгеброй примерно в объеме нашего 8-9 класса и зачатками геометрии. Даже «ЕГЭ профильного уровня» (SAT 2 Math) из заданий по более или менее высшей математике, если её можно так назвать, содержит только задания по комбинаторике.

Во-вторых, оказалось, что и английский тест, который решал этот АИ, был по элементарной математике, а не высшей. За исключением задачи на дифференцирование.

gorodnev

Да я что-то и задач на дифференцирование не нашел в секции D, 40 крайне простых вопросов. Я сначала подумал, что речь идет про AP Calculus

haoNoQ

Микроскоп провалил тест по забиванию гвоздей!

На самом деле нет. То есть с одной стороны конечно да, machine learning применяется в задачах которые тупо заучиванием формул и алгоритмов не решить (это я сейчас сильно унизил науку об SMT, ну да ладно), а научить искусственный интеллект формуле — примерно как научить естественный интеллект формуле (и я рад что статья это в какой-то степени подтвердила, но это не очень неожиданно).

А с другой стороны, в этих ваших школьных задачах самое сложное — понять, насколько тупым был составитель и опуститься до его уровня, чтобы расшифровать

техзаданиеусловие. Хотя там и не было совсем текстовых задач, взять хотя бы эти которые "упростить выражение". И вот тут, конечно, я бы на успехи deep mind посмотрел с интересом, и оригинальная статья весьма любопытна, рекомендую.GiperBober

Ну вот зачем так писать статьи? Сайт превращается в новостного агрегатора…

Разобрали бы хоть, в чём конкретно делались ошибки (не все знают английский, чтобы разобраться в картинке и ещё перевести объем по ссылке). Что ещё за Transformer там неожиданно появляется?

Разобрать пару примеров — задача выглядит так, человек решил бы вот так, а ИИ почему-то распознал задачу так и выдал такой-то ответ.

Насколько синтезированные тесты, на которых обучался ИИ, соответствовал реальным школьным тестам?

Какие результаты выдают школьники в этих тестах?

HiTechSpoon

Интересно, а в каком объеме там высшую математику преподают?

MedicusAmicus

Не ИИ провалил тест, а команда DEEP MIND выбрала неверные алгоритмы.

Статьи об успехах/неудачах ИИ все больше персонифицируют тот самый И.

"Мы даем сущности ярлык для удобства, а затем начинаем обращаться с этим ярлыком, как с исходной сущностью, забывая о том, что было в начале"

iroln

Видимо, этот датасет они использовали для обучения?

santa324

Ну да, скормим нейронке миллионы примеров вопросов и ответов текстом — и она внутри своей структуры научится понимать человеческий язык в вопросах, выведет все математические законы…

Это скорее проверка самих тестов, на сколько они однообразные и предсказуемые. Вот если бы их генерировала какая-нибудь программа — могло сработать )

Daemonis

Ну, вообще-то, они свой датасет сами и сгенерировали.

Ndochp

— Третье условие. Ансельмика запрут в шкаф, и он будет выходить оттуда

только для того, чтобы сделать уроки за нас и наших друзей. Для этого его

будут кормить учебниками.

— Ура! — в восторге закричал Ансельмик. — Школьные учебники так хороши,

что их даже крадут!

(С) Джанни Родари

КАК МАРКО И МИРКО ЛОВИЛИ БАНДИТОВ

IonovVladimir

Теперь школьники скажут, что они умнее компьютера. Каспаров не смог, а мы смогли :) Хотя, на мой взгляд, сравнивать ИИ и человеческий мозг некорректно. Это как сравнивать бегуна и поезд. Если хочешь, бегай по вагонам, но зачем бежать вдоль «железки»?

ИИ силён, когда он знает контекст и этот контекст не меняется. Например, при переводе устойчивого оборота с одного языка на другой. «When in Rome, do as the Romans» — «В чужой монастырь со своим уставом не ходят».

ИИ слаб, когда он выпадает из контекста. Например, если слово употребляется в переносном значении или с противоположным смыслом. Девушка говорит парню: «Орхидеи ещё не зацвели». И тот понимает, что его отшили. А ИИ нет.

Шахматисты научились дружить с компьютером. Лучше «и — и», чем «или — или». Надо просто довести ИИ до ума, а то так и останется на уровне 35%. Интуиция мне подсказывает, что в математике это сделать проще, чем в лингвистике.

jetcar

ИИ это не только набор алгоритмов, а ещё и полученный опыт(куча систематизированных данных), пример с выражениями в переносном смысле и у людей не сработает если до этого не было подходящего опыта, вопрос только в количестве опыта и скорости обработки этого опыта потому что данных в базе может быть очень много и надо как мозг суметь их оптимизировать, у ИИ вопрос только к качеству алгоритмов оптимизации запросов, чтоб и быстро было и слишком не переоптимизировал

hippohood

> Девушка говорит парню: «Орхидеи ещё не зацвели». И тот понимает, что его отшили. А ИИ нет.

Я бы тоже не понял. Так что, это просто специфический опыт. Если ИИ несколько раз девушки отошьют, то он начнет понимать с полуслова.

Между прочим, сдача экзаменов это тоже весьма специфический опыт. Известный факт что языковые тесты носители языка без подготовки сдают весьма посредственно, если вообще сдают (особенно если он давно уже не студенты).

IonovVladimir

Daemonis

Собственно, здесь и решалась скорее лингвистическая задача. Думаю, никто не сомневается, что если компьютеру дать задачу «реши квадратное уравнение» в удобном ему виде, он решит и не вспотеет. Проблема в том, что задача ему давалась в «человеческом» виде, и он должен был «догадаться», что это и что от него требуется.

Например, одна из моделей правильно решала «Calculate 17 * 4.», но выдавала неверный результат, если не было точки в конце.

Occama

Мне кажется, или 35% в задаче обучения, решённой, видимо, с нуля — это весьма неплохой результат?

alsoijw

Зачем для решения нужна нейросеть? Почему обычные алгоритмы не подошли?

KvanTTT

Какие обычные? SMT солверы и другие? Нужня для того, чтобы посмотреть, можно ли обучить нейросеть высокоуровневой системе — это как минимум интересно.

alsoijw

Да, речь о них. ведь они уже работают

Daemonis

Потому что задача не «решить квадратное уравнение», а «научить ИИ понимать, что это квадратное уравнение и решать его».

fivehouse

Я вот что не понимаю. Не уже ли авторы этой поделки не понимают, что они дискредитируют и направление и все что делают, что могло бы принести реальную пользу в реальных вопросах? Не уже ли авторы этой поделки не понимают что сверх-ультра-DeepMind провалит любой тест по математике из начальной школы полностью, где надо будет читать задачу и понимать, что у Машеньки 2 белые корзинки, у Коли на 3 яблока больше? Не уже ли авторы этой поделки не понимают что сверх-ультра-DeepMind провалит любой тест по математике, где надо будет составить по задаче элементарное уравнение по описанию или понять каких данных в задаче не хватает. Интересно, какой уровень дискредитации надо достичь разработчикам, чтобы прекратить эту неумную пропаганду?

alsoijw

fivehouse

Из моего понимания уровня той кустарщины которой является DeepMind по сравнению с тем, что нужно для понимания и решения школьных задачек про Машеньку, Колю, яблоки и корзинки. Из отсутствия доступных результатов на рынке. И из много чего такого…

playermet

Две тысячи лет назад в каком-то городе:

> Я вот что не понимаю. Не уже ли сторонники круглой Земли не понимают, что они дискредитируют и направление и все что делают, что могло бы принести реальную пользу в реальных вопросах? Не уже ли они не понимают что любой тест на округлость Земли будет провален? Интересно, какой уровень дискредитации надо достичь астрономам, чтобы прекратить эту неумную пропаганду?

> Откуда такая уверенность?

> Из моего понимания уровня той кустарщины которой является глобус по сравнению с тем, что нужно для понимания картографии. Из отсутствия доступных результатов мореплавания. И из много чего такого…

То что результатов нет прямо сейчас еще не значит что они не будут достигнуты, если к ним идти. Вот если не идти — тогда они гарантированно не будут достигнуты. Если бы исследователи останавливались на этапе «ну ничего же нет пока», то не было бы сейчас ни телефонов с тачскринами, ни электричества, ни зданий, ни даже примитивных инструментов и одежды, сидели бы по пещерам и ели сырое мясо с корешками.

Я бы понял претензию, если бы авторы впихнули сети в реальный продукт, в котором они неуместны. Но они лишь изучили поведение нейросети с целью поиска способов их улучшения, и все правильно сделали. Шаг за шагом, и когда нибудь получится создать модель человеческого разума, пускай и без сознания, но зато способную дешево и круглосуточно выполнять несложную человеческую интеллектуальную работу.

fivehouse

В будущем все будет хорошо, просто замечательно. Настоящий ИИ используя покоренный термояд будет терраформировать объекты солнечной системы как семечки. Всю работу будет делать ИИ. Но шаг сделанный DeepMind давно не является каким-то супер достижением. Мало того, авторы не понимают сделанного и причину его работы или не работы, именно поэтому их способ движения тупиковый. Достижения DeepMind давно превратились в явное стояние почти на месте, которое манипуляциями граничащими с обманом выдается за сверхдостижения. Это и есть злостная дискредитация. Когда вы прыгаете на месте при виде Луны, вы конечно на время становитесь ближе к Луне. Когда вы совершенствуете свою технику прыжков, увеличиваете силу ног и подпрыгиваете выше и ближе к Луне, кому-то начинает казаться, что у вас прогресс на пути полета к Луне. И сообщение о достижениях DeepMind звучат почти как, кто-то прыгнул на 1 см выше по направлению к Луне — у нас прогресс в деле полета на Луну. А суть же происходящего — полная дискредитация. А задаваться же вопросом что же конкретно надо для желаемого и почему, для области исследований ИИ считается невежливым моветоном. Хорошо, что с Луной как-то дошло.