Если в двух словах описать события трёх частей предыдущего цикла статей, то в видеоадаптерах GTX 980 и GTX 970 использовался одинаковый чип GM204, основанный на архитектуре Maxwell, и отключение части элементов «бракованных» чипов, не прошедших тестирование для использования в GTX 980 позволило создать всё ещё очень быструю и производительную видеокарту. Настолько быструю, что разрешение 2560х1440 и максимальные настройки графики не являются для неё какой-либо проблемой.

Сегодня же поговорим про топовые модели чипа Maxwell в видеоадаптерах GTX Titan X и GTX 980Ti. Эти видеокарты работают на «максимальной» конфигурации чипов архитектуры Maxwell: GM200-310. Так ли она хороша, что отличает её от GTX 980 и почему это продукты совершенно разного уровня — под катом.

Maxwell большой и Maxwell маленький

Если не рассматривать чипы первого поколения GM10x (которые достались младшим решениям и мобильным видеоадаптерам), то у GM20x есть ряд особенностей, которые присущи всем чипам, вне зависимости от конфигурации.

Во-первых, в GM20x применяется ряд новых технологий.

Например, работа с динамическим (виртуальным) суперразрешением, позволяющим использовать 4k2k-разрешение даже на FullHD-мониторах:

Улучшенные алгоритмы сглаживания изображения, практически не влияющие на частоту кадров:

Определённые улучшения для работы с VR-шлемами, новые алгоритмы для обработки освещения и много чего ещё. В целом, все они нацелены на топовый сегмент и игру «на все деньги», с максимальными настройками графики, на высоких разрешениях и с использованием недешёвого VR-оборудования.

И если младшие 200-е Maxwell’ы обеспечивали приемлемую производительность в разрешении 2560х1400 и 4k2k, то сейчас настал черёд настоящих монстров.

Если сравнивать топовые решения GM204 и GM200 (GTX 980 и Titan X соответственно) то отличия видны даже на диаграммах архитектуры чипов. Вот так схематично выглядит чип, использующийся в GTX980:

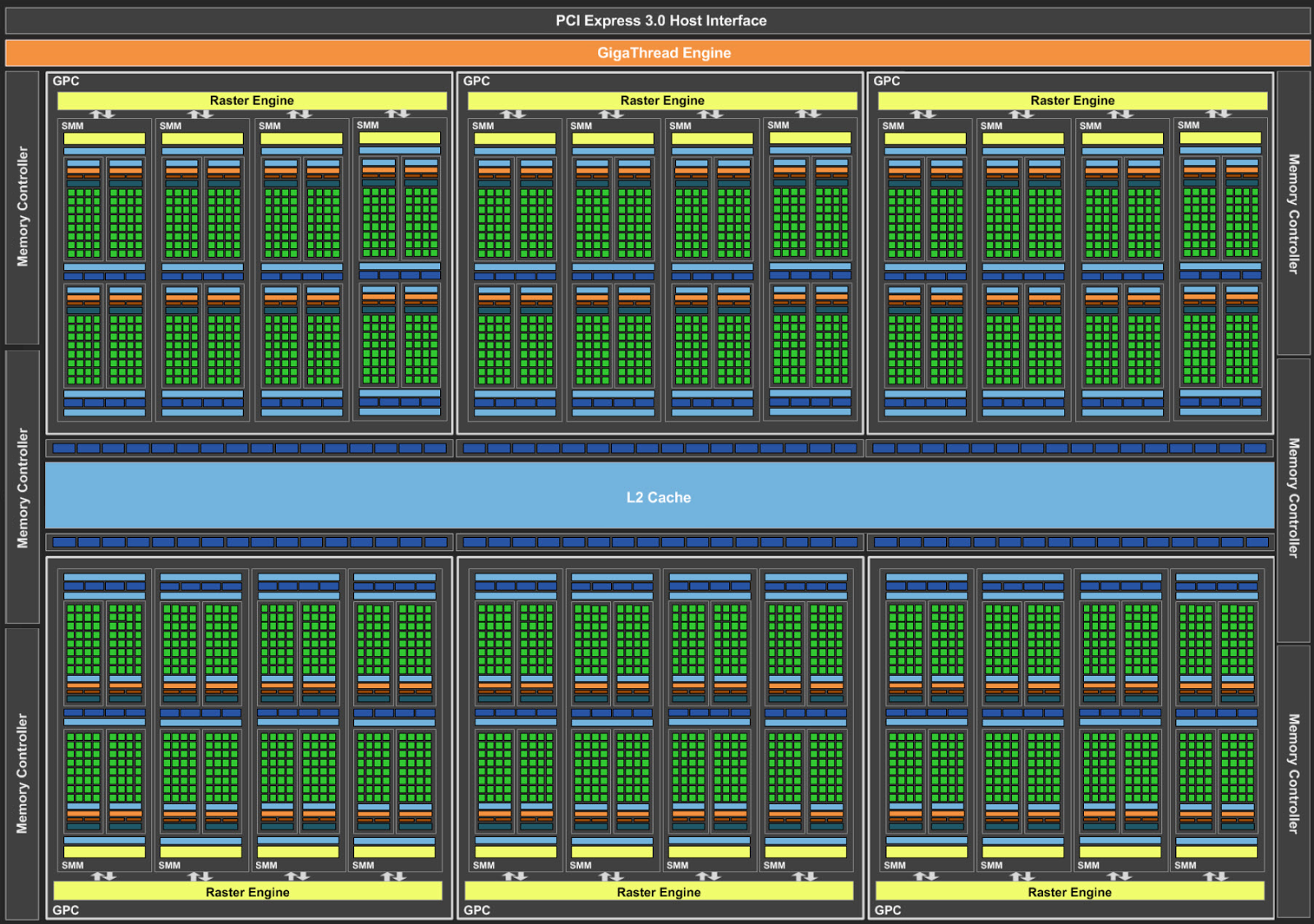

А вот диаграма для текущего флагмана, GTX Titan X:

Как видите, вместо четырёх крупных блоков (NVIDIA называет их SMM) используется шесть, соответственно, контроллеров памяти также шесть, а не четыре. Ширина шины памяти, количество блоков растеризации, универсальных шейдерных процессоров, блоков текстурирования, в новом флагмане на 50% больше, чем в топовом «консьюмерском» чипе:

| Сравнение спецификаций топовых решений NVIDIA: |

||||

| |

GTX Titan X |

GTX 980 Ti |

GTX 980 |

GTX 780 Ti |

| Ядра CUDA |

3072 |

2816 |

2048 |

2880 |

| Блоки текстурирования |

192 |

176 |

128 |

240 |

| Блоки растеризации |

96 |

96 |

64 |

48 |

| Частота ядра |

1000MHz |

1000MHz |

1126MHz |

875MHz |

| TurboBoost |

1075MHz |

1075MHz |

1216MHz |

928Mhz |

| Частота памяти |

7GHz GDDR5 |

7GHz GDDR5 |

7GHz GDDR5 |

7GHz GDDR5 |

| Шина памяти |

384-bit |

384-bit |

256-bit |

384-bit |

| Объём VRAM |

12GB |

6GB |

4GB |

3GB |

| Скорость вычислений FP64 |

1/32 FP32 |

1/32 FP32 |

1/32 FP32 |

1/24 FP32 |

| Тепловой пакет |

250W |

250W |

165W |

250W |

| Ядро GPU |

GM200 |

GM200 |

GM204 |

GK110B |

| Architecture |

Maxwell 2 |

Maxwell 2 |

Maxwell 2 |

Kepler |

| РРЦ |

$999 |

$649 |

$549 |

$699 |

Из «табличных» характеристик видно, что новая 980Ti куда ближе к GTX Titan X, чем к консьюмерской GTX 980.

Что немаловажно, «обрезка» неудачных чипов GM200 производилась достаточно аккуратно, и единственные изменения, затронувшие конструкцию 980Ti — это отключение 2 из 24 блоков потоковых мультипроцессоров (каждый из которых содержит 128 вычислительных ядер CUDA и 8 блоков текстурирования) и уменьшение объёмов памяти вдвое. Вот так выглядит чип GTX 980Ti:

Остальные же элементы, вроде блоков растеризации и шины памяти остались нетронутыми, и из-за этого реальная производительность GTX 980Ti в играх отстаёт от Titan X всего на 3-5%, и это при том, что 980Ti как минимум на треть дешевле.

Разница же в цене между GTX 980 и 980Ti на российском рынке, к сожалению, далеко не 100 долларов, как показано на РРЦ, а существенно больше, но она со временем уменьшится. А вот разница в производительности никуда не денется, а с выходом новых тайтлов ещё и вырастет.

Убийственная производительность

Ко мне на стол попала видеокарта GTX 980Ti производства Palit, причём не в «референсном» дизайне, а с фирменной системой охлаждения JetStream.

Ещё в прошлой серии постов было ясно, что производительности GTX 970 (а, соответственно и 980) с головой хватит на игры с разрешением 2560х1440, так что в этот раз программа испытаний завела меня в тупик. Если не рассматривать косяки плохой оптимизации, которые сможет завалить грубой вычислительной мощностью только совершенно безумная AMD FuryX (и о ней скоро поговорим) и всякие двухчиповые решения вроде R9 295X2, то для всех остальных игр стоял не вопрос «будут ли лаги», а «насколько красивую картинку можно выжать».

Для настройки графики можно использовать ПО GeForce Experience. Фирменный софт NVIDIA умеет самостоятельно подбирать настройки графики в играх для максимального качества изображения с комфортным показателем FPS, при этом учитывает возможности вашего железа1.

1 — для некоторых игр, которым вы принудительно выставили оконный или безрамочный режим, GeForce Experience может попробовать поставить DSR 4k2k, после чего игра перестанет работать. Решается выставлением нативного разрешения в GeForce Experience.

Project CARS? GTA V? Assassin Creed? War Thunder с настройками «кино»? BF4? FarCry 4? Company of Heroes? Crysis 3? FPS нигде не просел ниже комфортных значений. Единственное из последних тайтлов, на чём результат меня совершенно не устроил — это WItcher 3 (ну, он просто кривой, польша не умеет в оптимизацию топовых настроек и всё такое). А Batman: Arkham Knight я не покупал, а сейчас его нигде не достать.

Бенчмарки проводить просто бессмысленно. Всё работает. Включаешь, ставишь максимальные настройки, DSR 4k2k, «фирменное» сглаживание NVIDIA, обходящееся видеокарте практически бесплатно, запускаешь игру и наслаждаешься зафиксированными вертикальной синхронизацией 30-ю FPS. Снимаешь блокировку — почти всюду средний FPS вырастает до 40-50. В играх попроще (или в нативном разрешении для монитора) FPSметр растёт, как на дрожжах. В пресловутых Diablo 3 и TeamFortress 2 количество кадров в секунду с лёгкостью уходит за три сотни.

Проблемы возникают только с откровенно кривооптимизированными играми. Тот же Ведьмак 3 прекрасно работает на достаточно скромных конфигах и средне-высоких настройках: о пользователях не самых мощных ПК позаботились. А то что максимальные настройки вводят в ступор абсолютно любое железо — ну так кому это надо, полутора энтузиастам? В принципе, такой подход мне понятен, но лаги от этого не исчезают.

Что пишут о 980Ti железячные издания? Все сходятся во мнении, что 980Ti — один из лучших одночиповых ускорителей, а Titan X, в общем, не особо то и нужен. Вот мнение спецов из Oveclockers.ua:

Вполне ожидаемо видеокарта GeForce GTX 980 Ti демонстрирует внушительный отрыв от существующих однопроцессорных графических решений. По всем параметрам это максимально близкое к Titan X решение. Новый графический чип со значительно большим количеством вычислительных блоков и 384-битная шина памяти обеспечивают преимущество над бывшим лидером GeForce GTX 980 на уровне 23–30%. При этом наибольшее преимущество наблюдается в самых тяжелых графических режимах или при повышении разрешения до 4K. И младший представитель серии GTX 980 зачастую не в состоянии компенсировать свое отставание за счет повышения частот. Разгонный потенциал GeForce GTX 980 Ti на хорошем уровне, и по максимальным частотам GM200 лишь немного уступает GM204. Но достижение таких частот уже сопряжено с большими трудностями из-за более высоких требований к системе охлаждения. Даже на референсной видеокарте вполне реально повысить производительность на четверть, но лишь при максимальной скорости вентиляторов. Так что особый интерес у пользователей вызовут нереференсые версии с альтернативным охлаждением. Надеемся, некоторые из них попадут в ближайшее время к нам на тестирование. Высокая производительность нового флагмана сочетается еще и с повышенной функциональностью — полная поддержка DirectX 12.1 и оптимизации для работы с системами виртуальной реальности.

А вот что пишут коллеги по цеху из 3dNews.ru:

NVIDIA удается двигать вперед производительность дискретных GPU, несмотря на ограничения техпроцесса 28 нм, который используется в этой категории микросхем с 2011-2012 года. GeForce GTX 980 Ti, оставшись в рамках TDP, которые заданы прошлыми флагманскими продуктами на базе GK110, предлагает совершенно новый уровень производительности в 3D-рендеринге и вычислениях FP32. Кроме того, GTX 980 Ti поступил в продажу по меньшей цене ($649), чем GTX 780 Ti в свое время ($699). В глазах перфекциониста впечатление от новинки немного портит тот факт, что в GTX 980 Ti отключена часть вычислительных блоков GPU, но на поверку это практически не влияет на игровую производительность и даже не всегда сказывается в расчетных задачах. В то же время небольшой компромисс в спецификациях GPU позволил NVIDIA нарастить объем поставок, пустив в дело частично дефектные чипы.

… ……

Поскольку производительность в FP64 не позволяет провести черту между игровой (GTX 980 Ti) и полупрофессиональной (TITAN X) картами на базе GM200, разница проявляется лишь в избранных вычислительных задачах одинарной точности (FP32), когда количество активных ядер CUDA прямо связано с результатом. В отличие от ситуации с оригинальным TITAN и GTX 780, на этот раз существование отдельной разновидности ускорителя с полностью разблокированной конфигурацией GPU имеет под собой меньше оснований. Впрочем, TITAN X сослужил службу желающим получить самое лучшее, не дожидаясь по-настоящему массовых продуктов, и по-прежнему остается непревзойденным однопроцессорным ускорителем для FP32.

Ferra.ru:

Производительность GeForce GTX 980 Ti оказалась достаточно прогнозируемой. Если судить о характеристиках используемого в этой видеокарте графического процессора GM200 с урезанным блоками SMM, то она лишь немногим уступает флагману в лице GeForce GTX TITAN X. В некоторых случаях эта разница даже не ощущается. Если коротко о быстродействии GeForce GTX 980 Ti: это великолепное решение для гейминга в разрешении WQHD.

GeForce GTX 980 Ti ожидаемо получила уменьшенный до 6 Гбайт объем видеопамяти. Однако нехватку «мозгов» в современных играх можно ощутить лишь в очень тяжелых режимах. Это 4K-разрешение плюс установка зубодробительной кратности сглаживания.

Думаю, можно не продолжать, тенденция и так ясна.

Titan X vs 980Ti

Основное отличие 980Ti от топовой просьюмерской карты GTX Titan X — количество памяти. У «номерной» серии — 6 Гб, как у титанов прошлого поколения, основанных на архитектуре Kepler, у нового Titan X — 12 Гб. В тестах с GTX 970 мы уже определили, что даже самые графически нагруженные проекты, обладающие нормальной оптимизацией, с трудом выходят за 3.5 Гб потребления видеопамяти, а уж 4 ГБ (теоретически) и вовсе хватает всем.

В случае с 980Ti можно попробовать выйти и за 4ГБ, например, настроив GTA V таким образом, чтобы одновременно работало и 4k2k DSR, и «дорогое» полноэкранное сглаживание, однако раньше сдастся сам GPU, и даже замена видеокарты на GTX Titan X не позволит получить комфортных значений при таких настройках, а уж с графической точки зрения они и вовсе абсурдны. Разве что вы где-нибудь найдёте 5k3k монитор и захотите играть в нативном разрешении, и при этом у вас будут объективные причины включать полноэкранное сглаживание.

Ну а ещё можно взять Assassin's Creed Unity, которому сколько ни дай — всё мало. И в нём GTX 980Ti раскроется на все сто процентов: и запасов памяти ей хватит, и вычислительной мощности. Главное, придерживаться принципов здравого смысла: нужды в одновременной работе DSR и полноэкранного сглаживания нет решительно никакой.

Что касается чистой вычислительной мощности, то и у GTX 980Ti, и у дорогущщего Titan X производительность FP64 установлена на уровне 1/32 от «нормальной» производительности FP32. Как обычно, за числодробилками — либо в профессиональный сегмент с куда более внушительными бюджетами, либо в AMD с их топовыми решениями. Игровая производительность отличается минимально (так как и пропускная способность памяти, и количество блоков, отвечающих за вывод готовой картинки осталось неизменным), а небольшие послабления в области постобработки с лихвой компенсируются разницей в цене. Быть может, за цену одного Titan X (порядка 70-75 тысяч рублей) и не взять две 980Ti (45-50 тысяч рублей, в зависимости от вендора), но разница в производительности явно не стоит переплаты, если вы собираетесь на такой карточке только играть. А аналогичная производительность в FP64 создаёт нездоровый перекос в плане «кому вообще нужен TItan X за такие деньги». Если хочется дешёвых и эффективных вычислений — проще взять топовое решение AMD. А 12 Гб памяти… ну не знаю, если уж у вас нашлись деньги на Titan X и потребность в таком количестве видеопамяти, сдаётся мне, две 980Ti станут всё равно более эффективным вложением средств.

В сумме

GTX 980Ti — мощнейший ускоритель, избавленный производителем ото всех бутылочных горлышек. Поддержка новейшего DirecX 12.1 имеется, ждём, когда все эти фичи задействуют производители в каком-нибудь Crysis 4 или FarCry 5, чтобы в очередной раз поразить нас качеством картинки, генерируемой в реальном времени. Пока же основным тайтлом, который обещает принести в игрострой хоть что-то новое в плане качества картинки я бы навзал StarWars Battlefront, видео с которым регулярно будоражит YouTube. Всё же, работа освещения в нём поставлена просто потрясающе. Кинематографичность происходящего поражает.

Решили, что данной информации достаточно? Цена на GTX 980Ti в Юлмарте стартует с 45 тысяч рублей за референсный дизайн, у меня же на тесте была (и пока остаётся) вот такая карточка от Palit.

Кто бы что не говорил про этого производителя, но с охлаждением у неё всё хорошо, (блок питания и кулер процессора ночью шумят сильнее, чем видеокарта в «игровом» режиме), дроссели не свистят, к работе никаких нареканий нет. К тому же у Юлмарта отличный гарантийный отдел, а производитель установил срок гарантийных обязательств в 36 месяцев.

Планы на будущее

Единственное интересное применение GTX 980Ti и тем новым технологиям, которые внедрены в чипы Maxwell, которое мне удалось найти — это подцепить к ней Oculus Rift. Необходимое оборудование нашлось по друзьям-знакомым, в ближайшее время ждите отчёт.

Также я планирую стравить 980Ti с флагманами красно-белых, лучшими решениями на архитектуре прошлого поколения, Kepler. В принципе, уже сейчас ясно, что в 4k2k у 980Ti мало конкурентов. Не смотря на сумасшедшую архитектуру памяти и внушительные показатели самого GPU, Fury X страдает и от того, что у неё на 2 ГБ памяти меньше, чем у основного конкурента, и от достаточно слабенькой (по сравнению с «большими» Maxwell’ами) геометрической составляющей. Задавайте вопросы, заказывайте тесты, пожелания будут учтены.

Комментарии (37)

ConstSe

24.07.2015 02:05Надо Delta Force запустить. Она тормозила на всём топовом, что на момент её эксплуатации было. Хотя в графике далеко никаких откровений не было.

slonopotamus

24.07.2015 09:54-1> зафиксированными вертикальной синхронизацией 30-ю FPS

Может все-таки 60?

Haoose

24.07.2015 11:40А Batman: Arkham Knight я не покупал, а сейчас его нигде не достать.

Кто вам такое сказал?

plati.ru/search/BATMAN%20ARKHAM%20KNIGHT

Shirixae Автор

24.07.2015 11:45А вы бы стали платить за игру такого качества? )

Haoose

24.07.2015 11:59+1Вопрос не про качество игры, а где ее достать для теста.

P.S. Хотел, но все же не купил. Подожду патча, посмотрю станет ли лучше.

Shirixae Автор

24.07.2015 12:00Ну вот и я для теста видеокарты брать такое сырое [censored] за деньги, а не демо-версию на каком-нибудь трекере, не стал бы.

geovas333

24.07.2015 12:35+14 ГБ (теоретически) и вовсе хватает всем

Вот этот вопрос не дает мне покоя с момента покупки первого (нулевой не в счет) ПК.

Моя история такова:

2003 — GeForce MX440 64mb

2006 — Radeon X1600PRO 128mb

2008 — Radeon HD2600XT 256mb

2012 — Radeon R6850 1024mb

2016 — ???

На момент покупки каждой из этих карточек мне вполне хватало их памяти, все убеждали меня, что N мегабайт хватит всем! Но мой личный опыт подсказывает нехитрую зависимость: каждые 2 года необходимый объем видеопамяти удваивается.

Я вот грешным делом думаю немного подождать и взять Radeon R9 390 8096mb… Или произошла какая-то революция и теперь 4096mb действительно хватите всем?

Shirixae Автор

24.07.2015 12:41+1Нет, произошли консоли, и большинство кроссплатформенного буллшита реально вкладывается в эту память. А ПК-эксклюзивов не так много. Если у вас не 2560х1440 и не 4k2k монитор, то 4 ГБ с головой на ближайшие пару-тройку лет. Для 2560х1440 4 ГБ достаточно для всех текущих тайтлов, ну а что там будет с оптимизацией следующих продуктов для высоких разрешений — пока не ясно. Я об этом писал уже в статьях про GTX 970, посмотрите в самом начале этой статьи ссылочки. Восьмигиговая R9 390X — безусловно, оверкилл. Кто-то сильный, а кто-то умный, и всё такое. Внутри — архитектура от 7970, немного улучшенная количественно и качественно. Для игр в этом поколении, увы, Maxwell в большинстве случаев решает. А в текущем варианте цен R9 290 и R9 290X во многом выгоднее, чем поколение R9 300, если вы готовы смириться с тем, что кое-где придётся немного снизить качество постобработки. И так будет ещё пару-тройку месяцев, пока топовые R9 200 не закончатся на складах.

geovas333

24.07.2015 13:08Спасибо, почитаю! Монитор пока 1920x1080 и у счетом кризиса, в ближайшее время, ничего не изменится, хотя я мечтаю о 3-х мониторной конфигурации.

Меня смутило вот что: 4gb у топовой Fury X и целых 8gb у более «бюджетных» моделей. Это навело меня на мысль, что память больше никому не нужна, видимо я ошибся.

FoxCanFly

То есть нынешние топовые игровые видеокарты в современных играх не обесспечивают 60фпс и комфортными считается 30? Отстал я от жизни.

foxin

«ну так кому это надо, полутора энтузиастам?» (с)

ivlis

Мне надо. Численные вычисления гонять.

Shirixae Автор

За FP64 вам к красно-белым. 7970 по цена/выхлоп (она же R9 280X) получается одной и самых выгодных, если мне память не изменяет.

grozaman

Просто нынче ААА-девелоперы пали под жутким натиском собственных маркетологов. В итоге слово «оптимизация» для них за семью печатями. Практически каждая новая игра с ценником 1-2к выходит сырой. Бывает настолько сырой, что её аж снимают с продажи (почитайте про Batman: Arkham Knigth, у них было 10 тестеров ПК-версии, когда их должна быть не одна сотня, игру откладывали почти на год, в итоге игра до сих пор лагает на компьютерах с двумя GTX 780 Ti). И это далеко не единичный пример, 2014-2015 года задали очень хреновую тенденцию в купе с этим «ранним доступом», который в 99% введет к забиванию на игру болта.

OnYourLips

От жанра зависит.

Если вы играете в стратегию, или с геймпадом в какую-нибудь аркадную игру, то 30 вполне хватит: вспомните XBox 360 или PS3.

А вот для шутеров, управляемых клавиатурой и мышью, нужно минимум 60.

Hertz

Для шутеров комфортным считается игра на мониторе 120-144Гц, частота обновления кадров нужна соответствующая, вот там и нужна такая лихая мощность.

А в играх типа GTA V (не онлайн), например, лично я действительно комфортно играю и при 30, лишь бы проседаний не было.

P.S. Пардон, 120-144Гц в шутерах это luxury, а 60Гц — просто комфорт :-)

Shirixae Автор

Может быть, если речь идёт о турнирных онлайн-шутерах, а игроки уже такого класса, что подобные показатели действительно влияют на результат больше, чем эффект плацебо. Правда, им как раз ни графон, ни 4k2k обычно не нужны.

В остальных же случаях что 30, что 60 — один фиг, есть ещё input lag у монитора, polling rate у USB, пинги, сама реакция человека… В общем, 30 вполне хватает на комфортный синглплеер там, где не требуется огромная частота кадров именно с точки зрения геймплея.

VenomBlood

30FPS — это мало не только для игры, это мало даже для UI системы. На 4k мониторах по дефолту почему-то отключают DP 1.2, как результат изначально они работают в режиме 30Hz. Ощущение такое что стоит «Generic VGA Driver» или как оно там тогда называлось, после включения DP 1.2 и переключения на 60Hz разница поразительная.

Shirixae Автор

Монитор-то всё равно 59(60) Гц будет выдавать, что при 30 FPS, что при 45. Не путайте развёртку и кадровую частоту.

VenomBlood

Не сочтите за труд пояснить какой мне прок от 60Гц при 30FPS (чресстрочную развертку сразу выкинем, с ней играть невозможно)? Даже для видео, при всем том что в нем ниту никакой интерактивности, разнца между 30 FPS и 60 FPS видна очень хорошо, в шутерах, где надо использовать мышку — разница еще гораздо более заметна.

grozaman

Раставим все точки над И:

0-25 FPS — неиграбельно. Разве что нервы портить.

Стабильные 30 FPS играбельны, но заставляют периодически вспоминать, как же хорошо оптимизирована CS:GO.

40-60 FPS более чем играбельны и являются комфортным уровнем игры.

100, 200, 300 FPS и более сейчас редкость и можно увидеть только в 2D играх, Source-based, ну и в различных старых.

При этом для задрота CS:GO (да и не только GO) будет существенна разница между 250 и 400 FPS. Другими словами для каждого игрока приемлемый уровень отличается.

VenomBlood

Хм, а есть железо, на котором реально увидеть 400FPS (Я имею ввиду 400Hz мониторы)? или это чисто условные примеры?

grozaman

Эта разница реально заметна в тех же Source-based играх. Можете проверить. Сначала поставьте высокие настройки, у вас в зависимости от ПК будет 30-60 FPS (если совсем хороший ПК, то могут быть и все 200, но я ориентируюсь на средний), затем самые-самые низкие, у вас будет 250-420 примерно. И вы реально будете замечать разницу. Скажу лишь то, что на многих турнирах геймеры ставят самые-самые низкие настройки, несмотря на то, что им дают далеко не самые слабые ПК. В других играх зачастую всё упирается в оптимизацию и будь у вас хоть суперкомпьютер вы всё равно выше определенного значения не поднимите.

VenomBlood

До определенного уровня разница будет заметна из-за того что не каждый новый кадр не всегда попадает в промежуток между обновлениями монитора, т.е. 60FPS на 60Hz будет смотреться чуть хуже чем допустим 90FPS на 60Hz или 60FPS на 120Hz (просто потому что 60/60 в реальности количество кадров в секнуд будет чуть ниже 60), но вот для 400FPS чтобы увидеть разницу я думаю даже 240Hz монитора не хватит.

grozaman

Да, думаю вы правы, дальше разве что плацебо :)