Привет, Хабр! Сегодня я расскажу, как развивается сфера Data Science. 2020 год стал переломным не только для мира в целом, сфера данных активно совершенствуется и сегодня можно уже подводить итоги года. Встречайте тренды DS в 2020-2021 году.

Я сделал КДПВ, а потом обработал с помощью нейросети. Кто узнал фильм — тот молодец! :-)

Я сделал КДПВ, а потом обработал с помощью нейросети. Кто узнал фильм — тот молодец! :-)

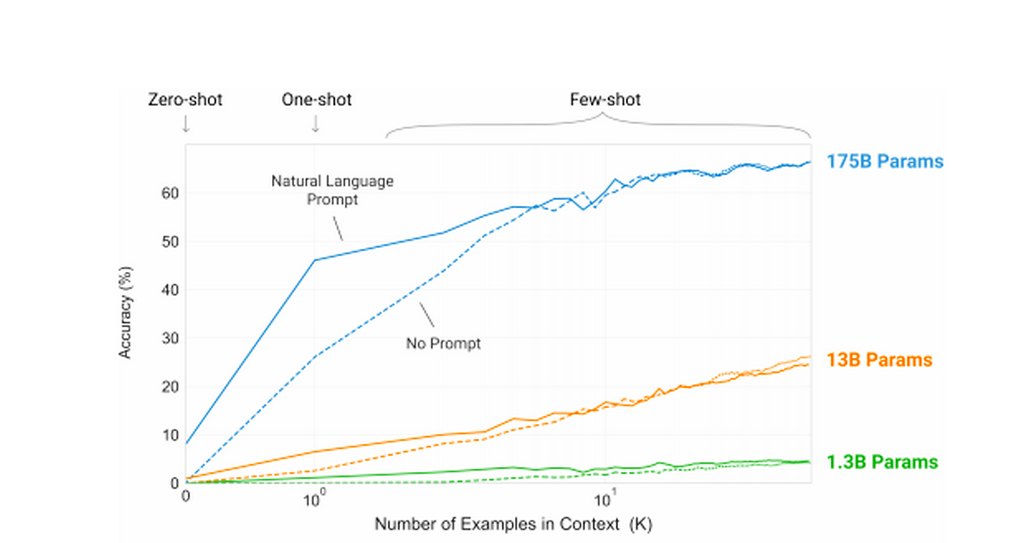

В мае 2020 года команда OpenAI выпустила новый алгоритм обработки естественного языка GPT-3. Сегодня это, без сомнения, лучший существующий алгоритм для данной цели.

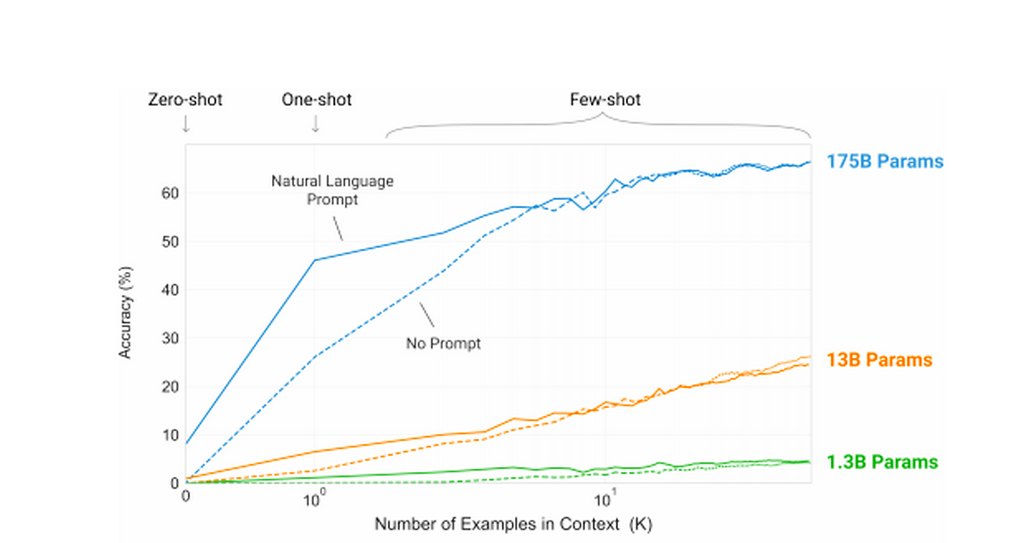

Улучшения системы по сравнению с прошлой версией GPT-2 просто колоссальные. Количество параметров алгоритма увеличилось более чем в 100 раз. GPT-3 использует 175 млрд. параметров, когда GPT-2 использовал только 1,5 млрд.

И если раньше нейросеть могла генерировать текст, который только приблизительно напоминал человеческий, то сейчас её возможности куда шире.

Собственно, поэтому OpenAI не выпускают алгоритм в свободный доступ — с его помощью можно просто похоронить Интернет под лавинами фейковых новостей.

Потенциальная польза в GPT-3 просто огромна. От создания нового поколения голосовых помощников до разработки адаптивных игровых механик, которые выведут RPG на абсолютно новый уровень.

Наука о принятии решений — довольно свежая дисциплина, которая изучает научные теории о принятии решений. Чтобы решения принимались не по субъективному опыту или ощущениям ЛПРа, а с помощью анализа и сопоставления данных.

DI позволяет автоматизировать принятие рутинных и операционных решений, разгружая человека, принимающего решение.

Decision intelligence основывается на AI и глубоком обучении. InferVision, к примеру, обучали на 100 тыс. кейсов.

Конечно, при текущем развитии технологии AI ещё не может принимать объективно лучшие решения в системах со множественными вариантами. Ему просто не хватает мощностей и исходных данных для анализа. Но во многих моментах он позволяет исключить импульсивность человека, его ангажированность и банальные ошибки мышления. А ещё автоматизировать рутинные процессы принятия решений и сохранить время специалиста для решения сложных задач.

Облачные системы аналитики существовали и раньше, но в 2020 году динамика их развития сильно увеличилась.

Облачная аналитика позволяет упростить процесс использования больших массивов данных, которые часто обновляются. Единая система аналитики для всех подразделения компании помогает актуализировать результаты аналитики и ускорить их использование.

Аналитика в реальном времени — это следующий этап, к которому стремятся многие компании. Лучше оперировать горячими результатами анализа, который сделан несколько секунд назад. Ведь анализ, сделанный вчера, уже может оказаться неточным.

Облачная аналитика — это перспективный инструмент для гигантов бизнеса, которые имеют отделы аналитики в каждом филиале. Поэтому крупные компании типа IBM сегодня плотно занимаются разработкой таких систем.

Связанное с облачной аналитикой, но при этом самостоятельное явление.

Качество данных для анализа критично. Если у стартапа нет возможности провести глобальное маркетинговое исследование, то он рискует двигаться вслепую, не зная реальных потребностей ЦА.

Но сейчас аналитику можно купить. Маркетплейсы данных — это полноценные рынки информации. Известная Statista — один из первых подобных маркетплейсов, но сейчас отрасль растёт колоссальными темпами.

Рынок Big Data в 2020 году составляет 138,9 млрд. долларов. Эксперты прогнозируют, что к 2025 он вырастет до 229,4 млрд. Это колоссальные масштабы, в которых львиную долю будет занимать именно продажа информации, а не её майнинг.

Хайп по поводу блокчейна уже немного прошёл. Это в 2017 году только ленивый не хотел запустить свою криптовалюту, а в 2020 блокчейн используют в более прагматичных целях.

Комбинацию блокчейн и big data называют идеальным союзом. Блокчейн сосредоточен на вычленении и записи достоверных данных, data science анализирует большие массивы данных, чтобы находить паттерны развития и делать прогнозы.

Big data — это количество, а блокчейн — качество.

Потенциальных преимуществ от интеграции блокчейна в анализ big data просто куча:

Блокчейн для KYC (know your customers). Технология используется банками и государственными организациями. Но так как между разными организациями нет общего хранилища данных, в каждой из них проходить идентификацию нужно отдельно. Блокчейн решает эту проблему.

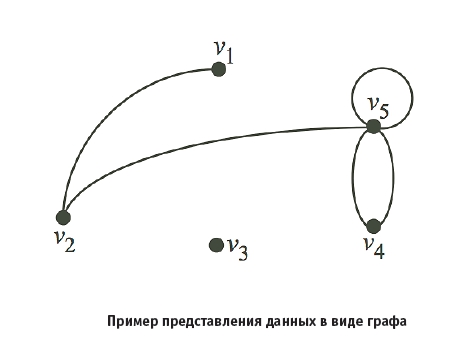

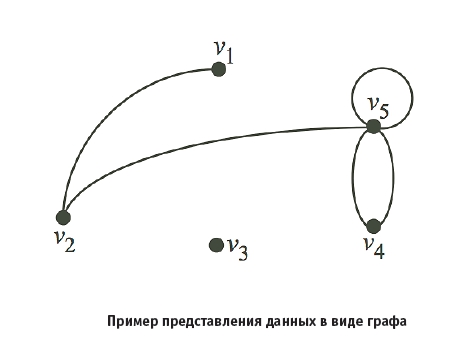

Не самый популярный и распространённый тип СУБД. Он разработан специально для хранения топологий, которые включают в себя узлы и их взаимосвязи. Это не просто набор данных в классическом формате таблицы. Сама их суть отличается.

В основе графов — именно связи между сущностями, а не сами сущности.

И это просто клондайк для маркетинга. Ведь анализ графовых БД можно использовать для анализа лидеров мнений и инфлуенсеров в соцсетях, персонификации рекламы, программ лояльности, анализа вирусных кампаний, усиления SEO и много другого.

Графы позволяют анализировать сложные иерархические структуры, которые с помощью реляционных БД моделировать было бы проблематично.

В 2020 году значительно увеличился интерес к графовым СУБД. Их используют Ebay, Airbnb, IBM, Adobe, NBC News и десятки других крупных компаний. И специалисты, которые умеют хорошо работать с графовыми БД, ценятся на вес золота.

Python продолжает захватывать мировой рынок аналитики и разработки. И его позиции только укрепляются. Вот в этой статье можно почитать подробнее.

В рейтинге PYPL, Python, который анализирует Google Trends уверенно лидирует.

В рейтинге GitHub по количеству пулреквестов Python занимает второе место: 15,9% от общего числа всех пулреквестов. Для сравнения: язык R, с которым Python всегда соперничает в аналитике, находится аж на 33-м месте, и на его долю приходится только 0,09% пулреквестов.

Специалисты с владением Python в аналитике нужны больше. Мы не так давно анализировали рынок вакансий Data Science в России и обнаружили, что владение Python нужно в 81% вакансия, а вот R (без Python) требуют только в 3% случаев.

R остается хорошим языком для аналитики, но Python практически полностью захватил рынок. Если в 2012 году они находились примерно в равном положении, то сейчас лидерство Python неоспоримо. И с этим нужно считаться.

2020 год принёс в Data Science много нового, ведь сама сфера аналитики больших данных сейчас активно развивается. Безусловно, это далеко не все тренды, о которых стоит упомянуть. И отдельный вопрос дата-сайентистам — а какие профессиональные тренды повлияли на вашу работу в этом году больше всего? Нам очень интересно услышать.

ИИ и нейросети

Искусственный интеллект хоть всё ещё испытывает трудности с тестом Тьюринга, но успехи на этом поприще есть.

В мае 2020 года команда OpenAI выпустила новый алгоритм обработки естественного языка GPT-3. Сегодня это, без сомнения, лучший существующий алгоритм для данной цели.

Улучшения системы по сравнению с прошлой версией GPT-2 просто колоссальные. Количество параметров алгоритма увеличилось более чем в 100 раз. GPT-3 использует 175 млрд. параметров, когда GPT-2 использовал только 1,5 млрд.

И если раньше нейросеть могла генерировать текст, который только приблизительно напоминал человеческий, то сейчас её возможности куда шире.

Один студент в своём аккаунте Apolos публиковал статьи, написанные GPT-3. Не очень сложные, в стиле мотивационного тренера. И только один из десятков тысяч читателей заподозрил, что статьи написаны не человеком.

Собственно, поэтому OpenAI не выпускают алгоритм в свободный доступ — с его помощью можно просто похоронить Интернет под лавинами фейковых новостей.

Потенциальная польза в GPT-3 просто огромна. От создания нового поколения голосовых помощников до разработки адаптивных игровых механик, которые выведут RPG на абсолютно новый уровень.

Кстати, вы уже пробовали AI Dungeon, текстовую игру, которую ведет GPT-3? Если вдруг нет, попробуйте, это очень интересный опыт. Вот в этой статье описан один из таких опытов.

Decision intelligence

Наука о принятии решений — довольно свежая дисциплина, которая изучает научные теории о принятии решений. Чтобы решения принимались не по субъективному опыту или ощущениям ЛПРа, а с помощью анализа и сопоставления данных.

DI позволяет автоматизировать принятие рутинных и операционных решений, разгружая человека, принимающего решение.

Медицинская система InferVision, основанная на алгоритме Alpha Go, была запущена в 2015 году, а именно в 2020 она показала всю свою мощь. В Китае многократно выросло число людей, проходящих компьютерную томографию. Специалисты просто не справлялись с обработкой результатов. Ведь на анализ одного КТ медику нужно от 10 до 30 минут.

На помощь пришла InferVision, которая анализировала КТ за 5 секунд. Это позволило сразу отсеивать здоровых людей, у которых нет патологических изменений в легких. А у людей с патологиями система сразу же выдавала предполагаемый диагноз. Естественно, всё это проводилось под контролем специалиста, и решения принимал именно он, но это позволило сократить время на обработку одного анализа в несколько раз.

Decision intelligence основывается на AI и глубоком обучении. InferVision, к примеру, обучали на 100 тыс. кейсов.

Конечно, при текущем развитии технологии AI ещё не может принимать объективно лучшие решения в системах со множественными вариантами. Ему просто не хватает мощностей и исходных данных для анализа. Но во многих моментах он позволяет исключить импульсивность человека, его ангажированность и банальные ошибки мышления. А ещё автоматизировать рутинные процессы принятия решений и сохранить время специалиста для решения сложных задач.

Облачная аналитика

Облачные системы аналитики существовали и раньше, но в 2020 году динамика их развития сильно увеличилась.

Облачная аналитика позволяет упростить процесс использования больших массивов данных, которые часто обновляются. Единая система аналитики для всех подразделения компании помогает актуализировать результаты аналитики и ускорить их использование.

Аналитика в реальном времени — это следующий этап, к которому стремятся многие компании. Лучше оперировать горячими результатами анализа, который сделан несколько секунд назад. Ведь анализ, сделанный вчера, уже может оказаться неточным.

Облачная аналитика — это перспективный инструмент для гигантов бизнеса, которые имеют отделы аналитики в каждом филиале. Поэтому крупные компании типа IBM сегодня плотно занимаются разработкой таких систем.

Маркетплейсы данных

Связанное с облачной аналитикой, но при этом самостоятельное явление.

Качество данных для анализа критично. Если у стартапа нет возможности провести глобальное маркетинговое исследование, то он рискует двигаться вслепую, не зная реальных потребностей ЦА.

Но сейчас аналитику можно купить. Маркетплейсы данных — это полноценные рынки информации. Известная Statista — один из первых подобных маркетплейсов, но сейчас отрасль растёт колоссальными темпами.

Естественно, персональными данными никто не торгует (по крайней мере легально). Имена и фамилии, адреса проживания, номера телефонов и email защищены законом. Но вот обезличенные данные продавать можно. А там очень много полезного для бизнеса. Возраст и пол, социальное положение, предпочтения, сфера работы, хобби, национальность и сотни других параметров, которые вы оставляете в сети, вплоть до выбора гаджетов на iOS или Android. Вспоминаем старую истину — если что-то в сети бесплатно, то возможно оплатой являетесь вы сами.

Рынок Big Data в 2020 году составляет 138,9 млрд. долларов. Эксперты прогнозируют, что к 2025 он вырастет до 229,4 млрд. Это колоссальные масштабы, в которых львиную долю будет занимать именно продажа информации, а не её майнинг.

Блокчейн в аналитике

Хайп по поводу блокчейна уже немного прошёл. Это в 2017 году только ленивый не хотел запустить свою криптовалюту, а в 2020 блокчейн используют в более прагматичных целях.

Комбинацию блокчейн и big data называют идеальным союзом. Блокчейн сосредоточен на вычленении и записи достоверных данных, data science анализирует большие массивы данных, чтобы находить паттерны развития и делать прогнозы.

Big data — это количество, а блокчейн — качество.

Потенциальных преимуществ от интеграции блокчейна в анализ big data просто куча:

- Улучшение безопасности данных и результатов аналитики.

- Сохранение максимальной целостности данных.

- Предотвращение использования неправдивых данных.

- Аналитика в реальном времени.

- Улучшение качества big data.

Блокчейн для KYC (know your customers). Технология используется банками и государственными организациями. Но так как между разными организациями нет общего хранилища данных, в каждой из них проходить идентификацию нужно отдельно. Блокчейн решает эту проблему.

Платформа Samsung Nexleger, которую запустили в Корее, упрощает эту схему. Теперь достаточно пройти полную процедуру идентификации только в одном банке или организации. Если нужно будет создать аккаунт в банке, который входит в систему проекта, то сделать это можно за несколько минут. Теперь все круги бюрократического ада нужно пройти только один раз — и все.

Графовые базы данных

Не самый популярный и распространённый тип СУБД. Он разработан специально для хранения топологий, которые включают в себя узлы и их взаимосвязи. Это не просто набор данных в классическом формате таблицы. Сама их суть отличается.

В основе графов — именно связи между сущностями, а не сами сущности.

И это просто клондайк для маркетинга. Ведь анализ графовых БД можно использовать для анализа лидеров мнений и инфлуенсеров в соцсетях, персонификации рекламы, программ лояльности, анализа вирусных кампаний, усиления SEO и много другого.

Графы позволяют анализировать сложные иерархические структуры, которые с помощью реляционных БД моделировать было бы проблематично.

В 2020 году графовый анализ активно использовали для трекинга распространения вируса в Китае и за его пределами. Исследование основано на динамических данных 200 стран, что позволяет прогнозировать дальнейшее развитие ситуации в мире и принять меры, чтобы смягчить последствия. Если интересно, полное исследование здесь.

В 2020 году значительно увеличился интерес к графовым СУБД. Их используют Ebay, Airbnb, IBM, Adobe, NBC News и десятки других крупных компаний. И специалисты, которые умеют хорошо работать с графовыми БД, ценятся на вес золота.

Python в Data Science

Python продолжает захватывать мировой рынок аналитики и разработки. И его позиции только укрепляются. Вот в этой статье можно почитать подробнее.

В рейтинге PYPL, Python, который анализирует Google Trends уверенно лидирует.

В рейтинге GitHub по количеству пулреквестов Python занимает второе место: 15,9% от общего числа всех пулреквестов. Для сравнения: язык R, с которым Python всегда соперничает в аналитике, находится аж на 33-м месте, и на его долю приходится только 0,09% пулреквестов.

Специалисты с владением Python в аналитике нужны больше. Мы не так давно анализировали рынок вакансий Data Science в России и обнаружили, что владение Python нужно в 81% вакансия, а вот R (без Python) требуют только в 3% случаев.

R остается хорошим языком для аналитики, но Python практически полностью захватил рынок. Если в 2012 году они находились примерно в равном положении, то сейчас лидерство Python неоспоримо. И с этим нужно считаться.

2020 год принёс в Data Science много нового, ведь сама сфера аналитики больших данных сейчас активно развивается. Безусловно, это далеко не все тренды, о которых стоит упомянуть. И отдельный вопрос дата-сайентистам — а какие профессиональные тренды повлияли на вашу работу в этом году больше всего? Нам очень интересно услышать.

Eще курсы

- Профессия Этичный хакер

- Frontend-разработчик

- Профессия Веб-разработчик

- Курс «Python для веб-разработки»

- Продвинутый курс «Machine Learning Pro + Deep Learning»

- Курс по Machine Learning

- Курс «Математика и Machine Learning для Data Science»

- Разработчик игр на Unity

- Курс по JavaScript

- Профессия Java-разработчик

- C++ разработчик

- Курс по аналитике данных

- Курс по DevOps

- Профессия iOS-разработчик с нуля

- Профессия Android-разработчик с нуля

nitrosbase

Близко к Gartner Top 10 Trends in Data and Analytics for 2020.

Ну разве что 375 пробы, если в РФ.

raamid

Сами что сказать-то хотели?