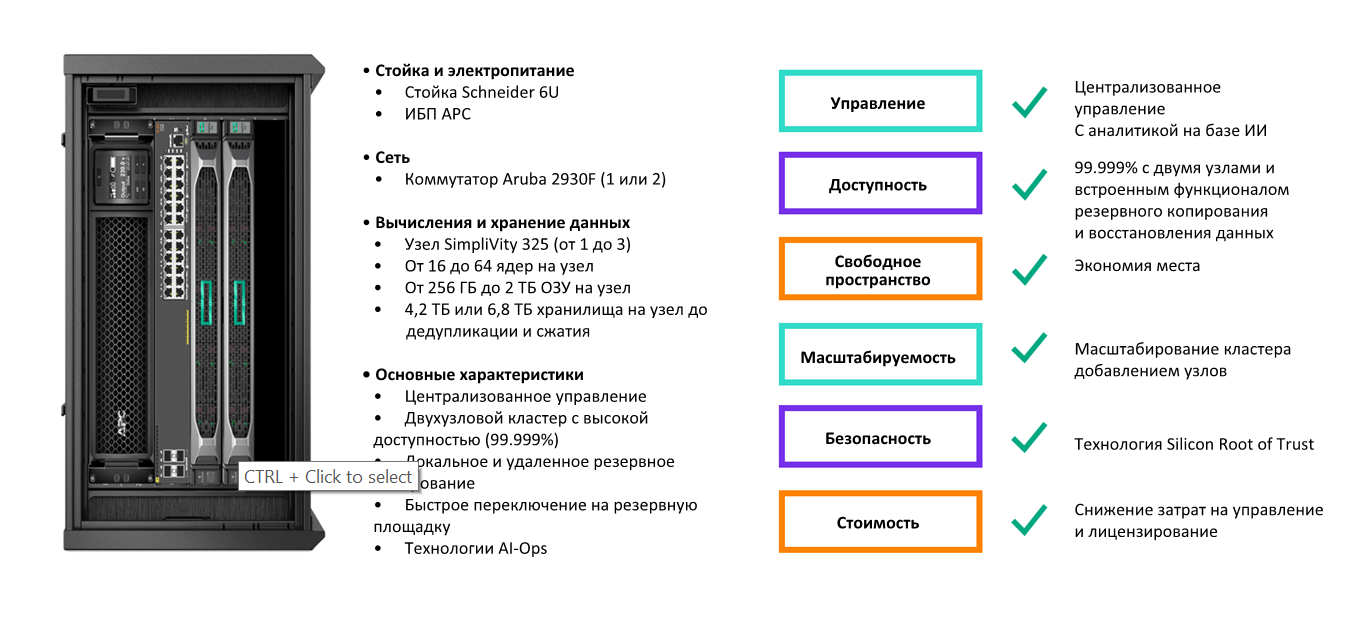

В заключительной статье серии приведем пример решения для вычислений на периферии, которое обеспечивает высокую доступность уже в двухузловой конфигурации. Это демонстрирует, насколько простым может быть развертывание инфраструктуры в филиалах. Приведенный ниже пример конфигурации включает полный стек оборудования: гиперконвергентные узлы, сеть, стойку и ИБП. Он довольно компактен и подходит для удаленных площадок с ограниченным пространством.

Общая информация о решении

В основе этой публикации находится опыт работы с заказчиками, ищущими компактные, экономически эффективные решения для вычислений на периферии с функцией высокой доступности. Как правило, заказчики, сталкиваются со следующими сложностями при реализации подобных проектов:

отсутствие ИТ-персонала на площадке;

обеспечение непрерывности бизнес-процессов;

сильно ограниченное пространство;

небольшой бюджет для каждой площадки.

Описываемое двухузловое решение обеспечивает высокую доступность системы в минимальной конфигурации. Если бы у гипотетического заказчика было несколько площадок, он мог бы развернуть такое на каждой из них и не только высокую доступность, но и возможность аварийного восстановления. Подробнее об этом написано в третьей части этой серии статей, в которой приведена информация о возможности HPE SimpliVity для защиты данных и аварийного восстановления (DR).

Рассмотрим подробнее предлагаемую конфигурацию.

Гиперконвергентная платформа

HPE SimpliVity 325 предоставляет гибкость при выборе конфигурации вычислительных ресурсов и поставляется в двух вариантах ёмкости в зависимости от требований к системе хранения. Ключевыми моментами здесь являются компактность благодаря высоте 1U, небольшая цена, а также обеспечение высокой доступности с возможностью локального резервного копирования. При наличии других филиалов или центральной площадки эта система также позволяет без дополнительных затрат реализовать резервирование данных между ними.

Два примера реализации гиперконвергентного решения с использованием платформы HPE SimpliVity 325, которая может поддерживать от 15 до 39 виртуальных машин.

Описание и сайзинг решения:

Платформа |

2 х SimpliVity 325 |

2 х SimpliVity 325 |

ЦП |

3,0 ГГц / 16 ядер |

2,5 ГГц / 32 ядра |

ОЗУ |

256 ГБ |

512 ГБ |

Система хранения данных |

4 SSD x 1,92 ТБ |

6 SSD x 1,92 ТБ |

Сеть 1 Гбит/с |

4 порта Base-T x 1 Гбит/с |

4 порта Base-T x 1 Гбит/с |

Сеть 10 Гбит/с |

2 порта SFP+ x 10 Гбит/с |

2 порта SFP+ x 10 Гбит/с |

Электропитание |

2 блока питания Platinum Hot Plug 800 Вт |

2 блока питания Platinum Hot Plug 800 Вт |

Сайзинг решения |

15 ВМ |

48 ВМ |

Соотношение виртуальных и физических процессоров |

6:1 |

6:1 |

Переподписка ОЗУ |

Без переподписки |

Без переподписки |

Количество виртуальных ЦП на ВМ |

4 |

4 |

Объем ОЗУ на ВМ |

8 ГБ |

8 ГБ |

Виртуальный диск ВМ |

100 ГиБ |

100 ГиБ |

Общее количество виртуальных ЦП, необходимых для рабочей нагрузки |

60 |

192 |

Общий объем ОЗУ, необходимый для рабочей нагрузки |

120 ГБ |

384 ГБ |

Общий объем системы хранения на виртуальном диске |

1,5 ТиБ |

4,8 ТиБ |

Общее количество доступных виртуальных ЦП |

120 |

384 |

Общий доступный объем ОЗУ |

211 ГБ |

464 ГБ |

Общий объем системы хранения, доступный с дедупликацией и сжатием |

4,9 ТиБ |

7,9 ТиБ |

Количество виртуальных ЦП, доступных при отказе узла |

60 |

192 |

Объем ОЗУ, доступный при отказе узла |

211 ГБ |

464 ГБ |

Объем системы хранения, доступный при отказе узла |

4,9 ТиБ |

7,9 ТиБ |

На практике всегда нужно отталкиваться от фактических требований заказчика, но приведенные выше примеры показывают, как может выглядеть расчет.Возможно также использовать 64-ядерные процессоры для снижения переподписки или увеличить объем памяти в узлах, если каждой ВМ нужно предоставить больше оперативной памяти. Оба приведенных варианта предлагает достаточный запас ёмкости хранилища, который можно использовать для резервного копирования виртуальных машин.

Вот пример политики резервного копирования, которую можно было бы применить:

Пример политики резервного копирования для двухузлового кластера SimpliVity 325:

Периодичность |

Местоположение резервных копий |

Объем изменных данных, % |

Срок хранения резервных копий |

Ежечасно |

Локальный кластер |

0,5 |

1 день |

Ежедневно |

Локальный кластер |

3 |

1 неделя |

Еженедельно |

Локальный кластер |

8 |

1 месяц |

Ежемесячно |

Локальный кластер |

26 |

3 месяца |

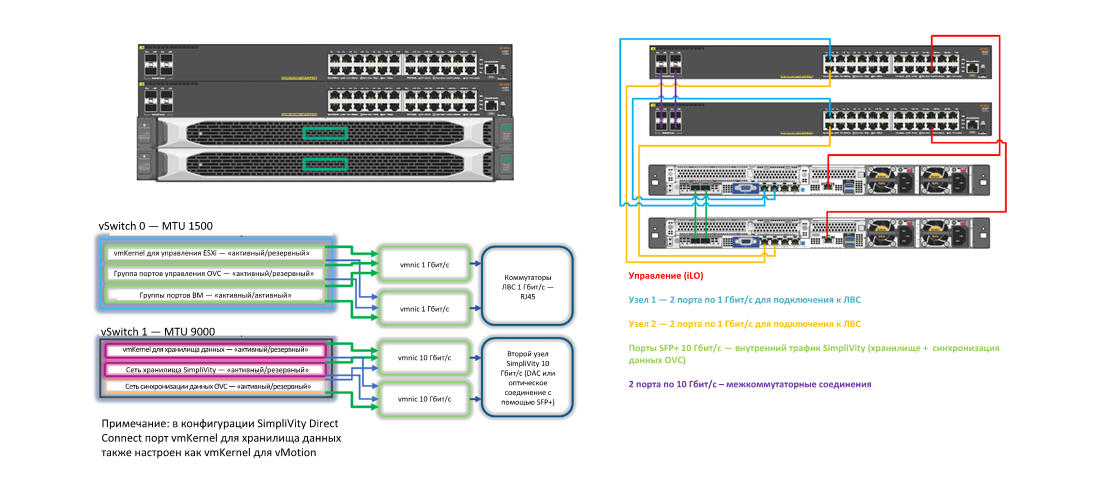

Сеть

Также понадобятся два коммутатора и чаще всего внешнее подключение на скорости 10 Гбит/с не является обязательным требованием для инфраструктуры небольшого филиала. Однако, оно по-прежнему требуется для трафика гиперконвергентного хранилища, и, поскольку у нас всего два узла, мы можем напрямую соединить их. Стоит отметить, что если в кластере будет сразу три или более узлов или в перспективе он будет расширен до такой величины, то потребуются уже коммутаторы 10 Гбит/с.

Для снижения расходов были выбраны два коммутатора Aruba 2930F. Они предоставляют функции корпоративного уровня, и данные коммутаторы можно развертывать и управлять ими с помощью Aruba ClearPass Policy Manager, Aruba Airwave и Aruba Central.

Стойка и ИБП

Узкий шкаф для настенного монтажа Schneider Electrics высотой 6U —

это идеальный выбор для размещения оборудования в филиале с ограниченным пространством. Шкаф может быть оснащен колесами, чтобы он мог стоять на полу, или его можно закрепить на стене с помощью соответствующих кронштейнов. В нем можно легко разместить ИБП, систему распределения электроэнергии, средства мониторинга окружающей среды и обеспечения физической безопасности, а также сетевое оборудование и серверы.

Совместно со Schneider Electric было подготовлено комплексное техническое решение, которое позволило решить все ставившиеся перед комплексом задачи задачи. Например, для защиты от повреждения данных при длительном отключении электропитания в систему было добавлено ПО PowerChute для управления ИБП компании Schneider Electric, которое обеспечивает корректное выключение гиперконвергентной системы при низком уровне заряда батарей.

Собираем все вместе

Теперь у нас есть все компоненты для создания простого стека филиальной инфраструктуры, решающего типичные проблемы, обсуждавшиеся в части 1.

Гиперконвергентная инфраструктура для периферийных вычислений, часть 1. Проблемы удаленных офисов и филиалов.

Гиперконвергентная инфраструктура для периферийных вычислений, часть 2. Управление несколькими удаленными площадками.

Гиперконвергентная инфраструктура для периферийных вычислений, часть 3. Отказоустойчивость и высокая доступность.

Гиперконвергентная инфраструктура для периферийных вычислений, часть 4. Резервное копирование и аварийное восстановление.

Гиперконвергентная инфраструктура для периферийных вычислений, часть 5. Отказоустойчивость и масштабируемость.

Гиперконвергентная инфраструктура для периферийных вычислений, часть 6. Эффективная защита данных.

amarao

Я всё время хотел спросить. А чем гиперконвергентная инфраструктура отличается от суперконвергентной или просто конвергентной? В чём состоят конкуретные преимущества использвания гиперконвергентных сетей в сравенении с суперконвергентными?

Спасибо!