Компания Stability.ai объявила о публичном релизе модели графической нейросети Stable Diffusion. Можно подумать, что это лишь очередная новость о том, что в мире искусства появилась ещё одна рядовая нейросеть. Но это далеко не так по двум причинам, одну из которых вы видите в хабах. Подробности — к старту нашего флагманского курса по Data Science.

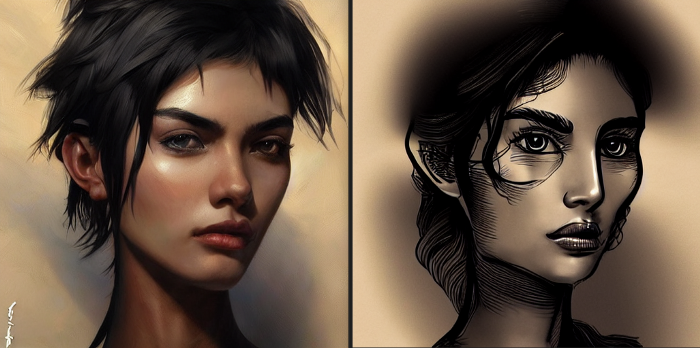

HollyB#1382 (портрет)

Во-первых, в отличие от сравнимых с ней по качеству DALL·E 2 и Midjourney, нейросеть Stable Diffusion имеет открытый исходный код. Поэтому любой желающий может бесплатно создавать на её основе приложения для решения конкретных задач по преобразованию текста в изображение.

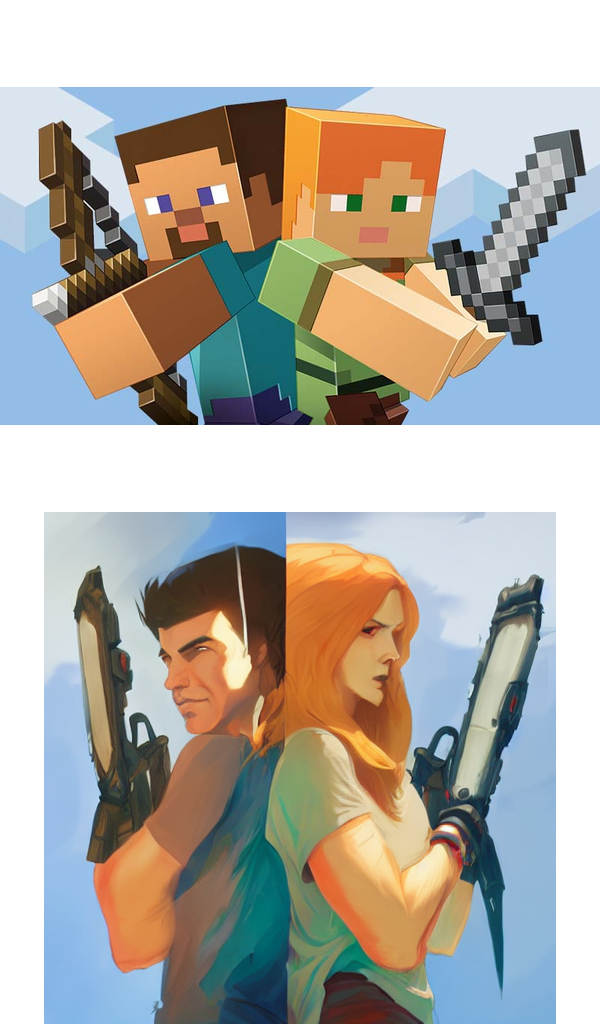

Люди уже создают проекты на Google Colab из текстовых описаний (от Deforum и Pharmapsychotic), а также в плагине Figma и пользуются поисковыми системами для поиска текстовых описаний, сгенерированных изображений и начальных значений Lexica.art. Кроме того, разработчики Midjourney предусмотрели возможность комбинирования этой нейросети со Stable Diffusion, что привело к удивительным результатам (такая возможность временно отключена, но может вскоре снова стать доступной, как только будет решена проблема вредоносного потенциала такой связки):

Midjourney + Stable Diffusion; alessandrochille, Darken, eyecon01

Пока я пишу эти строки, с релиза Stable Diffusion не прошло и трёх суток. Трудно представить себе, что может произойти в последующие недели и месяцы.

Прокачать ваши навыки или погрузиться в IT впервые помогут флагманские курсы SkillFactory:

Во-вторых, в отличие от сопоставимых по открытости кода DALL·E mini (Craiyon) и Disco Diffusion, Stable Diffusion позволяет создавать фотореалистичные и эстетичные произведения искусства, не уступающие по качеству моделям OpenAI и Google. Многие даже утверждают, что это высокотехнологичная «генеративная поисковая система», как любит называть подобные разработки Мостак.

Чтобы вы смогли оценить уровень художественности и технологичности Stable Diffusion, я добавлю несколько своих любимых изображений, найденных мной в сообществах на Discord (все эти изображения созданы Stable Diffusion, если нет указания об обратном).

ai_coo#2852 (стрит-арт)

Stable Diffusion воплощает всё лучшее, что есть в нейросетях мира искусства: это, возможно, лучшая из существующих графических нейросетей с открытым исходным кодом. Она пока не имеет аналогов, и её, без сомнения, ждёт большое будущее.

В своих статьях я часто писал о нейросетях на стадии разработки — за годы до того, как они станут пригодными для повседневного применения. Эти статьи интересны лишь с теоретической точки зрения, но Stable Diffusion — пример модели, интересной и с теоретической, и с практической точек зрения. Она совмещает наработки современных исследований и опыт реального применения. Приложения на её основе уже создаются, и вы уже очень скоро сможете использовать их для решения серьёзных и не очень серьёзных задач.

Любопытно, что новости о подобных сервисах могут приходить от тех, от кого вы их совсем не ждёте. От родителей, детей, супругов, друзей и коллег. Словом, все те, кому совершенно чужд мир графических нейросетей, могут неожиданно узнать о новинках в этой области. Через графику технологии ИИ способны достучаться даже до тех, кто привык не замечать стремительного приближения будущего. Разве это не поэтично?

HollyB#1382 (морской пейзаж)

Stable Diffusion — нечто большее, чем DALL·E 2 с открытым кодом

Студия Stability.ai создана, чтобы «разрабатывать открытые нейросети для реализации наших возможностей». Это не экспериментальные модели, которые большинство людей никогда не увидит. Это инструменты, применение которым может найти каждый. И это выгодно отличает нейросеть от OpenAI, где секреты лучших разработок (GPT-3 и DALL·E 2) охраняют как тайну мироздания, и Google, где бета-версии собственных систем (PaLM, LaMDA, Imagen и Parti) пока даже не планируются. Уже несколько месяцев назад до меня дошли слухи о том, что Stability.ai создали нечто большее, чем запланированная ими альтернатива DALL·E 2.

Основатель Stability.ai Имад Мостак учился на ошибках OpenAI. К примеру, то, что нейросеть Craiyon стала по-настоящему вирусной, лишь доказывает, что закрытая бета-версия DALL·E имела ряд недостатков. Люди хотят не наблюдать, как создаются шедевры, а создавать их. Поскольку публичный релиз не раскрывал ни код, ни веса модели, до которой нет дела большинству пользователей, студия Stability.ai сама сделала этот важный шаг. Она создала готовую к работе онлайн-платформу для тех, кто не умеет или не хочет программировать.

Twobob#2909 (природа)

Эта платформа называется DreamStudio Lite. Она позволяет бесплатно генерировать до 200 изображений, чтобы оценить глубину возможностей Stable Diffusion. Подобно DALL·E 2, здесь есть также платная подписка: за 10£ вы сможете создать до 1000 изображений (OpenAI раз в месяц возвращает 15 кредитов, но, чтобы получить больше, вам нужно приобрести 115 кредитов за 15$). Для большей ясности приведём эти цены к общему знаменателю: в DALL·E изображение стоит 3 цента, а в Stable Diffusion — всего 1 цент.

Stable Diffusion можно использовать через API (стоимость масштабируется линейно: 100 сгенерированных изображений обойдутся вам в 1£). Помимо генерации изображений Stability.ai в ближайшее время анонсирует DreamStudio Pro (аудио/видео) и Enterprise (студиям).

Стоит также отметить, что помимо создания изображений по текстовому описанию DreamStudio в ближайшее время реализует функцию генерации одних изображений из других также с использованием текстового описания. Вот несколько примеров:

clif08#7318

symmetry#5379

Neverduft#5541

На том же сайте есть ресурс для подбора запроса, который пригодится всем, кому это в новинку (ведь найти «общий язык» с моделями чрезвычайно сложно). Здесь, в отличие от DALL·E 2 (и даже Craiyon), можно через параметры влиять на результат и лучше им управлять.

Студия Stability.ai сделала всё возможное, чтобы упростить доступ к моделям. OpenAI были пионерами, поэтому их движение вперёд замедляла необходимость просчитывать все риски и случаи необъективности модели. И всё же OpenAI не стоило так затягивать закрытое бета-тестирование и создавать бизнес-модель подписки, которая ограничивает свободу творчества. Midjourney и Stable Diffusion уже доказали это.

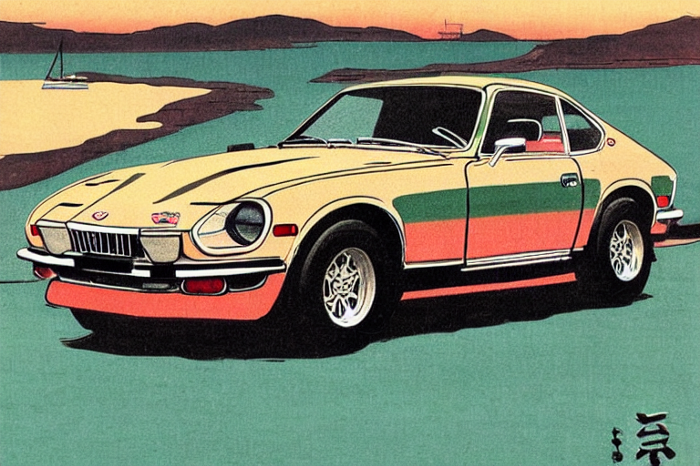

RobotElbows#3572 (стиль укиё-э)

Открытость и безопасность важнее приватности и контроля

У технологий с открытым кодом тоже есть ограничения. Как я уже писал в статье GPT-4chan ‘the Worst AI Ever’, открытость важнее приватности и жёсткого контроля, но она никогда не должна угрожать безопасности.

Студия Stability.ai относится к этому серьёзно. Поэтому она подключает юристов и специалистов по этике сообщества Hugging Face к распространению моделей по лицензии Creative ML openRAIL-M (на условиях, близких к модели BigScience’s BLOOM). Как сказано в анонсе, это «либеральная лицензия на коммерческое и некоммерческое использование», которая предусматривает открытый, но ответственный подход к последовательному использованию моделей. При этом любые производные работы должны распространяться на не менее ограничительных условиях.

not#2122 (витраж)

Модель с открытым кодом — очень важный шаг, но не менее важно создать защитные механизмы, которые не дадут этой модели стать орудием обмана и самоутверждения за счёт нарушения чужих прав. Однако эти нежелательные последствия возможны и без нарушения условий лицензии. В своём блоге Имад Мостак написал об этом так: «Поскольку мы обучали эти модели на парах «изображение — текст», найденных на широких просторах всемирной паутины, модель может воспроизводить некоторые предрассудки общества и создавать опасный контент, поэтому смягчение этого эффекта и открытое обсуждение подобных искажений могут привести всех к нужному диалогу». Открытость и безопасность в любом случае важнее приватности и контроля.

Открытый код — новые горизонты

Благодаря прочным этическим ценностям и открытости Stable Diffusion планирует обойти конкурентов в степени влияния на мировые реалии. Тем, кто хочет скачать эту нейросеть и запустить её с жёсткого диска, нужно учесть, что это потребует 6,9 Гб VRAM, а это соответствует высококлассному GPU. Легче DALL·E 2, но для компьютеров большинства неподготовленных пользователей — ноша неподъёмная. Если вы готовы к такому, то можете, как и я, пользоваться Dream Studio.

pontap#4224 (акварель)

Повсеместно признаваемая лучшей генеративной моделью, Stable Diffusion станет основой для разработки бесчисленных приложений, сайтов и сервисов, которые изменят то, как люди творят и работают с произведениями искусства. До сих пор, чтобы получить достойные результаты, приходилось использовать DALL·E 2 или Midjourney, ограниченные своей полной непрозрачностью (Craiyon лучше подходит для мемов, но не соответствует требованиям профессионального качества).

А теперь приложения под самые разные задачи вырастут как грибы после дождя, и ими сможет воспользоваться каждый. Уже сейчас многие улучшают детские рисунки, собирают коллажи при помощи внешней и внутренней ретуши, создают обложки журналов, рисуют мультфильмы, делают различные трансформационные и анимационные видеоролики, одни изображения из других…

Многие из этих возможностей доступны в DALL·E и Midjourney, однако Stable Diffusion поднимет графику на новый уровень. Этого мнения придерживается и Андрей Карпати: «Я считаю день релиза Stable Diffusion историческим для человеческого творчества, спрессованного в единый и общедоступный артефакт. Это значимая часть фазового перехода к слиянию работы естественного и искусственного интеллекта, сферы, в которой мы прежде не сдвинулись ни на дюйм».

Stable Diffusion приводит к очень важному диалогу

Глобальные перемены радуют далеко не всех. Как я уже писал в статье о графических нейросетях How Today’s AI Art Debate Will Shape the Creative Landscape of the 21st Century, «… мы сталкиваемся с очень непростой ситуацией — и открытый код всё лишь усугубляет. Художники и другие творческие личности бьют тревогу, и тому есть причина. Многие из них потеряют работу, ведь не сумеют успешно конкурировать с современными программами. Такие компании, как OpenAI, Midjourney и Stability.ai, построили свой успех на плодах творчества многих художников. И вместо вознаграждения они «без спроса посадили им на шею» всю целевую аудиторию своих нейросетей».

Как я написал в той же статье, нейросеть уровня Stable Diffusion — это новый класс программных инструментов. Чтобы её понять, нужно адаптировать мышление к новым реалиям. Результаты появления таких нейросетей нельзя точно предсказать по аналогиям с прошлым. Какие-то из них мы уже видели, а какие-то увидим впервые. Будущее, которое нас ждёт, — неизведанная территория, и относиться к нему нужно соответствующим образом.

HollyB#1382 (портрет)

Заключение

Публичный релиз Stable Diffusion — это, без сомнения, самое важное и значимое событие в мире графических нейросетей. И это только начало. Имад Мостак написал в Twitter: «Поскольку наши модели быстрее, лучше и специфичнее, можно ожидать, что их качество вырастет по всем направлениям. Не только изображения, но со следующего месяца и аудио, а дальше мы перейдём к 3D и видео. Язык, код и больше машинного обучения уже сейчас...»

Мы стоим на пороге революции, которая продлится несколько лет и изменит наше понимание графики и творчества в целом, взаимодействие с ними и отношение к ним. И не только в философском и интеллектуальном ключе, но как нечто общее и переживаемое каждым из нас. Мир творчества уже никогда не будет прежним, и мы должны быть открытыми новому и уважать друг друга, чтобы вместе построить это светлое будущее. Только ответственное отношение к технологиям с открытым кодом приведёт к тем переменам, которые мы будем рады увидеть.

Joe#5956 (городской пейзаж)

Попробуйте запрос beautiful. Он может вас удивить.

А мы поможем прокачать ваши навыки или освоить профессию, востребованную в любое время:

Комментарии (34)

DistortNeo

30.08.2022 23:40+7Тем, кто хочет скачать эту нейросеть и запустить её с жёсткого диска, нужно учесть, что это потребует 6,9 Гб VRAM, а это соответствует высококлассному GPU под заказ.

Эмм? Это же обычная игровая видеокарта.

gxcreator

31.08.2022 01:49+12For those of you who want to download it and run it on their computers, you should know that it takes 6.9Gb of VRAM — which fits in a high-end consumer GPU

МГИМО финишд

stranger777

31.08.2022 09:33+1И нет, это не "МГИМО" переводчика. Это моя ошибка, возникшая от усталости при редактировании, когда в сознании перепутались consumer и custom.

gxcreator

31.08.2022 09:59Как-то уже привык к такому в переводах в корпоративных блогах.

stranger777

31.08.2022 10:51+1Делаем всё возможное, чтобы избегать таких ошибок (перед глазами первым встал Git с его blame и diff, но есть, конечно, решения намного проще и лучше). Отсюда, на самом деле, эта самая усталость и такая большая пауза в публикациях: ставим блог на качественно новые рельсы. Ещё раз спасибо :)

mrise

02.09.2022 14:04Вот да. Когда текстовые нейросетки из арсенала Kobold AI начинаются с 8 гигов VRAMы, а заканчиваются переполнением гугловских TPU в colab-e при использовании слишком щедрых настроек, эти 7 гигов VRAMы выглядят довольно скромно.

amazed

31.08.2022 08:11+16Стиль статьи:

Мы на пороге, это великое событие, сейчас вас просто разорвет....

Бла-бла-бла... этика.... бла-бла-бла .. авторские права...

... бесплатно!...

Как читаются статьи подобного стиля итоге: "ага, кто-то сделал очередную ненужную хрень и хочет сорвать куш на хайпе".

В общем не лучший стиль для изложения материала.

Lsh

31.08.2022 12:17+1— Ты всего лишь машина. Только имитация жизни. Робот сочинит симфонию? Робот превратит кусок холста в шедевр искусства?

— А Вы?

Я, робот

badimao

31.08.2022 14:34+2В недалеком будущем.

Игра имеет лишь очертания сюжета. И это даже не сюжет, это внутренний голос игрока.

Игрок познает игру, а игра познает игрока.

И на основе его реакций, психотипа, желаний и представлений, рендерит мир который полностью соотвествует представлению игрока, историю для игрока про игрока.

И вот в этот момент, возникает подозрение, а не обстоят ли уже дела на самом деле так...

ainu

31.08.2022 14:57+3Тем, кто хочет скачать эту нейросеть и запустить её с жёсткого диска, нужно учесть, что это потребует 6,9 Гб VRAM, а это соответствует высококлассному GPU под заказ.

На самом деле, можно запустить и на 1050ti (4 гигабайт), и на 1070 (8 гигабайт), я и там и там запускаю. На 1070 в режиме "турбо" (ест дополнительный гигабайт), на одну картинку в 50 шагов уходит 39 секунд.

Также на днях появилась версия для CPU, генерация занимает три минуты.

DROS

01.09.2022 10:31@ainu , а можно линки на репы? А то в многообразии зеркал ничего толкового не ищется.

ainu

01.09.2022 11:30+3Я долгое время пользовался вот этим https://github.com/basujindal/stable-diffusion, это форк оригинальной версии, который делит на кусочки сетку, и по очереди засовывает в видеопамять - в десять раз дольше, но можно запустить даже на 1050ti. Самый нормальный способ - запуска - python optimizedSD\txt2img_gradio.py - вебинтерфейс, чтобы между генерациями не грузить модель в память каждый раз.

Но начиная с сегодняшнего вечера хочу перейти на https://github.com/AUTOMATIC1111/stable-diffusion-webui, пост на реддите, больно красиво выглядит, и есть новые крутые киллер-фичи, которые запрашиваются сообществом. Там же есть гайд, где получить файл ckpt версии 1-4 (я магнет-ссылкой качал).

Для запуска на процессорах, AMD и прочих необычностях, советую глянуть вот такую подборку https://www.reddit.com/r/StableDiffusion/comments/wqaizj/list_of_stable_diffusion_systems/

На реддите есть еще и несколько exe файлов, для тех, кто не умеет ставить питон, и вообще много чего есть.

Также часть пользователей используют телеграм-ботов (ссылок не дам, но они существуют, хабраэффект их сломает), а также многочисленные коллабы. Благодаря оптимизированной версии программы, SD может быть запущена в обычной бесплатной версии гугл-коллаба, я пользовался вот этим https://colab.research.google.com/github/pharmapsychotic/ai-notebooks/blob/main/pharmapsychotic_Stable_Diffusion.ipynb. Вообще коллабов полно, есть и для анимации, и для инпейтинга, и чего только нет.

habropaul

31.08.2022 22:33Что уважаемые хабровчане думают про апскейл аудиотреков в низком разрешении (раз уж аудио было упомянуто автором оригинальной статьи в конце)?

Я однажды немного поинтересовался темой, вот что мне удалось обнаружить.

На сайте энтузиастов в мире аудио (проводят измерения громкоговорителей и периферии), в теме посвященной апскейлу выяснилось, что пока данная тема скудна на соответствующие исследования. Пока среди посетителей сайта не нашёлся юзер, попытавшийся самолично произвести код для подобной махинации.

Вот что он пишет:

«Привет ребята! После нескольких часов тестирования различных моделей (GAN, RNN, CNN, DNN) я пришел к выводу, почему никто на самом деле этого не сделал.

Это невероятно сложно для последовательных данных!

Обработка и масштабирование изображений на самом деле не проблема, поскольку каждое обрабатываемое изображение замкнуто само на себя и не имеет отношения к другим изображениям. Однако музыка или звук в целом подобны одной непрерывной линии, потоку данных, сигналу. Проблема со звуком заключается в том, что если вы обрабатываете отдельные сегменты звукового файла, программа не знает другие сегменты, и поэтому возникает проблема хлопков и щелчков, поскольку первое и последнее значение отдельных сегментов редко совпадают. Вы можете исправить это с помощью некоторого сглаживания после обработки, но это просто уродливое решение…

Я думаю, что лучше всего передать весь аудиофайл; не только сегменты, а действительно весь файл в нейронную сеть. Но для этого требуется безумное количество вычислительной мощности и оперативной памяти. Это как если бы вы пытались накормить белку целой машиной мороженого вместо одной чайной ложки.

Я пытался. Независимо от того, насколько «маленькой» я пытался сделать песню, как только ты пытаешься отправить 3 минуты аудио через сеть, она становится эквивалентом данных из нескольких музыкальных альбомов. Даже моя RTX 3090 подняла белый флаг.

Так что либо вы арендуете суперкомпьютер или, по крайней мере, чрезвычайно дорогой облачный сервер для обучения ИИ, либо нам просто нужно подождать, пока кто-нибудь не подготовит очень хорошую статью по этому поводу. Глядя на ход развития искусственного интеллекта, это не должно занять много времени.»

Refridgerator

01.09.2022 06:05Этот юзер потерпел неудачу, потому что забыл о том, что нейросеть — это не ИИ. Нейросеть по сути — это база данных со сжатием и потерей информации, и данные для неё надо подготавливать. В случае аудио для этого потребуется как минимум FFT, (M)DCT или вейвлет-преобразование, а также манипуляции с каналами и кепстрами. Вейвлет-преобразование как раз и переводит аудио в изображение и наоборот — так что нет никаких преград для апскейла аудио, кроме необходимости овладевать матаном. И даже нет необходимости в нейросетях.

habropaul

01.09.2022 09:56Я недавно подумал о том, что данная область развития может являться бесперспективной в связи с утратой аудио-треками в эпоху масс-медиа субъективной ценности. Проще говоря, по меркам индустрии (которая и является главным аккумулятором всей творческой энергии наличествующей у людей, аналогично с Академией и знанием) — проще написать новый трек чем улучшать старый.

Апскейл аудио — это из разряда мечтаний ретроградов, которые хотят улучшить любимую пианинку, записанную в пятидесятых, или для рэперов с минусами в 192 kbps.

cepera_ang

31.08.2022 22:50+1Вирджин ОпенИИ: не будем выкладывать нашу нейронку, это может подорвать безопасность всего мира!11.

Чад Стабилити: выкладывает все в опенсорс с инструкциями как запустить на последнем чайнике.

Результат: Dalle генерирует только скучный корпоративный арт по приглашениям и за деньги и уже вынужден снижать цены в разы и о нём за полгода слышали только гики, а весь остальной мир играет с офигенно креативной стабилити, за неделю встроили уже везде, где только можно и разве что бабушки на лавочке ещё не обсуждают сюжеты о нём в новостях. И главное, никто ещё не пострадал, ни от сгенерированной дезинформации, ни от расистских картинок, ни от изображений оружия или сисек.

myhambr

01.09.2022 19:46Столько нейросетей постоянно выходит, сплошной прогресс каждый месяц.

Известите, когда наконец появится плагин к Photoshop или Lightroom, который наконец научится открывать закрытые глаза. Автоматически, без ручного вырезания. Можно с использование второго опорного кадра с открытыми глазами.

Про Akvis Chameleon знаю, но это долго и нудно, а хочет быстро, качественно, молодёжно и с нейросеткой за 1 клик.

vconst

02.09.2022 09:52Глаза — фик бы с ними. А вот апскейл нейросетью меня по настоящему удивил и порадовал. Кадр с дрона, ночью, шумноватый — увеличивается реально в два раза, с адекватным изменением деталей, элементы становятся тоньше, как будто реально камера имеет в два раза более высокое разрешение

VitalySh

Stable diffusion - как завораживающая игра. Можно поставить генерацию на ночь, а потом искать среди тысяч картин что-то достойное и интересное. А потом дорабатывать и преобразовывать.

Один из моих последних экспериментов в ней (все картины - результат прямой генерации Stable Diffusion, без пост обработки):

Портреты

dyadyaSerezha

С последней познакомишь?)

Lsh

На чём запускаете?

VitalySh

запускаю модифицированную версию https://github.com/basujindal/stable-diffusion на RTX 3080 10GB VRAM

EugeneH

Подскажите, пожалуйта, 2я и 3я картинки это img2img на основе первой или инпэинт? Или и то, и другое вместе?

Используете GFPGAN?

У меня пока не выходят нормальные портреты, но пейзажи сети определенно удаются.