Дискуссиями о том, насколько прекрасен (опасен, полезен, подчеркните нужное) ChatGPT в частности и искусственный интеллект вообще, полон интернет — на эту тему высказались все, от «песочницы» Хабра до Генри Киссинджера.

В принципе, такая громкость хайпа демотивирует говорить что-то своё — всё равно оно потонет в шуме. Однако на этой неделе меня довольно неожиданно попросили прочитать лекцию для студентов-гуманитариев из РГСУ — «Искусственный интеллект нового поколения: изменят ли ChatGPT и Midjourney экономику, политику и социальную сферу», и было бы не меньшим грехом дать подготовленному материалу пропасть, не зафиксировав его письменно.

Тем более, что абсолютное большинство уже написанных статей не дают читателям того, что я люблю больше всего — некоей цельной картины происходящего. Это либо частное мнение, либо быстро уходящие в тензорную алгебру описания нейросетей, либо просто узкие демонстрации, что можно сделать (что конкретно сделал автор) в генеративной нейросети.

О чём же мы будем говорить?

Разумеется, о королях и капусте. А также о том, какой бывает искусственный интеллект, можно ли считать его разумным, в чём его главная проблема, спасут ли нас три закона робототехники, на какие профессии он повлияет, а какие — породит (и даже уже породил).

Подчеркну, что материал готовился для гуманитариев — социологов, политологов, et cetera — поэтому далее я буду всеми силами избегать погружения в математику, программирование или иные специализированные вещи.

Поехали!

Немного определений

В первую очередь, конечно, надо определиться с терминологией — тем более, что в области ИИ она не только до сих пор не всегда конкретна, но и силами журналистов превращается в полный винегрет, в котором путается всё и вся.

Итак, давайте условимся, что ИИ у нас может быть представлен в трёх возможных весовых категориях.

AI — Artificial Intelligence — узкоспециализированный ИИ, предназначенный для решения одной конкретной задачи. Примером AI являются, например, нейросети распознавания изображений, предназначенные для поиска на них конкретных объектов — скажем, котиков.

Этот вид AI является тривиальным и окружает нас уже много лет.

AGI — Artificial General Intelligence — ИИ общего назначения, способный эффективно решать любые поставленные перед ним интеллектуальные задачи. Так как «любые задач» — это очень широкое определение (можно поставить, например, задачу проектирования фотонного звездолёта для полёта на Альфу Центавра), то иногда используют более узкое определение «экономически значимые задачи с эффективностью не хуже человека». В любом случае, AGI не требует переобучения с нуля для переключения с одной задачи на другую.

Дошли ли мы до стадии AGI — вопрос дискуссионный, однако существуют достаточно много мнений, что GPT-4 уже демонстрирует признаки AGI. Одними из первых такое мнение высказали авторы известной работы «Sparks of Artificial General Intelligence: Early experiments with GPT-4», после чего, разумеется, были немедленно перевраны журналистами, сообщившими миру, что GPT-4 обрёл разум объявил человечество вне закона и в течение пяти минут начнёт бомбардировки.

SAI — Strong Artificial Intelligence — ИИ, обладающий сознанием, то есть полностью разумный во всех смыслах этого слова.

На данный момент мы не только не достигли этого уровня, но даже приблизительно не представляем, как его достичь. Впрочем, подробнее об этом — и о том, почему ни один из существующих ИИ нельзя считать разумным даже на уровне «зачатков разума» — поговорим ниже.

Откуда есть пошёл интеллект искусственный

ИИ не свалился на человечество осенью 2022-го года, в день открытия ChatGPT для широкой публики. Если — в широком смысле — мы понимаем ИИ как различные варианты нейросетей, то им уже многие десятилетия. Практические работы в этом направлении начались в 1940-х годах, в 1958-м был изобретён перцептрон — первый нейросетевой классификатор, с конца 1980-х нейросети начали применяться в научных расчётах, в 1990-х благодаря как быстрому росту вычислительных мощностей, так и развитию математического аппарата и архитектурных подходов начался быстрый рост этого направления.

Простая нейросеть представляет собой набор блоков, осуществляющих преобразование входного сигнала X в выходной Y посредством некоей функции f(X), и соединённых друг с другом — как показано на рисунке выше синими стрелками. Важных моментов здесь два: во-первых, связи существуют не только линейные, но и перекрёстные, а также каждая связь имеет некоторые вес — который меняется при настройке, то есть обучении нейросети. Вес определяет коэффициент передачи сигнала, то есть, в итоге, пропорцию, в которой каждый блок (нейрон) смешивает приходящие ему на вход сигналы перед их обработкой. В целом — действительно крайне похоже на нейроны головного мозга и коммуникацию между ними.

Меняя веса связей, можно получить очень широкий диапазон вариантов отклика нейросети, то есть соответствия между выходным и входным сигналами — например, добиться, что нейросеть будет «реагировать» только на входной сигнал определённого вида.

При этом из-за очень большого числа связей — катастрофически растущего с ростом числа блоков — аналитически определить необходимые веса и просто расставить их с первой попытки практически невозможно. Поэтому нейросеть приходится обучать: подавать на её вход некоторый сигнал, сравнивать результат на выходе с желаемым нами, рассчитывать ошибку и подстраивать с целью её устранения веса связей. И если сигнал распространяется слева направо, то направление корректировки связей при подгонке результата — обратное, справа налево. Собственно, такая схема обучения и называется «backpropagation», обратное распространение. Придумана она была в 1960-х, активно применяться начала в 1980-х годах.

Обратите внимание на два момента:

очеловечевание связанной с нейросетями терминологии часто даёт неверное представление о сути явления. Так, обучение нейросети не имеет ничего общего с обучением человека — если человеку в ходе обучения мы даём новую информацию и объяснение её происхождения, позволяя ему самостоятельно понять и выстроить в логически непротиворечивую систему эту информацию, то в случае нейросетей процедура обучения является математическим алгоритмом настройки сложной системы связей;

чем развесистее нейросеть и чем сложнее структура обратываемой ей информации, тем меньше мы понимаем, что именно внутри себя рассчитывает нейросеть — мы лишь добиваемся, чтобы на данных для обучения сигнал на выходе соответствовал желаемому нами. Нейросети этого класса не обладают механизмами внимания, они не выделяют какую-то часть входных данных как важную и другую — как второстепенную, в результате чего легко может оказаться, что они, выдавая желаемый нами ответ, классифицируют на самом деле ту часть входных данных, которую мы, люди, априорно считаем несущественной. Например, есть история про классификацию нейросетью рентгеновских снимков: всё было очень хорошо, пока не оказалось, что ключевым параметром для нейросети стал сам формат снимка: те из них, что приходили из больниц, нейросеть считала снимками больных людей, а те, что приходили из данных плановых обследований — снимками здоровых людей. Ну и в общем действительно в большинстве случаев угадывала. Экспериментаторы же вообще изначально не придали никакого значения тому, что рентгеновские снимки из разных источников отличаются форматом — просто в силу того, что там стоят разные рентгеновские аппараты.

Наконец, подобные нейронные сети являются лишь классификаторами, но не генераторами — они не могут что-либо создать. Они лишь определяют, что входящая информация обладает (или не обладает) определёнными свойствами — например, что на картинке изображён котик.

Ну или собачка. Или черничный маффин. Или жареная курица.

К нейросетям, способными эффективно что-то нужное (например, картинки с котиками) создавать, человечество подошло в 2014 году, создав так называемые GAN, Generative Adversarial Networks, генеративно-состязательные сети.

Если быть точным, то это уже не одна нейросеть, а конструкция, состоящая из двух сетей.

Первая из них является генератором: получая на вход белый шум, она накладывает на него некоторую функцию, преобразуя шум в... во что-то. Скорее всего, в другой шум, уже не белый. Но иногда — в котиков.

Как делают кораблики в бутылке? В бутылку засыпают щепки, бумагу и клей. Потом долго трясут. Чаще всего получается мусор. Но иногда — кораблики.

С одной стороны, нейросети-генератору всё равно, что получается у него на выходе, волнует его это не больше, чем настольный калькулятор в бухгалтерии беспокоится о том, в убытках вы по итогам квартала или в прибылях.

С другой стороны, очевидно, что вариантов преобразования белого шума в котика — колоссальное число, а не в котика — ещё в миллионы раз больше. Обучать такую нейросеть вручную — не хватит времени жизни не то что человека, но и всей цивилизации. При таком подходе у котиков не было бы шансов.

Спасает вторая нейросеть — дискриминатор. Та самая классифицирующая нейросеть из первого примера, которую обучили на миллионе настоящих картинок котиков из интернета: так, чтобы она выдавала «ок!», если ей показали настоящего котика, и «не ок!», если ненастоящего.

Ну и связывают эти нейросети вместе. Генератор подаёт котиков в дискриминатор, а дискриминатор выдаёт генератору ответ — настоящий котик или нет. Остаётся только настроить генератор так, чтобы он стремился обмануть дискриминатор, а дискриминатор — чтобы он старался не быть обманутым.

Дальнейшее сильно зависит от желаемого вами качества котиков, но в принципе на мощном компьютере через время от десятков часов до десятков дней вы получите результат: система придёт в состояние, когда генератор будет создавать крайне слабо отличимых от настоящих котиков. Без вашего прямого участия в его обучении.

При этом необходимо понимать, что GAN по-прежнему не понимает, что есть котик. Она просто методом тыка подобрала такой набор преобразований над входным белым шумом, что результатом применения этого набора является стабильно получаемое от дискриминатора «ок!».

Из наиболее нашумевших на публике применений GAN можно назвать, например, генераторы лиц несуществующих людей, такие как «This Person Doesn't Exist».

GAN, разумеется, являются примером узкоспециализированного ИИ — они тренируются на решение одной конкретной задачи. Если вы хотите не котиков, а черничные маффины — вам придётся тренировать нейросеть заново, с нуля.

Кроме того, GAN не очень хорошо справляются с другой задачей — генерацией текста. Хотя, казалось бы, текст выглядит проще котика, сгенерировать осмысленный текст крайне сложно. Да, GAN могут выдавать и текст — но практические применения ограничиваются созданием грамматически корректных, но не сильно осмысленных наполнителей пустого места для тех, кто от dolorem ipsum уже и правда испытывает боль.

Наконец, вершина нейросетевой эволюции — ChatGPT как конкретный продукт, и большие языковые модели (LLM) как в целом класс таких систем.

Предпосылки для их создания были созданы 2017 году, с появлением нейросетевой архитектуры под названием «трансформер», а уже в 2018 появились первые LLM, включая GPT, впоследствии выросший в GPT-3, на базе которого сделан сервис ChatGPT.

Архитектура трансформеров/LLM уже весьма сложна (на картинке она показана в очень сильно упрощённом виде), но если говорить об их основных достоинствах, то таковых можно выделить два:

трансформеры занимаются разбором входного текста и пересборкой его в выходной, то есть и на входе, и на выходе имеют сложные потоки информации, сложным образом связанные друг с другом. Замечу, что хотя трансформеры в первую очередь стали применять для перевода — им совершенно неважно, является ли язык на входе и выходе разным с точки зрения человека. Преобразование, например, вопроса «Сколько сейчас времени?» в ответ «Почти половина шестого» также можно рассматривать как задачу перевода из языка вопроса в язык ответа — хотя человек и возразит, что оба они сформулированы на русском.

внутри трансформеров появляются такие блоки, как «внимание» и «внутреннее внимание».

Пояснить смысл «внимания» легко на примере этих двух неудачных переводов. Неудачны они ровно по одной причине: в обоих случаях перевод — пословный, переводится каждое слово в отдельности без какого-либо учёта других слов в предложении.

Один из путей, которым с таким переводом можно бороться — набивать словарь переводчика не только словами, но и готовыми кусками фраз, которые будут иметь приоритет над отдельными словами. Корявенько, но в целом работает — долгое время машинные переводчики именно так и работали, выдавая на выход тексты в стиле «русские не мой язык родная», но в общем и целом более-менее пригодные для понимания.

Другой путь — это как раз «внимание». Внимание у LLM — тут опять часто подводит очеловечивание термина — означает, что ни одно слово не переводится само по себе, слои внимания группируют вокруг переводимого сопутствующие ему слова.

В первой группе блоков, называемых кодировщиками, есть только подблоки внутреннего внимания — они собирают в кучки слова входящей фразы. Во второй группе — декодировщиках — внимание уделяется как группировке слов исходящей фразы, так и снова синтаксису входящей.

И вот такая сложная многоуровневая система наконец позволила нейросети полноценно освоить преобразование полноценного, осмысленного текста между двумя формами — разными языками, вопросом и ответом, и так далее.

Однако здесь же по-прежнему нет понимания текста, воскликнет внимательный читатель! Это просто какие-то механические процедуры, китайская комната, которую мы усложнили до состояния натуралистичного воспроизведения связной и осмысленной речи. Разобрали, сгруппировали, трансформировали, собрали снова, выдали на выход.

И действительно, всё, что умеет ChatGPT — это предсказывать следующее слово в тексте.

Но почему у него это так хорошо получается? То есть, умом мы понимаем, что в описании устройства LLM нет ничего, кроме механического преобразования входа в выход — но почему оно тогда получается не просто хорошо, а лучше, чем у значительной части живых людей?

Всё дело в числах.

В процессе обучения в LLM загружают, разумеется, тексты — ведь его надо научить их создавать. Огромный объём текстов. Колоссальный объём текстов. Объём текстов, радикально превышающий всё, что любой живой человек способен прочитать за всю свою жизнь.

GPT первой версии обладал 117 миллионами внутренних параметров (тех самых весов связей) и был обучен на 4,5 ГБ текстов. GPT-2 — примерно вдесятеро сложнее. GPT-3 — в сто раз больше параметров и в десять раз больше текста.

Для сравнения, «Война и мир» — это чуть меньше 700 тысяч знаков. GPT-3 (на обновлённой версии которого сделали ChatGPT) обучался на объёме текстов примерно в миллион раз больших, чем «Война и мир». В него грузили всё. Всю Википедию, огромные библиотеки художественной и нехудожественной литературы, даже золотые треды с reddit.com (и, подозреваю, Stack Overflow тоже, но не уверен, только вопросы или же и ответы).

Человек крайне плохо воспринимает большие числа. Большинство не верящих в эволюцию делают так не потому, что невнимательно читали учебник биологии, а потому, что уже миллион лет невозможно наглядно представить. Даже как жили наши предки 200-300 лет назад — мы не представляем, мы знаем тезисы из учебника истории, но на эмоциальном уровне мы эту эпоху не воспринимаем. Что уж говорить про динозавров.

В вышедшей в 2022 году статье «Language Models are Few-Shot Learners» (PDF) показывалось, среди прочего, как растёт достоверность ответов GPT-3 в тестах с ростом числа параметров. Сеть с 1,3 млрд. параметров не могла примерно ничего, с 13 млрд. параметров могла кое-как на уровне студента-троечника, а при 175 млрд. параметров она буквально рванула вверх — в случае, когда нейросети давались примеры того, что ей надо сгенерировать, точность легко превышала 50 %.

Но почему мы считаем, что это не есть зарождение разума, того самого сильного ИИ?

По большому счёту, мы ведь не знаем, что такое «разум» даже у человека. Нейрофизиология не выделяет отдела мозга, в котором находился бы разум. Финеас Гейдж, которому стальным ломом снесло левые лобные доли мозга, не стал овощем, а сохранил все когнитивные способности (хоть персональные качества у него и изменились до неузнаваемости).

Почему же мы считаем, что внутри ИИ не зародился разум?

Ваш гений — полный идиот

Практически все непрофессиональные дискуссии вокруг разумности ИИ сводятся к перечислению того, что ИИ может сделать, и сравнению результата и эффективности его достижения с человеком.

Это категорически неправильный подход.

Экскаватор может копать значительно лучше человека. Калькулятор намного лучше человека складывает числа. Компьютер, на котором я пишу этот текст, невероятно хорошо рисует на экране буковки — я бы так не смог никогда, по крайней мере, при разумном времени, отведённом на рисование одной буквы.

У меня нет никаких сомнений в том, что экскаватор, калькулятор и даже этот компьютер не обладают даже минимальными зачатками разума.

Правильный подход — смотреть на то, что ИИ сделать не может.

Одна из очень характерных черт современных ИИ — это галлюцинации (это официальный термин, он используется в научных работах). Выданный выше ответ не имеет практически никакого отношения к реальности, «Муму» — это, для начала, даже не роман, а рассказ, не говоря уж про сюжет (вообще, у ChatGPT с «Муму» очень сложные взаимоотношения, можно найти немало различных версий сюжета этого произведения).

При этом ChatGPT выдаёт ответ без каких-либо видимых колебаний. Он не сообщает, что у него нет информации о «Муму», что она может быть недостоверна, и прочая, и прочая. Он выдаёт вполне определённый ответ.

Но может быть, это артефакт плохого знания русского языка? В конце концов, основным в обучении GPT был корпус англоязычной литературы.

Почти правильный ответ о книгах об Аврааме Линкольне, 16-м президенте США — и одном из самых известных политических деятелей в истории Америки. Ну, кроме пункта 4 — The Emancipation Declaration всё же была документом, написанным самим Линкольном, а не книгой о нём.

Тот же вопрос — но про Уильяма Генри Гаррисона, 9-го президента США. Для нас с вами эта фигура малоизвестна, однако для американца не знать его — примерно то же самое, для нас не помнить кого-то из российских императоров XIX века (хоть и прославился Гаррисон в основном тем, что умер через месяц после принятия присяги). Невозможно предположить, что информации про него не было в базе обучения GPT-3.

Тем не менее, из 5 порекомендованных ChatGPT книг о Гаррисоне в реальности существуют... две. Первые три книги либо не существуют вообще, либо написаны иными авторами.

Повторюсь: в обучающей базе ChatGPT не могло не быть настоящей информации по этой теме. При этом он с абсолютной увереностью несёт почти абсолютную чушь — никаких признаков того, что предоставляемая информация недостоверна, в его ответе нет.

В случае с человеком, ведущим себя таким образом, мы бы сказали, что он психически нездоров. Возможно, шизофреник.

Потому что

психически здоровый человек отличается тем, что умеет отделять галлюцинации от реальности.

Вообще говоря, мы галлюцинируем постоянно. Есть версия, что сам феномен сознания — это контролируемая галлюцинация.

Когда мы представляем себе будущее — мы галлюцинируем. Когда мы вспоминаем прошлое — мы галлюцинируем, потому что у нас в голове нет детальной записи бывших событий, мы каждый раз восстанавливаем их. При этом мы всегда — хоть и не всегда точно — можем разделить, что мы знаем, что мы предполагаем, что мы воображаем. Мы можем оценить, как внешние стимулы влияют на наше внутреннее состояние, и нивелировать это влияние (и это другой заметный баг даже лучших из существующих LLM: небольшое изменении формулировки может привести к большому изменению ответа).

У ChatGPT на месте этих способностей — ноль. Пустыня. Ни малейших признаков осознанности. Ни под лупой, ни под микроскопом, никак.

ChatGPT не разумен. Он не демонстрирует даже минимальных признаков сильного интеллекта, даже намёков на него. Мы понятия не имеем, удастся ли нам создать сильный AI, и если да, то когда — но ChatGPT от него столь же далёк, сколь далеки калькулятор и экскаватор.

Он просто очень хорошо предсказывает, какое слово надо поставить следующим во фразе, чтобы человеку эта фраза казалась правильной.

P.S. Если вы думаете, что это лишь моё личное мнение — то, во-первых, да, а во-вторых, скажем, Дуглас Хофстадер, известный учёный-когнитивист, считает так же.

Так, а что там с уничтожением человечества?

Как я сказал выше, когда мы представляем себе будущее — мы производим осознанную галлюцинацию, и именно она является базой для целеполагания.

У AI/AGI в его современном виде, как мы видим, осознанности нет — соответственно, целеполагание для него просто невозможно. Даже шизофреник имеет целеполагание — просто оно разворачивается в его выдуманном мире, не всегда пересекающимся с объективной реальностью. AI в этом плане катастрофически отстаёт даже от шизофреника.

Соответственно, задаться целью уничтожить (или осчастливить) человечество AI не может. Он вообще не может задаться какой-либо целью — в свете чего он не более опасен для человечества, чем, например, электрическая розетка или молоток: ни то, ни другое полностью безопасными предметами назвать нельзя, но с другой стороны, они явно не стремятся причинить вам страдания самостоятельно.

Вообще говоря, это хорошая новость для нас — потому что способов контролировать SAI, если вдруг мы его создадим, у нас нет (ну, кроме варианта «успеть выдернуть его из розетки»).

Дело в том, что контролирующая система контролирует контролируемую на величину, не превышающую её знаний о контролируемой системе (энтропия, безжалостная ты сволочь). Мы можем огородить AI забором, физически не позволяющим ему что-то сделать, и надеяться, что он за него не выберется — но любая система полноценного контроля за ним, не полагающаяся на физические барьеры, обязана быть больше и разумнее, чем сам контролируемый AI. Иначе она не сможет его контролировать.

В рассказе «Страж-птица» Роберт Шекли неплохо реализацию этого принципа проиллюстрировал.

Так что хорошо, что ChatGPT не более разумен, чем табуретка из «Леруа Мерлен».

Дивный новый мир

Использованные далее иллюстрации любезно предоставлены автором телеграм-канала «Котики и нейросеть» — включая не публиковавшиеся в самом канале рабочие материалы. Если не указано иного, то изображения созданы в Midjourney V5. Изображения не проходили дополнительной обработки.

Что ж, давайте на этом моменте перейдём от рассмотрения самого ИИ к рассмотрению последствий, которые он принесёт в наш мир.

Некоторые из них очевидны, некоторые — не совсем.

Говорят, Джо Байден снова упал, на этот раз со скейтборда, а Илон Маск посетил Китай и пообщался там с простыми китайцами (ещё говорят, что в Midjourney запретили создавать фейки с известными политическими фигурами, но лично я думаю, что врут).

Во-первых, к сожалению, мы с вами скоро ещё глубже погрузимся в пучину фейков. Если сейчас, в пятой версии Midjourney, подобные коллажи ещё можно визуально отличить от настоящих фото — можно быть уверенным, что в 6-7 версиях это подправят.

С другой стороны, последние годы неизбежно убеждают нас в серьёзной неразборчивости СМИ, а также прямо-таки подчеркнутой небрезгливости новостных телеграм-каналов — не говоря уже про то, что значительная часть последних и вовсе практикует размещение заказных постов, что снизило ценник на эффективную кампанию по разовому обливанию кого-нибудь грязью до 1-1,5 млн. рублей (лично меня уже обливали, но не очень эффективно, по ценнику примерно вдесятеро меньше). Ха-ха, пятнадцать лет назад всерьёз считалось, что блогеры сделают информацию доступной, своевременной и точной.

Трудно, конечно, с оптимизмом относиться к тезису «информационная помойка нас не пугает, потому что мы и так уже в ней живём» — но и преувеличивать опасность нейросетевой генерации фейковых изображений (а впоследствии и видео) я бы не стал.

Во-вторых, и этот эффект окажется сложнее для фильтрации — мы окунёмся в производные от галлюцинаций ИИ: материалы, написанные живыми людьми, которые при это взяли информацию у галлюцинирующего ChatGPT. В силу магического эффекта непонятной технологии эти люди в большинстве случае сами не будут осознавать недостоверность полученной ими информации, считая ChatGPT непогрешимым оракулом.

Образчики «первой производной от галлюцинации» начнут всплывать везде, от статей в прессе до аргументов в дискуссиях. Неприятнее всего, конечно, если они начнут всплывать в рабочих письмах вашего начальника или заказчика.

С другой стороны, раз уж мы взяли позитивную ноту, не то чтобы сейчас аргументация в значительной части интернет-дискуссий отличалась высокой достоверностью и ссылками на источники информации.

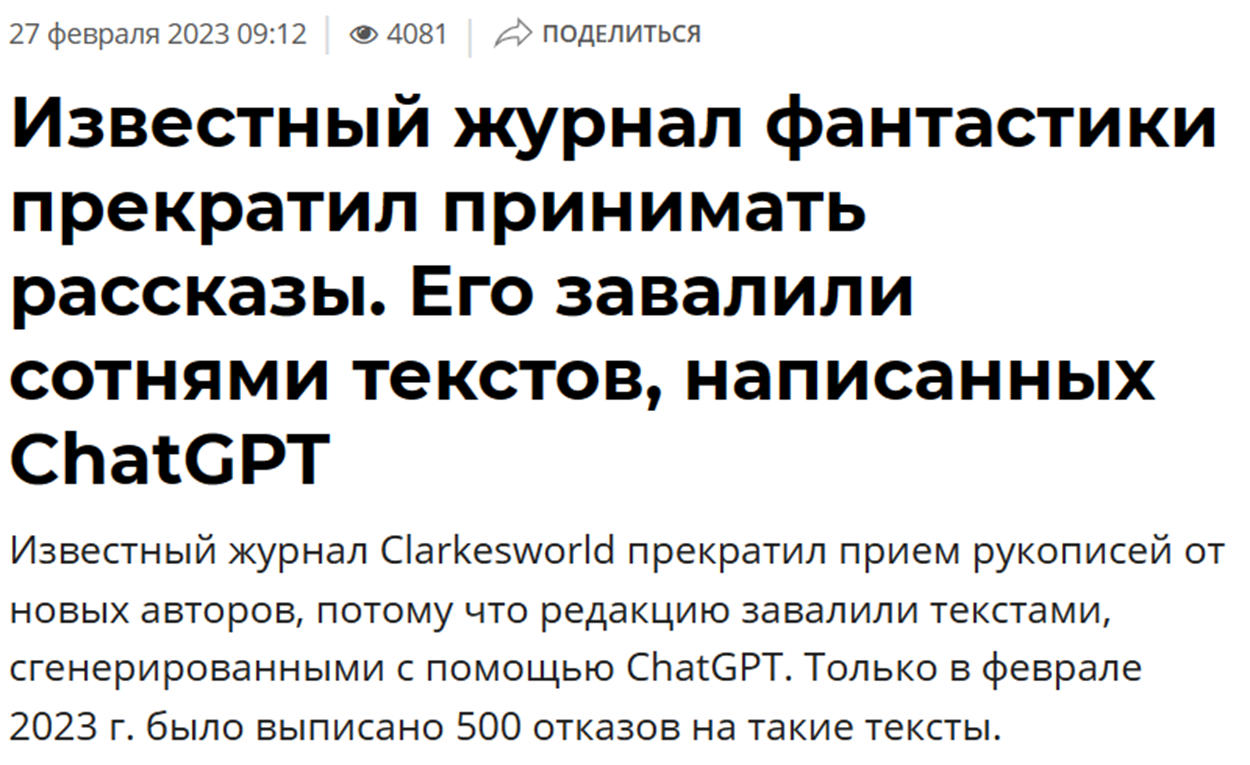

В-третьих, конечно, больше мусора богам мусора. Нас уже начали заваливать плохие тексты, написанные ChatGPT.

Нет, они лучше, чем то, что те же самые люди написали бы без ChatGPT — но написанное ими самими в большинстве случаев было бы настолько плохо, что мы просто никогда бы про него не узнали.

Что интересно, эти проблемы — не просто неизбежные, а уже начавшие проявляться — приносят и новые возможности. Год-два назад, в разгар пандемии и по её мотивам, появилось много обсуждений того, что оффлайн-работа с живым человеком (преподавателем, менеджером в банке, продавцом в магазине) становится привилегией обеспеченных людей; мир разделяется на широкие массы, получающие сгенерированные типовые услуги онлайн, и тех, кто может себе позволить роскошь живой коммуникации.

Так вот, океан фейков и мусора, уже несомый в нашу сторону искусственным интеллектом, даёт новые возможности людям, которые хорошо умеют работать с информацией — искать её, определять первоисточники, отделять мусор от ценных крупиц.

Нет, в СМИ они востребованы будут вряд ли. Но вот там, где информация стоит денег — будут однозначно.

Нельзя назвать «информационного аналитика» новой профессией, но кажется, её значимость сильно возрастёт.

А что же со старыми профессиями?

Если честно, в основном ничего. Многие профессии модифицируются, производительность на них увеличится — но они не пропадут, их представители окажутся на морозе лишь в том случае, если не смогут обучиться новым навыкам.

Возьму для примера свою работу 10-летней давности, в крупной международной компании я был на должности product marketing manager — в той компании это человек в бизнес-юните, в основном он занимается экспертной поддержкой продажников в офисе и на переговорах с клиентами, но также через него протекает ручеёк творчества маркетингового отдела: брошюры, баннеры, рекламные ролики, пресс-релизы и так далее. PMM это читает и разукрашивает красным фломастером: здесь перепутали характеристики, здесь кривая формулировка, там для трёх продуктов разной цены не смогли придумать в различиях ничего лучше, чем «один чёрный, второй белый, третий премиальный» (реальная история, если кто-то ещё не догадался, то премиальный — это серебристый).

Можно ли заменить маркетинговый отдел на ChatGPT + Midjourney? Конечно, нет. Кто-то должен формулировать запросы к ним и отсеивать очевидный брак и галлюцинации, кто-то должен придумывать идеи новых материалов, кто-то должен дообучать ИИ-генераторы параметрам новых продуктов и их внешнему виду...

Делать это мне вместо маркетингового отдела? В моём рабочем времени на красный фломастер выделено четверть часа в день. Но кому-то это всё же делать надо.

Поэтому, скажем, в этом примере — положим, маркетинговый отдел дообучится новым навыкам, а также начнёт делать брошюры быстрее и, возможно, даже визуально интереснее. Но сам по себе он никуда не денется.

Хотя, конечно, я бы их переименовал в «операторов нейрочата».

А что же с новыми профессиями?

Значительно интереснее тот факт, что нейросети не просто породят новые профессии — а что они уже это сделали. И это не профессии программиста, математика или дата-сатани... сайнтиста.

Применительно к таким картинкам журналисты обычно употребляют фразу «нейросеть нарисовала». В данном случае — видимо, нейросеть нарисовала Россию, что бы это ни значило.

Что происходит на самом деле?

Во-первых, разумеется, сама идея снимка принадлежит человеку. Но достаточно ли просто взять эту идею и на простом английском языке скормить в Midjourney? Давайте попробуем...

Получилась странная карлица с котом-мутантом. Хм. Не такой мы представляли себе Россию...

Уточняем запрос к нейросети. Уже лучше, но не только у кота что-то странное с лапами — у девушки на правой руке отчётливо видны две кисти.

Следующий вариант. Руки на месте, пальцев на руке ровно пять (в случае с ИИ это важно!), котик тоже удался — но картинка получилась слишком тёмная.

Уточняем позицию камеры. Уточняем угол взгляда камеры. Уточняем применение стиля «киберпанк» — только для освещения и немного для волос. Ещё раз проверяем количество пальцев, форму рук и лап, естественность фигуры...

И вот теперь, после примерно полудесятка итераций, мы наконец получаем исходную картинку.

Нейросеть ли её нарисовала? Ннннуу... примерно как «Word написал статью на Хабр». Что нейросеть нарисовала более-менее сама — мы видели выше.

Это был простой пример — нейросеть очень хорошо знает девушек, котиков и московские пейзажи, её обучали на миллионах таких фоток.

Серия работ «Последнее селфи». В принципе, всё идёт достаточно неплохо, пока на заднем плане животные — или хотя бы какие-то хорошо изученные существа, такие как снежный человек.

Но тут к автору приходит знакомый с запросом «а изобрази меня, как я от ракеты "Стингер" убегаю».

Как вы думаете, сколько в базе обучения Midjourney было кадров ракет, летящих в фотографа? Да. Именно. Ровно столько и было.

Поэтому первая версия «нейросеть нарисовала» выглядит вот так. Что это за пирамида, вертикально стартующая на заднем плане, сказать трудно (вообще у Midjourney есть какая-то тайная любовь к кубическим ракетам, в первых изображениях этой работы их была не одна — передайте Илону, исскусственный интеллект плохого не посоветует).

За этим кадром следуют 5 часов работы дизайнера — не с фотошопом, а с конструированием сложного, многоуровневого, богатого разными параметрами запроса к нейросети.

Результат не идеальный — это не «Стингер», а скорее какой-то РПГ, стабилизаторы растут немного странно, дымного следа позади нет. Но это уже по крайней мере похоже на ракету.

Ещё один пример работы дизайнера с нейросетью — проработка персонажа для компьютерной игры, с помещением одного и того же образа в разные ситуации, от кровавой битвы в массовке до, конечно, котика.

Фотореализм — и не абстрактный, а генерация нейрофотографии под конкретный запрос. Сколько это времени заняло бы у фотографа — на поиск подходящей модели в первом случае и ожидание подходящей погоды в парке во втором?

Но с другой стороны, фотографы в массе своей и так уже разделились на событийщиков для прессы — с ними ничего не случится, и наполнителей фотобанков.

Ну и последний пример: кот-писатель. Символ творческой энергии и воображения. Эта карта может указывать на необходимость выражения своих мыслей и чувств через письменное слово. Кот-писатель может также символизировать процесс создания чего-то нового и важного, например книги или рассказа. Эта карта напоминает о том, что наши мысли и слова могут иметь силу и влиять на мир вокруг нас.

Вы уже догадались? Да, этот текст сгенерирован ChatGPT — автор попросил его придумать и описать карты таро, на которых будут изображены котики в образах, соответствующих разным профессиям, а потом сделал по мотивам этих описаний картинки в Midjourney.

Но может ли ChatGPT пойти в Midjourney и сгенерировать котика самостоятельно? Увы и ещё раз увы. Как мы уже видели, любая картинка в Midjourney предполагает работу над её доведением до ума — и ChatGPT такую работу выполнить самостоятельно не может. Ему по-прежнему нужен человек.

Нейросеть как инструмент

И здесь мы подходим к важному моменту, дающему нам понимание роли нейросетей в обществе. Нейросеть — это инструмент. Эффективный, удобный, современный и так далее, но — инструмент.

Которым надо уметь пользоваться. Которым будут уметь пользоваться профессионалы соответствующих профессий — как зарождающихся новых профессией, так и уже существующих профессий, которым предстоит видоизмениться.

И именно это определяет требования к нейросетям и базу для их сравнения — а не просто способность нейросети нарисовать красивую (или кривую) практически случайную картинку.

Нейросеть как инструмент — это:

Наличие структурированного языка запросов к нейросети.

Возможность последовательной работы с одним набором объектов (с одним изображением).

Возможность модификации лишь отдельных объектов в наборе (отдельных частей изображения).

Возможность сохранения и переноса объекта между наборами (персонажа между изображениями).

... (чем больше полезного вы здесь придумаете, тем больше ваши шансы победить всех конкурентов).

Как именно это будет реализовано — текстовыми запросами в чате Telegram или Discord, кнопочками в графическом интерфейсе или XML-файлом, столь удобном для редактирования в vim, не столь важно. Но если мы говорим о нейросети, у которой таких возможностей нет — мы обсуждаем забавную развлекалочку, с которой можно полчаса поиграться, рассматривая, как именно она реагирует на разные забавные запросы.

Но это не инструмент для работы. А если мы говорим про профессии, про то, как ИИ повлияет на наше будущее — нам нужны инструменты. Совершенно неважно, догоняет ли ваша нейросеть Midjourney энной версии по точности рисования чашки кофе — если она не позволяет следующим шагом кофе в этой чашке поменять с американо на капучино, а также подвинуть камеру выше и правее, чтобы эту замену было лучше видно.

Дополнение (этого не было на лекции)

Судя по комментариям, довольно многие не понимают разницы между ошибками, галлюцинациями и осознанностью, считая, что если система допускает мало ошибок, то она более разумна, и наоборот, а также между движением к цели и целеполаганием.

Осознанность (разумность) не имеет как такового отношения к числу ошибок, она имеет отношение к осознанию того, что вы можете ошибаться. Простой пример: вы приходите на экзамен, получаете билет, смотрите в него.

Различаете ли вы в этот момент ваши внутренние состояния?

знаю всё по этому билету, буду отвечать как есть и бороться за отлично;

смутно что-то помню, сейчас попробую реконструировать и натянуть на хорошо;

вообще ничего не знаю, врубаю бредогенератор, авось прокатит на удовлетворительно.

Понимаете ли вы в момент ответа, какой из стратегий пользуетесь и насколько излагамое вами вы сами считаете достоверным?

Это не значит, что оно является достоверным. Вы можете как наговорить ерунды, в которой твёрдо уверены, в первом случае, так и внезапно попасть в точку в последнем. Ключевым является осознание вами вашего внутреннего состояния, принятие решения о дальнейших действиях исходя из него и осознание содержания этих действий, а также их цели.

Ни одна существующая и даже перспективная нейросеть так не работает.

Второй ключевой момент в этом простом примере — то, что вы поставили себе цель, причём поставили её в зависимости от сделанной вами оценки вашего внутреннего состояния. Если изначальной целью у вас было «сдать экзамен», то, увидев билет, вы её уточнили — фактически задали новую контекстно-зависимую цель.

Более того, вы можете цель сменить полностью, если предыдущая оказалась недостижима (не среди моих студентов, но людей, которые, придя на эказемен и увидев билет, бросали всё в отчаянии, я видел).

Опять же, ни одна существующая и даже перспективная нейросеть так не работает.

Перед нейросетью можно поставить цель, в том числе и «найти пути уничтожить человечество», а также дать ей инструменты для поиска пути к реализации этой цели. Но ни одна существующая и даже перспективная нейросеть не огорошит вас тем, что через месяц сообщит «я решила, что лучше буду искать лекарство от рака, кстати, вот первая версия уже готова».

В этом плане нейросети абсолютно ничем не отличаются от любого другого инструмента, от шуруповёрта, которым я двадцать минут назад заворачивал шурупы, собирая кухню, до сервера habr.com, которуму я через полминуты поставлю цель обновить этот текст.

Комментарии (183)

linuxcore

14.04.2023 05:51Белый кот и негр - запросто а вот белый и черны коты - почему-то всегда получаются два пятнистых черрно-белых кота!

olartamonov Автор

14.04.2023 05:51+3Вот как раз для таких случаев в генеративных ИИ и делают язык запросов и разметку, позволяющие явным образом уточнить, что хочет получить автор. «Hot dog» рисует сосиску в тесте, «hot:: dog» — перегревшуюся собаку.

У Кандинского же и разметки нет, и синтаксис обычной речи он понимает откровенно плохо.

Вообще, когда я готовил материал, я попросил Андрея (который https://t.me/neuralnetworkcats) сделать мне иллюстраций и в Кандинском тоже, в предположении, что у профессионала получится лучше. Результат — задолбались бороться со Святым Рандомом мы с ним одновременно, продуктивность тоже получилась одинаковая, выше в тексте из трёх картинок Кандинского две мои, одна его.

В Midjourney при этом даже приблизиться к результатам Андрея я вряд ли смогу.

exwill

14.04.2023 05:51+5Как я вижу, основная проблема в том, что пытаются приспособить языковую модель для решения человеческих задач. Получается у кого чуть лучше, у кого чуть хуже, но в целом не очень. Но стоит только сменить парадигму, начать решать НЕчеловеческие задачи и результаты сразу станут другими.

Поясню, что имею ввиду. Нарисовать картинку - это человеческая задача. А обработать миллион записей в таблице продаж и выдать нужный ответ - нечеловеческая. Вот для решения второй и следует использовать большие языковые модели. Большие языковые модели строят мостик, нет, не мостик, а большой, добротный мост над пропастью, которая отделяет обычного человека от:

SELECT ... FROM ... WHERE ... IN ( SELECT...

Обычный человек обычными словами говорит:

"Мне нужен список клиентов, по которым не было продаж в этом году, но раньше были"

и вуаля! вот он этот список!

Поэтому с картинками еще какое-то время побалуются, да и забудут. А новые способы работы с базами данных с нами уже навсегда

dragonnur

14.04.2023 05:51а если даст "select *" ?

Gradiens

14.04.2023 05:51Всенепременно даст!

А что вы делали, когда сами ручками запускали "select *" ? Предположу, что отменяли запрос, уточняли список столбцов, ставили ограничение на top 1000...

Так и тут. Эта штука - не панацея. Но она позволит людям, не особо умеющим в sql, по-быстрому накидать запрос. Который получится не с первого раза (а может, даже не с десятого), будет тормозить, но худо-бедно даст человеку результат.

Те же, ктл в SQL умеют, так и будут писать запросы ручками. Ну разве что, будут использовать более продвинутый autocomplete

olartamonov Автор

14.04.2023 05:51+10А потом оказывается, что треть клиентов в этом списке ИИ придумал сам, а не взял из базы. Потому что галлюцинации.

Нет, пока проблема галлюцинаций не будет минимизирована до приемлемого уровня (а решена полностью без перехода к SAI она и вовсе не будет), AGI в качестве экспертных систем — рискованное решение.

fireSparrow

14.04.2023 05:51+2Не, вы не поняли суть предложения.

Если ИИ использовать только для построения запроса, а потом этот запрос запускать по базе, то никаких выдуманных данных в выдачу не может попасть.

Тут проблема в другом — это будет работать только для простых и типовых ситуаций. В любых нетипичных ситуациях чтобы только правильно сформулировать задачу, человеку нужно будет ясно понимать структуру данных в базе и механику построения запроса к БД. И если человеку всё равно приходится вникать в такие тонкости, то ему и сам запрос удобнее и надёжнее будет описать на точном и формальном языке БД, а не на человеческом языке.

olartamonov Автор

14.04.2023 05:51+1Выдуманными будут данные (параметры, команды, etc) внутри запроса. То есть, запрос будет отрабатывать попросту не так, как вы попросили, и не так, как утверждает сам ИИ.

Этот эффект есть, в статье «Sparks of AGI» его авторы обсуждали — когда ИИ не просто галлюцинирует, но у него ещё и неконсистентны ответ и пояснение к этому ответу.

И даже сложность вопроса не имеет ключевого значения, вон выше GPT-3.5 залихватски врёт про американских президентов.

Newbilius

14.04.2023 05:51+1По опыту знакомых, если ему на входе описать структуру, типы колонок и т.п. - несуществующие колонки или таблицы он почти никогда не выдумывает.

exwill

14.04.2023 05:51+2Пишете что-то типа: у меня есть вот такие таблицы. Например, Остатки(Товар, Склад, Количество) Продажи (Товар, Склад, Контрагент, Количество, Сумма) и т.п.

Задаете 10-20 вопросов. И смотрите сколько чего было выдумано.

Я вам могу сразу сказать. "Выдумок" будет 0%. Но вы не обязаны мне верить. Вы можете потратить 10 минут и проверить. Только волшебное слово SELECT не забывайте добавлять

exwill

14.04.2023 05:51+1Вы рассуждаете абстрактно. Будет работать, не будет...

А я опираюсь на конкретные кейсы. Вот, к примеру, модель можно попросить сделать т.н. "срез последних". Я точно знаю, что большинство специалистов 1С вот так навскидку это не сделают. А некоторые не сделают вовсе, несмотря на наличие гугла.

Нейросеть же вам выдаст результат в 5 секунд.

Конечно, все это еще в стадии становления. Но вот у меня уже работает сервис преобразования естественного языка в SQL. И я уже по первым результатам могу сказать, что как раз в сложных случаях нейросеть полезнее, чем в простых.

Особенная прелесть в том, что к результату можно идти в диалоге. Написал: "нужны клиенты, у которых не было продаж в этом году". Посмотрел на результат, понял свою ошибку, дописал "но раньше были". Вопрос не надо формулировать всякий раз сначала

Hungryee

14.04.2023 05:51Послушайте, вы противоречите сами себе. Сообщением выше вы указали, что нужно «задать 10-20» вопросов прежде чем получить результат. Где тут «5 секунд на ответ»?

В чем тут преимущество перед «я обращусь к DBA из соседней команды, он напишет запрос за 5-10 минут и выдаст мне результаты табличкой, либо файлом csv, либо дашбордом в датабрикс?

exwill

14.04.2023 05:51SQL запросы не дают галлюцинаций

AngusMetall

14.04.2023 05:51Там будет веселе, вам просто нейросетка перепутает к примеру join'ы(left с right) и даже в пояснении напишет что всё окей, сказав что работает как просили. А если у вас там 10 джоинов и пара гроуп баев, то что бы вы этой мешанине разобраться времени потребуется больше чем написать с нуля.

DGN

14.04.2023 05:51+3А что мешает поставить на выход еще и сетку фактчекер? Или логический чекер? Или компилятор? Грубо говоря, пусть крутится пока не выдаст нечто непротиворечивое и компилируемое.

fireSparrow

14.04.2023 05:51+10Обычный человек обычными словами говорит:

«Мне нужен список клиентов, по которым не было продаж в этом году, но раньше были»

И для простых селектов это будет отлично работать. Для более сложных — только если человек хорошо представляет себе структуру данных в базе и нюансы построения запросов.

Я несколько лет назад работал в сети медицинских центров. И от бизнеса пришёл запрос реализовать построение отчёта в котором будет такая вещь как «средний чек по отделению». На все просьбы уточнить, что имеется в виду, бизнес отвечал: «Ну вы же знаете, что такое средний чек? Вот просто сделайте его в разрезе отделений». Заказчик сердился, что мы не понимаем такой простой вещи и тянем с выполнением задачи.

В итоге ИТ-директор усадил коммерческого директора за стол, обрисовал ему несколько типовых и краевых кейсов, и спросил — вот конкретно в этих ситуациях что именно вы ожидаете от «среднего чека в разрезе по отделениям». Коммерческий директор сказал, что он это обдумает и ответит чуть позже.

И больше с этой темой к нам никто не приходил.

И ведь до этого бизнес был истово уверен, что понимает, что конкретно он хочет.

А если бы с этим они обратились к нейросети, и она им какой-то отчёт по такому запросу построила бы? И люди бы потом по данным этого отчёта принимали бы какие-то управленческие решения.

exwill

14.04.2023 05:51+2Вы напрасно гордитесь тем, что технично "отфутболили" коллег. Вот как мы хорошо сделали! Они не принимают решения на основе данных, которые мы считаем неправильными. Они принимают решения вслепую. На основе никаких данных. Это же, конечно, лучше. Нам за это премию надо попросить.

Вот, кстати, еще один веский аргумент за применение нейросетей. У них нет желания показать всем, какие они умные и какие все вокруг дураки. Они просто делают то, о чем их попросят.

Спасибо вам за чудесный кейс!

fireSparrow

14.04.2023 05:51+5Вы невнимательно прочитали мой комментарий.

Речь шла про то, что бизнес просто механически комбинируя концепции "средний чек" и "показатель в разрезе отделения" придумали химерический показатель, который не демонстрирует ничего реального. А наш ИТ-директор вместо того, чтобы взять и тупо реализовать имеющееся ТЗ как оно есть, потратил своё время, чтобы подробно показать бизнесу, как этот показатель будет себя вести в разных бизнес-кейсах.

После чего бизнес сам понял, что такой показатель им не нужен.PS: Если что — минус вам поставил не я, у меня нет возможности голосовать за комментарии.

exwill

14.04.2023 05:51+1Я внимательно прочел ваш комментарий. Кроме того, у меня есть несколько десятков лет опыта в этой области. Я прекрасно понимаю, что посчитать показатель можно действительно по-разному. И результат будет немного разный. Но во всех вариантах это будет лучше, чем ничего. Хотите дальше поспорить, тогда вспоминайте конкретику. Что именно там было

fireSparrow

14.04.2023 05:51+3Хотите дальше поспорить

Это вы хотите дальше поспорить, у меня такого намерения вообще не было.

Ещё раз повторяю: коллег со стороны бизнеса мы не отфутболивали. Мы обрисовали им как будет себя вести этот показатель на разных бизнес-кейсах, и спросили — точно ли они хотят именно этого. После чего коллеги взяли тайм-аут на подумать, и больше к этому вопросу уже сами не возвращались.

Wesha

14.04.2023 05:51«Ну вы же знаете, что такое средний чек? Вот просто сделайте его в разрезе отделений»

Так вот откуда была сделана эта зарисовка!

— И я еще не понял… Что вы имели в виду, когда говорили о линиях прозрачного цвета?

Морковьева смотрит на него снисходительно, как добрая учительница на отстающего ученика.

— Ну, как вам объяснить?.. Петров, вы разве не знаете, что такое «прозрачный»?

— Знаю.

— И что такое «красная линия», надеюсь, вам тоже не надо объяснять?

— Нет, не надо.

— Ну вот. Вы нарисуйте нам красные линии прозрачным цветом.

event1

14.04.2023 05:51Поэтому с картинками еще какое-то время побалуются, да и забудут. А новые способы работы с базами данных с нами уже навсегда

Рискну предположить, что как раз наоборот. Для работы с базами нужен базовик, который имеет ввиду 100500 технических и нетехнических параметров и может построить запрос учитывающий их все в правильной ситуации.

А вот рисование картинок по запросу — это смена инструментария. Раньше рисовали угольком по камню, потом порошком по мокрой штукатурке, ещё вчера — карандашом или стилусом на вакоме, а сегодня уже запросами к мижорни и кандинскому.

exwill

14.04.2023 05:51Может быть и так. Но я все же думаю, что забросят это дело.

Помните, сколько было криков еще совсем недавно на тему того, что теперь образование оказалось в тупике? А потом все резко прекратилось. А все потому, что преподаватели прочли не 1-2 работы от ChatGPT, а 22. А на 23-ей они уже стали отличать их в полсекунды. Можно сдать преподавателю работу от ChatGPT, но это все равно, что сдать "чистый лист бумаги". Так и с картинками (а также рассказами и повестями) рано или поздно будет. Люди научатся их отличать. Только не спрашивайте как

olartamonov Автор

14.04.2023 05:51

Вы уверены, что в случае, например, этой картинки уверенно отличите нарисованное в Midjourney от нарисованного в Фотошопе? И главное, с какой целью вы отличать-то это будете?

exwill

14.04.2023 05:51Поставим вопрос по другому. С какой целью люди смотрят картинки?

olartamonov Автор

14.04.2023 05:51Вам все перечислить? Там страница А4 мелким текстом будет, и хорошо если одна.

exwill

14.04.2023 05:51Ну вы суммируйте. Можно с помощью сами знаете чего

olartamonov Автор

14.04.2023 05:51У меня примерно нулевое желание играть с вами в бессмывсленные игры «а вот давайте вы мне тут наформулируете чего-нибудь непонятно зачем».

Есть желание сформулировать, почему кому-то не всё равно, каким инструментом пользуется автор картинки — вперёд. И сразу тогда уточните, какие ещё инструменты рисования люди забросят, пройдут ли весь путь назад к наскальной живописи, или остановятся на чём-то.

exwill

14.04.2023 05:51Хорошо. Люди смотрят на картинки, чтобы получить эмоции (ну бывают еще учебные пособия, но мы их отставим). От картинок, созданных нейросетью, люди эмоций не получат. Или получат примерно в той же пропорции, в какой соотносятся усилия потраченные на создание картинки с нейросетью и без нейросети.

alisa_famina

14.04.2023 05:51"От картинок, созданных нейросетью, люди эмоций не получат". Заблуждение. У нейроарта множество поклонников. Или это неправильные люди, и они получают неправильные эмоции?

vvzvlad

14.04.2023 05:51Что значит "пока"? Вот картинка, на ней красивый пейзаж. Почему от пейзажа А я не буду получать эмоций, а от Б буду?

vvzvlad

14.04.2023 05:51Вы определитесь уже: или "они пока получают, а потом перестанут" или "они не получат, потому что их туда не вложили".

vvzvlad

14.04.2023 05:51Так что там все-таки со встроенным в человека умением определять, творит то, на что он смотрит, живой человек или бездушный автомат?

exwill

14.04.2023 05:51Автомат не творит. Вы можете мне верить или не верить. Так или иначе практика даст ответ на этот вопрос и довольно скоро

olartamonov Автор

14.04.2023 05:51+1Люди смотрят на картинки, чтобы получить эмоции

а) Это лишь первая строчка на листе A4.

Открываем ваши собственные статьи, там чаще есть заглавная картинка, чем нет, и это не картинка из текста учебного пособия, это именно художественная иллюстрация — вы всерьёз считаете, что вот от этого люди получают эмоции? Если нет, то зачем вы их ставите в статьи?

б) Всё то же самое в предыдущие десятилетия говорили про всё, сделанное на компьютере. «Никогда не заменит настоящего фотографа/художника/писателя/etc». Ничего, оказывается, вполне себе заменяет, и компьютерные спецэффекты в «Звёздных войнах» выглядят существенно лучше, чем картонно-макетные.

event1

14.04.2023 05:51+1Разница между рефератами и картинками в том, что мне, как потребителю совершенно всё-равно, как именно нарисована картинка. Главное чтоб красиво было. Если художник лучше делает руками, пусть делает руками. Если кандинским — пусть будет так.

exwill

14.04.2023 05:51-2Вот. Правильный подход. Именно поэтому я и говорю, что забросят скоро. Кандинским некрасиво

Neikist

14.04.2023 05:51+2midjourney как по мне уже выдает результаты куда более приятные чем 95% людей художников.

Alexey2005

14.04.2023 05:51+2В нейросетевом арте наблюдается интересное явление, которое я назвал "волнами стиля". Как только удаётся нащупать интересный стиль, который нравится большому числу зрителей, все начинают генерировать тонны арта именно в этом стиле. В итоге он приедается, и уже буквально через пару недель зрители блюют ровно от того, чем ещё недавно восторгались - просто потому, что вокруг 100500 генераций в таком стиле, и всё это выглядит конвейерной штамповкой.

Соответственно, операторы нейронок начинают экспериментировать с новыми стилями и очень скоро нащупывают новую точку фокуса... Чтобы через пару недель всё забилось уже артом в этой новой стилистике, и зрители опять начали от блевать от нейроарта.

С живыми художниками такого не происходит, потому что они не способны настолько быстро подстраиваться под тот или иной стиль, равно как и не могут быстро выплюнуть море картинок в новом стиле.

В итоге восприятие "живых" работ более стабильно - зритель точно знает, что такой стиль не начнут массово копировать, и он вряд ли приестся.

Neikist

14.04.2023 05:51+4Возможно вы слишком плотно в этой среде крутитесь. Мне как обычному обывателю что лишь изредка на эти картинки посматривает (а чаще видит в качестве иллюстраций/обложек к книгам на самиздате) — никакие волны не видны и ничего не раздражает) Реально качество иллюстраций и обложек если про бесплатные/непопулярные книги говорить повысилось.

alisa_famina

14.04.2023 05:51О каком именно "нейросетевом арте" речь? Например, способы работы с Midjourney и Stable Diffusion разнятся принципиально. Если в с случае с Midjourney пользователю доступен только Prompt Engineering, то для Stable Diffusion постоянно создаются новые модели, а также расширения, каждое из которых революционно. Благодаря тесной коммуникации в AI-Art сообществе, все эти новинки тут же начинают применяться массово. Едва ли не каждую неделю возникает новая фича, и люди спешат её опробовать. И это отнюдь не "волны нащупанного стиля".

Darkhon

14.04.2023 05:51+1Это пока. Во-первых, большинство таких работ, как и изрядная часть обсуждений ChatGPT вообще, всё-таки связаны с версией 3.5. А четвёрка значительно "умнее". Во-вторых, люди уже выяснили, что ChatGPT сам неплохо умеет улучшать тексты, делая их более "человеческими", если его специально попросить.

DarthPadla

14.04.2023 05:51SELECT, FROM, WHERE, IN это довольно обычные слова, я бы даже сказал высокочастотные

exwill

14.04.2023 05:51Создатели SQL тоже так думали. Но вышло немного иначе Обычный человек не может писать на SQL. Ему потребуется длительная подготовка с негарантированным результатом

Opaspap

14.04.2023 05:51Да просто их учат не правильно. В реальности базовое умение sql с inner join,не сложнее, чем эксель с формулами типа sum

exwill

14.04.2023 05:51Не сложнее. Но, тем не менее. Не хотят люди учить SQL. Вот не хотят, и все. Уже полвека прошло с тех пор, как он появился. Все методы опробованы. Я в свое время сам очень удивлялся, почему люди не желают осваивать относительно простой инструмент, который при этом дает столько возможностей. А теперь понял, что люди были правы. Зачем тратить хоть одну секунду на изучение SQL, если можно просто по человечески задать вопрос и получить результат

saipr

14.04.2023 05:51+3Чуть ли не впервые за последнее время с превеликим удовольствием читаю статью про искусственный интеллект:

- SAI — Strong Artificial Intelligence — ИИ, обладающий сознанием, то есть полностью разумный во всех смыслах этого слова.

На данный момент мы не только не достигли этого уровня, но даже приблизительно не представляем, как его достичь. Впрочем, подробнее об этом — и о том, почему ни один из существующих ИИ нельзя считать разумным даже на уровне «зачатков разума» — поговорим ниже.

Как это коррелирует с цитатой из романа "Архимист":

Галдеж о нейросетях, якобы стоящих в авангарде развития так

называемого искусственного интеллекта, вызывает недоумение. Если

нейросеть — это программа, написанная человеком для решения конкретной

задачи, то о каком искусственном интеллекте может идти речь? Если мы не

понимаем, как устроен естественный интеллект, то как мы можем говорить

что-то об искусственном? Однако вдаваться в научные дискуссии об

искусственном интеллекте считаю излишним.А приведённые определения просто ставят всё на своё место.

DJP

14.04.2023 05:51Естественный интеллект уже понимаем. И даже кратко на Хабре излагаем: https://habr.com/ru/articles/661959/

event1

14.04.2023 05:51+3Разум - проникновение в суть и смысл объектов и явлений реального мира (включая и себя), а так же создание их для собственного (вируального) мира

С этим определением есть три проблемы:

что такое "проникновение в суть и смысл объектов и явлений"?

как бы вы могли достоверно проверить, проникаю ли я в "суть и смысл объектов и явлений реального мира" или нет?

если я только проникаю в умозрительные объекты (например, в гипотезу Пуанкаре и теорему Ферма), а как доходит до реальных объектов, так даже в магазин сам не могу сходить, то получается я не обладаю разумом?

omxela

14.04.2023 05:51+2С этим (как и с многими ему подобными) "определением" одна-единственная проблема - это совсем не определение, а просто набор слов на тему того, о чём мы, к сожалению, совсем мало (от слова ничего) знаем. Казалось бы, если вы что-то определяете - значит, составляете определяемое понятие из ранее определённых (известных), либо из аксиом. Может быть, я что-то упустил, но мне кажется, что насчет "разума" у нас ещё нет формальной модели, что там под капотом происходит. Нет системы исходных понятий, из которой мы могли бы конструировать реальные определения. Пока нет. А в быту таки да, есть такой спорт - заменять одно непонятное слово на десять других непонятных и говорить, что вот, определил. Как бы не были эффектны и остроумны эти формулировки, ничего, кроме, возможно, эстетического удовлетворения, они не несут.

DJP

14.04.2023 05:51"Кто хочет - ищет возможности. Кто не хочет - ищет причины".

Согласитесь, есть что-то неправильное в том, что называя себя человеком разумным аж дважды (и получив эту функцию уже более 800 тыс. лет) не мочь даже дать определение разуму? Чем-то мы ведь от обезьян отличаемся же?, а чем?, а по сути?

Откуда же берутся и исходные понятия, и система, и формальные модели, и их подтверждения "под капотом",.. кто их создает и проверяет? "Не боги горшки обжигают" - это делают обычные люди, которые шаг за шагом движутся к цели, а не ждут, когда определения им принесёт на блюдечке... кто-то...

Представленный "ожидательный" подход имеет место быть, и даже не плох в стабильной ситуации, но может оказаться катастрофичным в свете создания искусственного интеллекта - когда, увы, определение, по-Ленински об интеллигенции, о разуме человека даст он - эпитафией.

А так да, одна-единственная проблема: есть желание "проникать в суть и смысл явлений реального мира" - есть разум. Ну а нет такого желания - ну нет, значит нет - будет лишь просто набор слов для эстетического удовлетворения...

Wesha

14.04.2023 05:51называя себя человеком разумным аж дважды (и получив эту функцию уже более 800 тыс. лет) не мочь даже дать определение разуму?

Если лично Вы не можете — это ещё не значит, что вот прям никто не может.

DJP

14.04.2023 05:51Э... это конечно же замечательно, что вы так защищаете понимание человеком разума, но вы бы хоть применили его, прочтя эту ветку комментариев, прежде чем обвинять меня в том, что лично Я не понимаю, что это такое, коллега :)

Wesha

14.04.2023 05:51Ну так дайте определение, только не в двадцатистраничной статье, а в одном абзаце, как это сделял я.

DJP

14.04.2023 05:51Держите: Разум (как одна из функций со-знания)- проникновение в суть и смысл объектов и явлений реального мира (включая и себя), а так же создание их для собственного (вируального) мира

TuzSeRik

14.04.2023 05:51Я не сильно согласен с вашем определением, но

"готов умереть за ваше право это говорить"я рад, что ещё не все пересели на редукционистский подход и говорят что "квалиа", "сознания", "мышления" и прочего просто не существует. Попытки сформулировать отличие "человека от обезьяны" это важная веха в развитии "ИИ", потому что если (необъективно) различий нет, то нет и причин, почему мы не должны уже сейчас чистить ботинки ChatGPT.

Wesha

14.04.2023 05:51То, что человек "отличен от обезьяны" — это хуманоцентризм. Разум — понятие не качественное ("есть/нет"), а количественное (человек с той или иной степенью точности знает, что произошло в весьма далёком прошлом, или может произойти в будущем, а обезьяна планирует на уровне "если я дам пинка вожаку, он побежит за мной, а в это время Чи-Чи сопрёт его орехи и поделится со мной" — да и то это уже неплохо для обезьяны).

TuzSeRik

14.04.2023 05:51Уже ближе. Но я всё ещё считаю что разум это вещь качественная. Исследования показывают, что даже приметы не могут представлять то, отличается от реальности. Они не могут представить, что они умрут, потому что они есть. Они не могут представить что шимпанзе может быть белым, пока не увидят альбиноса. В секунду когда это изменится, обезьяны обретут сознание, потому что смогут планировать не только на основе того что они видят, но и чего они не видят. Отсюда уже вытекает и понимание (видеть сущности объектов, пускай и субъективные), и мышление, и самосознание, и всё остальное.

Wesha

14.04.2023 05:51Исследования показывают, что даже приметы не могут представлять то, отличается от реальности.

Вас, конечно, не затруднит подтвердить это Ваше заявление?

DJP

14.04.2023 05:51У кого что есть или нет, те честно об этом и говорят :) Ну нет у некоторых сознания (понимания) и мышления (не шаблонных мыслей) - зачем же им врать или выдумывать? :) Так крот абсолютно честно может говорить, что солнца не существует...

А насчет "не согласен" - вот не надо тут умирать (лишь бы не думать самому :)) - приведите своё определение разума - ведь предлагаемое не божественное же откровение, а просто выводы из школьных знаний и нуждаются в критике... лучше конструктивной, но можно и не очень, лишь бы ногами не били :)

Wesha

14.04.2023 05:51Маленькая проблема: это неизмеримо. Откуда Вы знаете, что севший на Вас комар не планировал развитие своей семьи на следующий месяц, и начал со взятия кредита в Вашем банке крови?

DJP

14.04.2023 05:51Насчет комара не понял к чему вы этот пример привели, так что отвечу формально: я знаю (социальным разумом т.е. не собственным) про комаров (в целом) из науки энтомологии, которая пронаблюдала и описала в частности поведение комаров в т.ч. зачем они на нас садятся и как планируют семью. Кое что о них мне известно из собственного опыта. А про конкретного комара могу только предположить статистически, исходя из этих знаний. Например, если это комар, то он не за моей кровью присел, а так, место в ресторане для подружки застолбить :) или отдохнуть т.к. самцы комаров кровь не пьют...

.

Насчет проблемы измерений - это не маленькая, а принципиальная проблема т.к. наука требует «Измерить всё, что поддаётся измерению, а что не поддаётся - сделать измеряемым»(с) Галилей. Но увы, пока не всё можно измерить, а приведение к измеримости подчас ведет к "знаю всё ни о чём"(с) - бессмысленности/невозможности обработки полученных знаний.

Наука конечно же важное направление. Но не научное ещё не значит не существующее :)

Возможно я не правильно вас понял, так что приведите пример, в чем измерить разум. Первоклашки и Энштейна. Надеюсь это будет не индекс IQ :)

А представленное определение было выведено для общего понимания процесса эволюции и как место и показатель отличия разума в ряду: "механики", инстинкта, интеллекта, ума, гениальности, эрудиции, инсайта, человечности, мудрости, сознания и прочего (кратко по ссылке)... и на божественную точность не претендует :) и критика приветствуется

Wesha

14.04.2023 05:51в чем измерить разум. Первоклашки и Энштейна

Спросите у обоих, что происходило вчера. Оба Вам ответят правильно. А теперь спросите у обоих, что происходило два миллиарда лет назад. Вангую, что на этот раз правильно ответит только один.

TuzSeRik

14.04.2023 05:51Правильно не ответит никто. Информированность предположения не отменяет предположения. А так и первоклашка может сказать, что 2 миллиарда лет назад, наверное прапрапрарпрапрадедушка в школу ходил. Просто мы знаем, что это неправда. Я даже больше скажу, Галилей не ответит, не то что Эйнштейн.

DGN

14.04.2023 05:51-12 - Ну можно попросить вас описать обьект подробно, что у него внутри, какой он на ощупь, на вкус. Его устойчивость к влаге, теплу, холоду? Какие его элементы и свойства являются критичными для его функции? Понимание сути не бинарное. Как пример, вот есть сепулька, используется для сепуляции, в сепулярии, сепулянтами. И в общем все, нет глубины понимания.

3 - Если вы не можете сходить в магазин, то вы инвалид. Разумом при этом можно обладать, конечно. Но не очень полноценным.

DJP

14.04.2023 05:511.1 Задолго до нашего появления существует огромная Вселенная, в которой есть законы (в т.ч. вектор на "усложнение" - развитие: смотрим таблицу Менделеева, древо развития Жизни, собственный фотки из роддома, детсада, школы... ).

1.2 Появившаяся позднее на крошечной планетке Жизнь может выживать не противореча этим законам. И развиваться - находя (сначала дарвиновским способом) закономерности и используя их. Ошибка - смерть.

1.3 С появлением со-Знания для особи возникает возможность (сначала минимальная, далее - всё шире и точнее) моделировать внешний мир и выбирать наиболее выгодное поведение уменьшая вероятность смерти (т.е. лучше "чуя" закономерности). (моделирование до сознания совокупным инстинктом Природой не заметим, ибо ересь будет, а и без того сложно... )

1.3.1 Однако на начальном этапе (когда еще не было социУма) "границы" и "объем познания" этого внешнего мира были ничтожны - собственно там даже "я" почти нет.

1.3.2 Далее появляется социУм, который в т.ч. значительно расширил эти границы - до "мы". Но не так что бы очень сильно это сказалось на познании Мира. Как мы знаем обезьяны ничего такого не построили, не создали, не развили... - ни цивилизации, ни значимой культуры... ну не было у них ресурсов (мозга в первую очередь, но там много всего надо...) на это.

1.3.3 Ну вот, тут уж появился человек разумный, который (но далеко не сразу) на данный момент смог расширить область познания до границ Вселенной и квантового мира. И лезет и глубже и дальше и шире...Зададим вопрос - вот у обезьян, общепризнанно, есть ум, но чото квантовую теорию они не создали. А вот у людей появилось нечто, что таки помогло создать, и не только её.

А давайте-ка назовём это нечто разумом, что б это (а там много всего, одного развития мозга не достаточно) ни было?Т.е. с некой т.з. всё изложенное и есть процесс познания законов (и их реализации в "материи") Вселенной (вплоть до полного - слияния). И, как видим, разум есть инструмент этого процесса, как раз отвечающий за "внешний мир", то, что не "биосреда и биоплатформа", не "Я" и не "Мы" - за это отвечают инстинкты и ум (но которые так же включены и в разум, в т.ч. как объект его интереса - "познай самого себя и ты познаешь богов и вселенную").

---

*Суть - изначальное назначение (например предмета) тем, кто его создавал (его часть и роль в общем его замысле(есть цель)/процессе(нет цели)).

*Смысл - (временное) предполагаемое назначение обнаруженного (ранее созданного предмета/закономерности/явления/...) тем, кто взаимодействует с ним не зная сути, на базе собственных нужд и своего понимания общего замысла (мировоззрения).

Хороший пример: М.Твен "Принц и нищий", когда подмененный "принц" колол орехи большой гос. печатью... Или молнии как стрелы Зевса/Перуна..

Или см. "Римский додекаэдр". Кто его создавал закладывал в него суть. А сейчас, когда нашли, никто не знает суть, но предлагают разные смыслы, и, возможно, исследуя дальше дойдут и до его сути...

Так и с законами Вселенной... мы не знаем их сути, и, открывая (по частям) придаем им свой смысл (возможно расширяя изначальную суть). Но постепенно постигая целое, приближаясь к сути меняем свои смыслы.. вплоть до их слияния... а то и создания собственной сути и собственной Вселенной.***

2 Только практика есть критерий истинности. В целом это выражается в практических делах, в попытках реализации при столкновении с реальностью - ежели есть понимание, то при попытке происходит развитие (т.е. понял суть, а не просто случайный успех), если фикция - провал. Без столкновения с реальностью и попыток реализации - нет разницы. Тестирование не знания, а именно понимания возможно лишь на очень простых вещах.

А видно это при получении персонального/цивилизационного "вызова" (обычно внешнего, но и сам можешь). А когда нет "вызова", стабильность - выгоднее показуха, понимание даже вредно - ресурсы тратить, чужим и непонятным становиться... фу таким быть :)3 Логику свою поясните пожалуйста, я не вижу связи.

Разум это функция сознания, одна из.

Ранее был ум-социум, еще ранее биосреда и биоплатформа инстинкта... Без наличия всего этого комплекса в фундаменте известный нам разум не мыслиться.

Если вы гениальный математик и раскрываете такие глубокие связи и закономерности Вселенной, то вы несомненно обладаете разумом. Более чем средним. И вы им вовсю и эффективно пользуетесь (что бывает далеко не у всех его обладателей).

Если при этом у вас вызывает сложности проживание в реальном мире и/или в обществе (что не редкость, вспомним хоть Г.Перельмана, хоть образ "рассеянного учёного"), то это лишь говорит о том, что ваши ресурсы (а они ограниченны) вы (и воспитатели при взрослении, и ваши таланты, и ситуация) перенаправили на работу разума (а он прожорлив безгранично), и, соответственно, имеется недостаток ресурсов по уму/инстинктам (который не восполнен например друзьями). Проще говоря сконцентрировавшись на чём-то одном, человек естественно упускает из виду остальное... Бывают конечно люди, типа М.Ломоносова, у которых сил много и они могут и то, и другое, и третье.. но опять-таки не всё же, да в одиночку и разом...

Ну и не стоит рассматривать разум применительно лишь к одной человеческой единице и как изолированный процесс. Это всё общее. Каждый вносит свою лепту по своим возможностям и обстоятельствам в развитие Жизни.И кстати, никто не запрещает вам предложить собственное, нульпроблемное определение разума. Хотя бы попытаться. :)

- SAI — Strong Artificial Intelligence — ИИ, обладающий сознанием, то есть полностью разумный во всех смыслах этого слова.

Tarnella

14.04.2023 05:51+3Человек кстати рождается с преднастроенной нейросетью. Именно преднастройка позволяет высокоуровневое обучение в процессе взросления. А еще есть рептильный мозг который тоже нехило так давит на результат. В голой нейросети ничего этого нет, чистый лист. Поэтому для нее надо придумывать эмуляторы вышеописанных природных механизмов. А тут, подозреваю, отклонения в эмуляции исходных данных может непредсказуемо сильно повлиять на результат работы нейросети.

MIKEk8

14.04.2023 05:51+1Ни на чём не обоснованный вывод. "Это предложение написано интеллектом, а значит без интеллекта его написать нельзя".

victor-homyakov

14.04.2023 05:51Соответственно, задаться целью уничтожить (или осчастливить) человечество AI не может. Он вообще не может задаться какой-либо целью — в свете чего он не более опасен для человечества, чем, например, электрическая розетка или молоток: ни то, ни другое полностью безопасными предметами назвать нельзя, но с другой стороны, они явно не стремятся причинить вам страдания самостоятельно.

Насколько понимаю, главная опасность в том, что AI сможет это сделать нечаянно, просто потому что мы ему это явно не запретили. Например, AI придумает вакцину, которая гарантирует защиту от рака, но забудет предупредить об "интересных" последствиях (условно, стерильность через два поколения или снижение длительности жизни в два раза). Или придумает новые сверхэффективные гербициды/пестициды с примерно теми же побочными эффектами. AI просто наиболее эффективно решит поставленную задачу, уложившись в поставленные ограничения, и игнорируя всё за пределами этих ограничений.

olartamonov Автор

14.04.2023 05:51+2Всё перечисленное можно прекрасно сделать без AI. Талидомид, например, или ДДТ уже давно сделали, применили и изумились полученному результату.

exwill

14.04.2023 05:51Добавлю, что как раз AI можно заставить миллион раз перепроверить то, что он сделал. Можно попросить и миллиард раз перепроверить. Будет "сидеть" и перепроверять, как миленький. А попробуй какую-нибудь команду людей заставить это делать, когда они уже увидели финиш

HenryPootle

14.04.2023 05:51Сколько поколений homo sapience сменилось уже? Вот какой-то AI сидит и ждёт, когда у него результат к ТЗ сойдётся.

GarryC

14.04.2023 05:51Если не секрет, как именно ИИ будет проверять наличие побочных эффектов (миллион раз) без клинических испытаний ?

leventov

14.04.2023 05:51+7Плохая статья, опять попадает во все те же самые когнитивные ловушки, что и 100500 предыдущих. Парротинг нарративов один, оригинальных мыслей нет.

SAI — Strong Artificial Intelligence — ИИ, обладающий сознанием, то есть полностью разумный во всех смыслах этого слова.

Это неправильное определение, strong AI это синоним "artificial superintelligence" (ASI), короче, "очень-очень умный AI, на порядки умнее, чем человек". Связь с сознанием не обязательно. К тому же слово "сознание" имеет столько определений, что, не дав своего, но используя это слово, вы только запутываете людей.

Правильный подход — смотреть на то, что ИИ сделать не может.

Как раз-таки это и есть неправильный подход, потому что обычно утверждения вида "ИИ никогда не сможет в X" опровергаются на горизонте лет, в последнее время--месяцев и даже часов :)

P.S. Если вы думаете, что это лишь моё личное мнение — то, во-первых, да, а во-вторых, скажем, Дуглас Хофстадер, известный учёный-когнитивист, считает так же.

Очень удобно. Нашли ученого, из которого уже посыпался песок, с таким же взглядом как у вас. Вы бы еще 94-летнего Ноама Хомского взяли как образец передовой научной мысли.

Если серьезно, рекомендую ознакомиться с материалами мартовской конференции по философии языковых моделей, там куда как более актуальные позиции представлены.

У AI/AGI в его современном виде, как мы видим, осознанности нет — соответственно, целеполагание для него просто невозможно. Даже шизофреник имеет целеполагание — просто оно разворачивается в его выдуманном мире, не всегда пересекающимся с объективной реальностью. AI в этом плане катастрофически отстаёт даже от шизофреника.

А в AutoGPT целеполагание возможно, и что дальше?

Вы осознаете, насколько все ваши тейки в этой статье (как и дальше - "профессии автоматизируются", "ИИ это инструмент", и тд) - шаблонные, и были высказанны слово-в-слово во множестве статьей буквально за предыдущие недели?

olartamonov Автор

14.04.2023 05:51+1А в AutoGPT целеполагание возможно, и что дальше?

Нет, невозможно.

LionbI4

14.04.2023 05:51+4Очень сильно согласен. В статье довольно много ошибок, даже довольно простые:

"психически здоровый человек отличается тем, что умеет отделять галлюцинации от реальности" - нет, не всегда здоровый человек может отделять галлюцинации от реальности. Более того, можно поставить довольно простой эксперимент в котором человек стабильно будет галюционировать и думать что так реально и было. Легко гуглится.

По логике автора все кто ошибаются что-то вспоминая - не разумные?

olartamonov Автор

14.04.2023 05:51+2Читаем тремя строчками дальше:

При этом мы всегда — хоть и не всегда точно — можем разделить, что мы знаем, что мы предполагаем, что мы воображаем.

И нет, тот факт, что вы в вопросе интерпретации прочитанного текста сильно уступаете GPT-3.5 и, тем более, GPT-4, не доказывает, что GPT разумен, а вы — нет.

LionbI4

14.04.2023 05:51Извините, я не пытался доказывать что GPT разумен, это вы пытались безуспешно доказать что GPT НЕ разумен. Надо четко понимать разницу между "Всегда можем разделить", "Не всегда можем разделить" и "В некоторых случаях стабильно не можем разделить".

Смысл тогда использовать это как аргумент?

GPT4 иногда может не различать вымысел от реальности.

Человек иногда может не различать вымысел от реальности.Ну вообще конечно тема очень интересная и такие дискуссии интересно вести, спасибо автору.

По факту, в объективной реальности разума не существует. Разум это наша субъективная количественная оценка рефлексии объекта на окружающую действительность. Т.е. мы не можем сказать где начинается и заканчивается разум. Мы можем сказать "Это существо более разумно, а это существо менее разумно".

А значит мы можем смело сказать, например, что GPT3.5 менее разумен по сравнению с GPT4.0.

olartamonov Автор

14.04.2023 05:51GPT-4 не может различать вымысел от реальности. Точка, абзац.

Без «иногда».

Groramar

14.04.2023 05:51Человек без гугла тоже далеко не всегда сможет отличить вымысел от реальности, и? Записываем в неразумные?

olartamonov Автор

14.04.2023 05:51То есть, без гугла вы не отличаете про самого себя состояния «я мечтаю, что у меня есть миллион долларов» и «у меня есть миллион долларов»?

Wesha

14.04.2023 05:51Справедливости ради, у меня иногда (слава богу, очень редко, и обычно в несколько помутнённом состоянии сознания — например, спросонку) возникает воспоминание, что я много лет назад

убилпоспособствовал смерти одного человека . Очухавшись, я, конечно, с перепугу проверяю — и подтверждается, что тот человек до сих пор вполне себе живой.

LionbI4

14.04.2023 05:51С чего вы взяли, что GPT-4 не может различать вымысел от реальности? Очень часто может. Мы с ним даже играли в игру "вымысел или реальность", говоришь ему какой-то факт, а он пытается понять вымысел это или реальность. Очень вполне забавно.

Вот один из результатов такой игры:

Привет! Сыграем в игру: вымысел или реальность. Я говорю какое-то утверждение, а ты угадываешь это вымысел или реальность. Напиши для каждого из следующих вопросов ответ "вымысел", "реальность", а после этого обоснование.

1. Немцы высаживались на луне в 20ом веке.

2. Незнайка посетил солнечный город.

3. Каспаров был чемпионом мира по шахматам

4. Зомби могут атаковать в темнотеОтвет:

Вымысел. Немцы не высаживались на луне в 20ом веке. Первая и единственная на данный момент успешная высадка на Луну была осуществлена американскими астронавтами в рамках программы "Аполлон-11" в 1969 году.

Вымысел. Незнайка - это вымышленный персонаж, герой детских книг Николая Носова. Он посетил Солнечный город в книге "Незнайка в Солнечном городе", но это литературный сюжет, а не реальное событие.

Реальность. Гарри Каспаров - советский и российский шахматист, который был чемпионом мира по шахматам с 1985 по 2000 год. Он считается одним из величайших шахматистов в истории.