Сегодня многие компании, не желая принимать на себя затраты на покупку и обслуживание физических серверов, выбирают виртуальные площадки. Воспользовавшись услугами хостинг-провайдера, можно создать качественный интернет-портал, доступ к которому будет одинаково хорошим из Москвы и Владивостока. И при этом технической поддержкой будет заниматься команда провайдера — остается подумать лишь о наполнении.

RUVDS — довольно молодой, но активно развивающийся хостинг-провайдер с собственным дата-центром уровня TIER III, расположенным в Москве. Вот в нем мы и побываем. Но сначала — немного из истории этого ЦОД.

В 2015 году компания RUVDS приняла решение о строительстве собственного дата-центра. Она достаточно долго искала площадку, которая могла бы удовлетворить запросы энергообеспеченности и связи, а также общей надежности, и остановились на площадке одного из стратегических заводов нашей страны, который сумел предложить наилучшие условия. Принимая во внимание, что в дата-центре важна, в первую очередь, надежность, RUVDS пригласила к сотрудничеству очень опытную команду из компании MTW.RU. Ее специалисты оказали неоценимую помощь в строительстве дата-центра. В итоге это позволило построить ЦОД в максимально сжатые сроки при высоком качестве, учитывая многолетний опыт MTW.RU.

Помещение дата-центра находится на территории стратегического предприятия — АО «Композит», в бомбоубежище. Данный объект интересен еще и тем, что представляет собой комплекс из нескольких независимых залов (гермозон), помещения которых герметичны.Это повышает отказоустойчивость ЦОД, а также позволяет более гибко подходить к реализации индивидуальных запросов заказчиков в отношении безопасности и надежности.

Так что сегодня в распоряжении RUVDS — собственный дата-центр, который компания эксплуатирует по договору долгосрочной аренды, расположенный по адресу: Московская область, Королёв, ул. Пионерская, д. 4 на территории ведущего материаловедческого предприятия Федерального космического агентства АО «Композит». Помещения дата-центра аттестованы в соответствии с требованиями ФСТЭК, проектировались в соответствии категорией надежности TIER III, согласно стандарту TIA-942 (резервирование N+1 с уровнем отказоустойчивости 99,98%).

Площадь дата-центра — порядка 1500 кв.м. Часть её занимают операторская, бытовые помещения, дизель-генераторы и прочие системы. Имеющиеся резервы позволяют оперативно увеличить площадь ЦОД и подаваемую мощность электропитания как минимум вдвое. Среднее энергопотребление на стойку сейчас составляет примерно 15 кВт*час.

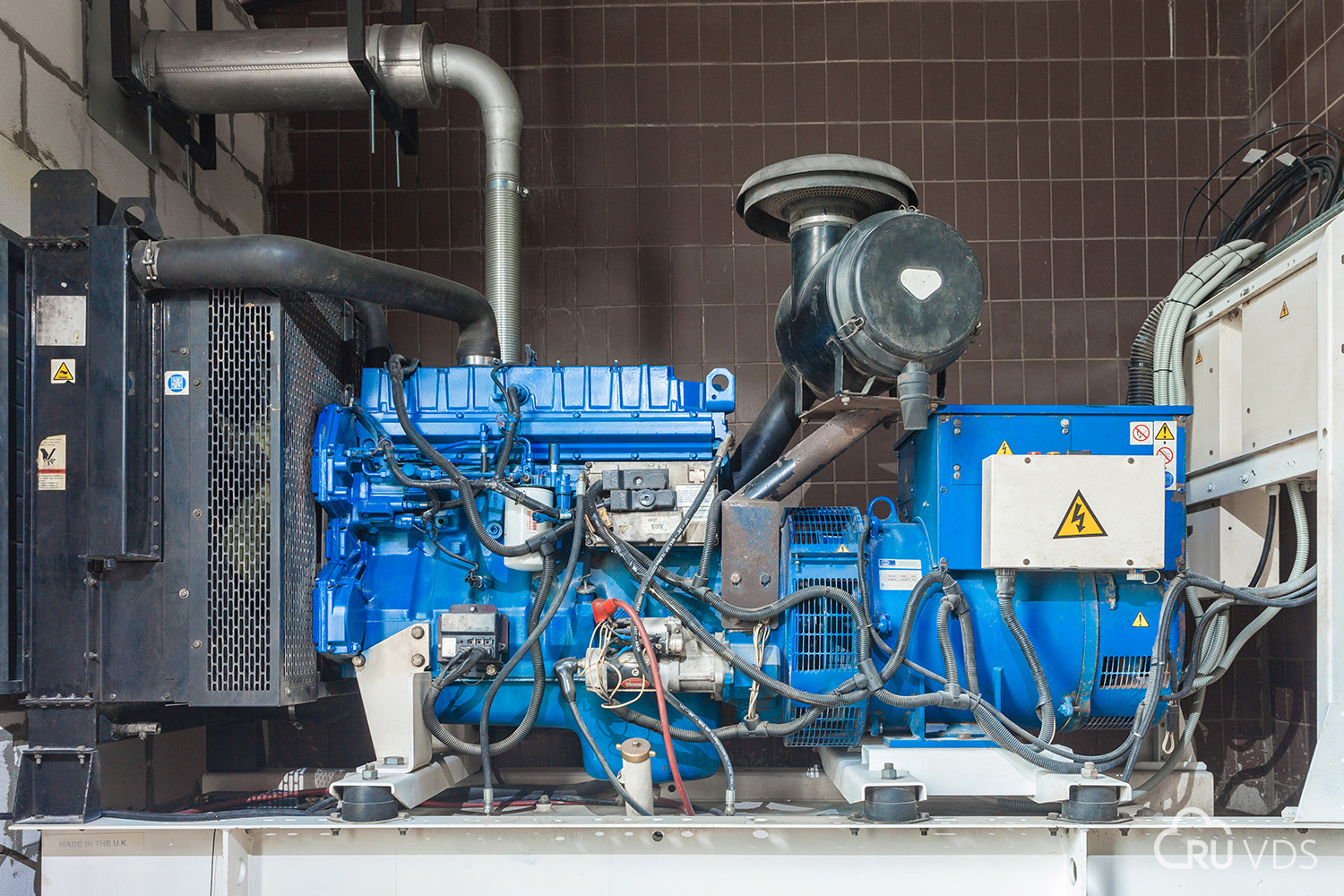

Высокий уровень отказоустойчивости ЦОД обеспечивается тремя независимыми каналами подключения к магистральным узлам связи ММТС-9 и ММТС-10, что позволяет гарантировать высоконадежный скоростной доступ в интернет со средним пингом по Москве до 3 мс и пропускной способностью до 30 Гбит/с, системой защиты от DDoS на базе решения Cisco Guard, резервируемыми системами охлаждения, двумя независимыми линиями электропитания по 0,5 МВт, что соответствует энергообеспечению 1 категории и позволяет осуществлять переключение между вводами менее чем за одну секунду, системой бесперебойного питания на базе решения APC, а также двумя резервными дизель-генераторами и системами автоматического запуска, способными обеспечить автономную работу ЦОД в течении 24 часов.

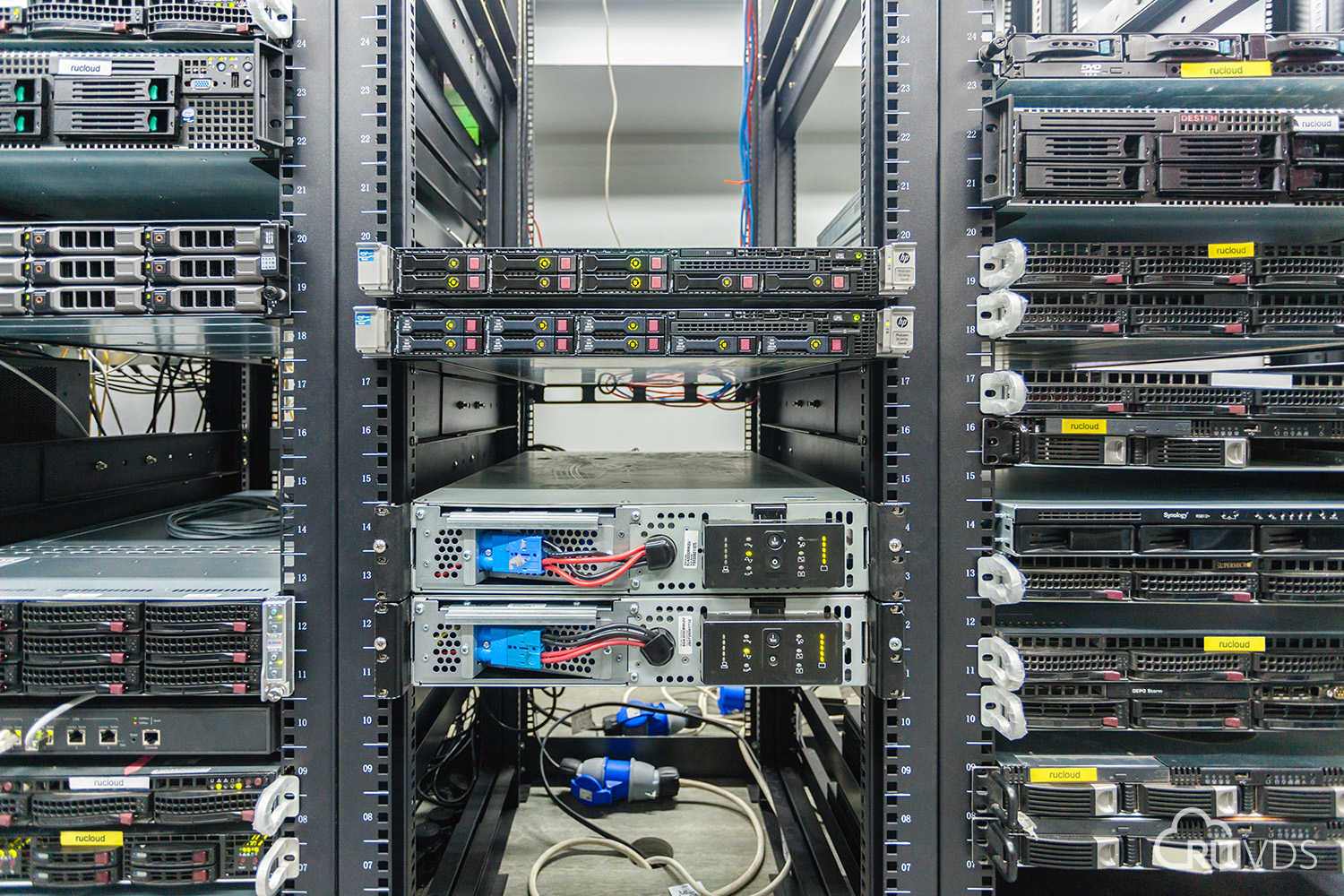

RUVDS известна первоклассным техническим оборудованием ЦОД — именно оно позволяет предоставлять клиентам быстрые и надежные виртуальные машины для размещения VDS/VPS-серверов. В работе своих серверов RUVDS использует SSD-накопители корпоративного класса, а для достижения максимальной скорости передачи данных они объединяются в RAID-массивы. Таким образом, клиенты RUVDS могут рассчитывать на скорость до 100 тысяч IOPS, а старт VDS Windows происходит за несколько секунд.

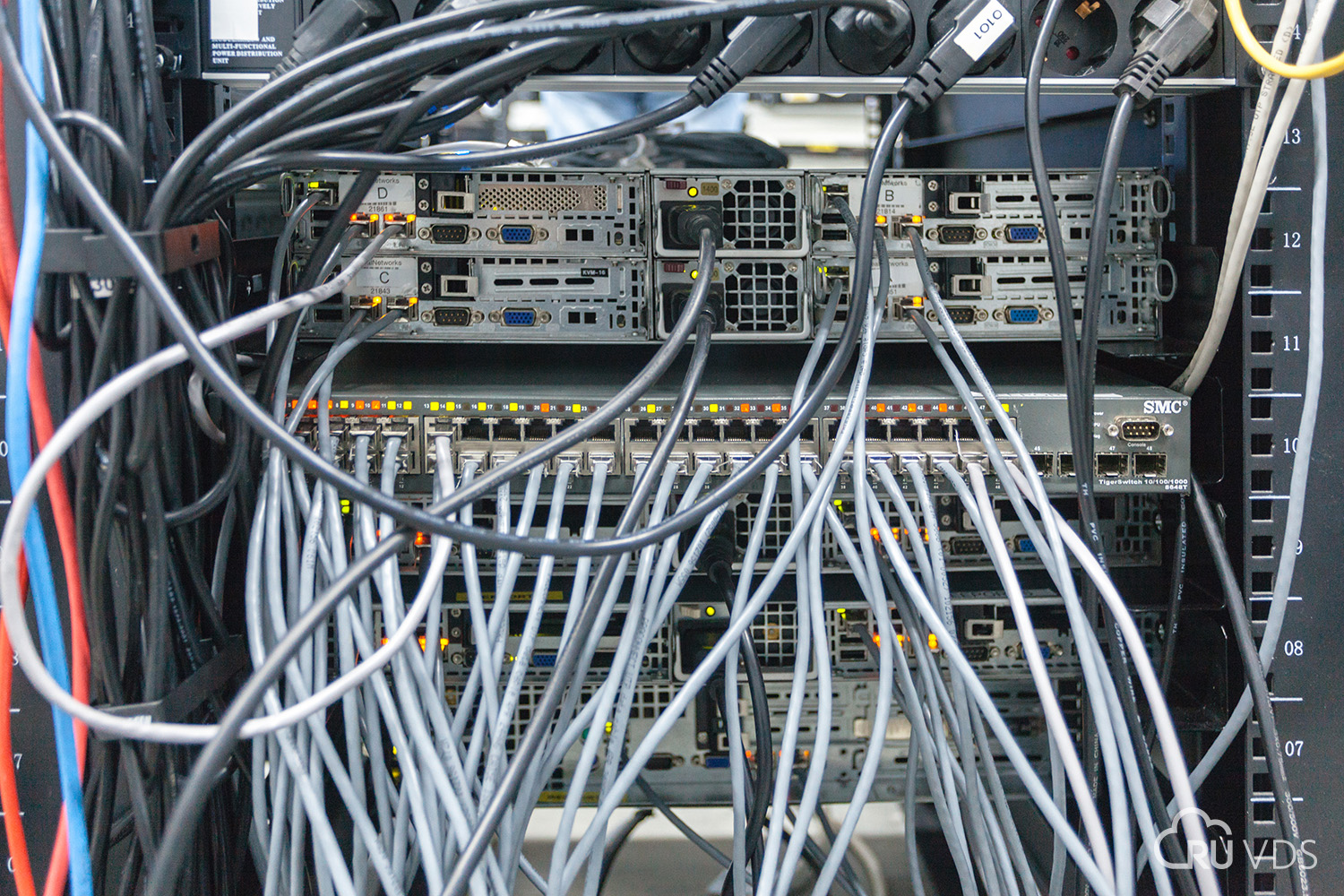

Сетевая инфраструктура ЦОД в соответствии с классической архитектурой имеет три уровня (ядро, агрегирование и доступ). Уровень доступа реализуется путем установки коммутатора в каждую стойку (Top of the Rack, ToR) или одного коммутатора на несколько стоек (Middle of the Row, MoR). Коммутаторы уровня агрегирования и ядра зарезервированы. Используется в основном сетевое оборудование Cisco.

На базе продукта этого производителя (Cisco Guard) реализована и система защиты от атак DDoS. Она имеет пропускную способность более 1 млн пакетов в секунду с возможностью оперативного наращивания мощности.

Волоконно-оптические линии связи разные маршруты прокладки до основных точек обмена трафиком.

В ЦОД организована система резервирования N+1. В дата-центр заведено три физических линии связи с пропускной способностью в 10 Гбит/с каждая с выходом на магистральные узлы связи М-9, М-10. На эти физические каналы заведено более 15 интернет-провайдеров. Это позволяет гарантировать клиентам высокую скорость VDS: не ниже 250 Мбит/сек.

Новейшее оборудование от лидеров в своих областях — Intel, Cisco, Supermicro — позволяет хостингу называться надёжным и отказоустойчивым.

С марта 2016 года RUVDS стала партнером Huawei, что позволило ей выйти на новый уровень работы. В дата-центре RUVDS приступили к развертыванию новейших платформ виртуализации китайского вендора.

Решения компании Huawei используются операторами связи и крупными корпорациями по всему миру уже более двух десятков лет. Сотрудничество с российским хостинг-провайдером отвечает стратегии Huawei — выходу на широкий российский рынок.

Каждая стойка содержит до 42 серверов, а каждый сервер с оперативной памятью до 400 Гбайт и подсистемой хранения данных емкостью до 7 Тбайт обслуживает до 100 клиентов.

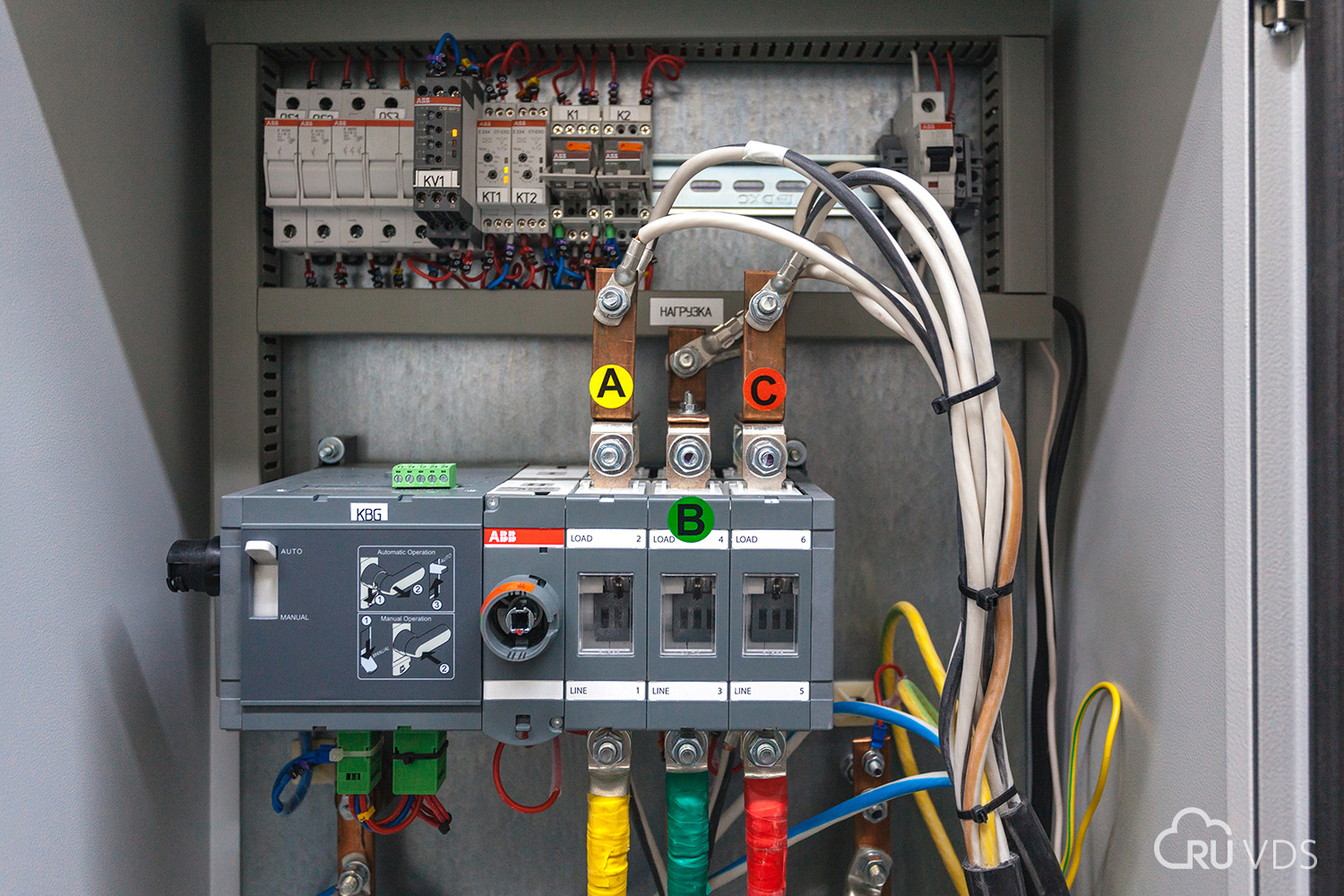

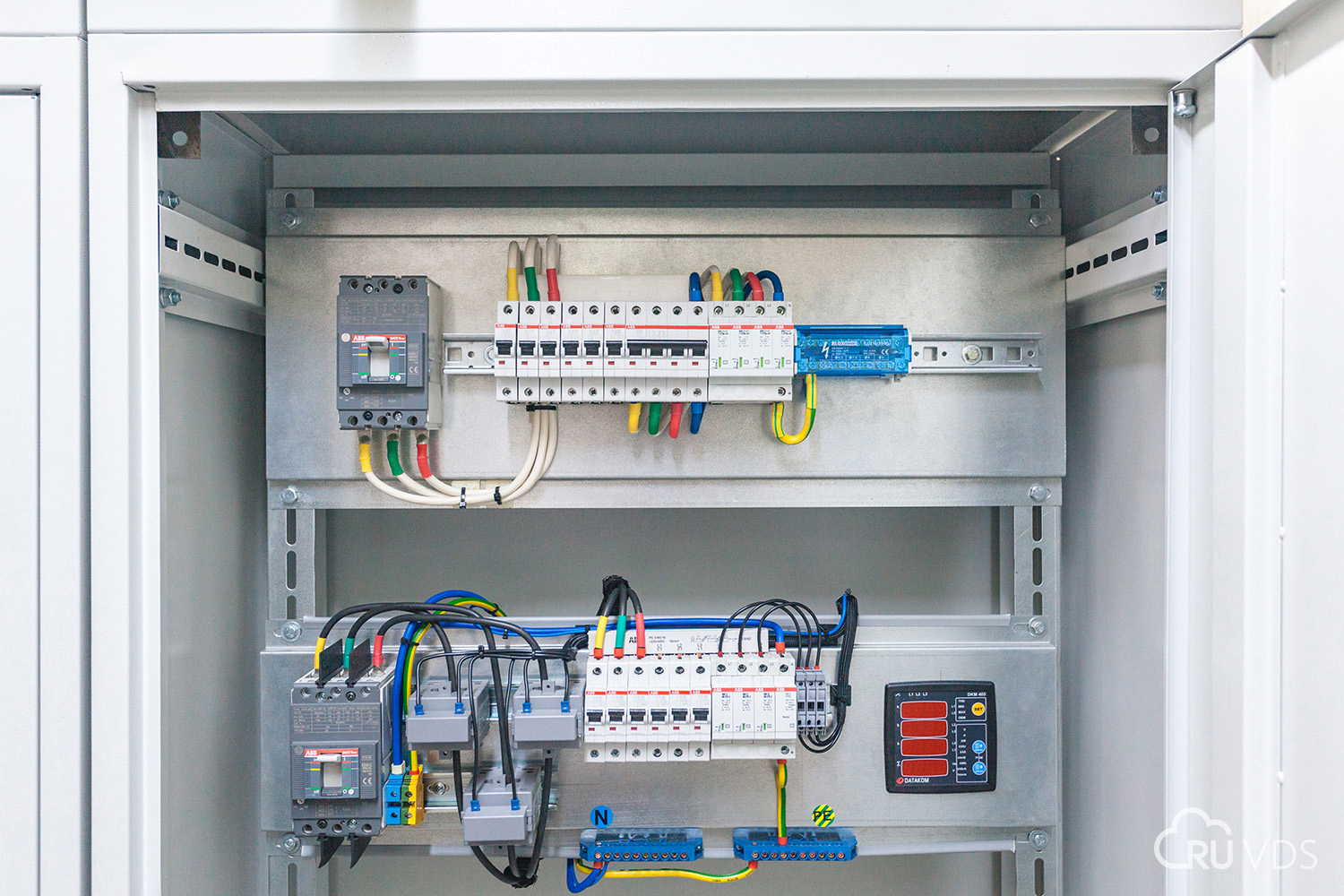

Система бесперебойного гарантированного электропитания построена по классической схеме. Энергоснабжение ЦОД обеспечивают две подстанции, которые питают дата-центр по двум независимым линиям. На объекте установлен комплекс ИБП и ДГУ (схема резервирования — N+1).

Каждый физический сервер подключен к источнику бесперебойного питания. Если эти составляющие вдруг не справятся, то в работу включатся дизель-генераторы, которые обеспечат дата-центр электричеством до решения проблем с подстанцией.

Автомат ввода резерва обеспечивает резервирование, переключение между подстанциями, дизель-генератором. Он оперативно переводит нагрузку на дизель-генератор после отключения внешнего (городского) напряжения.

Дизель-генераторная установка и топливное хранилище для ДГУ способны обеспечить автономную работу ЦОД без дополнительной дозаправки в течение суток, а имеющийся договор на оперативную поставку топлива дает возможность еще более увеличить этот срок.

Распределение электропитания организовано по схеме 2N. К каждому шкафу с оборудованием подходят две магистрали — соответственно, серверы с двумя блоками питания могут быть подключены сразу к обеим. Созданная инфраструктура электроснабжения позволяет выделить до 30 кВт на стойку.

Каждая гермозона оборудована газовой системой пожаротушения, которая обеспечит бесперебойную работу серверов даже в случае пожара. Площадь одной гермозоны — около 25 кв.м. Система пожаротушения работает на основе газового огнетушащего вещества (хладона) и интегрирована с системой пожарной сигнализации (датчики раннего реагирования и температурные датчики). Для защиты оборудования от воздействий внешней среды и проникновения пыли используется система приточно-вытяжной вентиляции, которая фильтрует подаваемый в гермозону воздух и поддерживает в помещении избыточное давление.

Гермозона представляет собой изолированное помещение, в котором установлена двухконтурная система охлаждения, выделенная система газопожаротушения. В гермозоне установлено два ряда по 10 открытых стоек.

Организация независимых гермозон позволила существенно снизить расходы на систему газового пожаротушения с сохранением высокого уровня надежности. На тушение помещения достаточно одного баллона.

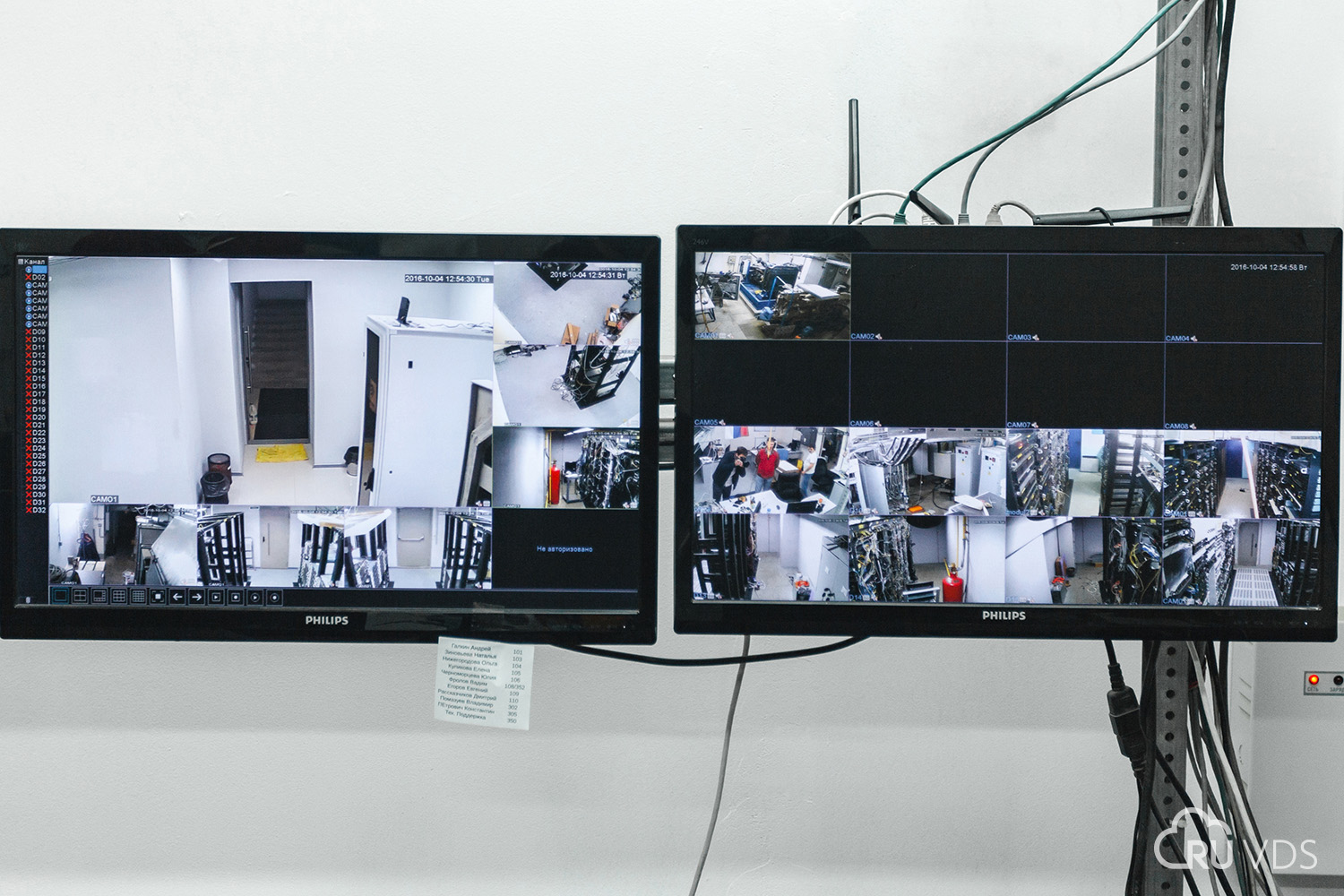

Каждая гермозона оборудована системой видеоконтроля, физическим ограничением доступа. В среднем в гермозоне находится порядк 20 стоек по 42 сервера в каждой.

Ввод питания в гермозону.

Все гермозоны и служебные помещения находятся под видеонаблюдением. Система видеонаблюдения установлена также по всем периметрам доступа.

Всего таких периметров четыре. Первый — закрытая, круглосуточно охраняемая ФГУП МВД России и контролируемая по доступу территория, на которой находится ЦОД. Второй — контролируемая ЧОП территория самого ЦОД. Третий — в ЦОД. Четвертый — контролируемый вход в каждую гермозону по магнитной карте.

Тремя независимыми системами охлаждения (водяное, воздушное и притяжно-вентиляционное с системой воздухоотчистки) и системой обеспечения влажности гермозон на уровне 40-50%.

Часть воздуховода и воздушного насоса.

В рамках сотрудничества с Huawei запланирован переход к новой системе охлаждения — жидкостной взамен традиционной воздушной. Пока что эта технология является довольно новой, по крайней мере для России. Но несмотря на то, что ее внедрение потребует определенного переоборудования, именно жидкостное охлаждение позволит максимально оптимизировать работу ЦОД и практически исключить возникновение проблем, связанных с перегревом серверов.

ЦОД растет, недавно была введена в эксплуатацию новая гермозона. На фото первая стойка в новом модуле.

В дата-центре RUVDS также организована система защиты от затоплений и наводнений — периметры ЦОД усиленно гидроизолированы, а в самом дата-центре установлена система гидронасосов с резервированием N+1 с датчиками затопления, плюс установлены двойные крыши со специальной системой стоков.

В ЦОД находится круглосуточная работа дежурных-специалистов технической поддержки. Техподдержка работает 24 часа в сутки, семь дней в неделю. Мониторинг серверов и инфраструктуры осуществляется в ручном и автоматическом режиме под контролем сотрудников. Регулярно проводится тестирование системы энергообеспечения.

ЦОД RUVDS пользуется популярностью среди крупных корпораций — в частности, таких, как «Компания БКС» и АО «ФИНАМ» и еще целого ряда коммерческих структур. Виртуальные серверы от RUVDS использует и «Коворкинг 14» — недавно запущенный социально-ориентированный проект. Высокотехнологичное оборудование хостинг-провайдера позволяет оказывать разнообразные услуги.

Комментарии (35)

RazorBlade

19.10.2016 15:24+13А сервера между юнитами маркетологи ставили? Особо порадовала фото с паутиной проводов. Перед тем как публиковать статью, могли бы показать ее своим технарям.

a_shats

19.10.2016 16:02+5Фото в статье — из серии «ад сисадмина», «я его слепила из того, что было» и пр.

За такое в тех самых компаниях, которые вроде как желают «улететь в облака», админов бьют канделябром, фигурально выражаясь.

Нет, я прекрасно понимаю, что если уложить кабели в стойке правильно — менять патч-корды быстро станет трудно. Видел уже подобное.

По жуткому серверному зоопарку — я правильно понимаю, что это сервера не ваши, а сторонних организаций?

Собственно, по применимости бомбоубежища под ЦОД — там самое главное «против» — это высота дверных проемов: стойку в сборе туда — выглядит, по крайней мере, может быть на фото размеры искажены — не затащить.

В разборе-да, но мне кажется, что такое отношение к кабельной прокладке может не понравиться хозяевам этой стойки.

ruvds_official2

19.10.2016 16:07Уважаемый, a_shats. Вы действительно правы, когда говорите, что красиво уложенные кабели потом трудны в обслуживании.

Насчет «зоопарка» — наша компания не только предоставляет в аренду виртуальные сервера, мы также сдаем выделенные физические сервера, и предоставляем место для эксплуатации (суть место в стойке), поэтому, конечно, на фото есть сервера сторонних организаций.

По поводу высоты дверных проемов не очень понятно. Мы были во многих дата-центрах и нигде не видели дверей, куда в рост пройдет стойка на 42 юнита. Тем более не видели людей, которые подобную стойку переносили) Все таки перенос сервера при необходимости делается по-другому, с переключением на резервный источник питания и связи, по одному юниту и аккуратно в заранее подготовленную новую стойку. Переносить стойку целиком нецелесообразно и опасно.

a_shats

19.10.2016 16:45+1По кабелям: если какой-нито совет вдруг нужен — используйте для укладки патч-кордов

— кольца большого диаметра, относительно редко расположенные по высоте стойки

— патч-корды где-то до 60 шт. на стойку не жгутовать, больше — таки придется стягивать — но тогда надо прокладывать патч-корды «с запасом» процентов эдак в 50 и маркировать не только по концам, но и где-то посредине кабеля

— разумеется, питание и слаботочка — в разных рядах органайзеров

— коммутацию выносить в отдельные стойки

По поводу зоопарка — не думали унифицировать вот это вот всё, если большая часть всё-таки ваша? Этим же управлять в эксплуатации просто ужасно: у всех серверов свои интерфейсы управления (где-то IPMI/iDRAC/iLO/IMM и прочее, где-то нет и обходятся просто iKVM), все имеют свой набор spares и так далее.

По поводу дверей, куда пройдет в рост стойка: во-первых, брэнды первого уровня, эксплуатируемые у крупных заказчиков, имеют такой сервис — поставку стойкой в сборе и уже каблированной, во-вторых — есть чертовски большие и тяжелые штуки (всякие большие Power'ы, хай-энд СХД и прочие кошерные вещи), которые поставляются именно и только так. И которые в итоге у вас в ЦОДе разместить, скорее всего, не удастся.

chupasaurus

19.10.2016 18:57Подписываюсь под последним абзацем, наблюдал за увлекательным 4-часовым квестом «как 4 мастера спорта+ по пауерлифтингу поднимают на второй этаж Hi-End СХД по лестнице с проемом высотой 185 см и м/э площадкой 200х80». По завершению основной части было немного плачевно наблюдать, как шкаф поехал в машинный зал на встроенных в него колёсах.

4ebriking

19.10.2016 19:36И ни разу не наклонили? круто же. Но скорее всего таки отказ от гарантии в итоге.

chupasaurus

19.10.2016 20:06Все 6 степеней свободы были задействованы. Но не кантовали, всё делали плавно и аккуратно (на лестнице всё в кафеле, сломали 2 небольшие плитки.

ArkturTierry

19.10.2016 16:03+2Извините за оффтоп, но «Помещение дата-центра находится на территории стратегического предприятия — АО «Композит», в бомбоубежище»… Разве запрет на нецелевую эксплуатацию бомбоубежищ уже отменили?

ruvds_official2

19.10.2016 16:10+1Это бывшее бомбоубежище. Ранее, как известно, завод был более масштабным, работников было больше. Сейчас все изменилось и у завода есть возможность и право сдавать в аренду неиспользуемые помещения.

4ebriking

19.10.2016 19:39+1Сдавать в аренду… И за сколько времени вы готовы вернуть помещение к первоначальной функции в случае расторжения договора или изменения законодательства?

Что-т мне кажется вы неоправданно рискнули.

foxmuldercp

19.10.2016 21:33В Киеве есть датацентр "Бункер". на хабре помнится тоже статья с фоточками. я там лично был, и жене в камеру махал по интернету :)

wasya

20.10.2016 11:00Плюс секретность — Пионерская, дом 4 — это около сотни корпусов, и расположен на площади примерно 1кв км.

stifff

20.10.2016 23:49Вот очень интересно, кстати.

Является ли объект объектом ГО?

Если да, то каким образом его можно будет освободить за шесть часов по требованию?

serafims

19.10.2016 16:57Как-то фото с вводом питания в гермозону странно смотрится.

Думаю, если вы опишете, какие нестандартные решения были применены, будет интереснее.

Resert

19.10.2016 17:46Спасибо за статью, наглядно показано что в облаках не всегда стойки и сервера вылизаны как на маркетинговых фото. Все так-же паутина из патчкордов, старое оборудование с гламурными стикерами на скотче. В общем хороший аргумент для руководства когда дело дойдет до выбора причесать свое хозяйство или пустить все в облака.

a_shats

19.10.2016 18:01+1>наглядно показано что в облаках не всегда стойки и сервера вылизаны как на маркетинговых фото.

Такие вещи и монтируются, и обслуживаются по принципу «чем быстрее и дешевле — тем лучше».

За всех, разумеется, сказать не могу — но многие хостеры и прочие владельцы ЦОДов с кучей серверов поступают схожим образом.

Resert

19.10.2016 18:18Смотрю на фото «Ввод питания в гермозону.» и задаюсь маленьким вопросом.

Среднее энергопотребление на стойку сейчас составляет примерно 15 кВт/час.

В среднем в гермозоне находится порядка 20 стоек по 42 сервера в каждой.

Простой расчет 15 кВт/час * 20 стоек = 300 кВт/час в одной гермозоне, при такой нагрузке сечение входного кабеля должно быть сантиметра 3?

ru_vds

19.10.2016 18:33+1Да, все верно. Если вопрос касается фото "Ввод питания в гермозону", то это только один из щитков, идущих в гермозону, их там несколько.

avost

19.10.2016 18:45+3Ну, во-первых, нет такой еденицы измерения кВт/ч. Даже кВт ? ч тут излишне, проще писать мощность в киловаттах. Получается это… 1300А, поделим на три фазы, лезем в таблицу — по 150 квадратов на жилу. 14мм диаметр жилы. Как-то так у меня получилось. Три квадратных сантиметра — это 90000 кв мм ;) и почти 4см диаметра 8-) немного лишку хватили.

novice2001

19.10.2016 22:35Про едИницу измерения мощности поддержу. В кВт ее писать не просто проще, а единственно правильно.

Labunsky

20.10.2016 00:15Еще бы эта вся красота работала получше, а то пока что ваши VPS самые медленные среди всех, что видел

ru_vds

20.10.2016 09:58-2По поводу скорости работы вашего сервера обратитесь в службу поддержки на почту support@ruvds.com, с указанием логина вашего сервера. Также, мы снизили цены на SSD диски, и появился новый тариф на SSD (CPU 1x2ГГц, RAM 512Mb, SSD 10 Gb) — за 95 рублей в месяц, без каких либо ограничений, подробнее здесь.

Wesha

20.10.2016 01:24Иными словами, Скайнету ничего не грозит: все его сервера уже давно сидят по бомбоубежищам.

rtzra

20.10.2016 08:52Подскажите про наклейки с надписями на сервера — что вы используете?

darthslider

20.10.2016 11:31Полагаю какой-то из этикеточных принтеров Dymo.

Очень удобно но лента не дешевая конечна, да и расходуют они ее не слишком экономно.

2PAE

20.10.2016 13:36Первая мысль при взгляде на анонс была: «О! Кто-то приспособил сервера с Халфой под мирные цели! Интересно, интересно! » причём именно сами уровни. Виртуальность в массы. :)

Wesha

21.10.2016 03:17Слышал байку, что кто-то где-то замутил план-схему компьютеров в здании в виде уровня халфы. При этом, чтобы рестартовать какую-нибудь железку, можно было в этом уровне добежать до соответствующей комнаты и садануть в неё из ракетницы.

DenimTornado

Идеальная КДПВ! Извините за оффтоп)

habriella

Сколько

уроков информатикитёплых воспоминаний в этом скриншоте :)