«С высокоскоростными компьютерами одним воздухом не обойтись»

В кинофильме «Железный человек 2» есть момент, когда Тони Старк смотрит старый фильм своего почившего отца, где тот говорит: «Я ограничен технологиями своего времени, но однажды ты сможешь разобраться в этом. И тогда ты изменишь мир». Это фантастика, но идея, которую она выражает, вполне реальна. Идеи инженеров часто сильно опережают их время. В «Звёздном пути» гаджеты были всегда, но остальному миру пришлось работать несколько десятилетий над тем, чтобы создать планшеты и электронные книги.

Концепция жидкостного охлаждения прекрасно вписывается в эту категорию. Сама идея существует с 1960-х, но она оставалась радикальной по сравнению с куда как более дешёвым и безопасным вариантом воздушного охлаждения. Потребовалось более 40 лет, пока жидкостное охлаждение не начало понемногу развиваться в 2000-х, да и тогда оно было в основном прерогативой любителей ПК, стремившихся разогнать свои CPU далеко за пределы рекомендованных Intel и AMD ограничений.

Сегодня системы жидкостного охлаждения набирают популярность. Такую систему для ПК можно купить меньше, чем за $100, а кустарное производство, нацеленное на промышленное применение и дата-центры (типа CoolIT, Asetek, Green Revolution Computing, Ebullient) предлагает жидкостное охлаждение (ЖО) для серверных. ЖО в основном используют в суперкомпьютерах, высокоскоростных вычислениях или других ситуациях, где требуется огромное количество компьютерной мощности, а процессоры работают почти со 100% загрузкой, но подобные варианты становятся всё более распространёнными.

Существует два популярных типа ЖО: прямое охлаждение чипов и погружное. При прямом охлаждении радиатор крепится к CPU, как у стандартного кулера, но вместо него к нему подсоединяются две трубки. По одной подходит холодная вода, охлаждающая радиатор, поглощающий тепло CPU, а по другой уходит горячая. Затем она охлаждается и возвращается к CPU по закрытому контуру, напоминающему кровоток.

При погружном охлаждении оборудование заливается жидкостью, которая, очевидно, не должна проводить электричество. Этот подход больше всего похож на бассейны охлаждения ядерных реакторов. Погружное охлаждение остаётся более продвинутым вариантом, и требует более дорогих теплоносителей, нежели прямое подключение, где можно использовать обычную воду. Кроме того, всегда существует риск утечки. Поэтому пока что наиболее популярным остаётся вариант прямого подключения.

В качестве одного из основных примеров возьмём компанию Alphabet. Когда эта родительская для Google компания в мае 2018 представила процессоры для ИИ TensorFlow 3.0, директор Сундар Пичаи сказал, что эти чипы настолько мощные, что «впервые нам пришлось установить в дата-центрах жидкостное охлаждение». Эту цену пришлось заплатить Alphabet за восьмикратное увеличение производительности.

С другой стороны Skybox Datacenters недавно объявила о планах создания огромного суперкомпьютера на 40 000 серверов от DownUnder GeoSolutions (DUG), предназначенного для разведки месторождений нефти и газа. Этот проект будет выдавать 250 петафлопс вычислительной мощности, больше любого из существующих – и ожидается, что серверы будут охлаждаться при помощи жидкости, будучи погружёнными в цистерны, заполненные диэлектрической жидкостью.

В любом случае, «жидкостное охлаждение – это охлаждение будущего, и всегда им будет», — сказал Крэйг Пеннингтон, вице-президент проектного отдела в операторе дата-центров Equinix. «Кажется очевидным, что это правильный подход, но никто его не применял».

Как же ЖО превратилось из эзотерического искусства на рубеже вычислений в практически общепринятый метод в современных дата-центрах? Как и все технологии, это произошло частью в результате эволюции, проб и ошибок, и большого количества инженерных решений. Однако за ЖО сегодняшние дата-центры должны благодарить ранних оверклокеров, являющихся невоспетыми героями этого метода.

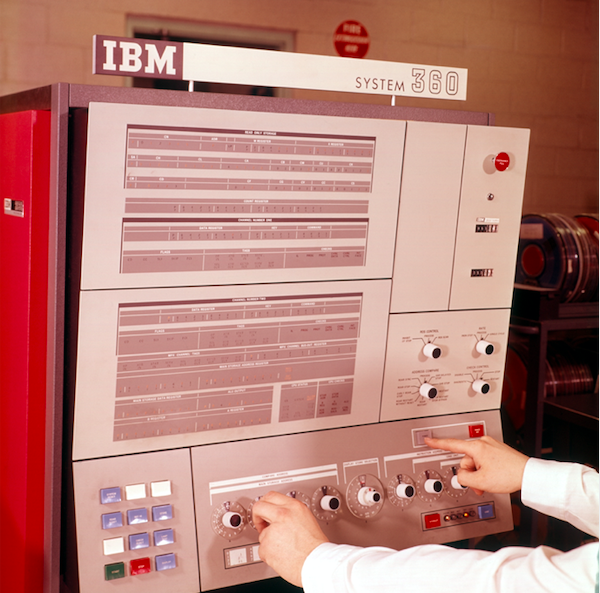

Панель управления системы IBM System 360 обработки данных

Что мы имеем в виду под жидкостным охлаждением

Жидкостное охлаждение стало популярной идеей в 1964, когда IBM изучала вопрос погружного охлаждения для мейнфрейма System 360. Это был один из первых мейнфреймов компании; серии 700 и 7000 существовали более десяти лет, а System/360 «начала эру компьютерной совместимости – впервые позволив разным машинам из продуктовой линейки работать совместно», как пишут в IBM. Концепция была простой: охлаждённая вода должна была протекать через устройство, охлаждающее её до температуры меньше комнатной, а потом воду подавали бы прямо в систему. Схема, использованная IBM, сейчас известна, как заднее охлаждение, когда радиатор крепится сзади мейнфрейма. Устройство засасывало горячий воздух из мейнфрейма вентиляторами, а потом этот воздух охлаждался водой, примерно как радиатор охлаждает двигатель автомобиля.

С тех пор инженеры усовершенствовали эту базовую концепцию, и появилось две доминирующих формы ЖО: погружение и прямой контакт. Погружение – это оно и есть; электроника находится в жидкой ванне, которая, по очевидным причинам, не может быть водной. Жидкость не должна проводить электричество, то есть, быть диэлектриком (такие компании, как 3М даже специально разрабатывают жидкости для этого).

Но у погружения есть много проблем и недостатков. К находящемуся в жидкости серверу можно подобраться только сверху. Поэтому там должны быть расположены внешние порты. Серверное размещение корпусов 1U в стойке был бы непрактичным, поэтому сервера не получится размещать последовательно. Диэлектрик, а обычно это минеральное мало, очень дорогой, и его сложно очищать в случае утечки. Понадобятся особые жёсткие диски, а переделка дата-центра потребует значительных вложений. Поэтому, как в случае с упомянутым выше суперкомпьютером, погружение лучше всего осуществлять в новом дата-центре, а не переделывать старый.

ЖО прямого контакта, напротив, заключается в том, что радиатор (или теплообменник) находится на чипе, как обычный радиатор. Вместо вентилятора в нём используются две водяные трубы – одна приносящая холодную воду для охлаждения, а вторая уносящая горячую воду, нагретую контактом с радиатором. Подобная форма ЖО стала наиболее популярной, её переняли у таких производителей, как HP Enterprise, Dell EMC и IBM, а также у производителей корпусов Chatsworth Systems и Schneider Electric.

Прямое охлаждение использует воду, однако оно очень чувствительно к её качеству. Нефильтрованную воду из-под крана использовать нельзя. Только посмотрите на свой кран или душевую лейку. Никому не нужно накопление кальция в серверах. По меньшей мере для прямого охлаждения требуется чистая дистиллированная вода, а иногда её смесь с антифризом. Изготовление такого теплоносителя – само по себе наука.

Intel’овский связной

Как мы перешли от радиаторов IBM к современным экастравагантным системам охлаждения? Опять-таки, благодаря оверклокерам. На рубеже веков жидкостное охлаждение начало набирать популярность у оверклокеров ПК и любителей, собиравших свои компьютеры, которые хотели повышать скорость их работы за пределы официальных ограничений. Однако это было эзотерическое искусство без стандартных проектов. Каждый делал что-то своё. Собиравшему всё это человеку нужно было быть таким макгайвером, что сборка изделий IKEA казалась полной ерундой. Большая часть систем охлаждения даже не влезала в корпуса.

В начале 2004 года ситуация благодаря внутренним изменениям в политике Intel начала меняться. Инженер из дизайн-центра в Хилсборо, штат Орегон – где проектируется большинство чипов компании, несмотря на то, что её штаб-квартира находится в Санта-Кларе, Калифорния – уже несколько лет работал над особым проектом по охлаждению. Проект обошёлся компании в $1 млн, и был нацелен на создание жидкостного кулера для процессоров от Intel. К сожалению, Intel собиралась его закрыть.

Инженер надеялся на иной исход. Чтобы спасти проект, он пришёл с этой идеей в Falcon Northwest, компанию из Портленда, выпускавшую геймерские надстройки для компьютеров. «Причина состояла в том, что в компании думали, что жидкостное охлаждение подстрекает людей на оверклокинг, а это занятие в то время было под запретом», — сказал Келт Ривз, президент Falcon Northwest. И в такой позиции Intel была своя логика. В то время беспринципные розничные продавцы из Азии продавали разогнанные ПК под видом более мощных, и с плохим охлаждением, и в глазах общественности это каким-то образом превратилось в проблему Intel. Поэтому компания выступала против разгона.

Однако этот инженер из Орегона считал, что если он сумеет найти клиентов и рынок для такого кулера, то Intel в результате уступит. (Кроме того, получившийся у Intel продукт был куда как лучше по качеству, чем то, что имелось на рынке, сказал нам Ривз). Поэтому после определённых внутренних уговоров и переговоров между компаниями, Intel позволила Falcon продавать системы охлаждения – в частности потому, что Intel уже производила их тысячами. Единственным подвохом было то, что Falcon не могла упоминать о том, что в деле участвует Intel. Falcon согласилась, и вскоре стала первым производителем, поставлявшим полностью герметичные системы ЖО в стиле «всё в одном» для ПК.

Ривз отметил, что это передовое решение для ЖО было не особенно дружелюбным для пользователя. Falcon пришлось изменить корпуса, чтобы туда вмещался радиатор, и изобрести пластину охлаждения для воды. Но со временем производители кулеров, например, ThermalTake и Corsair, изучили то, что делала Intel, и занялись последовательными улучшениями. С тех пор появились несколько продуктов и производителей, к примеру, CoolIT и Asetek, специально делавших ЖО для дата-центров. Часть их продуктов – к примеру, трубы, которые не ломаются, не трескаются и не протекают с гарантией до семи лет – в итоге были предоставлены по лицензии производителям систем охлаждения для конечного пользователя, и такой обмен технологиями в обе стороны стал нормой.

И по мере роста этого рынка в разных направлениях даже Intel в итоге поменяла своё мнение. Теперь она рекламирует возможности разгона процессоров серий K и X, и даже не заботится о том, чтобы продавать вместе с топовым CPU для игроманов штатные кулеры.

«ЖО уже опробованная технология – ею занимаются все на стороне потребителя, — сказал Ривз. Intel перестала поставлять штатные кулеры с самыми мощными CPU, потому что им нужно ЖО; это уже доказано и благословление от Intel получено. Не думаю, что найдётся кто-то, кто скажет, что полные решения для этого недостаточно надёжны».

Погружное охлаждение в дата-центре. Короба заполнены диэлектрической жидкостью, которая поступает по трубам

Жидкостное охлаждение от Skybox Datacenters с погружением. Теплообменники погружаются вместе с компьютерным оборудованием, и диэлектрическая жидкость не покидает цистерну. Водяной контур проходит через комнаты и подходит к каждому теплообменнику.

Факты в пользу практичности жидкостного охлаждения

Долгое время в традиционных дата-центрах предусматривали фальшпол с небольшими отверстиями, через которые поднимался холодный воздух, засасываемый серверами. Это называлось CRAC, или кондиционер компьютерной комнаты. Проблема в том, что сейчас уже недостаточно продувать холодный воздух через отверстия в полу.

Основная причина недавнего бума в области жидкостного охлаждения – это необходимость. Сегодняшние процессоры слишком сильно греются, а сервера расположены слишком близко, чтобы воздух мог эффективно их охлаждать, как отмечают даже в Google. Теплоёмкость у воды в 3300 раз больше, чем у воздуха, и водяная система охлаждения способна прокачивать 300 л воды в минуту, по сравнению с 20 кубометрами воздуха в минуту.

Проще говоря, вода может охлаждать гораздо эффективнее и в гораздо меньшем пространстве. Поэтому после многих лет попыток уменьшить энергопотребление, производители процессоров могут разбрасываться мощностью и выкручивать напряжение для максимальной производительности – зная, что жидкостное охлаждение справится с этим.

«Нас просят охлаждать чипы, энергопотребление которых скоро выйдет за пределы 500 Вт, — сказал Джеф Лайон, директор CoolIT. – Некоторые процессоры, ещё не вышедшие на рынок, будут потреблять по 300 Вт. Всё это развивается по запросу ИИ и машинного обучения. Скорости роста уровня охлаждения просто не хватает».

Лайон сказал, что CoolIT рассматривает возможность расширить систему охлаждения до чипсетов, систем регулирования мощности, сетевых чипов и памяти. «Не будет ничего радикального в том, чтобы заняться ещё и памятью, — добавил он. – Есть варианты RAM с продвинутой упаковкой, потребляющие по 18 Вт на DIMM. Типичный DIMM потребляет 4-6 Вт. Среди систем с большим объёмом памяти мы встречаем сервера, где установлено 16, а то и 24 DIMM – а это очень много тепла».

Один за другим производители сталкиваются с такими запросами. Equinix наблюдает, как средняя плотность растёт от 5 кВт до 7-8 кВт, а теперь и до 15-16 кВт, причём некоторое оборудование демонстрирует плотность уже в 40 кВт. «Так что общий объём воздуха, который надо прокачать, становится слишком большим. Это не случится мгновенно, но в следующие пару лет произойдёт фундаментальное принятие жидкостного охлаждения», — сказал Пеннингтон из Equinix.

Немного о погружном охлаждении

Компания Green Revolution Cooling концентрируется на погружном охлаждении, и её директор Питер Поулин говорит, что с точки зрения энергоэффективности погружное охлаждение лучше прямого по двум причинам. Во-первых, со всех серверов удаляются вентиляторы. Только это в среднем уменьшает энергопотребление на 15%. А один клиент компании уменьшил его на 30%.

Есть ещё одно непрямое преимущество устранения вентиляторов: тишина. Несмотря на то, что в серверах часто используются очень маленькие вентиляторы, в серверных ужасно шумно, и находиться в дата-центре неприятно как из-за жары, так и из-за шума. Жидкостное охлаждение делает эти места куда как более приятными для работы.

Ещё одно преимущество – для поддержки системы погружного охлаждения требуется очень мало энергии. Там всего три движущихся части: помпа для циркуляции охладителя, помпа для перемещения его к башне охлаждения, и вентилятор башни охлаждения. После замены жидкостным охлаждением воздушного потребление электричества может упасть до 5% от того, что тратилось на кондиционирование воздуха. «Вы получаете огромное снижение потребления энергии, что позволяет вам делать много всего другого, — сказал Поулнин. – В зависимости от потребителя, дата-центр может быть более энергоэффективным или же уменьшить выбросы углерода, которые ассоциируются со строительством дата-центров».

Факты в пользу энергоэффективности жидкостного охлаждения

Потребление энергии уже довольно давно заботит индустрию дата-центров (Агентство по охране окружающей среды США отслеживает этот показатель не менее десяти лет). Сегодняшние дата-центры – это огромные предприятия, потребляющие, по оценкам, 2% от всей мировой электроэнергии, и выбрасывающие в атмосферу столько CO2, сколько и индустрия авиаперевозок. Поэтому интерес к этому вопросу не угасает. К счастью, жидкостное охлаждение позволяет уменьшать счета за электричество.

Первая экономия происходит из-за отключения кондиционирования воздуха в дата-центре. Второе – устранение вентиляторов. В каждой серверной стойке есть множество вентиляторов, нагнетающих воздух, однако их количество можно уменьшить до небольшого числа или до нуля, в зависимости от плотности.

А с технологией «сухого охлаждения», в которой отсутствует замораживание, можно достичь ещё большей экономии. Изначально охлаждение с прямым подключением прогоняло воду через холодильник, охлаждавший её до 15-25 градусов Цельсия. Но в итоге оказалось, что жидкостные охладители, пропускавшие воду через длинную последовательность труб и вентиляторов, охлаждают трубы, нагревающиеся от горячей воды, и естественная тепловая диффузия также охлаждает воду до достаточной температуры.

«Поскольку этот процесс настолько эффективен, вам уже не надо беспокоиться об охлаждении воды до какой-то низкой температуры, — говорит Пеннингтон. – Тёплая вода всё равно эффективно забирает весь жар у серверов. Не нужен цикл компрессии, можно просто использовать сухие кулеры».

Сухие кулеры также экономят воду. Крупный дата-центр, использующий холодильники, может потреблять миллионы литров воды в год, однако дата-центр с сухими кулерами не потребляет воды. Это экономит и энергию, и воду, что может оказаться весьма полезным, если дата-центр будет расположен в черте города.

«Мы не потребляем большого количества воды, — сказал Пеннингтон. — Если всё аккуратно спроектировать, получится закрытая система. Вода не вливается и не выливается, нужно просто доливать воды где-то раз в год, чтобы цистерны оставались полными. Вы ведь не доливаете воду себе в машину постоянно, вот так и у нас».

Принятие следует за эффективностью

Один реальный пример: Dell, перейдя на жидкостное охлаждение, увеличила эффективность использования энергии (PUE) на 56%, как утверждает Брайан Пэйн, вице-президент по управлению продуктом и маркетингом PowerEdge в Dell EMC. PUE – это отношение энергии, которую необходимо затрачивать на охлаждение системы, к энергии, необходимой для работы системы [на самом деле, это отношение общей энергии, используемой дата-центром, к энергии, которая тратится непосредственно на питание IT-инфраструктуры / прим. перев]. PUE равная 3, означает, что на охлаждение системы тратится в 2 раза больше энергии, чем на питание системы, а PUE = 2 означает, что и на питание, и на охлаждение энергии тратится одинаково. PUE не может быть равна 1, поскольку охлаждение необходимо, но операторы дата-центров одержимы попытками приблизить показатель как можно ближе к 1,0.

Кроме улучшения PUE, увеличение вычислительной мощности, которое получают клиенты Dell, может составлять до 23%, и это не перегружает систему сверх меры. «На основе необходимых вложений в инфраструктуру, мы прогнозируем годовую окупаемость системы, — говорит Пэйн. – Я бы сравнил это с покупкой более энергоэффективного кондиционера для дома. Вы немного инвестируете, но затем со временем ощущаете выгоду по счетам за электричество».

В качестве совершенно иного приверженца жидкостного охлаждения возьмём суперкомпьютерный центр в Огайо, OSC. В этом кластере трудятся 1800 узлов. После перехода на ЖО, как сказал Даг Джонсон, главный системный архитектор, центр вышел на PUE = 1,5. OSC использует внешний контур, поэтому вода выводится из здания и охлаждается до температуры окружающей среды, которая летом в среднем равняется 30 °C, а зимой – гораздо меньше. Чипы доходят до 70 °C, и даже если вода нагревается до 40 °C, она всё равно остаётся гораздо холоднее чипов, и служит своей цели.

Как многие из ранних приверженцев новой технологии, для OSC это всё в новинку. Пять лет назад центр вообще не использовал ЖО, а сегодня оно занимает 25%. В центре надеются, что через три года планка вырастет до 75%, а ещё через несколько лет они полностью перейдут на ЖО. Но даже в сегодняшнем состоянии, по словам Джонсона, для охлаждения центра требуется в четыре раза меньше энергии, чем до перехода на ЖО, и в целом это решение уменьшило общее энергопотребление на 2/3. «Думаю, что процент будет повышаться, когда мы начнём интегрировать в систему охлаждения GPU».

С точки зрения клиента для оценки новой технологии нужно потратить время и энергию – только поэтому такая крупная компания, как Dell вообще согласилась сотрудничать с CoolIT для рекламирования ЖО. Неудивительно, что на первом месте среди беспокойства клиентов остаётся возможность утечки. Однако, несмотря на все колебания, оказывается, что в данный момент у них нет особого выбора, если они хотят достичь наилучшей производительности.

«Страх перед утечками был всегда, — говорит Лайон из CoolIT. – Изменилась ситуация, и теперь других вариантов просто нет. С высокоскоростными компьютерами одним воздухом не обойтись».

Комментарии (12)

saboteur_kiev

06.03.2019 15:45Теплоёмкость у воды в 3300 раз больше, чем у воздуха, и водяная система охлаждения способна прокачивать 300 л воды в минуту, по сравнению с 20 кубометрами воздуха в минуту.

Тут правильно сравнивают 300 л воды и 20 кубометров воздуха? 1 кубометр это 1000 литров.

То есть одним этим преимущество теплоёмкости воды в 3300 уменьшается в 66 раз (до 50-ти).

Diaboliko

09.03.2019 00:45Имхо всё не верно подано.

Вода имеет большую теплоемкость -> можно отвести суммарно больше тепла, прежде чем она прогреется до температуры источника (естественно, целевое значение ниже раза в два), воздух же поднимится до этой температуры довольно быстро и, как следствие, для охлаждения его нужно прогонять в огромных объемах. При этом утилизация теплоемкости (если можно так сказать) не большая. А вода (хотя почему речь именно о воде, а не, хотя бы, о смеси)… При должной прокачке будет иметь примерно одинаковую температуру во всем контуре.

c_kotik

06.03.2019 15:50+1Было бы любопытно почитать обзор/сравнение применяемых жидкостей при прямом охлаждении и есть ли какие новшества в этом плане. Ведь основной минус воды — опасность замыкания при протечках (хоть дистиллированная вода и изолятор, но со временем теряет это свойство). Новеки в основном для погружного, минеральные масла очень проигрывают воде по важным в контексте применения параметрам:

-вязкость

-теплоемкость

-теплопроводность

Igor_O

06.03.2019 16:58+1Если коротко — самое большое новшество — это погружное охлаждение Новеком с кипением/конденсацией.

Все остальные варианты, как минимум, не окупаются по сравнению с хорошо сделанным воздушным фрикулингом. Новек с кипением-конденсацией тоже будет окупаться много лет. Но там хотябы есть шанс.

И, пока, все более-менее крупные внедрения сталкивались с длительными простоями из-за пролива воды внутрь серверов и коммутаторов. Я когда свою систему делал… там столько под этой водой камней, что просто ужас. Я, честно говоря, не ожидал, что все будет настолько плохо. И, чтобы все сделать правильно, требуются некоторые технологии, которые пока более-менее надежно умеют три или четыре предприятия в мире, все из которых работают на военную авиацию или космос. Или я попробовал использовать клей, но подходящий — он есть в каталогах, но купить его можно только если есть бумага, что ты подрядчик пентагона и этот клей нужен для «оборонного» заказа.

Я начинал несколько раз писать статьи на эту тему. И даже лет пять или шесть назад что-то здесь на Хабре пытался опубликовать, но оно так и сгинуло в песочнице. Эта тема местных жителей, в среднем, не очень занимает.

c_kotik

06.03.2019 17:12+1Я бы, например, с удовольствием прочитал на данную тематику статьи. Проектировать конечно юниты с киловаттами мощности я не собираюсь. В планах лишь переделка мини-ПК под жидкостное охлаждение. Ведь их главный плюс — гибкость переноса теплообмена в удобное место. Конечно, этой теме 100 лет в обед — вода с ингибиторами и в путь! Но вот что есть нового, проверенного и протестированного в этом плане — не ясно.

ПС

В плане занятных решений откопал одну древнюю штуку:

https://fcenter.ru/online/hardarticles/cooling/28822-Ohlazhdenie_zhidkim_metallom_kuler_Danamics_LMX_Superleggera

Igor_O

06.03.2019 18:22+2Ну так это она, классика жанра! Крутой сплав натрия с калием, красивые заявления… и… температура ядра на 6 градусов выше, чем у (пусть и очень хорошего) кулера с обычными тепловыми трубками. Почему? Очень просто — вода вообще уникальное вещество. И очень мало других веществ со столь же высокой теплоемкостью. А у NaK — теплоемкость примерно в 4 раза ниже, чем у воды. Но. Интересное начинается при фазовых переходах. Теплота испарения воды примерно 2.2 МДж/кг. Соответственно, подобрав давление в тепловой трубке — мы получаем идеальную систему теплопередачи. Пока ТТ в рабочем диапазоне и вода в зоне нагрева выкипела не вся — более крутой штуки в условиях Земли примерно нет. А тут жидкий металл, который, конечно, имеет более высокую, чем вода, теплопроводность. Но «теплоемкость» по сравнению с фазовым переходом вода-пар — никакая.

Но вот что есть нового, проверенного и протестированного в этом плане — не ясно.

Вы мне, конечно, не поверите. Но воздух. У меня много знакомых баловались с водянкой в разное время. От наколенных самоделок до дизайнерских решений за большие килобаксы. В какой-то момент затраты сил и средств на поддержание этой байды в живом и рабочем состоянии каждый раз начинали перевешивать все (две штуки) плюсы водянки и люди возвращались к старому доброму воздуху.

Вся проблема в том, что большинство производителей идет по пути — наделать больше дыр в корпусе, навесить больше больших вентиляторов. Это не работает. Работает серверный вариант — взять воздух с одной стороны, выбросить его с другой стороны, с минимизацией перетоков нагретого воздуха туда, где мы что-то пытаемся охлаждать. Я в свое время существенно улучшил охлаждение со снижением шума в небольшом корпусе просто стратегически правильно воткнув картонную перегородку.

Из личного опыта — основная засада — в охлаждении видеокарты. «Хорошие» и «дорогие» системы охлаждения видеокарты — просто тупо дуют горячим воздухом во все стороны. Правильный вариант — когда в глубине стоит вентилятор, который продувает воздух сквозь закрытый кожух и выдувает его наружу. Я недавно наконец надыбал себе видеокарту с правильным охлаждением. Сразу избавился от трех вентиляторов в корпусе, и от большей части шума.

переделка мини-ПК

А вот с мини-ПК — вообще все плохо с точки зрения водянки. Они мелкие. Они на столе. Там в любом случае не бывает БП мощнее реальных честных 200 Вт. На охлаждение даже всех 200 Вт нужно 30-35 cfm воздуха. Это, извините, меньше, чем поток, который дает Noctua NF-P12 на минимальной скорости! (при уровне шума 13 Дб, т.е. слышно, если лопасти вентилятора уже начали задевать ухо...)

Igor_O

Иногда удивительно — какая у людей в голове каша…

1. Жидкостное охлаждение так или иначе используется в компьютерах почти с момента их появления. Да, ламповые и релейные компьютеры еще были на воздушном охлаждении, но с появлением транзисторной логики — первым делом появились компьютеры с жидкостным охлаждением.

2. Ушли они не потому, что жидкостное охлаждение плохое. Ушли они потому, что оно само по себе является источником проблем. Если сделать систему прямого охлаждения компьютеров жидкостью хотя бы соответствующую Tier II — Мы получим плотность мощности типа 5 кВт на стойку. Что прекрасно охлаждается воздухом без каких-либо «коридоров» прямым фрикулингом «с улицы».

2а. Про сравнение сухих и мокрых градирен — все здорово, но в сухой градирне при +40 «за бортом» вы не получите воду холоднее примерно +42, а в мокрой — можно при некоторых условиях получить воду температурой ниже +35…

3. Даже на фотографии хорошо видно — 24 юнита, занимающие площадь примерно как стойка глубиной 1200 мм. На фотографии большая часть заполнена обычными двухпроцессорными серверами. Это что-то типа 0.5 кВт на юнит максимум. Это плотность мощности, которая считалась очень класнной… 15 лет назад! 11 лет назад уже был запущен СК «Чебышев» с мощностью 25 кВт на стойку… Все прекрасно охлаждалось воздухом. 9 лет назад был запущен «Ломоносов», в котором прекрасно охлаждались под 70 кВт на стойку воздухом (да-да! стандартные 42Ux600х1000).

Запихиваем такие стойки в систему с фрикулингом наружным воздухом — и вот вам система с PUE ниже 1.15 примерно во всем мире (что-то типа 1.05 для Москвы и Питера).

Как им удалось сделать настолько плохо?! Просто чиллер с фрикулингом и ИБП с КПД пусть даже всего 90%, уже дадут в климате Огайо PUE ниже 1.3!

А дальше — просто деньги. В оранжевой ванне на иллюстрации — что-то около пол тонны Новека. По цене — оригинальный продают что-то типа по 300-400 долларов за кг? Китайцы демпингуют и продают по 100-200 за кг (но, как обычно, вместо новека 7000 пришлют какой-нибудь FM200, т.к. для них это одна фигня). Но даже по 100 долларов за кг — это 50 килобаксов одной жидкости на 24 юнита. Окупать они это будут лет 15-20 (даже без учета того, что с той гибкой подводкой, которая видна на фото, жидкость из водяной части системы охлаждения будет вся вытекать раз в три года и новек весь из ванн будет выкипать).

Ну и да, еще одна мелочь — дополнительные 500 кг массы жидкости на каждый конструктив — это значит, что далеко не везде это можно поставить. В большинстве случаев потребуется усиление перекрытий или, при новом строительстве, закладывать на 500 кг на квадрат большую нагрузочную способность. А это тоже деньги. И их тоже нужно будет окупить. И в результате, выходим на минимальный срок окупаемости «никогда»…

PS: И да, я «немного» в теме, на водяное охлаждение угрохал пару лет своей жизни…

PPS: И да, ванна с Новеком — выглядит как наиболее разумный и безопасный вариант системы ЖО. Но только нужно понимать, что выигрыша ни в плотности мощности, ни в PUE по сравнению с хорошо сделанными системами воздушного охлаждения — вы не получите.

rPman

Плотность размещения оборудования с жидкостным охлаждением на порядок выше чем на воздухе. Все проблемы с отводом тепла переезжают в другое место, по трубам, именно ради этого городят городушки с жидкостями.

5кв тепла на стойку — у вас какая то фигня, у меня порядка 4кв на пару/тройку юнитов водянки — без проблем (я про кастомную систему говорю, ибо готовое обычно такое дорогое что даже смотреть страшно)… кастомно сложнее именно охлаждение воды сделать эффективное, я только сухое делал но задумывался и о мокром, справлялся обычным автомобильным радиатором, где то до +10 градусов и ниже оно даже на пассиве отводит достаточно тепла.

В промышленном варианте с отводом тепла жидкостной системы проблем нет, ставится пара блоков на мегават, на крыше, и голова не болит.

Igor_O

Вот кто вам сказал такую глупость? Вы поверили? Вы учли, что воде нужны трубы?

Еще раз. На воздухе. В стандартной 19" стойке шириной 600 мм и высотой 42U — много лет проработала система с 60-72 кВт на стойку. Максимум, что есть на воде — стойка около 130 кВт размером чуть меньше, чем 2х2х2 метра. Т.е. реальная плотность, даже с учетом кондиционеров, примерно в два раза меньше, а если предположить фрикулинг уличным воздухом — то и во все четыре раза меньше. На уровне… 2007-8 годов… На самом деле, на 100-120 кВт на стойку мы на данный момент упираемся в… блоки питания. Мощность БП на кубический сантиметр объема сейчас уже очень близка к физическому пределу для существующей элементной базы. После 100 кВт в стандартной стойке добавление мощности приводит к увеличению объема блоков питания, из-за которого нам начинает не хватать объема для размещения процессоров.

Еще раз. Я говорю про уровни надежности инженерной инфраструктуры. Охлаждение — это часть инженерной инфраструктуры. Вы уверены, что в вашей системе можно не останавливая и не ухудшая характеристики работы ИТ сервисов, например, заменить потекший ватерблок на чипсете материнки? А Tier II уже требует N+1 по основным компонентам инженерной инфраструктуры. А если замахнуться на Tier III — то там еще понадобится кольцо подачи ОЖ, кольцо возврата ОЖ, резервирование ватерблоков, три крана на каждый тройник и прочие веселости и радости. И все это должно быть доступно для обслуживания без отключения компьютера. С погружным охлаждением все чуть-чуть проще, но тоже не совсем без проблем.

Ну вообще то, «обычный автомобильный радиатор» — это что-то от 40-50 кВт расчетного съема тепла для разницы температуры воздуха и температуры ОЖ порядка 40 градусов (для машин типа Оки и подобных «микролитражек» около 25-30 кВт). Было бы удивительно, если бы он у вас не справился с 4 кВт. Но опять же — три юнита на воздушном охлаждении, которые уже реально работали 8 лет назад, это было больше 7 кВт, если не считать блоки питания и коммутаторы. С учетом БП, коммутаторов, вентиляторов и всего остального — больше 1.7 кВт на юнит именно не по номиналам блоков питания, а реального энергопотребления/тепловыделения.

rPman

Не смогу вам парировать потому что не разбираюсь в системах высокой надежности, а именно на это вы акцентируете внимание. Считайте что вы выиграли спор, ок?

p.s. Если вы специалист, скажите пожалуйста, что такое резервирование ватреблоков, если это конечно не коробка с запасными частями на замену?

Я касался жидкостного охлаждения лично с оборудованием собранном на коленке из дешевых комплектующих с ali и прекрасно вижу что с воздухом все на порядок геморнее. Потоки воздуха нужно проектировать и планировать с учетом размещения оборудования, а это в свою очередь сильно увеличивает расстояние между ними и добавляет много лишнего места, когда как трубки с жидкостью можно гнуть и упаковывать почти без ограничений, раскладывая оборудование штабелями, как угодно, т.е. рассматривая удобство именно монтажа и доступности замены.

p.s. для защиты от потециальной утечки, я делал монтаж так чтобы все водоблоки относительно устройств были снизу,… в один слой, т.е. если что то капнет то на корпус а не плату.

А еще то в датацентре у вас температура 18, а влага и пыль находятся под контролем, у меня же, ради снижения издержек, всего этого счастья не было, и проблем из-за этого именно воздушное охлаждение создает много, так что нет, спасибо, лучше водянка и общий контур (а не как водянку только внутри оборудования для отвода тепла наружу корпуса, но снаружи все те же вентиляторы).

и да, с водой сильно тише ;)

Igor_O

Ватерблок — устоявшееся сленговое название водяного радиатора на процессоре, или на чипе видеокарты, или на модуле памяти.

По определению, для соответствия Tier II и выше мы должны резервировать все важные части системы охлаждения, как то, насосы, вентиляторы, радиаоторы. Т.е. чтобы если у нас «ватерблок» отвалился от чипа — чип должен продолжать охлаждаться. Должен быть «резервный» ватерблок. Что для систем прямого водяного охлаждения — примерно невозможно.

Ну тут как бы название статьи "… как в дата-центрах стало..." Учитывая, что я за последние 10 лет 8 лет занимался или проектированием систем охлаждения для суперкомпьютеров, или проектированием ЦОД-ов, такое название сразу вызывает желание примерить к заявлениям статьи популярные версии стандартов для ЦОД…

Это вы просто еще не добрались до действительно интересного. С воздухом все на два порядка проще со всех точек зрения. А вода — боль на каждом стыке! Особенно когда количество охлаждаемых водой процессоров становится больше 20… (а это значит минимум 10 чипсетов, 10 эзернетов, 20 регуляторов напряжения для процессоров… А еще эта злобная мелочевка, типа преобразователя напряжения для какой-нибудь вспомогательной микрухи, которая выделяет меньше ватта, но без охлаждения начинает перегреваться и вызывать трудно диагностируемые глюки...)

Ну тут был эксперимент, когда группа товарищей поставили стойку просто в палатке на улице. Без фильтров, охлаждения и контроля влажности. После года — никаких проблем. Фильтры сейчас нужны просто, чтобы чисто было и не сильно пачкать руки о платы при обслуживании. Нормальная полноценная фильтрация сейчас нужна только в помещениях, где живут ленточные библиотеки.

С влажностью сложнее — если влажность слишком низкая — начинаются пробои с корпусов микросхем на случайные ножки. Как правило ничего не сгорает, но общее наблюдение, что в морозы интернет работает хуже — оно никуда не делось. Оно все еще так и есть (мой провайдер что-то наладил и после 17-го года с регулярными перебоями по несколько дней, почти весь 18-й год было счастье «без разрывов», но вот в прошлое похолодание в январе 19-го… было несколько отключений длительностью до пары часов… и пара десятков странных перебоев по 5-15 минут).

rPman

p.s. спасибо за статью про системы охлаждения