Не прошло и года с момента выхода нашей тестовой статьи про самый умный обогреватель, как мы уже успели завести блог на Хабре. Первая публикация в нашем блоге — обзорная. Прогуляемся по офису, производству, поглядим по сторонам. Большинство из увиденного станет темами последующих публикаций.

Всем привет! Мы — компания "Теркон КТТ". Наша специализация — опытное внедрение систем охлаждения на базе контурных тепловых труб (далее — КТТ). Раньше такие трубы применялись только в космической промышленности. Сегодня их уже можно встретить внутри настольных компьютеров. Завтра они окажутся внутри начинки ЦОДов и Микро-ЦОДов.

Мы располагаемся на территории Уральского турбинного завода, занимаем часть этажа одного из корпусов. Найти нас легко, но проехать не просто. Потому что на пути к нам — Охрана. Набор дядечек с рациями проверяют все проезжающие автомобили на наличие непонятно чего в багажниках. Чтобы проехать мимо, нужно оказаться в списке, что в руках у юнита. Списки эти обновляются по рациям. А рации не всегда работают. Машин много, дойти до будки некогда. Так некоторые товарищи и ходят подолгу, не синхронизированные. А ты стоишь, "радуешься" и ждешь своего появления в заветном списке.

Пройдя каждый раз новый квест с охраной можно попасть в нашу обитель. Здесь есть и офисные помещения и производственные, есть раздевалка, неожиданно большая кухня и даже душ. Но нас интересует не это. Нам, конечно же, интересны примеры применения контурных тепловых труб. А их тут немало.

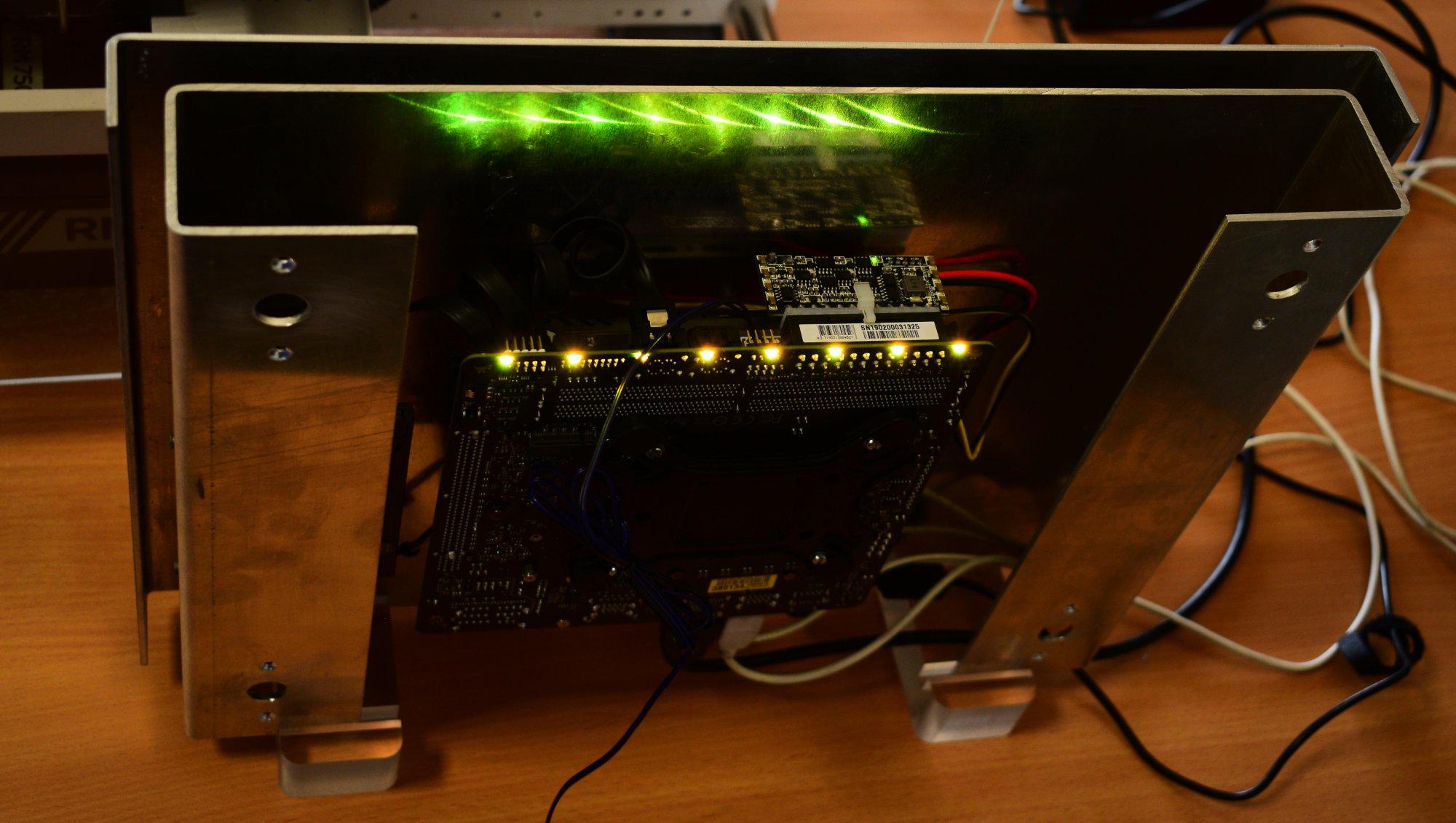

Небольшой парк бесшумных настольных компьютеров, имеющих сейчас скорее историческую ценность.

Более свежие наработки по безвентиляторным настольным ПК. Компактный медиацентр. На базе корпуса Powerman ME100, габариты 200 x 55 x 200 мм.

Рабочий компьютер, например, для программиста. На базе корпуса Thermaltake Core G3.

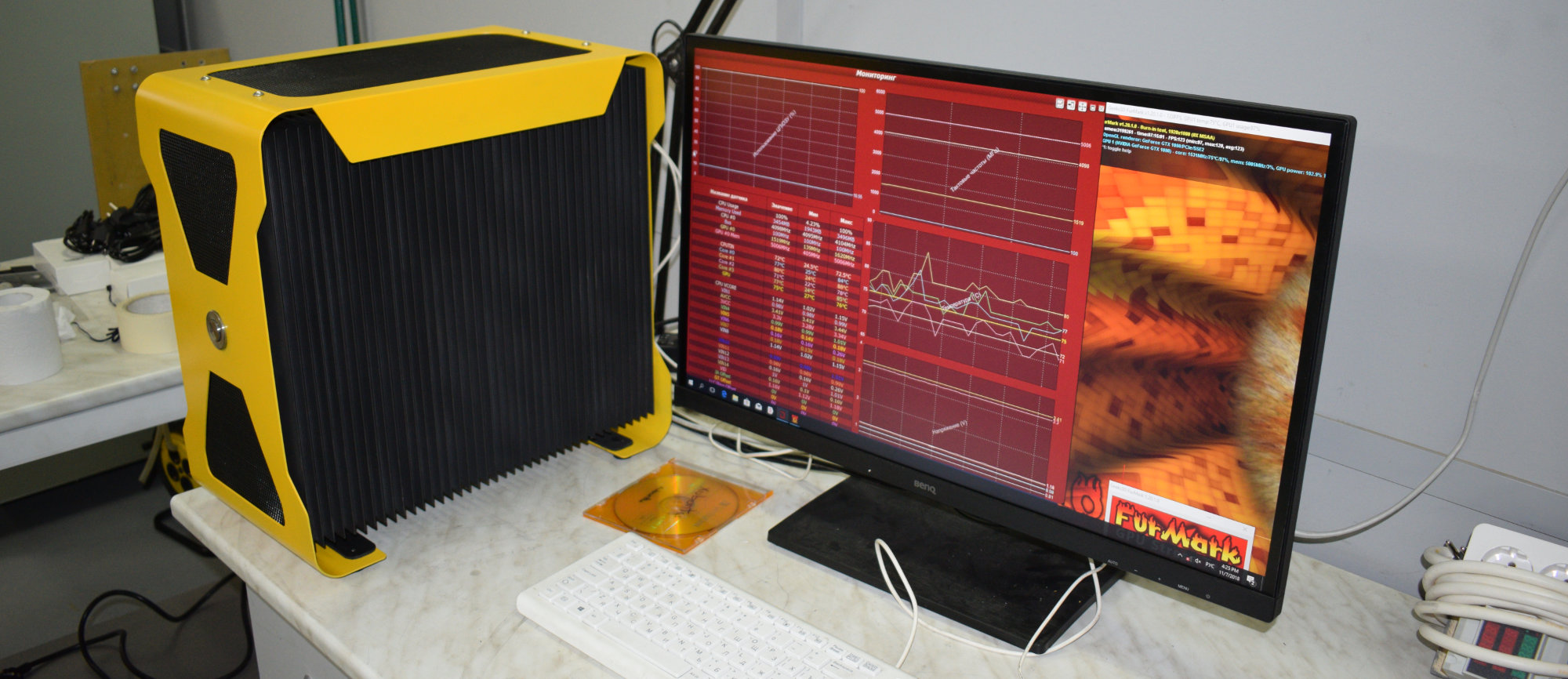

Игровой компьютер со встроенной защитой от кражи. Внутри — Intel Core i7-7700K, Nvidia GTX1080, плюс примерно 30 килограмм радиаторов.

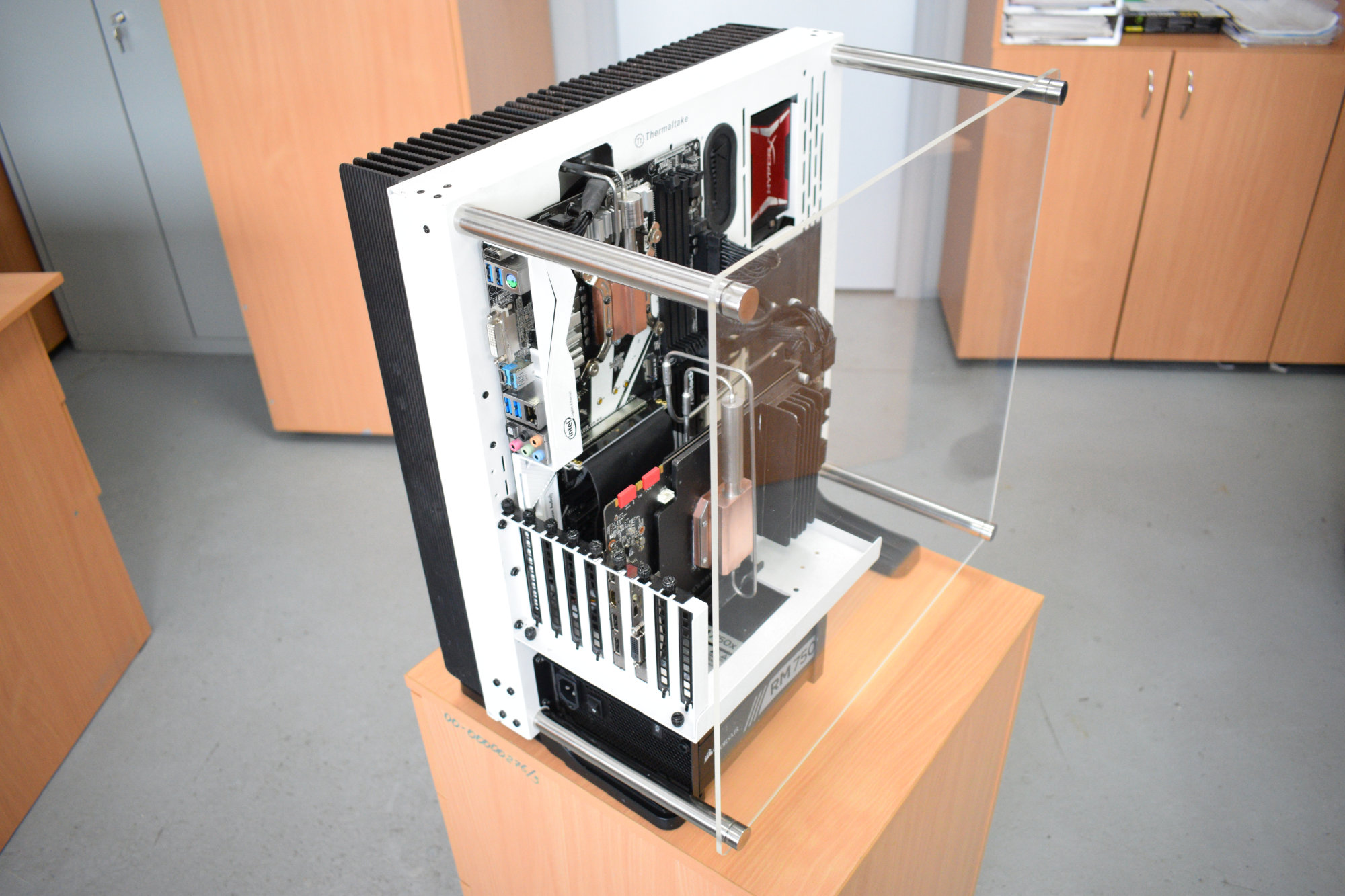

Игровой компьютер на базе корпуса Thermaltake Core P3. С меньшей защитой от кражи, для более слабых игроманов. Всего-то порядка 20 кг. Внутри — Intel Core i7-6700K, Nvidia GTX1070.

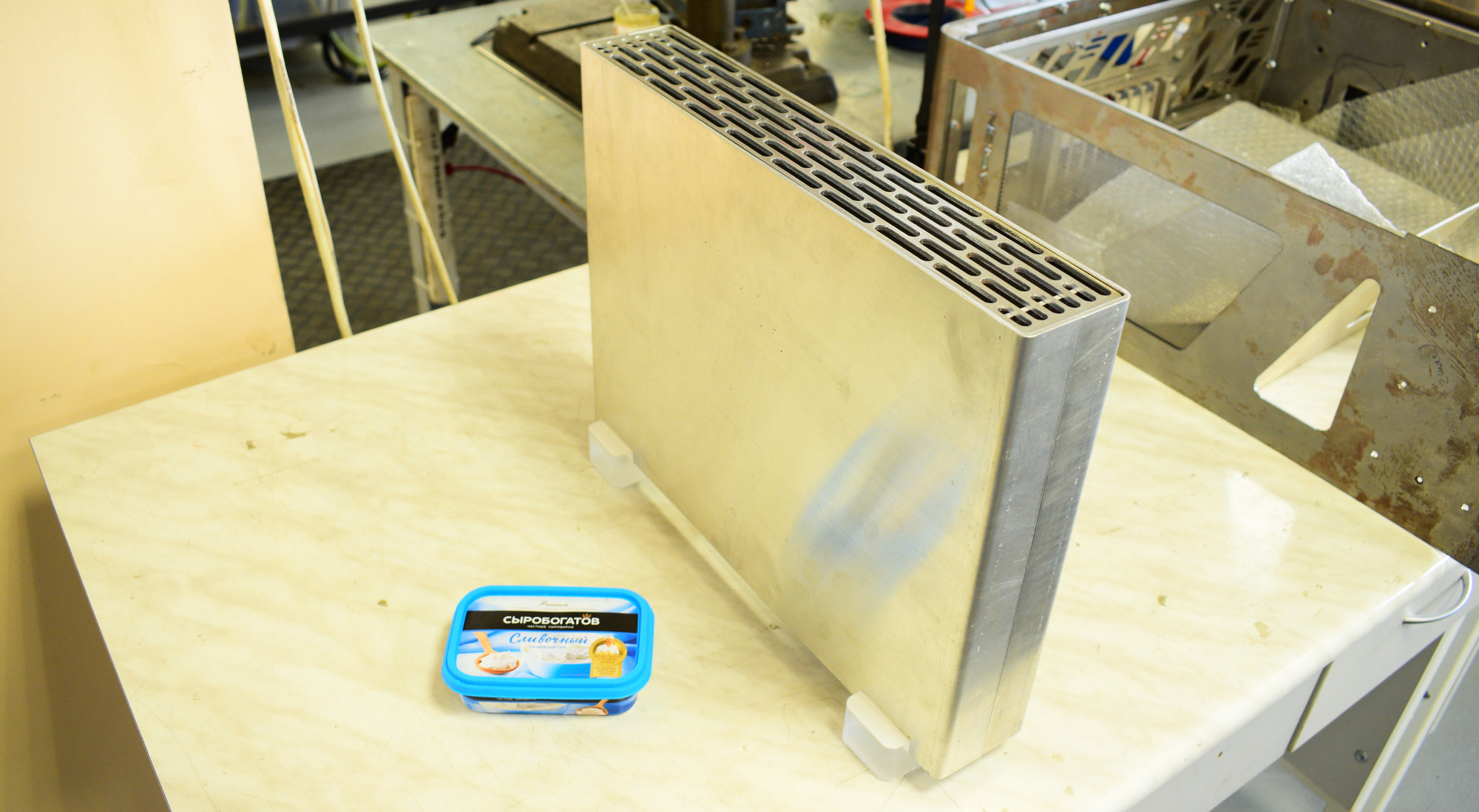

Новые разработки по настольным ПК, еще не завершенные. Совсем легкие и не защищенные. И недорогие. Внешнюю видеокарту не потянут, но вполне потянут какой-нибудь современный AMD Ryzen.

Но что мы все о настольных, да о настольных. Пора переходить к более серьезным материям. Компьютеры со временем становятся все мощнее и горячее. Когда таких компьютеров десятки и расположены они вплотную друг к другу, вопрос эффективного охлаждения стоит гораздо острее.

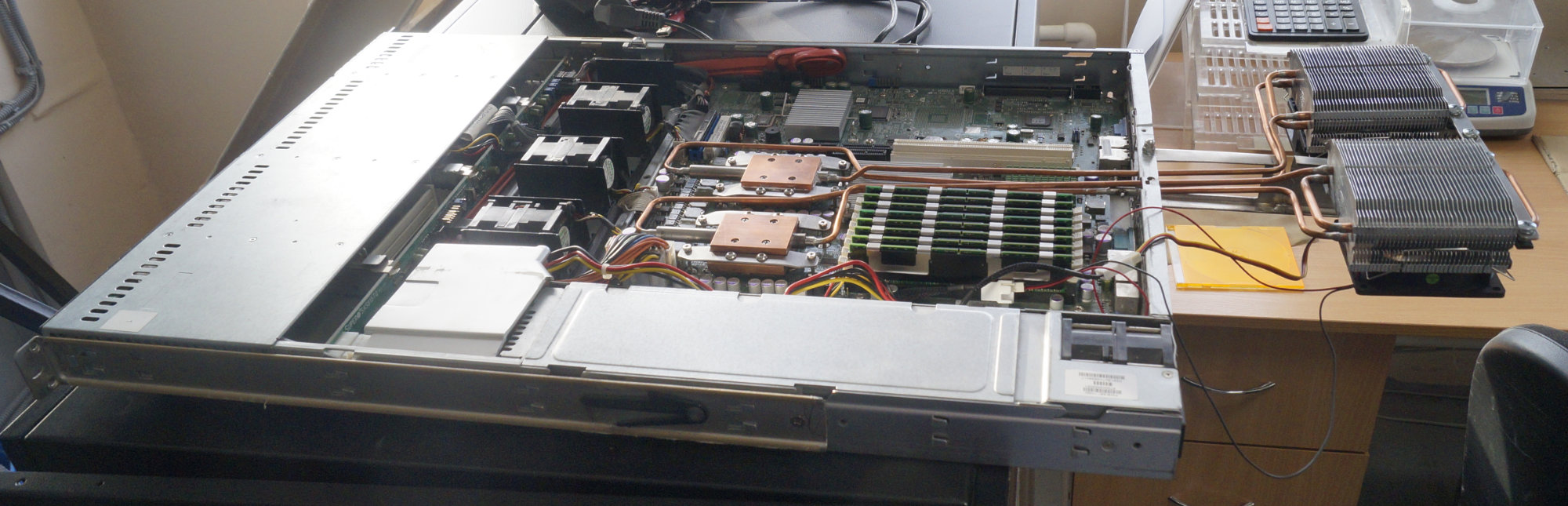

Вот, например, стоечный сервер.

А вот — блейд.

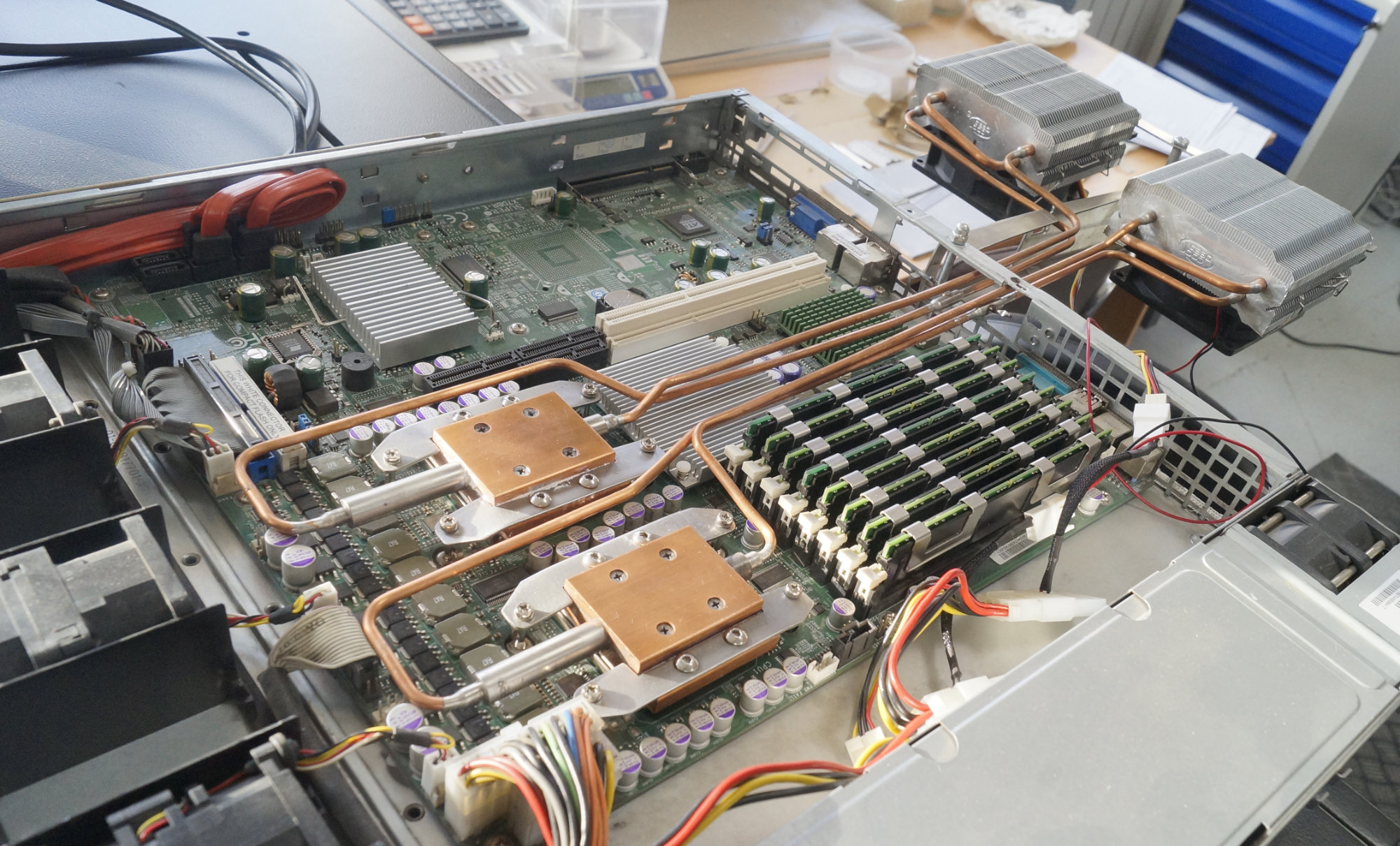

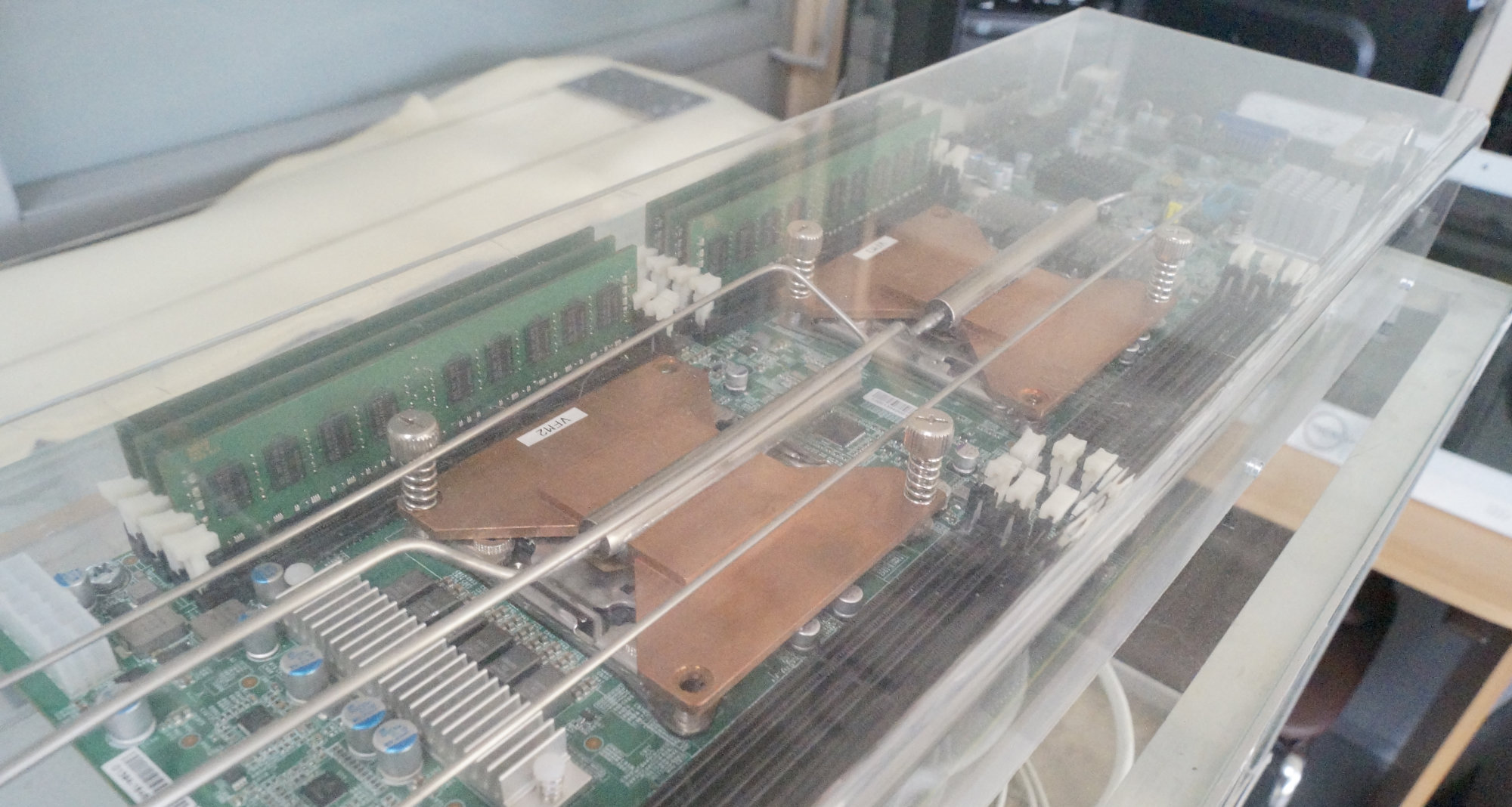

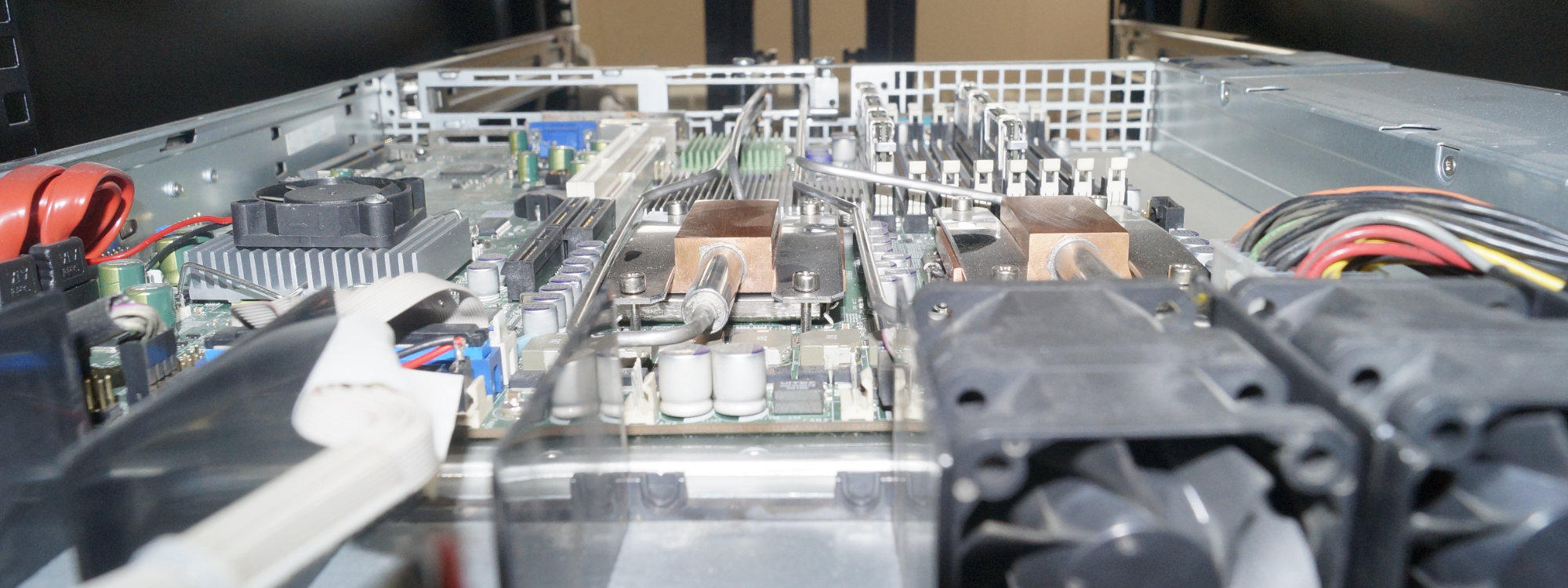

Это давние эксперименты с модифицированным воздушным охлаждением. Сейчас концепция изменилась — вывод тепла на наружную жидкостную шину. Никакой жидкости внутри сервера, никаких мощных насосных станций. Новая методика отрабатывается вот на этом шкафу:

И выглядит примерно вот так внутри сервера:

И вот так сзади серверной стойки:

Здесь расположена вертикальная жидкостная шина. Внизу шины — отвод к радиатору:

На фото — только рабочая модель. Не нужно пугаться чего-то некрасивого или неудобного. Скоро появится новая доработанная ревизия. Нужно пугаться скачка эффективности системы охлаждения. Готовиться к появлению возможности значительно увеличить IT-нагрузку в рамках неизменной подведенной электрической мощности. И вставать в очередь если и не за приобретением наших систем, то как минимум, чтобы становиться нашим партнером. :)

Кстати, именно сейчас мы рассматриваем возможность заключения партнерских соглашений с производителями Микро-ЦОДов. С нашей системой охлаждения ваш Микро-ЦОД сможет приобрести новые ключевые конкурентные преимущества. По вопросам партнерства можно обращаться ко мне webself.

Для тех, кому интересна тема эффективного охлаждения электроники и кто хочет быть в курсе наших разработок, мы начинаем вести две соцсети — ВКонтакте и Instagram. В них мы будем кратко публиковать наши новости до появления полновесных статей здесь на Хабре.

Следующая наша статья будет про устройство контурных тепловых труб и про их отличие от обычных тепловых трубок, которые имеются сейчас практически в каждом современном настольном компьютере и ноутбуке.

Комментарии (77)

Detuner

23.05.2019 09:48+1У меня вопрос про стойку с жидкостной шиной: что происходит, когда нужно ненадолго вытянуть сервер из стойки для обслуживания? На фото видно, что теплообменники прилеплены к шине на термопасте, и конструкция явно не hot-plug. Я понимаю, что это только экспериментальный прототип, но очень интересно, как планируется решать эту проблему.

webself Автор

23.05.2019 09:52Сейчас как раз работаем над соединениями в этой части. Можно будет отцепить нужный сервер от шины и вытянуть его для обслуживания. Насчет использование термопасты — пробуем решить этот вопрос качественной шлифовкой поверхностей. Чтобы обойтись без термопасты. Прямо сейчас нет финального решения.

Detuner

23.05.2019 10:16Дело в том, что иногда бывает нужно вытянуть из стойки работающий сервер.

Я вижу ещё одну серьёзную проблему: обычно в компьютерах (а особенно в серверах) не только процессоры и видеокарты требуют активного охлаждения. Если избавиться от всех вентиляторов в корпусе, резко ухудшатся условия работы остальных компонентов — RAID-контроллеров, жестких дисков, цепей питания и т.д. Это значит, что в серверах совсем без вентиляторов обойтись точно не получится. А это в случае с ЦОДом означает, что нужно иметь уже две инженерных системы охлаждения — водяную и воздушную, причём они не резервируют друг друга, отказ каждой из них фатален.

webself Автор

23.05.2019 10:32Работающий сервер можно будет вытянуть либо совсем ненадолго, либо сбросив нагрузку на его цп, либо, если это не подойдет, будет можно на время выемки ставить специальный радиатор. Про полный пассив на серверах никто не говорил. Часть вентиляторов придется оставить. Мы не конкурируем с просто воздушной системой. Мы конкурируем с жидкостной, при этом избавляя от возможных протечек внутри оборудования, например. В одной из статей будут в цифрах объяснятся все перспективы нашей системы, думаю, вам будет интересно. А вообще — спасибо за такие подробные комментарии. Собрать такую обратную связь — одна из целей нашего появления здесь.

Detuner

23.05.2019 10:44+1Спасибо, тема очень интересная, буду ждать новых статей.

Идея в порядке бреда: можно ли (хотя бы теоретически) изготовить гибкую тепловую трубку?

webself Автор

23.05.2019 10:55Можно, есть даже три варианта. 1. Спиральная трубка, 2. Гофротруба, 3. Обожженная обычная трубка. Каждая со своими особенностями. Для какого применения вы думаете использовать ее?

Detuner

23.05.2019 11:05Такую трубку можно было бы проложить вместе с кабелями через органайзер, и тогда можно смело прикручивать внешние теплообменники к шине на термопасту. Для этого, конечно, лучше всего подойдёт гофротруба. Вот только придётся удлинить трубку примерно на метр, что отрицательно скажется на теплопроводности.

webself Автор

23.05.2019 11:11Не очень понял. Откуда и куда может пойти такая трубка? Учитывая еще, что наши КТТ — замкнутые, а не просто отрезки.

Detuner

23.05.2019 11:20У серверов бывает такая штука под названием

cable management arm

webself Автор

23.05.2019 11:23Спасибо за фото. Не думаю, что наши трубки настолько гибкие ) Вряд ли такое получится. Все варианты о которых я писал выше — скорее для однократного формования системы «по месту». Регулярные сгибы-разгибы, как провода, они вряд ли вынесут.

Aleksandr_Sv

23.05.2019 10:58Может я ошибаюсь, но таких ситуаций очень мало, когда нужно вытащить работающий сервер не останавливая его.

Detuner

23.05.2019 11:14Скажем так, в большинстве случаев этого можно избежать, но это связано с дополнительными затратами времени. Например, заменить комплект вентиляторов можно «на горячую», отключать сервер для этого не требуется. Даже планки памяти в современных серверах можно втыкать на ходу (хотя лично я никогда не пробовал, страшновато).

webself Автор

23.05.2019 11:16Для замены комплекта вентиляторов ведь тоже надо сбросить нагрузку? Иначе все перегреется довольно быстро.

Detuner

23.05.2019 11:27Вовсе нет, вентиляторы-то обычно с горячей заменой. Вытягиваешь сервер, открываешь крышку, под ней блок вентиляторов и пластиковая крышка-воздуховод, направляющая поток воздуха к радиаторам. Вентиляторы на защёлках, меняешь их по одному, выдернул-вставил.

DarkTiger

23.05.2019 11:14Множество таких ситуаций. Например, есть стойка на 256 нод, и таких стоек несколько десятков. Понятно, что ноды ломаются частично или совсем, и понятно, что надо неработающие ноды заменять, не останавливая всю стойку при этом. Стандартная задача горячей замены со стадартными решениями — сбрасываем снапшот на локальный SSD ноды или по сети и выключаем ноду. Заменяем на исправную, включаем и подгружаем снапшот.

Ну а если сдохла нода — то же самое, но без снапшота. Обычная ситуация горячей замены. Так и коммутаторы меняют, и блоки питания — в таких стойках вся инфраструктура дублирована, очень уж они дорогие, очень много стоит их простой, да и простое включение-выключение выбивает электронику

Aleksandr_Sv

23.05.2019 11:39Учитывая что практически везде на современных серверах используется виртуализация и современные гипервизоры позволяют одной командой вывести ноду из работы переложив её нагрузку на другие ноды, не вижу острой необходимости вытаскивать работающий сервер. Ну а диски меняются и без вытаскивания сервера.

safari2012

23.05.2019 18:11Бывали случаи, когда приходилось перемещать в пределах здания работающую стойку целиком, без останова.

DarkTiger

23.05.2019 11:06Не надо планировать решать эту проблему, есть стандартные водяные разъемы для отключения подачи-отбора воды. Вовсю применяются в суперкомпьютерах (например, A-Class в Т-Платформах) и во множестве другого оборудования, где требуется водяное охлаждение. Просто надеваешь его или снимаешь, при этом вода не вытекает — клапаны с обоих сторон.

webself Автор

23.05.2019 11:09Мы не решаем проблему подачи-отбора воды. Там сухое соединение наших КТТ и жидкостной шины.

vibornoff

23.05.2019 12:20Если б не ваше принципиальное «никакой жидкости внутри сервера», можно было бы разместить внутри сервера пассивный гидроблок с питанием от жидкостной шины по гибким трубкам, а на него сбрасывать тепло вашими КТТ. Эффективность такого решения выше, т.к. теплопроизводительность гидроблока определяется в основном скоростью прокачки теплоносителя через него, а тепловой трубки — её сечением и длиной, так что при той же тепловой нагрузке можно поставить трубки потоньше, раз место сброса тепла поближе :-)

webself Автор

23.05.2019 15:53В имеете в виду, чтобы трубки подсоединялись внутри сервера к гидроблоку, а каждый сервер подключался двумя фитингами к внешней жидкостной системе?

vibornoff

24.05.2019 11:41Именно так

webself Автор

24.05.2019 11:44В таком случаем нет каких-то особенных отличий от обычной жидкостной системы. Прокачка жидкости под высоким давлением по тонким трубкам, огромные внешние гидроблоки в серверной (неплохо так потребляющие энергию), жижа внутри серверов (которая даже на дорогущих фитингах иногда, но течет) и так далее.

Detuner

24.05.2019 15:29Такой гидроблок не будет иметь никаких соединений внутри сервера. Выводим из него две медных трубы через заднюю панель — все фитинги оказываются снаружи.

c_kotik

24.05.2019 16:18Так и обычные водоблоки в серверах делают без фиттингов — всё запаяно для надёжности и только подключение сзади.

Detuner

24.05.2019 17:33Тут всё-таки есть некоторая разница. Одно дело — несколько отдельных водоблоков, соединённых трубками, хоть и пайка, но это всё-таки соединения. Другое дело — один единственный «кирпич», к которому идут тепловые трубки. Этот кирпич можно даже сделать не внутри корпуса, а снаружи, с креплением на задней стенке. Этот вариант уже почти ничем не отличается от водяной шины на стойке, но он гораздо удобнее.

webself Автор

24.05.2019 17:41На самом деле ничего такого хорошего в куче разных водоблоков нет. Это куча водяных соединений. И если какое-то из них потечет с верхнего юнита, разница в том, что оно снаружи, а не внутри будет небольшая. Далее, надо будет использовать какие-то фитинги, предусматривающие закрытие соединения, чтобы была возможность отцеплять сервер. Куча этих фитингов тоже будет точками отказа, плюс стоить тонну денег.

Detuner

24.05.2019 18:02Согласен, с точки зрения опасности протечек шина с нижним подключением надёжнее. Но меня очень смущает история с прижимом к ней теплообменников «на сухую». Полировка проблему не решит, можно сколь угодно тщательно всё отполировать и подогнать, но одна крохотная песчинка, попавшая между шиной и теплообменником, сведёт все усилия на нет. Отдельная неприятность в том, что нет другого способа проверить, всё ли в порядке, кроме как включить сервер и посмотреть, не перегреется ли он под нагрузкой.

webself Автор

24.05.2019 18:27Если в термопасту попадёт песчинка — тоже будет перегрев. Если в жидкостной разъем попадёт — то потечёт вода. У нас там вертикальная поверхность, вероятность появления песчинки там крайне маловероятна, разве кто-то специально её на какую-нибудь соплю приклеит. Но в этом случае песчинку скорее всего просто вдавит в шину :)

CrazyRoot

23.05.2019 09:52Компьютерные корпуса в лучших традиция ВПК — хрен поднимешь, никакой эстетики и всюду углы.

Стоечный сервер… а что то не понял, радиаторы болтаются непосредственно на медных трубках, без доп. креплений? Если вы конечно не хотите сказать что вон та алюминиевая полоска это силовой элемент для крепления радиаторов…

Вертикальная шина. Вообще не понятно что к чему… Отвод к радиатору… т.е. выкидываем тепло из стойки в помещение где стоит эта стойка?

c_kotik

23.05.2019 09:56Так там пассивные корпуса. Они априори не могут быть лёгкими с горячим железом.

Ну а вместо «теплообменника между ККТ и СЖО» почему то обозвали вертикальной шиной)

webself Автор

23.05.2019 09:59Корпуса из алюминиевых листов, которые сейчас разрабатываются, кстати, вообще пушинки.

webself Автор

23.05.2019 09:58Про дизайн — на вкус и цвет, как говорится. Лично для меня варианты на основе готовых корпусов выглядят вполне симпатично, сам пользуюсь и дома и в офисе. 30-килограммовое чудо — конечно не для всякого игромана )) Возил его как-то в машине «из точки А в точку Б», понял, что больше такой подвиг совершать не буду… Про вертикальную шину — радиатор вообще на улице висеть может, почему в помещение со стойкой?

Arcuen

23.05.2019 11:54Вот вам бесплатная идея, можете потом рекламировать, как ноу-нау: используйте термоэлектрические элементы для более активной передачи тепла от процессора к радиатору.

voshka

23.05.2019 12:09Я полагаю, что одним из плюсов использование КТТ, это вынос «радиаторов» за пределы корпуса компьютера, где их можно увязать в одну общую систему через жидкостные теплообменники, при этом они более компактные, не потребляют энергию, и более эффективные по сравнению с просто жидкостным охлаждением, за счет кипения-конденсации.

Arcuen

23.05.2019 12:18Тогда

внутри начинки ЦОДов и Микро-ЦОДов

будут радиаторы в пару сотек килограмм, если не в пару тонн весом? Пассивная передача тепла будет справляться только до определённых значений тепловыделения. И вот чтобы увеличить тепловой поток от чипов или ключей к теплоносителю — можно применить термоэлектрику. Вибраций там нет, значит и жить элемент может дольше.

voshka

23.05.2019 12:46Необязательно отводимое КТТ тепло сдувать, можно и жидкостью собирать, всё зависит от масштабов и количества оборудования.

Непонятно что Вы понимаете под пассивной передачей тепла, в КТТ с помощью насоса, за счет капиллярных сил циркулирует теплоноситель. Вот такие миниатюрные КТТ и по 100 Вт способны передавать, в зависимости от конструкции и типа теплоносителя, а в космической отрасли применяют КТТ мощностью в несколько сотен Вт.

Arcuen

23.05.2019 12:55Я про передачу тепла от чипа к КТТ. Что там в КТТ происходит — это совсем другой вопрос. Если между охлаждаемым элементом и системой охлаждения воткнуть термоэлектрику, особенно каскадом, то можно сотни ватт спокойно отводить. Например, таким вот элементом. Скажу сразу — не реклама, просто пример хороший.

Detuner

24.05.2019 09:39+1Элементы Пельтье — это игрушки в основном для оверклокеров, т.к. им нужно не просто отвести тепловую мощность, а ещё и достичь минимальной температуры на холодной стороне. Думаю, что в серверах мы их не увидим никогда, по нескольким причинам.

Во-первых, это низкий КПД. Отводя 100Вт тепловой мощности от процессора, элемент добавит к ней ещё 100Вт собственной. Для оверклокера это не проблема, но в масштабах ЦОДа это очень серьёзное увеличение затрат на питание и охлаждение.

Во-вторых, сдохший элемент является отличным теплоизолятором, а если не повезёт — ещё и сам будет подогревать процессор на те же 100Вт, что гарантированно убьёт его.

В третьих, традиционная схема с отводом тепла на обычный радиатор в случае серверов практически не имеет недостатков, т.к. у серверов нет ограничений по шуму, можно использовать компактный радиатор и любое количество вентиляторов любой мощности.

А применение термоэлементов с тепловыми трубками мне видится и вовсе бессмысленным. В традиционной схеме с воздушным радиатором смысл термоэлемента в том, чтобы увеличить температуру радиатора, т.к. от неё напрямую зависит скорость теплопередачи радиатор->воздух, т.е. производительность радиатора. Могу ошибаться, но у тепловых трубок производительность мало зависит от температуры при условии, что она выше температуры кипения теплоносителя.

webself Автор

24.05.2019 09:47Еще раз спасибо за очень полезные комментарии. Все так. Уточню смысл применения КТТ в серверах. КТТ позволяют отказаться от части вентиляторов, не сильно значительно, но снижая потребляемую мощность этой подсистемы. Основная заметная экономия выходит за счет того, что в нашем варианте для охлаждения ЦОДа требуется гораздо меньше кондиционирования. А это снижение затрат и на приобретение кондиционеров, и на электричество и на резервирование. Будет пост с подробными расчетами для обсуждения.

drWhy

24.05.2019 12:48Кроме дополнительного тепловыделения недостаток элементов Пельтье — в возможном образовании конденсата, а то и в обмерзании. Т.е. использовать их без мониторинга и управления в серверах нельзя. А регуляторы на десятки ампер добавят свою лепту в общее тепловыделение.

vvzvlad

23.05.2019 14:15Наглядный пример двух вещей: эффекта данинга-крюгера и бесполезности "идей" в чистом виде(кражи которых так опасаются стартаперы).

Arcuen

23.05.2019 15:08Крюгерами с Данингами и не пахнет. Сам делал рабочий прототип PID-регулятора для такой системы, видел воочую цифры, считал теплоёмкости и прочее.

vvzvlad

23.05.2019 21:52Если бы не пахло, вы бы были в курсе, сколько через такой элемент можно прокачать энергии, какой у него кпд, и задуматься, почему же такую замечательную штуку столь мало используют в системах охлаждения.

Arcuen

23.05.2019 23:21Работал некоторое время в фирме в Германии, где такие решения вполне успешно продавались. В основном для охлаждения оптических сенсоров в промышленности.

webself Автор

24.05.2019 07:03А название фирмы не вспомните? Теперь интересно становится. С элементами Пельтье были мысли поработать и даже немного экспериментировали, но это не привело к ожидаемому эффекту.

Detuner

24.05.2019 10:33+1В основном для охлаждения оптических сенсоров в промышленности.

Дайте угадаю требования к охлаждению оптических сенсоров: минимальная температура (чем ниже, тем меньше шумит сенсор) и отсутствие вибрации. При этом тепловая мощность небольшая, её можно отвести на пассивный радиатор вменяемых размеров.

Arcuen

24.05.2019 10:45Да, для оптических сенсоров хватало десятков ватт. Но были и проекты с охлаждением процессоров. И низкая температура достигается за счёт создания мощного теплового потока.

webself Автор

24.05.2019 22:45В серверах реально мы боремся за энергоэффективность. Никому не нужно решение, которое сделает процессор сервера холоднее, но будет жрать х2 мощности.

vvzvlad

24.05.2019 22:00И не особая критичность к общему кпд системы, лишь бы данные с сенсора качественными были.

voshka

23.05.2019 11:56webself какой теплоноситель Вы используете, и возникают ли проблемы с «незапуском» КТТ?

На одном из фото насос установлен вертикально, это не сказывается на работе КТТ?

webself Автор

23.05.2019 17:25Теплоносители разные используются. Это может быть аммиак, может фреон, есть еще ряд вариантов. Всё зависит от условий применения КТТ, мощности нагрузки и т.д. Проблемы с «незапуском» бывают, мы их решаем. КТТ могут работать при любом положении и даже в условиях микрогравитации. Для запуска КТТ должны быть выполнены определенные условия на этапе ее проектирования и изготовления. В том числе и подбор теплоносителя.

c_kotik

23.05.2019 14:47На правах бреда — можно сделать боковинах юнита (или любую другую стенку корпуса) в виде теплообменной пластины.

И на стойке под боковины такую же пластину с трубкой СЖО для теплообмена. Площадь будет возможно достаточно большой, что бы не прибегать к термопасте.

Detuner

24.05.2019 11:52сделать боковинах юнита (или любую другую стенку корпуса) в виде теплообменной пластины

Тогда уж логичнее сделать теплообменником дно корпуса. Не придётся совмещать теплообменник с рельсами, а пластины жидкостного охлаждения можно размещать «бутербродом» между серверами. Для стандартных стоек придётся делать сервера форм-фактора 0,5U и 1,5U, чтобы оставить между ними место под пластины, либо делать нестандартные стойки, т.к. занимать пластиной целый юнит явно никто не захочет. В таком виде оно реально могло бы работать, если бы не одно «но»: если уж мы втыкаем водяные теплообменники между серверами, проще и удобнее встроить эту пластину прямо в корпус и подключать его гибкими шлангами к стоечной магистрали.

Мне представляется разумной такая конструкция: вставляем в корпус сервера один водоблок-теплообменник с двумя штуцерами, выходящими наружу в задней части корпуса. Теплообменник максимально простой и надёжный, никаких водяных трубок, соединений и хомутов внутри сервера, вероятность протечки внутрь минимальная. А тепловые трубки использовать для передачи тепла от процессоров к этому теплообменнику. Плюсов множество: можно выдвигать сервер не отключая охлаждение, можно унифицировать теплообменники (вплоть до форм-фактора карты PCI-E), не нужно решать проблему с тепловым контактом в разъёмном соединении без термопасты.

vibornoff

24.05.2019 12:35habr.com/ru/company/thercon/blog/452910/#comment_20189840

Человек утверждает, что разницы с традиционной водянкой в таком случае нет.

Как по мне, так лукавит.

Но это их дело — им и карты в руки.

rudnik85

23.05.2019 21:10Внутри — Intel Core i7-7700K, Nvidia GTX1080,

Я правильно понимаю что видеокарта тоже сделана на тепловых трубках и выведена на радиатор?

Извините, а сколько стоит такой комп? Он потом вообще потом ремонтопригоден? Или при подыхании, к примеру, видеокарточки нужно отвозить к Вам?

Есть ли вариант отправить Вам комплектуху, а вы упакуете это в корпус? Цена вопроса?(Можно сильно примерно)

webself Автор

23.05.2019 21:20Да, там две подсистемы охлаждения на тепловых трубках. И два здоровых радиатора. Процессор охлаждается на один радиатор, видеокарта — на другой. Что вы понимаете под ремонтопригодностью? Разобрать при желании это хозяйство можно. А поменять мать или видяху — вряд ли. Потому что трубки под конкретные модели сделаны матерей и видиокарт. Система охлаждения, как у желтого, обойдется в 50-60к примерно.

rudnik85

23.05.2019 21:40Да понятно, что разобрать можно всё что угодно, вопрос обычно в дальнейшей сборке до работоспособного состояния.

Понятно. Т.е. получается полу-одноразовый комп, потому что если сдохнет мать или видяха, либо всё разбирать и потом пихать в обычный корпус, либо за денежку отправлять Вам…

Исчезает та гиковская магия быстрой разборки компа и работы «потрохов» на столе, это так, к слову.

У жёлтого видяха 1060? Интересует корпус пол самую популярную мощную видюшку 1080

drWhy

24.05.2019 13:16Английская компания AMEC Thermasol производит плоские алюминиевые тепловые трубки серии MHP. При толщине 1.2-2.5, ширине 20-50 и длине 100-500 мм отводят до 300 Вт тепловой мощности. Допускается изгибание (в т.ч. «Z», «U»), радиус изгиба 2-6 мм. Положение — любое, конечно с потерей кпд относительно оптимального (вертикального, нагреватель снизу).

Наполнены трубки ацетоном, температура кипения 56°C — идеально для электроники и, в отличие от воды не нужно снижать давление в ТТ. Также ацетон обладает низкой электропроводностью. Горюч, но летуч, за счёт чего вероятность воспламенения при протекании можно оценивать как низкую.

Цена 12-25 евро/шт.

Вопросы вызывает способ прижима мягкой трубки к радиаторам.

cahbe

Я не совсем понял — а в чём именно тут необычность и нестандартность? Вы удлинили тепловые трубки? Вроде как году эдак в 2005 этим баловались домашние разгонщики, собирая подобные системы из синей изоленты, шнурка и медной трубки от кондиционера в домашних условиях. И даже без истории про сложность прохождения охраны на режимном обьекте, коим являются практически все заводы.

webself Автор

Чем КТТ отличаются от обычных тепловых трубок я постараюсь подробно рассказать в следующей публикации. Это про необычность и нестандартность. А вот про баловство домашних разгонщиков было бы очень интересно почитать подробнее. Может быть напишите об этом пост, раз вы хорошо в теме?

c_kotik

Возможно имелись ввиду данные статьи:

overclockers.ru/lab/show/17937/Esche_raz_o_kustarnom_izgotovlenii_teplovyh_trubok

overclockers.ru/lab/show/15686/teplovaya-trubka-svoimi-rukami-doma-na-kolenke

webself Автор

Спасибо, изучу.

voshka

Вам стоит изучить в чем разница между тепловой трубой и контурной тепловой трубой.