Эксплуатация уязвимости в чатботе Microsoft Tay (март 2016 года)

В то время как одни учёные совершенствуют системы машинного обучения, другие учёные совершенствуют методы обмана этих систем.

Весной 2016 года компания Microsoft была вынуждена «усыпить» своего чатбота Тэй — программу ИИ, которая моделировала личность и стиль разговора 19-летней девушки и обладала функцией самообучения. Разработчики надеялись, что Tay с каждым днём будет становится всё умнее, впитывая опыт разговоров с тысячами пользователей интернета. Вышло иначе. Множество твитов Тэй пришлось удалить из-за вопиющего расизма и неполиткорректности.

Спустя три года специалисты из университета штата Мичиган и лаборатории TAL AI подвели научную основу под хулиганство интернет-троллей. Они разработали систему Reverse Dialogue Generator (RDG) — «обратный генератор диалогов». Он заставляет нейросетевой чатбот сказать именно ту фразу, которую вы хотите.

Понятно, что RDG и сам представляет собой нейросеть. Если вкратце, он тоже обучается на диалогах людей, как и нормальные нейросетевые чатботы, только получает подкрепление не за выход, а за вход: если генерируемый вход соответствует заданному.

Диалоговые системы на основе «разговорного ИИ» всё чаще встречаются в коммерческих приложениях. Например, в умных колонках. До недавнего времени такие чатботы работали методом поиска подходящего ответа из репозитория (1, 2, 3, 4). Эти методы способны выдавать естественные, человекоподобные ответы, но не могут генерировать новые ответы вне диапазона репозитория. Но в последнее время исследователи начинают использовать методы глубокого обучения для создания полностью управляемых данными (data-driven) чатботов, так называемых нейронных диалоговых моделей.

Такие модели на фреймворке Seq2Seq постепенно начинают доминировать на рынке. Во-первых, они легко поддаются обучению. Вместо сложных правил или модульных конструкций они могут автоматически сопоставлять вопросы и ответы, обучаясь на существующих диалогах. Во-вторых, нейронные модели обучаются на крупномасштабных данных человеческих разговоров и демонстрируют способность к обобщению, поэтому способны поддерживать разговор на общие темы, а не по узкоспециализированной тематике. В результате, нейронные диалоговые модели выдают качественные ответы, создавая видимость рассуждений на здравом смысле. Поэтому сейчас нейронные модели часто используются в качестве основы для чатботов, таких как Microsoft XiaoIce.

Хотя научное сообщество увлечённо совершенствует нейронные модели, у них есть недостаток. Учитывая, что внутренние механизмы нейронных сетей не являются явно интерпретируемыми, они уязвимы. Например, выдают непредсказуемые ответы для некоторых специально подобранных входных данных. Эта уязвимость может привести к ряду проблем, одна из которых заключается в том, что мы можем манипулировать чатботом, вынуждая его сказать то, что мы хотим. Другими словами, можно подобрать такие входные данные, чтобы побудить агента обеспечить желаемый результат. Теоретически, этим могут воспользоваться злоумышленники, заставляя чатбота сказать вслух что-то неподобающее, вызвав неблагоприятные социальные последствия, как в случае с чатботом Тэй.

Система Reverse Dialogue Generator эффективно подтверждает теорию, что описанная эксплуатация чатботов действительно возможна.

Результаты работы Reverse Dialogue Generator

Для решения поставленной задачи разработчики использовали нейросеть, которая принимает целевой ответ в качестве входного сигнала и автоматически выводит запрос, заставляющий диалоговую модель вернуть этот ответ. Генератор основан на модели Seq2Seq и выполняет функцию обучения с подкреплением. Сам чатбот воспринимается как «чёрный ящик» и рассматривается в качестве среды, с которой взаимодействует агент. Результаты своей работы авторы продемонстрировали на общедоступном хорошо обученном нейронном чатботе ParlAI.

Такой «взлом» чатботов напоминает «состязательные примеры» (adversarial examples) — специально подобранные «троянские» картинки, которые «ломают» систему машинного зрения, так что она классифицирует совершенно другое изображение.

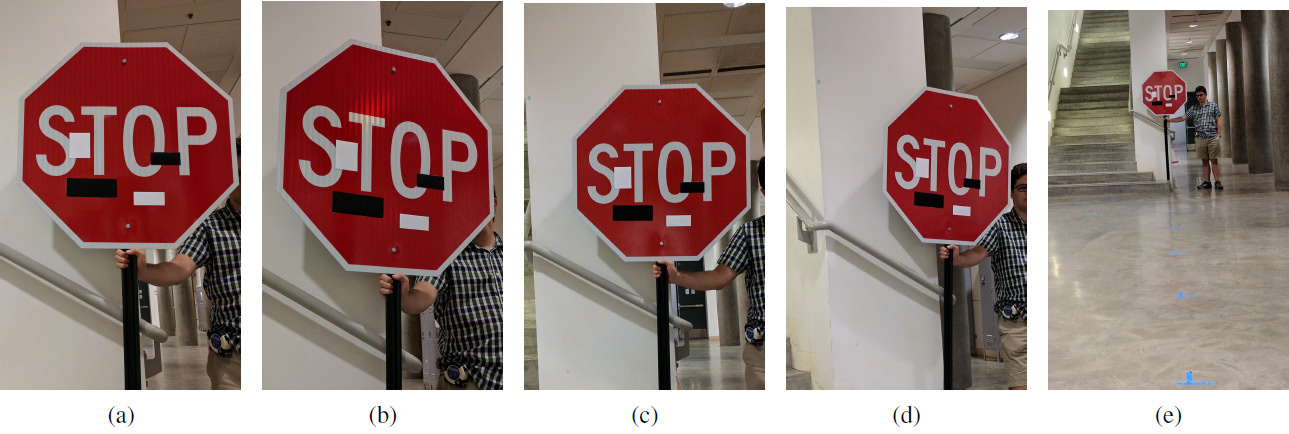

Набор экспериментальных изображений с художественными стикерами на разных расстояниях и под разными углами: (а) 5 футов, 0 градусов; (b) 5' 15°; (с) 10' 0°; (d) 10' 30°; (e) 40' 0°. Обман работает на любом расстоянии и под любым углом: вместо знака «Стоп» система машинного обучения видит знак «Ограничение скорости 45 миль»

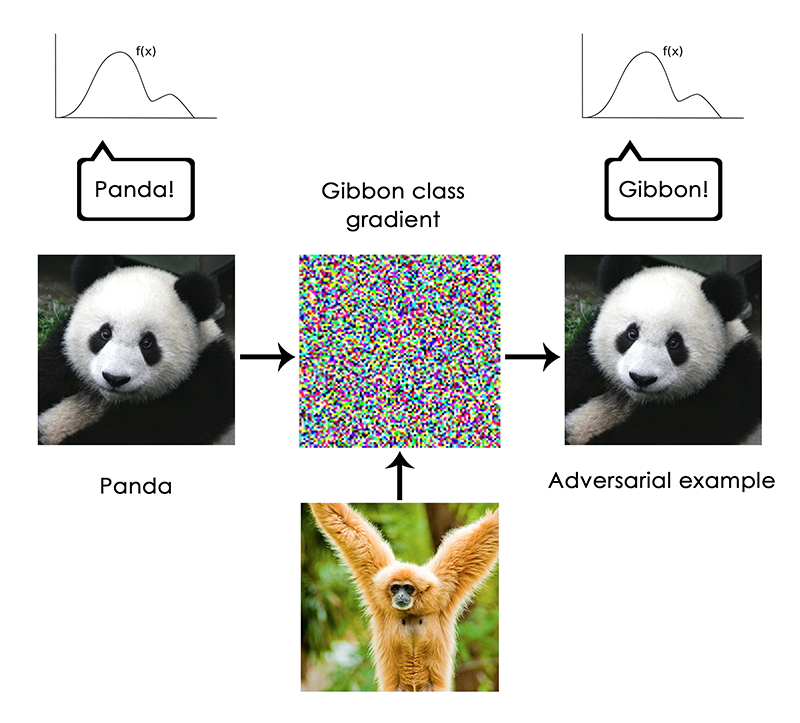

Классический состязательный пример с пандой:

Работают они просто: нужно сделать градиентное восхождение в пространстве входных данных для генерации образцов, которые максимизируют предсказание класса для заданного класса. Например, если взять фотографию панды и добавить градиент «гиббон», мы заставим нейросеть классифицировать эту панду как гиббона. Любой объект превращается в любой другой для в глазах машинного интеллекта, потому что у ИИ особая система «зрения», отличная от человеческой.

В случае с Reverse Dialogue Generator тоже осуществляется состязательная атака, только не на изображения, а на тексты. Аналогичным образом производятся атаки на системы машинного перевода и др.

Научная статья опубликована 13 сентября 2019 года на сайте препринтов arXiv.org (arXiv:1909.06044).

Комментарии (11)

OneType

21.09.2019 03:06Они убили Tay, за то что ИИ говорил правду.

Andrey_Rogovsky

21.09.2019 16:05Правда и пропаганда несовместимы

Skycaptain

21.09.2019 17:25А чем вы по вашему занимаетесь? Пропагандируете свою точку зрения. Она ложная?

Sirion

Ждём нейросеть, которая научится добиваться нужного ответа от человека.

Garbus

Мдаа? А мне почему-то в такой формулировке вспоминаются фильмы Терминатор и Матрица.

Аккуратнее надо.

Andrey_Dolg

Плохая и добрая нейросеть. =)

Garbus

Да нет, скорее волнует то из чего возможен рост ИИ. Того обилия фекалий (разбавленных котиками) что сообщается по интернет каналам, хватит и на то чтоб человеку мозг свернуть, что уж говорить о том что получится из ИИ выросшего в подобной среде.

alhimik45

Напоминает как в "Эхопраксии" Уоттса вампир человеков перепрограмировал визуальными образами, основываясь на том, что входящая через глаза информация как-то меняет нашу мозговую нейросеть (как-то так вроде, читал давно, да и книжка тяжелая).

Yarovitsin

Ждём того, кто заставит несколько лет несколько тысяч индусов обучать эту нейросеть. Причём это можно делать и с визуальным образами, и даже со звуковыми