Исследователи из Бингемтонского университета совместно с сотрудником компании Intel разработали методику, которая позволяет определять дипфейки с заменой лиц. Метод работает на основе невидимых для глаза изменений цвета кожи, обусловленных кровообращением.

Свой метод Умур Айбарс Чифтчи, Лиджун Инь и Илке Демир описали в статье под названием «FakeCatcher: обнаружение искусственно созданных видео при помощи биологических сигналов». Они объясняют, что на настоящей видеосъёмке лица человека есть слабые изменения цвета, вызванные особенностями кровообращения. Такие изменения можно обнаружить на 32 точках с помощью фотоплетизмограммы (ППГ).

ППГ позволяет регистрировать изменения кровяного потока с использованием источника инфракрасного или светового излучения и фоторезистора или фототранзистора. ППГ нередко используется для наблюдения за состоянием новорождённых без прикрепления каких-либо датчиков к их коже.

Дипфейки не лишены таких изменений цвета кожи, вызванных кровообращением, но они не воссоздают их с высокой точностью. Исследователи из Бингемтонского университета и Intel обнаружили, что эти биологические сигналы на искусственно созданных видео несогласованны и нестабильны.

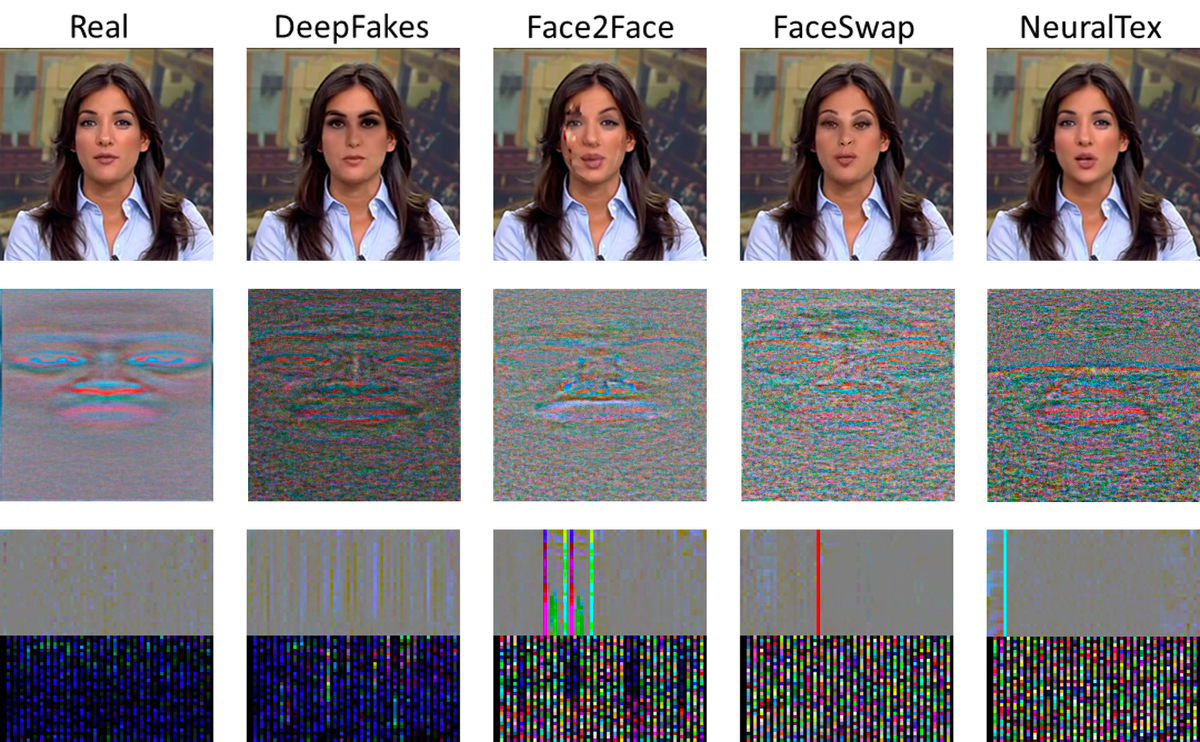

Несоответствия в изменениях цвета лица, обнаруженные в дипфейках, предоставили исследователям основу для создания собственной системы глубокого обучения, которая получила название FakeCatcher. Данная система способна обнаруживать дипфейки с точностью более 90%. В экспериментах с собственными наборами видеоданных метод исследователей обнаруживал дипфейки с точностью 97,3%. Система также обнаруживала дипфейки из датасета FaceForensics ++ с точностью 93,4%.

Ранее исследователи из Alibaba Group, Университета Кюсю, Технологического университета Наньян и Тяньцзиньского университета представили DeepRhythm, модель обнаружения дипфейков, которая также распознаёт изменения цвета лица, вызванные кровообращением. Обе группы исследователей заявляют, что в будущей работе хотят изучить способы объединения своих систем с существующими методами распознавания видео-дипфейков. Это позволило бы им найти более точные и надежные способы определения искусственных видео.

В июне инженеры Disney Research представили нейросеть, которая заменяет лица на фотографиях и в видео. Замена осуществляется в полностью автоматизированном режиме. Дипфейк реалистично заменяет мимику и речь в соответствии с оригиналом. Замена лиц может стать высококачественным инструментом для студий визуальных эффектов, работающих над голливудскими блокбастерами. Возможно, систему будут использовать для реалистичной подделки видеозаписей в целях развлечения.

oisee

Точно, еще 2012 года была работа на эту тему:

anatoly314

Ха ха, так, а в чем проблема, чтобы научить ее создавать эти точки в высоком разрешении?

balamutang

Насколько я понимаю там суть в том что в момент удара сердца кожа краснеет на 1%, а потом бледнеет обратно.

Дописать алгоритм дипфейка чтоб он менял цвет на 1% 60 раз в минуту вроде не так уж сложно

Coline

Я не разбираюсь в теме, но у меня вопрос — а она разве уже не учитывает с момента её создания? Дипфейк это же нейросеть, так? Нейросеть обучается на входных данных. Входными данными для дипфейка, насколько я помню, является видео, разобранное на кадры. Видео снимают в привычном человеку диапазоне видимого света. Если эту разницу можно увидеть, значит и на видео она должна быть зафиксированна. Значит, и нейросеть будет вкурсе, что цвет меняется, потому что это было в её входных данных и она, с моей точки зрения, должна была учитывать этот момент, потому что её учили воспроизводить то, что она видела. Если эту разницу нельзя увидеть, то и на видео она зафиксированна на будет. Значит, и пытаться ответить на вопрос «фейк или нет» по этому признаку было бы бессмысленно

balamutang

Я тоже не спец, но насколько понимаю нейросеть просто «натягивает маску», насчет цвета не уверен, скорее всего цвет берется средний на лице в видео, лишь бы «швы» совпали, врядли он там пульсирует как надо. Но теперь будет.

PrinceKorwin

Сеть обучают на изображениях малого размера. Там эти эффекты могут быть нивелированы.

staticmain

Скорее всего, как и сказано в статье,

. Т.е. оно 60 ударов, но не/\__/\__/\__/\__а что-то типа/\__/\__/|_/|_/\__|\|\__/\__Alert1234

можно переносить нестабильную часть с оригинального изображения на дипфейк

staticmain

Дипфейки делаются нейросетью, там нельзя руками впихнуть дополнительные условия.

Разве что каким-то волшебным образом гасить все колебания цвета на итоговом видео в ноль, а потом накладывать их ритмичный вариант уже вне зоны компетенции нейросети в полуавтоматическом режиме

xapienz

Можно скормить нейросети две группы видео, где в одной группе есть сигналы циркуляции крови, а в другой нет, нейросеть научится.

Если получить доступ к алгоритму исследователей, то дообучить нейросеть на результатах этого алгоритма.

Alert1234

Для вас «нейросеть» прямо неделимый черный ящик. На каждое подсвойство можно свою нейросеть сделать и обучить, хоть ушами шевелить заставить в такт движениям челюсти. К тому же сложный результат будет делаться комплексно, кроме нейросети и алгоритмические возможности можно применять.

Moskus

Эту разницу можно увидеть (как иначе работает сам метод motion amplification?), вопрос в том, как происходило обучение, считались ли эти изменения полезным сигналом или случайным шумом.

Coline

То есть, получается, весь смысл такой

— есть множество всех изменений, происходящих с лицом, которые можно зафиксировать в видимом диапазоне

— есть изменения, являющиеся подмножеством множества выше, которые ввиду настроек обучения и/или хотелки создателей, не будут регистрироваться нейросетью

— поиск ответа на вопрос дипфейк или нет, будет строиться поиске и эксплуатации такого множества

Moskus

Где-то так. Могу предположить, что и другие изменения, которые и могут быть усилены технологией motion amplification, могут быть взяты в оборот. Например, какие-то микродвижения, которые связаны с речью, звуком, вибрацией, действием механики оптического стабилизатора камеры (если камера не статична).

lucius

Идея отличная, думаю что она хорошо бы сработала на том соревновании на Каггле за 1кк$.

Хотя в будущем просто будут полностью сглаживать следы циркуляции крови и накладывать новые цельные, просто в качестве постобработки.

anatoly314

Я думаю в будущем у каждого видео будет цифровая подпись которая будет проверятся каким то образом, подписываться сертификатом и т.д… Если подписи нет, то видео не будет считаться аутентичным. Это в случае с оффициальными видео, политики и т.д. Все остальное аудио/видео будет считаться априори подделкой.

vikarti

Уже было в фантастике. Хроники 33 миров Борис Иванов.

Класс железок назван «полицейским регистратором» (причем прямо сказано что это отдельная железка, даже с защитой от вскрытия), полиция обычно использует монструозные варианты но есть дорогие и элегантные. Можно свободно купить. Видео с регистратора автоматом принимается как доказательство.

Там же кстати интересный момент с глобальной сетью и что будет если объявить что-то несуществующим(не секретным а именно несуществующим) (ГГ нашел разницу в данных между тем что в сети и тем что в бумажном архиве, пошел к хакеру чтобы узнать кто поправил в сети, какие полные данные в сети из-за этого были удалены и так далее. Хакер даже денег брать не стал после того как ему показали различие в данных — просто с его точки зрения явная ложь в планетарной сети в сочетании с механизмами контроля целостности глобальной сети может вообще порушить многое. Заказчика установили и ему слили а исполнитель ГГ был и не и не нужен).

alex6999

Посмотрите сериал The Capture, как раз про дипфейки.

Moskus

Adobe недавно трубили о подобной технологии для "доверенных фото".

vikarti

И как они это контролировать будут если не контролируют полностью устройство ?

(причем тут мало будет даже вусмерть залоченной прошивки — надо какую то защиту от «поставили экран перед камерой и на экране — то что надо» — а значит ставить например минимальный 3D-сканер благо уже делают — FaceID так работает ну и Kinect старый)

Moskus

Конкретно Adobe хотят не совсем этого — они хотят позволить редактировать фотографии, но сохранить возможность надёжно проследить связь между тем, что поступило на вход редактора и получилось на его выходе.

Но, в конечном счёте, это действительно просто дань моде, точнее — паранойе на тему поддельных фото.

granvi

И как же система увидит это через слой макияжа?

BlackSCORPION

А разве deepfake уже научился делать что то реалистичное?

В Голливуде на сколько знаю, до сих пор применяют motion capture технологии, и все равно получается такое себе, когда смотрел Gemini в кинотеатре, мыльно пластилиновое лицо молодого Уилл Смита оставило неприятное впечатление.

В Ирландце незаметно получилось омолодить Роберта Де Ниро, но там совсем лайтово, я думал грим, пока не увидел на ютубе видео о том как его снимали )

anonymous

Мне кажется ученые скушали какой-то грант и предложили фигню за эти деньги.

Что делать с макияжем, гримом, болезнями, тенями, веснушками, родимыми пятнами и тд?

Да и просто дообучить модель генерировать такие признаки.

anonymous

Минисующему: а почему бы не написать ответ, что не так в моем комментарии? Выглядит как простое выливание злобы на окружающих.

glagola

Прикольно, как сами исследователи, публикуя свои идеи по идентификации дипфейков — развивают и совершенствуют дипфейки…