Интернет наполнен самыми причудливыми фотографиями и видео знаменитостей. Кто-то пробуется на новые роли, делает вызывающие заявления, выступает в не самых благоприятных образах, неожиданно снимается в фильмах 18+ и творит прочие абсурдности. В общем-то, человек — хозяин своей судьбы, поэтому переживать за всех этих людей не стоит. Но проблема в том, что новые технологии позволяют «подставить» даже вполне здравомыслящего человека, создав дипфейк, видео или фото. Но и от этой «болезни» нашлось лекарство.

Ученые из Университета штата Нью-Йорк в Буффало предложили надежный способ, позволяющий отличить дипфейковое изображение от настоящего. В основе решения — отражение в глазах человека. Как ни странно, но искусственно сгенерированное сетью GAN-изображение имеет отличия в бликах и отражении в глазах.

Лицо VS дипфейк

За последние годы технологии изменения лица на фотографиях получила новые виток разивтия. Отличить настоящее фото от скомпилированного стало почти невозможно. Выявить подделки не могут даже алгоритмы. И неудивительно, вся эта сфера развивается по спирали с догоняющим эффектом. Что это значит? Пока одна сторона создает новые технологии подмены лица, другая — работает над программами обнаружения этих фейков. Процесс так и не заканчивается, а постоянные усовершенствования приводят к спиральной динамике во всех сферах, связанных с созданием/обнаружением дипфейков.

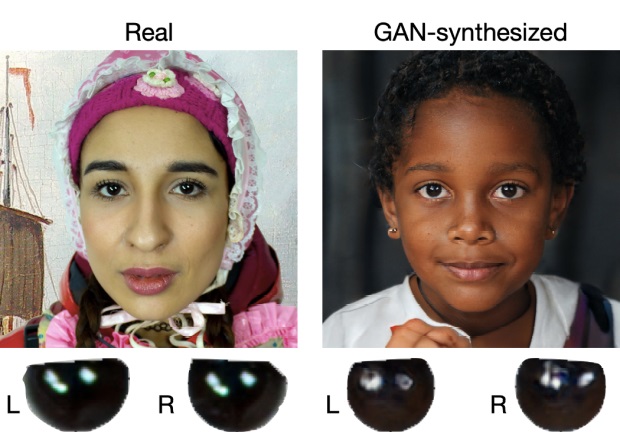

Так что там с отражениями? Глаза человека находятся ближе между собой, чем источник света. Когда мы берем реальную фотографию, то ее отражения в нашем правом и левом глазах одинаковые. Они могут иметь отличия, но незначительные. Так вот, в алгоритмах для подмены изображений отсутствуют «физические ограничения, описывающие поведение отражений». Как итог, создаваемые сетью лица имеют отличные между собой отражения и блики.

Как работает новый алгоритм?

Для правильной работы алгоритма необходимо соблюдение следующих условий:

- Оба глаза смотрят в камеру. Линия, соединяющая глаза, параллельна камере.

- Глаза отдалены от источника света или отражения.

- Источники света или отражатели видимы обоими глазами.

Затем запускается алгоритм. И работает он по следующей схеме:

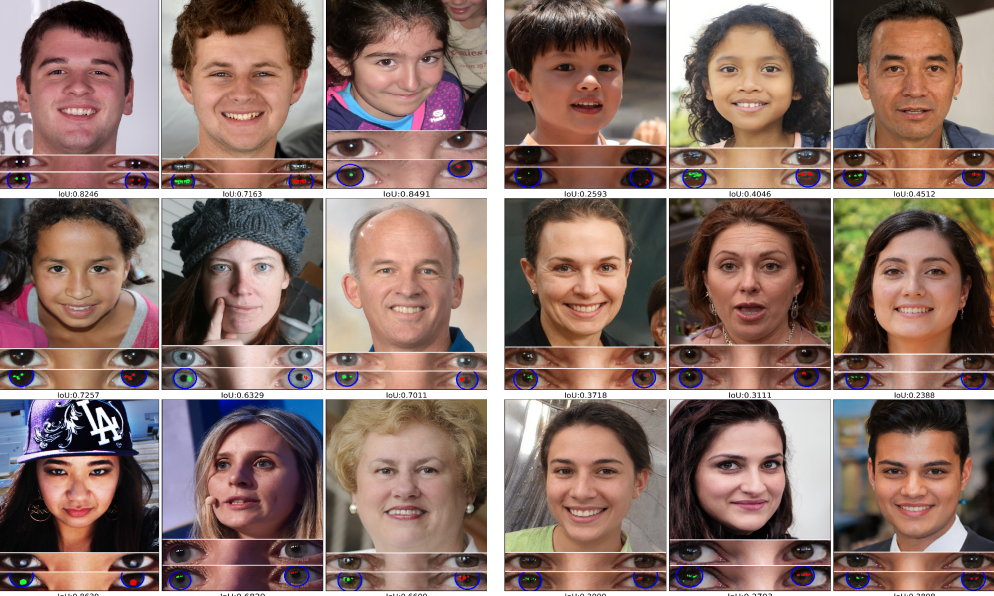

- Алгоритм находит на фотографии лицо.

- Обозначает контур лица и размечает реперные точки: кончики глаз, рот, нос, брови.

- На основании ключевых точек вырезает область глаз, ограниченную радужной оболочкой.

- Затем включается механизм бинаризации. Если яркость пикселей выше пороговых значений, то они отмечаются черным цветом, остальные оставляют белыми.

- Получают два изображения: в правом и левом глазах.

- С помощью коэффициента Жаккара сравнивают их идентичность.

Оценка результатов

Для оценки эффективности и работоспособности алгоритма ученые использовали две выборки:

- реальные лица из Flickr-Faces-HQ;

- искусственно созданные нейросетью StyleGAN2 лица с ресурса This Person Does Not Exist.

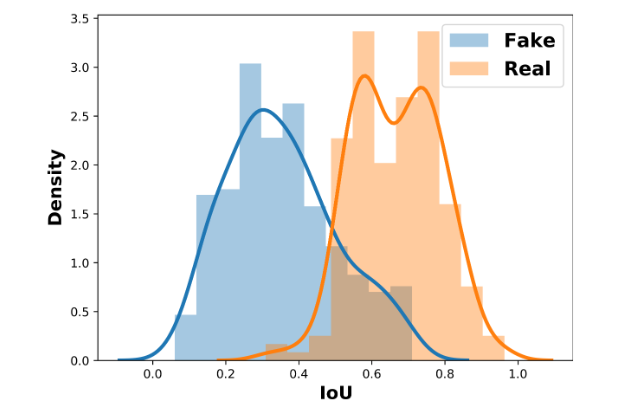

Собрав необходимые данные, они построили график. Также добавили для анализа ROC-кривую.

На графике видно, что идентифицировать лица, реальные или сгенерированные, удалось с точностью 94%. Результат впечатляющий.

Но есть и минус. Алгоритм отлично работает с портретным изображением и ярким светом. То есть практически в идеальных условиях. Помимо этого, алгоритм сравнивает не форму изображение в целом, а разбивает фотографии на пиксели.

Боли дипфейков

Авторство технологии дипфейка, появившейся в 2014 году, приписывают студенту Стэнфорда Яну Гудфеллоу. Ее долго использовали среди разработчиков в научных целях. Но уже через три года один из пользователей Reddit заменил с помощью технологии лица знаменитостей в порнофильмах. И понеслось.

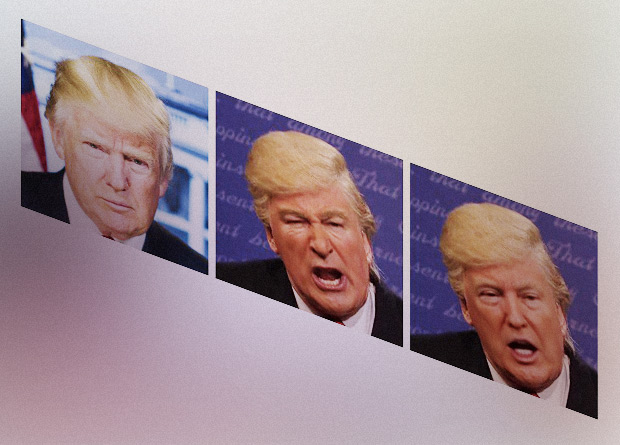

Два самых распространенных варианта применения ложных изображений — это троллинг знаменитостей и политические манипуляции.

Палата представителей конгресса США увидела реальную угрозу в существовании технологии. И считает, что дипфейки представляют угрозу национальной безопасности. В Калифорнии в итоге запретили на законодательном уровне распространение дипфейков с кандидатами во время выборных кампаний.

ScratchBoom

Наконец-то глаза на дип фейках перестанут быть косыми.