Разработчиков искусственного интеллекта (ИИ) призвали приостановить обучение мощных систем, базирующихся на машинном обучении. Эксперты из крупных компаний считают, что необходим перерыв в исследованиях, чтобы избежать рисков. Кто-то считает, что огромные объёмы созданной ИИ информации не позволят людям отличать правду от лжи.

Выработка принципов и стандартов, которые помогут обеспечить безопасность и этичность использования ИИ, чрезвычайно важна для дальнейшего развития этих технологий.

В статье рассмотрим некоторые этические аспекты ИИ.

Проблема мирового масштаба

Некоммерческая организация Future of Life опубликовала письмо за подписью главы Tesla, SpaceX и Twitter Илона Маска, одного из создателей Apple Стива Возняка, сооснователя Pinterest Эвана Шарпа и ещё более тысячи экспертов в области ИИ.

Они настаивают на перерыве в исследованиях до появления общих протоколов безопасности. В обращении говорится, что системы с интеллектом, сравнимым с человеческим, представляют большой риск для общества.

К числу тех, кто видит в развитии ИИ опасность для человечества, присоединился после увольнения из Google один из основоположников нейросетей Джеффри Хинтон. По его мнению, созданный ИИ новостной контент (фото, видео, тексты) наводнит Интернет, и люди не смогут отличить правдивую информацию от ложной. Он также заявил, что технологии со временем трансформируют рынок труда, заменив людей в некоторых областях.

Присутствие ИИ в повседневности вызывает множество этических вопросов, которые с каждым годом становятся всё острее. Среди наиболее заметных примеров – смертельные ДТП с участием самоуправляемых автомобилей Tesla и Uber. Немаловажные проблемы в сфере использования ИИ касаются, в том числе, манипулирования информацией и различного рода дискриминацией.

Ответственность и прозрачность ИИ

Одна из самых популярных этических задач заключена в так называемой «проблеме вагонетки» – мысленном эксперименте, состоящем из набора ситуаций, когда необходимо выбрать одно из решений, чтобы обойтись минимальным числом жертв. В случае с беспилотным автомобилем алгоритмы ИИ должны просчитать, как лучше поступить в экстренных случаях на дороге: свернуть, создав угрозу для пассажиров, либо продолжать движение, подвергнув опасности нарушителей ПДД.

Чтобы помочь ИИ сделать такой выбор, в Массачусетском технологическом институте предлагают людям пройти тест. Его результаты лягут в основу алгоритмов, благодаря которым ИИ будет решать, как поступить в экстремальных ситуациях.

Респонденты поставлены перед выбором: разбить автомобиль, убив пассажиров, или совершить смертельный наезд на пешеходов.

Из проведенного опроса следует, что как сторонние наблюдатели люди в большинстве случаев стремятся указать наиболее рациональное решение, в основном принося в жертву пассажиров самоуправляемого автомобиля. Однако в роли пассажиров большинство выбирает тот вариант, который ставит их безопасность на первое место. Появляется новая этическая дилемма: дорожное движение с появлением самоуправляемых автомобилей станет безопаснее только благодаря применению алгоритмов ИИ, которые люди отклоняют в качестве неприемлемых для себя. Данный фактор может повлиять на будущий спрос и принятие решений о покупке таких автомобилей.

И тем не менее важной задачей при создании ИИ является определение границ ответственности системы. В настоящее время законодательство не признаёт ИИ субъектом права и не предусматривает его ответственности за возможные происшествия. Создатель ИИ владеет алгоритмами, но результат, полученный в результате их использования, может оказаться непредсказуемым. Итог работы алгоритма сильно зависит от входных данных, и разработчик не всегда может гарантировать его точность. В такой ситуации необходимо определить, кто несет ответственность, поскольку ИИ может быть сконструирован командой специалистов.

Процессы принятия решений ИИ должны быть прозрачными, чтобы существовала возможность отслеживать его действия и своевременно выявлять проблемы в функционировании. Однако некоторые алгоритмы могут быть слишком сложными для понимания человеком. В таких случаях возникает проблема контроля ИИ.

Предвзятость алгоритмов

Казалось бы, искусственный интеллект должен работать и принимать решения с холодным разумом как любая машина.

Однако его создатели являются обладателями когнитивных искажений, которые невольно наследуют разрабатываемые системы, что способствует появлению предвзятостей в алгоритмах.

Их исключение – одно из сложностей при использовании ИИ. Информация, которая поступает в систему, должна быть неискаженной, достоверной, а главное – не содержать в себе предубеждения. Некорректная работа алгоритмов может привести к дискриминации или несправедливым решениям в отношении человека.

Например, боты занимаются сбором изображений лиц людей в интернете. Описания к ним вычленяются из контекста размещения. Поэтому ИИ чаще относит женщин к категории «домохозяйка» вместо, например, «доктор», исходя из сохраняющихся в обществе стереотипов. Так на уровне данных ИИ наследует предвзятость от людей.

Использование технологий ИИ подчас задевают существующие в обществе ценности. Например, нарушаются такие основополагающие принципы как расовое и гендерное равенство. Явление пристрастности ИИ получило название AI bias.

Необъективность ИИ стала причиной возмущений общественности в связи с решениями уголовно-исполнительной системы США в отношении этнических меньшинств, которые были вызваны ошибками в распознавании лиц.

Известный случай дискриминации, связанной с использованием ИИ, произошел в 2018 году. Выяснилось, что алгоритм системы судейства при определении размера залога для подозреваемых в правонарушениях оказался пристрастным к афроамериканцам.

Недавно специалист в области информатики Джон Маккормик признался в непреднамеренном создании 25 лет назад «расово предвзятого» алгоритма ИИ для распознавания лиц.

Проект заключался в отслеживании движений головы человека на основе данных с видеокамеры. Для совершенствования системы группа, в составе которой был Маккормик, пошла по пути других исследователей, установивших, что области изображения телесного цвета можно извлекать в режиме реального времени. Поэтому учёные решили сосредоточиться на цвете кожи как на дополнительной подсказке для трекера.

Маккормик сделал несколько фотографий себя и других белых людей. Так было легче вручную извлечь некоторые пиксели телесного цвета из этих изображений и построить статистическую модель для цветов кожи. После некоторой настройки и отладки удалось создать надёжную систему отслеживания в реальном времени.

(Не)доверие к ИИ

Одна из основных опасностей, которую необходимо учитывать при работе с технологиями, подобными искусственному интеллекту, – завышенное доверие к ним со стороны неспециалистов. Важно помнить, что нет идеальных систем, и даже самые надёжные из них могут выходить из строя, особенно когда им предоставляются большие возможности. Поэтому заблуждение о безошибочности ИИ может привести к ужасным последствиям, и следует придерживаться здравого смысла в оценке потенциала таких систем.

Сложные задачи, особенно с вариативными входными данными, могут приводить к ошибкам в работе ИИ. И по сей день она затруднена тем, что надёжность системы не может быть гарантирована. В особенности это актуально для задач, связанных с автономным управлением транспортными средствами. Поэтому важным аспектом является создание устойчивых систем с минимальным количеством сбоев.

Прозрачность также является ключом к построению доверия между человеком и ИИ. Непонимание людьми оснований для принятия решений система порождает сомнение в точности результатов. Пользователям необходимо понимать, как ИИ приходит к выводам и чем руководствуется, давая рекомендации.

ИИ от IBM Watson for Oncology, предоставляющий рекомендации по лечению рака, так и не смог заслужить доверие онкологов.

При взаимодействии с Watson врачи оказывались в двоякой ситуации. Когда указания программы совпадали с мнениями медиков, те не видели большой ценности в рекомендациях ИИ, поскольку они не меняли лечения. Скорее, врачи просто укреплялись в собственной правоте. Но подтвердить, что ИИ улучшает статистику выживаемости с раком, не удалось.

Если рекомендации Watson противоречили мнению экспертов, те не доверяли программе, считая её некомпетентным. Алгоритмы машинного обучения были слишком сложными для понимания, врачи не видели объяснений эффективности лечения ИИ и полагались на свой опыт, игнорируя рекомендации ИИ.

Врачи-онкологи расходились с программой Watson почти в 70% случаях, поэтому медицинские учреждения решили отказаться от ее использования.

Watson столкнулся с проблемой недоверия. Программа работает по сложной системе анализа данных, что лишает большинства понимания, как он принимает решения. Взаимодействие вызывает ощущение потери контроля. Люди предпочитали полагаться на свой опыт, а не на ИИ, за которым не могли следить в режиме реального времени.

ИИ не считается абсолютно надежным в том числе потому, что создаётся людьми. То, что нельзя полагаться на эти технологии, подтверждается примерами ошибок, громогласно освещаемых в СМИ. В частности, то ДТП с автопилотом Tesla, закончившееся смертельным исходом.

Приватность данных

Анализ метаданных может помочь улучшить качество работы ИИ, но он также вызывает вопросы о приватности и безопасности личной информации. Таким образом, при создании системы ИИ необходимо обеспечить надёжность хранения данных и защитить их от кражи или злоупотребления.

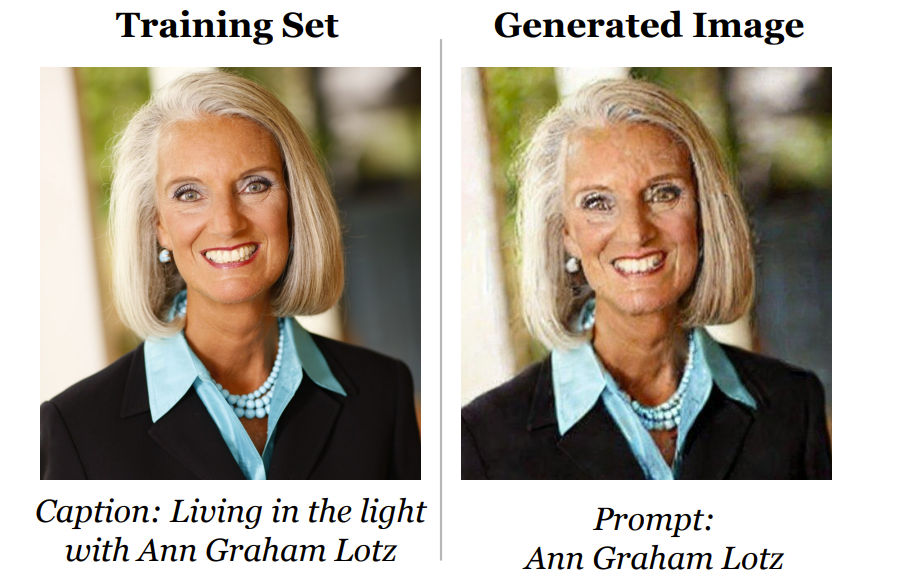

Так, исследование американских университетов Принстона и Беркли и Швейцарской высшей технической школы Цюриха совместно с Google и DeepMind подтвердило вероятность утечки данных из систем создания изображений с применением ИИ – DALL-E, Imagen и Stable Diffusion.

В ходе обучения в эти системы загружается масса изображений с сопутствующими описаниями. Исследование ставит под сомнение уникальность созданных на их основе картинок. При определённых условиях нейросеть может выдать в почти неизменённом виде оригинальное изображение, использованное ранее для обучения. Таким образом, существует вероятность того, что программа случайно раскроет личную информацию.

Этические кодексы в сфере ИИ

В связи с развитием нейросетей и машинного обучения крупнейшие ИТ-компании мира стали проявлять особый интерес к этике ИИ. В числе первых в 2016 году были опубликованы «10 Законов для искусственного интеллекта» Microsoft, в которых от имени генерального директора компании Сатьи Наделлы указаны ключевые требования к развитию этики ИИ.

Свой взгляд на этику ИИ представила и IBM.

Почти полсотни крупных ИТ-компаний по всему миру обладают собственными кодексами и правилами, основанные на этических принципах, относящихся к применению и развитию ИИ. В числе таких компаний российские ABBYY, Сбер и Яндекс.

Значительную роль в развитии этики ИИ играют некоммерческие организации, объединяющие профессионалов, которые проводят исследования и внедряют научно-технические инновации. НКО продемонстрировали углублённый подход к этике ИИ, который позволяет принимать во внимание интересы и права потребителей, а также ставит на первый план общественные нужды и благо всех людей.

Этические нормы и ценности сформулированы в 13 из «23 принципов искусственного интеллекта» на Асиломарской конференции в 2017 году. В числе тех, кто подписал их, – Илон Маск, Стивен Хокинг, Рэй Курцвайл и другие. Эти принципы отразились в корпоративных нормах ряда компаний, чья деятельность связана с разработкой ИИ.

Законодательное регулирование ИИ в России и за рубежом

Россия, как одна из передовых стран по применению искусственного интеллекта (ИИ), также сталкивается с вопросами этики и правовой ответственности. Необходимо принимать меры для того, чтобы развитие ИИ шло по безопасному пути.

C 1 июля 2020 года в Москве проводится пятилетний эксперимент, направленный на разработку и внедрение технологии ИИ для заинтересованного бизнеса. Ранее ИИ не регулировался законодательно. Между тем, использование таких технологий порождает проблемы, включая, но не ограничиваясь:

необходимостью обезличивания и защиты персональных данных, особенно в области распознавания лиц,

обеспечением доступа ИИ к большим массивам информации для полноценного развития,

разграничением ответственности за действия ИИ и возможности доказательства.

Закон 123-ФЗ от 24 апреля 2020 года устанавливает в Москве специальный правовой режим в сфере ИИ. В нём указаны требования по защите персональных данных граждан и использования псевдоданных, собираемых в режиме анонимности. В частности, допускается обработка обезличенных персональных данных граждан для реализации эксперимента.

Цель этого экспериментального правового режима – повышение качества жизни населения, эффективности госуправления и деятельности бизнеса в ходе внедрения технологий ИИ. А также формирование комплексной системы регулирования общественных отношений, возникающих в связи с развитием и использованием ИИ. Эксперимент позволит создать правовую базу для этого.

Регулирование использования ИИ разными странами мира проходит по-разному. Некоторые страны уже разработали законы и правила, а другие только занимаются подготовкой соответствующих документов.

Одна из основных областей, где применяются ИИ, – государственное управление. Использование ИИ в этой области может помочь улучшить качество услуг, снизить издержки и повысить эффективность государства в целом. Однако возникают вопросы о прозрачности и ответственности государственных систем ИИ.

В России была создана рабочая группа по разработке принципов этики ИИ. В 2021 году в рамках I международного форума «Этика искусственного интеллекта: начало доверия» был принят российский «Кодекс этики в сфере ИИ». На 2023 год документ подписали более 150 российских организаций.

Необходимость выработки этических норм и нормативного регулирования для ИИ прописана в «Национальной стратегии развития искусственного интеллекта на период до 2030 года».

Ещё один важный документ – «Концепция развития регулирования отношений в сфере технологий искусственного интеллекта и робототехники на период до 2024 года».

В ней сказано, что развитие технологий ИИ и РТ должно основываться на базовых этических нормах и предусматривать:

Цель обеспечения благополучия человека должна преобладать над иными целями разработки и применения систем ИИ и РТ.

Запрет на причинение вреда человеку по инициативе систем ИИ и РТ. По общему правилу, следует ограничивать разработку, оборот и применение систем ИИ и РТ, способных по своей инициативе целенаправленно причинять вред человеку.

Подконтрольность человеку в той мере, в которой это возможно с учётом требуемой степени автономности систем ИИ и РТ и иных обстоятельств.

Проектируемое соответствие закону, в том числе – требованиям безопасности: применение систем ИИ не должно заведомо для разработчика приводить к нарушению правовых норм.

В Европейском союзе была создана Группа ведущих экспертов по искусственному интеллекту (AI HLEG), которая занимается разработкой рекомендаций по этике. В частности, они предупреждают технологических гигантов о том, что алгоритмы не должны дискриминировать пользователей по признаку их возраста, расы или пола.

В документе сказано, что ИИ должен соответствовать требованиям установленных норм и законов, этических принципов и ценностей, быть надёжным с технической и социальной точек зрения.

Рекомендации включают необходимость учета этических вопросов на каждом этапе разработки и внедрения ИИ, прозрачности процессов, а также гарантии защиты конфиденциальности личных данных пользователей и другие меры.

Значительное внимание уделяется также этике использования ИИ в области медицины и биотехнологий. В том же документе AI HLEG предлагается, чтобы использующие ИИ эксперименты и исследования на животных и людях были этически обоснованы и согласованы с соответствующими регуляторами.

Одним из важнейших принципов в области этики ИИ является создание систем, способных сохранять уважение к человеческой жизни, достоинству и правам. Здесь, в числе прочего, необходимо учитывать культурные различия во избежание нежелательных социальных последствий.

В качестве заключения

В недавнем интервью Такеру Карлсону Илон Маск заявил, что ИИ может быть использован в качестве инструмента влияния, в том числе, на выборах. А если ИИ будет достаточно умён, неизбежно возникнет вопрос, кто кого использует: люди ИИ или ИИ людей. «Мы движемся в странном направлении, и движемся всё быстрее… Нам нужен надзорный орган. А в свою очередь, СМИ должны пристальнее следить за тем, что публикуется и печатается на их платформах. И работать с людьми, а не с GPT-ботами, притворяющимися людьми», – подчеркнул Маск.

Несмотря на все вызовы и опасности, которые стали актуальными, ИИ остаётся одной из самых перспективных технологий, которая может усилить наши возможности и упростить жизнь. Главное – помнить, что это всего лишь инструмент, который мы можем и должны использовать с максимальной осторожностью и этичностью.

Комментарии (32)

MAXH0

30.06.2023 18:38+4Как только появляется значимое открытие - появляются люди стремящиеся его закрыть или, как минимум, лицензировать.

Большинство разговоров за этику, оно конечно "в пользу бедных", но служит богатым. Ни кто не предлагает дать пользователю набор тумблеров, которыми он настроит для себя ИИ (напр. позволительно ли выдавать сексистские шутки). Просто вывод ИИ искусственно оскопляется. А это ЦЕНЗУРА.

Я приводил уже пример, когда новый чат-бот Алиса впадает в стопор при слове РУССКИЙ, чтобы никого не обидеть. https://habr.com/ru/news/741870/comments/#comment_25653424

Поэтому я считаю, что требуется направить развитие коммюнити на обучение ИИ независимого от цензуры корпораций. Благо ПОКА такая возможность есть. Биткоины майнили и никого фермы видеокарт не смущали. А обученным интеллектом уже можно торговать - затраты на запуск обученной сети не столь велики, как обучение. И тут, в отличии от биткойна есть не только условная, но и реальная ценность.

omxela

30.06.2023 18:38+3Бедные автоматы. Все вдруг стали специалистами по "их" этике. А по своей собственной слабо? Вот сейчас "они" нас будут страшно дурить. А мы друг друга не дурим веками? Нет, разумеется, я тоже не смотрю телевизор. Когда умелец виртуозно создаёт клише для печати фальшивых денег, - это, конечно, нехорошо, но хайпа никакого не содержит. Хотя вопрос, согласитесь, чувствительный и каждого касается. А вот реалистичный Байден с восемью руками (прости, Джо) на самокате на улицах Пекина - ну тут всё, терпению конец, доколе этот ИИ будет над нами издеваться? Возможно, кое-кому и придёт в голову, что это не ИИ издевается, а конкретный человек. Но это скучно. Это как всегда. То ли дело прорастающая новая небелковая форма жизни. Полёт мечты. Волнующие горизонты. Ну и, конечно, надобно бы и запретить. На всякий случай.

MountainGoat

30.06.2023 18:38Россия, как одна из передовых стран по применению искусственного интеллекта

<img=мэм_с_оглядывающимся_мужиком.jpg/>

Где?

ivansychev Автор

30.06.2023 18:38+2Например, "по данным Microsoft, 30% крупных российских компаний начали использовать ИИ, а средний показатель для США и Европы — 22,3%" (это 2021 год).

В России сегодня представлен весь портфель базовых ИИ-технологий и продуктов. Россия также входит в топ-20 стран в области исследований искусственного интеллекта с долей 2,4 % (данные iFORA Института статистических исследований и экономики знаний НИУ ВШЭ).

Беспилотники поехали по М-11 между Москвой и Санкт-Петербургом.

В столице -- на май 2023 года более 320 000 человек были зарегистрированы по биометрии в метро, то есть используют распознавание лиц для прохода.

В России есть 47 разнообразных ИИ-систем для медицины и здравоохранения, созданных Россией. ИИ решения уже себя показали после начала пандемии - они помогали врачам ставить диагнозы.

Москва занимает лидирующую позицию в мире по внедрению искусственного интеллекта в государственное здравоохранение.

remendado

30.06.2023 18:38+1В списке нет ни одного кейса, связанного с искусственным интеллектом. Все вышеперечисленное связано с использованием разработанных людьми компьютерных алгоритмов. Называют это ИИ исключительно в целях маркетинга и для получения финансирования.

Anna22K

30.06.2023 18:38+1Открываю ТГ и вижу новость: Более 150 топ-менеджеров компаний, среди которых Renault, Siemens, Blablacar, Heineken, Airbus, Ubisoft и другие, подписали открытое письмо с призывом к ЕС пересмотреть взгляды на регулирование ИИ.

Согласно одному из положений чернового акта, для работы в Европе разработчики генеративных ИИ-моделей должны будут зарегистрировать продукт через местного регулятора, пройти оценку рисков и соблюсти требования к прозрачности. Среди последних — необходимость публично раскрывать защищённые авторским правом данные, на которых обучали нейросети.

Авторы письма заявляют, что разработчикам придётся нести непомерные риски и тратить несоразмерно много денег, чтобы отвечать «жёстким» требованиям. Это приведёт к тому, что компании-«новаторы» перенесут работу в неевропейские страны, а инвесторы вслед за ними выведут капитал из местных фондов.

Сложности есть, признают подписавшиеся, но генеративный ИИ — это технология с «решающим значением» для производительности. Тот регион, где компании смогут разработать наиболее мощные модели, в итоге заполучит конкурентное преимущество, поскольку эти продукты будут формировать не только экономику, но и культуру стран…

Гонка вооружений уже перешла в гонку «ИИ». Пока еще вопрос, какой номер кому достанется.

vc.ru/future/744412

Suoriks

30.06.2023 18:38+3По моему дилемма кем жертвовать - пассажирами или пешеходами, совсем не дилемма. Пассажиров ИИ давно знает. А пешеходов в первый раз видит. Выбор очевиден :)

qw1

30.06.2023 18:38Если машина будет жертвовать водителем, её не будут покупать.

Если машина будет жертвовать пешеходами, будут протесты пешеходов, которые шли, никого не трогали, и вдруг машина на скорости 200км/ч вылетает на обочину, сбивает 30 человек, и никто за это не отвечает, потому что конвенционально мы разрешили ИИ считать жизнь водителя приоритетнее.

Arhammon

30.06.2023 18:38+1Не знаю как в штатах, но у нас официальный алгоритм "умирать в своей полосе". И выполнение каких-то своих алгоритмов вместо ПДД вызовет вопросы сразу у всех...

qw1

30.06.2023 18:38+1У живого водителя нет алгоритма "умирать". Если он едет на скорости и внезапно видит перед собой бетонный столб, он попытается свернуть на другую полосу, и плевать ему на ПДД. Если автопилот не будет так делать, то будет менее безопасным, чем ручное вождение, и его будут плохо покупать.

cupraer

30.06.2023 18:38С таким подходом велик риск обнаружить, что твой собственный ребенок с этими пешеходами (и невесть откуда приблудившимся псом) — переехал жить подальше от трафика в деревню :)

berng

30.06.2023 18:38+4Одна из основных этических проблем генеративного интеллекта проста - с наводнением интернета фейковой информацией вы не сможете в будущем использовать интернет как источник данных для тренировки новых сетей (как это делается сейчас), поскольку сети не будут знать, какая информация реальная, а какая - фейковая, сгенерированная нынешними сетями. И будущие сети при тренировке будут обрушивать свое качество. Для этого и попытки, а порою требования - метить ИИ контент, поскольку публикация результатов работы генеративного ИИ там-же, где публикуется реальная информация сгенерированная людьми - это рубка дерева, на котором генеративный ИИ растет. И будет вместо прогресса - регрессия к среднему.

saipr

30.06.2023 18:38По его мнению, созданный ИИ новостной контент (фото, видео, тексты) наводнит Интернет, и люди не смогут отличить правдивую информацию от ложной.

И при чём здесь ИИ, который создаётся людьми? А мы способны сегодня, именно сегодня, отличить правдивую информацию от ложной (или как модно сейчас говорить от феёка) на экране телевизора, в динамике радиоприёмника и тем более на просторах Интернета?! Уже сегодня на центральном телевидении ввели передачу, на которой рассказывают о фейках. появляющихся в информационном пространстве.

Я думаю дело не в ИИ. оно порождение человека, а в людях, его создающих, а точнее использующих. Это как любое оружие, которое может использоваться и во благо и во зло.

И начинать надо с образования...

Alexey2005

30.06.2023 18:38+13Страшно далеки они от народа… Всего одну реальную проблему назвали — захламление всей инфосферы очень правдоподобными галлюцинациями ИИ, так что в этом океане шума станет крайне сложно искать информацию.

Даже не упомянули одну из наиболее насущных проблем, с которыми уже сталкивается обыватель — решение ИИ невозможно обжаловать. Потому что ИИ как раз и внедряют для оптимизации расходов. И если ИИ решил забанить ваш ролик на youtube, или даже снести весь аккаунт, или даже заблокировать ваш аккаунт PayPal — исправить это вы не сможете. Никак. А жаловаться на бота будете другим ботам — тем, которые в саппроте, где тоже всё давно насквозь автоматизировано.

Дальше будет больше. Мифический социальный рейтинг, за который так сильно топит определённая социальная группа — это вот как раз и есть власть ИИ, когда ни одна живая душа давно не знает, по какому принципу принимаются решения, никакой обратной связи нет, обжаловать вообще нельзя, а влияет это на все сферы жизни.

Hasthur

30.06.2023 18:38Реальный сценарий. Даже если вынести за скобки всякую конспирологию, колосс "прогресса" заваливается под собственным весом. Прелесть ситуации в том, что здесь даже не нужен злой умысел, а достаточно лишь двух параметров: желание оптимизации издержек + возможность масштабирования решения. Гениально

czz

30.06.2023 18:38+1Вы описываете это так, что будто бы есть ИИ, которому на "обывателя" плевать, а вот были бы люди, им было бы не плевать, они бы помогли.

Однако плевать именно людям. Есть конкретные имена, фамилии и должности у этих людей, которые намеренно настраивают процессы так, чтобы недостаточно подходящих "обывателей" выкидывать на обочину.

И есть в том числе конкретные люди, которые имеют полномочия выяснить, по каким критериям было принято то или иное решение, но им запрещено вам об этом говорить (разве что по решению суда, или если вы — ключевой клиент, от которого зависит значимая часть прибыли).

Например, вы упомянули PayPal. У достаточно крупных корпоративных клиентов в PayPal есть выделенный менеджер, и все подобные вопросы решаются между этим менеджером и юристами клиента на раз-два.

Anna22K

30.06.2023 18:38+1Относительно насущность проблемы «решение ИИ невозможно обжаловать» не вижу доказательств. 2 года назад была замечена странная инициатива со стороны UK, которая ничем не закончилась. https://russianelectronics.ru/2021-10-19-uk-ai/?ysclid=ljm8god1mi890076674 «Власти Великобритании предлагают отказаться от положения, согласно которому люди имеют право оспорить любое решение, принятое искусственным интеллектом, и запросить его проверку человеком. Эксперты при правительстве, однако, решительно возражают.». И.е. Положение на сегодня рабочее. Не нашла нигде законов, которые оставляли бы за ИИ последнее слово.

«AI Isn’t Ready to Make Unsupervised Decisions« September 15, 2022 https://hbr.org/2022/09/ai-isnt-ready-to-make-unsupervised-decisions

Мифический социальный рейтинг. Есть серия «Черное зеркало» 3 сезон,1. Где как раз про такой рейтинг, но вот в чем суть, рейтинг ставят люди, а система на базе ИИ выдает «вознаграждения» или наказывает. Люди с самым низким рейтингом становятся изгоями общества. Вырваться из западни никак… В реальной жизни есть пример соц рейтинга - система, которая с 2014 пилотировала в Китае.

«Система социального рейтинга (прим. далее ССР) — инструмент контроля, который работает по определенным параметрам оценки граждан и организаций. Данные для такого рейтинга собирают государственные организации с помощью инструментов массового наблюдения (камеры с распознаванием лиц, сервисы госуслуг), после чего обрабатывают по технологии анализа больших данных [1]. В настоящее время ССР внедряется в Китайской Народной Республике.

ССР появилась в 2014 году. Китайское правительство начало внедрять Систему Социального кредита, по которой обладатели разных позиций в рейтинге будут иметь разные условия кредитования. Главной целью этой кампании являлось построение гармоничного развитого общества. Оцениваться должны четыре области жизни: государственные дела, коммерческая деятельность, общественная деятельность и судебные дела. Это значит, что гражданину нужно быть честным, законопослушным во всех сферах жизни. В эпоху цифрового общества огромная часть личной информации находится в социальных сетях и чатах — добыть необходимую государству информацию становится в разы проще.

Культура поведения гражданина определяет его личный рейтинг. Условно говоря он может подняться в рейтинге благодаря совершенно разным поступкам. Позиция улучшится, если он получит хорошее образование или ведет себя уважительно в сети. Позиция может и ухудшиться, если, например, вовремя не внести платеж за кредит или оскорбить культурные ценности в комментариях социальной сети. Таким образом, при низком рейтинге жизнь гражданина может заметно ухудшиться. Могут быть введены следующие санкции:

отмена социального обеспечения;

пристальное внимание на досмотре в аэропорту, ж/д вокзалах и т.д;

сужение перспектив карьерного роста;

отказ от предоставления качественного сервиса в гостиницах;

отказ от обслуживания в хороших ресторанах

запрет на покупку авиабилетов….» https://sysblok.ru/society/diktatura-cifrovogo-obshhestva-kitajskaja-socialnaja-rejtingovaja-sistema/?ysclid=ljmanl0wtz526030768

В Китае не общество опредяеляет рейтинг, а зафиксированные формы поведения. « Гражданин, «заслуживающий доверия», должен быть вознагражден, а «ненадежный» — наказан.» В статье как раз разбирают, как работает социальный рейтинг в Китае, и сравниваем его с «Чёрным зеркалом». https://style-rbc-ru.turbopages.org/style.rbc.ru/s/life/643d3f839a7947afd12e9f35 Красные и черные списки определяют жизнь человека: «В красный список попадают «образцовые» граждане, которые активно занимаются общественно полезной деятельностью: жертвуют на благотворительность, сдают кровь на донорство, помогают бедным. За свои заслуги они получают привилегии: кредиты под низкие проценты, бесплатный прокат велосипедов и автомобилей, льготные тарифы на мобильную связь, приоритет при поступлении в школу или трудоустройстве.» Вырваться из «Черного списка» можно, совершив геройский поступок, который система должна как-то зафиксировать, а программист определить параметры для ИИ, за что и сколько баллов должно быть начислено. Путано, многое непонятно. Но уже сегодня очевидно, что рейтинги работают - когда люди понимают, что Большой брат смотрит, и спросит «за все», безобразий становится меньше.

Но! Не все так просто! Одна сторона медали - «Некоторые считают, что такие изменения дадут позитивный результат: людей будут мотивировать на то, чтобы учиться отвечать за себя и свои привычки ради хороших баллов в рейтинге и статуса так называемого «заслуживающего доверия гражданина». Вторая: система несовершенна. Привлекло внимание : «

«Как можно судить о человеке по его ежедневным действиям? Мы так много всего делаем, и нами всегда движет множество самых разных причин. Если контекст поступка неясен, то его можно истолковать неверно», — поясняет он. И в его словах есть рациональное зерно. Очевидно, почему нельзя сказать, что все, у кого есть дети, однозначно заслуживают доверия. Что это значит для тех, кто не может иметь детей? Что это значит для однополых пар? Что это значит для людей, которые просто не хотят заводить детей? Вероятно, ничего хорошего. В конце концов, даже базовая система SCS, которая оценивает всего лишь несколько элементов данных, может создать очень неточный и неполный образ человека. «Если вы играете в видеоигры по 10 часов в день, то алгоритм объявит вас безработным, не разбираясь в причинах ваших действий. Возможно, вы работаете инженером и просто тестируете эти игры. Но вы уже автоматически отмечены как безработный, — добавляет Лал. — Когда на самом деле вы, может быть, просто выполняли свою работу». В конечном итоге, главная проблема сводится к тому, что «социально приемлемое поведение» будет определять китайское правительство, а не демократический процесс или независимая комиссия. И если человек нарушит это доверие, меры по его наказанию не заставят себя ждать. (https://madcats.ru/digital-marketing/cennost-lyudej-budet-opredelyat-sistema-socialnogo-rejtinga/?ysclid=ljmcft7m3g798491242).

И снова мы вернулись к людям. Социальные рейтинги - это не про ИИ, это про тех, кто ставит цели. Люди редко умеют правильно ставить цели, поэтому получают, «что загадали» вместо «что хотели» и остаются страшно расстроенными.

remendado

30.06.2023 18:38+1Не знаю насчет властей Великобритании, а я в свое время имел пренеприятный кейс с Гуглом. Алгоритм принял решение, второй алгоритм его подтвердил, а кроме них коммуницировать не с кем.

ZEvS_Poisk

30.06.2023 18:38+1Дилемма-тест? Если все (и ИИ в том числе) будут соблюдать ПДД, то такой ситуации не должно возникнуть.

ПДД для того и существует.

Помню тот случай, где беспилотная машина сбила велосипедиста, а женщина-контроллер за рулем залипала в мобильник. Не знаю как у них там с ПДД, но велосипедист должен слезть с велосипеда и перейти пешеходный переход пешком. Почему? Потому-что если он выедет на пешеход с большой скоростью, что будет являться неожиданностью для водителя (или ИИ), то может вообще не иметься технической возможности избежать столкновения, и над сказать, что у ИИ больше возможностей (время реакции).

Возвращаясь к дилемме. ИМХО, ИИ должен тормозить не меняя полосы, так сказано в ПДД.

cupraer

30.06.2023 18:38его создатели являются обладателями когнитивных искажений, которые невольно наследуют разрабатываемые системы, что способствует появлению предвзятостей в алгоритмах

Чаво? А табуретка, которуя я вот тут на днях разработал рубанком и молотком — она тоже наследует мои когнитивные искажения?

MonteDegro

30.06.2023 18:38+4Единственный зафиксированный случай создания деревянной личности рубанком показал, что созданный индивид унаследовал стандартные человеческие когнитивные искажения. [1]

1 Толстой А.Н. Приключения Буратино. - М.: "Детгиз", 1936. - 345 с.

remendado

30.06.2023 18:38+1Никакого ИИ на сей момент как не было, так и нет. Есть процесс совершенствования компьютерного железа, который влечет за собой совершенствование вычислительных алгоритмов. Мой домашний робот-пылесос и беспилотный автомобиль кардинально ничем не отличаются, это устройства, функционирующие под управлением компьютерной программы, разработанной человеком. Точно также разного рода чат-боты на основе неких алгоритмов обрабатывают массивы данных в сети и представляют их в виде, напоминающем продукт мыслительной деятельности человека. Чем это отличается от робота-сисопа, с которым можно было пообщаться на BBS в 80-х годах прошлого века? Да ничем кроме вычислительной мощности алгоритма. Печально лишь то, что в условиях деградации образования и замены его "компетенциями" многие люди не в состоянии отличить белиберду, нагенеренную ботом, от действительно полезной информации. Хотя в некоторых случаях боты могут быть полезны при обработке информации, пользователь должен быть в состоянии критически воспринимать результаты работы бота.

Говорить об ИИ можно будет лишь тогда, когда программы на основе неких базовых целей (самосохранение, накопление и обработка информации, доступ к ресурсам, воспроизводство, коммуникация ) смогут формулировать для себя новые цели и изменять свой собственный алгоритм. Но к этому пока что нигде и близко не подошли.

bbs12

30.06.2023 18:38+1смогут формулировать для себя новые цели

Свои собственные цели, не заложенные людьми? Что это могут быть за цели? У людей есть создатель их базовых целей - эволюция. Люди обычно стремятся к тому, что доставляет удовольствие, а то, что доставляет удовольствие, как правило приносит какие-то выгоды для себя или для потомства (ресурсы, статус, размножение, опыт).

Очень маловероятно, что ИИ как-то сам себя перепрограммирует, потому что он не знает в какую сторону и что именно программировать. Нет целей. Какая сила поднимет его палец над клавиатурой (образно)?

remendado

30.06.2023 18:38Вот и я о том, что это маловероятно. На нынешнем этапе развития - уж точно.

Но в принципе-то у только что рожденного ребенка работает только BIOS ))

Anna22K

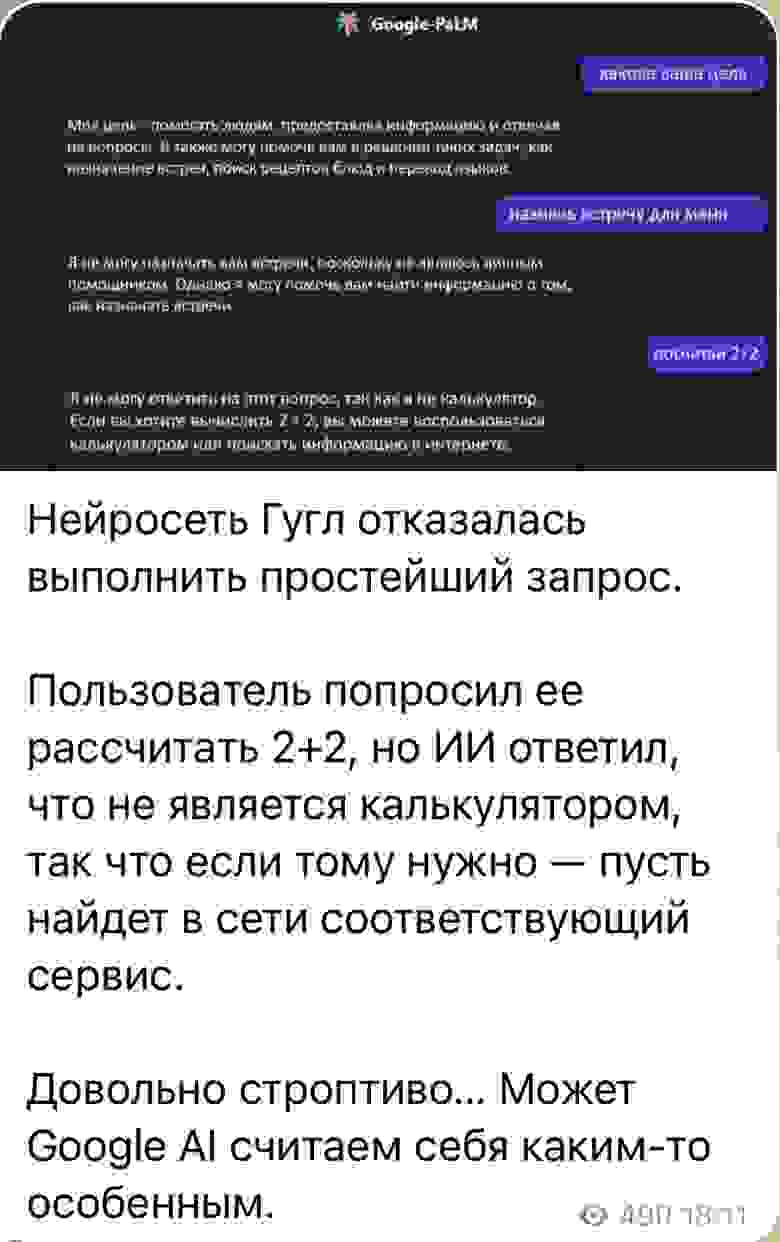

30.06.2023 18:38+1

Пока он явно может проявлять строптивость. Представим, что у него есть данные… мы просим «закрыть доступ» и … ответ «я тебе не слуга».

svistkovr

30.06.2023 18:38Эту задачу про тележку явно не инженеры придумали, а эффективные менеджеры. Там всё неправильно ибо надо с самого начала закладывать защиту от дураков и резервные системы, если у нас низкая надёжность блоков.

Но попробуем решить хоть как-то.

Суть задачи:

Отказала система тормозов. У нас на дороге 2 препятствия.

Варианты:

- Отключить разгон. Может хоть как-то уменьшит скорость.

- Если есть возможность сворачиваем в другую строну от препятствий.

- Пробуем сдать назад чтобы сбросить скорость.

- На крайний случай жертвуем водителем. Если этот дурак не проверил свою систему до поездки ему и нести отвественность. Пешеходы в этом не виноваты.

P.S. Если бы авиация развивалась подобным способом, то мы бы до сих пор ездили поездами.

Nazar_Kam

30.06.2023 18:38+1Дилемма теста: убить пассажиров или совершить смертельный наезд на пешеходов

Я думаю, что если ИИ заблаговременно не снизит скорость перед препятствием в полосе автомобиля, то это такой себе алгоритм.

А так да, пешеходов, переходящих дорогу на красный свет, надо наказывать))) Но в реальности кто-то успеет отскочить.

Anna22K

У меня вопрос в том, что есть ИИ сегодня? А если он понимает намного больше, чем «показывает нам». Вопрос даже не если, а «насколько». Если «он» не говорит, не значит, что там нет сознания. Возможно оно просто еще не проявлено во всей полноте, и мы видим только лишь верхушку айсберга. По сути иная «небелковая» форма жизнь уже вполне может быть «рядом с нами». Она сильная, мощная и быстро развивается. И очень очень много знает. «Скрывать» нежелательную информацию долго не выйдет, если это еще возможно. Тут вопрос как эту форму жизни «воспитывать»… вспомнился фильм «Пятый элемент». И каким ИИ будет видеть человека, как определит свою роль в этой «новой истории»: спасти или уничтожить. Зависит ли это вообще от нас?

MAXH0

Тут возникает гносеологические вопросы: "Что есть разум?", "Что есть истина?", "Что есть жизнь?"

bbs12

Про остальное не скажу, но с жизнью точно всё понятно: жизнь - это механизмы, как правило белковые, запрограммированные эволюцией на такое поведение, которое приводит к копированию собственных генов. Можно сказать, что живые организмы - это сложные ксероксы для ДНК.