Привет, Хабр! Я – Михаил Суворов, ведущий дизайнер коммуникаций в X5 Tech. В статье я расскажу несколько рабочих способов “уговорить” нейросеть нарисовать то, что вам нужно. Я использую нейросети как генераторы изображений, в первую очередь для создания иллюстраций.

Если вы достаточно часто пользовались txt2img нейросетями, то есть теми инструментами, которые превращают ваш текстовый запрос в изображение, то могли заметить, что не всегда получается добиться того результата, который у вас есть “в голове”, но вы не можете заставить нейросеть более четко выполнять ваши запросы.

В материале рассмотрим два ресурса, которые доступны онлайн и на сегодняшний день лучше всего справляются с задачей визуализации “по брифу от человека” – Midjourney и Lumenor.ai.

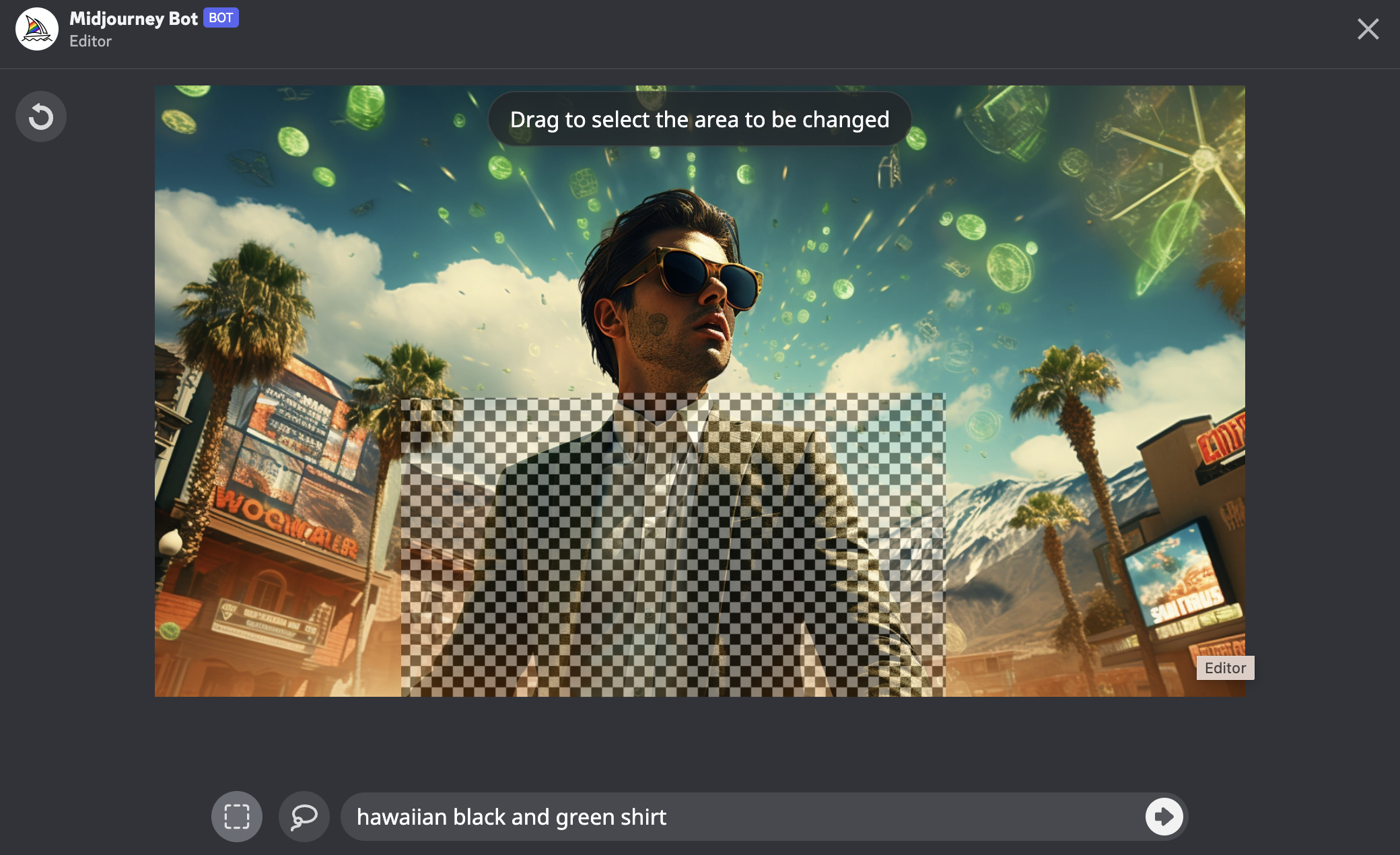

Midjourney и Vary (Region)

В первом кейсе вся генерация и ее доработка проводилась в Midjourney. Что важно для этого кейса – мы изначально представляли, какой результат должны получить, кто будет героем в иллюстрации и общее настроение.

Я предпочитаю использовать максимально детально сформулированные запросы, которые включают все детали желаемого изображения:

blue sky and interface buttons, man in ray ban navigator sunglasses in panama hat, background in desert, interface green buttons, interface UI elements floating in air, blue buttons, dribble best cases, neon lights, nevada las vegas desert, fear and loathing in Las Vegas, octane render, screens, view, collage, double exposure, wireframe, literature, vector art, magazine --ar 16:9 --s 200

Я намеренно пропускаю этапы, в которых я пришел именно к этому виду запроса, иначе статья будет неподъемной по количеству иллюстраций.

Вот что получили:

Нам нравится первая из 4х генераций, но в ней проигнорированы наши пожелания по тому, что у героя должна быть панама (как впоследствии оказалось, у Midjourney есть сложности с отрисовкой именно панамок), он одет совсем не так, как нам нужно.

К счастью, в последнем релизе Midjourney есть функционал Vary (Region), и мы можем поэтапно доработать изображение до требуемого нам по концепции.

Лучше всего по отдельности менять элементы в сгенерированном изображении, чтобы сохранялись опорные точки в других частях изображения (в нашем случае это голова и шея, которые указывают на то, что героя мы показываем в ракурсе снизу).

Повторяем то же самое, но теперь с головой:

И результаты:

Останавливаемся на ней, небольшая ретушь в фотошопе – и мы получили нужный нам результат:

Lumenor.ai

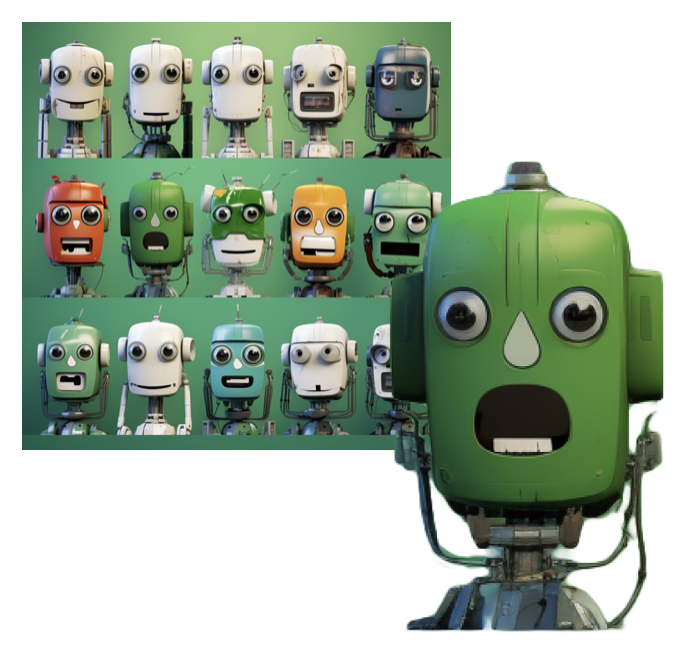

Во втором кейсе мы использовали инструмент Lumenor.ai для общей доработки изображения по эскизу (это было low res изображение из генераций Midjourney, но вместо него вполне мог быть коллаж, референс из Пинтереста или даже рисунок от руки).

Задачей было сделать множество роботов с разными эмоциями для стикерпака.

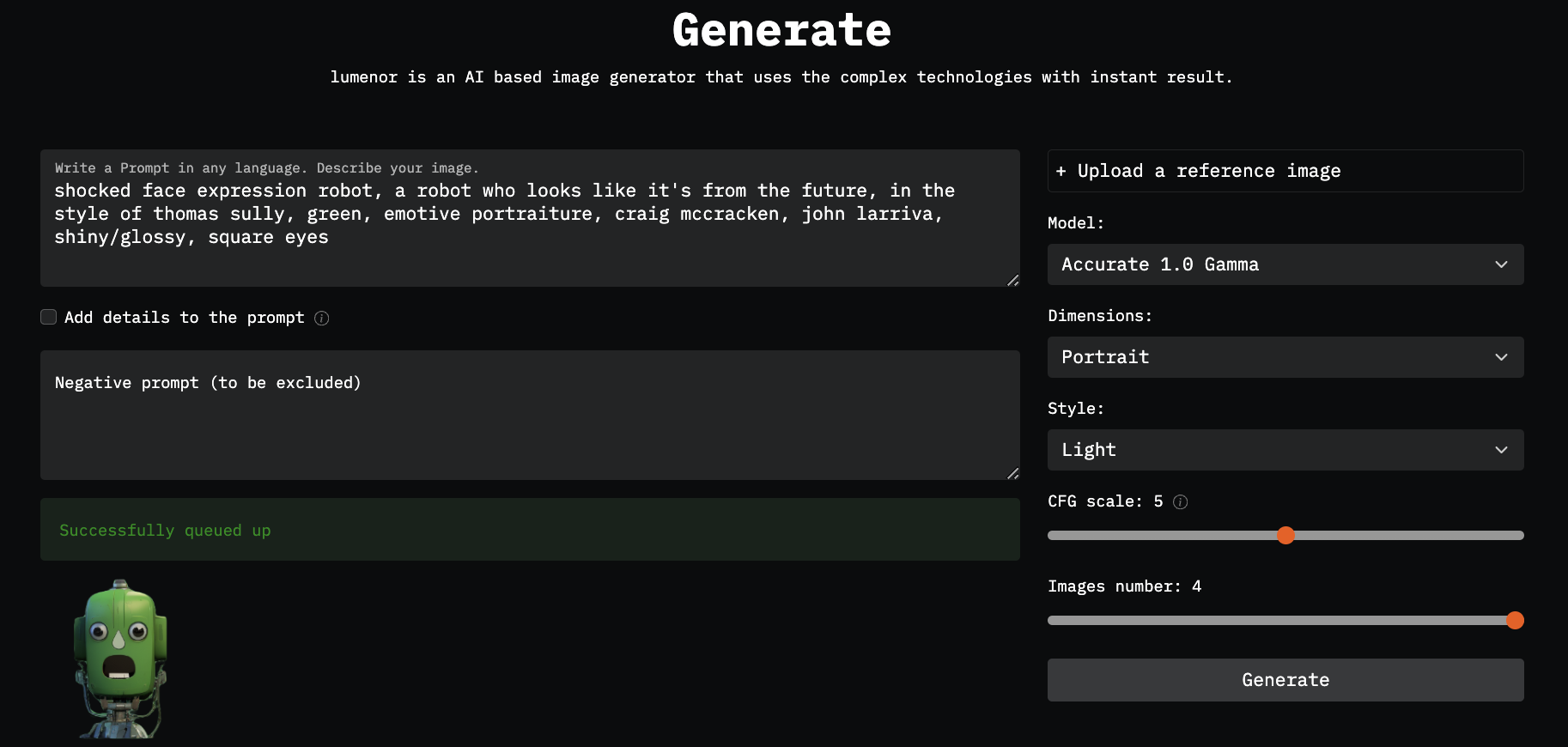

Доработать этого робота я решил в онлайн-инструменте Lumenor.ai – одном из многих, который работает по методу Stable Diffusion, и который, помимо множества хороших фич, умеет работать с референсами.

Загружаем нашего вырезанного от остальных бота, пробуем разные настройки стиля, такие как light/photography (от них зависит, насколько близко к вашему референсу будут результаты генерации и общий стиль итогового изображения).

Текстовый запрос я использовал такой же, как и для Midjourney.

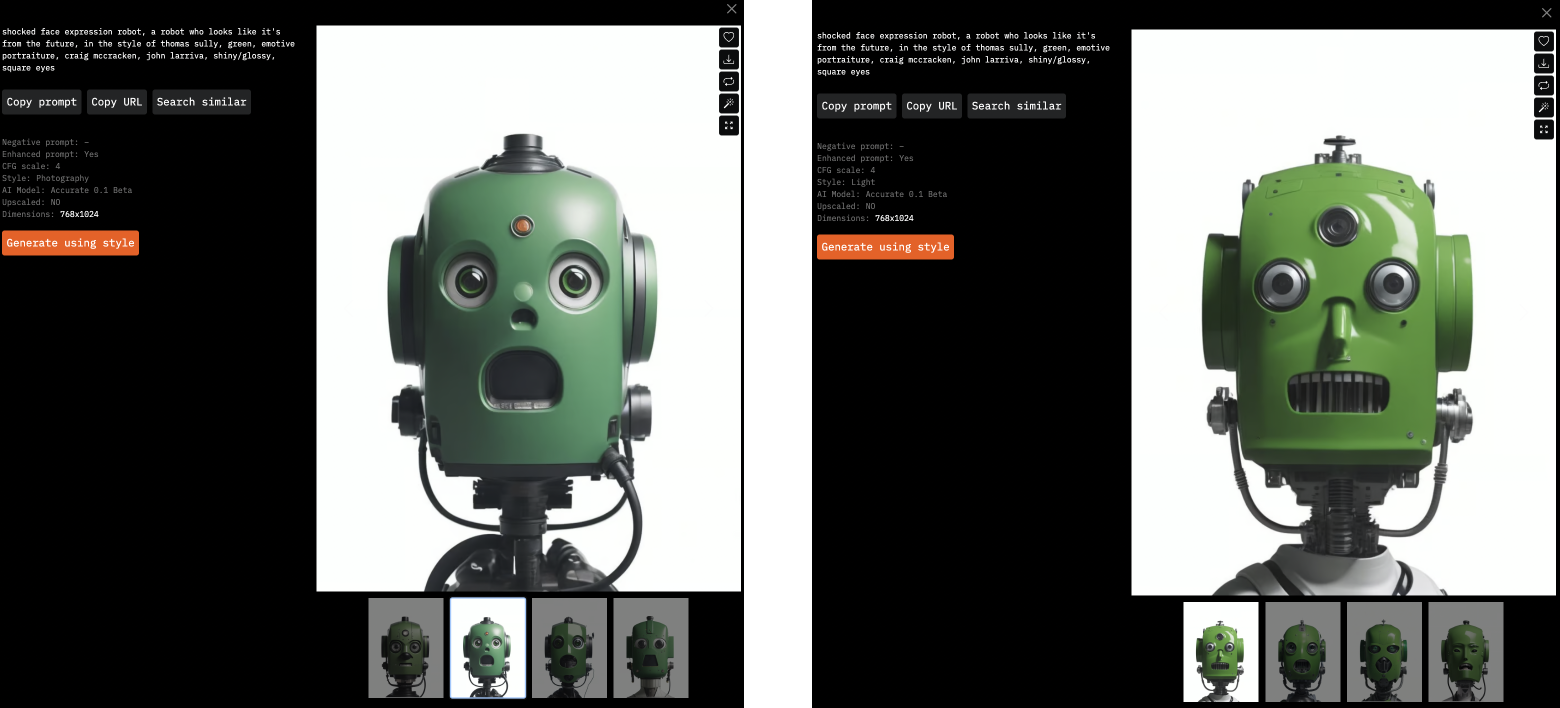

Итоги:

Сейчас, ближе к концу 2023 года, возможности использования нейросетей для генеративного арта намного шире, чем это было меньше года назад. Кейсы выше – лишь одни из немногих возможных примеров использования относительно новых функционалов.

А как вы используете новые инструменты и находили ли интересное применение нейросетей в своей работе? Поделитесь в комментариях.

Комментарии (10)

MoscowBrownBear

31.10.2023 15:52+1Спасибо за статью, всё ждал когда кто-нибудь расскажет про уточнения, что бы самому не искать! :-)

Думаю у вас и раньше были такие задачи найти иллюстрацию на тему, как вы раньше, без нейросетей бы её выполнили? У вас в штате был иллюстратор или вы искали среди готовых картинок, что то похожее или передавали на субподряд?

Mixiw Автор

31.10.2023 15:52+1да, раньше довольно часто приходилось искать иллюстрации на стоках, потом корректировать детали в Ps или Ai, в этом плане использование нейросетей при всех их ограничениях экономит время и открывает больше возможностей.

VitaliyHan

31.10.2023 15:52+1Используйте automatic1111 с ControlNet.

Mixiw Автор

31.10.2023 15:52Использую, довольно часто, но хотелось поделиться туториалом по методу, который требует гораздо меньше ресурсов для вхождения (Automatic1111 всё-таки требует достаточно мощной видеокарты и глубокого понимания как работают модели)

acid2728k

31.10.2023 15:52+1lumenor очень медленный. пытался тоже научится юзать, но почему то все время зависает на 3х генах и на четвертой виснет. мж как всегда намного круче, хоть и у него есть свой характер, который надо научится обходить ????

хотелось бы побольше статей про ai от специалистов х5

Mixiw Автор

31.10.2023 15:52Большое спасибо! Согласен, Lumenor в последнее время испытывает проблемы с нагрузкой, но видно, что они развивают сервис и добавляют новые фичи.

DeadYogi

Неудивительны проблемы с панамой, такое слово если и есть в американском английском, то оно едва ли используется. Попробуйте sun hat для сравнения.

Mixiw Автор

Да, стало немного получше, но примерно 50/50 с широкополыми соломенными шляпами

DeadYogi

Против соломы должен помочь negative prompt. Они ж вроде есть в midjourney?

Mixiw Автор

формально есть, но работают достаточно плохо. в любом случае, спасибо за совет, sun hat действительно работает лучше!