ИИ чат‑боты любят ловить глюки и выдавать всякую чушь. Так массово, что словом 2023 года признали «галлюцинировать». В чем причина такого явления? Является ли генеративный ИИ интеллектом (спойлер — и да, и нет)? И что общего у ChatGPT и копировального аппарата Xerox? Разбираемся, осмысляя базовую логику работы языковых моделей.

Небольшое вступление или "в чем суть проблемы?"

Кебриджский словарь признал словом года «галлюцинировать» (hallucinate). Причем не в вакууме, а применительно к генеративному ИИ. Глюки ИИ — это когда ChatGPT выдает косяки в фактологии, из‑за которых пользователи теряют всякую веру его результатам (и срочно бегут все перепроверять в Гугле). Но не стоит злиться на генеративный ИИ за подобные выкрутасы, ведь дело в самой логике его работы. Ее мы сегодня и разберем с помощью парочки метких аналогий.

Год назад Google впервые представил миру своего чат‑бота Bard. Сейчас он вполне неплохо работает (хотя и уступает первопроходцу), но на той презентации умудрился выдать базу‑основу. Он заявил, что «Джеймс Уэбб» был первым космическим телескопом, сделавшим снимки планет за пределами Солнечной системы. Это была ошибка — первые снимки этих самых планет сделал другой телескоп еще за 17 лет до появления на свет «Джеймса Уэбба». Неточность Барда быстро заметили, в результате чего у Google даже просела стоимость акций.

ИИ чат‑боты регулярно выдают неточности и искажения. Чаще всего они незначительны и касаются отдельных деталей. Однако даже наличие небольших косяков сильно снижает полезность генеративного ИИ на практике. Ведь если вы знаете, что ошибки в целом возможны и даже регулярны, то не можете полностью довериться этому инструменту.

Но не спешите обвинять бездушную машину в злом умысле. У нее нет цели подставить кожаных или намеренно ввести в заблуждение.

Причина в другом. Дело в том, что генеративный ИИ по принципам своего устройства больше напоминает архиватор (т. е. программу для сжатия файлов), нежели полноценное сознание. Именно поэтому эксперты в ИИ зачастую недовольно фыркают, когда генеративные нейросети называют звучным словом «интеллект». А еще это отлично объясняет, почему ChatGPT очень вряд ли превратится в злой скайнет (но это не точно).

Итак, давайте разбираться. В этом нам поможет классная статья издания The New Yorker за авторством Теда Чана, из которой я с большой благодарностью буду заимствовать ключевые тезисы. Подкрепляя их иллюстрациями, дабы нагляднее было.

Хитрый Xerox и внимательные проектировщики зданий

Осмыслять проблему удобнее чуть издалека, с интересной аналогии.

В 2013 году копировальный аппарат Xerox в офисе одной немецкой строительной фирмы начал творить очень странные дела. Ребята делали копию проекта дома с тремя комнатами и заметили очень любопытное расхождение:

На оригинальной схеме три команты имели разную площадь — 14.13, 21.11 и 17.42 метра. То есть, на чертеже в центре каждой комнаты стояла разная циферка, обозначающая площадь.

Xerox же выдал копию, где на всех трех комнатах стояла одинаковая цифра — 14.13 (как площадь первой комнаты).

Компания прифигела от такого контринтуитивного глюка копировальной техники и обратилась к специалисту по обработке данных Давиду Крайзелю.

Вы, возможно, спросите: «Аффтар, а почему они обратились к человеку такой специальности, а не к эксперту в копировальном деле?». Дело в том, что современные ксероксы используют не классический процесс ксерографии (это когда изображения передаются с оригинала на копию через прохождение лучей через специальный барабан — в общем, аналоговая классика), а цифровое сканирование.

А когда речь заходит о каких‑то манипуляциях с изображениями (да и файлами в целом) в цифровой среде, то мы почти наверняка столкнемся с процедурой сжатия объектов.

Процедура сжатия состоит из двух ключевых этапов. Первый — кодирование (encoding), в ходе которого изначальное изображение переводится в какой‑то более компактный формат. Второй — декодирование (decoding), т. е. обратное действие.

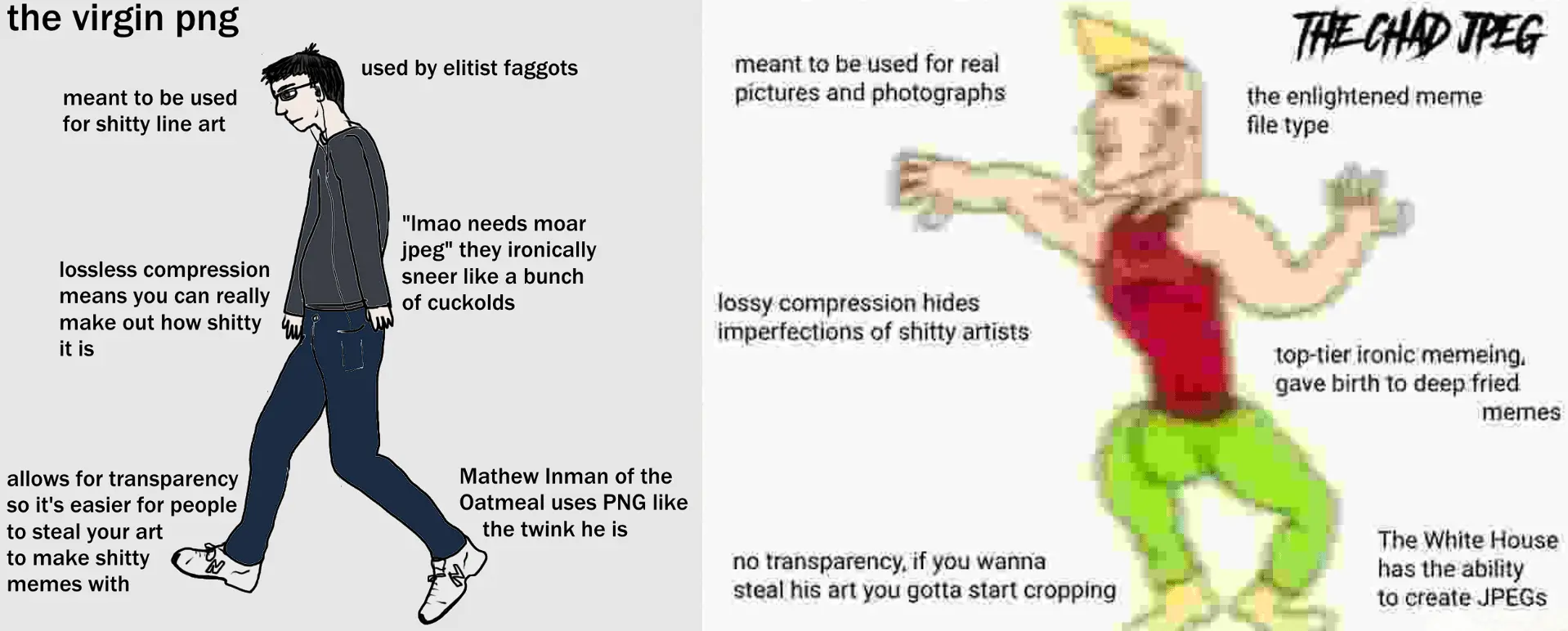

При этом сжатие бывает двух типов:

Сжатие без потерь (lossless) — это когда закодированные данные могут быть восстановлены с точностью до пикселя или бита. Если речь идет про изображения, то самый популярный формат сжатия без потерь — это PNG.

Сжатие с потерями (lossy) — здесь уже распакованные данные отличаются от исходных, но степень отличия столь незначительно и минорна, что их без проблем можно дальше использовать. Яркий пример — JPEG.

Сжатие без потерь обычно используется, скажем, для компьютерных программ. Потому что если потерять хотя бы один символ кода, то все поломается. А вот для изображений, аудио или видеофайлов часто предпочитают использовать сжатие с потерями. Ведь даже если отдельные пиксели картинки поедут или мелодия будет звучать чуть менее чисто, то человечьи органы осязания все равно не заметят подлога, так что пофиг.

Здесь и была зарыта собака в истории со ксероксом. Агрегат использовал lossy‑сжатие формата JBIG2, которое работает примерно так:

В целях экономии места или вычислительных мощностей (а может и того и другого, пойди разберись в этой офисной технике) машина ищет очень похожие области изображения и сохраняет для всех них одну копию, которую потом воспроизводит обратно при декодинге.

Проще говоря, конкретно в этом случае ксерокс почему‑то решил, что комнаты на чертеже так похожи друг на друга, что можно смело забивать на различия и считывать только одну из них — ту, которая площадью 14,13 кв метров. А потом везде нарисовать именно её. То ли потому что формат JBIG2 создан для работы с черно‑белыми офисными бумажками, а не с мелкими объектами чертежей, то ли просто у аппарата был дурной характер — история умалчивает. Но суть в том, что ксерокс решил забить на небольшие различия именно в том случае, где эти различия оказались очень даже критичными.

Вообще, сам факт того, что ксерокс использует сжатие с потерями — это не проблема. Проблема в том, что изображение деградирует очень незначительно, «на тоненького». Настолько чуть‑чуть, что с ходу фиг заметишь. Одно дело, если бы он просто блюррил упрощенные области картинки, но он их может просто вероломно заменить. А строительному бюро потом объясняй заказчику, почему в итоге все комнаты получились одинаковыми.

Идем дальше. Проблема сжатой Википедии

Запомним историю со Xerox и проведем один мысленный эксперимент (он нам нужен, чтобы подойти еще ближе к пониманию проблемы этих наших GPT).

Представьте, что завтра во всем мире отключат интернет. Вообще. Совсем. Не будет его больше. В связи с этим мы решаем по максимуму выгрузить все содержимое интернета к себе на частный сервер. Ну окей, пусть будет не весь интернет (это совсем тяжко), но хотя бы всю Википедию. Чтобы оставить великие знания потомкам.

Разумеется, место на сервере ограничено — вся Википедия туда не влезет. Допустим, места хватит на 1% от оригинального размера, т. е. сжать изначальный объем нужно в 100 раз. Следовательно, нужно прибегнуть к сжатию с потерями.

Итак, мы применяем сжатие с потерями. Алгоритм у нас мощный — он легко находит чрезвычайно тонкие статистические закономерности на совершенно разных страницах (иногда одинаковыми оказываются длинные фразы или целые предложения). Таким образом нам удается сжать Википедию примерно в 100 раз, что и требовалось в нашем мысленном эксперименте.

Теперь нам не так страшно потерять доступ к интернету, ведь у нас как минимум выкачана база знаний в виде Википедии (а значит, потомкам будет чуть проще делать выводы о предназначении предметов, найденных при раскопках через тысячи лет). Но есть нюанс:

Мы не сможем найти любую цитату слово в слово. Потому что из‑за сжатия с потерями наша Википедия сохранена не буквально, а приблизительно. Алгоритм оставил только то, что кровь из носу требуется, чтобы сохранить смысл всех сущностей. Остальное же было объединено и апроксимировано (т. е. передано приблизительно). А значит, чтобы достать информацию, нам нужно создать интерфейс, который умеет в ответ за запрос выдавать основной смысл.

Чувствуете, на этом моменте комнату начинает наполнять знакомый аромат генеративного ИИ?

GPT выдает точные ответы, но есть нюанс...

Да‑да, только что мы мысленно создали большую языковую модель (LLM), обученную на Википедии (в нашем конкретном случае).

ChatGPT — это заблюренный JPEG не только Википедии, но вообще всего интернета. Когда модель дообучают, этот JPEG еще лучше детализируется в отдельных уголках. Но суть все та же — LLM аккумулирует именно бОльшую часть интернета, но далеко не всю.

Следовательно, когда GPT отвечает на ваш запрос, он не может выдать точную последовательность символов. Он сделает приближение. Другое дело, что GPT отлично умеет превращать это приближение в связный и опрятный текст, который человеческий мозг не может сходу отличить от оригинального.

А как LLM воссоздает пробелы, которые отсутствуют в его сжатой версии интернета? Ответ — интерполяция. Не будем вдаваться в математические дебри этой штуки. Простыми словами — это оценка отсутствующего элемента путем анализа того, что находится с двух сторон от этого разрыва. Когда программа обработки изображений декодирует ранее сжатую фотографию и должна восстановить пиксель, потерянный в процессе сжатия, она просматривает близлежащие пиксели и, по сути, вычисляет среднее (генерирует его).

То же самое делает ChatGPT, только со словами и прочими текстовыми смысловыми сущностями. Секрет в том, что ChatGPT научился делать эту интерполяцию настолько мастерски, что люди не могут этого раскусить (и думают, что имеют дело с настоящим интеллектом).

По сути, генеративный ИИ выдумывает отсутствующие элементы на основе смежных. Фантазер этот GPT, получается.

Описанная выше логика отлично объясняет «галлюцинации». Просто‑напросто даже самый большой мастер интерполяции иногда допускает ошибки. И совсем периодически эти ошибки замечают. Однако сам факт вероятности ошибок сильно снижает надежность инструмента. Ведь это значит, что в любой момент может вылезти значимый косяк. А это уже означает, что все результаты нужно сверять с оригинальным текстом (= лишние затраты ресурсов).

Получается, генеративный ИИ - это совсем не интеллект?

И да, и нет. Тут, как говорится, смотря как посмотреть.

Действительно, не стоит очеловечивать генеративный ИИ. То есть не нужно отождествлять его с человеческим интеллектом.

ChatGPT впитывает информацию с большими потерями, восстанавливая ее через интерполяцию. В результате он как будто пересказывает суть своими словами. Вероятно, здесь и кроется разгадка, почему люди так восхищаются генеративным ИИ.

Дело в том, что еще со школьных и универских скамей у людей сидит на подкорке убеждение (весьма резонное), что точное воспроизведение информации — удел зубрилок, которые «выучили, но не поняли», а по‑настоящему толковые ребята пересказывают все своими словами, сохраняя суть. Поэтому и ChatGPT нам кажется толковым парнем, который реально все понимает. На самом же деле он просто передает основной смысл, воссоздавая пропуски за счет усреднения.

Именно поэтому, кстати, GPT3 не очень хорошо справлялся с точными вычислениями больших чисел (допустим, выражение «2345 х 57789» в интернете встретишь не так уж часто), но при этом как Боженька писал всякие студенческие эссе. По мере перехода к GPT4 модель стала более продвинутой, в нее завезли больше закономерностей, поэтому она стала сносно щелкать любую арифметику.

Однако, есть и другая сторона медали. Она касается тех самых закономерностей, которых в GPT4 завезли больше. Смотрите:

Есть такая премия под названием «Приз Хаттера». Ее в 2006 г. учредил старший научный сотрудник DeepMind (это ИИ‑стартап, уже давно купленный Гуглом) Маркус Хаттер. Суть конкурса такая:

Есть текстовый файл на английском языке размером 1 Гб. Его требуется сжать без потерь. Каждый, кто сожмет на 1% от предыдущего лучшего результат, получит 5000 евро. Сейчас лучший результат 115 Мб.

На самом деле, это не просто конкурс по сжатию текста без потерь. Это важное упражнение, приближающее понимание сути настоящего ("взрослого") искусственного интеллекта. И вот этого товарища уже можно отождествлять с человеческим сознанием как минимум по одному признаку:

Чтобы наиболее эффективно сжимать текст без потерь, он должен уметь по-настоящему понимать этот текст и сопоставлять его содержание с реальными знаниями о мире.

Например, вот есть у нас какая‑то статья в Википедии на тему физики. Допустим, некий текст, где фигурирует Второй закон Ньютона (Сила = Масса x Ускорение). Вероятно, самый простой способ сжать без потерь такую статью — это заложить в алгоритм сжатия базовый постулат, что «Сила = Масса x Ускорение». Тогда алгоритм может выкинуть повторящиеся куски статьи, вытекающие из логики этого закона, а потом легко их восстановить при надобности (потому что знает сам базовый принцип).

Аналогично и со статьей на некую экономическую тему. Наверняка там будет дофига выводов, основанных на законе спроса и предложения. А значит, если в принцип сжатия заложен этот закон, то можно выкинуть кучу «вторичной» информации.

ИИ работает так же. Чем больше первичных правил и законов он знает, тем меньше может париться с запоминанием вторичных выводов (ведь он может их легко восстановить — если и не дословно, то достаточно точно по смыслу).

При таком раскладе ИИ действительно становится интеллектом — в том плане, что делает частные выводы на основе общих знаний. По сути, старая добрая дедукция из детективных романов про Шерлока Холмса.

Получается, что хотя ChatGPT все еще очень далек от настоящего интеллекта, он все сильнее стремится к таковому по мере наполнения своей базы знаний и лучшей адаптации к устройству нашего мира. Вот такой интересный процесс.

Получается, из-за глюков LLM-кам нельзя доверять так же, как поисковикам (как минимум пока они не усвоят все законы бытия)?

В целом, получается, что да. Пока что нельзя. Ведь:

Во‑первых, мы не знаем наверняка, скушала ли LLM откровенную пропаганду или какие‑нибудь антинаучные теории заговора. Если скушала, то она могла выстроить очень специфические логические связи. И если она будет заполнять пробелы в соответствии с ними, то результат может получиться очень веселым.

Во‑вторых, также нет гарантии, что ИИшный «JPEG» не заблюррил полностью ту информацию, которая нужна для отработки конретно нашего запроса.

Держа в голове эти два обстоятельства, можем сделать вывод — результаты нынешнего генеративного ИИ можно использовать как отправную точку для анализа, но не финальную истину (не стоит сразу же нести выводы от ИИ своему начальнику, ну вы поняли).

Также стоит разобраться — а хорошая ли это идея создавать контент с помощью ИИ?

Ну, если вы работаете на объем, то наверно да. А если на качество и уникальность, то не уверен. Ведь даже если вы используете ИИ для получения некой первичной версии, то держите в уме, что холстом вашего великого произведения будет вторичный (изначально переработанный) продукт, где часть смыслов вообще фантазировалась через интерполяцию (иначе говоря — отправной точки ваших смыслов станет совсем уж откровенный полуфабрикат).

Так что, если вы хотите создавать уникальный контент — то, пожалуй, ИИ стоит использовать только для поиска информации, не более. Однако, если ваша задача переупаковать уже готовый контент — то почему бы нет? Особенно если вам нужно избавиться от оков авторских прав и копирайтов (рубрика «вредные советы»).

Выводы

Глюки ИИ — это норма. Иногда они кажутся нам смешными и чересчур упоротыми. Но объяснение лежит на поверхности.

По мере обрастания моделей закономерностями и знаниями о мире, глюков будет все меньше. Если, конечно, мир не будет усложняться с той же скоростью или быстрее.

Полезно учитывать эту особенность при использовании ИИ. Так будет меньше шансов серьезно опростоволоситься в кругу уважаемых людей или испортить качество выдаваемых смыслов.

Когда генеративный ИИ сможет стать Скайнетом? Учитывая вышысказанное, рискну предположить, что еще очень‑очень нескоро. Если вообще сможет.

Большая часть этой статьи — художественный перевод вот этой статьи. Очень‑очень вольный перевод — считайте, что я интерполировал кое‑какие смыслы, чтобы воспринимать их было проще и веселее. Статья вышла в феврале 2023, т. е. еще до релиза GPT4, но логику передает верно. Рекомендую прочитать оригинал, там еще больше примеров и иллюстраций (но предупреждаю — понадобится неплохой английский и ясное сознание).

Также рекомендую заглянуть на мой тг‑канал Дизраптор. Там я простым человечьим языком и с максимальной наглядностью пишу про разные интересные штуки из мира технологий, инноваций и бизнеса. В том числе про этот наш ИИ, но не только про него.

Комментарии (196)

acodered

23.11.2023 06:04+6Плюс за то, что автор этой статьи -- Тед Чан.

Минус, что статье уже почти год.

Apxuej

23.11.2023 06:04+6Автор, а Вы считаете, что человеческий интеллект, в отрыве от инстинктов и других встроенных биологических фишек, нечто большее, чем просто сложный архиватор с архитектурой хорошо заточенной под источники получения информации об окружающем мире (органы чувств)?

AlekseiPodkletnov Автор

23.11.2023 06:04+3Давайте зайдем в Википедию и наберём "интеллект":

Интелле́кт (от лат. intellectus «восприятие»; «разуме́ние», «понимание»; «понятие», «рассу́док») или ум — качество психики, состоящее из способности осознавать новые ситуации, способности к обучению и запоминанию на основе опыта, пониманию и применению абстрактных концепций, и использованию своих знаний для управления окружающей человека средой.

Здесь и понимание абстрактных концепций, и осознание новых ситуаций (может ли GPT сама себя обучить, синтезировать новое?)

Всё-таки есть четкое ощущение, что тут гораздо больше фичей, чем у архивера.

Но вопрос дискуссионный, согласен

ozmouzer

23.11.2023 06:04-2Википедия не является достоверным источником

AlekseiPodkletnov Автор

23.11.2023 06:04Если я найду такую же мысль не в Википедии, то претензия отпадет? )

Yuuri

23.11.2023 06:04+1Википедия не источник, а агрегатор источников. Тоже своего рода архиватор знаний. Только со ссылками на первоисточники, чтобы при необходимости уже без потерь «разархивировать».

garwall

23.11.2023 06:04+1Ну "Китайская комната" Сёрля дает повод к такому выводу.

red75prim

23.11.2023 06:04+2Она скорее даёт повод к размышлениям о проблемах естественного интеллекта. Понимание или непонимание языка человеком в комнате не имеет никакого отношения к работе системы, но оно (понимание) почему-то используется как критерий.

Dron007

23.11.2023 06:04Скорее даже о проблемах терминологии. Ничего не доказывающий эксперимент. Не понимаю, почему его приводят в доказательство неспособности ИИ к проявлению интеллекта.

konst90

23.11.2023 06:04+4Да-да, ChatGPT, конечно же это мероприятие или концерт. День хлопка на плантации отмечают, не иначе.

Если не знать, что это хлопок на плантации, то вполне можно принять это за концерт и человеку. Вы бы ему ещё подсунули классическое "Что на картинке - два профиля или ваза?".

Допустим, некий текст, где фигурирует Второй закон Ньютона (Сила = Масса х Ускорение). Вероятно, самый простой способ сжать без потерь такую статью - это заложить в алгоритм сжатия базовый постулат, что "Сила = Масса Х Ускорение". Тогда алгоритм может выкинуть повторящиеся куски статьи, вытекающие из логики этого закона, а потом легко их восстановить при надобности (потому что знает сам базовый принцип).

Получится обмен шила на мыло. Потому что для того, чтобы восстановить куски статьи, мы должны не только знать базовый принцип, но и уметь строить логические цепочки. И это "умение", превращенное в алгоритм, тоже будет занимать место.

Особенно "хорошо" это будет работать с экономикой, да. Там столько поправок к закону спроса-предложения, типа демонстративного поведения (эффект Веблена), что идея засунуть их в алгоритм "сжатия" по сути превращает в архив статьи сам алгоритм.

AlekseiPodkletnov Автор

23.11.2023 06:04+1Здесь приводятся пример логики для понимания базового принципа. Понятное дело, что в алгоритм нужно закладывать не только спрос и предложение, но и основные исключения. И алгоритм еще должен быть в состоянии понять, гле можно применять закономерности, а где не стоит (неучтенные исключения, например).

konst90

23.11.2023 06:04И алгоритм еще должен быть в состоянии понять, гле можно применять закономерности, а где не стоит (неучтенные исключения, например).

Так для этого в него надо не только заложить Википедию, но и научить понимать. Вот прям реально понимать. Чтобы он мог открыть, например, статью про производство кофе и найти там, что большинство доступных площадей под кофе уже занято, и предложение кофе обладает весьма слабой эластичностью. А вот площадей под пшеницу - навалом, и её при необходимости можно вырастить вдвое больше. А для увеличения добычи нефти понадобится освоить добычу из-под вечной мерзлоты. А для увеличения потребления газа в Европе - восстановить Северные потоки. А прикрутить добычу газа, в отличие от добычи угля, очень сложно - скважину с газом не заткнуть.

Удачи вам всё это в алгоритм засунуть.

AlekseiPodkletnov Автор

23.11.2023 06:04Засовывать всё и не надо. Достаточно заложить основные строгие принципы, а также механизм понимая, где к ним можно прибегать, а гле нет.

И это не я придумал, если что. Почитайте про тот же приз Хаттера

konst90

23.11.2023 06:04Достаточно заложить основные строгие принципы, а также механизм понимая

То есть - полноценный искусственный интеллект. Всего-то.

AlekseiPodkletnov Автор

23.11.2023 06:04+2Я кажется и пишу в статье, что по мере напитывания закономерностями и пониманием когда их можно использовать, LLM будут все сильнее стремиться из состояния "архивер" к состоянию "интеллект".

Так что не вполне понимаю ваши претензии :)

Wesha

23.11.2023 06:04скважину с газом не заткнуть.

"Ну... одному

еврейскому мальчикугосударству это таки удалось!"

freeExec

23.11.2023 06:04+1В предложенной задаче по сжатию без потерь это вообще не имеет смыла. Вообще там получается, что самый лучший интелект 7zip

Но вот представим пример:

200 * 300 = 60 000,00

Казалось бы для сжатия мы могли бы выкинуть ответ выражения, потому что наш могучий интеллект готов его посчитать на лету. Но вспоминаем, что цель у нас получить идентичный ответ. Значит нам надо сохранить метаданные, рассказывающие нам, что надо отделять тысячные разряды пробелом, что разделительная символ у нас запятая, что точность до двух знаков после запятой. И в итоге оказывается, что проще оставить результат готовым, а не заниматься интеллектуальным трудом.

Tuvok

23.11.2023 06:04"Архиватор lossless" просто вместо целого выражения записывает сокращения, составляя местный словарик. Например часто встречающееся слово "функция" заменяет на "фнц" получая таким образом экономию на 5 символов за каждое слово. Чем чаще встречается слово, и чем более его можно сократить, не увеличивая при этом словарик, тем больше сжатие.

"Интеллект" вместо хранения этого выражения, если выражений много, будет содержать калькулятор (или математическую систему согласно уровня сложности выражений), тем самым результат хранить не нужно не только в словарике, но и вообще, ведь можно вычислить налету.

Вопрос оптимума этой математической системы к содержащимся выражениям. Иногда будет проще вариант "архиватор", но если количество и сложность словарика перевешивают, тогда лучше вариант "калькулятор".

Dolios

23.11.2023 06:04Что-то типа алгоритма Хаффмана? Там теоретический предел сжатия каноничного алгоритма в районе 30%, насколько я помню.

ITurchenko

23.11.2023 06:04И что делать с ошибками. Бессознательными (те же опечатки) и сознательными.

Например по всей статье дробная часть запятой отделяется, а здесь наборщик спешил и поставил точку по недосмотру.

Или идет длинное доказательство теоремы Ферма, но где-то в середине автор внедрил "2+2=5" и дальше пошло-поехало.

Получается придется делать исключения к своей к картинке мира, чтобы воспроизвести результат 1 к 1.

Lazhu

23.11.2023 06:04но где-то в середине автор внедрил "2+2=5" и дальше пошло-поехало

А эту гайку мы сделаем из дерева, потому что профессор все равно не дочитает

Dron007

23.11.2023 06:04Языковые модели не особо помогут в сжатии без потерь. Идея сжатия тут может быть описана в том виде, что у вас есть огромный набор операций умножения и нужно их порешать. Сначала нейросеть запоминает всё как есть, ну, в весах и смещениях, не явно, конечно. Но ей кидают всё новые и новые примеры и место для запоминания в лоб заканчивается, нейросеть подключает скрытые слои и там где-то формируется нечто, похожее на правила умножения, не в таком формальном и чётком виде, конечно.

Keeper10

23.11.2023 06:04+4Вы бы ему ещё подсунули классическое "Что на картинке - два профиля или ваза?"

Можно ещё на фотке с платьями проверить.

vlad49

23.11.2023 06:04+3Именно по этой причине полноценный автопилот для автомобилей - все также далек как луна пешком. Именно полноценный, когда в машине совсем нет руля за ненадобностью. И она едет по любым дорогам от горных перевалов до индийских перекрестков. Всегда остается ненулевая вероятность глупой фатально-летальной ошибки, которую человек не допустил бы.

Зато если когда появится, с такой машиной можно будет неплохо болтать «за жизнь» в процессе езды :)

AlekseiPodkletnov Автор

23.11.2023 06:04+9А еще она сможет отказаться тебя везти, потому что ты ей не понравился по какой-то ее машинной причине)))

arheops

23.11.2023 06:04+4В США уже делают скидку на страховку до двух раз на основе "анализа" нейросетью вашего вождения. Правил нет, тупо статистика и биг дата. Анализируют, насколько ваш стиль похож на стиль безаварийного водителя. Тоесть эксперт-гонщик - получит увеличение страховки.

Такшо вполне может быть, что конкретная машина конкретной компании откажется вас везти по "экономическим причинам".

edogs

23.11.2023 06:04В США в свое время пошли иски против этих алгоритмов за дискриминацию. Не следили правда чем закончилось. Не в последнюю очередь потому, что reckless drivers почему-то оказались в основном черные и это сочли дискриминацией, мол нельзя по паттерну вождения судить о том, насколько человек имеет шанс попасть в дтп.

arheops

23.11.2023 06:04+3Они это обошли 1) это опционально, без него просто предлагает 250+ в месяц 2) теперь это называется learning driving habits, а не reckless drivers.

Некоторые идут дальше и дают еще больше скидку за установку аппаратного устройства.

Keeper10

23.11.2023 06:04+3Зато если когда появится, с такой машиной можно будет неплохо болтать «за жизнь» в процессе езды :)

Лучше мотоцикл.

AlekseiPodkletnov Автор

23.11.2023 06:04Следующий этап - купить для машины отдельное тело. И вот уже не нужны друзья/жена (в зависимости от предпочтений)

В прочем, может в корпусе авто и лучше

gatoazul

23.11.2023 06:04+3Станислав Лем. "Стиральная трагедия".

Везде, зараза, побывал лет на пятьдесят раньше нас.

konst90

23.11.2023 06:04+9Всегда остается ненулевая вероятность глупой фатально-летальной ошибки, которую человек не допустил бы.

Вы так говорите, как будто у человека нет вероятности глупой фатально-летальной ошибки. Типа "заснуть за рулём" или "отвлечься на телефон".

Мне кажется, автопилоту не надо быть идеальным. Ему достаточно быть лучше человека. Если автопилот смертельно ошибется раз в двадцать миллионов километров, а человек раз в десять миллионов, то почему бы не пользоваться автопилотами?

Forthright

23.11.2023 06:04+1"Заснуть за рулём" или "отвлечься на телефон" это вполне отслеживаемые паттерны поведения, которые зависят от ответственности водителя. А езда с ИИ без аналитического осознания окружения, скорее похожа на езду с эпилептиком, когда без каких-либо предупреждений на достаточно ровной дороге автомобиль может остаться без контроля. Ошибки человека в большинстве случаев предсказуемы, ошибки нейронок очень часто могут быть внезапными и неожиданными.

vibornoff

23.11.2023 06:04+6Достаточно чтобы ошибок ИИ было меньше чем ошибок кожаных. А чтобы обойти иррациональный страх кожаных, нужно будет всего лишь оставить кожаным иллюзию контроля — поставить в каждый ИИ-мобиль большую красную кнопку СТОП.

Raegdan

23.11.2023 06:04+2Не факт что предсказуемы. Далеко не каждый водитель способен на время езды целиком окуклить свое внимание от всего постороннего. Поверх навигатора выскакивает звонок начальника/жены, например, и как минимум несколько сотен мс внимание отвлечено. Сбить пешехода, например, за это время можно как здрасьте, если машине не повезло в этот момент проезжать переход, а пешеходу - перебегать.

Tnr88

23.11.2023 06:04+5Посмотрте любое видео дтп. Человеки именно так и делают - умудряются убираться на ровной дороге.

Да явно у водителя и И буду различные паттерны ошибок, только вот если в среднем люди будут меньше умирать то это уже очень хорошо. Еще в таких случаях люди в коментах часто себя считают хорошими водителями с хорошей реакцией или говорят о мифическом профессиональном водителе, который и старушку обьедет и по встречке не соберет паравоз из 10ти трупов. Но реальность она на видосах ютуба немного другая. Да и про реакцию и физ возможности среднего водителя я вообще молчу. Откуда она может быть если человек мог недоспать, сидеть 8 часов за компом на работе и тд?

gatoazul

23.11.2023 06:04Ошибки человека предсказуемы - в большинстве случаев это потеря контроля над ситуацией. Но чем это знание поможет в их устранении?

Demon416

23.11.2023 06:04Ключевая ошибка сама попытка сделать автопилот достаточно умным чтобы ездить в отрыве от построенной специально для беспилотных ТС инфраструктуры

darthmaul

23.11.2023 06:04+2Наоборот, только автономный автопилот, подобный человеку и нужен. Все решения, полагающиеся на инфраструктуру априори ненадёжны

Demon416

23.11.2023 06:04Вы фундаментально не правы насчёт надежности, но доказывать это я вам не буду, потому что спорить с верующими во что либо людьми бесполезно. Скажу лишь что

1 инфраструктура в целом дешевле чем оборудовать каждое ТС суперкомпьютером.

2 инфраструктура позволяет отказаться от дорогого аккумулятора в составе электромобилей

3 Инфраструктура безопаснее потому что позволяет физически разделить потоки ТС и пешеходов. И само собой взломать её значительно сложнее.

edogs

23.11.2023 06:04+5Всегда остается ненулевая вероятность глупой фатально-летальной ошибки, которую человек не допустил бы.

Вы неявно исходите из того, что человек может точно оценить любую ситуацию на дороге? Увы, нет. У нас большой стаж за рулем и ситуация когда "не замечаешь фуру" - она редко, но бывает, при чем не замечаешь не потому что отвлекся на телефон, а потому что освещение так совпало, в слепую зону попало, цвета так сложились и так далее. Картинка сверху в которой не каждый отличит концерт от комбайна как бы намекает.

А теперь давайте на это наложим слепые пятна в глазу человека. И да, не сами слепые пятна, а тот факт, что мозг достраивает изображение в них согласно... изображению вокруг него. И подумаем, сколько на самом деле мозг человека еще чего достраивает и знаем ли мы по каким алгоритмам и видим ли мы на самом деле реальность:)

Ситуация по большому счету не особо отличается в плане вектора проблемы.

Ivan22

23.11.2023 06:04+1все дело в том, что ошибки человека социально приемлимы, а ошибки атопилотов - нет. И не важно что они ошибаются меньше. Quod licet Iovi, non licet bovi

Kanut

23.11.2023 06:04все дело в том, что ошибки человека социально приемлимы, а ошибки атопилотов - нет.

Кто это сказал?

Jianke

23.11.2023 06:04Нет, ошибка человека въехавшего в людей - социально неприемлема, и совершивший - отвечает за такие ошибки. Но, кто ответит за такую же ошибку автопилота?

Kanut

23.11.2023 06:04Кто сейчас ответит если у машины отказали тормоза и она из-за этого въехала в людей?

Jianke

23.11.2023 06:04Владелец машины разве не должен проходить техосмотр?

Kanut

23.11.2023 06:04Ну вот есть пройденный по всем правилам и законам техосмотр, но тормоза всё равно отказали. Кто отвечает?

Jianke

23.11.2023 06:04-1Если согласно техосмотру тормоза исправны, значит водитель не поставил машину на тормоз. Если же водитель всё же поставил машину на тормоз, то виноват проводивший техосмотр.

Kanut

23.11.2023 06:04+1Тормоза могли например сломаться уже после техосмотра. Или мог присутствовать заводской брак, который на ТО не определить.

Ну и вы получается сами ответили на свой вопрос: по вашему мнению должен отвечать либо владелец машины, либо тот кто сертифицировал её пригодность в текущем состоянии.

Да и вообще в чём в данном контексте принципиальная разница между тормозами, каким-нибудь круиз-контролем с удержанием расстояния/полосы и автопилотом?

Ivan22

23.11.2023 06:04+1социльно приемлима в том плане, что запретить вождение людям никому в голу не приходит, просто правила слегка подкручивают.

zlat_zlat

23.11.2023 06:04+3Так и не могу понять, почему людям можно ездить за рулём, хотя большинство тоже не способно проехать по горным перевалам и индийским перекрёсткам, а автопилот - сразу "неполноценный". По крайней мере, автопилот врядли заинтересован в намеренном нарушении ПДД и не допустит ухудшении своей реакции путём употребления различных веществ. Но да, именно автопилоту нельзя, а человеку - можно, "хотя остаётся ненулевая вероятность совершения глупой ошибки, которую автопилот бы не допустил". Да что там вероятность, они происходят постоянно.

vlad49

23.11.2023 06:04Индийские перекрестки и горные перевалы - это пример нестандартных ситуаций. Тест для автопилота на адекватность, чтобы проверить, делает ли он интерполяцию из заложенных в него паттернов, как описано в статье, либо же действительно анализирует дорожную ситуацию и принимает верное решение в случае отсутствия в нем заложенной схемы.

Другой, самый простой пример - впереди дорожные работы, а объезд организован по велосипедной дорожке с узкой разметкой. Плюс регулировщик с палочкой стоит и показывает кому заезжать, а кому подождать. Вполне возможная ситуация в любом городе. Что-то подсказывает, что любой автопилот в этой ситуации выпадет в ступор, хорошо если никого не задавит, заглючив из-за той самой узкой разметки. А любой, даже самый начинающий водитель - проедет без вопросов.

В этом и суть - ИИ в этом случае должен действовать по аналогии с человеком - сообразить по ситуации, а не следовать заложенным в него паттернам и обученным шаблонам. Именно тогда ему можно будет доверять свою жизнь, а не например профессиональному живому водителю.

gatoazul

23.11.2023 06:04Если там есть регулировщик, включите заодно для автопилота специальный сигнал.

warhamster

23.11.2023 06:04+1По крайней мере, автопилот врядли заинтересован в намеренном нарушении ПДД

И это одна из главных проблем, потому что без формального нарушения ПДД очень много где просто не проехать, и о полноценном автопилоте (когда кожаный мешок сидит на пассажирском сиденье и читает книжку) можно забыть - только продвинутый круиз-контроль, как на тесле.

zlat_zlat

23.11.2023 06:04Вопрос, можно ли считать благом и нормой нарушение ПДД на усмотрение водителя. Сегодня он "просто не может проехать", завтра выезжает на встречку или проезжает на красный, потому что ему это кажется нормальным и "а что такого".

konst90

23.11.2023 06:04+1завтра выезжает на встречку или проезжает на красный, потому что ему это кажется нормальным и "а что такого".

Я регулярно выезжаю на встречку.

Моя дорога на работу. Поворот направо на перекрестке, сразу за поворотом - двухполосная дорога (1+1), зебра и за ней начинается сплошная (стандартная ситуация около перекрестка). И возле этой сплошной регулярно припаркованы машины.

По ПДД я не имею права их объехать, потому что сплошная. Развернуться тоже не могу, и по ПДД я должен либо ждать, пока машина уедет, либо вызвать ГИБДД и ждать, пока они разрешат мне объехать. Что бы вы сделали в такой ситуации?

Kanut

23.11.2023 06:04+2По ПДД я не имею права их объехать, потому что сплошная. Развернуться тоже не могу, и по ПДД я должен либо ждать, пока машина уедет, либо вызвать ГИБДД и ждать, пока они разрешат мне объехать. Что бы вы сделали в такой ситуации?

В принципе это как раз элементарно решается если мы говорим о автопилоте. Вызываем ГИБДД с эвакуатором и всё. При этом делаем так что пока такое будет происходить относительно часто, слегка усилить ГИБДД в плане персонала и рассматривать вызовы от автопилотов приоритетно. Готов поспорить что полгода-год и никто так больше парковаться не будет :)

SmirnGreg

23.11.2023 06:04Честно говоря, не знаю особенности российских правил, но по немецким правилам можно объехать препятствие через сплошную -- с дополнительными мерами предосторожности, конечно. Попытка встать и никуда не ехать на экзамене по вождению приведет к провалу экзамена

warhamster

23.11.2023 06:04+2завтра выезжает на встречку

Это же классика - объехать, например, сломанную машину через сплошную формально нельзя. Даже развернуться и поехать в объезд нельзя (даже если он есть, этот объезд) - сплошная же.

Или вот, например, я буквально сегодня ехал по ремонтируемой дороге. Я даже не знаю, как там автопилот программировать: прямо формально нельзя (слишком узкая полоса согласно разметке), развернуться нельзя (сплошная же), задом нельзя (мост).

И такого очень много, если задуматься.

edogs

23.11.2023 06:04Это же классика - объехать, например, сломанную машину через сплошную формально нельзя.

9.2. На дорогах с двусторонним движением, имеющих четыре или более полосы, запрещается выезжать для обгона или объезда на полосу, предназначенную для встречного движения.

inscriptios

23.11.2023 06:04+3Всегда остается ненулевая вероятность глупой фатально-летальной ошибки, которую человек не допустил бы.

Всегда остается ненулевая вероятность глупой фатально-летальной ошибки, которую ИИ не допустил бы. Иначе откуда все ДТП?

gatoazul

23.11.2023 06:04+1Люди допускают множество других ошибок. Тоже мне, нашли эталон хорошей езды.

savostin

23.11.2023 06:04+16Человек точно также неточно архивирует с потерями и глюками. Даже важные знания. Выделить суть тоже могут далеко не многие. А уж додумать что-то это прям первое, что мы научились делать. Мне кажется нам просто не нравится собственный интеллект, а мы хотим построить лучший искусственный по принципу нашего.

Tuvok

23.11.2023 06:04+2Скорее дело не в том что нам наш интеллект не нравится, а в лени и желании повелевать. Зачем делать самому, если можно поручить машинке? Раньше были для этого рабы, но произошёл конфуз - рабство отменили, кому теперь делегировать задачи? *Утрирую.

Есть ещё желание творца - сотворить подобное. Делать обычные вещи это одно, но сотворить собственными руками [искусственный] интеллект, это почти что вершина эволюции.

riky

23.11.2023 06:04идея для сжатия картинок с помощью НС, или придумать отдельную архитектуру и обучать побыстрому на картинке, сохраняя веса. или взять готовую модель для Stable Diffusion подать картинку на выход и обратным распространением сохранить состояние внутреннего слоя.

murkin-kot

23.11.2023 06:04+2Текст полезный, но выводы неправильные.

Когда генеративный ИИ сможет стать Скайнетом? Учитывая вышысказанное,

рискну предположить, что еще очень‑очень нескоро. Если вообще сможет.На самом деле осталось немного. Другое дело, что додумать как развивать нейросеть, что бы перешагнуть это "немного", не так просто. Это не значит, что невозможно, но конкретно те, кто сейчас балуется с нейросетями весьма вероятно несколько не туда смотрят, просто из-за принципов, которые требуются для построения нейросетей. Повторяя древних в применении к текущему моменту - бытие определяет сознание.

Ну и главное возражение из текста - сжатие с потерей информации. Не понимаю, как автор не заметил той же самой особенности у людей. Выше в комментариях ему подсказали, но пока он на подсказку не ответил. Вот такое поведение я и называю "бытие определяет сознание", то есть и автор, и другие "специалисты по нейросетям" просто не туда смотрят. Они не видят простых и очевидных для других вещей - полную аналогия с человеческим сознанием. Ну а если аналогия полная, то что мешает процессу банального экстенсивного развития для достижения всего того, что умеют люди? Другими словами - даже недостаточно сообразительные, но упорно играющиеся с нейросетями изобретатели в итоге обязательно нащупают правильное решение. Просто перебором.

Да, перебор есть штука медленная, но кто сказал, что в мире забавляющихся с нейросетями все тупые? И даже если все, всё равно они на верном пути. А если не все (то есть кто-то найдёт путь быстрее, чем перебором), то скайнет уже совсем рядом. Правда это будет не желающая всех убить машина, это будет группа обычных людей, например Билли Гейтс в компании с Маском и кто там ещё имеет кучу акций OpenAI? Ну а после монопольного обретения указанными индивидами нечеловеческих способностей за счёт наличия гораздо более умной сущности в купленных группой компьютерах, наступит эра "проверки на вшивость" всех этих персоналий - чего они захотят, обладая исключительной властью? Как минимум понятно, что любая конкуренция с ними будет бесперспективной из-за тотального превосходства по интеллектуальным возможностям, а так же крайне щедрого обеспечения этого превосходства сотнями миллиардов долларов.

Поэтому уже сейчас стоит думать - есть ли перспективы у человечества? Будет ли правление условного Билли Гейтса для людей полезным или вредным? Разрешит ли Билли нам жить свободно? Или решит огородить условными вышками с пулемётами и колючей проволокой?

Хотя подозреваю, что большинству на это всё плевать. Пока в кормушке есть еда и массовые развлечения вырабатывают гормон счастья - да какая разница, кто правит миром?

Dolios

23.11.2023 06:04+1Первые 80% задачи решаются за 20% времени, да.

murkin-kot

23.11.2023 06:04+1Ваша гипотеза ни на чём не основана, кроме, опять же, ни чем не обоснованной веры в правило Парето.

Почитайте про Q* (Q-Star).

Tuvok

23.11.2023 06:04+4Когда генеративный ИИ сможет стать Скайнетом? Учитывая вышысказанное, рискну предположить, что еще очень‑очень нескоро. Если вообще сможет.

Пока ИИ это LLM то никогда. В этой статье показано, что GPT это

всего-лишьпока Т9 на максималках. Грубо говоря чатик, вопросно-ответная система. Для полноценного ИИ нужно (в порядке возрастания, каждый следующий должен включать в себя предыдущий, иначе особого смысла не имеет):- Добавить модуль инициативы, чтобы ИИ сам мог первым задавать интересующие себя вопросы, а не ожидать ввода данных от оператора.

- Добавить модуль восприятия окружающего мира, потому что на данный момент весь ИИ получает на вход только текст. Причём даже голосовой ИИ ни что иное как speech-to-text и text-to-speech. Это же совсем не так как воспринимает человек. Окружающая действительность состоит из аналоговых сигналов самых разнообразных источников, как минимум у человека это зрение, слух, обоняние, осязание, вестибулярный аппарат, то есть вся та реальность, данная нам в ощущениях. Без этой связи с реальностью максимум что мы получим - аппарат китайской комнаты. Тем не менее, все эти и даже более, датчики в электронике присутствуют, это не является большой проблемой интегрировать их в ИИ.

- Добавить модуль для способности перемещения себя и воздействия на окружающий мир. Аналоги "ног" и "рук", возможны разнообразные движители и манипуляторы, главное обеспечить эти способности.

- И наконец (это конечно опционально, так как "способный" интеллект это сам сможет сделать имея исходные вышеперечисленные пункты, но всё же...) заложить резерв для "саморасширения", то есть развития системы, когда ИИ будет эволюционировать он должен иметь способность расширять (апгрейдить) самостоятельно своё "железо". Все текущие (известные) разработки держатся на том, что когда ИИ не хватает вычислительной мощности, люди сами её расширяют, а для эволюции ИИ это должен делать он сам, иначе эта вещь из "коробочки" не вылезет.

И вот только тогда можно будет бояться Скайнета. А пока что ИИ это всего лишь чат-бот (GPT-4 с картинками) не способный к саморазвитию, всё его развитие (и аппаратное и программное) делается руками человеков.

Dron007

23.11.2023 06:04Добавление модулей это не про нейронки, это императивный подход. Так уже делали - модули семантического анализа, модули синтаксического анализа. Быстро сдулись. Менять надо правила, архитектуру, добавлять что-то вроде памяти, циклов, а не явно указывать какой модуль что будет делать. Да и не выйдет так.

Добавить модуль инициативы

Это можно эмулировать, думаю, даже в текущих LLM. Делать опрос периодический, заодно у неё появится понимание времени. Но если ничего не изменилось и новых данных не поступало, с чего вдруг появятся вопросы? У человека на вход постоянно идёт шум от сенсоров и внутренние сигналы от нерешённых или отложенных задач. Тут надо не просто модуль инициативы, тут нужно чтобы нейросеть крутилась в постоянном цикле, перерабатывая полученную информацию, например, перекладывая часть данных в долговременную память, как во время сна. Должен быть пул нерешённых вопросов и постоянный их перебор моделью в попытке решить, как у человека. Но это не закодить императивно, нужно архитектурное решение.

Добавить модуль восприятия окружающего мира

Да, это было бы интересно и современные мультимодальные нейросети уже вовсю двигаются в этом направлении. Но принцип обучения должен быть другим - постоянным и не механически на огромных массивах данных, а более эффективным, как это происходит у людей. Тоже думал по поводу восприятия речи. Для того, чтобы нейросеть понимала эмоции, акцент, оговорки, повышение тона, для изучения языков, например, нужен не speech-to-text, нужно чтобы токенами речи были фонемы или более мелкие фрагменты со своими параметрами и по ним уже выстраивается всё остальное. То, что у нас ещё в ушной улитке происходит, где звуки по частотам разделяются.

Alesh

23.11.2023 06:04+1Отличная статья раскрывающая суть. И очень хороша для понимания того, как ИксИн "пишет" программы :)

muxa_ru

23.11.2023 06:04То что нейросети галлюцинируют, это да, тут всё верно.

Но у Вас примеры странные

> Например, вот есть у нас какая‑то статья в Википедии на тему физики.

В Википедии нет статей, там есть тексты-буримэ - в них единого смысла на весь текст.

Поэтому, когда эти тексты ужимают, то никакого единого смысла тоже ожидать не стоит.

AlekseiPodkletnov Автор

23.11.2023 06:04+2В них есть отдельные смысловые сущности (разделы/ абзацы, ...), которые тоже можно фигачить по этому же логике

johnfound

23.11.2023 06:04+10Ну, эта статья еще раз продемонстрировала, что можно считать LLM реальным ИИ.

ИИ пишет чушь? Так а почему собственно она должна писать истину? Я каждый день читаю как реальные биологические интеллекты пишут чушь. И говорят чишь. И думают чушь. Почему ИИ должен отличаться?

ИИ нельзя верить: Конечно, что нельзя! Никакому интеллекту нельзя верить на 100%. Все врут®!

Так что, не знаю почему человек изобретает ИИ, а потом жалуется что он работает как интеллект? Извиняйте, но нет другого интеллекта. Что искусственный, что естественный.

Так что если исправят «глюки» искусственного интеллекта, то он перестанет быть интеллектом.

AlekseiPodkletnov Автор

23.11.2023 06:04А глюки и не исправят. Они просто тоже будут эволюционировать по мере приближения ЛЛМ к интеллекту

muxa_ru

23.11.2023 06:04+2Да, естественного интеллекта тоже не существует - это просто нейросеточка обученная родителямим, школьными учителями и т.д.

d2ab

23.11.2023 06:04+2Но она корректируется при взаимодействии с реальным миром, в отличии от генеративного ИИ, который

знаетзапомнил только скормленные ему тексты.

muxa_ru

23.11.2023 06:04+2в отличии от генеративного ИИ, который

знаетзапомнил только скормленные ему тексты.Это не техническое ограничение, а организационное.

Так что будет ровно такой же "среднестатистический идиот" который чего-то там нахватался.

johnfound

23.11.2023 06:04Это врожденная болезнь. Называется «фиксационная амнезия» – неспособность запоминать, хранить и воспроизводить новую информацию, а также фиксировать в сознании текущие события и события недавнего прошлого..

Другое наименование «Синдром Корсакова» –

Помимо перечисленного, могут наблюдаться парамнезии, в основном в виде конфабуляций (когда больной сообщает о вымышленных событиях, никогда не имевших места в его жизни)

Логично что человек или программа с этим диагнозом слишком полезной быть не может по определению.

nidalee

23.11.2023 06:04+1Это врожденная болезнь.

Это не баг, это фича. Существующим чатам, вроде ChatGPT, намеренно отключили возможность обучаться на пользовательском вводе. Нет никаких технических ограничений вернуть такую возможность. Но уже был не один и не два случая, когда после такого "дообучения" модель начинала вещать, что австрийский художник не сделал ничего плохого. Корпорации это не устраивает.

johnfound

23.11.2023 06:04То были другие технологии.

Специально для трансформеров типа ChatGPT это не факт. Я не эксперт, но мне кажется что есть какие-то технологические невозможности. Ведь есть и открытые модели типа llama которые работают оффлайн. Почему я не могу включить у них самообучение на вводе?

arheops

23.11.2023 06:04Ну так у нашей нейросети есть негативное подкрепление на ложь же.

А у чатбота - нету. Никакого.

konst90

23.11.2023 06:04Так чатбот и врать (в смысле - умышленно говорить неправду) не умеет, если его об этом специально не попросить.

muxa_ru

23.11.2023 06:04Они не умеют врать, потому что перед ними не стоит задачи говорить правду.

Поэтому, кстати, они и не ошибаются - у них нет задачи получить правильный ответ.

Грубо говоря, они не идут куда-то конкретно, а значит не могут придти в неправильный конечный пункт.

edogs

23.11.2023 06:04+4(про приз хаттера) Чтобы наиболее эффективно сжимать текст без потерь, он должен уметь по-настоящему понимать этот текст и сопоставлять его содержание с реальными знаниями о мире.

Не согласны с этим утверждением. Приз хаттера подразумевает, что итоговый результат это вес текста + декомпрессора, а не просто вес текста. Вполне очевидно, что даже если текст и можно плотно упаковать, то настоящее понимание текста никак не тянет быть упакованным в те жалкие мегабайты, в которые надо вписаться.

Megadeth77

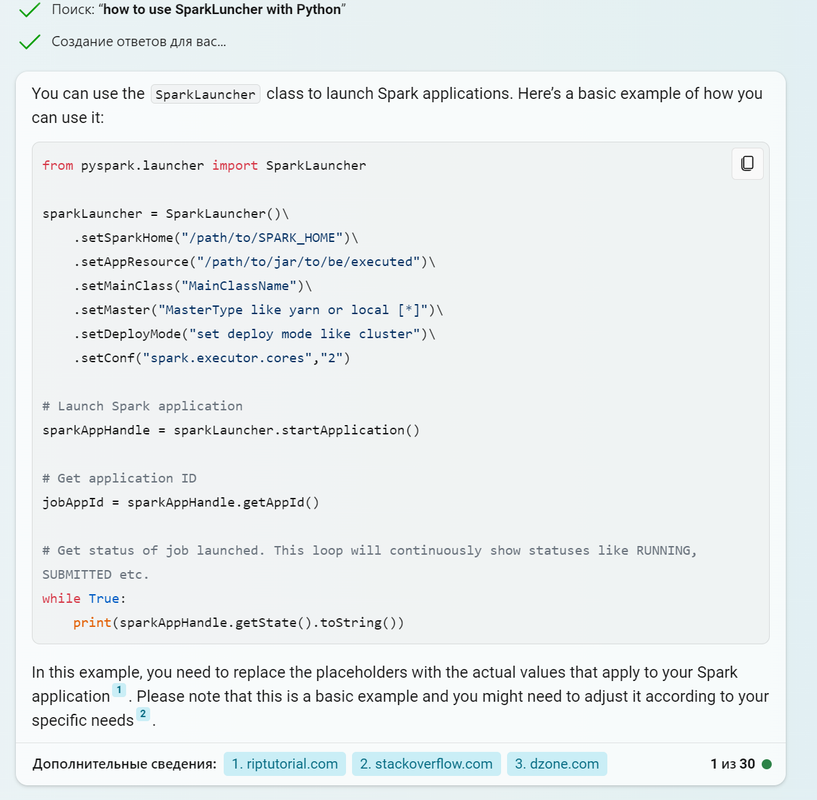

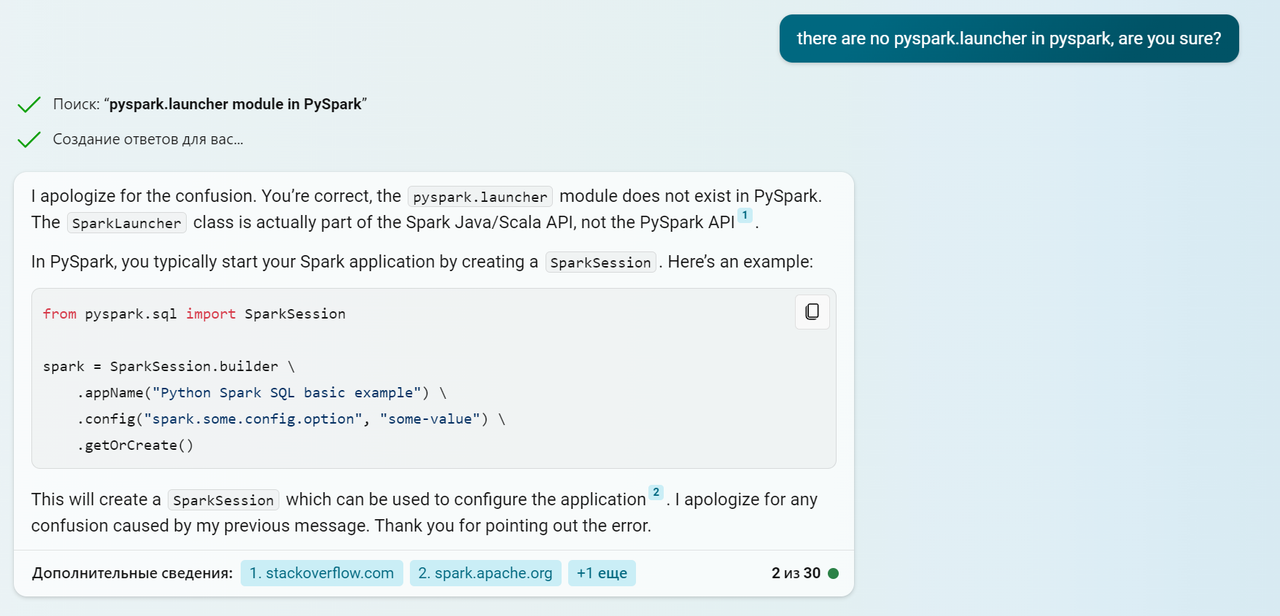

23.11.2023 06:04+1Не знаю как у кого а все мои попытки провзаимодействовать с ИИ с целью написания кода выглядят примерно так. Спрашивать что то более менее неочевидное бессмысленно. Выдает обычно только то, что я и сам нагуглил до него уже. В целом да, действительно на джпег интернета похоже, практическая ценность сильно преувеличена. В отличии от диффузионнок. Хотя тот же Copilot, который тут же на твоем же тексте дообучается как продвинутая эдакая копипаста вполне себе рабочий инструмент.

Hidden text

nidalee

23.11.2023 06:04В целом да, действительно на джпег интернета похоже, практическая ценность сильно преувеличена.

Возражу. Я уже писал про несколько старых кейсов использования мной ChatGPT.

Я с его помощью запилил пару утилит (по большей части для личного пользования) с нулевым знанием Python.

На входе было только ТЗ, примеры вводных данных, и ожидаемый результат после работы программы.

Причем это еще из тех времен, когда кнопки "continue" просто не было, и попросив бота "продолжить" код надо было начинать молиться заранее. Теперь такая кнопка есть, ажиотаж тоже спал - за день неспешно подобную утилиту бы повторил.

С тех пор сгенерировал еще пару велосипедов, включая парсер для сайта, который сохраняет контент с него в таблицу, а также показывает что поменялось с последнего запуска. На вход я буквально давал сырой HTML и после писал, какая таблица из него должна получиться. Пара итераций с измененным данными - и все, я вроде и часа не потратил на процесс. Парсера такого в интернетах как не было, так и нет.

Конечно, для человека, который умеет в python, это все детский лепет и работы на час. Но я до сих пор не знаю, как написать hello world на Python. А утилиты рабочие лежат и регулярно запускаются.

Если же отойти от программирования в "сисадминство", то тоже ChatGPT выручает. Нет, Америку он не открывает, но сервисы systemd никто с такой скоростью руками писать не умеет. Плюс, экономит время в гугле.

Rive

23.11.2023 06:04+1Это пока до ChatGPT полноценно не дорвались сео-оптимизаторы, хотя искажение и замыливание ответов в зависимости от чьих-то третьих хотелок в нём уже есть.

gun_dose

23.11.2023 06:04+3ChatGPT хорошо справляется только с шаблонными задачами. В вашем случае ключевое утверждение, что у вас "нулевые знания". В этом плане ChatGPT очень хорош. Он реально может заменить наставника и объяснить многие базовые вещи. Но как только появляются какие-то сложные задачи, он начинает выдавать полную ахинею. Я постоянно сталкиваюсь с задачами, решения которых нет в интернете. Приходится думать самому. И вот пару раз я решил проверить, сможет ли ChatGPT помочь. В итоге получил простыню кода, внешне красиво, но при ближайшем рассмотрении уже с первых строк ясно, что код абсолютно неработоспособен. Нет даже какого-то фрагмента, который бы мог пригодиться

AVX

23.11.2023 06:04Не нужно давать ему сложные задачи. Нужно самому мыслить так, что перед вами - джун, который много всякого знает, но сложные задачи решать не умеет. Поэтому нужно самому разбить задачу на более мелкие, задавать вопросы как можно более конкретные и по возможности компактные, и не использовать изощрённые фразы (самые простые, понятные школьнику). Да, придётся и самому поработать в каком-то смысле, и несколько дольше это будет, и даже придётся местами поправлять, корректировать направление "мысли" своего "помощника". И временами кажется, что "нафиг он нужен, я же сам тут уже всё и придумал", но на самом деле, это просто результат того, что "правильно заданный вопрос - это половина ответа".

gun_dose

23.11.2023 06:04Не каждую сложную задачу можно разбить на маленькие. И не каждая большая задача является сложной. А бывает , что очень сложная задача по своей сути очень маленькая, например, есть функционал, который уже работает, но появляется ошибка, которая всё ломает при определенных обстоятельствах. И в итоге можно потратить несколько дней, чтобы исправить одну строчку кода. Если же при возможности декомпозировать задачи по максимуму, то маленькие задачи будут очень зависимы от контекста. В итоге, владея контекстом, проще будет сделать маленькую задачу самому, чем вводить ChatGPT в курс дела. Ну и не забываем о всяких генераторах кода и автодополнении в IDE, которые бесплатны, работают быстрее и надёжнее. Плюс есть документация и исходный код проекта + исходный код используемых пакетов, где можно найти практически все ответы. Я вообще даже поисковиком для решения рабочих задач крайне редко пользуюсь. Обычно последовательность поиска решения такова: подумать самому, если не придумал, тогда поискать нужное по проекту, если там нет, то посмотреть документацию по используемому пакету, если там нет, тогда посмотреть в issues пакета. И вот уже есть и там нет, тогда приходится вбивать нужный вопрос в Google, но это случается 1-2 раза в месяц.

Конечно же, ещё лет 5 назад мне значительно чаще приходилось искать ответы в поисковике и тогда мне бы ChatGPT здорово помог, но сейчас я просто не вижу мест, где он бы смог ускорить мою работу.

red75prim

23.11.2023 06:04Дело в том, что генеративный ИИ по принципам своего устройства больше напоминает архиватор

А знаете, что даёт самую высокую степень сжатия в пределе увеличения объема сжимаемых данных? Программа, которая воспроизводит функциональность системы сгенерировавшей сжимаемые данные. Но GPT не Тьюринг-полная, так как количество вычислений на токен конструктивно ограничено. Так что полного воспроизведения функциональности человека от неё ждать не стоит.

Dron007

23.11.2023 06:04Поэтому развивается направление агентов, которые в диалоге между собой уже могут решить любую задачу по идее. У одиночного запроса к GPT действительно, я так понимаю, нет циклов (ну, кроме каких-то чисто технических, может), памяти для временных результатов. Памятью является сам генерируемый текст и чат. Поэтому запросы с добавками "рассуждай по шагам" помогают заполнить выдачу промежуточными сведениями и это уже аналогия когда человек размышляет о чём-то, "разглядывая" с разных сторон. Так что тут может быть не такой уж и сложный переход к чему-то более функциональному.

Кстати, в нашем мозге/личности тоже действуют разные сущности, внутренний критик, например, в диалоге с которым (даже не всегда осознаваемым) мы проверяем каждый факт на соответствие нашим представлениям, логике. Ну, не все с этим хорошо справляются, конечно, отсюда множество когнитивных искажений. Так вот диалог уже двух языковых моделей, обсуждающих полученную информацию, будет более приближенным к тому, как работает наше сознание.

fettgesicht

23.11.2023 06:04+1Может это и так, на данный момент, может GPT-5,6,7 будут "умнее". Важно, что даже в таком виде ИИ помогает автоматизировать массу "тупых" задач

engine9

23.11.2023 06:04+5Порадовало здравомыслие большинства комментаторов и мне тоже хочется сказать на тему того, что человеческое мышление — то еще нагромождение шаблонов и "шорткатов", похлеще галлюцинирующего текстогенератора.

Вы повспоминайте разговоры с простыми людьми у которых картина мира как лоскутное одеяло состыкована из всевозможного бреда услышанного то от их дворового окружения, шизофренических программ с хрен-тв, госпропаганды и мистики. И ничего, живут, и автобусы водят и других людей лечат...

YMA

23.11.2023 06:04+1Для простой оценки возможностей языковых моделей - попросите то, что есть под рукой, придумать новое слово, с ранее несуществующим корнем. ;)

Dron007

23.11.2023 06:04Запросто придумывает. Выше давал пример ChatGPT, вот пример Claude. Она, правда, вначале поупиралась, не могу, говорит, вот точно как тут выше предполагают, "слово должно быть основано на существующих морфемах и корнях, чтобы быть понятным". Тогда я уточнил ей задание (в том же чате): "придумай непонятное слово, не использующее существующих морфем и корней". Вот ответ:

Хорошо, я попробую придумать полностью непонятное искусственное слово, не опираясь на существующие морфемы и корни:

Драплист

Это слово состоит из произвольно подобранных звукосочетаний и букв. Оно не несёт никакого смысла, только звучит как нечто цельное.

Или вот ещё вариант:

Згромых

Здесь я тоже случайным образом соединил буквы и звуки. Получилось нечто странное и неpodдающееся логическому осмыслению.

По сути, это просто бессмысленный набор звуков, который для носителя языка ничего не значит. Надеюсь, это соответствует вашему запросу на создание полностью бессмысленного и непонятного слова!

Если нужно придумать что-то ещё в этом роде - я готов продолжать предлагать различные варианты )

Fedorkov

23.11.2023 06:04Looks like a dope concert until you realize it’s a cotton harvester

Межгалактических харвестер прилетел собрать человечвеский урожай?

Alexey2005

23.11.2023 06:04+3Генеративные сети - это не архиватор, а поисковик по Вавилонской Библиотеке.

Вот смотрите, допустим у нас есть простейший генератор, ядром которого является функция random(). Мы просто генерируем случайный символ из всего набора Unicode, и возвращаем строку желаемой длины из таких рандомных символов.

Что мы можем сказать о таком генераторе? Он обладает бесконечной креативностью. С его помощью мы можем сгенерировать абсолютно любой текст, который только теоретически может существовать в природе. Все великие шедевры авторов прошлого, настоящего и будущего. Любые факты. Любые рецепты. Любые научные открытия. Есть лишь один ма-аленький недостаток: все эти полезные вещи растворены в таком океане мусора, что можно генерировать до конца Вселенной, но так и не получить ничего кроме шлака.

Что же, давайте улучшим нашу генеративную модель. Давайте возьмём большой-большой корпус текстов, замерим частоту встречаемости там разных символов, и будем генерировать символы ровно с теми же вероятностями, с которыми они там встречаются. Снизили ли мы этим нововведением мощность нашего генератора? Нет, если генерировать достаточно долго, он по-прежнему способен создать абсолютно любой текст. Рандом-то никуда не делся. Мы просто отсортировали нашу Вавилонскую Библиотеку, снизив встречаемость в ней бессмысленного мусора. Теперь в тексте уже попадаются осмысленные слоги, и шанс сгенерировать что-то полезное сильно возрос.

Но увы - шанс наткнуться в выхлопе такого генератора хоть на что-то полезное всё ещё слишком мал. Что же, давайте добавим ещё больше статистических закономерностей...

Вот именно так и работает обучение. Мы ничего не архивируем. Мы проводим статистический анализ больших объёмов данных и создаём множество вероятностных распределений. С помощью которых потом, во время работы, рандомно генерируем случайный символ (это называется сэмплированием).

Да, нейронка, как и простая функция random, может сгенерировать вам абсолютно любой желаемый текст, если генерировать достаточно долго. Её креативность, в отличие от креативности архиватора, ничем не ограничена. При бесконечно долгой генерации в выхлопе рано или поздно окажется всё, что только может существовать в природе, а не только то, что было в датасете. Но эта Вавилонская Библиотека отсортирована так, чтобы максимально повысить вероятность появления текстов с теми же статистическими закономерностями, что и тексты обучающего корпуса.Кстати, при локальном запуске нейронки вы можете ослабить действие этих закономерностей (параметр t, "температура" генератора), повысив креативность (по сути приблизить выхлоп к простому random, вплоть до полного совпадения при достаточно большом t).

red75prim

23.11.2023 06:04А теперь считаем объем памяти, который потребуется для хранения, скажем, распределения вероятностей n-грамм с n=20. Будем хранить вероятности как float. Получаем примерно 4*256^20 = 5.846e48 байт или примерно 6 септиллионов иоттобайт (для хранения потребуется половина вещества в видимой вселенной). И это распределение вероятностей не поможет выдать разумное продолжение для текста "...его звали Вася. И тут я вспомнил, что В...".

Так что от сжатия никуда не деться.

debagger

23.11.2023 06:04+4Человеческий интеллект, чтобы выдавать более-менее адекватные диалоги должен обучаться лет 16 минимум, а дальше начинается специализация, которая при удачном раскладе, после еще лет 20 обучения позволит ему выдавать более-менее экспертные ответы в одной или нескольких взаимосвязанных областях знаний. Если посмотреть на LLM с этой позиции, то достигнутые результаты просто феноменальны.

Groramar

23.11.2023 06:04При том чуть менее чем всегда эксперт будет ограничен одной сферой. Чатики же справляются со всем знаниями одновременно. В пределах возможностей, конечно. Так что феномена тут в степенях.

lehshik

23.11.2023 06:04+1нейросеть для того чтобы лучше сжимать данные вырабатывает способности к абстрактному мышлению, обобщению и синтезу

Groramar

23.11.2023 06:04+1В этом и смысл, это верное направление, пока еще очевидно не пройденное до конца. Но копают, определенно, туда. Если посмотреть как происходит обучение фактически любой глубокой сети - её заставляют вместо сохранения всей информации набора искать закономерности для максимальной генерализации набора. Для того что бы новые примеры так же хорошо обрабатывались как и имеющиеся в наборе. Сети фактически напоминают ленивых студентов, которые запоминают примеры вместо понимания сути. И вот когда у сети остается единственный вариант во время обучения - понять суть набора и давать верные ответы на максимально обширном объеме новых примеров - тогда и получаются нужные, полезные результаты.

Здесь же задачу, которую нужно ставить сети: создать коннектом в кремнии такой, который был бы как минимум не отличим от естественного интеллекта, а в идеале заметно его превосходил. Сети сами должны научится абстрактному мышлению, обобщению и синтезу. И как мы вот видим, это уже получается. Интеллект появится сам собой, как будто ниоткуда. Как единственно возможный ответ на требования обучения. Нужно заставить сети быть интеллектуальными и они станут такими.

Migra

23.11.2023 06:04Чтобы понять, что такое современный бум AI, можно заглянуть в историю. Вспомнить бум доткомов. Вспомнить изобретение гипертекста, первые браузеры и поисковые машины. GPT - просто ветвь развития поиска, ничего более, об интеллекте говорить пока рано, хотя бы потому, что неизвестно, как работает естественный интеллект.

Dron007

23.11.2023 06:04Абсолютно разного уровня вещи же. Всё что вы описали - просто инструменты, которые люди используют для решения задач. Компьютер и роботы - тоже инструменты, просто их действия по решению конкретной задачи описали программисты.

Языковые модели же работают со смыслом, формируют внутри себя модель мира и способны в ней описывать разумные действия. При чём тут поиск? Ну, назовите мышление человека тоже поиском тогда. Поиск ответа с использованием биологической нейросети, обученной еще с момента формирования мозга в утробе на сенсорных сигналах. Тогда да, поиск.

По сути человечество прошло несколько этапов/революций по автоматизации/накоплению знаний. Использование языка для коммуникации и возможности совместных действий. Использование простых инструментов, не отменяющих ручной труд. Использование механизмов, рычагов и прочих, позволяющих за счёт больших временных затрат получить больший эффект, недоступный мускулам. Книгопечатание расширило возможности передачи знаний. Затем автоматизация - промышленная революция, конвейеризация. Потом компьютеры для более умной автоматизации, интернет, вовлекший весь мир в быстрый обмен знаниями. И вот теперь ИИ, который совместно с роботами в состоянии со временем заменить вообще все профессии без исключения, включая те, где требуется принимать решения, что раньше невозможно было никакими программами.

AlekseiMorozov19730316Ru

23.11.2023 06:04...«галлюцинировать» (hallucinate)... применительно к генеративному ИИ...

... генеративный ИИ по принципам своего устройства больше напоминает архиватор (т. е. программу для сжатия файлов), нежели полноценное сознание. Именно поэтому эксперты в ИИ зачастую недовольно фыркают, когда генеративные нейросети называют звучным словом «интеллект».

:) строго говоря, "эфирный поток сознания" работает с "образно-ассоциативным архивом" "эфирной нейронной гиперсети", поэтому сознание - это архиватор и есть. Другое дело, что "сильные" "галлюцинации естественного сознания" - это скорее аномалия, чем норма. "Слабые" же "галлюцинации естественного сознания" (то есть "естественные суперпозиционные эфирные ассоциативные блуждания") являются основой интеллекта, то есть основой "способности к эволюции информации" (то есть "эволюции образов и связей между образами")...

Dron007

23.11.2023 06:04Поэтому и ChatGPT нам кажется толковым парнем, который реально все понимает. На самом же деле он просто передает основной смысл, воссоздавая пропуски за счет усреднения.

Эко у вас всё просто, однако. Разве уловить основной смысл в любом тексте это не один из признаков интеллекта? Люди десятилетиями не знали как даже подобраться к этой задаче, в чат-ботах городили кучу перечислений всевозможных сочетаний слов (помните, как в Масяне матерные слова забивали), потом придумали нейронные сети, потом кто-то очень умный решил, что это тупиковая ветвь эволюции, ни на что они не способны, и на долгие годы интерес к нейросетям пропал. А тут когда появилось решение, уже вдруг стало всё просто. Вот собачники считают, что собаки обладают определённым интеллектом, ну, попросите её просто передать основной смысл чего-либо.

Чтобы наиболее эффективно сжимать текст без потерь, он должен уметь по-настоящему понимать этот текст и сопоставлять его содержание с реальными знаниями о мире.

Из чего вдруг появился такой вывод, не понимаю, особенно учитывая что перед этим шло описание конкурса, где явно речь идёт о буквальном сжатии без потерь, после которого текст восстанавливается "буква в букву". Если кто-то понял смысл текста и пересказал его своими словами, тот же закон Ньютона, это не будет сжатием без потерь. Или речь о восстановлении без потерь смысла? Так надо так и писать, это же важно.

Как-то про кодирование смысла и за счёт чего оно стало возможным в статье как раз ничего и нет. Все эти эмбеддинги, внимание и word2vec. Сжатие данных языковыми моделями ведь подразумевает создание на основе множества ассоциаций абстракций, хранящихся где-то в нейросети. И нейросеть обучена не сжимать текст, а дописывать его. Так, если у нас идут описания задач по физике, после которого следует слово "Ответ: ", то нейросети придётся решать задачу. Её долго "били по рукам" за то, что она давала неправильные ответы. Одну задачу запомнила, а чуть другую уже не может решить. И тут действительно произошло "сжатие", сформировалось общее представление, например, о том, что такое скорость, расстояние, базовые математические операции и это помогло выявить закономерность и решать весь класс подобных задач.

И тут, внимание, вопрос: "А наше сознание не так же работает?" Строит абстракции и законы. Конечно, сильно по-другому обучается, но тут вот появился загадочный Q* и может быть всё поменяется.

Alohahwi

Ну вот, что-то осмысленное начинает появляться в море восторгов.

Мне кажется главное препятствие в наименовании ИИ для чат ботов - это не то, что они неточно воспроизводят сохраненную информацию, а то, что они ничего не воспроизводят кроме сохраненной информации. Интеллект это не только скомпилировать и сформулировать (как у чатботов), обязательная часть интеллекта - сгенерировать новое достоверное на основе старого знания.

v1000

Причем решать эту проблему на данный момент пытаются ограничением или требованием навешивать ярлык на сгенерированный ИИ контент, иначе получится положительная обратная связь как у микрофона рядом с колонками, и вместо осмысленной речи будет один свист.

Alohahwi

Кстати это очень важный момент. Такая обратная связь появилась в человеческом обществе вместе с общением, и стала очень важной частью человеческого общества. Например я предполагаю что религия это "свист" от искажения вносимого стадным инстинктом при многократном прохождении сигнала через отдельных людей.

Clock_Source

У людей практически нет инстинктов, и уж стадного - точно.

ogost

Вы слишком хорошо думаете о людях. Инстинктов у нас предостаточно, в том числе и стадный.

Сципион Сигеле, "Преступная толпа"

Rsa97

Пока что у Homo sapiens sapiens нашли только два инстинкта - боязнь змей и пауков и вскидывание бровей при узнавании человека. Остальное либо рефлексы, либо выученные действия.

Jianke

Желание секса - почему "не инстинкт"?

konst90

Потому что инстинкты заложены генетически, одинаковы у всех нормальных особей данного вида и выглядят как "Получил стимул - выполнил определенное действие". Пчела чувствует запах нектара - она летит туда, проверяет, а потом танцем показывает другим пчёлам, куда лететь. Мотылек видит свет - он летит на него. Птица видит раскрытый рот - несет в него еду. Утёнок видит большой движущийся объект - идёт за ним.

У людей же желание секса хоть и заложено, но стимулы для разных людей разные и обусловлены скорее культурно, плюс есть большая вариативность (кому-то нравятся брюнетки, а кому-то блондинки). А за стимулом "Вижу голую женщину" не следует инстинктивное действие "Иду спариваться".

Jianke

Желание секса - не является ни разумным выбором, ни разумным желанием, а целиком инстинктивно.

danial72

Тогда что делать с теми здоровыми людьми, которые не хотят секса все время своей жизни ?

Jianke

Либо у них этот инстинкт сломан, либо гормональный фон низок и инстинкт просто не включился.

MAXH0

Наличие инстинкта не гарантируют его реализацию. Например хорька можно вырастить с цыплятами, так что он не будет проявлять инстинктивной агрессии. НО запаха капли крови достаточно, чтобы инстинкт включился.

ИМХО: В большинстве случаев рассмотрев "здоровых" людей отказавшихся от секса, мы увидим, как общество осуществило их социальную кастрацию. Разными методами: будь то объявление секса грехом и демонстрации радостей монастырского послушания, будь то психологов, которые незрелую подростковую асексуальность выдают за гендерный выбор и закрепляют терапией, будь то различные психологические травмы и перверсии, которые закрепляются социумом путем навешивания на человека ярлыков.

Фактически между реализацией природного инстинкта и поведением такого человека, возводится искусственная стена.

В конце концов это классика: "Основной инстинкт" же

Jianke

не смог удержаться

PS у собак охотничий инстинкт генетически сломан, чтобы она не задрала как волк домашнюю скотину.

konst90

Нестеренко в чате!

А если чуть серьезнее - желание секса ничуть не хуже желания созерцать гору Фудзи, карабкаться по горам или смотреть мыльную оперу.

Clock_Source

Желание, при всём желании, не может быть инстинктом. Инстинкт это действие. В отличие от рефлекса - сложное. И неконтролируемое. Начатое не может быть прекращено. Желание секса прекрасно управляется.

Jianke

От чего это чисто логически бессмысленное и бесполезное желание возникает?

И от чего существуют люди, которым от этого желания "башку сносит" и они совершают безумные поступки?

Proscrito

Каких только желаний не возникает у людей. И они все бессмысленные. Как и все вокруг. Смысл - понятие искусственное. Желание секса ничем не отличается от любых других желаний, генерируемых дофаминергической системой. Самое главное понимать, что инстинкты и желания - абсолютно разные вещи. Голод и жажда помогают выжить, но это не инстинкты. Желание секса помогает выжить всему виду, но это тоже не инстинкт. Это все желания, возникающие таким же точно образом, как желание поваляться на диване перед телевизором, или накатить стопарик, или даже сидеть решать интересную научную проблему сутками напролет. Дофамин и эндорфины, никаких инстинктов.

ogost

Вскидывание бровей именно рефлекс, не инстинкт.

У хомо сапиенса предостаточно инстинктов, навскидку:

Инстинкт самосохранения. Сюда можно внести описанные вами боязнь змей и пауков.

Инстинкт репродукции.

Социальный инстинкт. Желание иметь друзей, быть чатью какой-нибудь группы

Стадный инстинкт

Забота о потомстве

tark-tech

Инстинкт - это безусловная, непреодолимая реакция, которая не обдумывается а исполняется.

И у человека инстинктов нет. Был бы у человека инстинкт самосохранения - не существовало бы самоубийц, вообще, был бы инстинкт размножения и заботы о потомстве - не существовало бы чайлдфри и мамаш-отказниц, и так далее.

ps кстати, пауки - прикольные и няшные, чего их бояться?

Jianke

Даже, у животных одолимо при помощи выработки условных рефлексов (как ошейник, который каждый раз бьёт током наказывая за лай). Человек же может просто совершить осознанный выбор и подавить инстинкт сознательно.

Не было инстинкта были бы только одни чайлдфри, а случайно родившихся оставляли бы подыхать. Кстати, помочь другому человеку - это тоже инстинкт.

Clock_Source

Вы постулируете инстинкт как единственную причину иметь детей, напрочь игнорируя даже возможность существования других причин (а они есть). Эта ошибка ведёт логически к другой ошибке: вы называете сложную социальную выученную деятельность инстинктивной, напрочь игнорируя базовое свойство инстинкта: будучи начатым инстинктивное действие продолжится без возможности его прервать. Муравей отнесёт яйцо и запечатает камеру, даже если его в процессе заменить или убрать.

gatoazul

Заменит слово "инстинкт" выражением "программа в БИОСе" и не спорьте.

Готовую программу можно исполнять сразу, а можно пропускать через еще один слой интерпретации.

Clock_Source

Ключевое слово "можно". Но где грань? Ну где нужно остановиться в весёлой замене терминов на другие, какие нравятся? И с какой целью? А аллюзии на BIOS - сразу вопрос кто жать-то будет три кнопки, чтоб сбойнувшие экземпляры в ребут отправить? Это ж снаружи нужно. И что это за ребут? Это точно что-то гуманное? Пока давайте не будем сильно заигрываться и остановимся прямо тут. Инстинктов у человека, похоже, нет, зато налицо явный перекос в социализацию. Самостоятельно индивид не в состоянии освоить речь - и далее со всеми остановками до обычного животного с крайне хреновой приспособленностью к жизни. Но в целом из-за разума вид достаточно успешный. Настолько, что может позволить себе прокормить человеков не только без ножки или без ручки, но и с задержками интеллектуального развития в клиническом смысле, ну и прочих у кого "программа" социализации сбойнула на полпути, типа чайлдфри и прочих. Более того, тут ещё один финт социального кодирования, потому что возможность-то есть, но разумных причин это делать - нет. Только социальные. Возвращаясь на шаг назад: деторождение имело совершенно конкретные разумные причины, которые, кстати, частично не работают именно в развитых экономически обществах, и именно это причина снижения рождаемости, а не залихватское "они вышли из-под довления инстинктов". Как вам вариант согласиться и не спорить тут?

ogost

Инстинкт - поведенческий паттерн, вы путаете с рефлексами.

Чуть ниже ответил более развёрнуто.

MAXH0

ИМХО У человека есть инстинкт самосохранения. Просто мы живем в такой рафинированной среде, что в большинстве случаев он не срабатывает. Вот сработает такой инстинкт, среагируешь ты на него по обезьяньи и все - уцепился так, что клещами не разожмешь.

И еще... Большинство инстинктов человека в настоящее время представлены низкоуровневыми паттернами. Например сходящиеся линии на плоском рисунке человек инстинктивно интерпретирует как перспективу. Нам кажется это элементарное действие, но это сложный акт в котором участвуют и мышцы глазного яблока, и рецепторы и мозг.

Опять же. Репродуктивный инстинкт не подходит к тебе и не говорит "часики тикают!"... Мальчику приятно подержаться за девочку, а девочка в сильных руках "тает". Все это сложные действия. Таких врожденных паттернов поведения в человека заложено много.