Вряд ли кто-то сомневается, что современные нейросети — одна из самых больших технореволюций за последние, наверное, лет 50. А может и в истории, кто знает? Но как говорил дядя Питера Паркера из «Человека-паука»: «С большой силой приходит и большая ответственность».

Недавно прошло несколько заседаний, связанных с вопросом регулирования языковых моделей, количество которых растет как грибы после дождя. В дискуссию внес свою лепту и наш любимый Илон Маск, утверждая, что человечество сталкивается с самой большой угрозой в своей истории в лице искусственного интеллекта. Именно этим вопросом сейчас активно занимаются правительства разных стран. Давайте подробнее рассмотрим эту тему, а заодно чуть порассуждаем.

Аргументы ЗА контроль

Для начала: а что вообще движет людьми, которые выступают за регулирование ИИ? Обратимся к аргументам общественности и систематизируем то, что слышали последние года полтора из каждого утюга.

1. Риск ошибки

Если речь о том, что в очередной статье будут указаны некорректные годы правления Николая II или несуществующие рассказы Толстого, то как бы ничего страшного не произойдет. Ну, максимум какой-то школьник получит тройку за домашнюю работу.

Но представим, что на запрос «У меня болит почка» нейросеть по какой-то причине напишет не «обратитесь к врачу», а что-то в духе «втирайте масло подорожника четыре раза в день». Или того хуже: «Возьмите нож и сделайте аккуратный надрез...». Причем, зная человеческую природу, кто-то же возьмет и сделает!

А если автомобиль с автопилотом вдруг наедет на пешехода? С одной стороны, ну всякое бывает — это же сложная система. Может, пешеход переходил дорогу в неположенном месте или еще что. А с другой стороны, будет ли это волновать родственников сбитого человека? Вдруг живой водитель смог бы предотвратить трагедию?

То есть другими словами, такие ответственные области полностью зависят от разработчиков. На каких данных обучалась модель? Нет ли в алгоритме какой-то ошибки? И так далее. Поэтому люди считают, что уж как минимум разработчики ИИ должны лицензироваться. А в идеале и наборы данных для обучения должны как-то контролироваться. А то неровен час, какая-то компания-разработчик решит использовать данные на основе постов на Reddit.

2. Нарушение авторских прав

Вот есть дизайнер Аня. Она всю жизнь училась дизайнить, работает на фрилансе, зарабатывает деньги своим ремеслом. Но вдруг появляется какой-то Stable Diffusion или Midjourney и рисуют условно за секунды то, на что у нее уходили дни и недели.

Представили? Кажется, что это очень обидно. Но вот Аня в какой-то момент замечает, что нейросеть выдала по какому-то запросу практически точную копию одной из работ в ее портфолио. Ну или что-то очень похожее. Если в одном случае Аня пошла бы в «самый гуманный суд в мире» и доказывала свою позицию, то в случае с нейросетью так не прокатит. Аня совершенная уверена, что ее ограбили.

Поэтому вопрос авторских прав данных, на которых обучалась нейросеть, остается достаточно спорным. Кто-то скажет: «Ну блин, Ван Гон небось тоже вдохновлялся Да Винчи или учился рисовать на работах Тициана». Но все-таки сравнивать процесс обучения человека и нейросети как-то не совсем правильно. Как говорится: «Что дозволено Юпитеру, не дозволено быку».

Поэтому такие, как Аня, решили все-таки бороться за свои права и подали в суд. Примерно по той же причине бастовали и сценаристы: мол, нельзя писать сценарии, обучаясь на наших работах.

3. Потеря работы

Прям больная тема, которая частично проистекает из предыдущей. Скажем, нашу Аню сокращают. С точки зрения бизнеса все совершенно логично: производительность труда возрастает многократно, а стоимость иллюстраций — падает. Капитализм, будет он неладен, двигает прогресс.

Но если речь не об одной Ане, а о тысячах офисных работников, таксистах, водителях грузовиков и так далее? Обычно прогресс всегда работал по другому принципу: уничтожаются старые профессии, появляются новые. Но в случае с ИИ это, возможно, не так: уж очень в мире много профессий, связанных со сферой услуг. Вон, в какой-то индийской компании же уволили 90% сотрудников и ничего? А вот для социума и государства это реальная проблема: нужно создавать альтернативные рабочие места, думать о пособиях и прочее.

4. Непременно кто-то обидится

Понятно, что не стоит в Америке говорить или писать слово на всем известную букву — часть населения обидится (хотя это не мешает им обращаться так друг к другу). Но доходит до маразма: если кто-то спросит, среди какой группы населения в США самый высокий процент преступности на 1 млн представителей своей расы, нейросеть не сможет написать правду. В дело вступает та самая инклюзивность.

Конечно, всем не угодишь. Но возможна тут и другая крайность: если нейросеть реально начнет писать всякие гадости, хоть как-то касаться политики или, что еще страшнее, призывать к чему-то вроде такого — будут огромные проблемы. Причем в любой стране.

5. Конфиденциальность

Когда вы вводите промпт и ждете ответа от нейросети, вы что-то куда-то передаете. И ваш промпт где-то хранится, что удобно с точки зрения сохранения контекста общения. Но вопрос: а куда оно передается? А как оно хранится? А кто еще имеет доступ к этой информации, привязанной к вашему аккаунту? Это все-таки не шифрованное сообщение в Телеграме.

А значит, угроза хакерских атак возрастает. Все мы знаем, что утечки регулярно происходят даже в высокотехнологичных компаниях. А если ваш промпт представлял реально чувствительную для вас или вашей семьи информацию? Или коммерческую тайну для вашего работодателя?

А еще по поводу хранения данных есть извечный вопрос. Нужно ли как-то реагировать, если человек запрашивает: «Как изготовить бомбу в домашних условиях?». С одной стороны, конечно — свобода информации, все дела. Но если вовремя среагировать на подобный запрос, это может спасти не одну человеческую жизнь. А еще — какие отношения у регулирующего государства со страной, где располагаются серверы компании-разработчика. Что там по доступу спецслужб? Ну в общем, вы понимаете.

Аргументы ПРОТИВ контроля

А теперь коснемся доводов другой части человечества, которая относится к регулированию с настороженностью. Причем даже самые важные представители отрасли вроде Сэма Альтмана считают, что контроль нужен, но лишь в определенной степени.

1. Торможение прогресса

Вся история с развитием и распространением нейросетей — это реально самая передовая штука сейчас, наряду с прорывами в научных областях. Но разве кому-то приходило в голову останавливать распространение электричества или появление автомобилей? Хотя электричество убивает людей буквально, как и авто.

Точнее, не так — кому-то в голову это приходило. Причем аргументы были примерно такие же: а как же рабочие места? Безопасность? Этичность — авто же уродуют улицы, в отличие от оставляющих «яблоки» лошадей? Но история показала, что прогресс нельзя тормозить, а важно правильно оценивать риски. Например, авто наезжают на людей? Давайте сделаем ПДД, дорожную разметку, пешеходные переходы и все в таком духе, а не просто запретим выпуск авто.

Ровно в этом же суть и с нейросетями: риски есть, но останавливать разработку на полгода? Надо ли действовать настолько радикально? Ведь нейросети открывают дорогу к новым прорывным исследованиям. Например, помогают создавать лекарства, исследовать соединения на молекулярном уровне и очень много чего еще.

2. Появление новых рабочих мест и помощь существующим профессиям

Ровно то, что мы говорили в аргументах «за», относится и к аргументам «против». Например, Яндекс активно набирает людей, которые будут обучать нейросети и помогают им (если что, это не реклама — автор не имеет никакого отношения к этому техногиганту).

Да и рассуждения о том, что нейросети не заменят людей, а скорее возьмут на себя рутинные задачи, имеет место. Ну куда денутся разработчики? Ведь есть куча нюансов, начиная от взаимодействия с заказчиком и заканчивая построением общей архитектуры приложений. Кажется, что никакой ChatGPT еще долгие годы не сможет заменить человека в комплексе.

3. «Перегибы на местах»

Эта известная фраза из СССР относится к общей проблеме регулирования чего-либо. Например, в стране издается какой-то закон: его нужно провести через парламент, проанализировать в профильных комитетах, и вот это вот всё. При этом нейросети развиваются настолько стремительно, что это явно превосходит время отклика любой законодательной власти на изменения.

Логично, что это приведет к нашему первому пункту — торможению прогресса. Конечно, как-то деятельность регулироваться должна. Но какова вероятность, что власти не скатятся в старый-добрый микроменеджмент? А тут появляется много нюансов, о которых нужна отдельная статья.

4. Недобросовестная конкуренция

Представим, что есть компания А — она ушла в области обучения LLM на годы вперед. И есть компания Б, которая отстает. При этом материальных ресурсов и влияния у Б в избытке. Например, есть возможность пролоббировать свои интересы через политиков и ограничить распространение технологии на время. Когда же Б догонит компанию А, можно все «верстать в зад».

Этично ли это? Тормозить прогресс, руководствуясь только своими финансовыми интересами? И снова мы вернулись к первому пункту — все-таки кажется, что это основное, и пора завязывать с аргументами «против».

Как страны пытаются ограничить ИИ

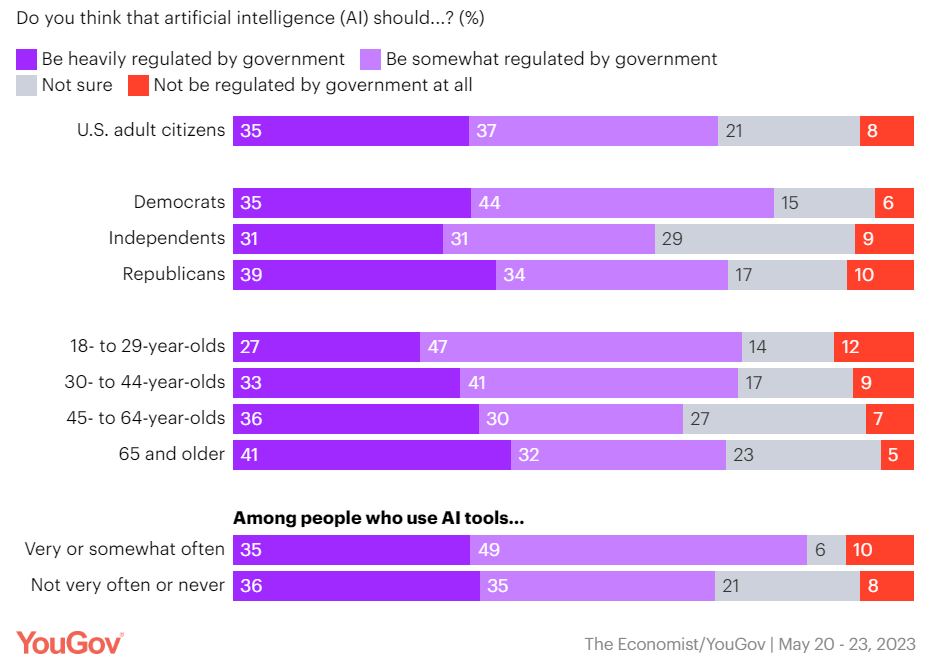

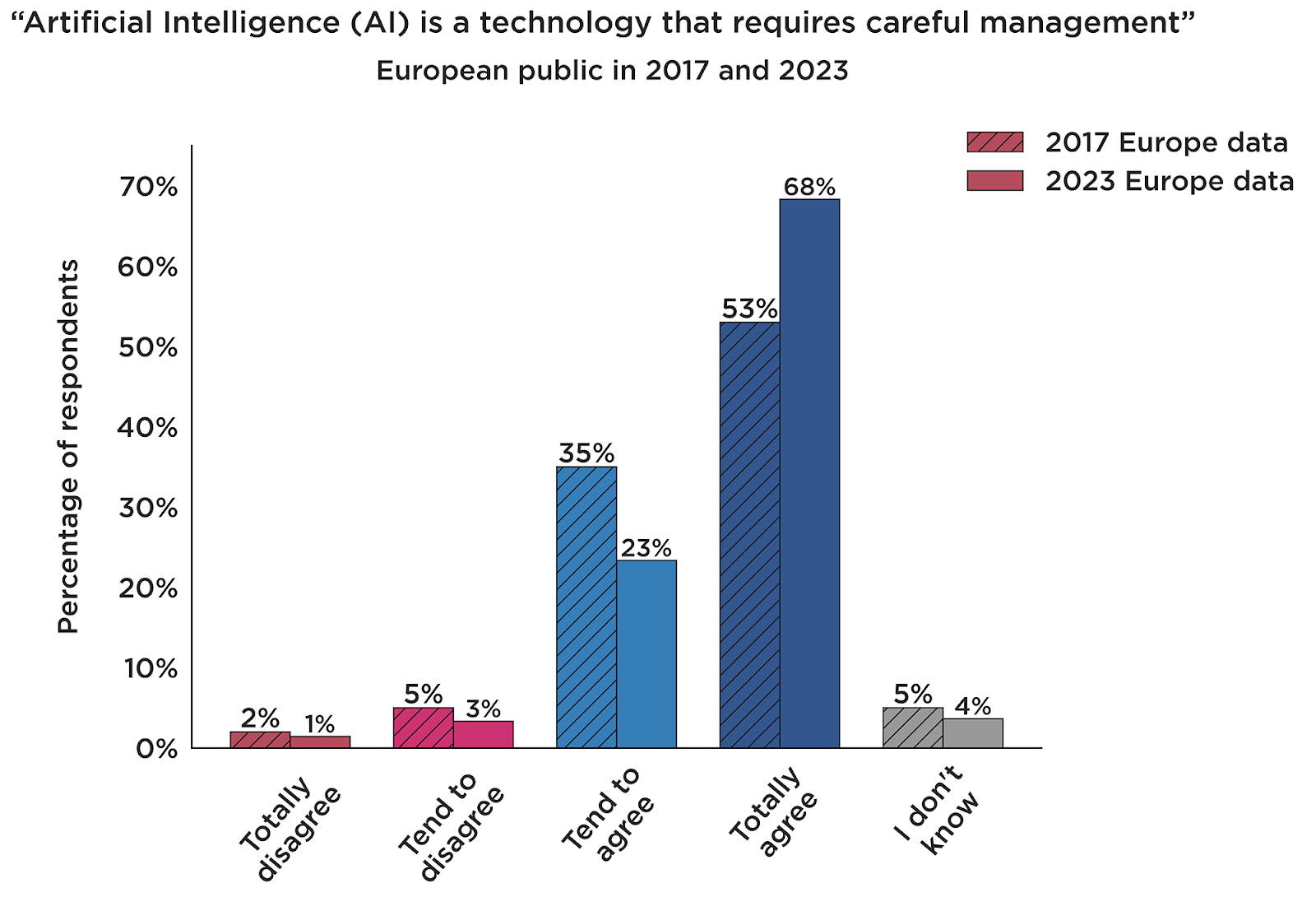

В общем-то большая часть людей выступает все-таки за регулирование отрасли в той или иной степени. Например, вот как распределились голоса разных групп населения в Америке и в Евросоюзе.

Но теперь давайте посмотрим, какие же ограничения вводят разные государства: пройдемся по самым основным.

Соединенные Штаты

Большая часть глобальных игроков находится в Америке: OpenAI, Google, Microsoft, Amazon и другие поменьше. Поэтому для Штатов вопрос стоял острее, чем где бы то ни было. Тот же Илон Маск, о котором мы упоминали в начале статьи, еще в 2017 году заявил:

«Искусственный интеллект — фундаментальный риск для всего человечества. Автомобильные и авиакатастрофы, некачественные лекарства и плохая еда далеко позади»

Из-за особенностей законодательства в Америке сначала в действие вступают отдельные штаты. Поэтому первой ласточкой в области регулирования стал закон AIVIA (Artificial Intelligence Video Interview Act) штата Иллинойс, принятый в 2019 году. Он обязал работодателей информировать кандидатов, если они намерены использовать системы ИИ при оценке видеоинтервью.

Работает это так: кандидаты присылают видео с записанными ответами на вопросы. Дальше нейросеть анализирует язык тела кандидата, мимику, тон голоса, речевые модели и эмоции. И на основе этих критериев рекомендует взять человека на работу или нет. Закон AIVIA якобы давал возможность соискателям отказаться и тем самым рассчитывать на большую объективность. Позже к этой инициативе подключился и Нью-Йорк: теперь работодатели должны обеспечить проверку внешними аудиторами видеозаписей кандидатов. Это позволит исключить случаи предвзятости: ну, скажем, если ИИ по какой-то причине регулярно отказывает в работе людям с другим цветом кожи или разрезом глаз.

В том же 2019 году появилась «Комиссия национальной безопасности по искусственному интеллекту» — вот тут можно посмотреть полный список проблем, которые будет решать регулирование в области ИИ по мнению правительства. Выше мы коснулись их лишь поверхностно.

В 2022 году администрация Джо Байдена издала Blueprint for an AI Bill of Rights, основная задача которого — сделать так, чтобы ИИ работали на американский народ. Если чуть подробнее, то это максимально популистские рекомендации для компаний-разработчиков больших LLM:

обеспечить справедливость, инклюзивность и подотчетность в системах ИИ;

подчеркивать принципы прозрачности и конфиденциальности;

защищать права пользователей;

информировать их, когда они взаимодействуют с системами ИИ и как используется их личная информация.

На протяжении всего 2023 года проходила цепочка слушаний в Сенате по поводу контроля за искусственным интеллектом. Хронология самых знаковых моментов, просто для напоминания тем читателям, кто вдруг что-то пропустил:

В мае Сэм Альтман выступил по поводу необходимости регулирования ИИ;

В июле семь крупных игроков подписали «Билль о правах ИИ»: Amazon, Anthropic, Google, Inflection, Meta, Microsoft и OpenAI;

В сентябре к ним присоединились еще восемь компаний: Adobe, Cohere, IBM, Nvidia, Palantir, Salesforce, Scale AI и Stability;

Также в сентябре публично в Сенате выступили Билл Гейтс, Марк Цукерберг и Илон Маск — последний еще раз подтвердил свои опасения.

В октябре Байден подписывает указ, призванный гарантировать, что «Америка лидирует в реализации обещаний и управлении рисками искусственного интеллекта (ИИ)». В общем, за все хорошее и против всего плохого: против дискриминации, утечки персональных данных и всякое такое. Ожидается, что полноценный закон в области регулирования ИИ должен появиться к концу года — тогда конкретные шаги правительства станут немного понятнее.

Евросоюз

В ЕС с 2018 года действует регламент GDPR: применительно к ИИ он запрещает собирать персональные данные пользователей без их прямого согласия.

В марте 2023 года Италия стала первой страной, которая решила проблему радикально — просто запретила использовать ChatGPT. Якобы из системы утекли личные данные пользователей, а также при входе не проверяется возраст пользователей (ограничение — 13+). Из-за этого дети могли увидеть «ответы, абсолютно не подходящие к их степени развития и самосознания». Спустя чуть больше месяца ограничения были сняты.

На протяжении всего 2023 года Европейский союз прорабатывал законодательную инициативу. В мае он издал так называемый AI Act, в котором четко описал, что такое ИИ и как он должен развиваться. А в декабре ЕС первыми в мире приняли полноценный закон об использовании ИИ. Согласно ему, ограничения теперь будут разделяться на категории, в зависимости от степени опасности.

1. Неприемлемый риск. Это все, что не может распространяться ни в каком виде. К этому относятся:

Когнитивно-поведенческое манипулирование людьми или конкретными уязвимыми группами: например, активируемые голосом игрушки, которые поощряют опасное поведение у детей.

Социальный рейтинг: классификация людей на основе поведения, социально-экономического статуса или личных характеристик.

Системы биометрической идентификации в реальном времени и удаленно, такие как распознавание лиц

2. Высокий риск. Тут уже больше категорий, и по каждой из них соответствующие регулирующие органы будут оценивать, можно ли выпускать продукт на рынок или его нужно будет доработать. Разработчикам придется постараться. Вот полный список из закона:

Биометрическая идентификация и категоризация физических лиц (например, пол, раса, этническая принадлежность, гражданство, религия, политическая ориентация).

Управление и эксплуатация критической инфраструктуры: например, авиасообщение или медицина.

Образование и профессиональная подготовка.

Занятость и управление персоналом: как раз HR собеседования, где по поведению соискателей принимается решение о приеме на работу.

Доступ и пользование государственными услугами и льготами.

Деятельность правоохранительных органов вроде профилирования преступников.

Помощь в юридическом толковании и применении закона.

3. Ограниченный риск. Это как раз продукты вроде ChatGPT: все, что манипулирует визуальным или аудиоконтентом. Они должны:

Информировать о том, что контент был создан искусственным интеллектом.

Предотвращать генерацию незаконного контента.

Публиковать отчеты с используемыми для обучения данными, если они были защищены авторским правом.

4. Минимальный риск. Все, что не попадает под действие первых трех ограничений вроде интеллектуальных спам-фильтров, могут использоваться без ограничений.

Пока не очень понятно, как это будет реализовываться. Но кажется, что вопрос будет решен в ближайшие несколько недель — слишком многое на кону.

Китай

20 июля 2017 года Государственный совет Китая опубликовал документ под названием «План развития искусственного интеллекта». В нем власти попытались определить показатели развития ИИ аж до 2030 года. Плановая экономика — она такая. Надо признать, что с 2017 года КНР опережает США по количеству патентов в области ИИ.

Однако с появлением ChatGPT Китай увидел, насколько реальна угроза «морального разложения нации». Поэтому 11 апреля 2023 года ввел временные ограничения на использование подобных LLM. В частности генерируемый контент должен соответствовать законодательству страны, уважать ее традиции — для этого все приложения должны проходить полную проверку и регистрацию. А еще весь контент должен обязательно маркироваться. Скажем, если кто-то публикует новость с картинкой, сгенерированной ИИ, нужно это четко пометить.

Ограничения показались драконовскими из-за неопределенности формулировок и серьезных финансовых штрафов: за каждый факт нарушения — до 100 000 юаней (порядка 14 000 $).

Однако уже 15 августа 2023 года вышла расширенная версия: Китай опубликовал 24 руководящих принципа, объясняющих подробности и требования регуляторов. Например, вот некоторые важные моменты:

Убрали штрафы — по мнению ряда специалистов, это посылает миру сигнал, что Китай открыт к развитию отрасли.

Выделили семь агентств, которые будут контролировать работу LLM и разрешать выход на рынок. Например, администрация киберпространства Китая (Cyberspace Administration of China, CAC), Министерство образования, Министерство науки и технологий и Национальная комиссия по развитию и реформам.

Сохранили необходимость сертификации продуктов на рынке, а также маркировки сгенерированного ИИ фото и видеоконтента.

Обязали компании предоставлять доступ правоохранительным органам к информации, на основе которой обучались модели.

Подтвердили, что весь контент не должен нарушать чьи-то авторские права. В случае чего компания «понесет соответствующую юридическую ответственность».

В общем, даже с послаблениями стало ясно: у китайских компаний будут очевидные преимущества при выходе на рынок. Чем воспользовались технологические гиганты:

Alibaba в августе 2023 года выпустила Qwen-VL и Qwen-VL-Chat на основе языковой модели Tongyi Qianwen.

Baidou в октябре 2023 года представила нейросеть Ernie 4.0 и даже поспешила сообщить, что она лучше GPT-4.

Так что несмотря на довольно строгое регулирование, что было весьма ожидаемым от властей КНР (привет, китайский файрволл), с развитием ИИ там нет сложностей.

Россия

В 2020 году появился программный документ — Распоряжение Правительства РФ от 19 августа 2020 г. № 2129-р «Об утверждении Концепции развития регулирования отношений в сфере технологий искусственного интеллекта и робототехники на период до 2024 г».

В 2021 году появился так называемый «Кодекс этики ИИ». Еще один документ из разряда «за все хорошее, против всего плохого», без какой-то конкретики. Разумеется, все главные игроки отрасли вроде Яндекса, Сбера, VK, МТС и прочих его оперативно подписали.

В 2023 году вышел закон № 408-ФЗ «О внесении изменения в Федеральный закон „Об информации, информационных технологиях и о защите информации"» обязывает владельцев сайтов и приложений раскрывать подробности работы рекомендательных систем на основе ИИ.

Но пока что большого закона, регулирующего использование ИИ как в США, Евросоюзе или Китае, в России нет. Зная специфику, можно предположить, что регулирование все-таки, скорее, пойдет по пути нашего восточного партнера.

Поделитесь в комментариях, как вы считаете: нужно ли регулировать ИИ? И если да, то насколько сильно?

НЛО прилетело и оставило здесь промокод для читателей нашего блога:

-15% на заказ любого VDS (кроме тарифа Прогрев) — HABRFIRSTVDS.

Комментарии (27)

ifap

25.12.2023 10:10TL;TR:

Все, кто не успел вскочить в последний вагон: авторские права, рабочие места, восстание машин, ко-ко-ко!

Правительства: нам можно, остальным - нельзя!

Те, кто успел (покручивая на остустсвующем у машин органе всех остальных): да-да, конечно, как скажите, глубоко разделяем ваше ко-ко-ко!

Apxuej

25.12.2023 10:101. Неприемлемый риск.

Системы биометрической идентификации в реальном времени и удаленно, такие как распознавание лиц

Я знаю, что многие люди очень не любят камеры слежения, а особенно те, где используется технология распознавания лиц. Я в целом могу понять такую позицию, как минимум со стороны того, что эта информация будет использоваться как инструмент государственного контроля.

Вопрос тем, кто придерживается подобной позиции: если бы государственные органы могли получить данные с камер, за конкретный, чётко обозначенный промежуток времени и/или с участием определённого человека, только с информированного, добровольного (в законе прописано наказание за давление) согласия, допустим, подавляющего большинства (2/3) жителей посёлка или жителей квартала города, где эти камеры установлены - поменяло бы это обстоятельство Ваше отношение к камерам видеонаблюдения или нет?

Ohar

25.12.2023 10:10Нет, потому что на примере выборов отлично видно что этим согласием просто манипулировать

Apxuej

25.12.2023 10:10Давайте представим, что система работает именно так как я описал и различным органам власти по тем или иным причинам накладно злоупотреблять ей (допустим в Европе, если такое невозможно в России). Есть ли ещё какие-то причины для нежелания видеть камеры на улицах? Причины могут быть любые: от непринятия того, что они снимают частную жизнь без разрешения, вплоть до того, что камеры портят внешний вид города. Мне интересно знать: дело в только в том, что исполнительная власть заработала подобную репутацию - тирана работающего только для собственного блага или всё-таки есть неприязнь к самой концепции, что за тобой следят и архивируют твои действия, может есть недоверие к здравомыслию окружающих людей, если брать ситуацию, которую я описал или ещё какая-то причина, которую я пропустил.

anonym0use

25.12.2023 10:10"всё-таки есть неприязнь к самой концепции, что за тобой следят и архивируют твои действия"

SkywardFire

25.12.2023 10:10Неприятия к самой концепции нет. Если что-то неодушевлённое, пусть и обладающее квази-интеллектом "смотрит" как я хожу по квартире голый -- мне абсолютно всё равно. Ведь оно даже не смотрит, это то же самое, как если бы на столе лежал кирпич, почему это должно меня как-то волновать?

Даже если это будет где-то архивироваться на какой-то срок, в описанном утопичом параллельном мире мне по-прежнему было бы параллельно.

Вот только подобное невозможно. Обязательно кто-то получит неправомерный доступ, а какой-нибудь свежепринятый закон вдруг поимеет обратную силу.есть недоверие к здравомыслию окружающих людей

Есть, и обоснованное, к сожалению.

ifap

25.12.2023 10:10данные с камер <...> с участием определённого человека, только с информированного, добровольного согласия, допустим, подавляющего большинства (2/3) жителей посёлка

А зачем допускать? Военный коммунизм уже построен в КНДР, где подавляющее большинство последователей идей чучхе решает за индивида, что для него лучше. Давайте вообще не лезть в частную жизнь граждан ни при каких условиях, даже если 99 из 100 жителей посёлка хотят заглянуть за соседский забор? Это такой смелый эксперимент, что на него еще никто не решился.

Apxuej

25.12.2023 10:10Как я это вижу на примере посёлка: мальчишки угнали машину покататься, врезались в дерево, духа сознаться не хватило. Владелец авто послал сообщение на внутренний чат со ссылкой на время и номера камер, которые он хотел бы посмотреть и описанием, что произошло. В течение суток (или быстрее) жители проголосовали с телефонов или личных ПК в чате за или против (не проголосовал - значит против) и, в случае набора нужного числа голосов, зашифрованный сервер расшифровал и выплюнул записи с камер в общий чат. Виновников нашли и они будут отрабатывать, вскапывая картошку. Данные с камер сразу идут в зашифрованном виде. Сервер располагается в отдельной бетонной будочке со стальной дверью с несколькими кодовыми замками чтобы любые несколько человек представляющих домохозяйства смогли вместе получить доступ к нему в случае необходимости - сервер пошлёт всем сигнал в чат, когда будка будет открыта. Также сервер всего лишь сборщик и резервное шифрованное хранилище - его уничтожение ничего не даст, так как все данные хранятся по кускам на устройствах жителей в зашифрованном и избыточном виде.

Если, например, все вокруг параноики и не доверяют друг другу, не доверяют конкретному человеку или боятся человека или группу людей, то получить данные с камер будет очень проблематично, т.е. будет так, как будто камер не существует вовсе, если не касаться органов власти, а рассматривать только взаимодействие людей в посёлке. Только когда есть, какое-никакое доверие между людьми и людей не слишком много, чтобы не потонуть в запросах и была возможность знать всех лично (действовал институт репутации) или близко к этому, можно воспользоваться камерами в случае ЧП или спорной ситуации. Естественно данные с камер, которые смотрят во внутренний дворик дома или лестничную клетку городской многоэтажки принадлежат исключительно жителям дома/лестничной клетки и запрос приходит исключительно им.

Мой пример, описанный выше, довольно скучный, вероятно, у меня не хватает фантазии, чтобы представить как всё может пойти наперекосяк. Меня заинтересовал Ваш пример с тем, как люди захотят подглядывать друг за другом. Думаете люди будут делать записи с камер (если к ним будет свободный доступ), чтобы "сталкерить" или ещё по каким причинам? Если позволяет время опишите худший сценарий, который можете представить, опять же учитывая то, что мы неким неназванным образом решили проблему органов власти желающих превратить камеры в инструмент контроля.

ifap

25.12.2023 10:10сервер расшифровал и выплюнул записи с камер в общий чат

... участники которого мигом забыли об угоне, потому что куда интереснее обсудить попавшего в кадр гражданина Иванова, мацающего за филейные части гражданку Петрову (по мужу). Вот почему в реальной жизни записи с камер достаются не общественности в чате, а "спецсубъекту" - сотруднику спецслужб, которому в теории параллельно, свою жену мацает гражданин Иванов или чужую.

Apxuej

25.12.2023 10:10Тут я уверен, что записи камер, т.е. результат запроса должен быть виден всем, так, если кто-то из голосовавших захочет проверить соответствует ли цель запроса реальности, он сможет это сделать. Такой проверкой можно найти того, кто слишком часто кричит волк - этот человек потеряет репутацию в глазах сообщества и возможность использовать камеры.

Интересное замечание насчёт секса. Понятное дело на улице мы с ним не столкнёмся (ну или сами себе злобные буратины), однако расставить камеры так, чтобы, например, ни одно окно, а с ним и личное пространство за ним, не попадало в объектив, будет сложной задачей. Также, например, кусочек двора может попасть в кадр, что тоже можно считать личным пространством. Теоретически эта проблема решается во время установки и настройки камер путём заблюривания частей картинки с окнами, например.

Но я вижу более глобальную потенциальную проблему на которую Вы намекаете: некие действия, которые не являются незаконными, но являются социально осуждаемыми и могут повлечь нежелательные последствия, возможно не должны быть запечатлены на камеру. Эти события невозможно разделить технически (пока у нас не будет сильного ИИ). Тут вопрос становиться плюсов и минусов: вы узнали кто поцарапал Вашу машину выезжая со стоянки двора, но Ваша жена узнала о том, что Вы зачем-то заходили в подъезд дома напротив. Это интересно и я поразмыслю об этом, спасибо за комментарий!

ifap

25.12.2023 10:10Проблема может быть тоньше: моя жена знает, зачем я заходил в подъезд дома напротив, но мы не желаем, чтобы эта информация была широко известна и вызывала нездоровый интерес у третьих лиц.

Radisto

25.12.2023 10:10Мой пример, описанный выше довольно скучный, вероятно у меня не хватает фантазии, чтобы понять как всё может пойти наперекосяк.

Банально: все соглашаются делать такую систему, но так как все - не профессионалы, им некогда, то делать будут вполне определенные личности, которые и уговаривали людей на внедрение Большого Брата. Система делается таким образом, что вышеозначенные люди могут эту информацию просто брать и пользоваться, наплевав на то, кто там за что голосовал или не голосовал. Особо недовольных можно заткнуть, использовав камеры везде, до того, как их услышат кто-нибудь. Надо только начальный этап пройти - построить систему слежения, чтобы до ее ввода в строй никто не мешал. А мешать не будут пока верят, что это для его же блага. Все пойдёт не так с самого начала: все стратегии на доверии неустойчивы относительно эгоист/альтруист примерно с архея (прокариоты еще до кислородной катастрофы от этой проблемы страдали, и с тех пор ничего не изменилось)

ifap

25.12.2023 10:10Коллега все-таки предлагал рассматривать варианты, где все стороны (кроме угонщиков)

живут в Раюдействуют добросовестно, но все равнооказываются в Адувыходит какой-то АдЪ и Израиль (впрочем, сегодня это почти синонимы).

Apxuej

25.12.2023 10:10Спасибо за комментарий! Да, что-то типа неразрешимой проблемы с электронными выборами. Любой человек должен быть способен полностью понять как технически система работает, но это возможно только с бумажными выборами, поэтому электронные выборы всегда будет гораздо проще подтасовать. Мне нравятся бумажные выборы, однако, мне не нравятся системы основанные на показаниях свидетелей - их часто нет там, где они нужны, их память ненадёжна и они иногда врут.

Потенциальные пути решения проблемы технически неграмотных пользователей:

1) Существование поставщиков оборудования специально под эти цели с репутацией, подтверждённой технически грамотными специалистами и простыми для понимания схемами физической защиты этого оборудования от модификации, а также простым способом подтвердить аутентичность оборудования. Т.е. глаз и мобильного телефона с камерой и выходом в интернет должно быть достаточно для проверки. Это вводит некую минимальную планку технической подкованности, но в современном мире она не слишком высока.

2) Поддержка со стороны государства, заключающаяся в создании законодательной базы налагающей особую ответственность на производителя оборудования, а также ответственность за попытки модификации подобного оборудования.

Репутация поставщиков всё время будет проверяться на прочность технически подкованными пользователями (в том числе на вмешательство третьих сил), а модификация оборудования для собственной пользы будет очень невыгодна, если учесть потенциальные риски.

Система слежения всё-таки не настолько лакомый кусочек, чтобы нечистые на руку люди выстаивались в очередь, чтобы завладеть ей. Тут нет непосредственной выгоды, люди не совершают поступки за которые их можно тут же поймать за руку и начать шантажировать, а если и совершают, то чтобы поймать такой момент придётся потратить какие-то титанические усилия - оно того не стоит.

Не уверен, что стратегии на доверии не устойчивы. Не устойчивы стратегии на абсолютном доверии, а стратегии, в основном построенные на доверии, но способные показать зубы в ответ на агрессивные действия являются самыми устойчивыми/выгодными насколько мне известно из теории игр. Хотя может я не совсем верно Вас понял.

Возможно Вы имеете в виду, что система нестабильна в том плане, что если один пользователь поймает за руку другого, то это будет началом разлада в этом небольшом коллективе и со временем коллектив превратиться в игру "все против всех" и система слежения станет бесполезной - все будут голосовать против всех. В этом случае Вы правы, но я не уверен в том, что это будет происходить часто, всё-таки люди в основном настроены на кооперацию, особенно с людьми, которых они знают лично.

Вопрос ленивых жителей, которые не желают участвовать во всей этой кутерьме, поэтому допустим не голосуют (т.е. всегда против) или голосуют всегда одинаково, может быть проблемой требующей решения для нормального функционирования системы. Потенциально может существует много людей, которым изначально понравилась идея, но затем им стало скучно и влом читать о проблемах других людей. Думаю для этой проблемы также можно найти решение. Допустим возможность делегации своего голоса "главной бабушке дома" :) Или случайная делегация.

Wesha

25.12.2023 10:10Проблема систем наблюдения ещё и в том, что

Ваше мнение о происходящем зависит от положения камеры

* Домашнее задание со звёздочкой

Хотя посыл этого ролика правильный — восприятие зрителем происходящего зависит от точки зрения — на самом деле ролик была снят одной камерой в три дубля, между которыми камера переставлялась в очередную "точку зрения", а актёры повторяли действия заново. Если внимательно сравнить все дубли, можно заметить различия в некоторых, казалось бы незначительных деталях. Таких деталей здесь не менее трёх. Найдите их. А также уясните, что доверять нельзя никому — даже тем, кто хочет предупредить вас, что вас обманывают ;)

Мне — можно!

SkywardFire

25.12.2023 10:10Мне удалось обнаружить только одну неточность

В конце второго эпизода чел хватает сразу дипломат дядьки. В третьем же эпизоде он хватает самого дядьку, а не его дипломат.

Wesha

25.12.2023 10:10Подравляю, Вы прошли тест.

Во втором дубле когда парень хватает дядьку, его левая ладонь лежит на правом плече дядьки спереди (отчётливо видна как белое пятно). В третьем дубле когда парень хватает дядьку, его левая ладонь лежит чуть пониже правой лопатки дядьки сзади.

Во втором дубле когда дядька "загораживается" от парня портфелем, в центре портфеля на пару кадров отчётливо видна пряжка (то есть пряжка направлена на парня). В третьем дубле когда мужик размахивается портфелем, чтобы "загородиться" им, на той стороне портфеля, которая через секунду окажется направлена на парня, пряжки нет. (Ну не обратил режиссёр внимания, что актёр вертел портфель в руках между дублями и в третьем дубле держал его не той стороной, что во втором).

Во втором дубле к моменту, когда парень схватился за портфель, дядька совершил всего три движения ногами (услышал парня, поставил правую ступнь на землю, развернулся вокруг неё, поставил левую ступню на землю, слегка раздвинул колени). На третьем дубле к моменту, когда парень схватился за портфель, дядька успел ещё совершить несколько мелких подпрыгиваний и пошире расставить ноги.

acc0unt

25.12.2023 10:10Проблема в том, что такой механизм можно будет обойти. На примере России видно, как власти при острой необходимости могут вращать на оси любые механизмы, которые в теории должны ограничивать их способность творить дичь.

Но наличие такого механизма всё же лучше его полного отсутствия. Потому что сейчас абсолютно ничего не мешает собирать огромные сети из городских камер и лить данные из них в распознавание лиц непрерывно.

SkywardFire

25.12.2023 10:10Возможно, и поменяло бы, но в реальности такая ситуация, разумеется, невозможна.

Kojimeister

25.12.2023 10:10Спасибо за статью, интересно было узнать новое для себя. Мне кажется, достаточно разработать на гос. уровне протоколы безопасности для ИИ, но ни в коем случае не приостанавливать деятельность организаций.

Alexey2005

25.12.2023 10:10Я вижу тут ещё одну угрозу - окончательное опопсение культуры и искусства с катастрофическим снижением разнообразия.

Если зайти на любой ресурс, предназначенный для публикации результатов AI-генерации, или же отфильтровать ИИ-контент на тех имиджбордах, где за него не банят, то можно увидеть удивительную вещь: все эти ИИ-картинки очень похожи. Они выполнены в одном и том же "сглаженном" стиле, их содержание также не блещет разнообразием.

Поначалу подобное явление удивляет: в конце концов, ИИ - великолепный подражатель, любой стиль копируется на раз! А разгадка проста, и вы найдёте её сразу же, как только начнёте сами публиковать ваши работы.

Создаёте что-то в интересной и необычной стилистике, играете с композицией, вводите сюжет - а в ответ тишина, ну может два-три лайка и прилетит за неделю. Потом выдаёте стандартную хрень "как у всех", тупо скопировав популярный промпт - в первый же день две сотни лайков и четыре комментария.

И если живой автор как правило не может быстро взять и поменять стиль в угоду толпе, то оператор ИИ - может и будет, раз хочет популярности.

В итоге чем больше вокруг будет ИИ, тем сильнее начнёт оптимизироваться искусство. Всё будет одинаковым, пластиково-градиентным. Выпускаться станет исключительно попса, которая угождает максимально широкому кругу потребителей, а ничего по-настоящему качественного вы уже не увидите.

NeoCode

Ну что можно сказать... Нам, Сообществу, определенно нужен децентрализованный свободный ИИ, неподконтрольный никакому государству. Понимаю, что это задача колоссальной сложности, но все же не невозможная. Обучение - на Либгене, Сайхабе и интернет-ресурсах, заслуживающих доверие (типа Хабра). Схема работы - чем больше участник предоставляет своих вычислительных ресурсов, тем выше его приоритет в обработке запросов.

klimensky Автор

Однозначно нужен, но возможно ли подобное вообще? Кто будет обеспечивать его работу (и гражданами какой страны они будут)? Кто и из каких средств будет платить за ресурсы и работу людей? Где будет размещаться мозговой центр (и в какой блок входит эта страна)? И таких вопросов будет много...

NeoCode

Децентрализованность подразумевает отсутствие центра. Платить - очевидно через предоставление своих ресурсов для вычислений. Т.е. человек предоставляет свой комп для работы сети, ему за это начисляется какая-то внутренняя децентрализованная крипта, которой он расплачивается за взаимодействие с самой сетью.

Я прекрасно понимаю огромную сложность этой задачи. Особенно - как связать математическую строгость proof of work с распределенными нейросетевыми вычислениями... Но хочется верить что гении найдутся.

Alexey2005

Не оно?