Уже сейчас ChatGPT и «коллеги» оказывают огромное влияние на различные отрасли бизнеса, науку и обычную жизнь интернет-пользователя. При этом модели постоянно совершенствуются, становясь всё более умелыми — они получают новые возможности, функции, осваивают недоступные ранее для ИИ отрасли. Чего ожидать от следующей версии ChatGPT, GPT-5?

Что это будет за модель?

Генеральный директор Open AI, компании, которая и формирует ChatGPT, заявил, что это «потрясающая новая модель». Его слова подтверждают некоторые пользователи, получившие доступ к демоверсии GPT-5. Конечно, это не финальный релиз, но уже сейчас результаты теста впечатляют.

В частности, представитель одной из компаний, протестировавший новую модель, заявил, что она «значительно сообразительней» предыдущей версии. GPT-5 была продемонстрирована с учётом сценариев и данных, отвечающих запросам его компании. При этом некоторые задачи выполняются автономно.

Среди прочих улучшений можно выделить следующие:

усовершенствованное понимание языка. Новая модель «осознаёт» контекст и различные нюансы речи, что даёт возможность генерировать более естественные и адекватные ответы. Ранее у GPT с этим возникали проблемы

мультимодальное обучение. GPT-5 учится на базе большого количества различных источников данных, включая текст, изображения и аудио, для получения более точных и разнообразных результатов. Разработчики заявили, что сейчас спектр источников гораздо шире, чем ранее

улучшенная персонализация. Ожидается, что GPT-5 будет предлагать индивидуальные результаты и сможет адаптироваться к предпочтениям пользователей и стилю письма

понимание комплексных задач. Сообщается, что GPT-5 в состоянии охватывать более сложные концепции, чем ранее. Модель сможет рассуждать и решать проблемы. Кроме того, в новой версии ожидается создание точных прогнозов на основе исторических данных

Альтман ранее заявил следующее: «Наиболее важные улучшения, вероятно, будут связаны с умением анализировать». Он объяснил, что имеет в виду способность моделей ИИ интерпретировать информацию, делать выводы и решать проблемы, используя имеющиеся данные и логические умозаключения.

Технические параметры новой модели ещё неизвестны, но объём обучающих данных существенно превысит показатели предыдущих версий. Эксперты считают, что вполне может появиться медицинский вариант модели, который станет выполнять роль относительно опытного терапевта. Кроме того, существует и вероятность появления других специализаций: «юриста», «консультанта по финансам» и т. п. Но это, скорее всего, будут платные варианты.

Речь идёт о том, что новая версия представляет собой многоступенчатый ИИ, способный выполнять задачи, которые ранее были недоступны для искусственного интеллекта. Вероятно, GPT-5 перестанет «лениться», как это случилось c GPT-4.

Релиз GPT-5 ожидается уже летом. И, кстати, в это же время будет представлена LlaMA 3, вероятно, одна из наиболее популярных open-source-моделей, развитие которой поддерживает Марк Цукерберг. Для разработки новой версии Meta закупила графических чипов более чем на $1 млрд.

Мощнее, умнее, разнообразнее

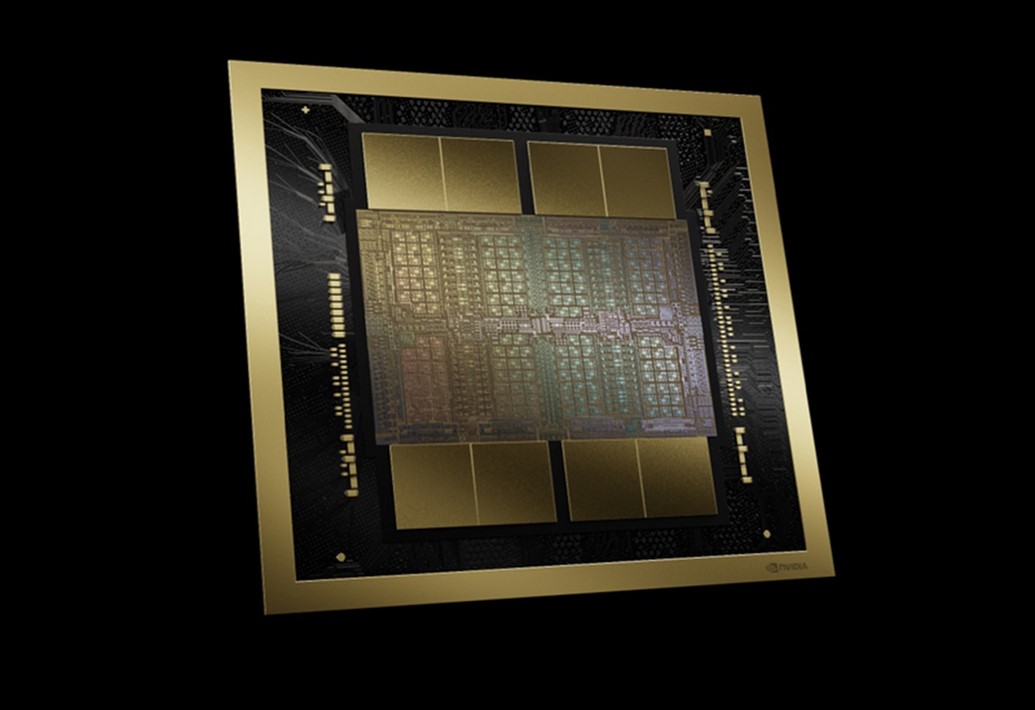

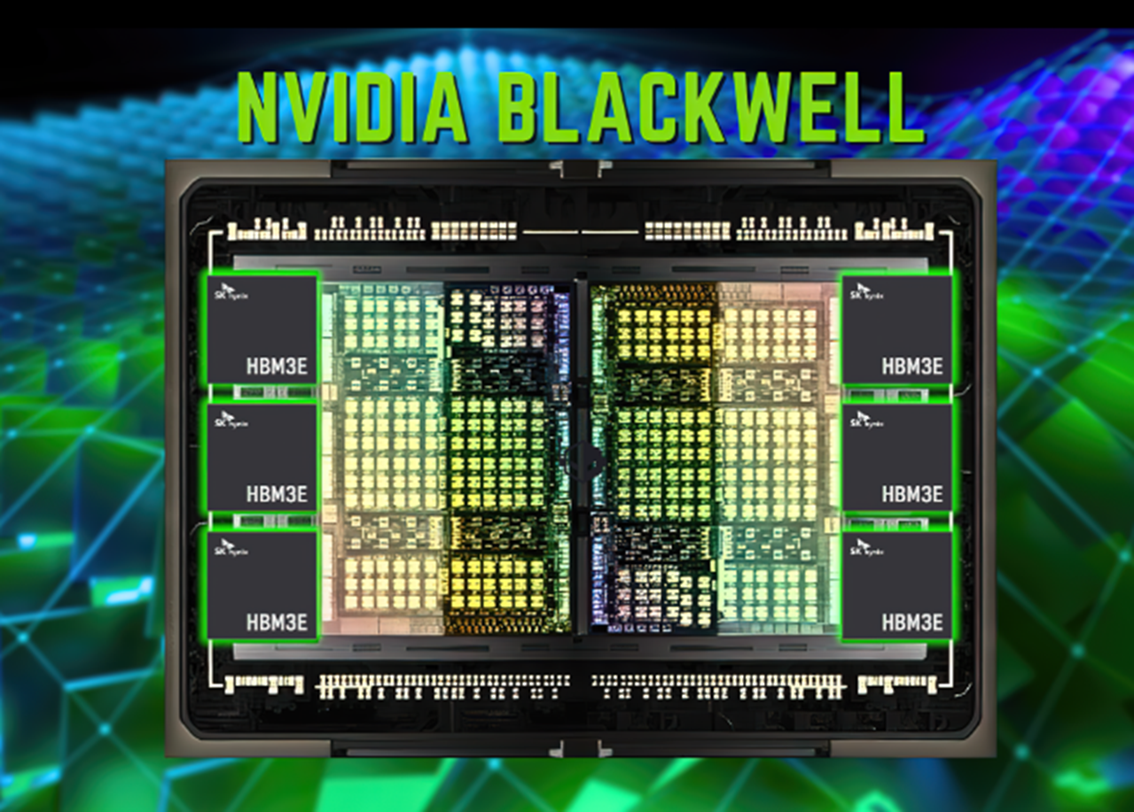

Аппаратное обеспечение для работы с ИИ-моделями тоже совершенствуется. Так, корпорация Nvidia продолжает развивать направление производства чипов для ИИ-отрасли. На днях руководитель американской компании заявил о выпуске самого мощного ИИ-чипа в мире. Кроме того, готовы и некоторые модульные системы, базирующиеся на основе GPU B200, так называется новинка.

В марте 2024 года Nvidia показала новые ускорители вычислений, которые базируются на архитектуре Blackwell. Последняя — «потомок» Hopper, предтечи, представленной два года назад.

Корпорация заявила, что новый чип предназначен для создания систем, позволяющих обучать поистине гигантские модели — уже не с миллиардами, а триллионами параметров. Это нужно для решения таких задач, как обработка естественного языка, создание мультимодальных приложений, кодогенерация и т. п. В нейминге архитектуры нет ничего удивительного, она названа в честь американского математика.

Стоит отметить, что чипы H100/H200 крайне востребованы на рынке, несмотря на свою цену. Новый чип, насколько можно судить, будет ещё дороже, но, скорее всего, его тоже станут массово покупать. Здесь стоит подробнее рассказать о характеристиках чипа.

Так, новый GPU состоит из двух кристаллов, которые произведены по специальной версии 4-нм техпроцесса TSMC 4NP (само собой, на мощностях TSMC) и объединены 2,5D-упаковкой CoWoS-L. Интересно, что это первый GPU компании Nvidia с чиплетной компоновкой. Чипы соединены шиной NV-HBI с пропускной способностью 10 Тбайт/с и работают как единый GPU. Всего новинка насчитывает 208 млрд транзисторов. Свой продукт компания называет двигателем для новой промышленной революции.

Собственно, имеет право, поскольку его возможности действительно отличные. Например, в вычислениях FP4 и FP8 этот GPU показывает производительность до 20 и 10 Пфлопс соответственно. Не в последнюю очередь функции чипа обусловлены новыми тензорными ядрами и вторым поколением механизма Transformer Engine. Он позволяет выполнять тонкую настройку вычислений для разных задач, что, конечно, влияет на скорость обучения моделей. Blackwell поддерживает работу с самыми различными форматами, включая FP4, FP6, FP8, INT8, BF16, FP16, TF32 и FP64.

В целом, всё говорит о том, что новые ИИ-модели станут гораздо более совершенными и «умными», чем любая из предшественниц. Насколько это будет полезно для бизнеса и науки — покажет время.

Комментарии (8)

OrkBiotechnologist

01.04.2024 16:46+4Нейросетка станет ещё чаще посылать в гугл искать ответ самому и говорить, что у неё всё работает?

MarselMM

01.04.2024 16:46+1Локальным llm сетям уже не хватает 64 Гб оперативной памяти, а по количеству параметров они значительно уступают промышленным ИИ. Когда уже дешевыми станут 256 Гб массовые домашние компьютеры.

Eugone

01.04.2024 16:46"Релиз GPT-5 ожидается уже летом."

В этом году OpenAI обещала выкатить только одну модель и это не GPT...

segment

Ну может что-то станет лучше, но пока как-то.. странно. По моим наблюдениям что 3.5, что 4.0 выдают результат хуже, чем был при запуске, но тут имхо, могу ошибаться. Уже где-то писал, что вероятно это связано с тем, что режут выдачу сильно из-за всяких запрещенных вещей. А запрещенного очень много. И если раньше я мог попросить модель следовать каким-то правилам при ответах, то сейчас почти сразу модель то забывает об этом, то потом внезапно вспоминает.

OrkBiotechnologist

Вообще такое ощущение складывается от всех нейросеток в принципе.

От поиска по картинкам, до перевода текста.

Не то их всех так кастрировали цензурой, не то в последних версиях Tensorflow/PyTorch что-то фундаментально поменялось и сделало всё кривее.

И результат скачет от обновления к обновлению, на примере тех же переводчиков - DeepL последние месяцы по ощущению работает хуже гугловского. Да и относительно самого себя в более ранних итерациях

Kasyan666

Пальцем в небо: сейчас на всех не хватает хардварных мощностей, поэтому нейросеткам режут их потребляемые мощности, дабы они не генерили ответ по два часа на каждый промпт.

cLegion

А вот это близко к правде, в одном из интервью Альтман сообщал, что качество напрямую зависит условных мощностей, поэтому им приходится балансировать, между окупаемостью и качеством.

Kergan88

Объяснение простое - нельзя впихуть невпихуемое.

С каждой попыткой починить чтото при помощи тонкого тьюнинга чтото другое - ломается.